产品介绍

产品背景

国家十四五规划及2035年愿景目标纲要中提到,要加快数字经济、数字社会、数字政府,以数字化转型整体驱动生产方式、生活方式和治理方式变革。新一代信息技术与行业加速融合,企业数字转型需求日益显现。为企业数字化提出了更高的目标“业务模式数字化+客户体验数字化+运营管理数字化”,企业数字化转型的要义:技术与业务的快速融合。 变革为企业带来机遇的同时也迎来了新的挑战,转型过程中的业务连续性成为了企业快速发展过程中的生命线,而业务连续性管理将成为运维的核心。 此外,在国产化浪潮下,主流软硬件更迭加快,在政策和技术的双轮驱动下,国产软硬件的市场份额逐年增加,基础软硬件国产化是IT市场发展必然趋势

IT运维困境

IT资产管理混乱,无法定义资产价值

- IT资产数量多,关联关系复杂多变,手工管理起来乱如麻,造成维护成本高,数据质量差。资产维保到期无感知,资产盘点无从下手,常规的运维工作极难开展;一旦出现故障,不知道找谁处理,不清楚影响范围有多大

IT监控缺乏全局视角,业务故障无法快速解决

- 每天接收海量告警事件,“狼来了”的故事持续上演,真实故障无法被响应;业务故障无感知,用户报障方察觉,信息部门变“救火队”,被动支持问题;无法清晰直观的展示业务系统的运行状态;

IT运维成本高,方式方法落后,产能低

- 高达80%时间手工处理重复、繁琐、低价值的日常运维工作,运维效率低;主机分散,运维入口不统一,权限无法统一控制,发生事故难以定位定责;经验难传承,“师傅带徒弟,口口相传”,不能形成知识库;

运维服务投入大,业务对服务的价值无感

- 服务请求量大,运维同事长期处于找人或者各种事件确认过程,造成大量的时间浪费;事件请求多以电话、企业微信等方式接收,常常出现事件处理遗漏或者遗忘等情况,经常导致用户投诉;运维人员疲于响应各类事件处理,但没有形成完整的工作记录,工作无法量化,价值难以体现;

产品定位

WeOps是为企业的IT运维部门提供覆盖资源管理、监控告警、健康扫描、运维工具、知识库等多项功能为一体的运维工具,通过打通各业务单元、贯穿各技术栈,以故障定位和全生命周期管理为核心,持续保障业务连续性。

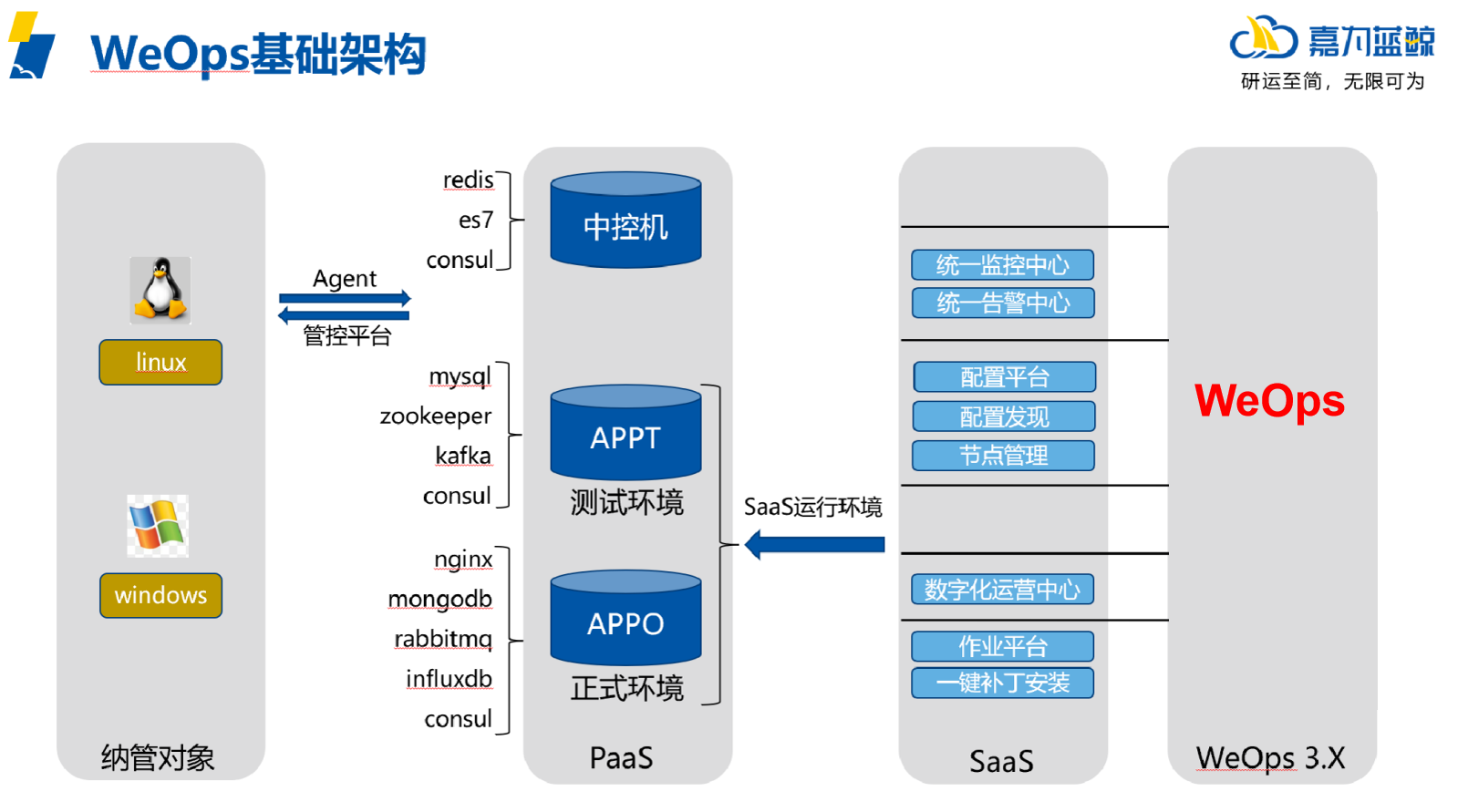

产品架构

产品模块

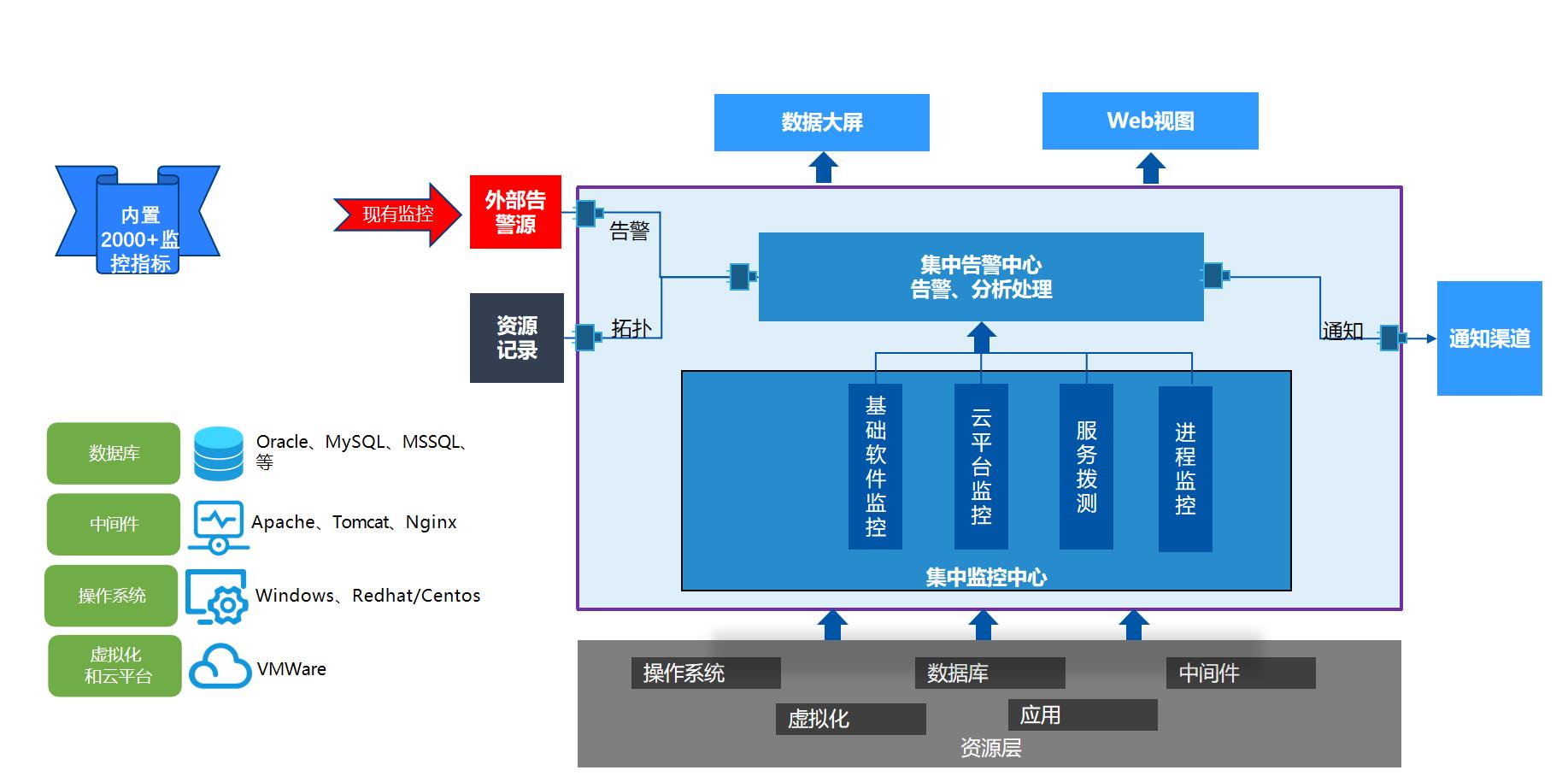

智能监控:业务及组件全方位监测,及时全面感知问题

WeOps性能监控提供统一的视图,支持看到应用整体的运行情况,覆盖:主机、数据库、中间件、K8S、网站、虚拟化、邮件系统、AD等对象

与其他监控工具不同,WeOps各模块之间融合联动,性能监控和智能告警、知识库以及自动化工具共同组成“发现问题-分析问题-解决问题-沉淀经验”的场景闭环,有效提升IT运维质量。

- 便捷易用,提供统一的应用视图

- 强大的监控能力,覆盖常用IT对象的2000+指标

- 具备自动化能力快速分析和解决问题

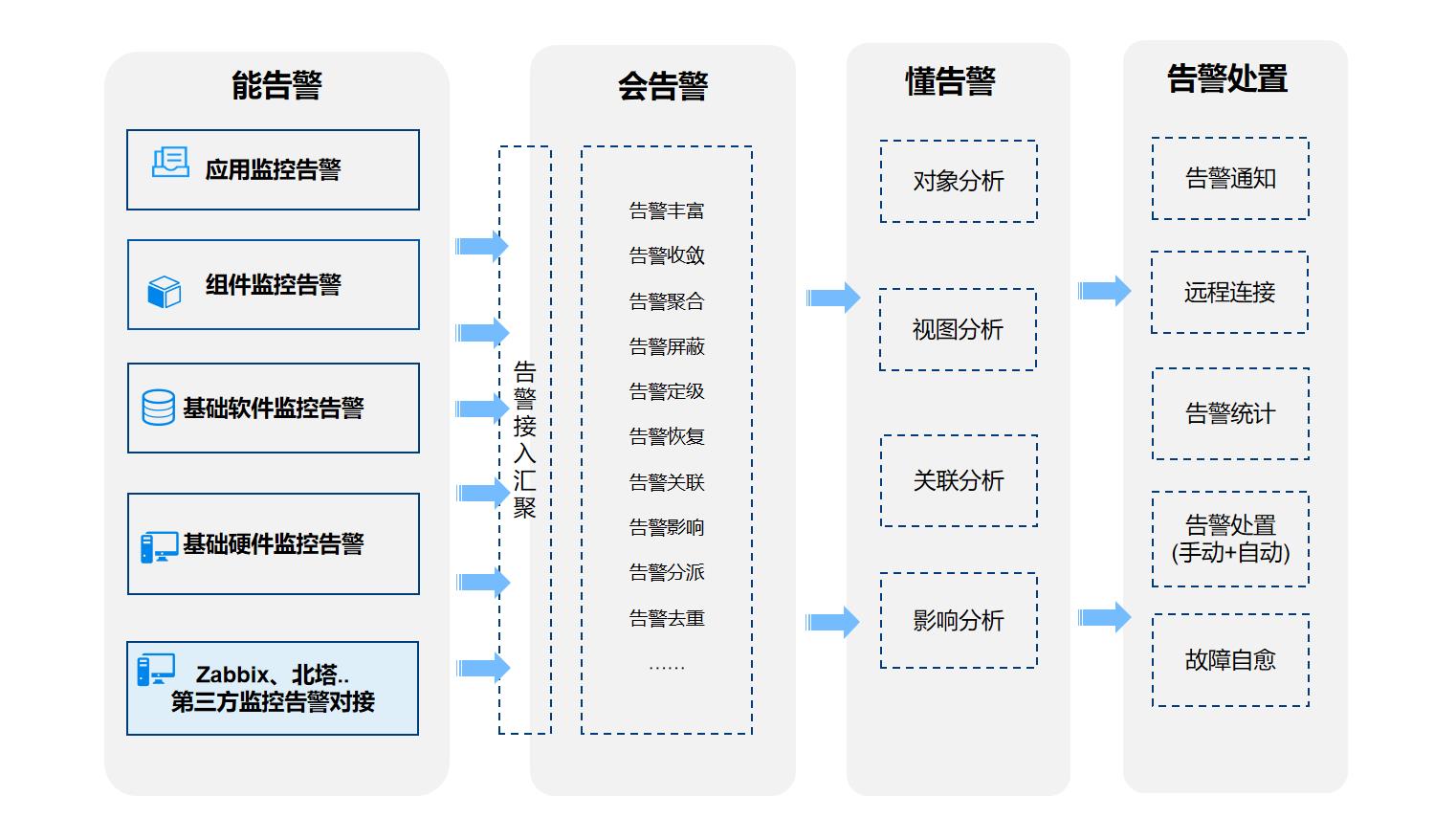

智能告警:故障及时感知,降低故障排查时间,提升运维效率,降低运维成本

WeOps智能告警提供智能处理告警的能力,集中海量的告警事件进行降噪和关联分析,辅助根因定位,并可联动自动化工具实现故障自愈,从而提升企业的运维效率,降低运维成本。

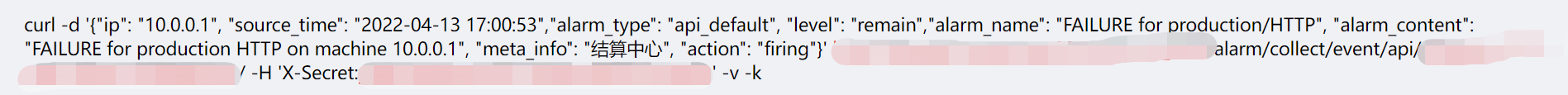

- 支持接入其他系统的告警事件进行集中管理

- 自动屏蔽无效告警,过滤重复告警

- 展示告警对象的关联拓扑,辅助根因定位和影响分析

- 故障自愈

日志管理:日志统一采集和管理,满足合规性要求

满足日志管理合规性要求,快速提高日志价值获取效率,扩充监控能力,完善监控体系。

- 使用无代理日志收集、基于代理的日志收集和日志导入,包括Syslog、JSON、Kafka、AMQP、SNMP等多种输入源

- 提供了多种日志字段提取的方式,将日志进行结构化,提取出相应的字段信息,有助于日志后继的分析

- 使用全文搜索引擎打造秒级关键字搜索功能,输入搜索条件一键抵达事件发生现场,无需手动登陆服务器查看日志。

- 提供监控告警规则,灵活配置支持各种日志监控应用场景,通过企业微信、电话等方式多种途径及时通知。

- 根据业务情况和系统状况,可以任意灵活插拔各种分析报表。报表自动刷新,异步交互,实时查看系统总览。

IT服务台:统一门户,凸显IT运维价值

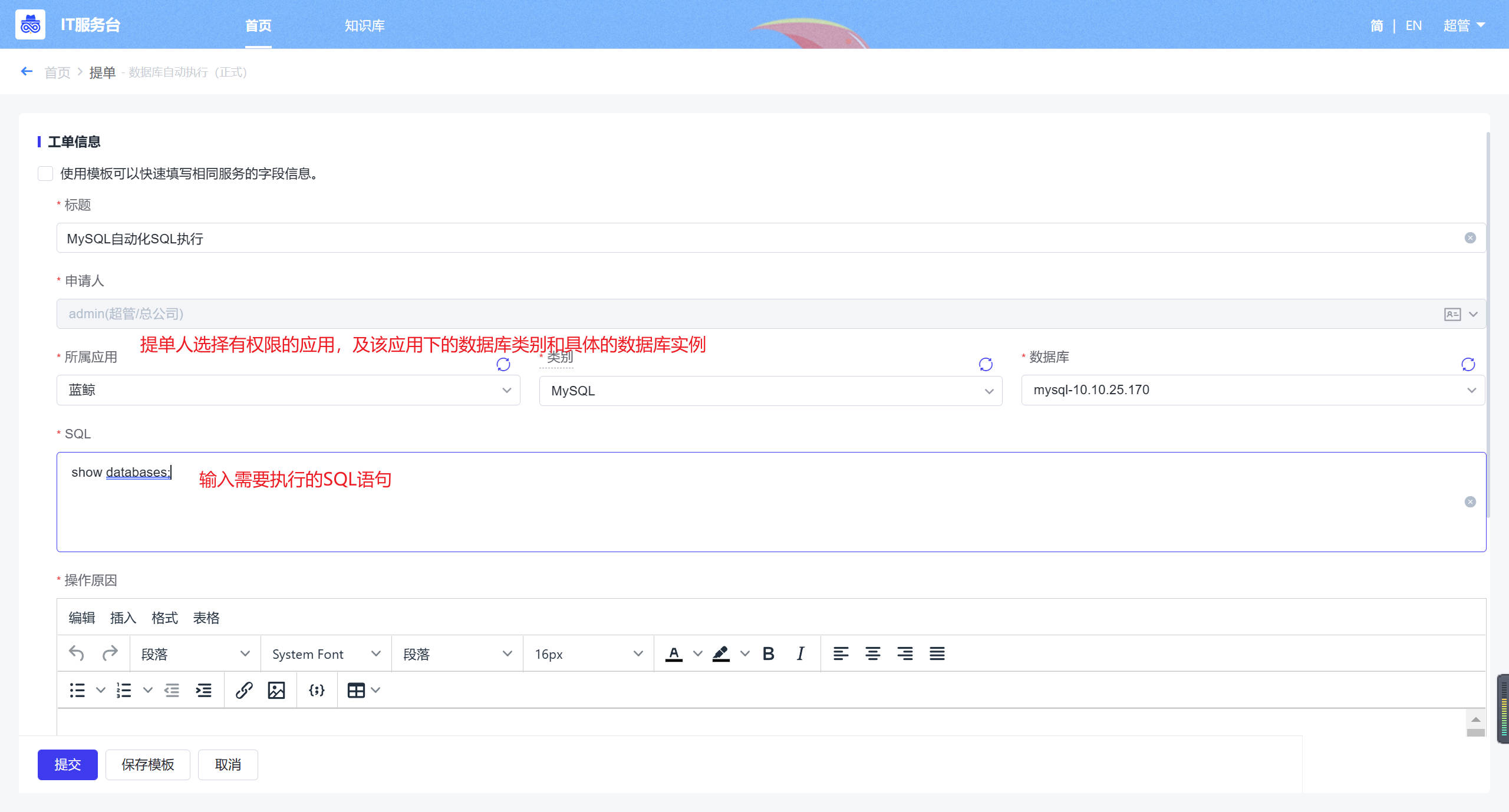

WeOps IT服务台促进IT团队对业务部门提供更加及时有效的运维持续性服务,支持快速构建服务流程,并可联动自动化工具提供自助服务的能力,提升IT服务满意度。

- 快速构建服务流程

- 为业务人员提供IT自助服务

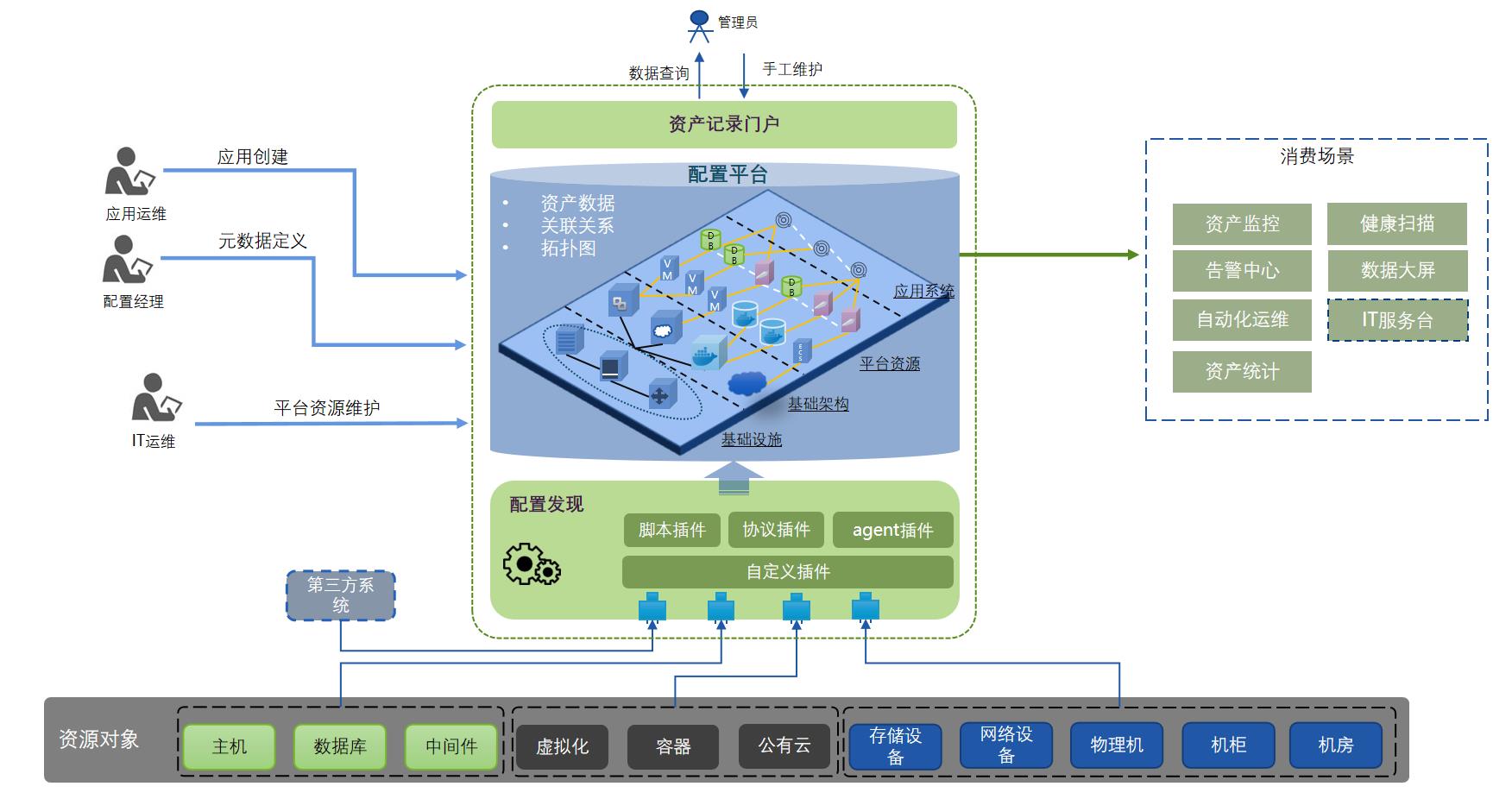

资产记录:资产管理自动化,构建自动化运维基石

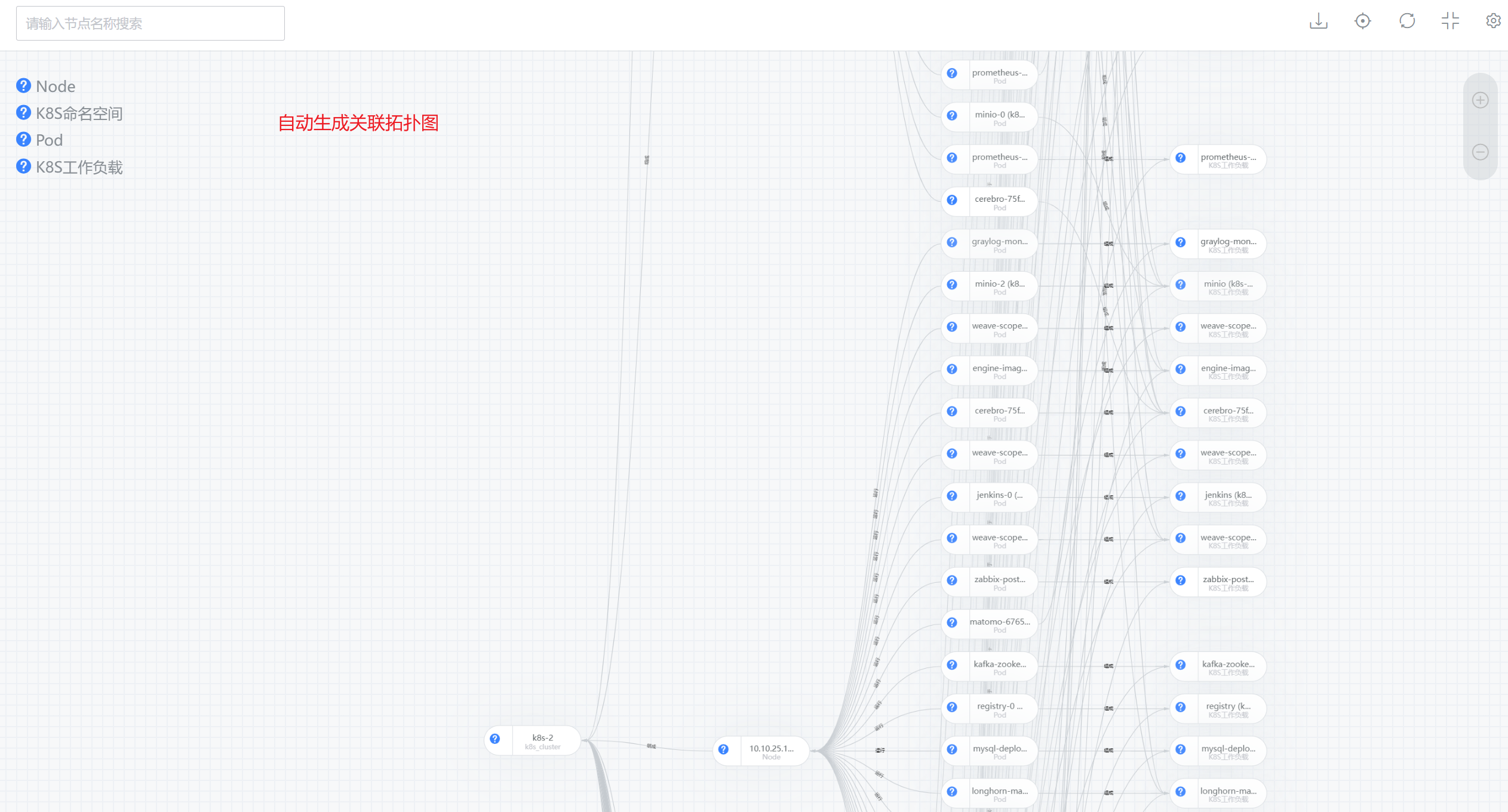

WeOps资产清单全面管理IT资产数据,自动采集资产的配置信息和关联关系,生成应用架构拓扑,提升企业IT资产管理的规范性和数据准确性。

- 自动发现资产数据和配置信息

- 自动生成架构拓扑

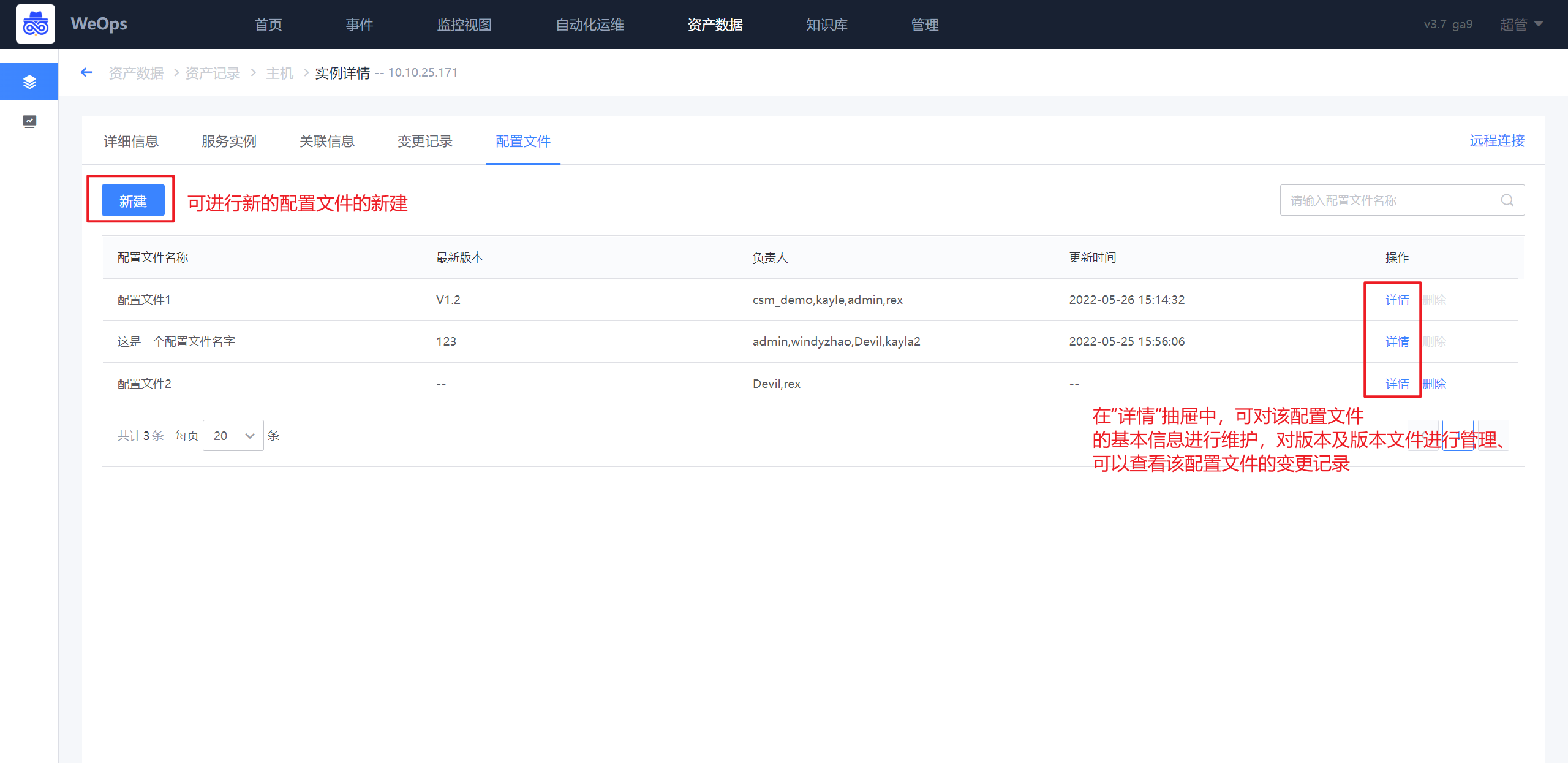

- 配置文件管理

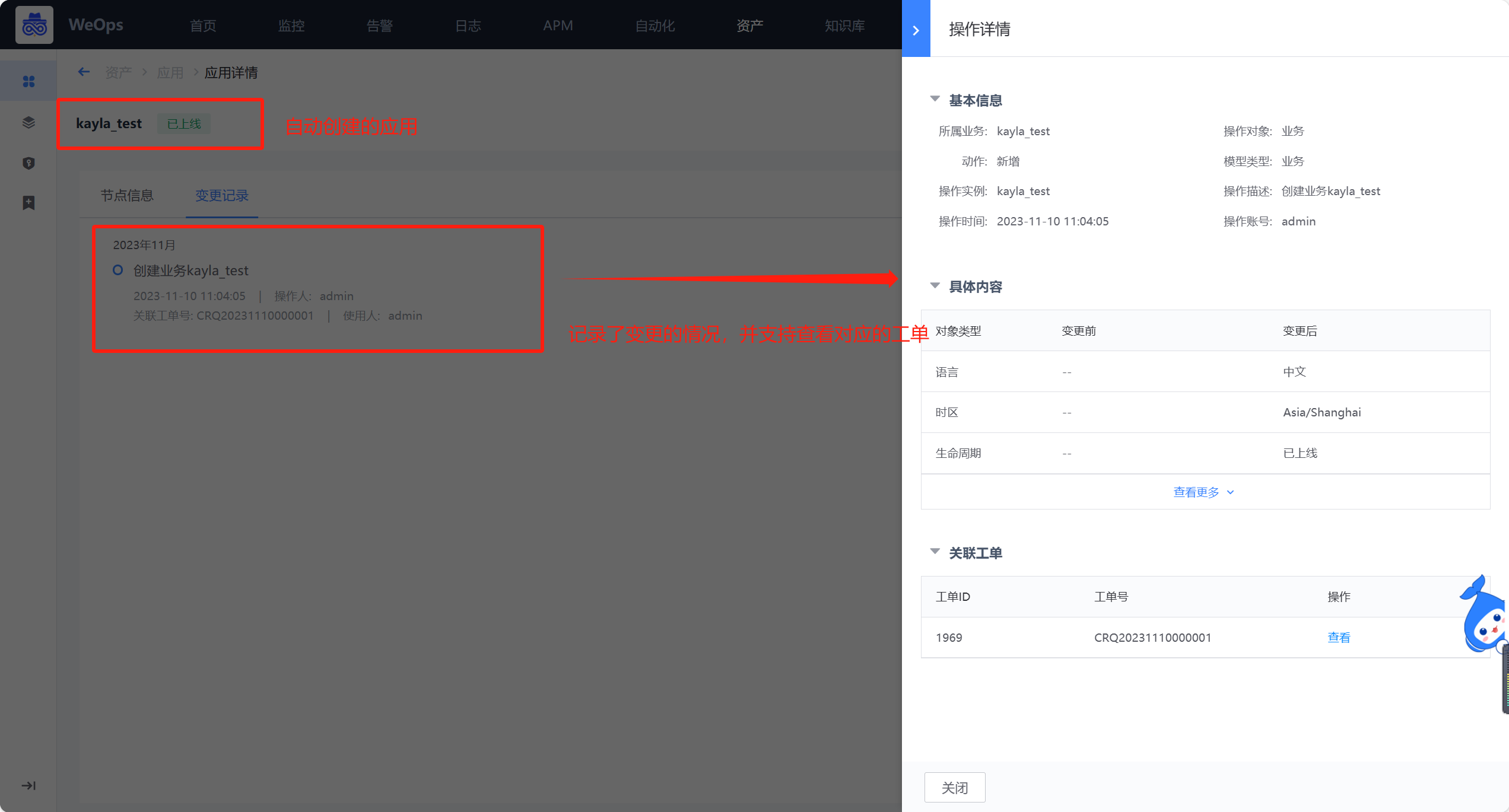

- 变更记录

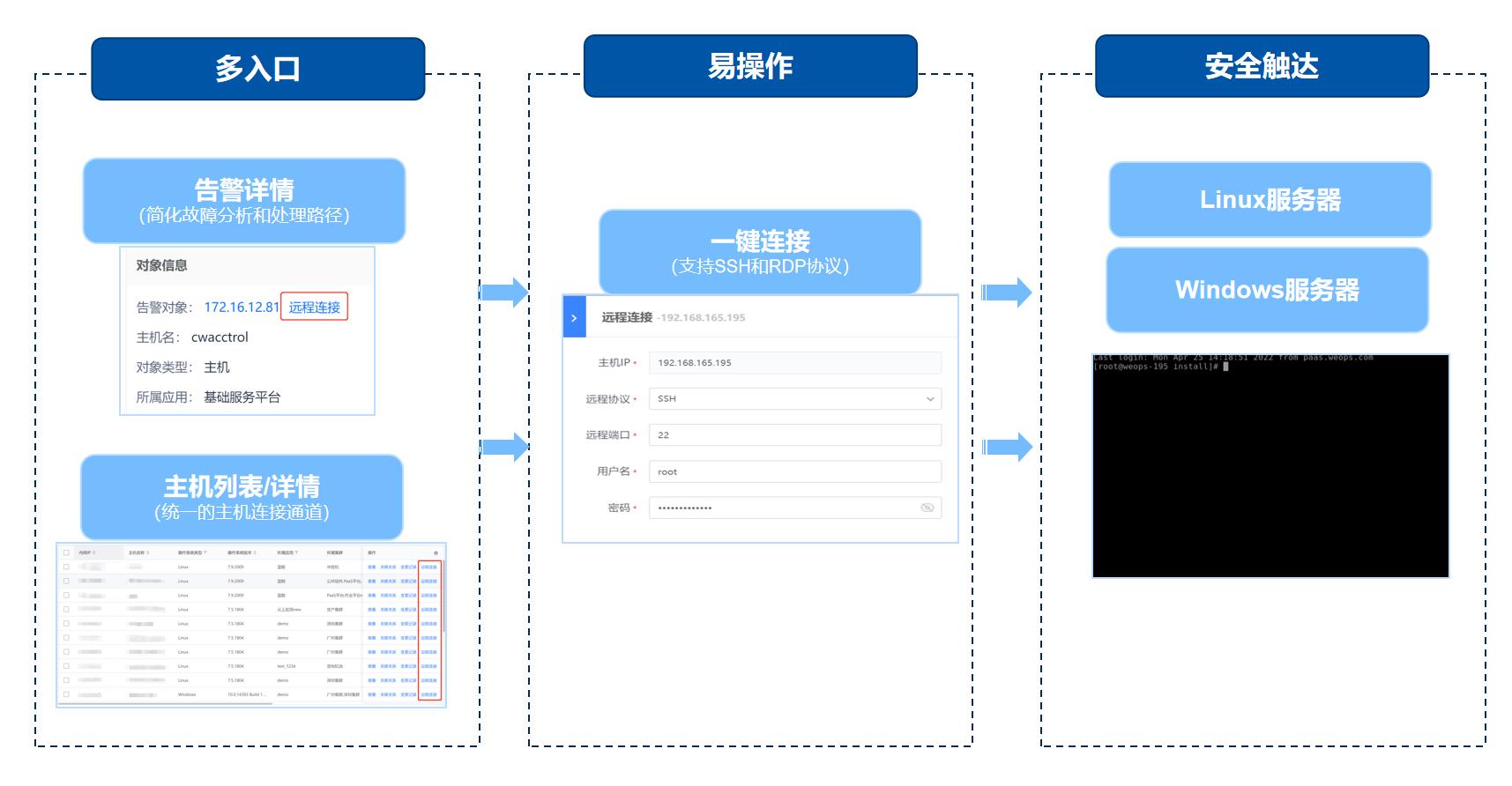

远程管理:一键远程,提供安全高效的连接通道

WeOps远程管理提供统一、安全、高效的运维连接通道,简化服务器故障分析和处理过程。

- 一键远程,高效运维

- 加密传输,安全运维

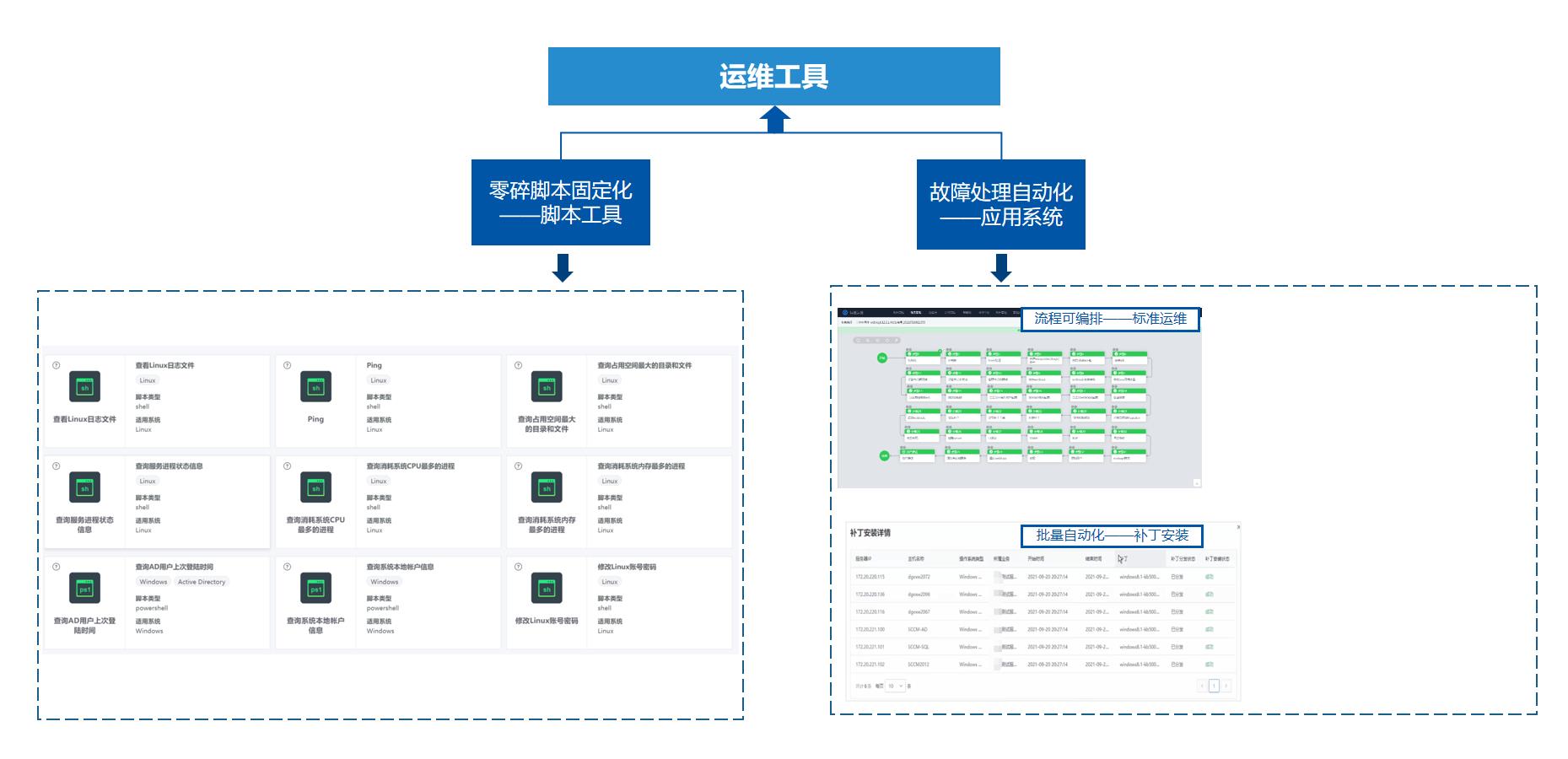

运维工具:持续积累的自动化工具,灵活丰富的故障处理手段

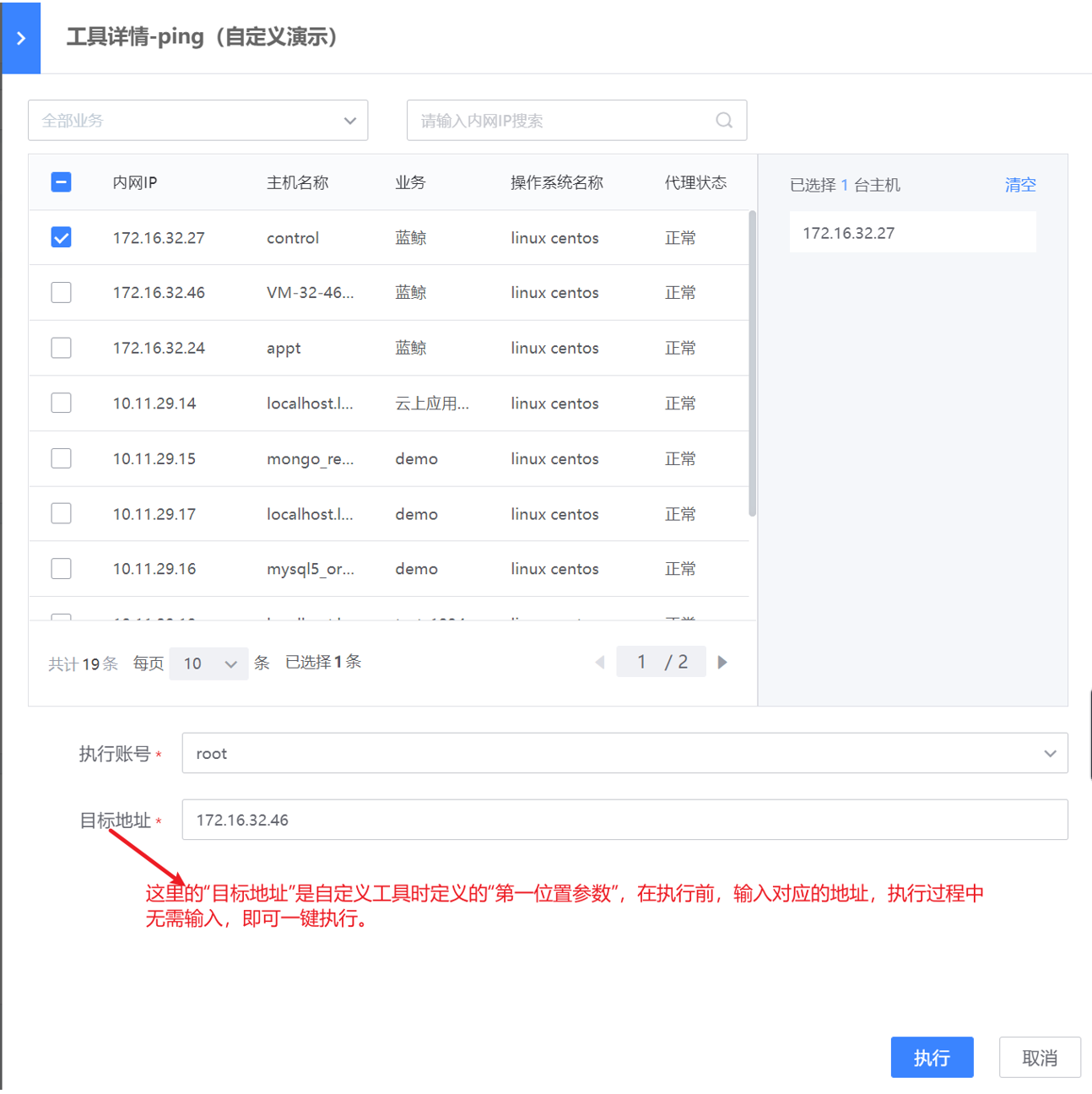

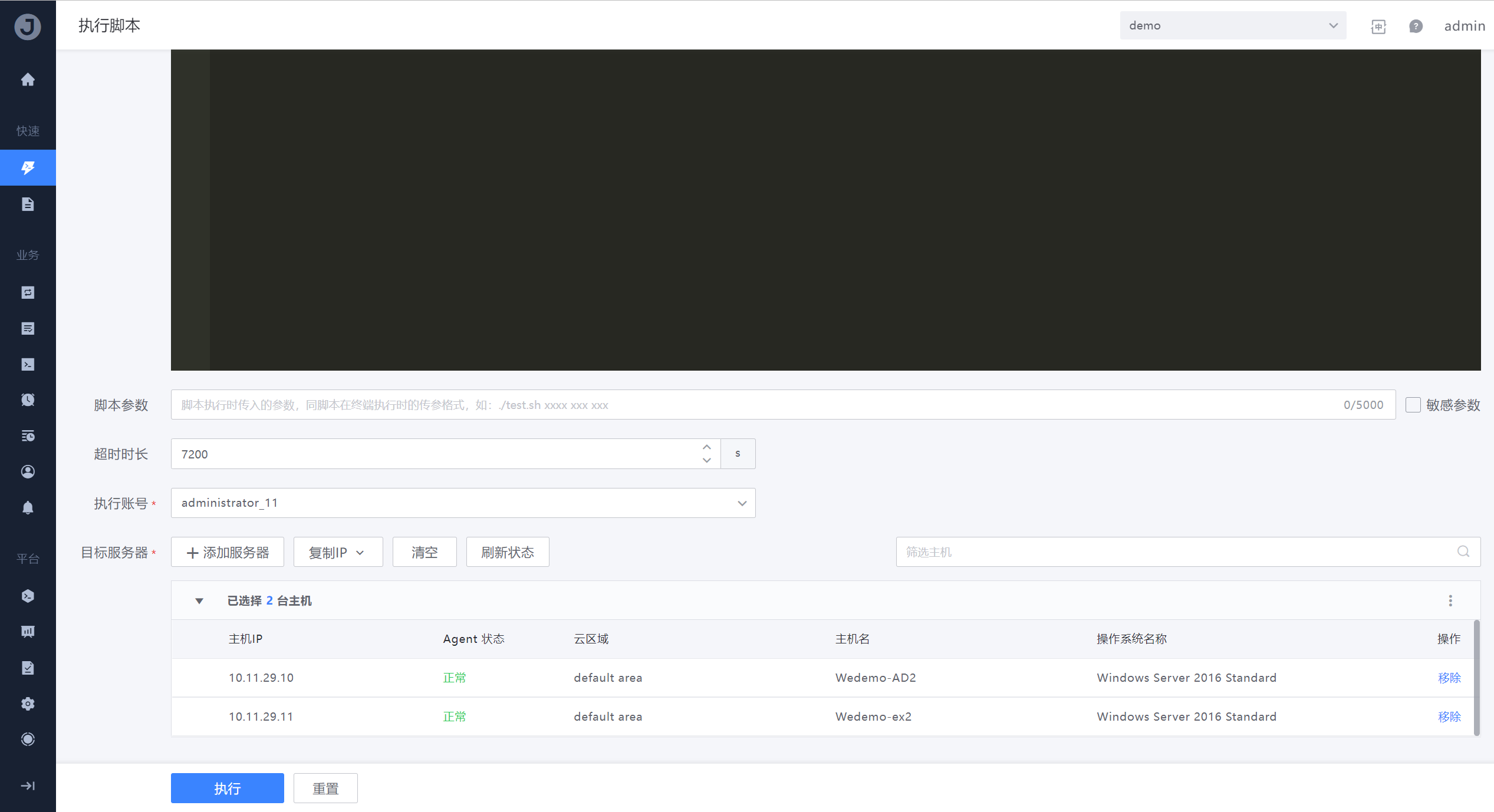

IT团队可以通过WeOps自动化工具将常用的脚本打包成简单易用的运维工具,支持批量快速下发脚本。 并且运维工具可被其他模块调用,如智能告警、IT服务台,形成故障自愈、自助服务等自动化能力。

- 简单易用,批量快速下发脚本

- 自定义制作运维工具

- 支持被其他模块调用

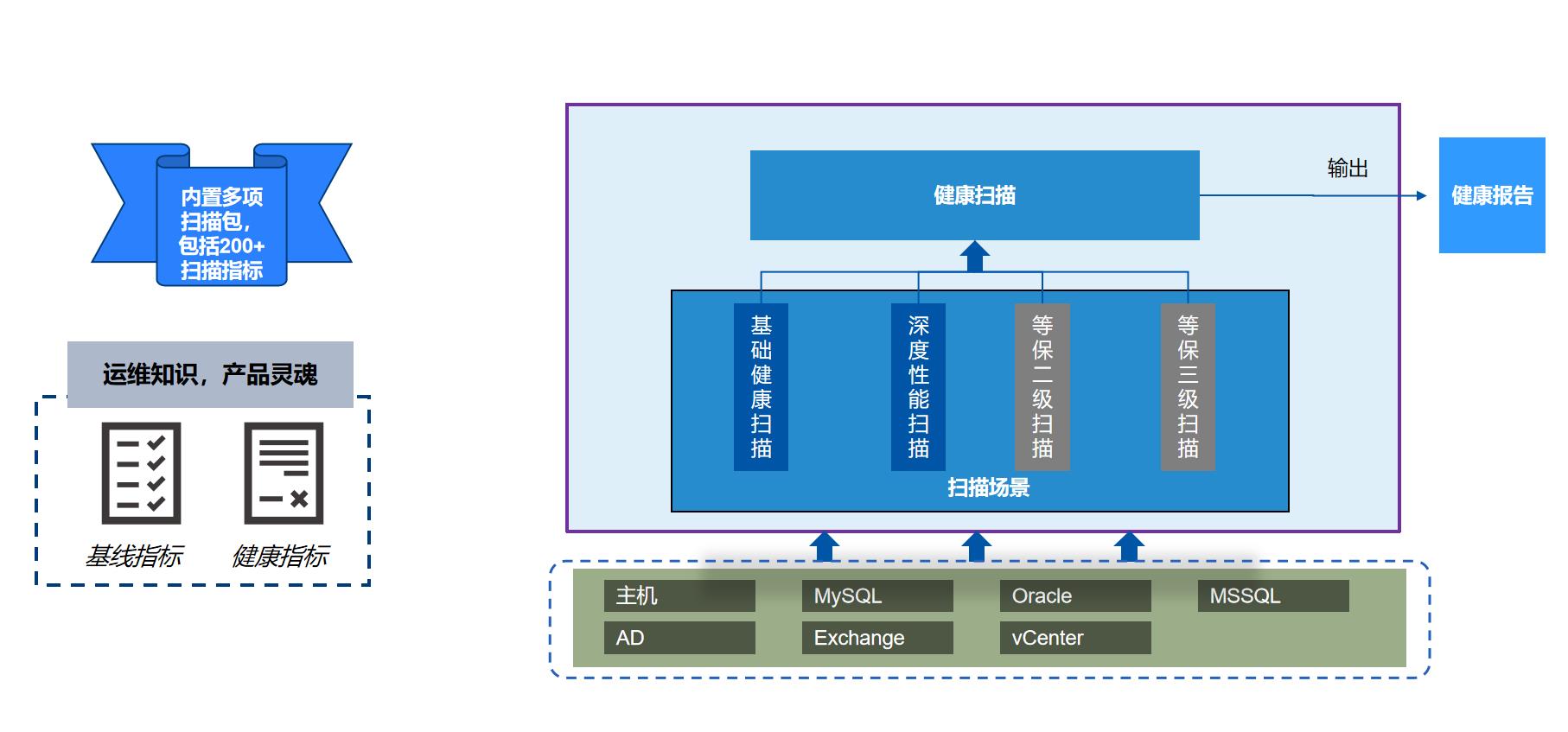

健康扫描:故障预防,消除潜在威胁

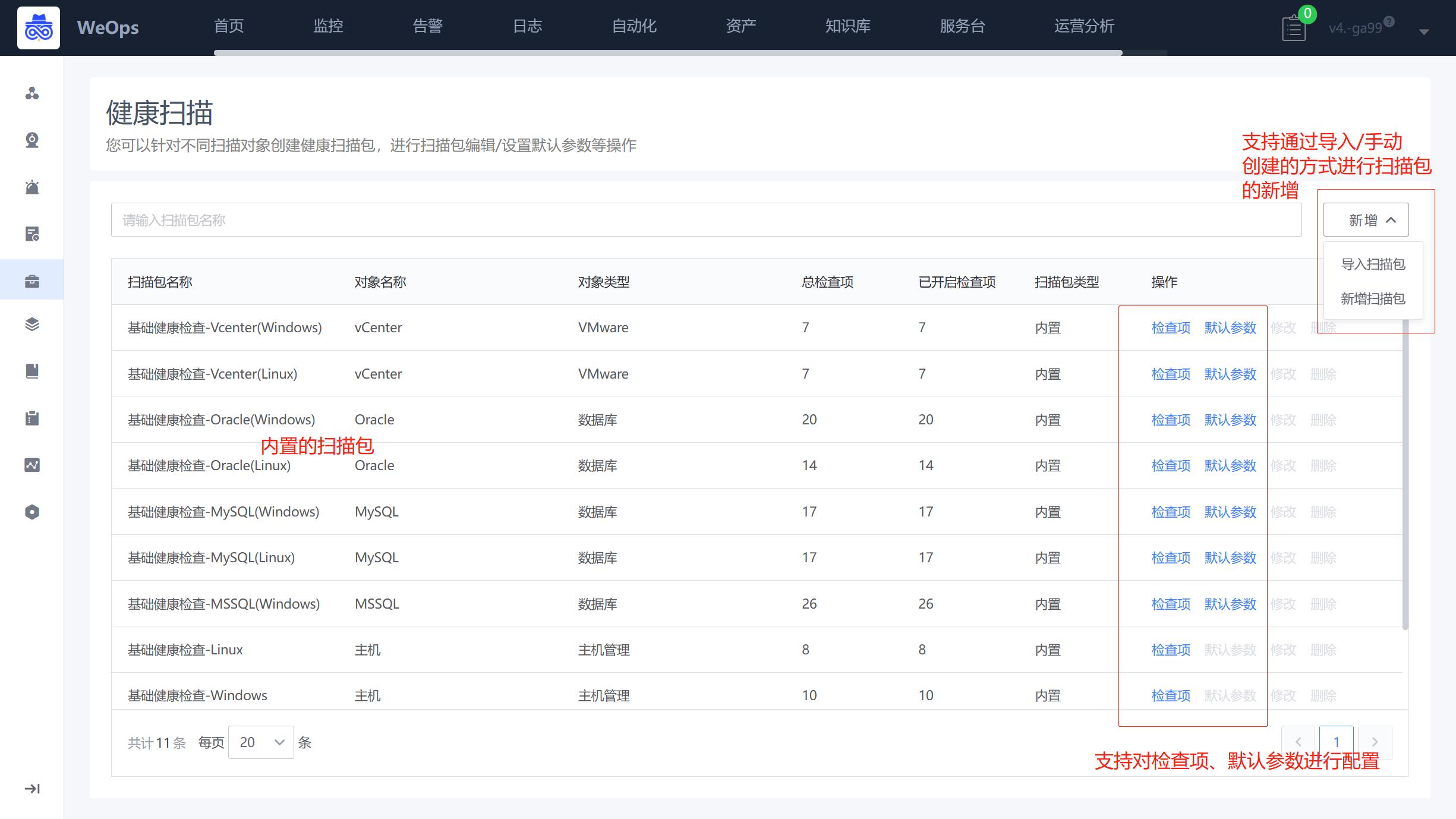

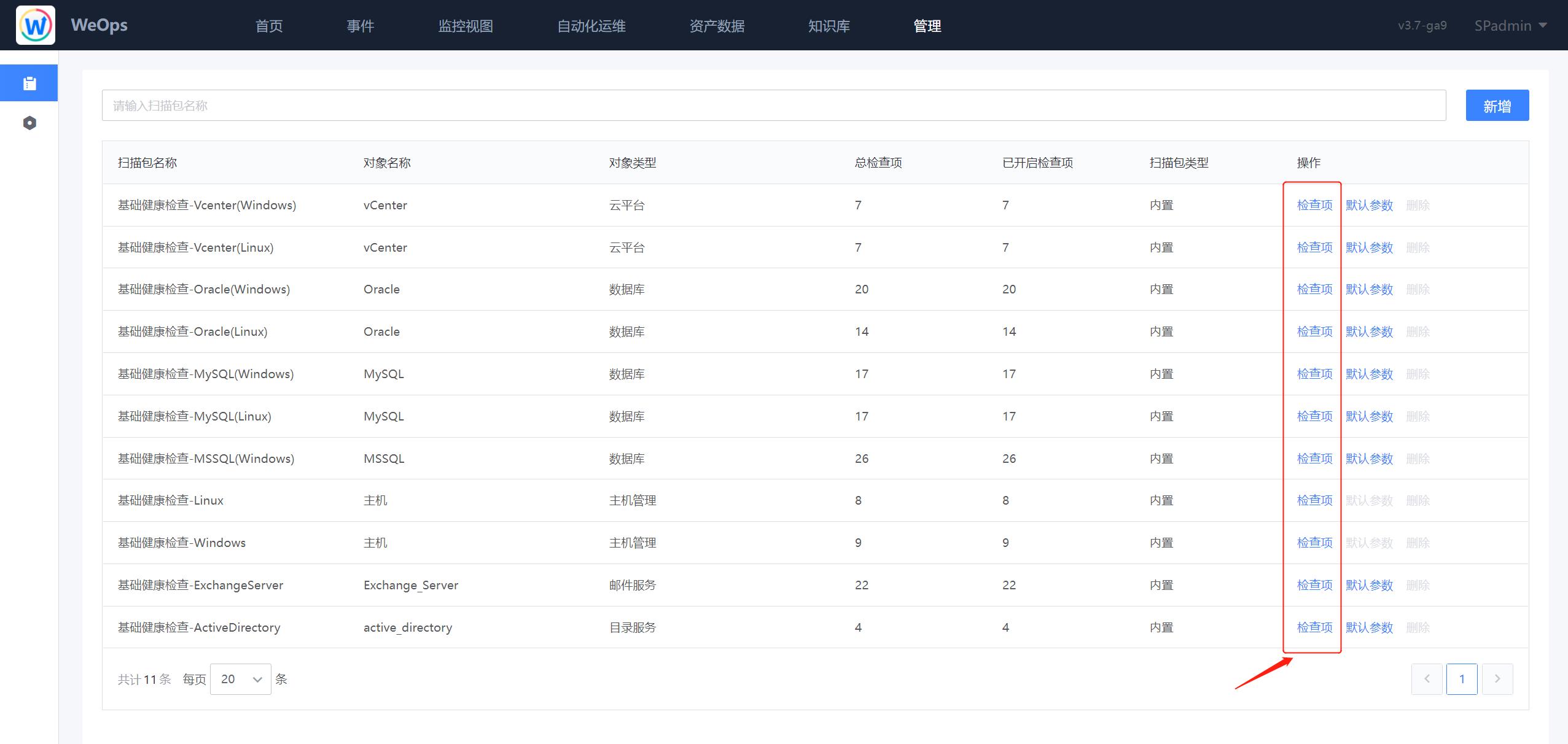

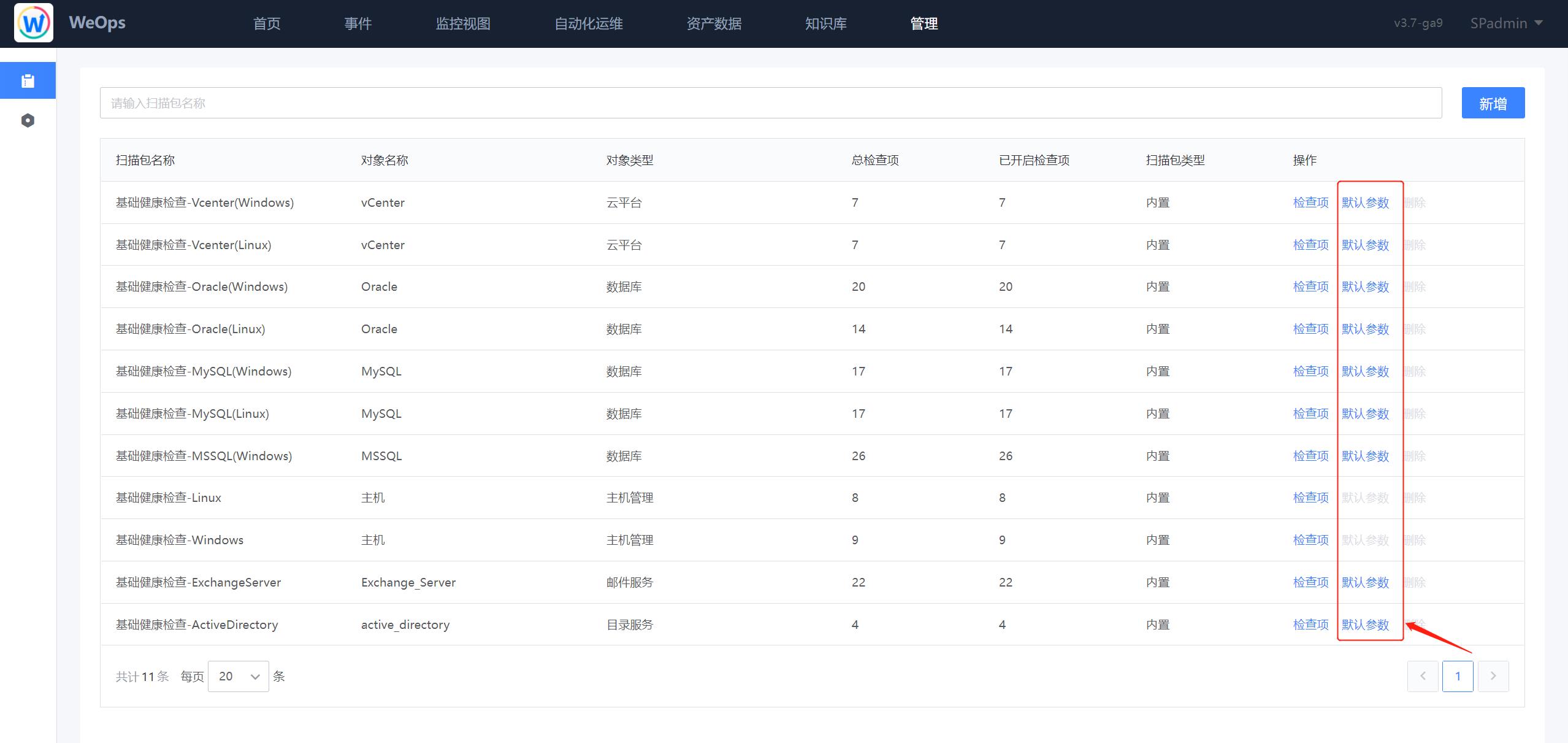

WeOps健康扫描针对各类IT资产提供了专业的巡检指标,全面检查主机、数据库、中间件、云平台等资产健康,并提供相应的改善建议。

- 定时批量扫描,高效巡检

- 专家定制巡检指标,自动生成专业的扫描报告

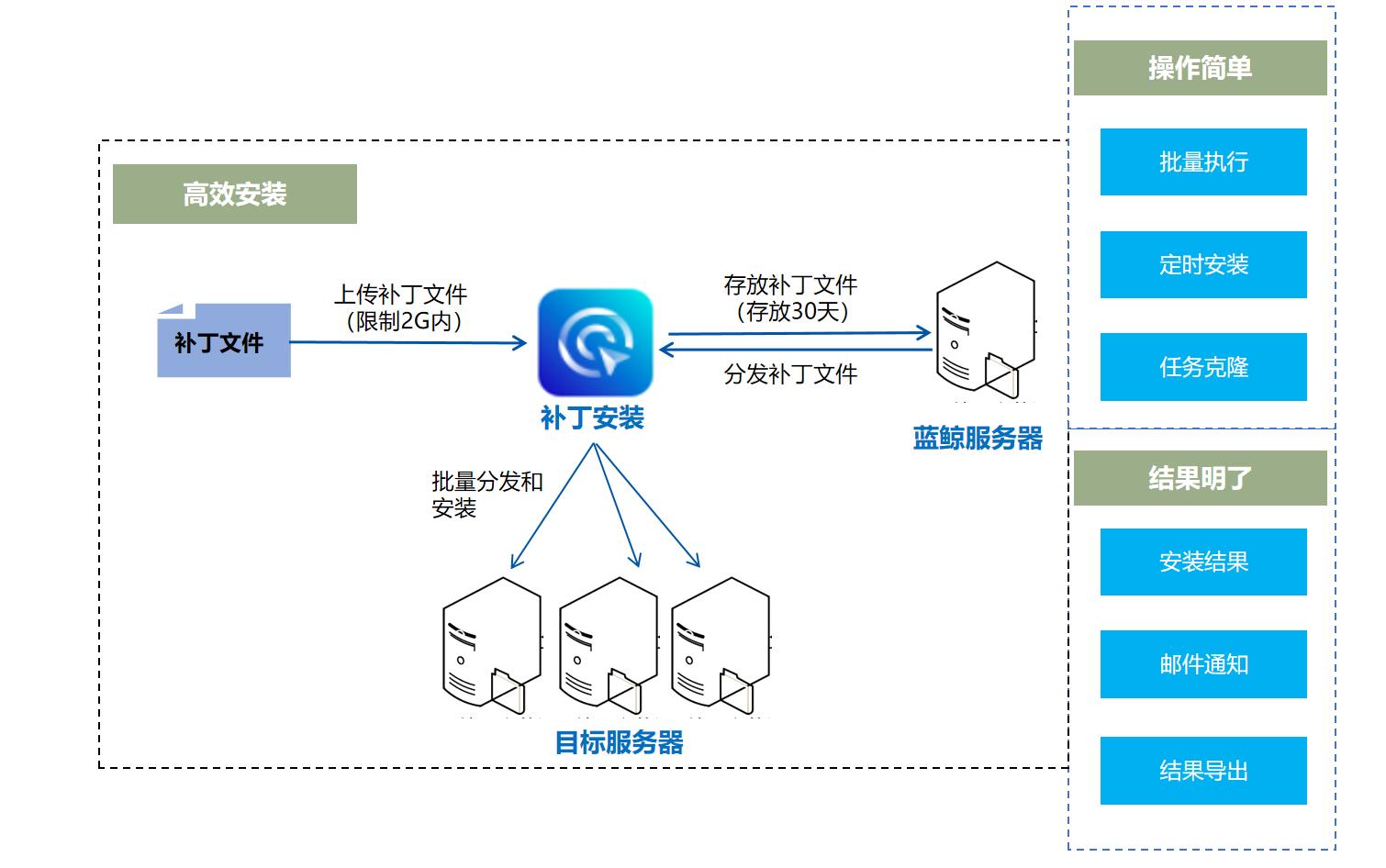

补丁安装:批量安装,省时省力,执行结果一目了然

WeOps补丁安装是省时省力的补丁批量安装工具,工程师不再需要彻夜紧盯,定时自动安装补丁,等待结果通知即可。

- 定时批量自动安装补丁

- 补丁安装成功率高

- 执行结果一目了然

知识库:经验复用让运维工作有迹可循

WeOps知识库和其他模块全方位打通:告警自动匹配解决方案、辅助完成服务工单、快速生成各类运维报告,让工作中沉淀的经验,灵活运用到工作中。

数据大屏:通过可视化展示全局视图

WeOps数据大屏动态汇总全局状态,运维全局一目了然,帮助管理人员直观审视业务运营与IT运维中的有效信息,提升企业IT管理的效能。

- 动态展现业务运行状况

- 持续增加场景化的精美大屏

产品优势

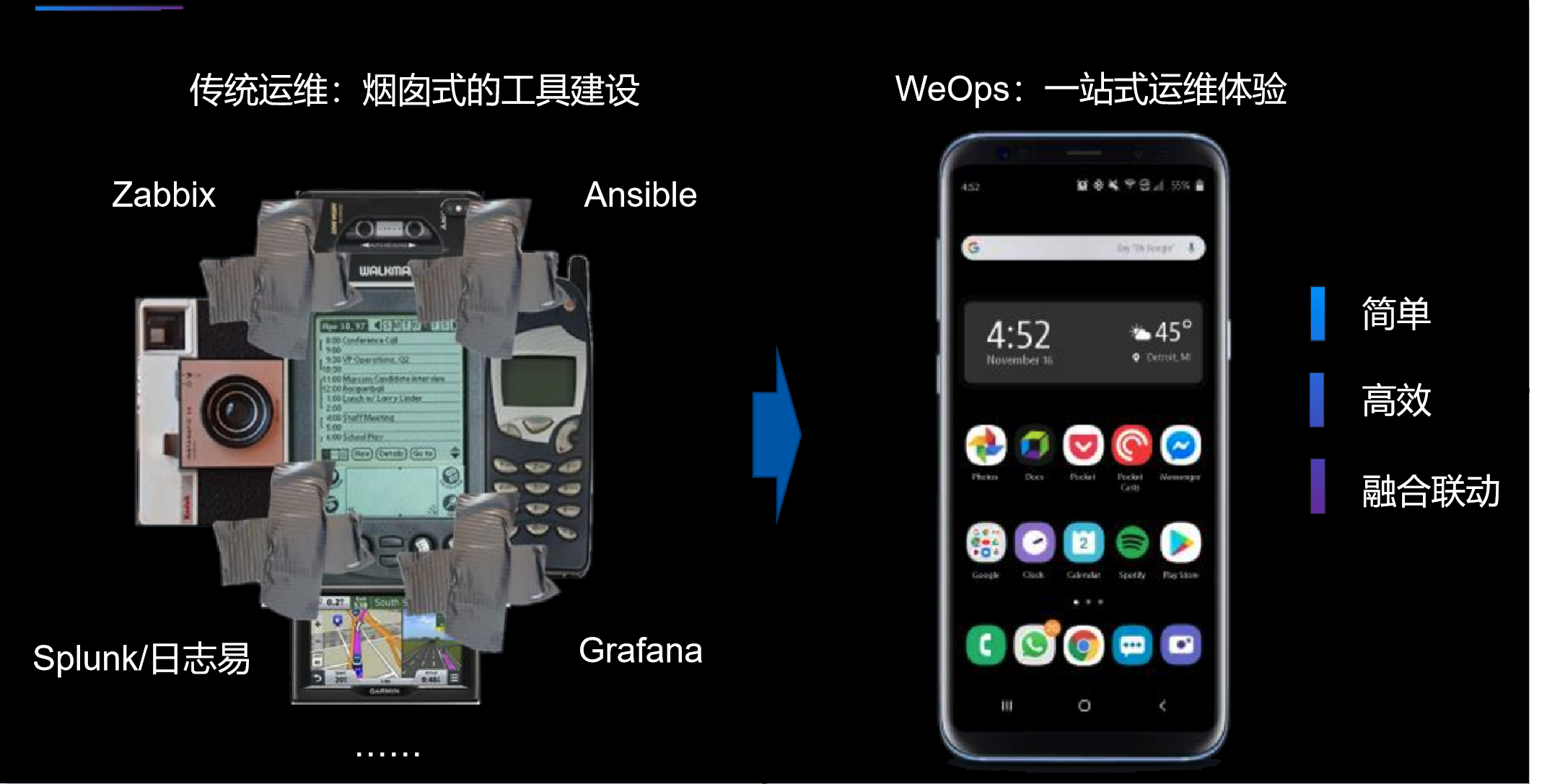

一站式运维体验

- 基于蓝鲸一体化平台构建,数据无缝对接,消除信息孤岛,统一访问入口,一站式使用各项运维模块,无需频繁切换。

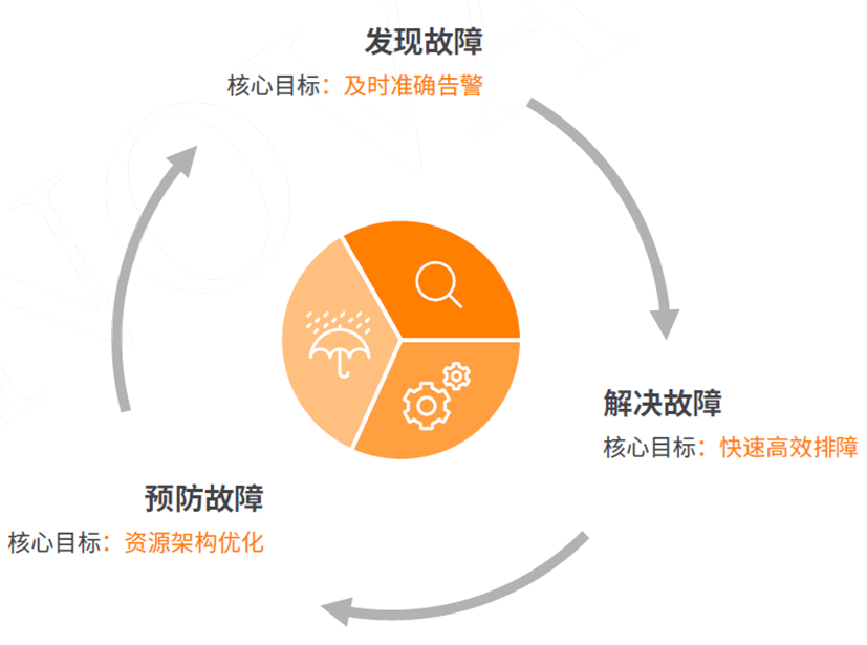

构建故障全生命周期管理能力

- 围绕业务系统故障全生命周期管理,通过资源纳管、健康扫描、监控告警、数据大屏、运维工具之间的场景联动,贯穿“预防故障”、“发现故障”、“解决故障”的全过程,帮助IT构建故障全生命周期能力,实现主动运维。

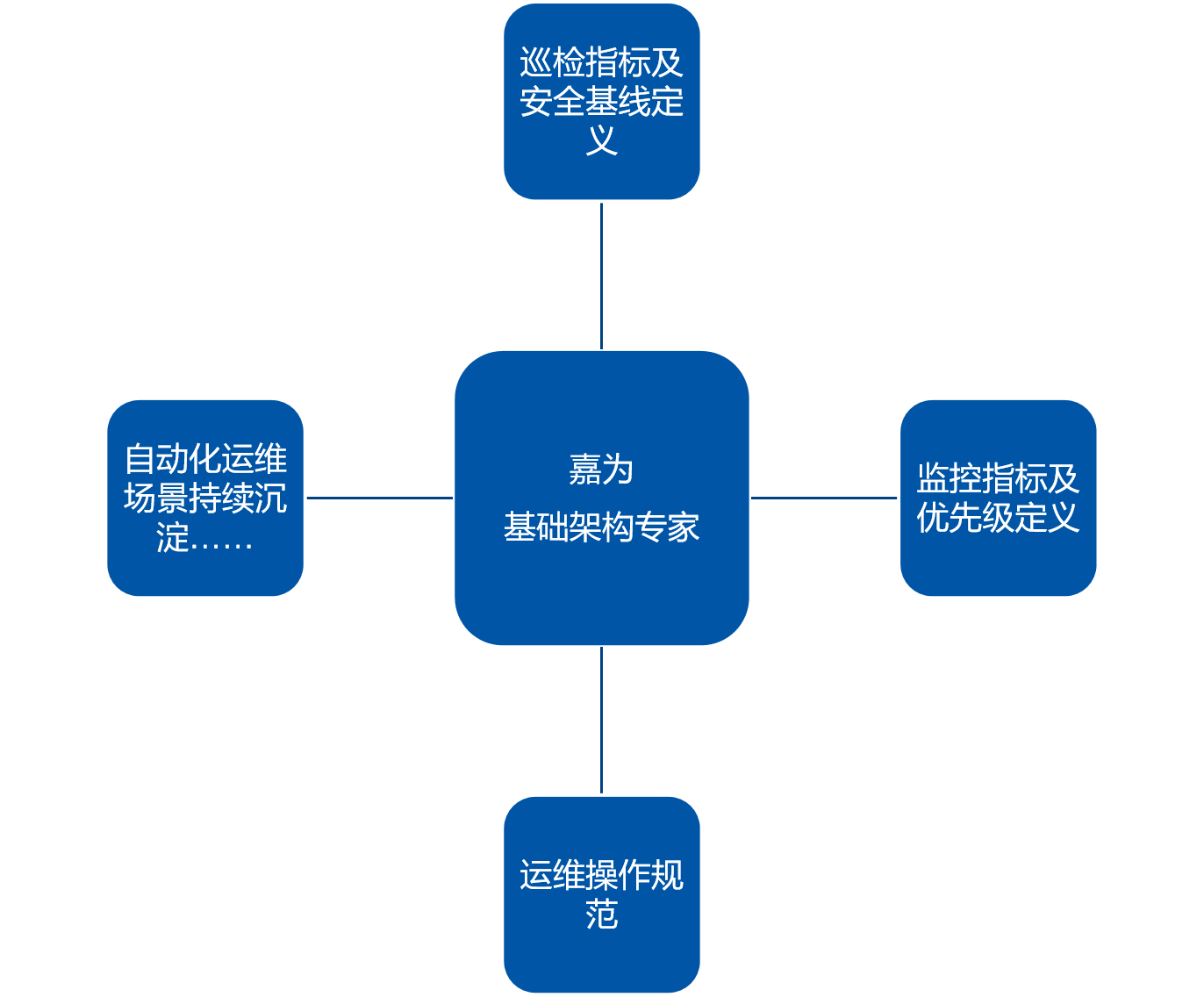

内置海量知识

- 基于嘉为20年超过200位运维专家知识沉淀打造,助力运维最佳实践的落地。

- 内置丰富的“指标库”、“脚本库”和“知识库”,提供通用资源模型及关联关系拓扑、通用基线指标以及告警最佳实践方案。

术语解释

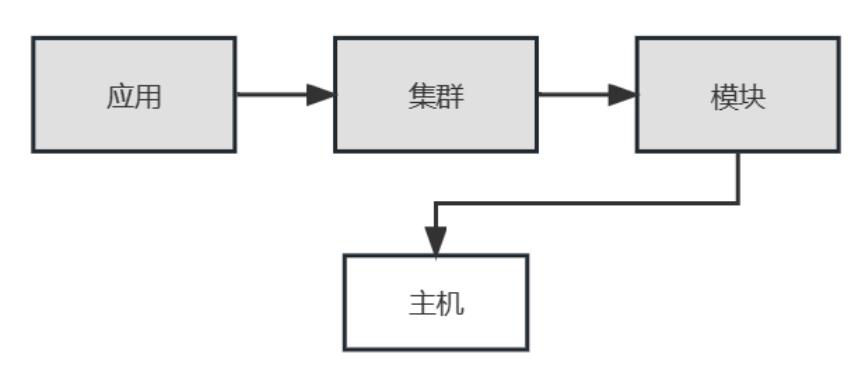

- 应用:指WeOps中纳管的业务系统,在传统企业中称为“应用系统”。

- 集群:用于区分一个业务的不同环境,或者同一个环境的多个部署区域。常见定义有,按照环境类型区分:正式集群、测试集群。按照区域区分:华东区、华北区。

- 模块:模块是业务拓扑管理的最小单位,通常用于标识一组固化的进程集合,例如 DB、DR、Login、Web 等。

- 空闲机:通过资源池分配到业务,默认放到空闲机模块中,在空闲机模块下即被定义为没有被设计资源。

- 实例:也称为配置实例,WeOps每条有意义的记录主体都是一个配置实例,例如一个交换机、一个主机等

- 模型:模型是对同类配置实例进行标准格式的定义,例如主机和机房有不同的配置记录需要:主机需要包含固资编号,机房需要包含运营商信息,可以定义主机、机房两个模型,以保证相关配置录入 的时候必须包含所需信息。除了属性列表以外,模型还能够定义唯一性校验、可关联性等。

- 关联关系:模型关联关系的分类,如主机与交换机、路由之间的关系可以分类为“上联”类型,软件与主机之间的关系是 “运行” 等。

- 监控指标:一般称为 Metric(s)、Item 或度量,即监控的内容,一般是坐标系中的纵坐标,比如 CPU 使用率、在线人数等

- 维度:一般称为 Dimension,区分指标的条件,比如 IP、主机名或平台(IOS、Andriod)

- 拨测节点:拨测发起的节点,就是要设置探测的源头,多个不同的位置节点检测同一个目标更能体现服务在地域上面的可用性。

- 活动告警:监控产品检测到的所有未恢复且未关闭的告警。

- 历史告警:已经恢复的告警事件。

- 告警级别:告警分为三个级别:“致命” Emergency 最严重,核心指标出现严重问题,将影响业务的稳定性,需要重点关注,红色;“预警” Critical 一般严重,需要关注,可能会导致更加严重的问题,橙色;“提醒”Warning 提示作用,需要了解,出现了问题的苗头,黄色

- 服务:服务场景的最小单元,具体提供服务的实体对象

- 服务目录:以目录列表形式,向外提供服务

- 流程:由处理人与处理节点,以及处理规则共同组成,以实现特定服务需求的功能

- 节点:流程中涉及到的每个具体步骤,或环节,或活动

- 知识库:面向用户或管理员的知识库,按类别及全文检索管理知识库

功能介绍

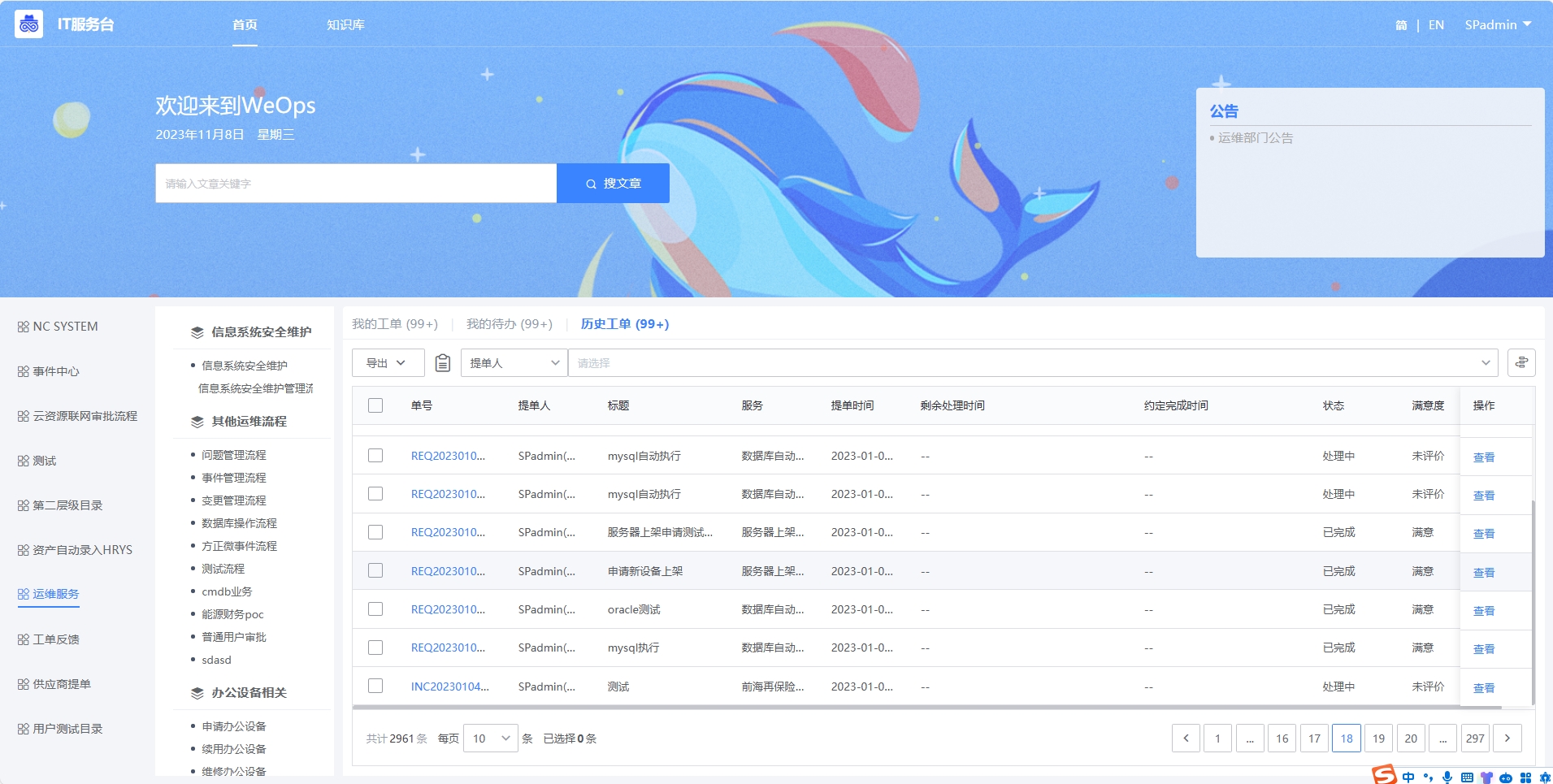

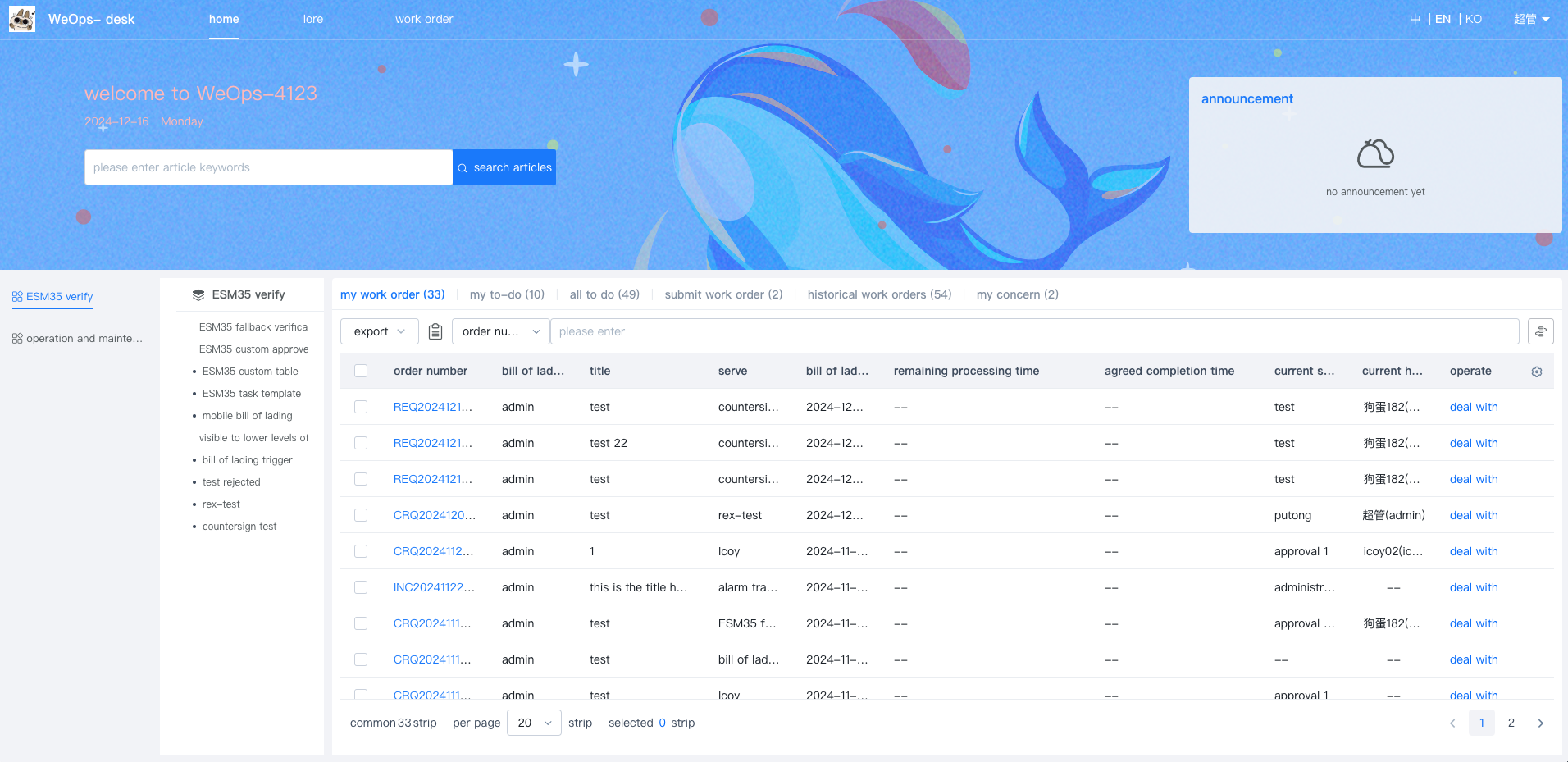

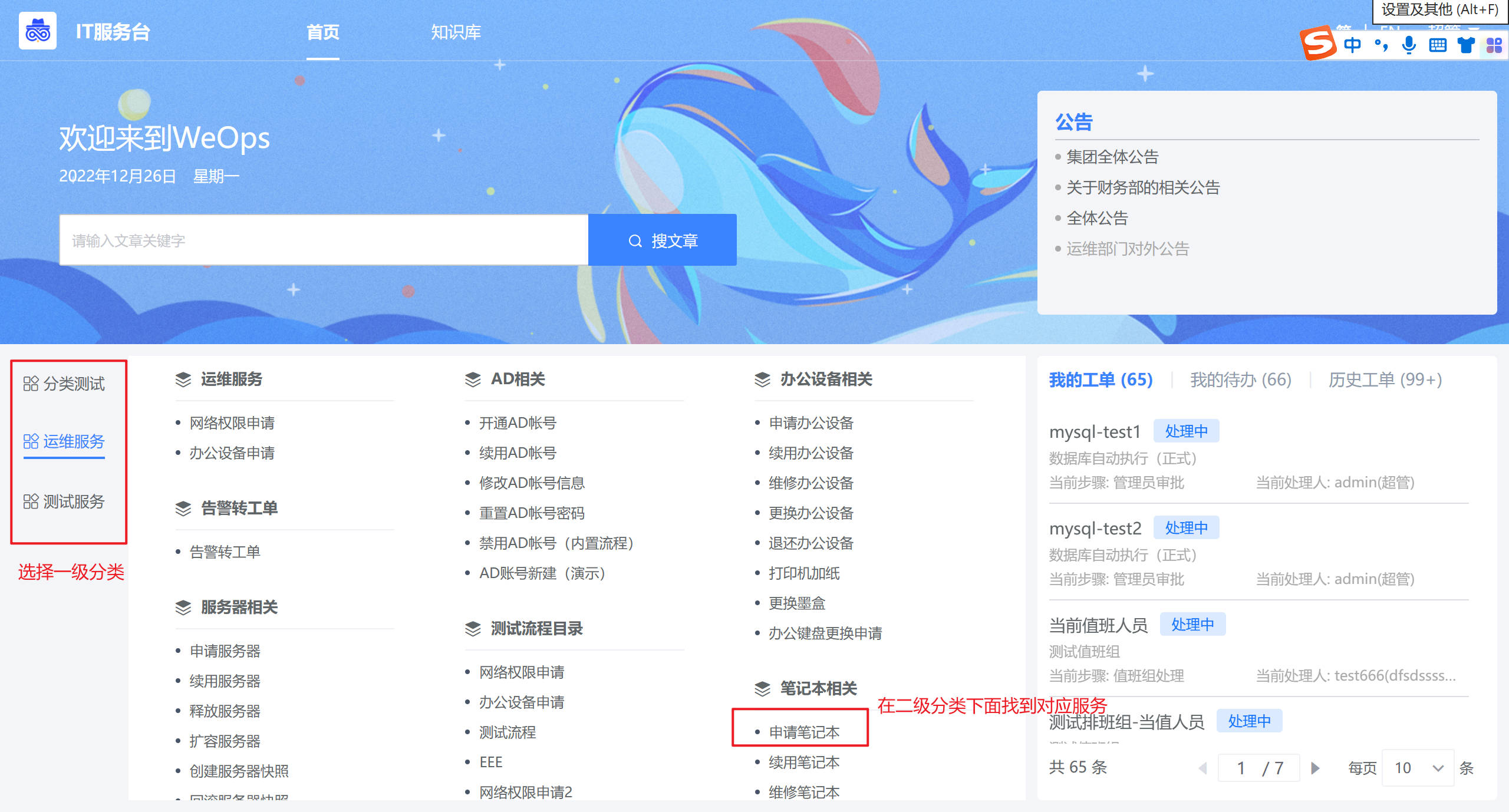

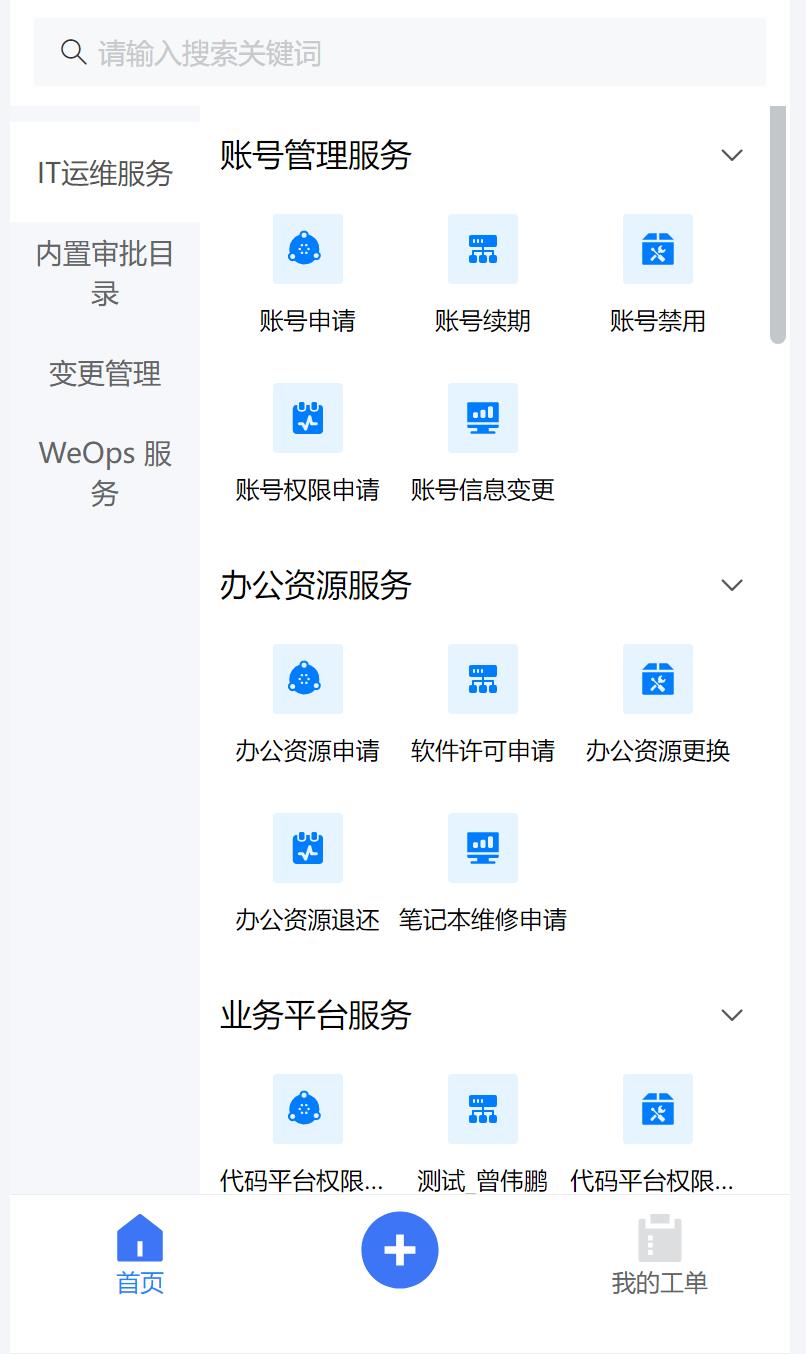

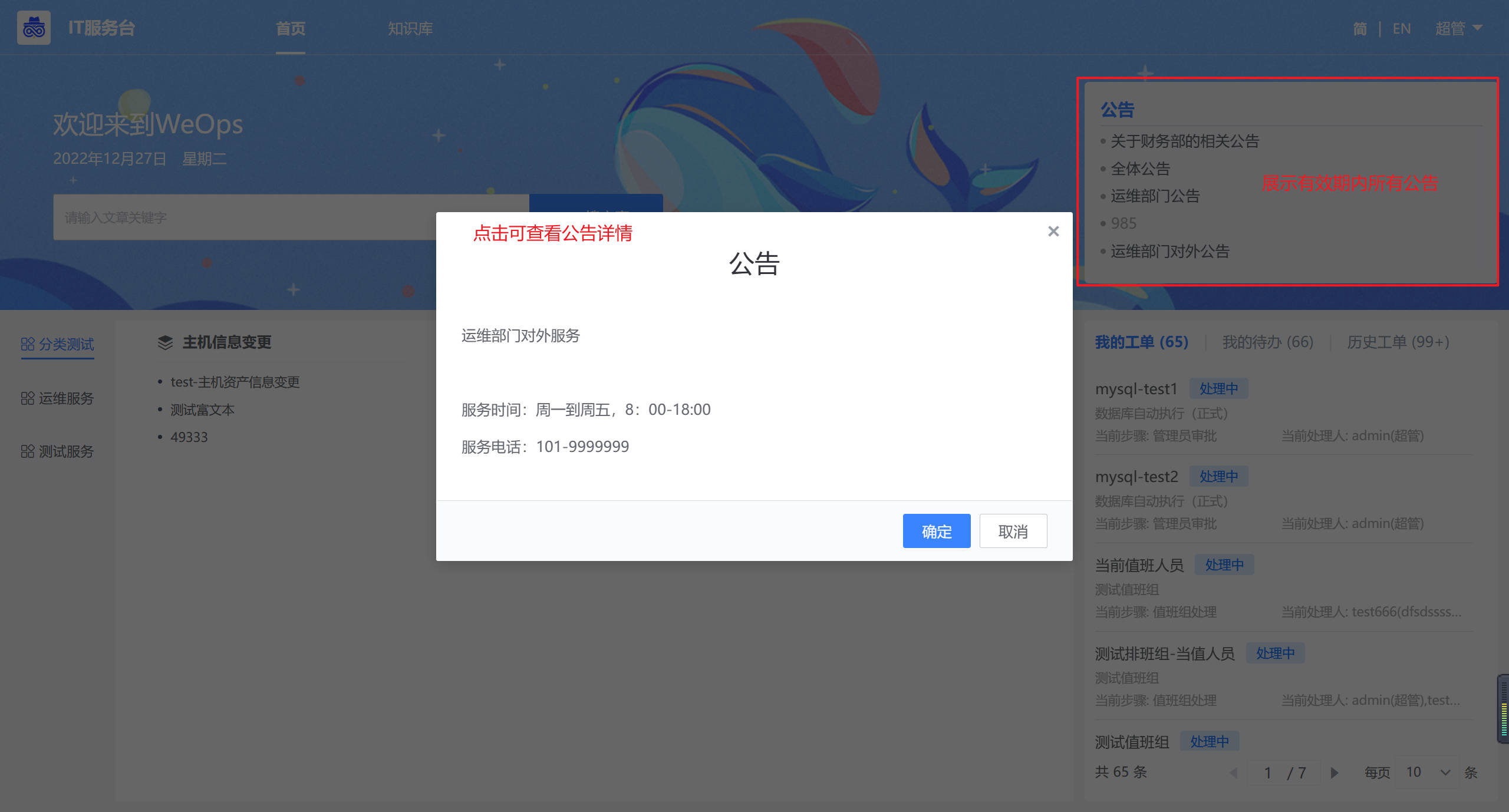

IT服务台门户

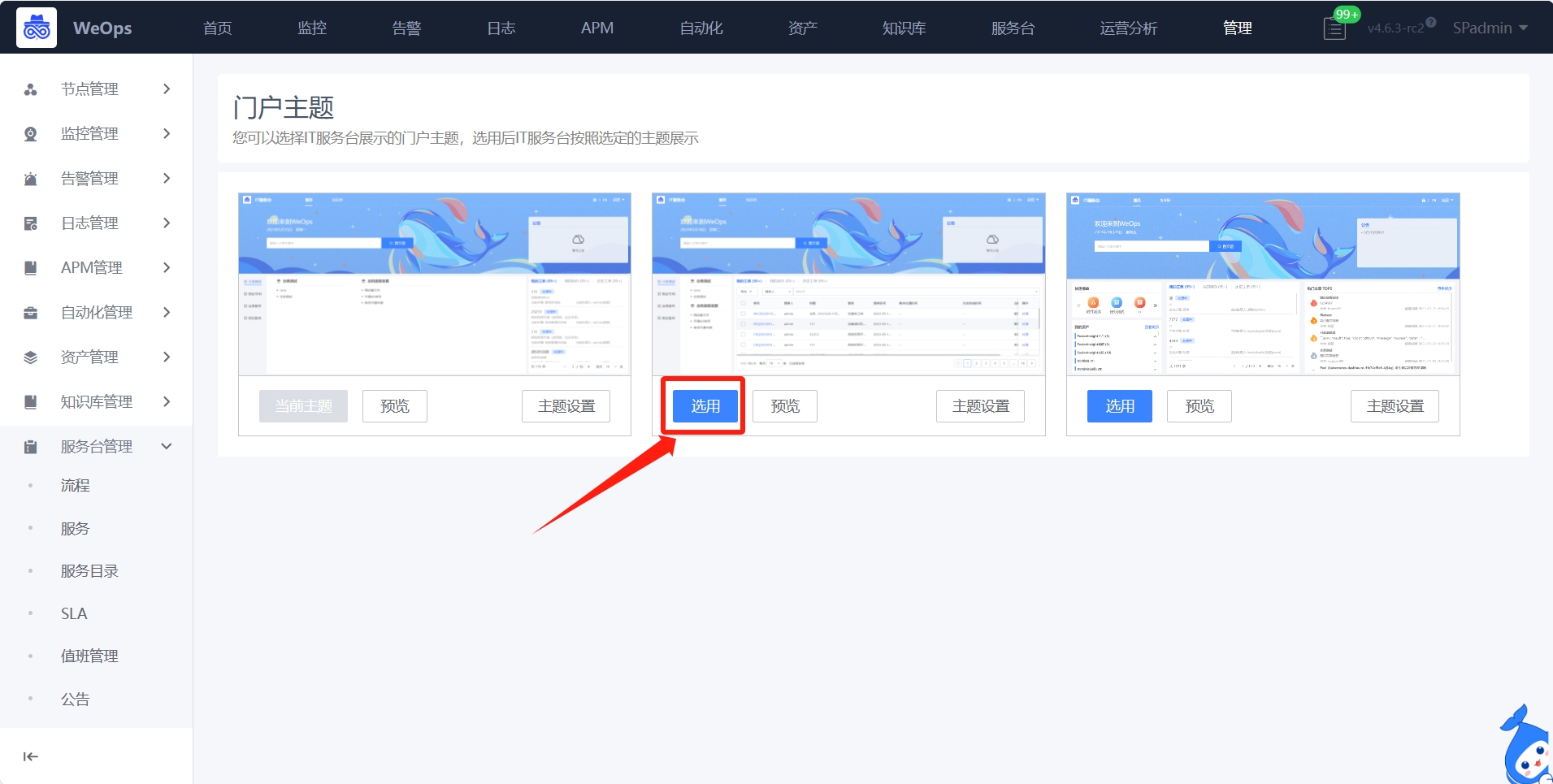

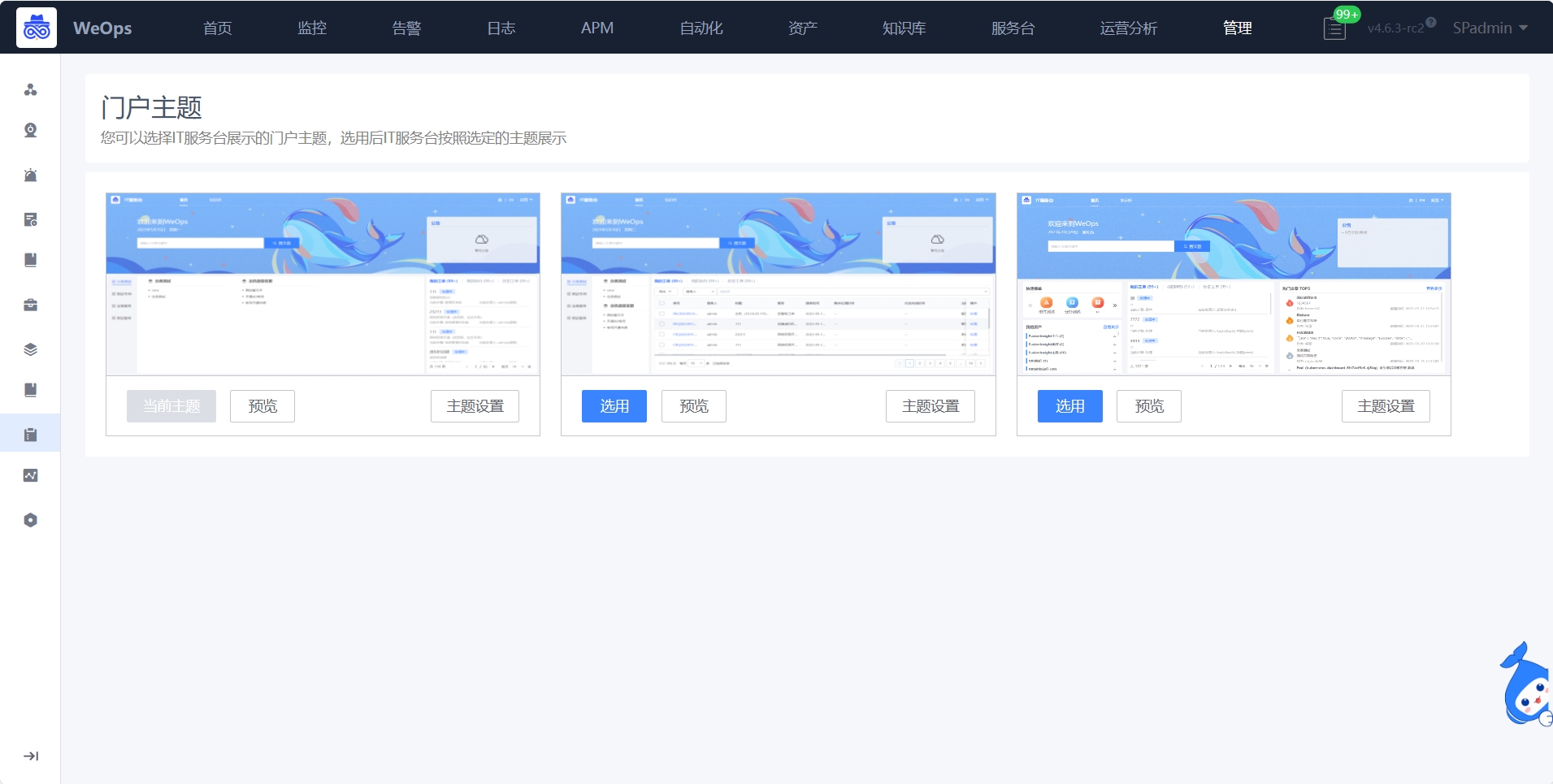

Weops 内置三类IT服务台门户可供选择适用,每个门户主要包括首页(提单+工单管理)、知识库(文章搜索和查看)等功能

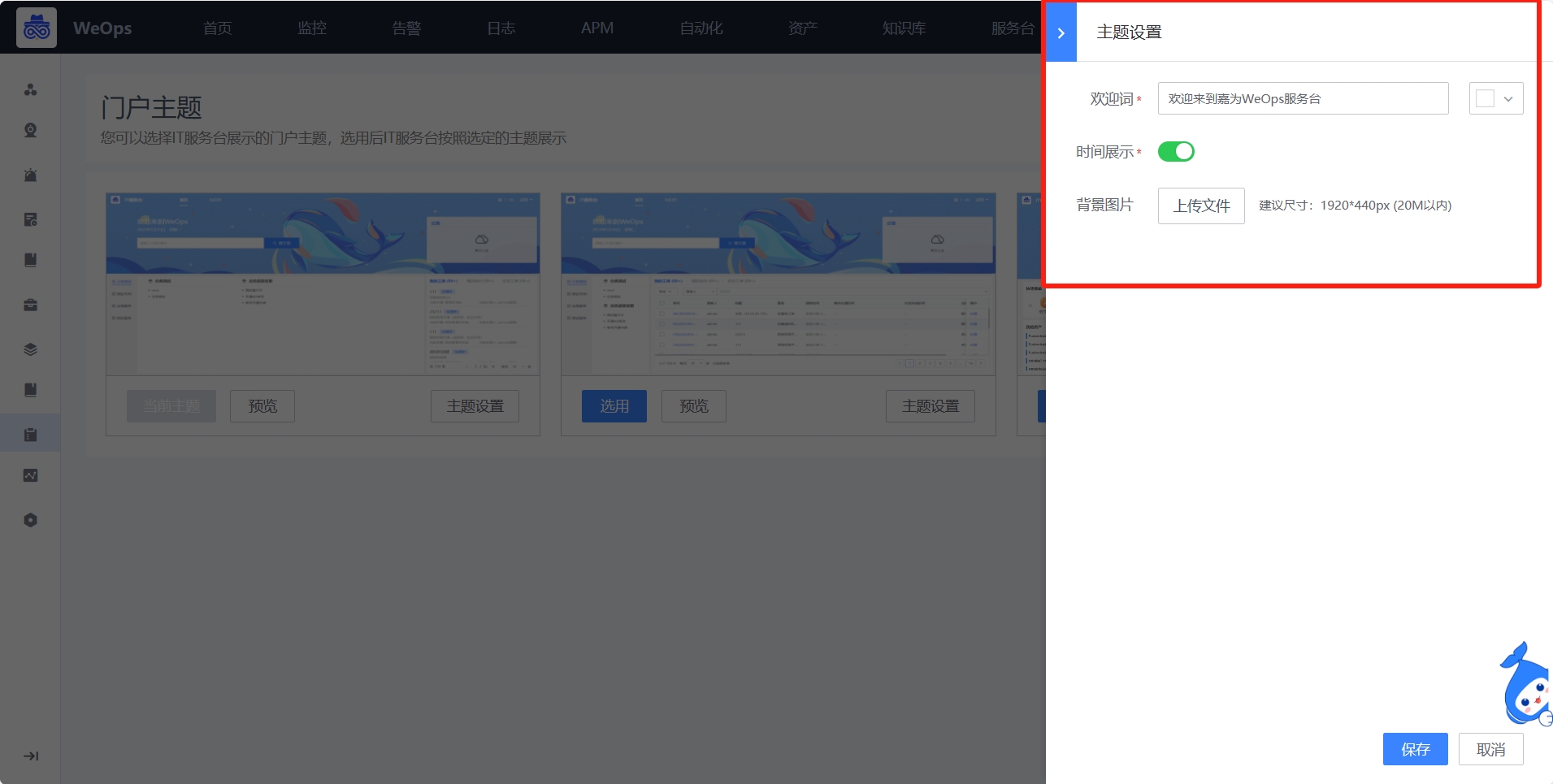

门户的切换和主题背景图片的替换,可以在WeOps后台进行

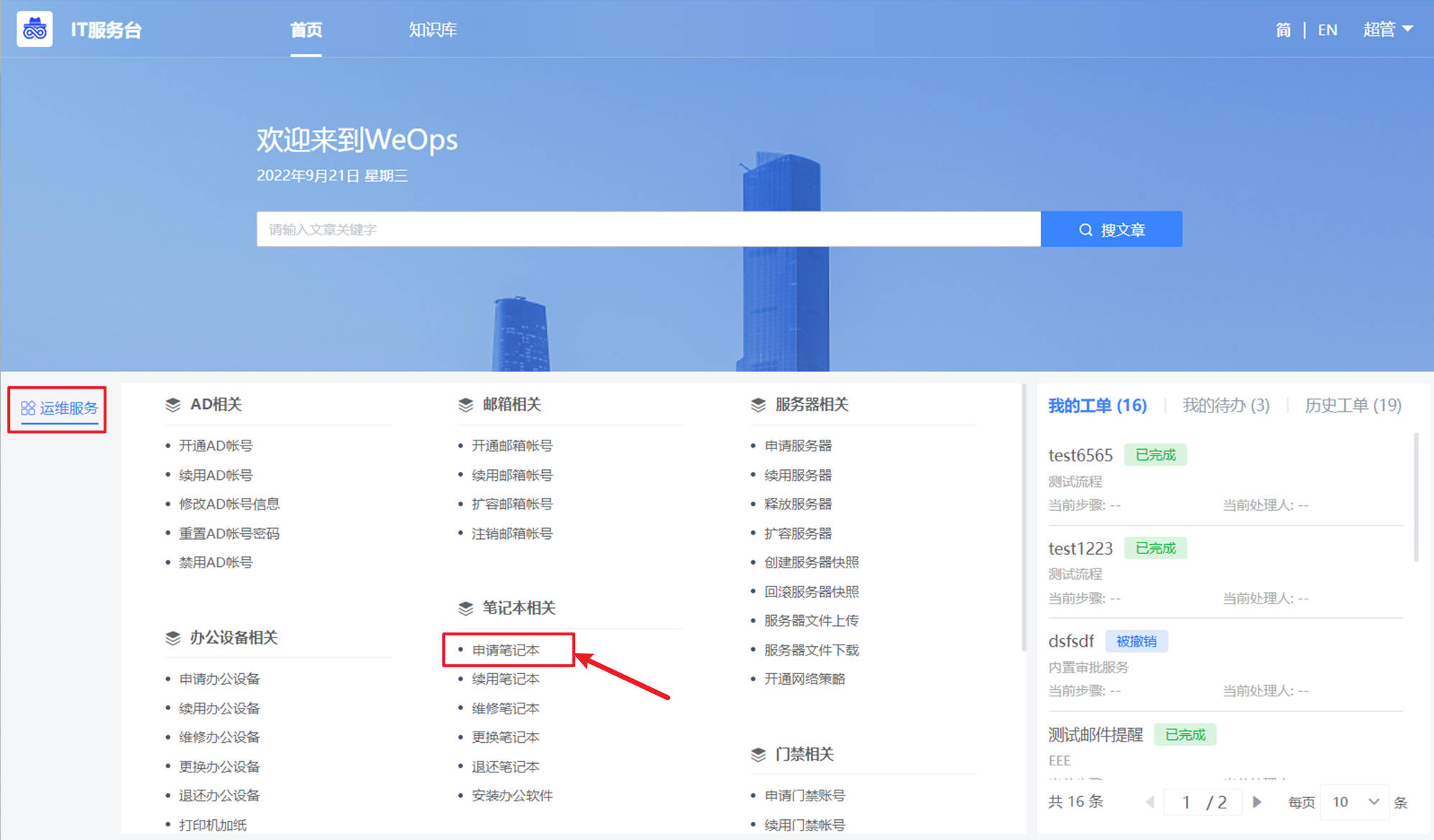

这里以其中一个门户介绍IT服务台具体的功能,服务台包括首页和知识库两大模块

首页

- 目前IT服务台已支持页面级别的中英自动翻译,包括PC端和移动端

- IT服务台支持中文和英文两种语言模式,首页主要包括以下三大部分:文章快速搜索、快速提单、工单明细

- 文章快速搜索:可在搜索框输入文章关键词,服务台知识文章进行搜索

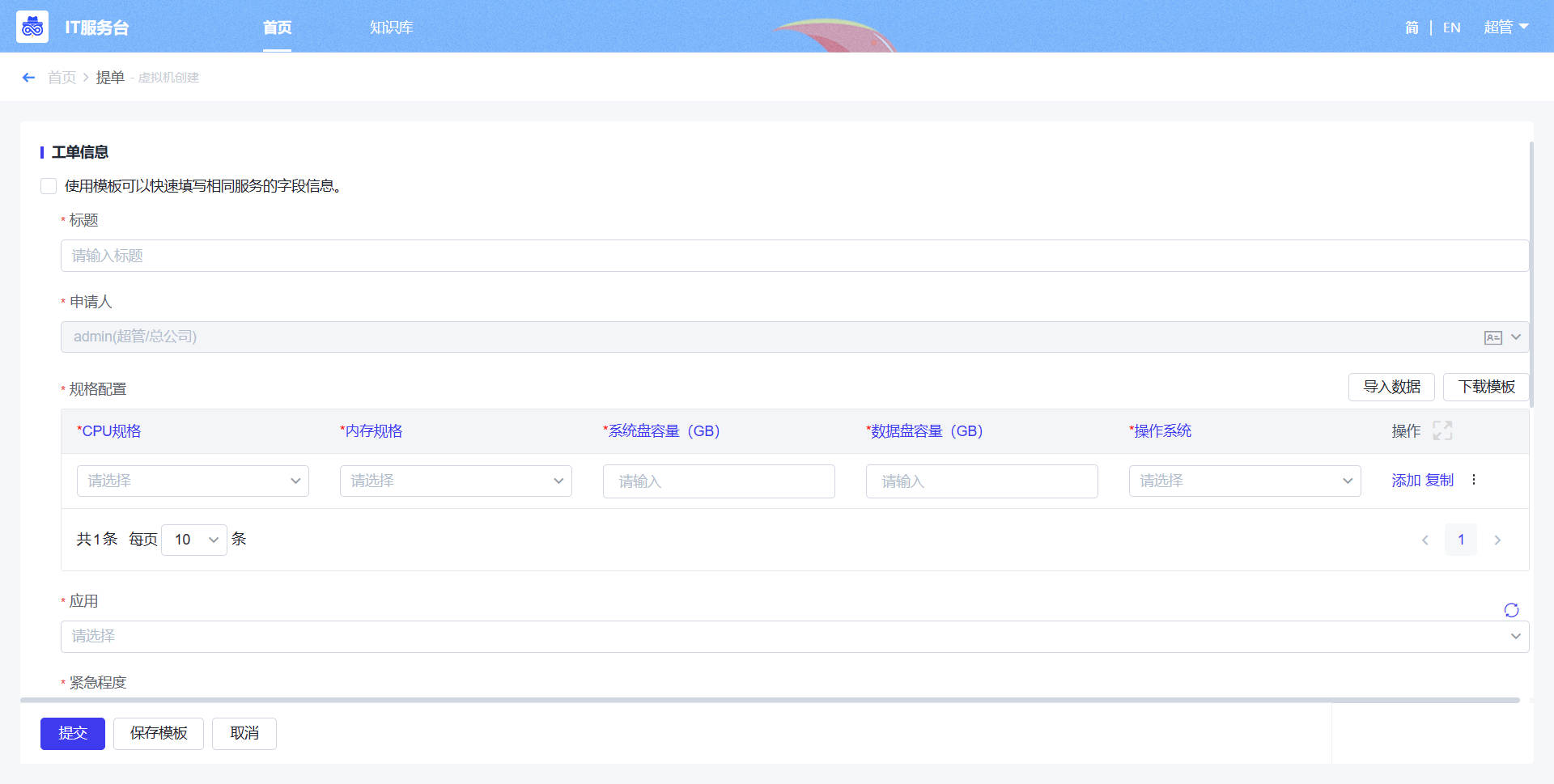

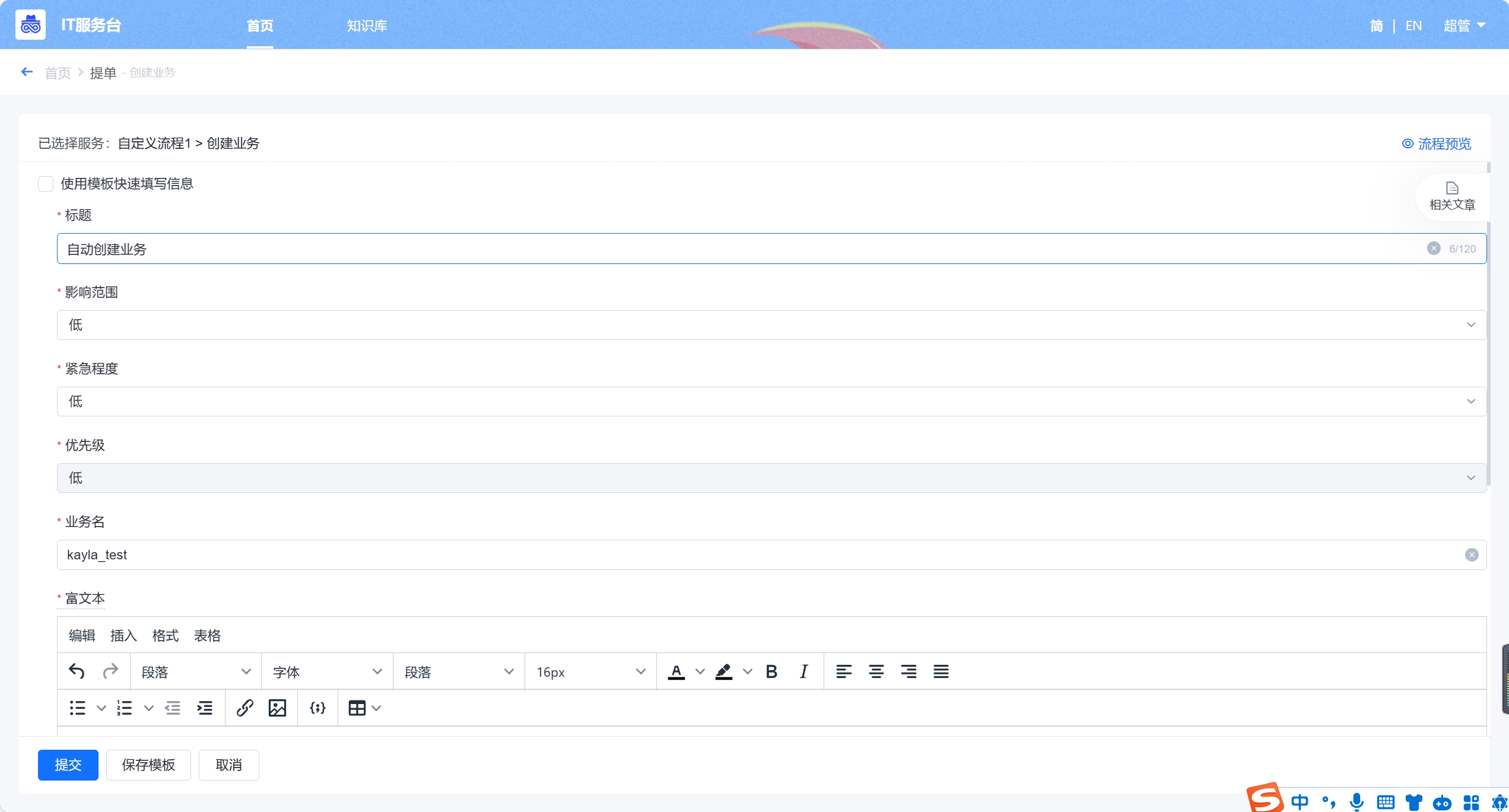

- 快速提单:根据WeOps后台设置的服务目录展示服务流程的不同分类,可以根据分类进行选择流程,点击流程即可进行提单(这里以“申请笔记本”为例,展示提单界面。)

- 工单明细:展示不同状态下的工单,工单列表具体包括:我的工单、我的待办和历史工单

- “我的工单”:展示所有“我”提交的工单,展示流程名称、当前步骤和当前处理人信息以及各个工单的状态

- “我的待办”:展示所有需要“我”审批的工单,展示流程名称、当前步骤和工单创建人信息

- “历史工单”:展示与我有关的所有工单,展示流程名称、工单创建人、工单创建时间信息以及各个工单的状态

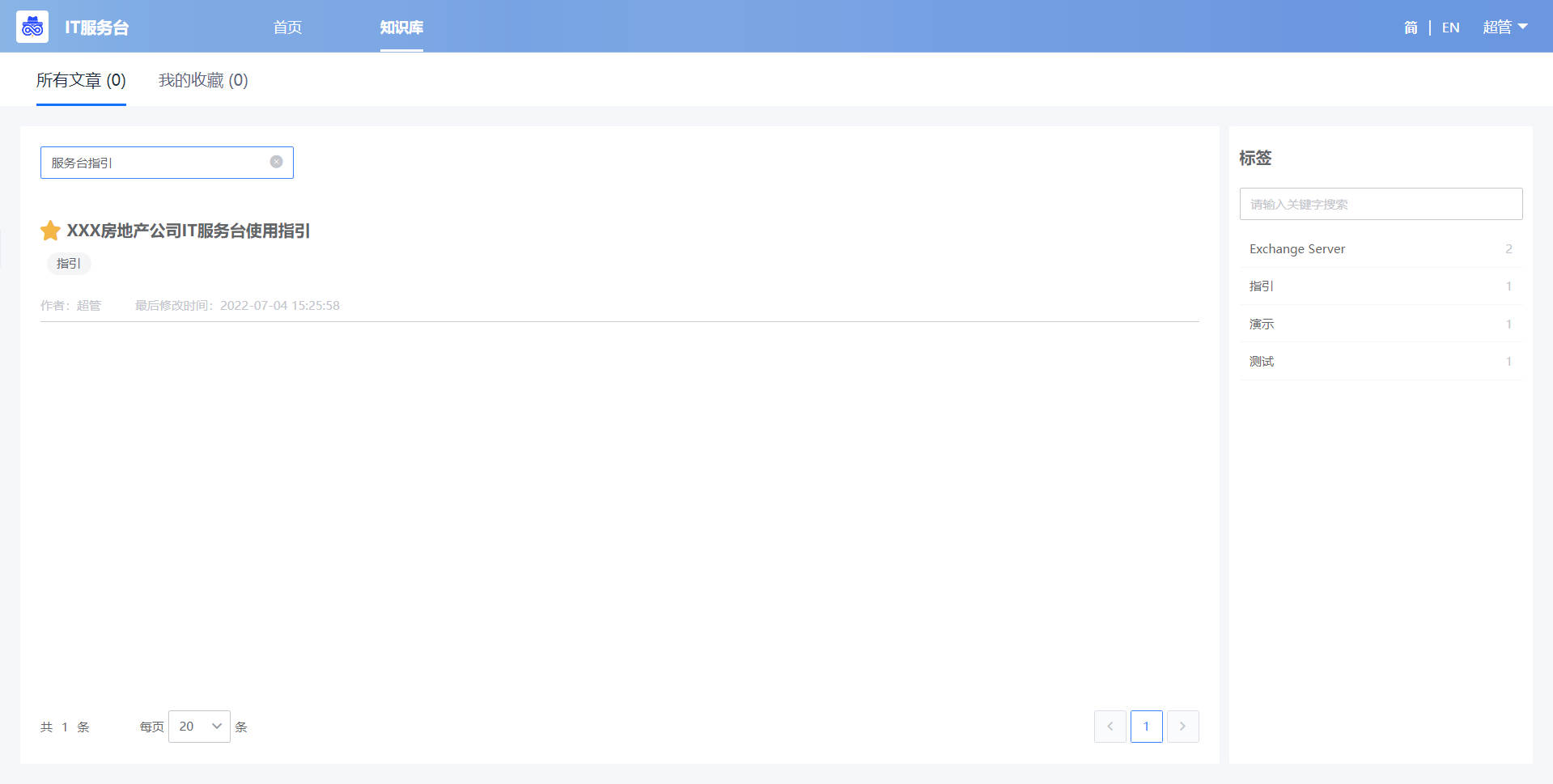

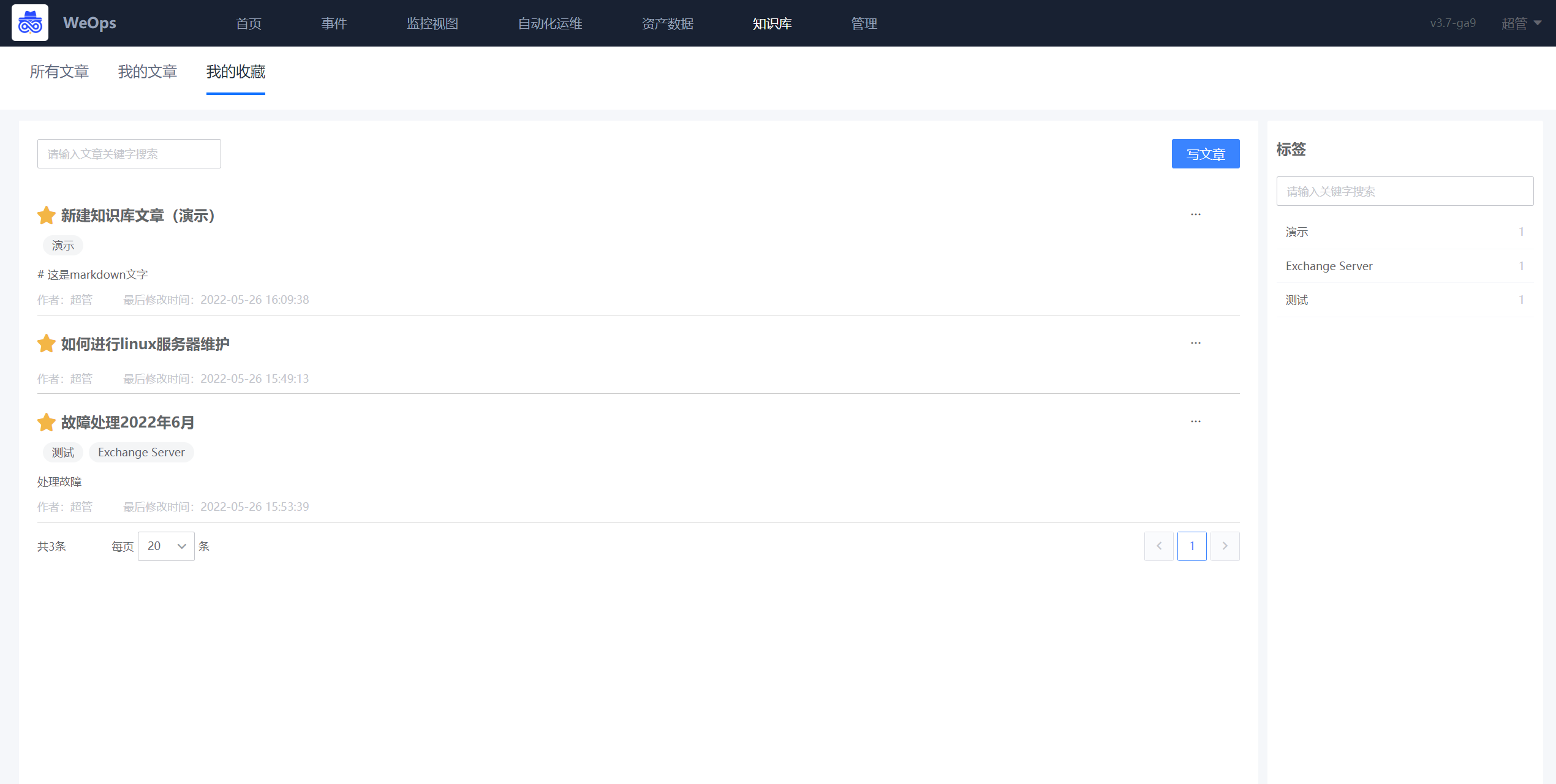

知识库

“IT服务台-知识库”展示了所有设置为“服务台文章”的文章(可在“WeOps-知识库”进行设置), 分为“所有文章”和“我的收藏”

- 所有文章:展示了在“WeOps-知识库”知识库标记的所有服务台文章,可以点击查看详情。

- 我的收藏:展示了我收藏的文章。

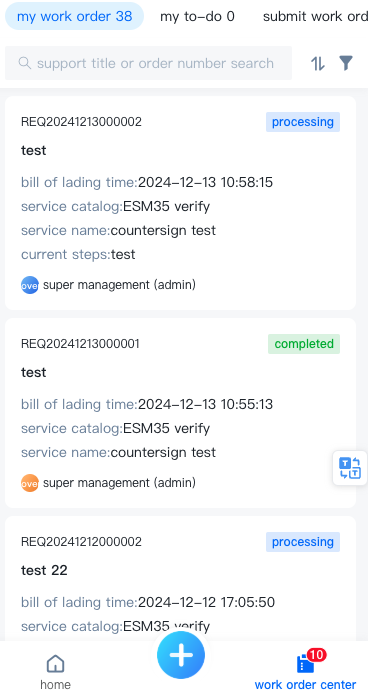

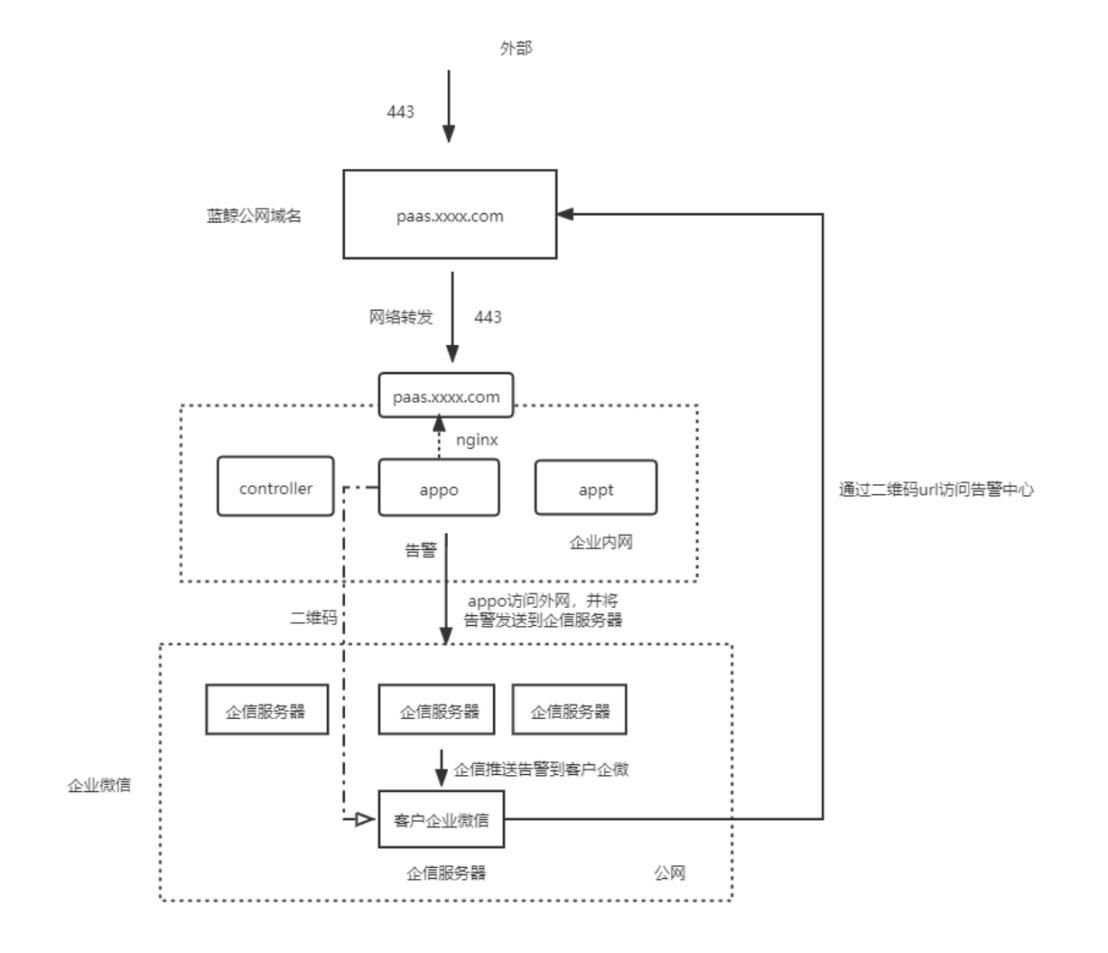

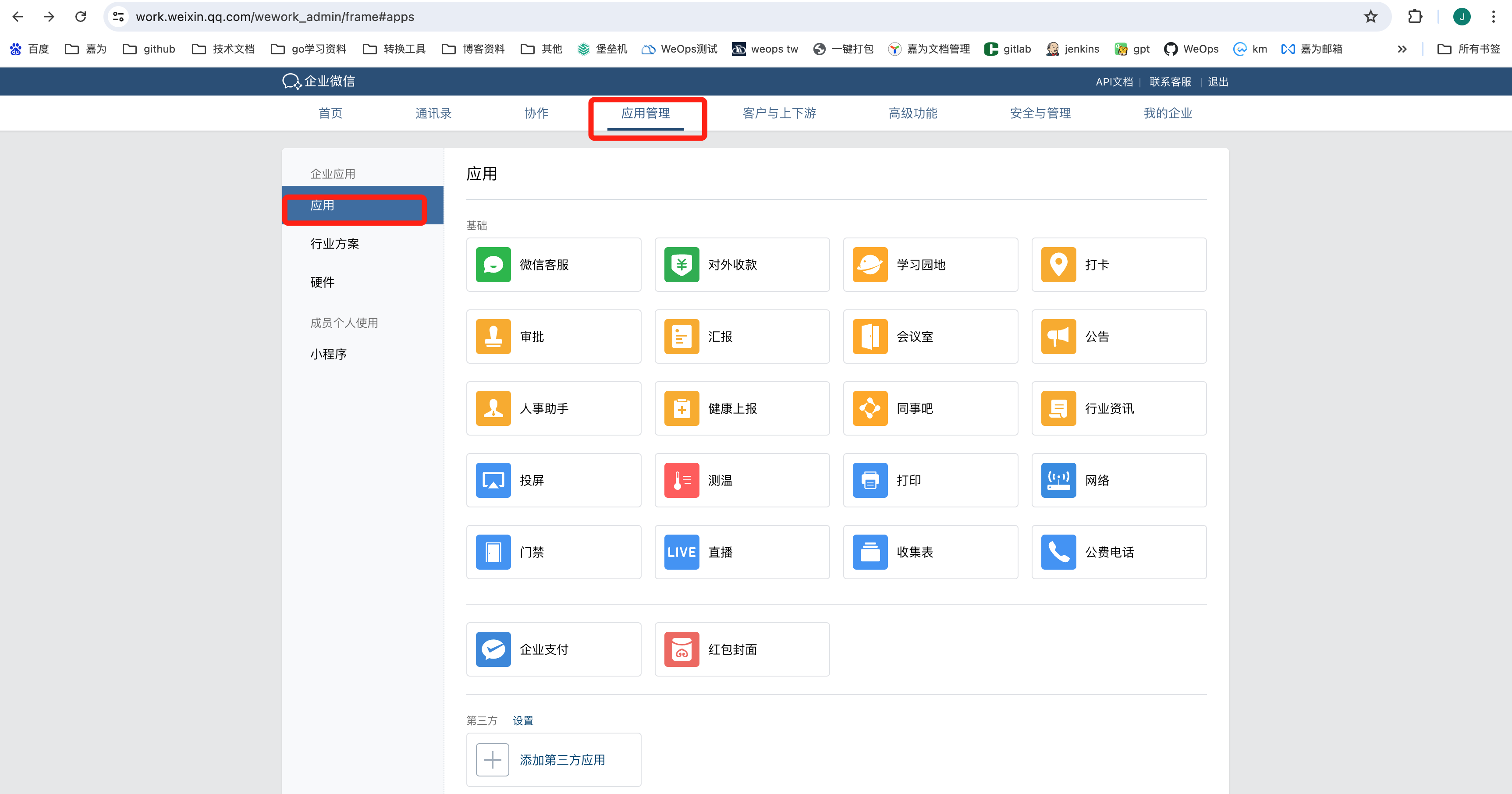

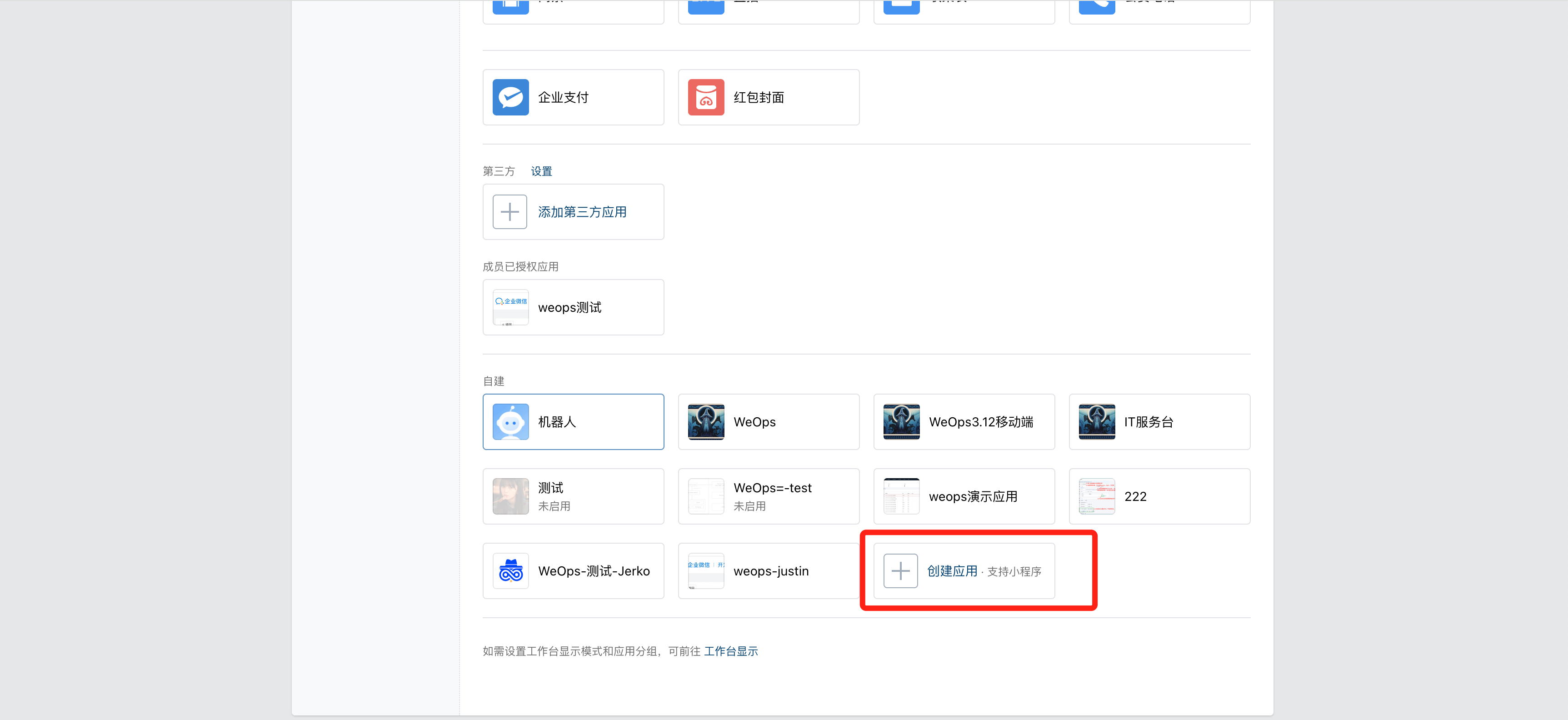

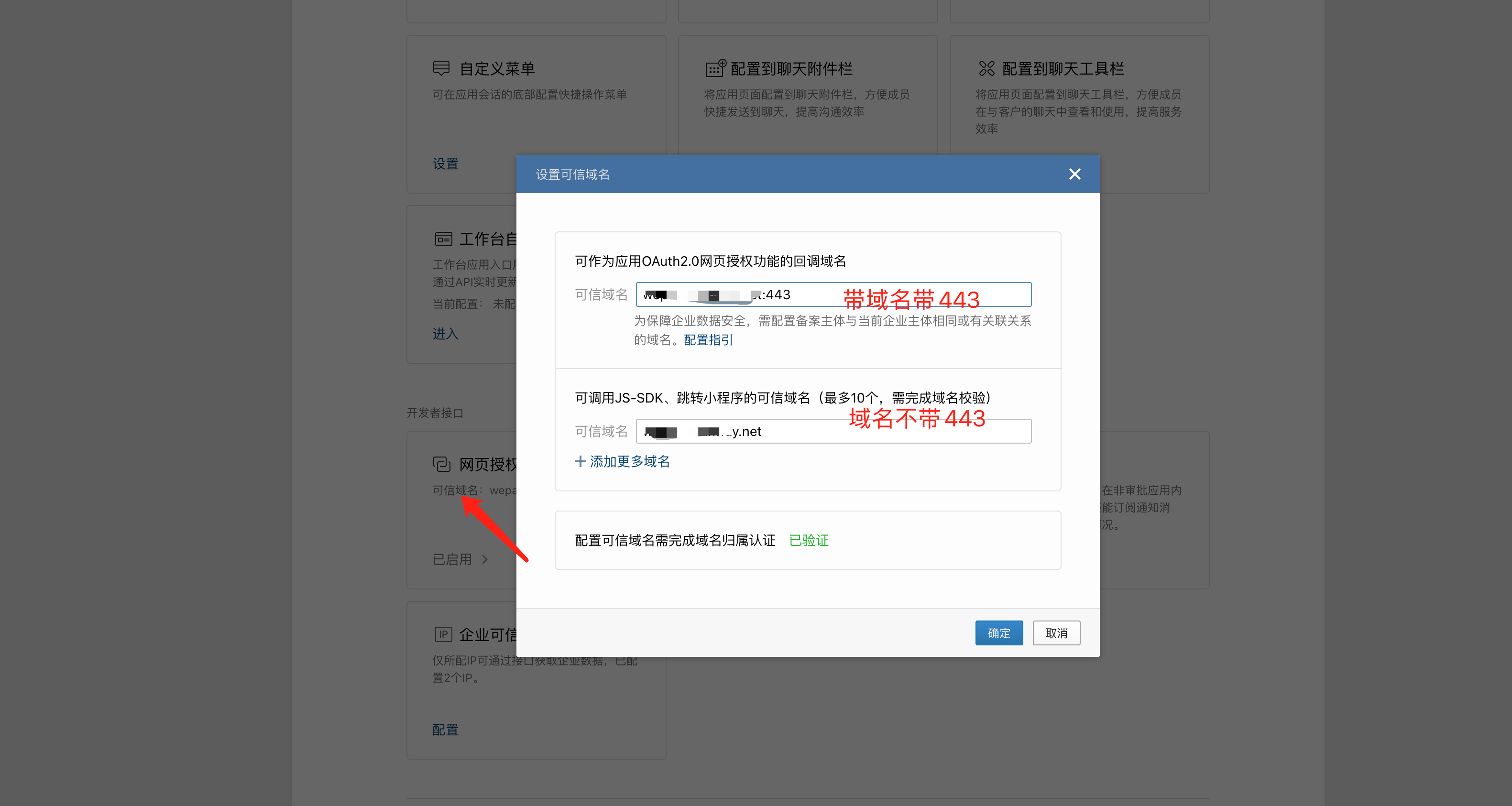

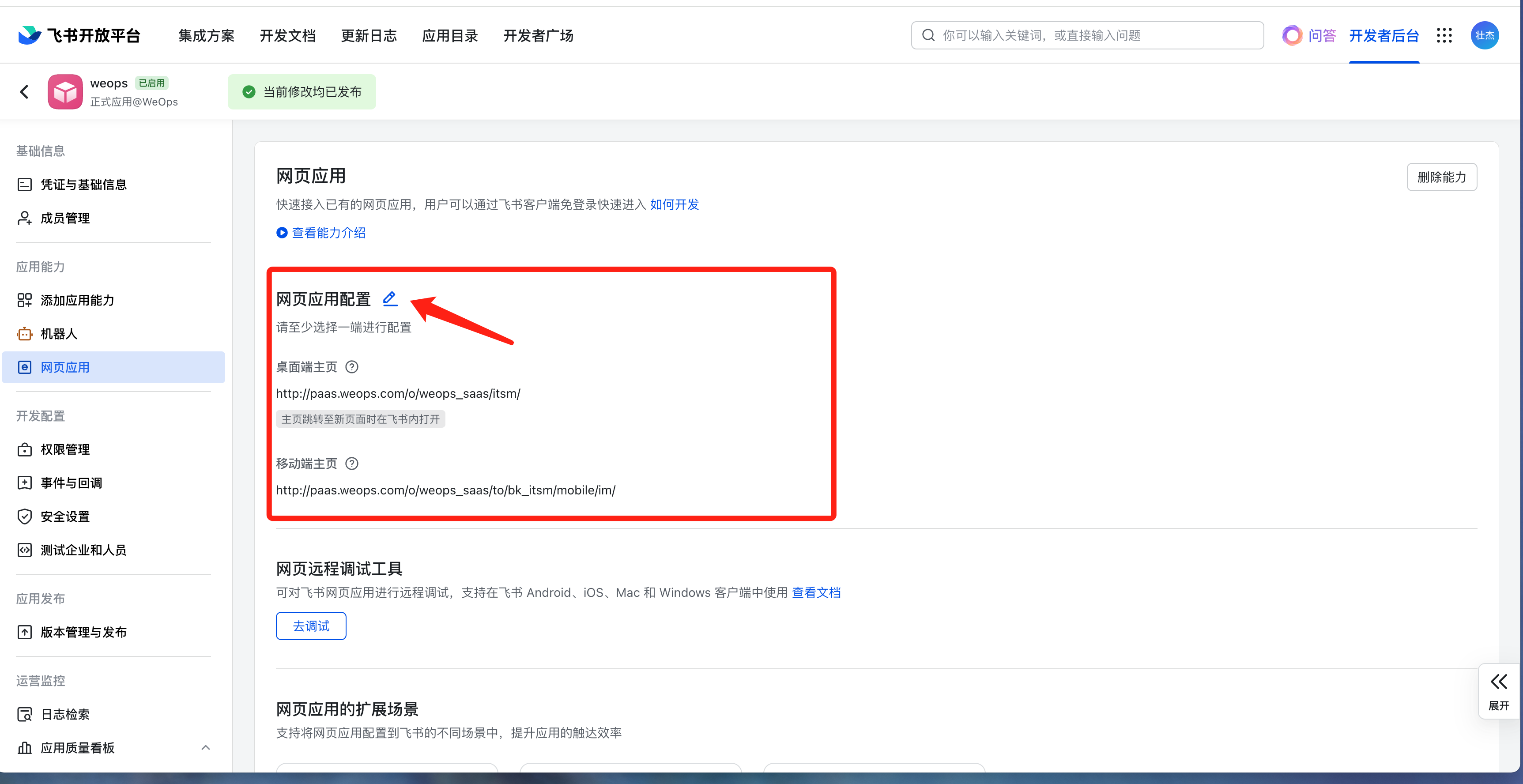

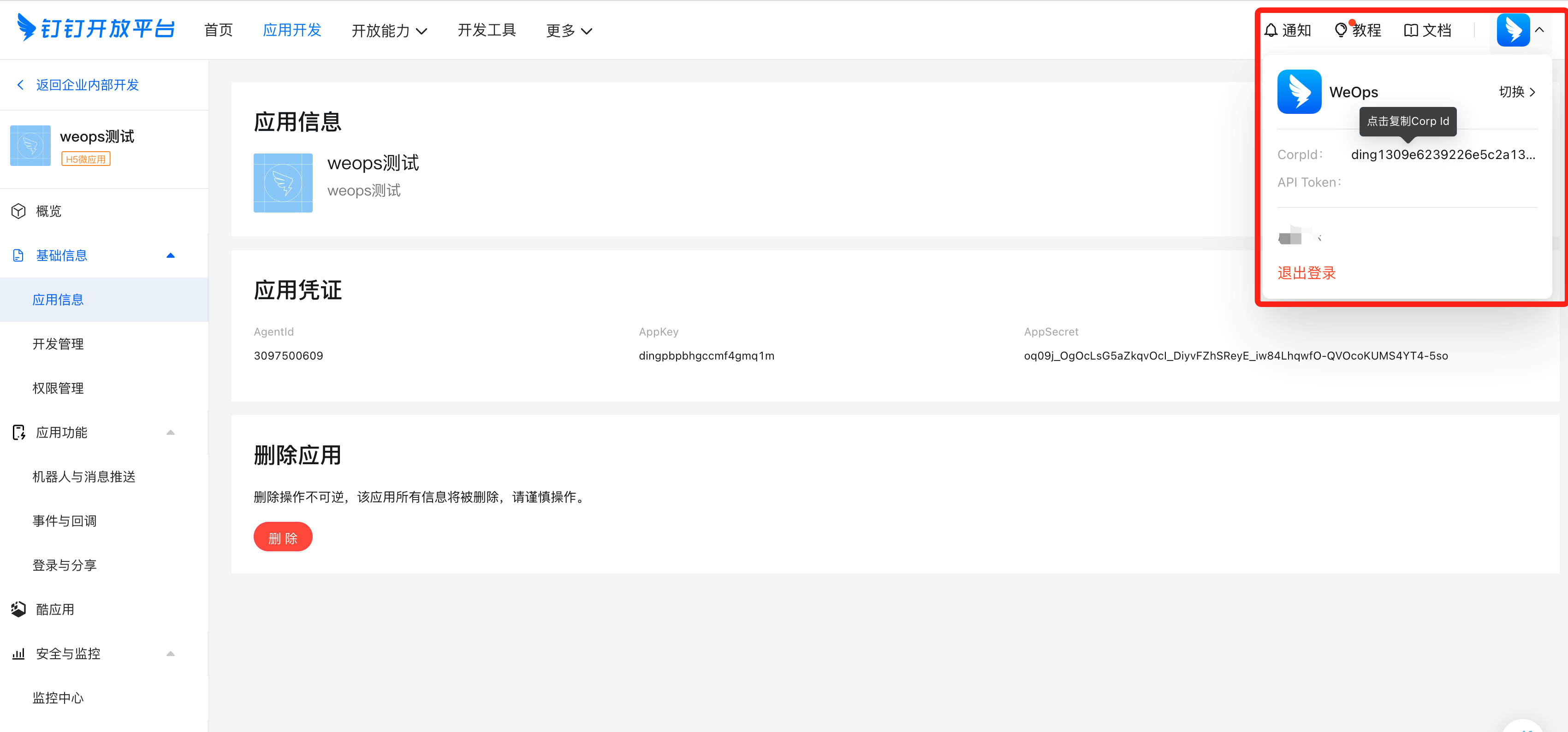

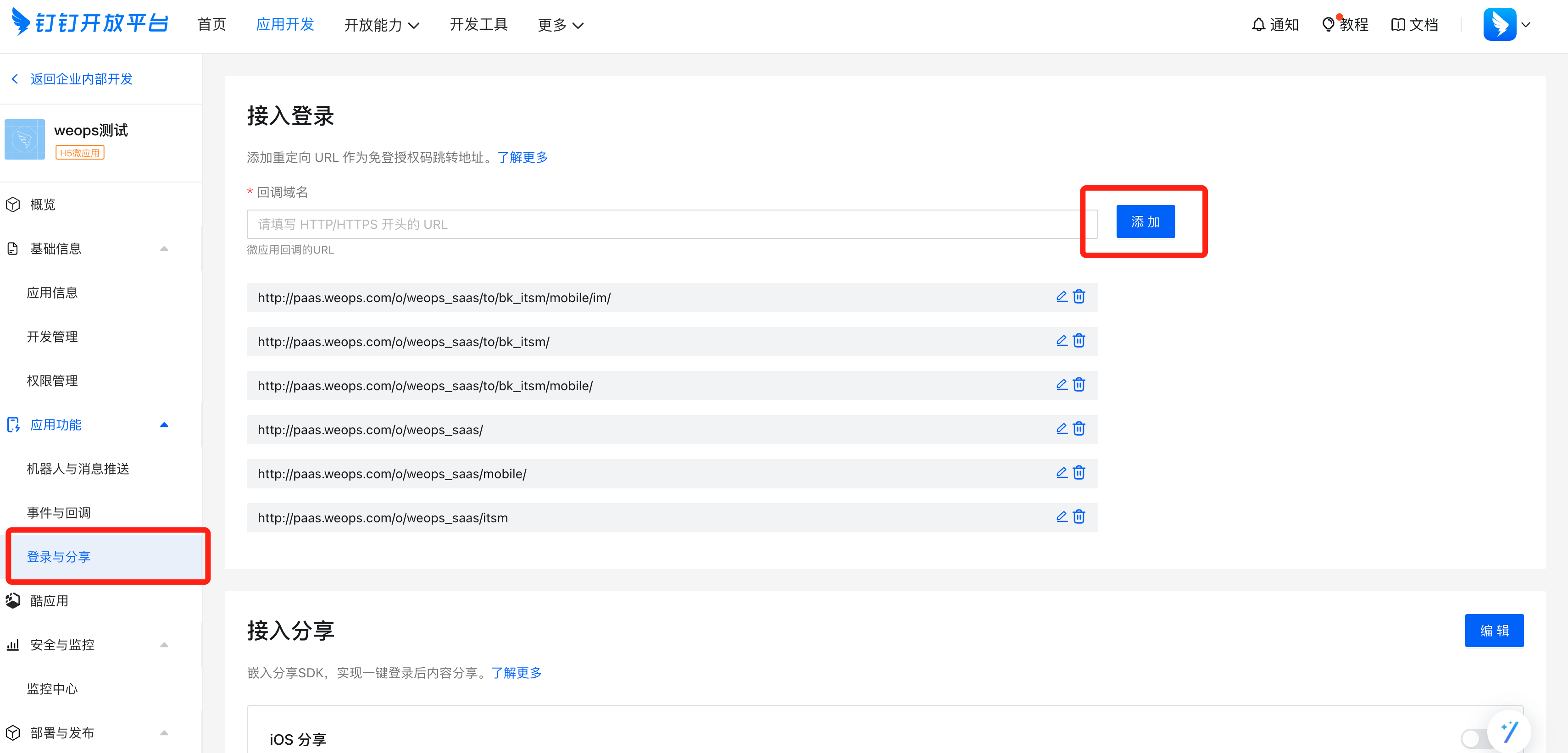

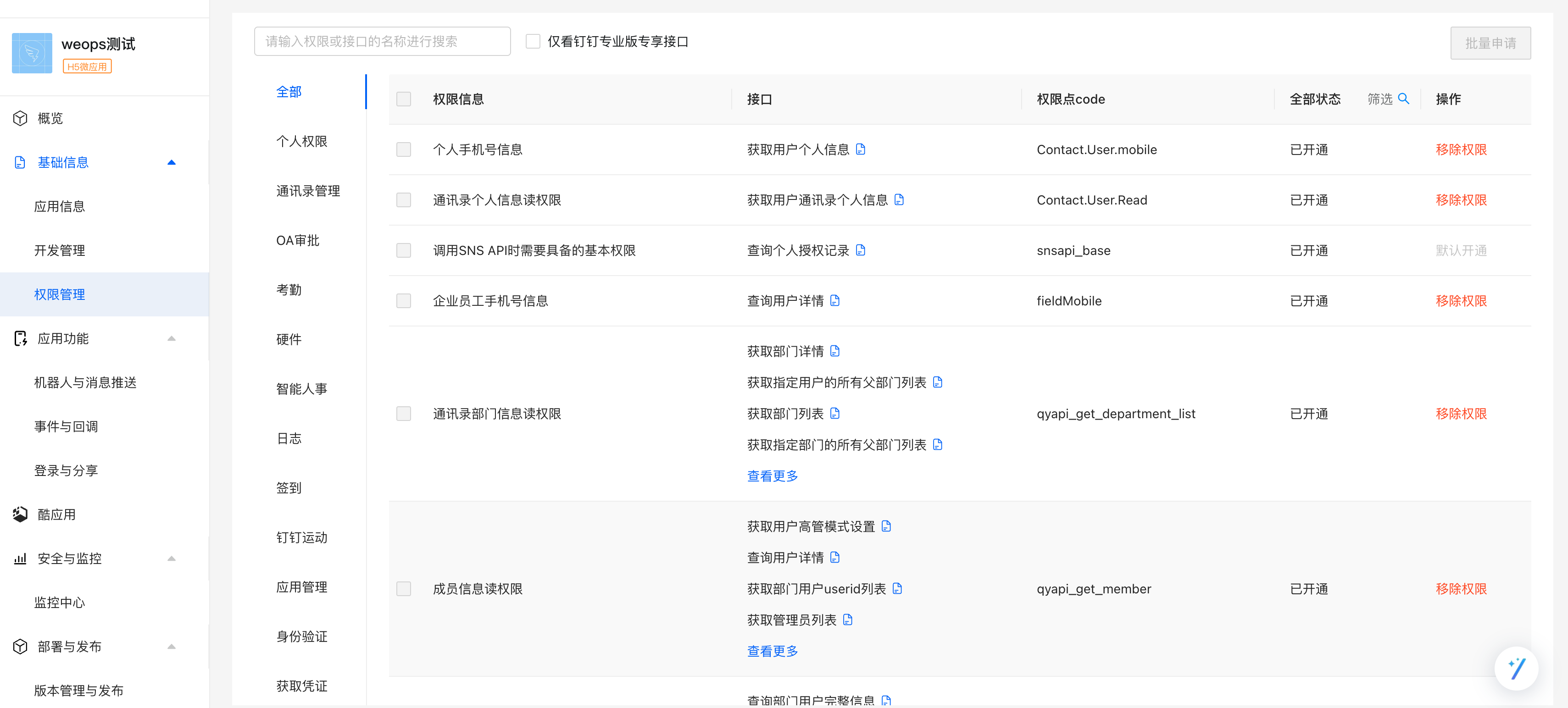

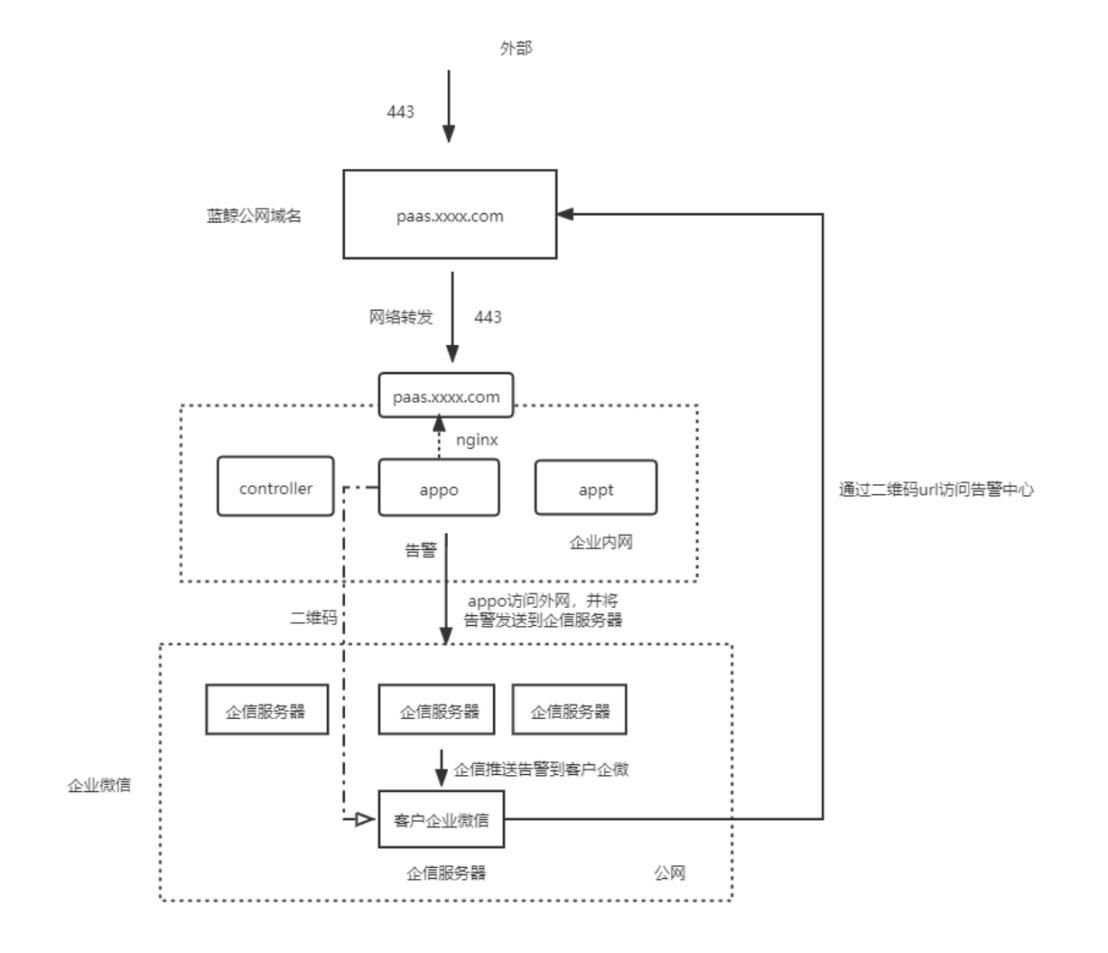

IT服务台移动端

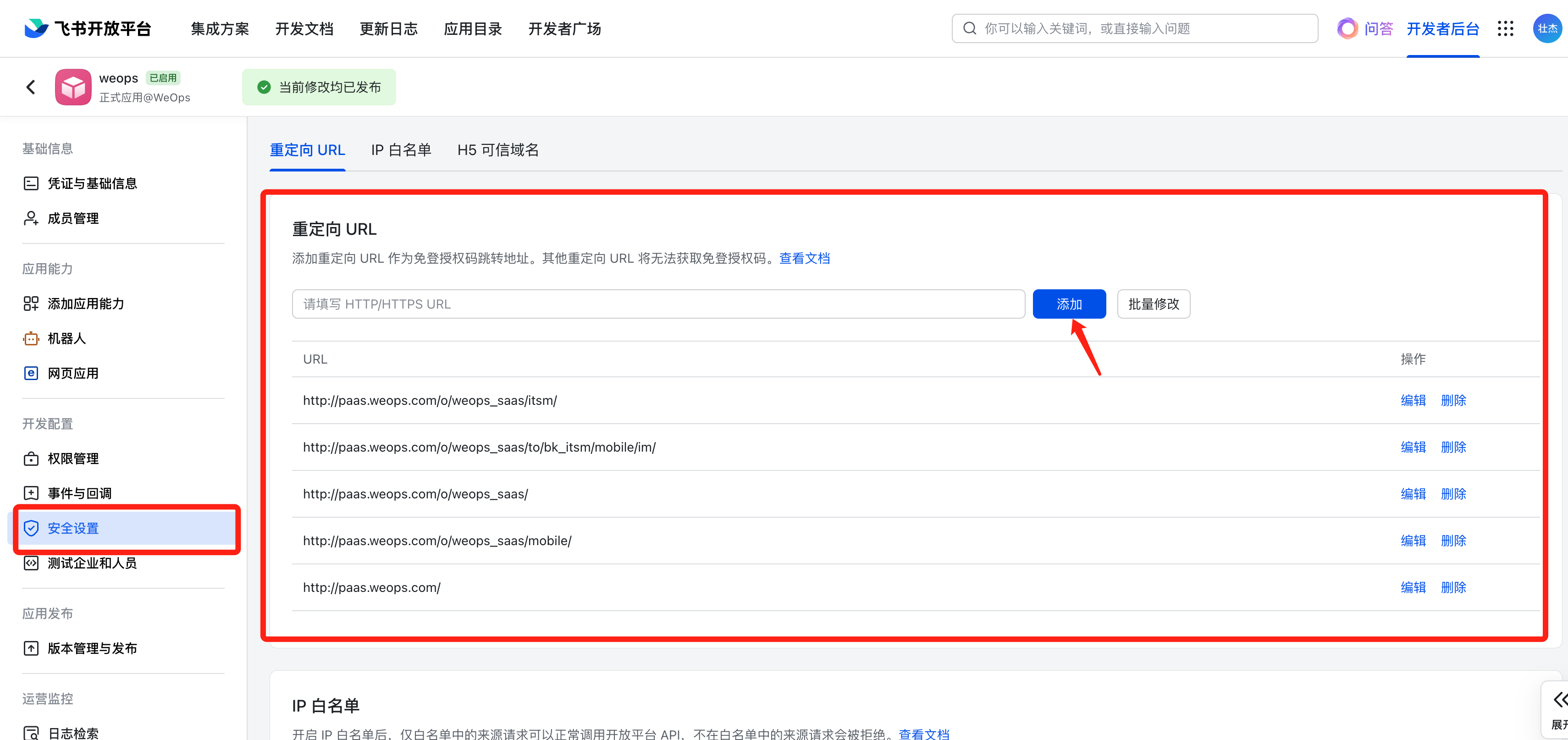

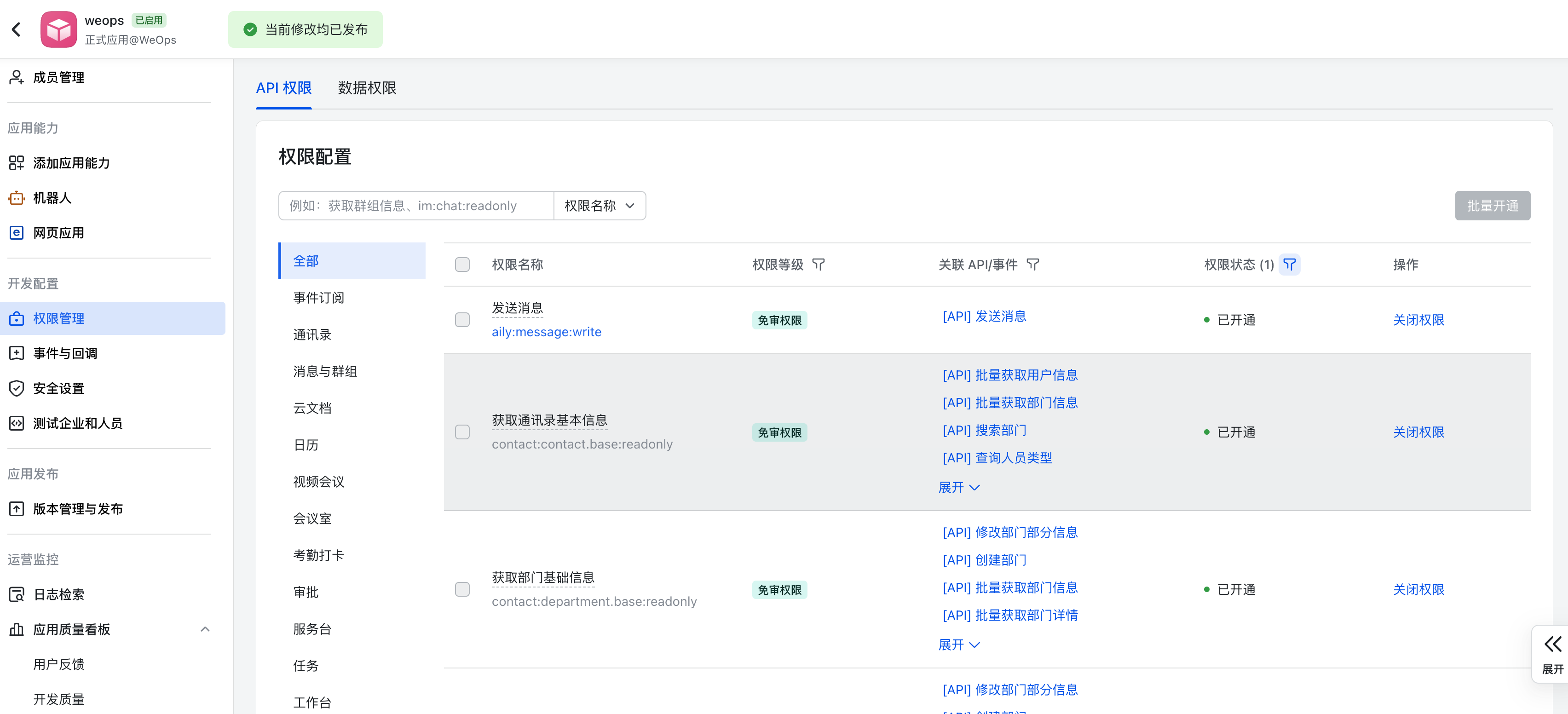

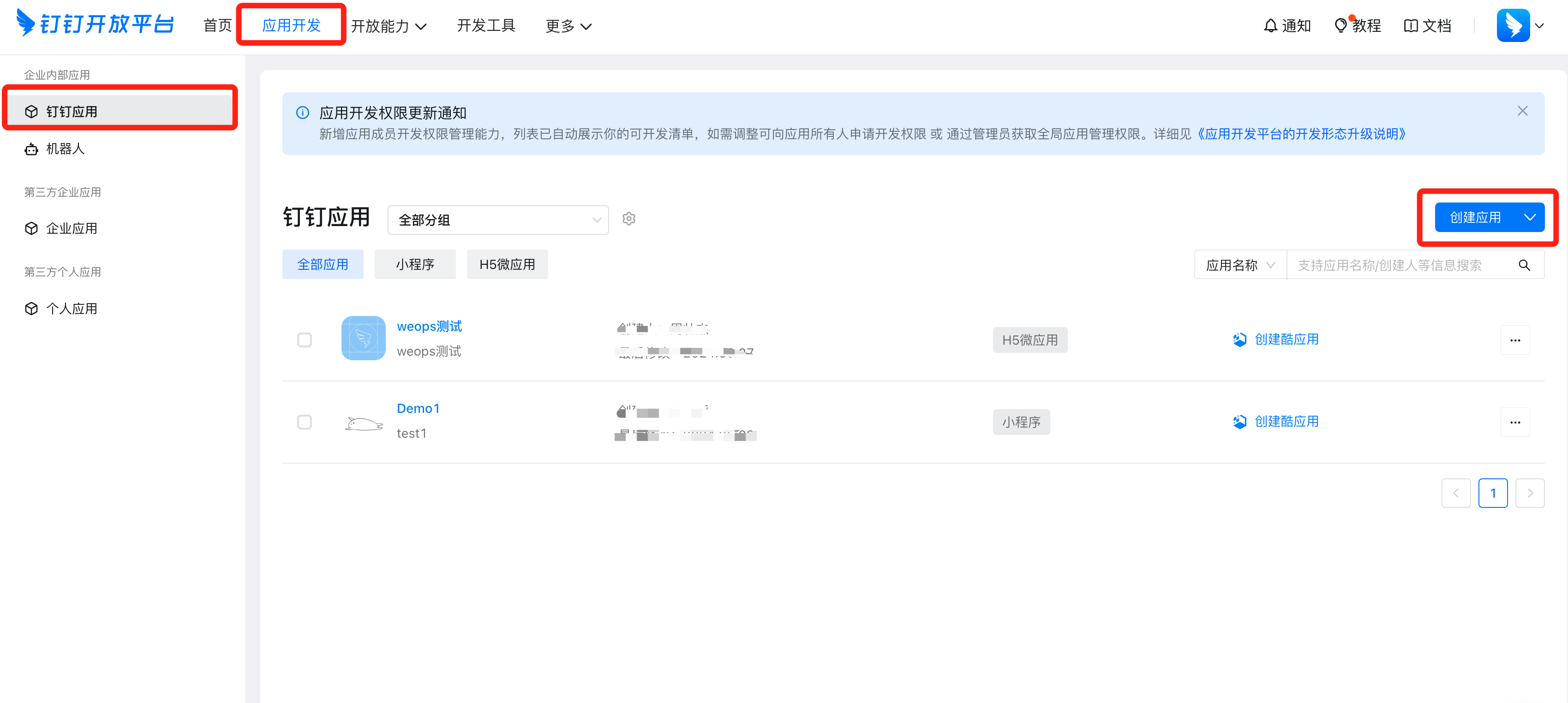

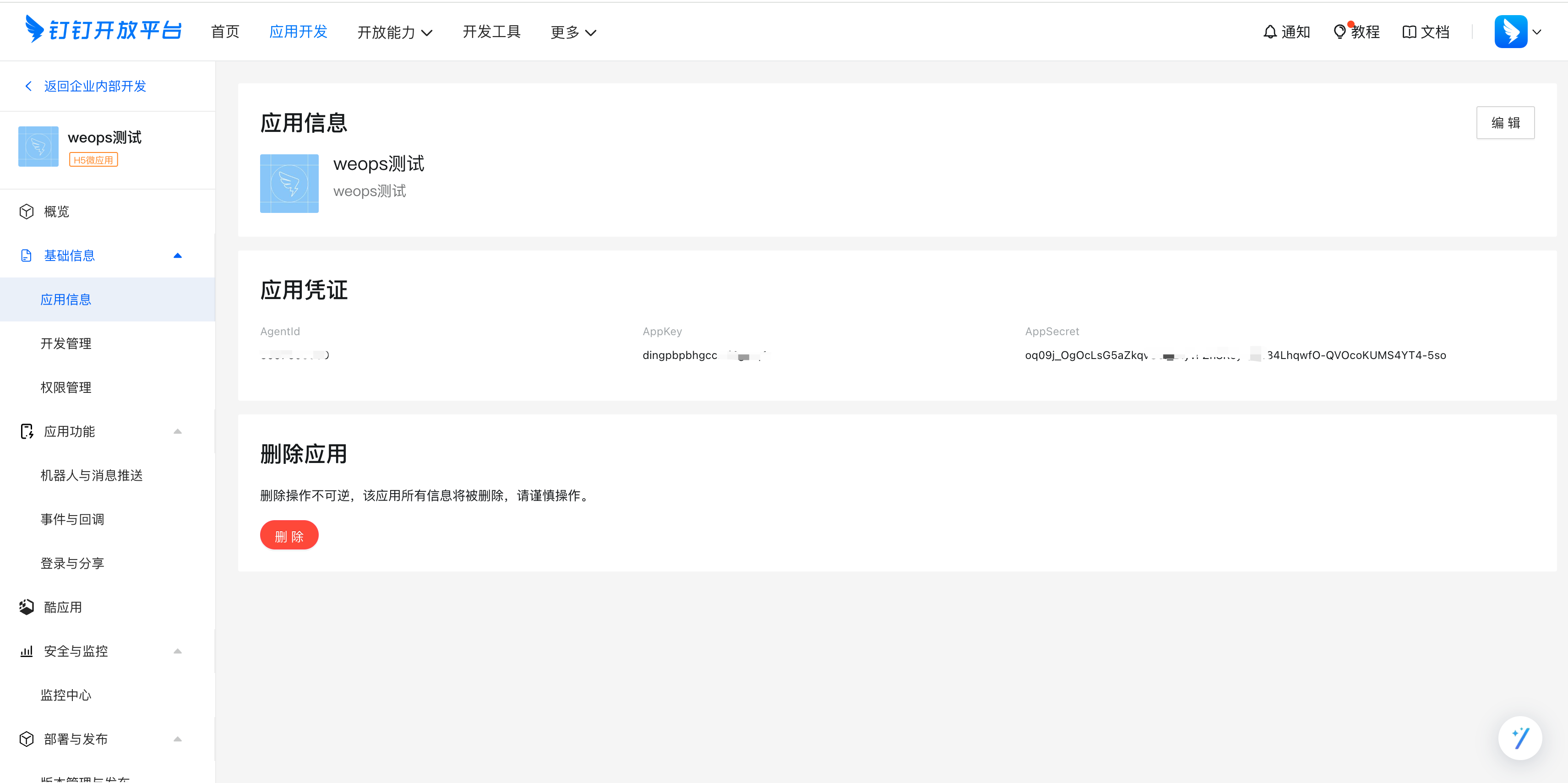

WeOps运维平台/IT服务台支持与IM对接提供移动端操作和管理能力,默认支持企业微信、钉钉、飞书,支持通过插件拓展对接其他IM。(不支持调整移动端访问域名URL)

IT服务台移动端主要功能如下

- 首页:移动端首页主要支持快速提单。

- 提单:点击首页“快速提单”的各个类型的工单管理/菜单的“+”进行快速提单,在提单页面中,在“提单申请”中,选择对应的服务目录和服务,在“提单信息”中,填写该工单的对应信息。

- 我的工单:我的工单包括“我的工单”、“我的待办”、“历史工单”分别展示我提交的工单、需要我审批的工单、所有与我有关的工单。

- 点击可查看工单详情

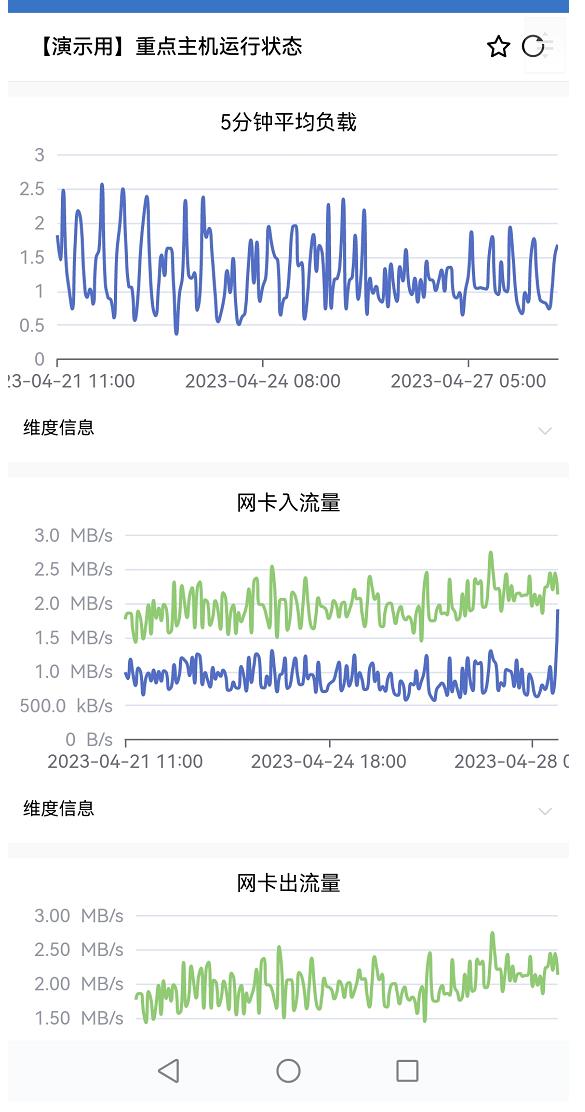

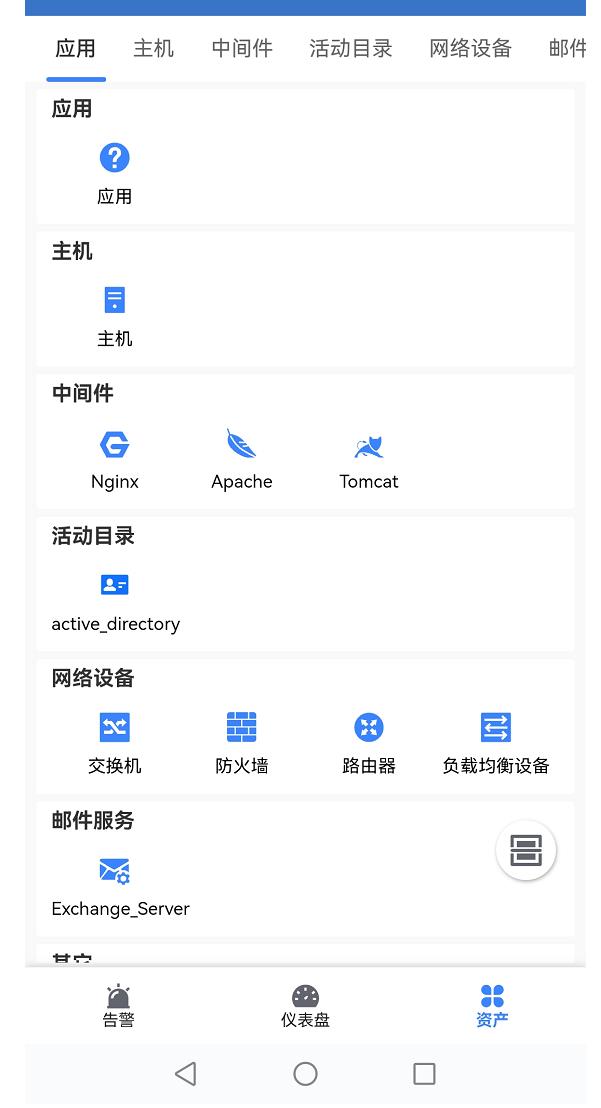

监控告警移动端

WeOps提供监控告警的移动端,满足多种场景的告警信息查看处理、监控信息查看的需求,包括告警、仪表盘、监控三个大模块

- 告警:展示了活动告警、我的告警、历史告警的列表,可以进行告警详情/视图的查看,支持告警认领/分派/关闭等处理

- 仪表盘:展示了所有视图、我的视图、我的收藏的基本情况,点击可查看仪表盘具体视图情况。

- 资产:展示了应用/基础监控/虚拟机/K8S/网站监控的基本情况,包括资产基本信息/监控视图/告警列表等,支持二维码/条形码扫描(需要使用WeOps-资产记录里面生成的资产编码),并展示扫描出来资产的监控情况、基本信息、告警情况等信息

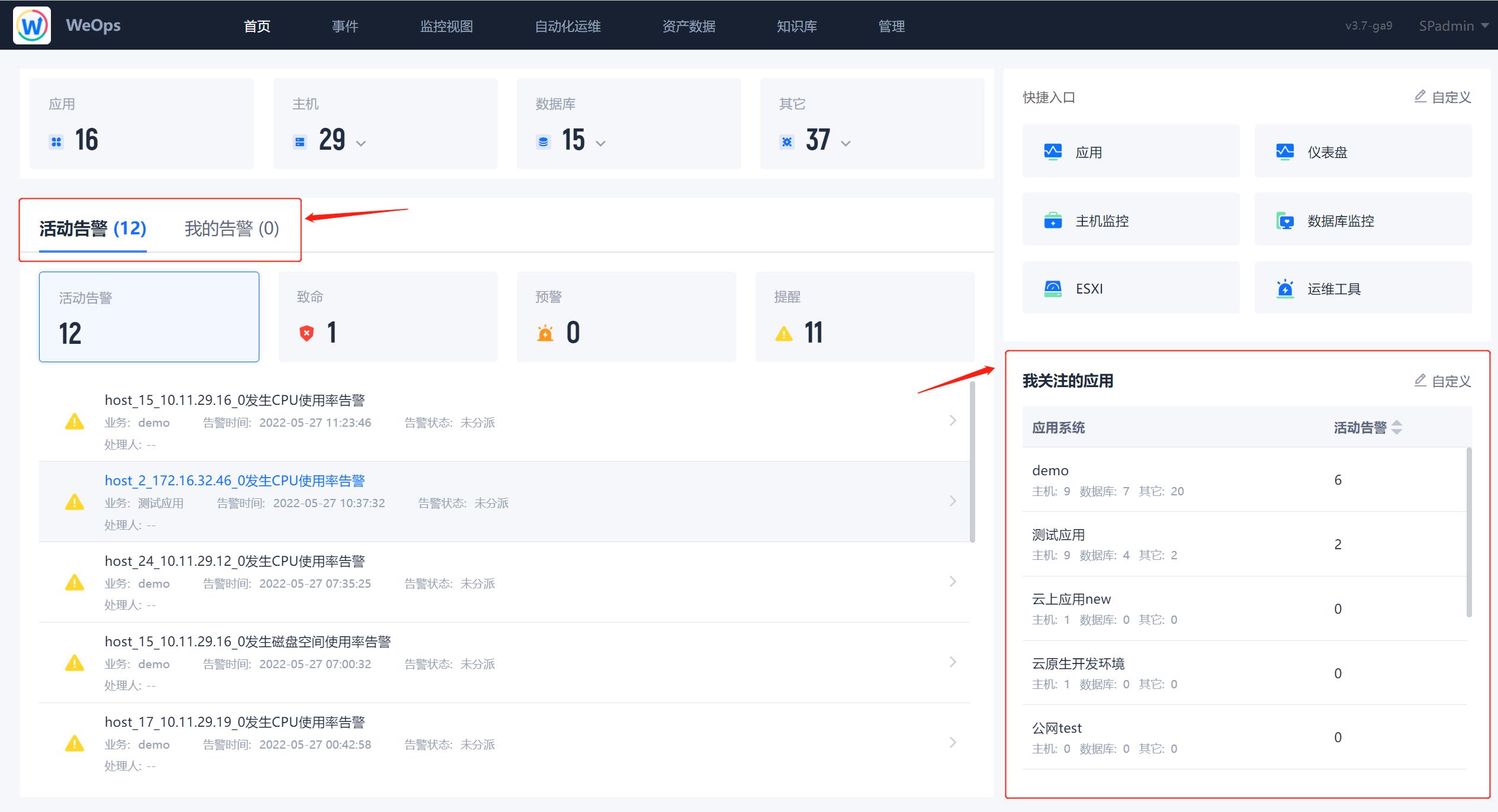

首页

首页主要展示WeOps关键的信息,可对于告警进行便捷的处理。

- ①资源情况:展示用户自己有权限的所有应用、主机(Windows、Linux、AIX、Unix、other…)、数据库(Oracle、MySQL、MSSQL、数据库集群、MongoDB、Redis…)、中间件(Apache、Tomcat、Nginx…),可以点击跳转至资产记录的对应页面。

- ②告警情况:活动告警和我的告警总数展示其中的致命、预警、提醒告警,点击告警信息,可查看该告警的具体信息,也可进行便捷的处理。

- ③快捷入口:可以自定义快捷入口

- ④我关注的应用:(我关注的)应用的资源数量、活动告警数

监控

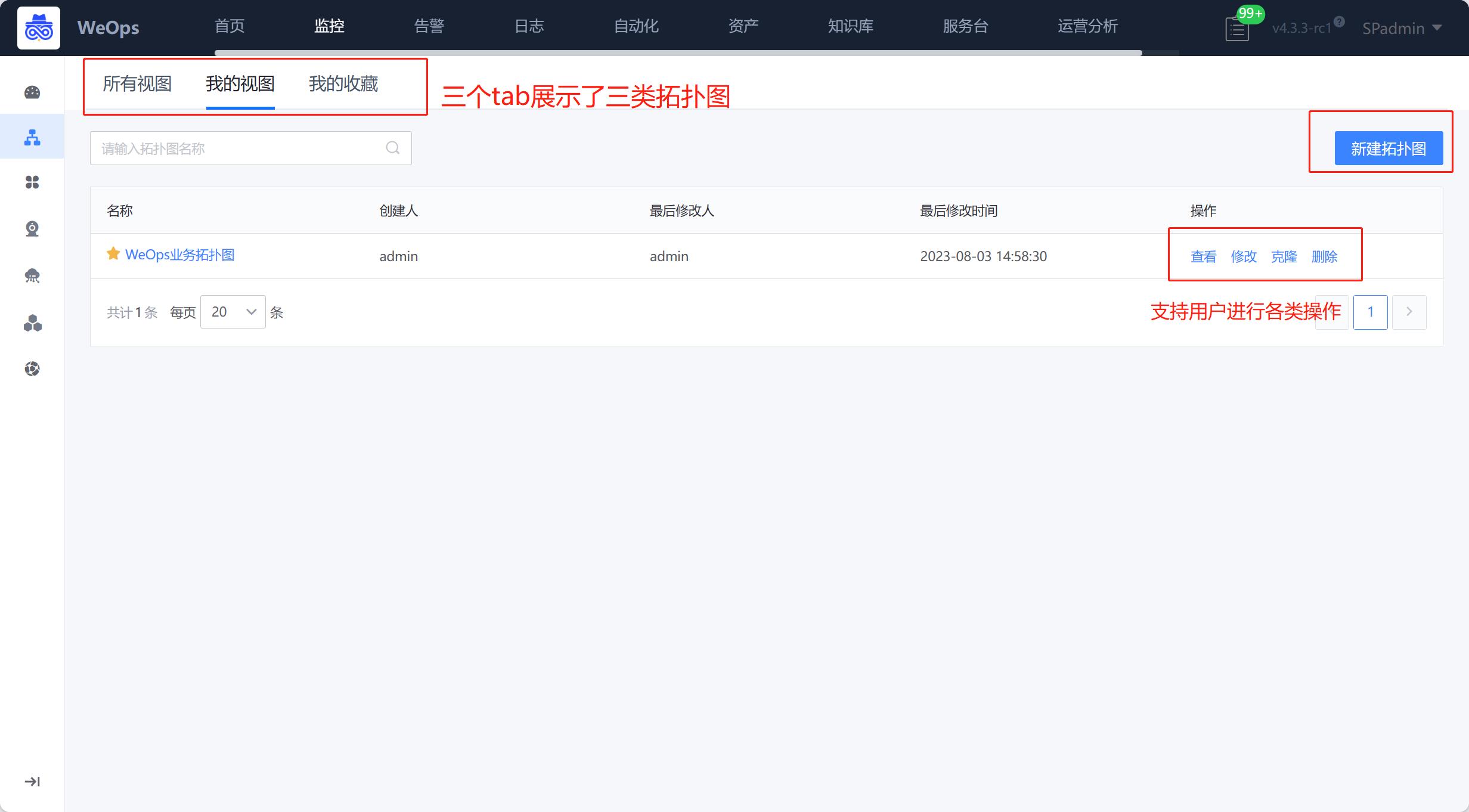

拓扑图

拓扑图支持对需要展示的资产对象进行自定义拓扑,绘制应用、资产等对象的关联关系,并展示告警信息,呈现告警关联链路。

(1)拓扑列表:拓扑列表分为三个tab:所有视图、我的视图、我的收藏。所有视图:展示我所有有权限查看的视图列表,点击进去可以查看具体的拓扑图;我的视图:我创建的视图;我的收藏:展示我比较关注的并且收藏的视图。

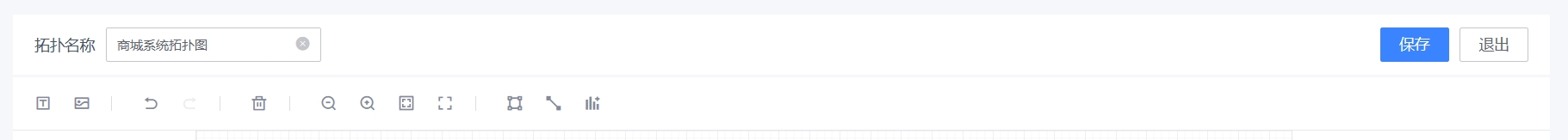

(2)拓扑图新建/编辑:如下图,支持进行拓扑图的绘制

拓扑图详细操作介绍如下:

- ①基本信息&操作区:各个要素的使用和说明如下

拓扑名称:填写拓扑图的名称,并保存

文本按钮:点击按钮,再点击画布,即可插入文本,并支持编辑文本

图片按钮:点击可插入2M内的图片

撤销按钮:支持返回到上一步

删除按钮:选择画布中的节点组件/连线,点击按钮,可以删除

放大/缩小:放大/缩小画布

适配页面:将画布的要素放置为最合适的位置

全屏展示:将整个拓扑图绘制放大至全屏展示

框选按钮:选中一个要素,按住shift,可以多选其他要素

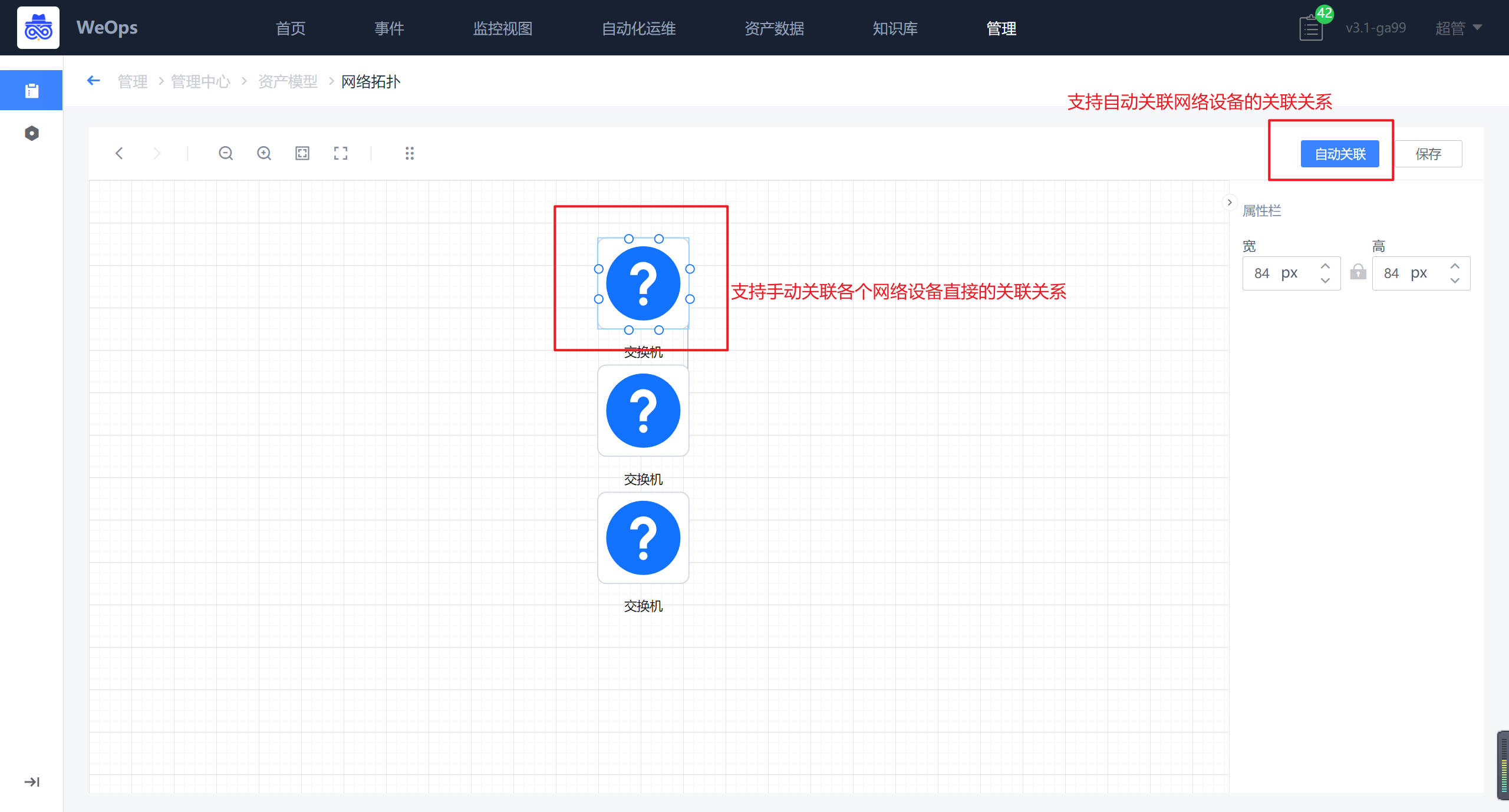

自动连线:针对网络设备类的资产,根据资产记录的关联情况,支持自动绘制连线

添加视图:支持添加“单值”类的监控组件,作为资产关联的监控关键指标展示- ②图标区:分为基础图形、业务拓扑、资产组件三类

分类说明如下

基础图形:作为节点组件的装饰使用,分为正方形、圆形、菱形和云形

业务拓扑:分为应用(业务)、集群、模块三类,用于展示应用的层级

资产组件:展示各类资产,包括主机、数据库、中间件、云平台、网络设备、硬件设备等等

使用:拖动选中的组件节点至画布,可以选择需要的具体的资产(支持多选),选中后,根据选择的资产数量和类型,在画布中即可呈现出来,可以调整位置和大小。- ③画布区:各个组件支持连线,鼠标拖动调节大小等操作

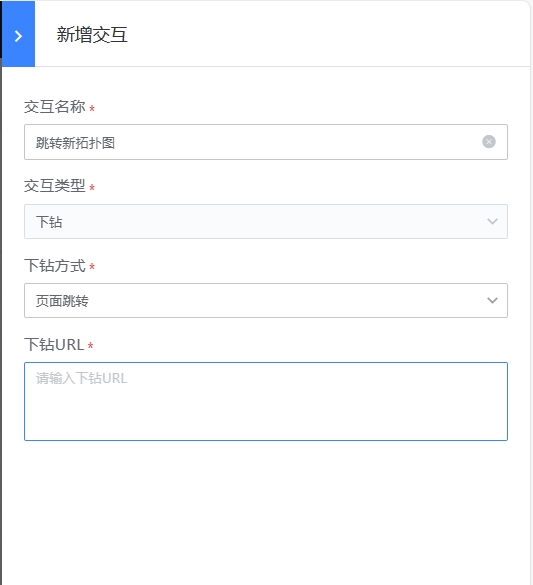

- ④节点&连线基础信息区:节点基础信息支持修改节点显示名称,样式和层级;并支持设置交互跳转交互(已经内置查看详情的交互),交互设置完成后,查看拓扑图时右键可以点击操作

- 连线基础信息支持修改连线的显示名

(3)拓扑图展示:点击查看拓扑图,可展示拓扑图已经绘制好的关联关系。交互:右键可以唤起交互列表(内置+自定义),内置了查看各个资产的详细信息,可以查看该资产的基本信息、监控视图、告警列表、关联拓扑等信息,其他交互可以按照规则点击使用。

仪表盘

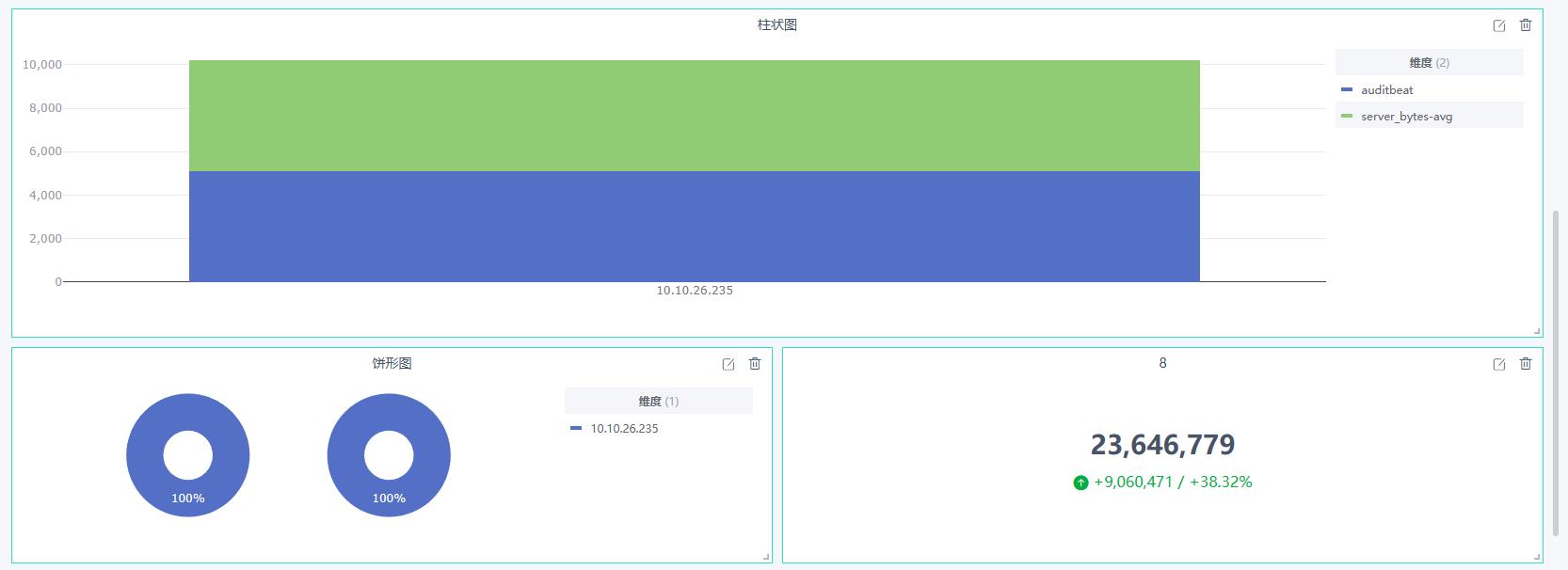

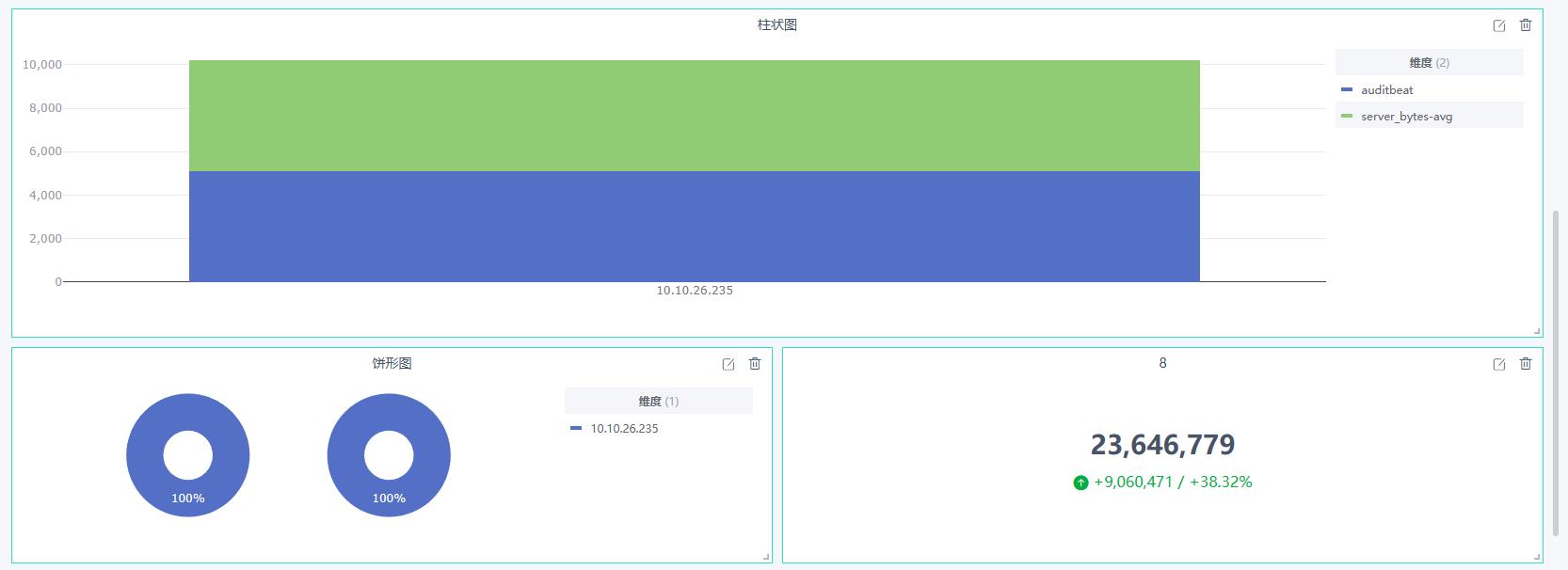

监控仪表盘可以进行快捷简单的监控视图配置,支持“仪表盘”、“折线图”、“柱状图”、“饼形图”、“单值”、“资产表格”、“运维工具”、“日志消息”、“日志表格”、“高级组件”等图表,可展示多项资产信息。

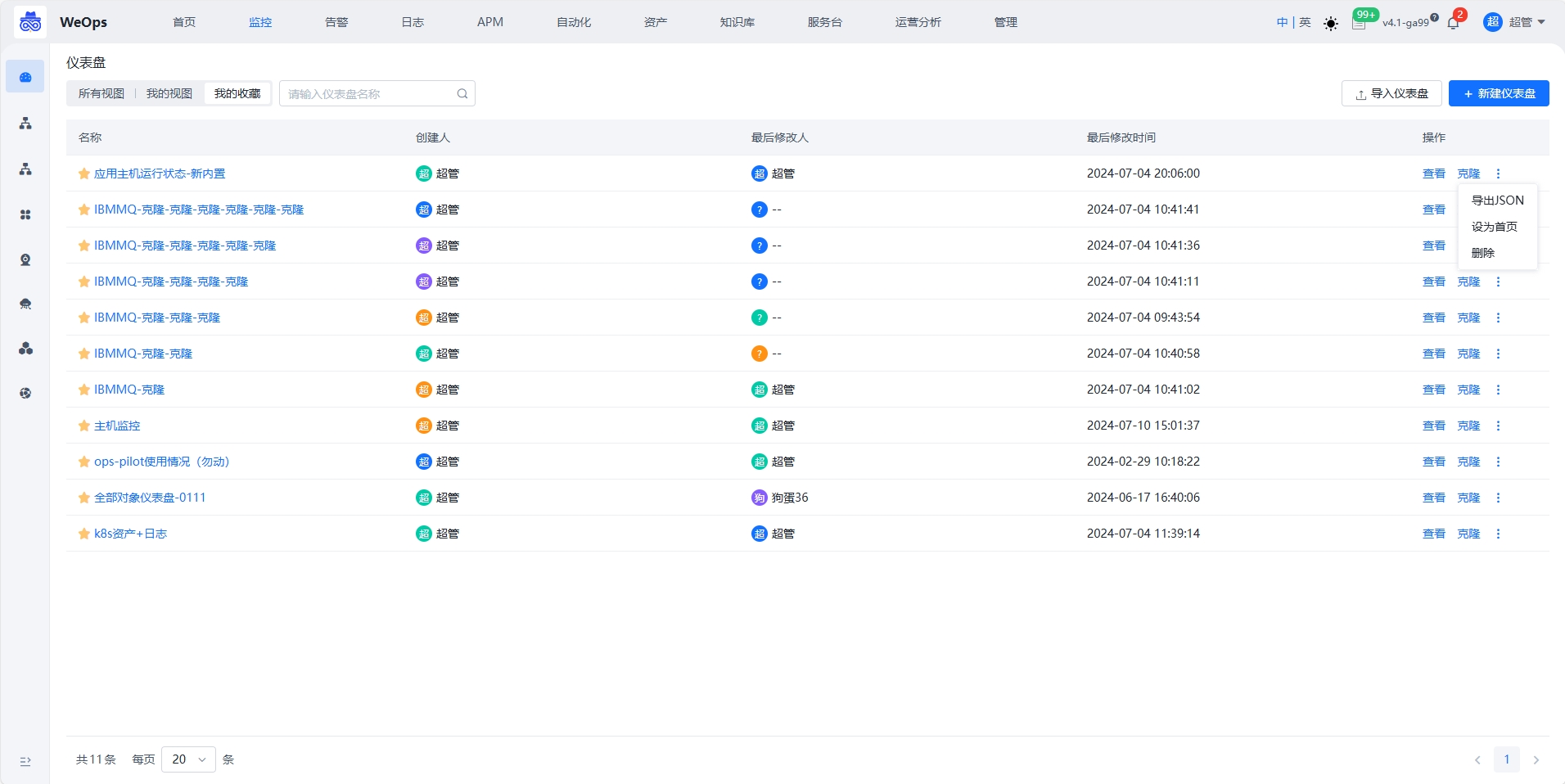

仪表盘列表

如下图,“仪表盘”列表页,分为所有视图、我的视图和我的收藏,支持仪表盘的创建、查看、克隆、修改、收藏、仪表盘的导出和导入、设置为首页。

仪表盘支持设置为首页,或者对已经设置为首页的仪表盘进行还原,如下图,设置首页后,该仪表的数据在首页展示,但是不能切换资产或者编辑。

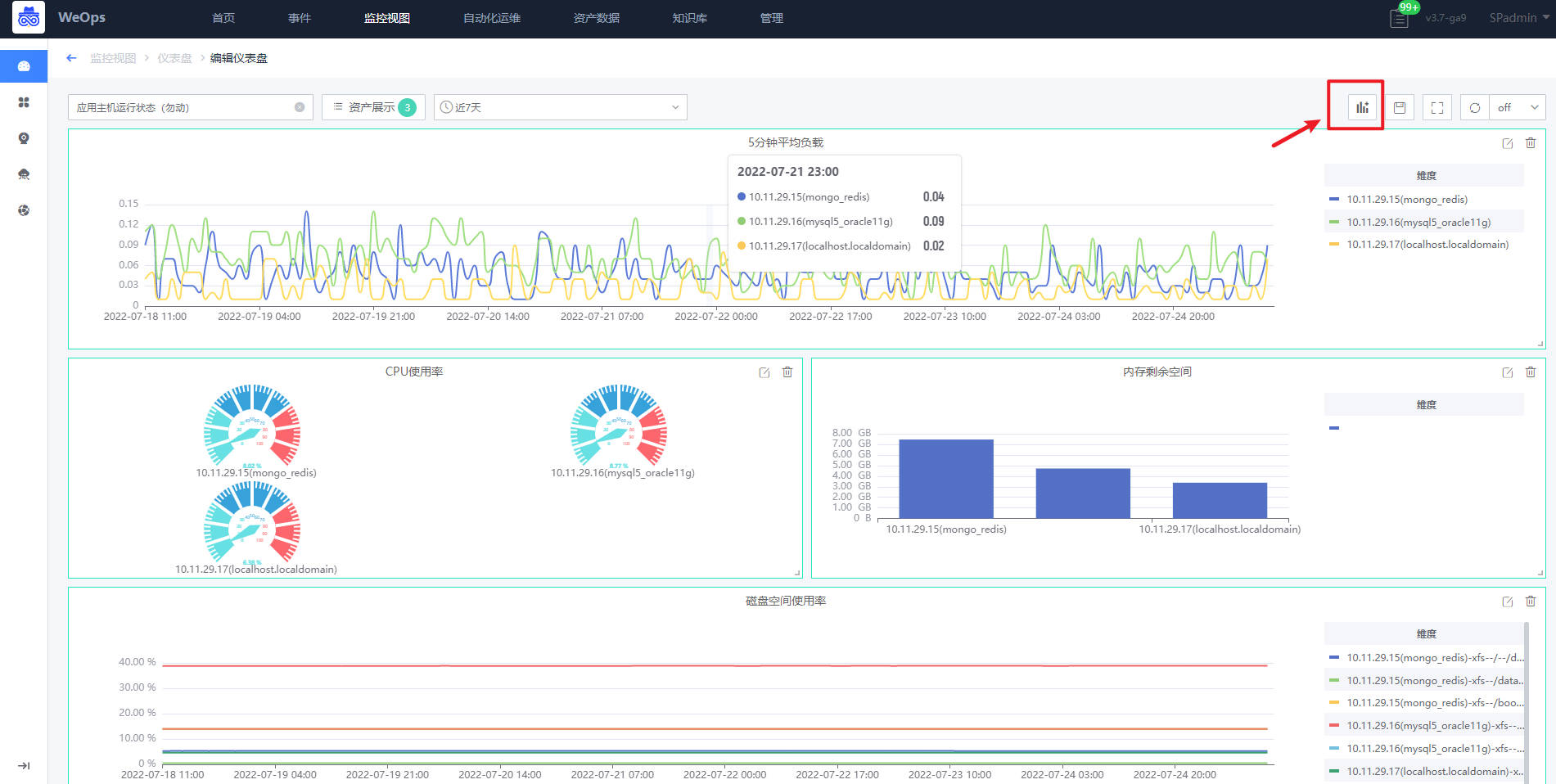

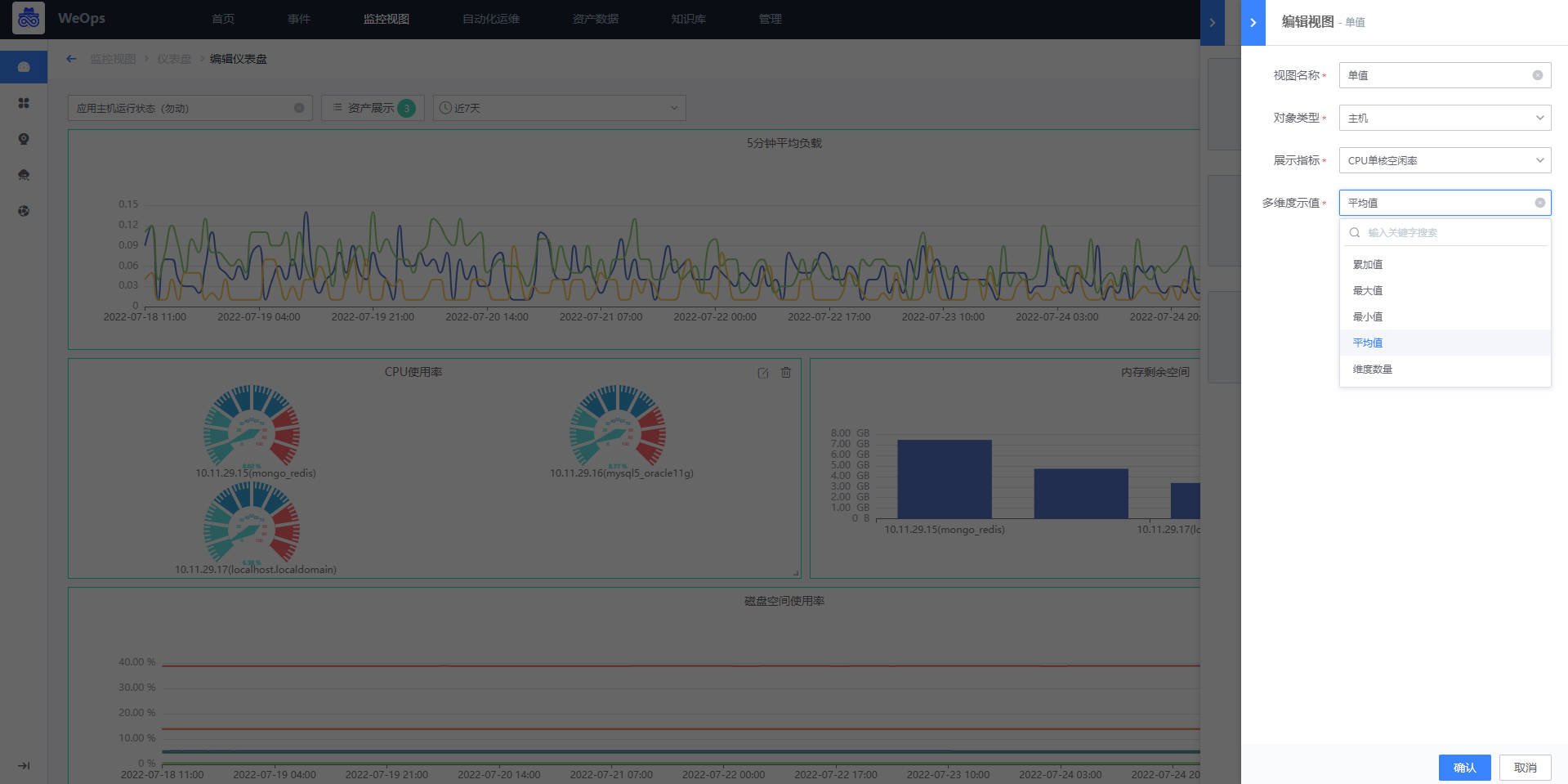

仪表盘编辑

如下图为“仪表盘-查看/编辑”页面,该页面支持以下功能

- 资产显示:支持对象的多选,可以同时选择主机、数据库等多类对象;支持应用的多选(新增一条资产展示);支持同一应用下资产多选,选择多项资产后,统计图会对应显示所有资产的监控指标数据。

- 时间范围选择:内置“近15分钟”、“近30分钟”“近1天”“近7天”等时间范围,支持自定义时间范围。

- 仪表盘操作:仪表盘可进行全屏放大、设置自动刷新时间。

- 统计图区域:各类统计图根据所选的资产及对应指标显示相关数据,各统计图支持再次编辑和删除。

仪表盘中的统计图新建如下

- 点击页面右上方“新建统计图”的图标

- 点击选择统计图类型

- 根据所选的统计图填写视图名称、选择展示的对象类型和监控指标、若为仪表盘/单值需选择多维度下数值的汇聚方式

仪表盘-监控组件说明

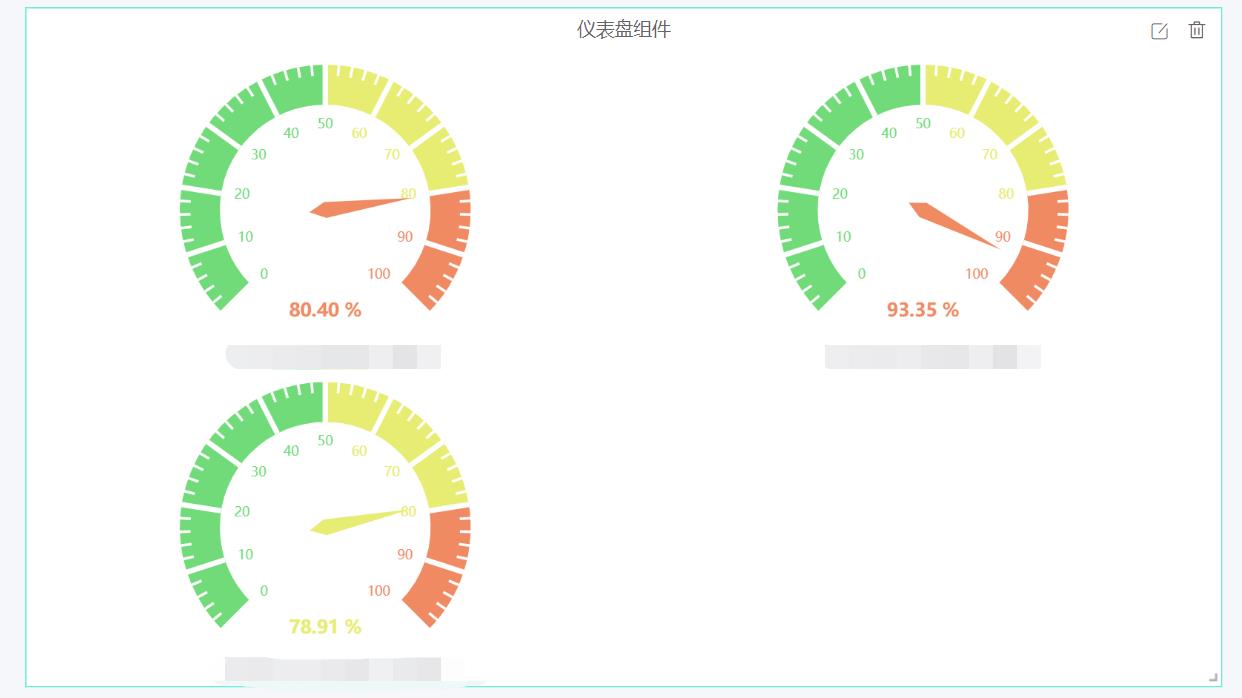

- 监控——仪表盘:展示指定时间范围内,该监控指标的最近数值;若该监控指标有维度,可以根据选择的维度汇聚方式展示“最大值”“最小值”“平均值”“累加值”“维度数量”(选择维度数量,单值则展示对应对象该指标下的维度数量),支持配置仪表盘展示的最大值/最小值,支持选择各个阈值的配色

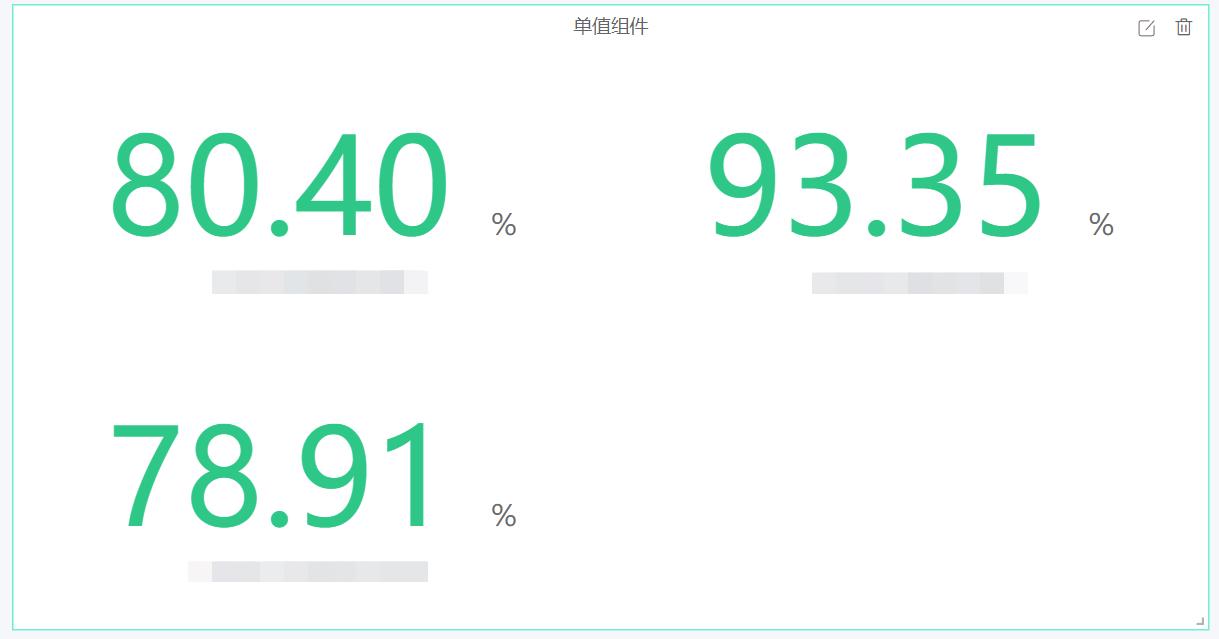

- 监控——单值:展示指定时间范围内,该监控指标的最近数值;若该监控指标有维度,可以根据选择的维度汇聚方式展示“最大值”“最小值”“平均值”“累加值”“维度数量”(选择维度数量,单值则展示对应对象该指标下的维度数量),支持设置维度过滤(比如磁盘这种监控指标,可以通过挂载点的维度进行过滤),支持选择各个阈值的配色。

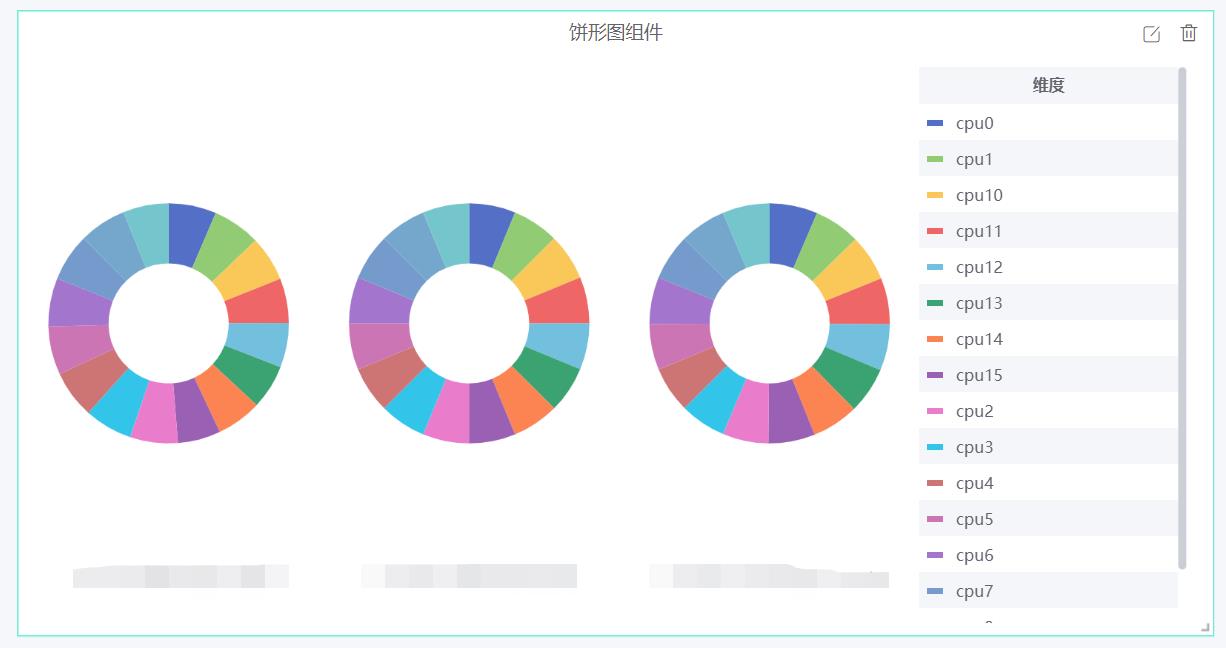

- 监控——饼形图:展示指定时间范围内,该监控指标的最近数值;每个饼状图代表一项资产,若有多维度,则在同一个饼状图中展示各个维度的数值。

- 监控——柱状图:展示指定时间范围内,该监控指标的最近数值;柱状图的每一簇代表一项资产,若资产有多维度,则在同一簇中进行展示各个维度的数值

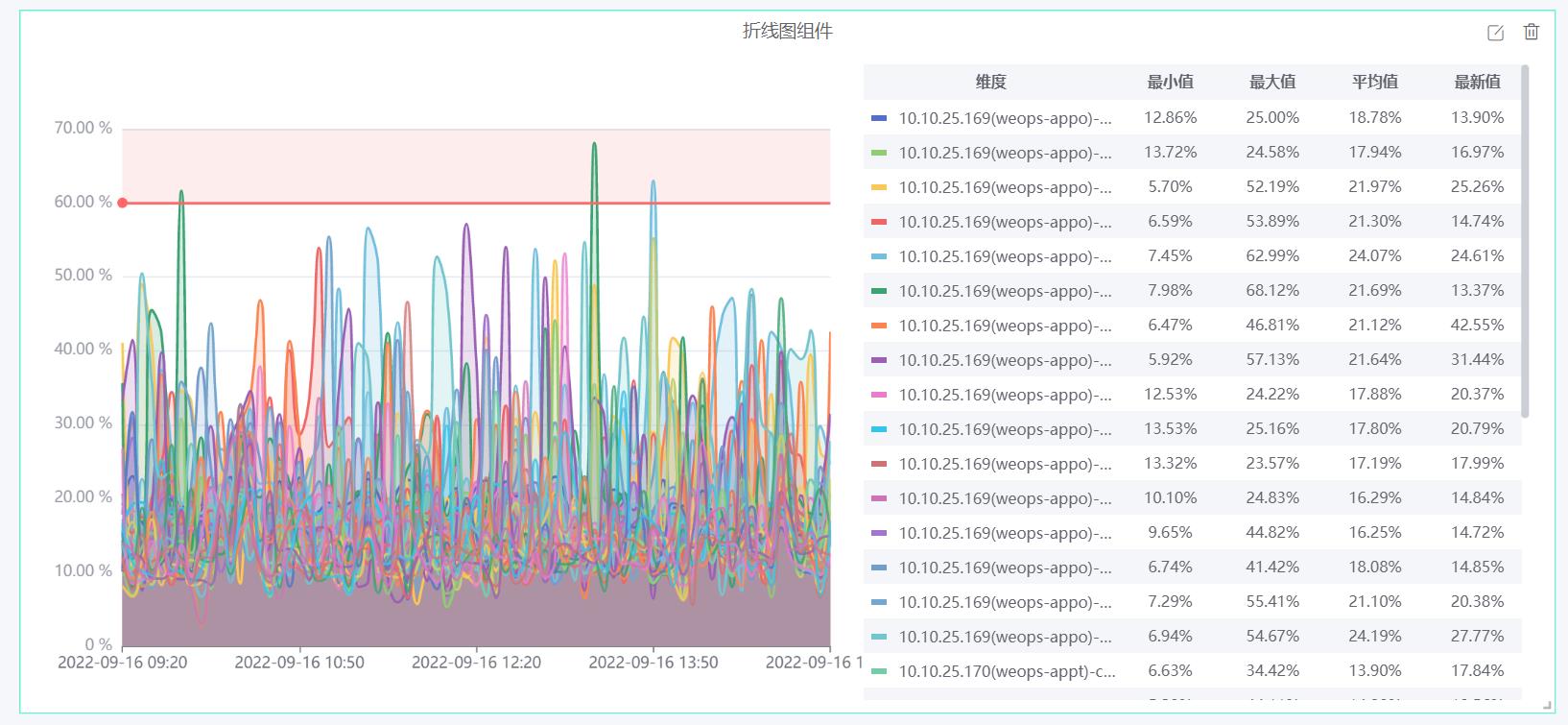

- 监控——折线图:以时间为横坐标展示指定时间内该监控指标的数值变化,多资产和多维度都在用一个折线图中展示,折线图支持配置阈值线,支持配置面积填充。

- 监控——水位图:展示指定时间范围内,该监控指标的最近数值;每个水位代表一项资产,若有多维度,则可以选择展示多维度的展示方式

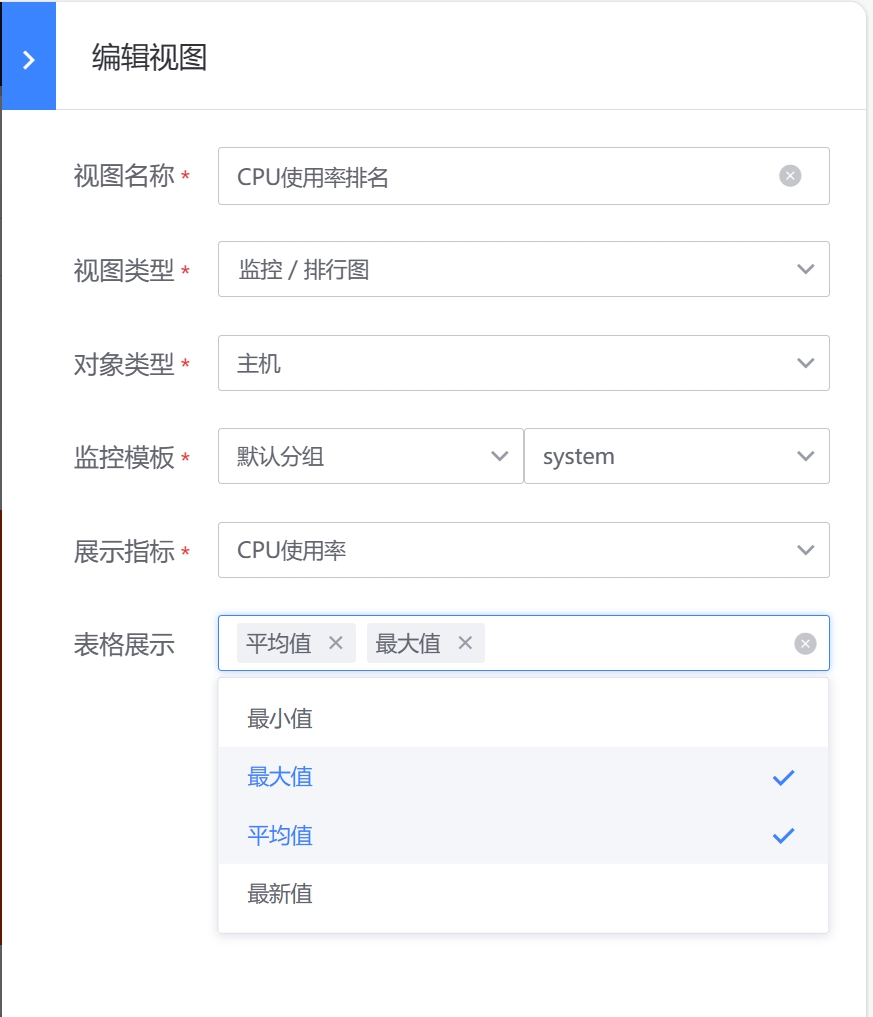

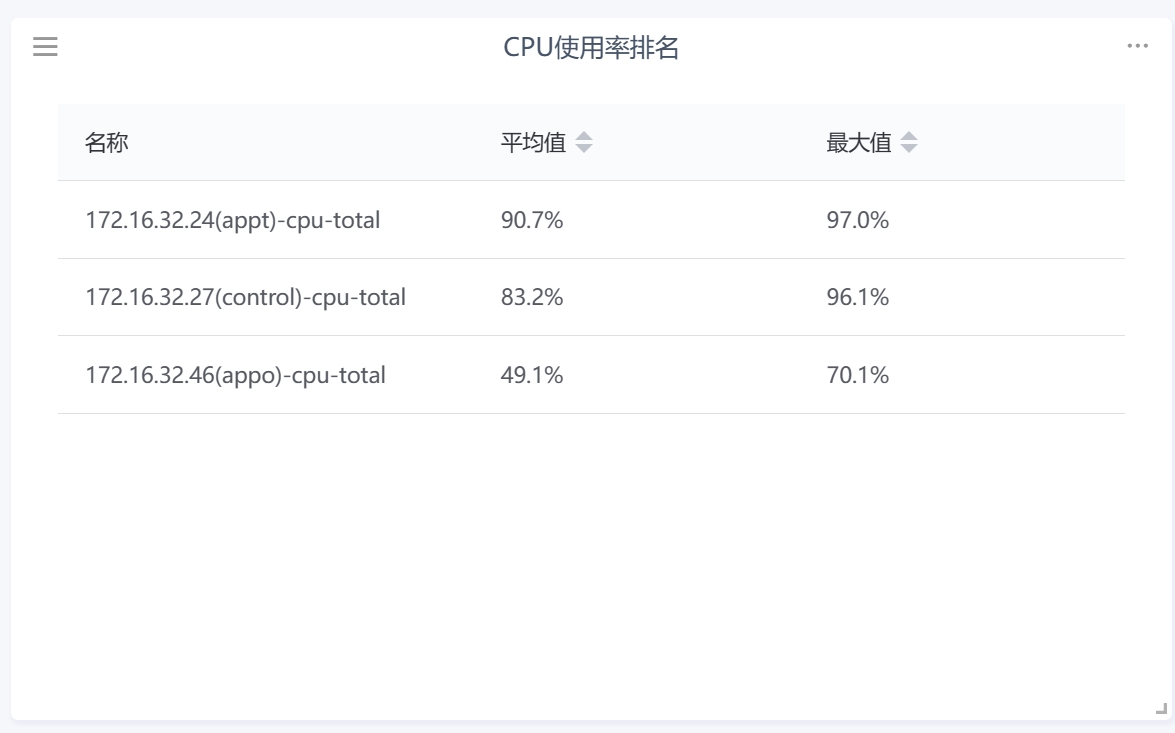

- 监控——排行图:展示指定时间范围内,该监控指标数值的排名情况,支持选择最新值、最大值、最小值等

仪表盘-资产组件说明

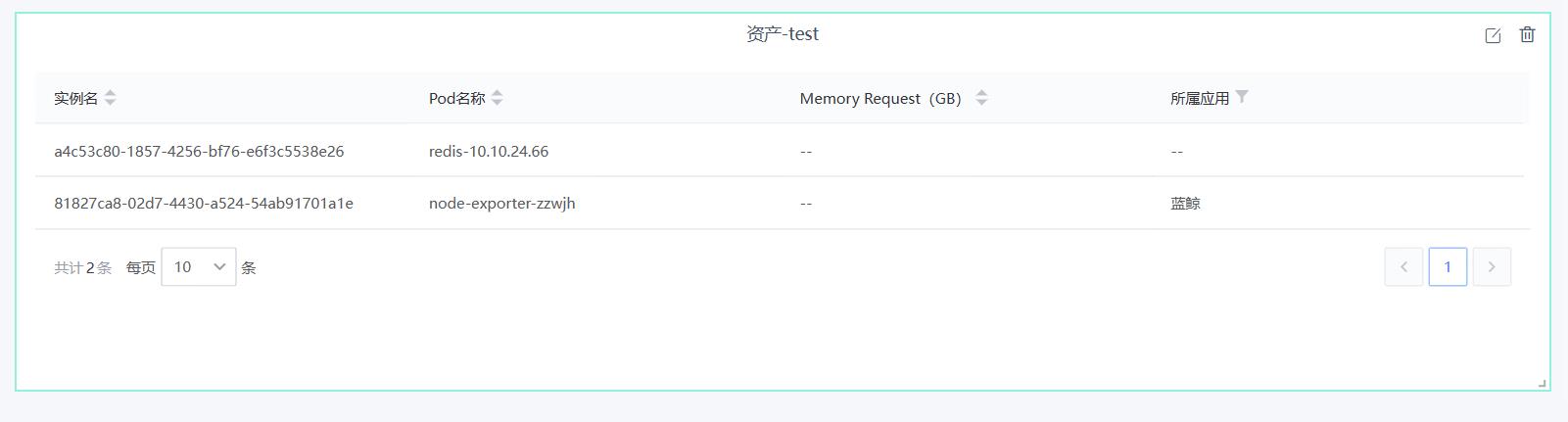

- 资产——资产表格:展示选中的资产基本信息,在配置过程中,可以选择展示的资产字段,对于枚举型字段等特殊字段,支持筛选/排序等操作

仪表盘-自动化组件说明

- 自动化——运维工具:支持配置展示不同的运维工具,支持在仪表盘直接使用该工具对选中的资产进行操作,并展示执行结果。

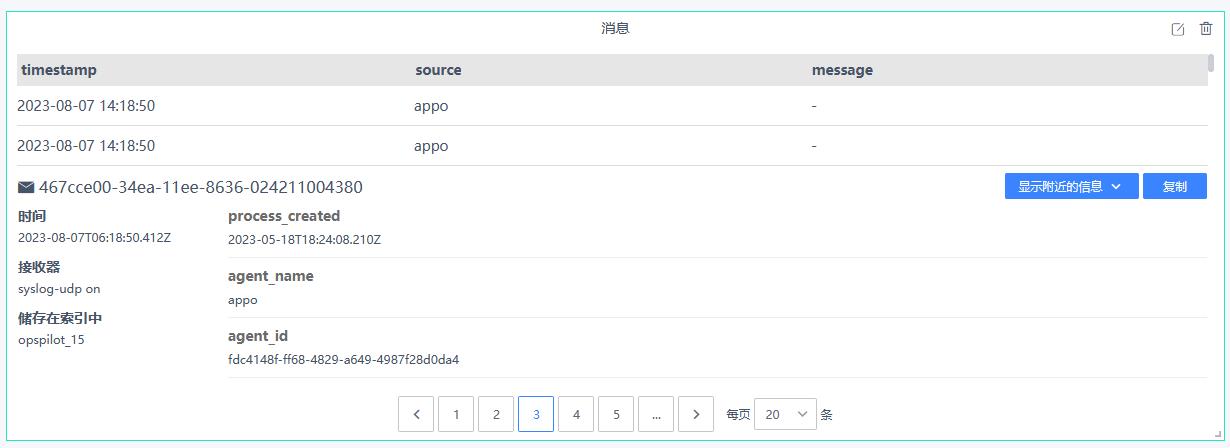

仪表盘-日志组件说明

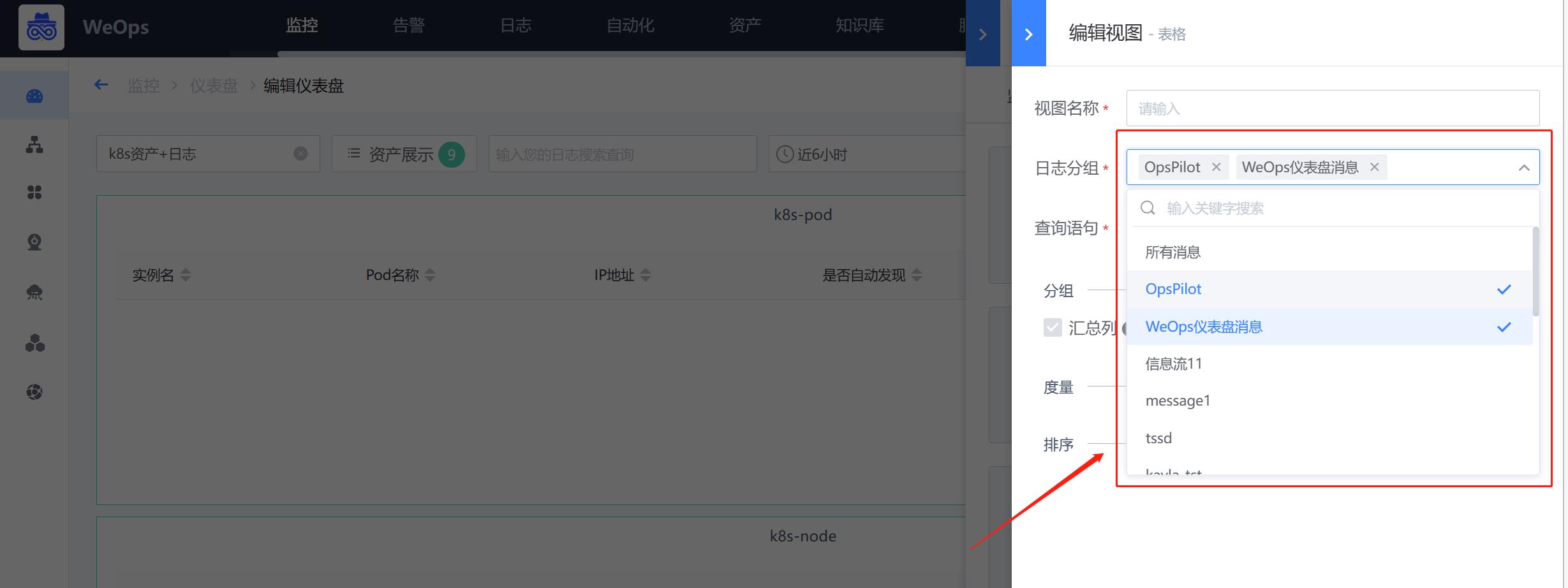

- 日志——日志消息:支持配置展示日志的原始消息情况,可配置搜索条件、展示字段等信息

- 日志——表格:支持配置对日志的原始消息进行统计,并呈现在表格中,可配置搜索条件、分组条件、度量(分组的统计度量值)、排序等操作

- 日志——单值:展示单个数值或统计结果,最近数据的第一个值

- 日志-饼形图/柱状图/折线图:以不同的形式展示各个分组的度量值的情况,比如百分比、趋势等。

- 日志-饼形图/柱状图/折线图:以不同的形式展示各个分组的度量值的情况,比如百分比、趋势等。

- 日志—地图组件:支持中国地图和世界地图,选择ip地区分布字段,呈现IP地址地区分布情况,可设置不同数量的阈值。

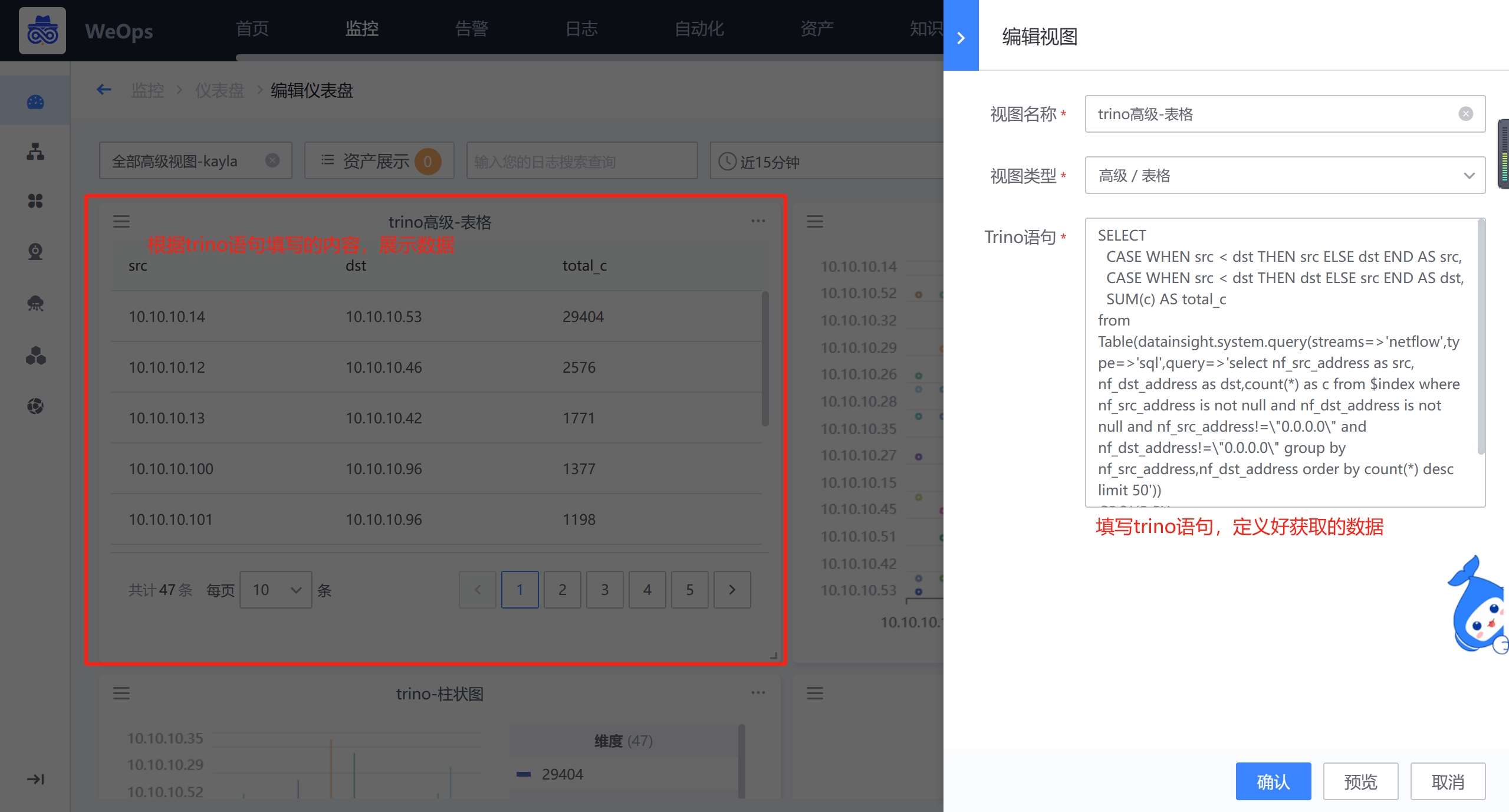

仪表盘-高级组件说明

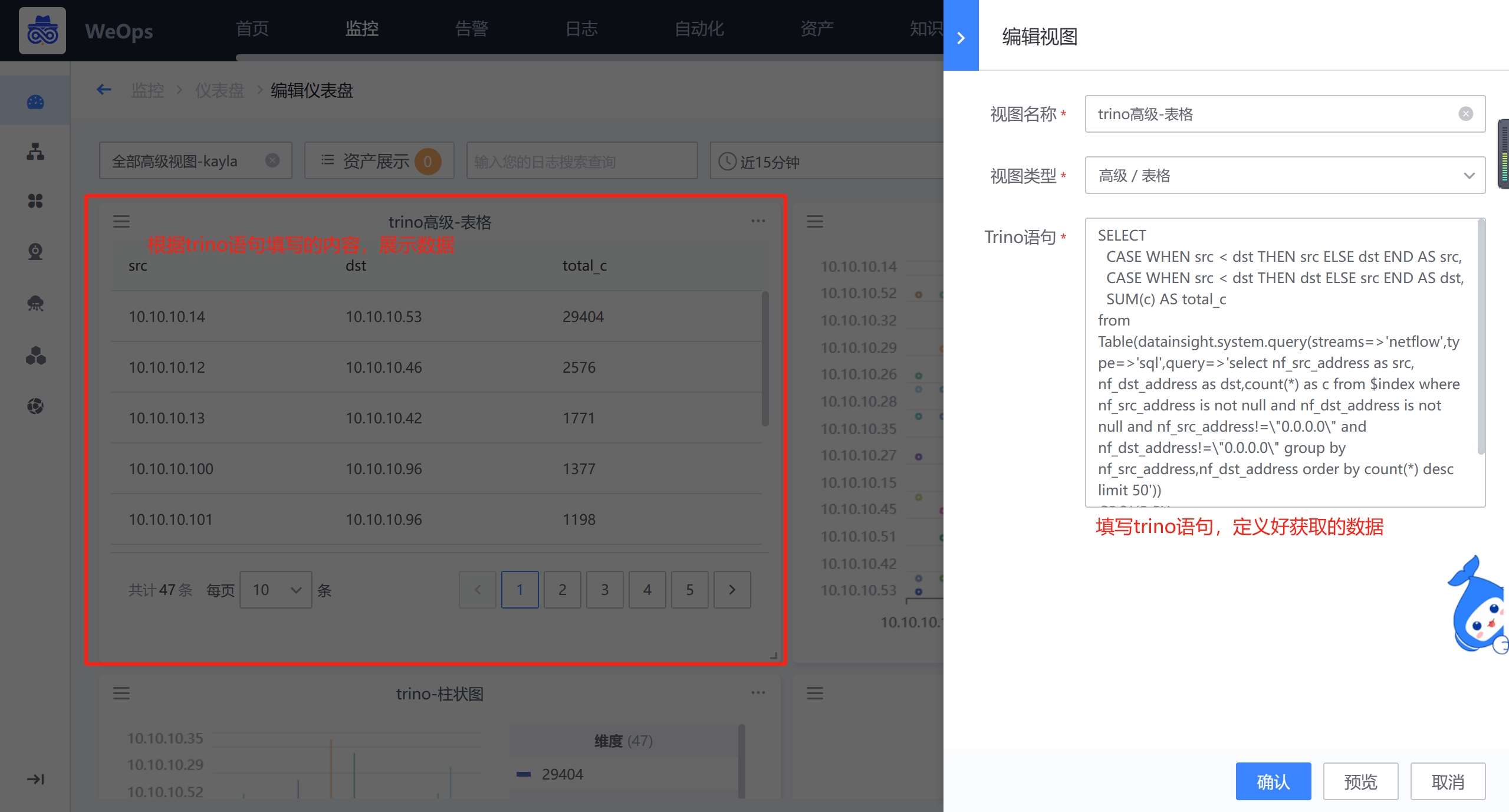

表格/单值

高级组件的表格和单值只需要填写Trino语句,在Trino中定义好需要获取的数据,就会以表格/单值的形式呈现

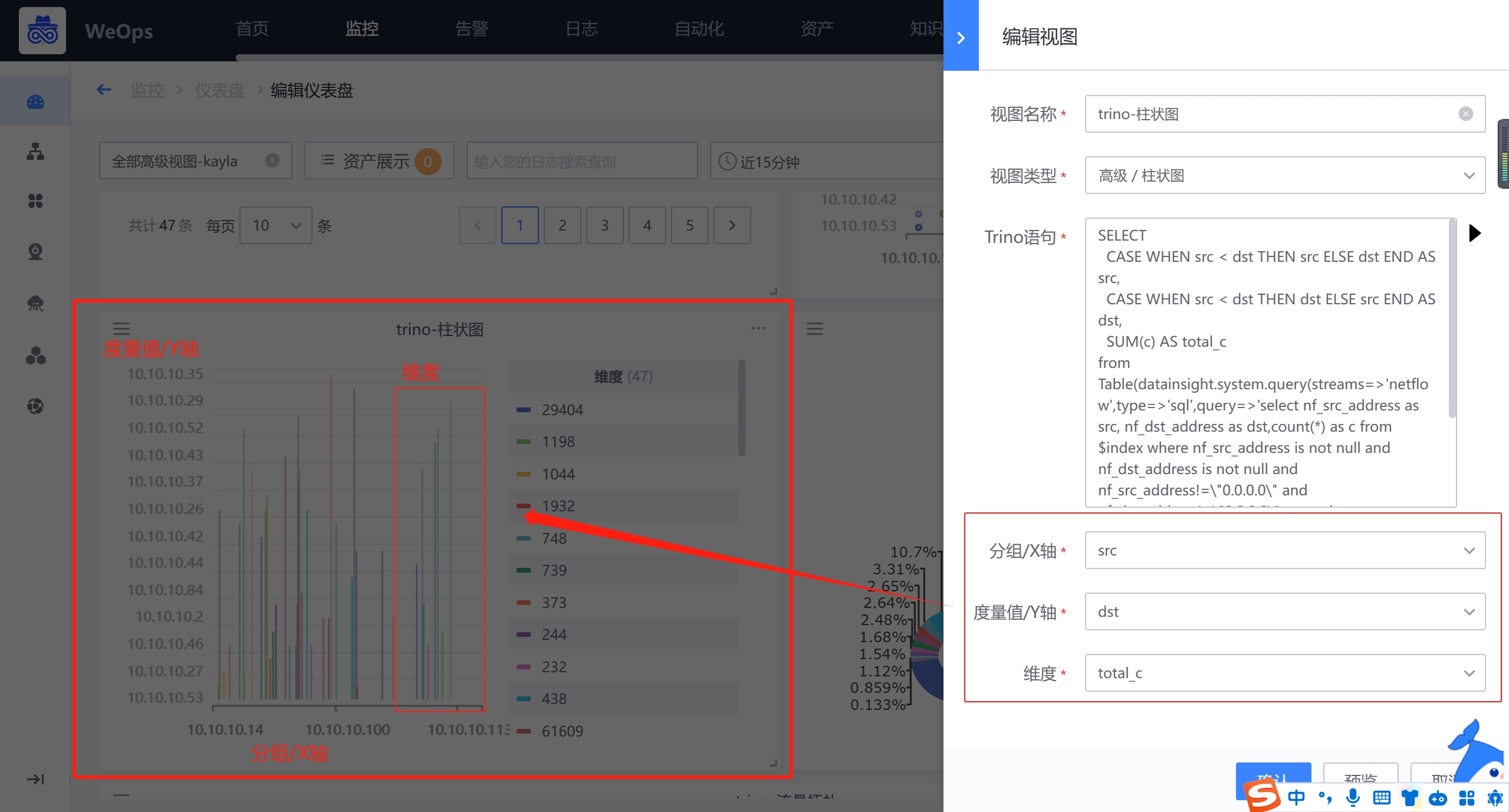

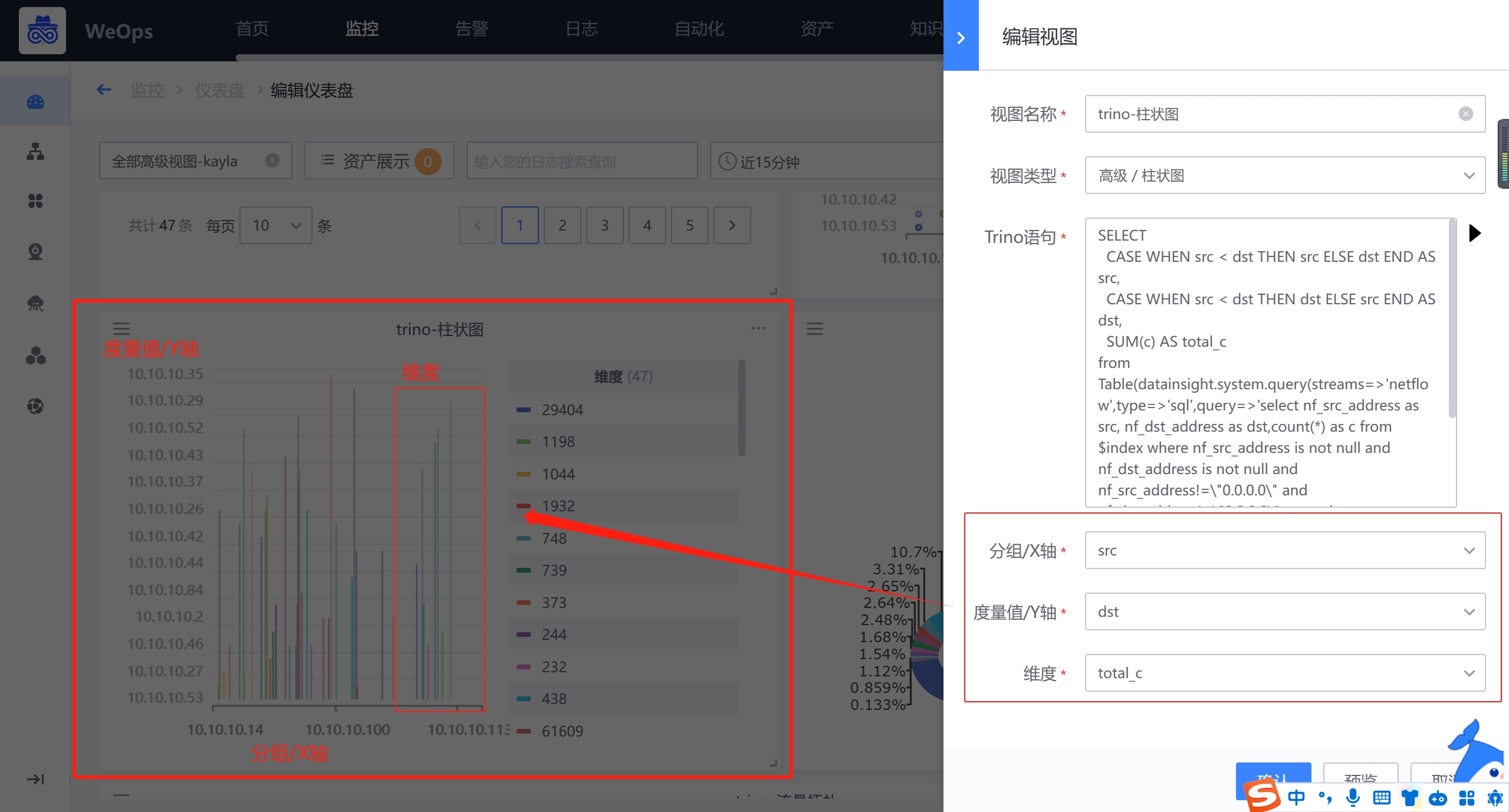

折线图/柱状图

高级组件的折线图和柱状图主要展示各个分组的变化情况,需要填写Trino语句,点击执行从Trino语句获取返回字段,选择成为分组/X轴,度量/Y轴和维度信息,以便使用

分组/X轴:就是类别,为折线图和柱状图的X轴,呈现各个分组情况。比如告警的所属应用,每个应用就是一个分组。

度量/Y轴:就是数值,为折线图和柱状图的Y轴,展示各个分组的具体的值的情况。比如告警的处理时长,展示每个应用的告警处理时长。

维度:当分组的数值有多种情况时,需要选择展示维度,比如告警区分优先级,需要分开展示每个应用致命/预警/提醒三个等级的处理时长

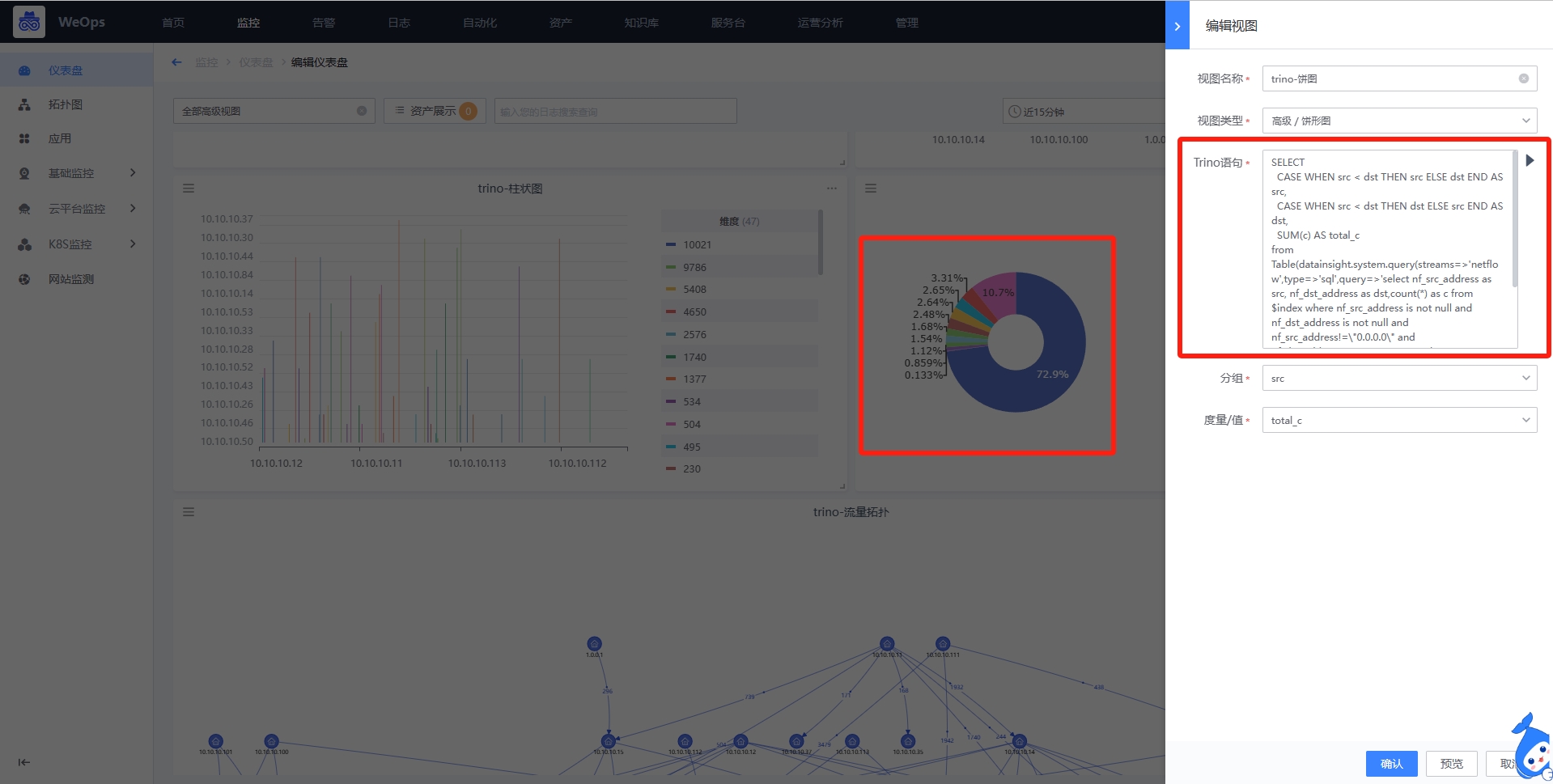

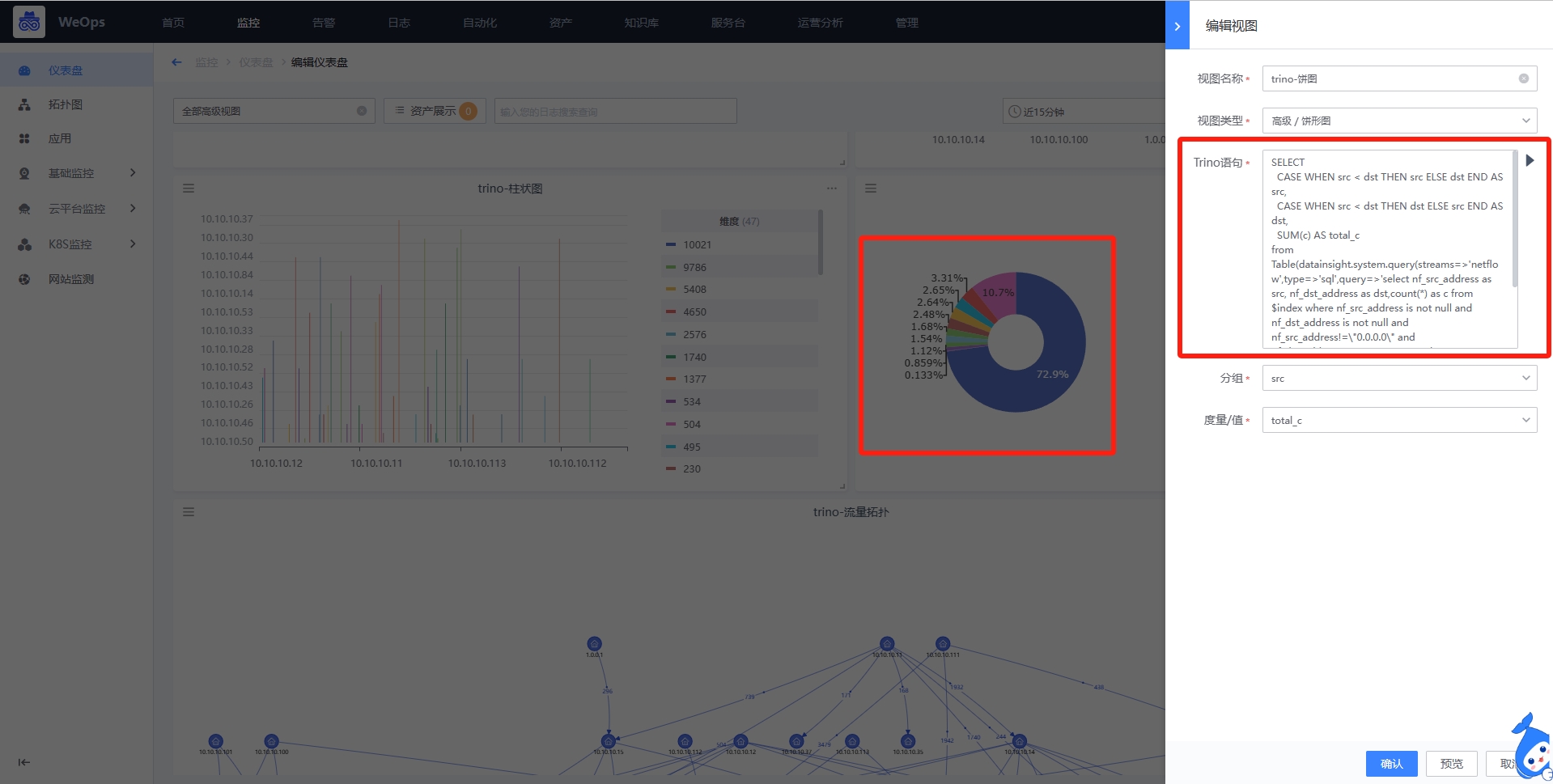

饼形图

高级组件的饼形图主要展示各个类别的百分比,需要填写Trino语句,点击执行从Trino语句获取返回字段,并且选择成为分组、度量值。

分组:就是类别,呈现各个分组情况,饼形图的每一块就是一个分组。比如分组是IP地址

度量值:就是数值,展示各个分组的具体的值的百分比情况,比如数值是IP地址的数量,则饼形图则表示所有IP地址数量的百分比。

流量拓扑图

高级组件的流量拓扑图主要展示源和目标直接的流向关系,需要填写Trino语句,点击执行从Trino语句获取返回字段,并选择为源对象、目标对象,以及连线上的数值

源对象:即开始的对象,比如网络五元组中的源IP

目标对象:结束的对象,比如网络五元组中的目标IP

连线数值:连线上面的数值(从源到目标的数值),比如从源IP到目标IP直接响应时长的数值等

桑基图

高级组件的桑基图主要展示源和目标直接的流量大小情况,需要填写Trino语句,点击执行从Trino语句获取返回字段,并选择为源对象、目标对象,以及度量值

源对象:即开始的对象,比如网络五元组中的源IP

目标对象:结束的对象,比如网络五元组中的目标IP

度量值:度量值决定了连线的宽窄,越宽说明流量/数值越大

仪表盘高级组件的详细介绍步骤详见《操作手册-6、其他设置-仪表盘高级组件配置》

- 目前,所有仪表盘内置的组件说明如下

| 所属模块 | 组件名称 | 作用 | 支持的配置 |

|---|---|---|---|

| 监控 | 仪表盘 | 展示指定时间范围内,该监控指标的最近数值 | 1、配置需要展示的监控指标 2、可以根据选择的维度汇聚方式展示“最大值”“最小值”“平均值”“累加值”“维度数量” 3、支持配置仪表盘展示的最大值/最小值,支持选择各个阈值的配色 |

| 监控 | 单值 | 展示指定时间范围内,该监控指标的最近数值 | 1、配置需要展示的监控指标 2、可以根据选择的维度汇聚方式展示“最大值”“最小值”“平均值”“累加值”“维度数量” |

| 监控 | 饼形图 | 指定时间范围内,该监控指标的最近数值,每个饼状图代表一项资产,若有多维度则展示百分比 | 1、配置需要展示的监控指标 |

| 监控 | 柱状图 | 展示指定时间范围内,该监控指标的最近数值;柱状图的每一簇代表一项资产,若资产有多维度,则展示多条 | 1、配置需要展示的监控指标 |

| 监控 | 折线图 | 以时间为横坐标展示指定时间内该监控指标的数值变化,多资产和多维度都在用一个折线图中展示 | 1、配置需要展示的监控指标 2、支持配置阈值线 3、支持配置是否面积填充 |

| 监控 | 水位图 | 展示指定时间范围内,该监控指标的最近数值 | 1、配置需要展示的监控指标 2、可以根据选择的维度汇聚方式展示“最大值”“最小值”“平均值”“累加值”“维度数量” 3、支持选择各个阈值的配色 |

| 监控 | 排行图 | 展示指定时间范围内,多个资产监控指标的数值的排行情况 | 1、配置需要展示的监控指标 2、可以选择展示“最大值”“最小值”“平均值”“累加值” |

| 资产 | 资产表格 | 展示选中的资产基本配置信息 | 1、支持配置所有资产管理的资产 2、支持选择展示的字段 3、对于枚举型字段等特殊字段,支持筛选/排序等操作 |

| 自动化 | 运维工具 | 展示/执行各个运维工具 | 1、配置展示不同的运维工具 2、在仪表盘直接使用该工具对选中的资产进行操作,并展示执行结果 |

| 日志 | 日志消息 | 展示日志的原始消息 | 1、配置搜索条件 2、配置展示字段 3、支持配置某个字段的升序/降序 |

| 日志 | 单值 | 展示单个数值或统计结果,最近数据的第一个值 | 1、配置分组和度量,确定统计的角度和值 2、设置趋势:越大越好、越小越好,普通 |

| 日志 | 表格 | 以表格的形式展示各个分组的度量统计数值 | 1、配置搜索语句 2、配置分组和度量,确定统计的角度和值 3、配置排序,分组和度量的字段可以设置排序 |

| 日志 | 饼形图 | 按照特定度量字段,统计各个分组该度量值所占的百分比 | 1、配置搜索语句 2、配置分组和度量,确定统计的角度和值 3、配置排序,分组和度量的字段可以设置排序 |

| 日志 | 折线图 | 用于展示统计数据的变化趋势,比如随时间的变化趋势 | 1、配置搜索语句 2、配置分组和度量,确定统计的角度和值 3、配置排序,分组和度量的字段可以设置排序 |

| 日志 | 柱状图 | 以柱形图展示日志数据,展示各个分组的度量值 | 1、配置搜索语句 2、配置分组和度量,确定统计的角度和值 3、配置排序,分组和度量的字段可以设置排序 4、支持设置堆叠/分组模式 |

| 日志 | 地图 | 以地图的形式展示IP地址的地域分布情况 | 1、配置搜索语句 2、选择中国地图/世界地图 3、配置地域字段 4、支持阈值配色 |

| 高级 | 单值 | 填写Trino语句,获取对应数据后,以单值形式呈现 | 1、填写Trino语句 |

| 高级 | 折线图 | 填写Trino语句,获取对应数据后,以折线图形式呈现 | 1、填写Trino语句 2、配置X轴、Y轴展示的数值和维度数值 |

| 高级 | 饼形图 | 填写Trino语句,获取对应数据后,以饼形图形式呈现 | 1、填写Trino语句 2、配置分组(组别)和度量值 |

| 高级 | 柱状图 | 填写Trino语句,获取对应数据后,以柱状图形式呈现 | 1、填写Trino语句 2、配置X轴、Y轴展示的数值和维度数值 |

| 高级 | 表格 | 填写Trino语句,获取对应数据后,以表格形式呈现 | 1、填写Trino语句 |

| 高级 | 流量拓扑 | 填写Trino语句,获取对应数据后,以流量拓扑形式呈现 | 1、填写Trino语句 2、配置源对象和目标对象 3、配置连线数值和阈值配色 |

| 高级 | 桑基图 | 填写Trino语句,获取对应数据后,以桑基图形式呈现 | 1、填写Trino语句 2、配置源对象、目标对象和度量值 |

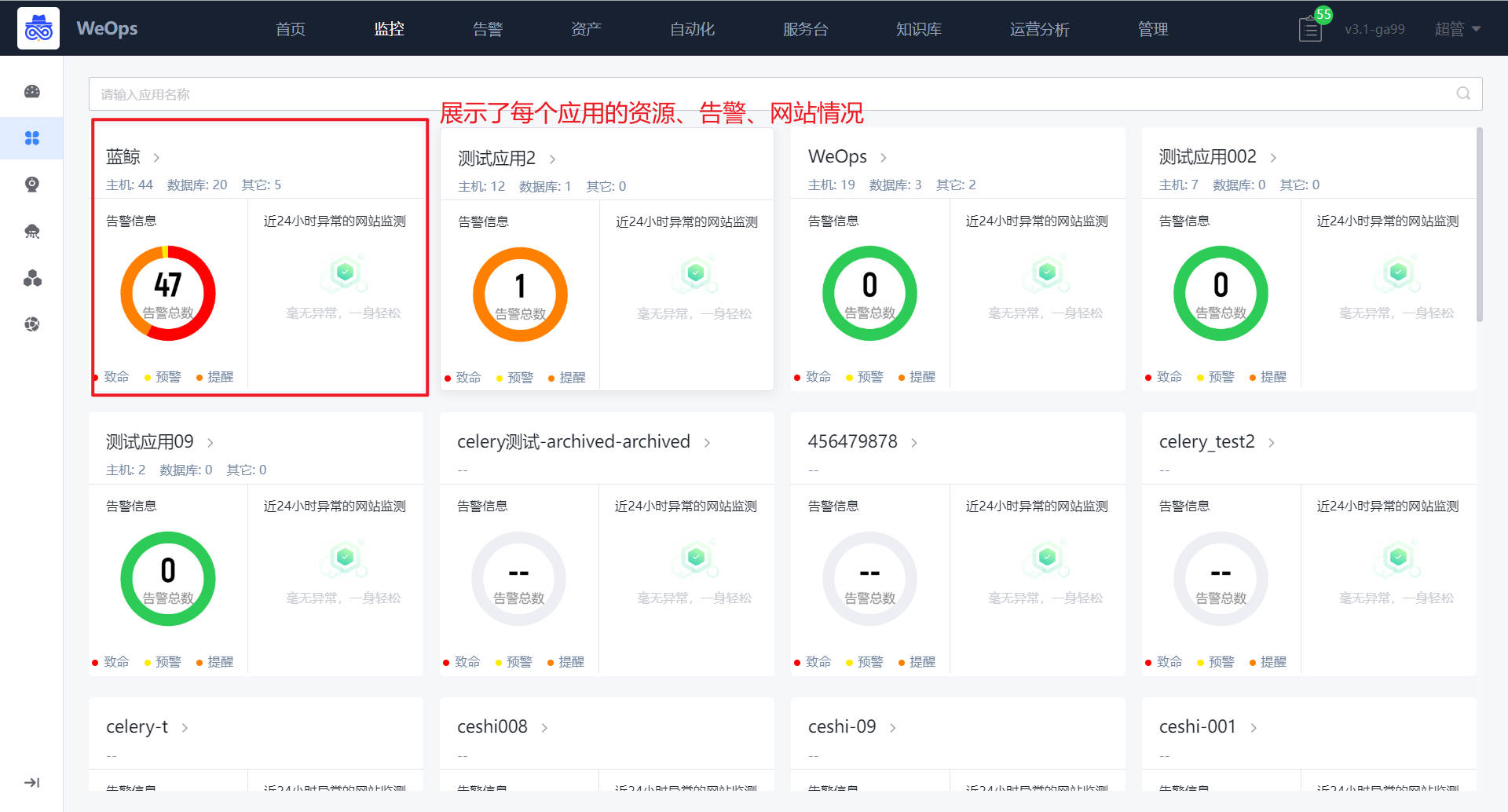

应用

“监控视图-应用”模块分为“总览页和详情页,总览页以应用卡片的形式展示了所有有权限应用的整体情况,包括该应用下资源情况、告警情况和异常网站情况。

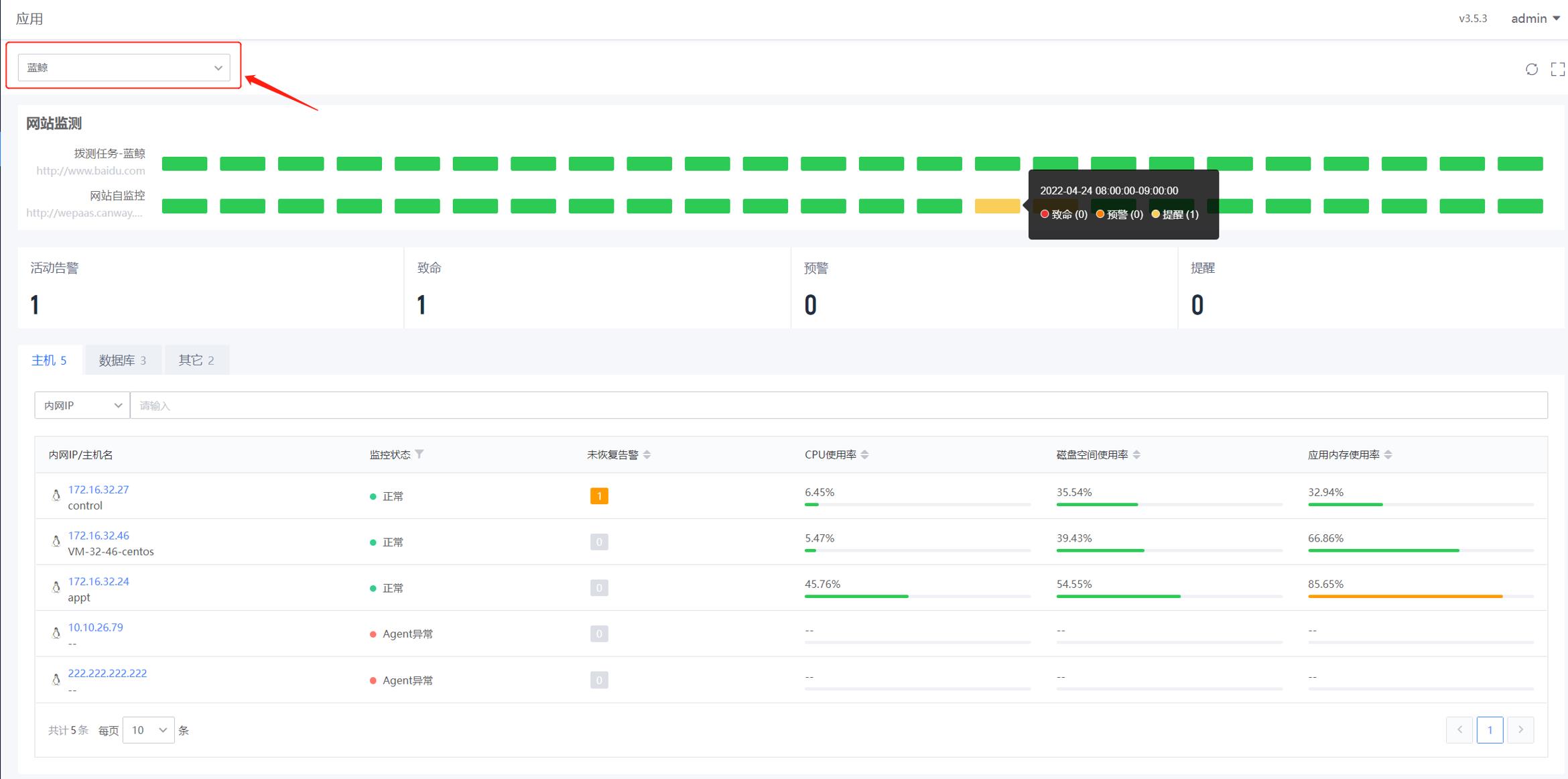

如下图,“监控视图-应用”的详情页,主要用于展示某应用下的网站监控情况、该应用下各个实例列表以及监控告警情况,在页面的左上角可以进行应用的切换。

- 网站监测: 展示该应用下的网站最近24个小时内的告警情况,以绿色表示该时间段无告警,黄色、橙色和红色表示该时间段存在的告警最大等级。

- 告警汇总概况:展示与该应用相关的实例/网站的活动告警数量汇总概览,可以点击查看不同等级的告警列表和详情。

- 实例列表:列出了该应用下的主机、数据库和其他实例的列表,可以在列表看到该实例的监控状态、未恢复告警、关键指标信息(比如CPU使用率,磁盘空间使用率、物理内存使用率),点击该实例可查看详细信息。

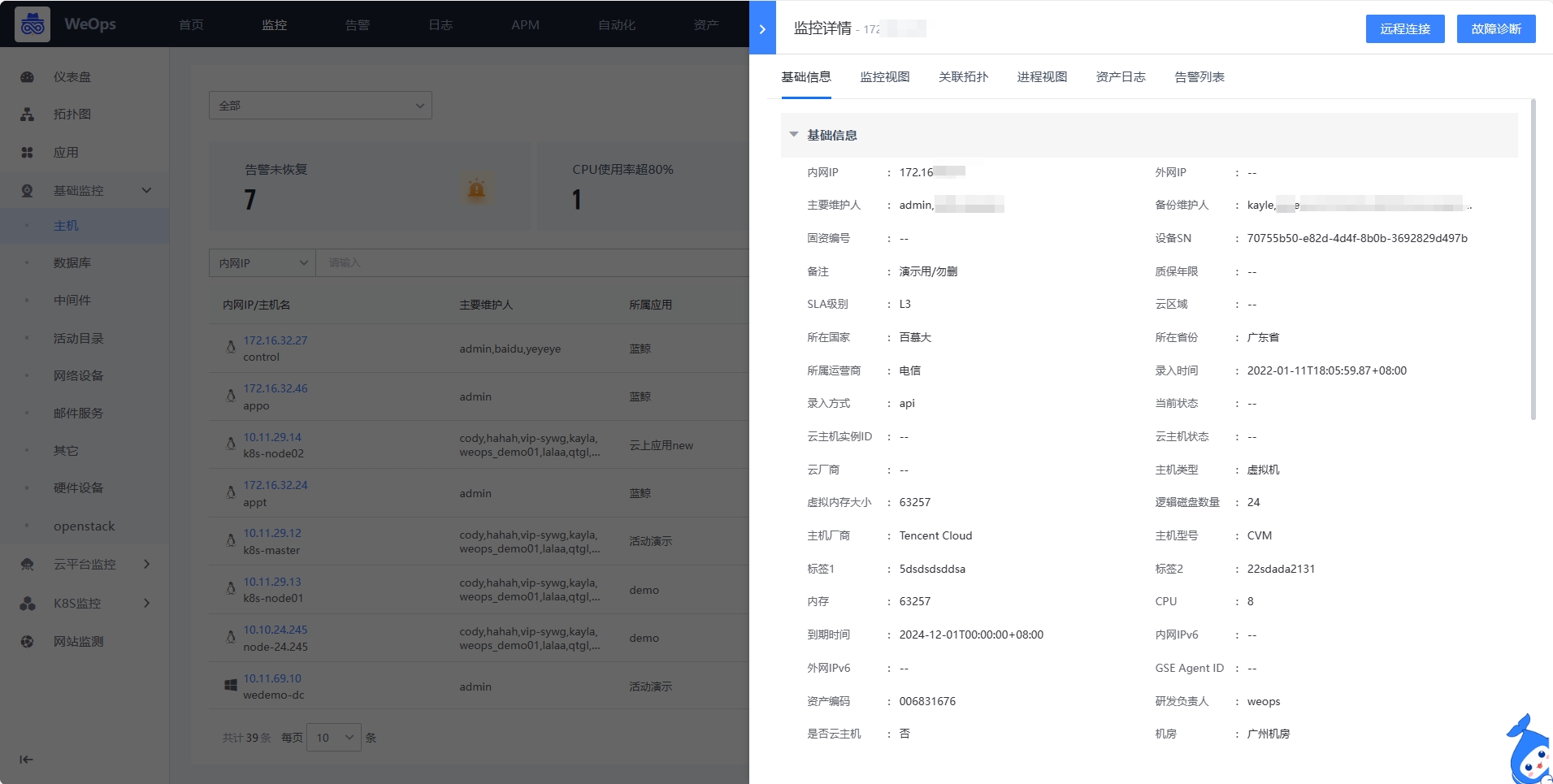

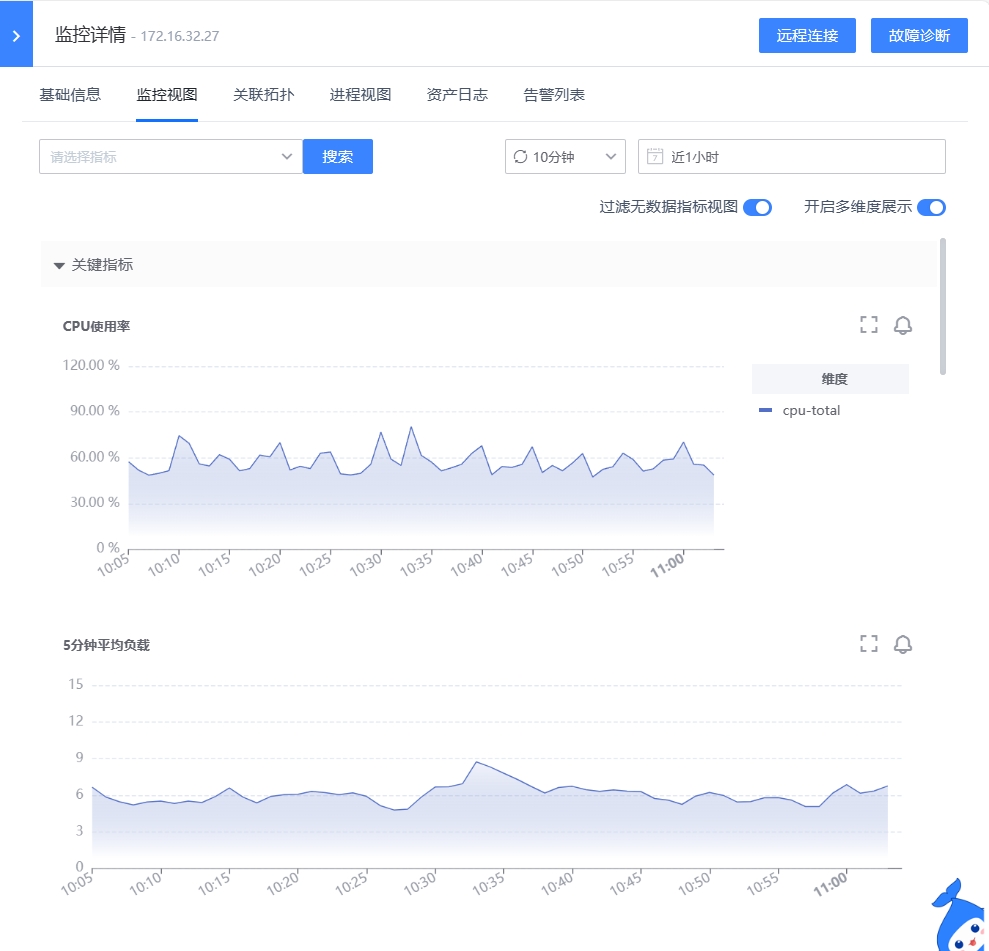

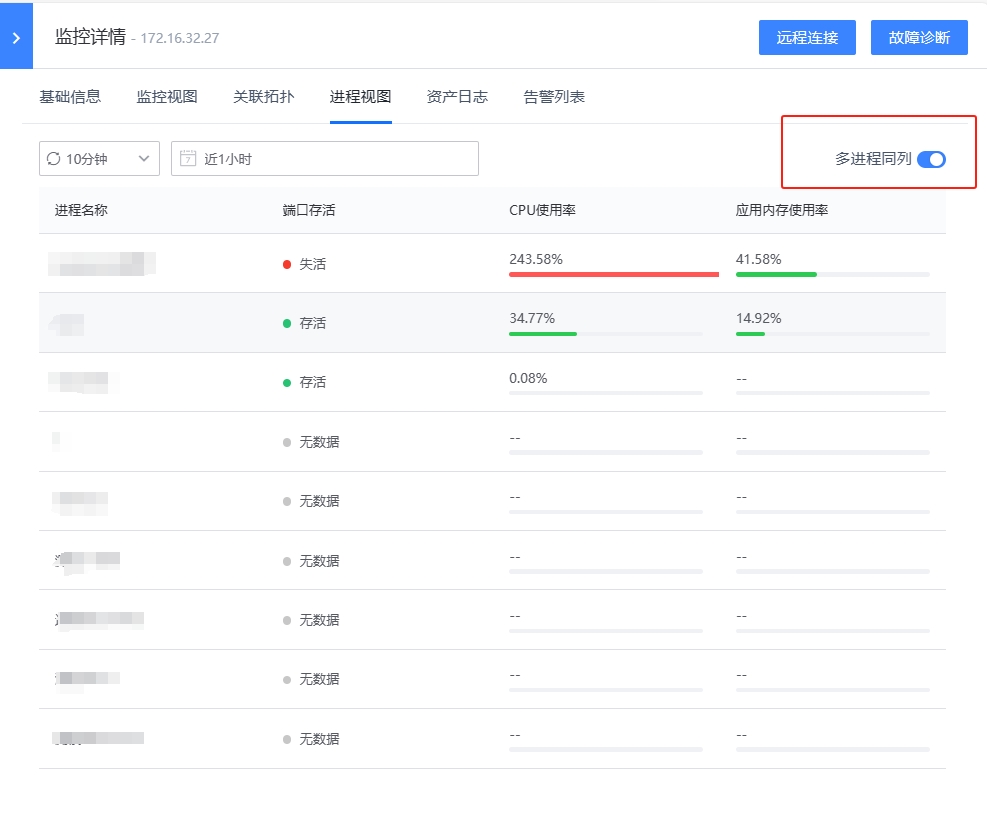

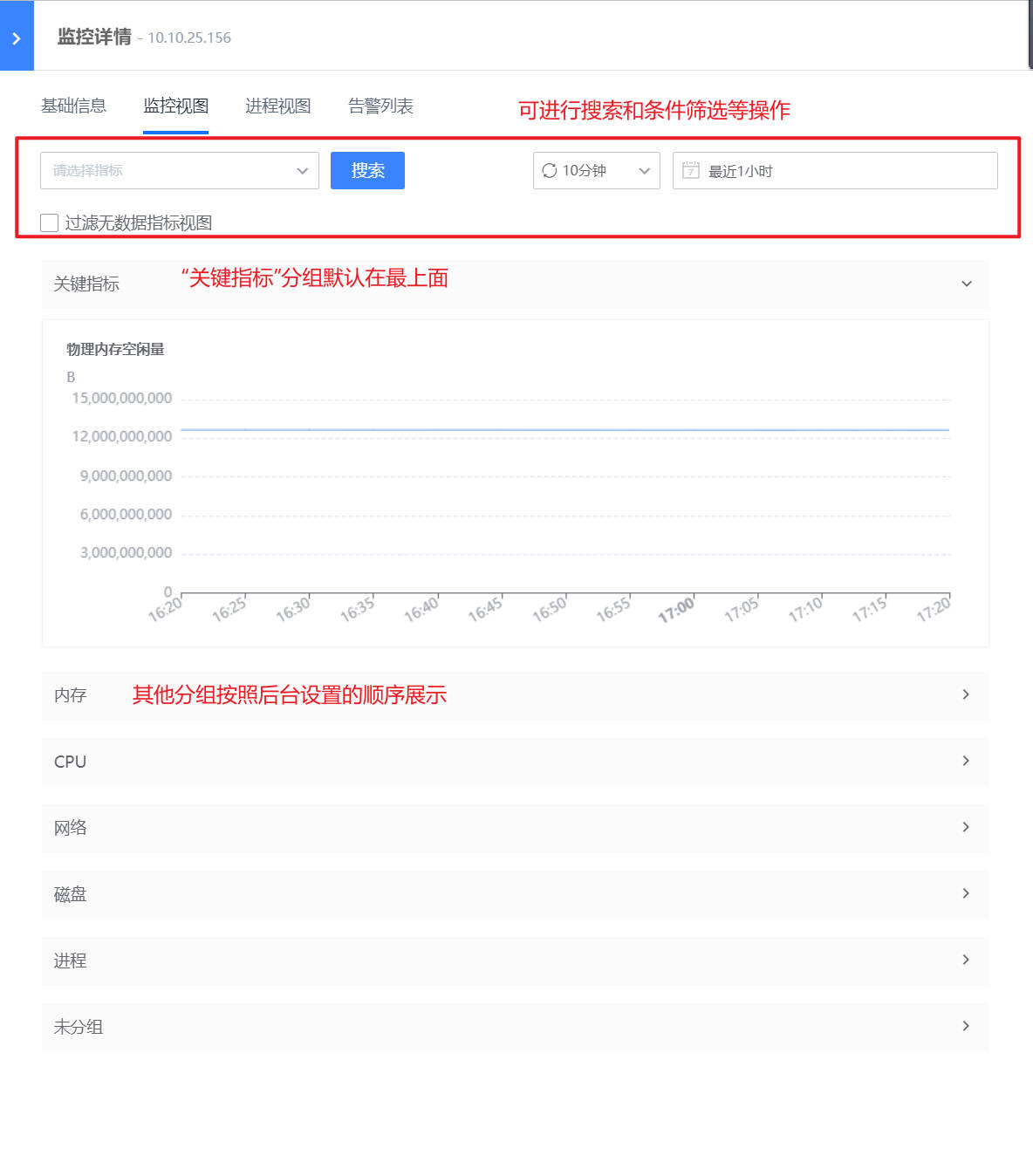

点击实例列表中的实例项,可查看该实例的详细信息, 以主机为例包括基础信息、监控视图、进程视图、关联拓扑、告警列表。

- 基础信息:展示该主机的基本信息,包括内网IP、操作系统、内存容量、磁盘容量等信息

- 监控视图:以分组的形式进行主机监控视图的展示,可以进行搜索等操作,灵活的选择需要的视图,此外设置了“关键指标”组,当某个指标设置为关键指标后,可在监控视图的最上方展示。(可在“WeOps-管理中心-监控管理-指标管理”中设置指标分组和关键指标)

- 进程视图:展示该主机相关的进程情况,分成两种展示方式:一是多进程在同一个表格展示,二是单个进程关键指标以折线图展示

- 关联拓扑:展示与该实例相关联的所有实例,可以点击查看关联实例详情

- 资产日志:通过“资产管理-数据关联”设置资产和日志的匹配规则,这里展示与该个资产相关联的所有的日志数据

- 告警列表:展示与该主机相关的活动告警和历史告警列表,可以点击查看各个告警项的详情,并进行处理。

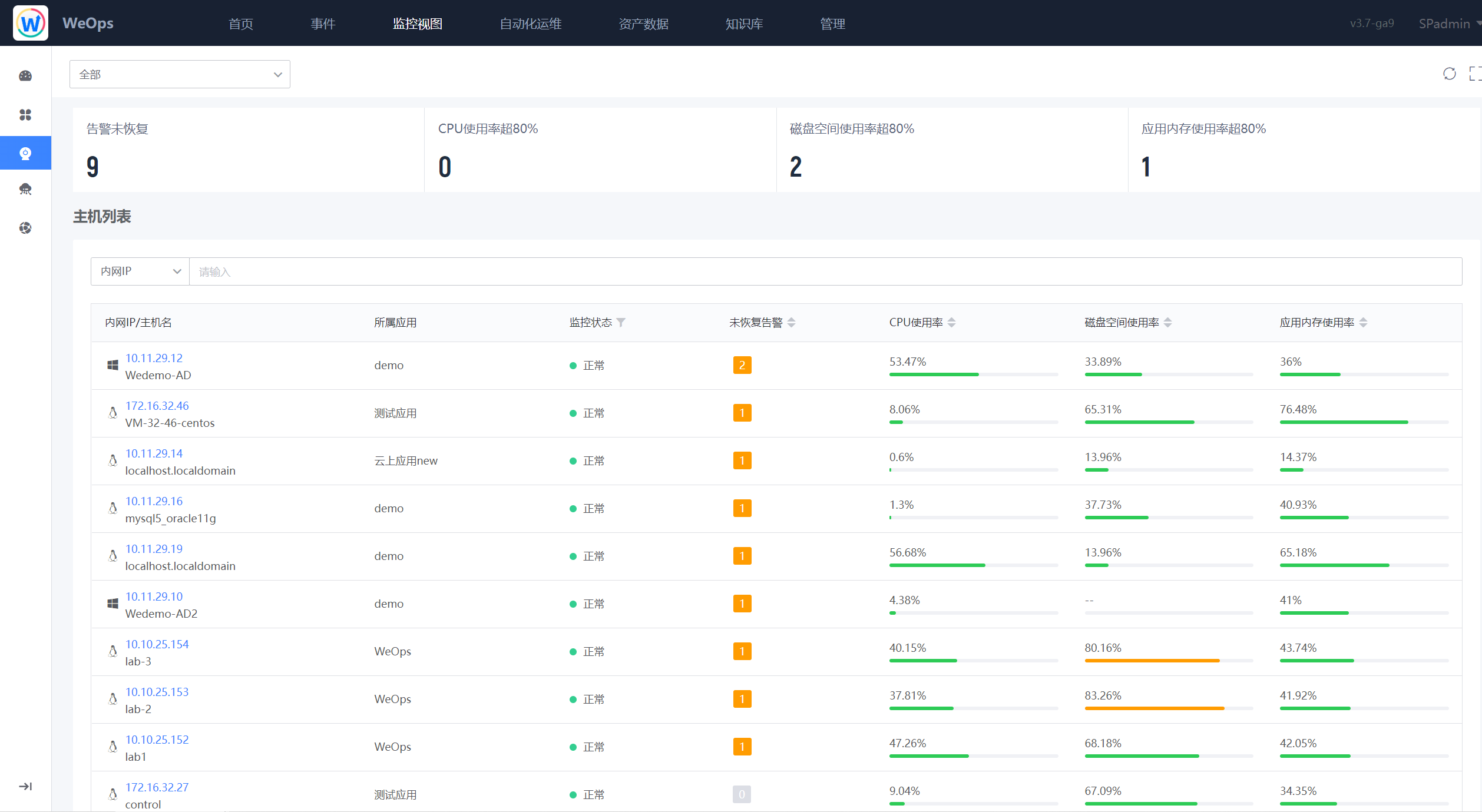

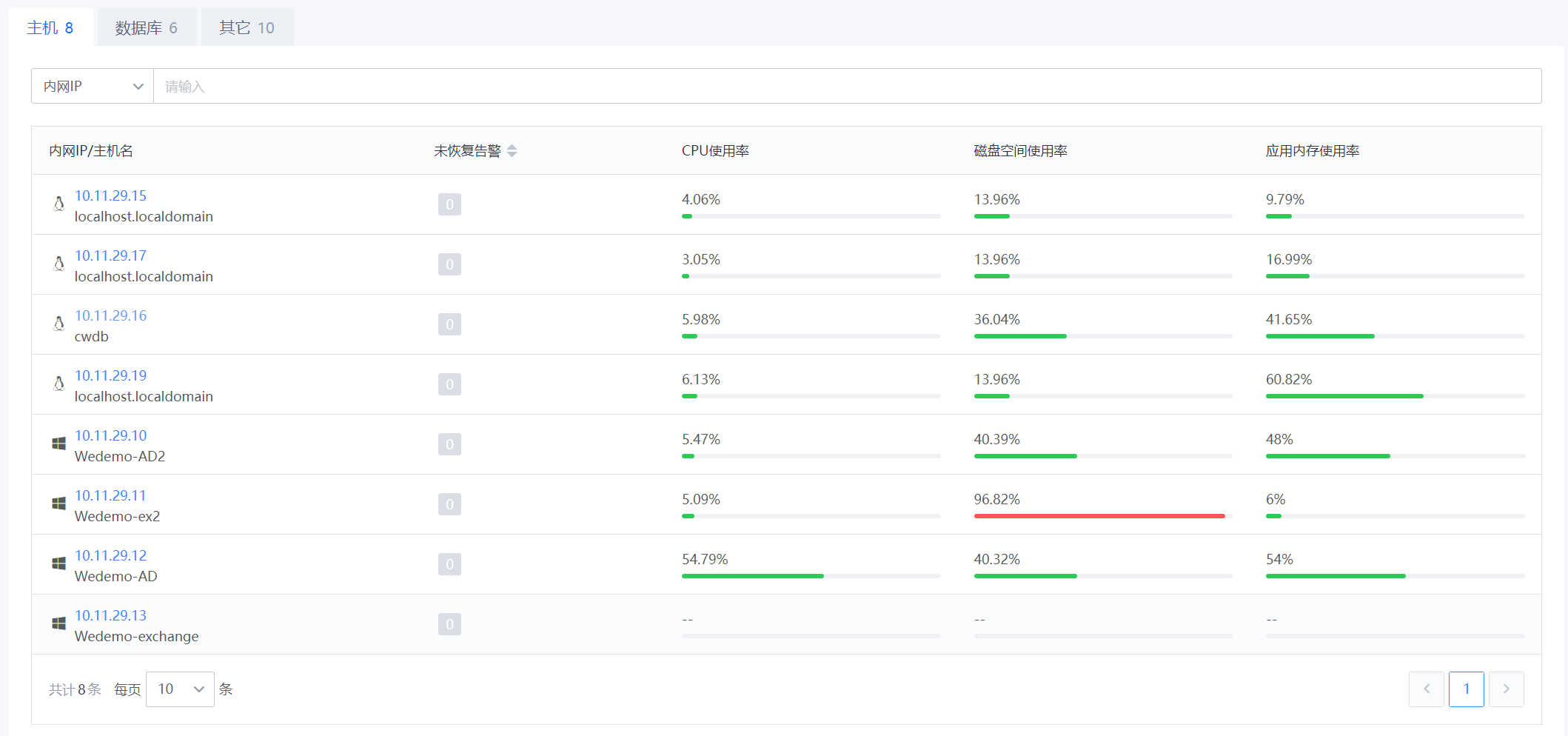

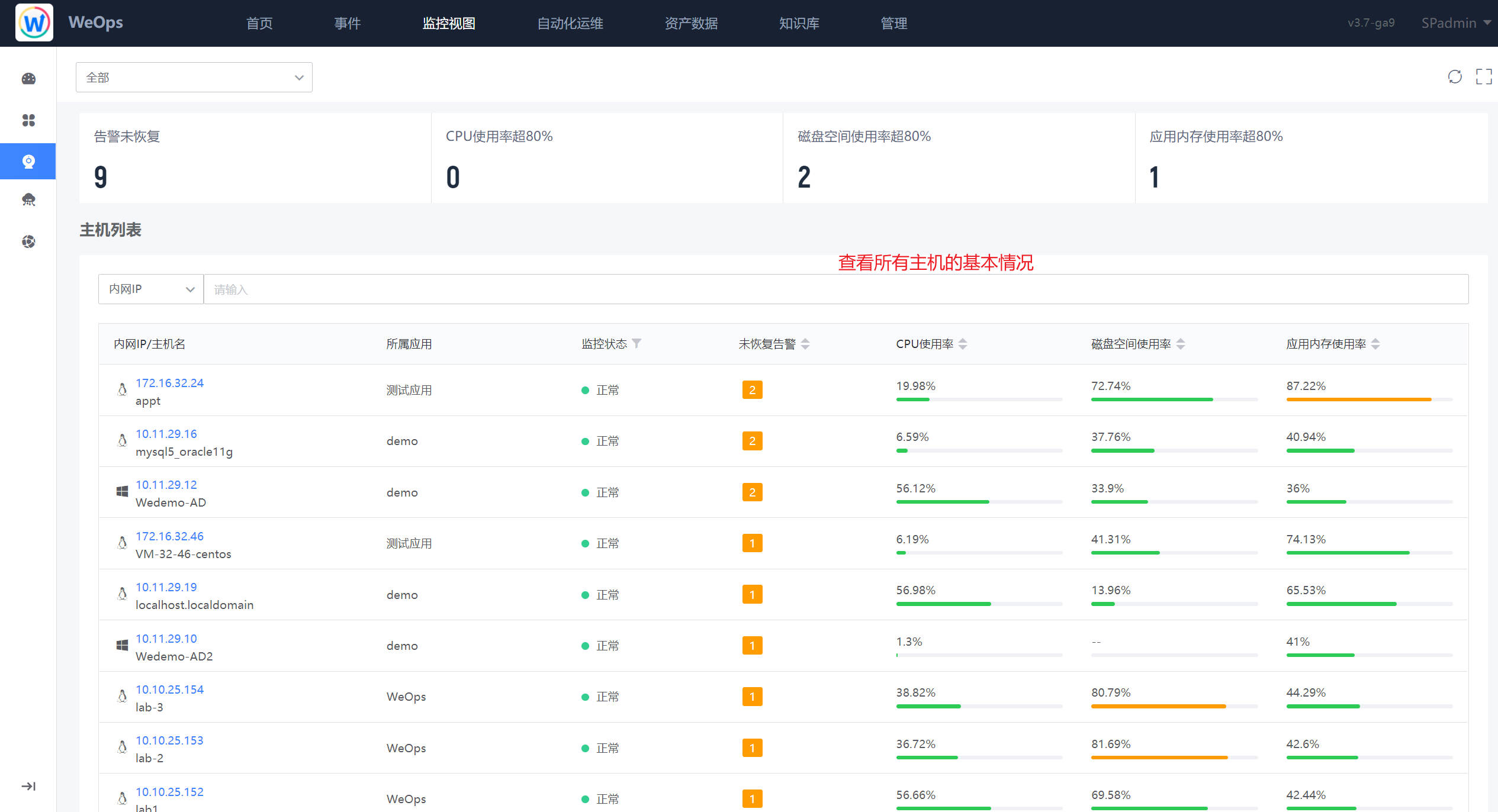

基础监控

主机

如下图,“监控视图-基础监控-主机”展示了所有的主机列表,包括监控告警状态、主机的关键指标信息等,点击各个主机可以跳转至该主机的详细信息抽屉,详情抽屉内容与“监控视图-应用”中的主机详情一致。

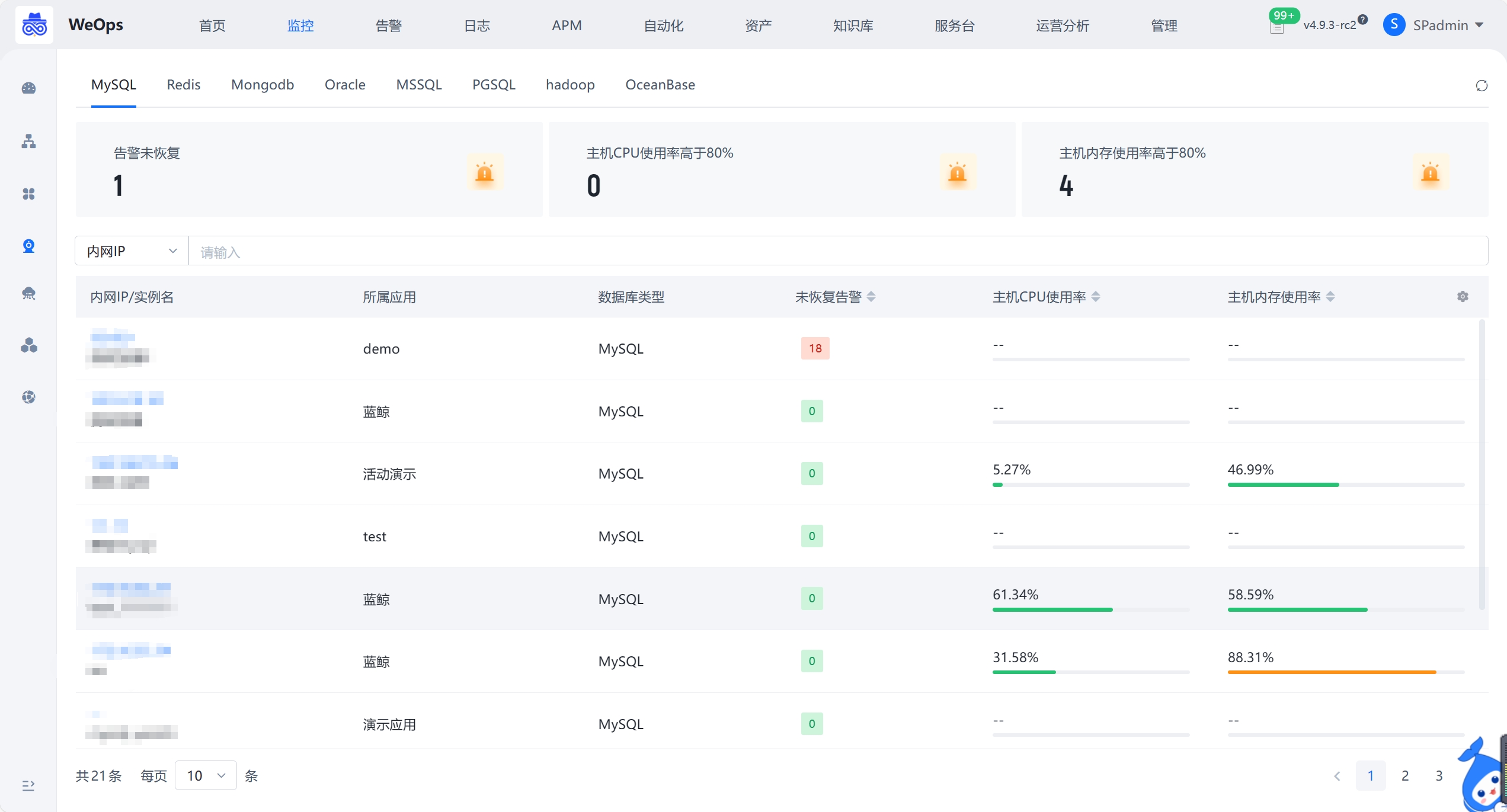

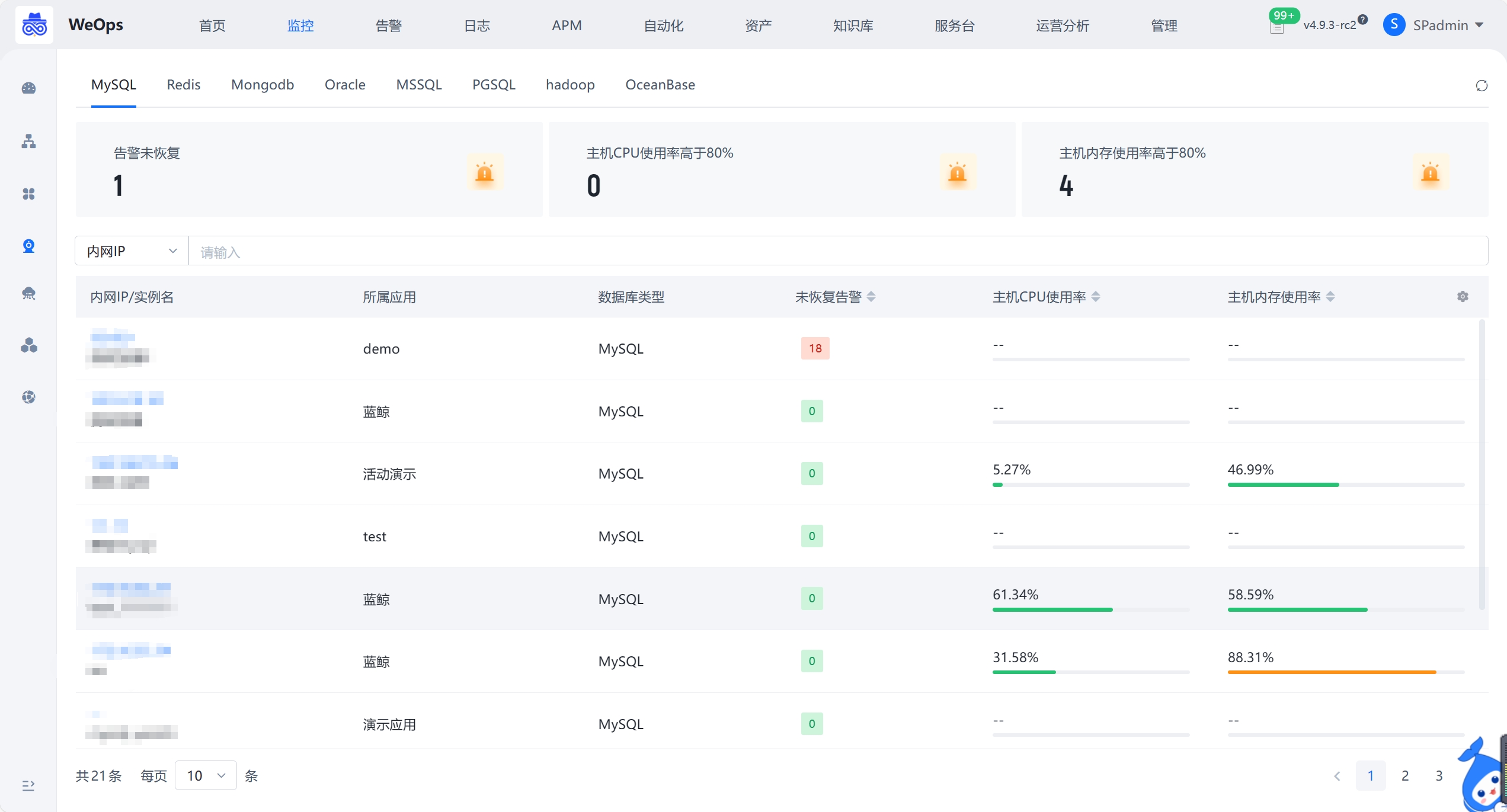

数据库

如下图,“监控视图-基础监控-数据库”展示了所有的数据库列表,包括数据库信息、监控告警状态、主机CPU使用率等,点击各个数据库可以跳转至该数据库的详细信息抽屉页。

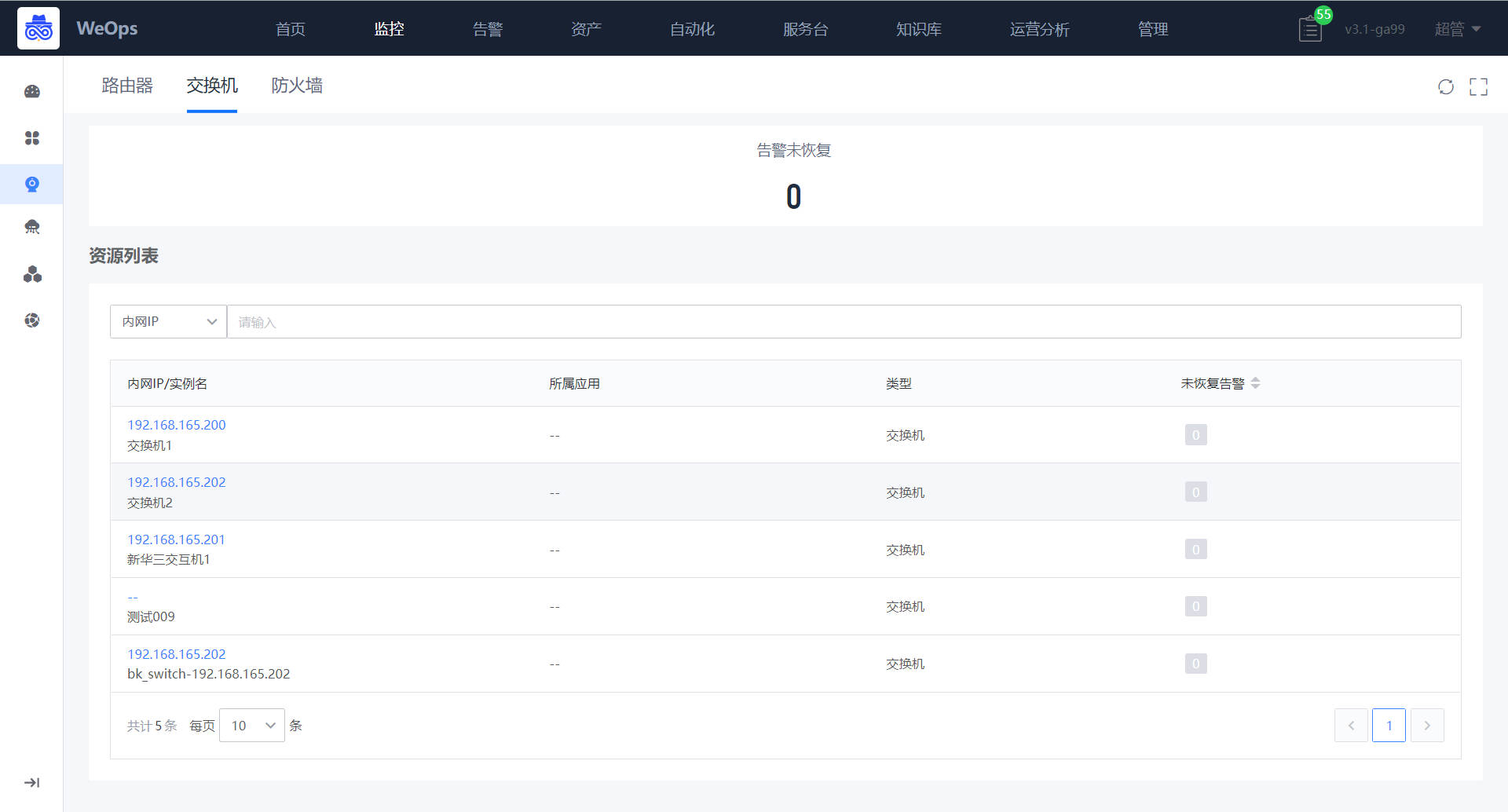

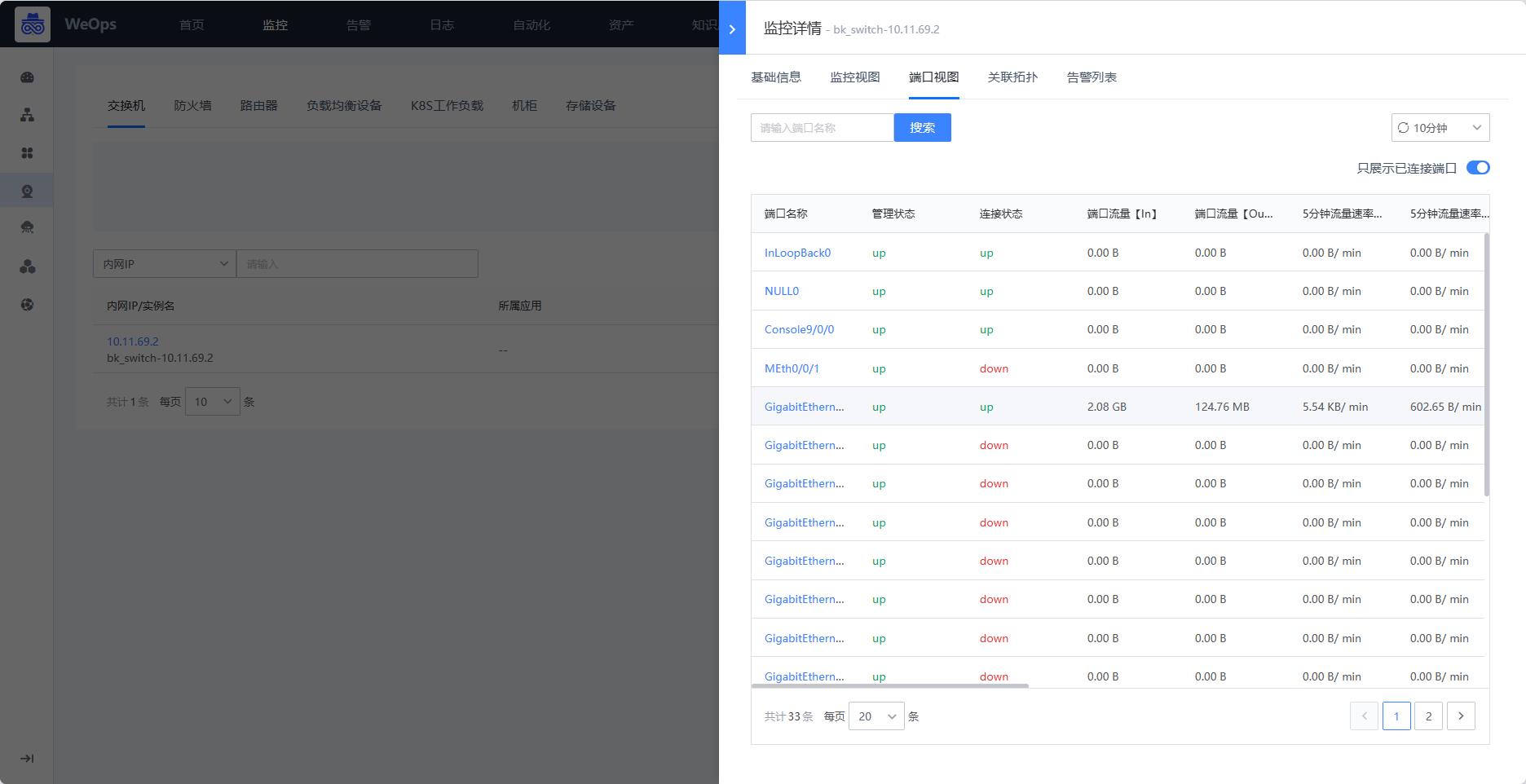

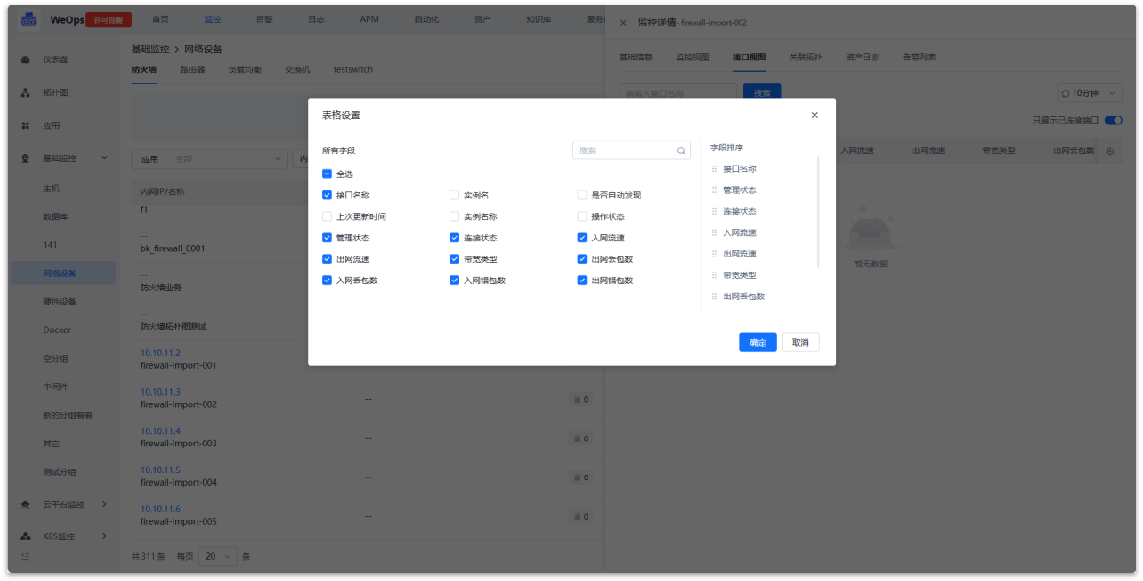

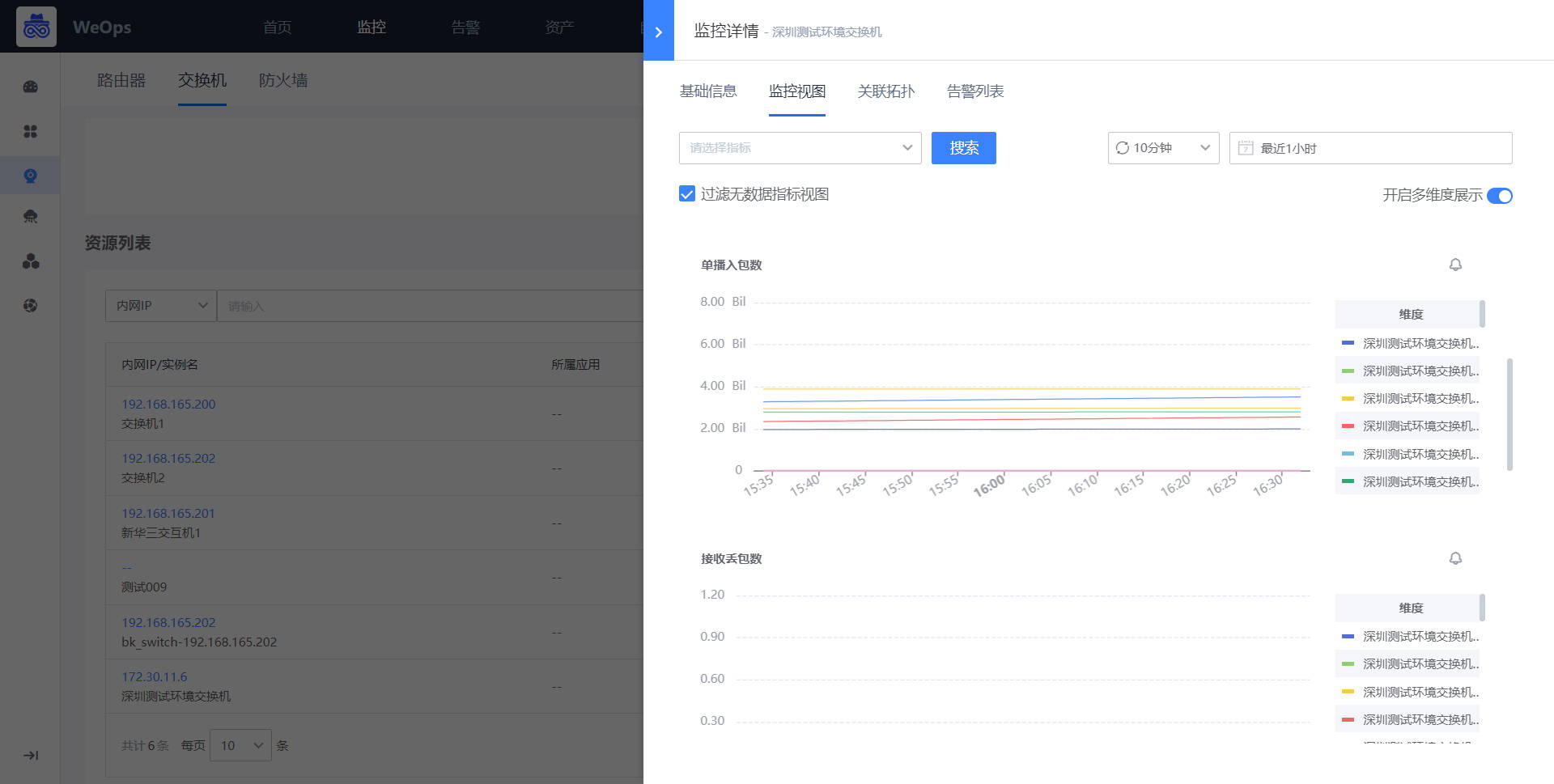

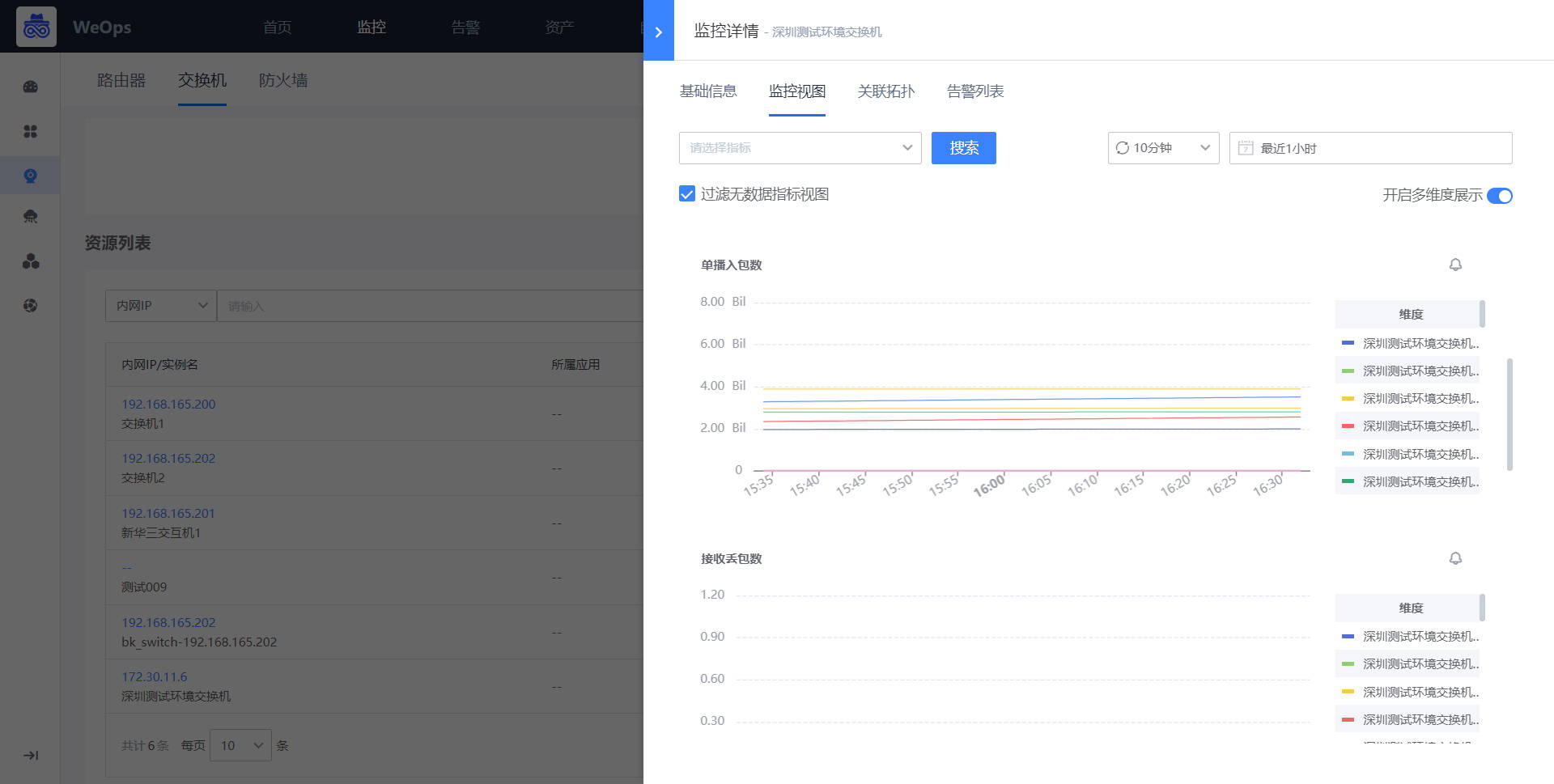

网络设备

- 如下图,“监控视图-基础监控-网络设备”展示了所有的网络设备列表,包括交换机、路由器、防火墙、负载均衡等,展示了网络设备的信息、监控告警状态、主机CPU使用率等,点击各个设备可以跳转至该设备的详细信息抽屉页。

- 点击网络设备,可查看网络设备的基本信息、监控视图、端口视图、告警列表等信息。

- 支持对接口监控视图进行配置,用户可以自由配置展示列表的表头字段。

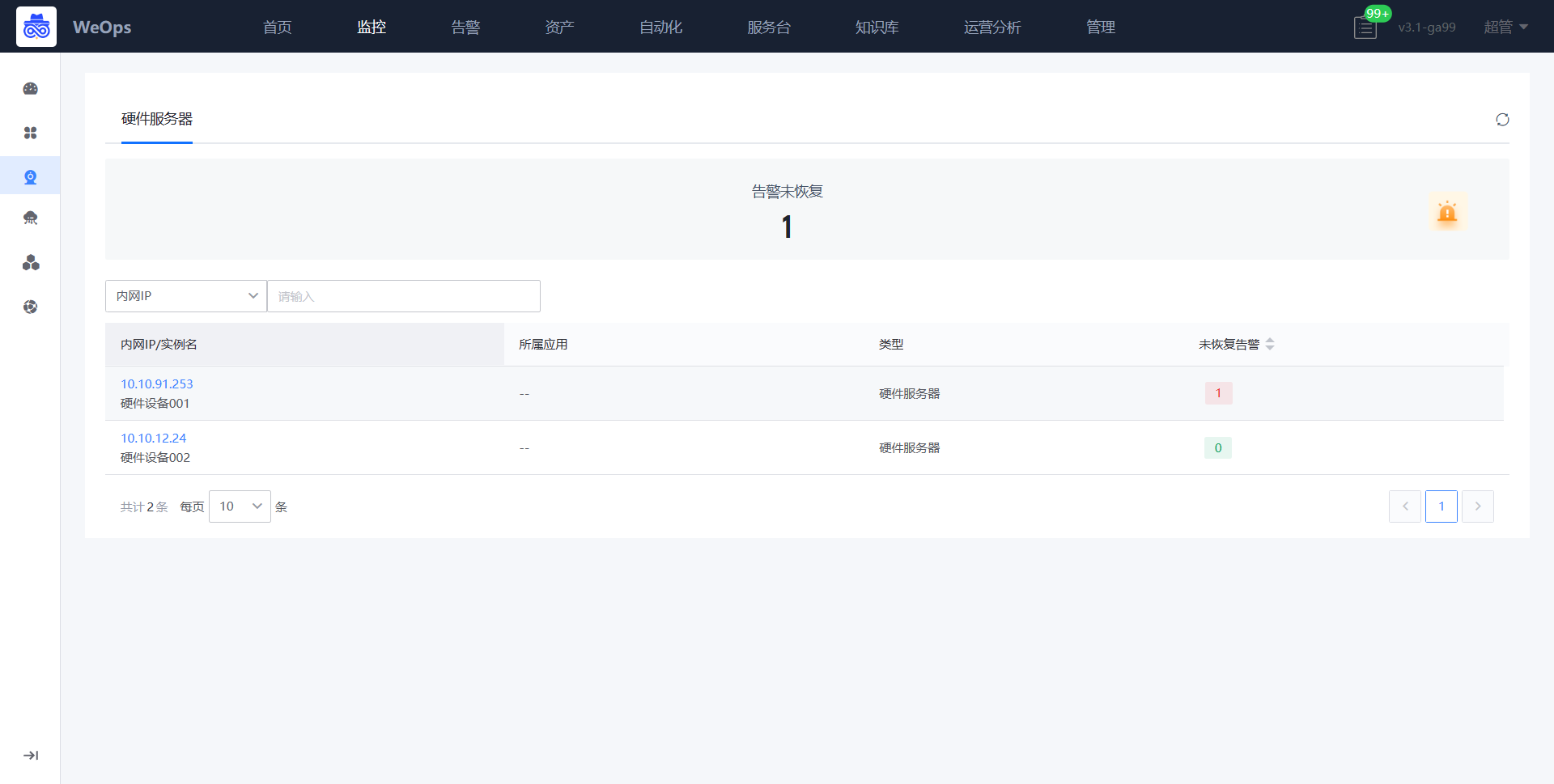

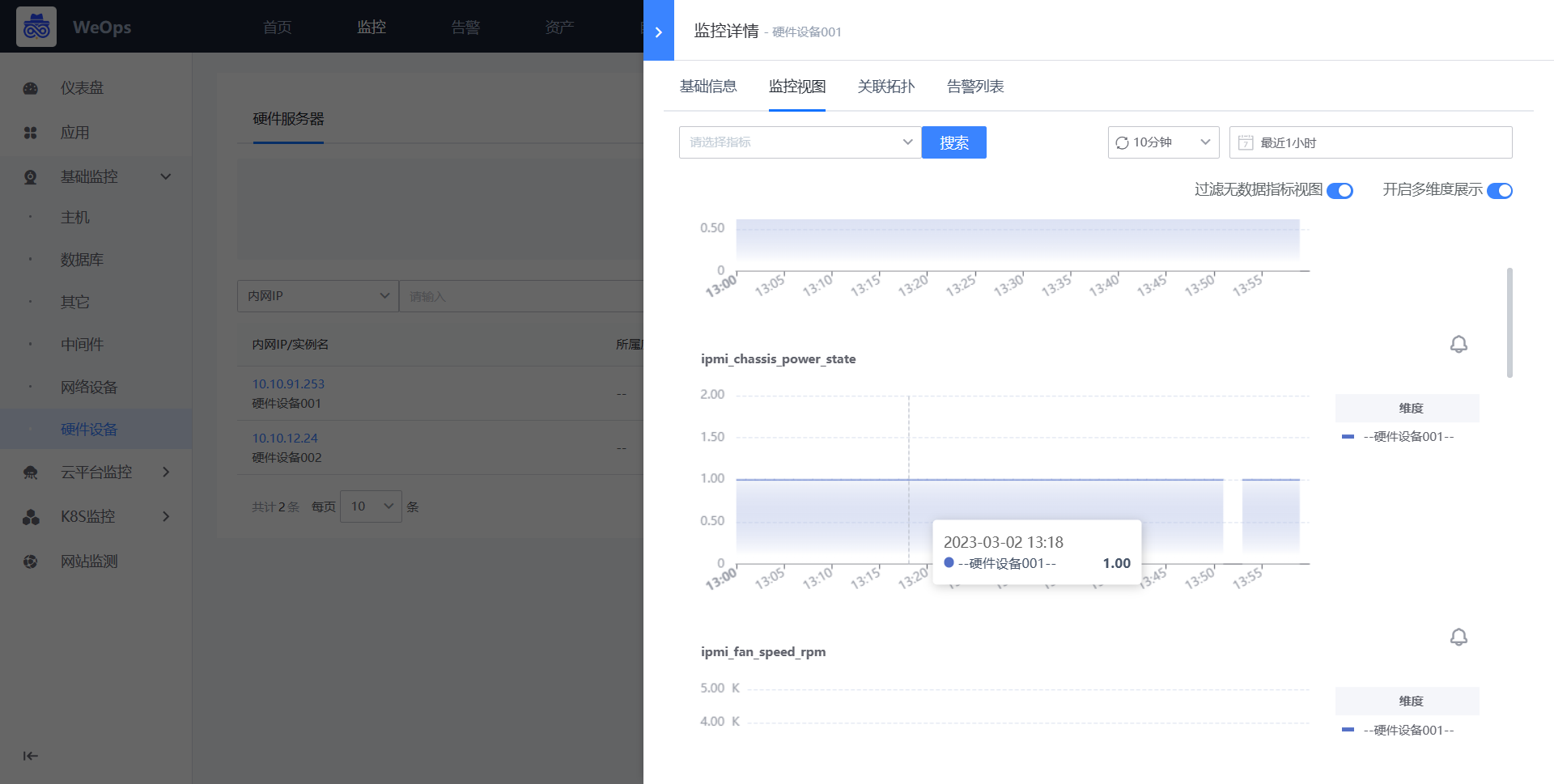

硬件设备

如下图,“监控视图-基础监控-硬件设备”展示了所有的硬件设备列表,展示了这些设备的信息、监控告警状态、主机CPU使用率等,点击各个设备可以跳转至该设备的详细信息抽屉页,展示了基本信息、监控视图、告警列表。

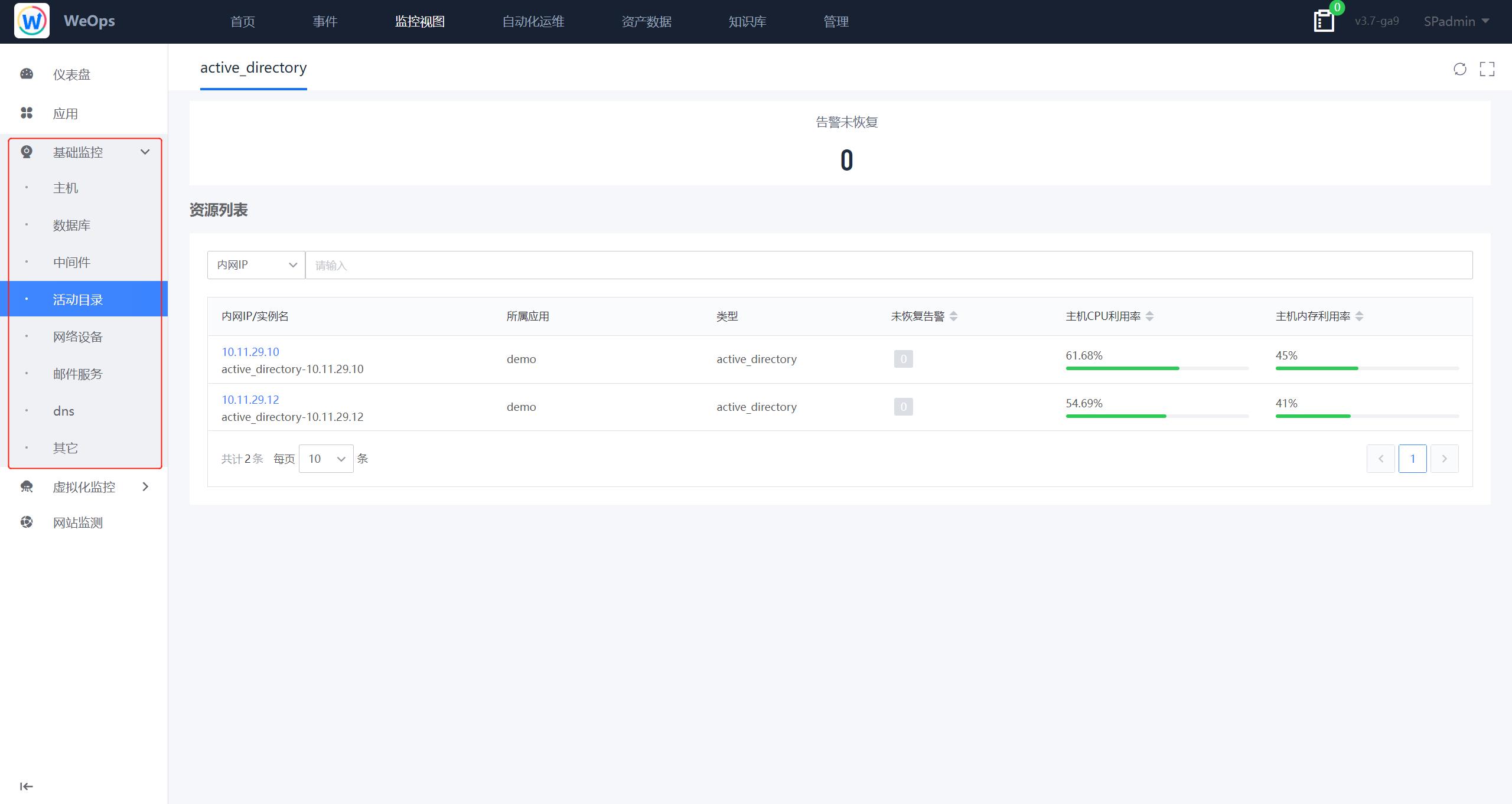

其他动态tab

如下图,“监控视图-基础监控-其他动态tab”根据监控的对象动态展示tab,比如中间件等,展示了这些实例的的关键数据、监控告警状态等,点击各个实例可以跳转至该实例的详细信息抽屉页。

云平台监控

WeOps支持云平台监控/自动发现的拓展,拓展后可在“云平台监控”的tab中展示出对应对象以及监控情况。

VMware

VMware的监控视图展示了VMware下的虚拟机、ESXI和数据存储的监控情况,包括基本信息、监控视图、关联拓扑和告警情况。

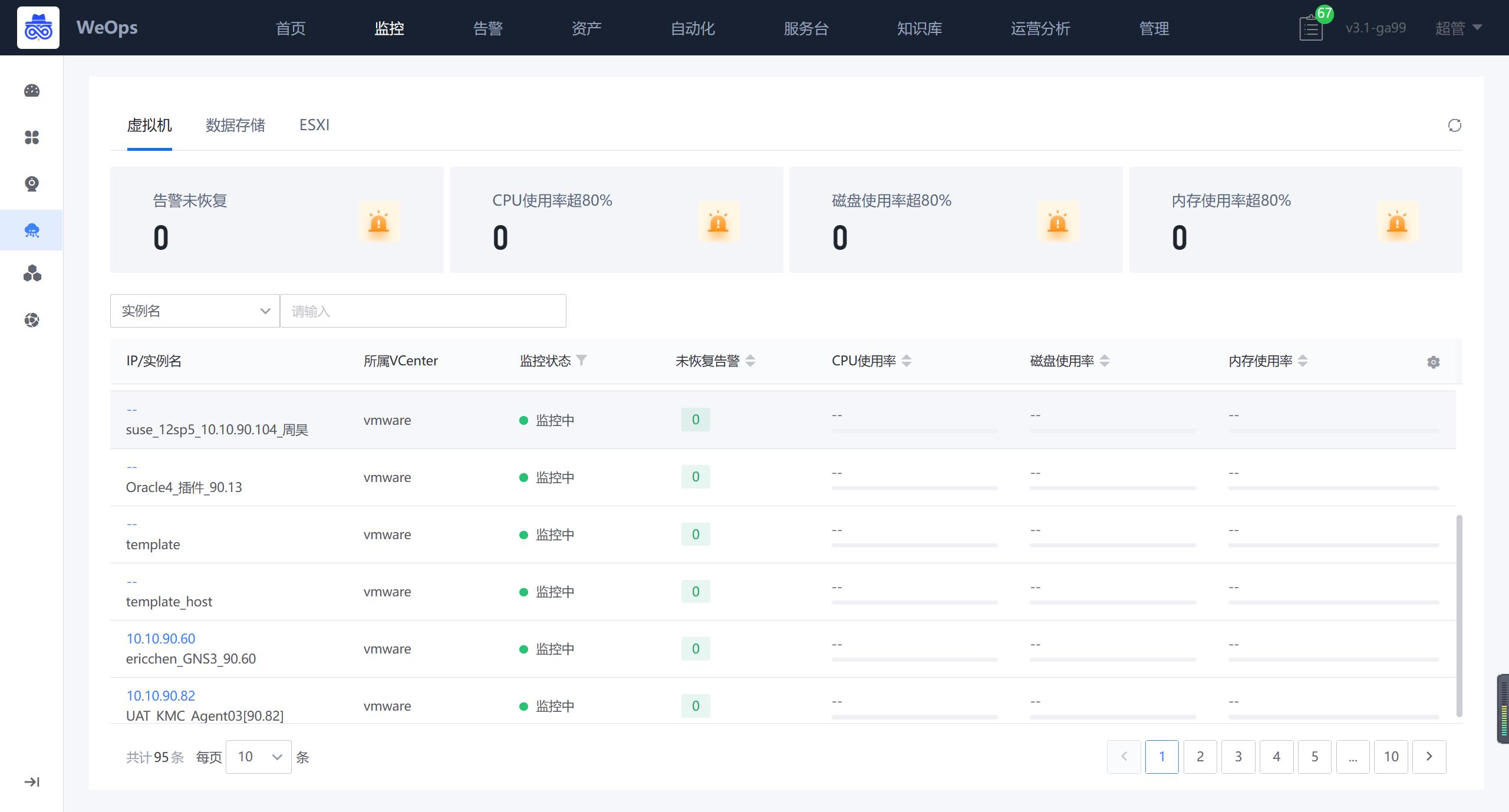

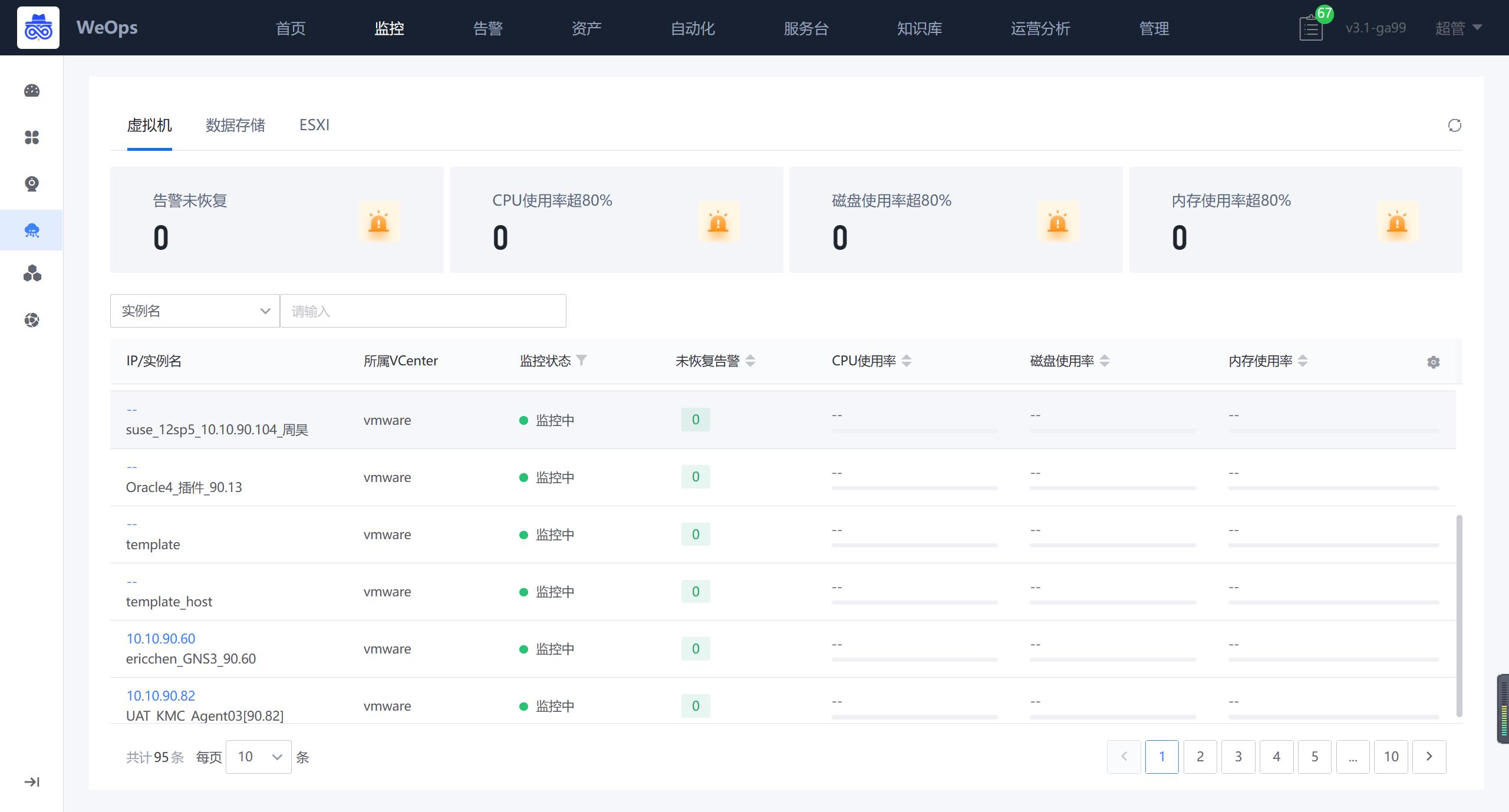

- 虚拟机

如下图,“WeOps-云平台监控-VMware-虚拟机”展示了所有的虚拟机列表,包括监控告警状态、关键指标信息等

点击各个实例可以跳转至详细信息抽屉页面,详情抽屉包括基础信息、监控视图、关联拓扑、告警列表。

- 数据存储

如下图,“WeOps-云平台监控-VMware-数据存储”展示了所有的数据存储列表,包括监控告警状态、关键指标信息等

点击各个实例可以跳转至详细信息抽屉页面,详情抽屉包括基础信息、监控视图、关联的ESXI、关联拓扑、告警列表。

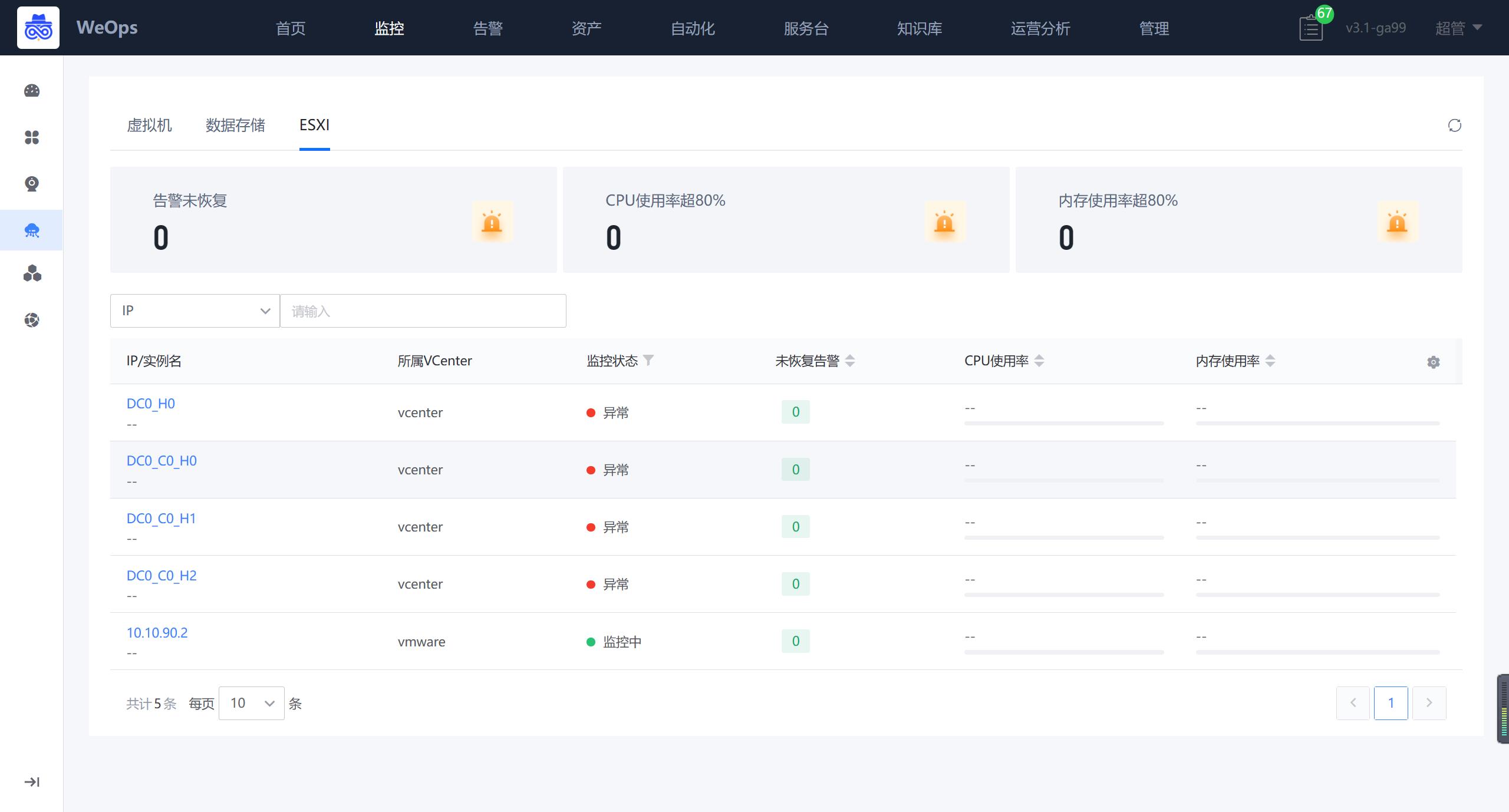

- ESXI

如下图,“WeOps-云平台监控-VMware-ESXI”展示了所有的ESXI列表,包括监控告警状态、关键指标信息等

点击各个实例可以跳转至详细信息抽屉页面,详情抽屉包括基础信息、监控视图、关联的数据存储、关联的虚拟机、关联拓扑、告警列表。

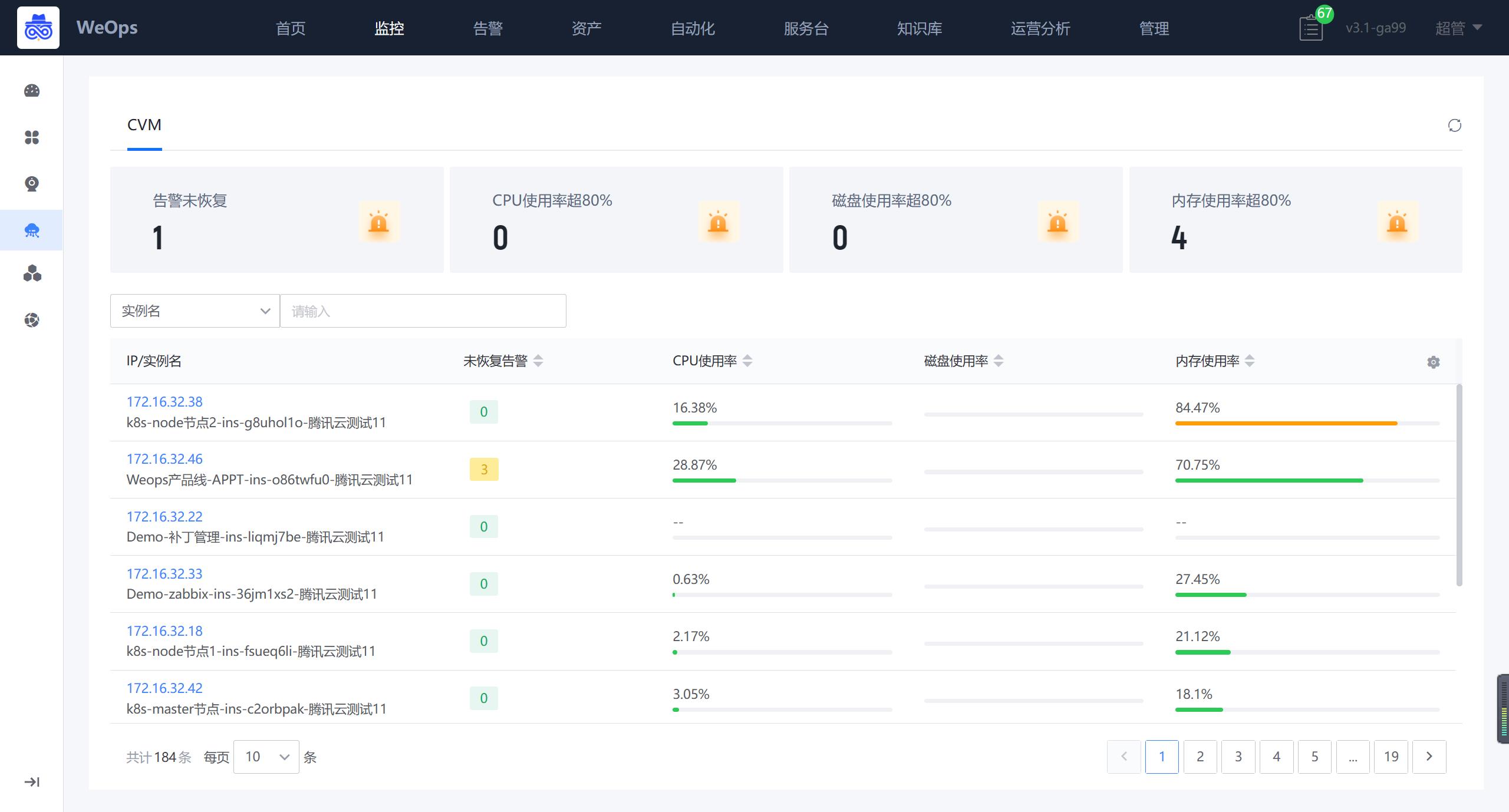

腾讯云

腾讯云的监控视图展示了所有CVM的监控情况,展示CVM列表,包括关键指标和告警状态等信息

点击各个实例可以跳转至CVM详细信息抽屉页面,详情抽屉包括基础信息、监控视图、关联拓扑、告警列表。

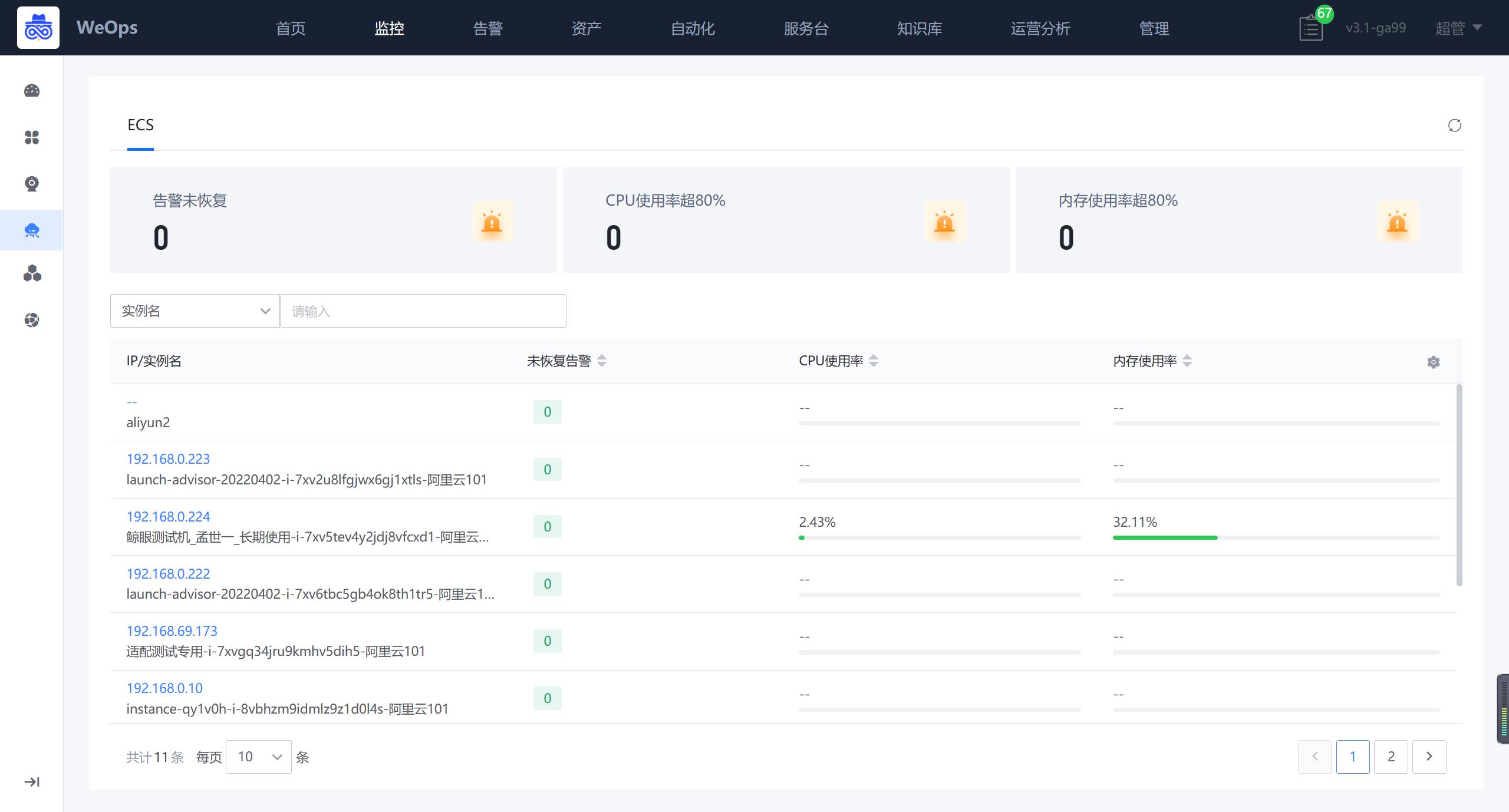

阿里云

阿里云的监控视图展示了所有ECS的监控情况,展示ECS列表,包括关键指标和告警状态等信息

点击各个实例可以跳转至ECS详细信息抽屉页面,详情抽屉包括基础信息、监控视图、关联拓扑、告警列表。

其他内置/自定义拓展的云平台的监控情况均在此展示

K8S监控

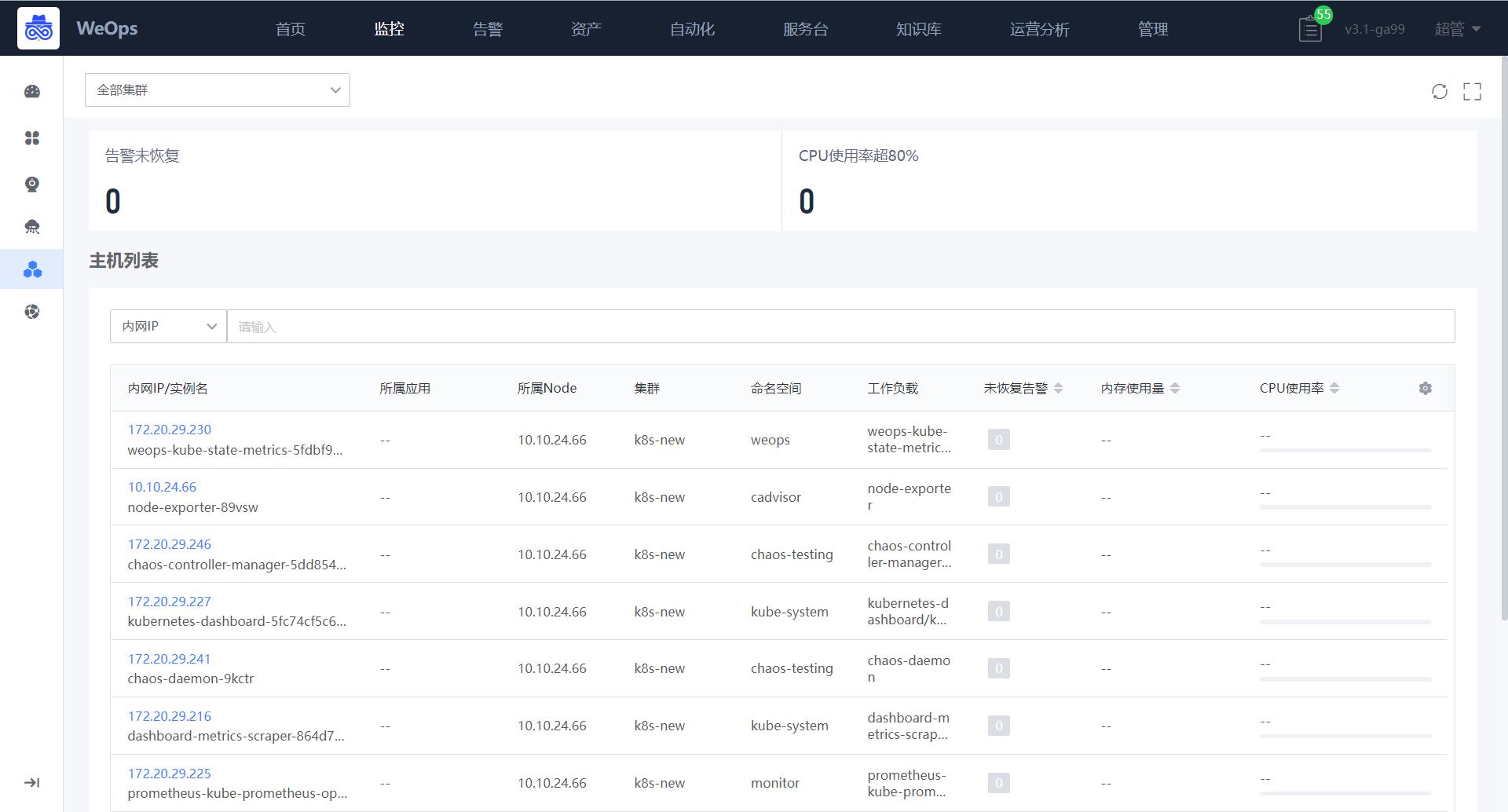

WeOps-K8S监控主要提供Pod、Node的监控,展现监控告警基本情况

Pod监控

如下图,“WeOps-K8S监控-Pod”展示了所有的pod列表,包括监控告警状态、关键指标信息等

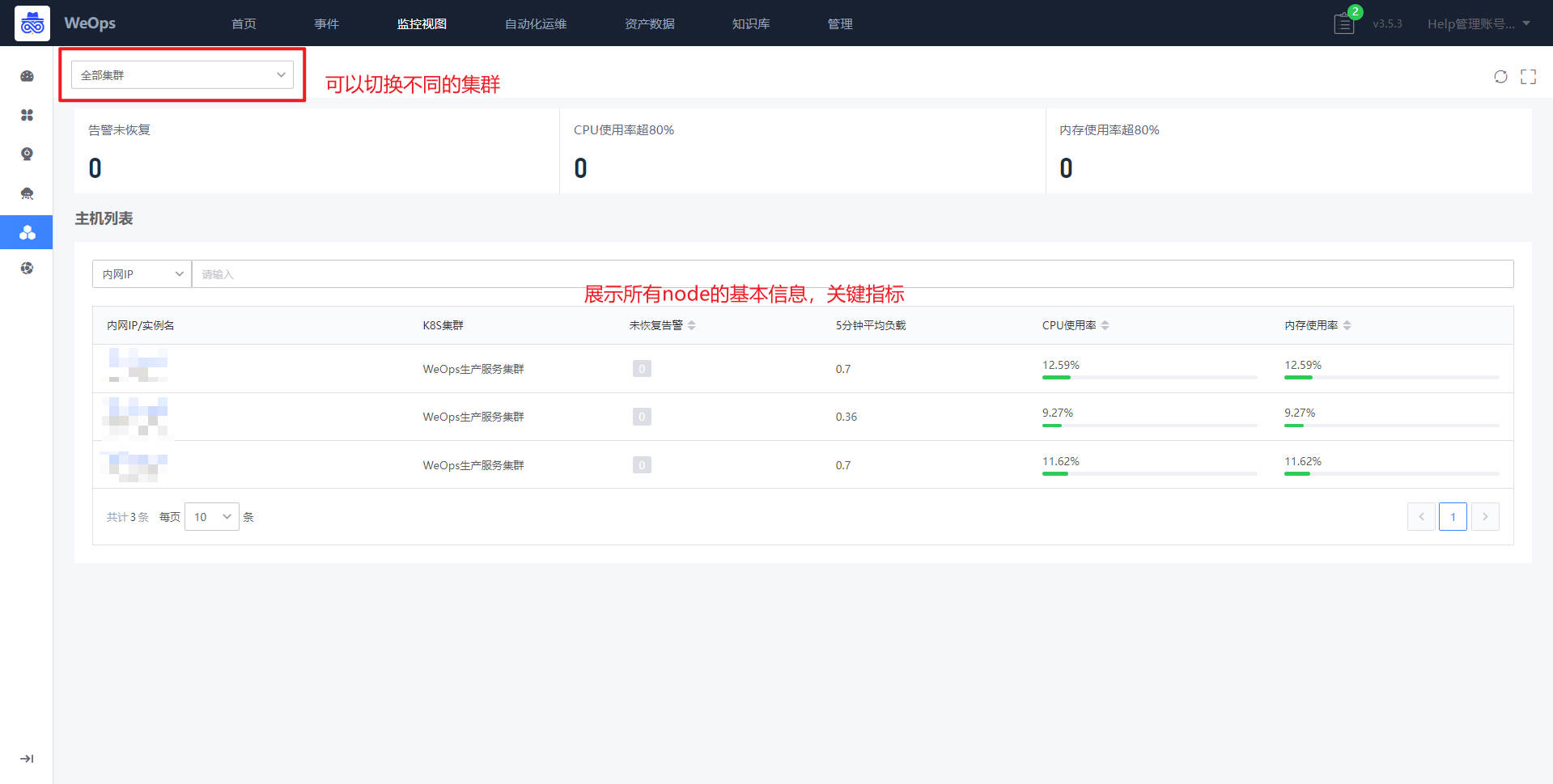

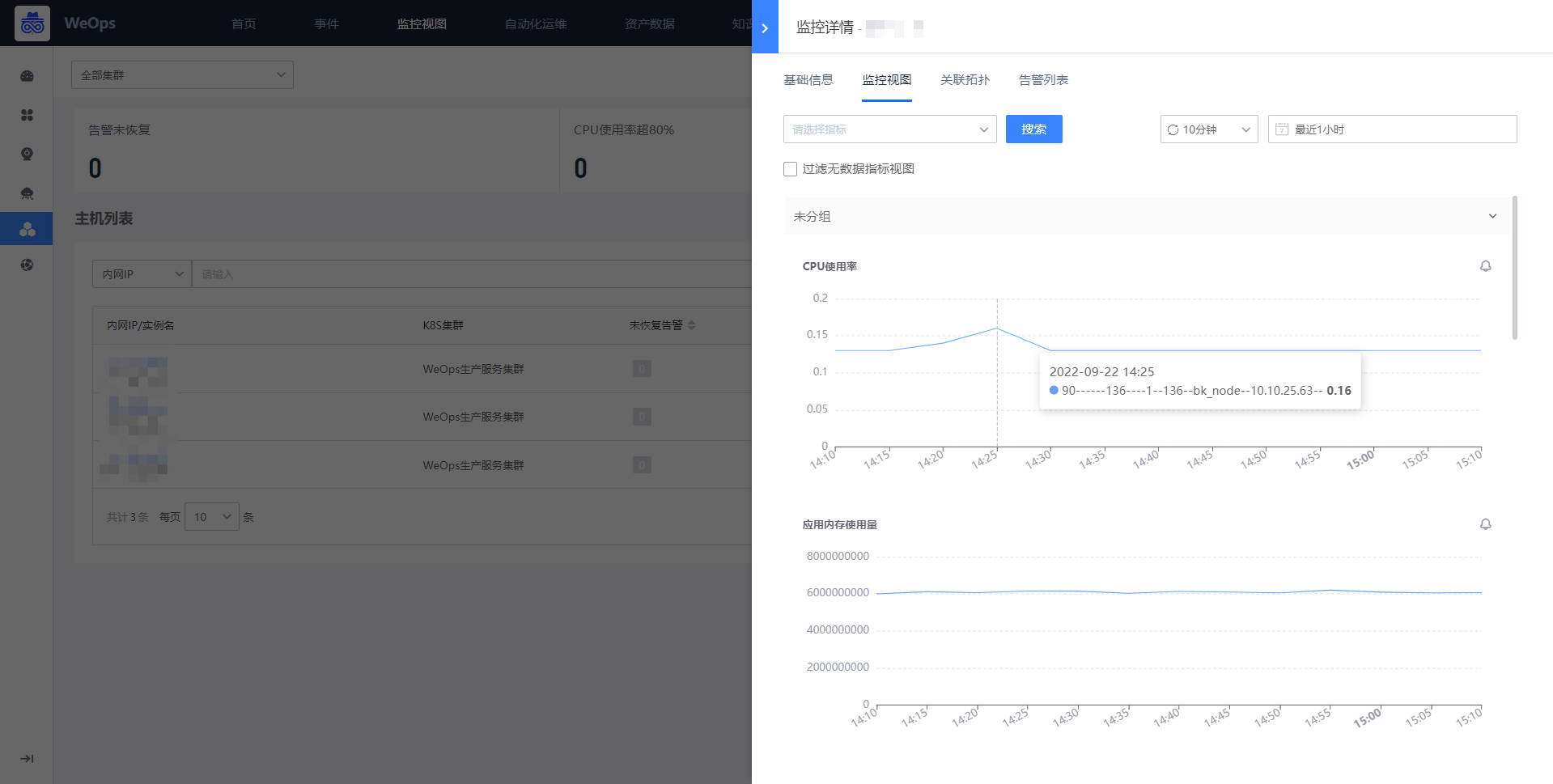

Node监控

如下图,“WeOps-K8S监控-node”展示了所有的node列表,包括监控告警状态、关键指标信息等,可以点击切换不同的集群查看不同的node列表

点击各个实例可以跳转至详细信息抽屉页面,详情抽屉包括基础信息、监控视图、关联拓扑、告警列表。

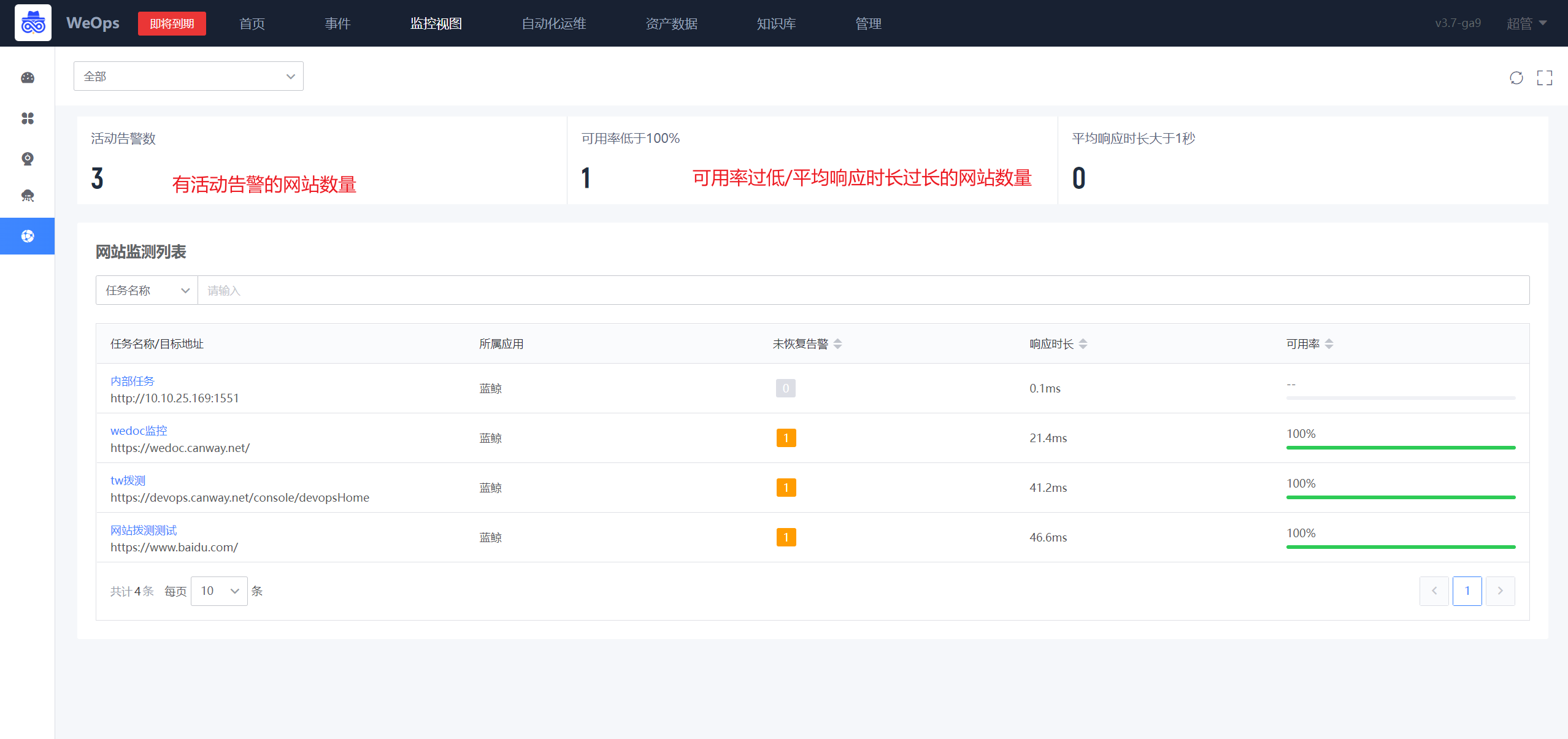

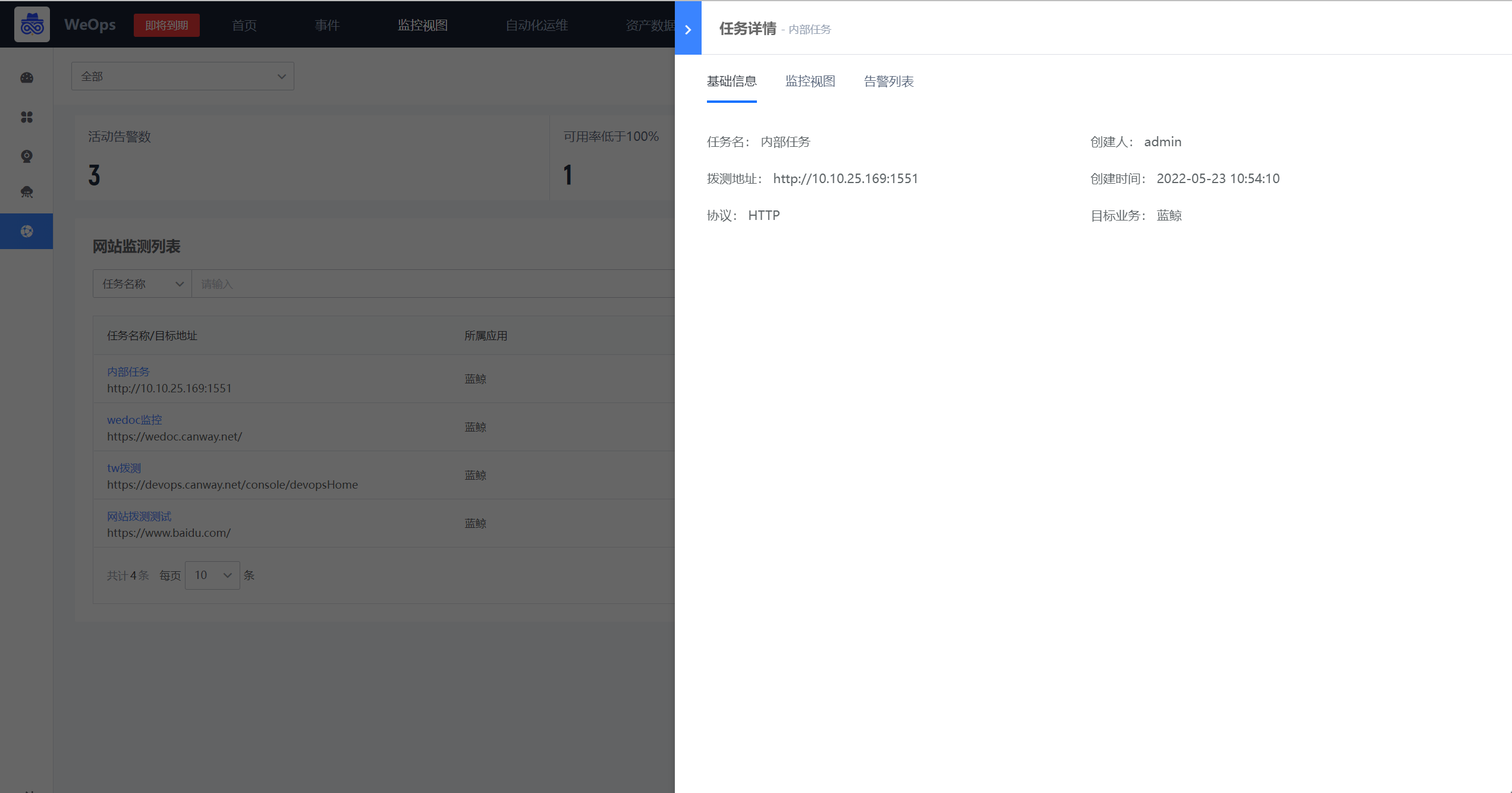

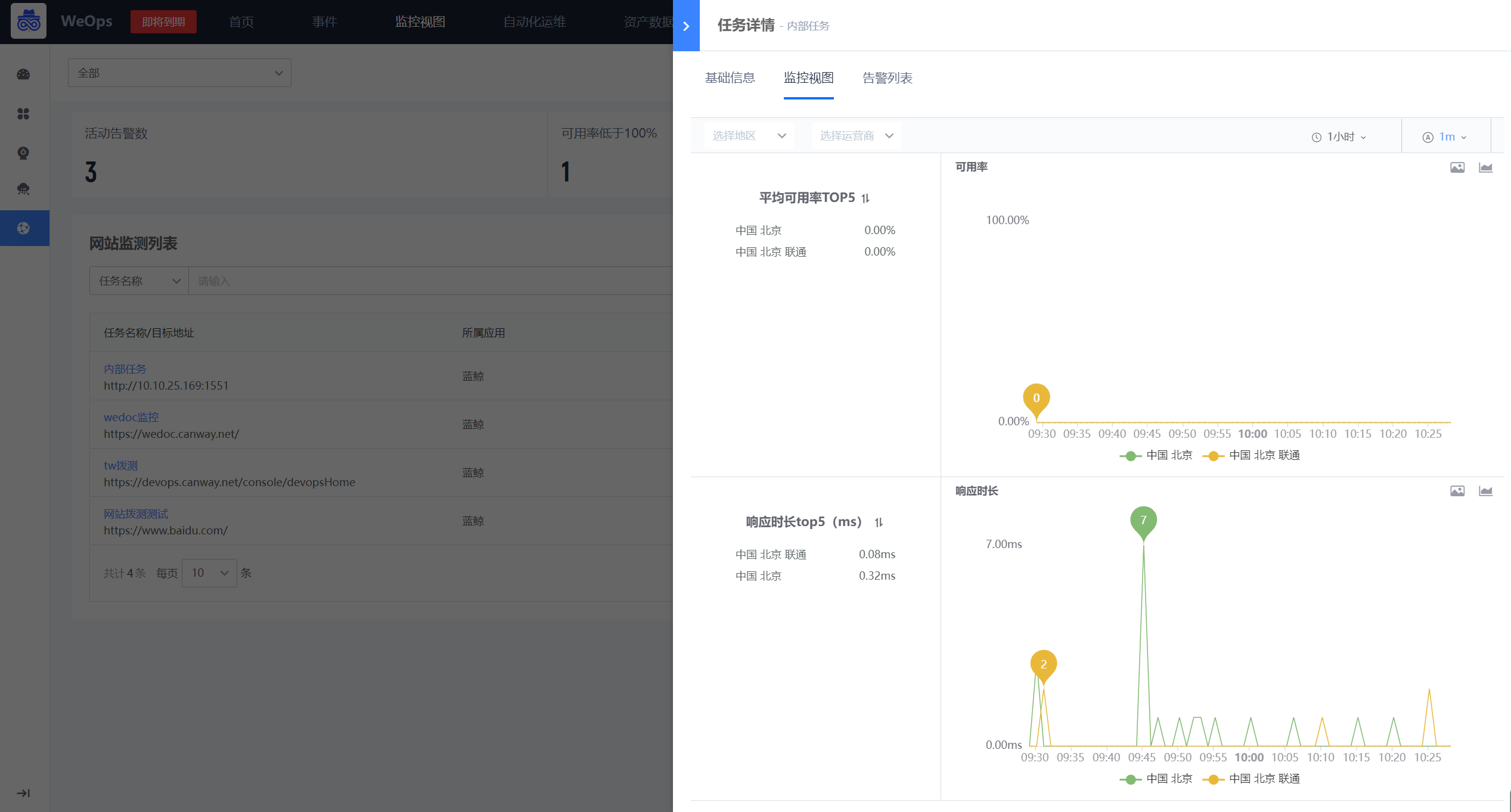

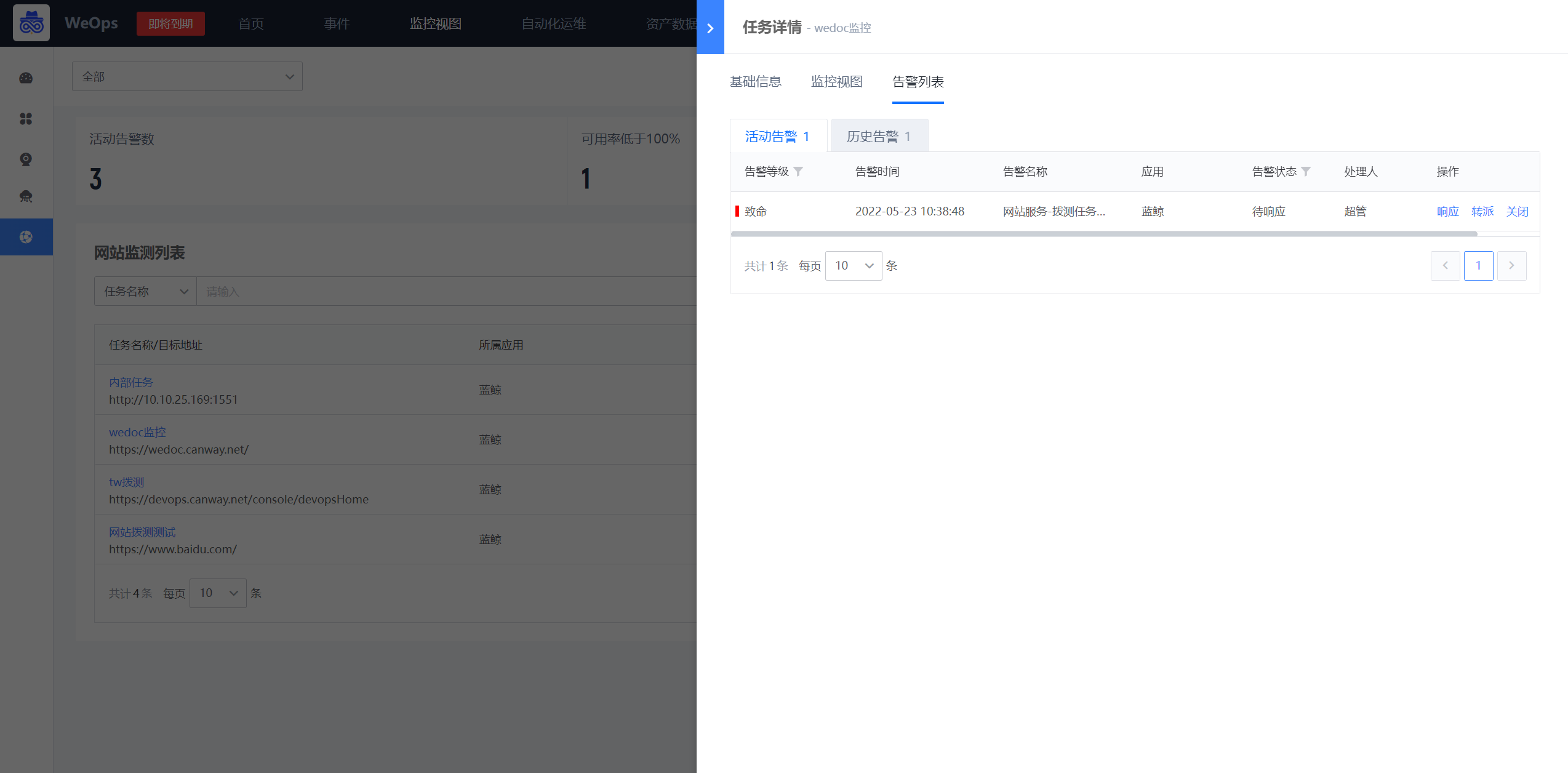

网站监测

如下图,“监控视图-网站监测”展示了所有网站的监测情况。

- 监测情况概览:有活动告警的网站数量、可用率低于100%的网站的数量,平均响应时长大于1秒的网站总数。

- 网站监测列表:展示所有网站的监测状态、告警状态、响应和可用情况。

- 点击各个网站,可以进入该网站监测的详情页面,如下图,包括:基础信息、监控视图(可以查看可用率和响应时长的折线/面积图)、告警列表。

告警

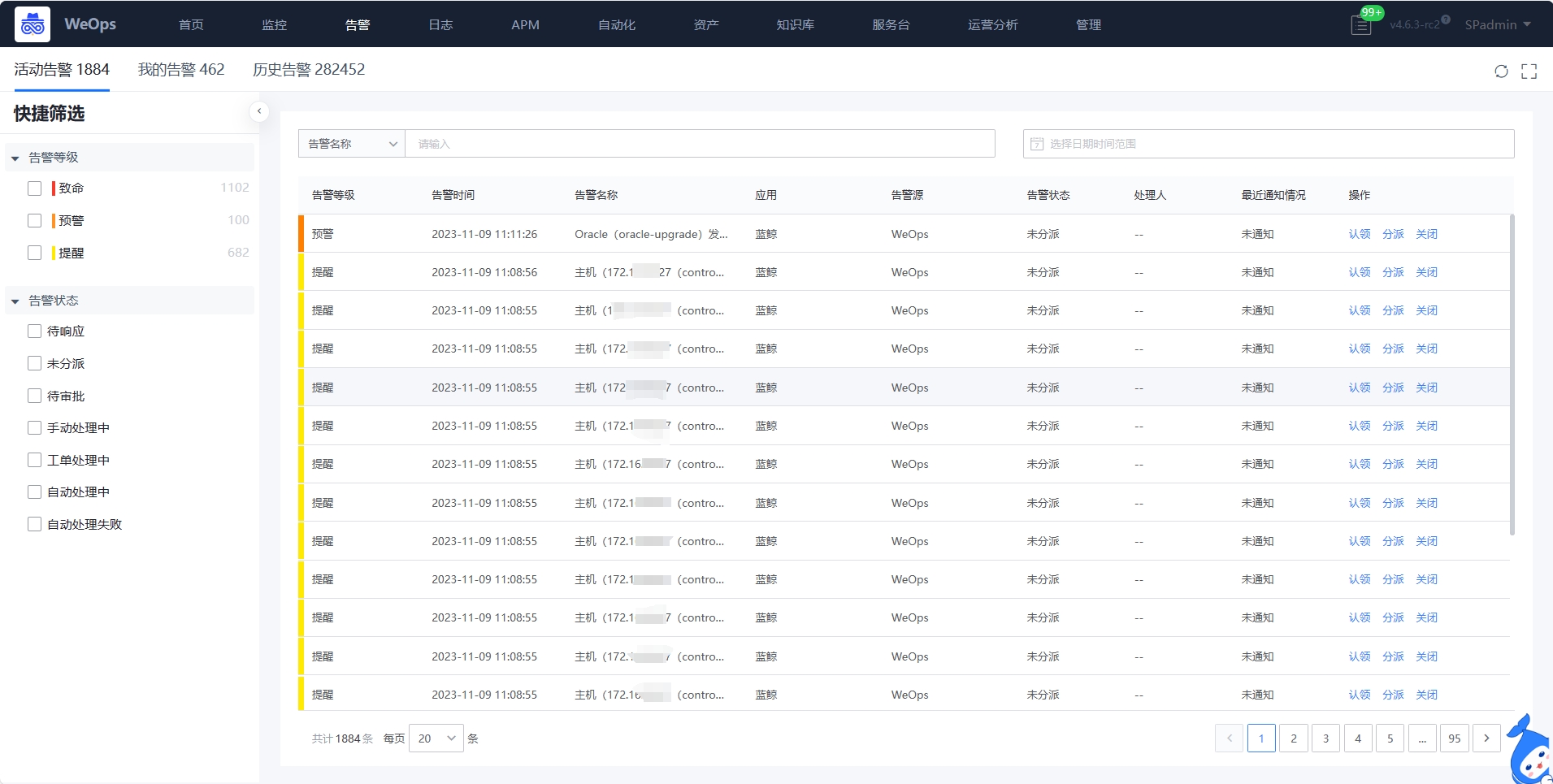

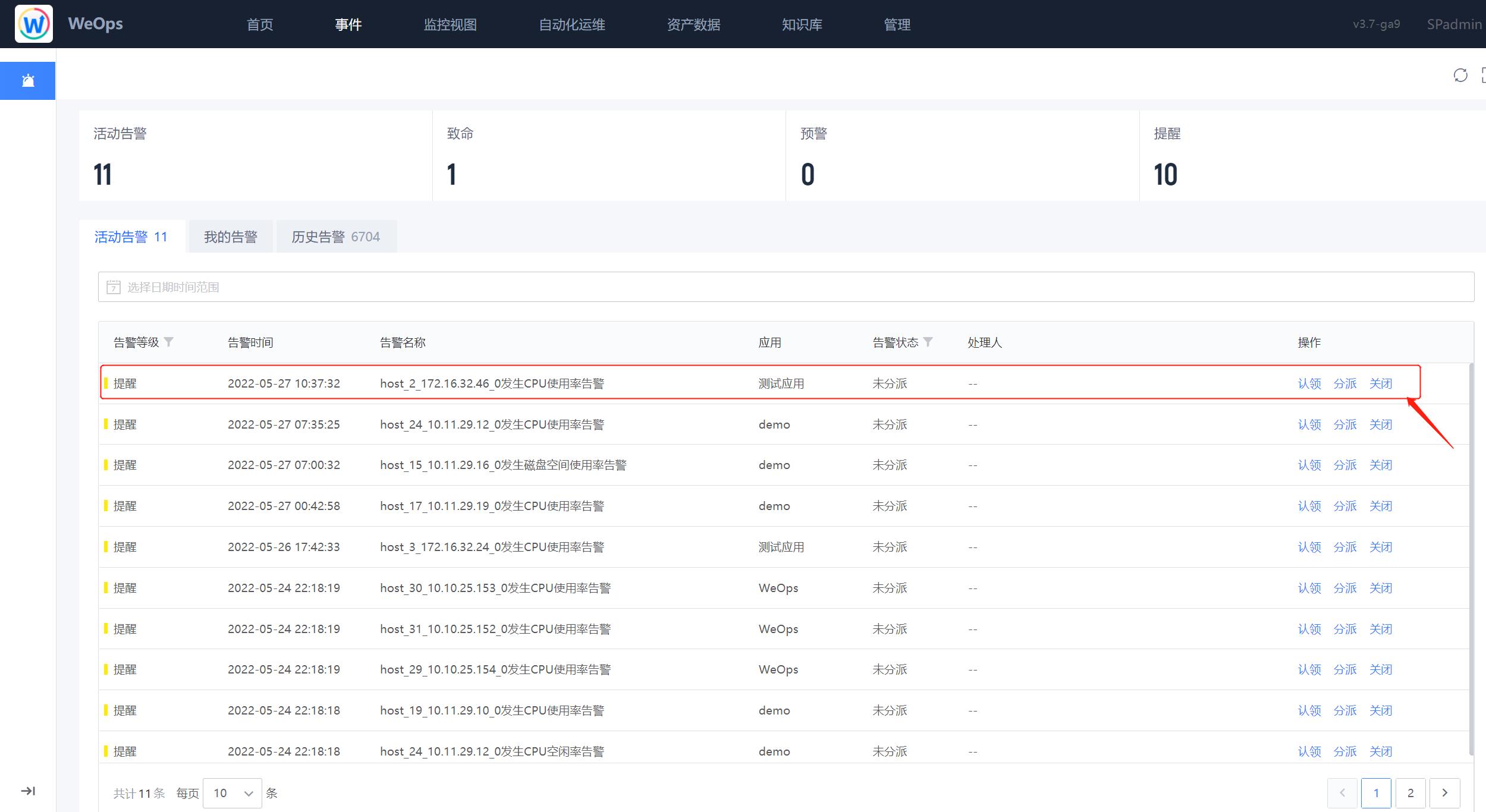

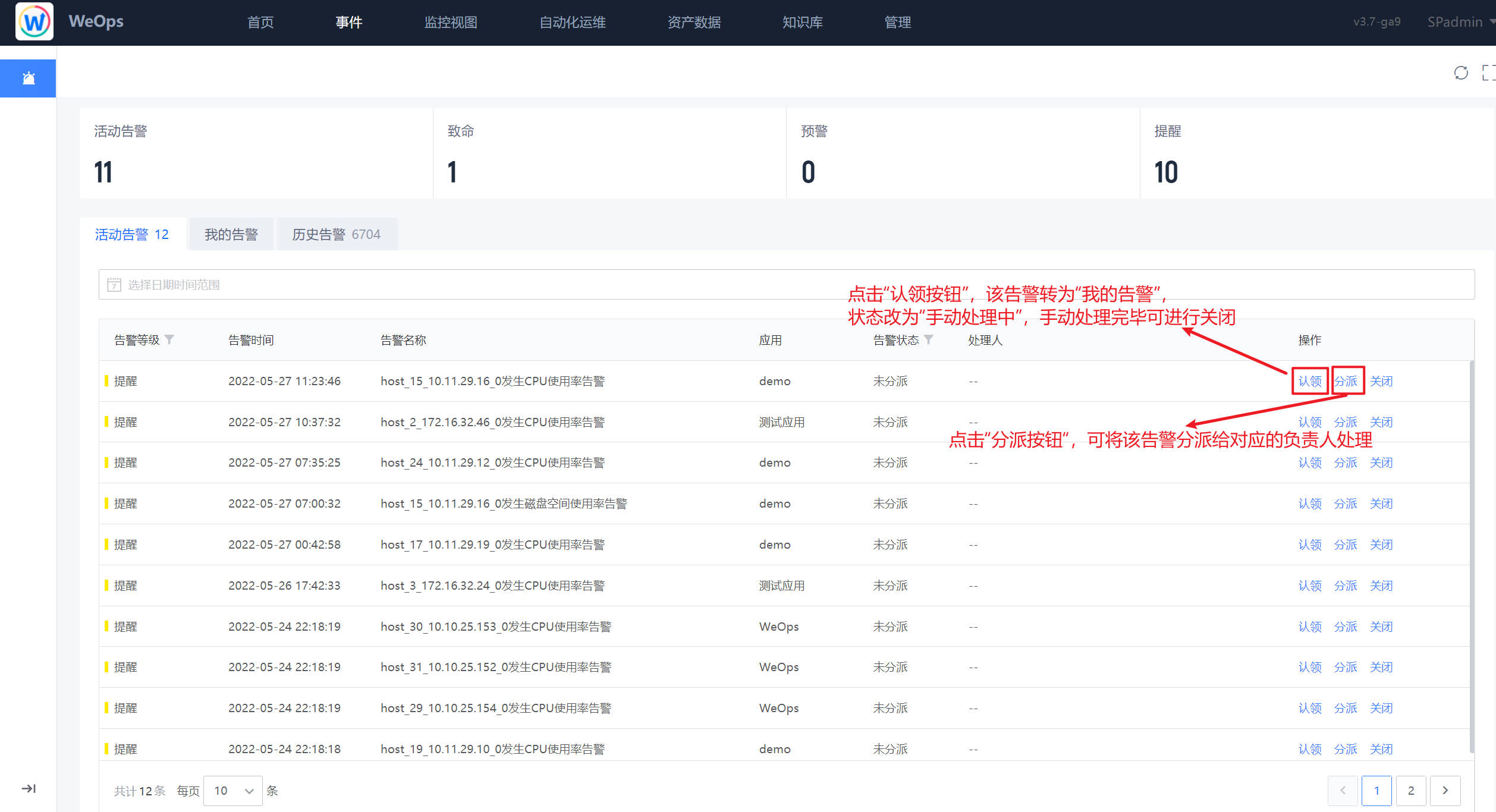

如下图,“WeOps-告警”用于展示“活动告警”“我的告警”和“历史告警”的列表信息,可以直接在列表界面进行各个告警项的操作,比如“认领”、“分派”、“关闭”等

(1)告警基本信息:点击各个告警项,可弹出该告警项的详细信息,具体如下:

- 信息展示:告警信息(展示告警发生的时间、内容和等级)、告警对象信息(实例名称、对象类型、所属应用)、策略信息、处理信息(可进行告警的处理)

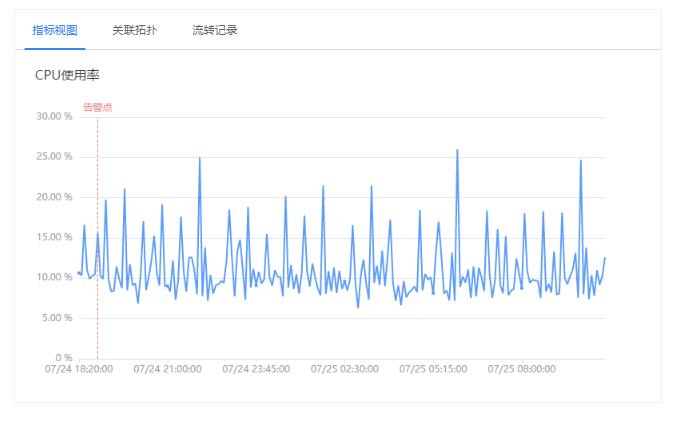

- 视图展示:包括指标视图可以清晰的查看告警发生点,设置的阈值线

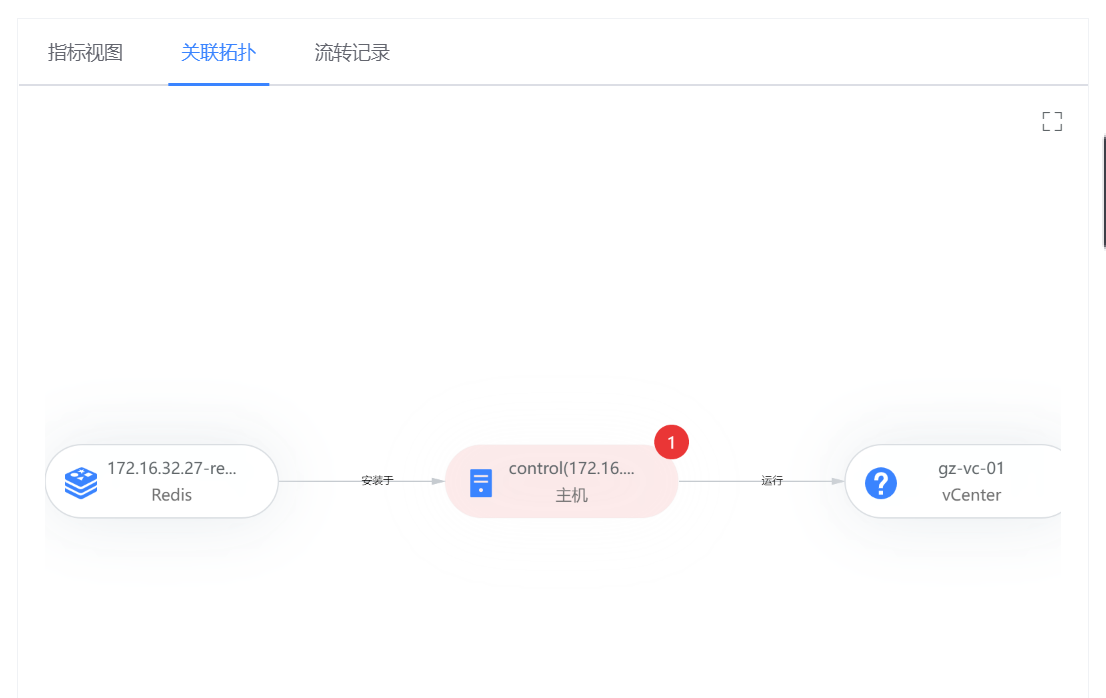

- 关联拓扑:可以清晰的看到产生告警的关联实例情况,可以点击查看关联实例的详细信息。

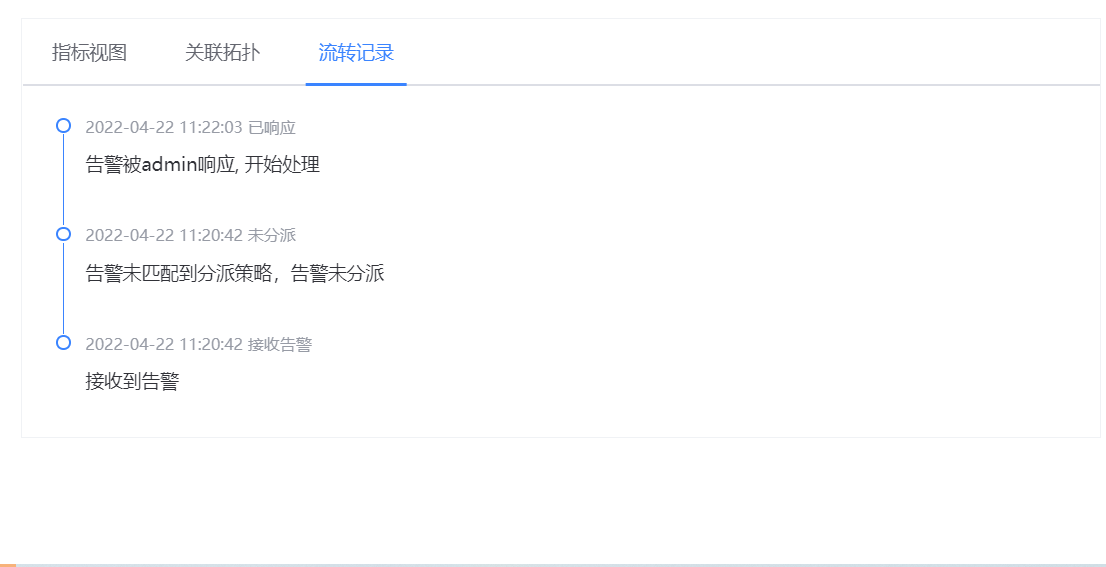

- 流转记录可以查看该告警的发生和处理的流转情况

(2)告警联动: 告警与其他自动化/仪表盘等模块进行联动,实现主机远程连接、故障诊断、故障分析和寻求建议等操作,实现从“告警产生-告警信息查看—故障分析——故障诊断”等全过程,各个操作说明如下

- 远程连接:当告警对象为主机时,支持进行远程连接,直接填写远程的凭据,连接该主机。

- 故障分析:当出现告警的时候,点击“故障分析”按钮,可以把故障资产的相关信息、监控指标、日志等,形成专业的故障分析仪表盘,方便进行故障分析。

- 故障诊断:当告警对象支持执行运维工具进行故障诊断时,可以在告警的详细中点击“故障诊断”按钮,在展开的运维工具中选择需要执行的工具,进行执行,从而方便的获取更多故障信息。

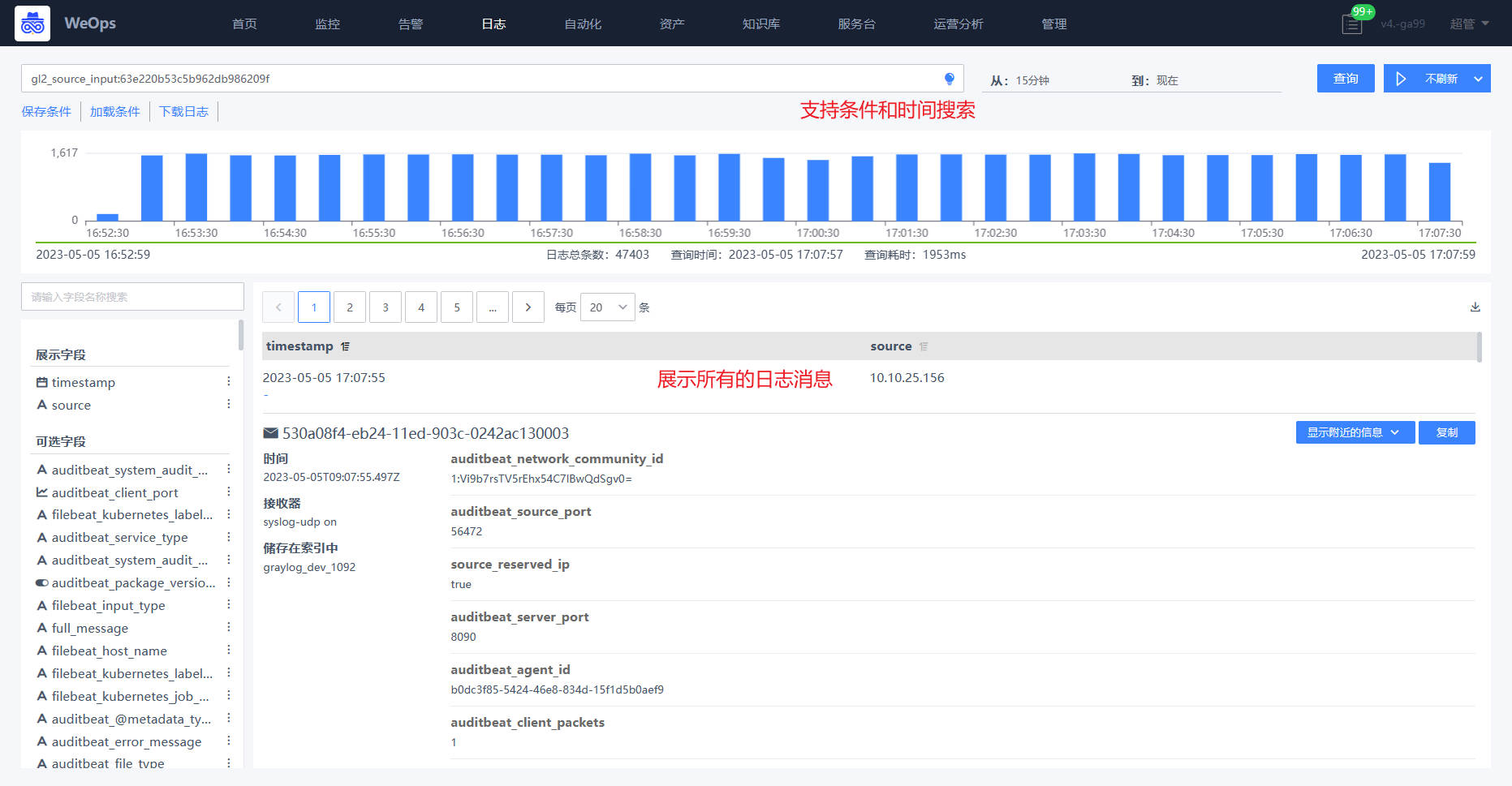

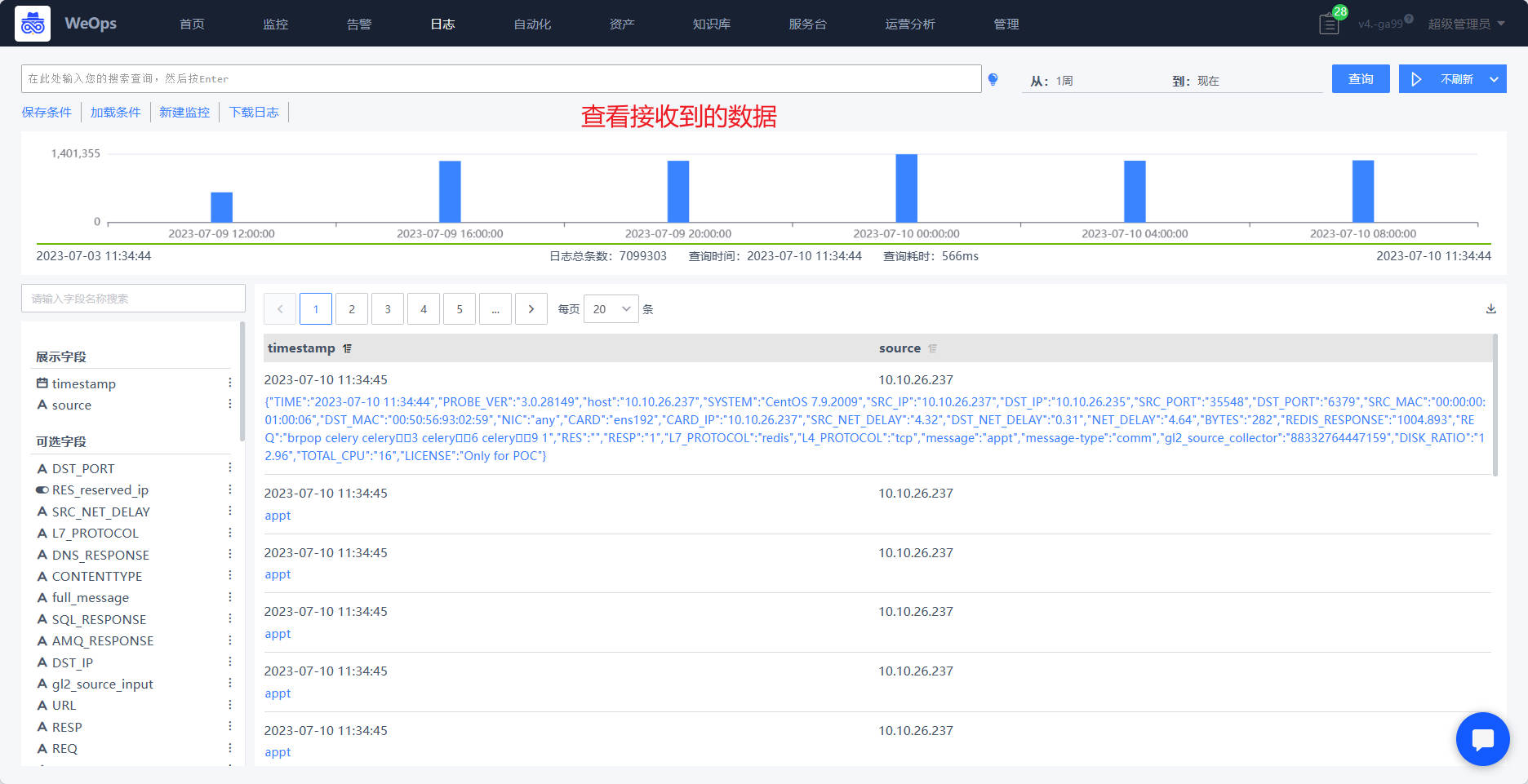

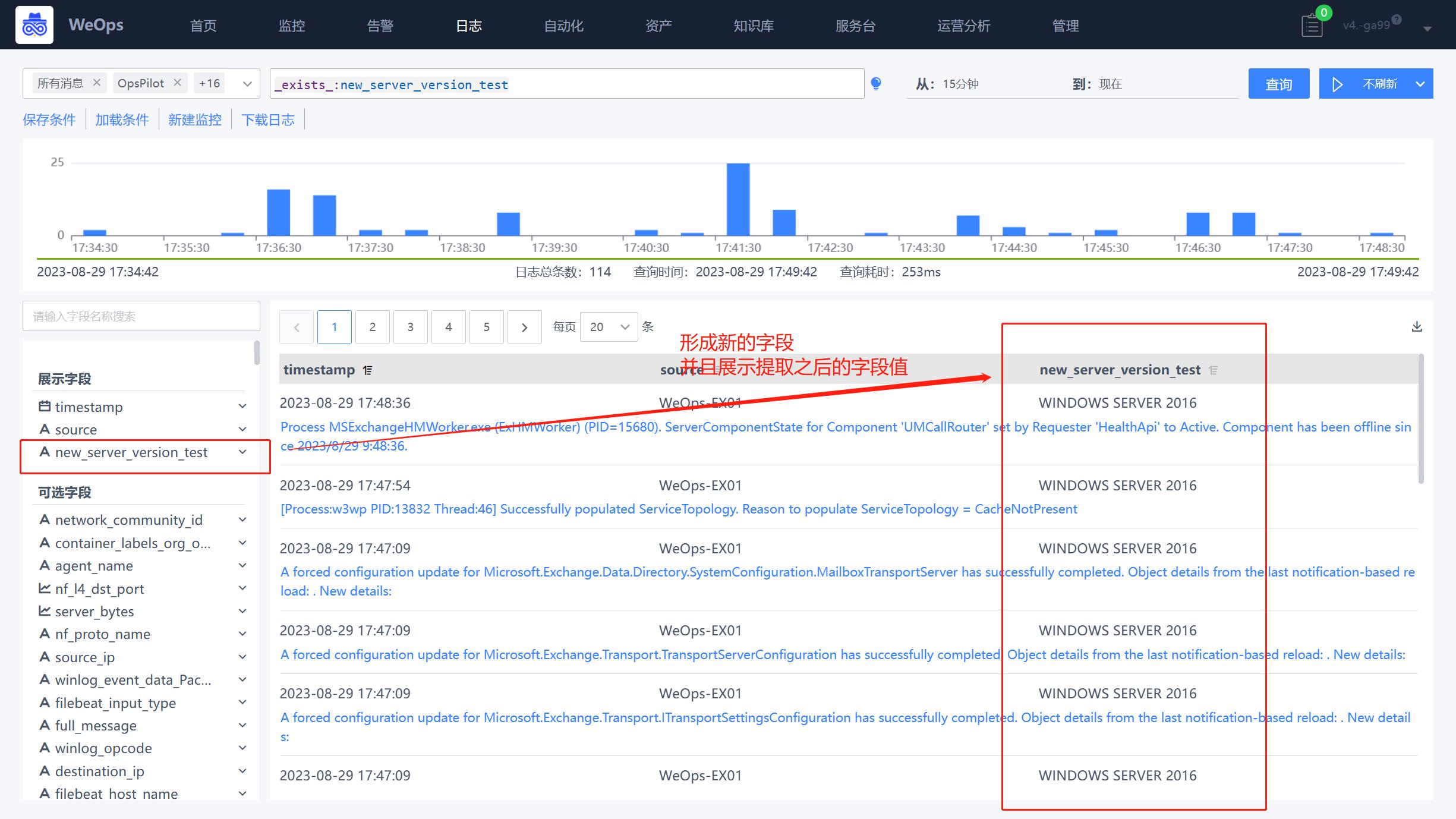

日志

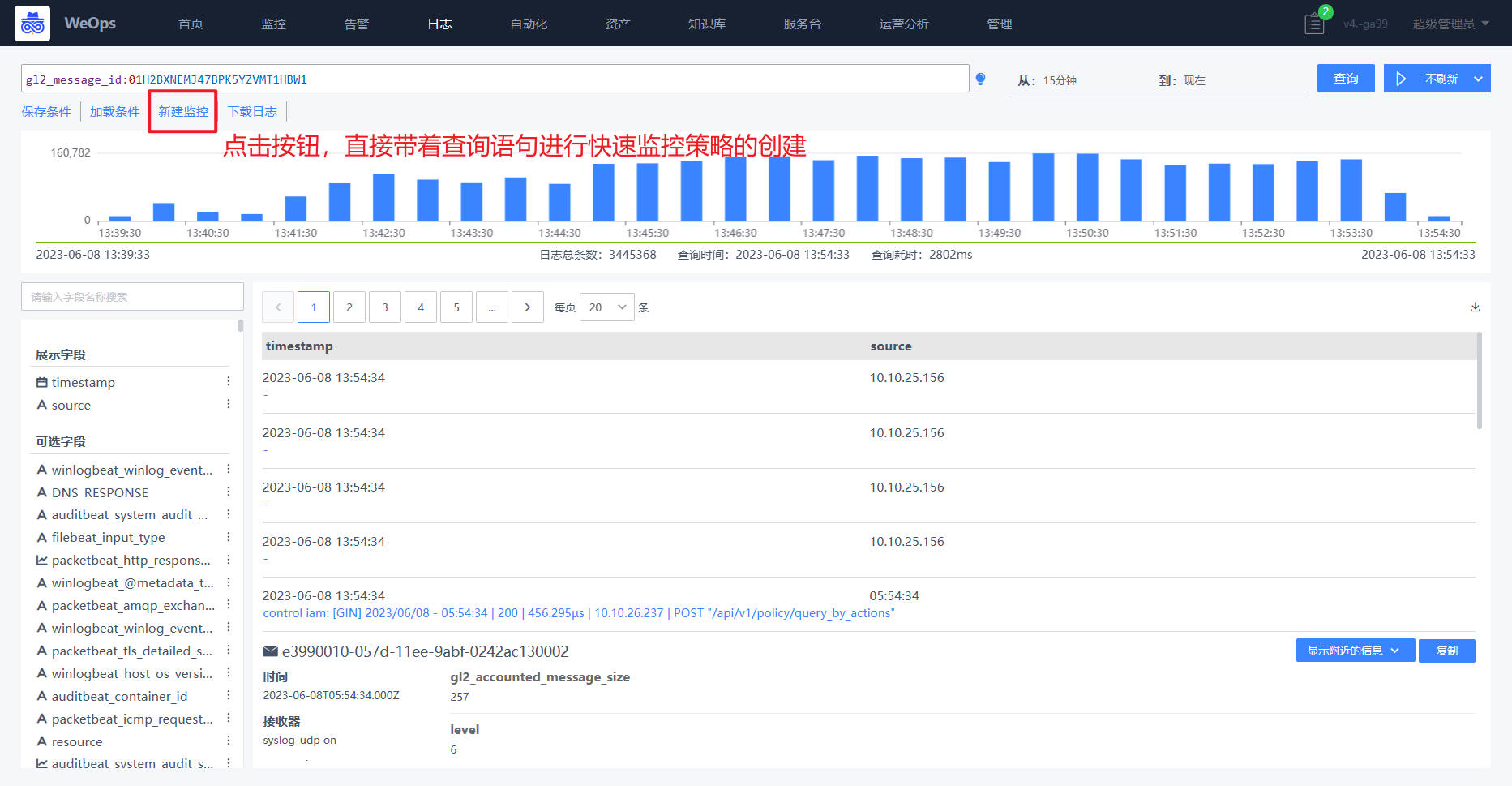

WeOps日志页面支持日志数据的相关搜索,灵活的展示所需要的日志信息,具体如下图

查询设置区域

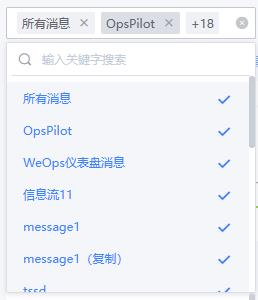

WeOps提供灵活的搜索语法和搜索条件,支持按照各自需求进行设置,搜索条件是由“日志分组情况+搜索框关键字+搜索时间”生成,并按照设置的刷新时间进行自动更新,设置的搜索条件可以保存,以便下次直接使用,具体的设置说明如下

- 日志分组:根据用户拥有的日志分组权限进行选择,仅展示选中后的分组内的日志数据。

- 搜索框:支持对日志的关键词进行搜索,点击“灯泡”按钮,可以查看语法指引,输入日志字段会自动给出下列字段列表,便于使用。

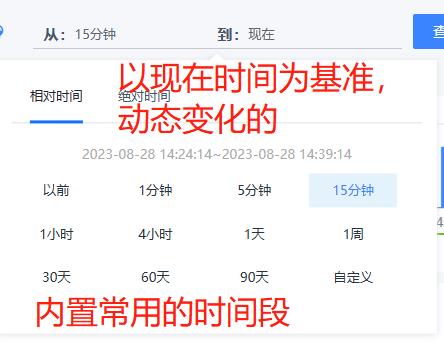

- 搜索时间:分成两类,相对时间和绝对时间,相对时间是指选择从过去的某个时间点到现在时间点的一段范围,是动态变化的,比如“1小时”是指1个小时前到现在的时间范围;绝对时间是一段确切的时间,不会随着时间流逝而动态变化,比如“2023-08-28 00:00:00 – 2023-08-29 23:59:59”就是指展示这段时间的日志。

- 刷新设置:支持设置自动刷新和不刷新,不刷新的是指在日志展示过程中不会更新最新的日志数据;自动刷新可以设置刷新时间,默认是5秒钟,开启自动刷新后,将会按照刷新时间自动更新日志数据。

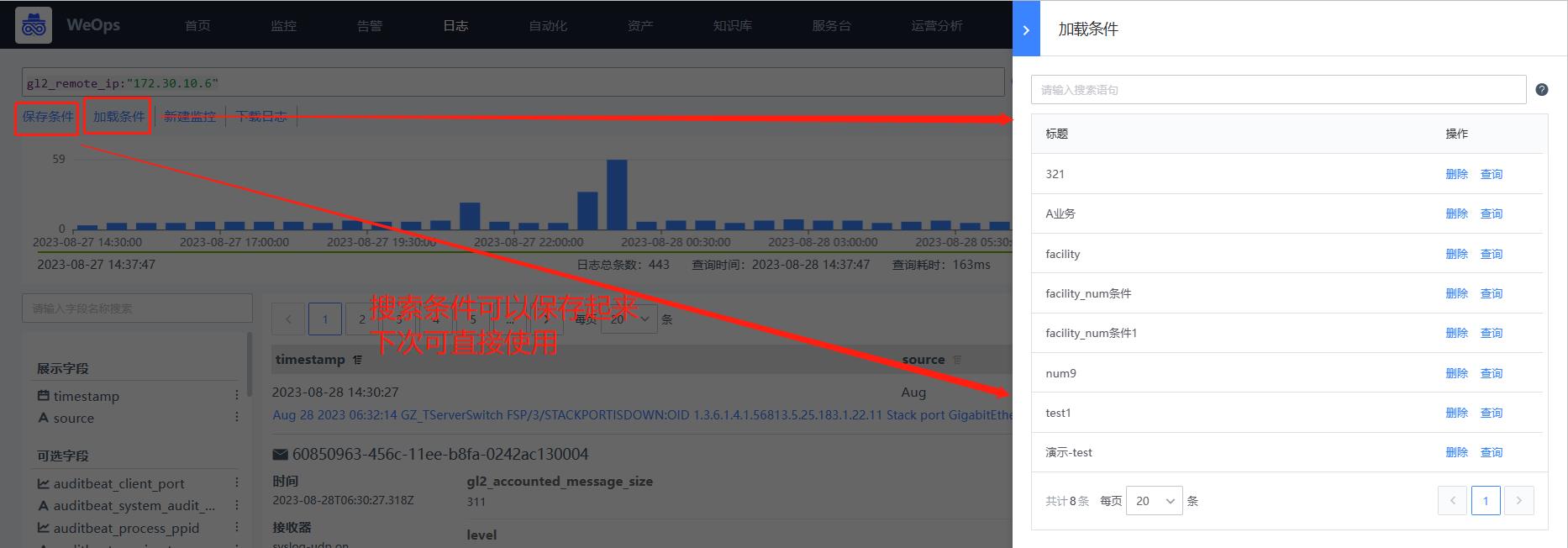

- 保存条件/加载条件:支持将常用的搜索条件进行保存为一个“保存条件”,可以保存的搜索条件为“日志分组+搜索关键词+搜索时间+展示字段”。当下次再使用该条件时,在“加载条件”中选择即可使用。

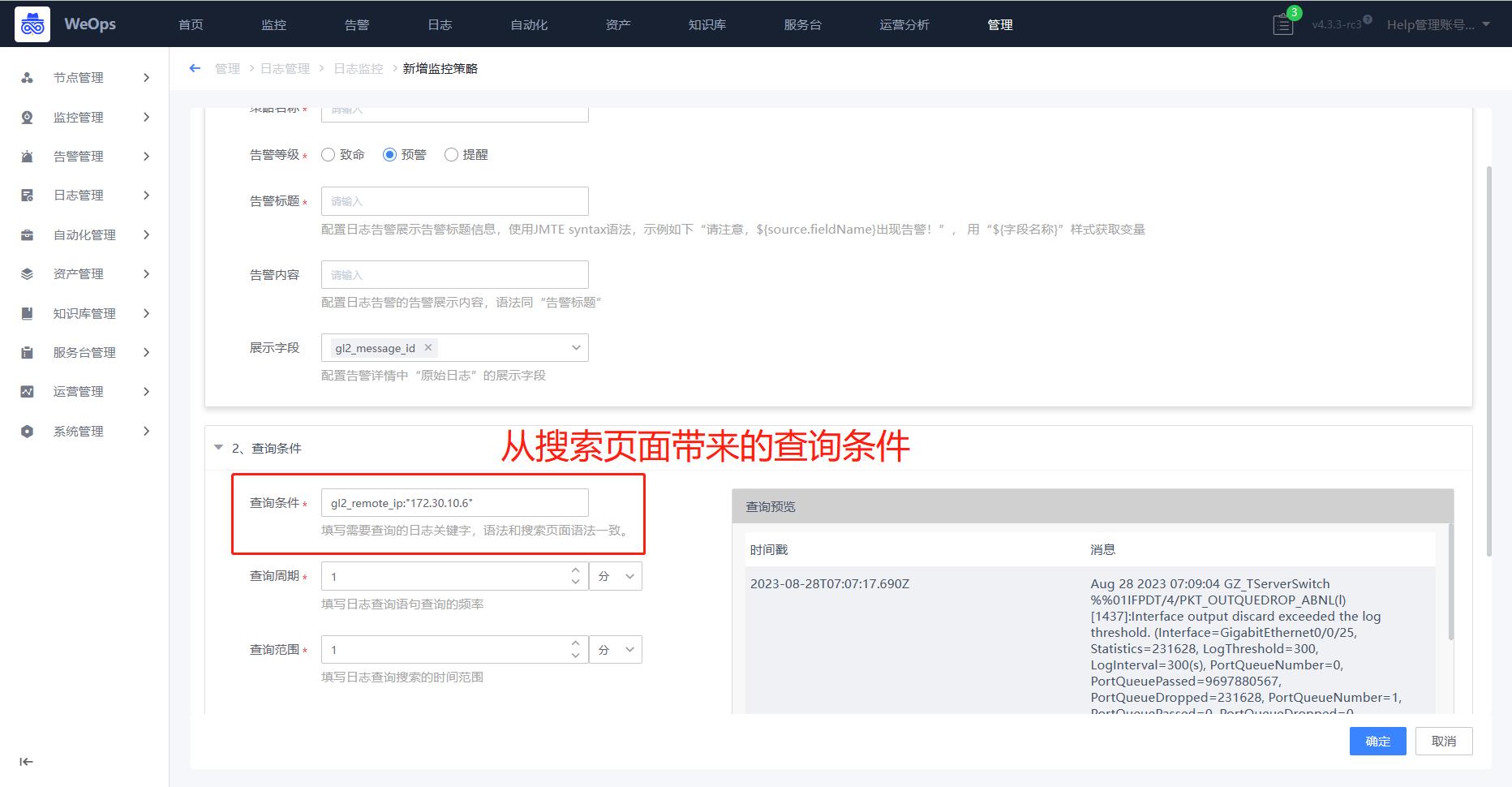

- 新建监控:点击“新建监控”按钮,可以快捷创建监控策略,在监控策略中,把本次查询的搜索关键词直接带入策略中

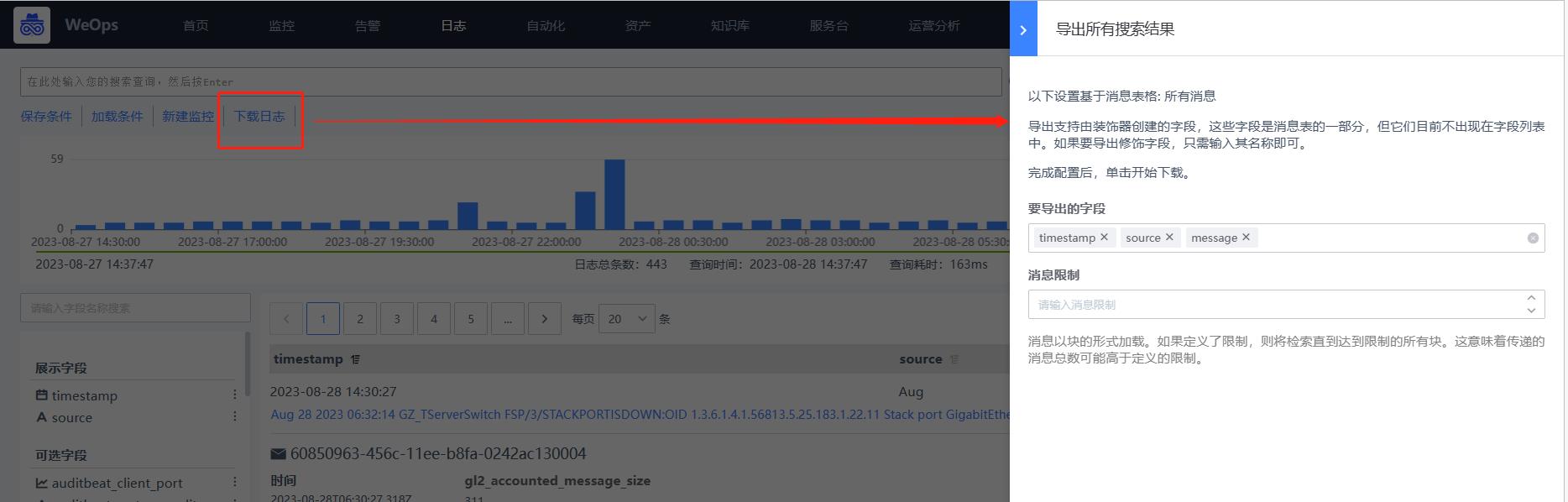

- 日志下载:点击“下载日志”按钮,可以下载该搜索条件下的所有原始日志,可以设置导出的字段和消息限制,导出格式为“.cvs”格式。

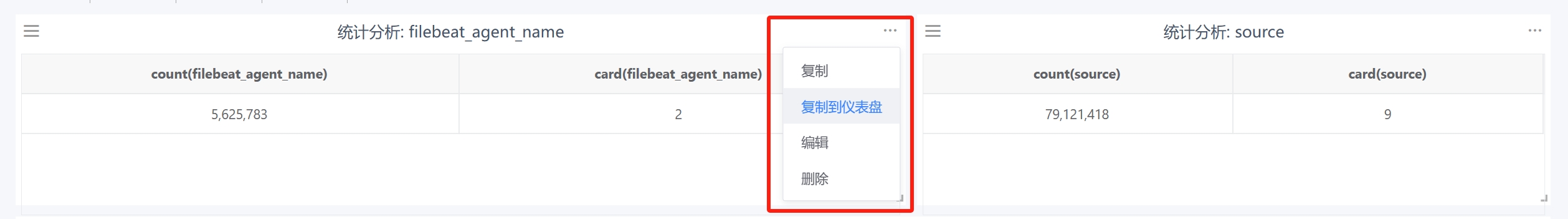

统计分析区域

- 当字段选择“统计分析”时,可以快速统计该查询时间范围内,字段所有的字段值的数量情况,并形成统计分析表格,统计分析表支持进行以下操作

- 复制:复制出一个一样的统计分析表格

- 复制到仪表盘:选择一个仪表盘,该组件会复制到该仪表盘内,成为仪表盘的一个组件

- 编辑:支持对该统计分析的组件进行编辑,编辑的选项与“仪表盘-日志-表格”组件一致

- 删除:将该组件进行删除

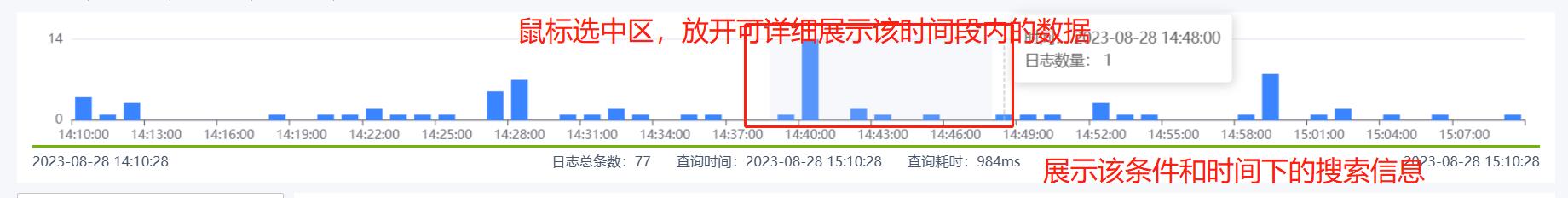

日志条形图区域

- 日志条形图:展示搜索时间段内,日志的随着时间的分布的情况;鼠标悬停可以展示该时间信息和日志的数量;鼠标左键按住拖动可以选择一段时间范围,放开后可以详细展示这段时间的情况和原始日志数据(相当于变化了搜索时间范围)

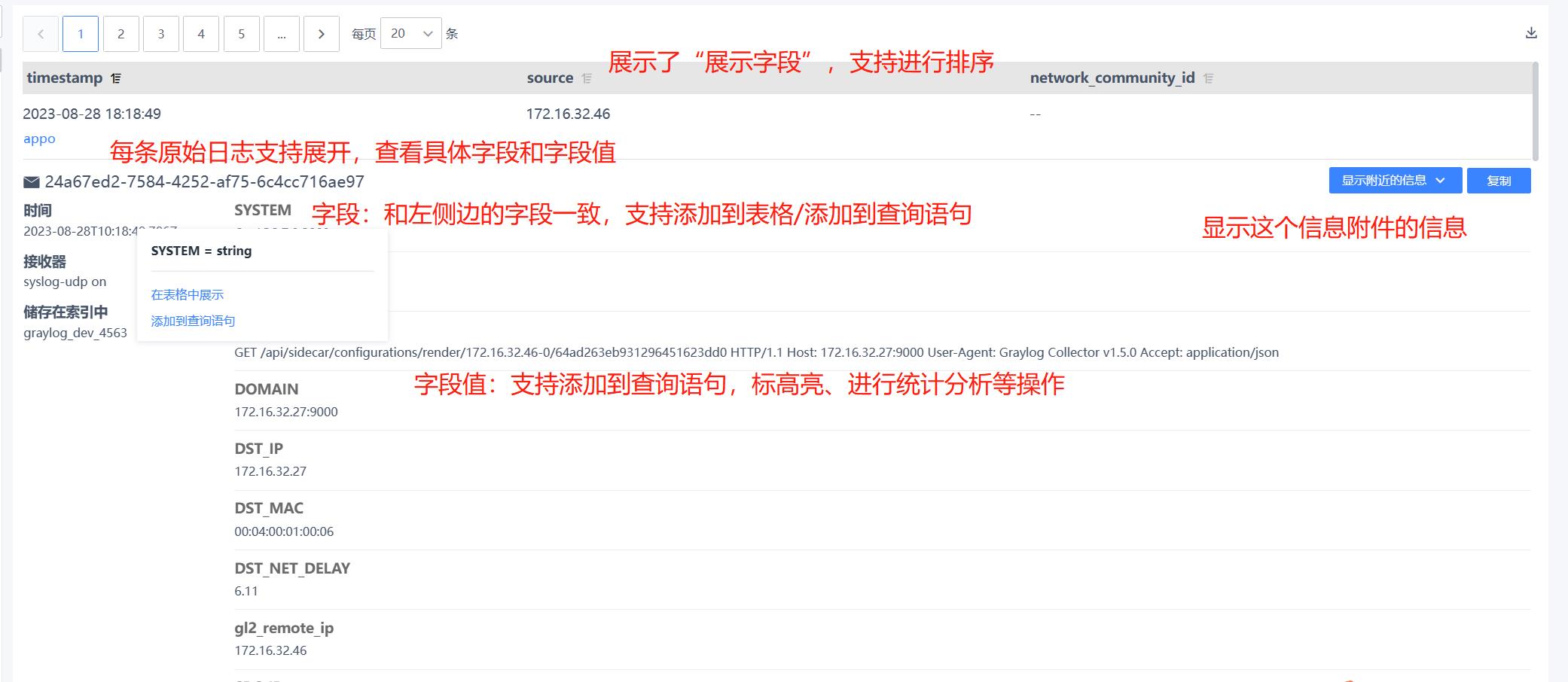

展示字段区域

WeOps-日志的字段区域展示了“展示字段”和“可选字段”两类

- 可选字段:展示所有的支持的字段,可以将该字段添加到表格中展示,或者添加到查询语句进行搜索

- 展示字段:展示了所有在表格表头的字段,从表格中移除,或者添加到查询语句进行搜索

- 可选字段和展示字段支持展示该字段的统计值top5,点击下拉该字段,即可进行统计展示。

原始日志区域

- 日志部分:日志部分展示了根据查询条件搜索到的所有的日志,可以点击查看详情每一条日志的详情,并进行特殊操作

- 对于字段:支持设置在表格展示(展示在表头)、添加到查询语句(直接展示在查询语句里面)、统计分析(形成该字段的数量的统计分析表格,并呈现在统计分析区域)

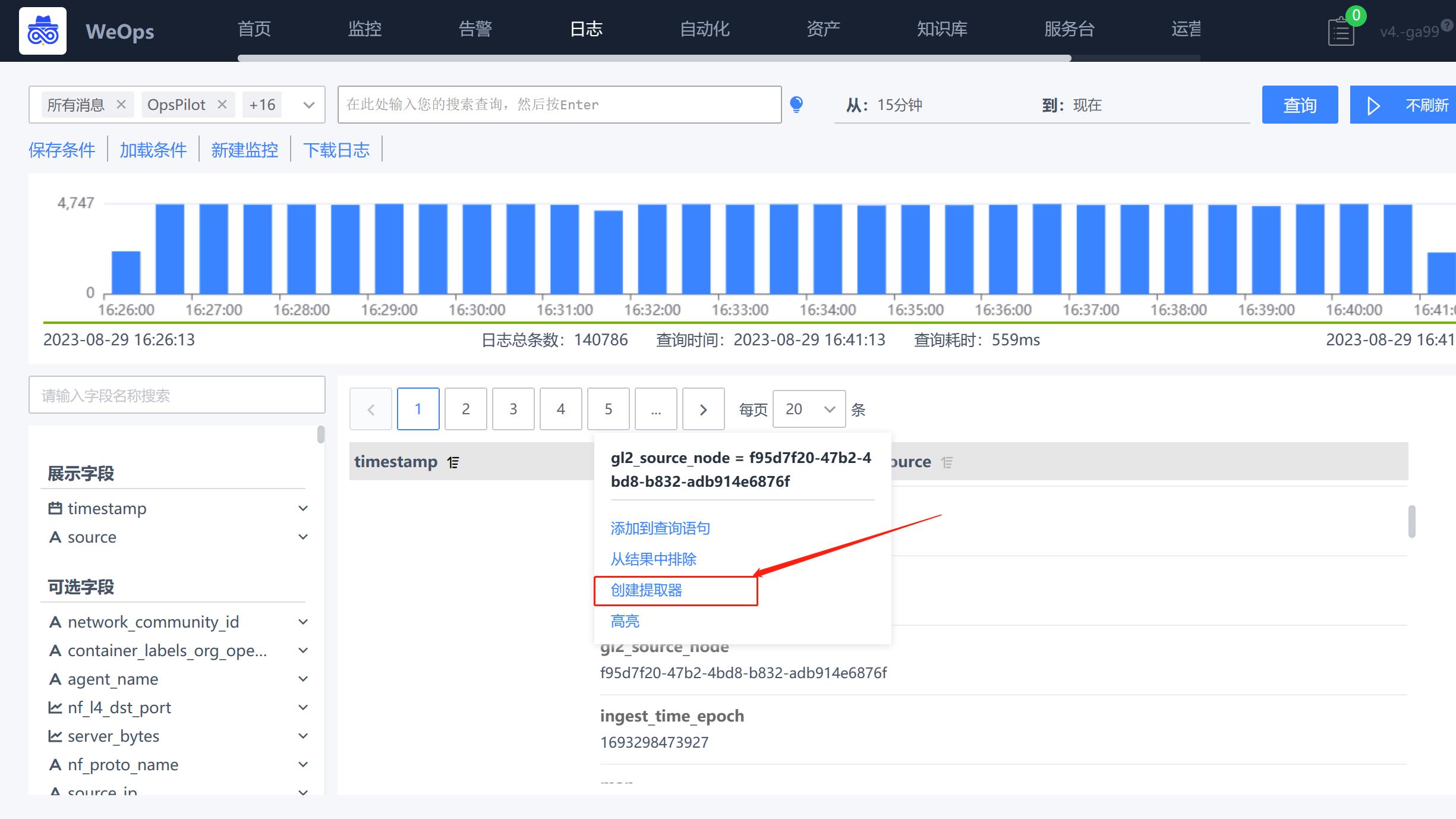

- 对于字段值:支持设置添加到查询语句(直接展示在查询语句里面,用于查询所有带这个字段值的原始日志)、设置“从结果中排除”(在查询语句中展示,用于查询所有不带这个字段值的所有原始日志)、设置“高亮”(把所有带这个字段值都标为黄底)、设置提取器(支持把这个字段值设置提取器,提取出来需要展示的关键信息保存为另外一个字段)

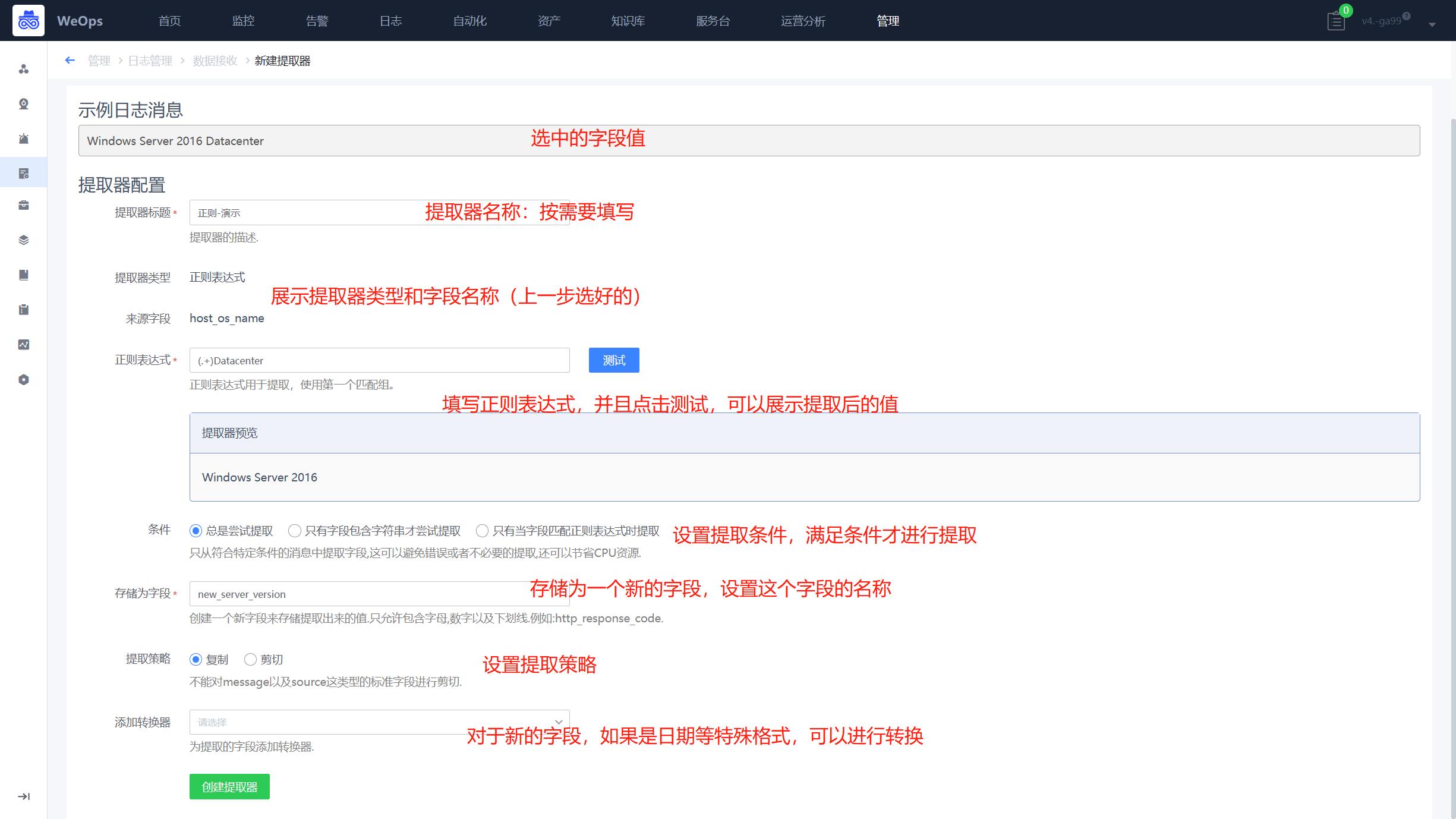

- 字段值提取器:支持复制输入、Grok模式等类型的提取器(各个提取器的对比如下表)。以正则表达式为例,设置提取器支持填写正则表达式、设置条件(什么情况下进行提取)、存储字段、提取策略(复制一个新的,剪切成为一个新的)、添加特殊格式的转换器

- WeOps支持的提取器如下表

| 提取器名称 | 适用 | 说明 |

|---|---|---|

| 复制输入 | 适用于需要从非结构化的日志数据中提取特定字段或值的场景。 | 将原始消息中的一部分数据复制到提取器的规则中,并将其存储在结构化的数据字段中 |

| Grok模式 | 适用于需要从非结构化的日志数据中提取特定字段或值的场景。 | 用于从非结构化的日志数据中提取结构化数据。它使用预定义的Grok模式或自定义Grok模式来匹配和提取数据,包括一些特殊的模式,用于匹配常见的数据格式,如IP地址、日期、时间戳等。(WeOps内置常用的Grok表达式)(Grok表达式是一种用于解析非结构化或半结构化数据的模式匹配工具。它是由Elasticsearch社区开发的一种基于正则表达式的模式匹配语言) |

| JSON | 适用于处理JSON格式的日志数据的场景。 | 可以从JSON格式的数据中提取特定的字段,并将它们存储在结构化的数据字段中。 |

| 正则表达式 | 适用于需要从未结构化的日志数据中提取特定字段或值的场景。 | 使用正则表达式从数据中提取特定的字段,并将它们存储在结构化的数据字段中 |

| 正则表达式替换 | 适用于需要替换日志数据中特定字符串的场景。 | 正则表达式替换器可以使用正则表达式从数据中匹配特定的模式,并将其替换为指定的字符串 |

| 分隔 | 适用于需要从日志数据中提取特定字段或值的场景。 | 使用指定的分隔符将数据分割成多个部分,并将它们存储在结构化的数据字段中 |

| 子窜捕获 | 适用于需要从日志数据中提取特定子字符串的场景。 | 使用指定的开始和结束字符串或位置来捕获数据中的子串,并将它们存储在结构化的数据字段中 |

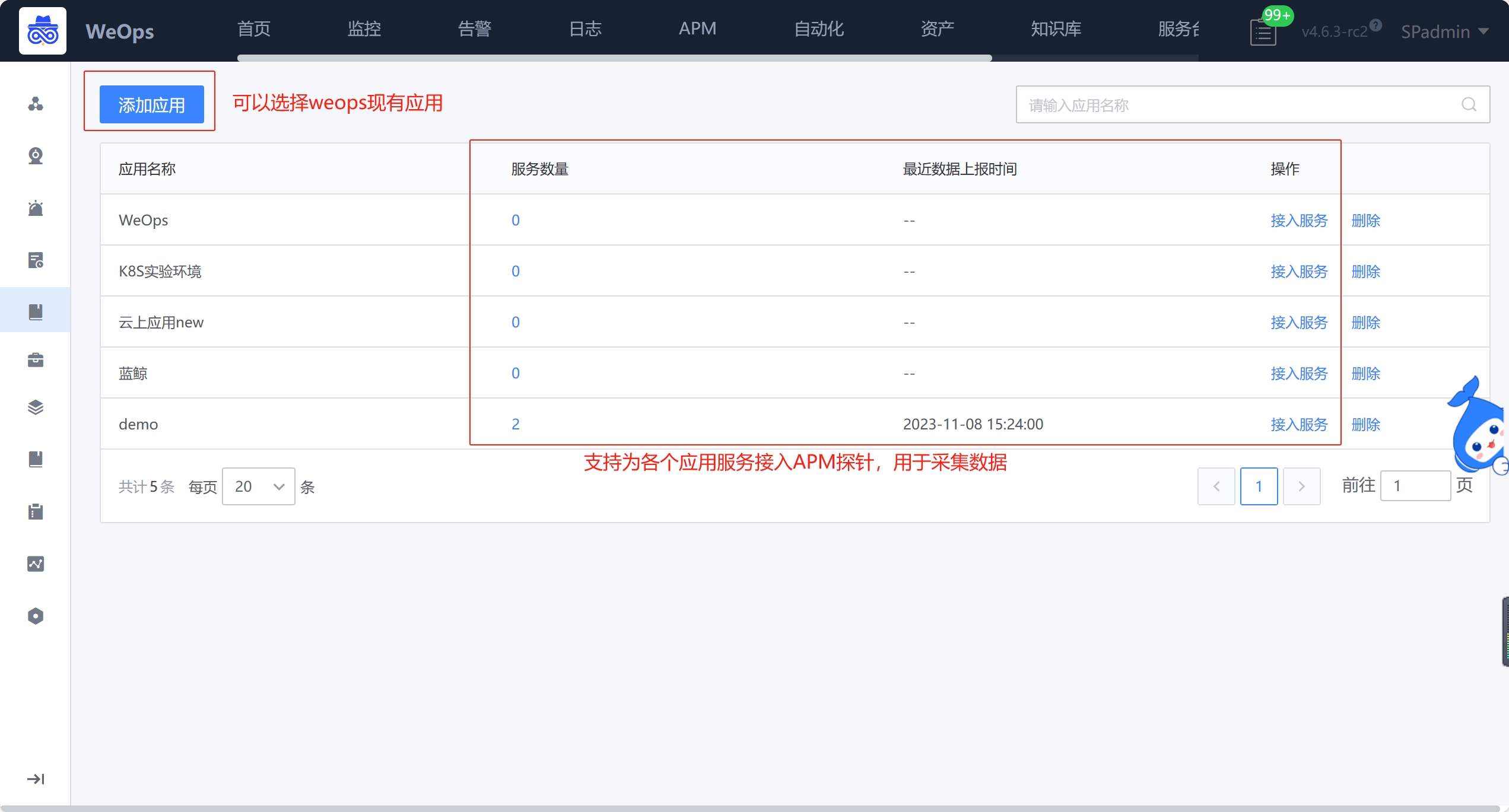

APM

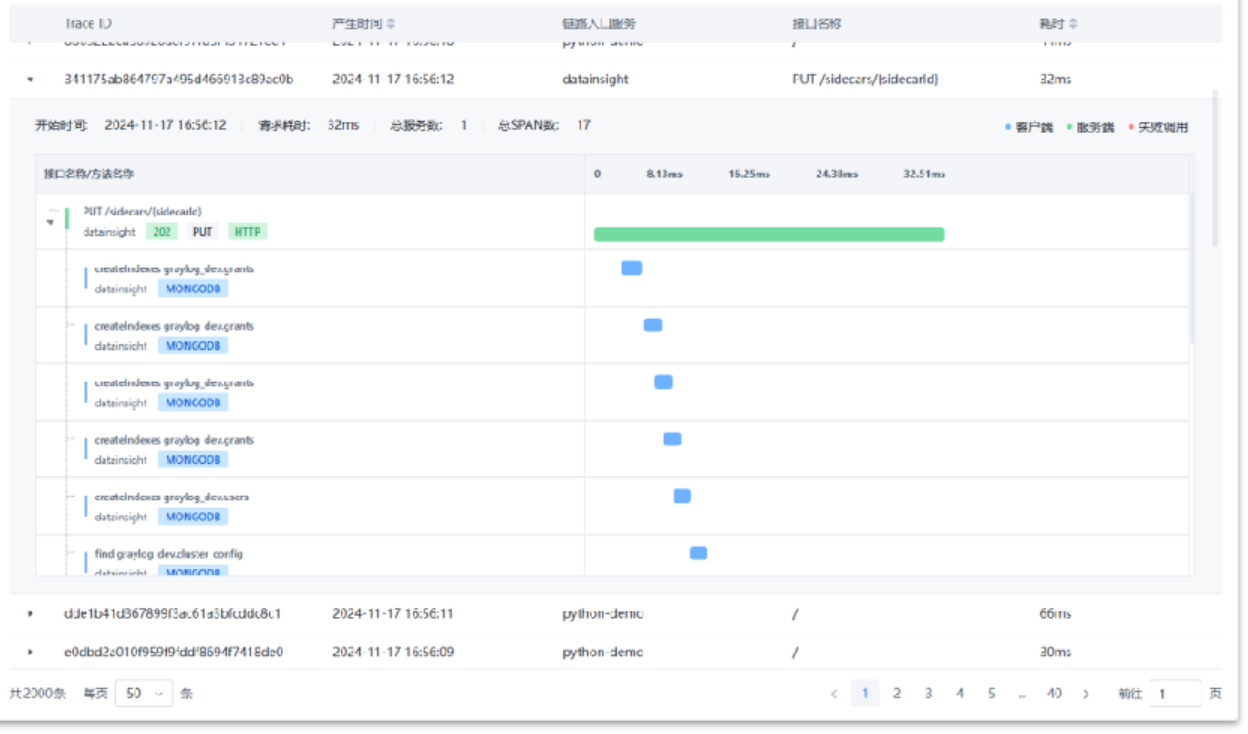

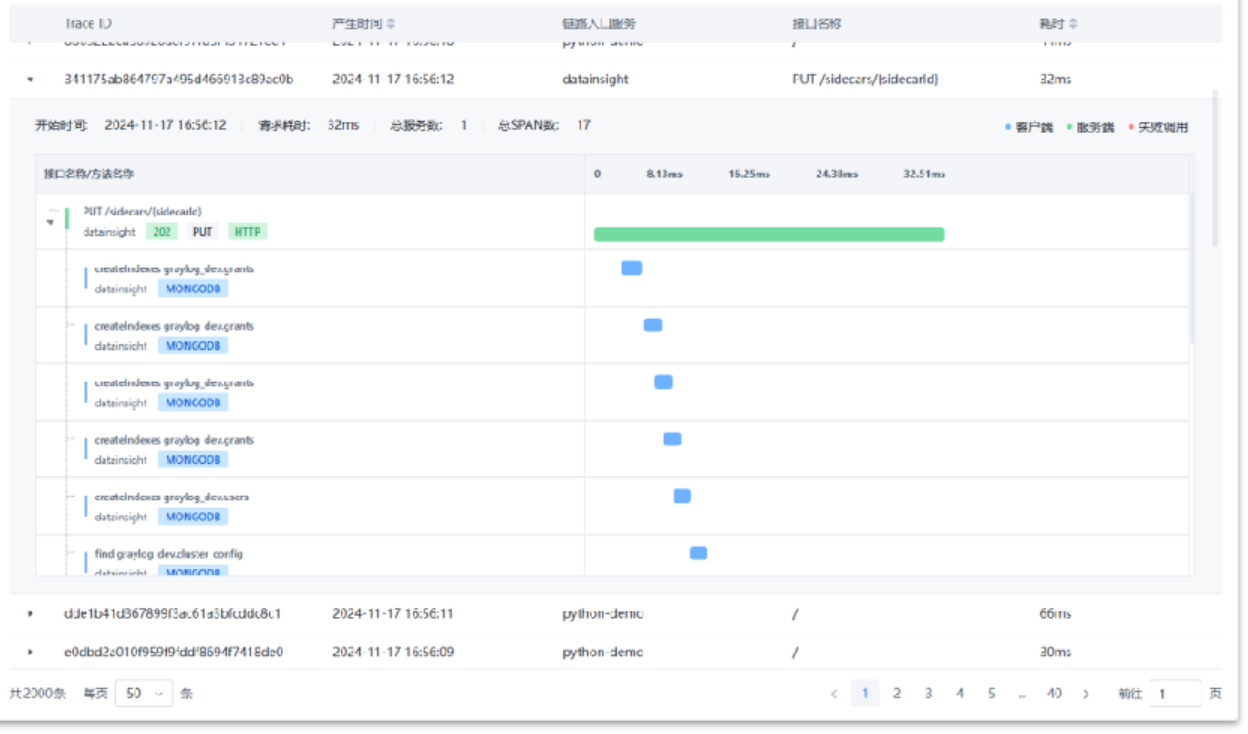

调用链检索

如下图,当应用的服务接入完成之后,可以在APM-调用链检索进行trace的搜索和查看。可分为如下四个区域,分别进行trace的条件/时间设置、trace列表查看和各个请求详情的查看。

- ①搜索条件区域:支持切换不同的应用和对应的服务,也支持通过trace ID或者链路入口接口/方法的关键词进行搜索,此外也可以设置耗时查询范围

- ②时间选择器:支持选择trace的产生时间范围,便于进一步锁定

- ③检索结果:展示符合搜索条件下所有的trace列表,可展开查看详情以及具体的请求步骤,各个请求也可点击查看详情。

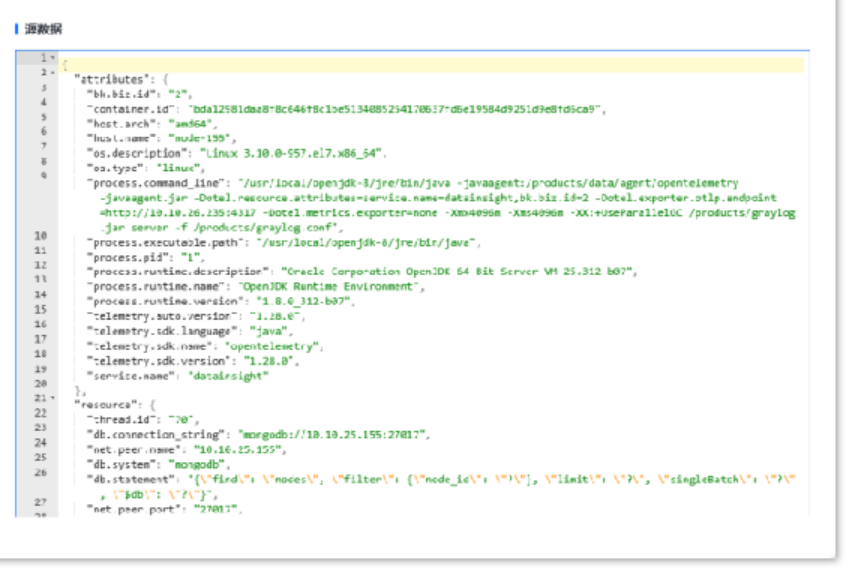

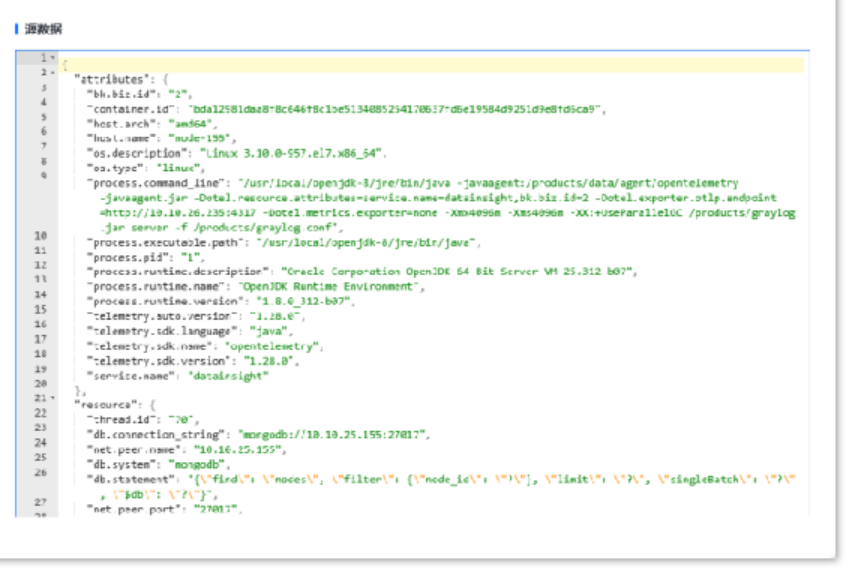

- ④请求详情:展示该次请求的相关信息,具体如下:

基本信息:该请求的基本调用信息,客户端和服务端调用的耗时情况

源数据:客户端和服务端原始的数据

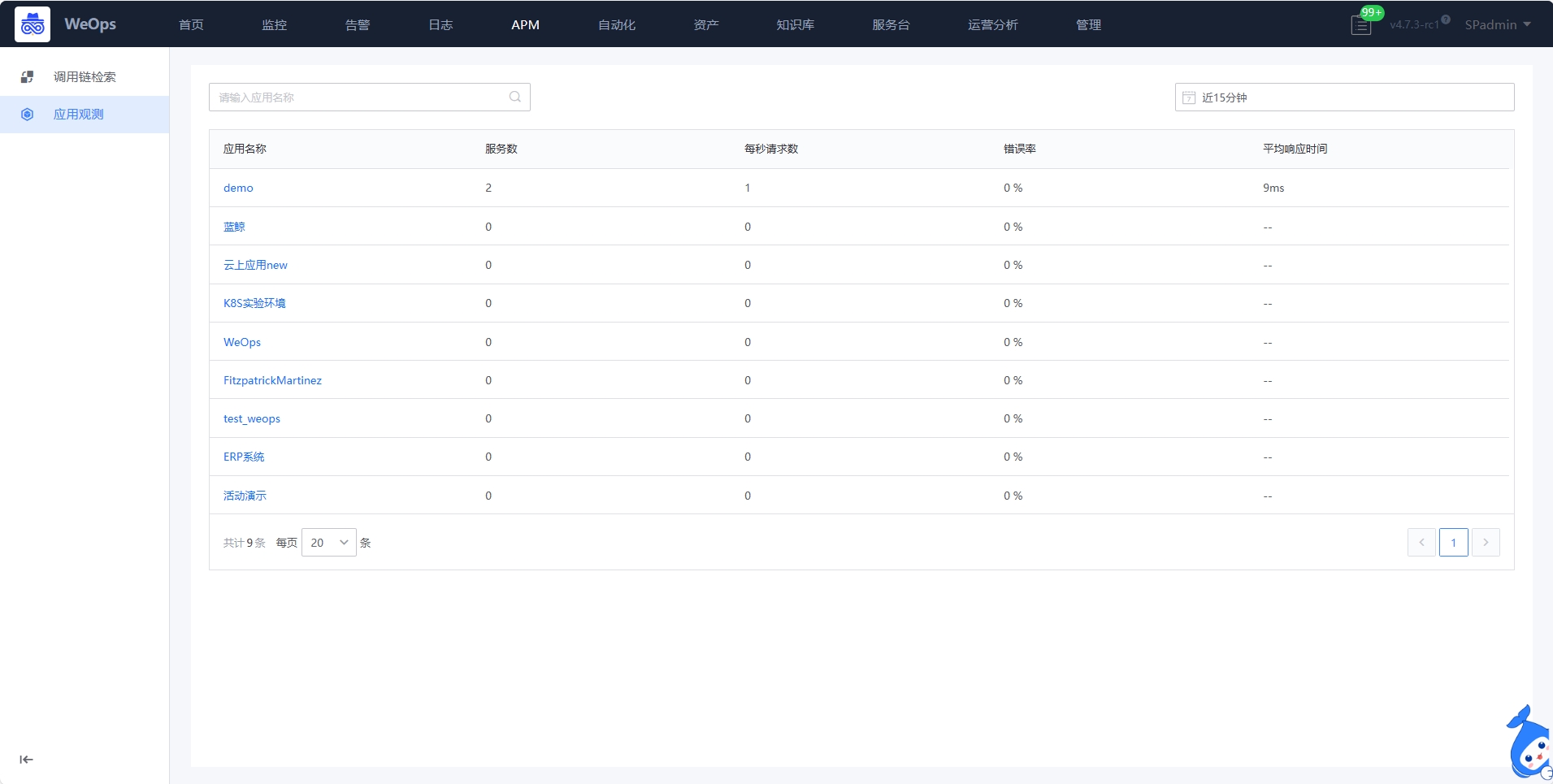

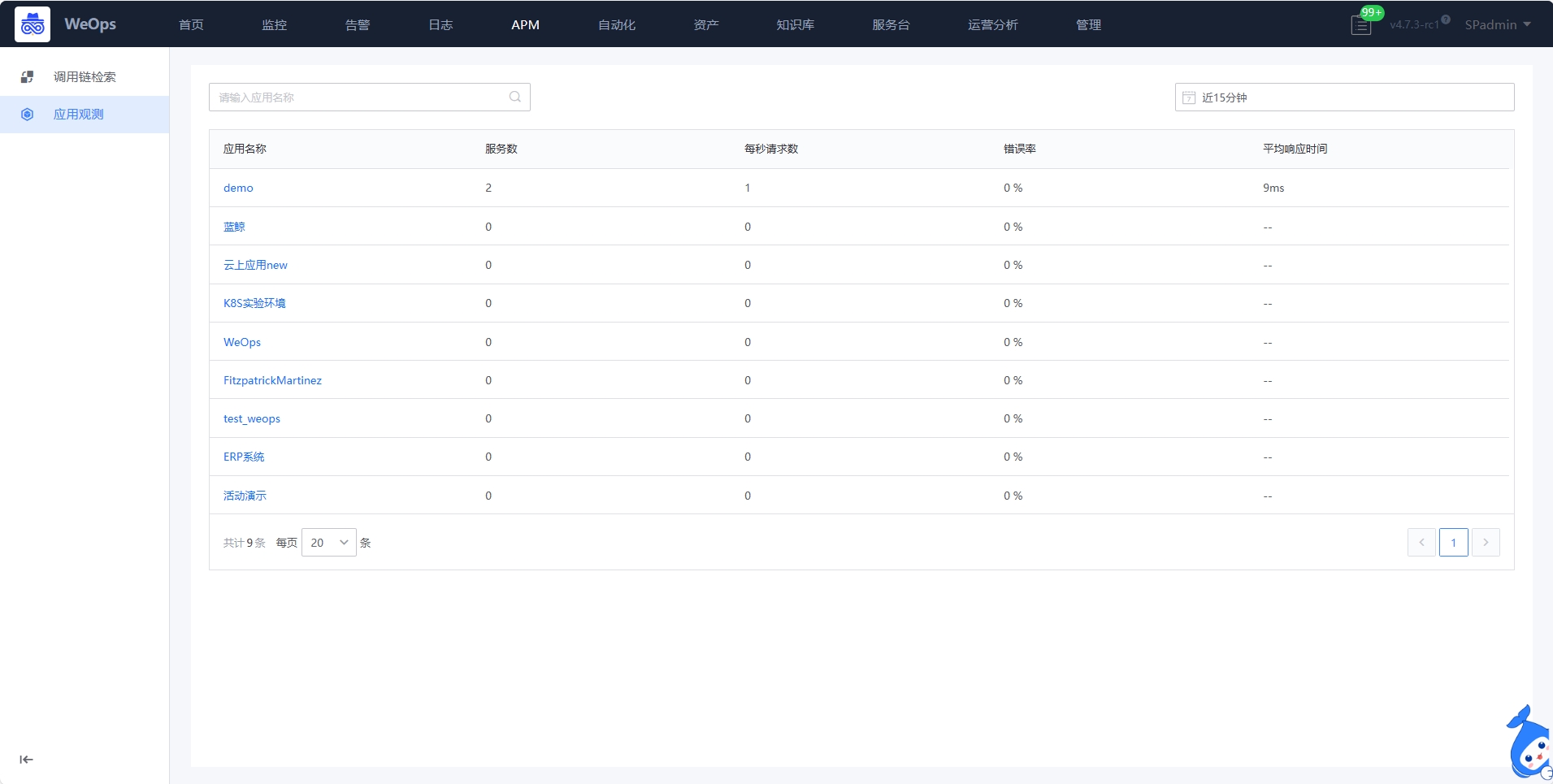

应用观测

应用观测提供应用下服务运行态全景调用关系和服务、接口请求量统计情况,帮基于全景视角观测系统运行时实际流量运行状态,清晰构建系统调用依赖关系包含服务、外部服务、数据库、中间件等系统组件。

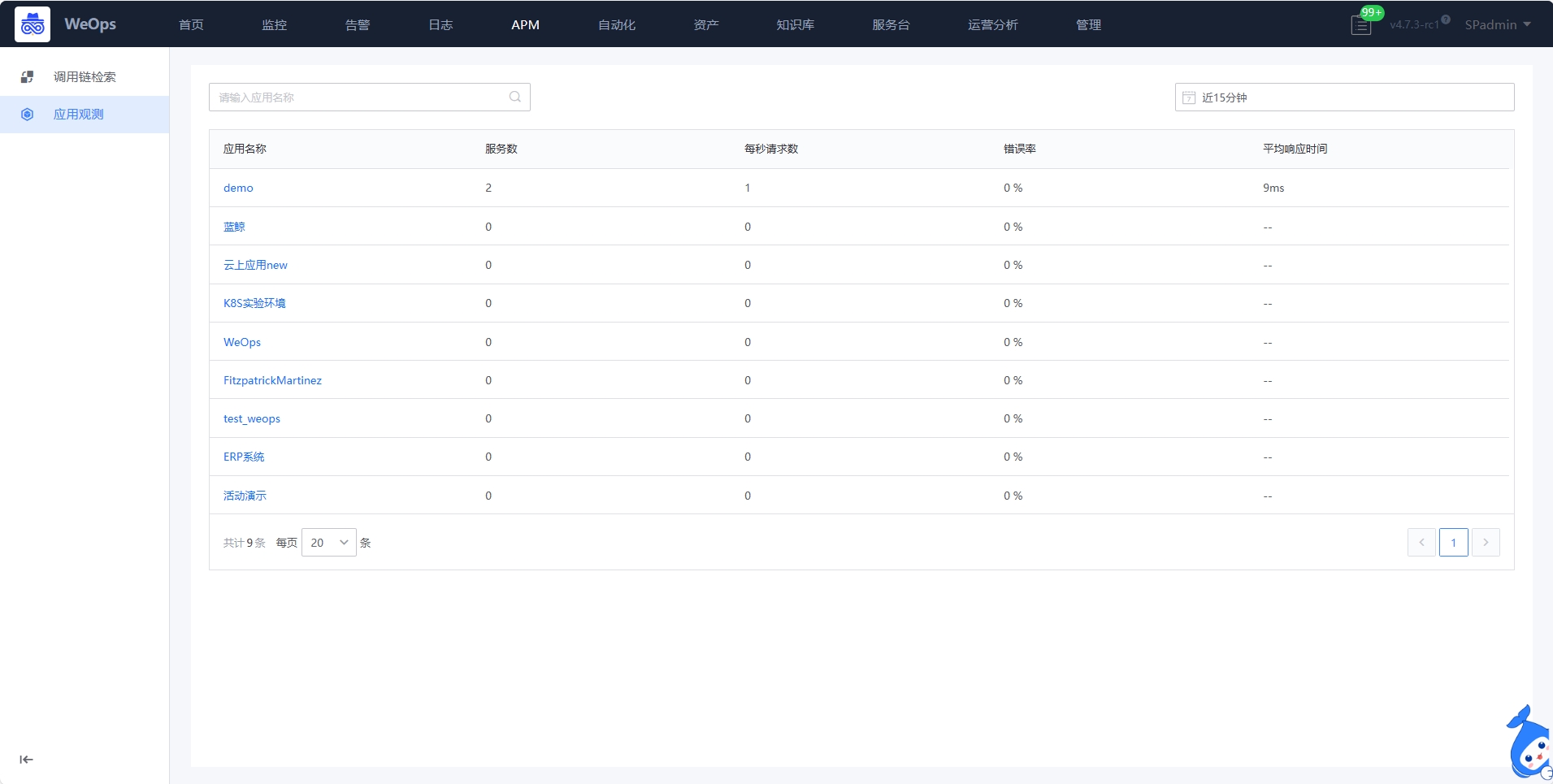

应用列表

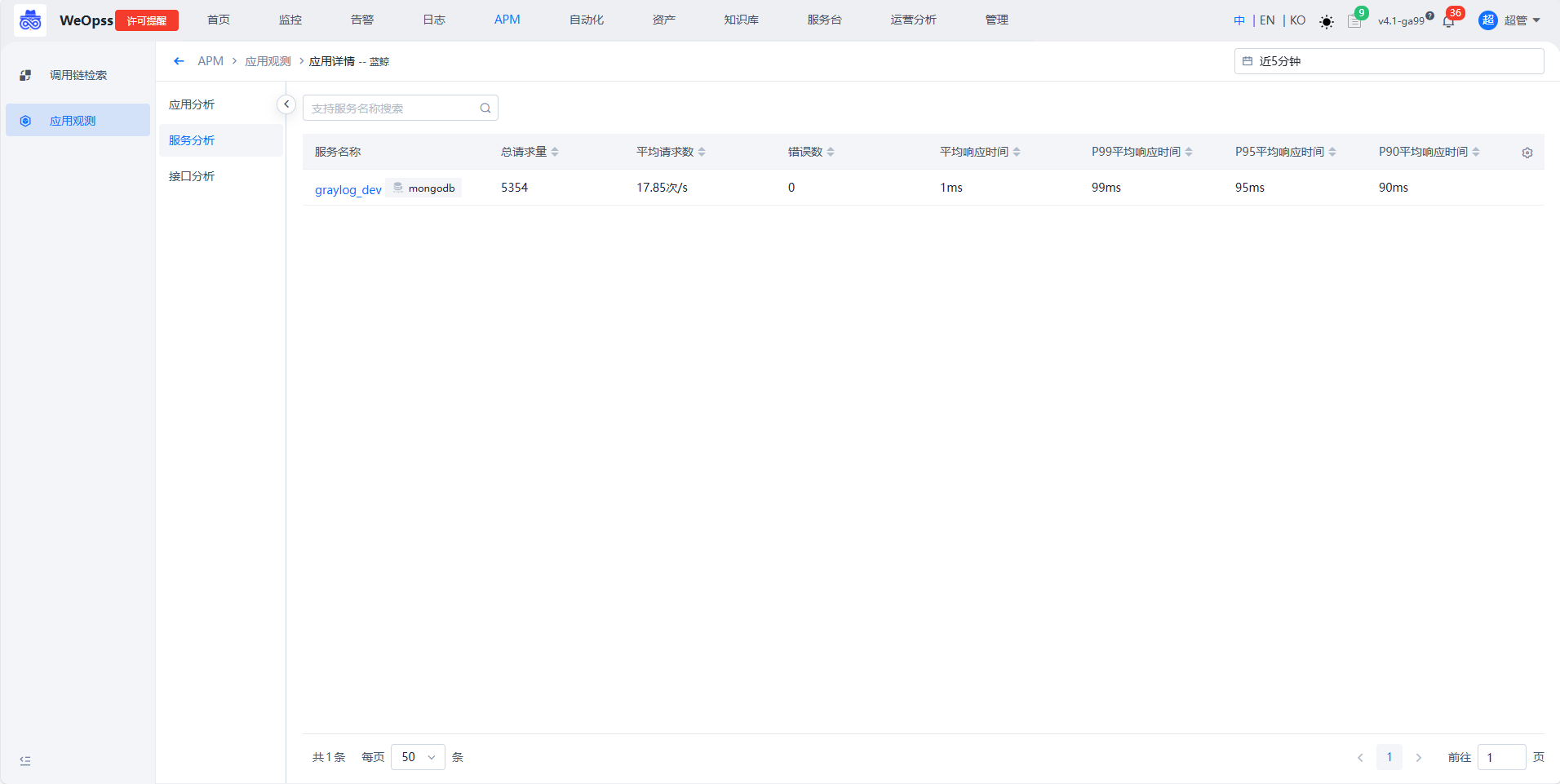

- 如下图,应用列表展示接入的所有应用,以及该应用的关键指标,点击进入该应用的详情页面。

- 应用的详情页分为三个模块:应用分析——展示整个应用的拓扑和关键指标情况,服务分析——该应用下所有服务的性能情况,接口分析——所有接口的性能情况。

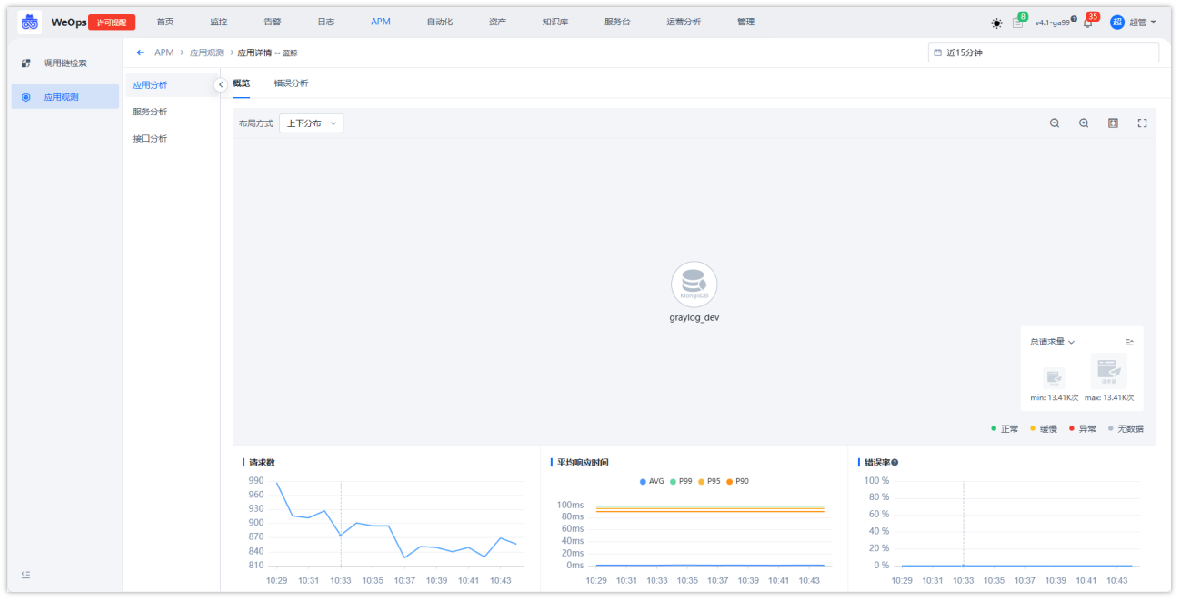

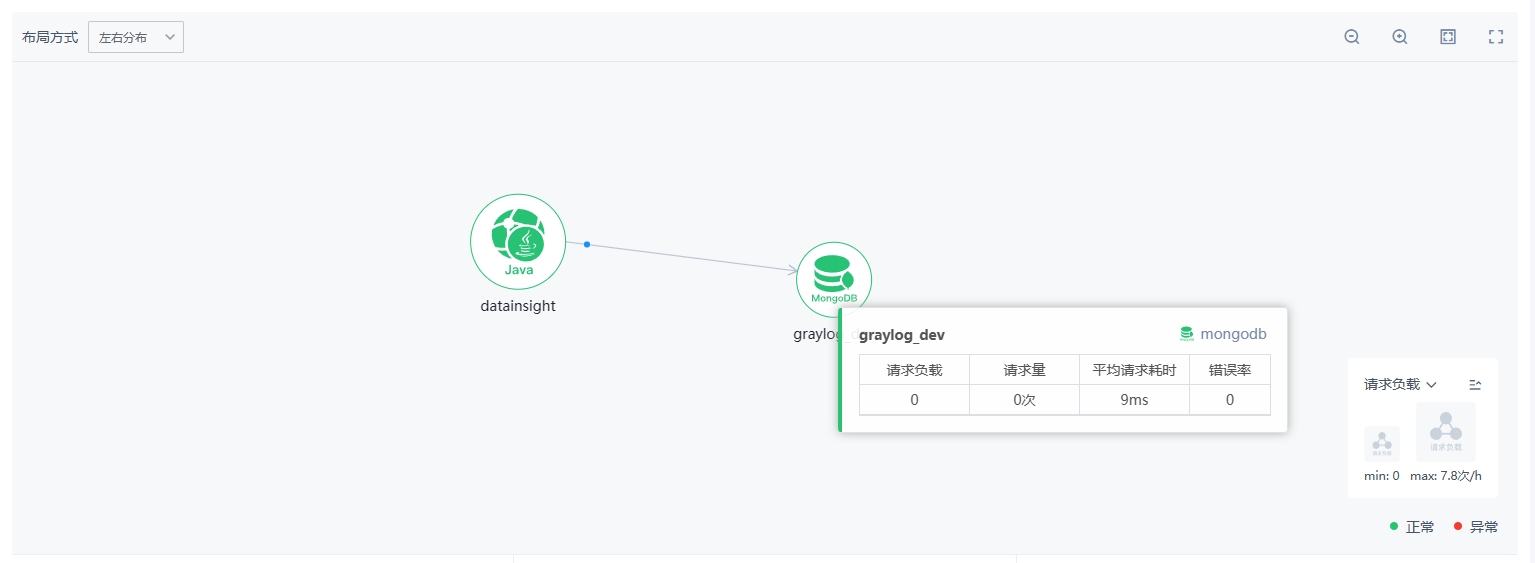

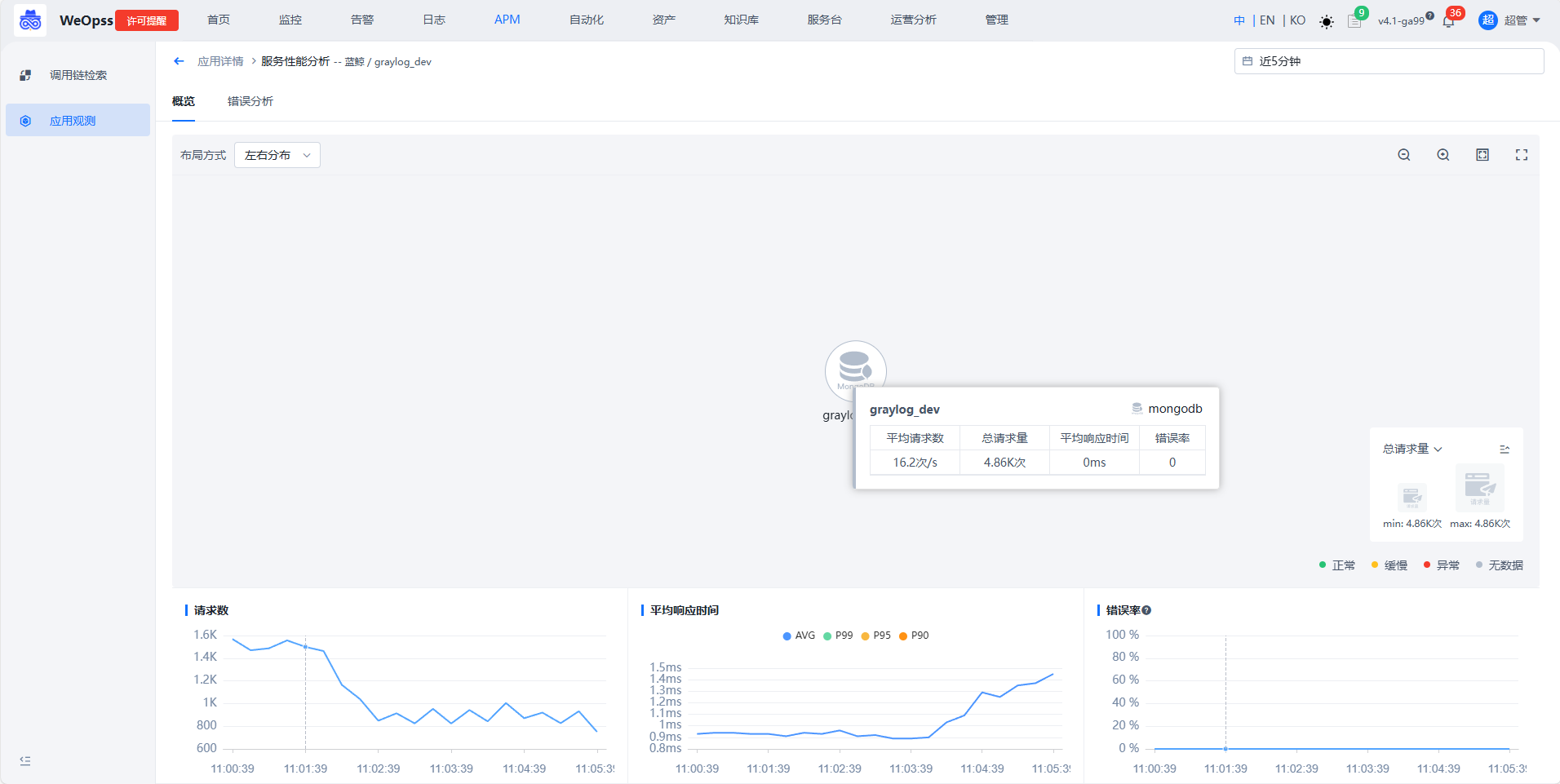

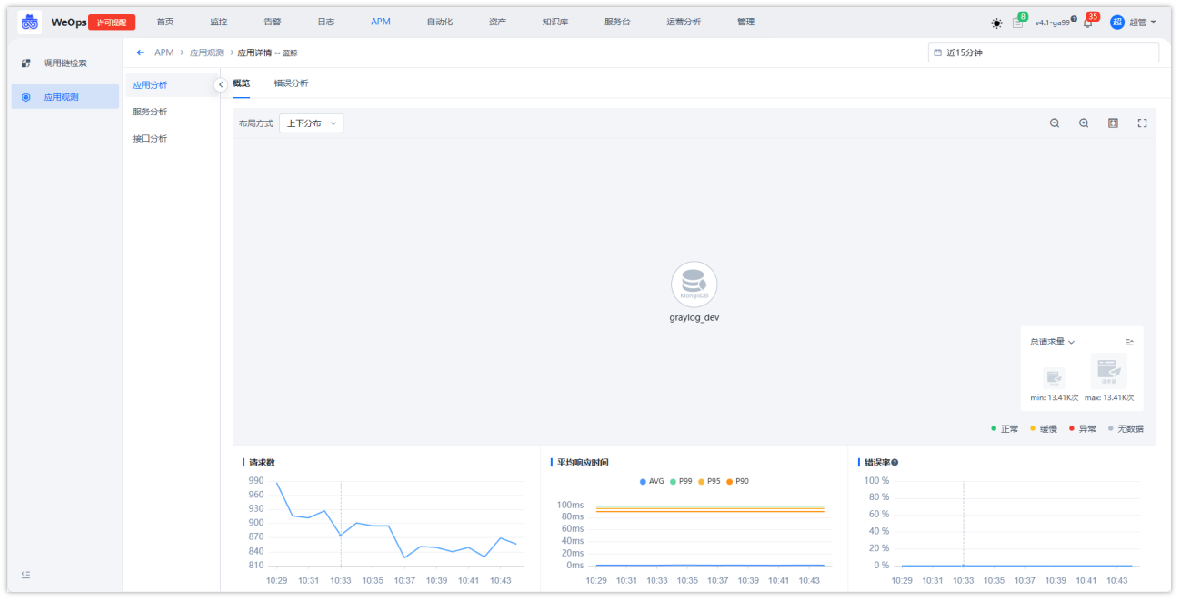

应用分析

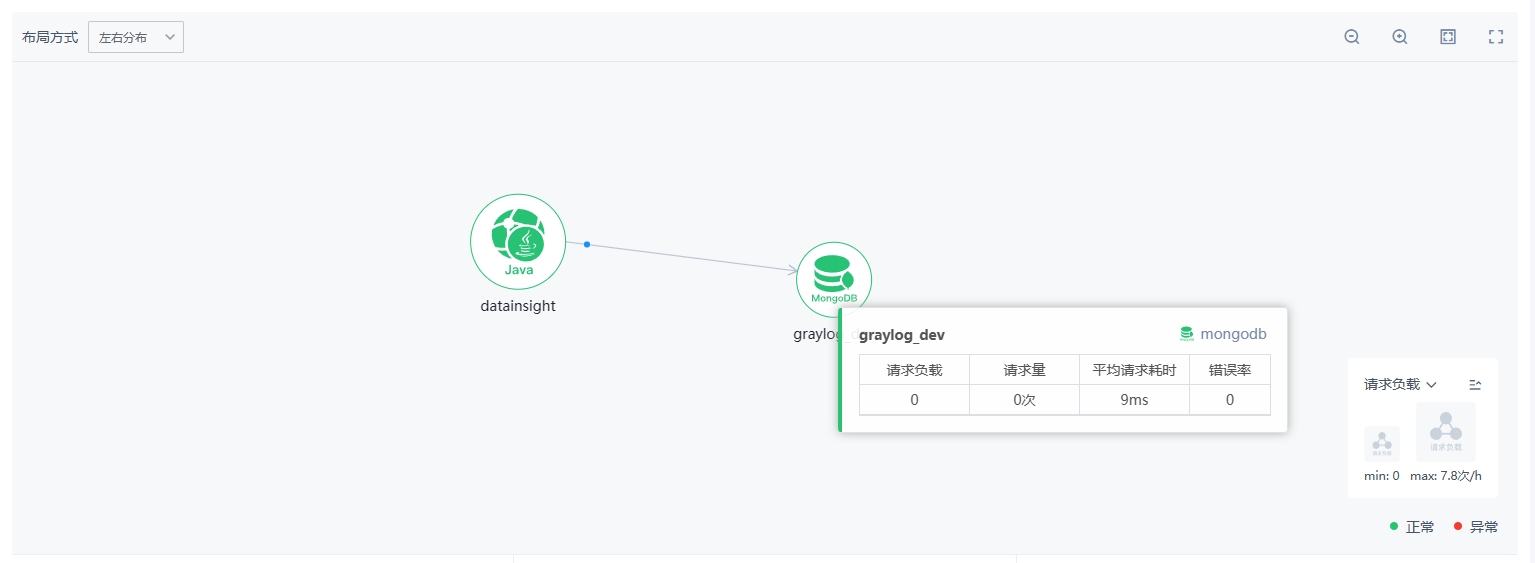

- 如下图,展示整个应用的全景拓扑图和该应用的关键指标信息,具体说明如下

① 时间选择区域:支持切换时间范围,切换后下方的拓扑图和指标折线图会根据选择的时间范围更新展示。

② 应用全景拓扑图:展示该应用所有服务的调用拓扑关系,具体说明如下

节点图标大小:根据服务请求量和请求负载判断节点拓扑大小,确定当前拓扑的最大值和最小值,其余节点按比例确定节点大小

图标悬停展示:将鼠标悬停在节点可以查看该节点详情,包括负载、请求量、耗时、错误等信息

③ 应用性能关键指标:提供当前时间范围的请求数量,错误数、服务请求,响应时间的关键指标折线图

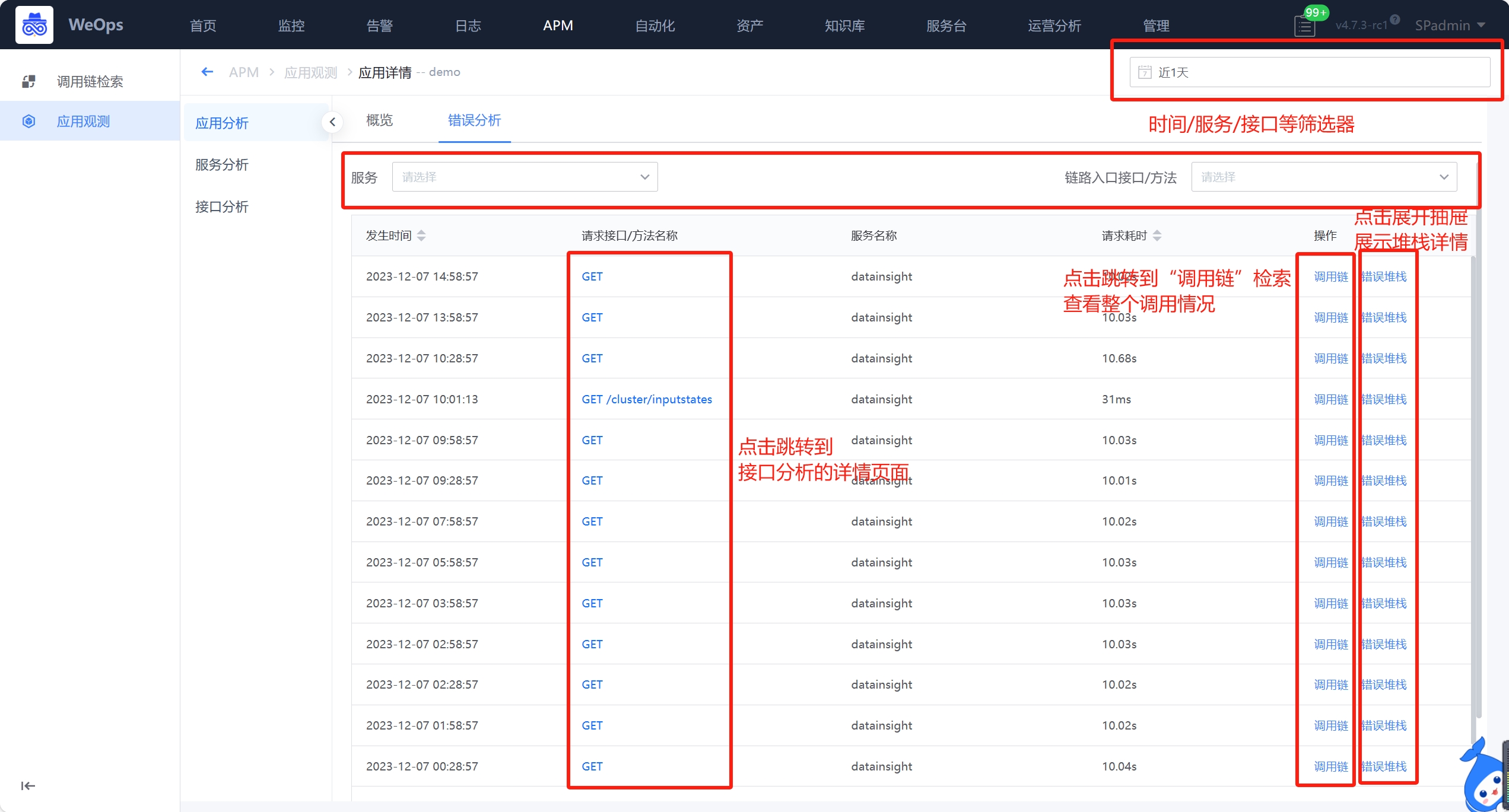

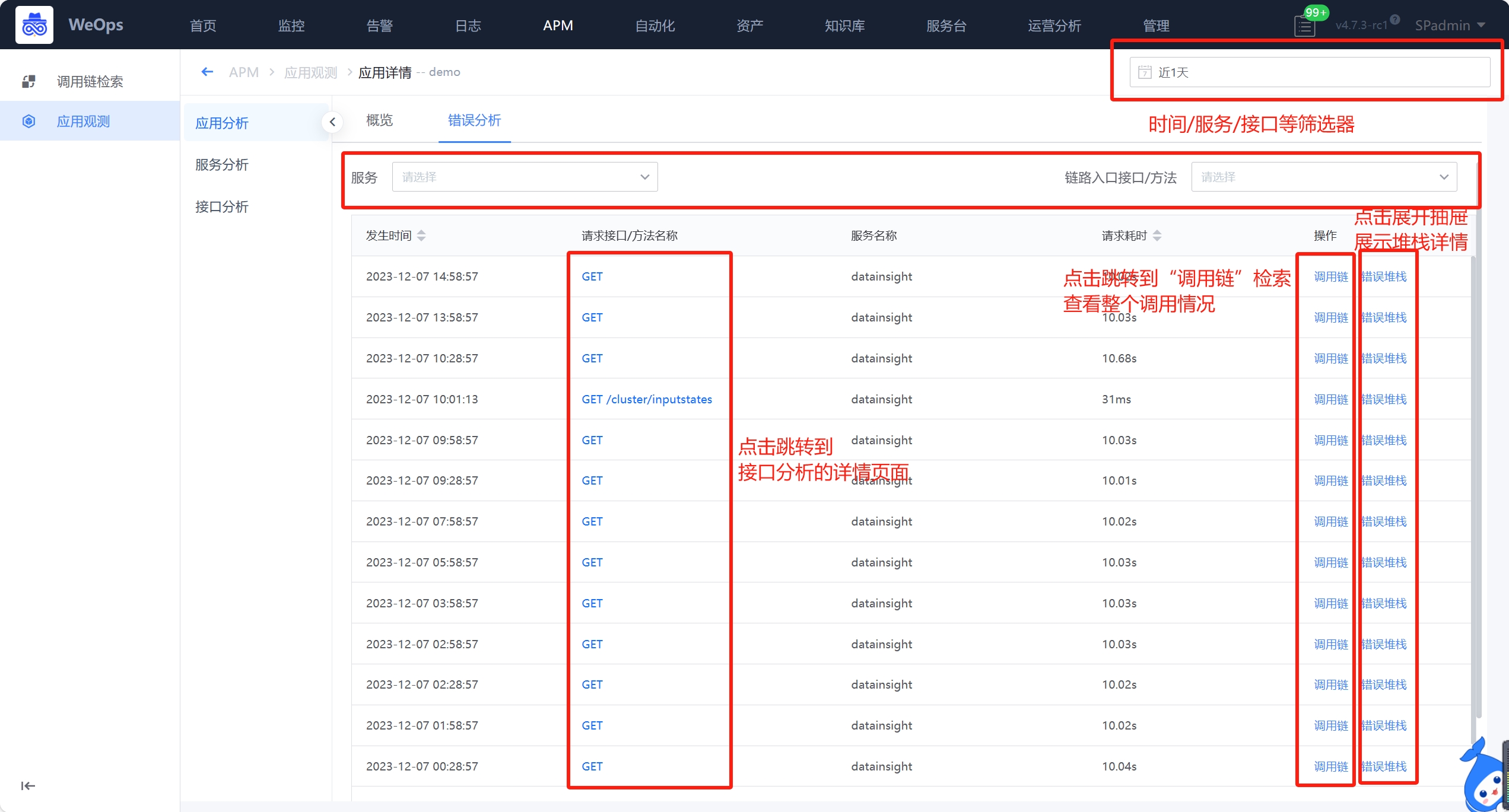

④ 错误分析:如下图,切换可以查询所有错误的情况,支持按照时间/服务/接口/方法进行筛选。点击接口名称可以调整至这个接口的分析页面;点击调用链,可以跳转到该请求的trace详情页;点击错误堆栈,可以查看堆栈的详情。

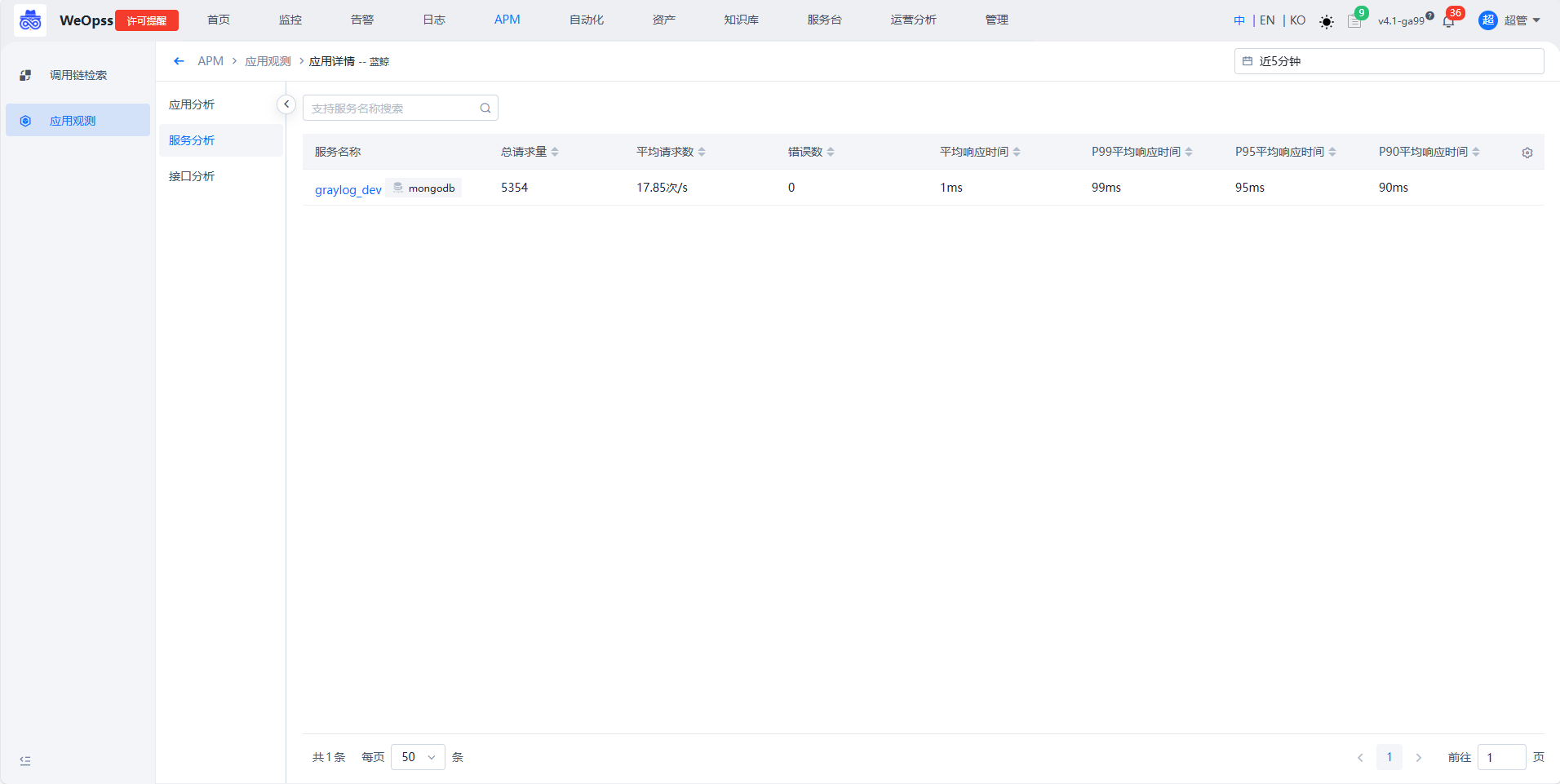

服务分析

- 如下图,展示该应用下所有服务的列表,展开后可以查看服务的详情

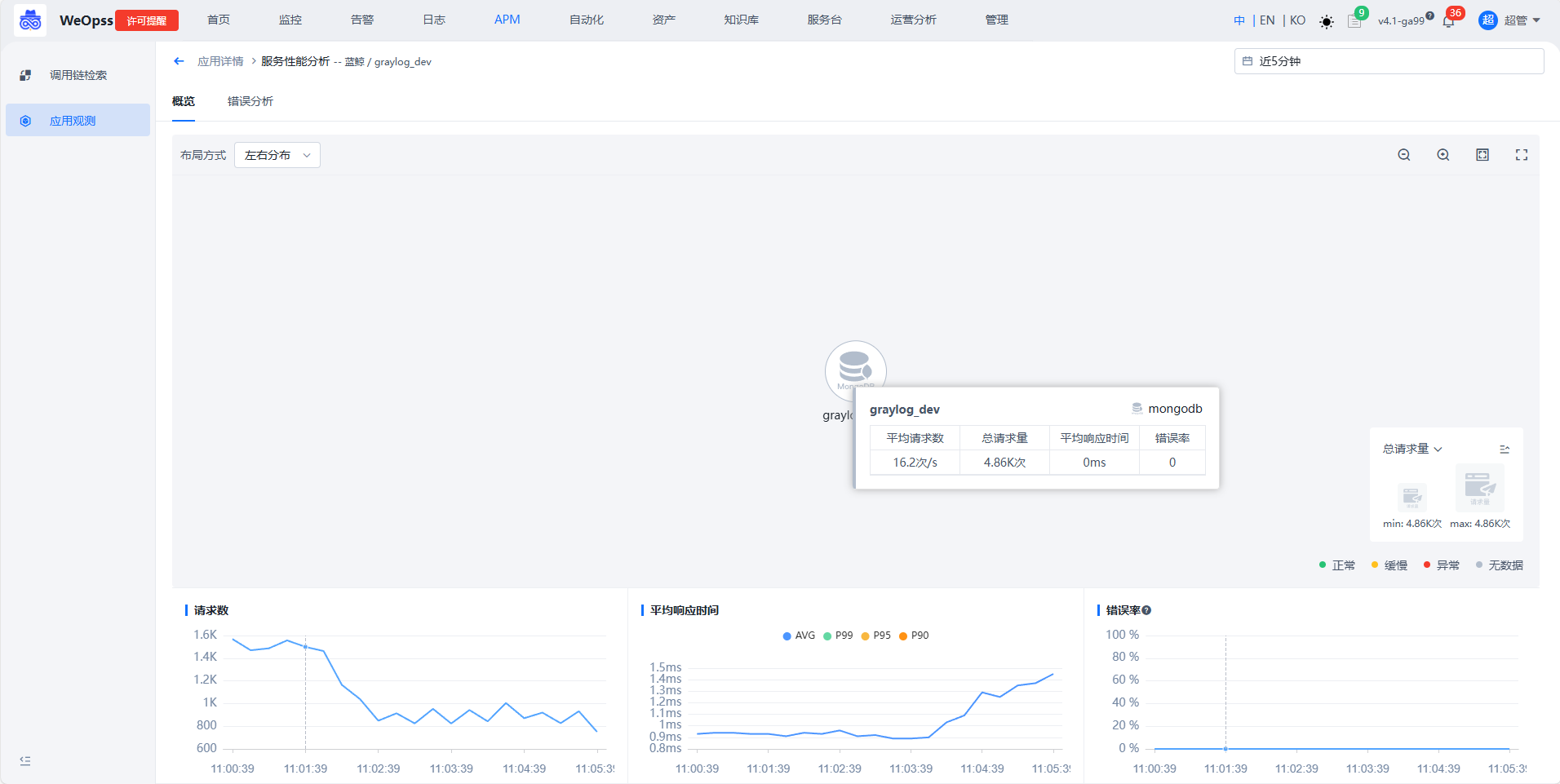

- 如下图,展示该服务相互调用的拓扑关系、关键指标(请求、响应时间、错误率)、错误分析

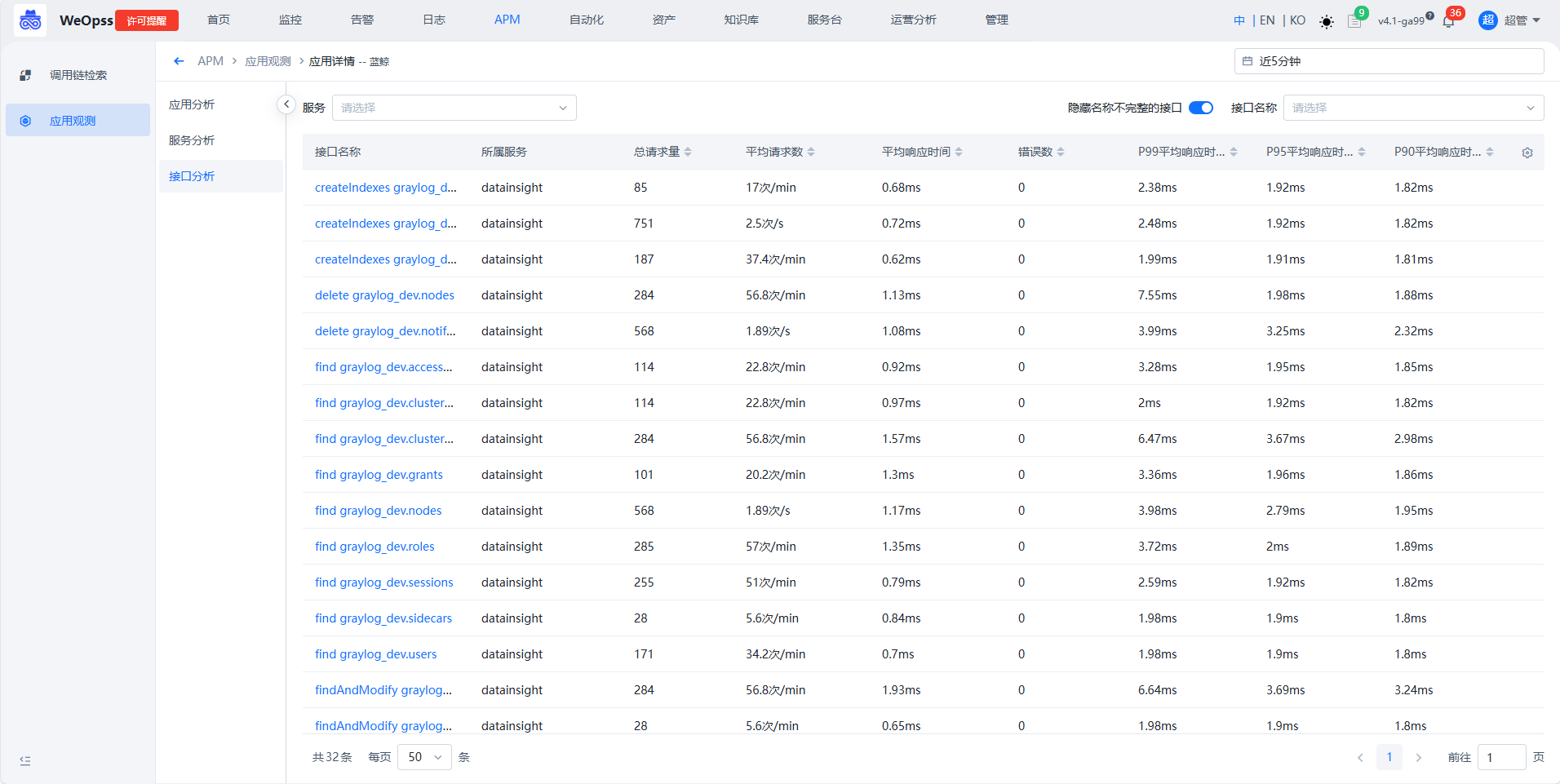

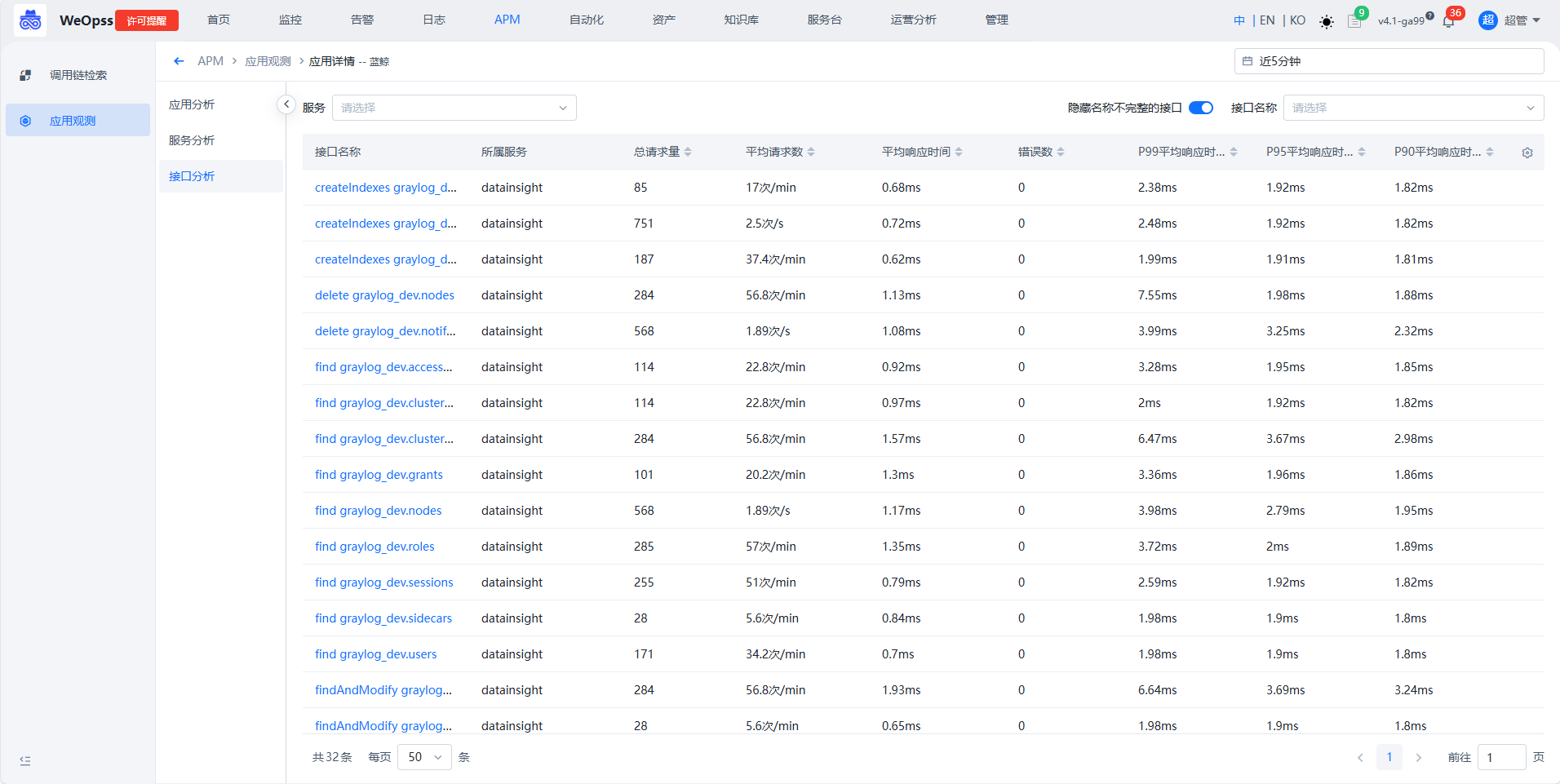

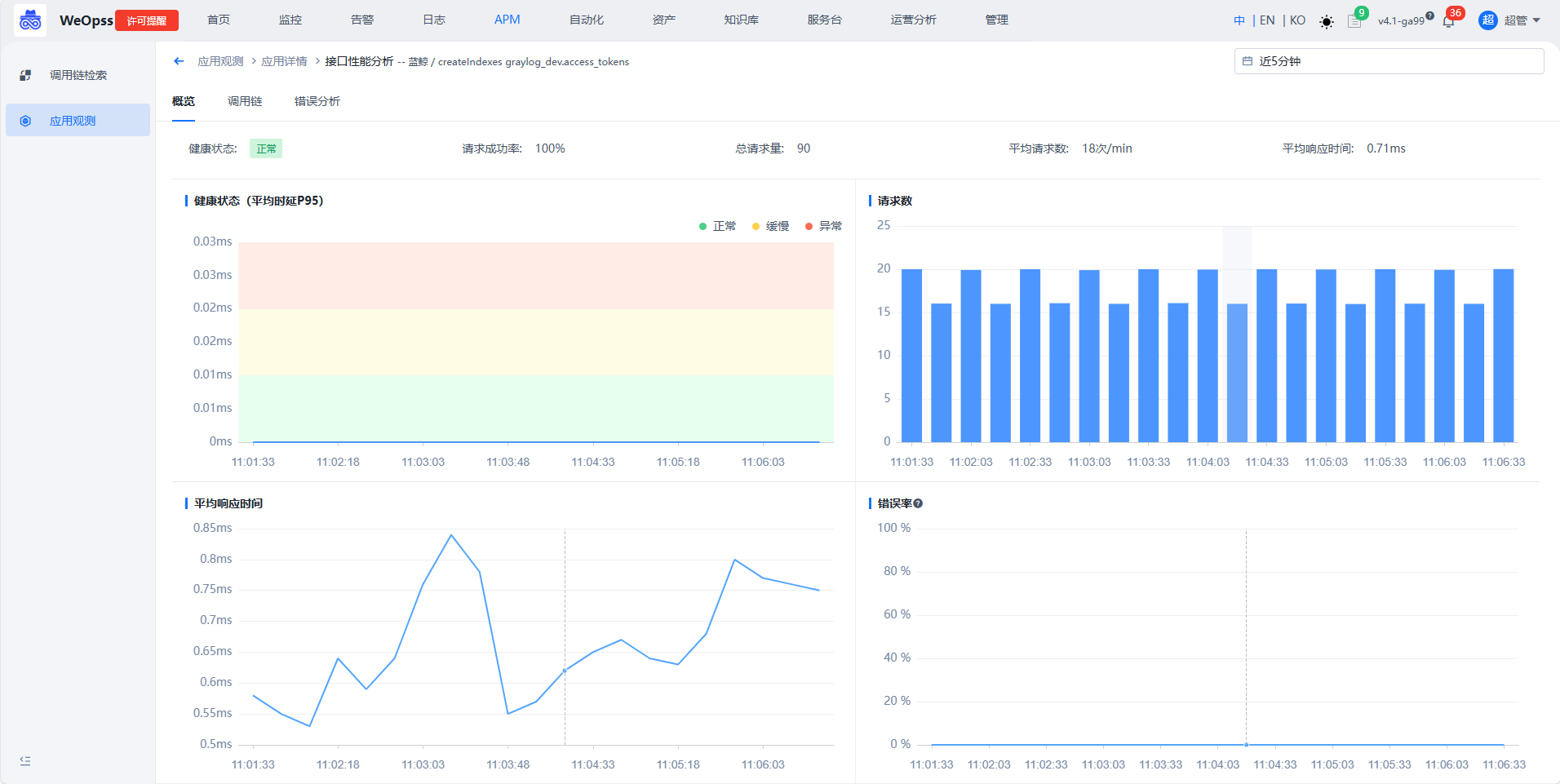

接口分析

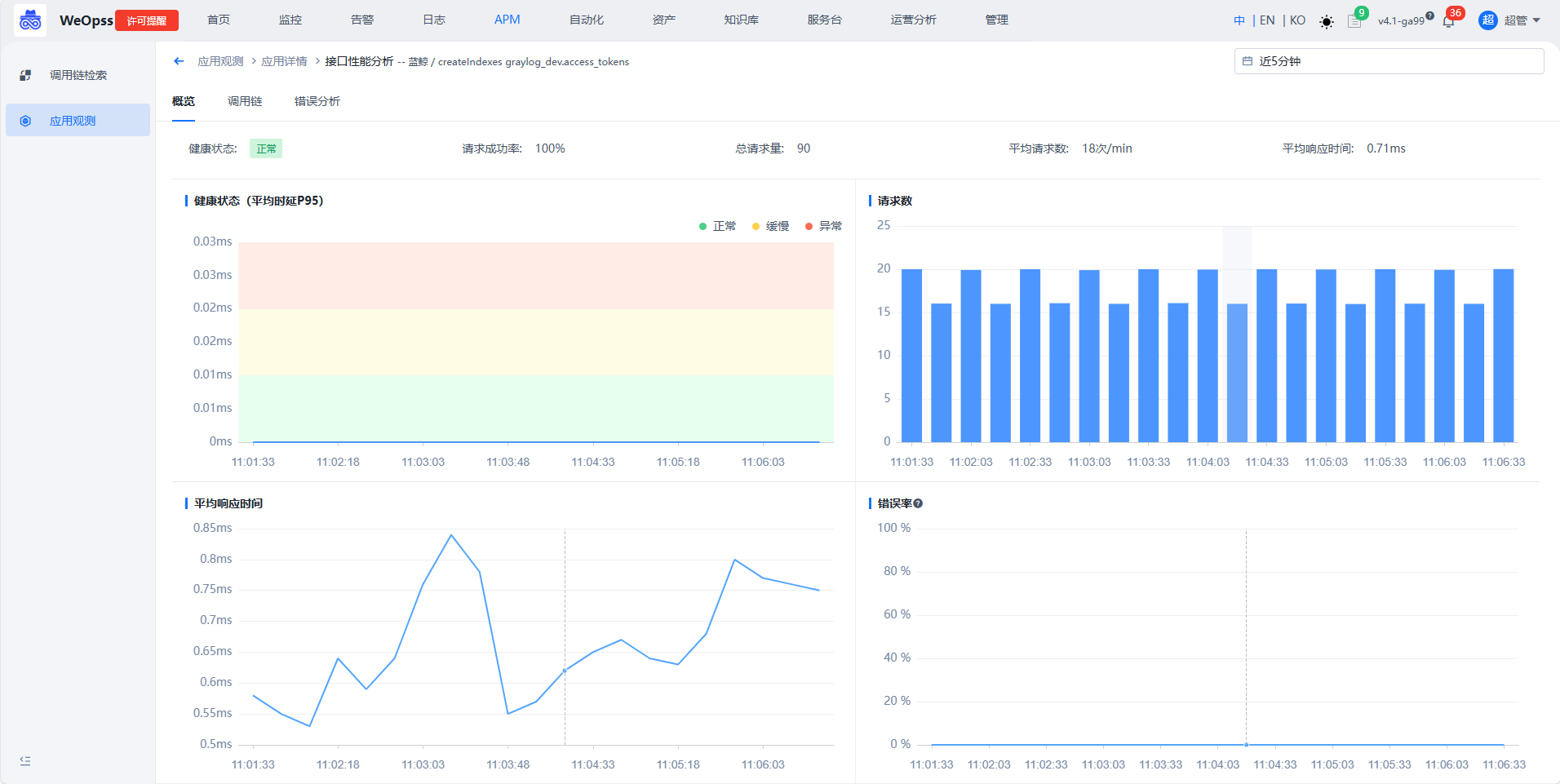

- 如下图,展示该应用下所有接口的列表,展开后可以查看接口的详情

- 如下图,展示该接口关键指标(请求、响应时间、错误率)、错误分析

资产数据

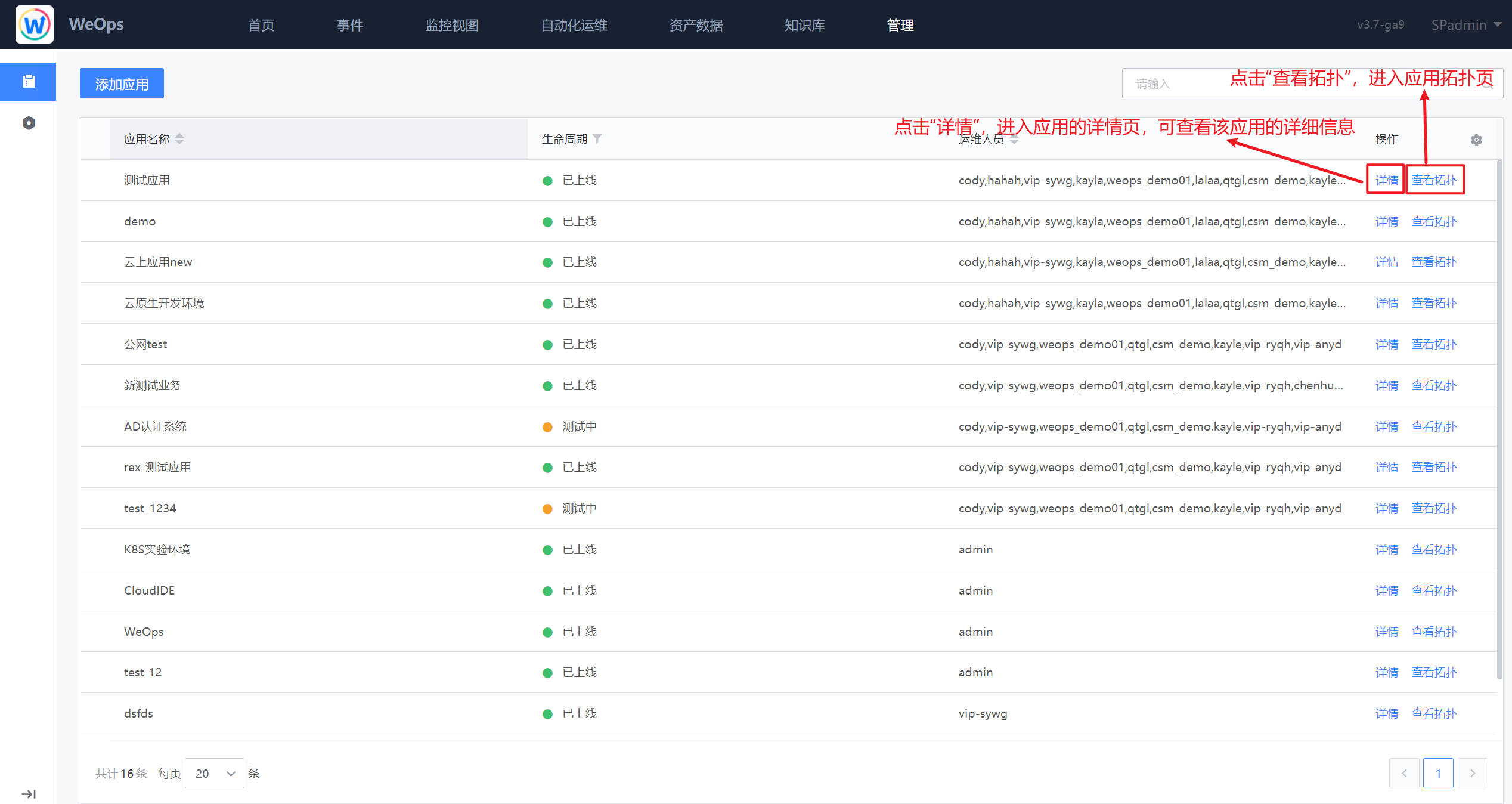

应用

如下图,应用管理界面展示了应用以及子应用的相关信息。可点击查看该应用的详情和拓扑信息,进行应用新建和归档操作。

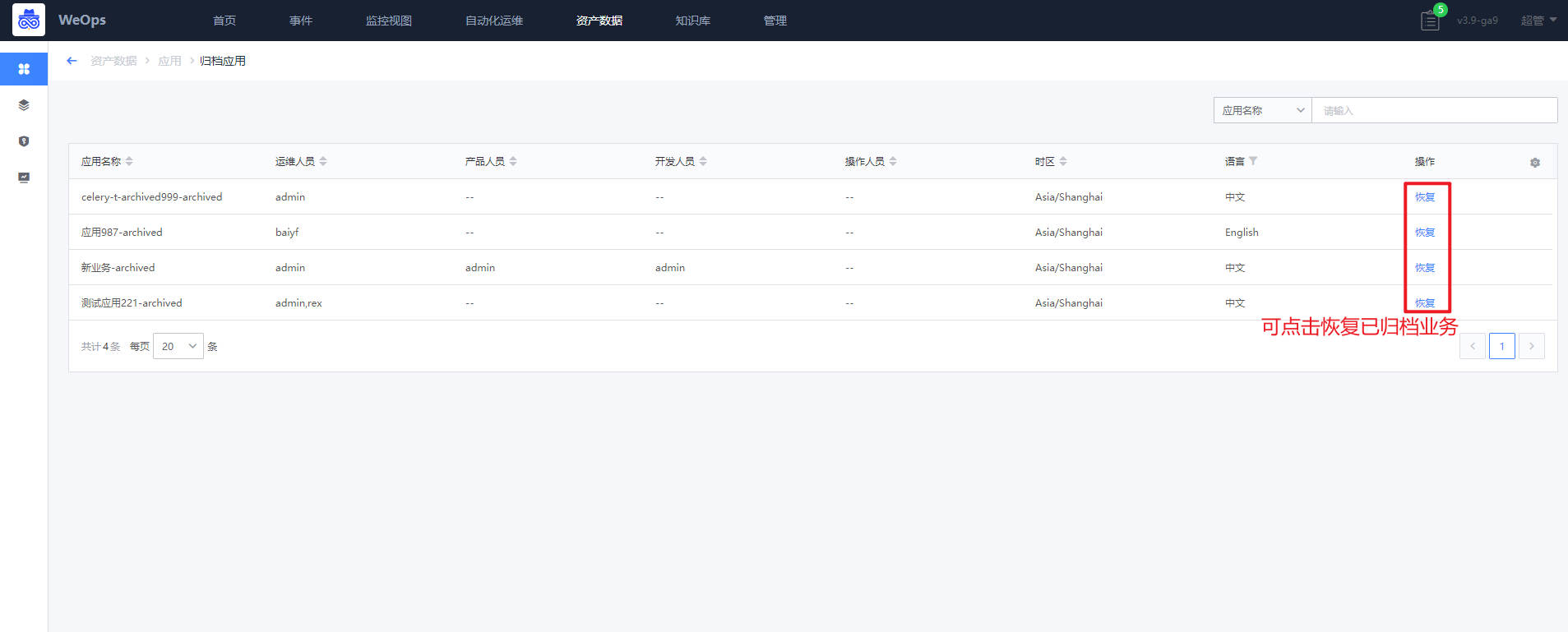

支持应用归档功能,已归档应用可以在“归档列表”中查看,也可以操作“恢复”应用

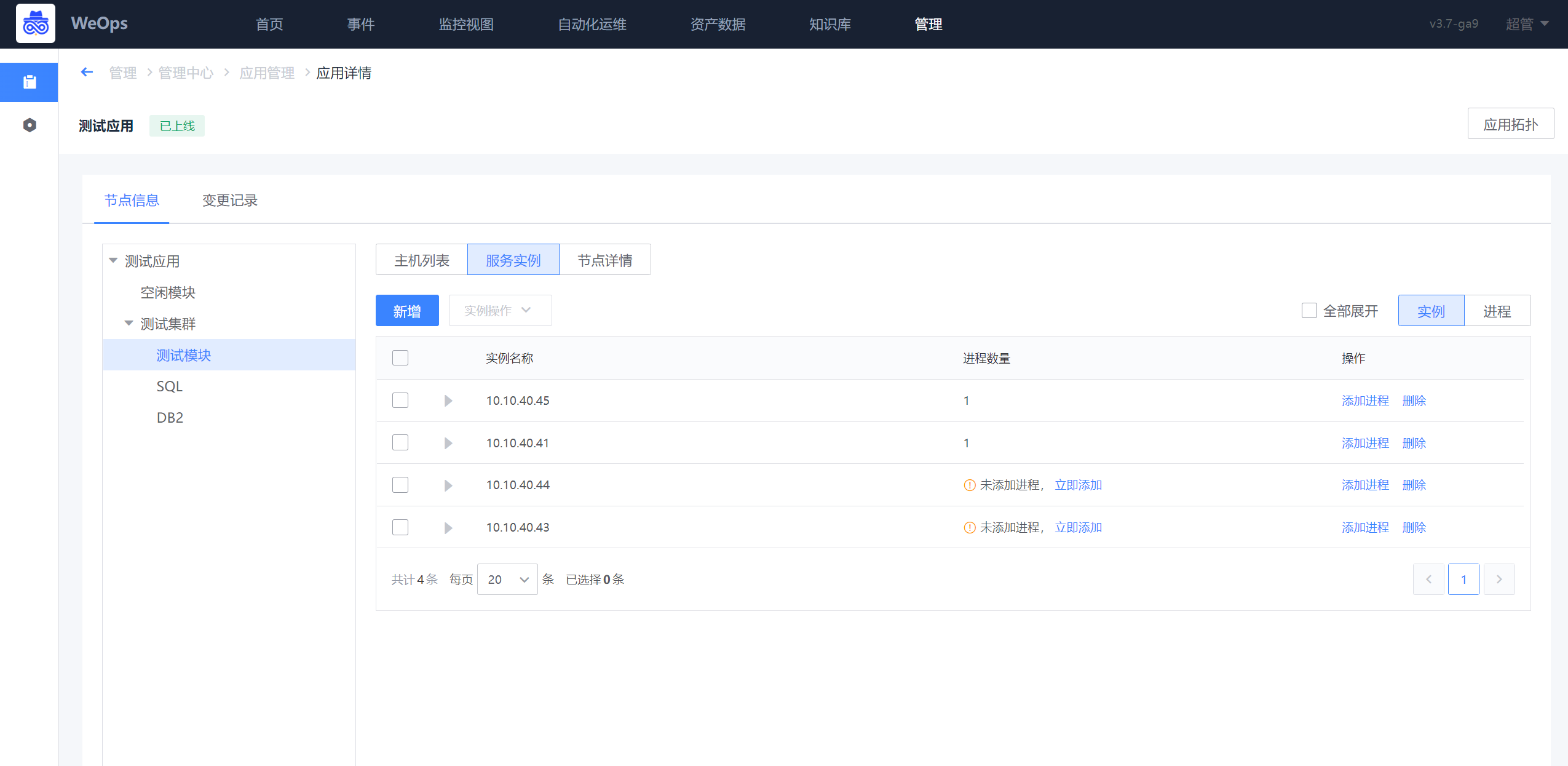

应用详情页主要展示了该应用的节点信息、变更记录、主机列表等信息,可以进行节点新建的查看和编辑、主机的新增和移动等操作、服务实例的新建和管理。

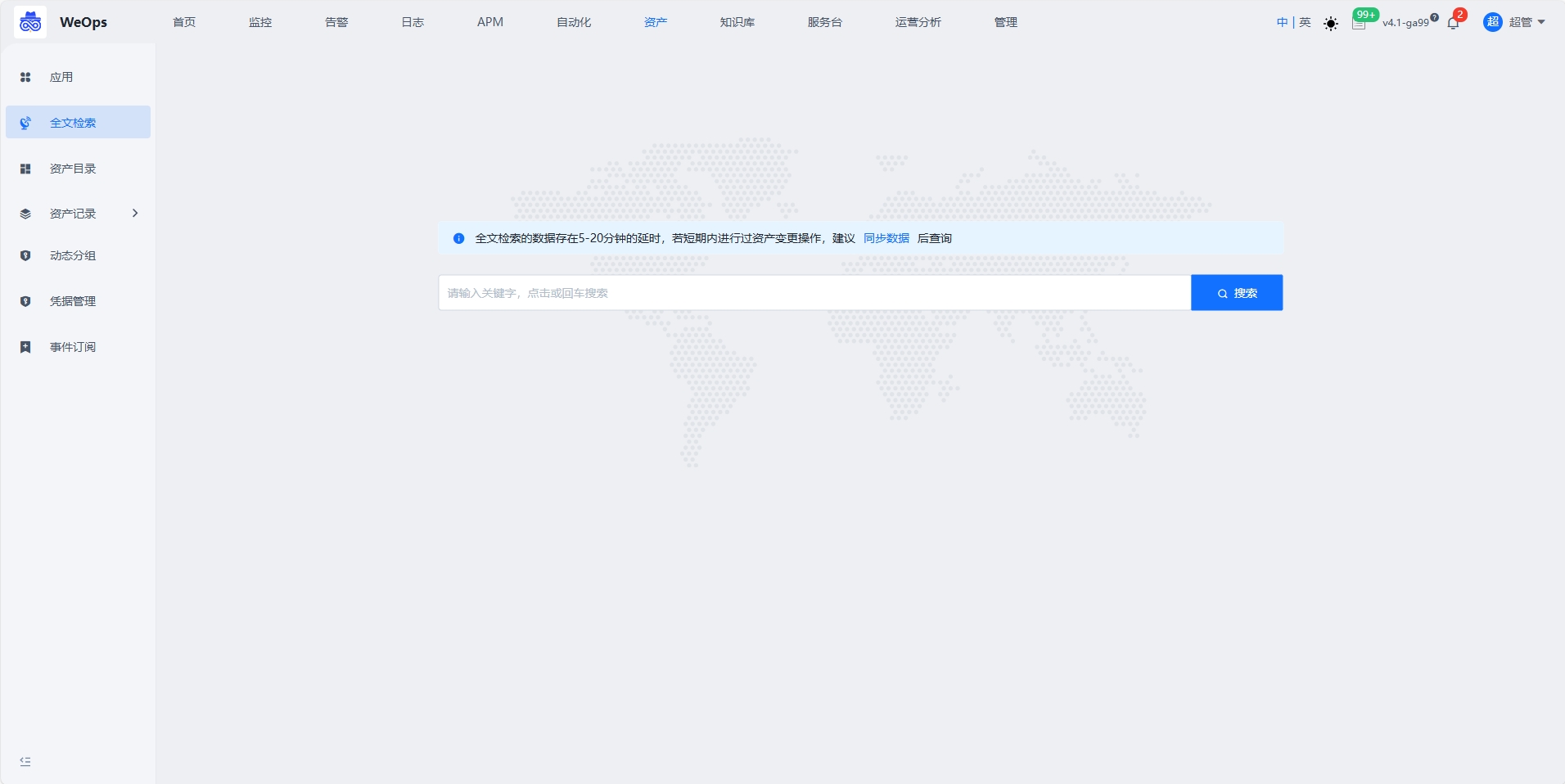

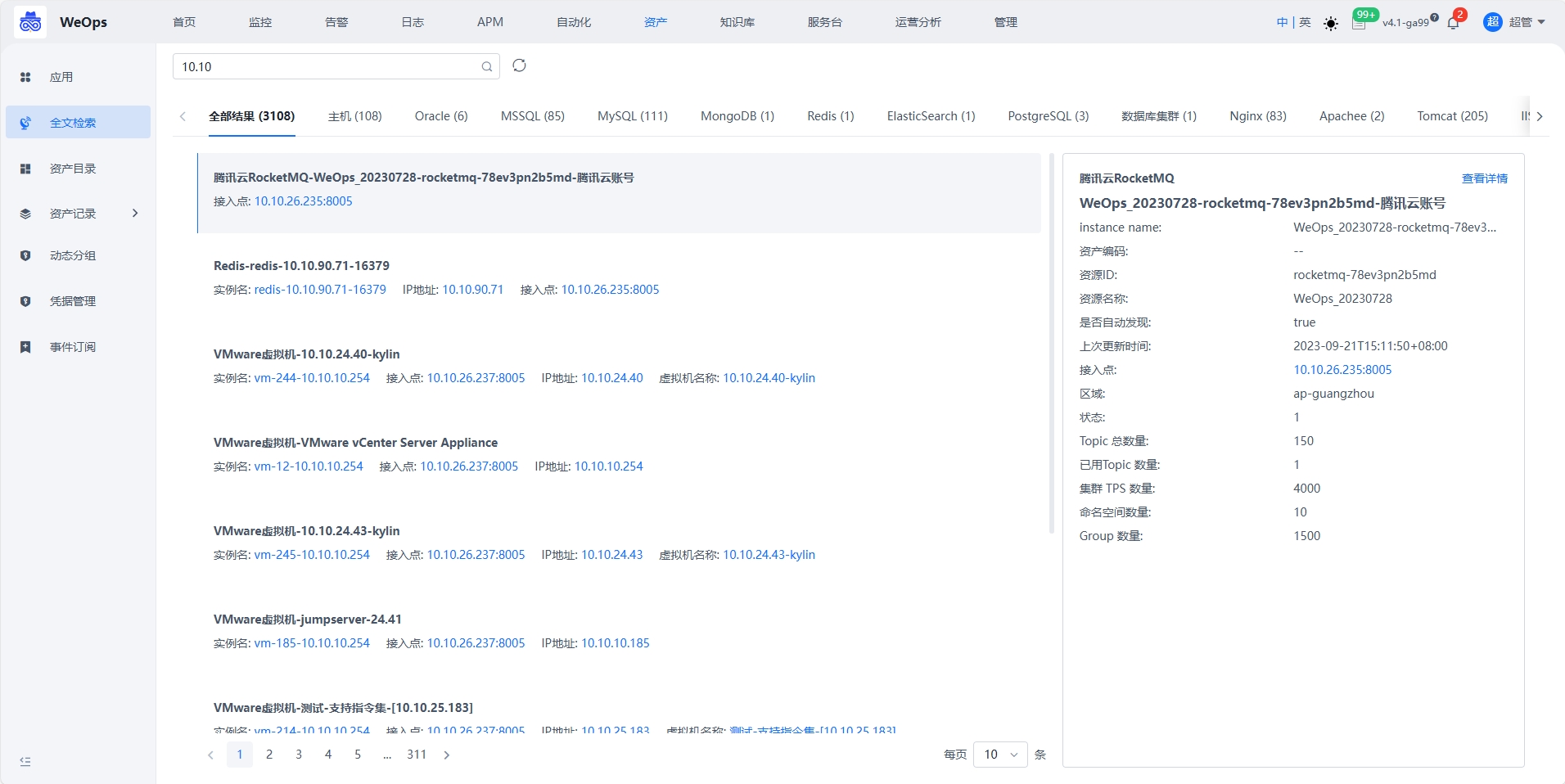

全文检索

为了让用户快速查找和查看资产的各种字段和属性信息,WeOps提供全文检索能力。全文检索的范围包括所有资产实例的所有字段属性,并且标识搜索到的关键词,可以点击查看资产的详情。

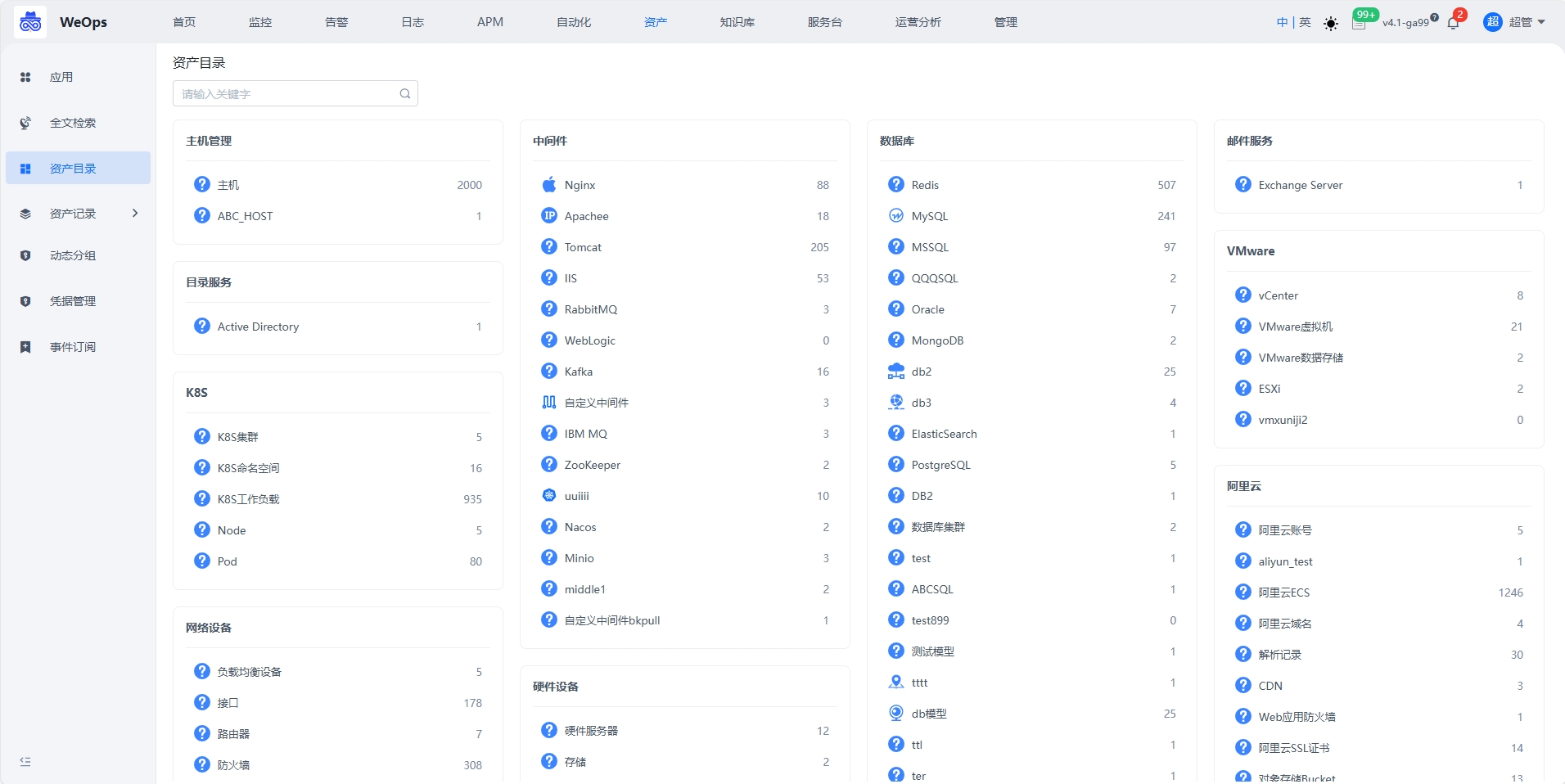

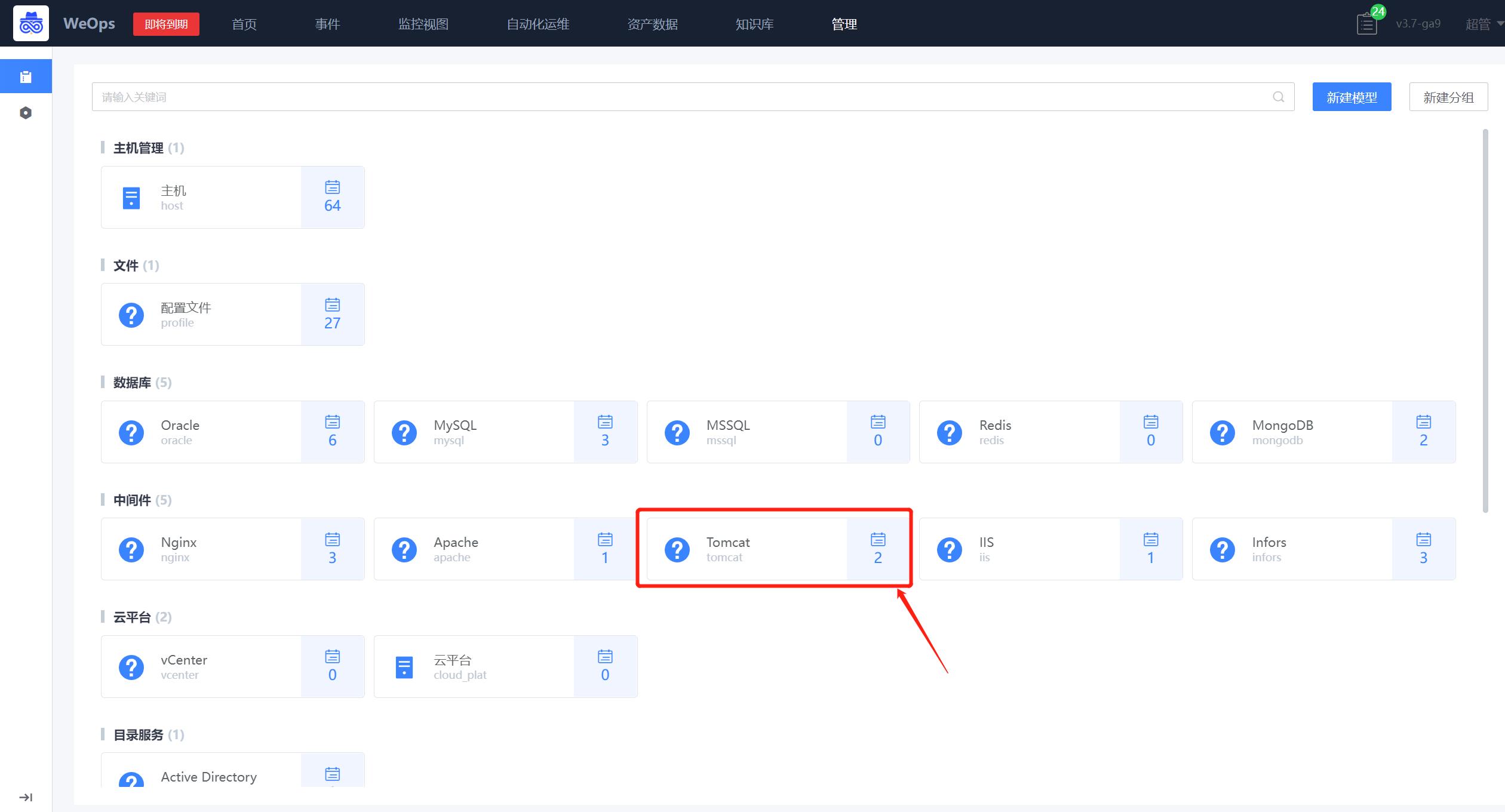

资产目录

运维团队需要全面了解公司所拥有的各种硬件、软件、网络设备等资产情况,并对其进行有效的管理和维护,需要一个总览页进行查看。 以一个简洁的页面呈现CMDB中所有的资产信息,如服务器、存储设备、网络设备等。用户可以通过该目录快速了解公司所拥有的各类资产情况和数量,并支持跳转到对应资产详细列表页面。

资产记录

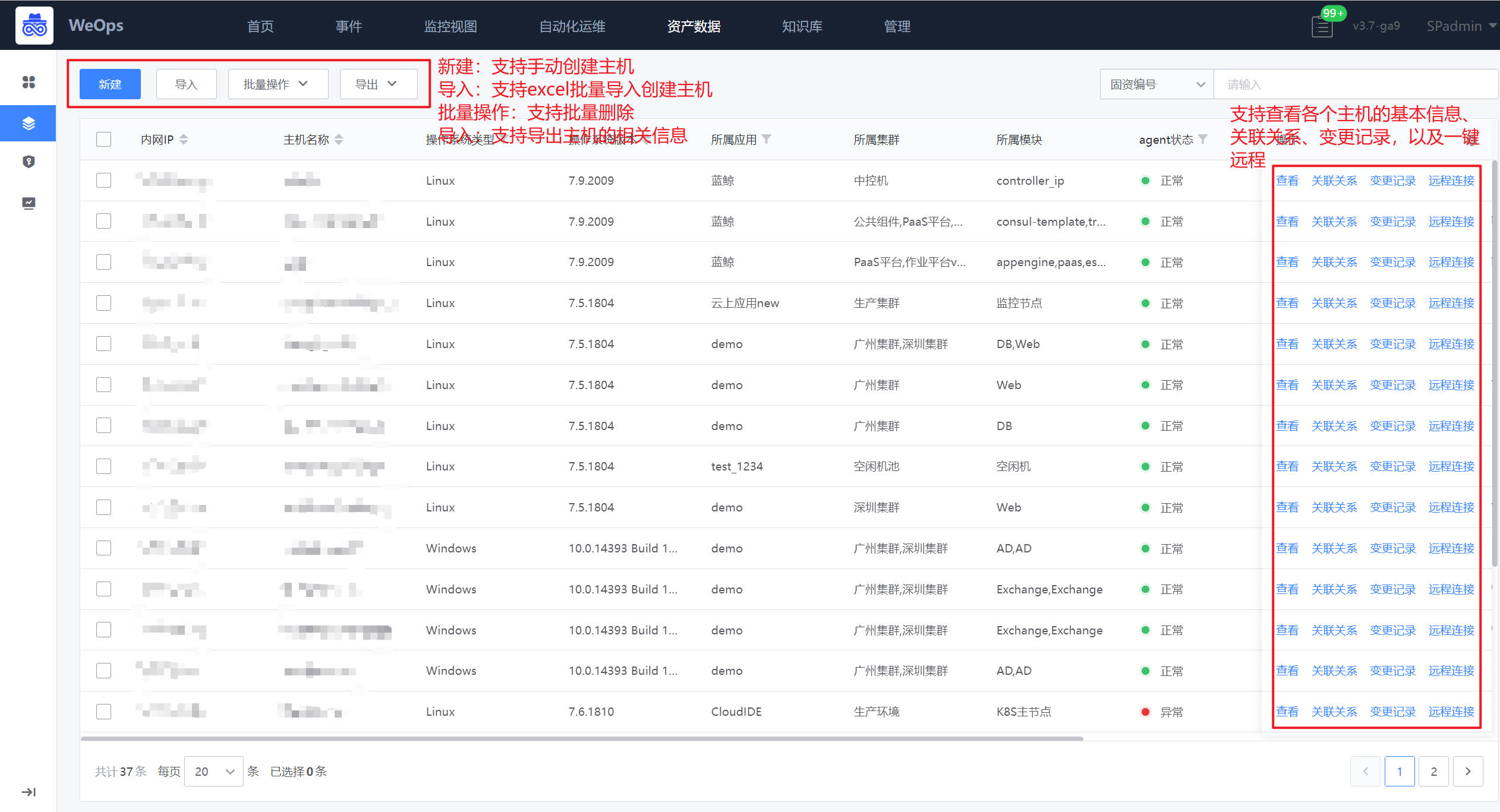

主机

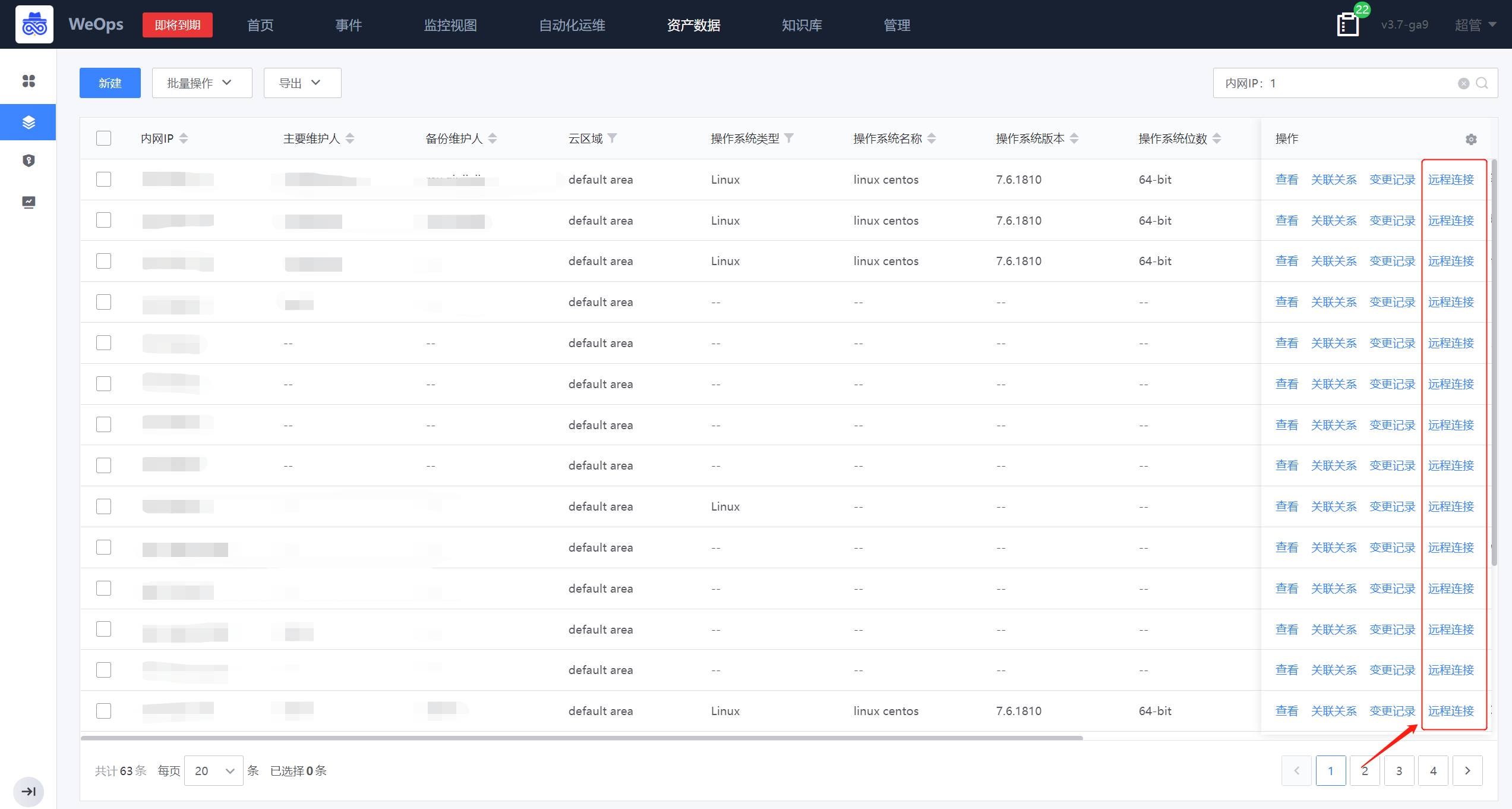

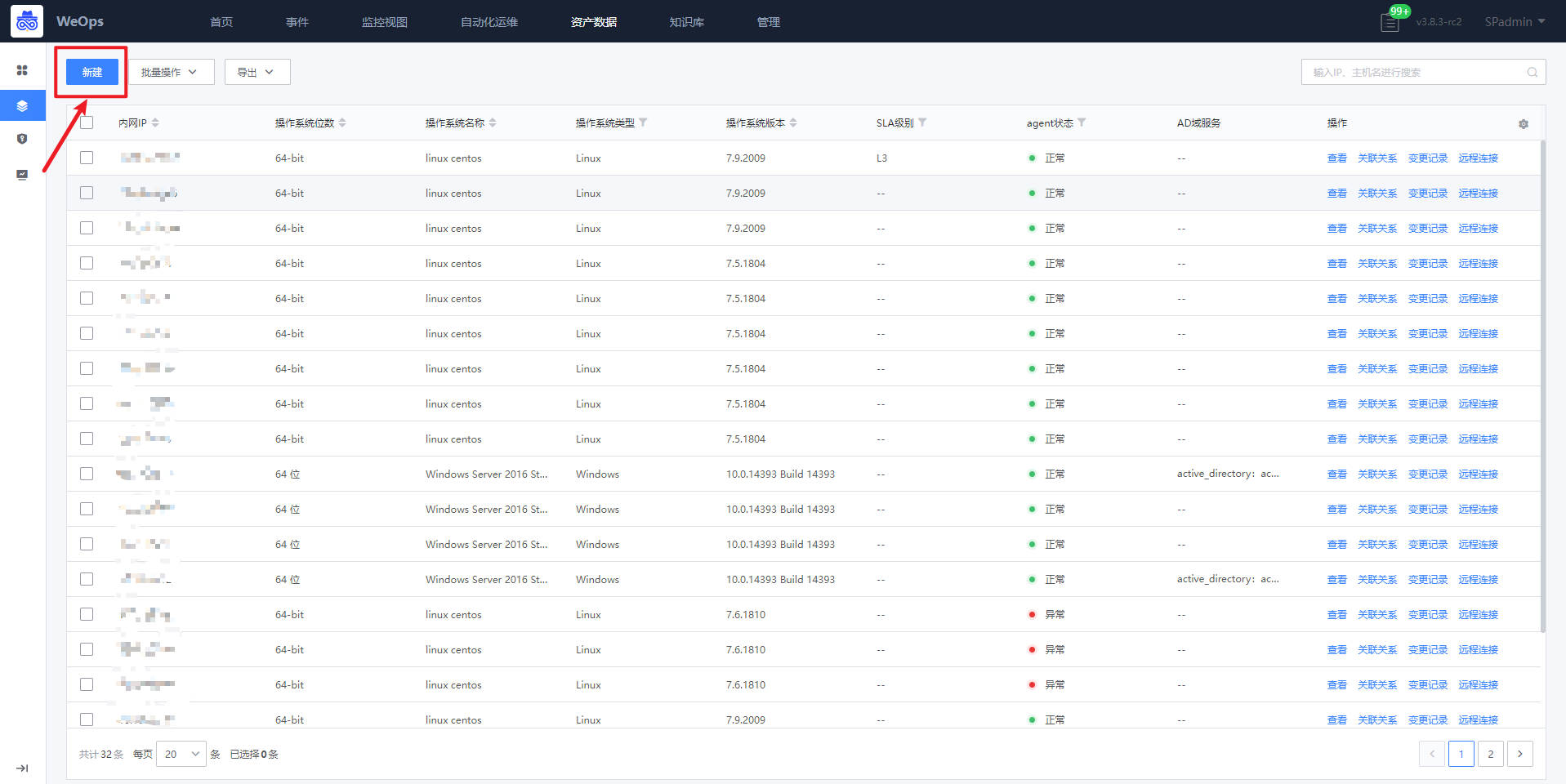

如下图,资产记录中的主机展示了所有的主机信息,可进行新建、批量修改和批量删除、导出,支持主机的远程连接。

- 详细信息:点击可查看该主机的详细信息。

- 服务实例preview:展示了该主机下的服务实例和对应进程的信息。

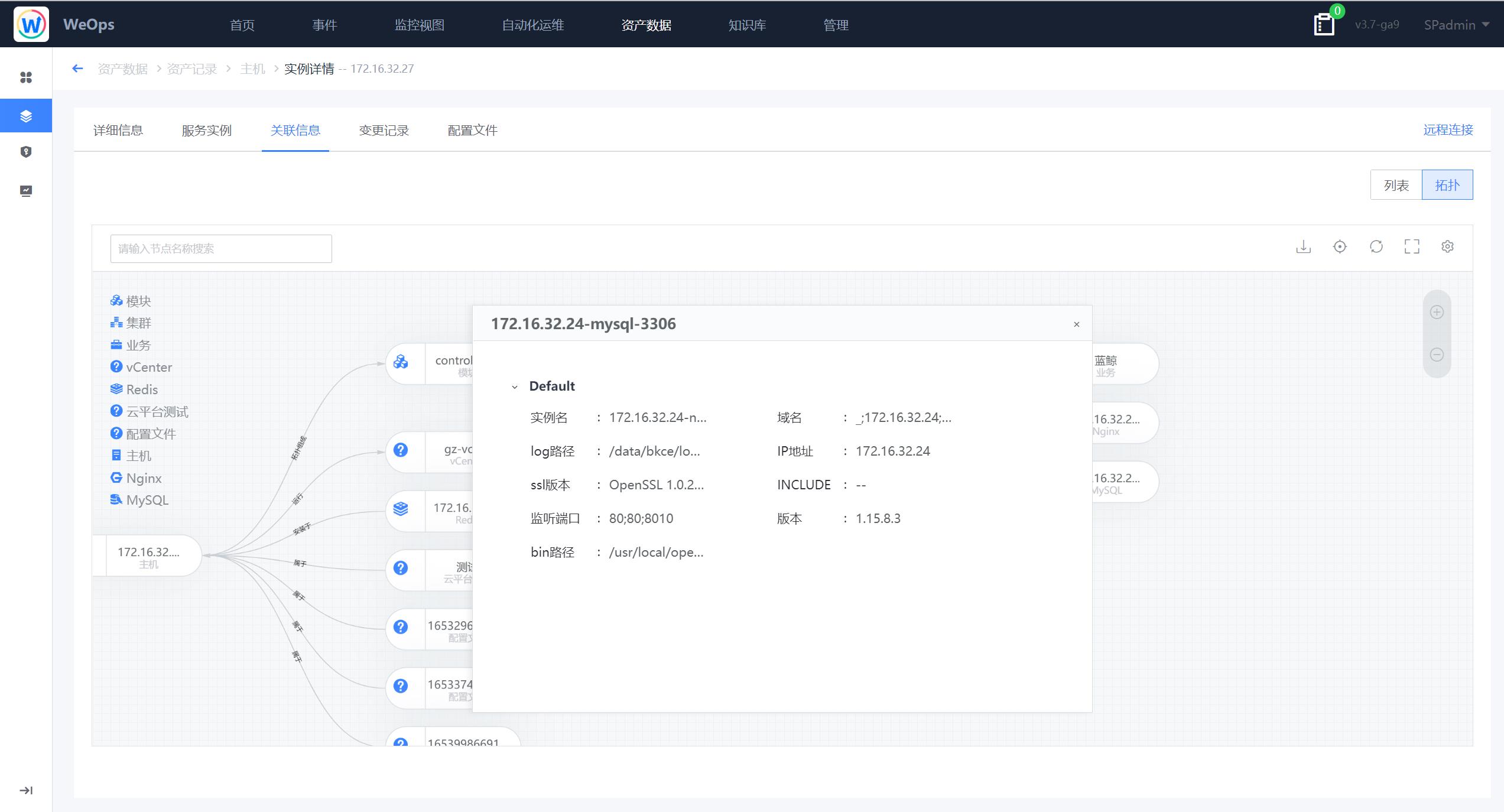

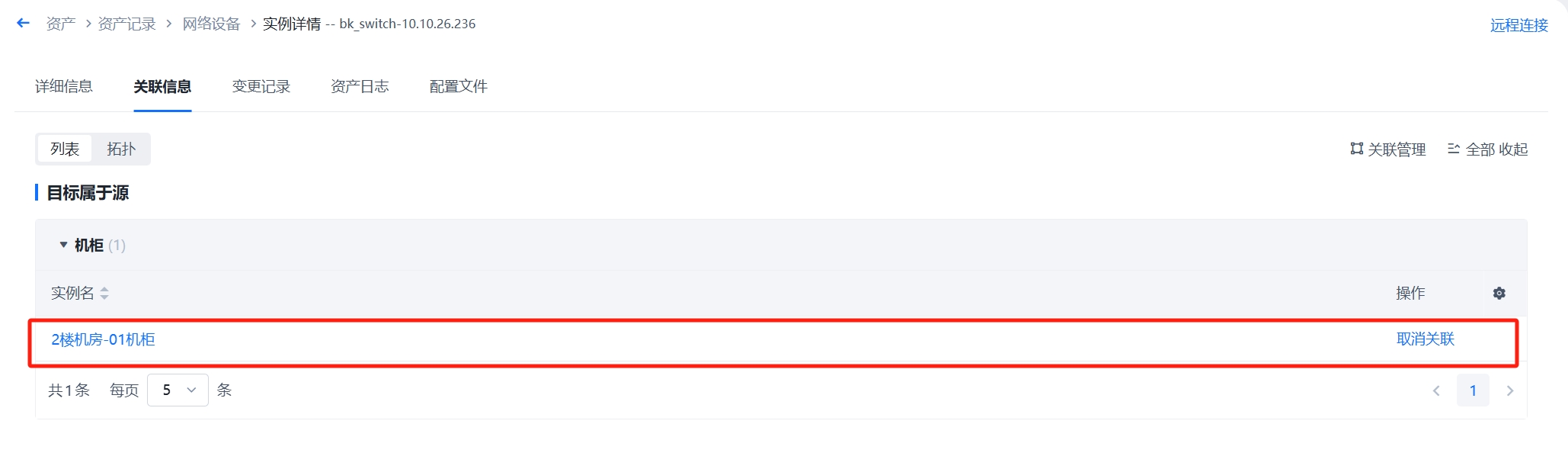

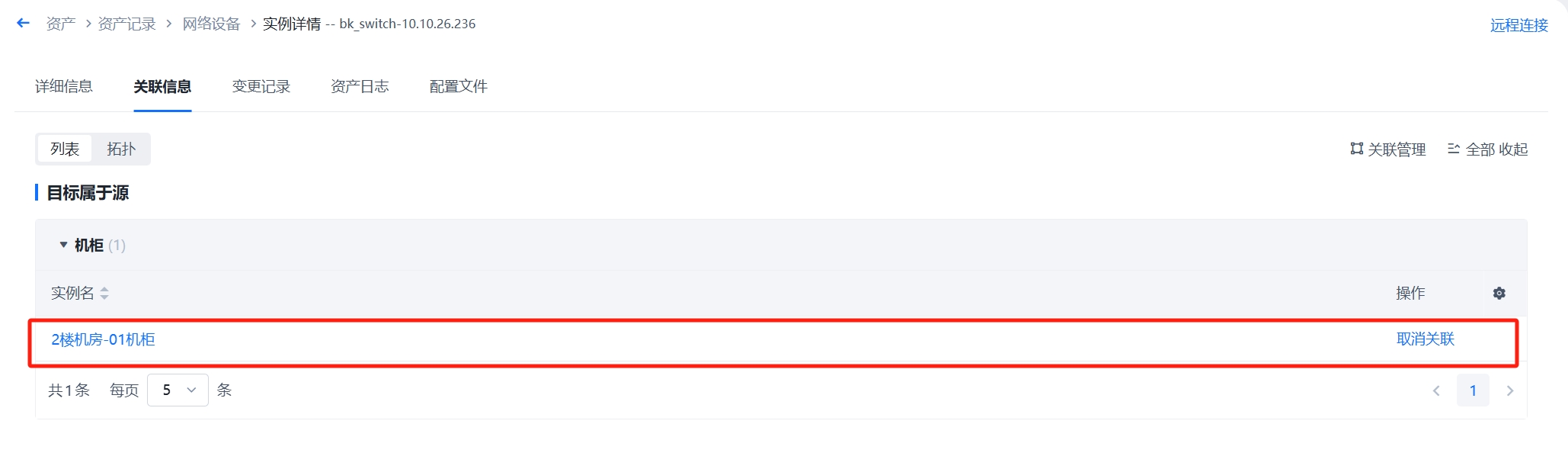

- 关联信息:以列表和拓扑图两种形式呈现与该主机相关的实例信息,列表和拓扑图均可点击查看关联实例的详情信息。

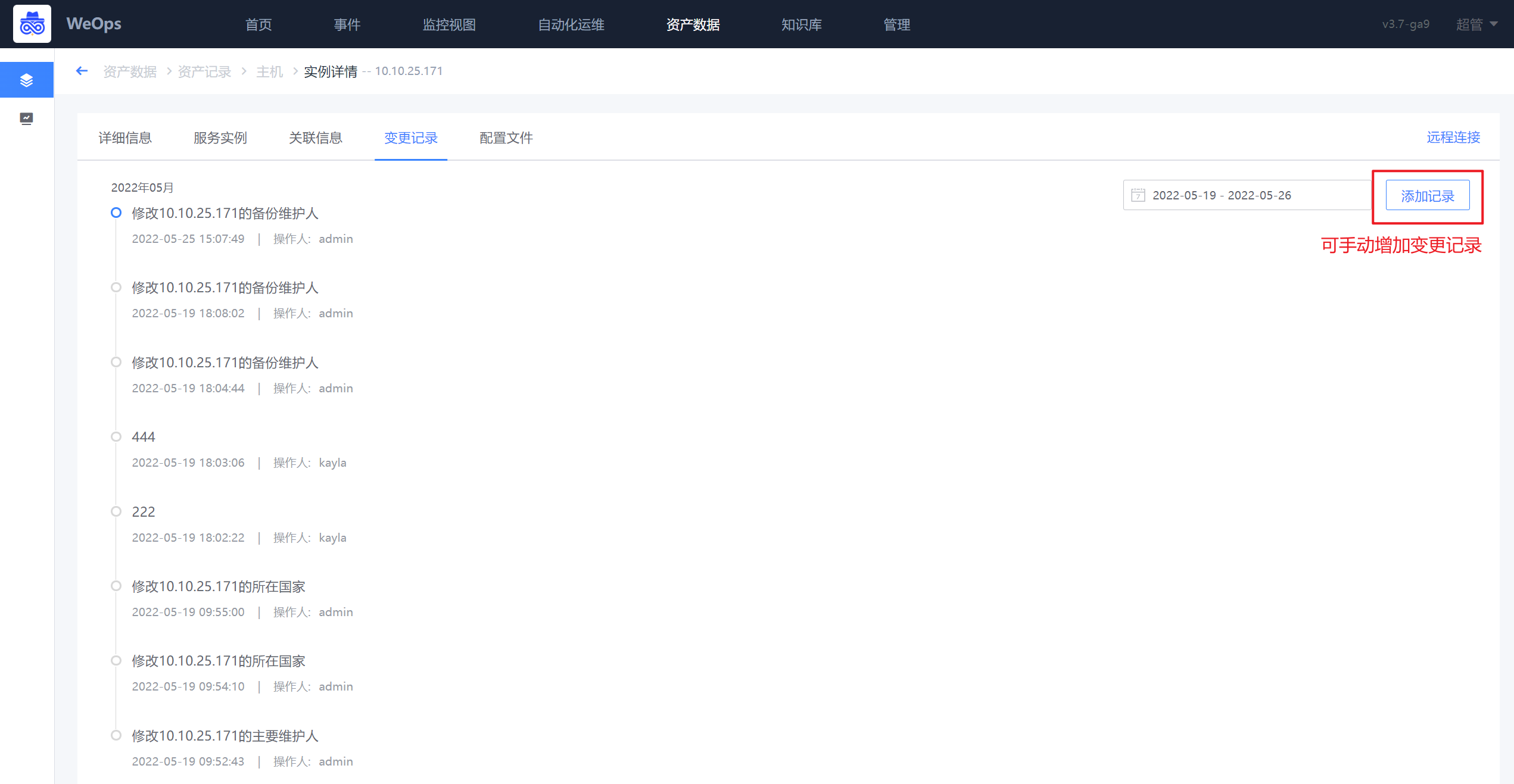

- 变更记录:可查看该主机的变更记录,可手动增加变更记录。

- 资产日志:当在“资产管理-数据关联”中配置好资产和日志的匹配关联后,可以在此处查看该资产的相关日志信息

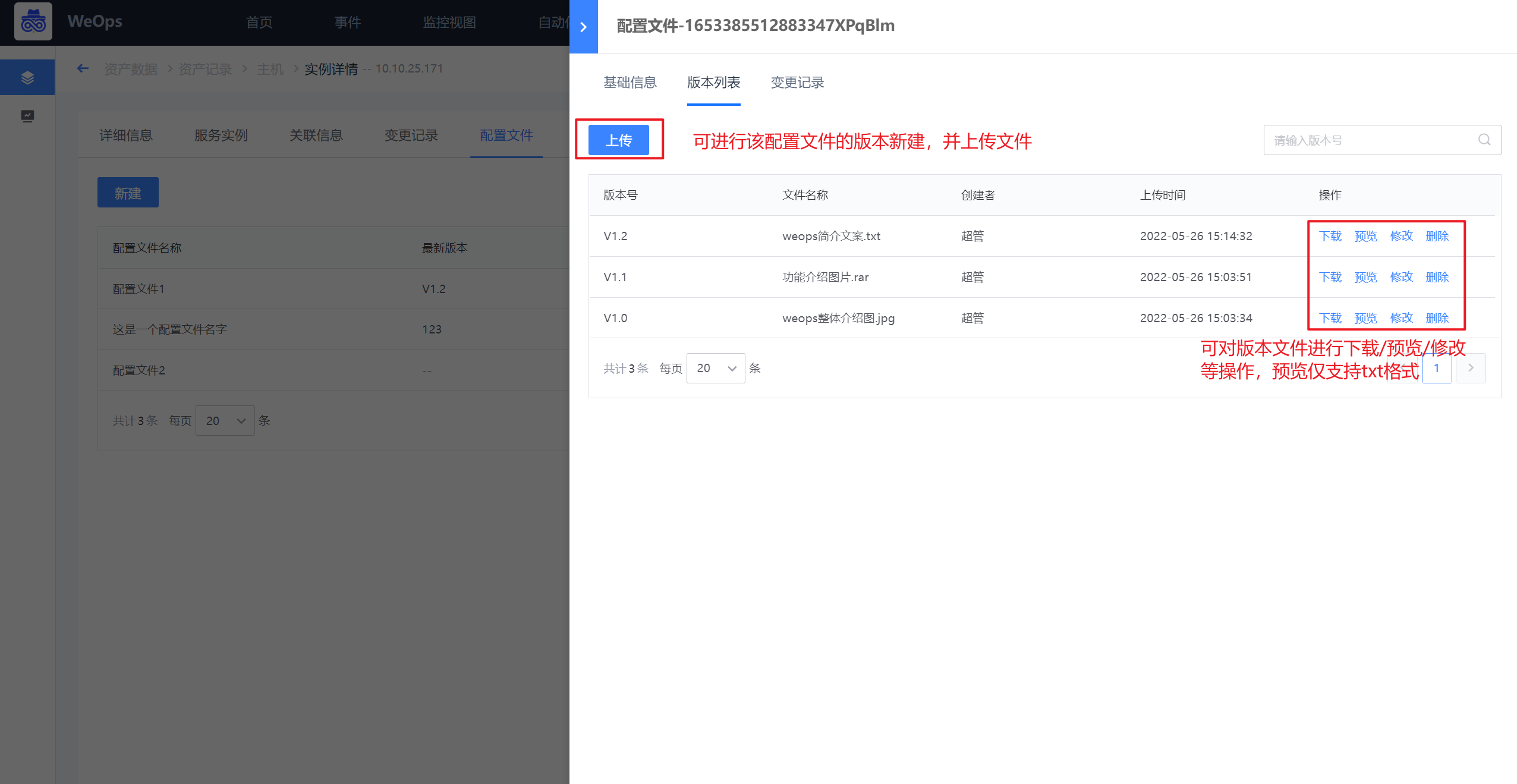

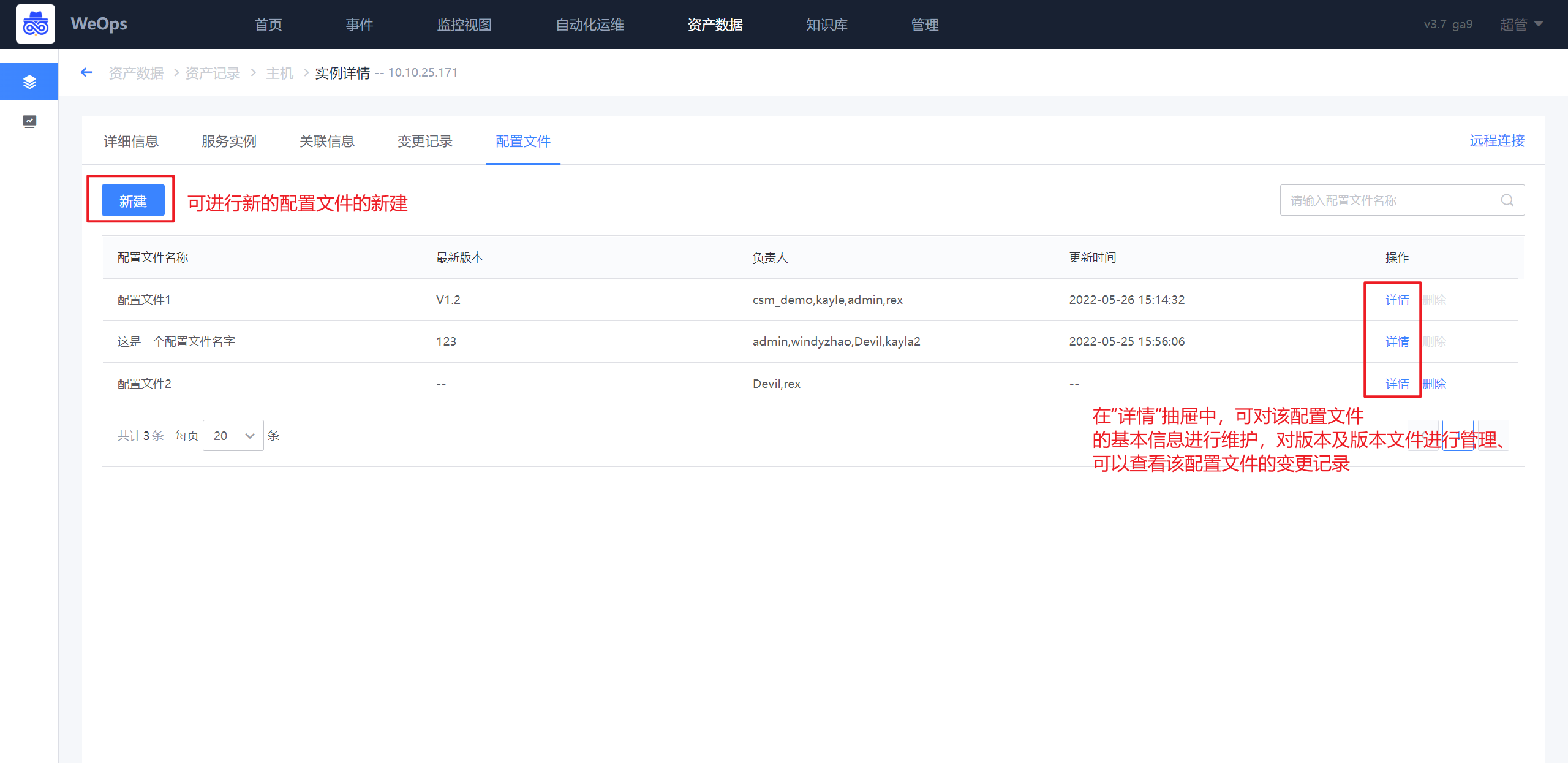

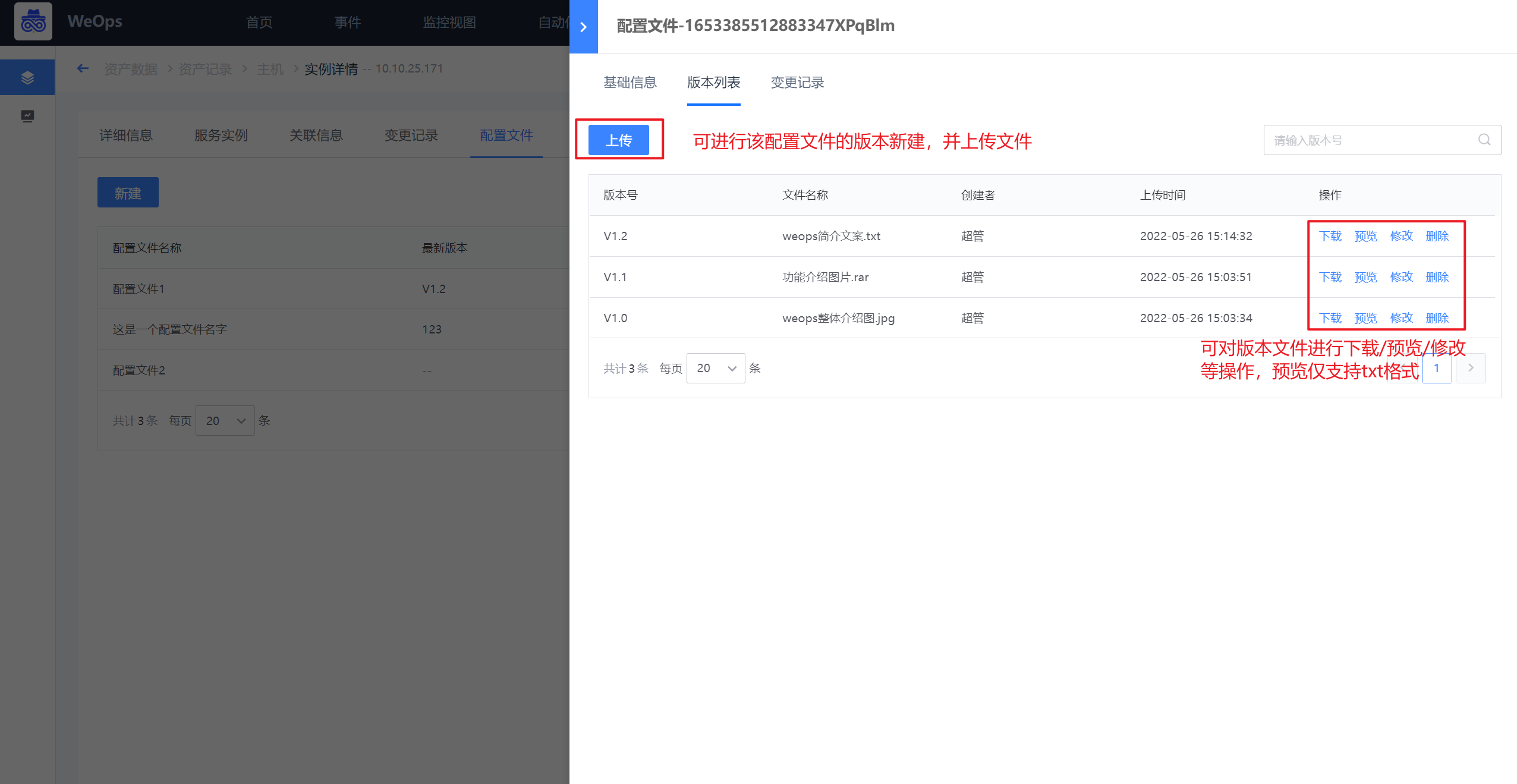

- 配置文件preview:如下图,可对配置文件进行管理,包括基本信息、版本管理(可进行各个版本文件的上传/下载/预览等操作)、变更记录。

- 远程连接:“WeOps-资产记录-主机”提供了Windows和linux主机的远程连接入口,可点击进行主机的远程连接

- 远程连接过程中可以选择“手动添加凭据”和“使用已有凭据”两类,Windows服务器可以选择分辨率,默认分辨率为1920*1080

- 手动添加凭据:支持RDP、SSH、VNC三类协议,Windows服务器默认RDP协议、默认远程端口为3389、默认用户名administrator;linux服务器默认使用SSH协议、默认远程端口为22、默认用户名root。

- 使用ssh协议时,要求对端的ssh服务器运行使用rsa密钥,如果ssh版本高于8,需将HostKeyAlgorithms +ssh-rsa添加到/etc/ssh/sshd_config中

- 使用已有凭据:可以使用之前已经保存的凭据进行连接。

- 远程连接的服务器支持全屏放大和文件上传:Windows默认system帐号,Linux默认root帐号;Windows文件存放目录“c:\windows\temp”,Linux文件存放目录“/tmp”;

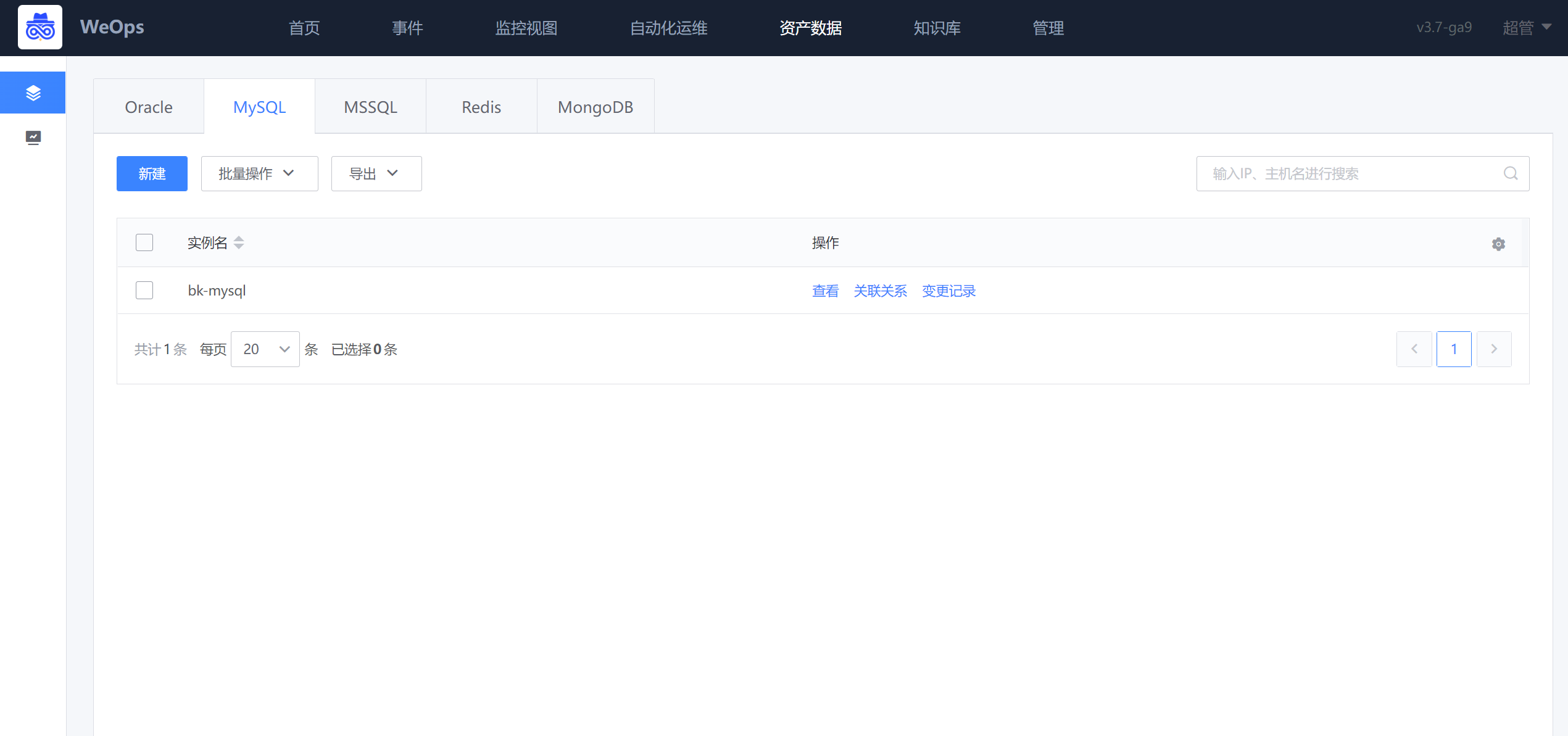

数据库

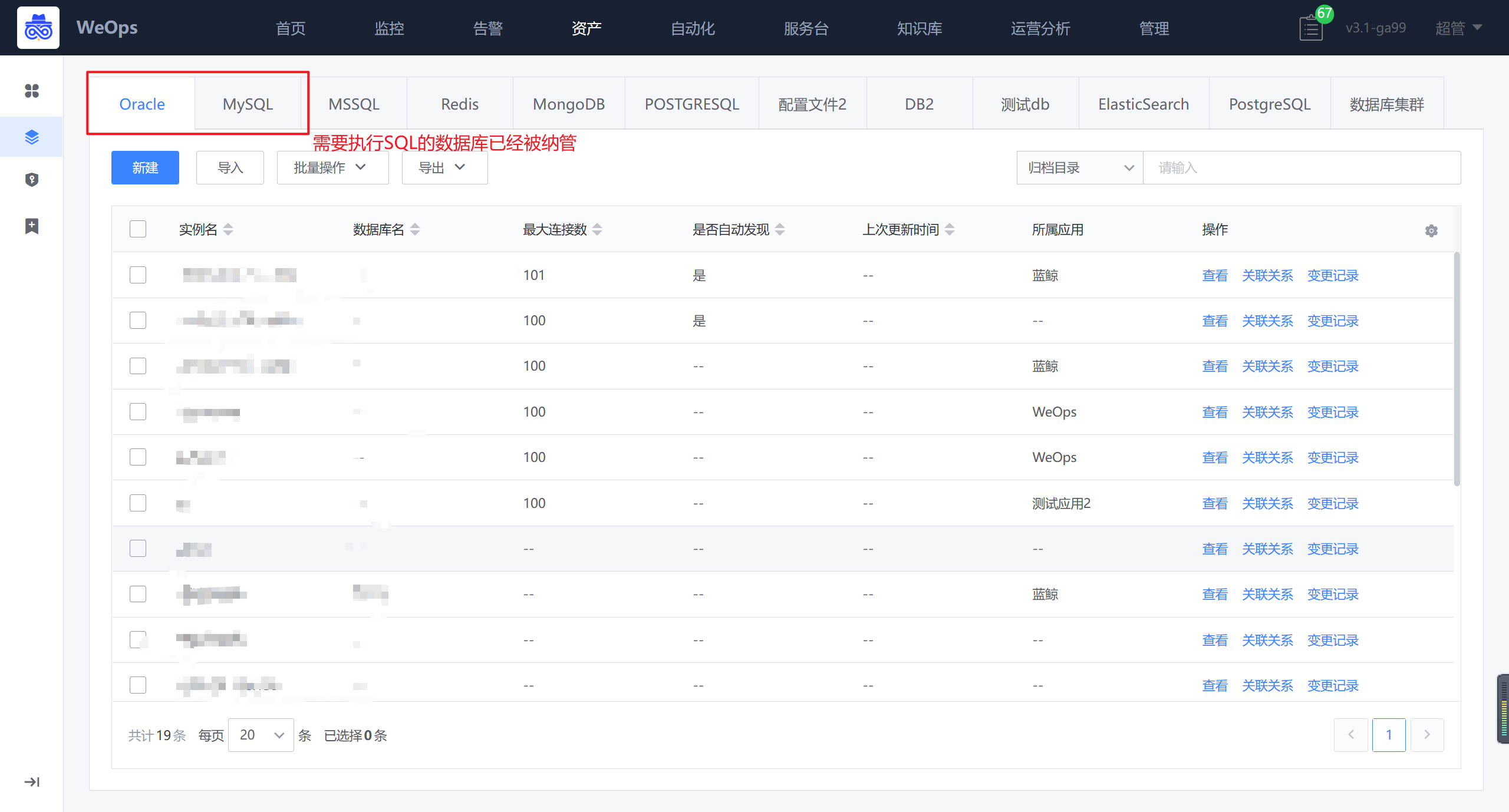

如下图,“资产记录-数据库”展示了所有类型的数据库列表的基础信息(包括所属应用)、关联关系、变更记录、配置文件。

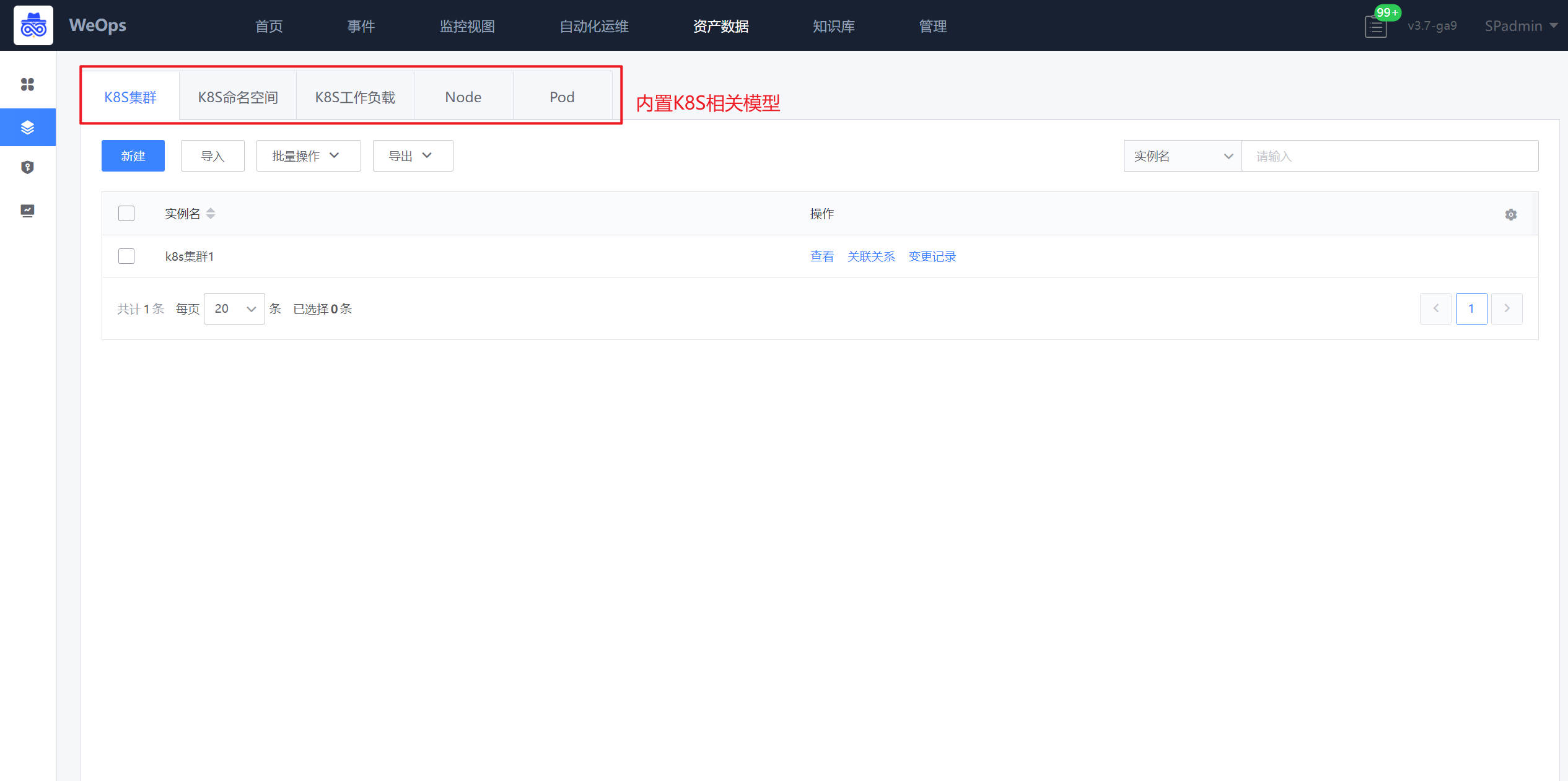

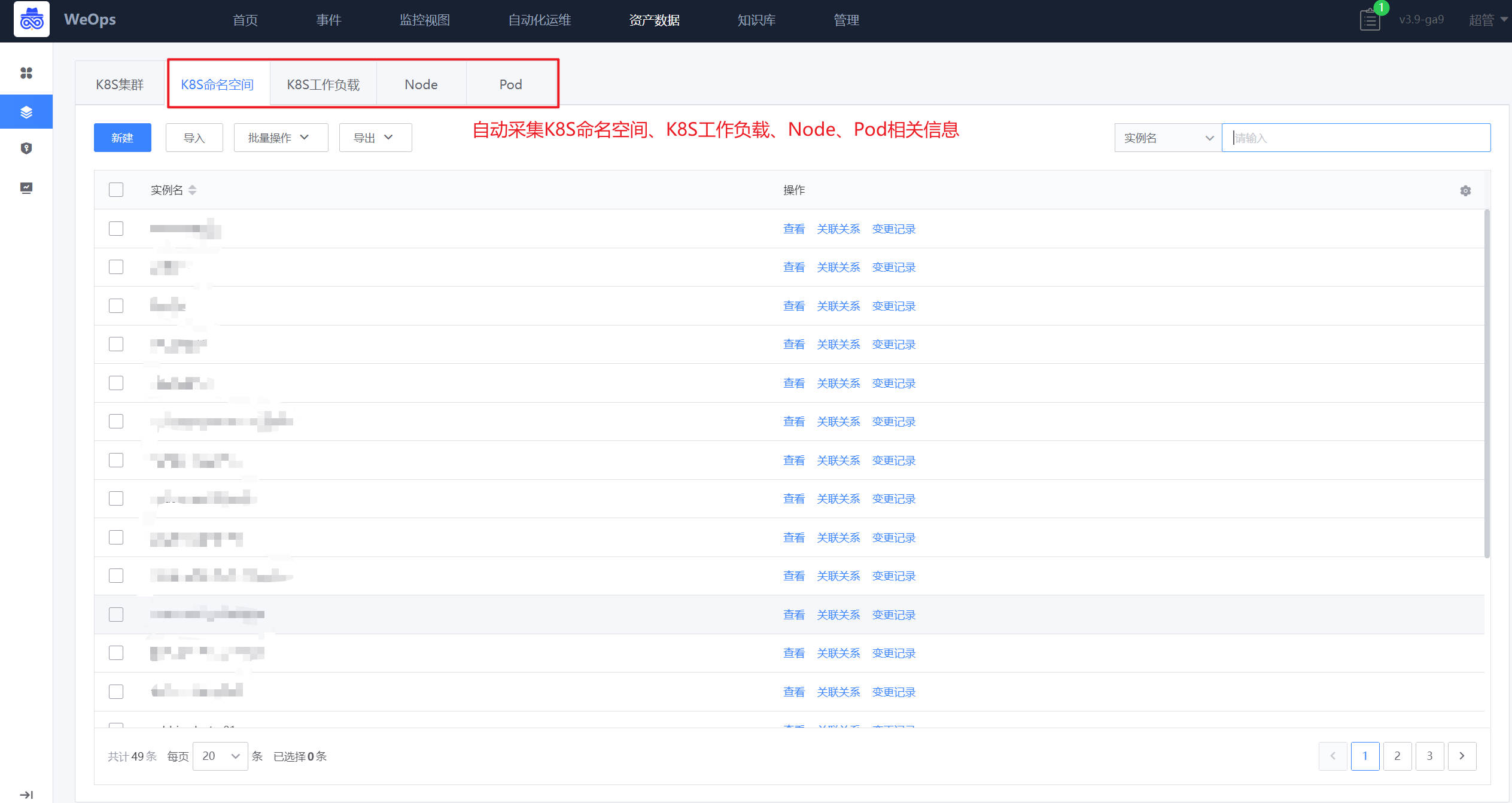

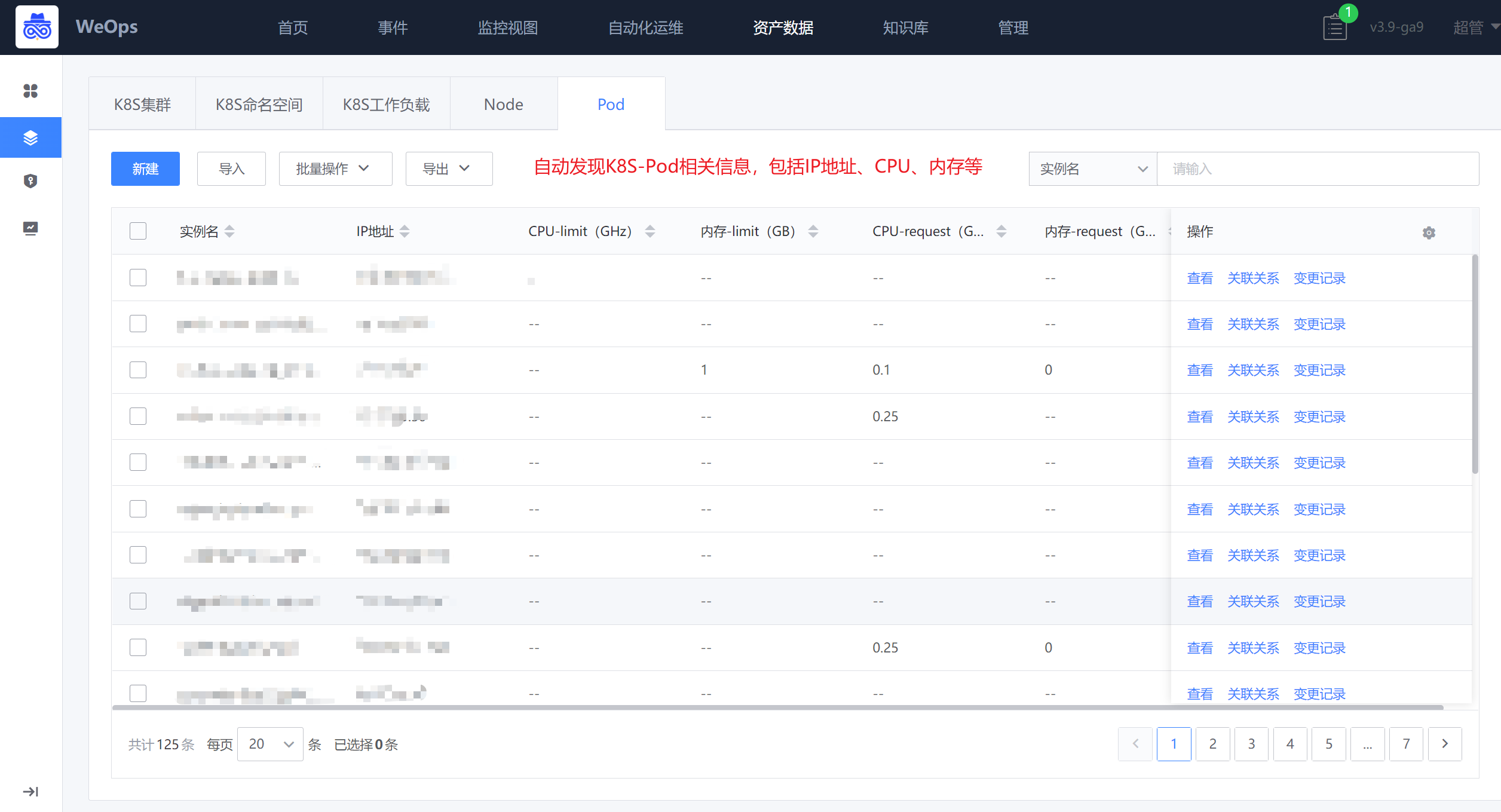

K8S

如下图,“资产记录-K8S”展示了内置的K8S相关模型,包括“K8S集群”、“K8S命名空间”、“K8S工作负载”、“Node”、“Pod”。

创建K8S集群信息,设置“自动发现”,即可采集该K8S下的K8S命名空间、K8S工作负载、Node、Pod相关信息,并形成关联拓扑。

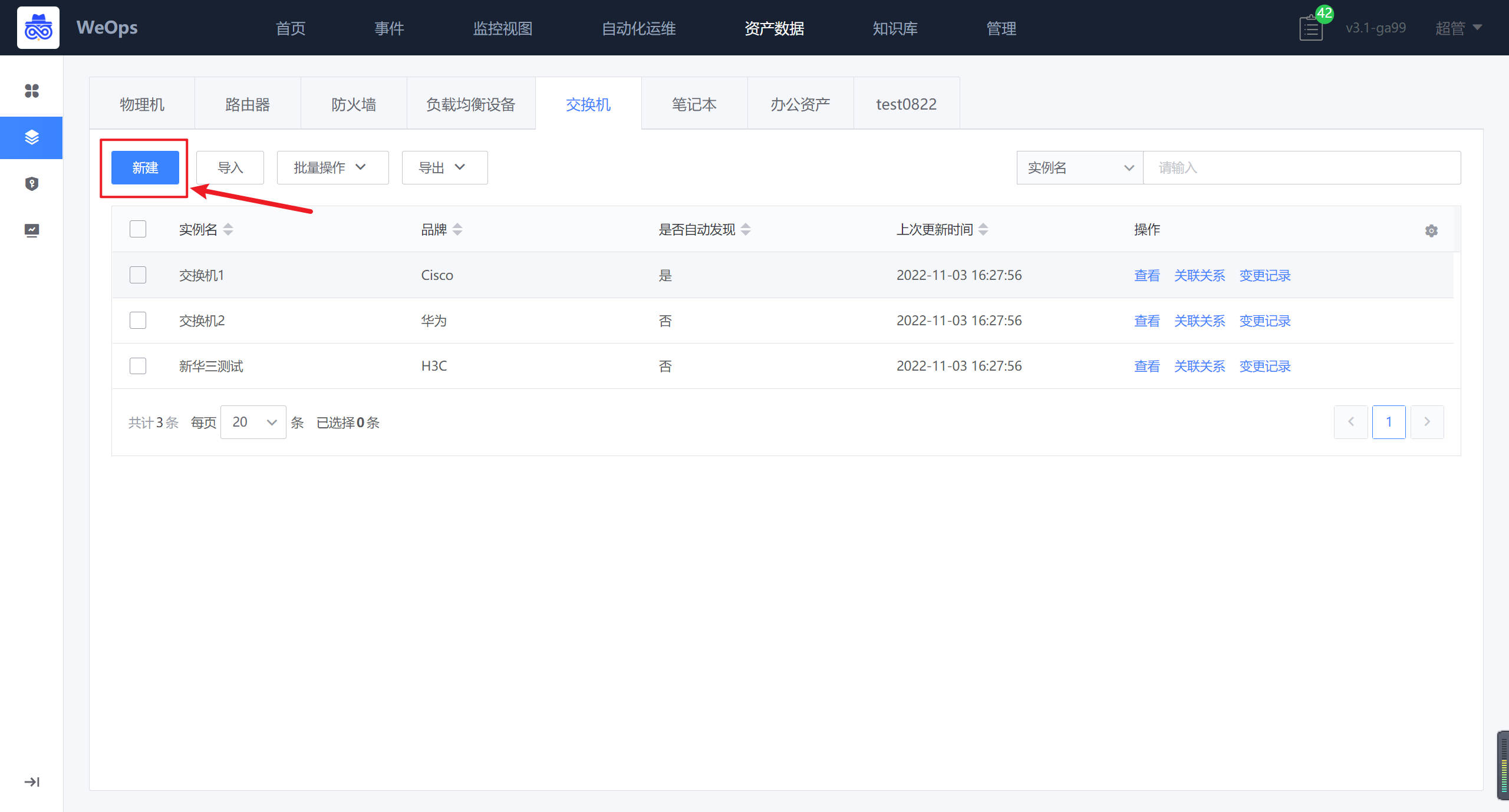

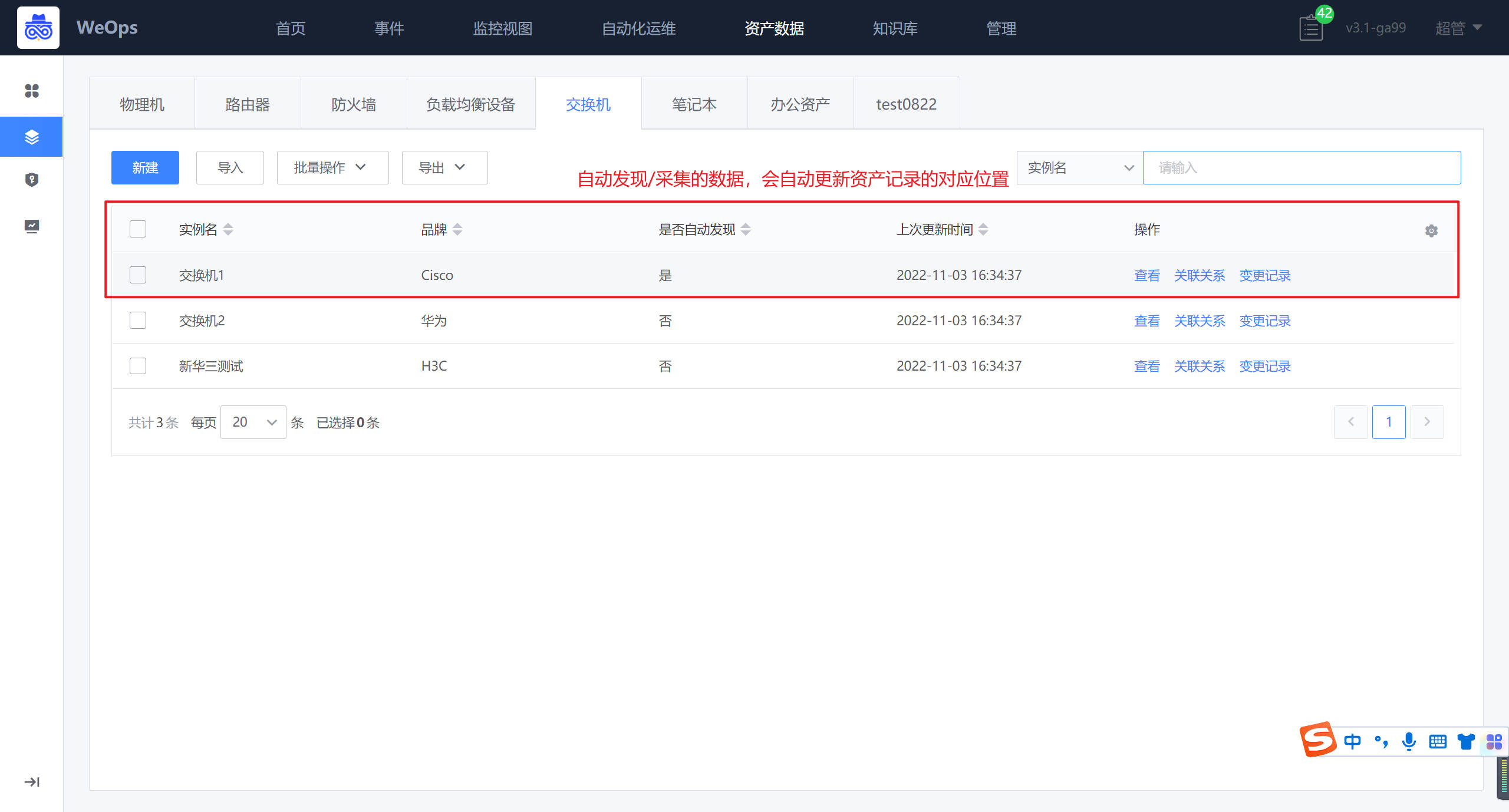

网络设备

如下图,“资产记录-网络设备”展示了内置的网络设备的相关模型,包括“路由器”、“防火墙”、“负载均衡”、“交换机”。展示了各类网络设备手动/自动发现采集的相关信息。

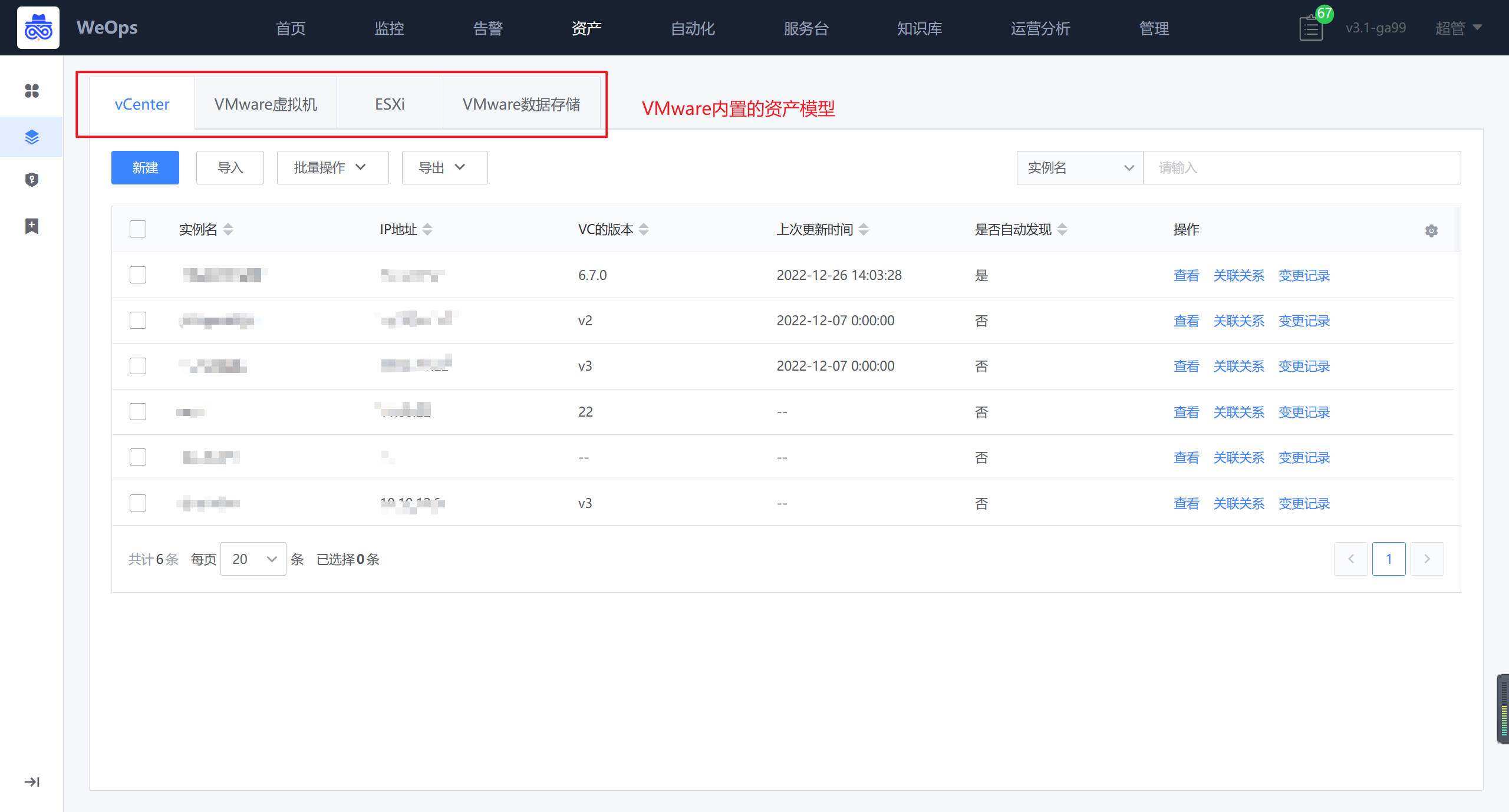

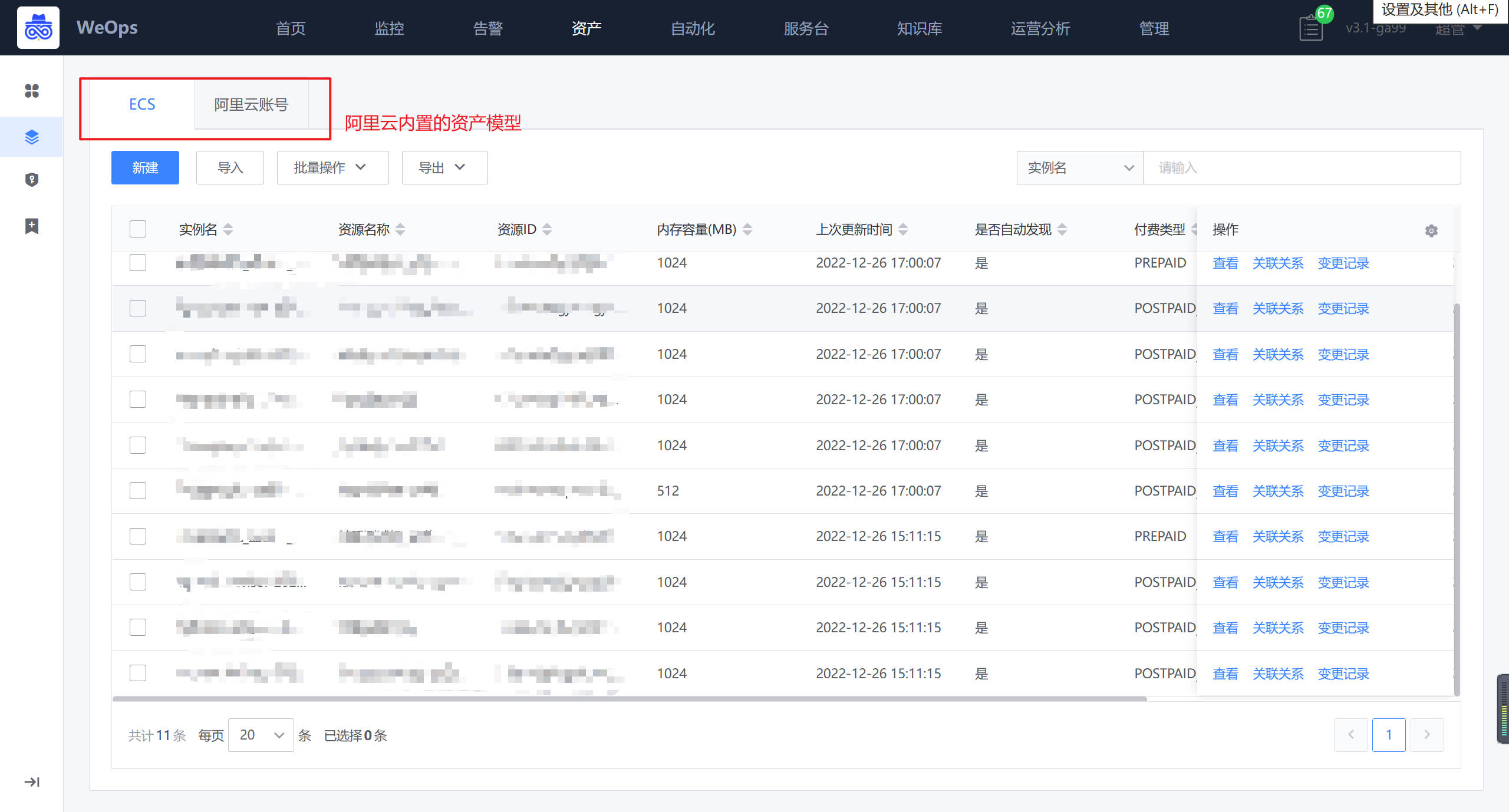

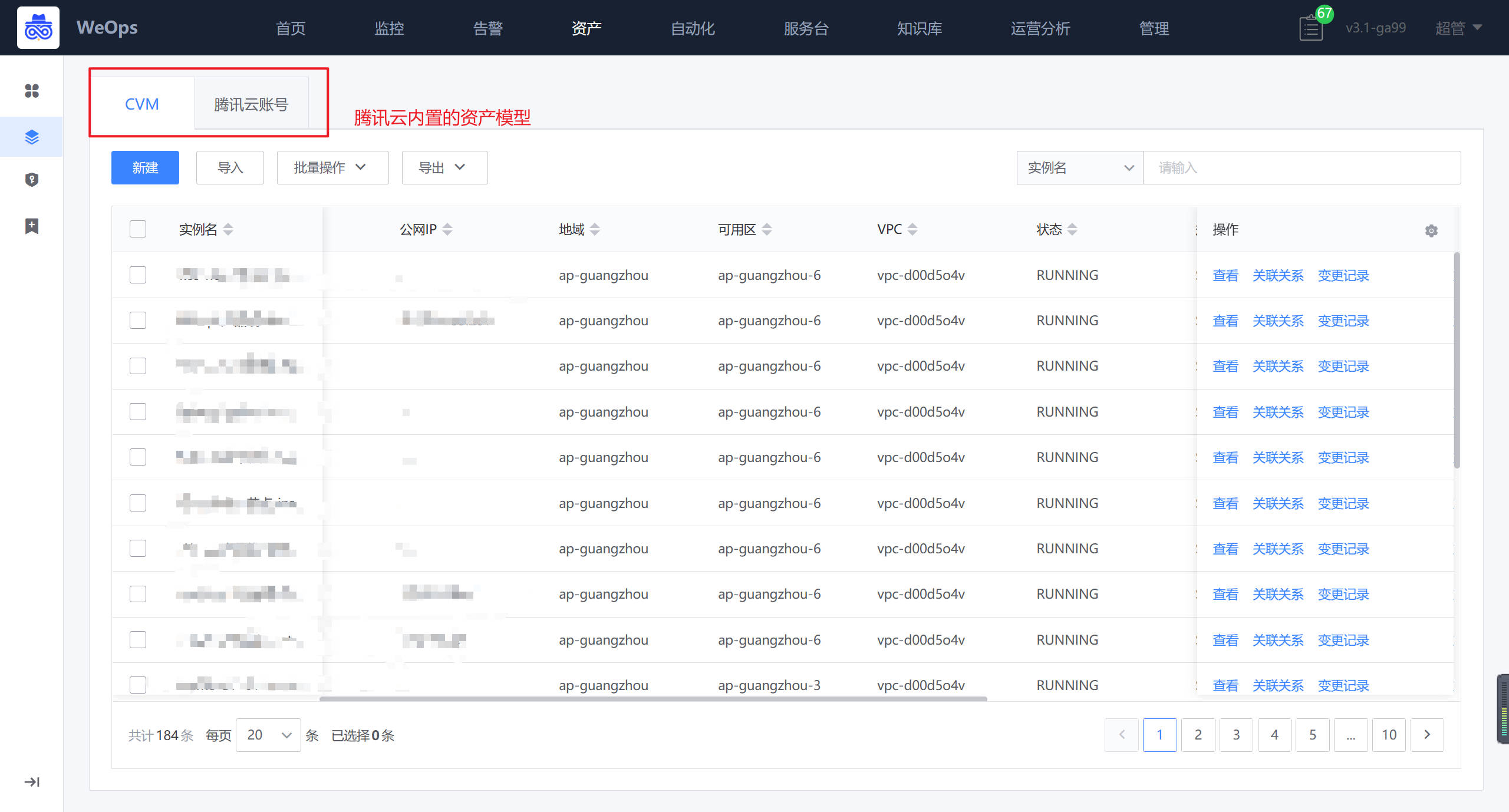

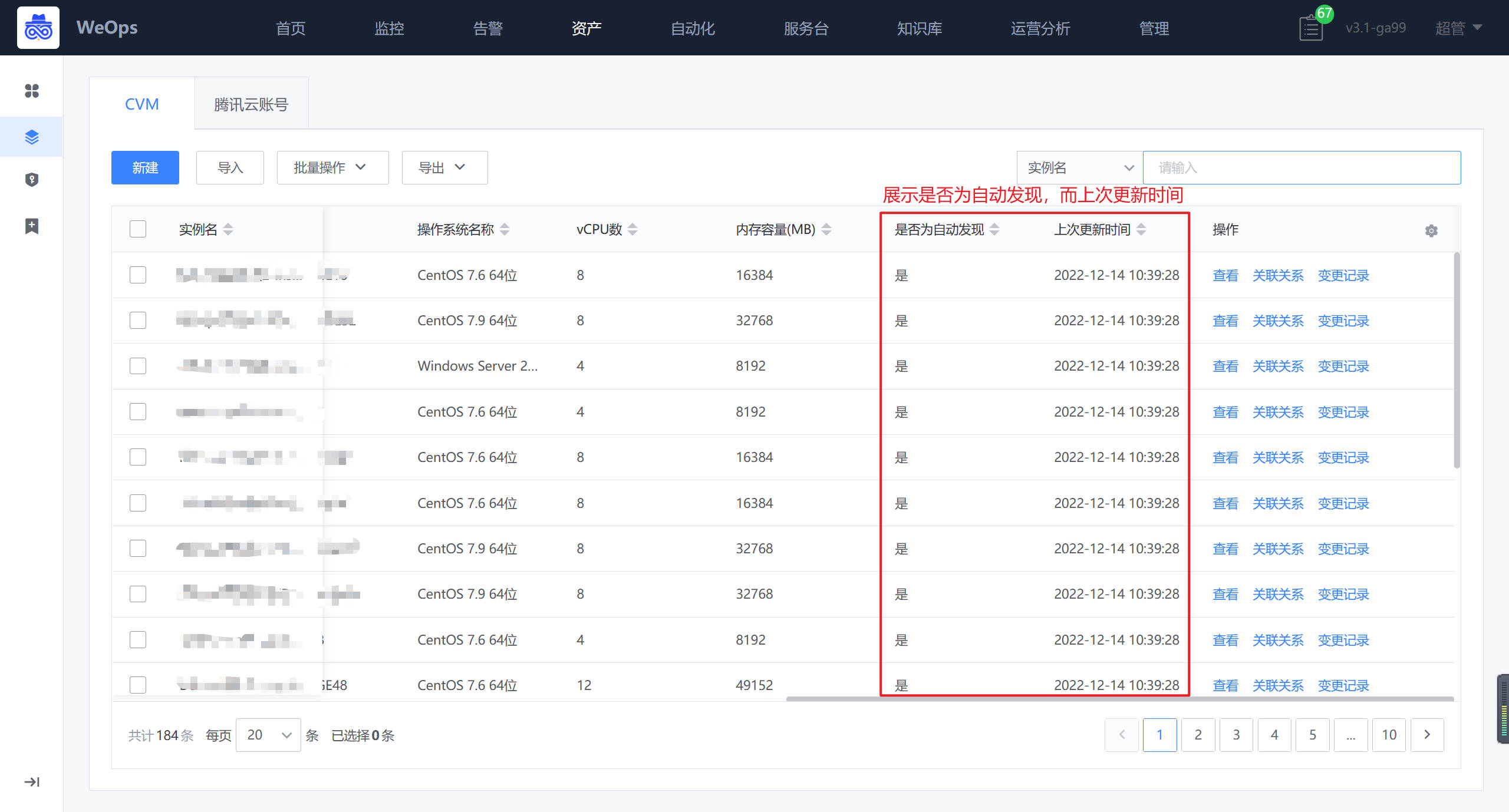

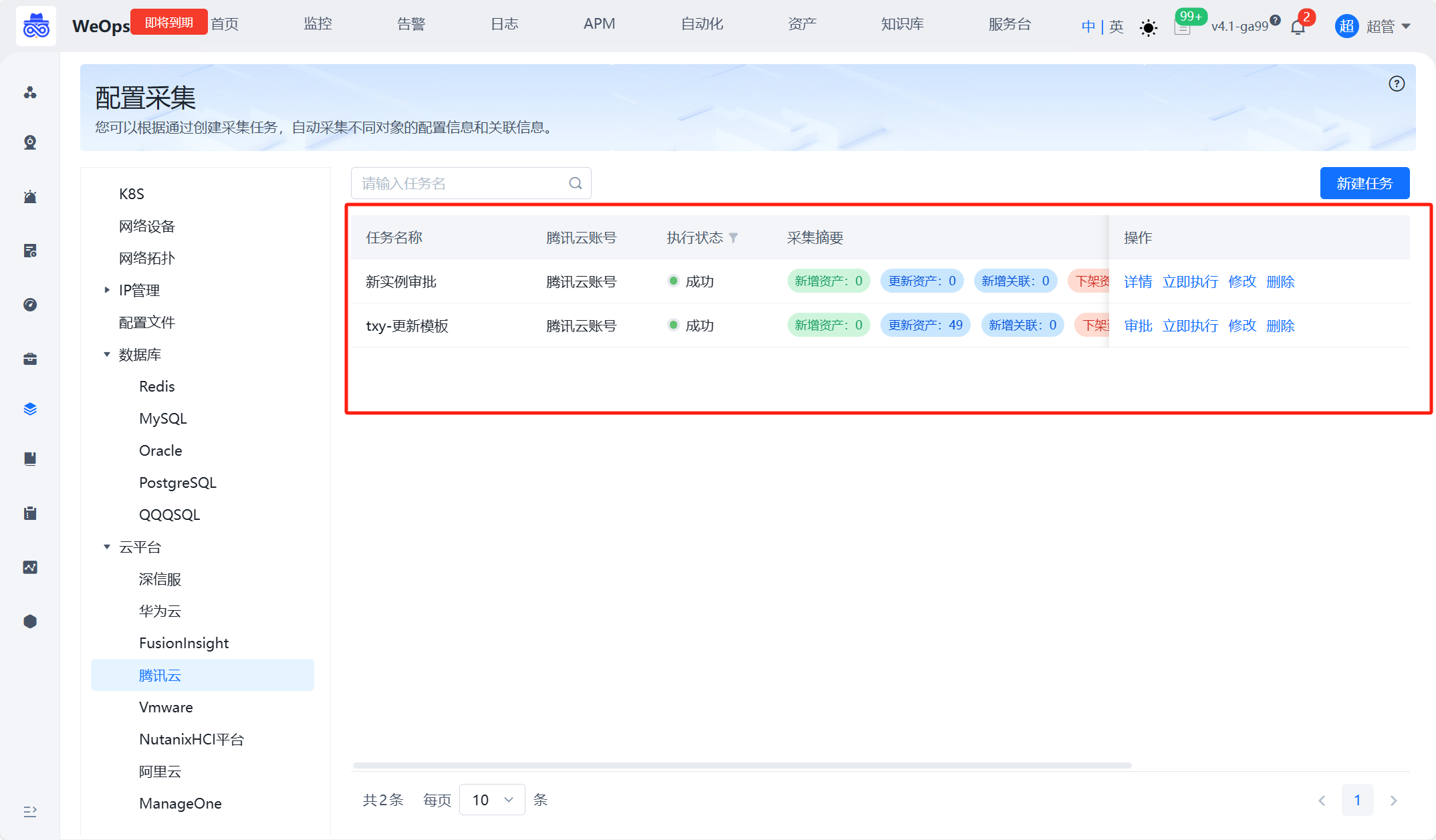

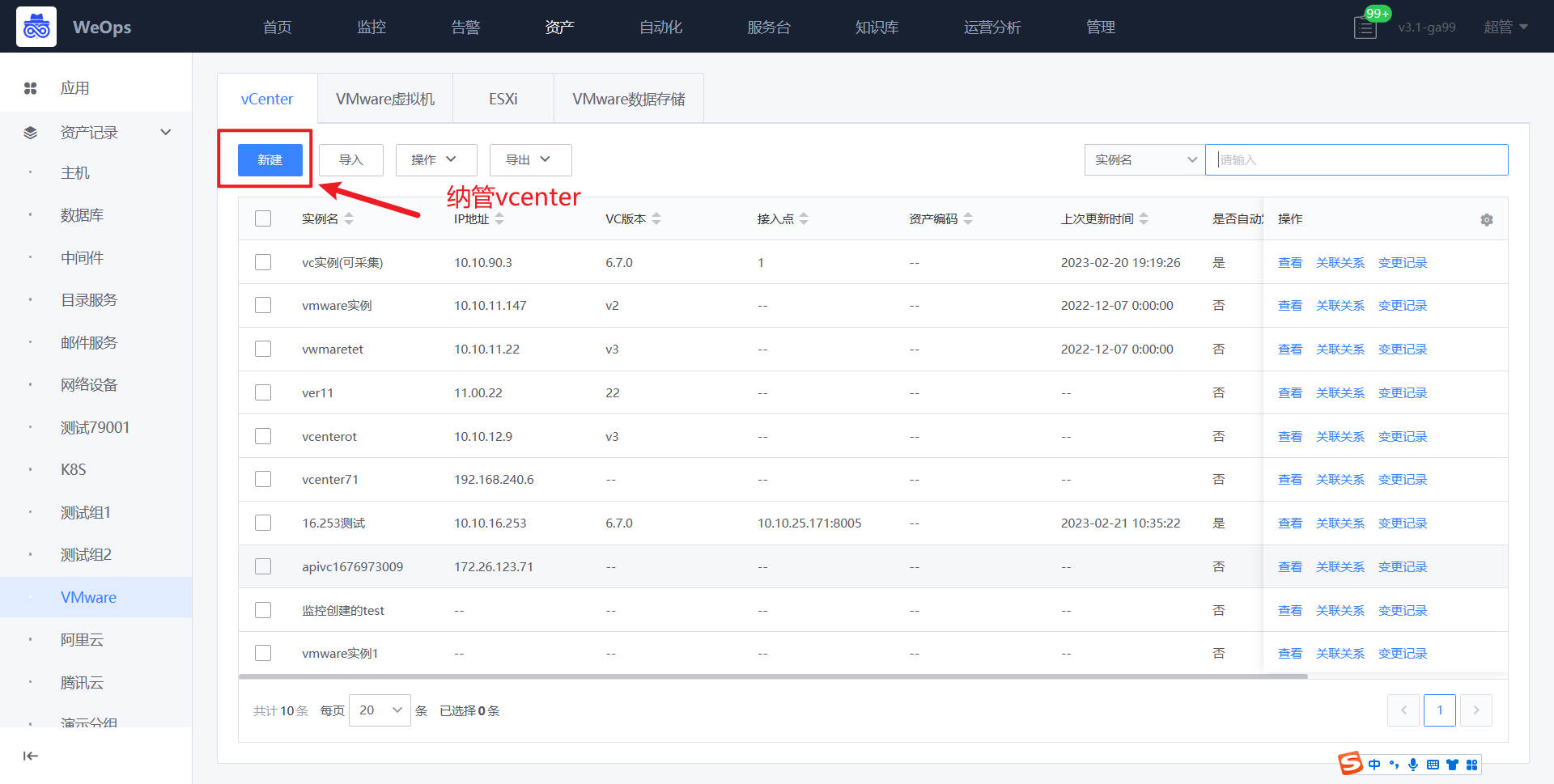

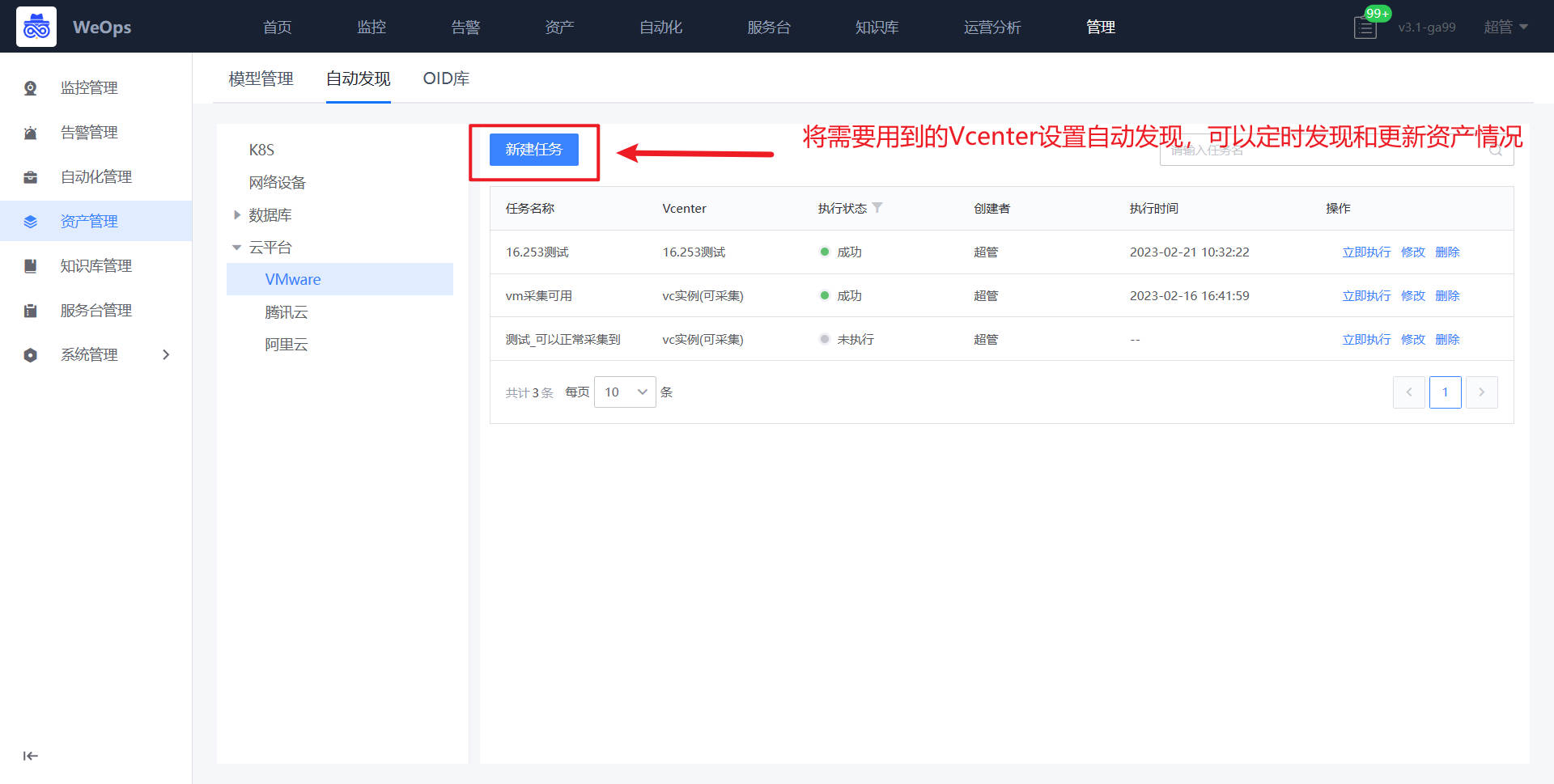

云平台

如下图,“资产记录-VMware/阿里云/腾讯云”展示了内置的云平台的相关模型,VMware包括了“vCenter”、“虚拟机”、“ESXI”、“数据存储”,阿里云包括了“阿里云账号”、“ECS”,腾讯云包括了“腾讯云账号”、“CVM”等。分别展示了云平台各个对象的手动/自动发现和采集的相关信息。

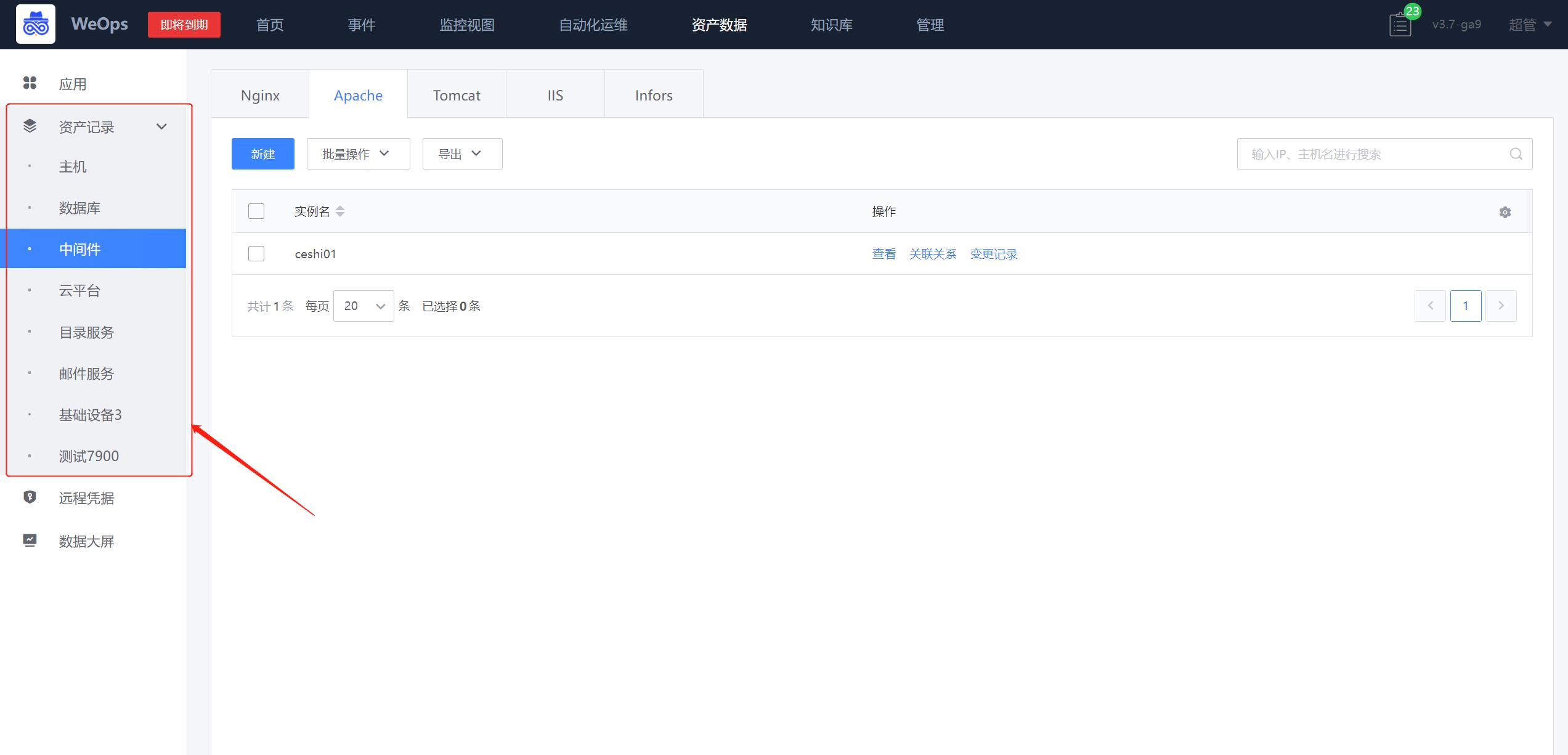

其他动态tab

如下图,“资产记录-其他动态tab”根据资产模型的分组情况进行动态展示,展示了中间件等其他实例类型的基础信息(包括所属应用)、关联关系、变更记录和配置文件。

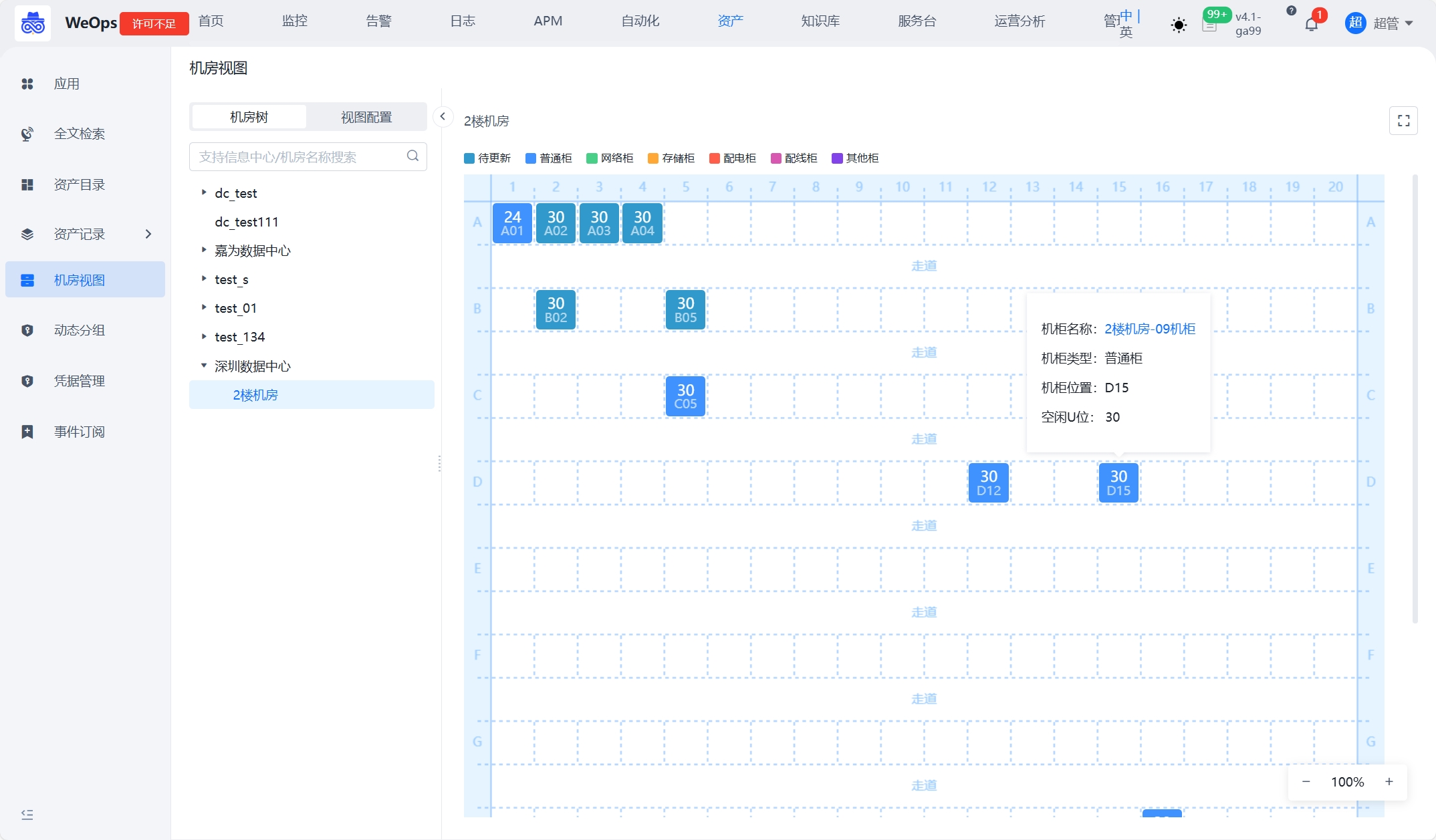

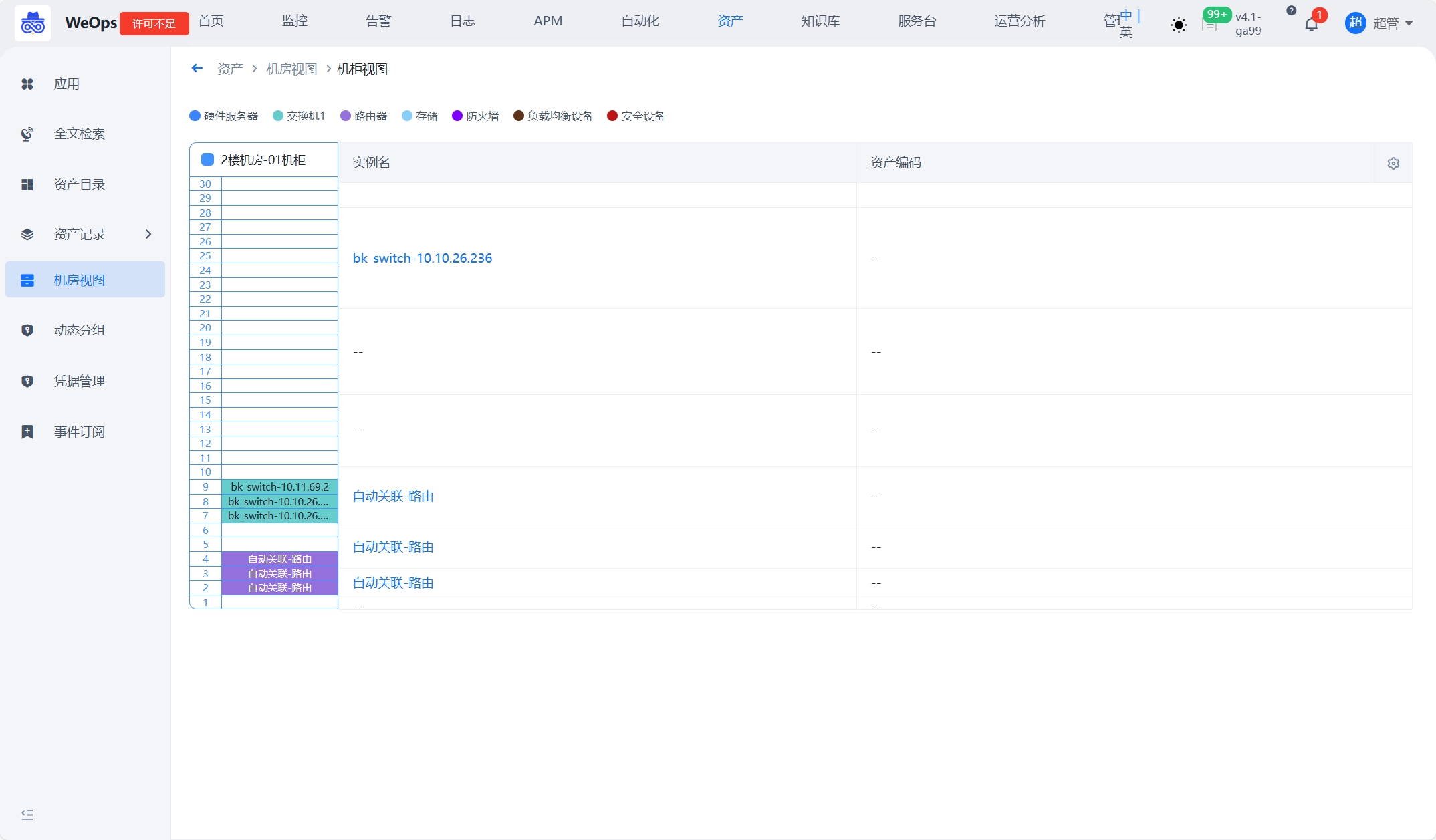

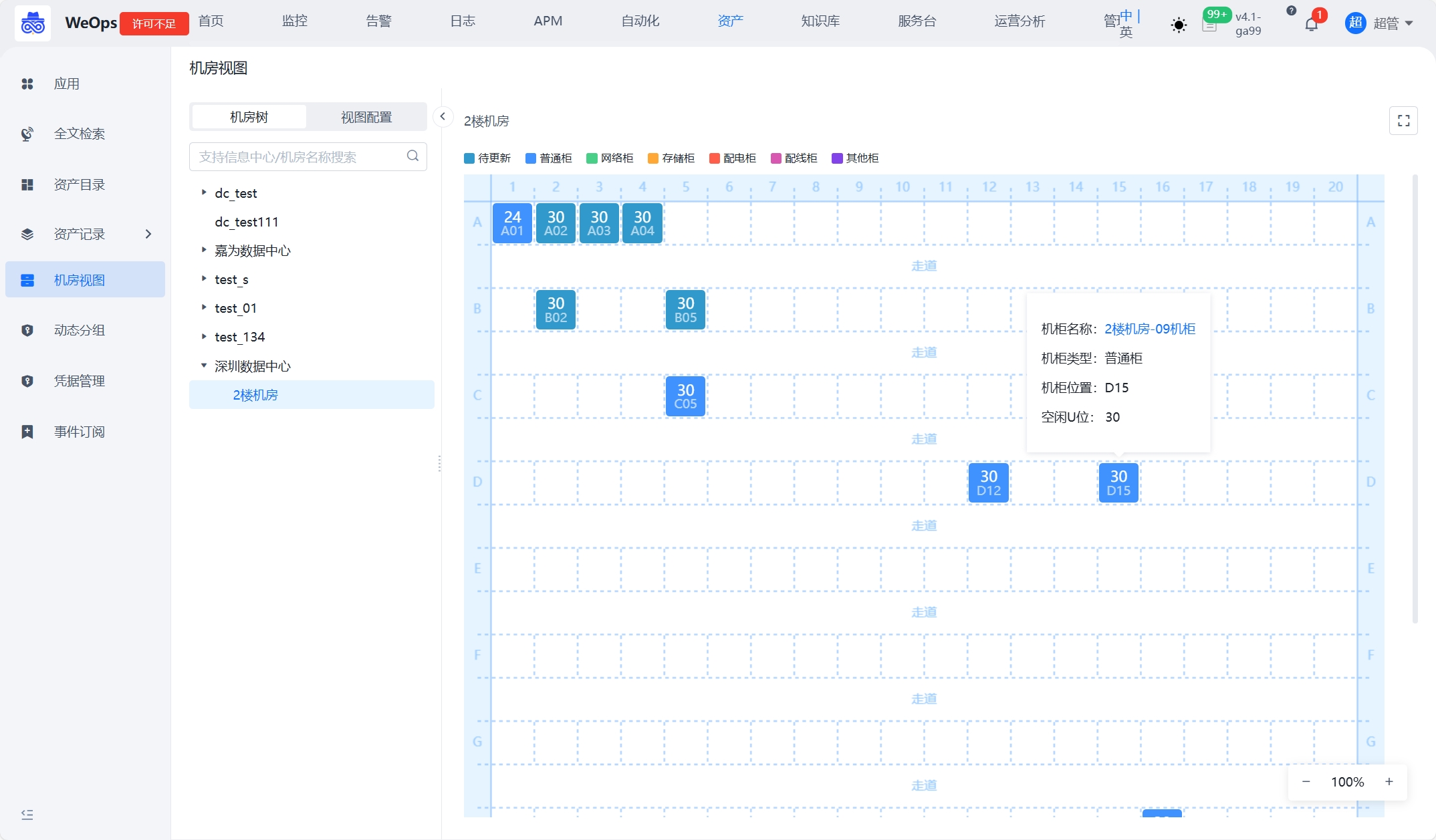

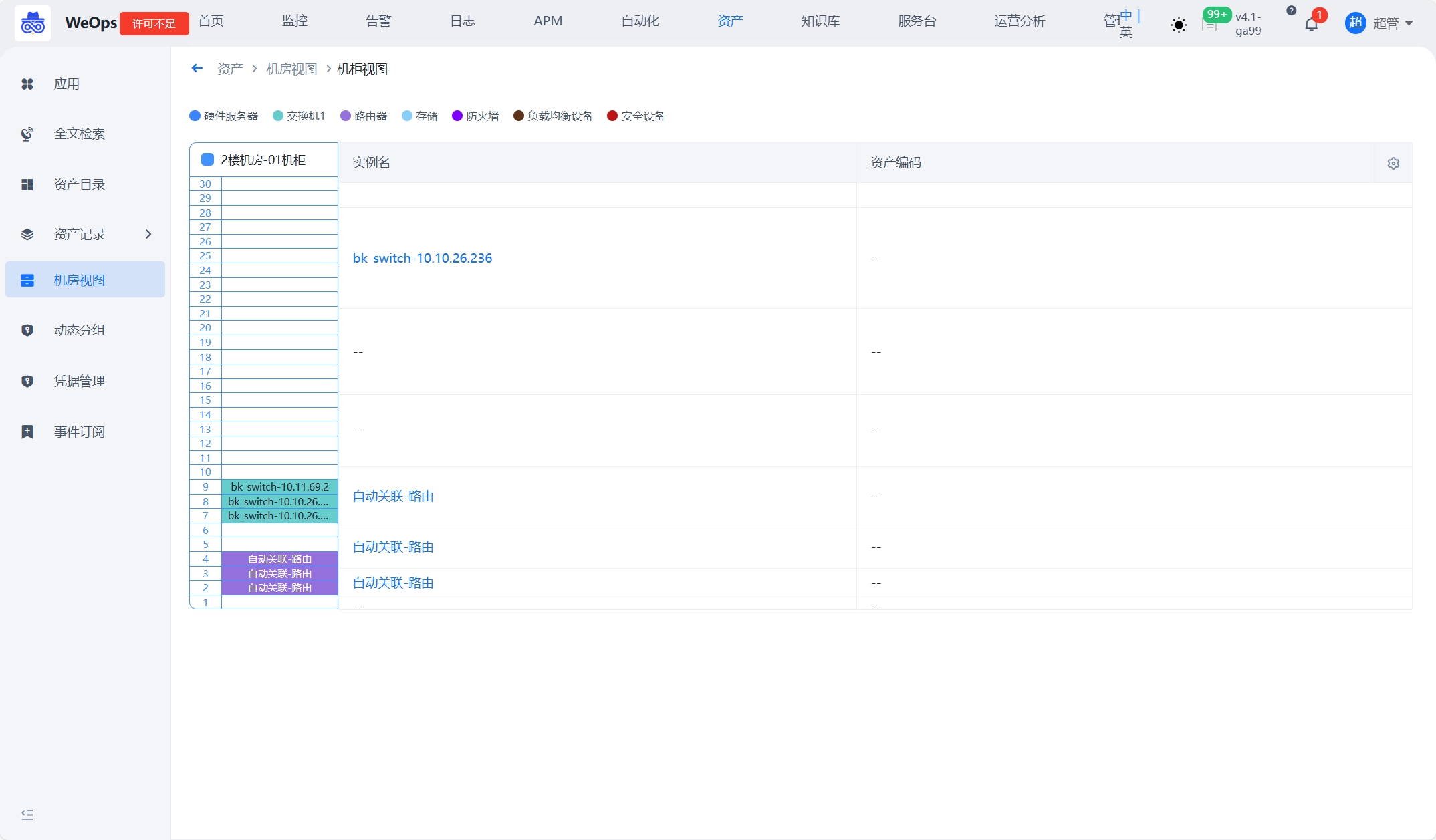

机柜视图

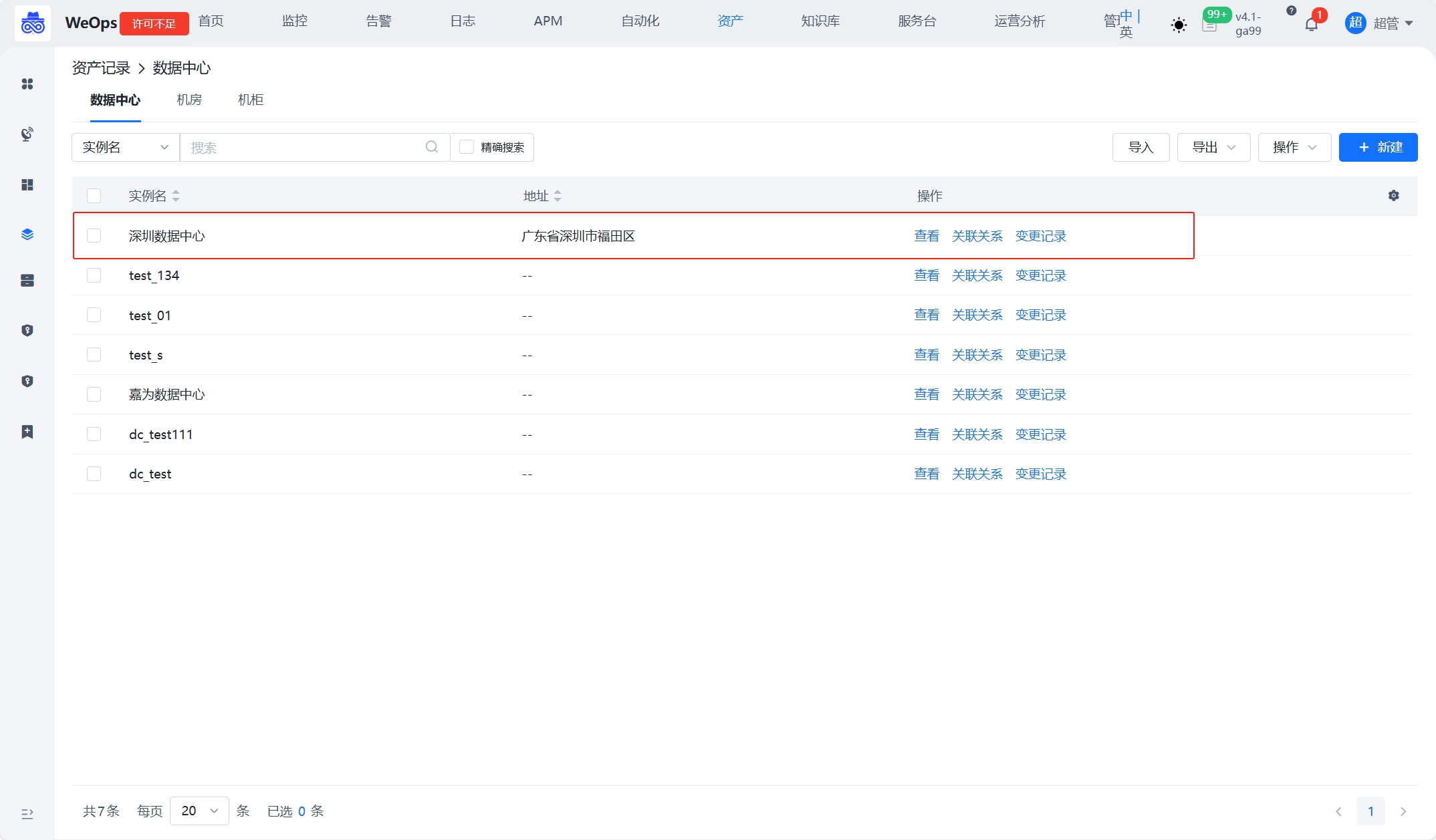

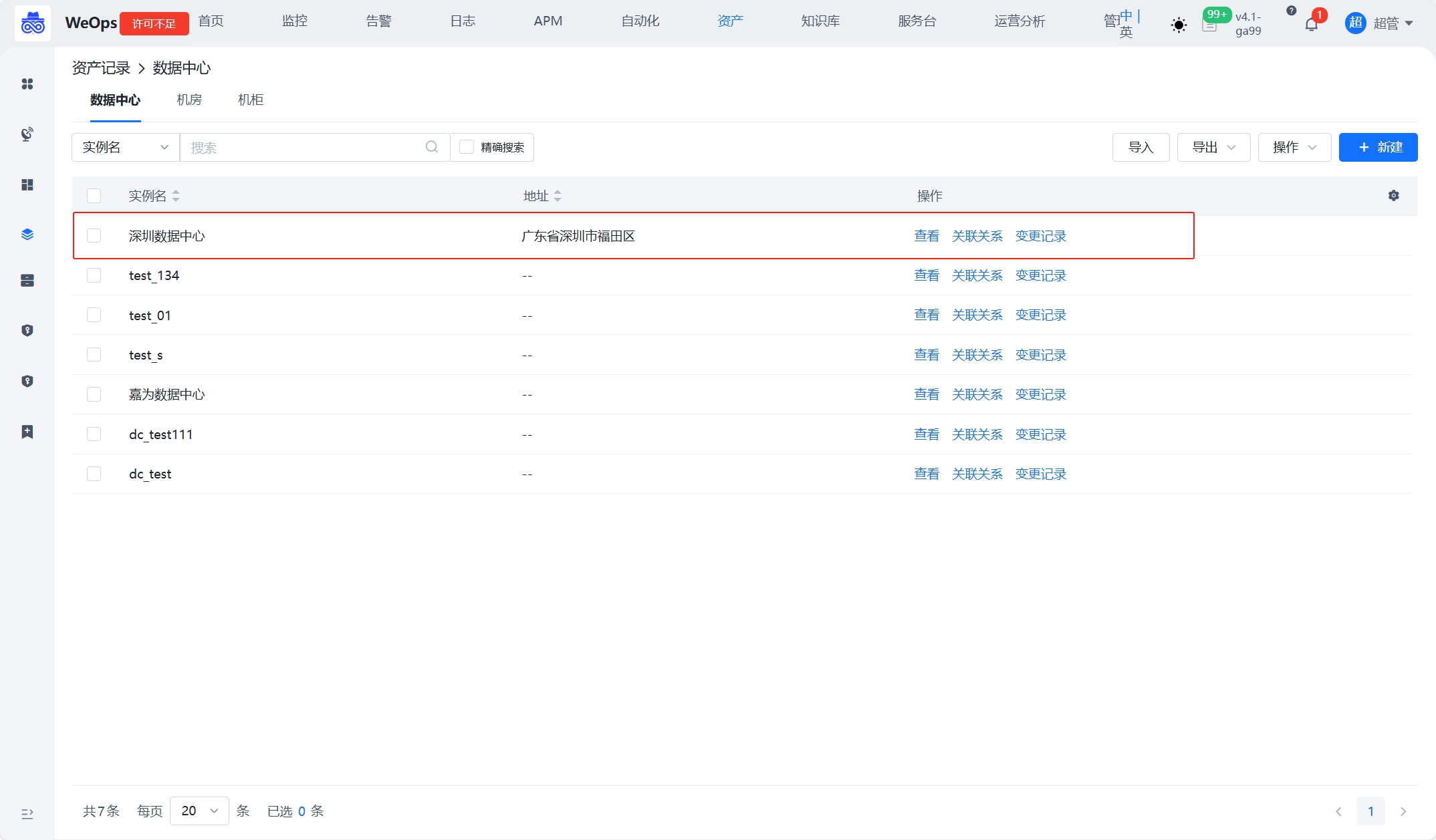

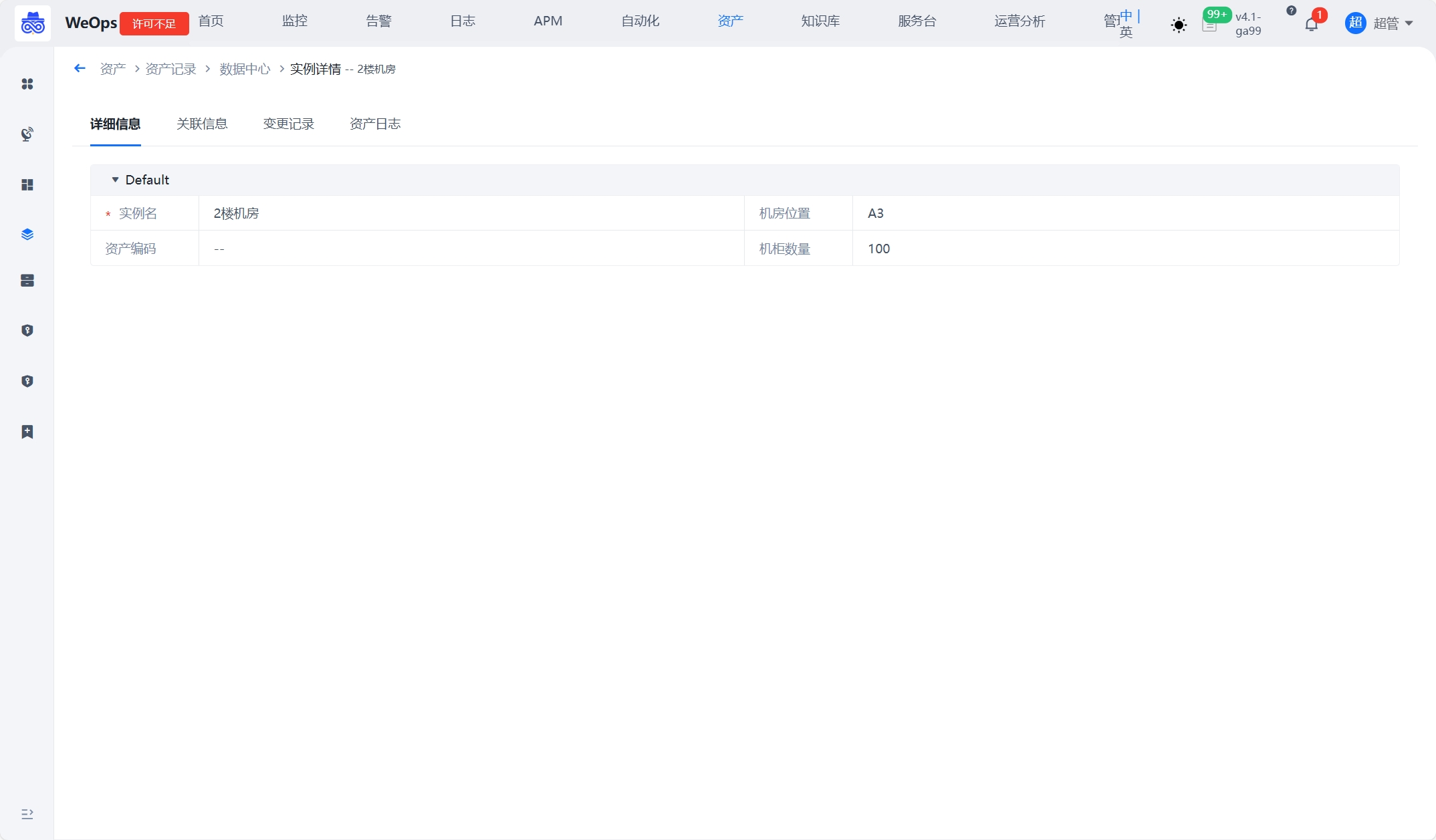

为了直观的展示机柜内设备的布局和状态,新增机房视图,用于各类IT设备的集中管理和展示。

资产设置

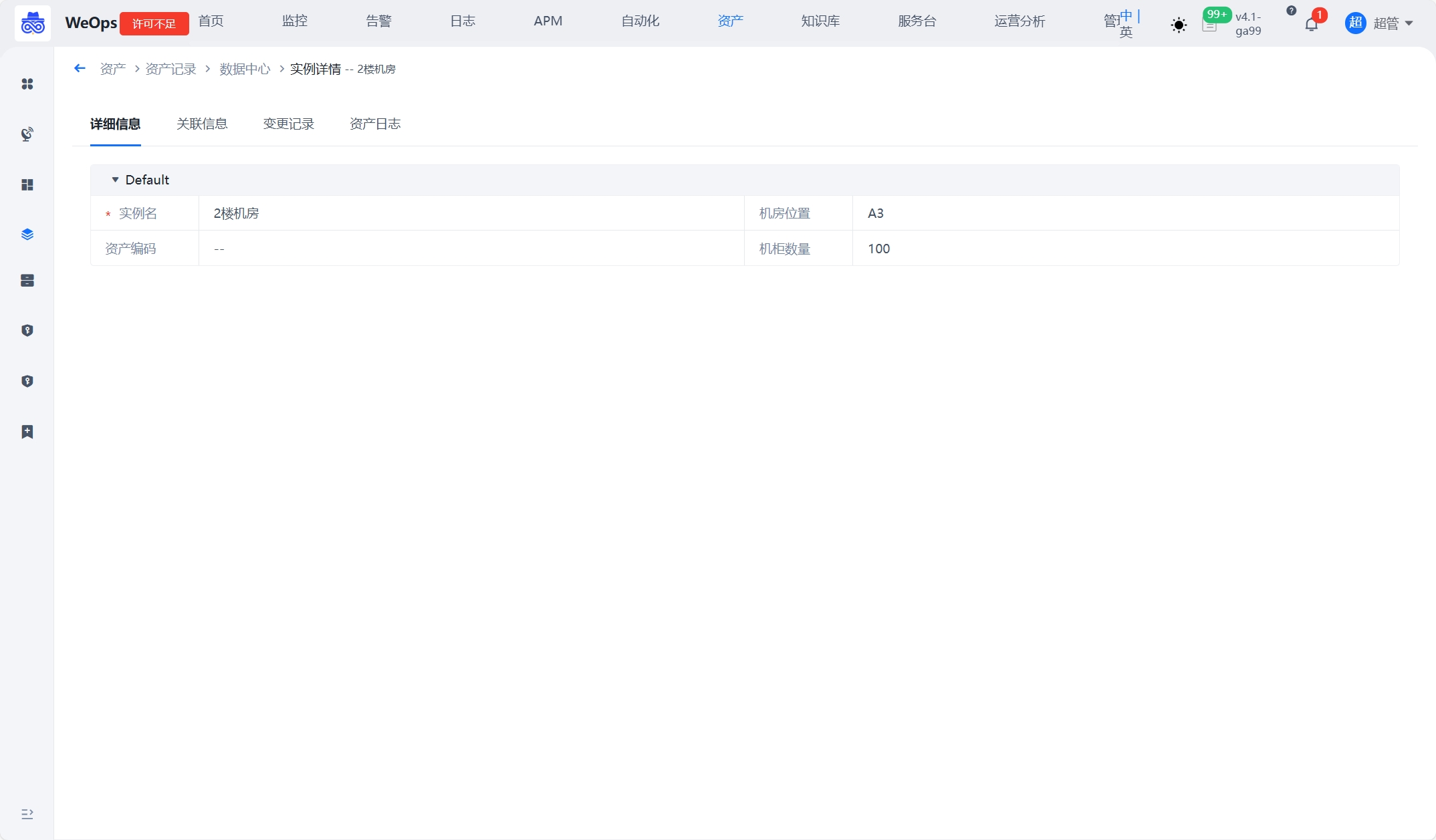

在资产记录中已经内置常用资产模型“数据中心-机房-机柜-设备(网络设备/硬件设备等)”,需要在资产记录的对应位置创建资产实例、填写位置信息并创建关联,步骤如下:

1、创建数据中心实例并填写信息(如“深圳数据中心”);

2、创建机房实例,并且关联到数据中心。比如创建“2号机房”,并且创建它与“深圳数据中心”的关联;

3、创建机柜实例,必须填写“机柜位置”字段,并且创建机柜与机房的关联关系。比如2楼机房放置了10个机柜,需要填写机柜的基本信息,必填“机柜位置”(机柜位置的填写标准格式为“A01”、“B11”等),创建机柜与机房的关联。通过机柜的位置和关联关系,可在机房视图中渲染出位置;

4、创建设备实例,支持“网络设备”和“硬件设备”分组下的实例,放置在对应机柜中,设备需要填写开始U位和结束U位,并创建与机柜的关联,可以渲染出机柜视图。

机房视图

根据“机房-机柜”关联和填写机柜的位置,在视图中按照机柜的位置和类型展示。

机柜视图

根据“机柜-设备”关联和设备的开始U位和结束U位,在机柜视图中展示设备的位置和信息。

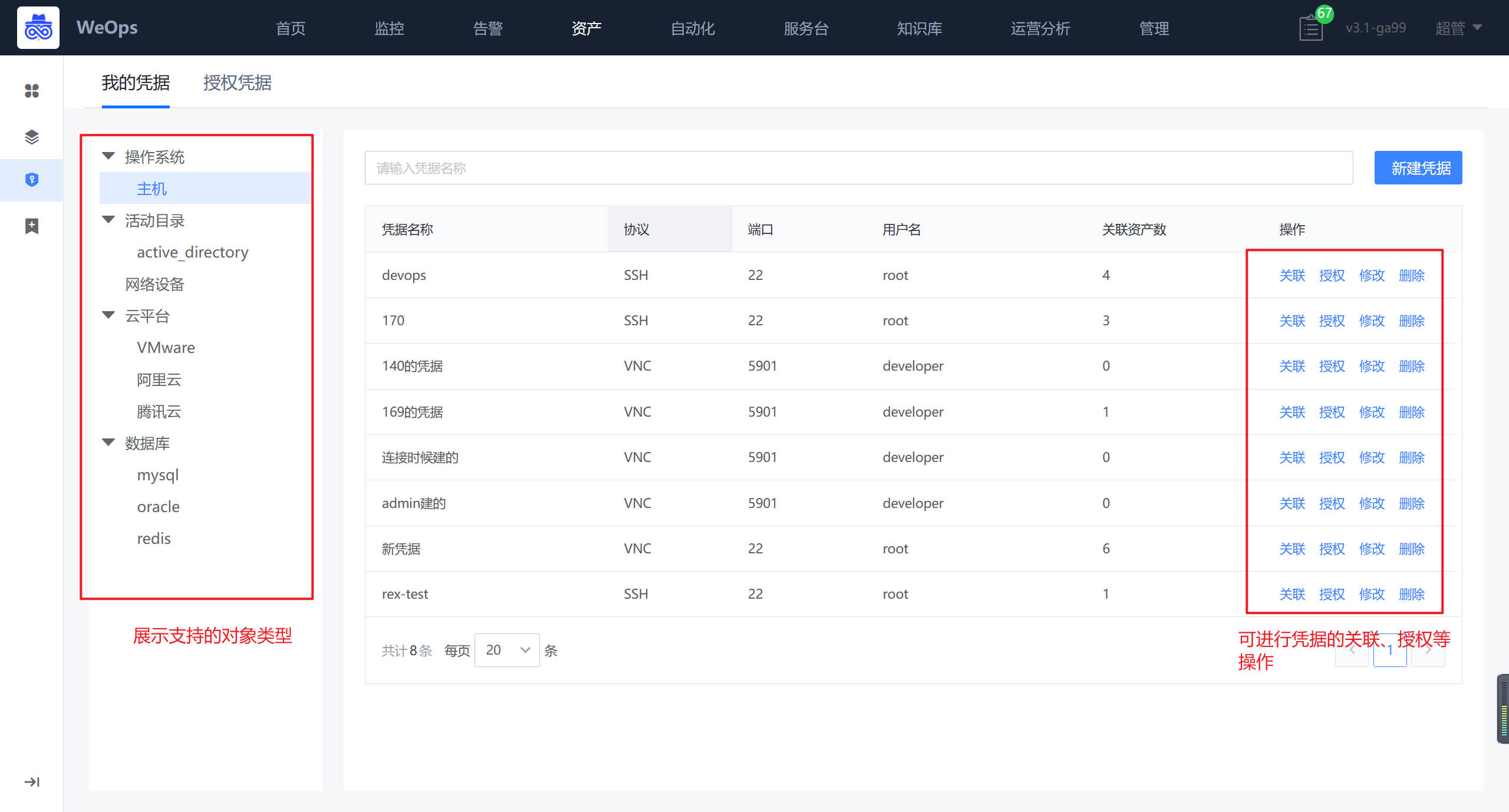

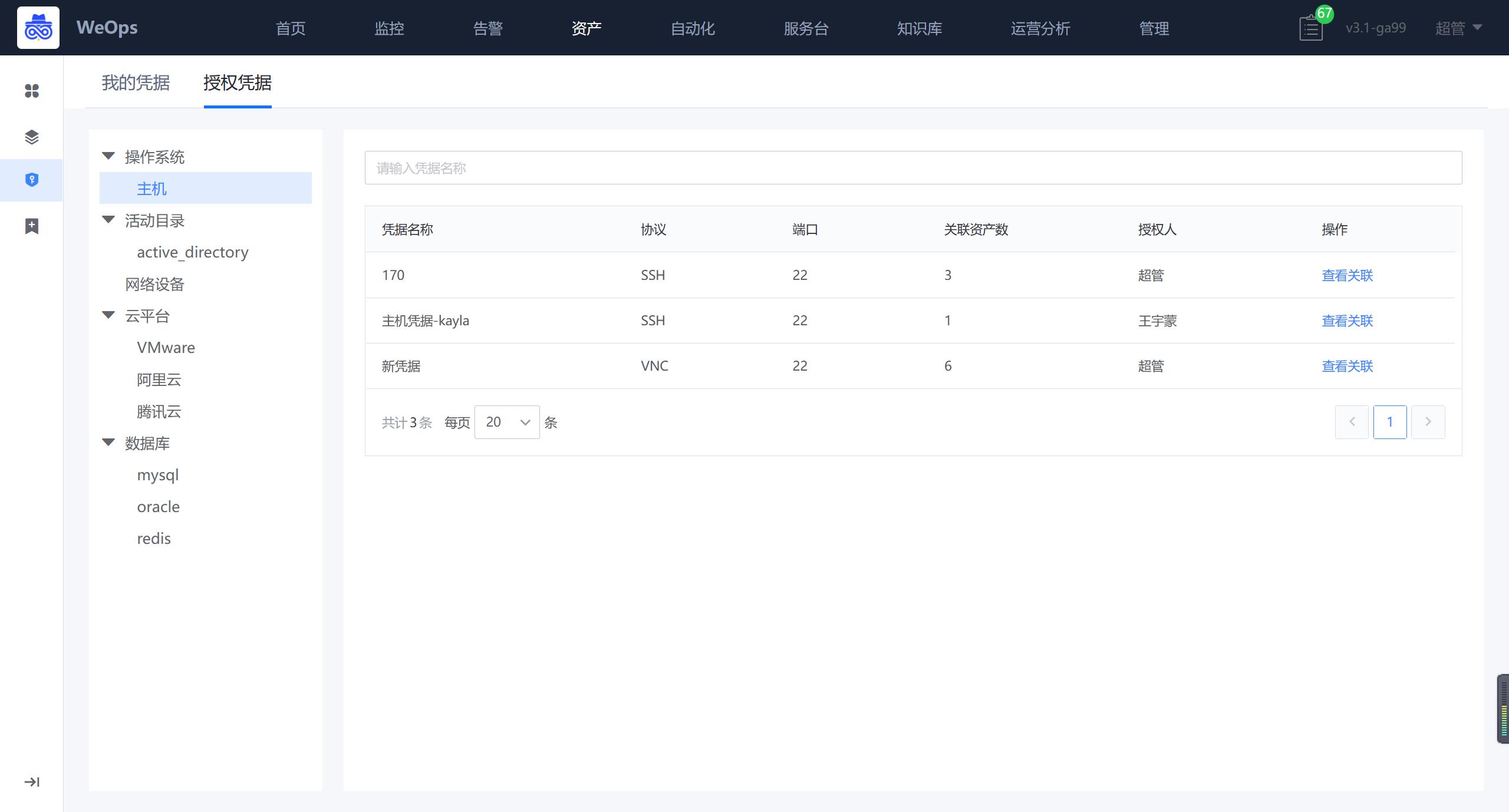

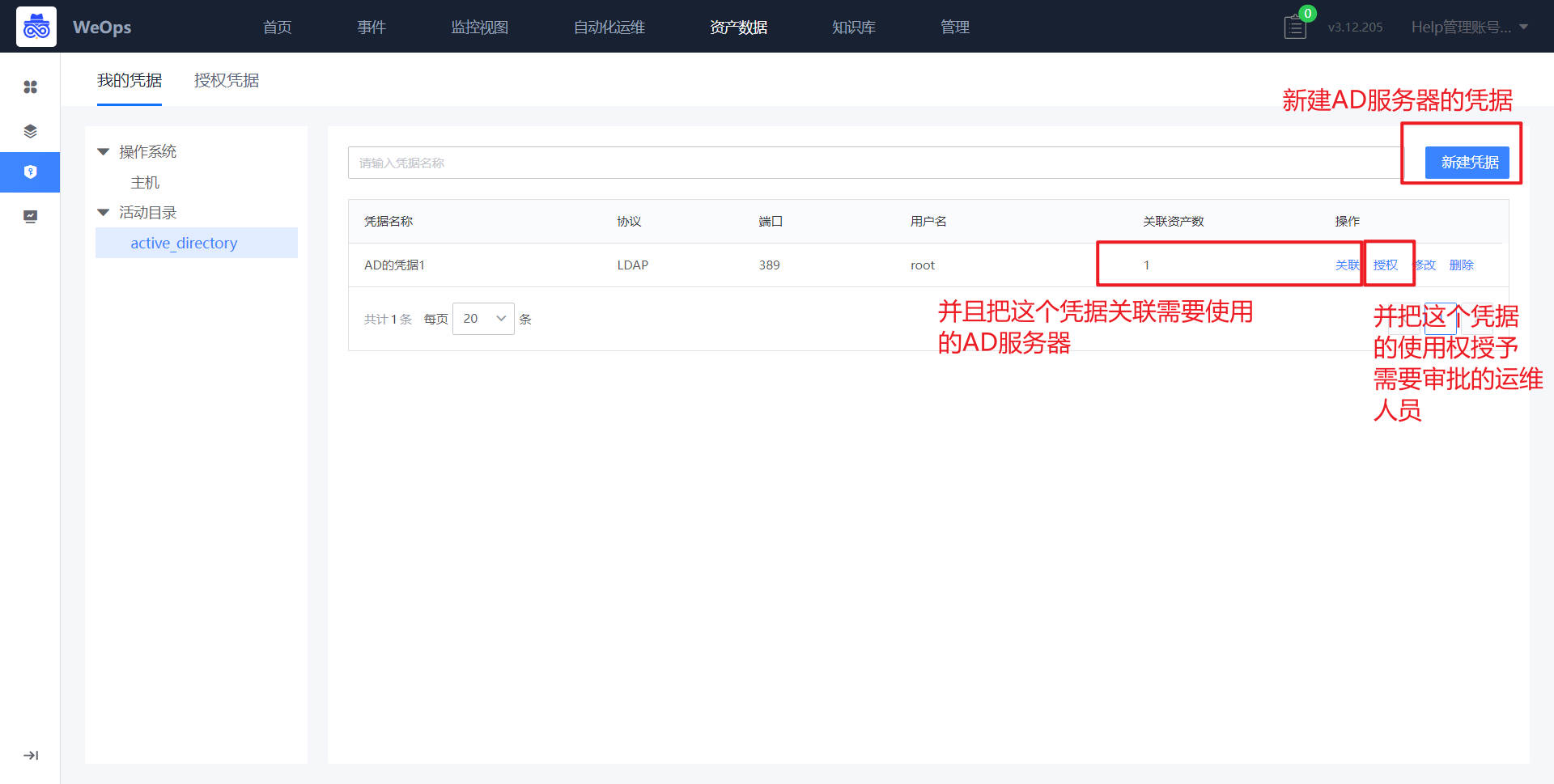

凭据管理

如下图,“资产数据-凭据管理”主要用于存放主机/AD/网络设备/数据库/云平台等资产的凭据,可进行凭据的增删改查和授权,包括如下两个模块:我的凭据、凭据授权

- 我的凭据:支持主机/AD/网络设备/数据库/云平台凭据的新建和操作,主机支持SSH/RDP/VNC协议,AD支持LDAP/LDAPS协议,凭据新建完成后需要关联资产,被关联的资产才可以使用该凭据。

- 授权凭据:别人授权给我的凭据,我可以在对应资产使用已经授权给我的凭据,也可以查看这个凭据关联的资产情况

凭据的使用场景

- 远程连接:“告警-主机”/“资产记录-主机”支持使用主机的凭据进行远程连接。

- 自动化工单流程:数据库/AD等凭据支持在内置的AD和数据库工单流程中选择使用

- 自动发现:网络设备和云平台的凭据支持在设置自动发现任务时选择使用

- 监控采集:网络设备和云平台的凭据支持在设置监控采集任务时选择使用

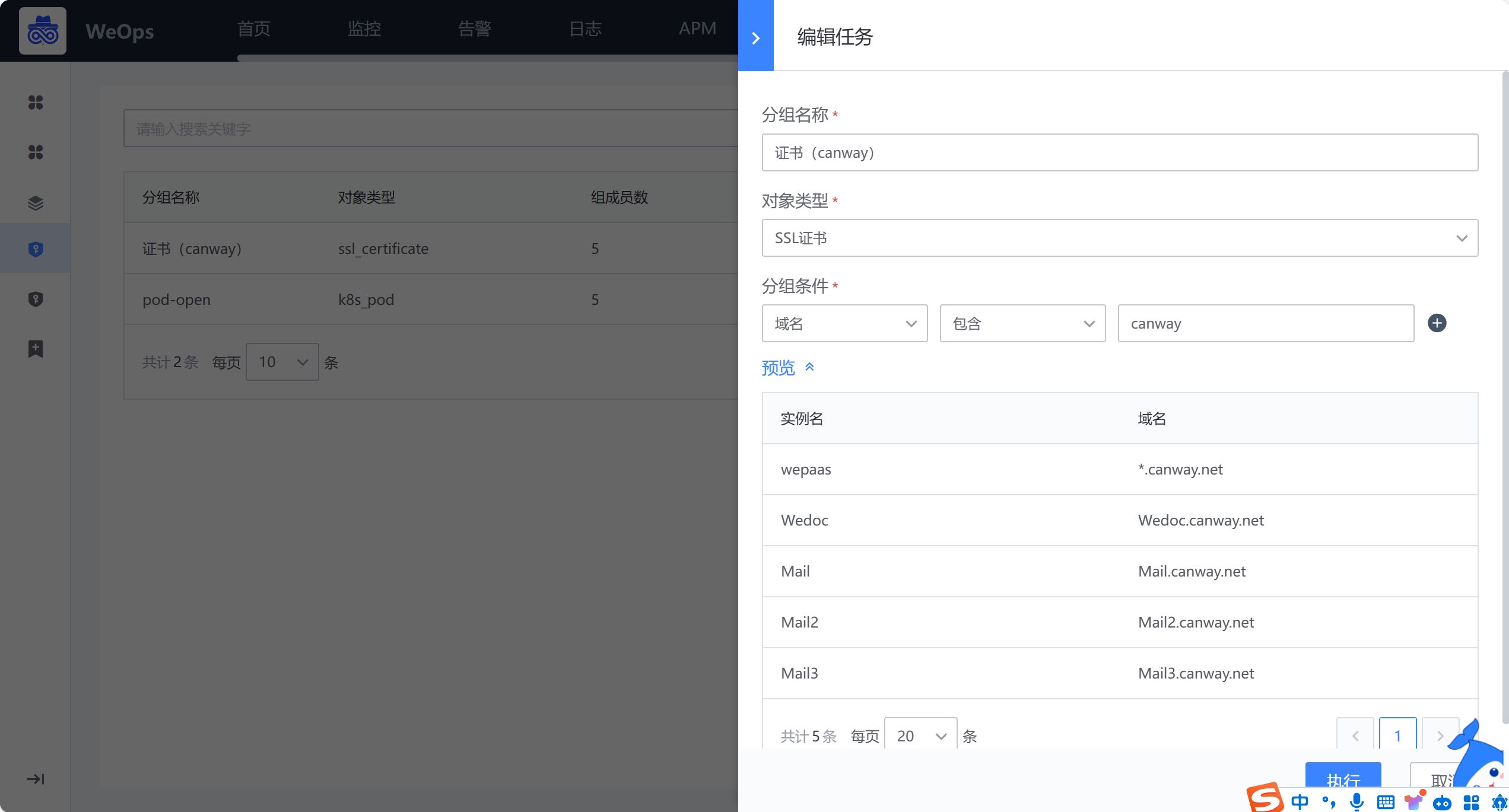

动态分组

- 当资产在变动的时候(增删改),对应的监控和订阅策略生效的对象支持动态变化,动态更新,适用于所有的资产类型

- 当动态分组设置完成后,可以用于事件订阅和监控策略的创建。

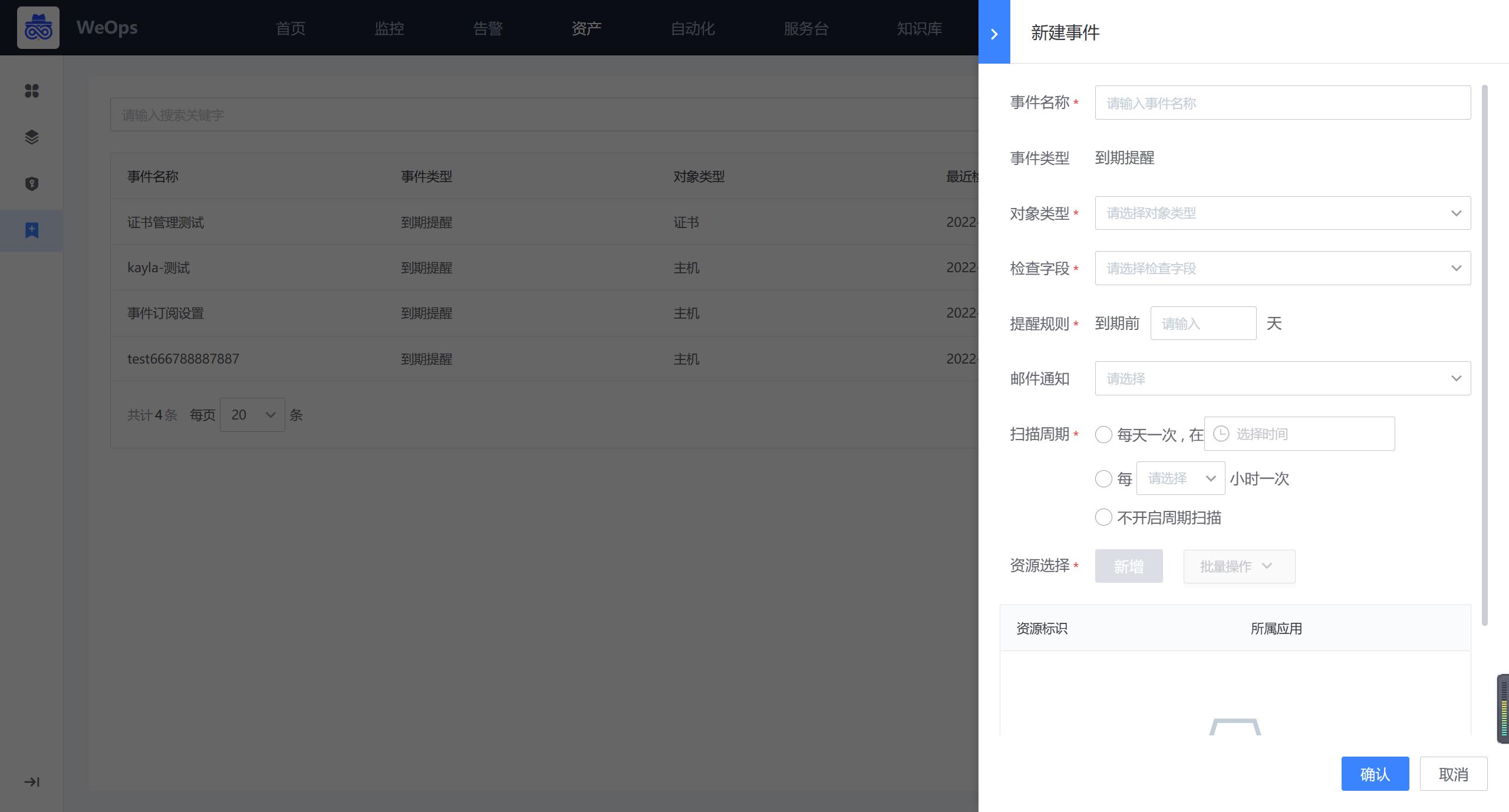

事件订阅

如下图,支持对资产记录中资产的到期情况进行订阅,可设置提醒的资产和字段,并设置到期提醒的规则。

自动化运维

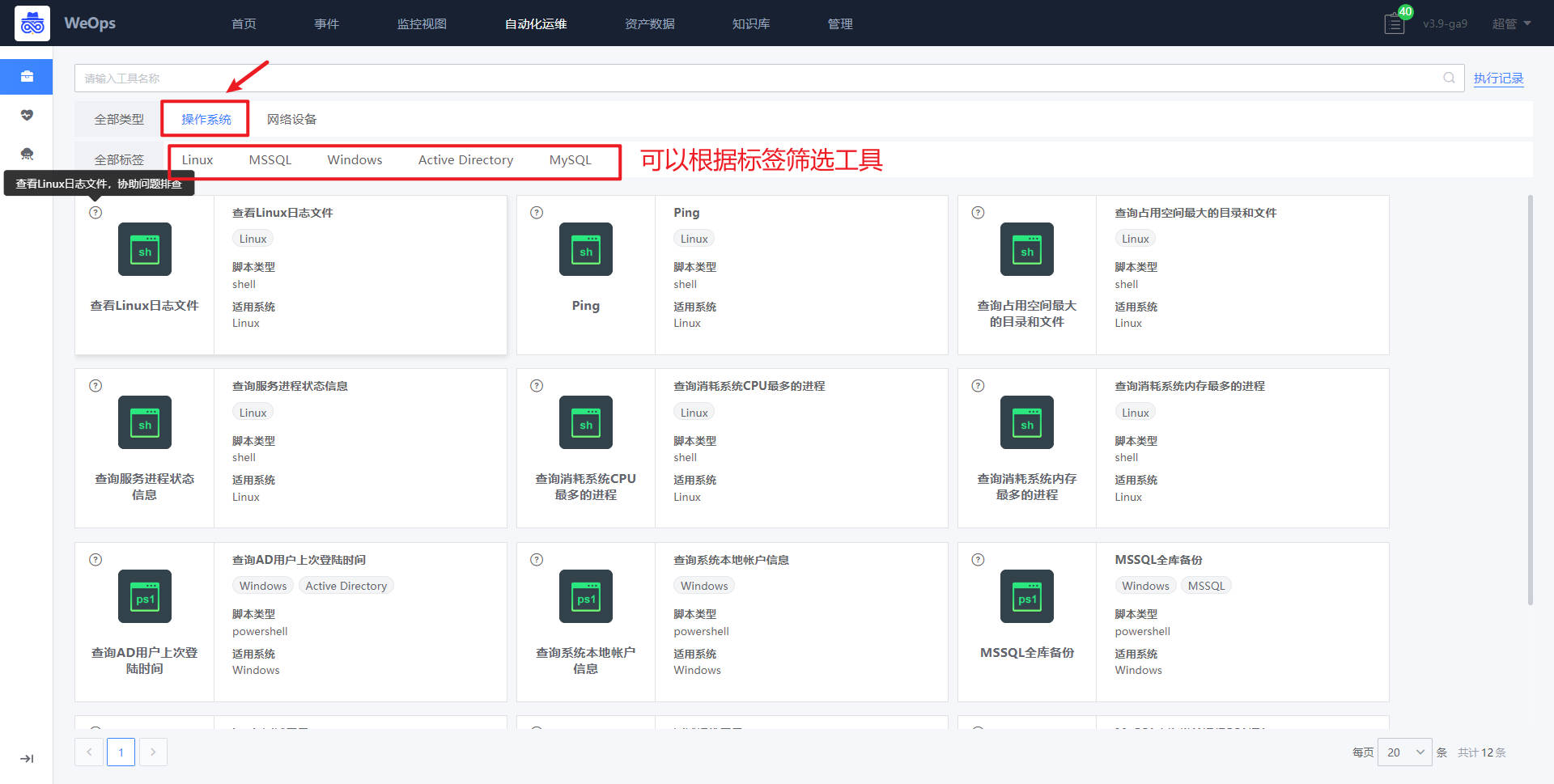

运维工具

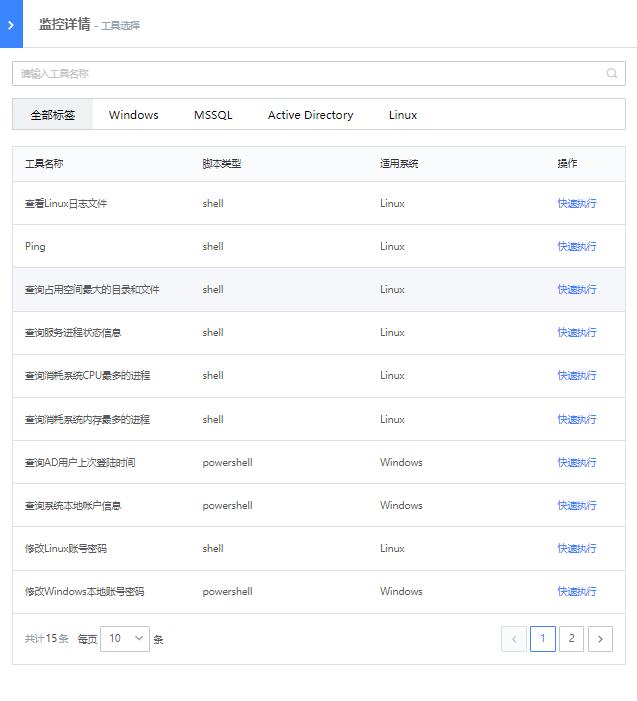

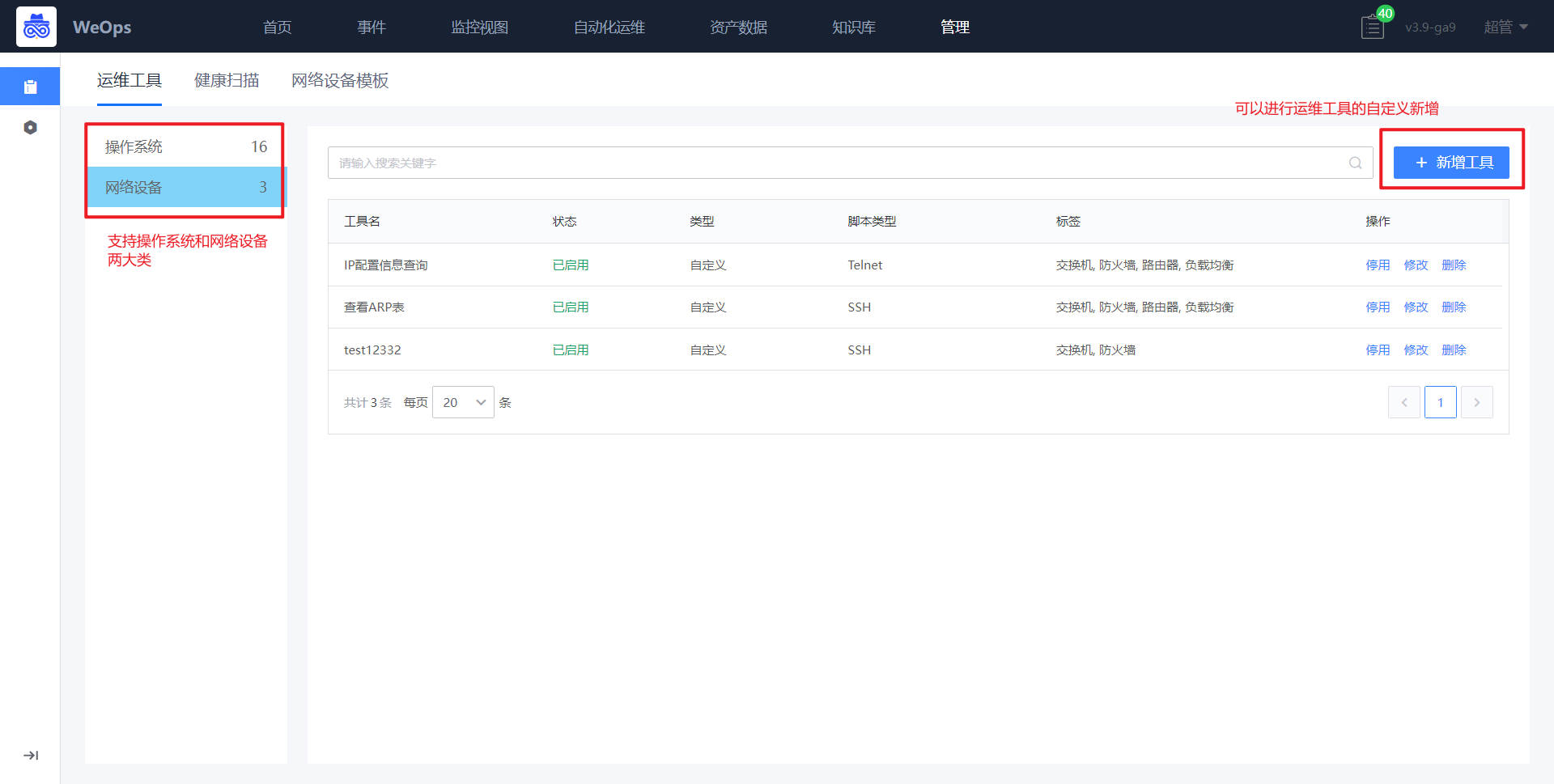

“自动化运维-运维工具”的类型分为操作系统工具和网络设备工具两类

操作系统工具

如下图,操作系统工具具展示了WeOps内置/自定义的常用的操作系统的脚本工具,支持脚本的快速执行。

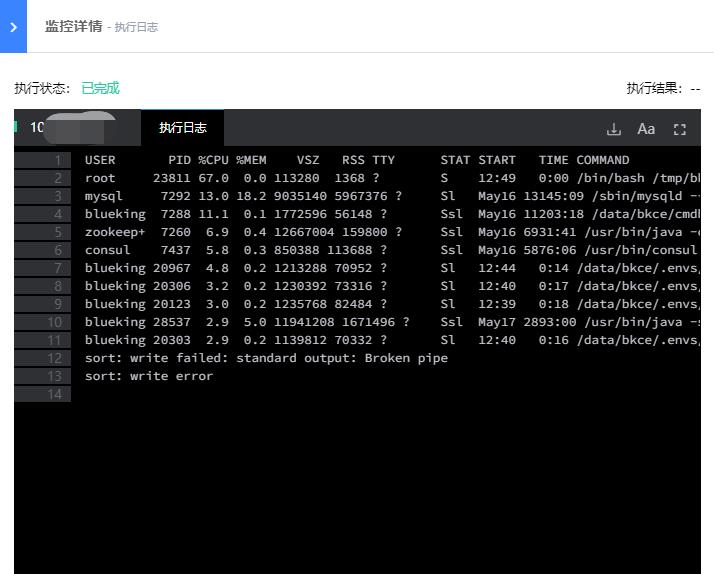

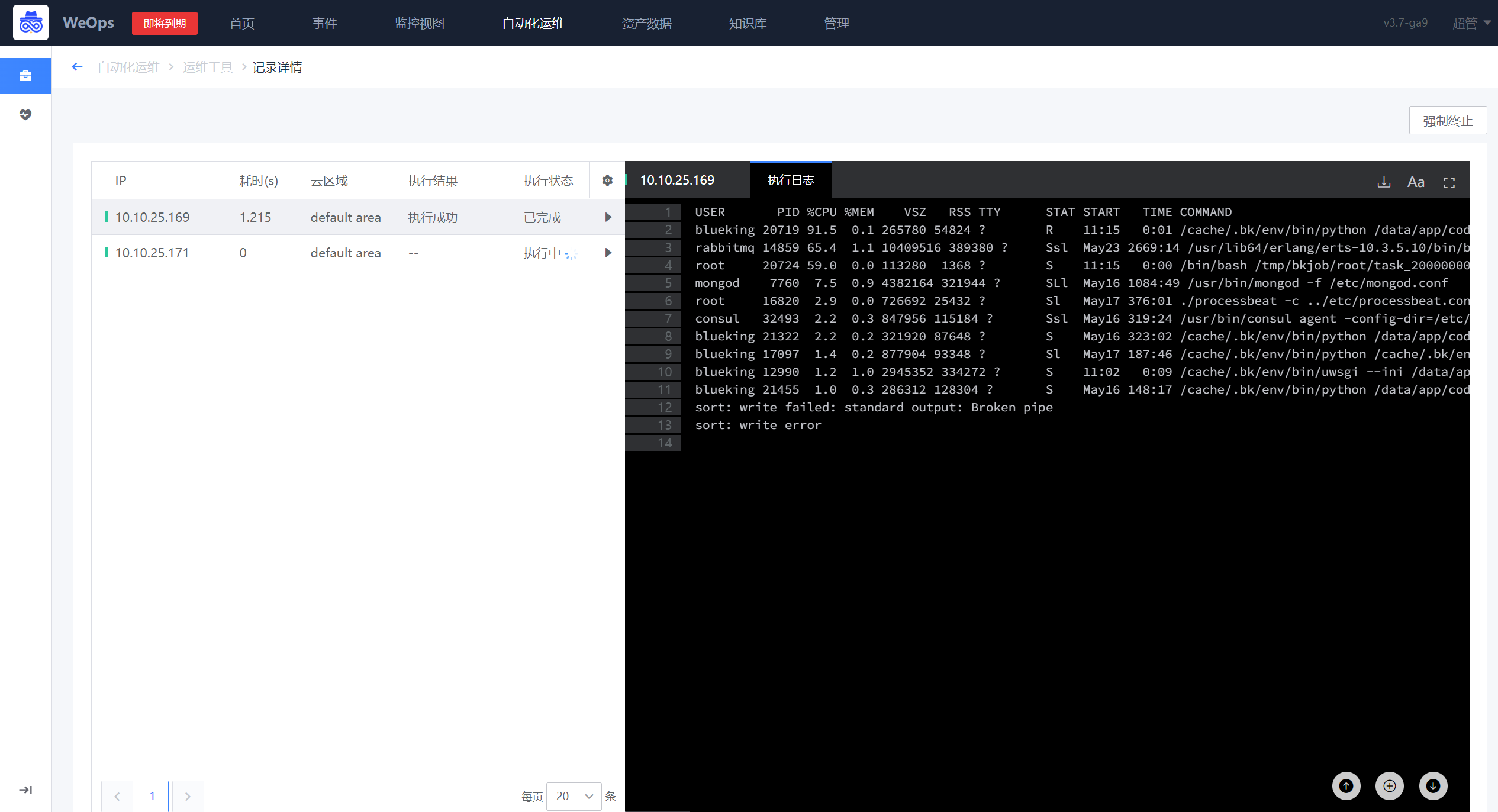

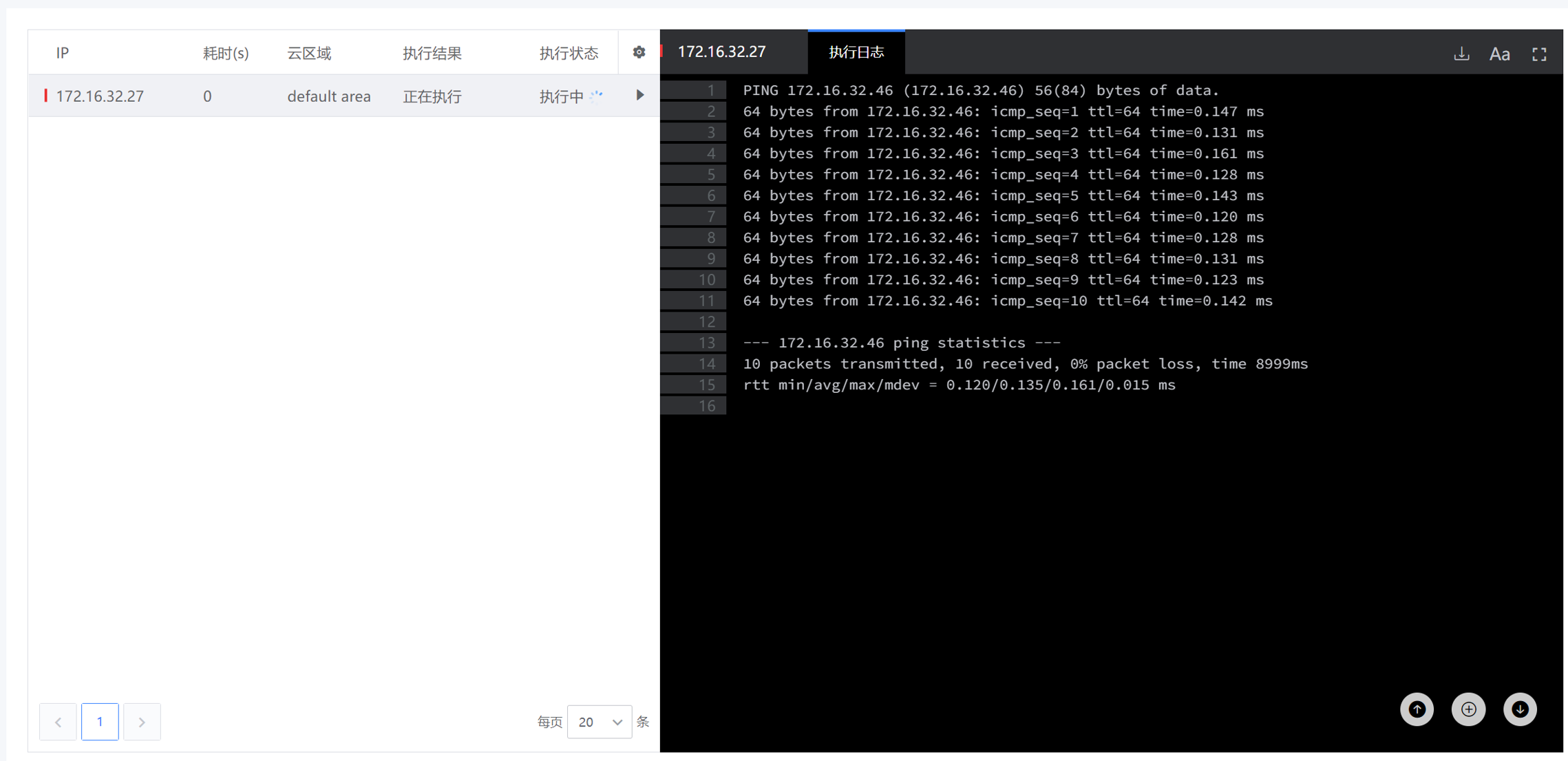

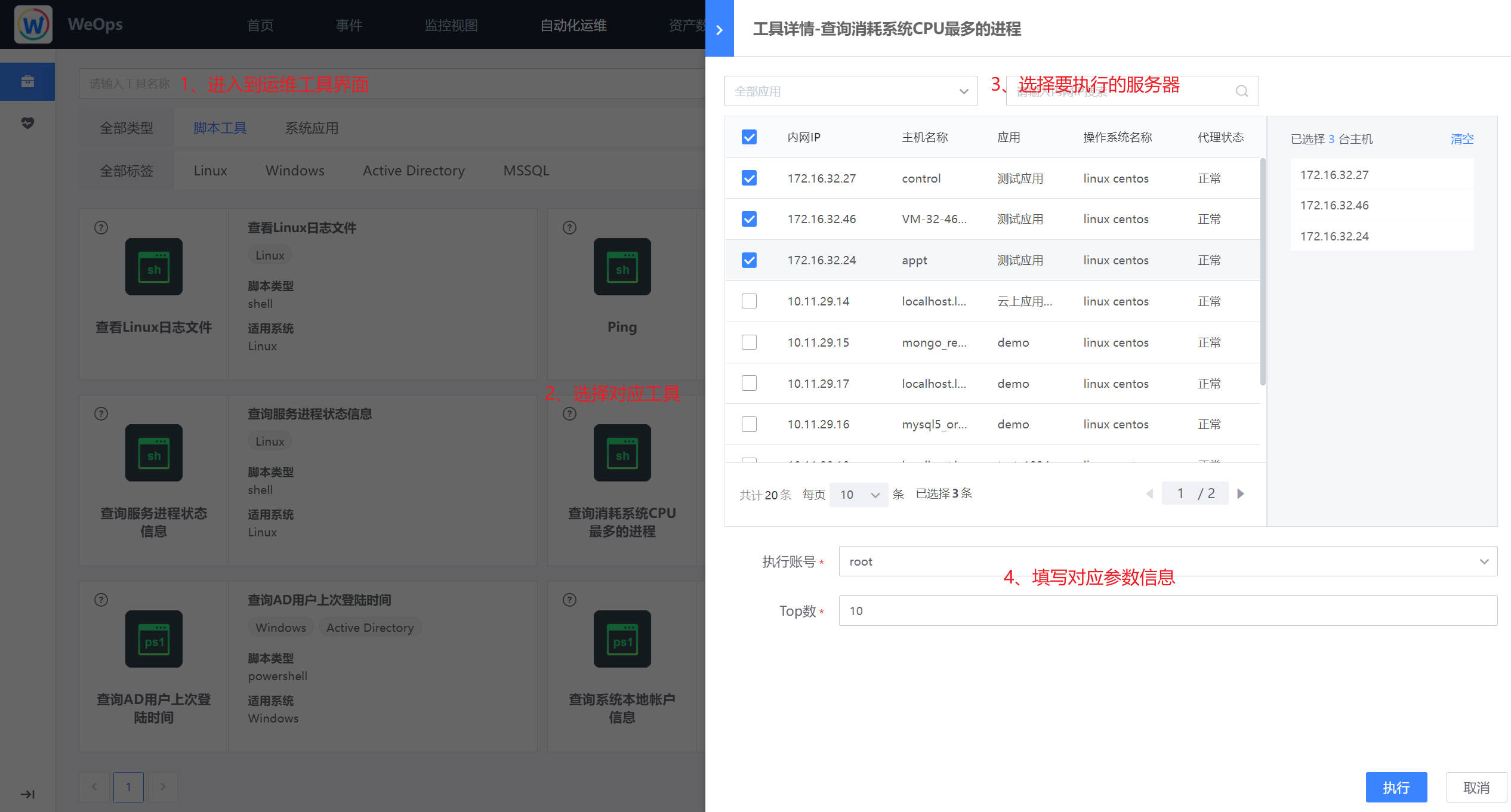

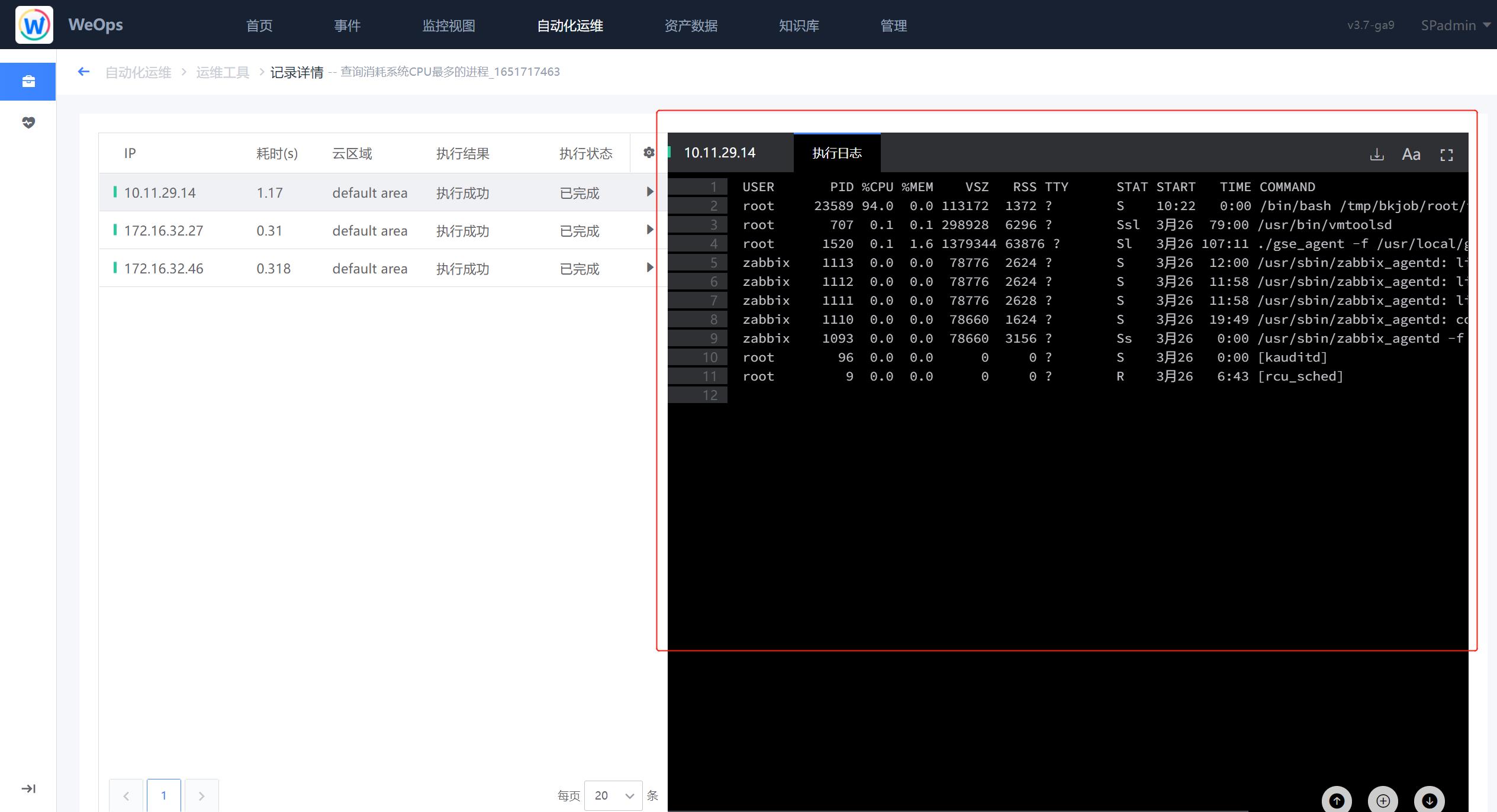

- 这里以“查询消耗系统CPU最多的进程”为例,点击脚本工具进入使用界面,选择对应的主机,输入参数,点击“执行”按钮,即可进行该脚本工具的使用。

- 如下图,执行完成后,可以再查看操作结果

脚本工具支持自定义,自定义方式详见“操作手册-3、其他配置-工具管理”

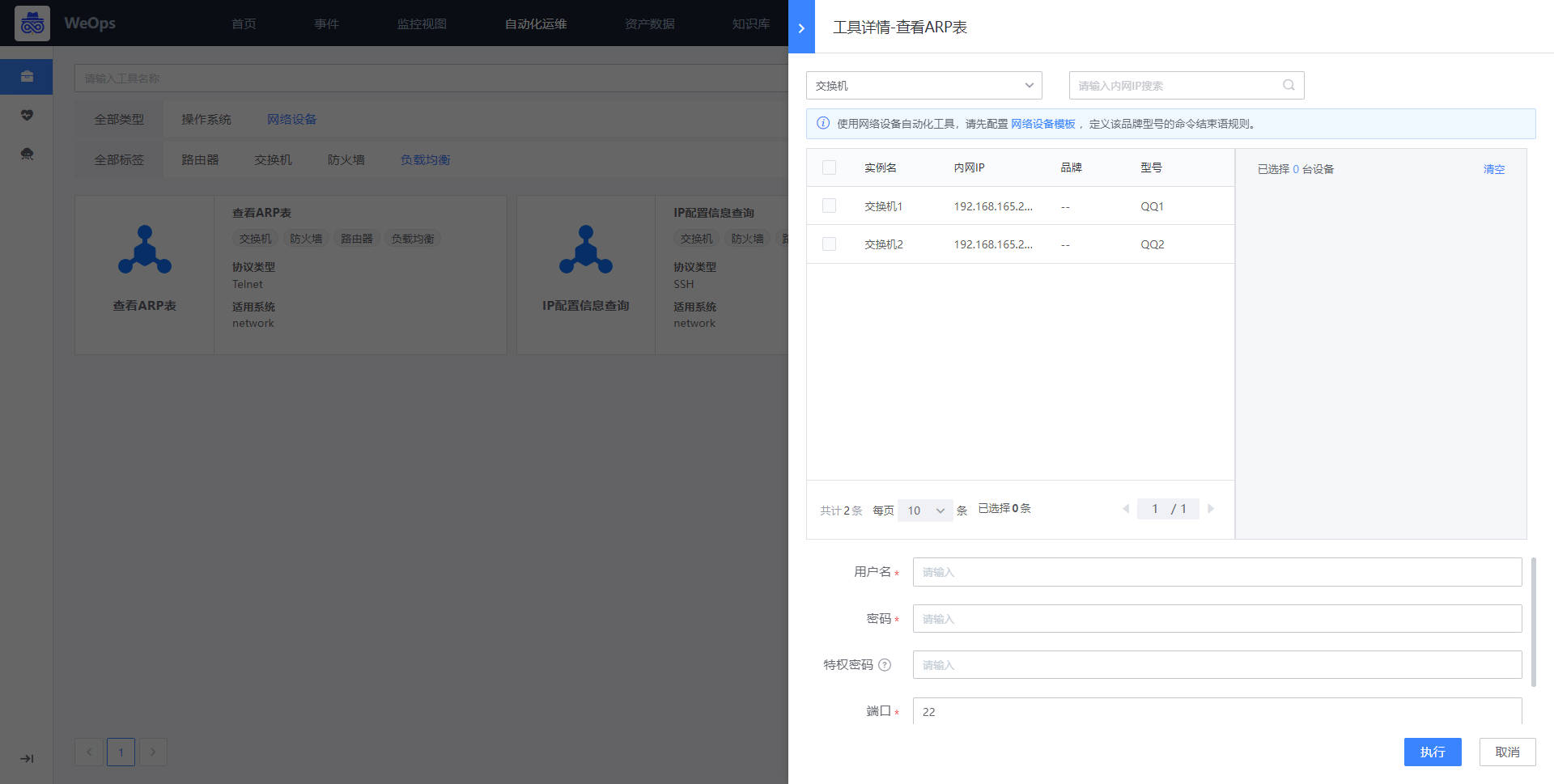

网络设备工具

如下图,WeOps支持网络设备的脚本工具的执行,展示了内置/自定义的脚本工具,可以快速执行。

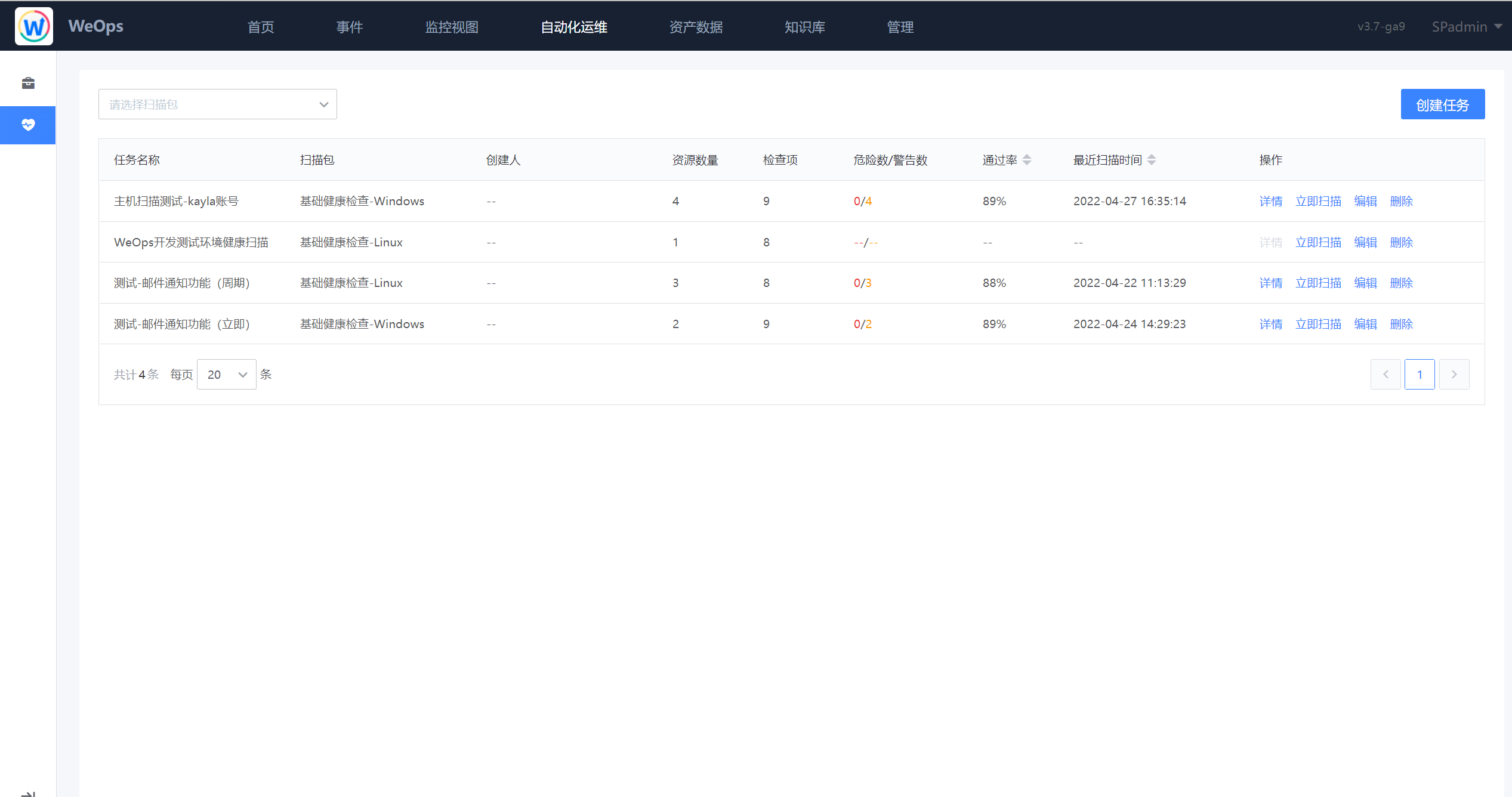

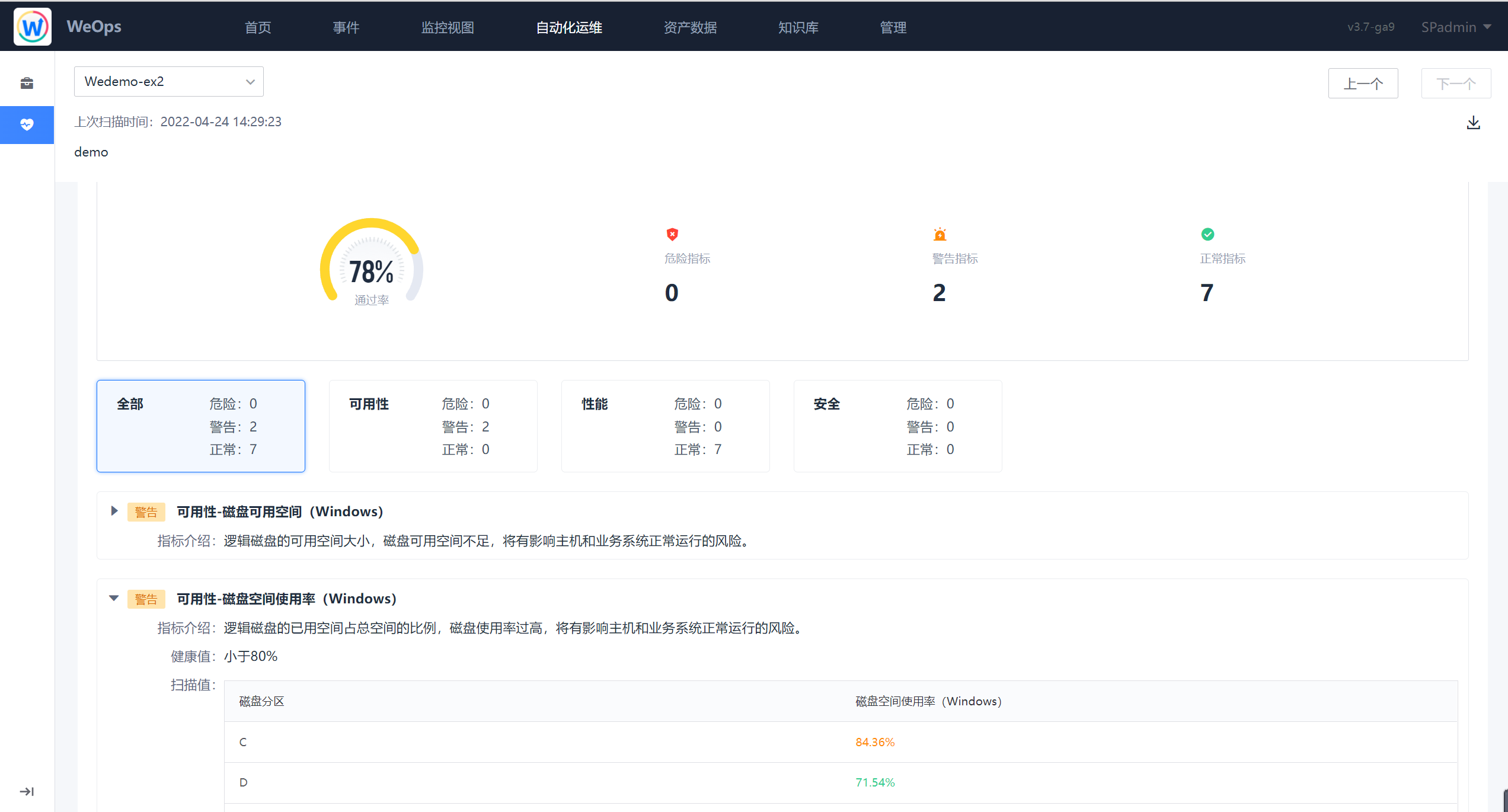

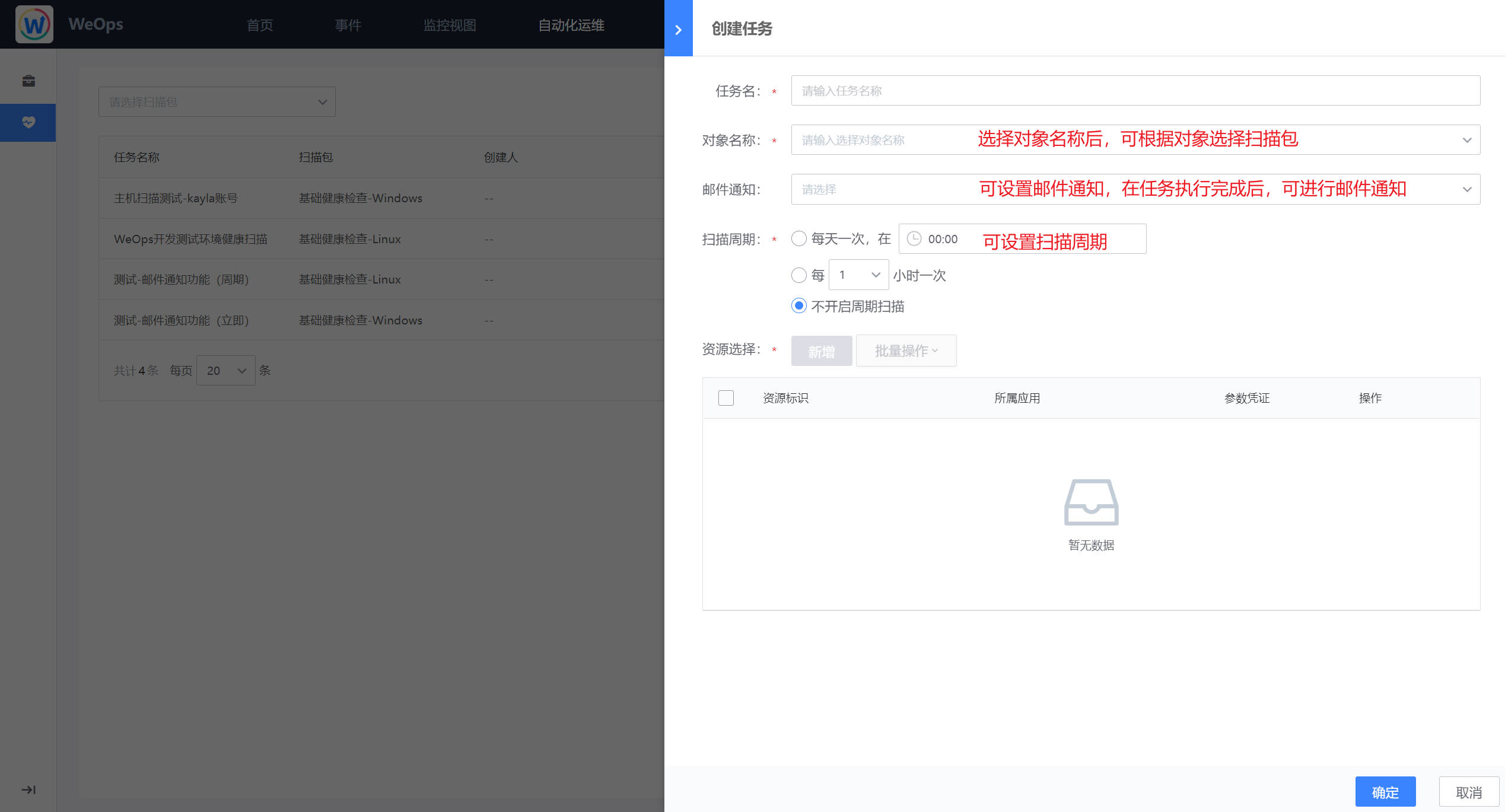

健康扫描

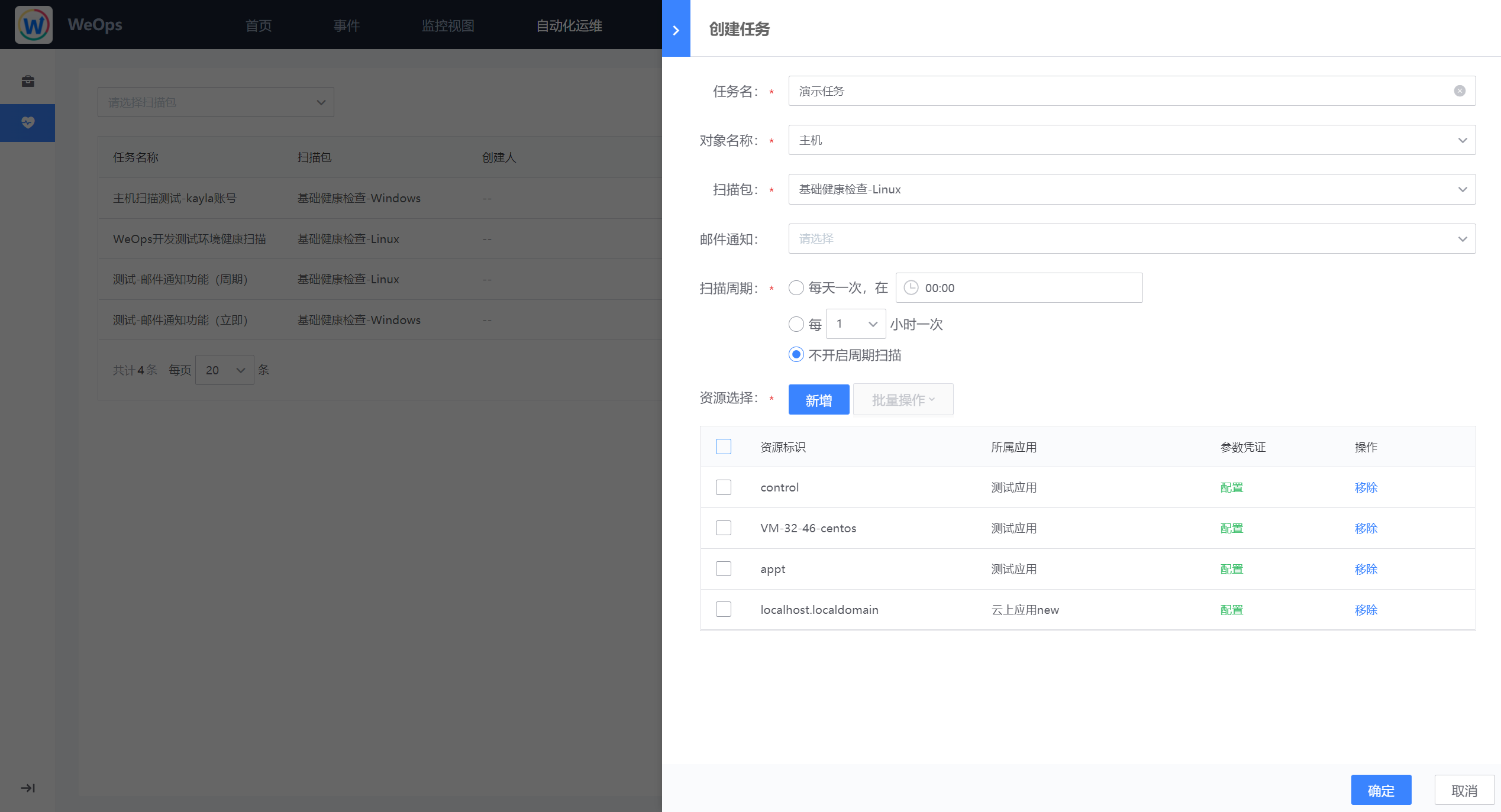

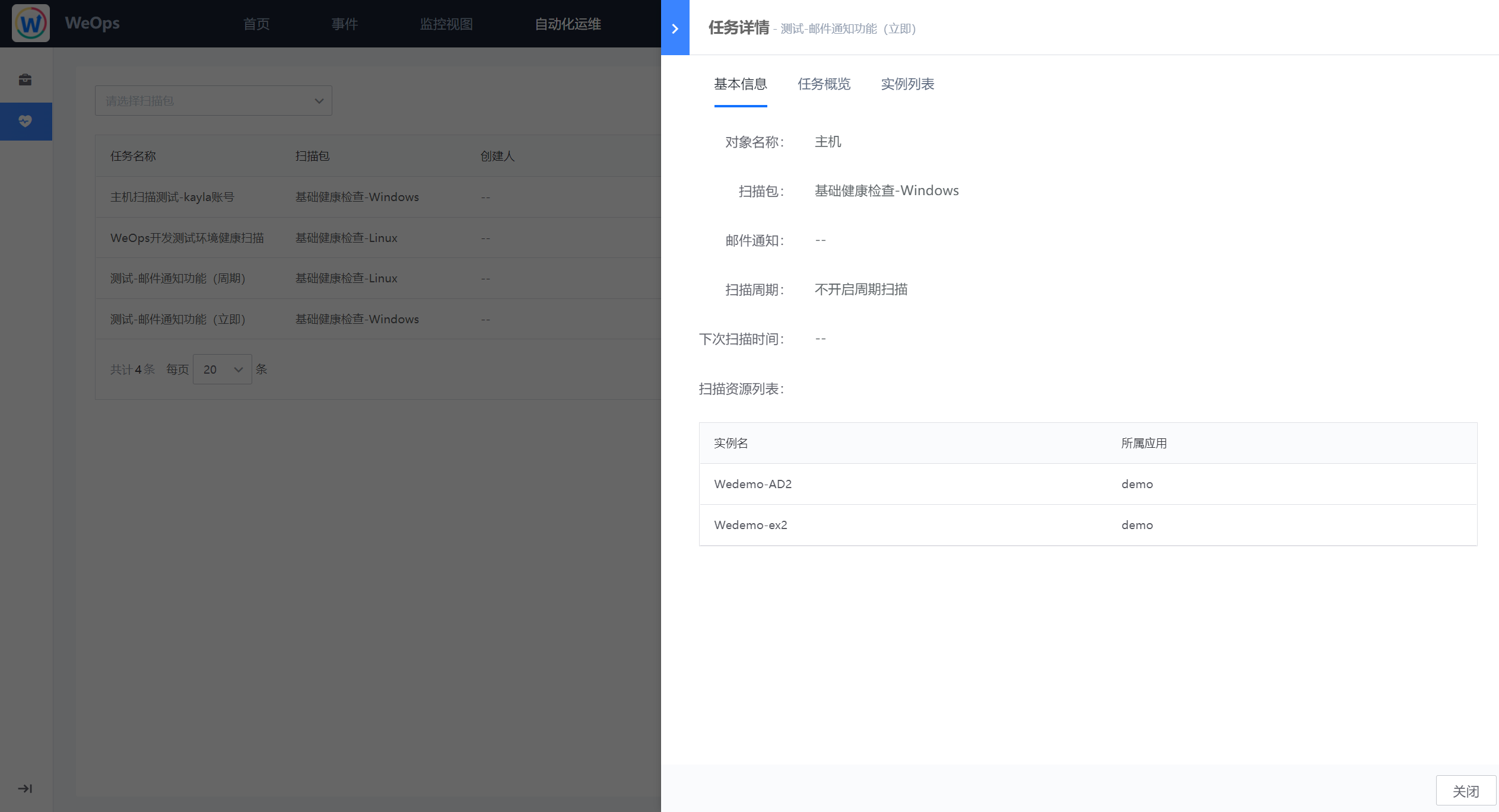

如下图,健康扫描以扫描包为主题,以任务的形式对指定的实例进行专题扫描,下图为健康扫描的任务页面,展示了创建的各个页面的基础信息以及扫描情况。

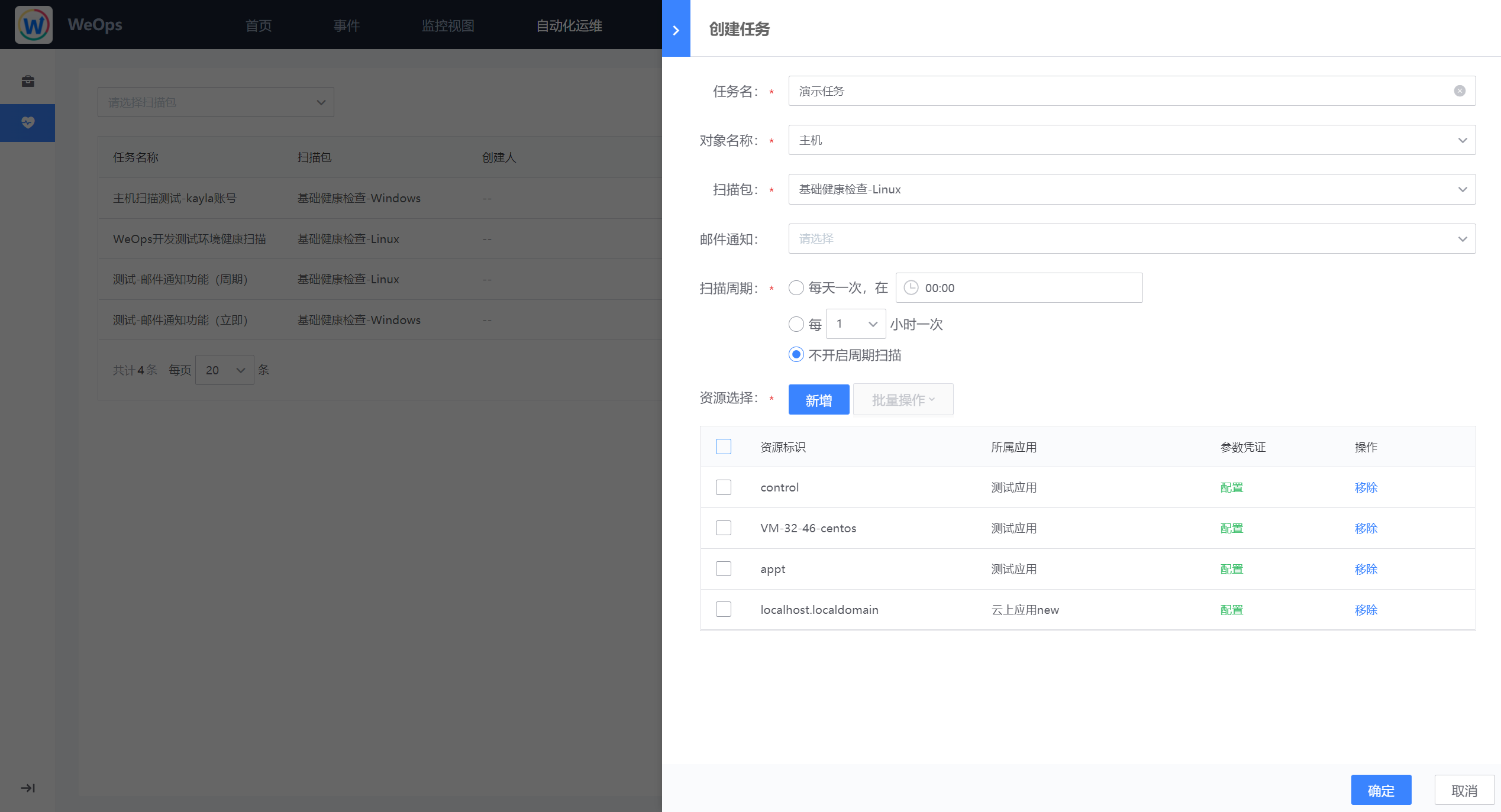

- 任务创建:如下图为任务创建界面,可选择主题的扫描包,以及对应资源,并可以选择扫描周期,也可以选择邮件通知人,选定邮件通知人后将在该任务扫描完成后接收到任务完成情况的邮件。

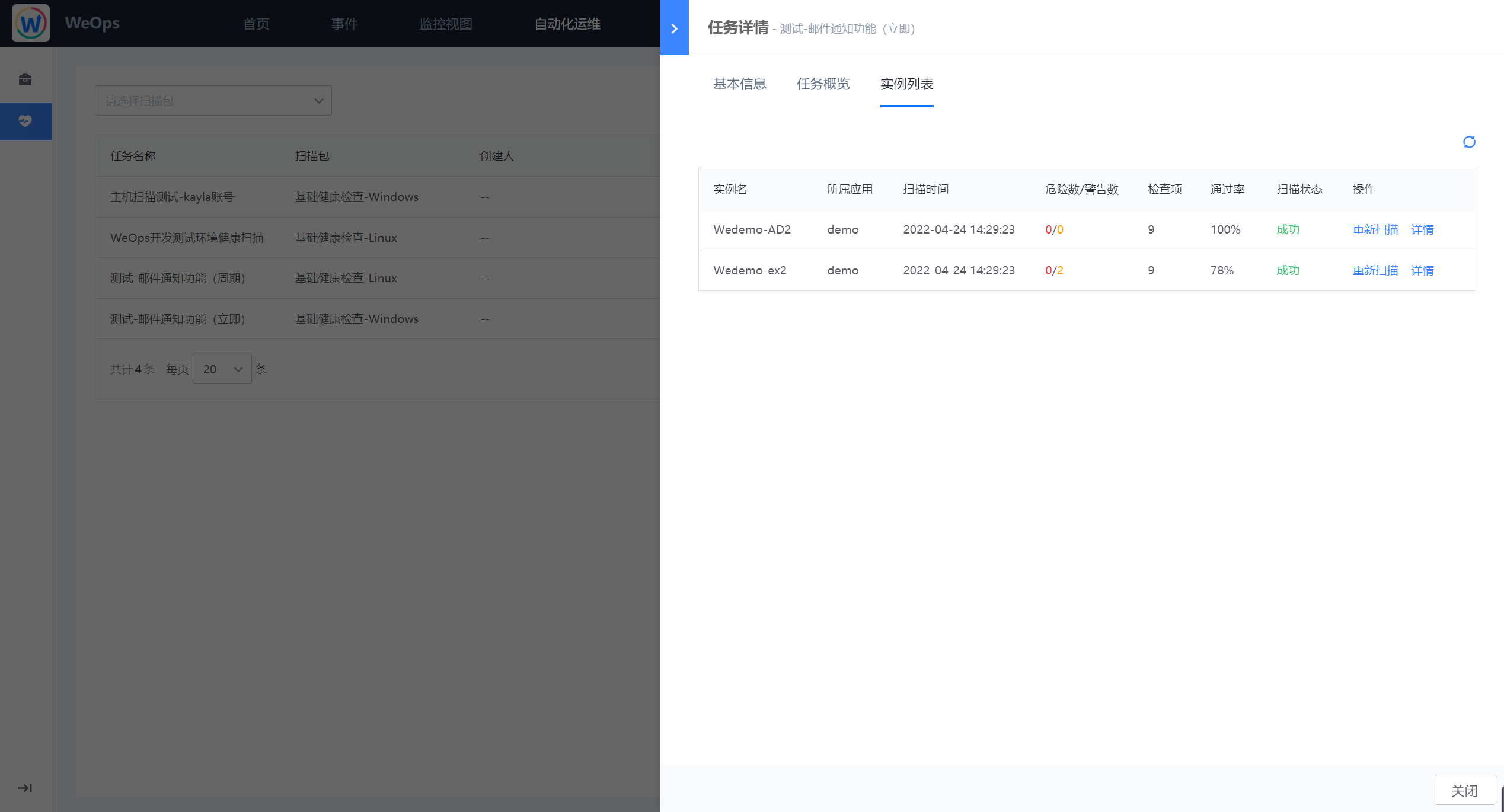

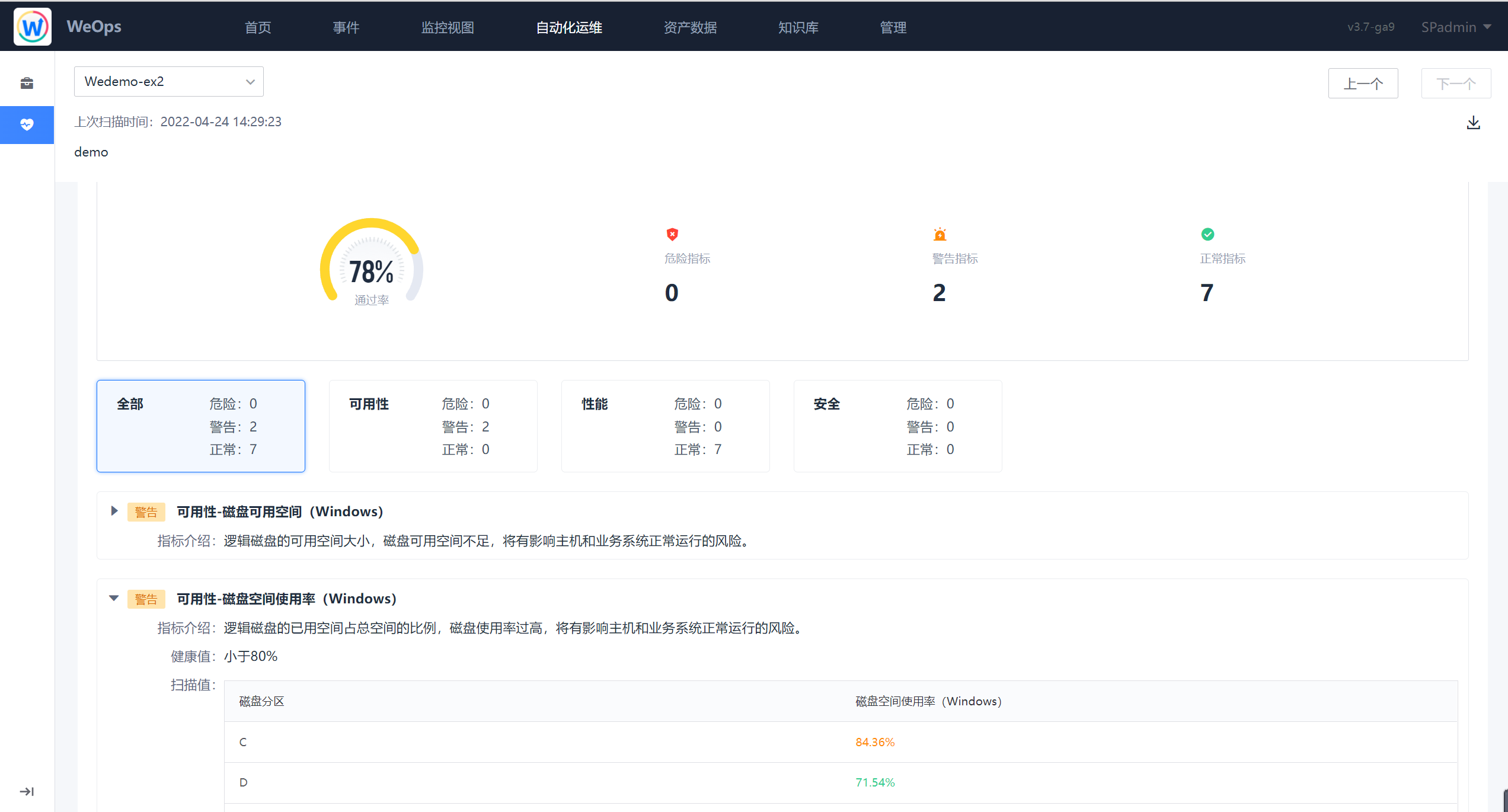

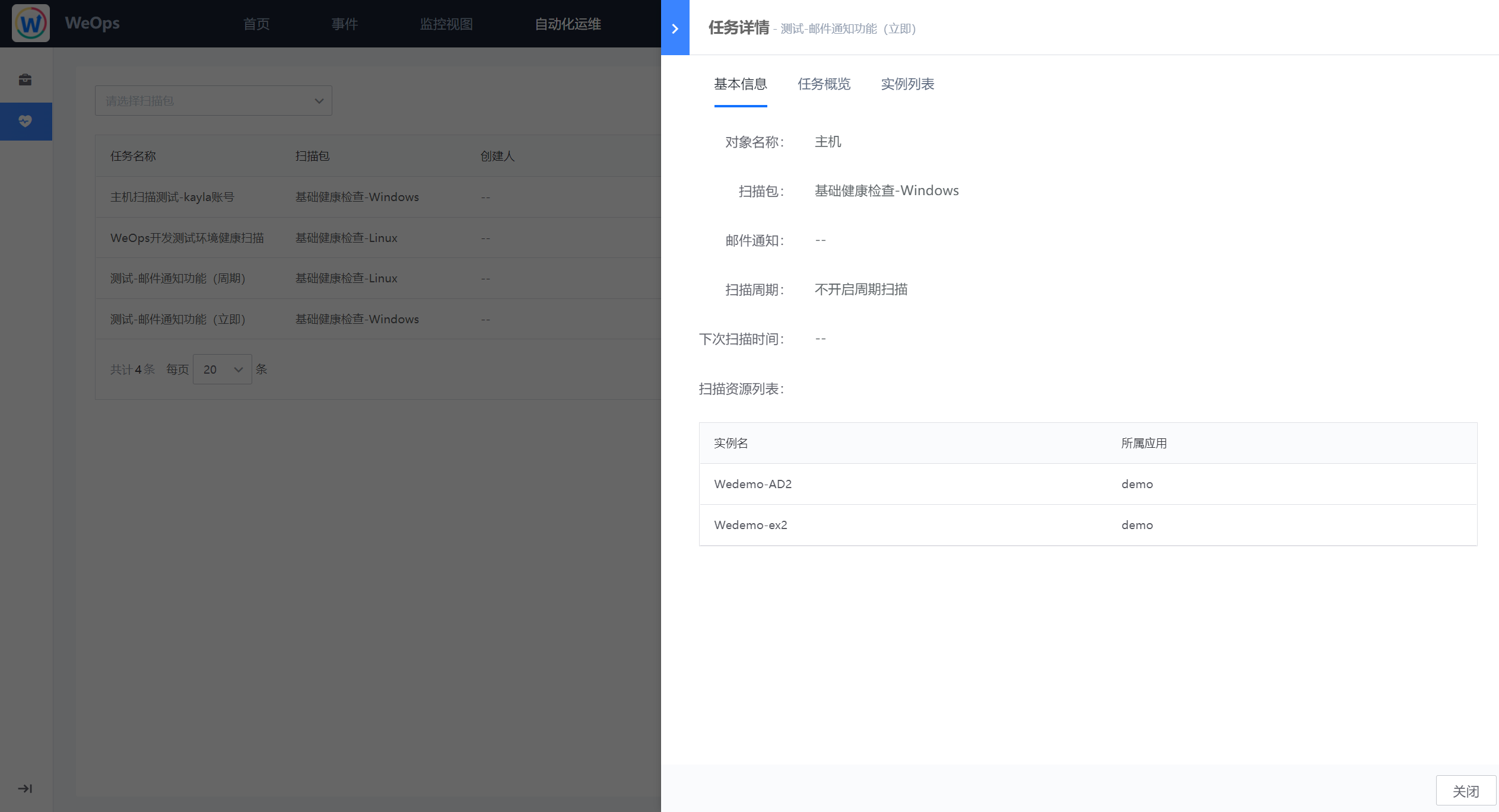

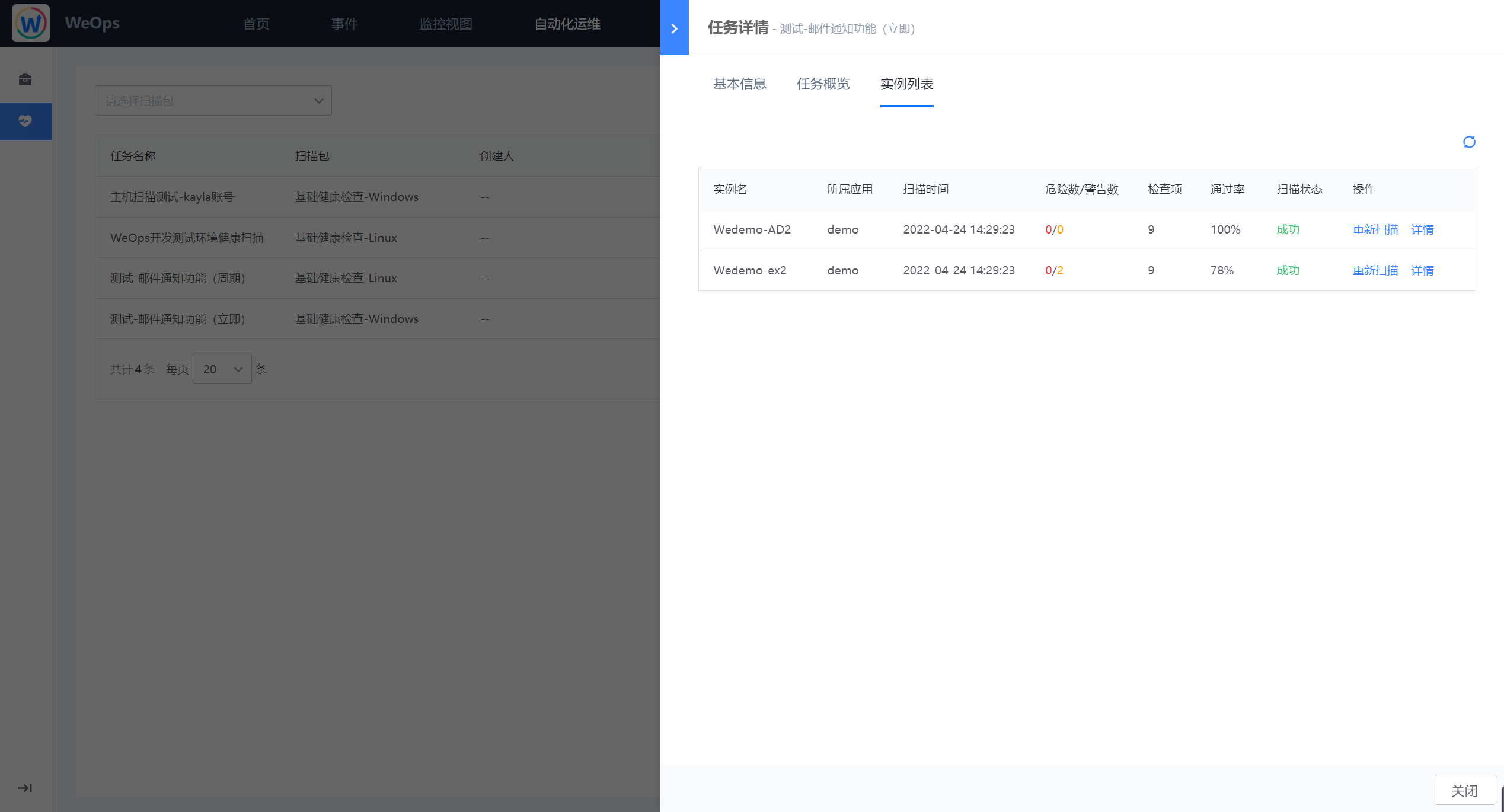

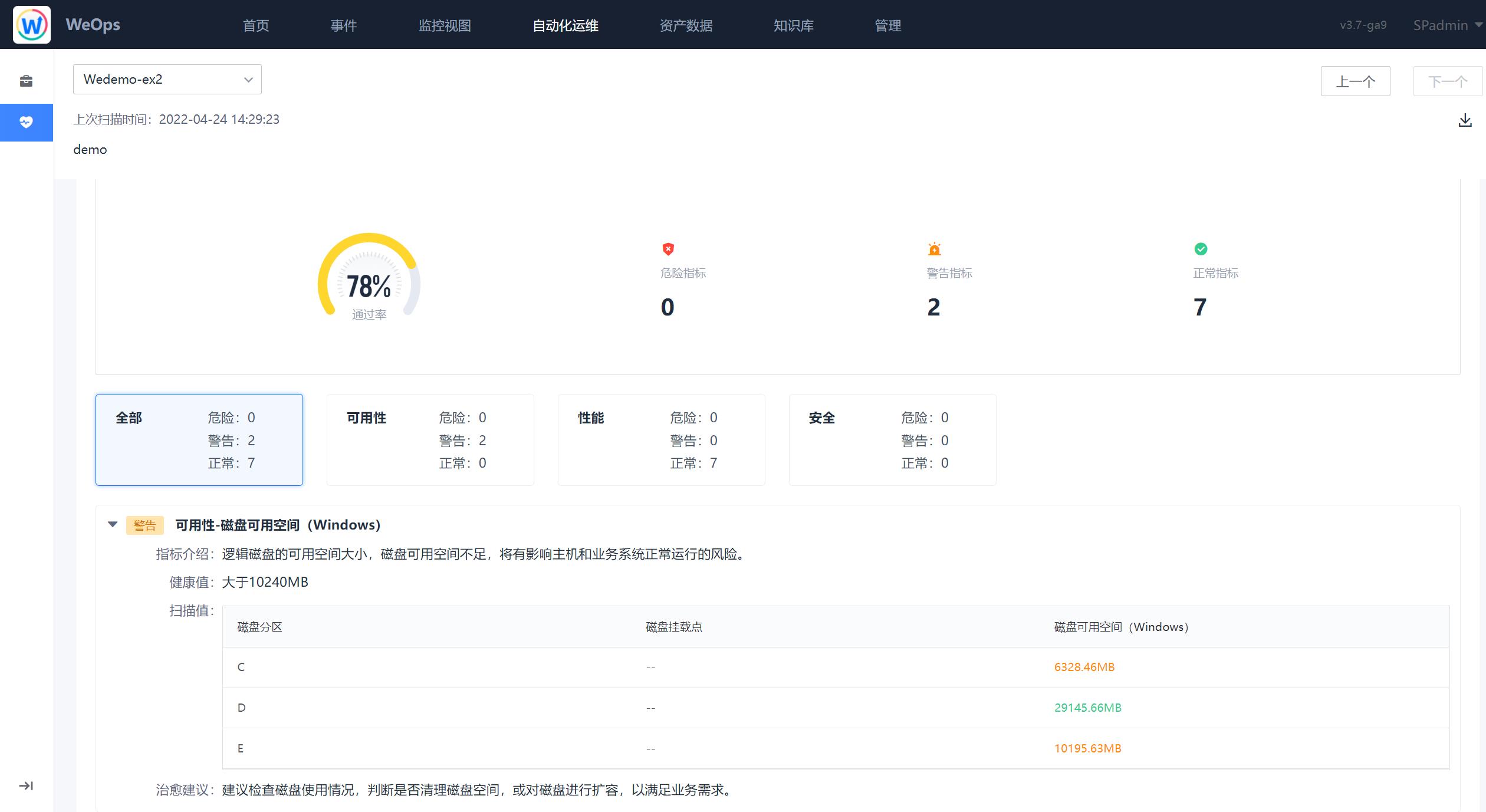

- 任务详情:如下图为任务详情界面,分为基本信息、任务概览、实例列表,基本信息展示该改任务的扫描时间、扫描包信息、扫描对象列表等信息;任务概览展示了该任务整体的健康状态、通过率、资源扫描情况以及警告/危险的指标情况,可以对任务概览进行PDF的导出;实例列表则将该任务下所有的扫描实例的情况进行展示。

- 实例详情:通过任务详情中的概览页/实例列表页可以查看具体实例的扫描报告,针对实例详情可以导出为PDF格式文件。

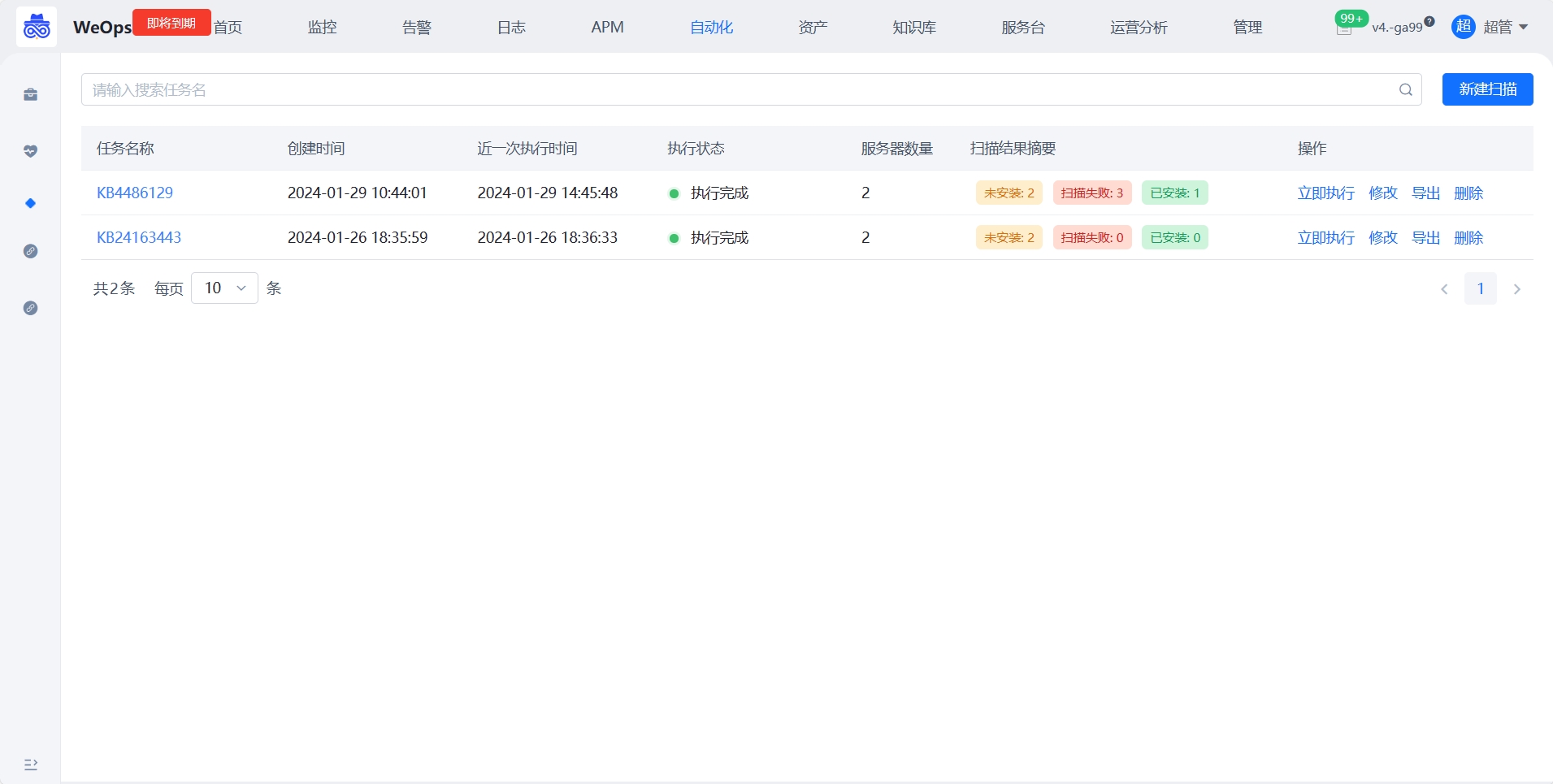

补丁安装

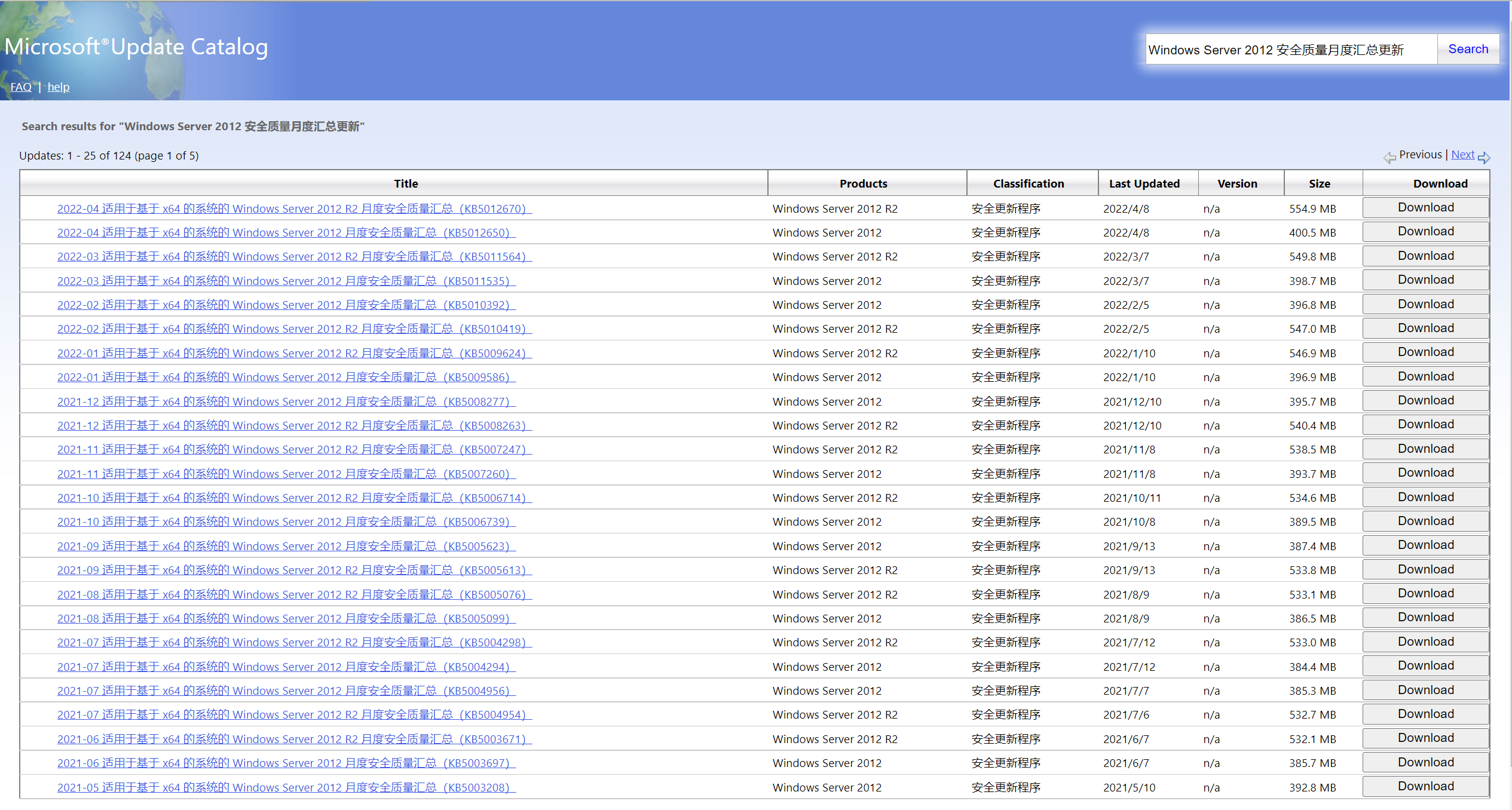

WeOps支持对Windows Server 2008及以上版本进行补丁扫描和安装。

补丁扫描

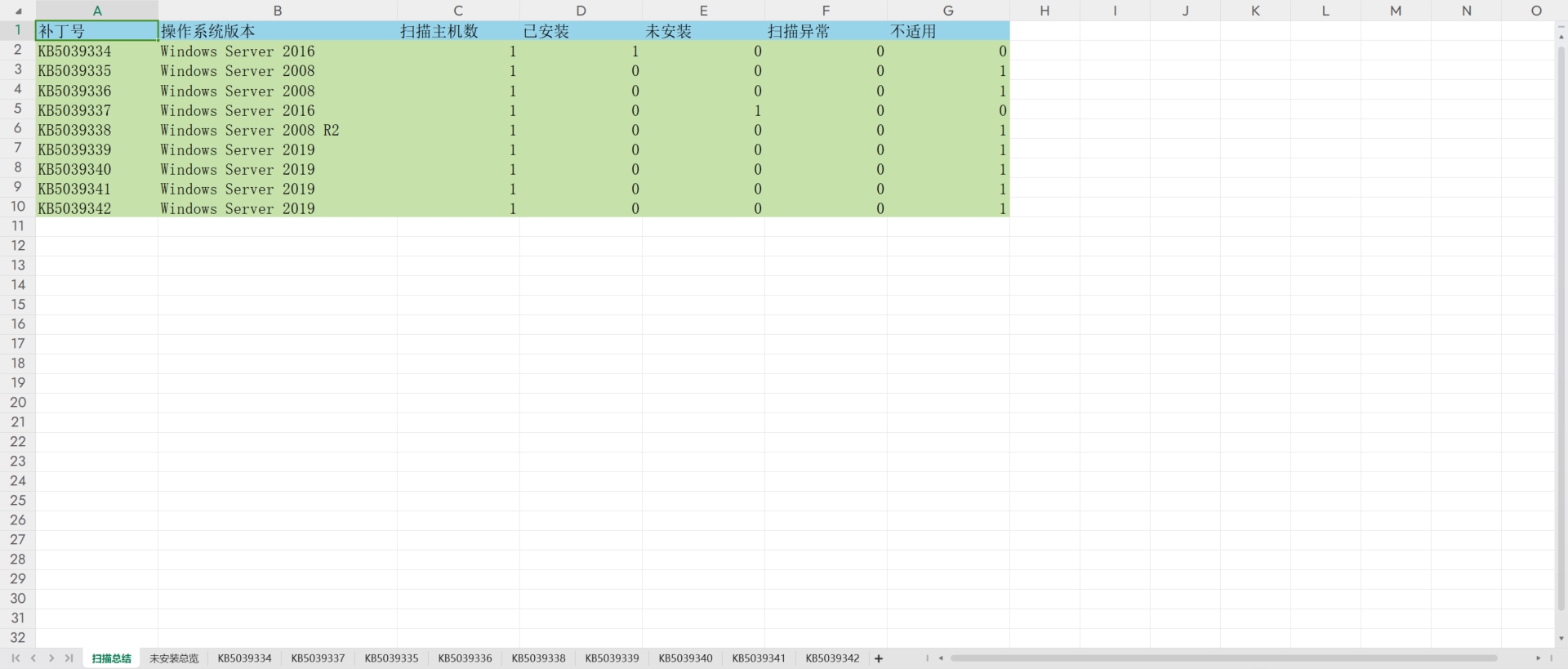

如下图,以任务的形式对服务器进行批量的补丁扫描,支持多补丁多服务器扫描

如下图,新建任务创建,目前支持Windows补丁扫描,需要添加补丁号(支持多个),选择服务器列表(支持多选),可以采用表格导入的方式进行补丁号的添加, 支持设置通知方式和通知人。

扫描结果如下:以补丁号为ta,分别展示所有服务器该补丁的安装情况(已安装/未安装/版本号不适用)

结果支持导出为表格

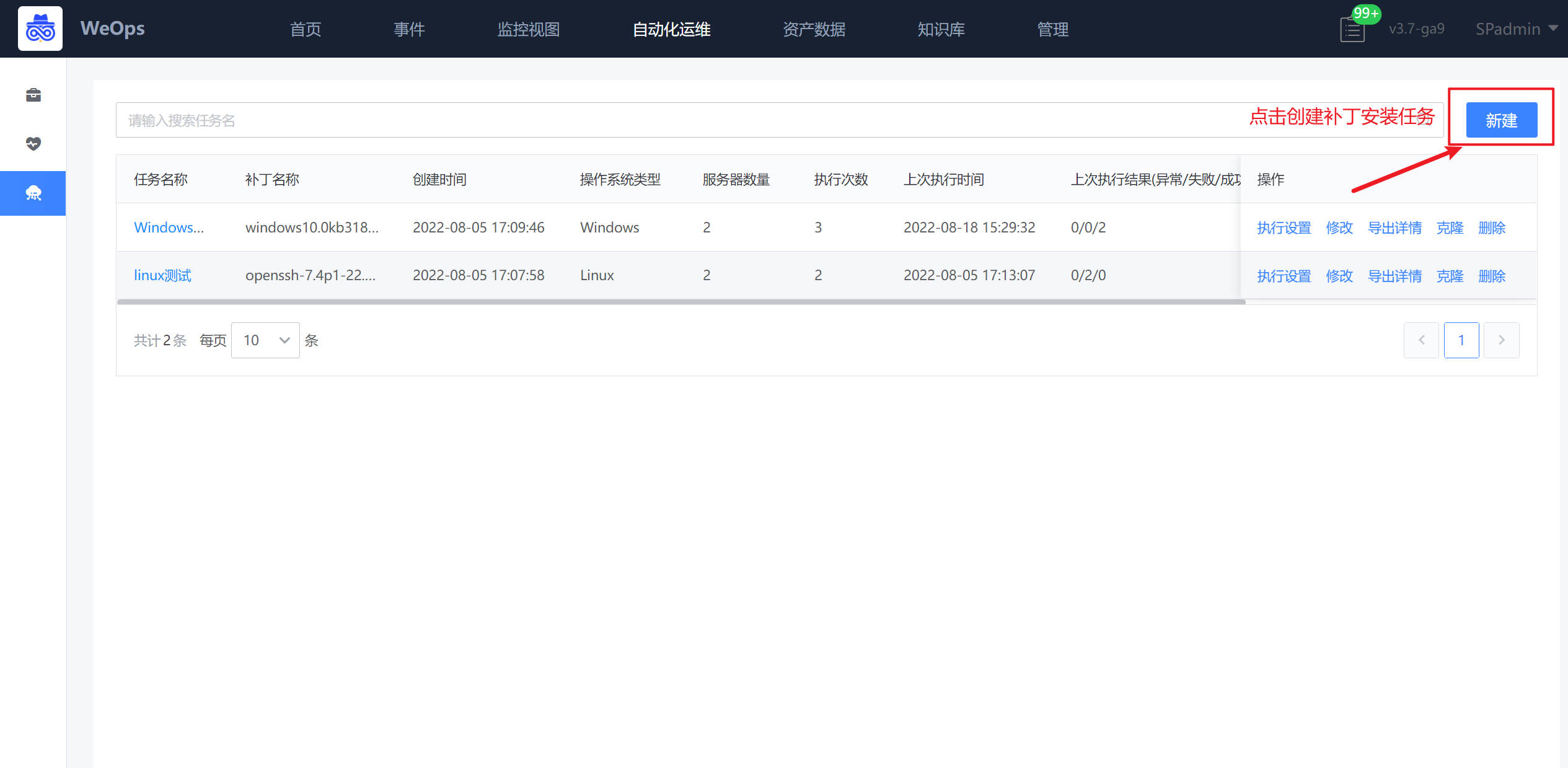

批量安装

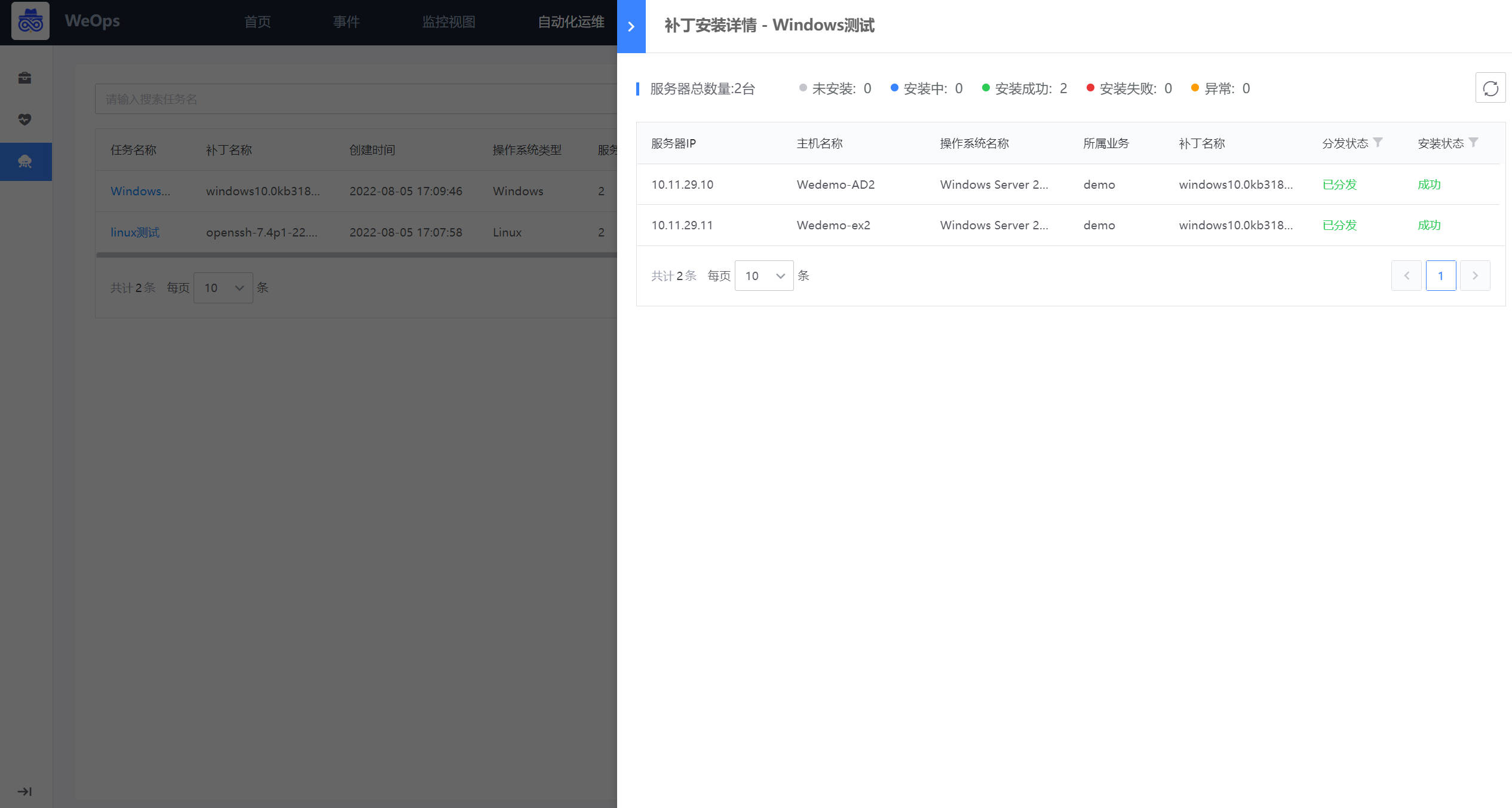

如下图,以任务的形式进行服务器的批量安装,与传统方式相比,节省时间、安装成功率高,同时支持Windows和linux两类操作系统。

任务创建:如下图,点击“新建”按钮,即可进行补丁任务的创建,需要填写任务名称、选择服务器、上传/选择补丁文件、设置通知人。

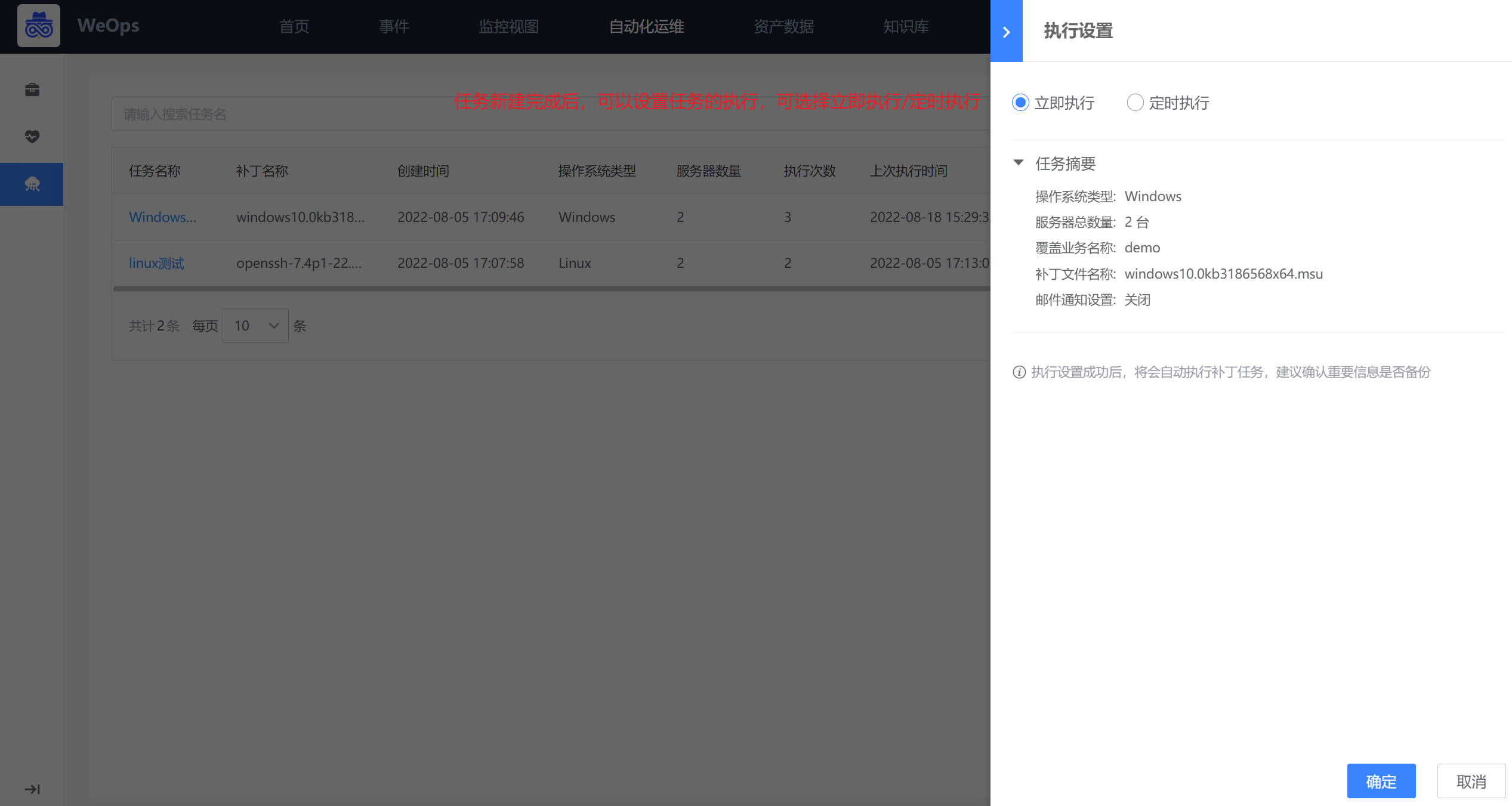

任务执行:点击“执行设置”可以进行执行相关设置,支持立即执行/定时执行。

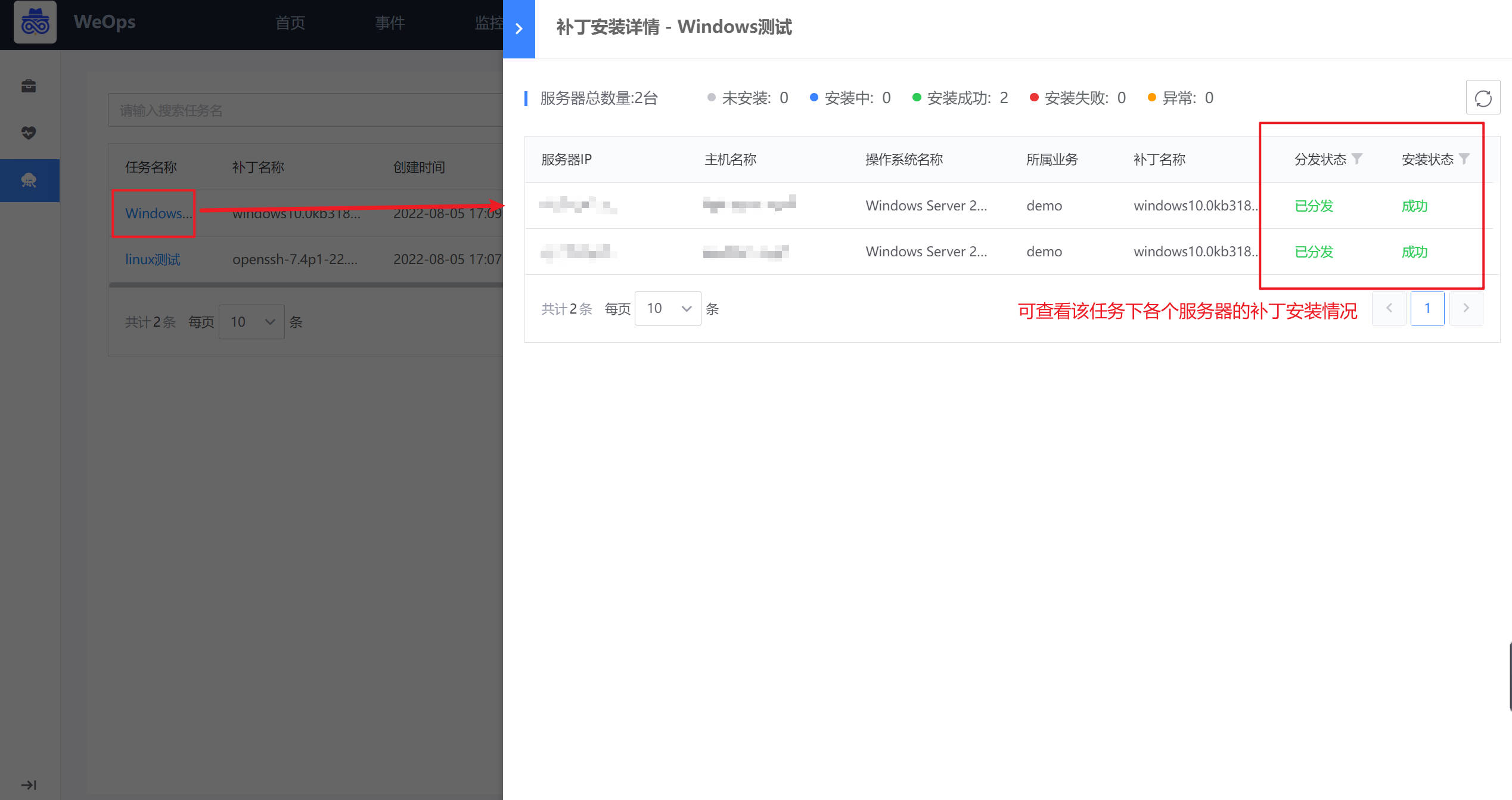

任务详情:任务执行中/执行结束,可以点击任务名称查看任务执行情况,可以点击“导出详情”按钮,进行任务执行结果的导出。

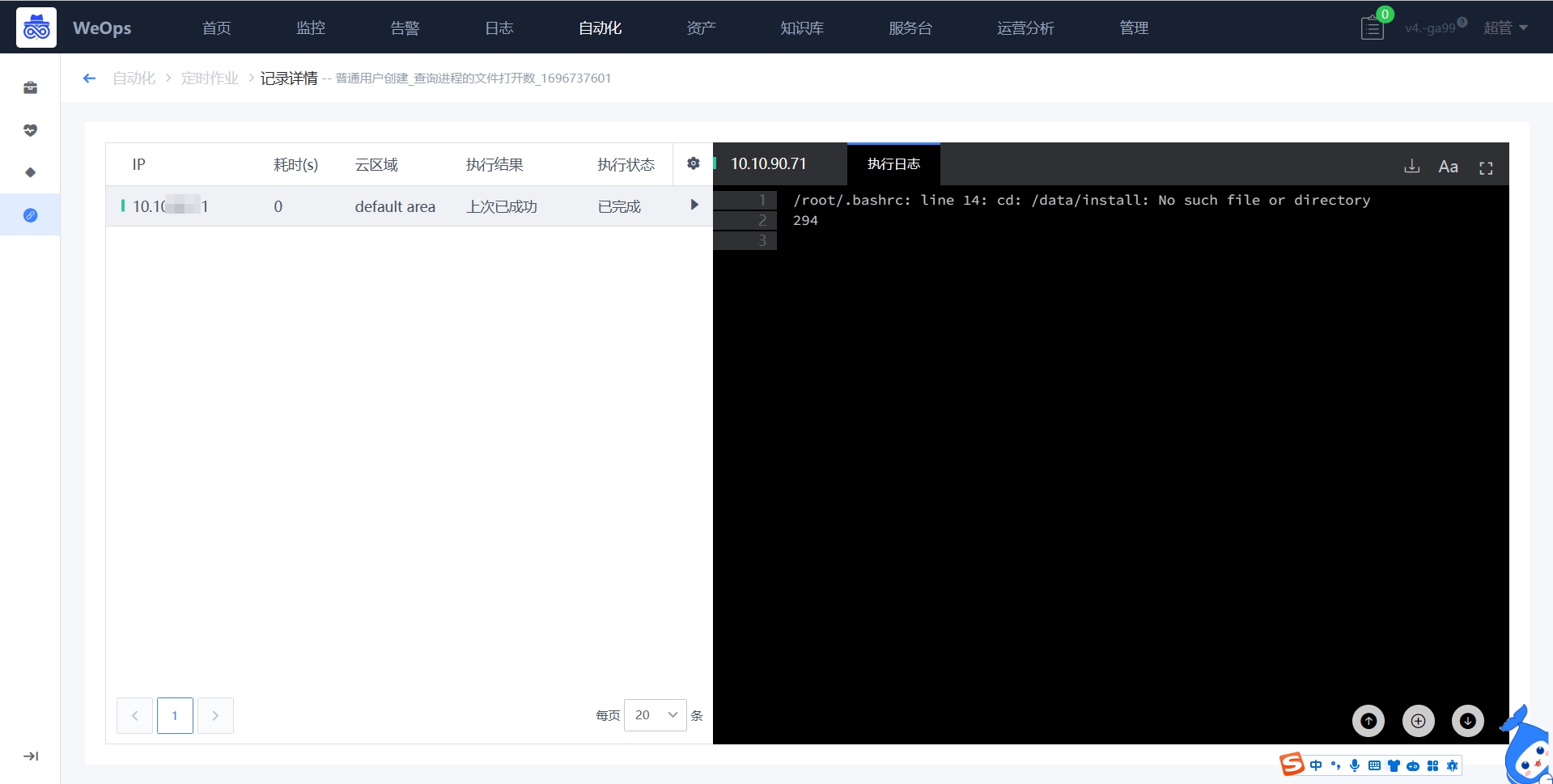

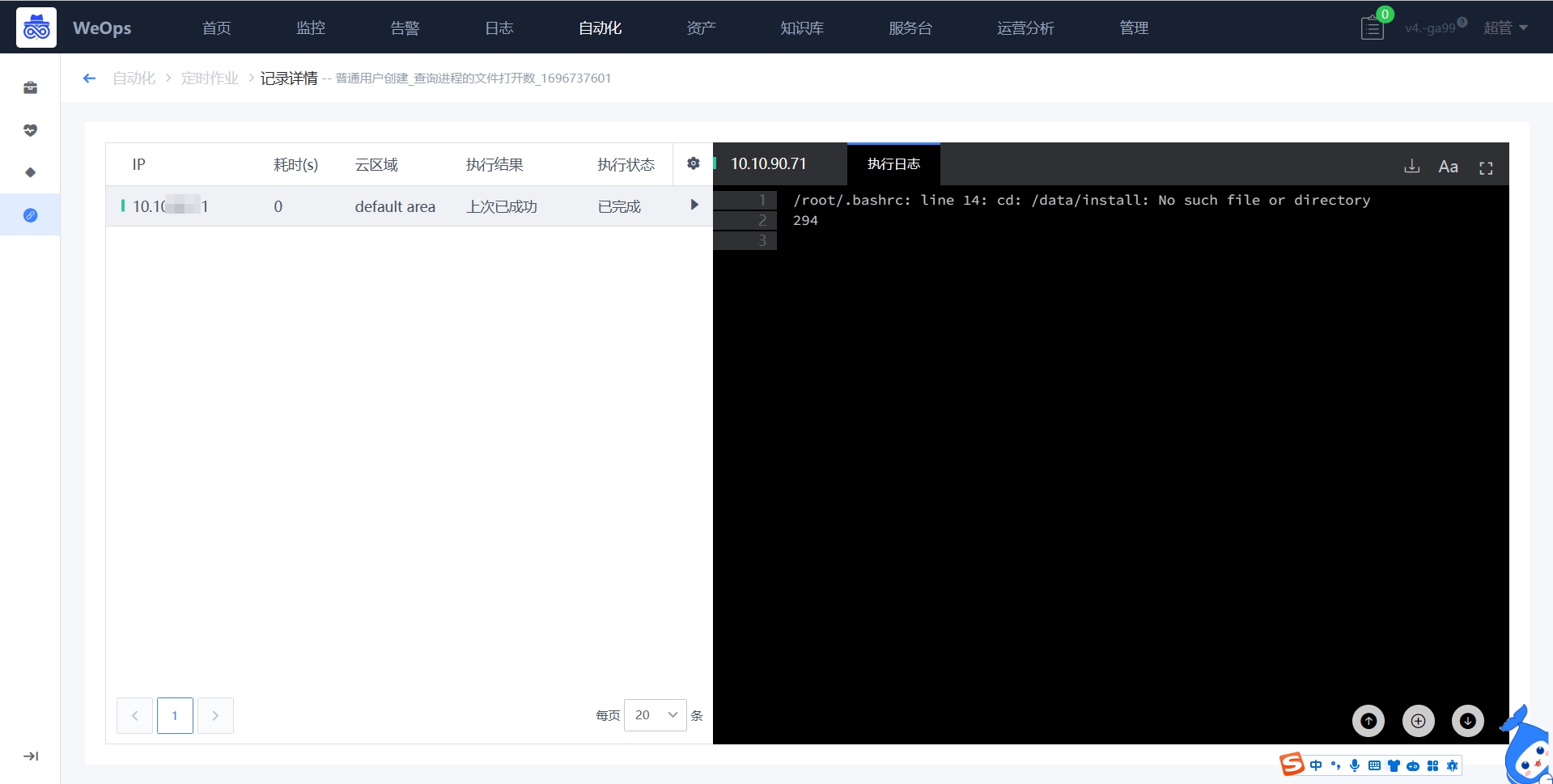

定时作业

- 如下图,以作业的形式进行脚本的定时执行,并展示每一次的执行结果。

- 新建作业:如下图,支持选择对应工具和资产,并且设置执行策略,其中定时作业支持无agent模式,即主机无需安装agent也可执行对应脚本,设置任务时需要填写对应凭据。

执行策略:定时执行-选择特定的时间只执行一次;周期执行-设置循环执行的周期,按照周期进行执行

工具类型:支持基础架构和网络设备两类设备的脚本执行

工具名称:与运维工具结合,可以选择现成的运维工具,进行定时作业

资源选择:支持跨业务选择多个资源,批量执行,支持无agent模式周期执行的时间语法采用crontab语法,具体说明如下

`数字`:固定的时间点,比如9点,周一

`*/数字`:"每隔",比如每隔2天,每隔15分钟

时间规范通常包含分钟、小时、天、月以及星期等信息,例如分钟可以是0-59的任意一个数字,小时可以是0-23,日可以是1-31,月(1-12),周(0-6)(星期天为0或者7)

比如:每隔2小时执行一次(0 */2 * * * ),每日凌晨1点执行一次(0 1 * * *),每周日凌晨1点执行一次(0 1 * * 0)- 查看执行记录:作业每次执行结束后,会记录该次的执行情况,点击执行记录,可以查看具体的执行返回情况。

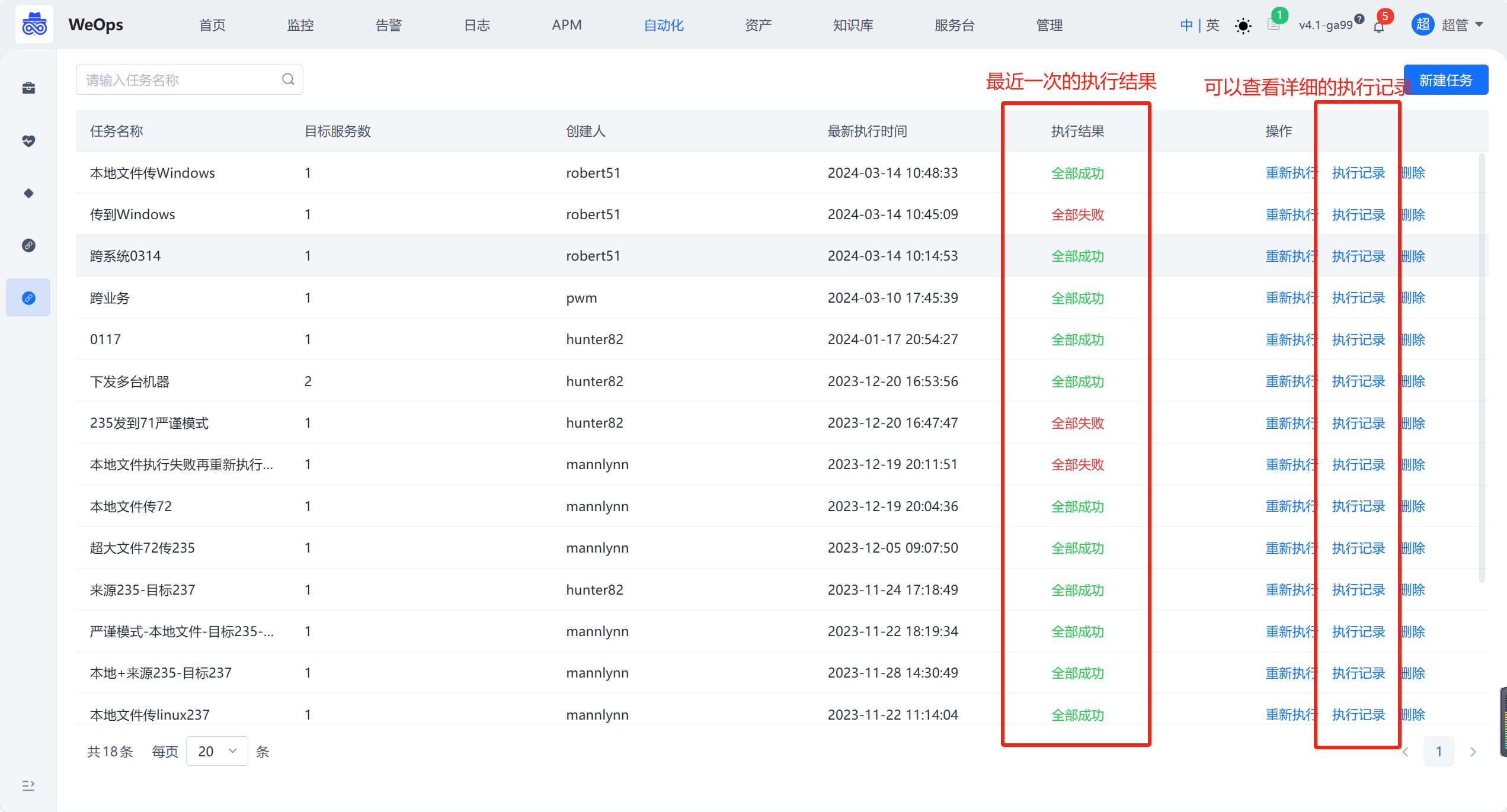

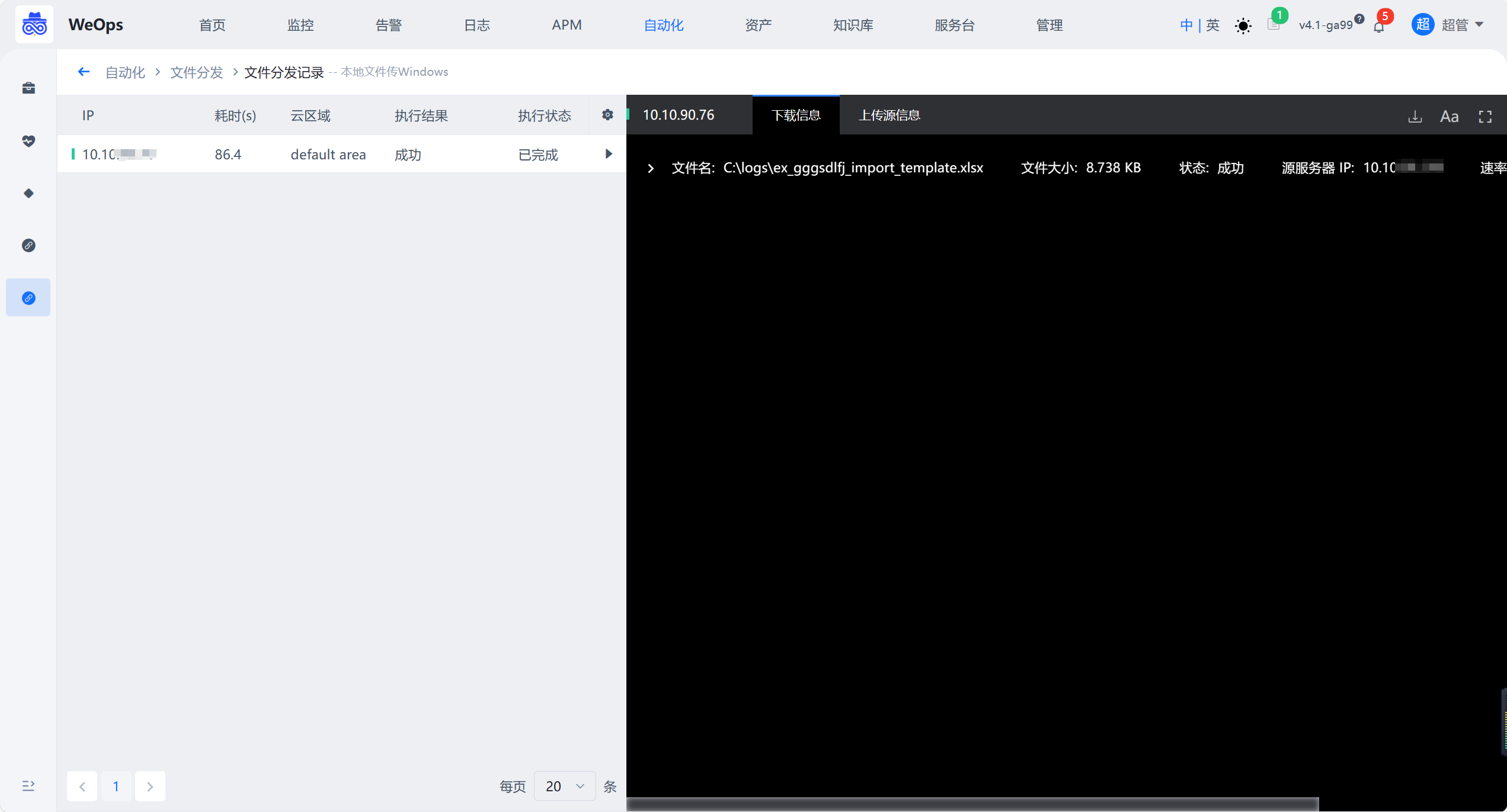

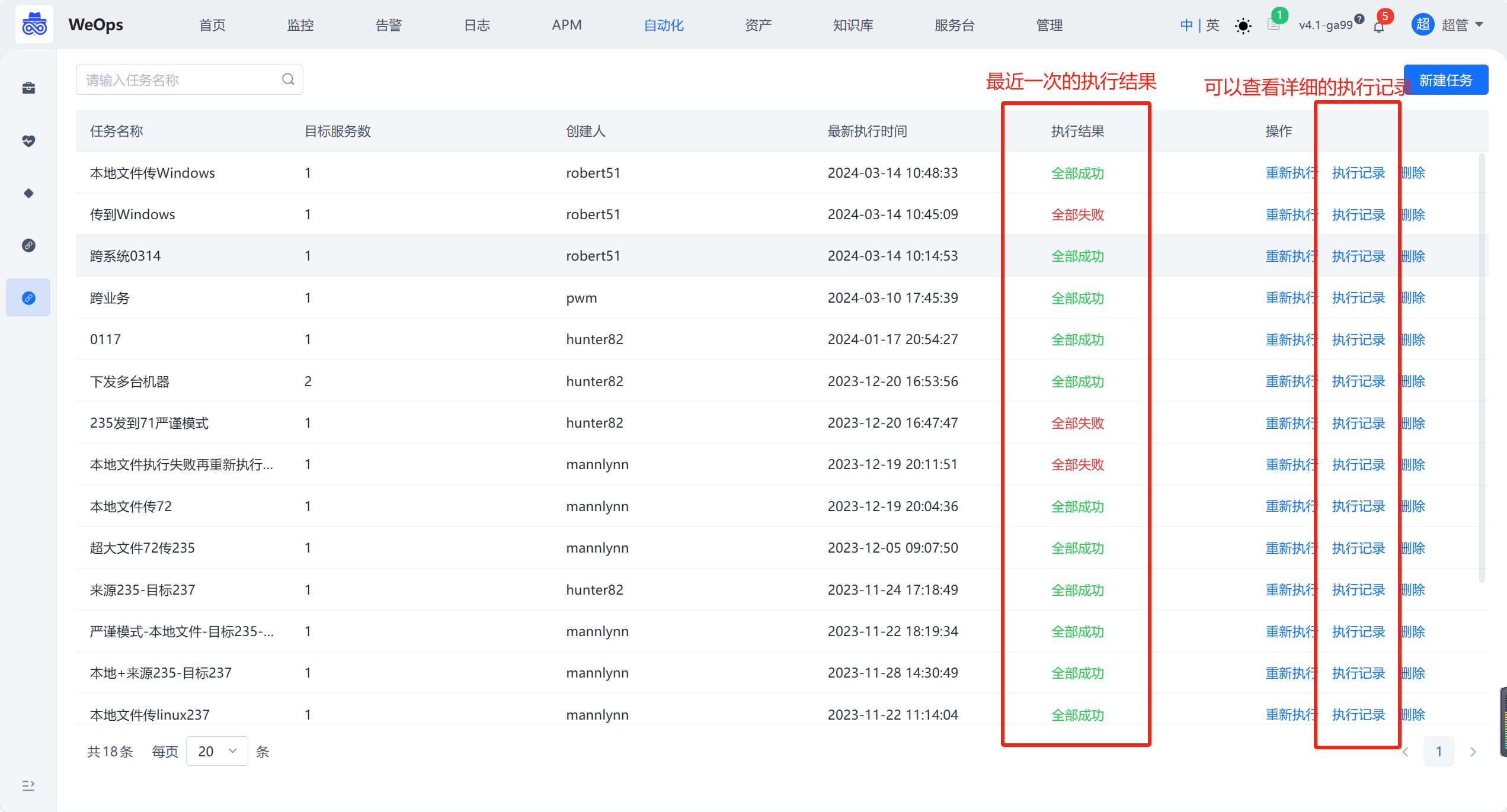

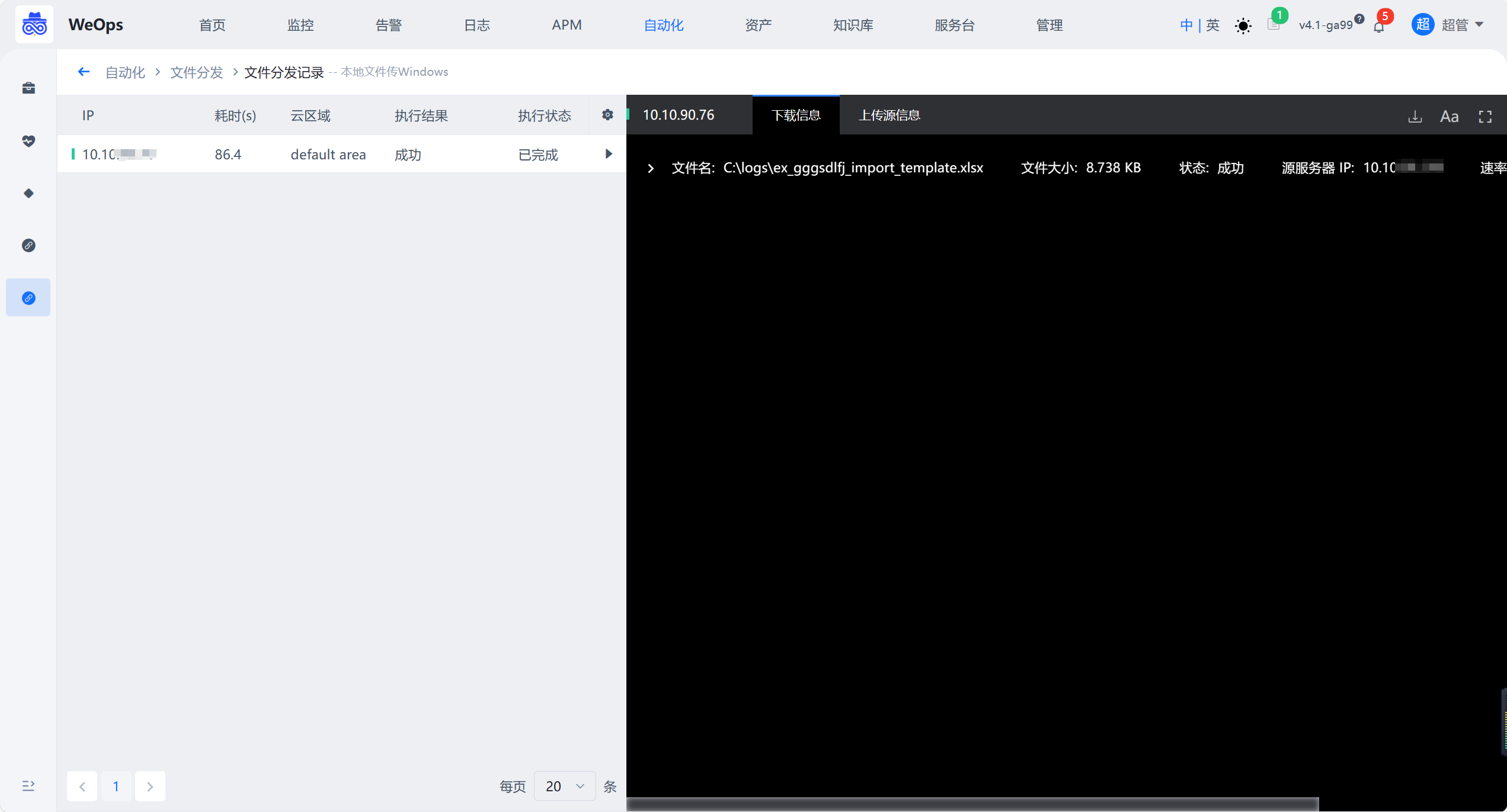

文件分发

如下图,需要进行一次性传输文件的用户,可以在这里快速的执行任务并进行执行。

填写内容如下

【基本信息】

任务名称:分发文件的任务名,方便后续在执行历史中有迹可循

超时时长:分发文件的超时设置,当文件传输时间超过时将会自动关闭,结果被视为 "执行超时"

上传 / 下载限速:由于蓝鲸管控平台 Agent 默认的配置是会根据服务器带宽和资源使用情况进行限制的,防止出现因为执行的任务导致拖垮业务的机器;所以当用户自己确认机器允许更大限度传输时,通过开启限速设置可以提高传输的速率

【源文件】

分发的源文件选择,支持选择 本地文件 或 其他服务器文件

【传输目录】

目标路径:文件分发到目标服务器的绝对路径地址

传输模式:强制模式不论目标路径是否存在,都将强制按照用户指定的目标路径进行传输(不存在会自动创建);严谨模式严谨判断目标路径是否存在,若不存在将直接终止任务

执行账号:文件分发的目标服务器相关的账号,如 Linux 系统的 root 或者 Windows 系统的 Administrator

目标服务器:从资产管理获取执行的目标服务器任务创建完后,执行点击“确定”,即可立即执行文件批量分发任务。

文件分发任务执行完成后,可以在列表中查看最新一次的执行结果,也可以在“执行历史”中查看执行的详细结果。

服务台

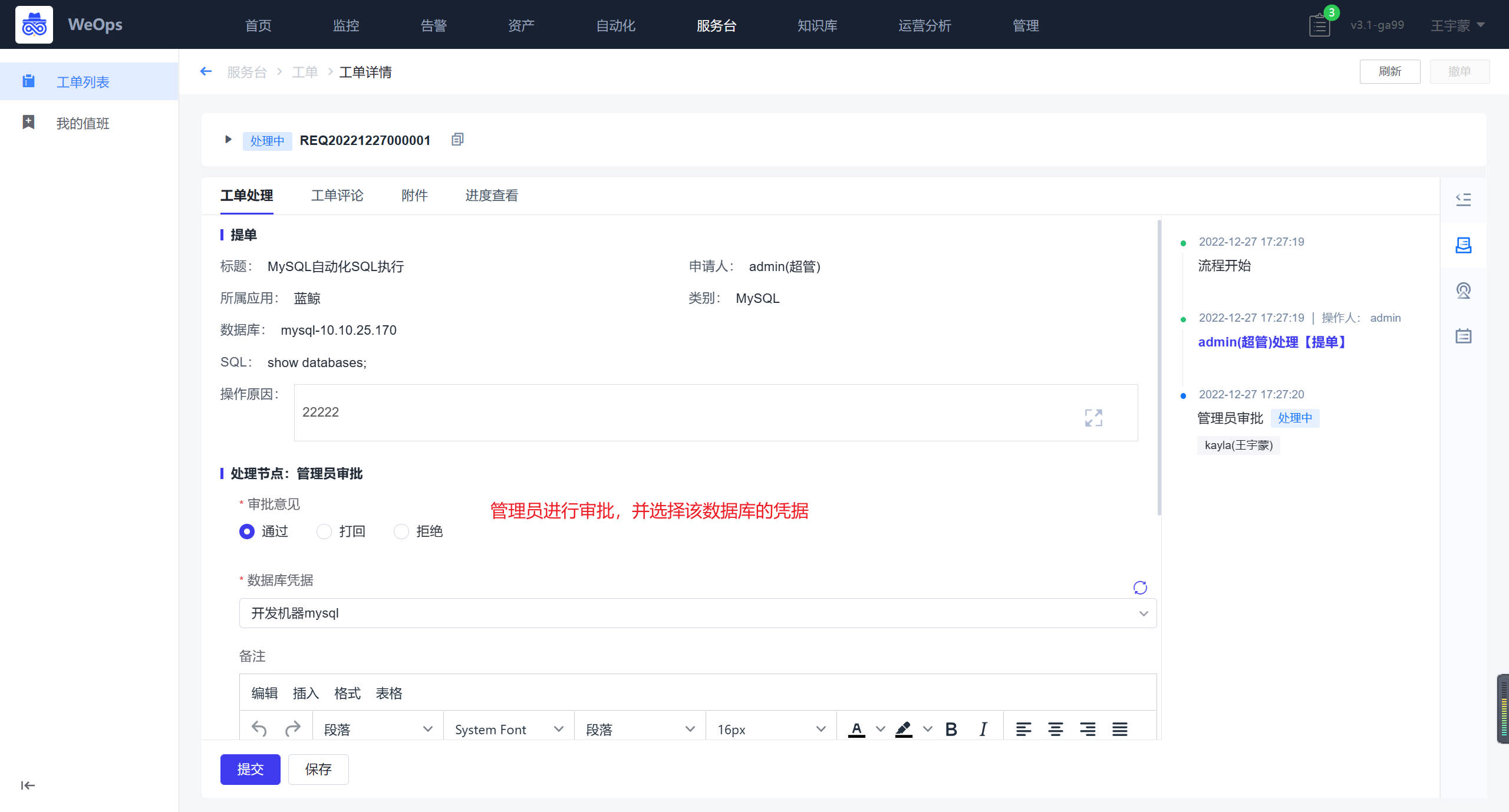

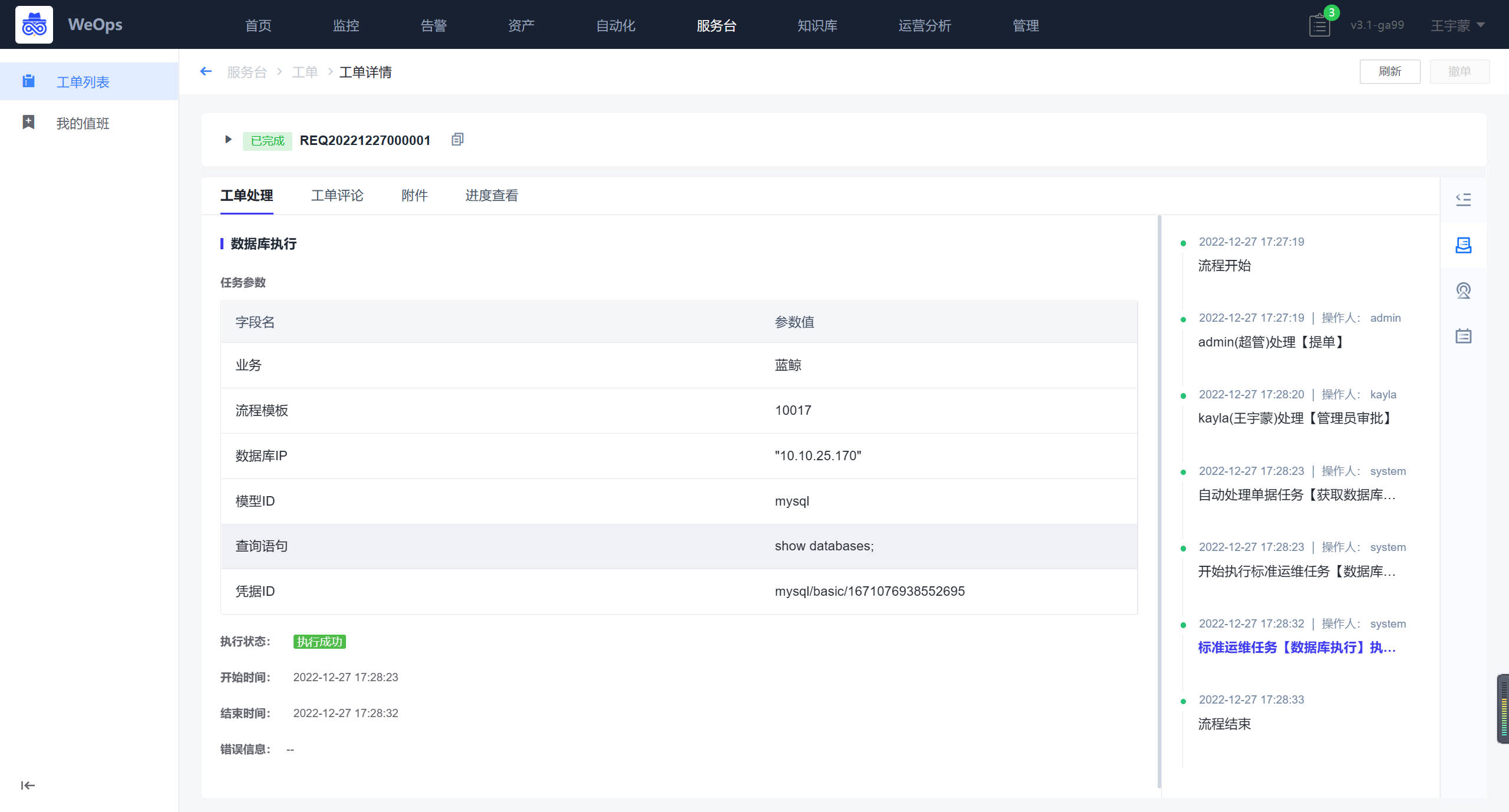

工单列表

如下图,“WeOps-服务台-工单列表”用于展示“我的待办”“所有待办”和“历史工单”的列表信息,可以直接在列表查看工单的提单信息和步骤信息,可进行工单的处理。

- 我的待办:展示所有需要“我”处理的工单列表,点击查看工单详情可以进行工单的处理

- 所有待办:展示所有未完成的工单列表,点击可以查看工单详情

- 历史工单:展示所有已经完成的工单列表,点击可以查看工单详情

- 我的待办/所有待办/历史工单均支持工单导出

点击可查看每个工单的详情,工单详情包括:工单内容(展示提单各个字段内容)、审批部分(对应审批人审批)和工单流转记录,其他展示区(可进行满意度评价,支持查看SLA等详情),此外可对该工单进行撤单,关闭、催办、挂起等操作。

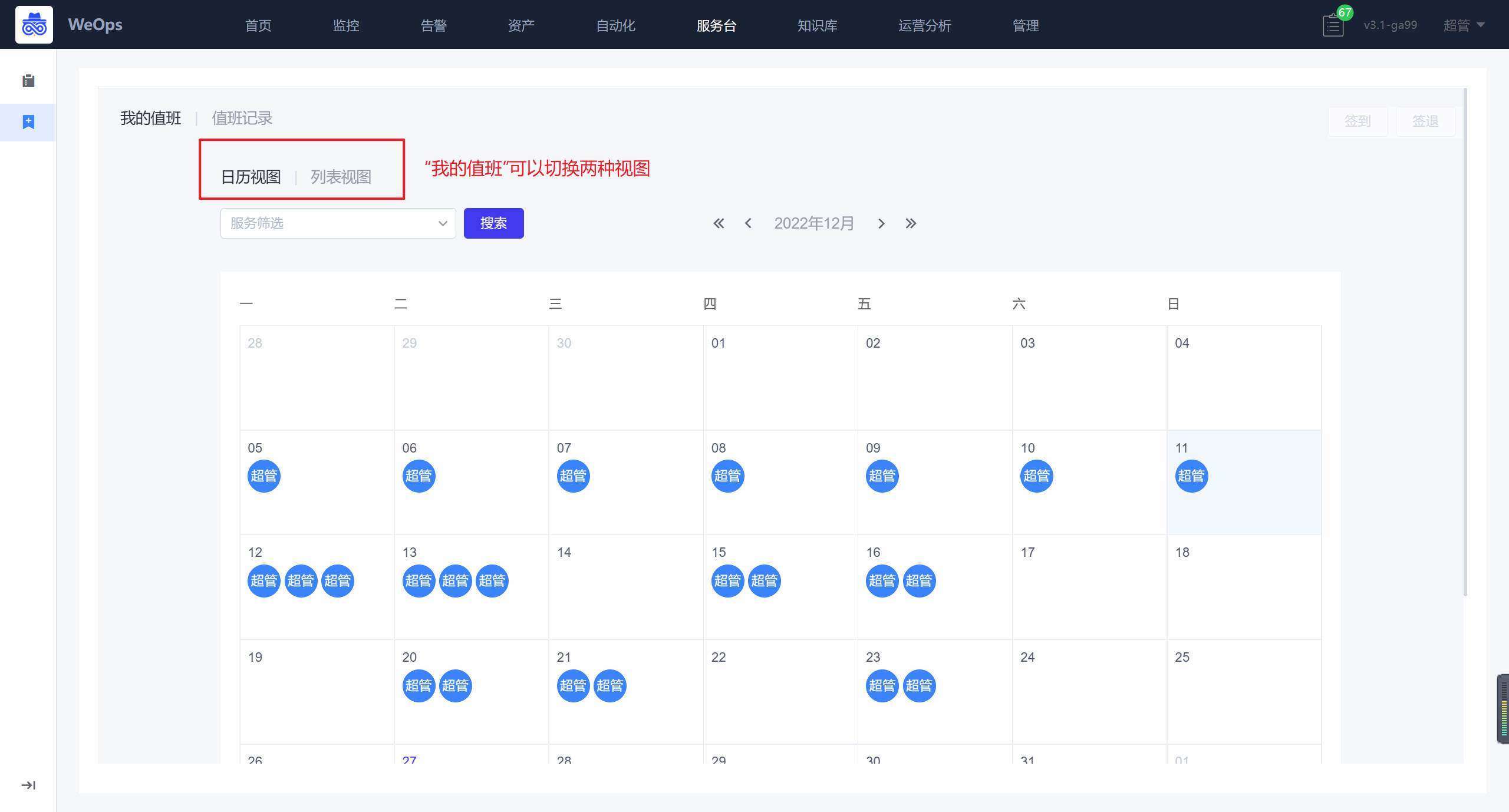

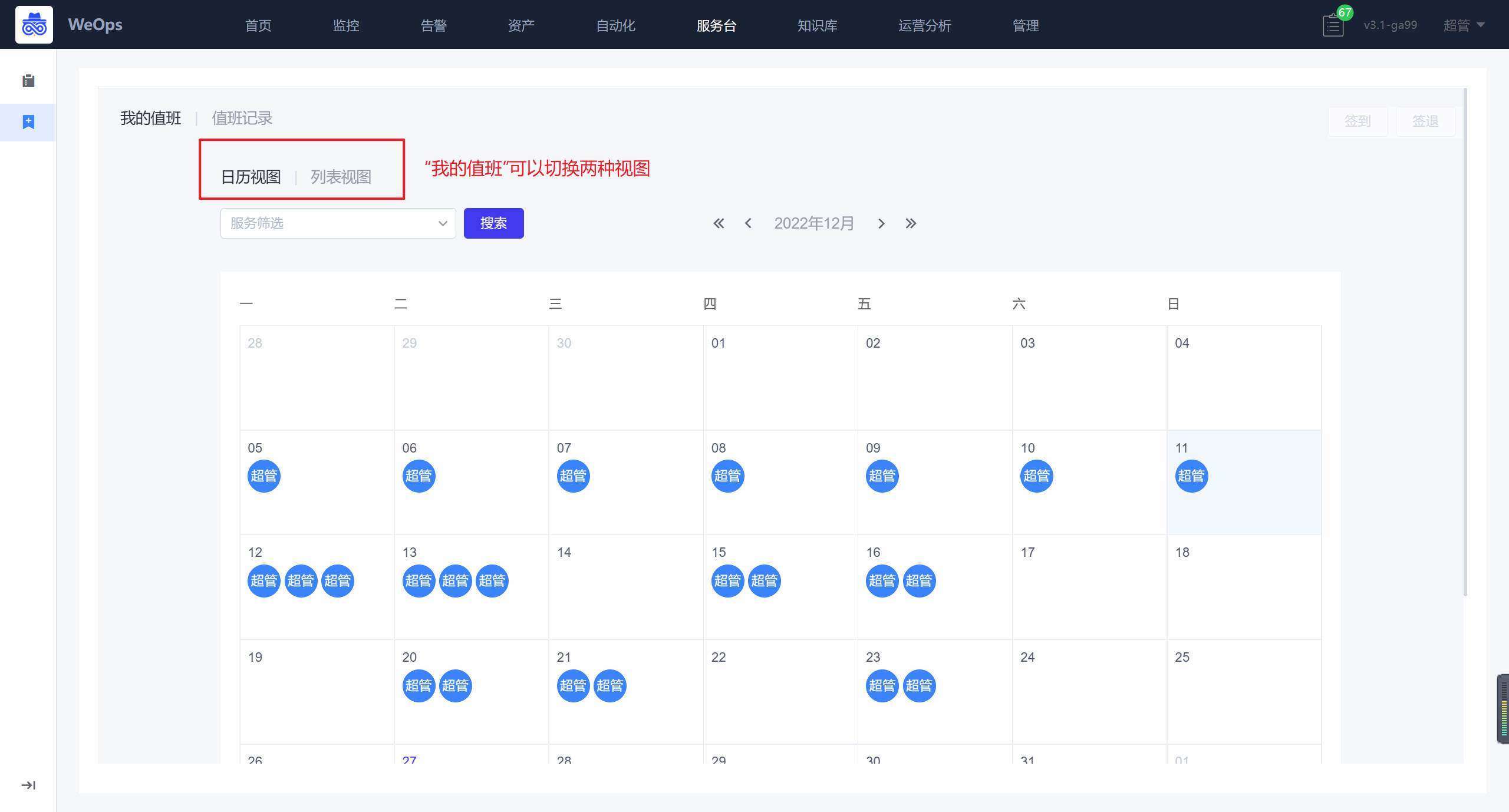

我的值班

如下图,“WeOps-服务台-我的值班”用于展示我的值班安排和值班记录。

- 我的值班:支持切换“日历视图”和“列表视图”两种视图,根据排班情况展示我的值班情况,可进行签到、签退、工作交接。

- 值班记录:可查询以往值班记录/未来值班安排,可查看详细的值班和交接日志。

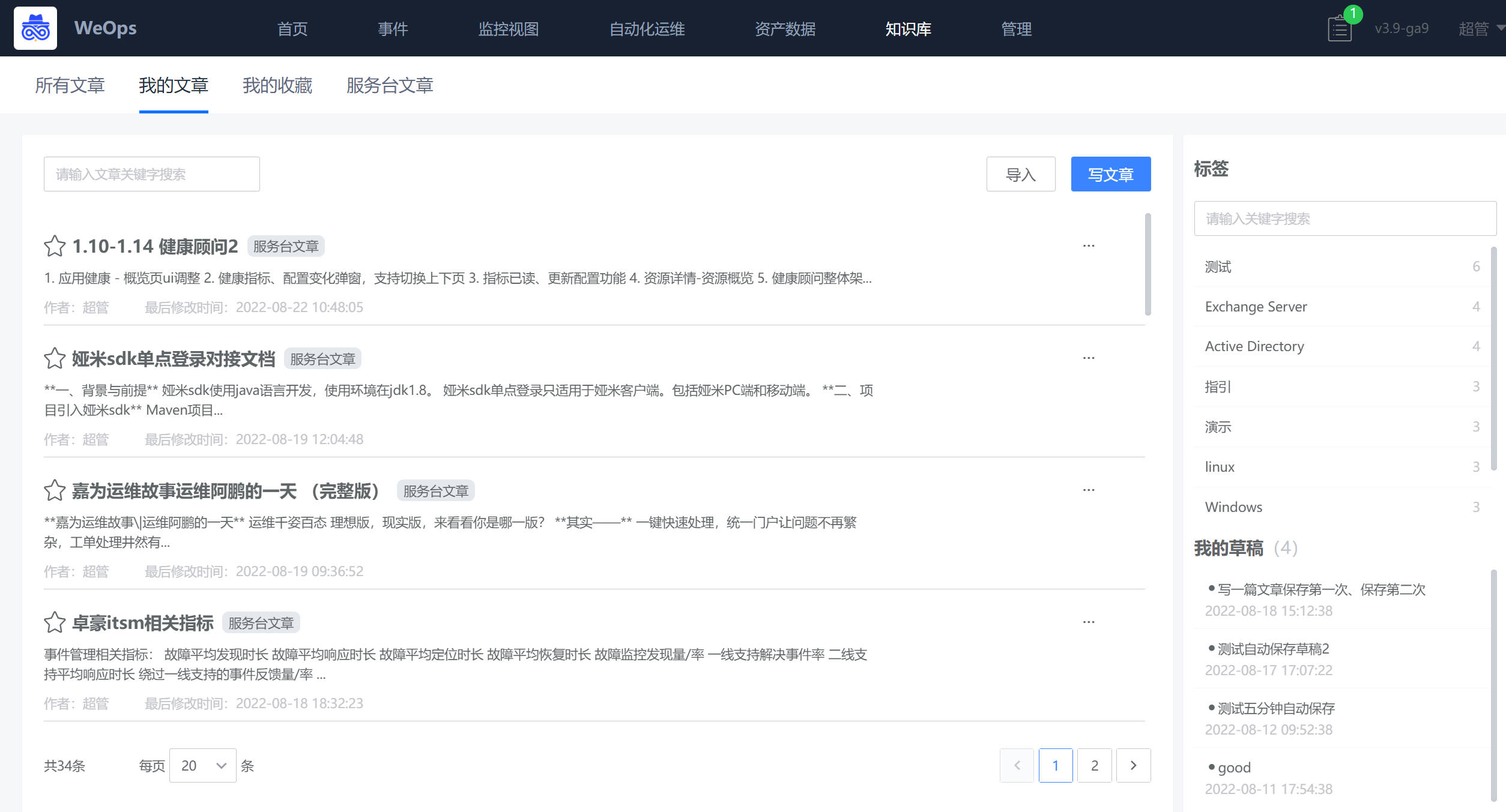

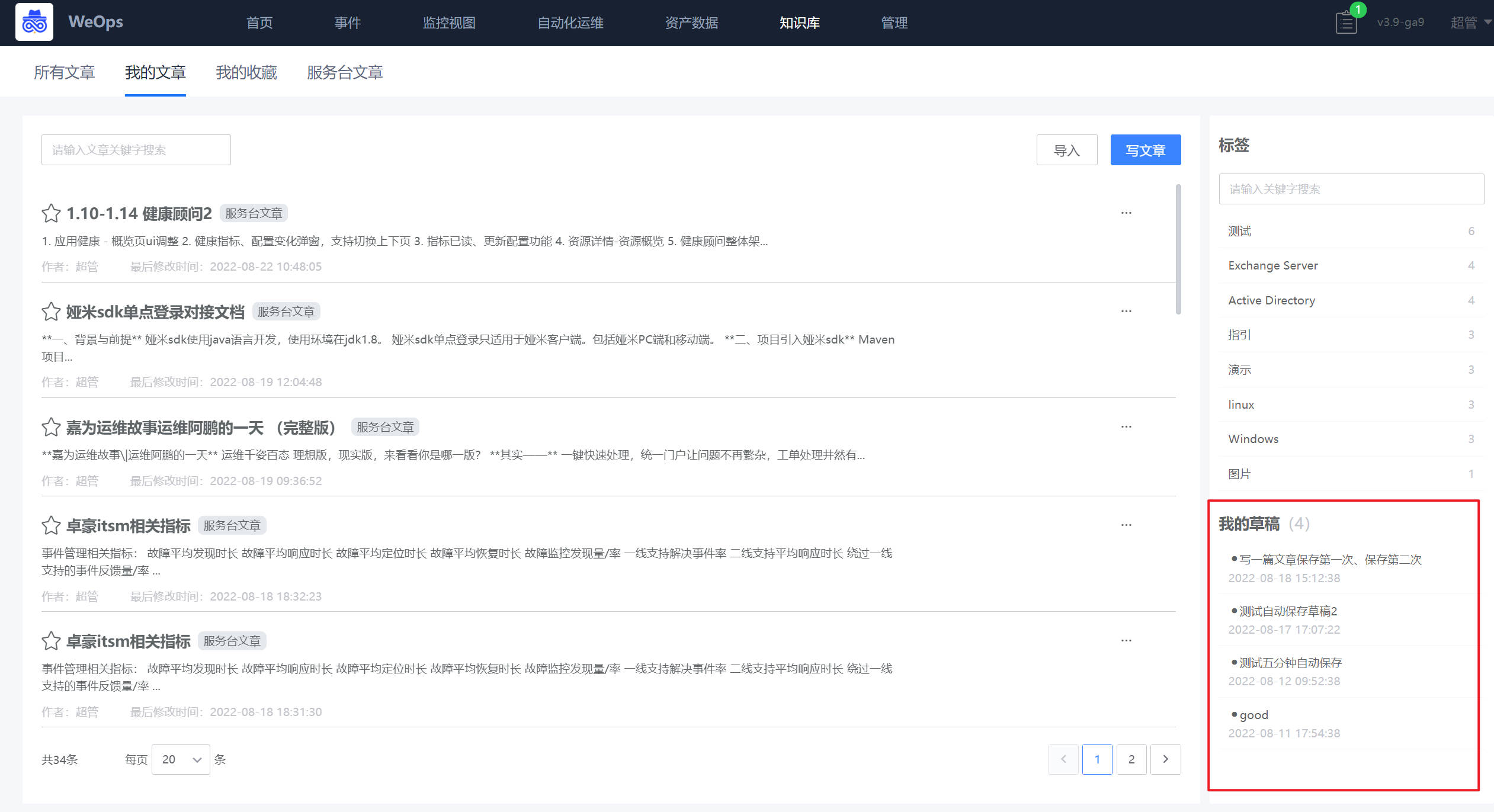

知识库

知识库支持文章的撰写、文章批量导入、文章暂存为草稿、文章的分类查看。

所有文章

知识库所有文章展示了所有人写的文章,可进行搜索、以标签进行筛选展示、对关注的文章进行收藏。

点击对应文章,可以查看该文章详情,可以进行该文章点赞、收藏等操作

我的文章

我的文章展示了所有“我”撰写的文章,可以对文章进行搜索和筛选,也可以进行重新编辑和删除的操作。

“文章导入”:知识库支持文章的批量导入,并为文章批量添加标签。

“写文章”可以选择模板进行文章的快速撰写,目前支持“Markdown”、“嵌入页面”、“图片”、“文件”三类组件。文章撰写后可以选择“发布文章”或者“保存草稿”

“我的草稿”:文章撰写时可以手动保存,或者5分钟自动保存为草稿,对于草稿支持再次编辑发布。

我的收藏

我的收藏对“我”关注的文章进行展示,可以点击文章标题前的星号进行收藏/取消收藏。

运营分析

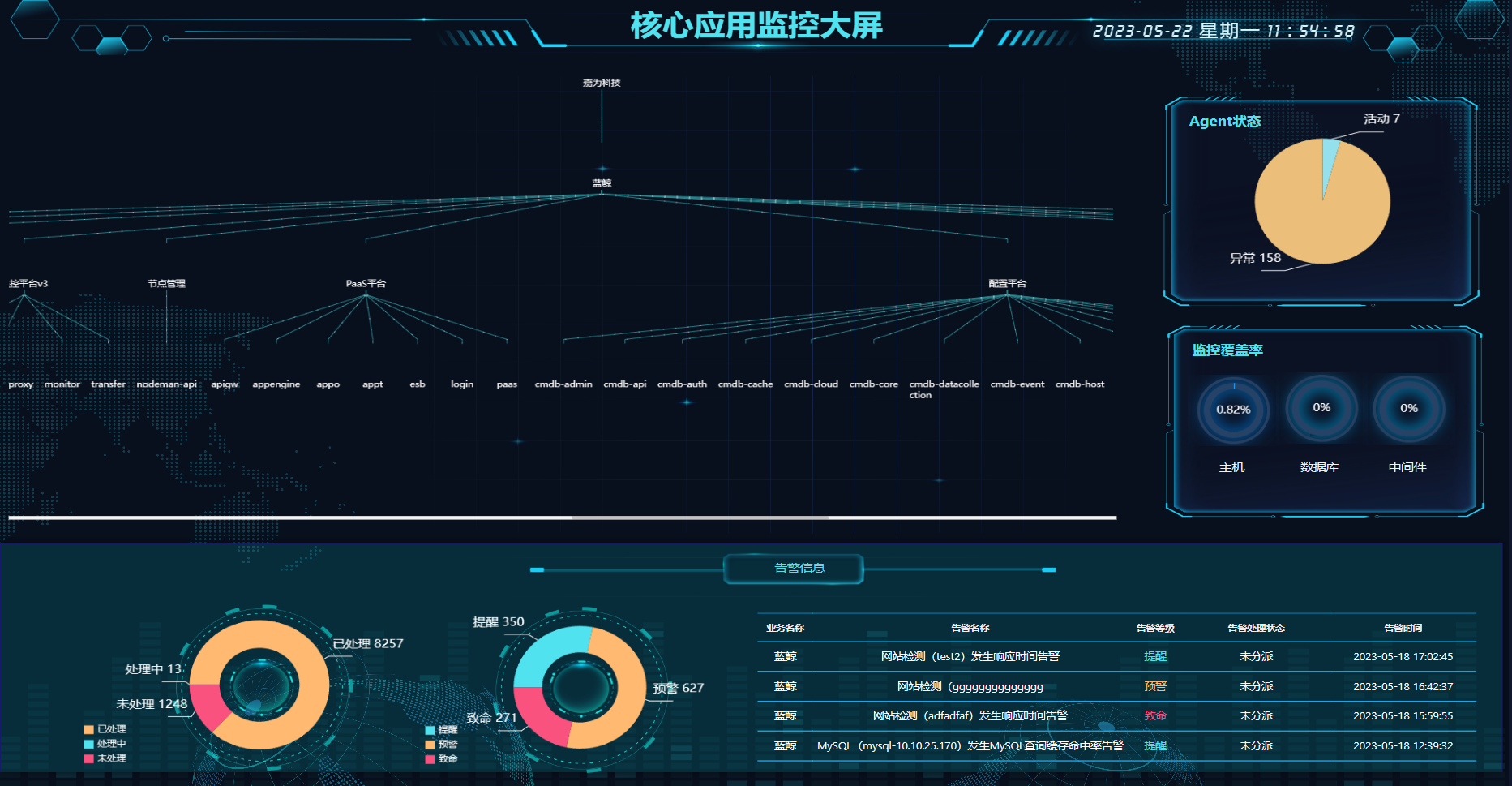

数据大屏

展示所有内置大屏和手动添加的大屏基本情况,目前已经内置4张大屏。

3D应用全景大屏

- 展示全部应用的拓扑情况和告警情况

- 点击应该可查看该应用的告警具体情况,包括告警等级、内容、指标视图等

- 展示该应用的3D拓扑图,便于全景展示应用的整体架构和告警链路。

- 每个应用可以点击进入该应用的APM服务大屏

资源大屏

- 展示资源概览数据:业务、主机、虚拟化平台、中间件、数据库。

- 资产分类统计:按操作系统、数据库、中间件统计。

- 主机数量统计:按业务TOP10。

- 资源分配统计:按业务。

- 资源消费统计:内存、vCPU、磁盘消费TOP5。

核心业务监控大屏

- 展示应用拓扑图。

- 告警概况:告警级别分布、告警处理状态分布。

- 实时告警信息:告警级别、分类、实例名、业务、告警描述、时间、状态。

- agent状态:正常、异常。

- 监控覆盖率:主机、数据库、中间件监控覆盖率。

应用墙

- 应用总览展示了所用应用的基本情况,包括应用总数量、正常应用数量、预警应用数量、预警应用数量

- 展示应用健康状态展示:严重、普通、轻微。

- 告警详情展示:业务名称、告警名称、告警等级、告警处理状态、告警时间。

运营报表

展示所有内置报表和手动添加的报表基本情况,目前已经内置2张报表。

告警数据运营分析表

- 整体展示了WeOps告警相关的关键指标数据,支持切换日期查询范围

- 单值:有效告警数、关闭告警数、未关闭告警数、未响应告警数、危险告警数、MTTR

- 折线图:告警压缩占比趋势图(有效告警、屏蔽告警、抑制告警)、告警处理数量趋势图

- 饼图:告警级别分布(危险、预警、提醒)、告警状态分布(各类告警状态)、告警对象分布(各类对象)

- 表格:应用分析(应用名称、有效告警数、关闭告警数、未关闭告警数、未响应告警数、危险告警数、MTTR)

- 表格:人员分析(姓名、被分派的告警、认领的告警、关闭的告警、MTTR)

工单数据运营分析表

- 整体展示了WeOps工单相关的关键指标数据,支持切换日期查询范围

- 单值:工单总数、关闭工单数、未关闭工单数、未响应工单数、MTTR、在SLA目标时间内解决的事件百分比、满意度(所有被调查满意度的服务请求记录中用户满意度分值总计 / 所有被调查满意度的服务请求总数)

- 柱状图:每日新增工单数、每日关闭工单数

- 表格:服务分析(服务名称、工单总数、关闭工单数、未关闭工单数、未响应工单数、MTTR、在SLA目标时间内解决的事件百分比、满意度)

- 表格:人员分析(姓名、关闭工单数、MTTR、在SLA目标时间内解决的事件百分比、满意度)

业务低负载报表

- 整体展示了业务低负责主机的统计情况

- 支持支持切换日期查询范围、业务选择范围、高峰期范围,支持设置低负载的CPU使用和内存使用情况

- 单值:主机数、Agent正常数、Agent异常数、未安装Agent数

- 表格:低负载主机(IP、主机名、操作系统、应用、CPU使用情况、内存使用情况)、正常负载(IP、主机名、操作系统、应用、CPU使用情况、内存使用情况)

管理

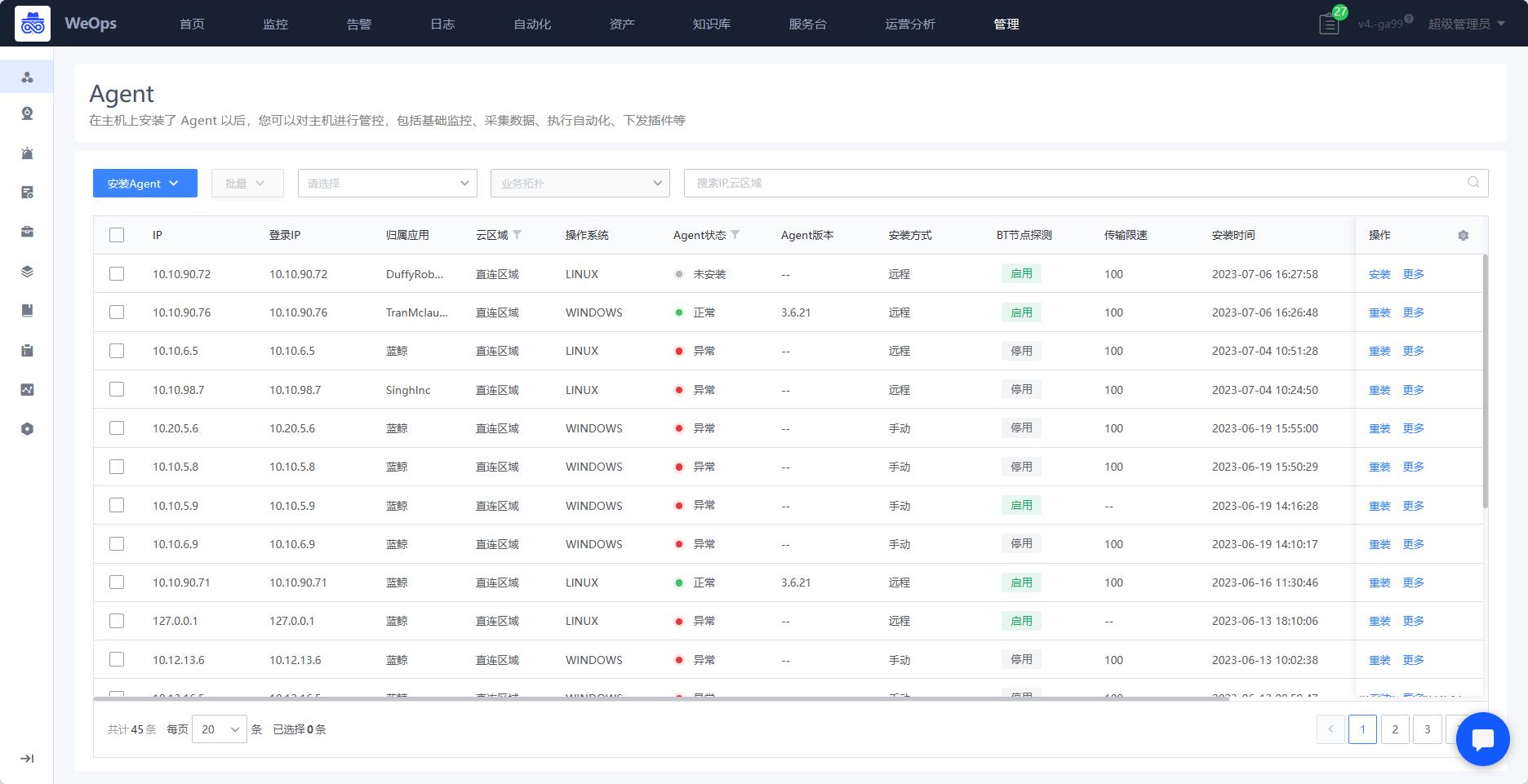

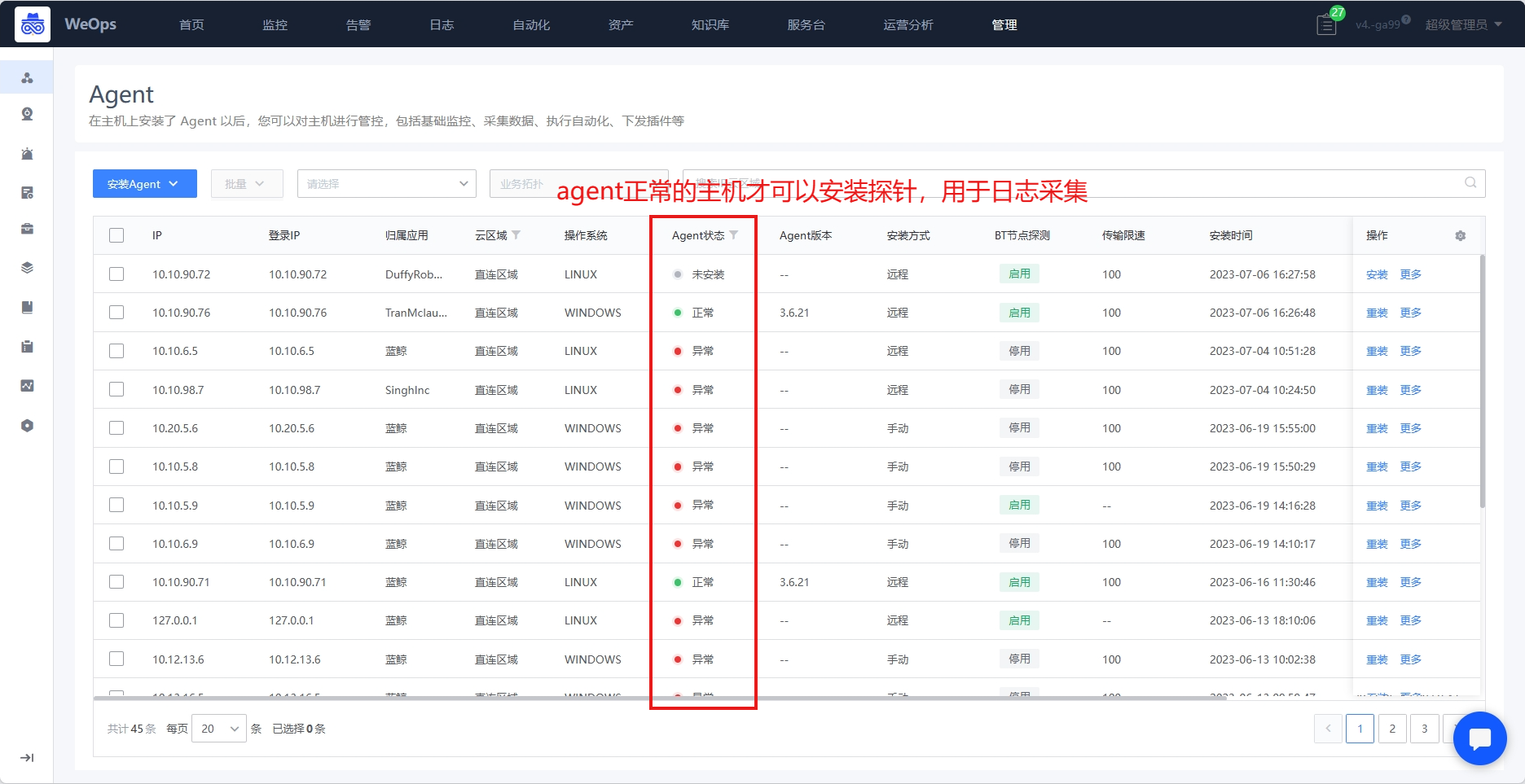

节点管理

Agent

- 支持主机进行Agent安装,安装后对主机进行管控,可进行主机监控、采集基础信息、执行自动化等操作。

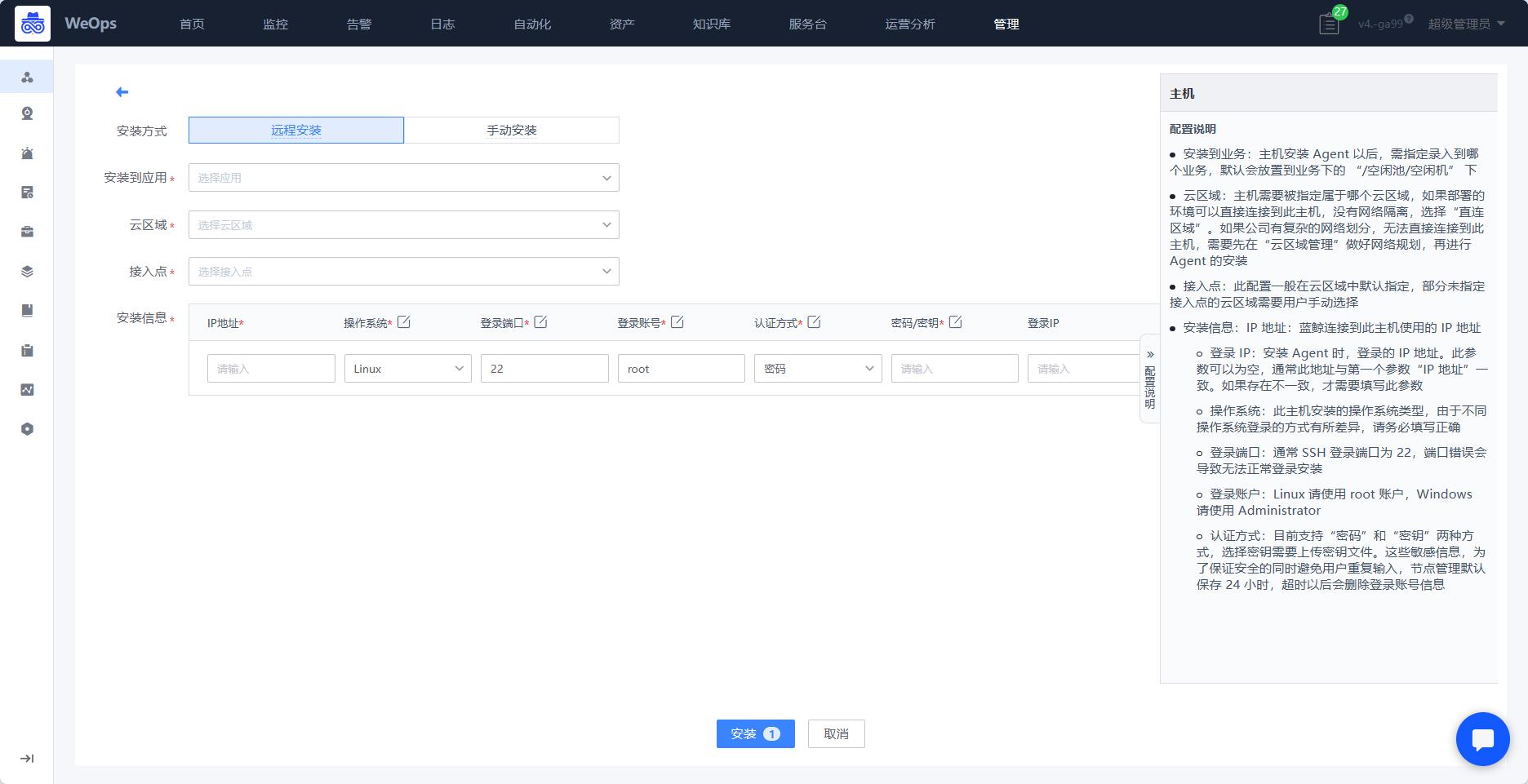

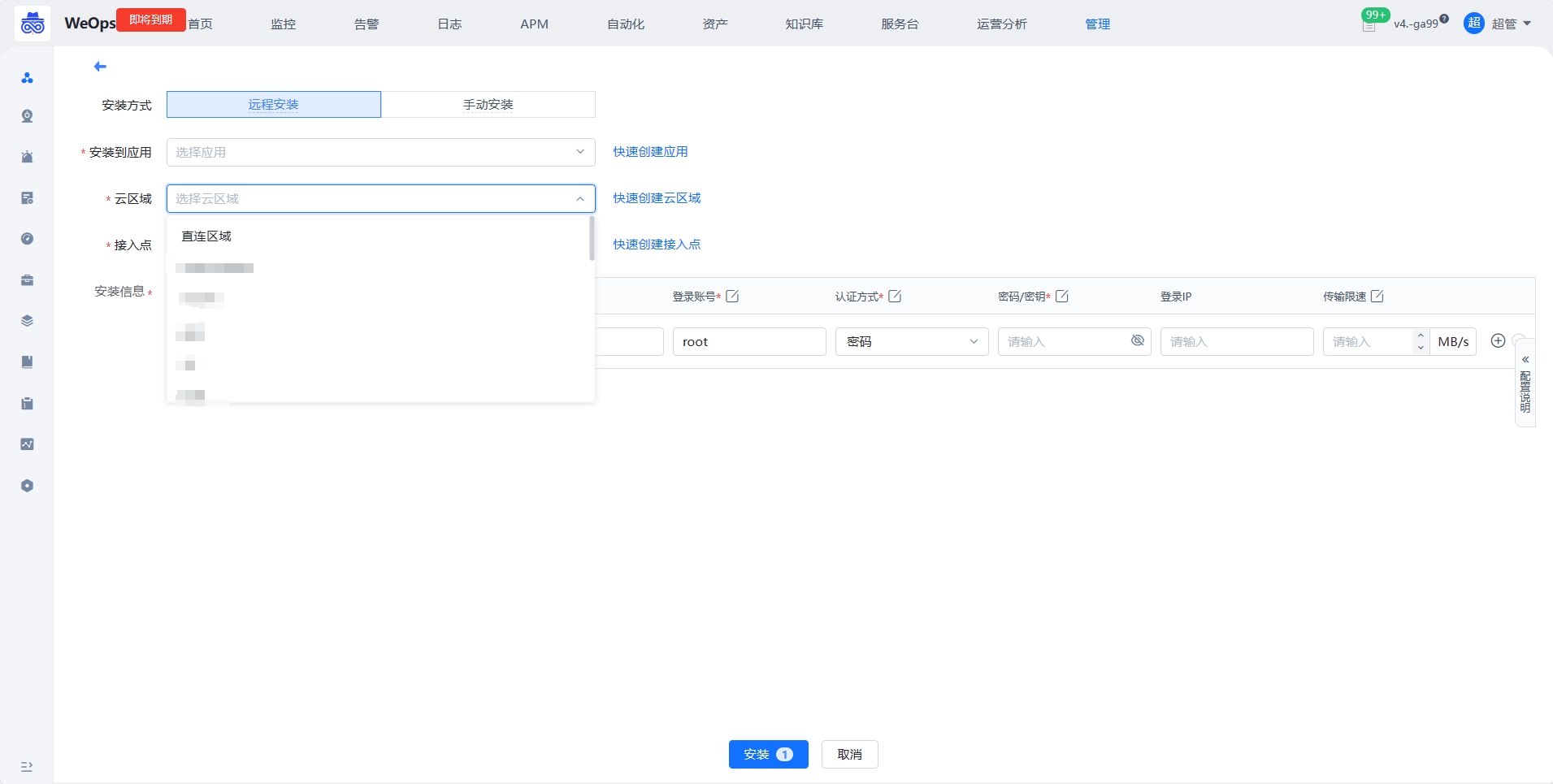

- 对于主机的agent安装,支持普通安装和表格批量导入安装,支持远程安装和手动安装两种方式进行。

云区域

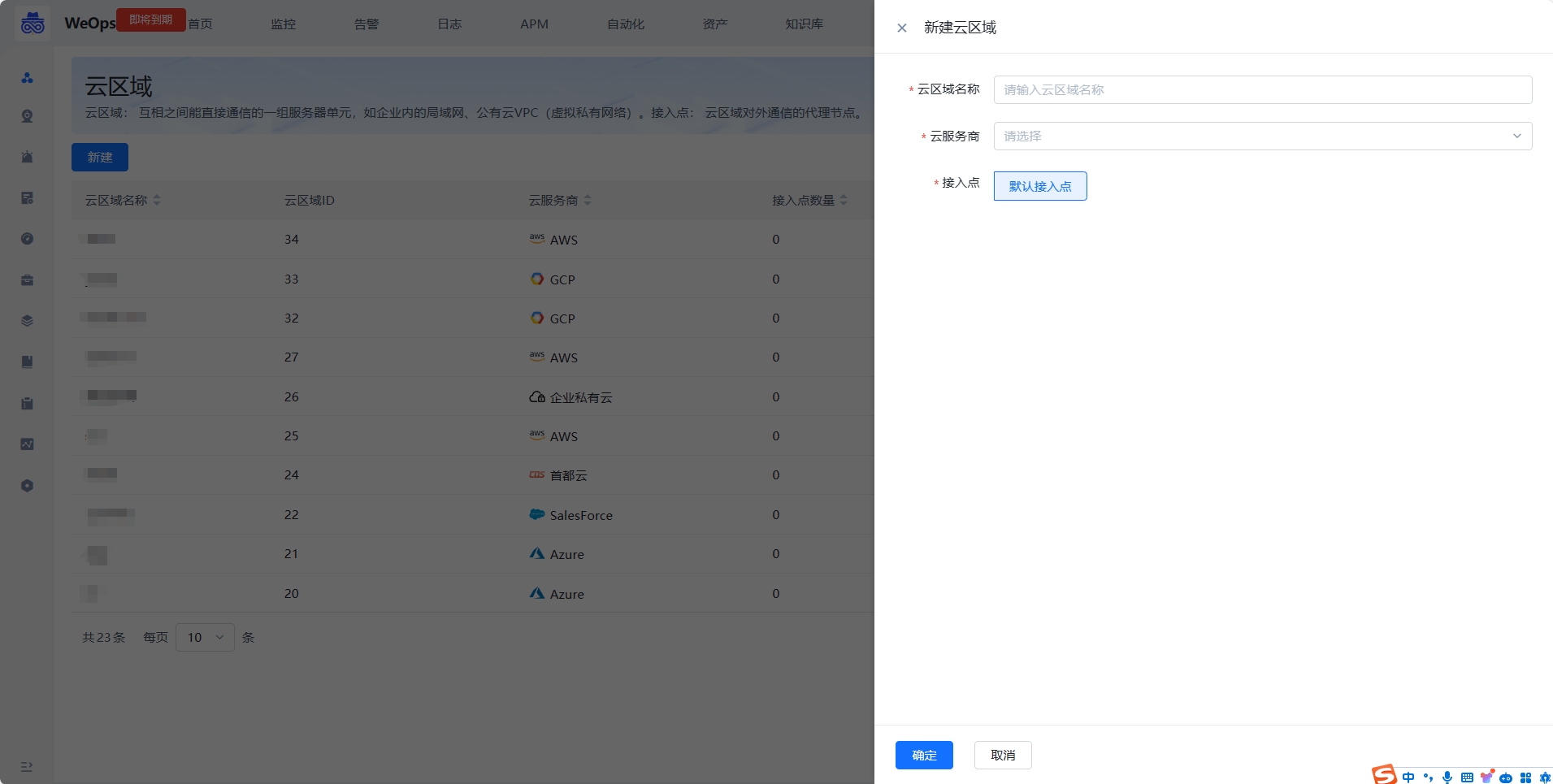

- 云区域是互相之间能直接通信的一组服务器单元,如企业内的局域网、公有云 VPC(虚拟私有网络)。WeOps在刚部署的时候,默认会创建“直连区域”,当主机可以直接与蓝鲸部署所在网络直接进行通讯连接时,Agent 安装到此区域即可。如果企业网络有区域划分,如办公网与生产网络隔离、总公司与分公司网络隔离、国内服务网与国外服务网隔离等情况,可根据实际的网络可连通性规划创建多个云区域。

- 接入点: 云区域对外通信的代理节点。

- 如下图,支持创建云区域,填写云区域名称,选择云服务商用于标识当前网络的提供商,接入点使用默认接入点,后续可以跟进指引进行接入点的安装

- 云区域创建完成后,可以在主机安装Agent的时候,选择使用。

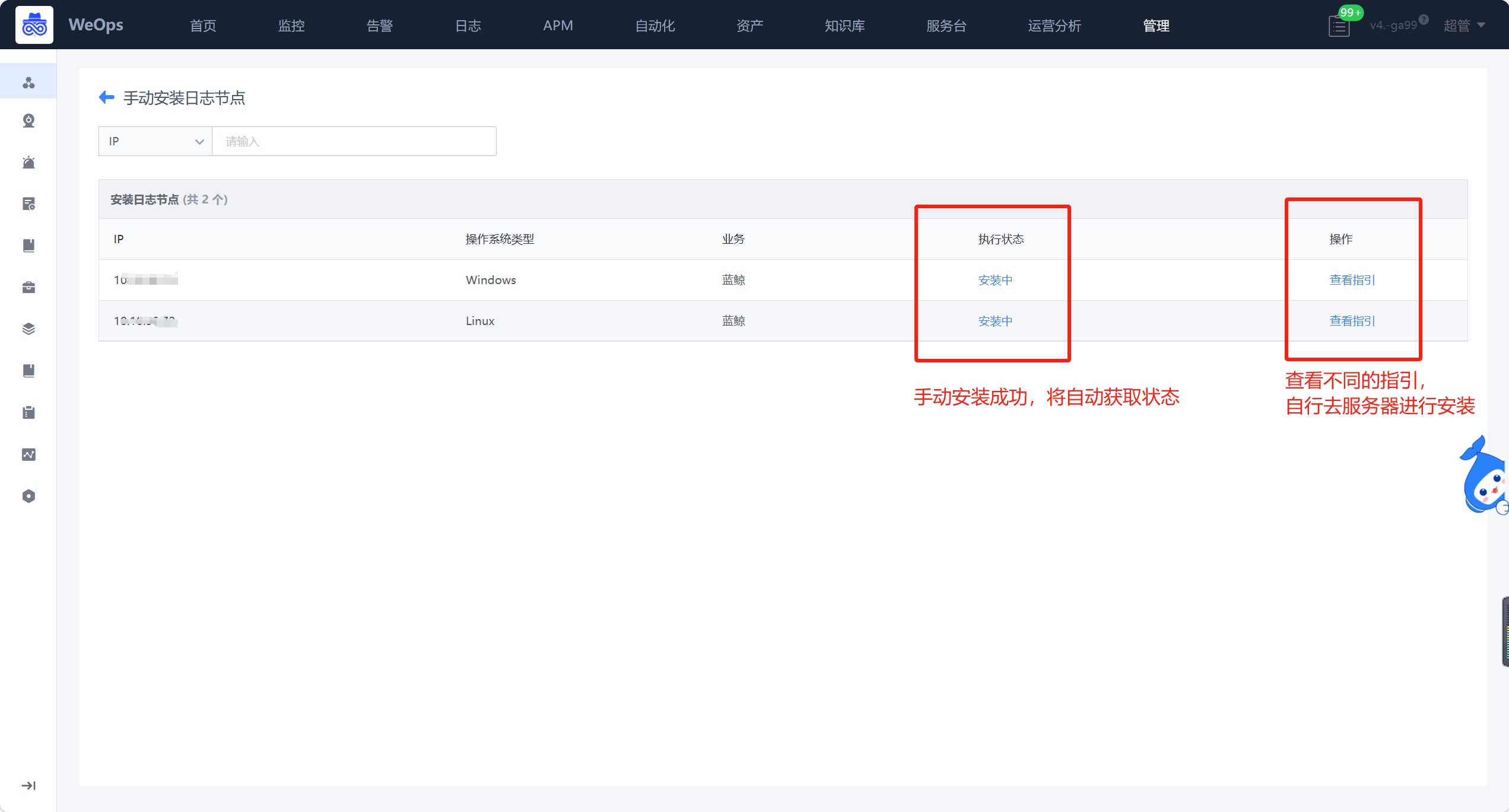

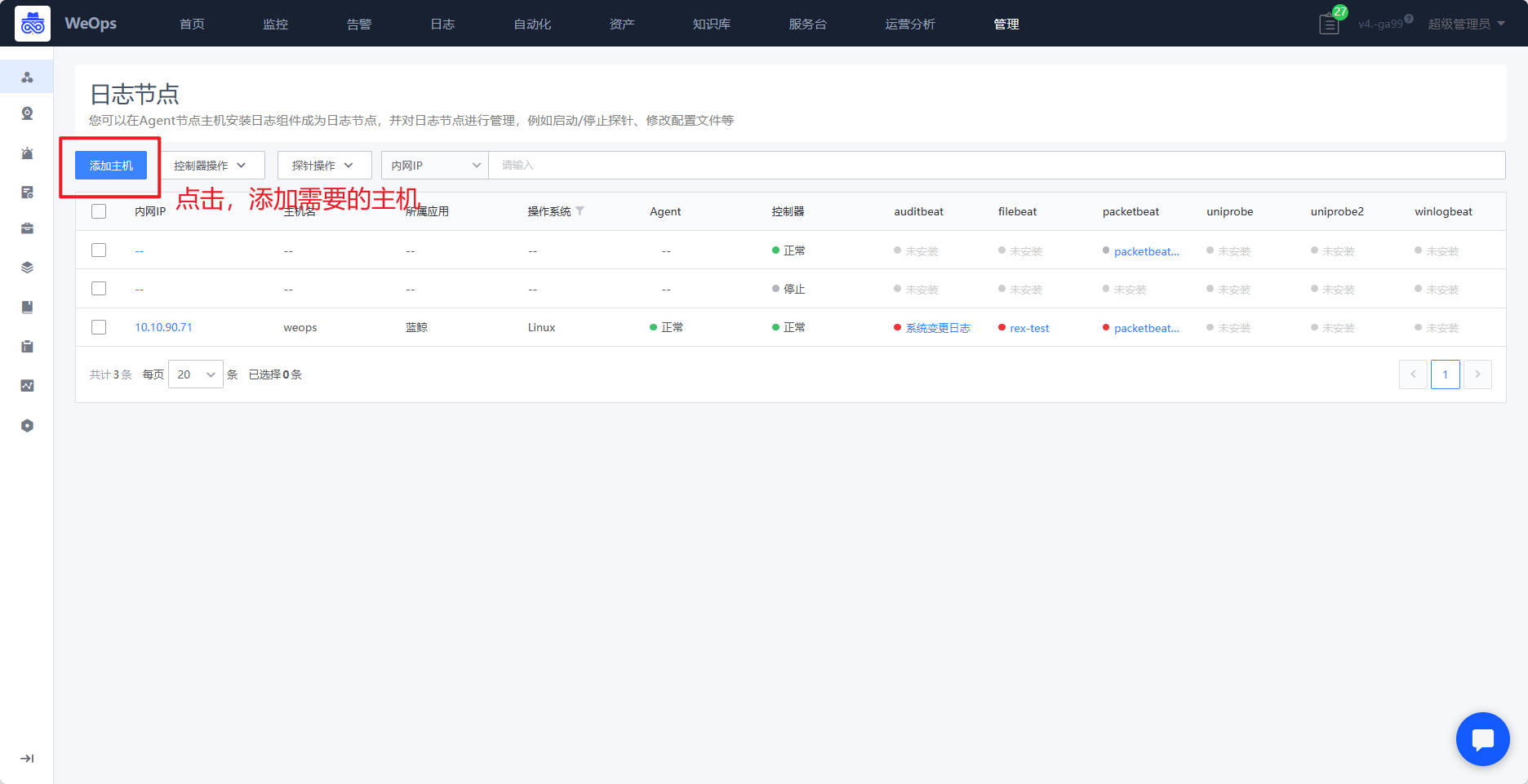

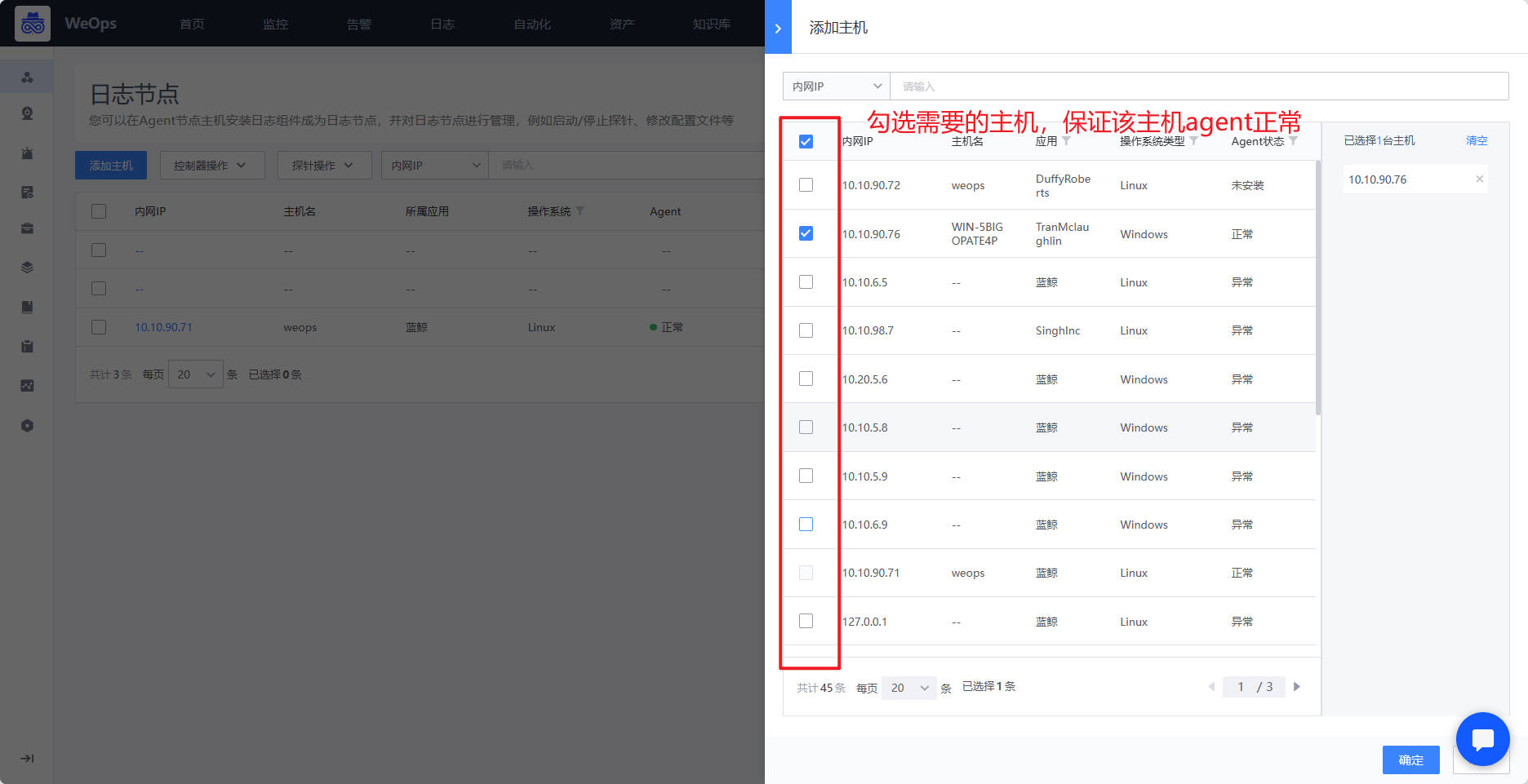

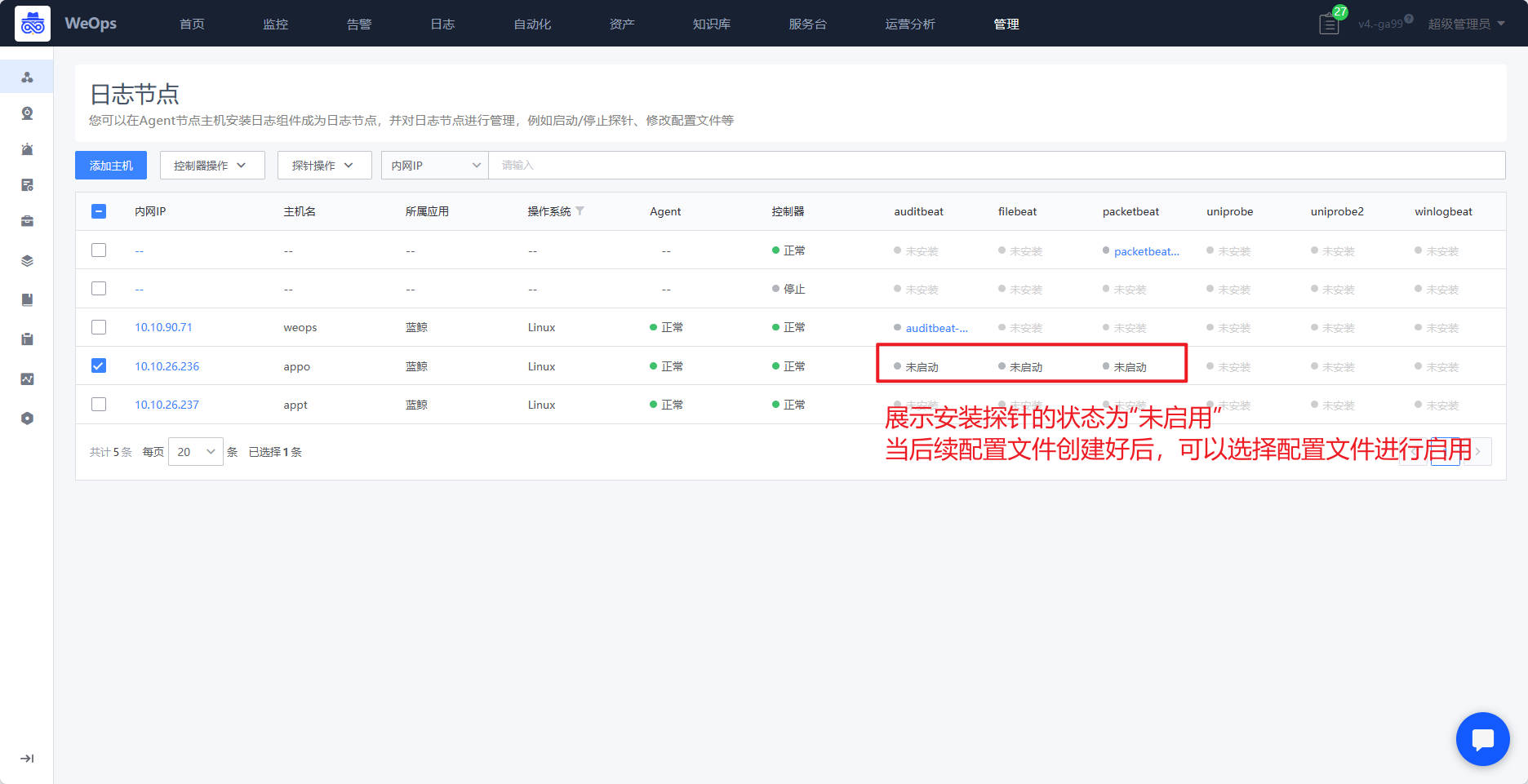

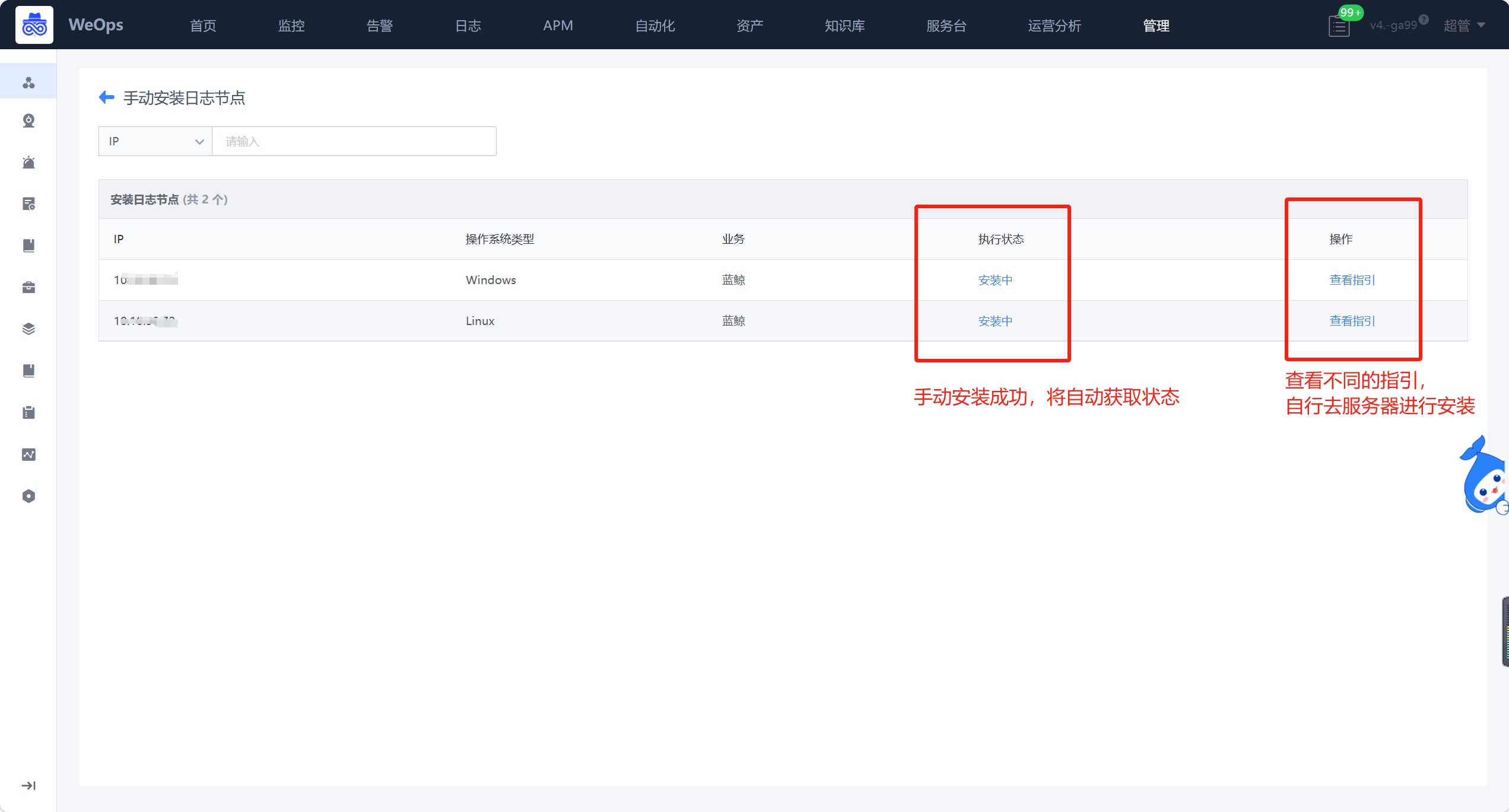

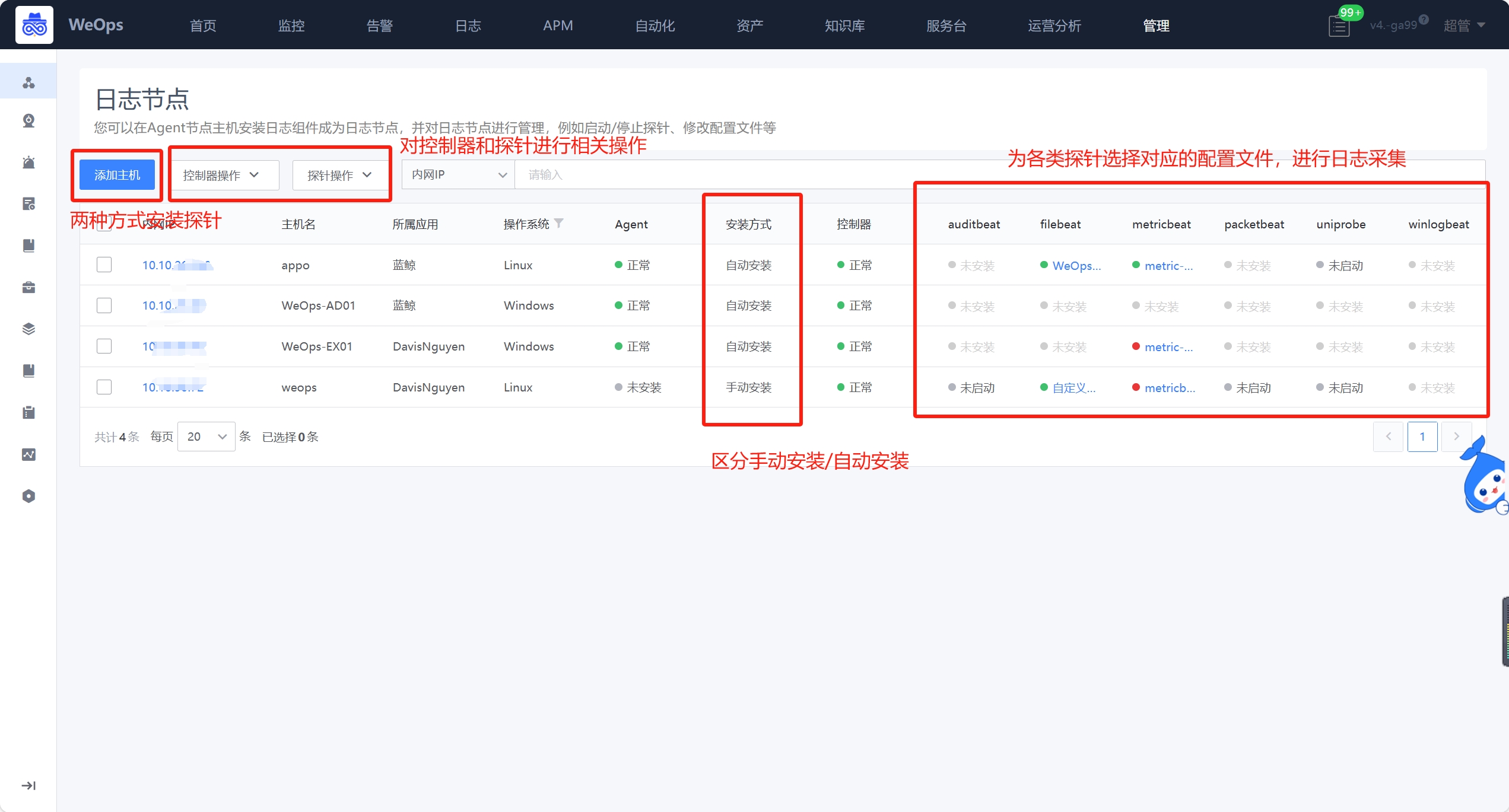

日志节点

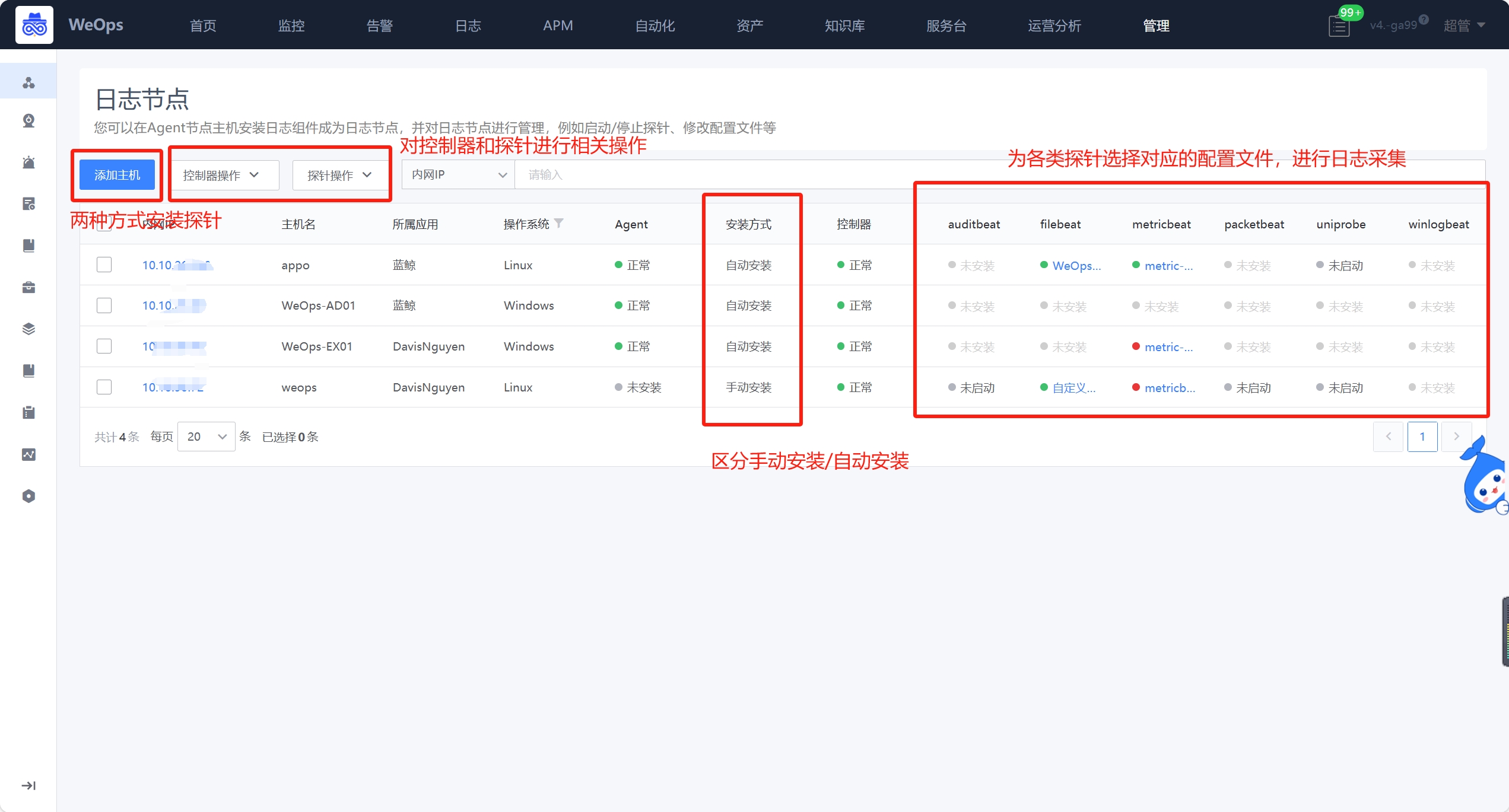

- 日志节点支持为已经安装了Agent的服务器安装日志探针控制器和日志探针,并为为日志探针关联对应的配置文件,以便采集不同的日志数据。

- 日志的控制器和探针的安装方式有两种,具体解释如下

自动安装:主机已经安装了agent,可以支持选择主机后,自动安装控制器和探针,以便后续采集日志数据使用。控制器和探针的重启、停止和卸载也支持自动进行。

手动安装:主机没有安装agent,可以采用手动的方式,去服务器上传并安装控制器和探针的安装包,安装成功后,与自动安装一直,可以选择对应的配置文件,进行日志数据的采集。控制器和探针的重启、停止和卸载也需要通过手动进行

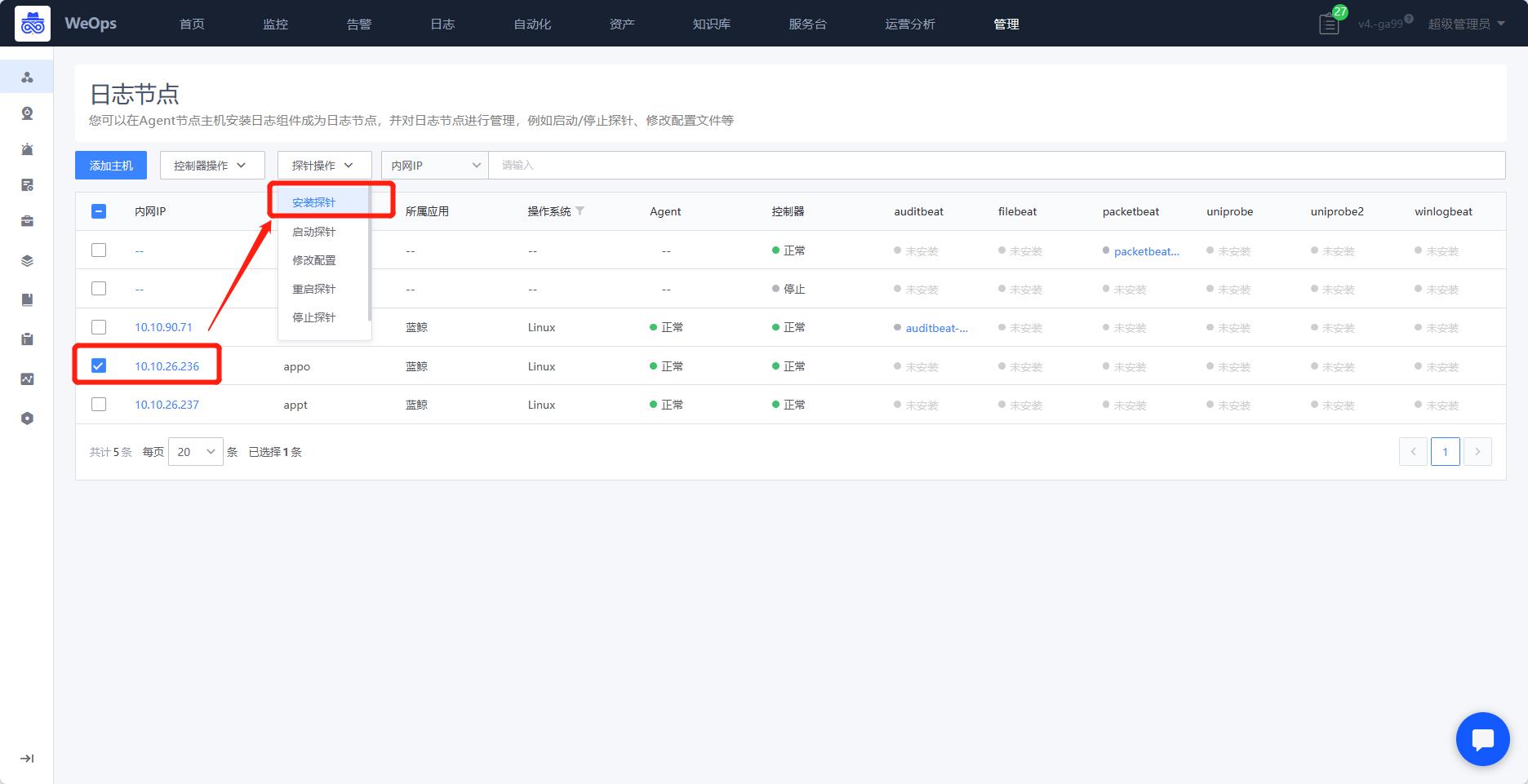

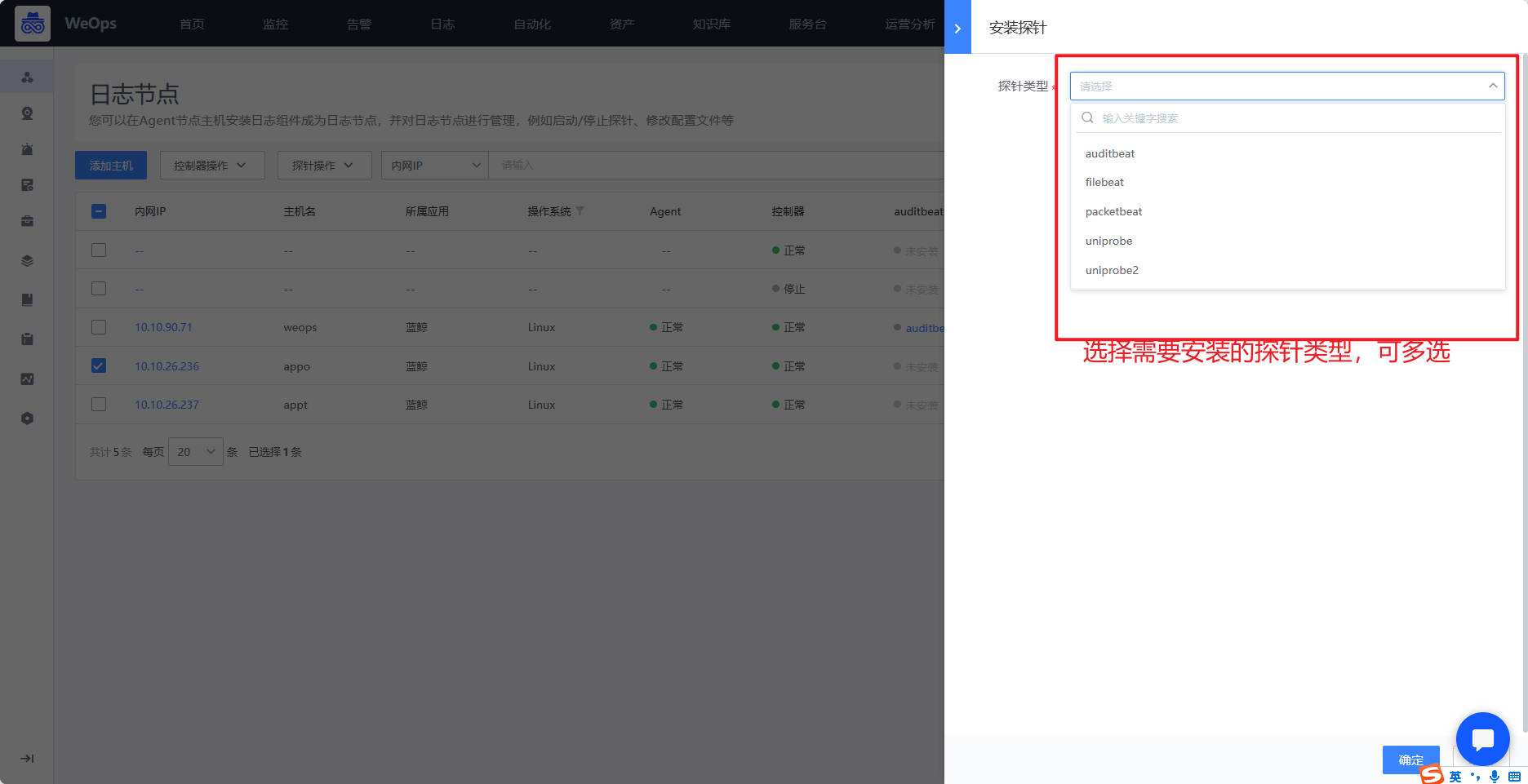

- 日志控制器操作,包括安装、启动、重启、停止、卸载等操作,探针则包括安装探针、启动探针、修改配置、重启探针、修改探针等操作

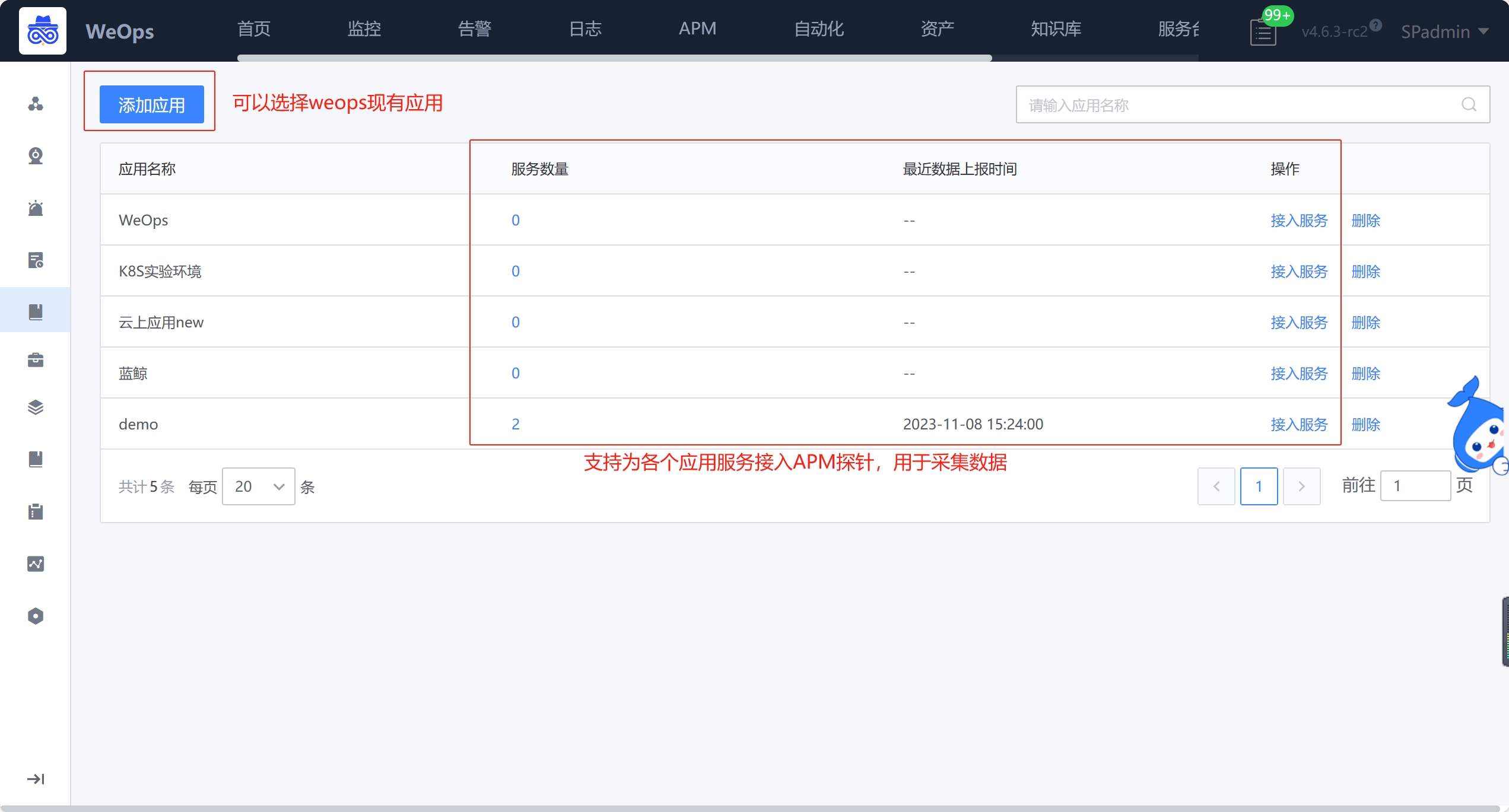

APM节点

展示所有已经接入的探针,以及这些探针所属的应用/服务,探针名称:接入时自定义;语言/版本:可进行筛选;所属应用/服务:可筛选,可跳转至详情页;最新数据上报时间

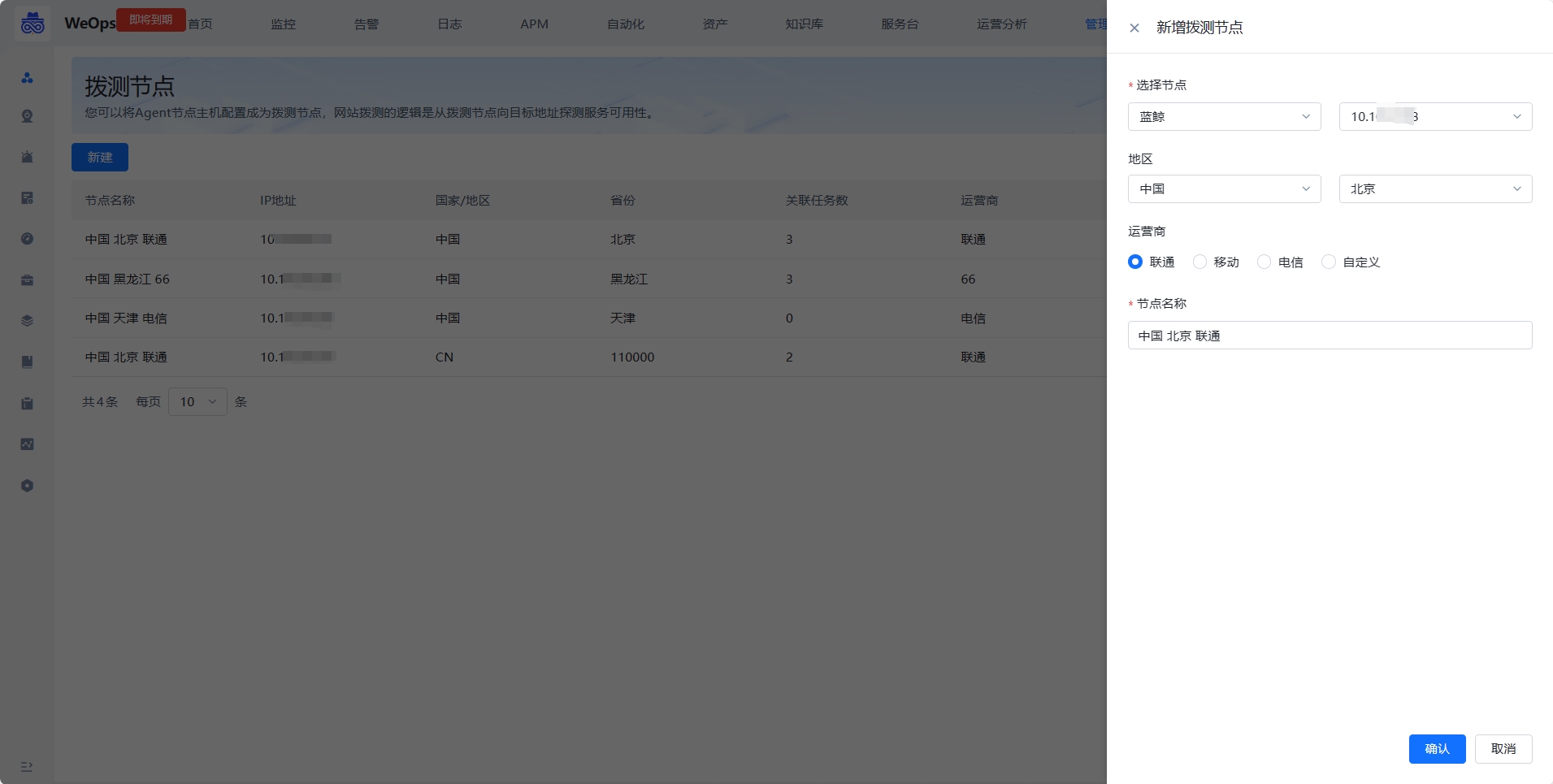

拨测节点

如下图,支持对服务拨测任务设置拨测节点,实现从拨测节点向目标地址探测服务可用性

新建拨测节点时,需要选择一个主机作为拨测节点,并且配置这个节点的地区和运营商等信息。

拨测节点配置完成后,可以在“监控管理-监控采集-网络监测”的任务中,选择并使用该节点。

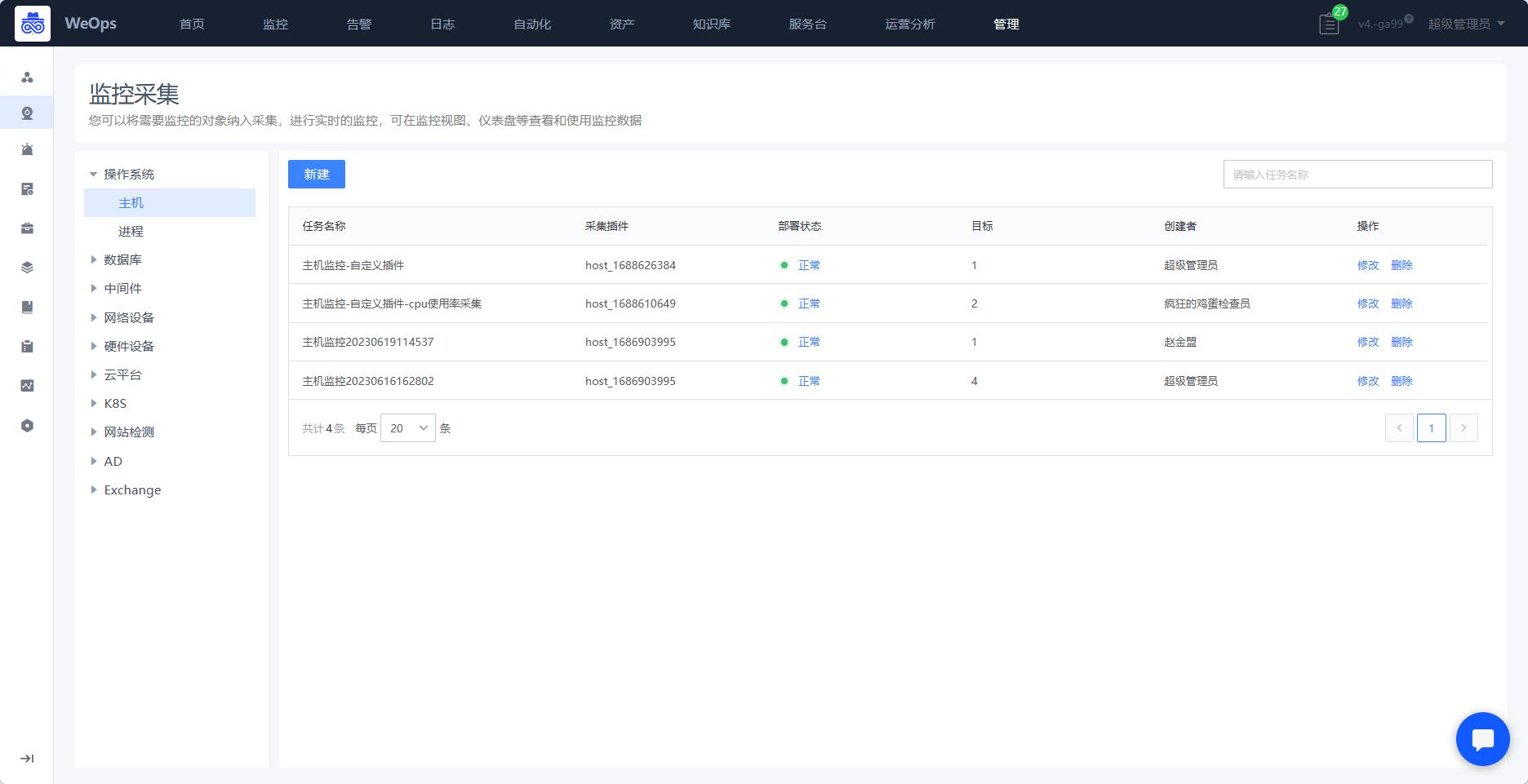

监控管理

监控采集

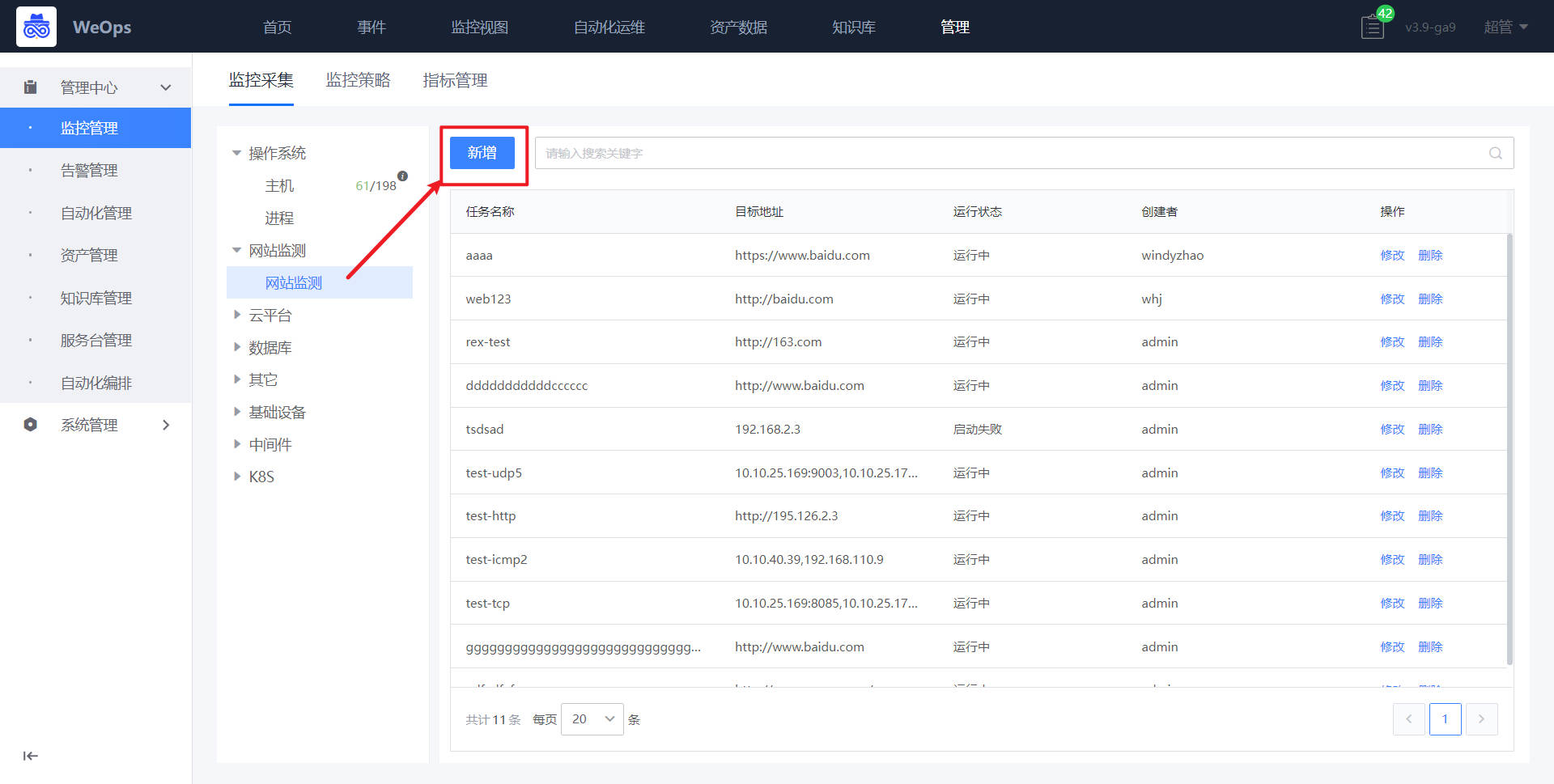

- 用于将监控对象纳入采集,主要包括主机、进程、数据库、中间件、K8S、网站监测等等等。可选择不同的监控插件进行采集,支持本地采集和远程采集。

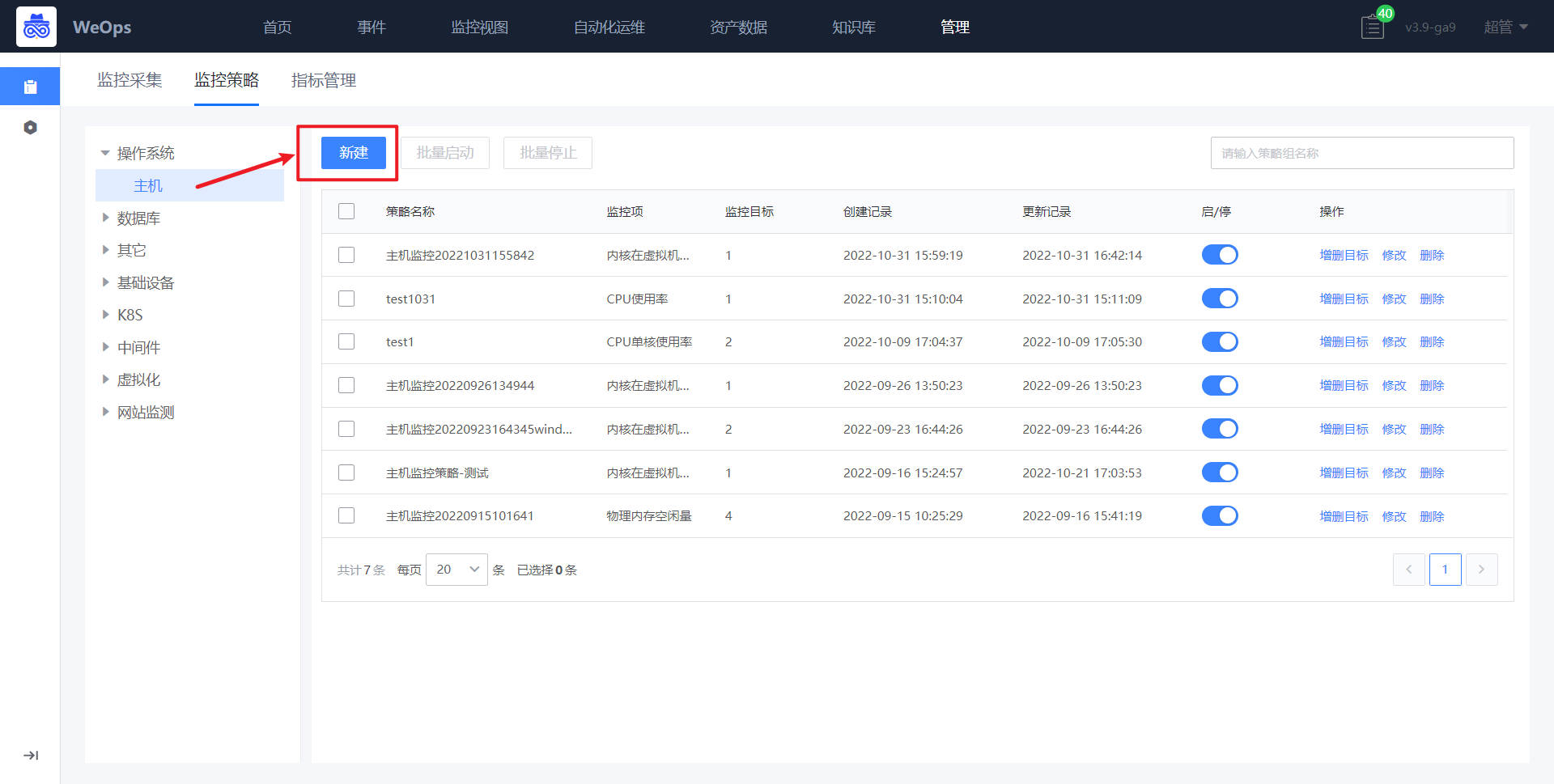

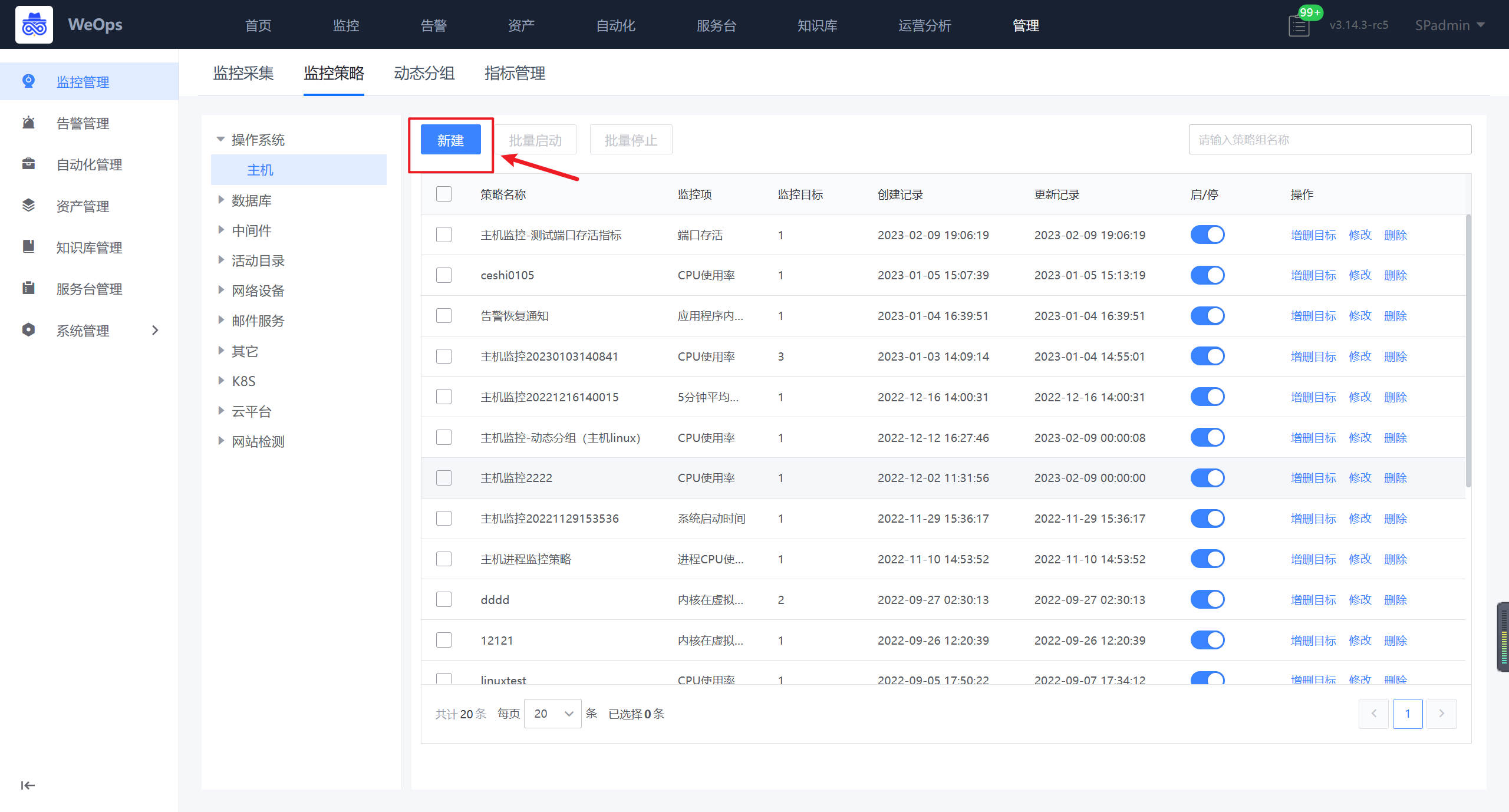

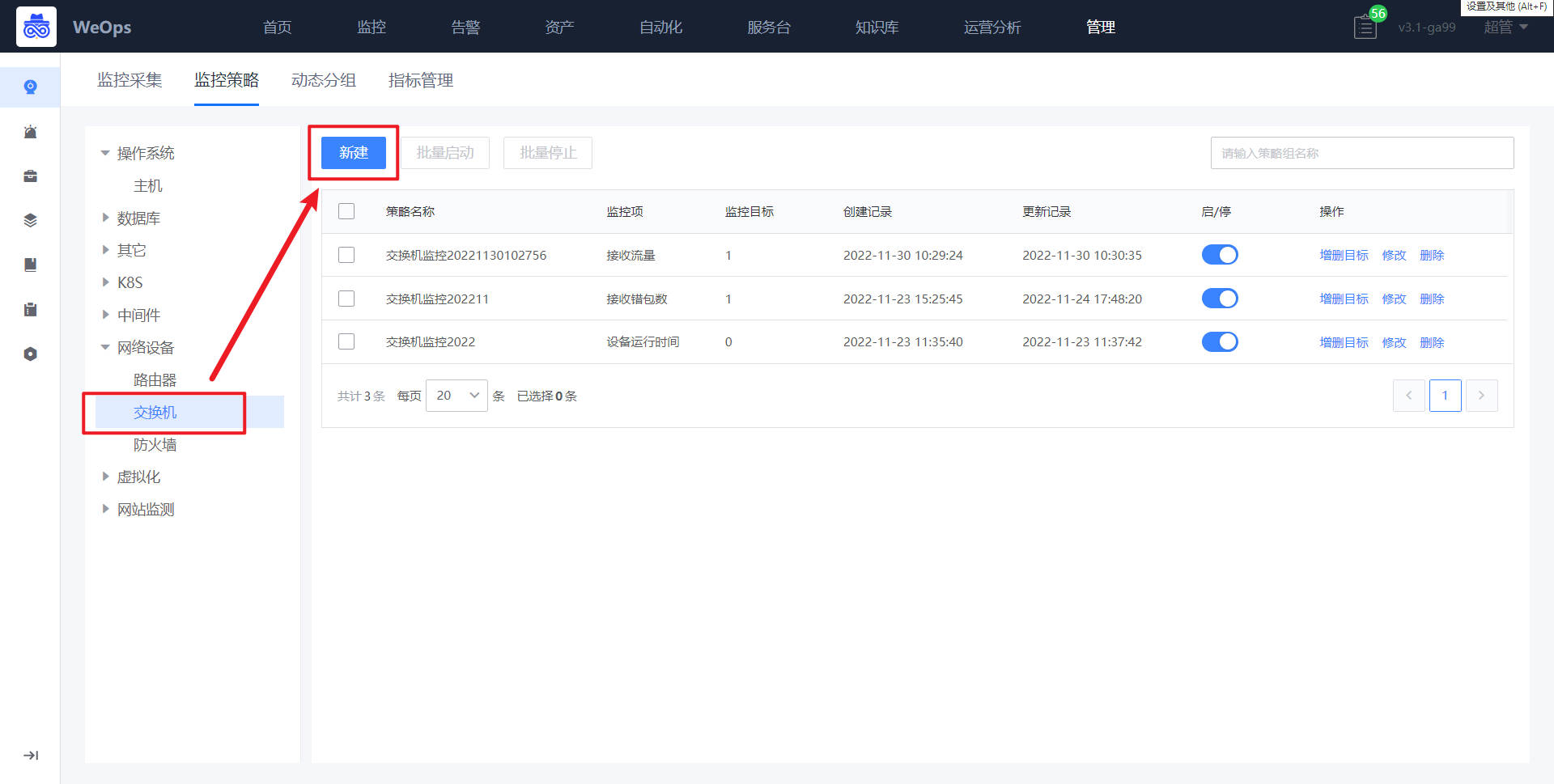

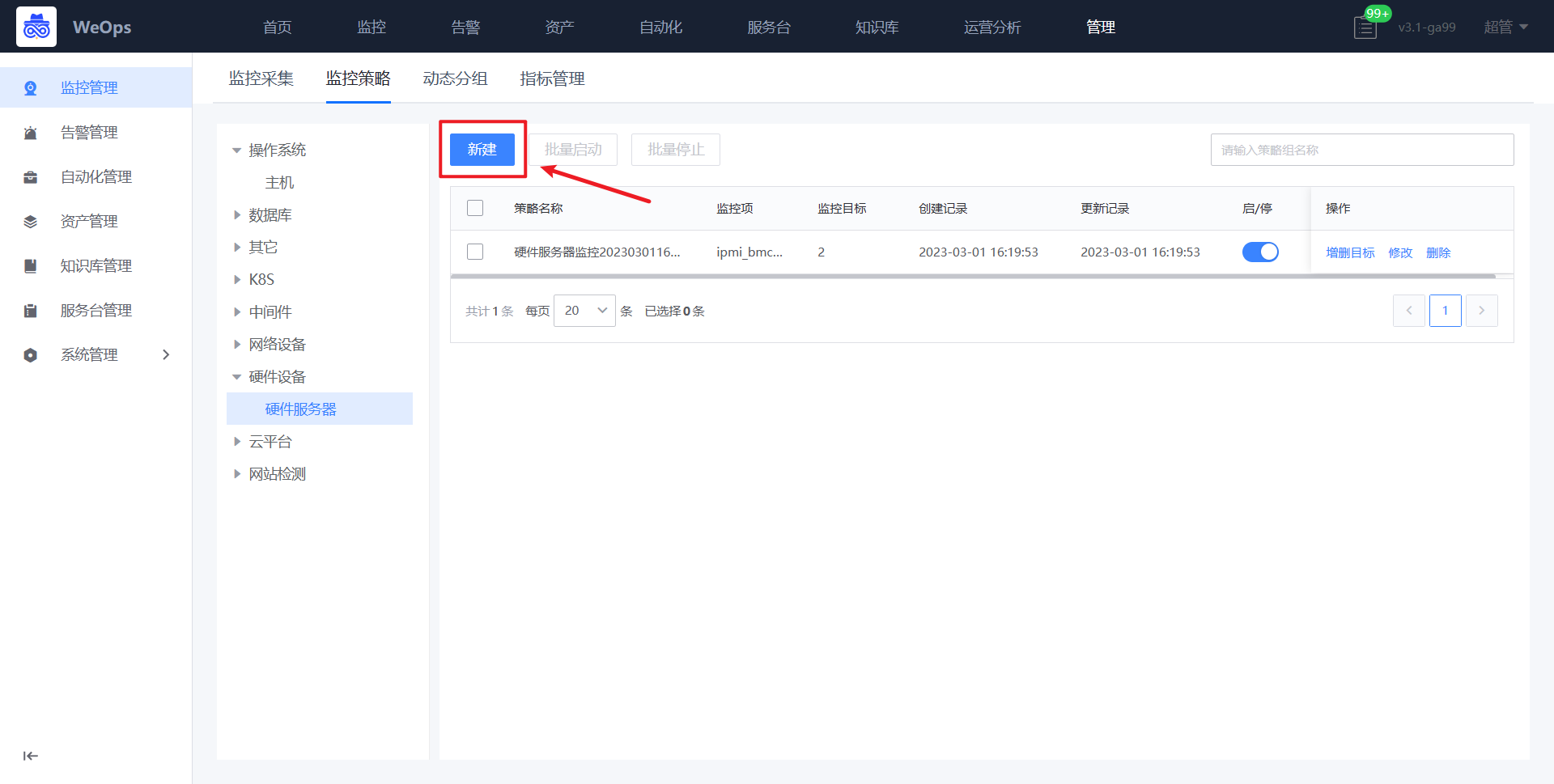

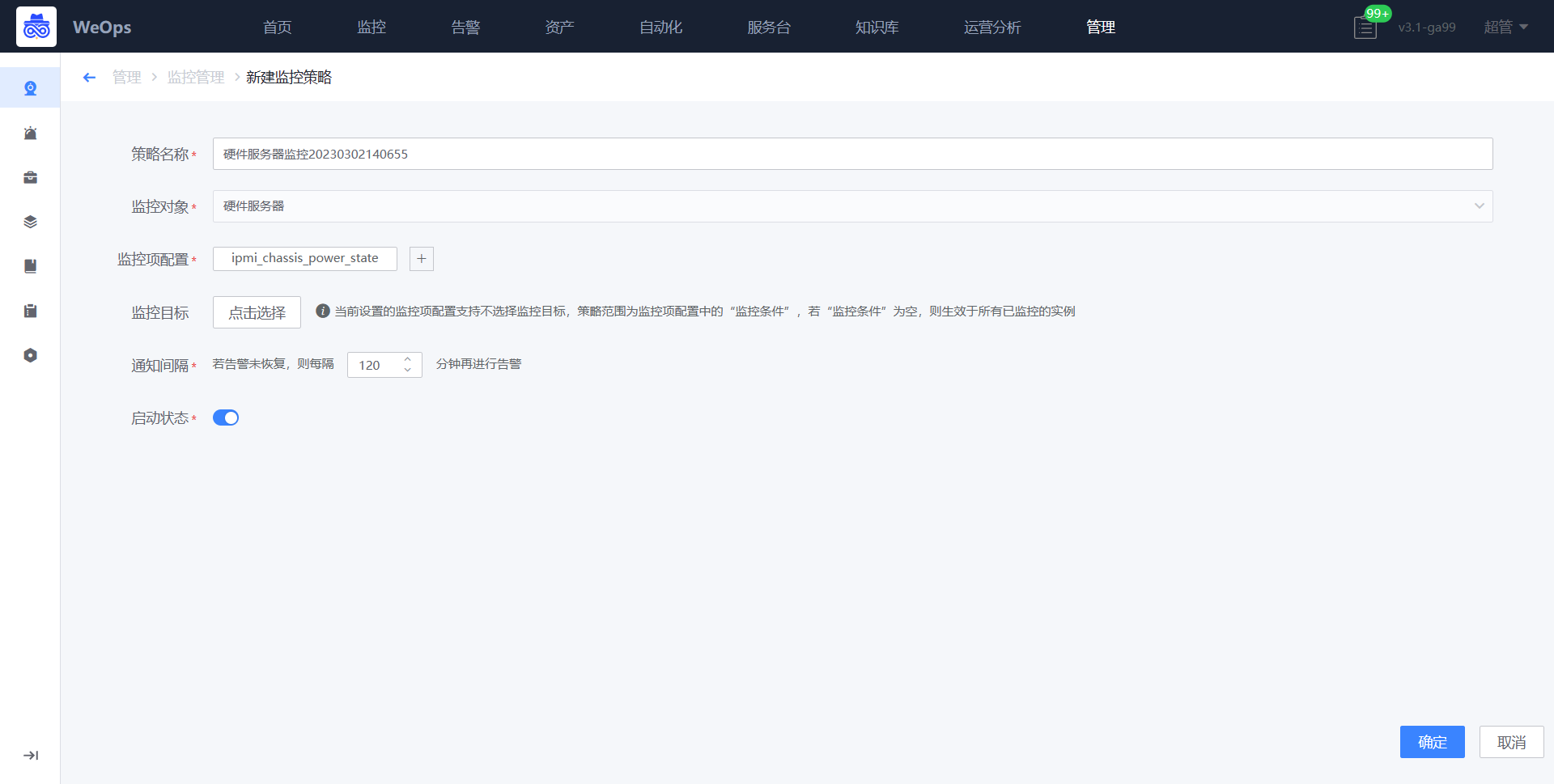

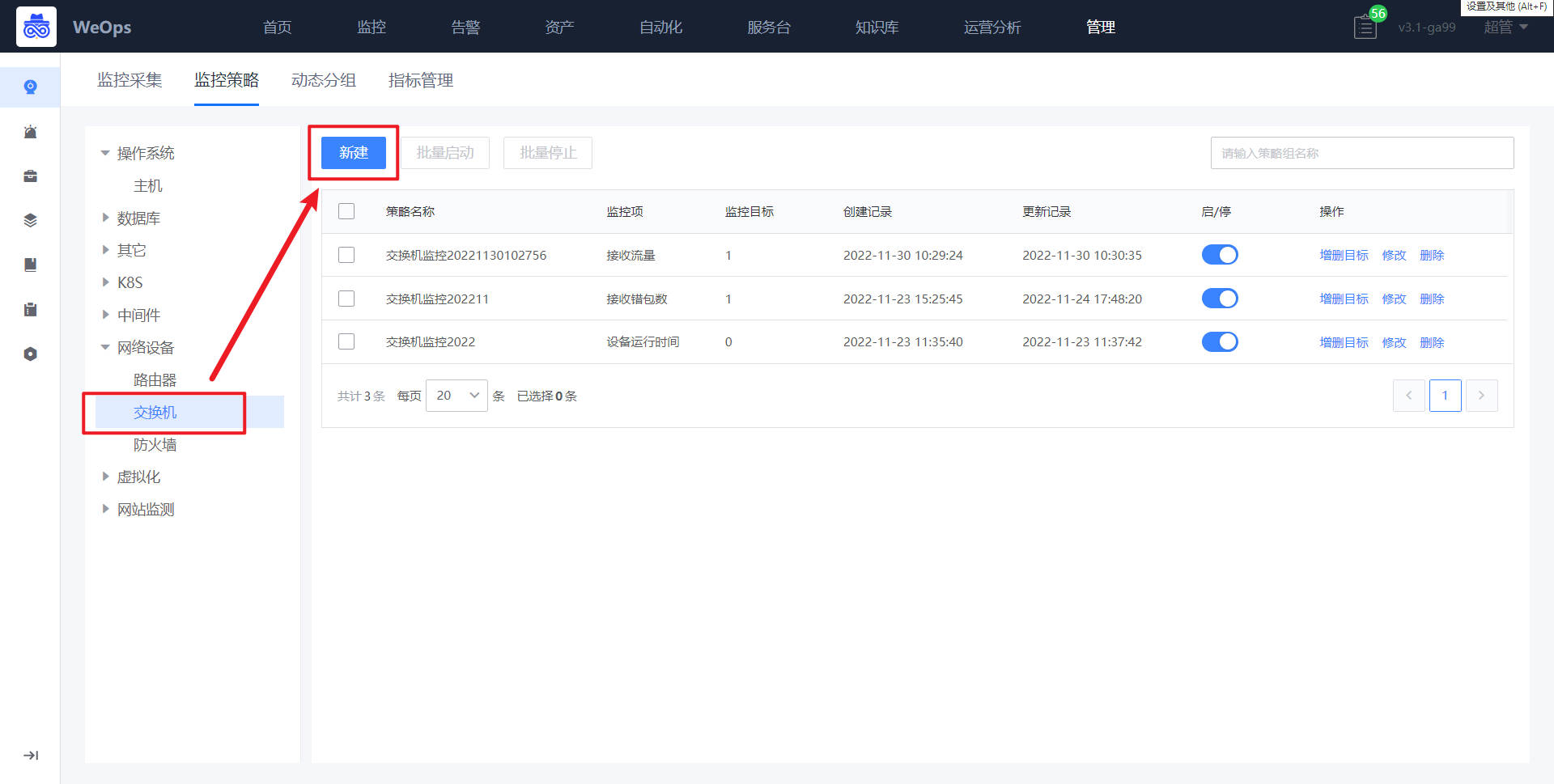

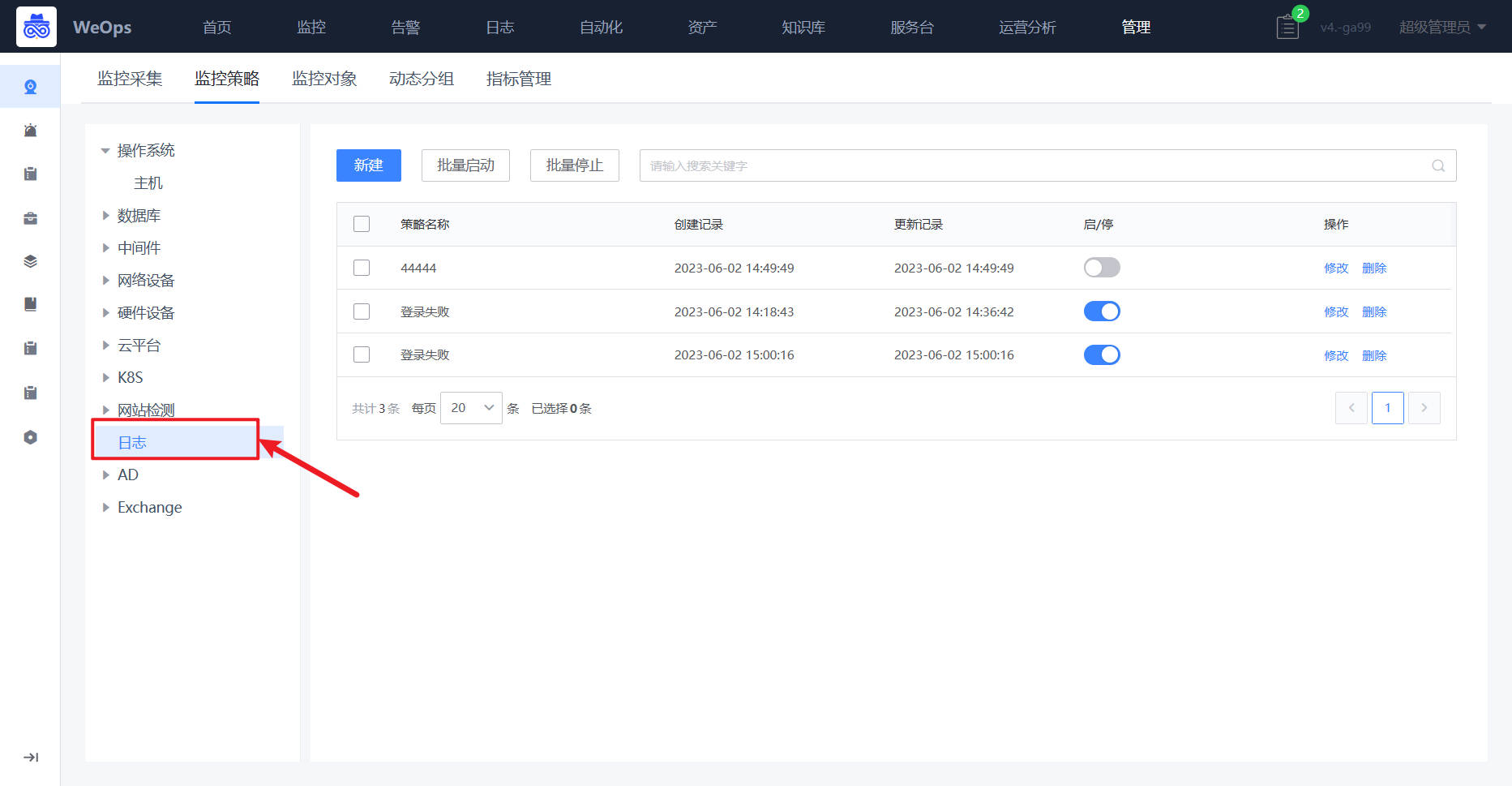

监控策略

- 对主机、数据库、中间件、网络设备、服务拨测、虚拟化平台等进行告警阈值配置。新建监控策略,需要选择对应的监控目标,监控项配置、通知间隔等信息

监控对象

- 对WeOps的监控对象进行管理,支持监控对象的创建、分组和其他操作,新增的监控对象将在监控采集、监控策略、指标管理和监控视图等配置和显示。

- 支持对监控对象创建分组,在监控视图、监控策略、监控采集等分组中生效。

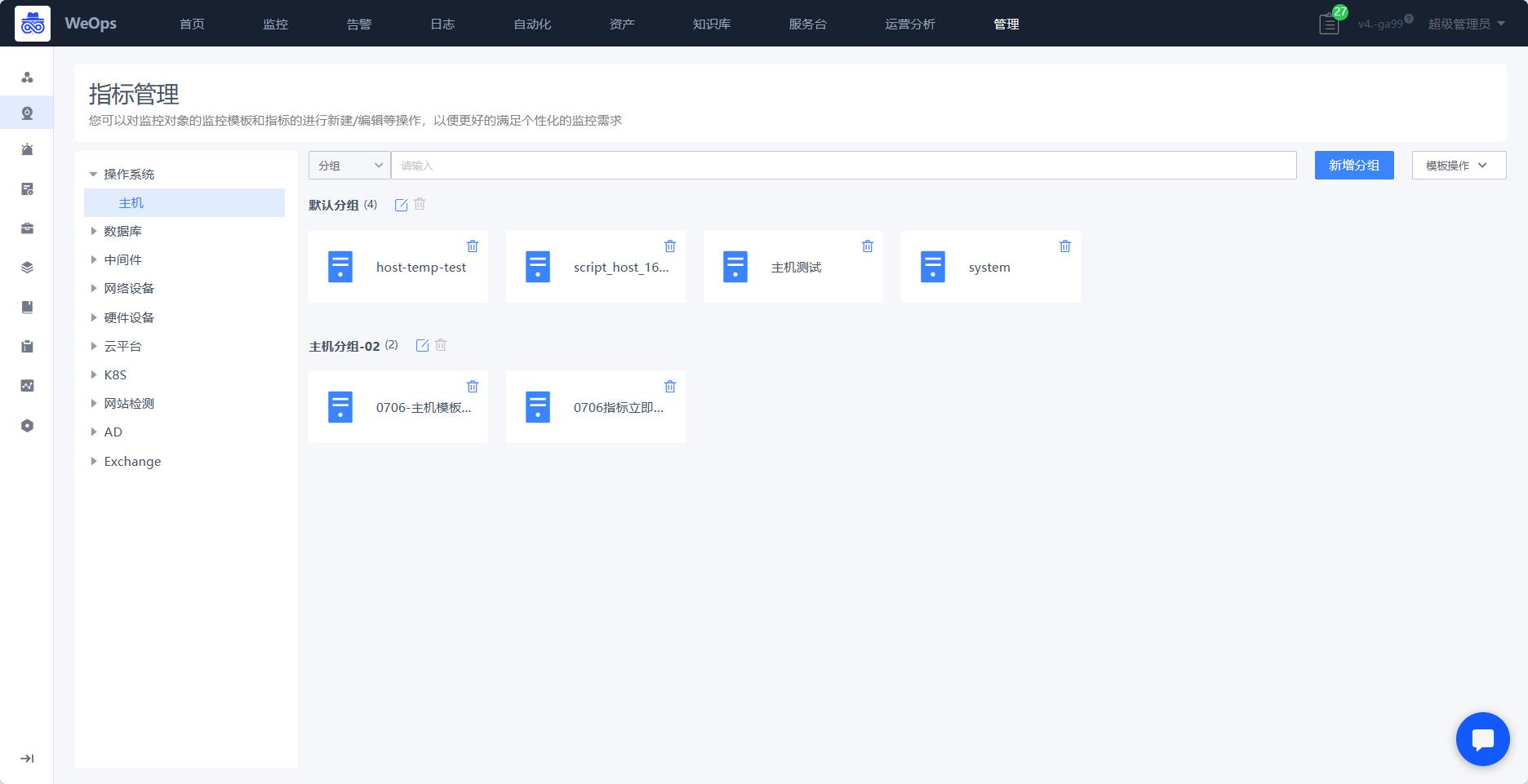

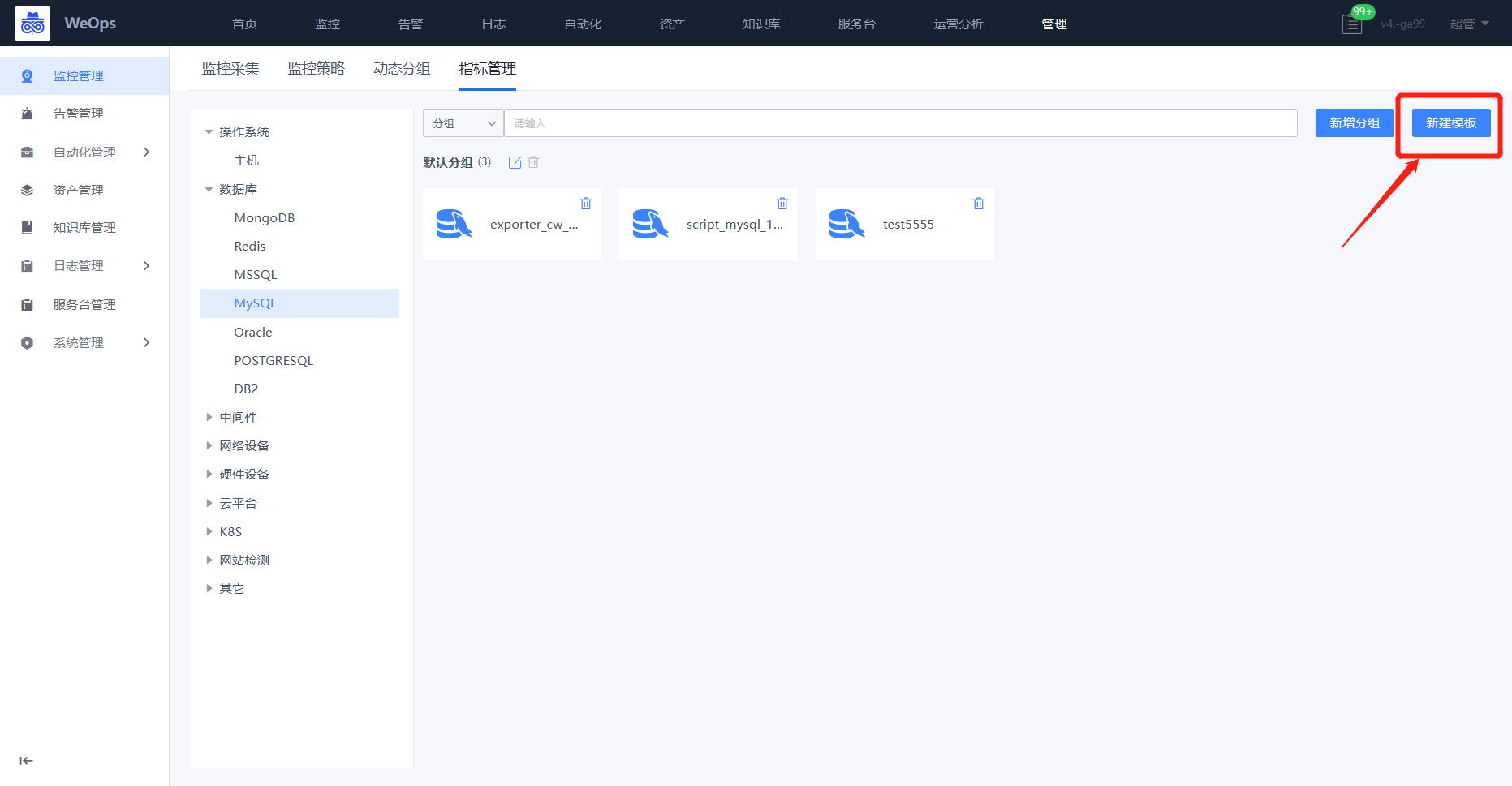

指标管理

- 对主机、数据库、中间件等各类对象的指标进行管理,可设置指标分组,可设置关键指标,支持对指标的阈值和描述进行修改。

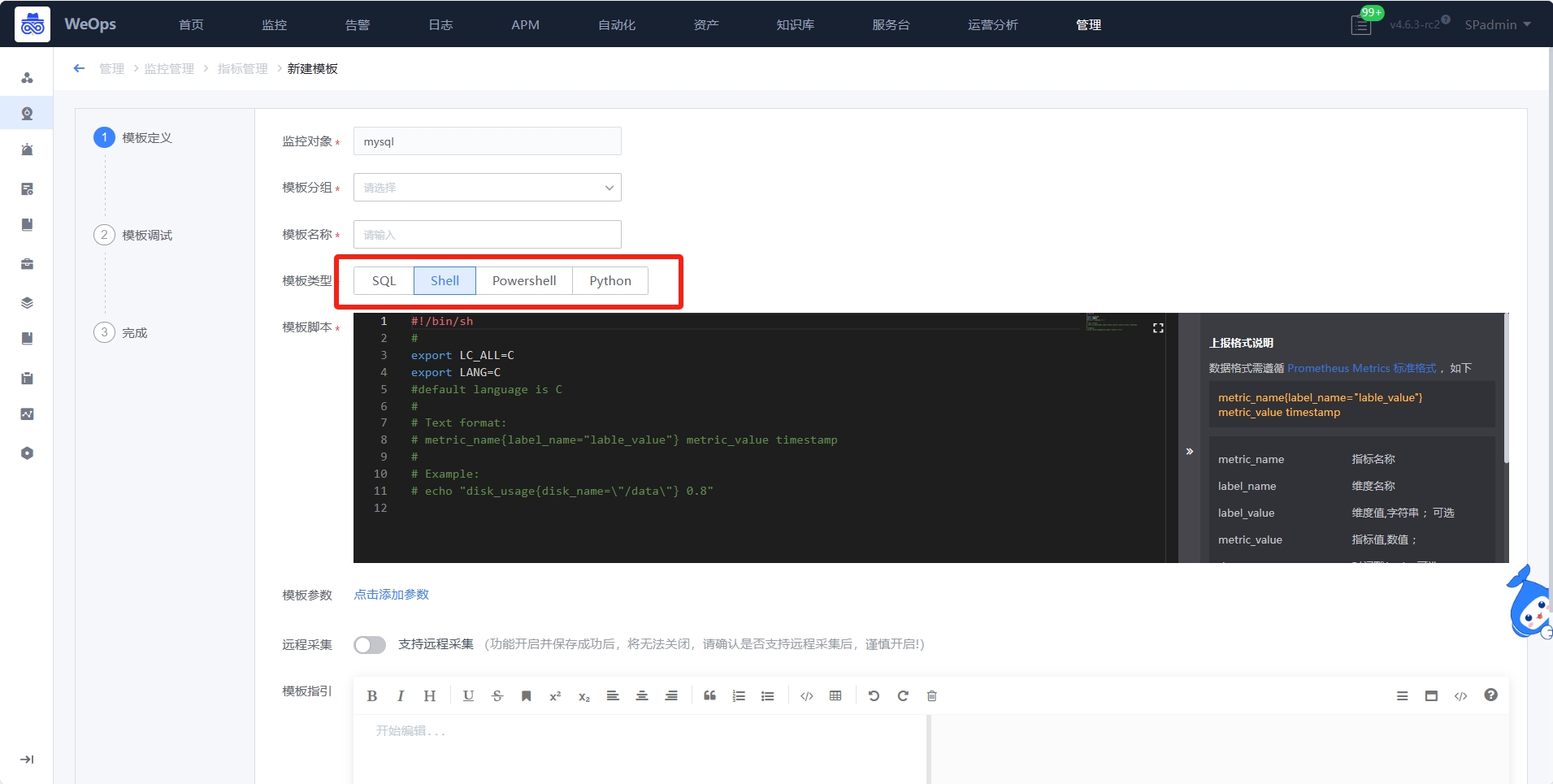

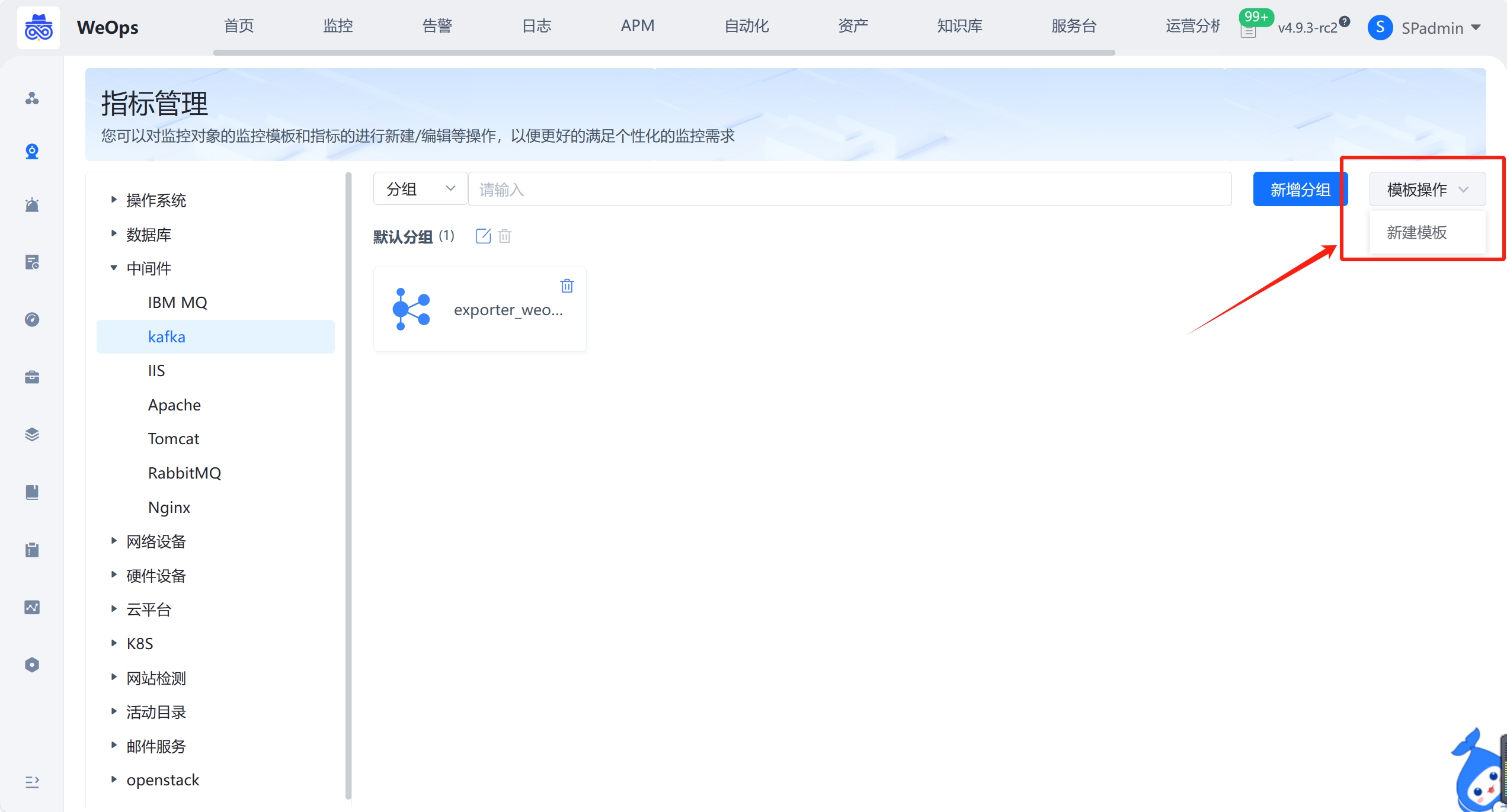

指标管理允许某些对象自定义新建监控模板,如下图,数据库支持SQL、shell和powershell、python类型的自定义监控插件;主机和中间件支持shell和powershell类型的自定义监控插件;网络设备和硬件设备支持snmp协议的自定义监控插件,若内置监控监控插件不满足监控需求,可通过自定义监控模板的方式进行新建

告警管理

告警处理

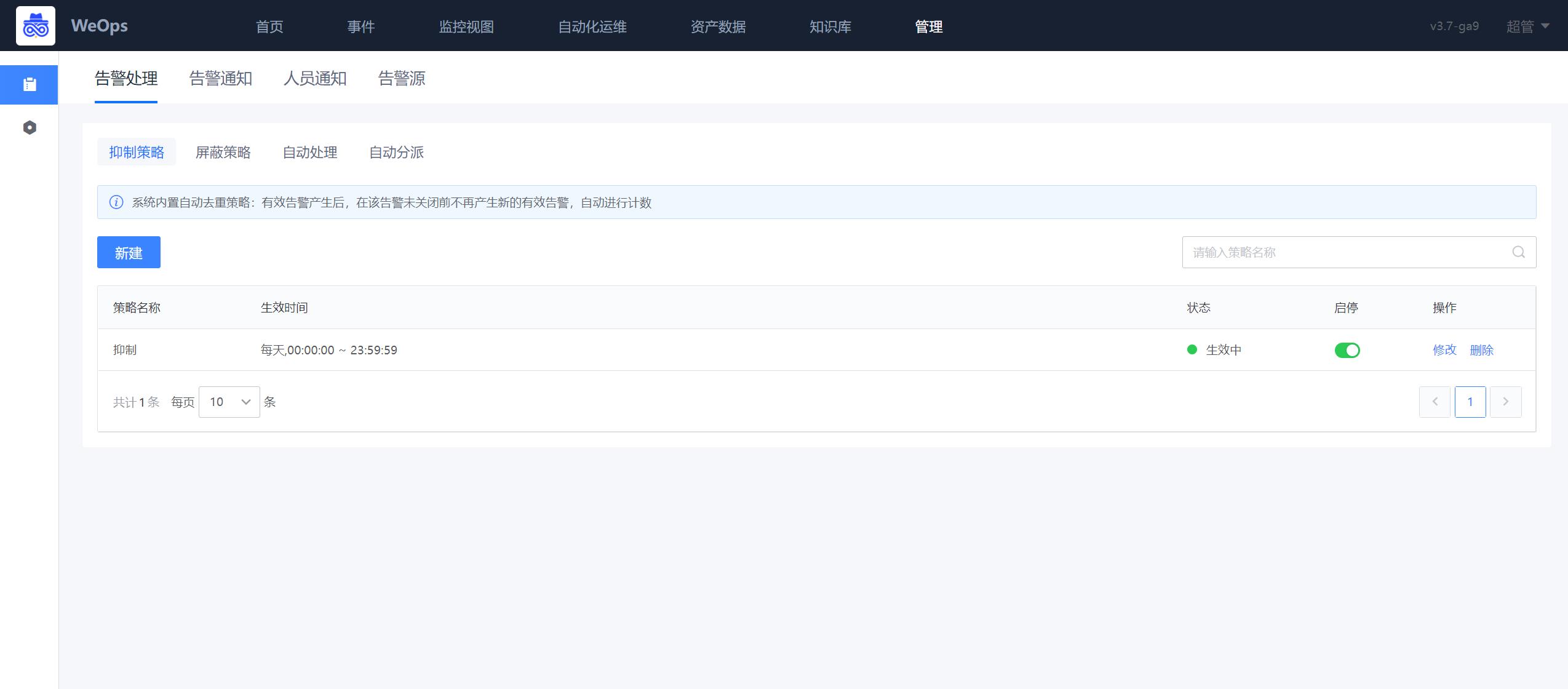

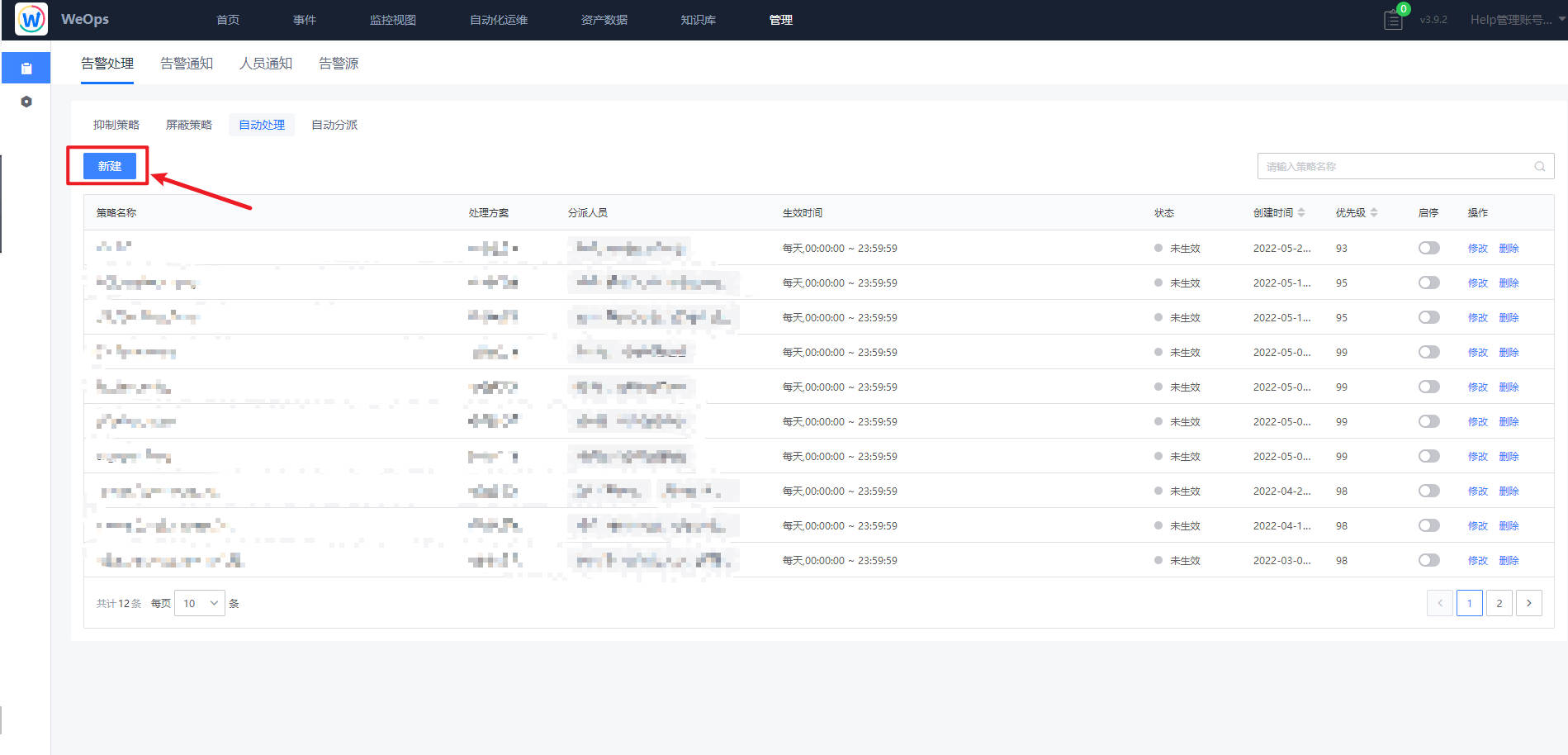

分为告警抑制、屏蔽策略、自动处理、自动分派,分别可以设置不同情况下告警的产生、通知的策略。

告警通知

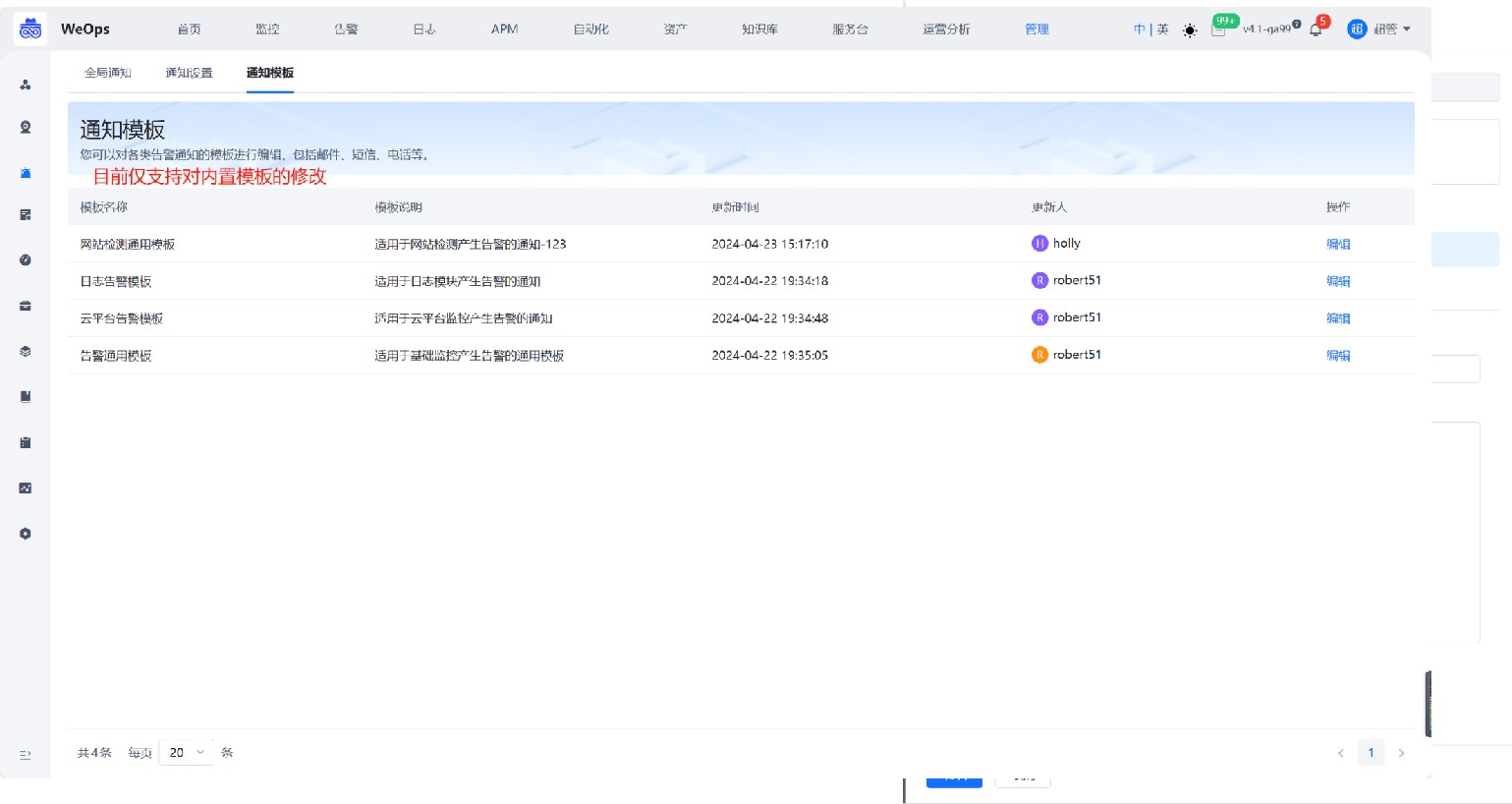

用于配置告警通知的策略,包括未响应通知策略、未分派通知策略、通知内容模板设置、用户默认通知方式等。

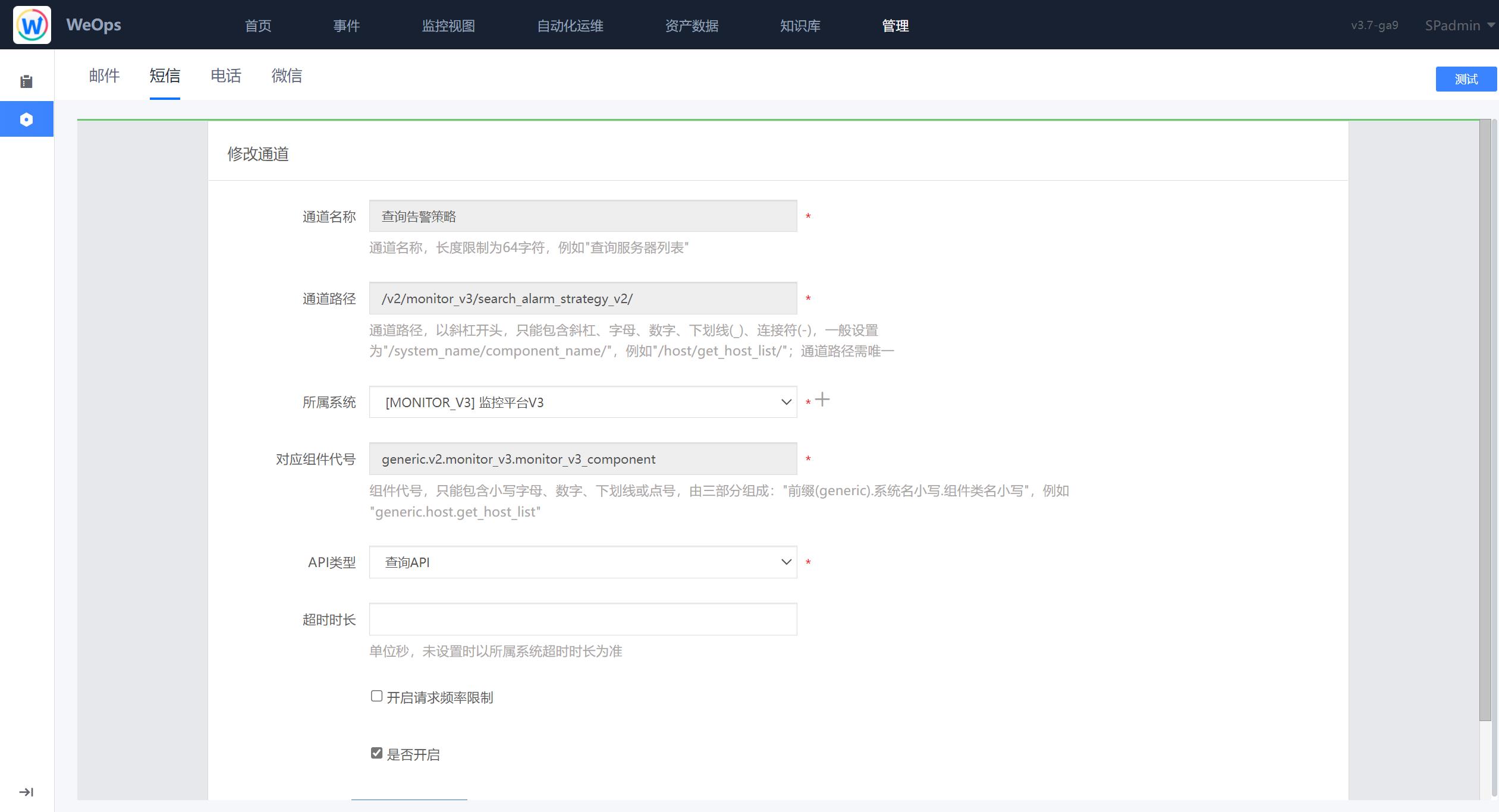

通知模板:通知渠道管理,支持自定义通知内容,支持对内置的几类模板修改,每种模板下的邮件、短信、企业微信和电话四种渠道都支持修改标题和内容

人员通知

人员通知:可针对不同的用户配置不同的通知方式。

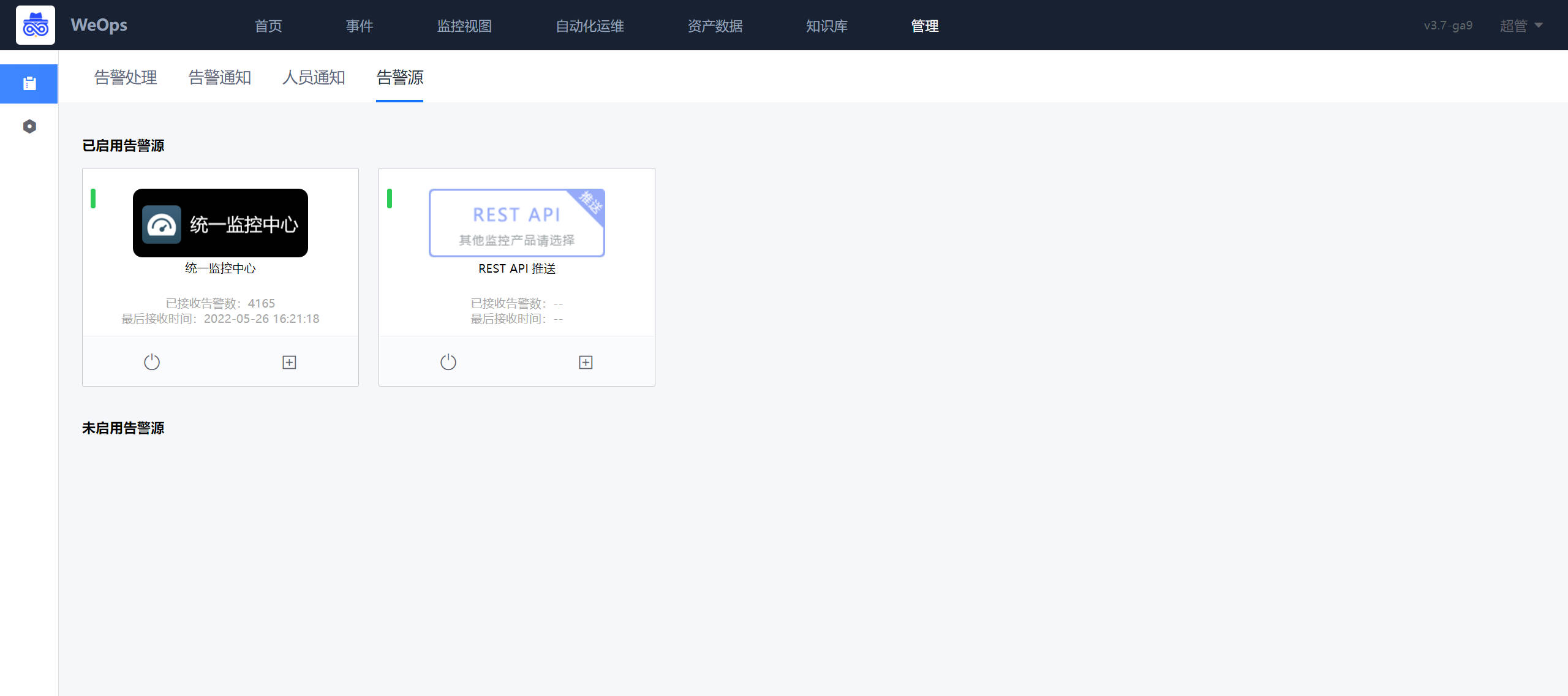

告警源

- 告警源:展示WeOps目前可以对接的告警源,可对告警源进行启用和管理。

自动化管理

WeOps的自动化管理支持运维工具的自定义,扫描包的设置,网站设备脚本模板的设置。

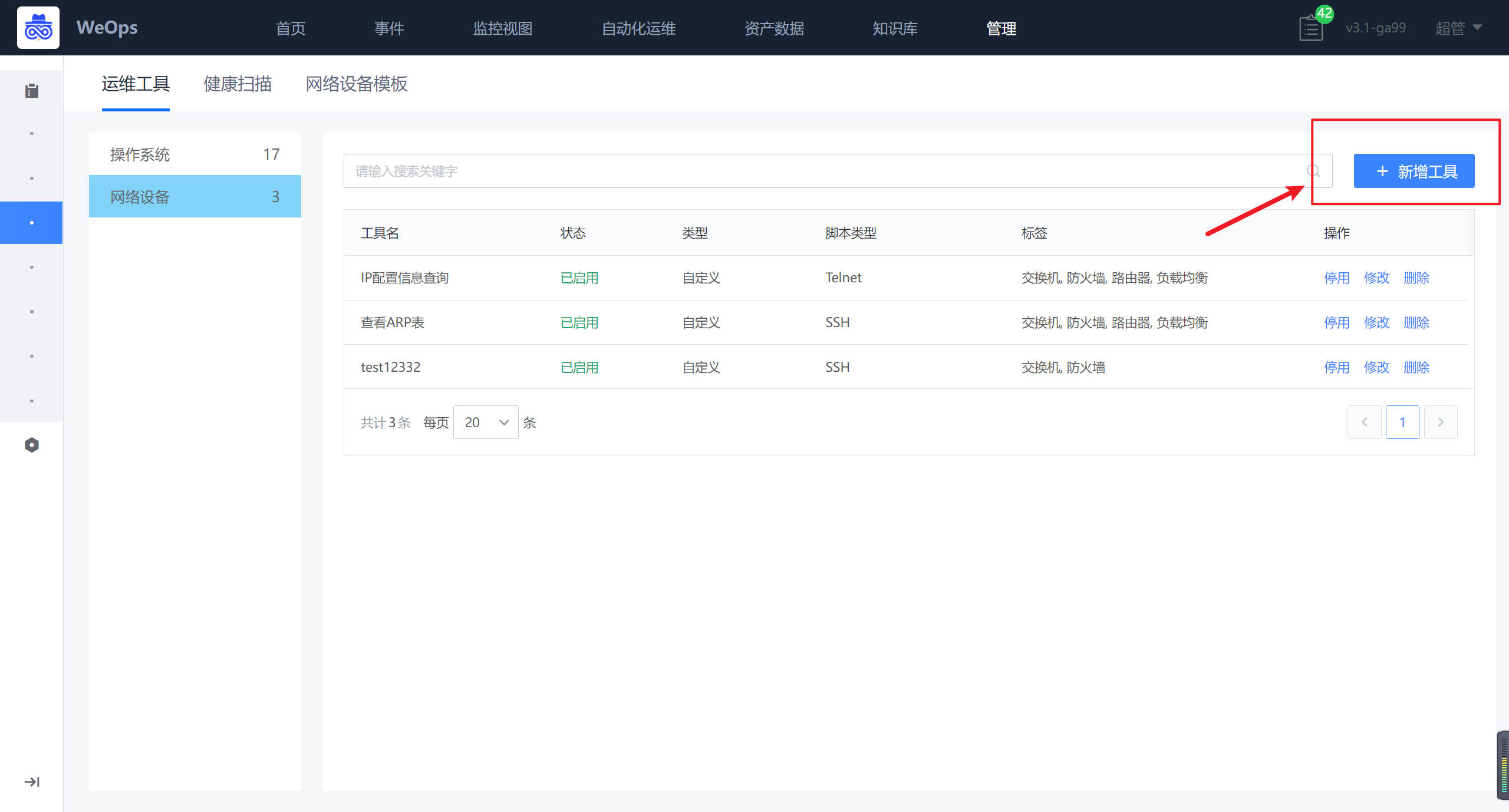

- 运维工具:对WeOps的运维工具模块进行管理,支持操作系统和网络设备两大类运维工具的新增/修改/启停/删除等操作

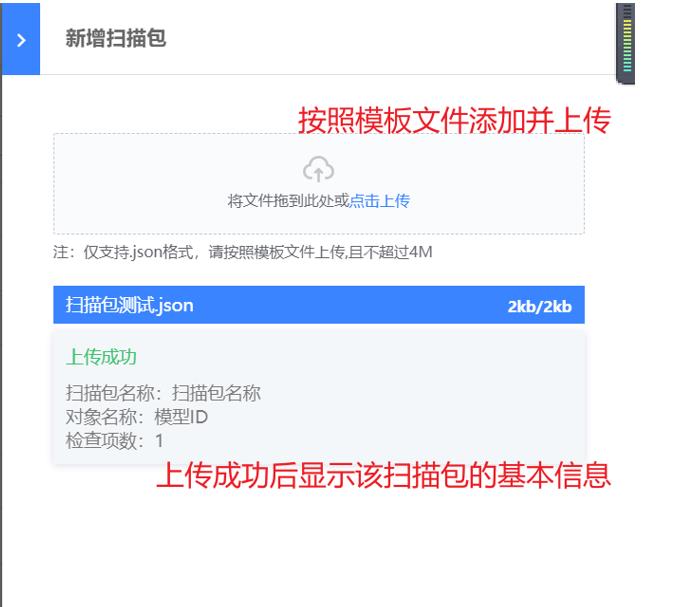

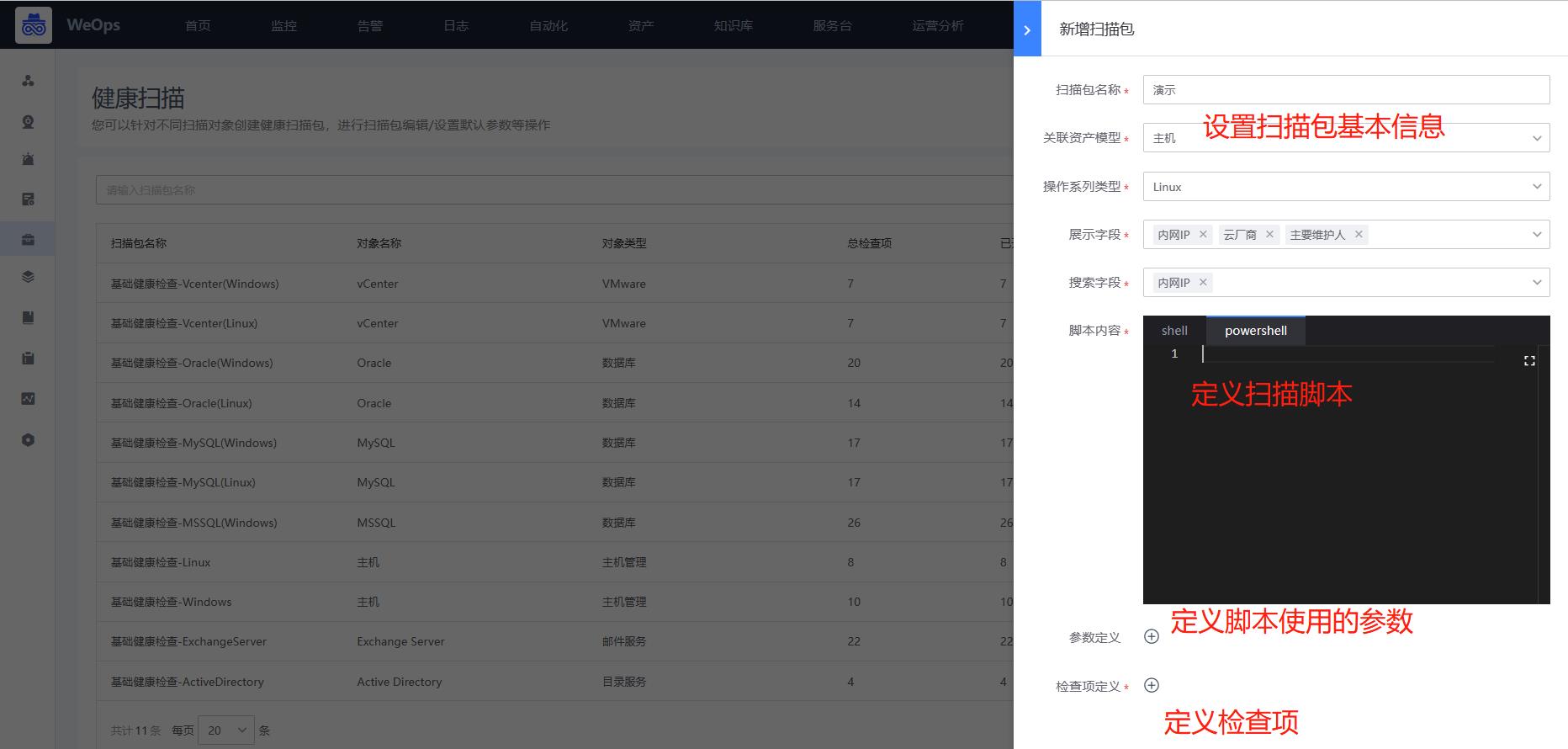

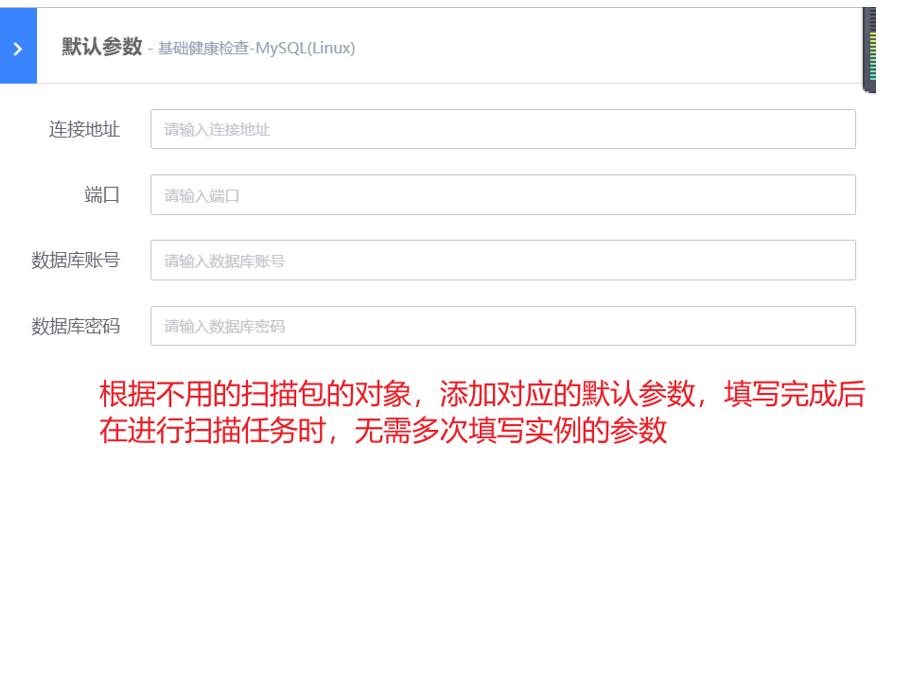

- 健康扫描:对WeOps健康扫描中的扫描包进行管理,包括以下操作:新增扫描包、对现有的扫描包检查项进行编辑和启停、设置默认参数。

- 扫描包的自定义和使用详见《操作手册-自动化运维——健康扫描》

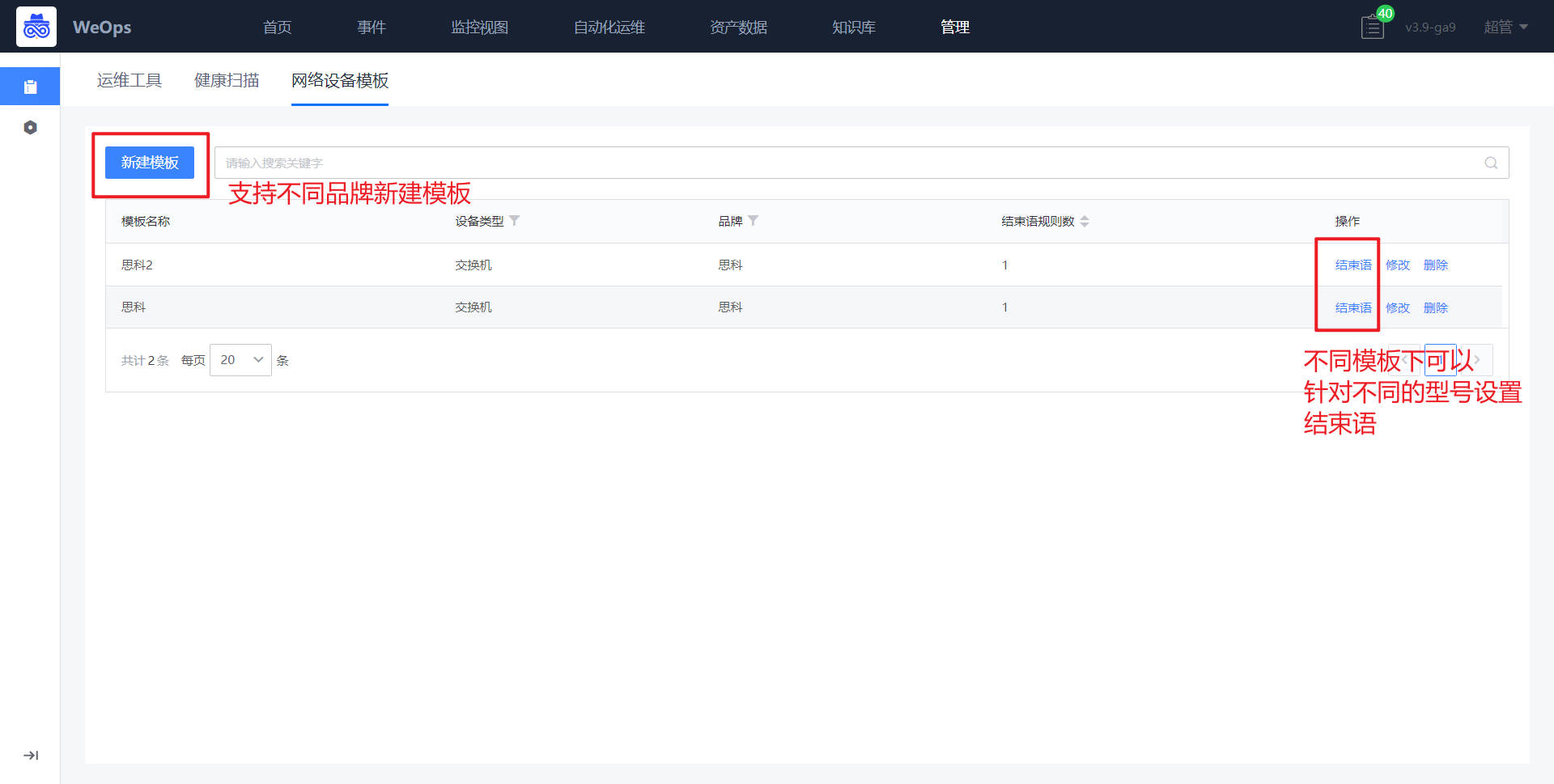

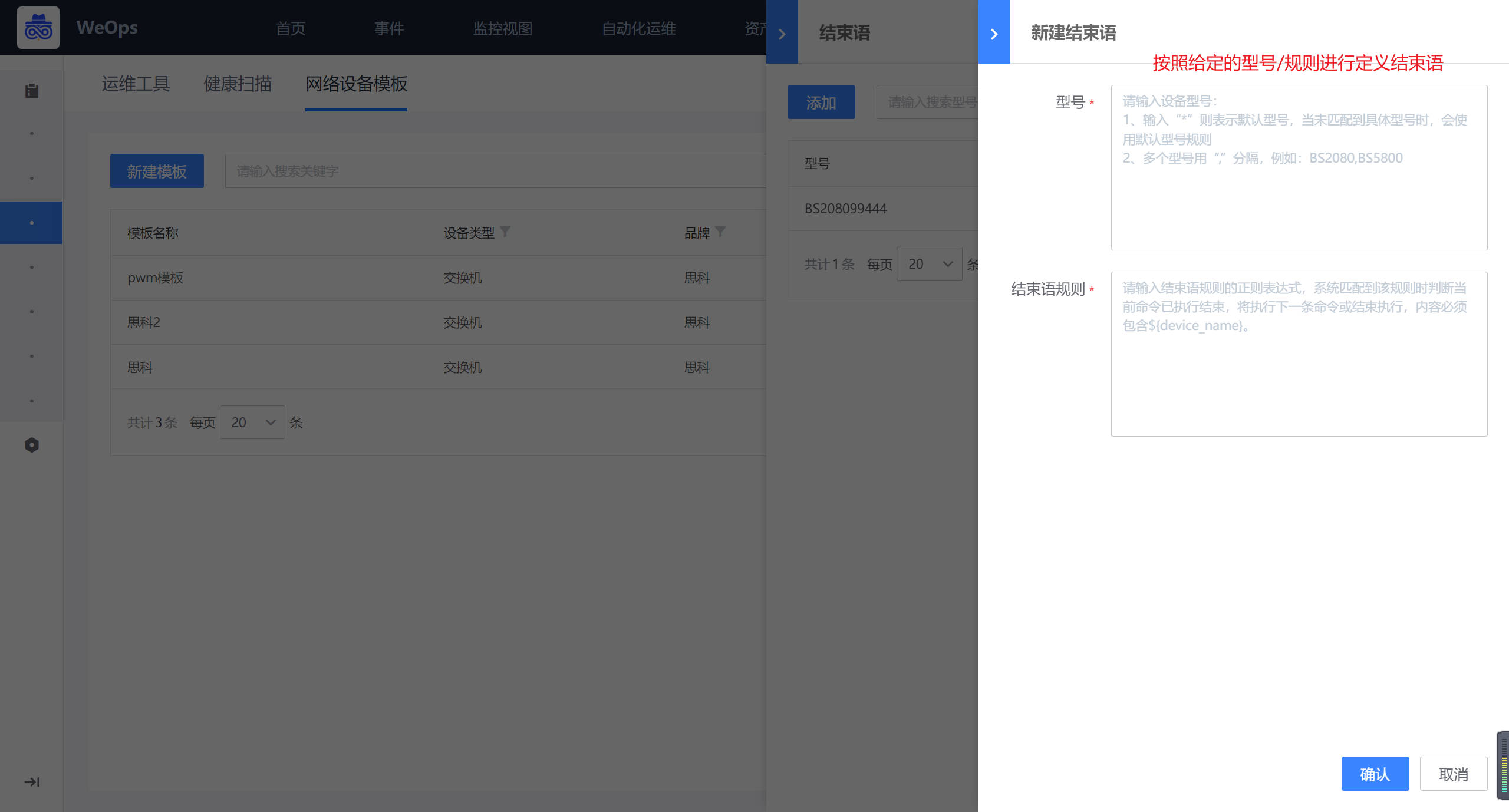

- 网络设备模板:可以针对网络设备的自动化执行设置执行结束语,支持思科/新华三/华为常用品牌

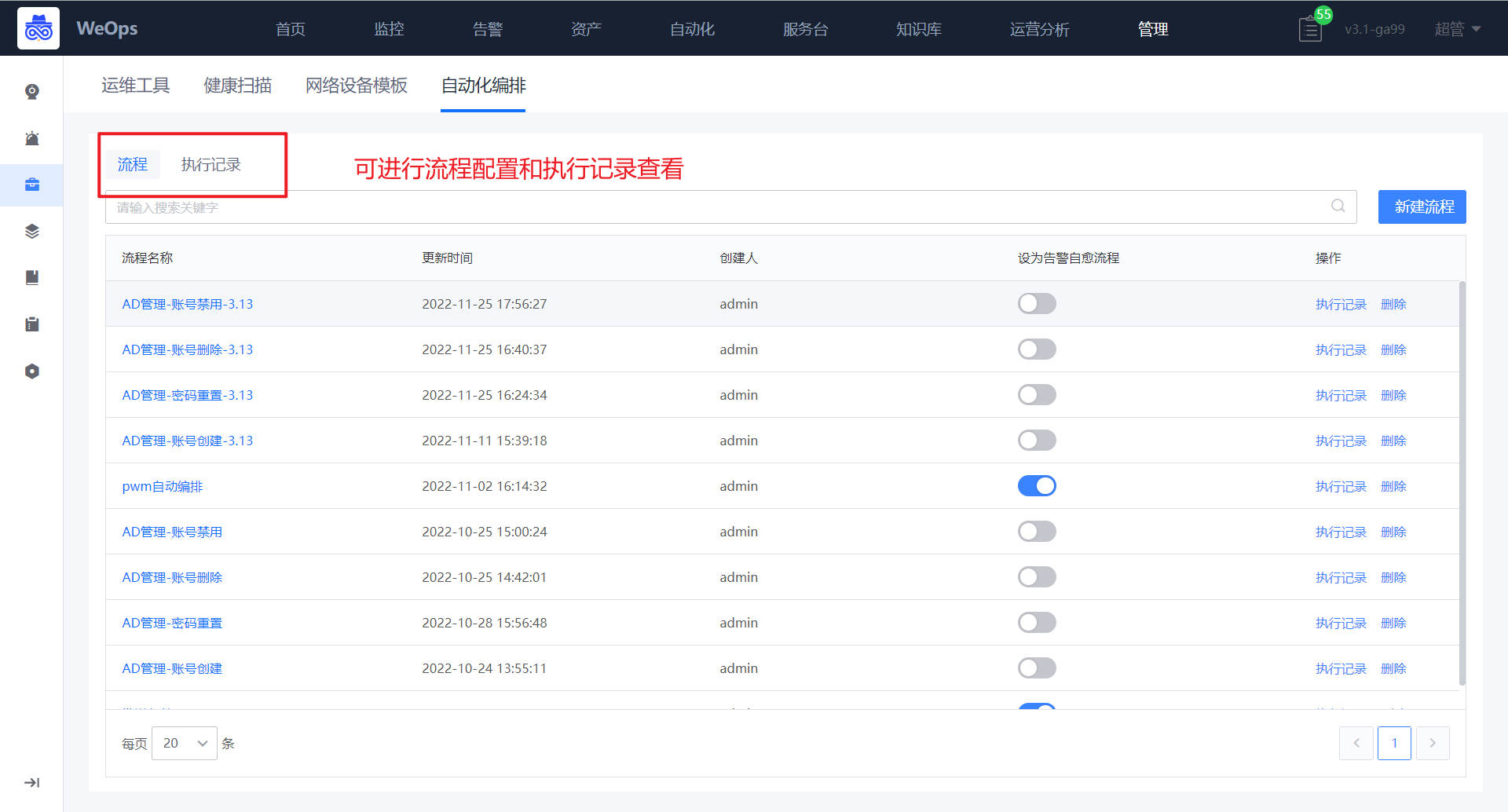

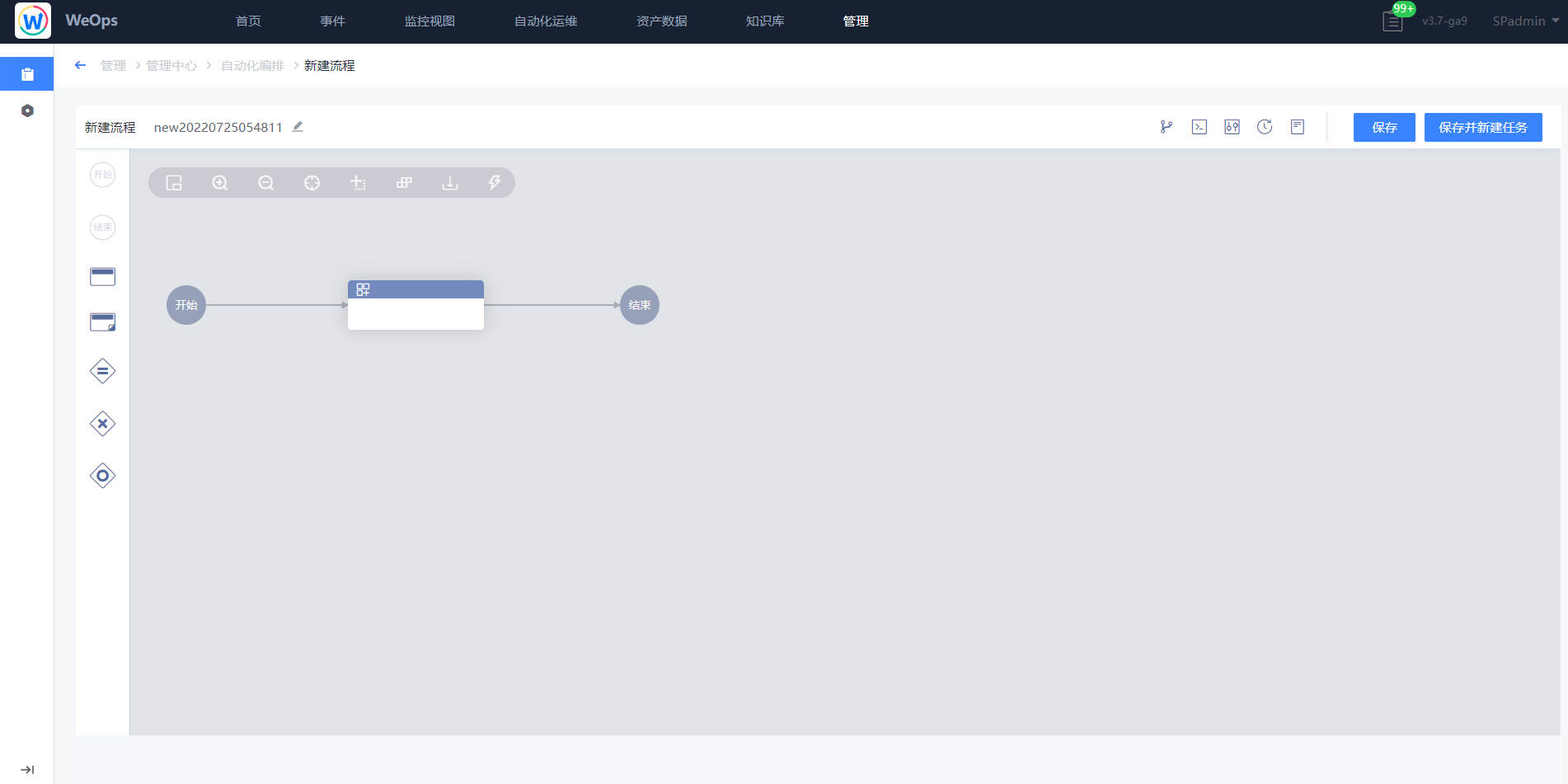

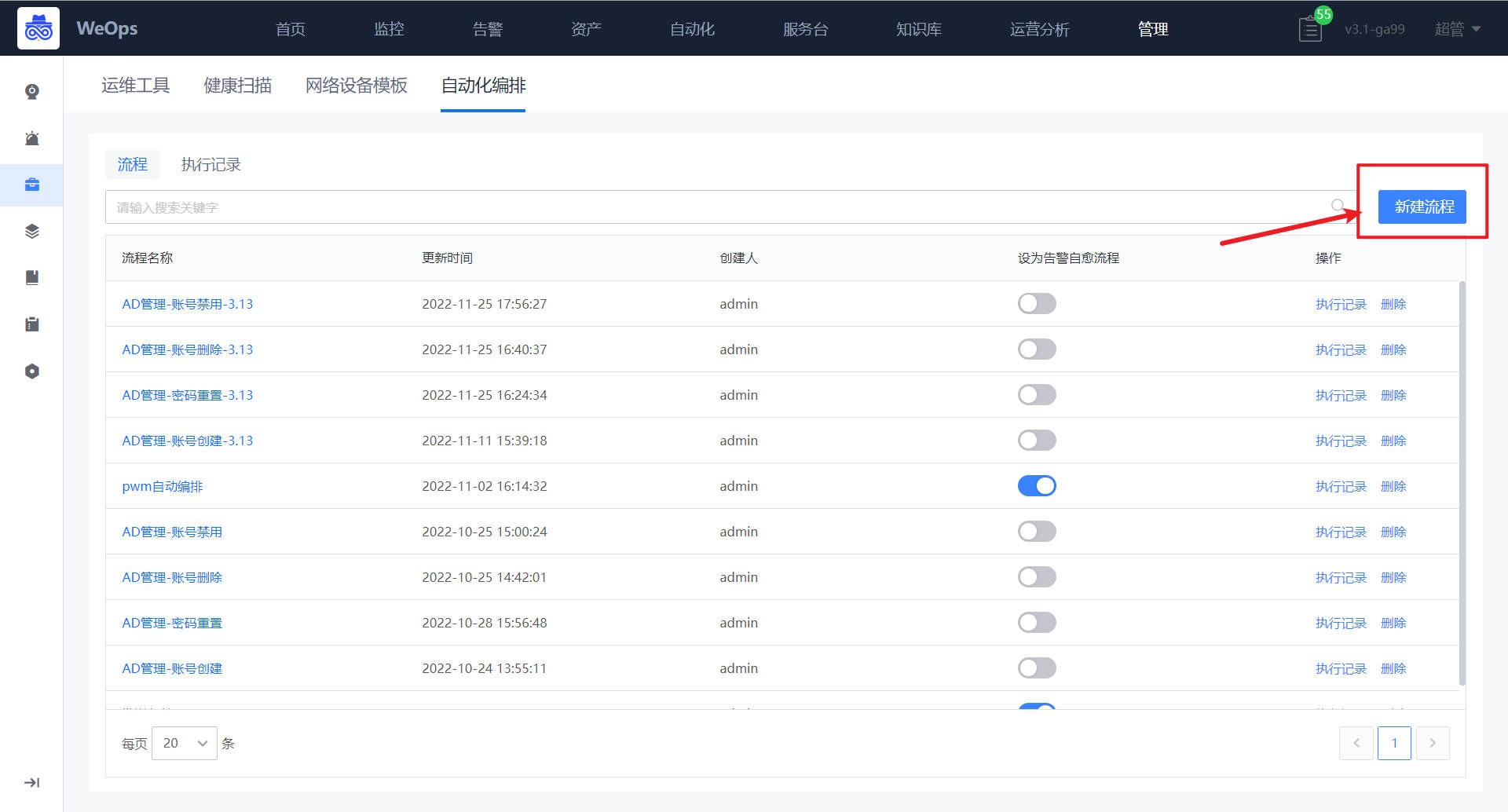

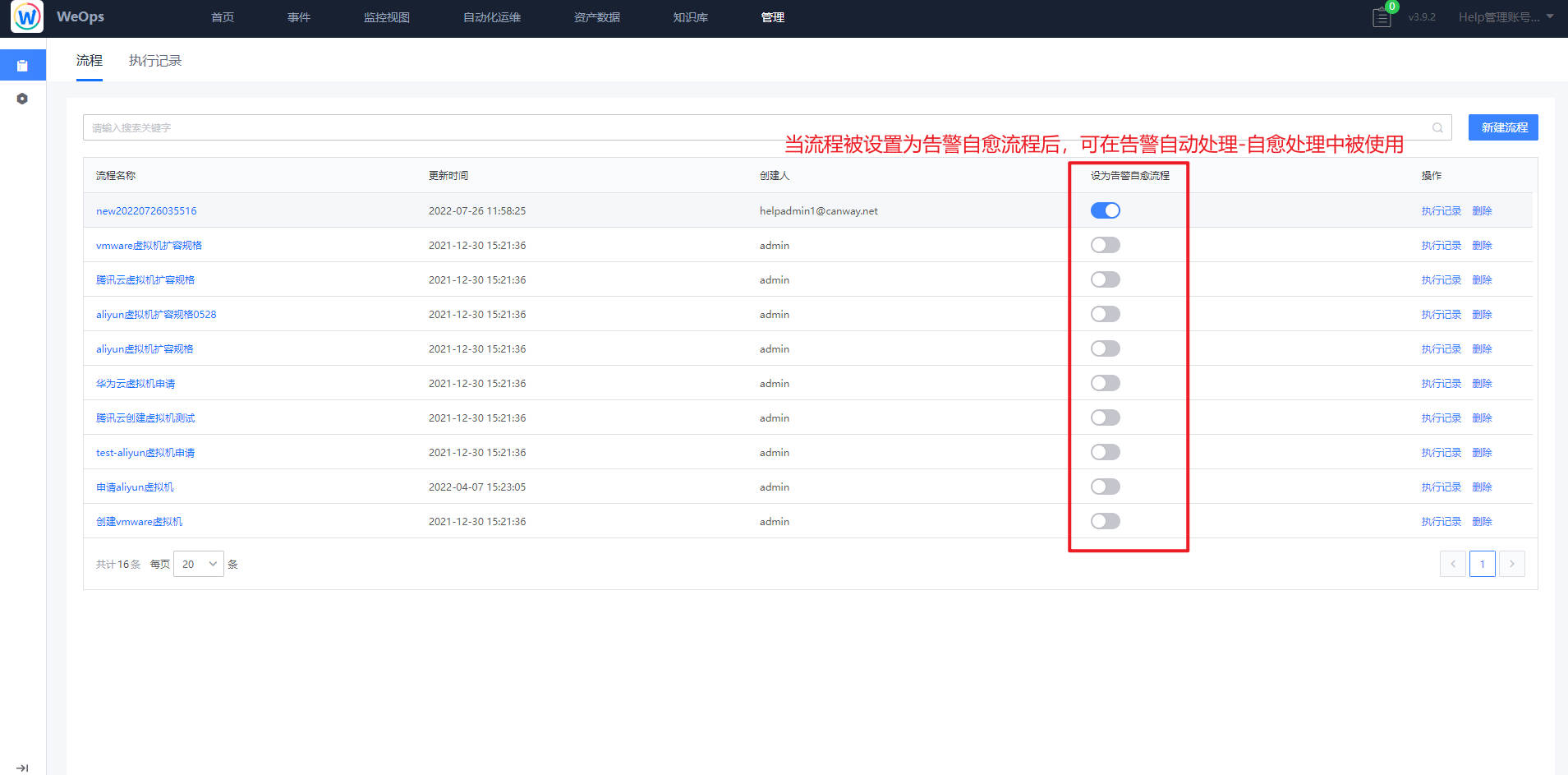

- 自动化编排:流程页面展示了所有的流程列表,支持搜索、新建流程、编辑流程、预览流程、设置“告警自愈流程”、查看执行历史、删除等操作。

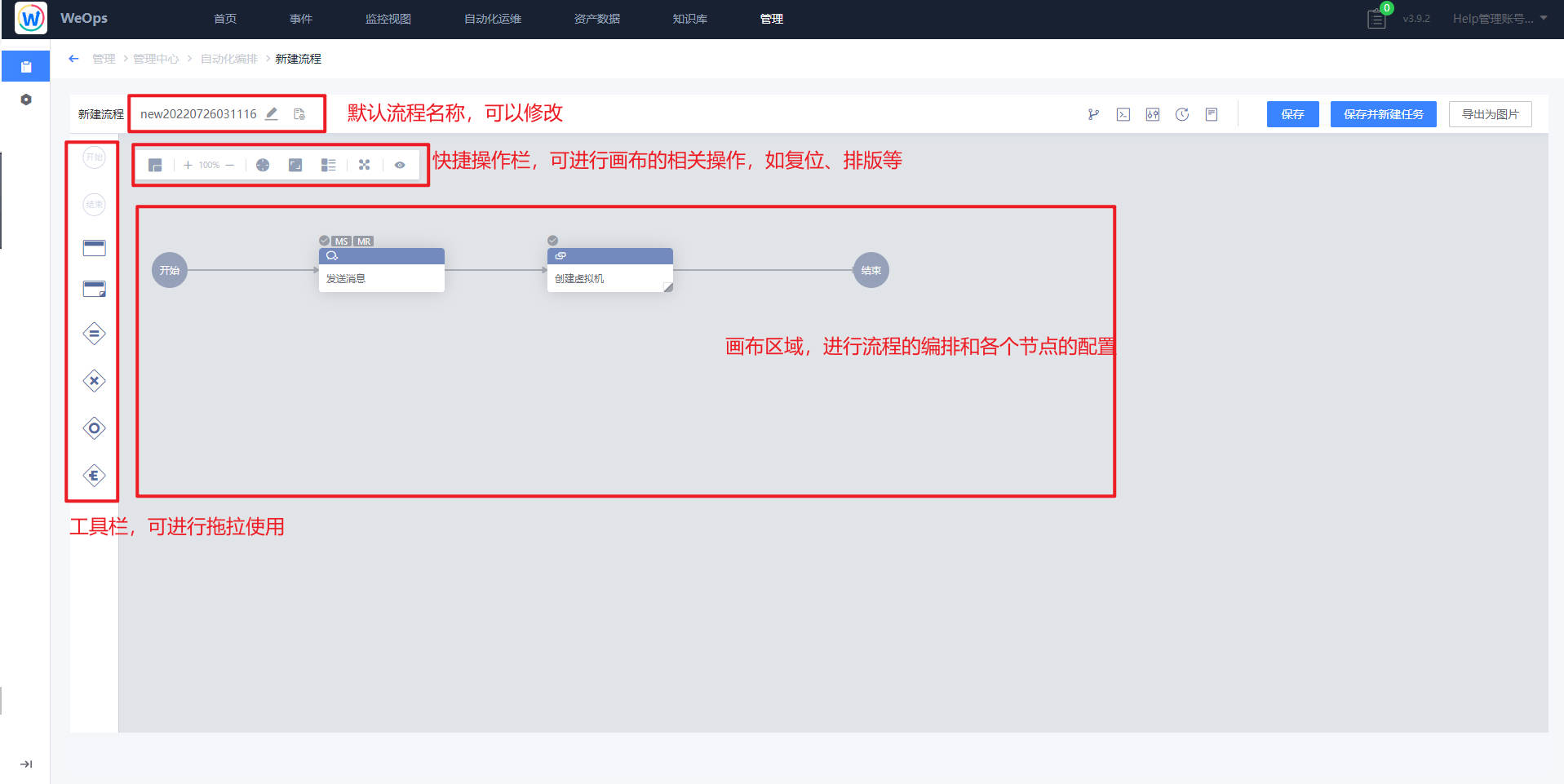

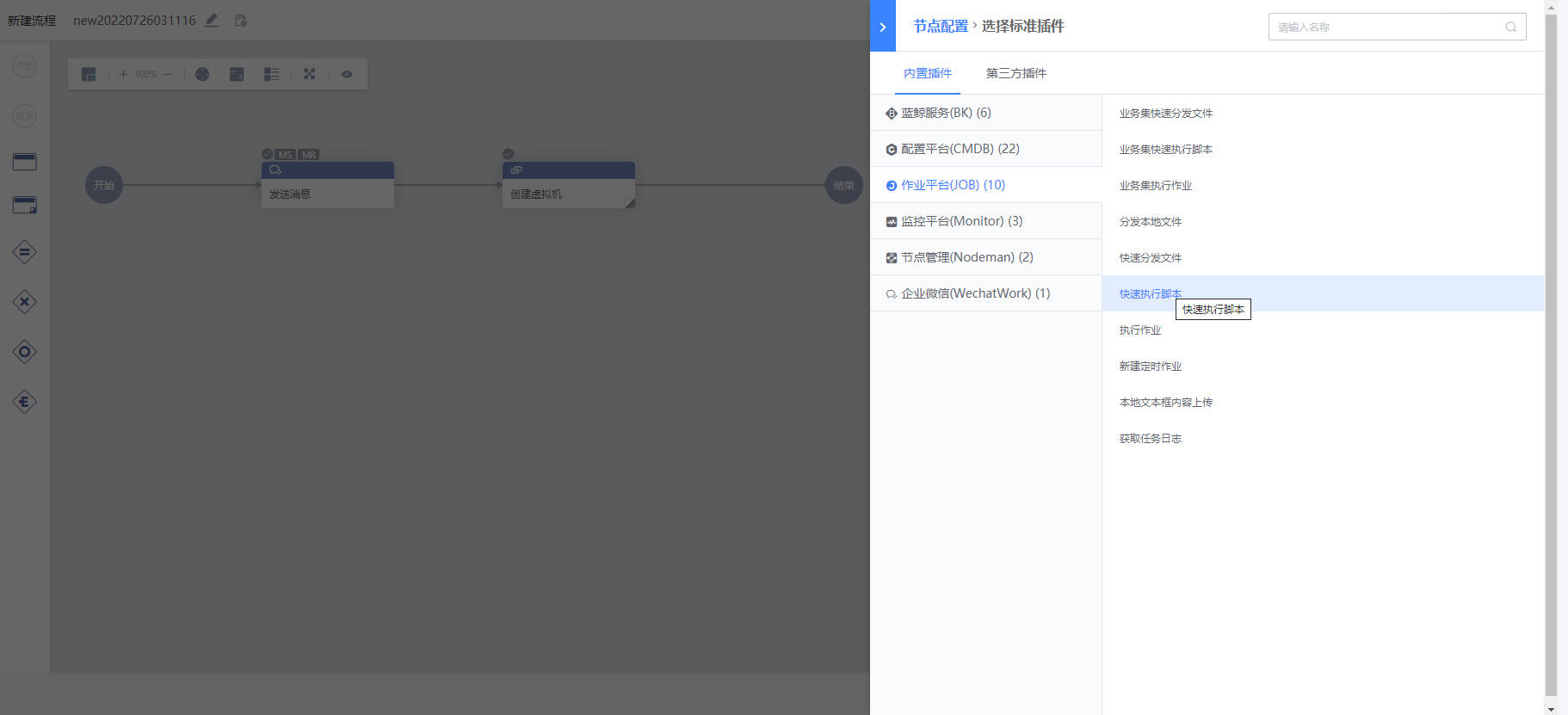

- 可视化任务流程配置。新建流程时,用户可以通过图形界面进行任务流程编排。在编排页面,用户可以通过左侧的工具栏来添加节点

- 任务历史可追溯,用户在任务记录页面,可以追溯之前的任务执行情况,可以对历史记录进行搜索,查看详情等操作。

资产管理

资产管理包括“资产模型管理”、“自动发现preview”、OID库、数据关联

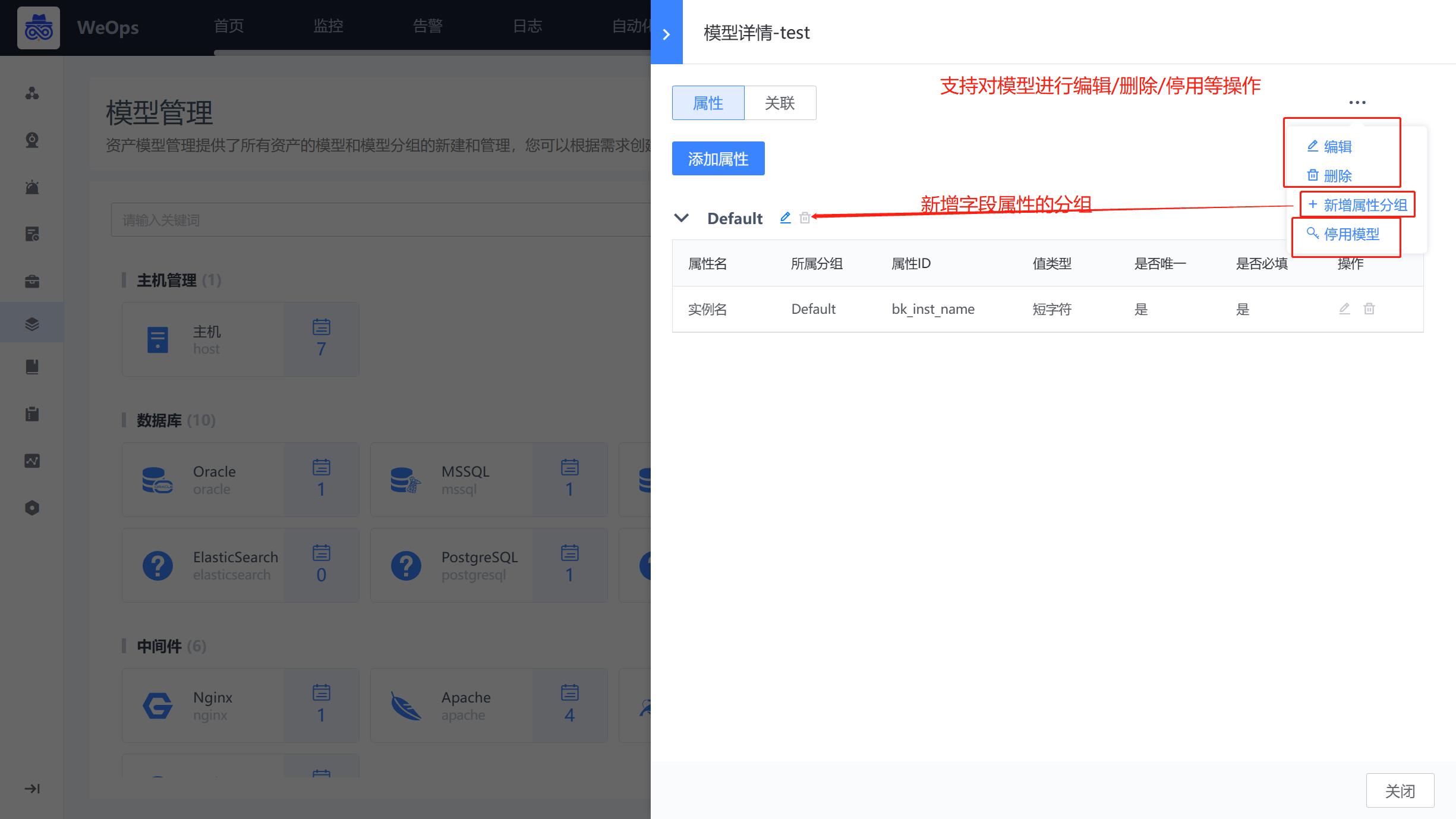

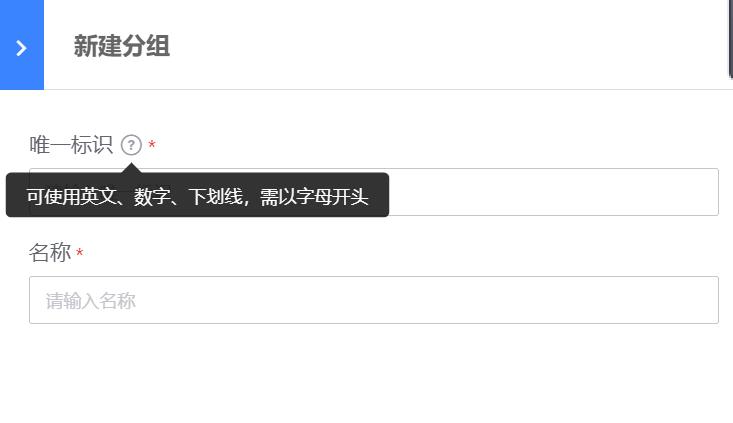

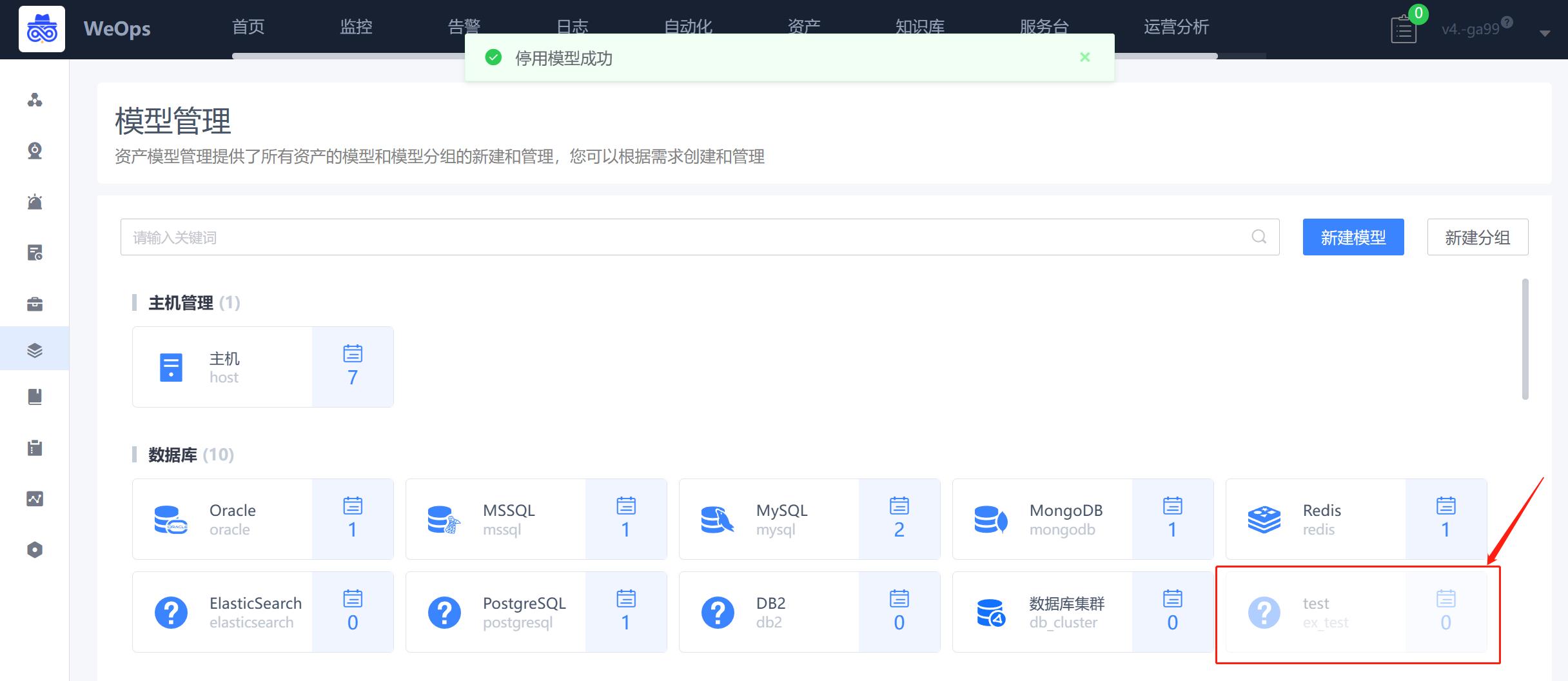

模型管理

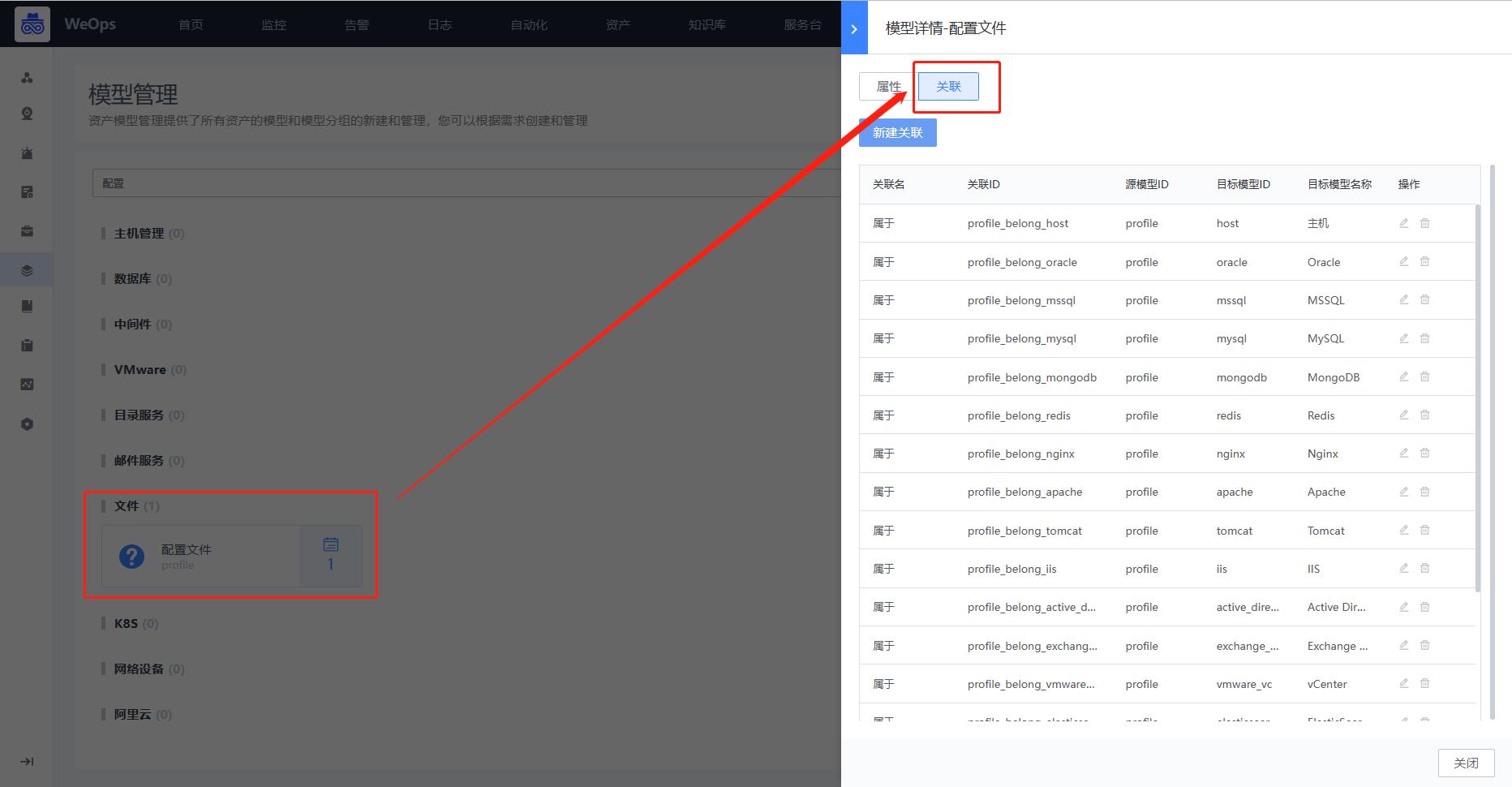

- 资产模型管理提供了WeOps所有资产的模型和模型分组的新建和管理,支持以下操作:模型分组的增删改查(内置模型分组不允许删除)、模型的增删改查(内置模型分组不允许删除)、模型属性字段分组的添加、模型的属性字段的添加/编辑、模型之间关联关系的添加/编辑。

- 关于资产模型更为详细的配置和使用详见《操作手册-其他配置-资产模型配置》

资产扫描

资产扫描的场景如下:纳管层面,资产扫描是从空白到扫描出来有资产的,配合配置采集自动更新配置信息;安全层面,全量扫描不在cmdb的资产的异常ip;运营层面,扫描ip不在管理范围内的,进行ip认领或者回收

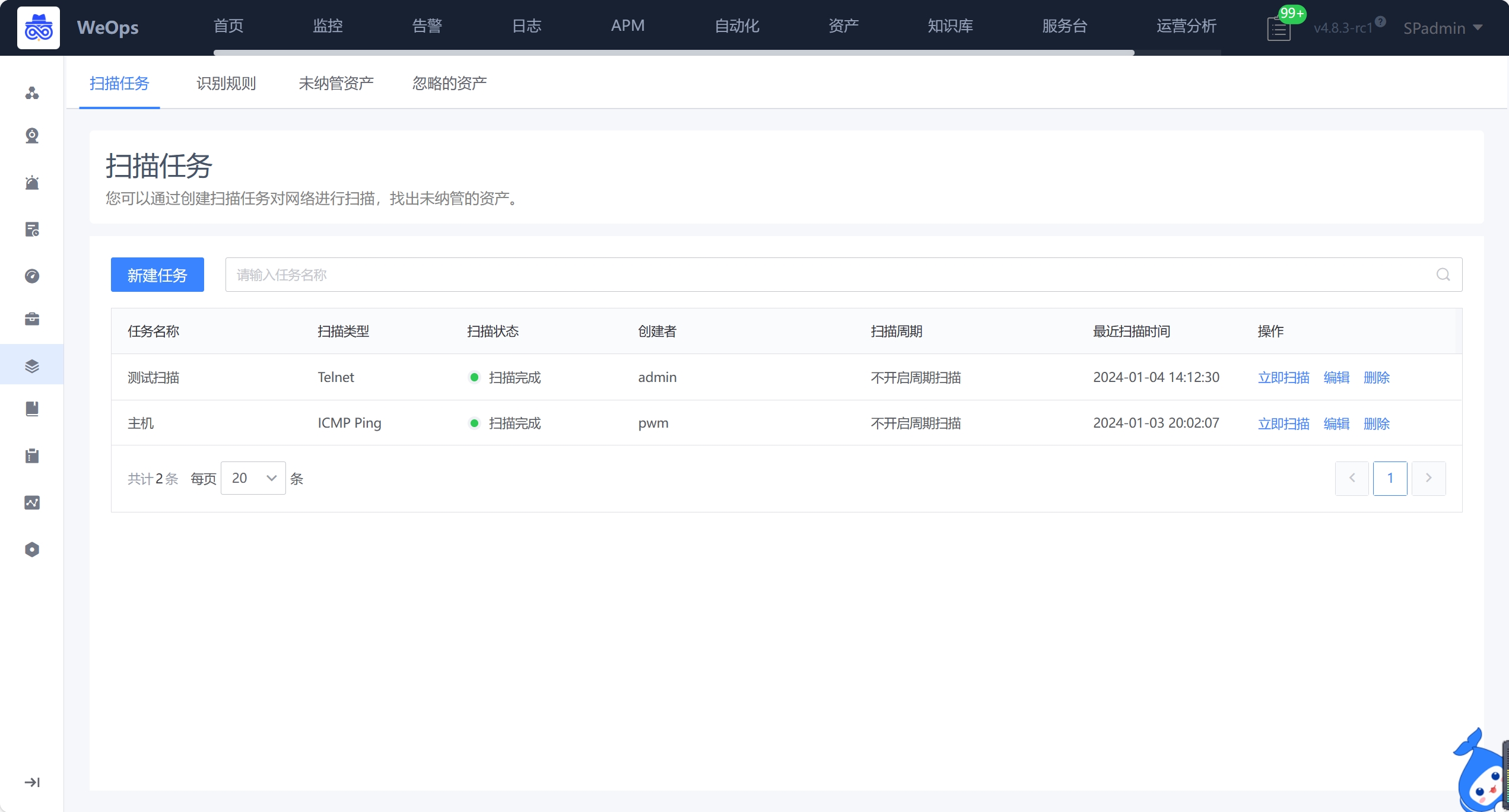

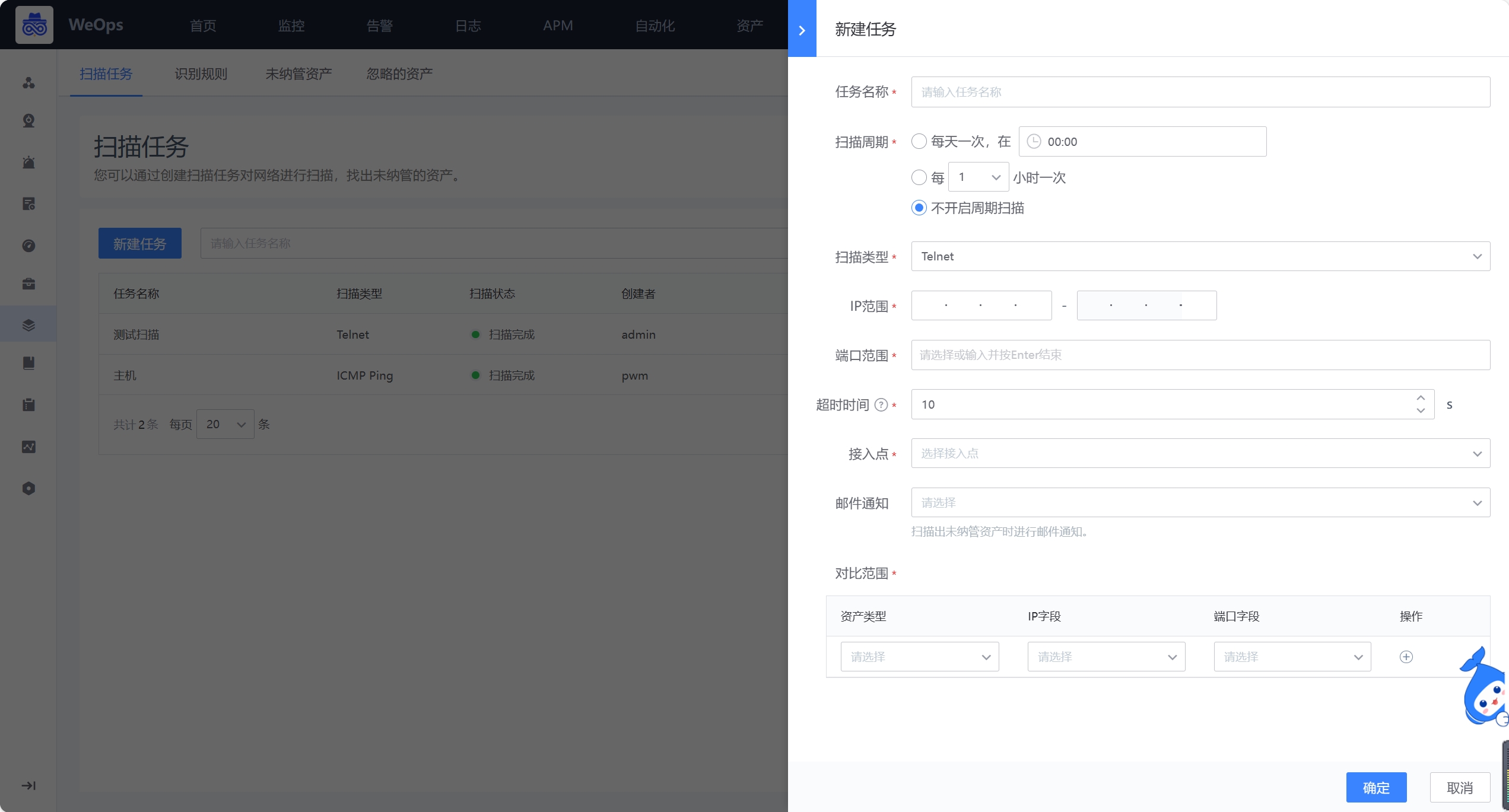

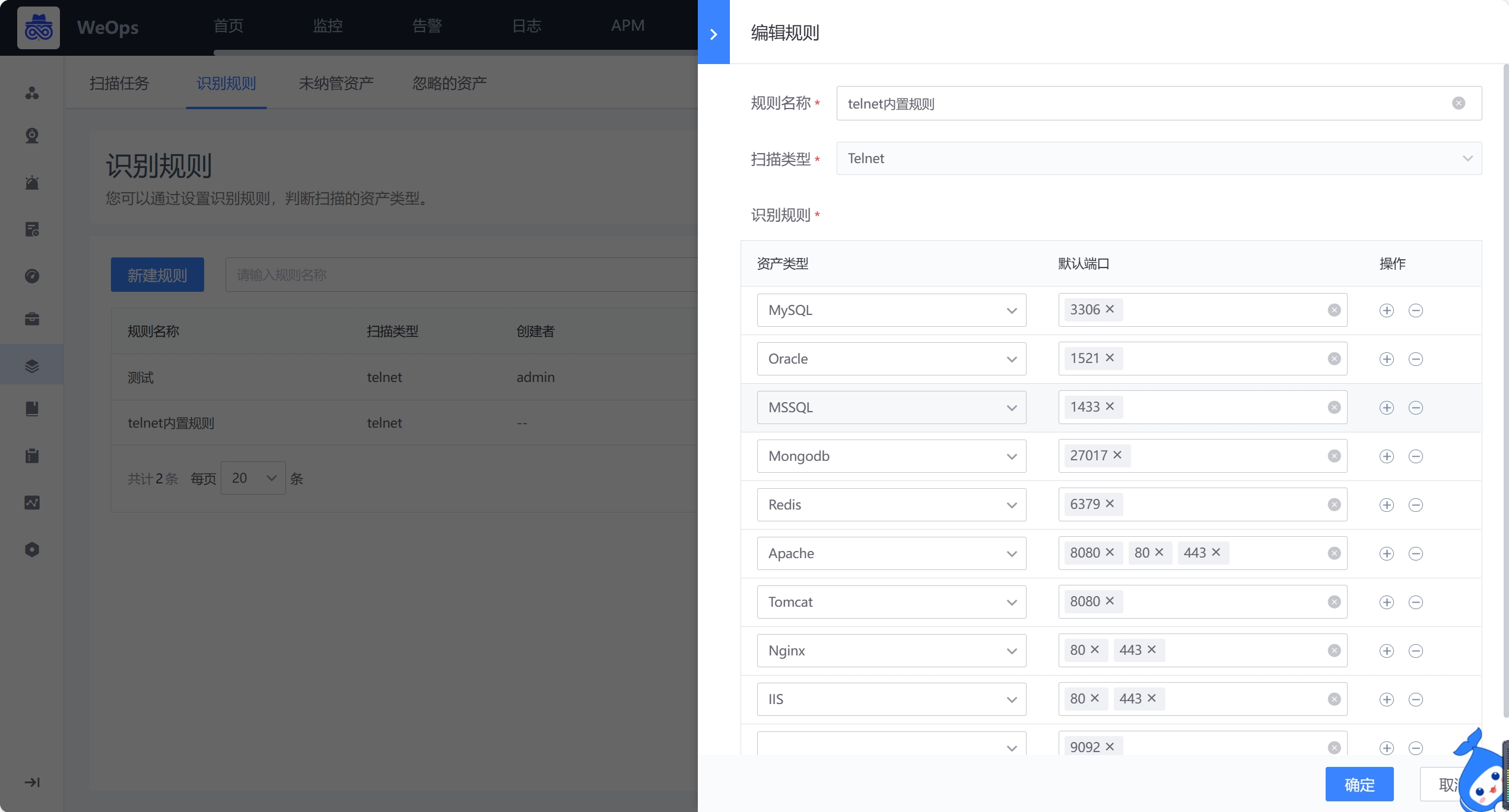

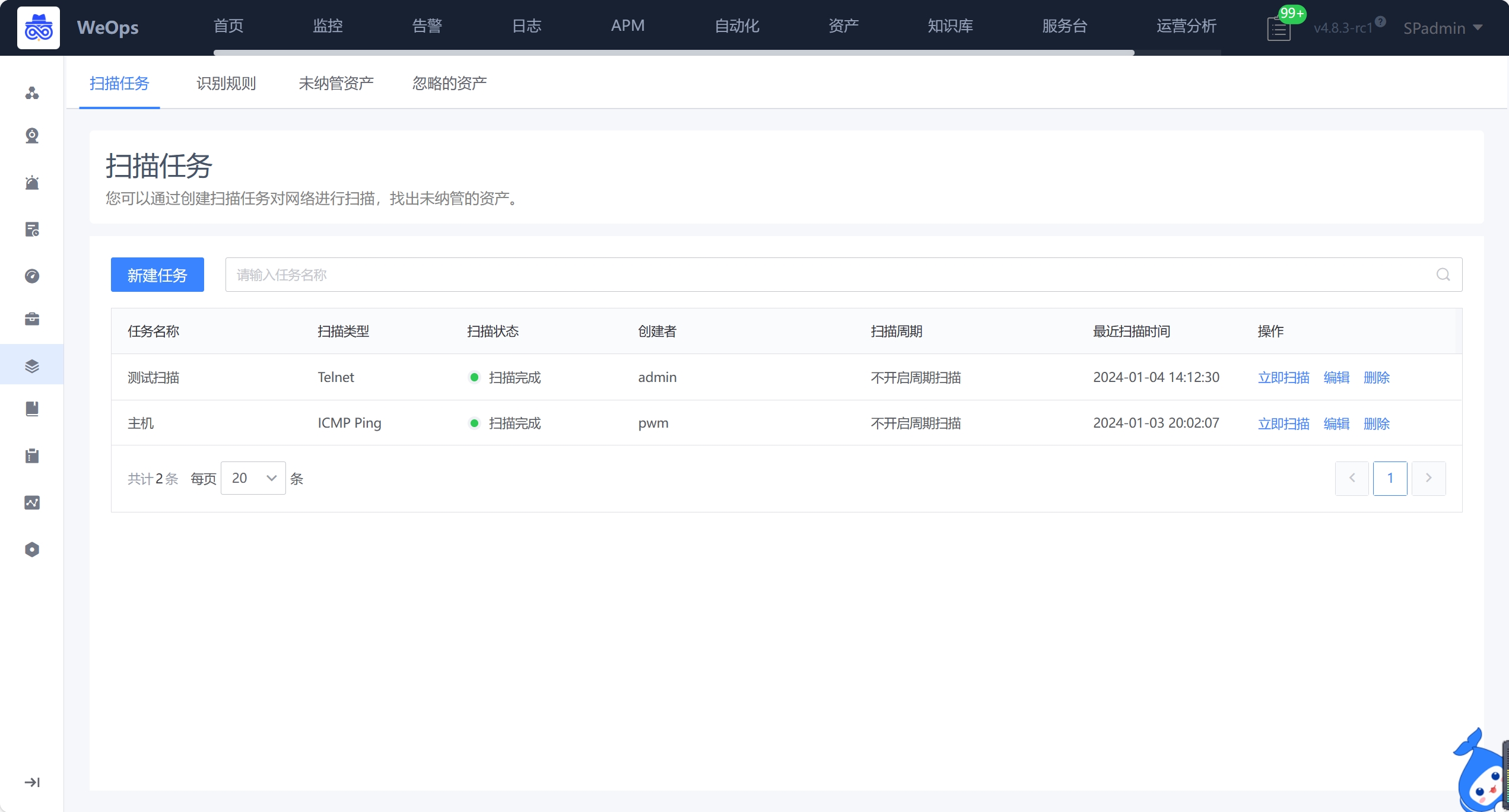

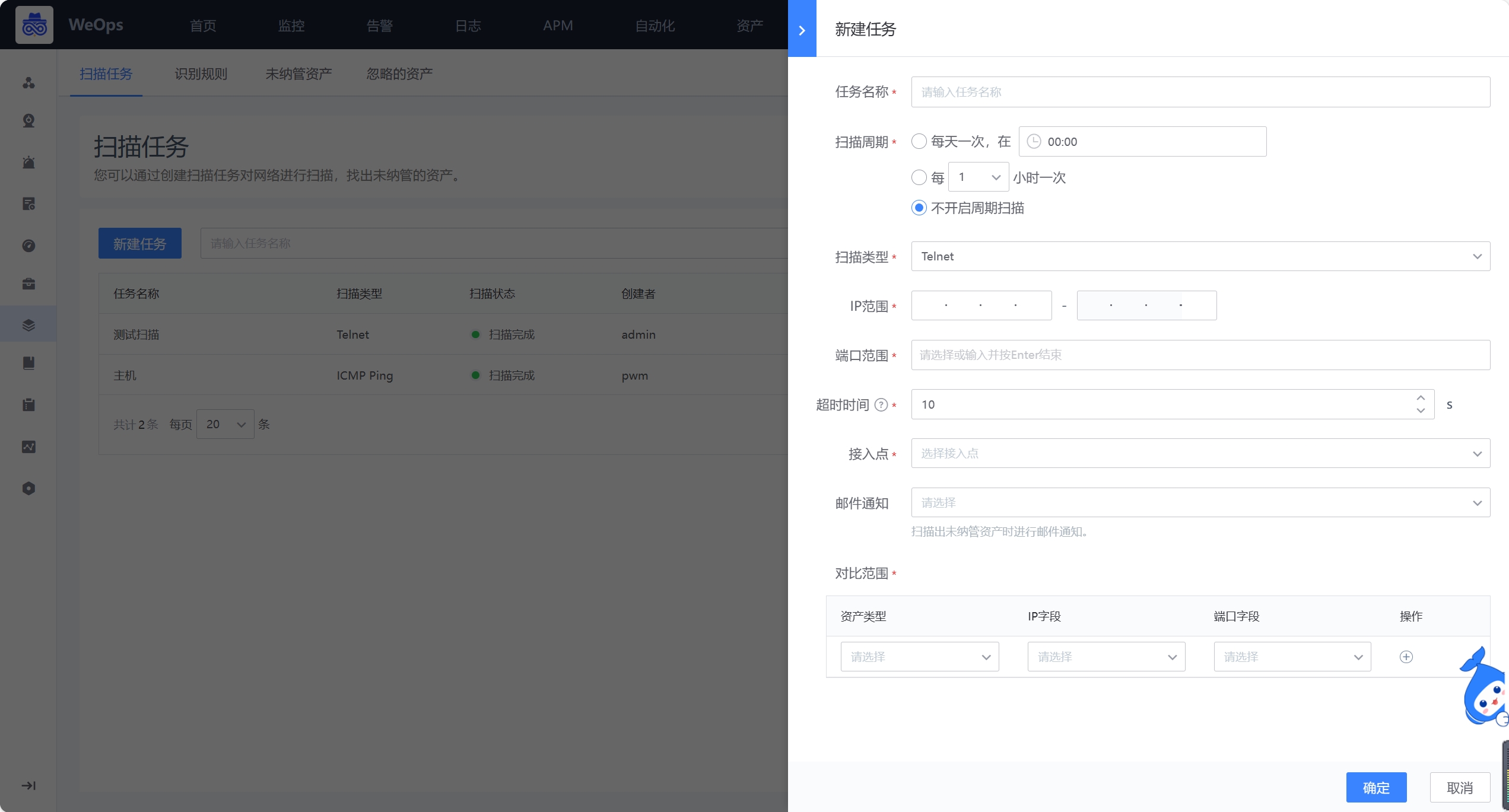

包括扫描任务的创建、识别规则、未纳管资产和忽略资产。

- 扫描任务,如下图,支持资产扫描任务的创建,可设置IP扫范围,支持ping(IP)、telnet(IP+端口)从网络中发现IT资产,支持配置CMDB的对比范围,进行对比。安装扫描的协议扫描出来的资产,会根据cmdb的资产范围进行对比,未纳管的资产,会呈现在“未纳管”列表中。

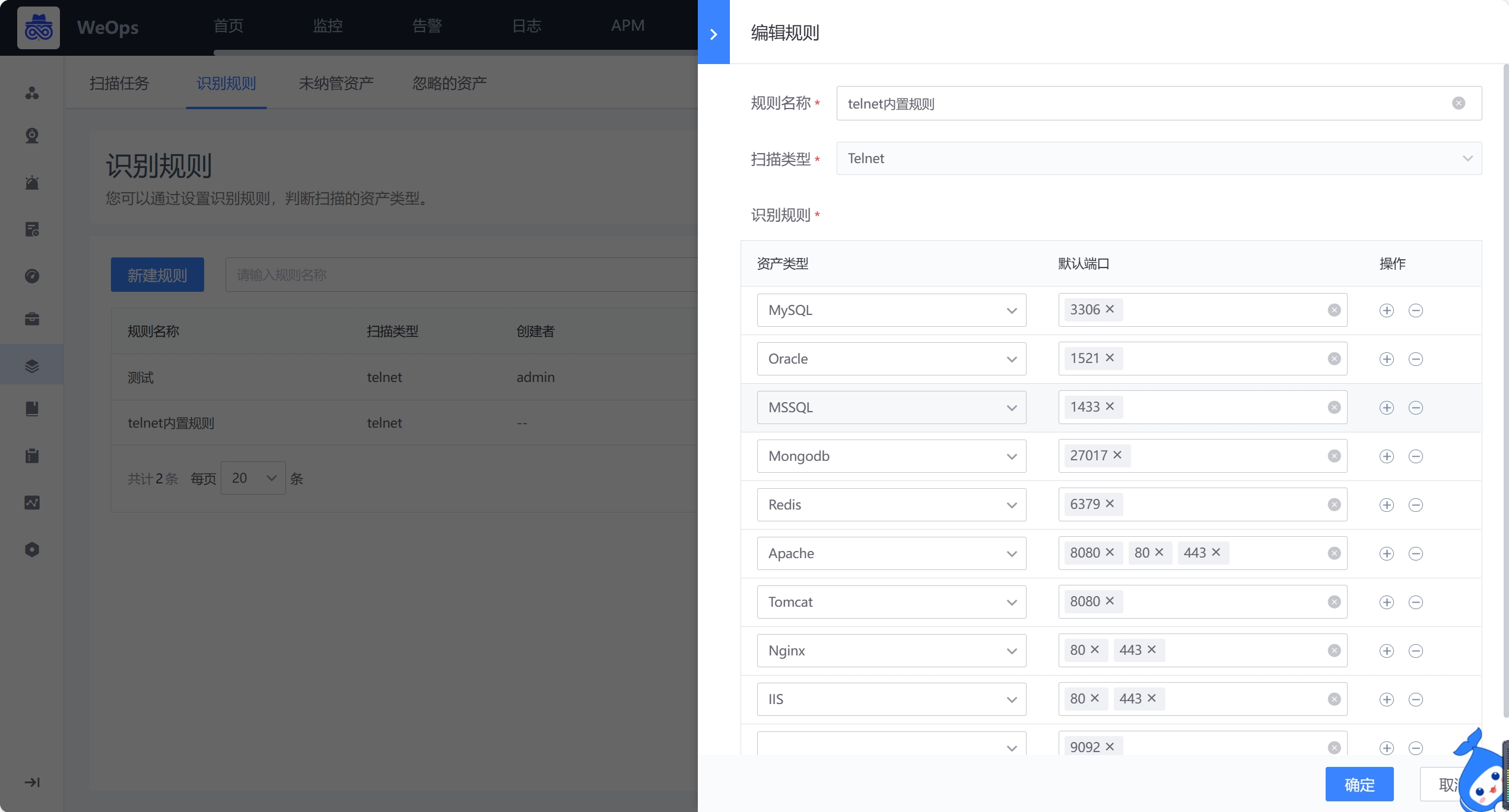

- 识别规则,支持设置Telnet的识别规则

- 未纳管资产,扫描的结果中,和cmdb对比后,cmdb没有纳管的资产会呈现在列表中,并按照识别规则展示资产的类型,对于未纳管的资产,支持一键纳管至cmdb中

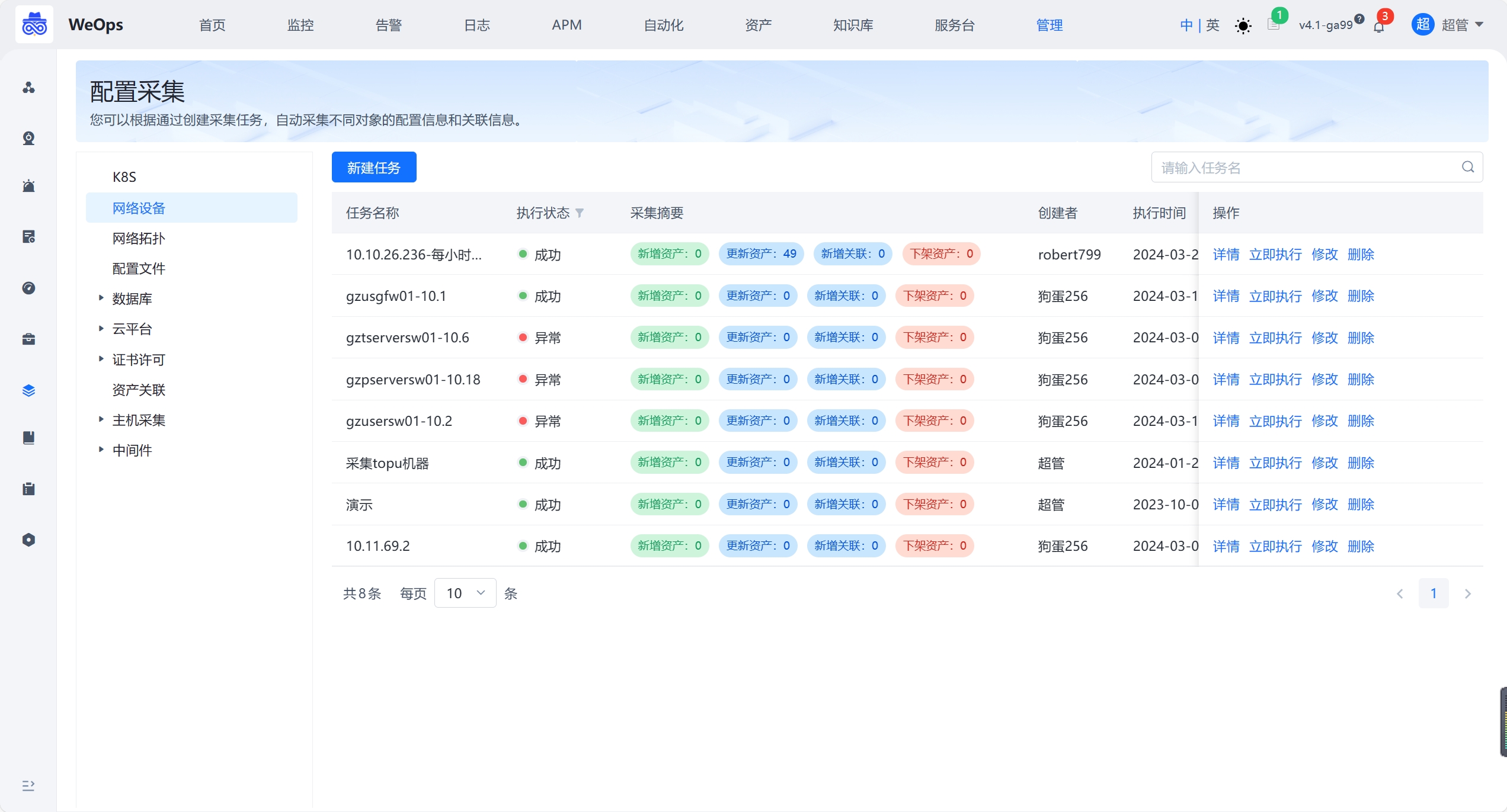

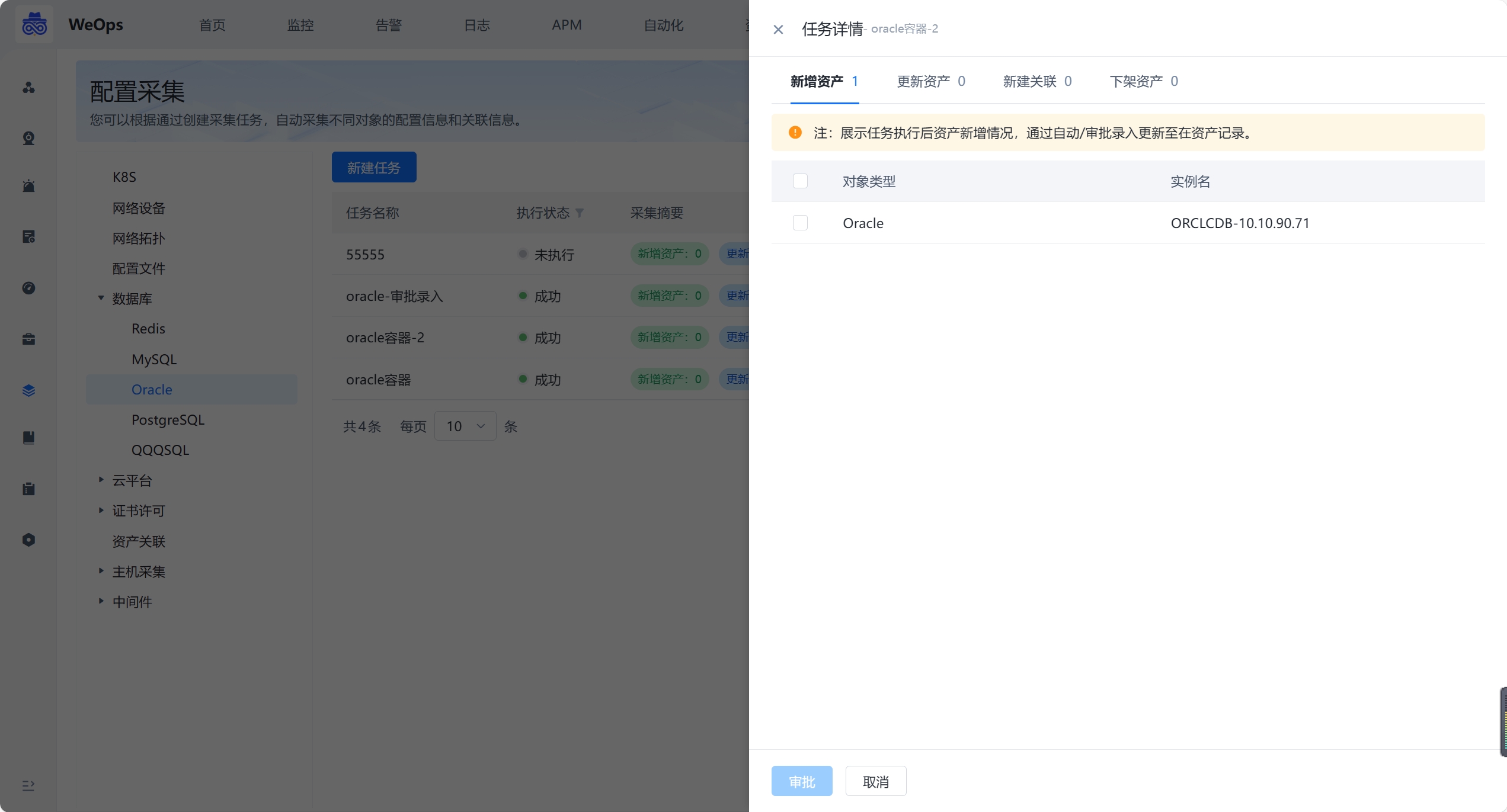

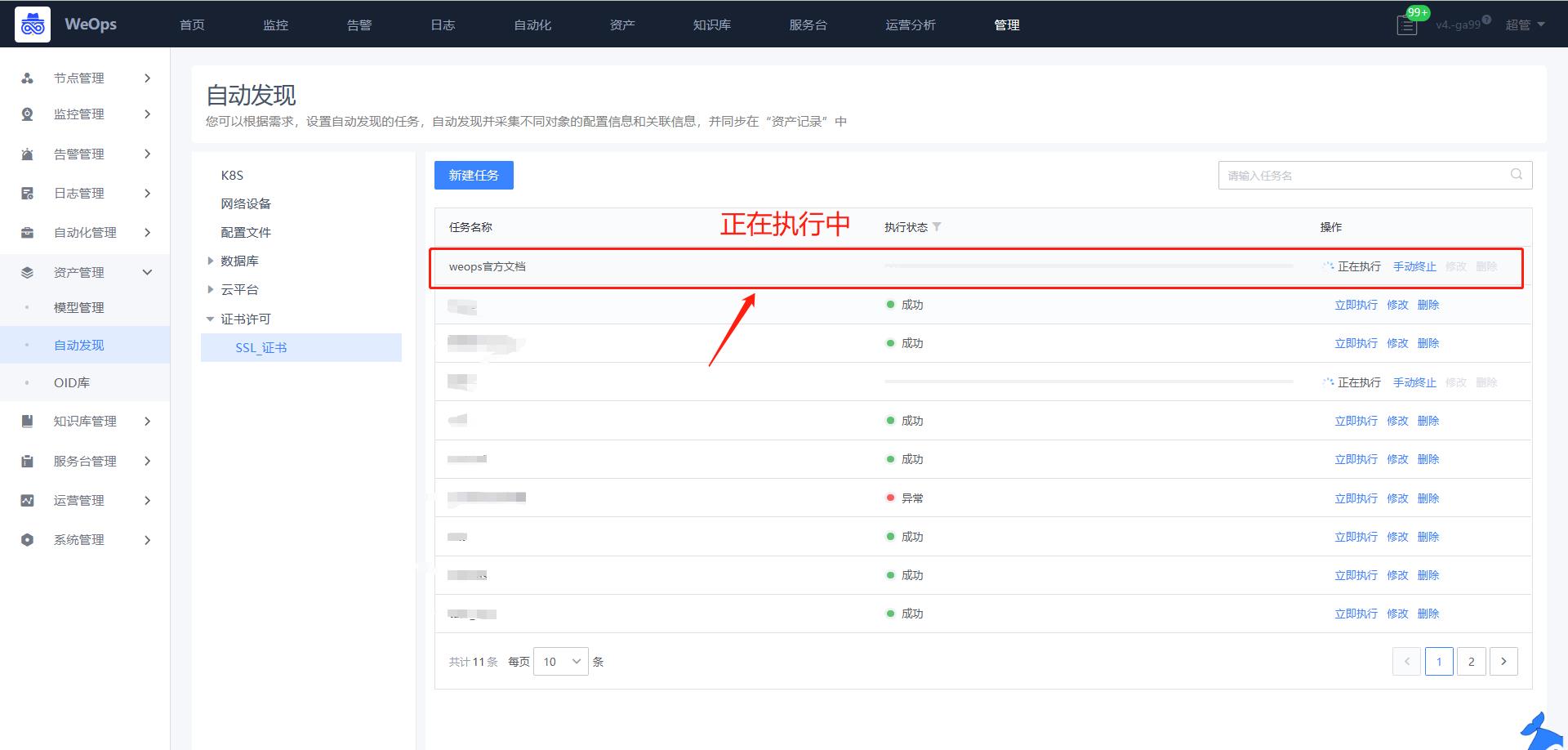

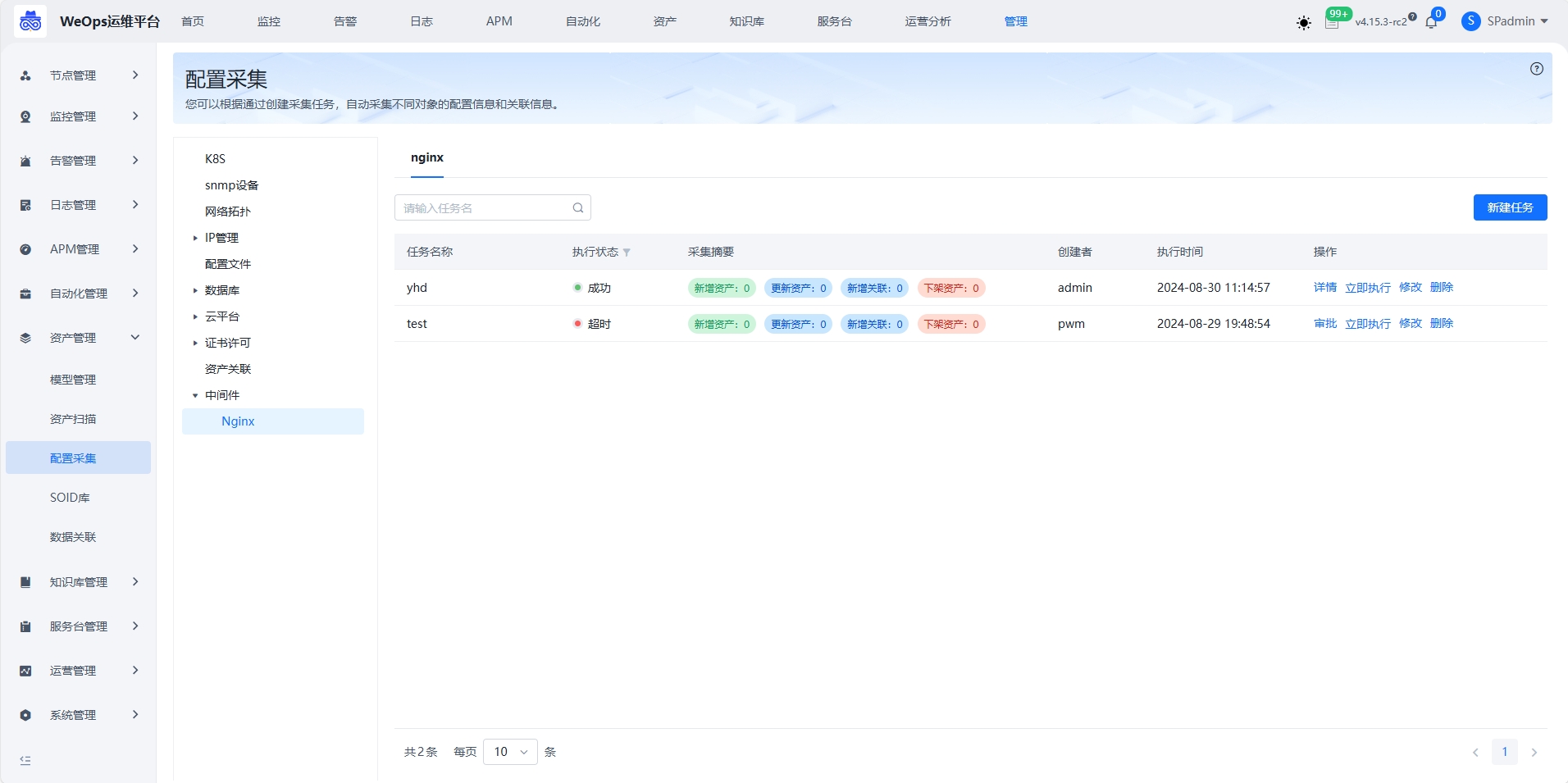

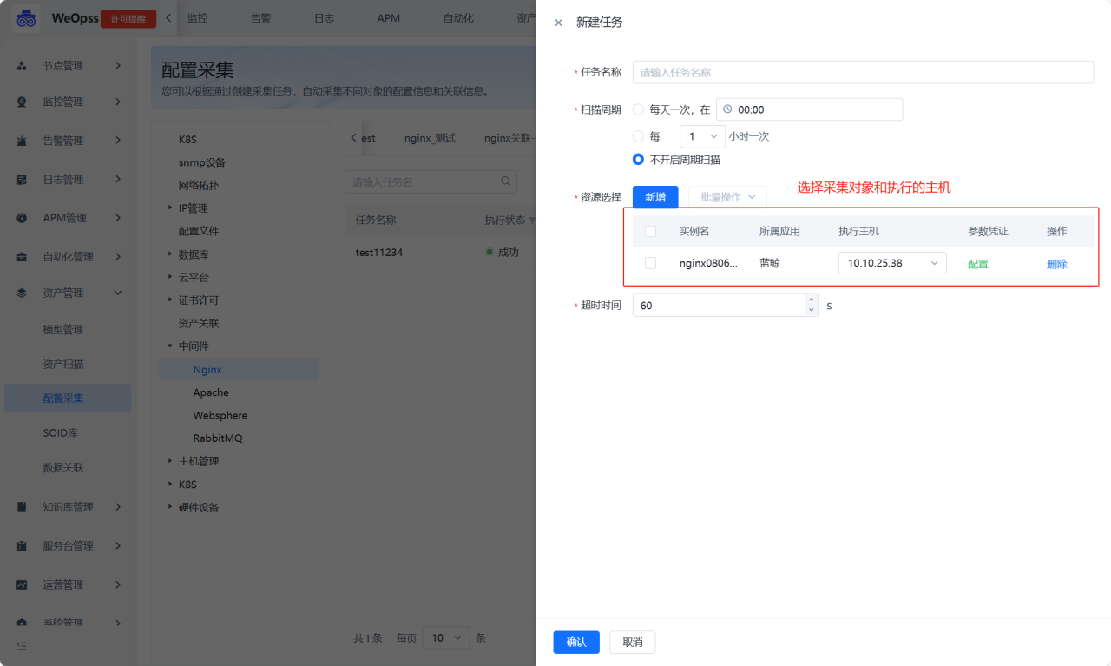

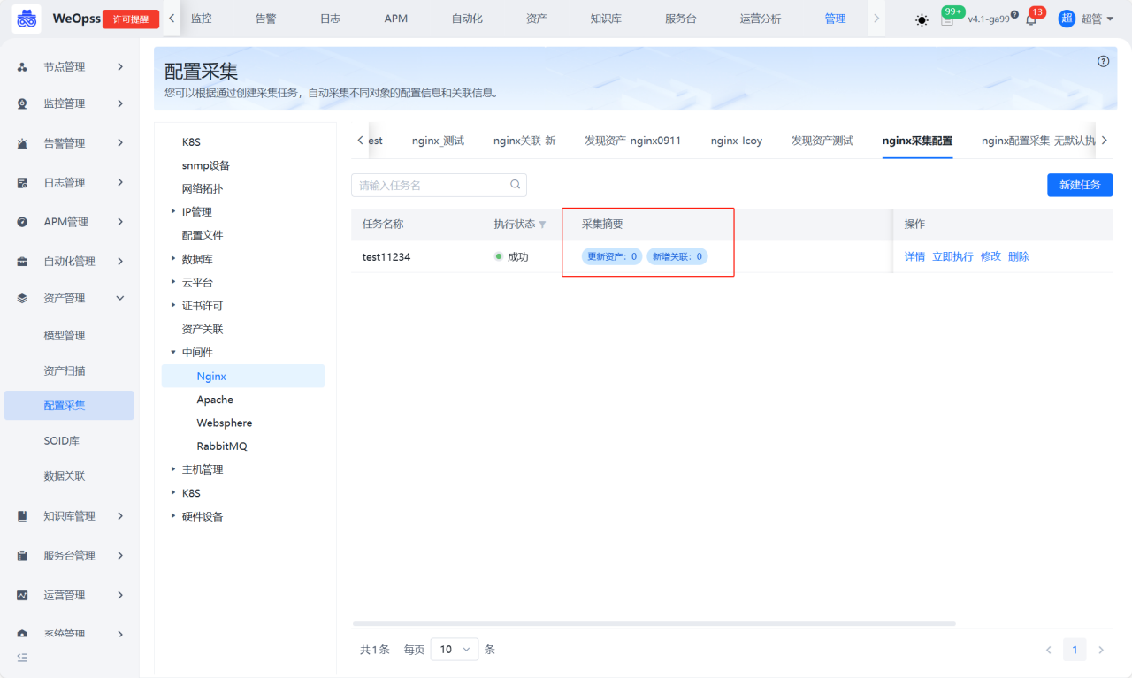

配置采集

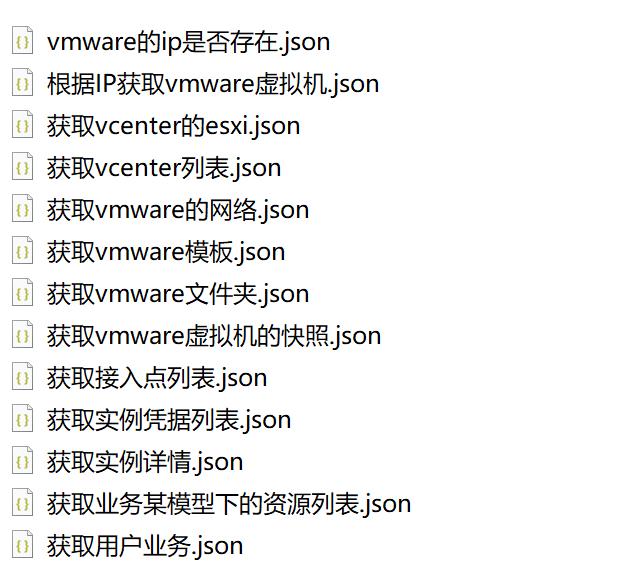

- 配置采集支持K8S/网络设备/数据库/云平台/SSL证书/配置文件等的自动发现,可通过新建任务的形式,创建自动发现和采集任务并执行

- 对于配置采集情况分为:新增资产、资产更新、新增关联和下架资产,支持查看详情。针对新增资产的情况可以设置“自动录入”和“审批录入”两种方式,通过审批后,新增的资产才可正式录入资产记录中。

- 关于数据库的自动发现和纳管,详见《操作手册-资源纳管配置-数据库/中间件纳管》

- 关于网络设备的自动发现和纳管,详见《操作手册-资源纳管配置-网络设备纳管》

- 关于云平台的自动发现和纳管,详见《操作手册-资源纳管配置-云平台纳管》

- 关于K8S的自动发现和纳管,详见《操作手册-资源纳管配置-K8S纳管》

- 关于SSL证书的自动发现和纳管,详见《操作手册-资源纳管配置-SSL证书纳管》

- 关于配置文件的自动发现和纳管,详见《操作手册-资源纳管配置-配置文件纳管》

- 关于资产关联的自动发现,详见《操作手册-资源纳管配置-资产关联》

- 关于IP的自动发现,详见《操作手册-资源纳管配置-IP》

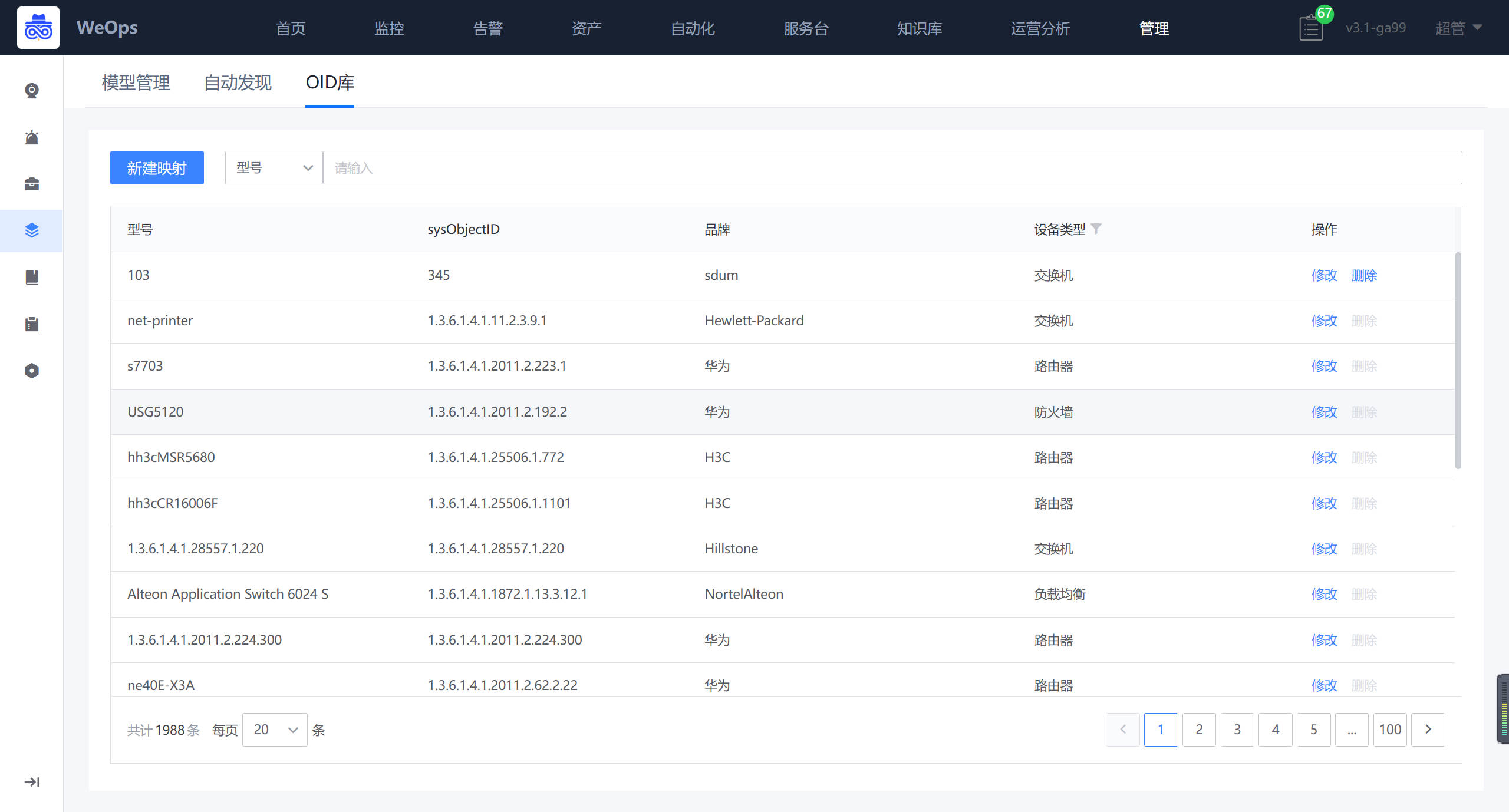

OID库

- OID库支持对网络设备自动发现和采集的设备类型的扩充,将需要自动发现的网络设备的OID和品牌、型号进行映射保存,即可支持对该品牌型号的网络设备的自动发现和采集。

数据关联

- 支持资产实例与日志数据相关联,关联后,可在资产详情/监控视图/告警详情等快捷查看资产相关联的日志信息

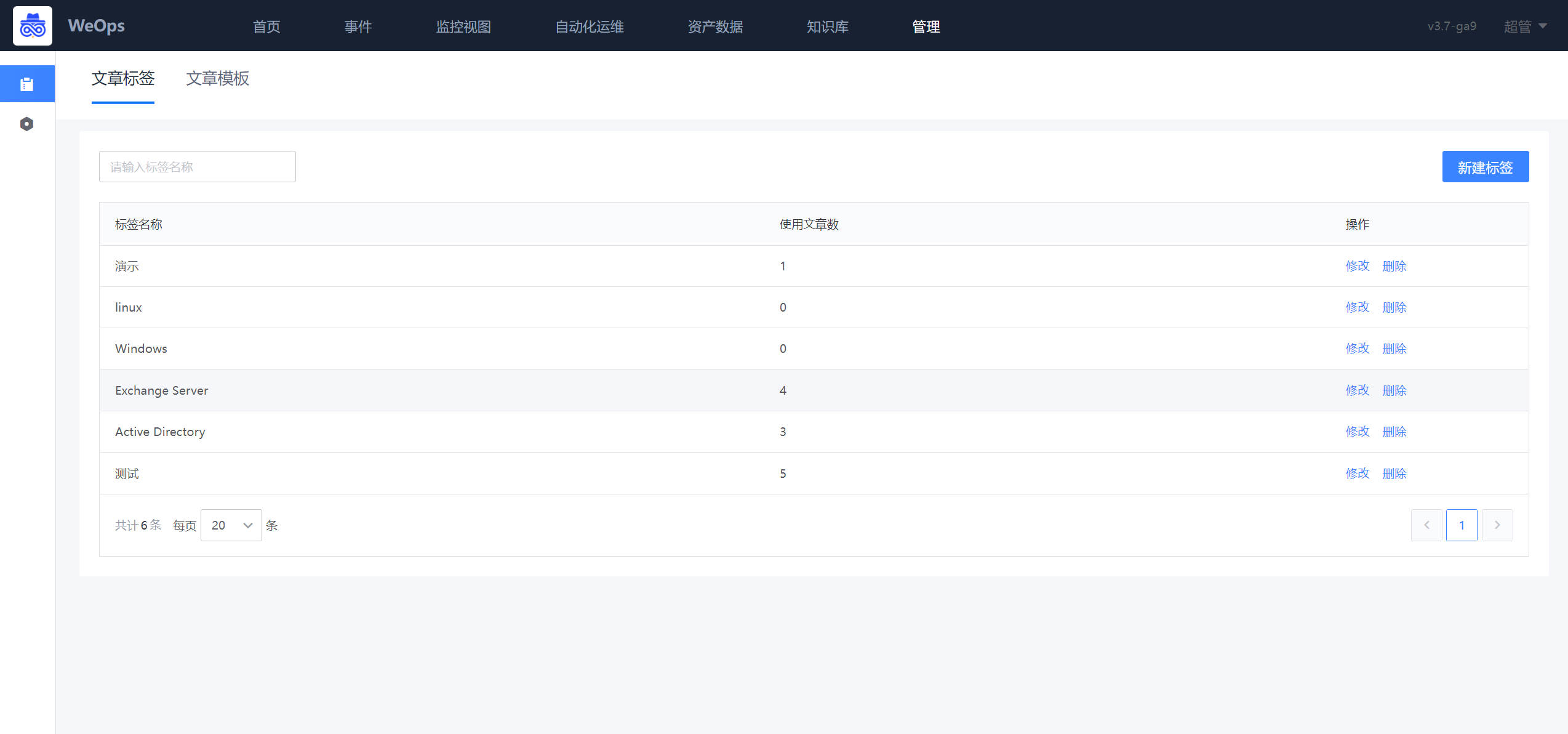

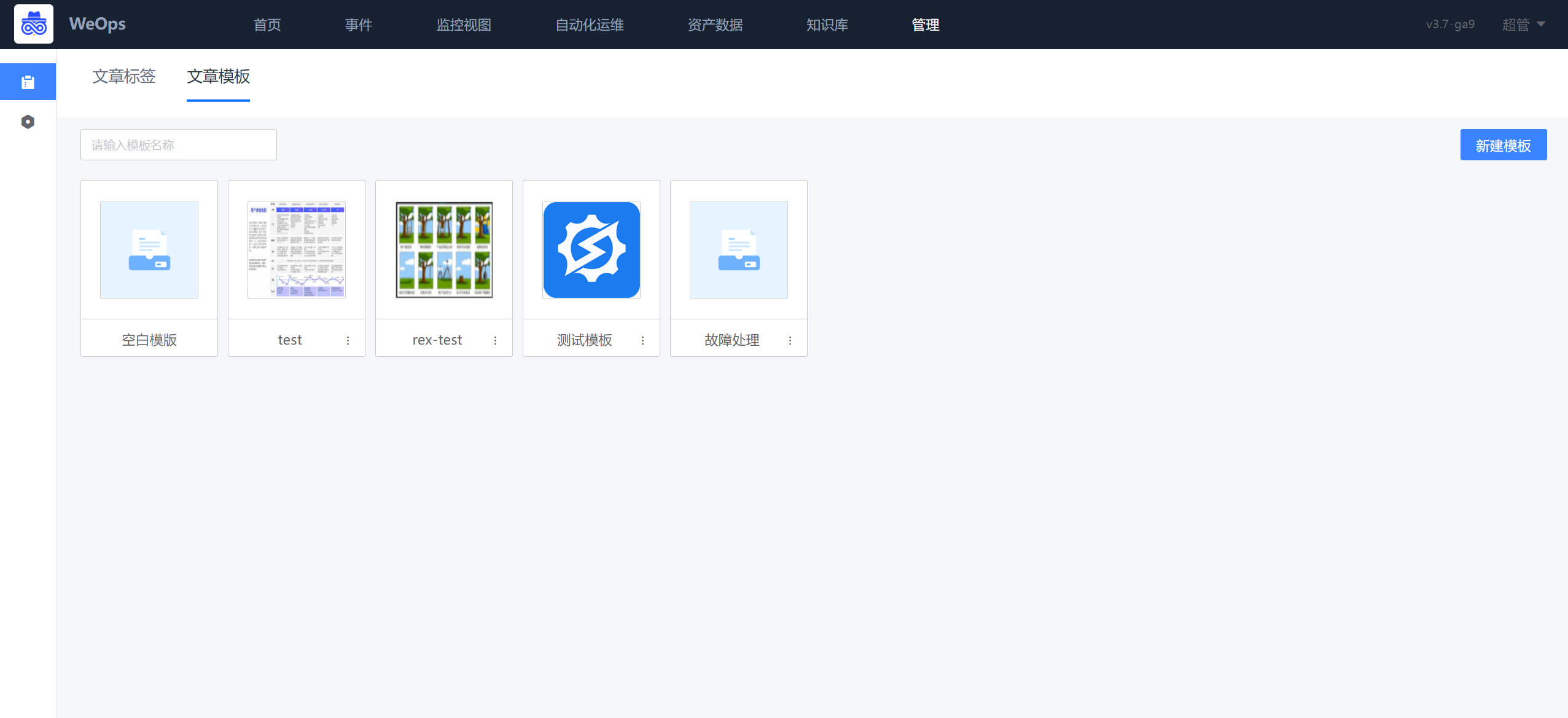

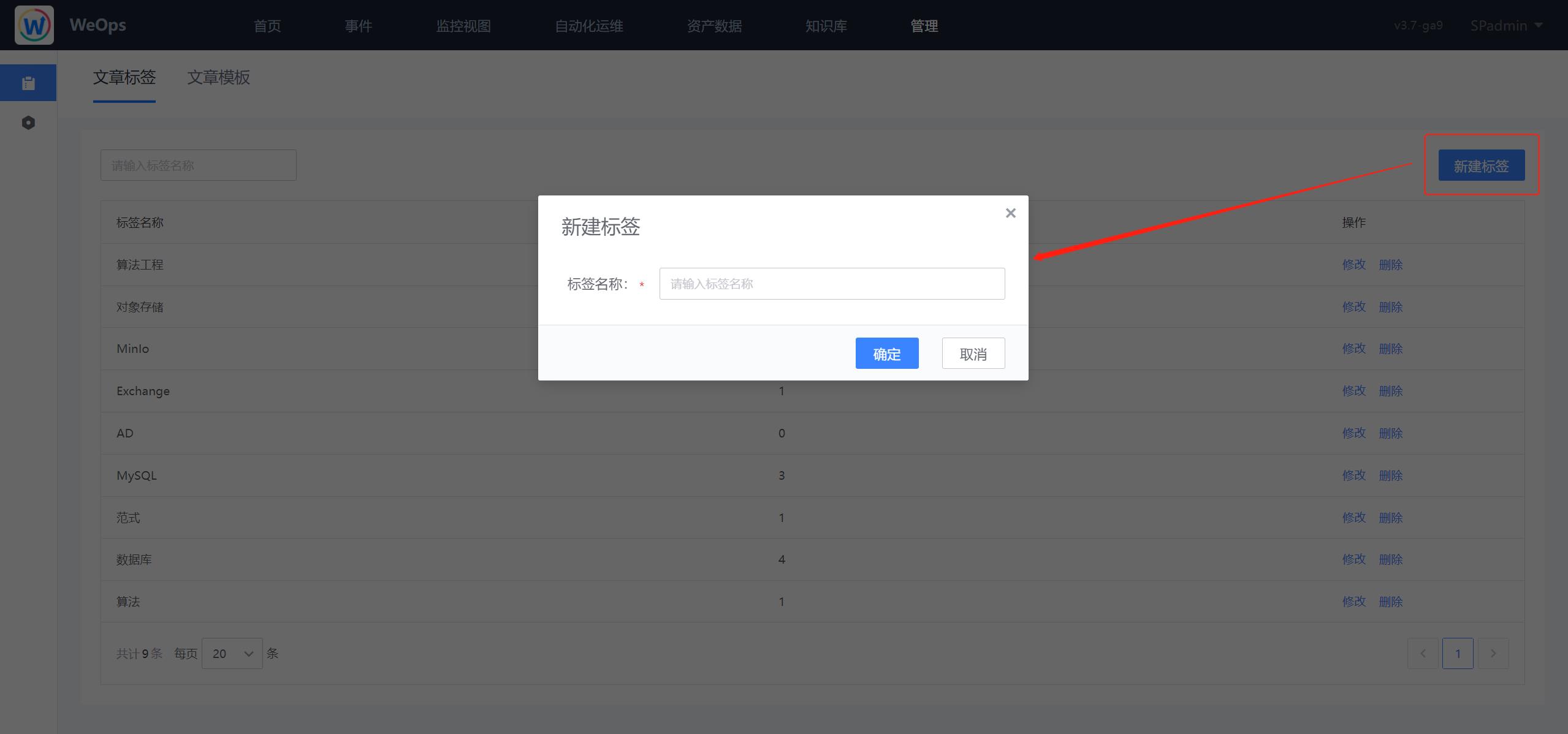

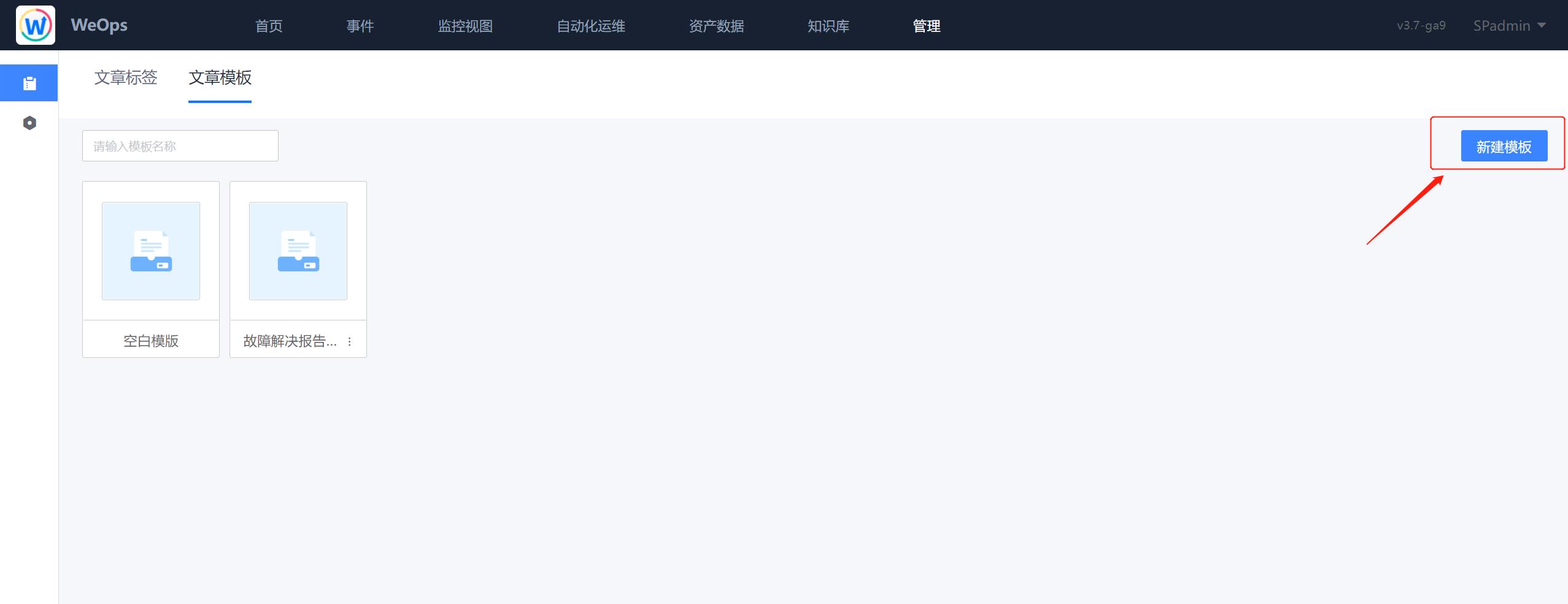

知识库管理

知识库管理是对知识库的文章标签和文章模板进行新建和管理。

日志管理

日志管理主要是对日志进行相关配置

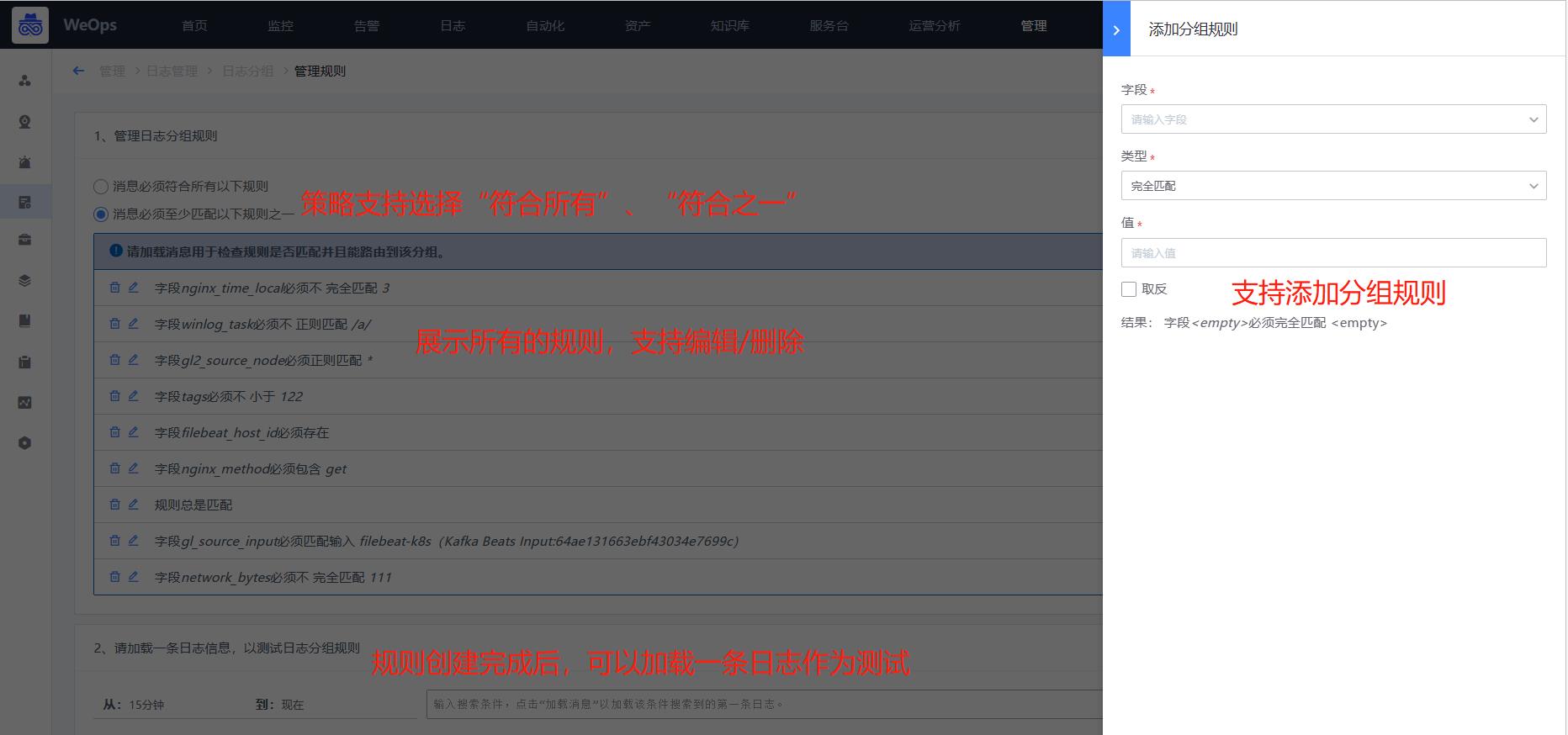

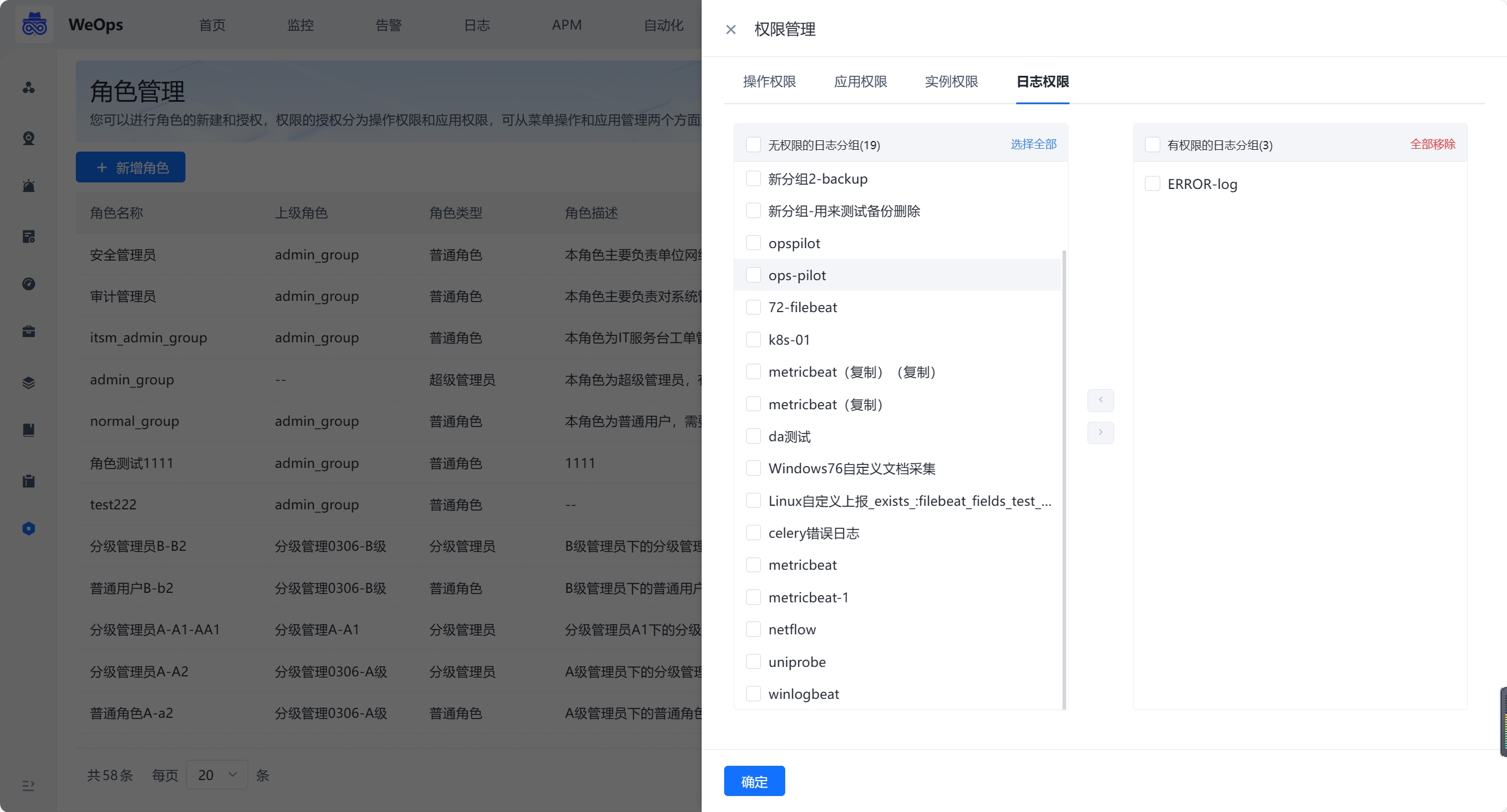

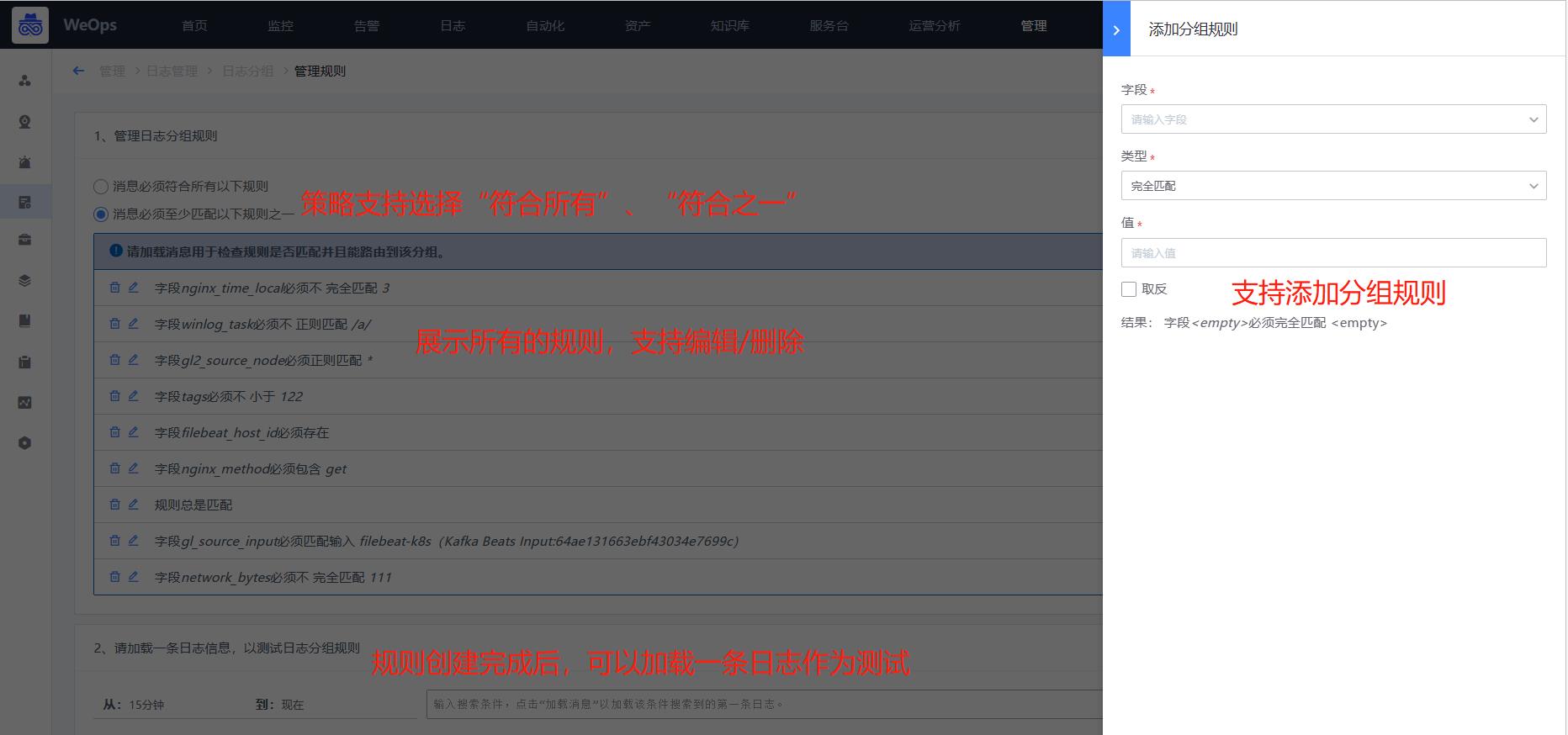

日志分组

- 支持对日志消息进行分组管理,对日志的分组设置分组规则,当满足这一规则的时候,日志将划为这个分组,并通过角色管理-日志分组授权给对应人员搜索/使用。

- 分组规则:一个分组支持多个分组规则,可以在分组中进行创建和管理

- 日志分组的详细介绍步骤详见《操作手册-3、日志设置-日志分组配置》

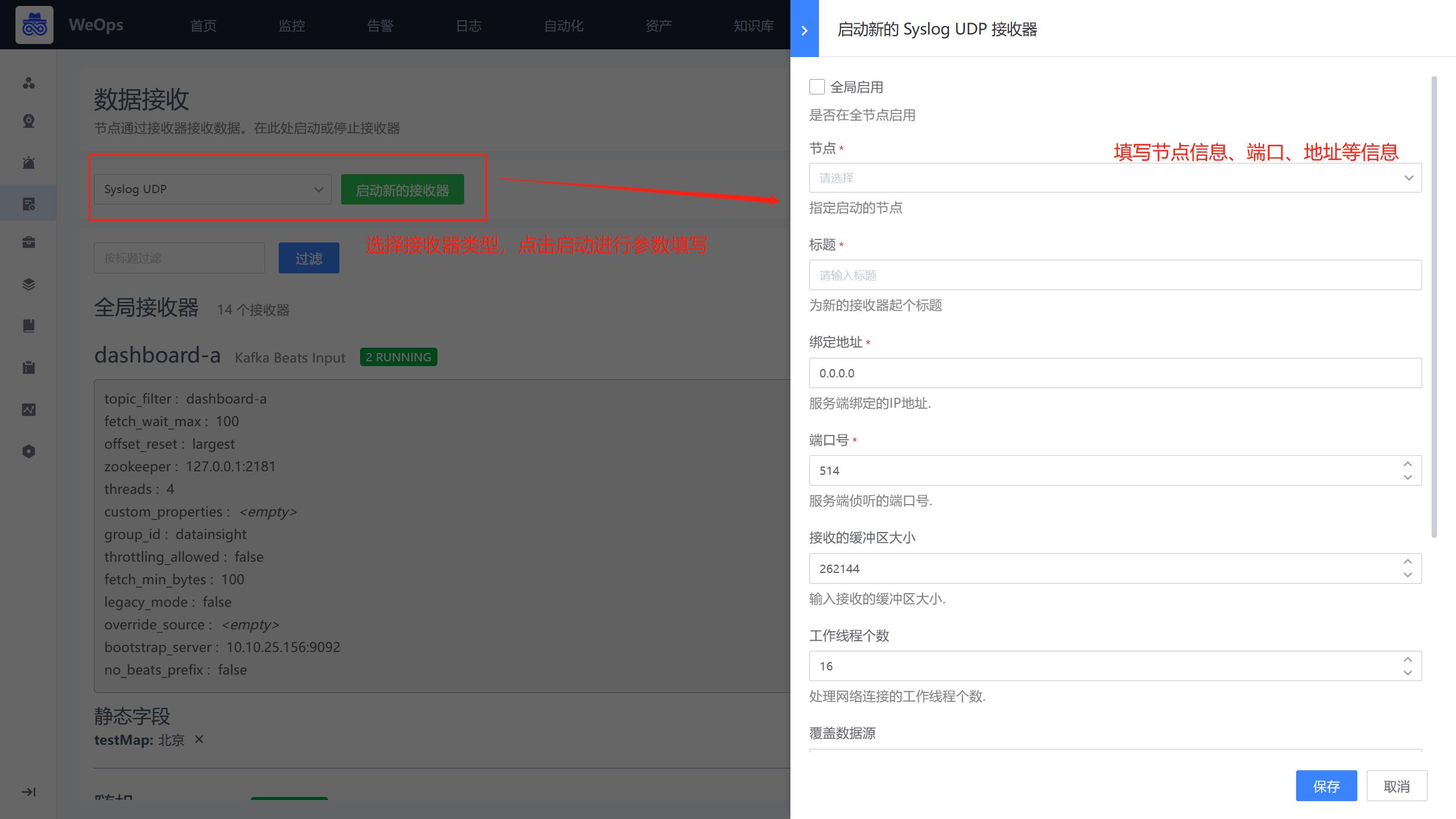

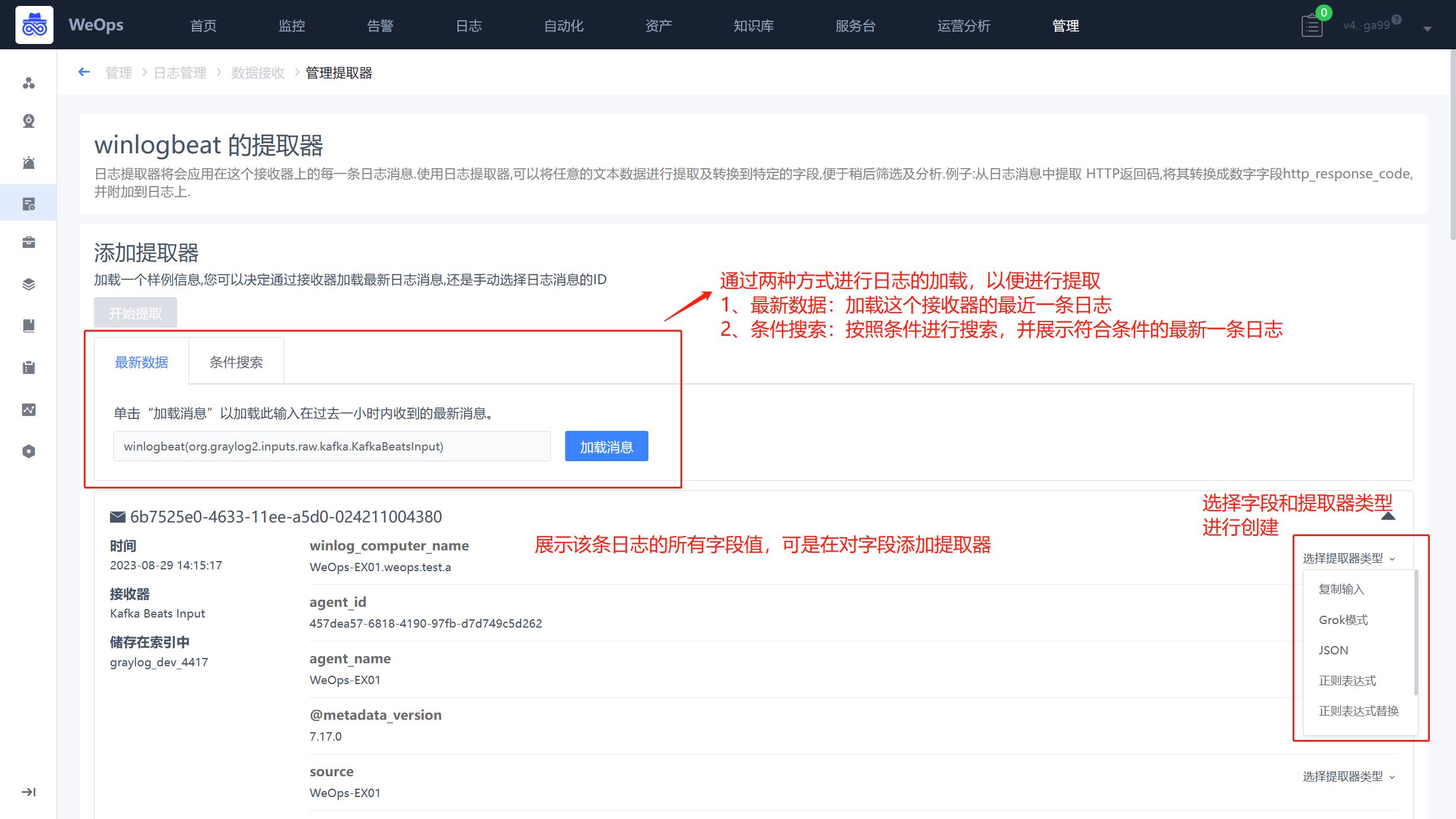

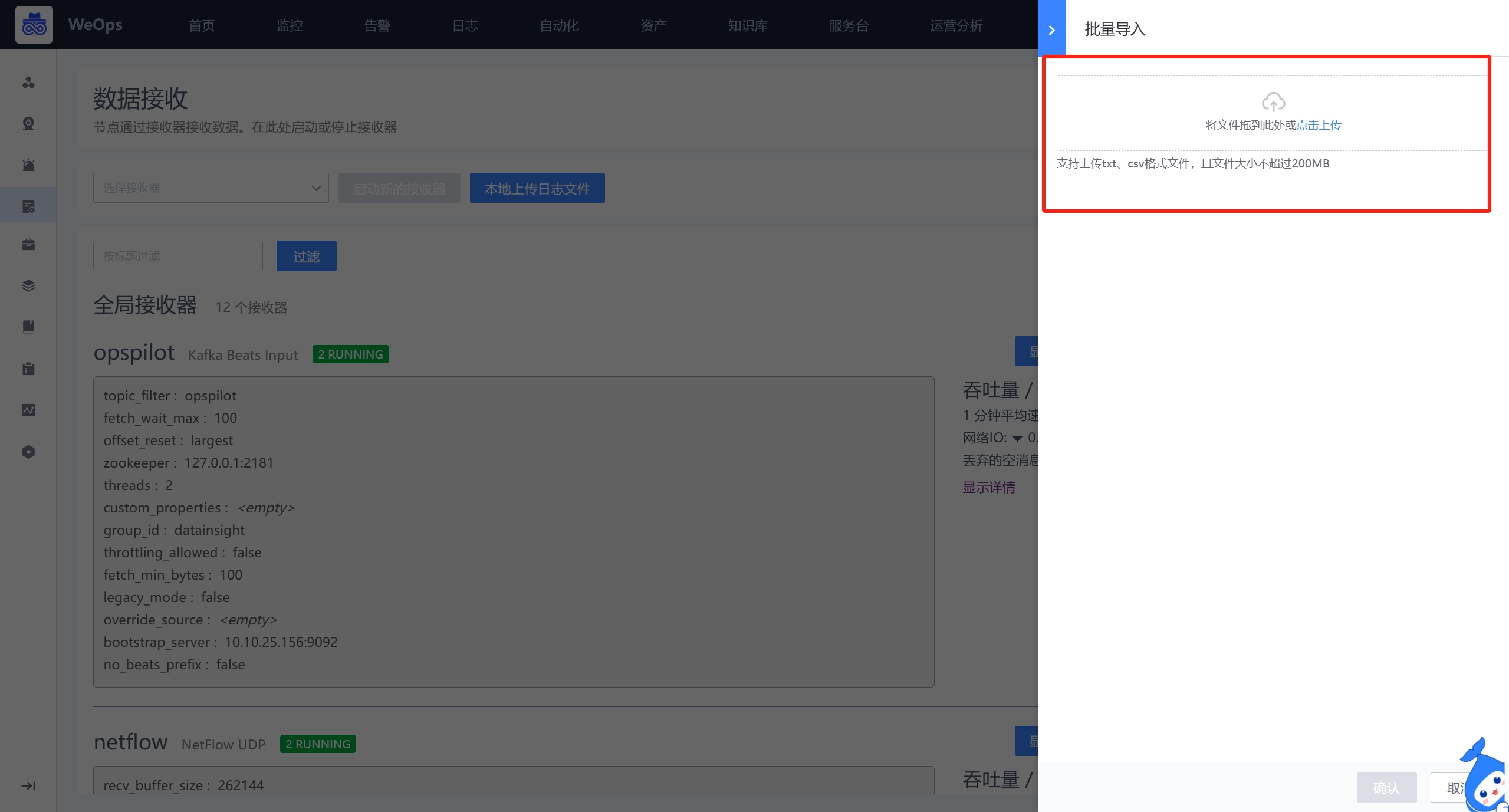

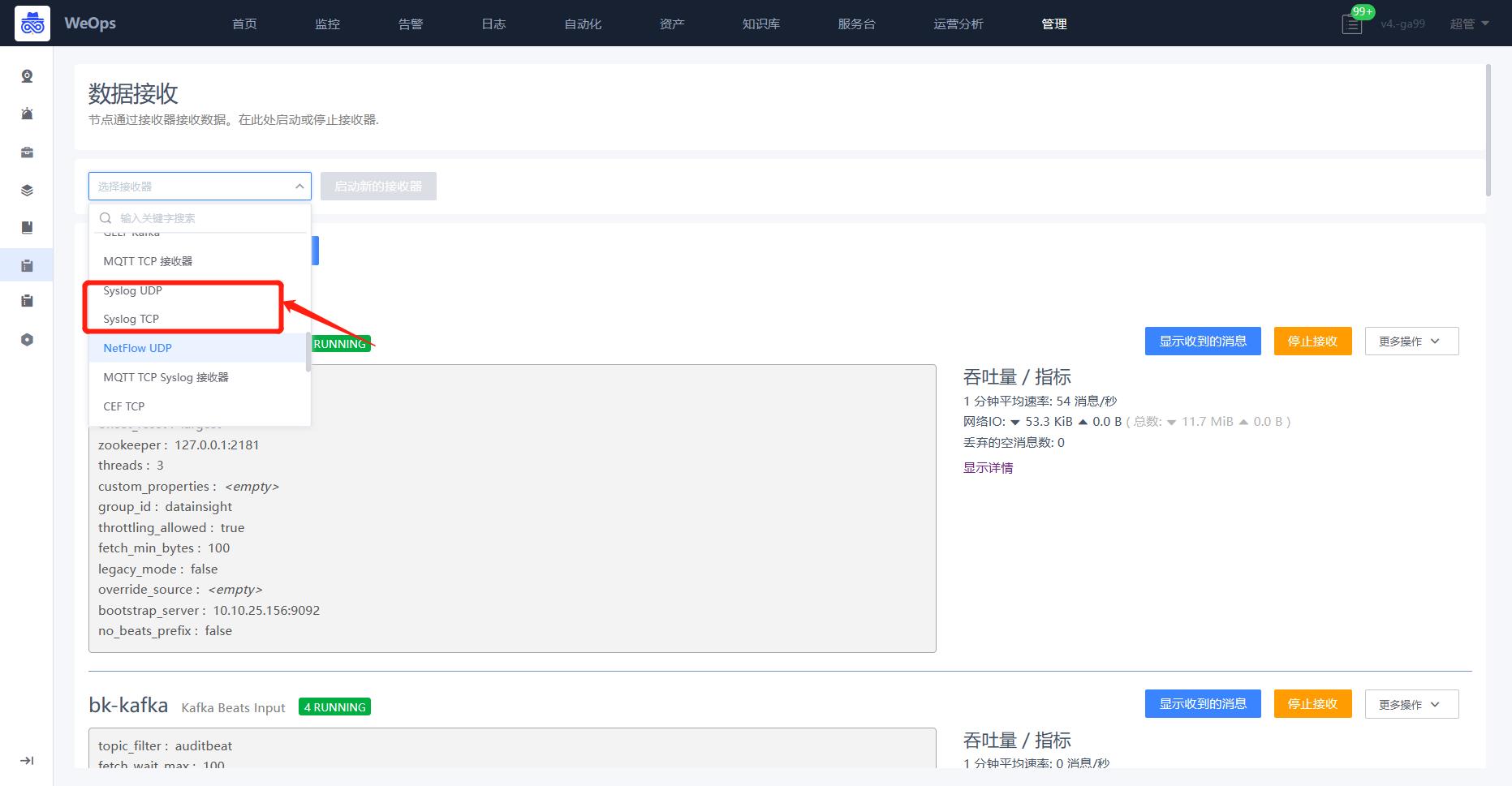

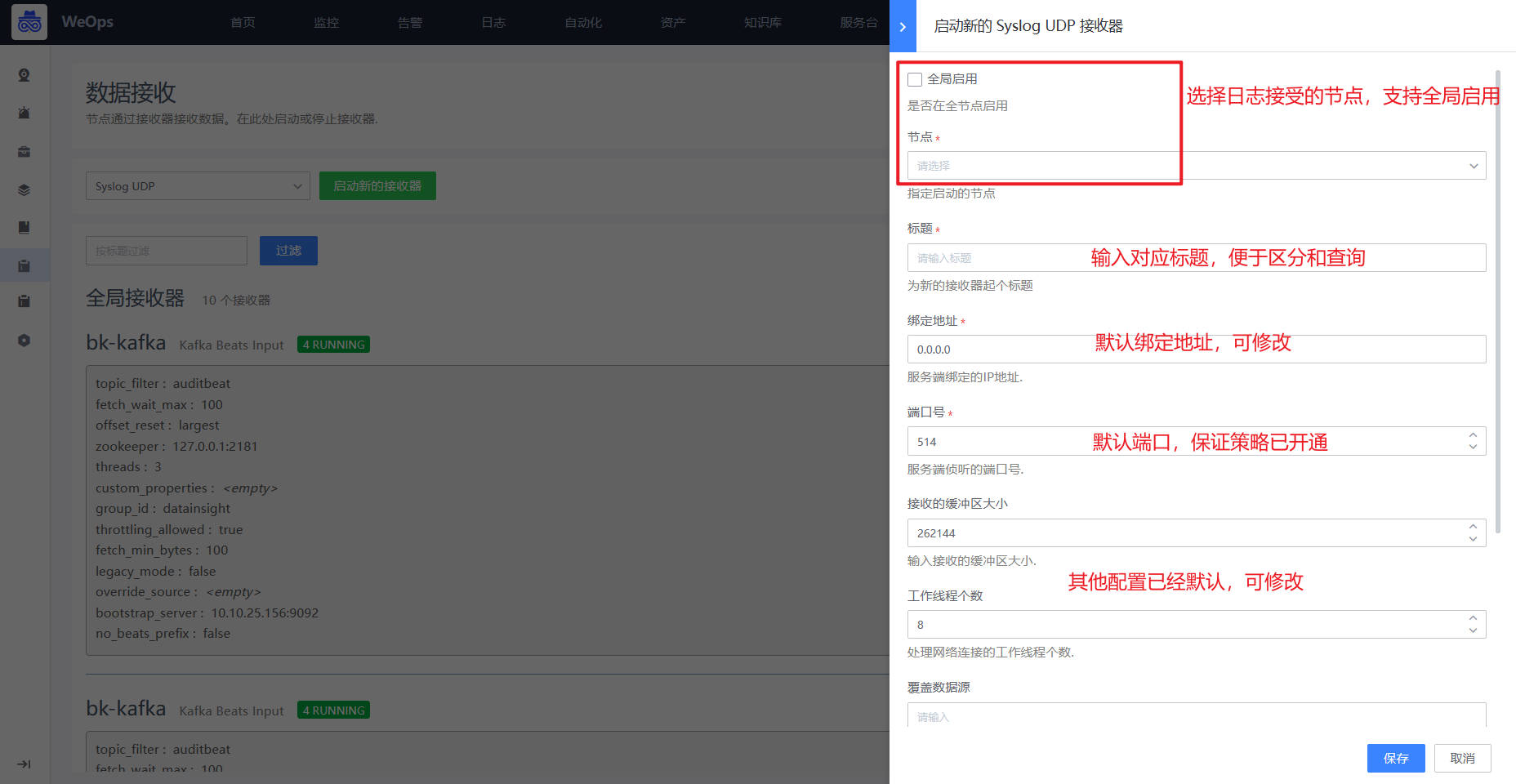

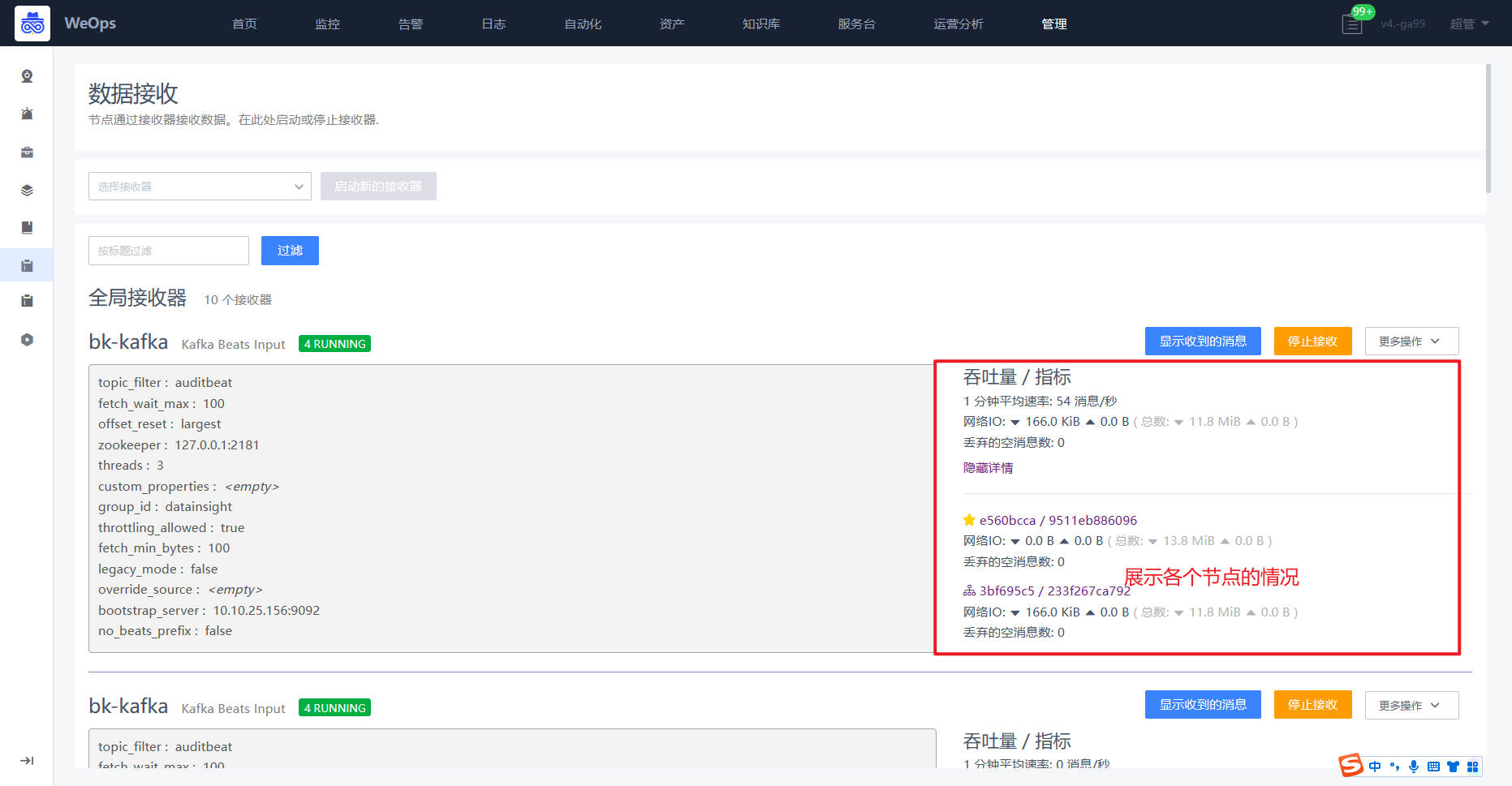

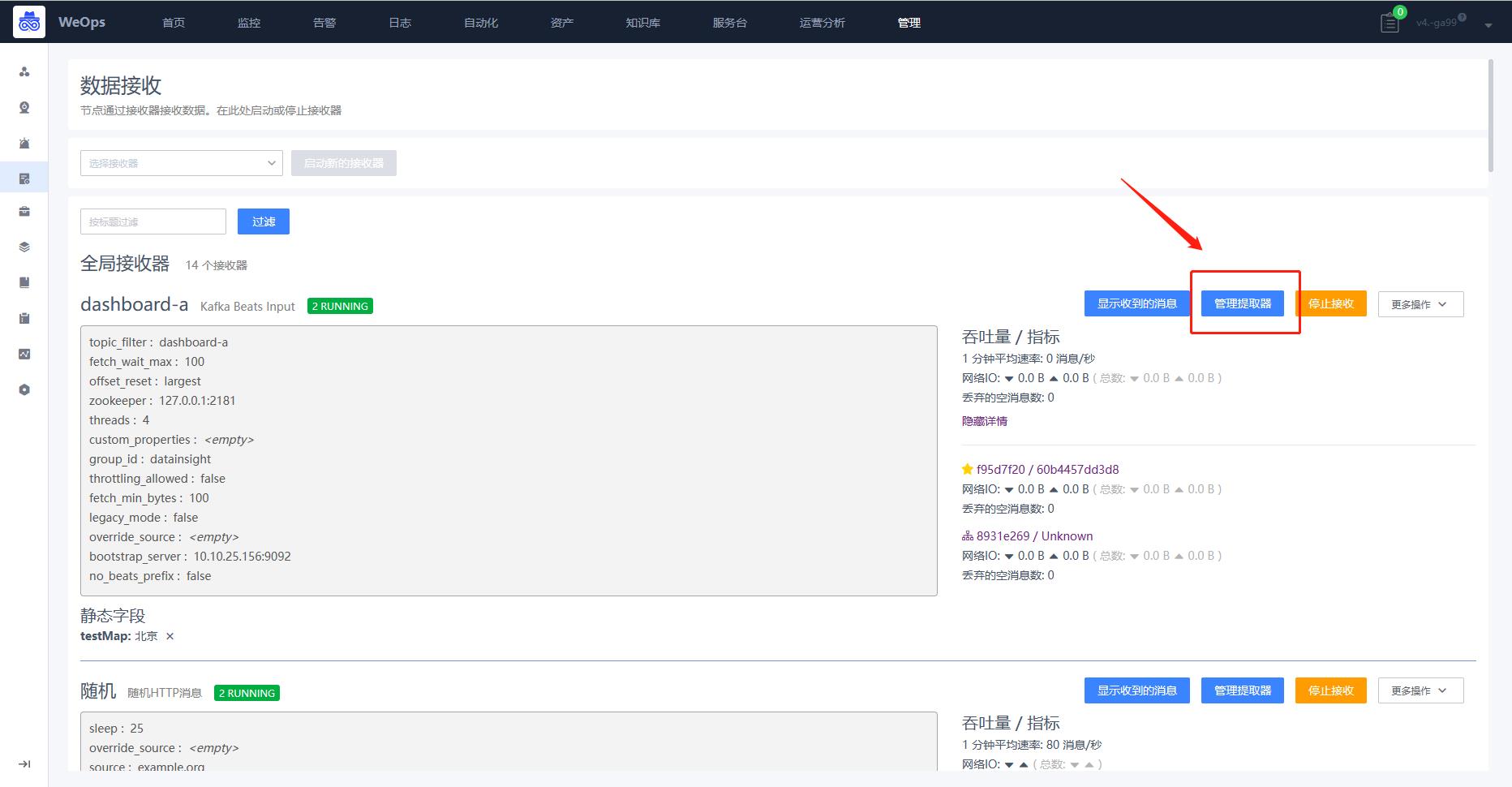

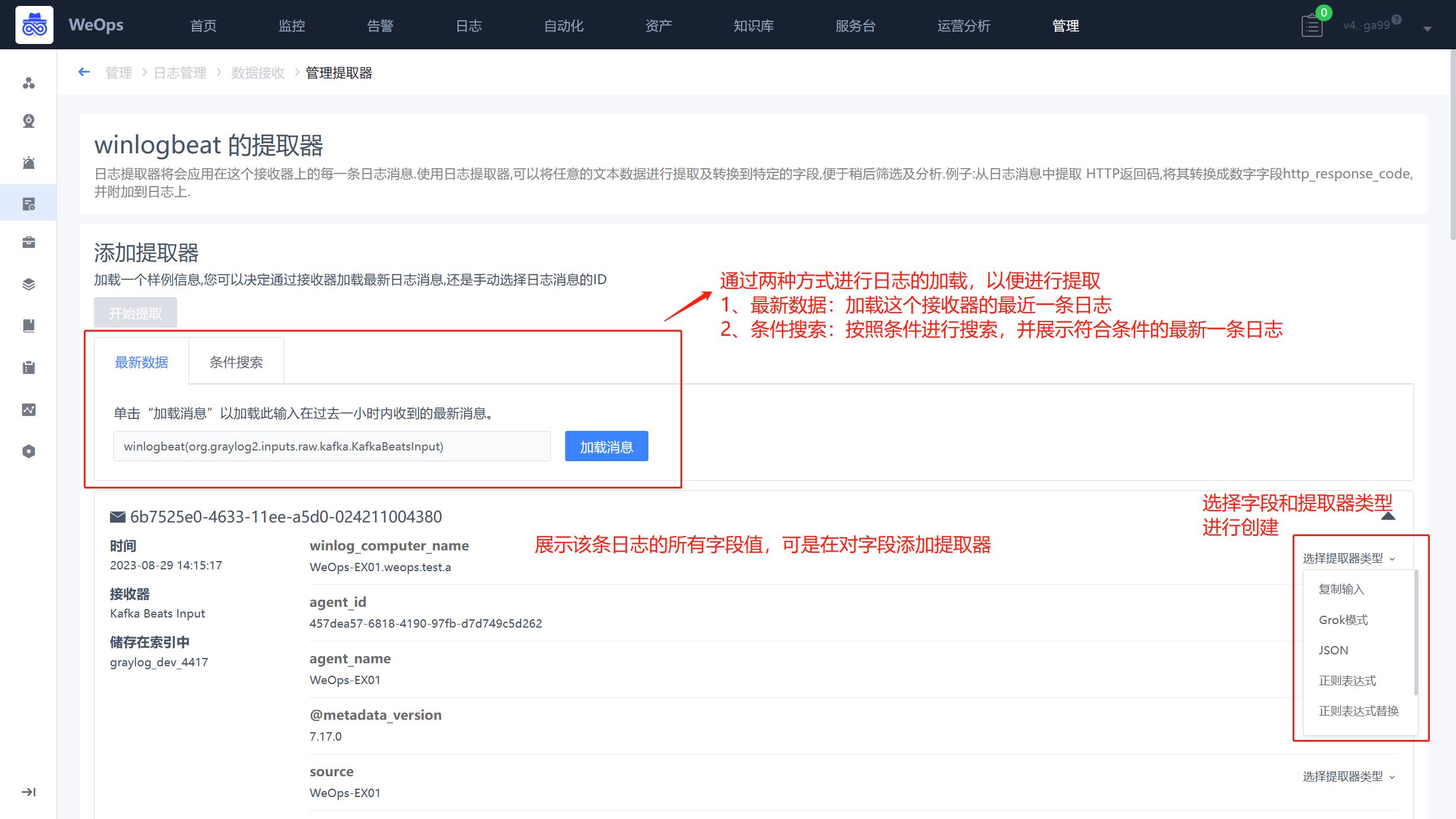

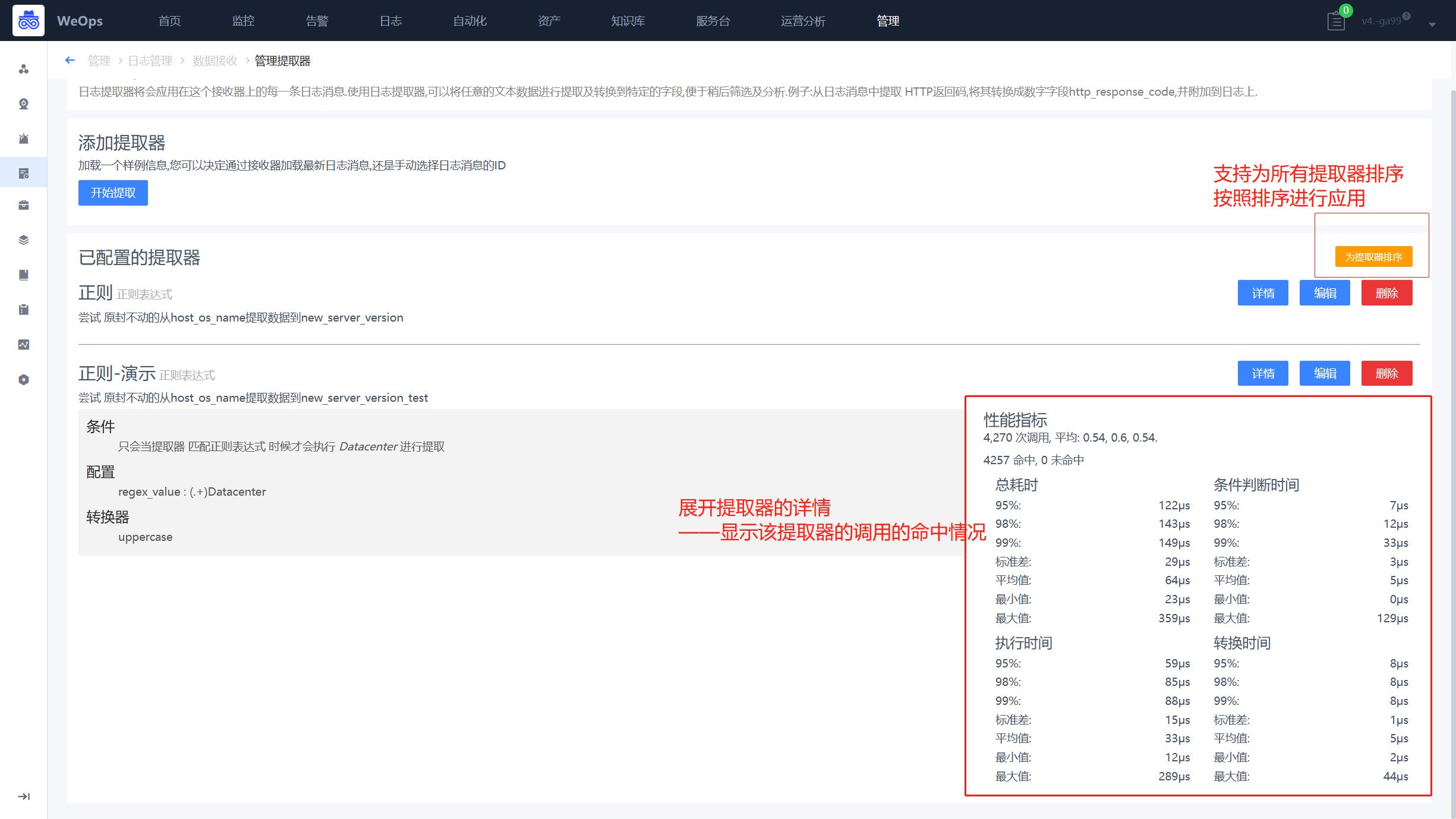

数据接收

- 展示所有支持的接收器,可以进行相关日志数据的接收配置,并展示所有接收器的基本情况。

- 根据实际需求,选择适用的提取器进行创建,比如选择syslog UDP提取器对交换机的日志进行提取,填写对应的端口等信息,并启用

- 支持为每个接收器创建提取器,选择提取的字段,为该字段选择适用的提取类型,设置提取规则并保存为新字段,以便后续使用。

- 支持导入本地的日志,支持的格式txt和CSV格式

- 日志数据接收的相关配置步骤详见《操作手册-3、日志配置-日志数据接入(syslog协议)》

- 日志提取器的详细配置详见《操作手册-3、日志配置-日志提取器配置》

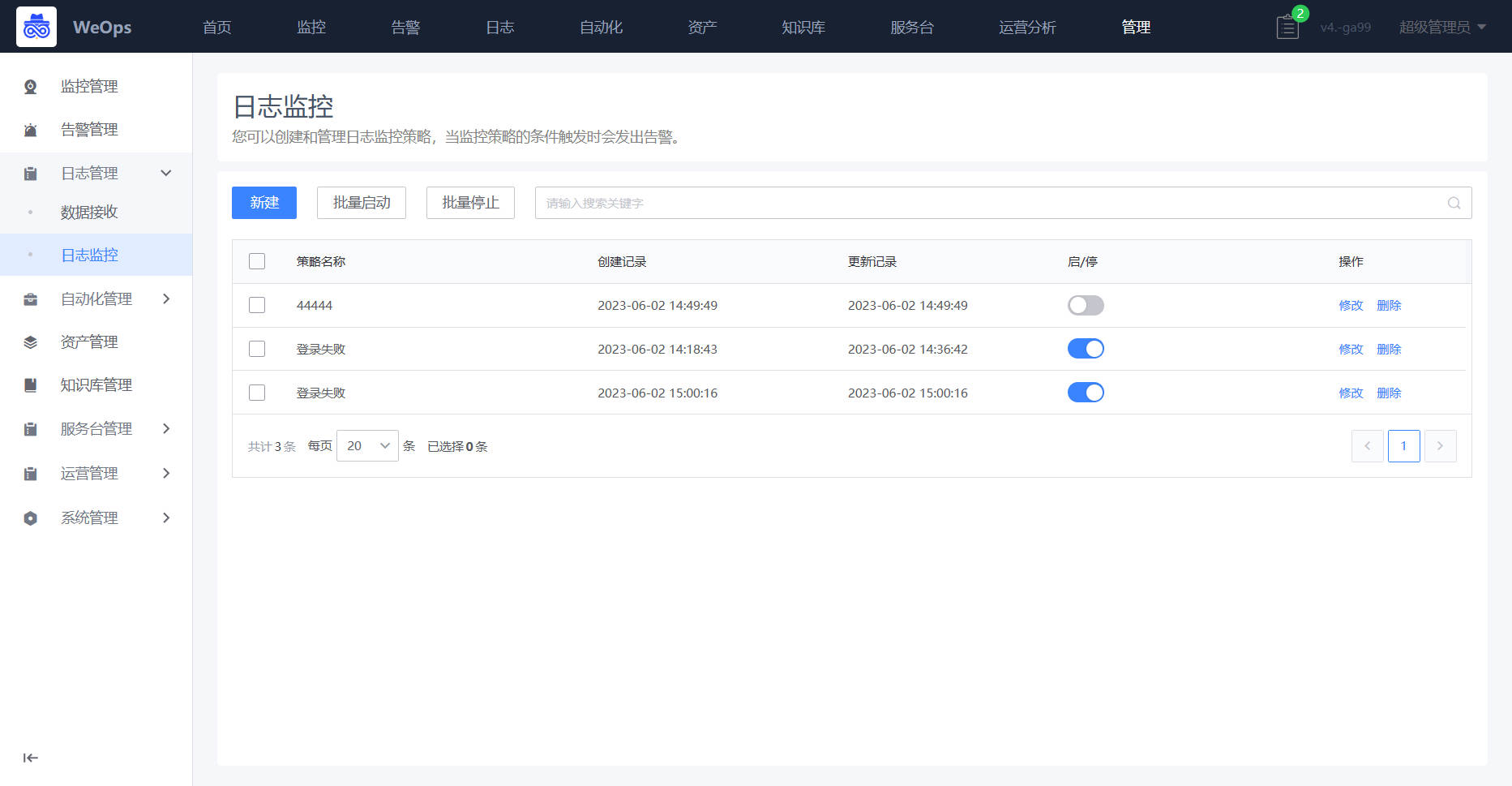

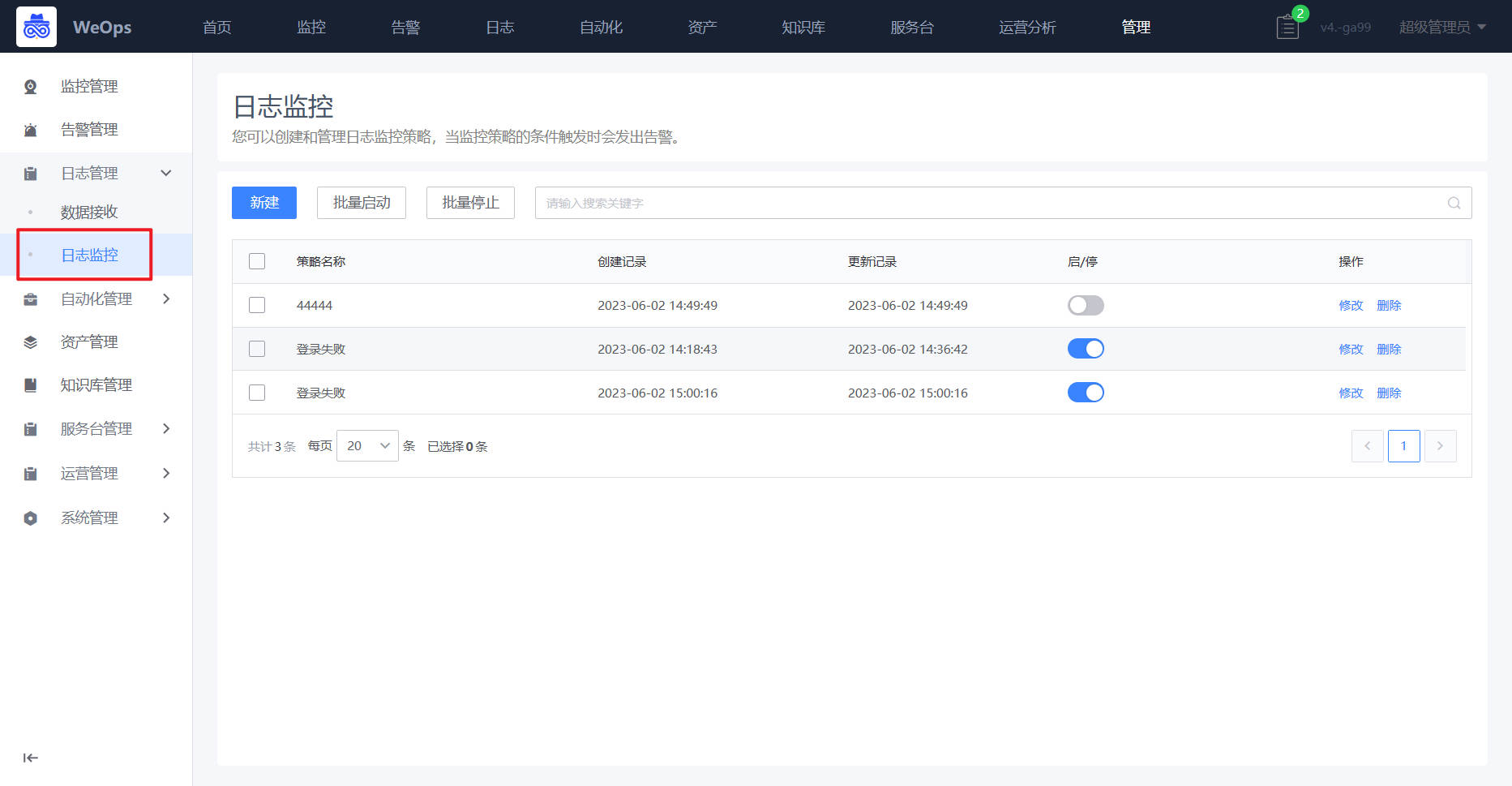

日志监控

- 展示所有日志监控策略,支持日志策略的新建/编辑和启停等操作

- 设置监控告警策略:根据业务需求,设置告警规则,如错误码出现次数、异常信息出现频率等,当监控到的日志数据符合告警规则时,自动发送告警通知,通知相关人员及时处理问题。

- 日志分组的详细介绍步骤详见《操作手册-3、日志设置-日志监控告警配置》

索引集

- WeOps为了存储日志原始数据,降低资源消耗,支持设置日志索引集,可以为每个索引集设置轮转规则,形成一组索引,即对应 Elasticsearch的索引分片。

- 如下图,是索引集列表页面,展示了所有的索引集的信息,点击进入,可以查看这个索引集的详细信息和索引信息。

- 索引集详情页如下图。

索引集操作:新建索引(手动循环此索引集上的当前活动写入索引);更新索引范围(使用后台系统作业重新计算此索引集的索引范围);编辑索引集(编辑索引集的信息,包括索引基础信息/轮转规则/操作配置等)

索引列表:展示这个索引集的各个索引的基本信息,并标明“当前可写入索引”(当前可写入索引不能被关闭和删除),其他索引(支持重新计算该索引的索引范围,支持手动关闭/删除)- 新建索引集,设置索引集的规则

标题:索引集的描述性名称

描述 :索引集的描述

索引前缀:用于由索引集管理的 Elasticsearch 索引的唯一前缀。前缀必须以字母或数字开头,并且只能包含字母、数字和支持的字符。

分词器 :(默认值standard)索引集的 Elasticsearch 分析器

索引分片:(默认值4)每个索引使用的 Elasticsearch 分片数量

索引副本:(默认值0)每个索引使用的 Elasticsearch 副本数

最大段数 :(默认1)ElasticSearch强制合并的段数量

轮转后索引优化:在索引轮转后禁用

字段类型刷新间隔:(默认5秒)多久刷新活跃索引的字段类型

轮转规则:支持按照索引时间/索引记录数/索引时间进行轮转,可设置轮转周期

轮转操作:轮转后的索引操作,包括删除索引,关闭索引/不操作。- 索引集创建完成后,日志分组支持选择存储到的索引集,并按照索引集的规则进行日志数据的轮转。

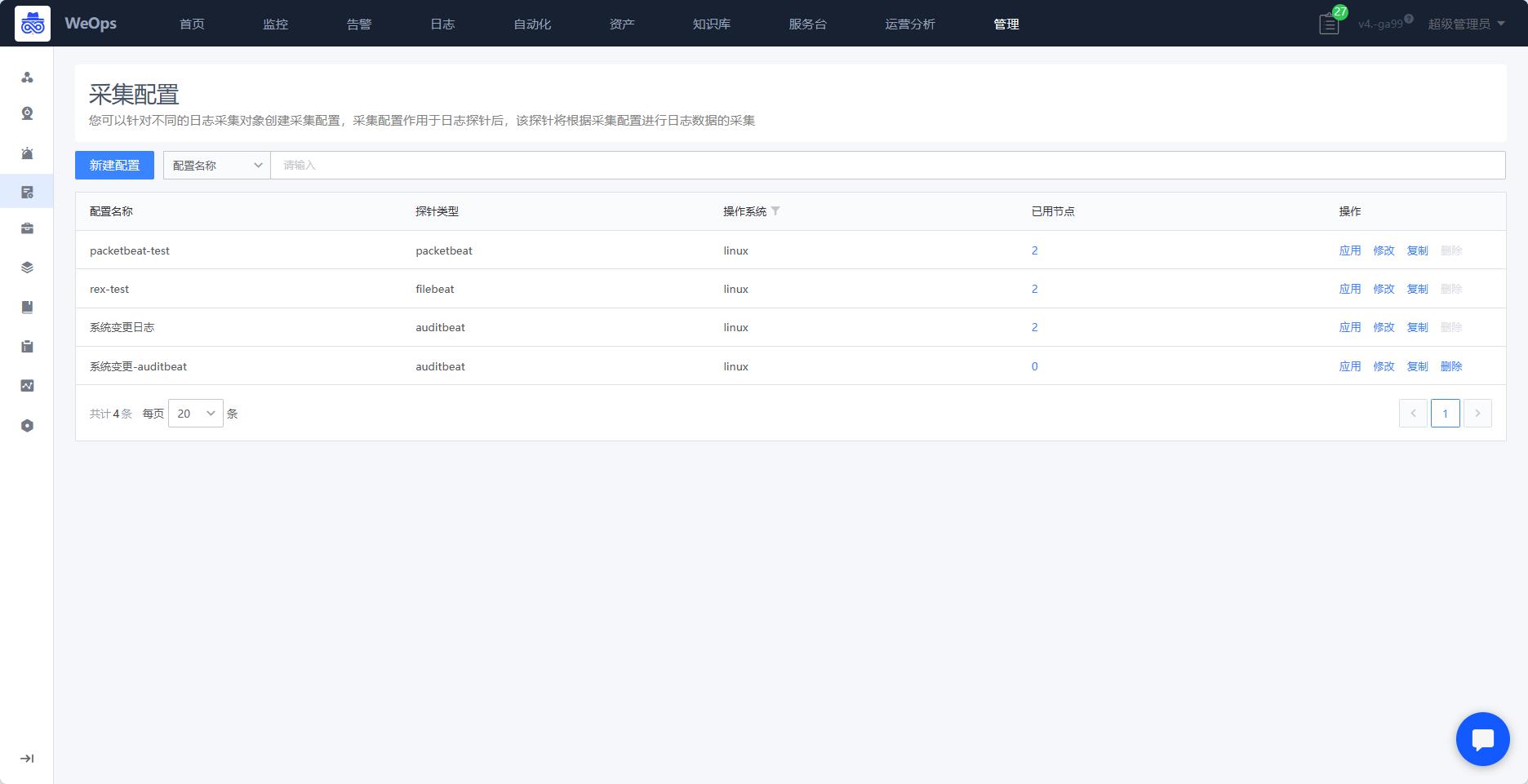

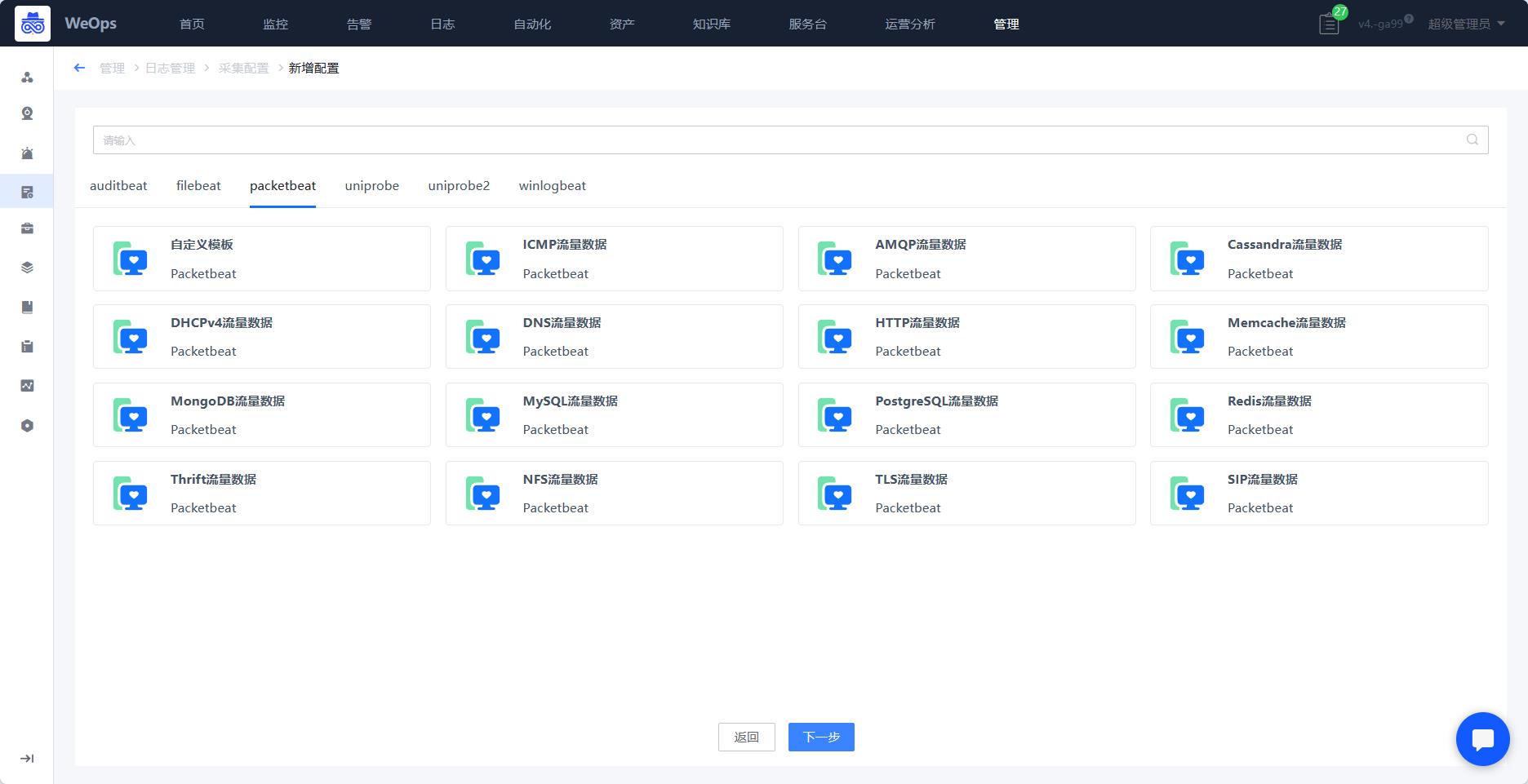

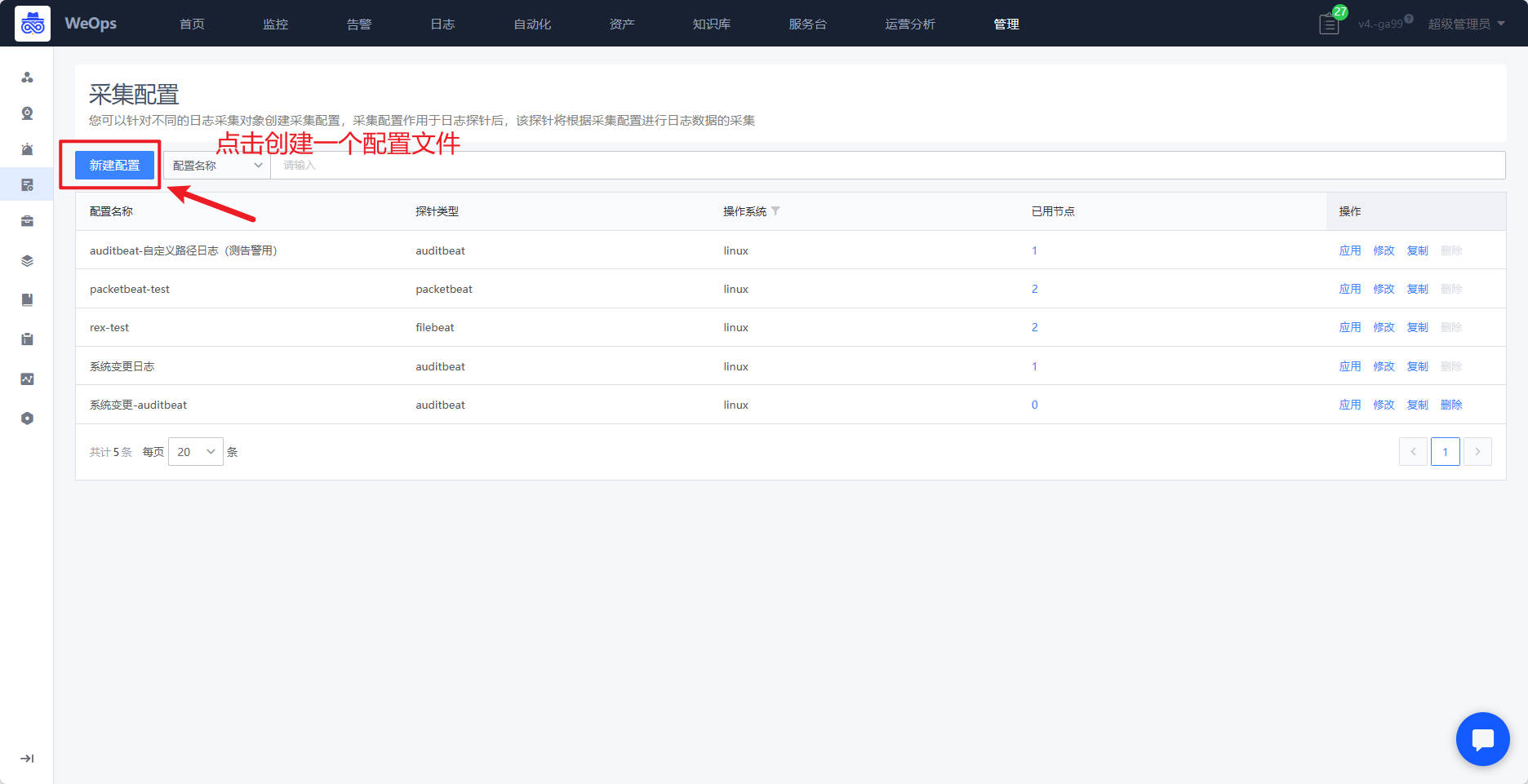

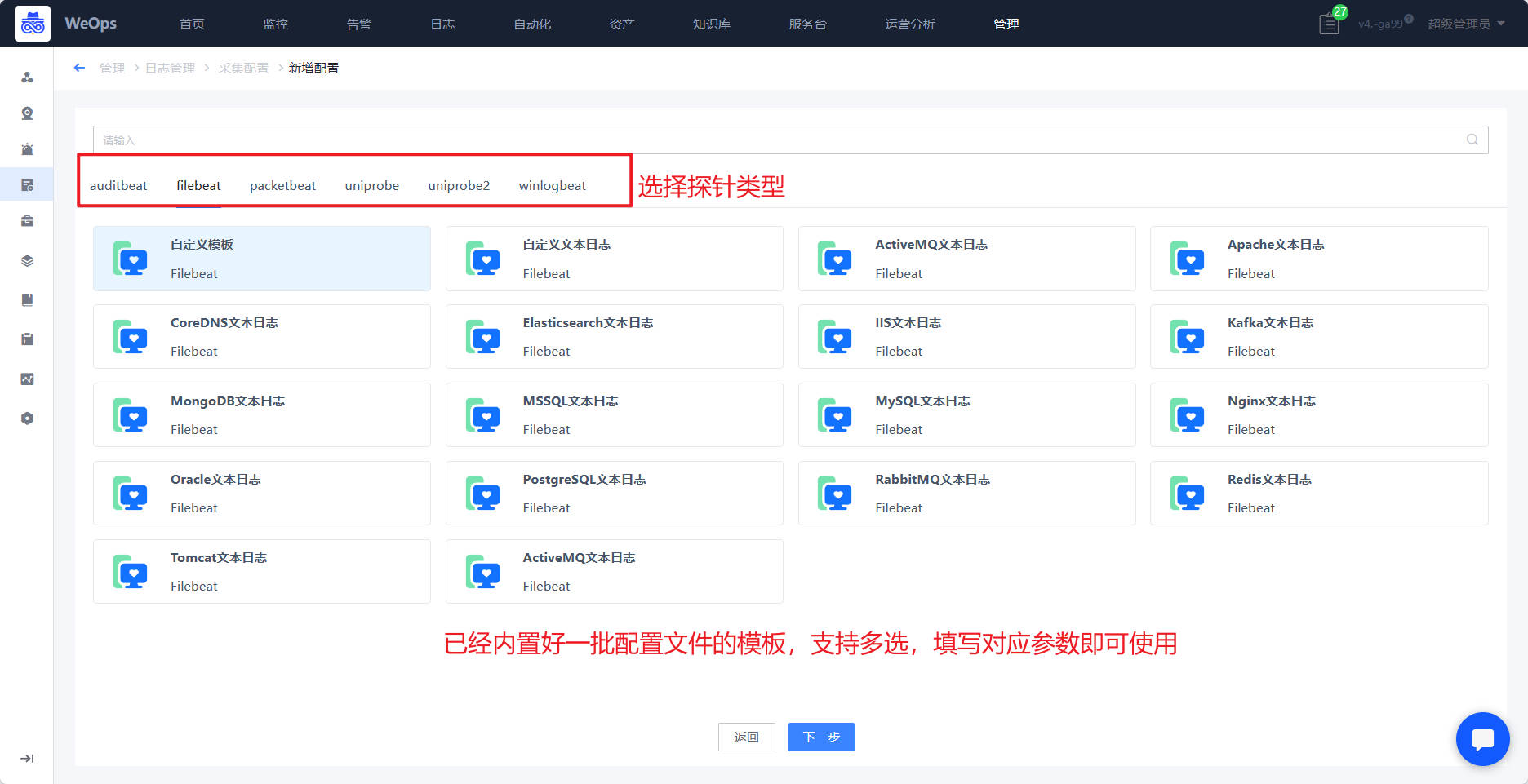

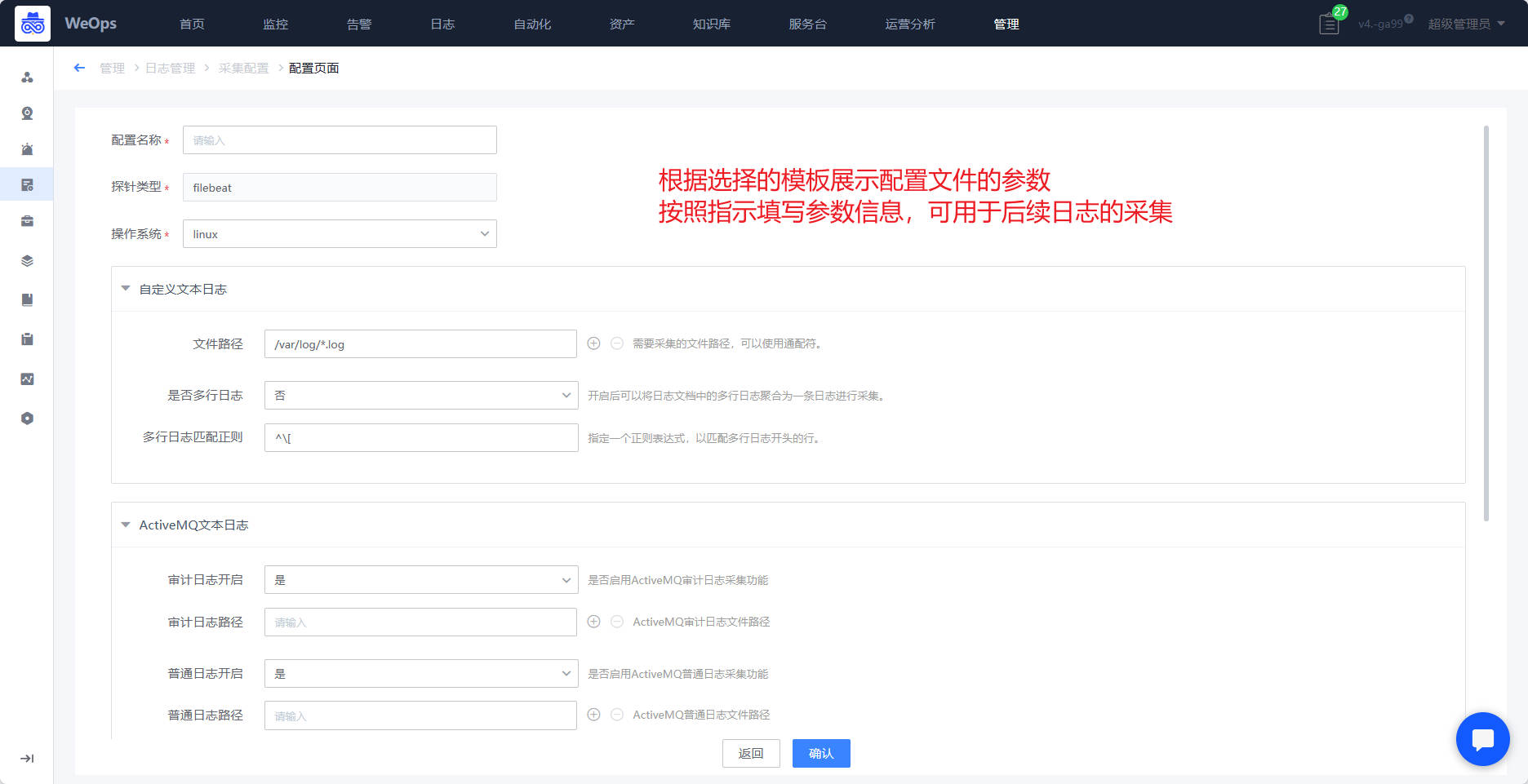

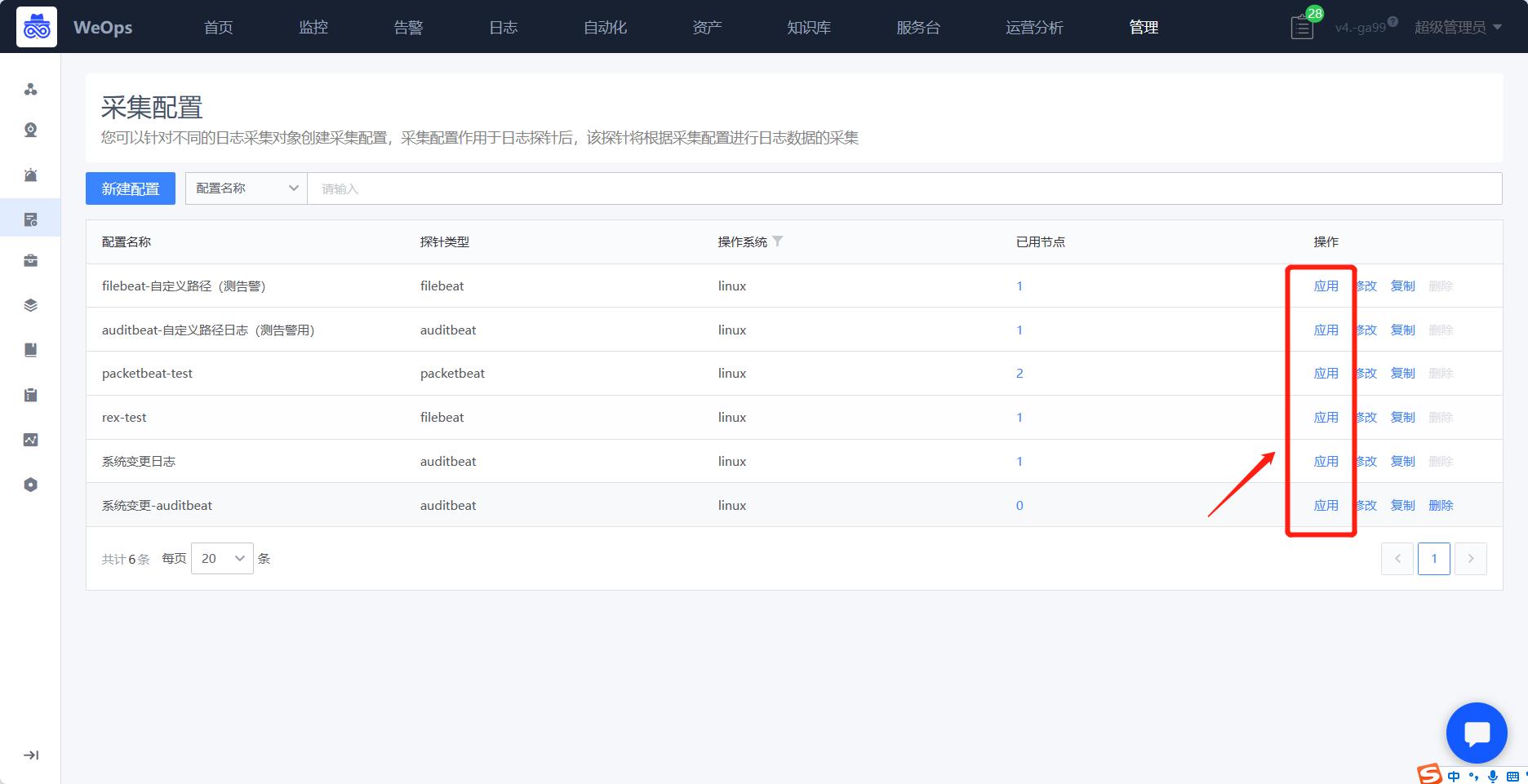

采集配置

- 可以针对不同的日志采集对象创建采集配置,采集配置作用于日志探针后,该探针将根据采集配置进行日志数据的采集

- 目前已经内置5类探针的数十种配置文件,可以根据需要采集的日志配置文件,进行采集

- 探针类的日志数据接入步骤详见《操作手册-3、日志设置-日志数据接入(探针模式)》

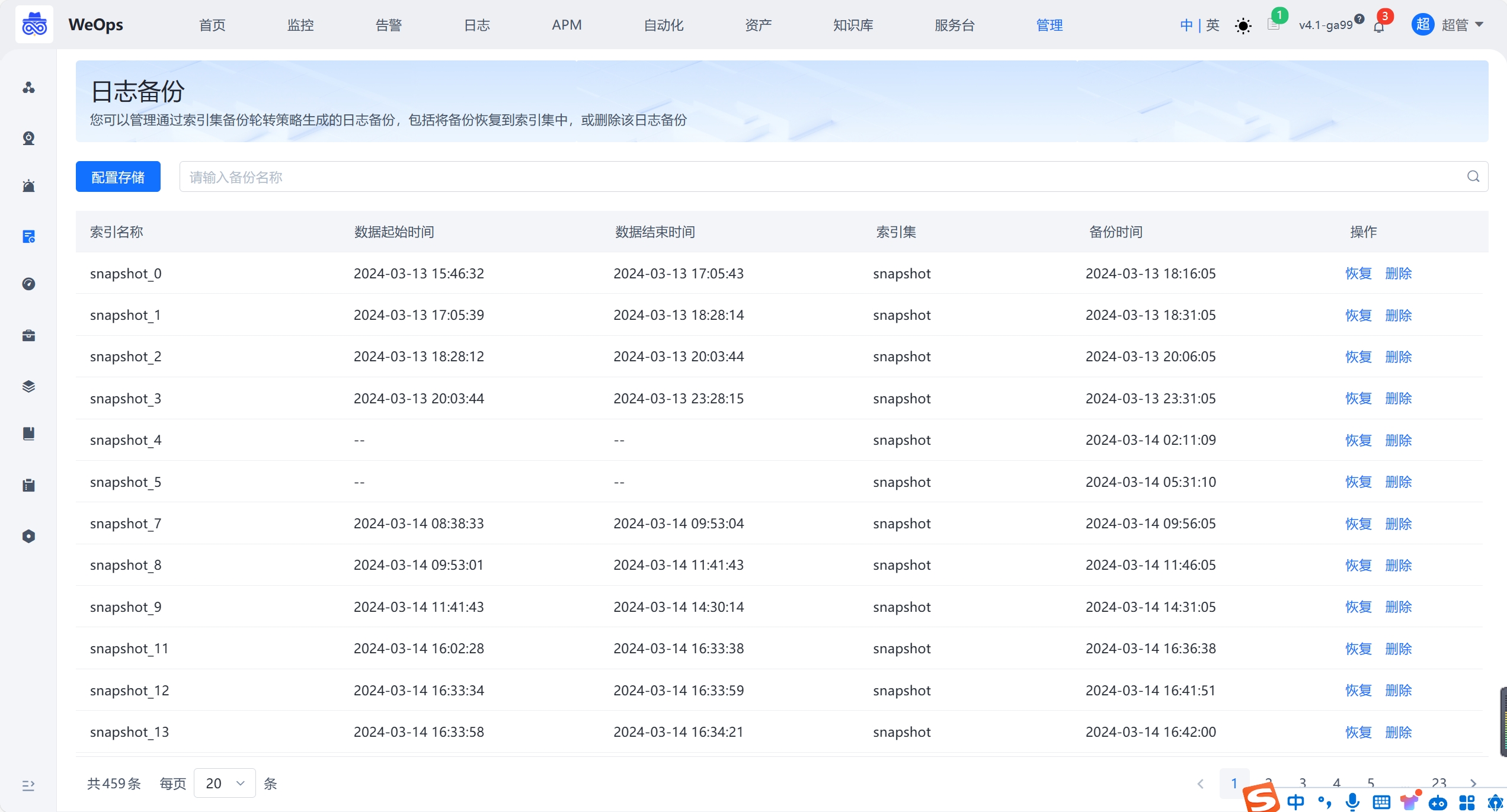

日志备份

- 日志数据的冷热分离是一种常见的数据管理策略,用于优化存储和检索大量日志数据,WeOps将日志数据分为两个类别:热数据和冷数据,并将它们存储在不同的存储介质上,可以实现更高效的存储和检索,同时减少存储成本。

- WeOps配置日志存储,并支持日志备份和恢复

APM管理

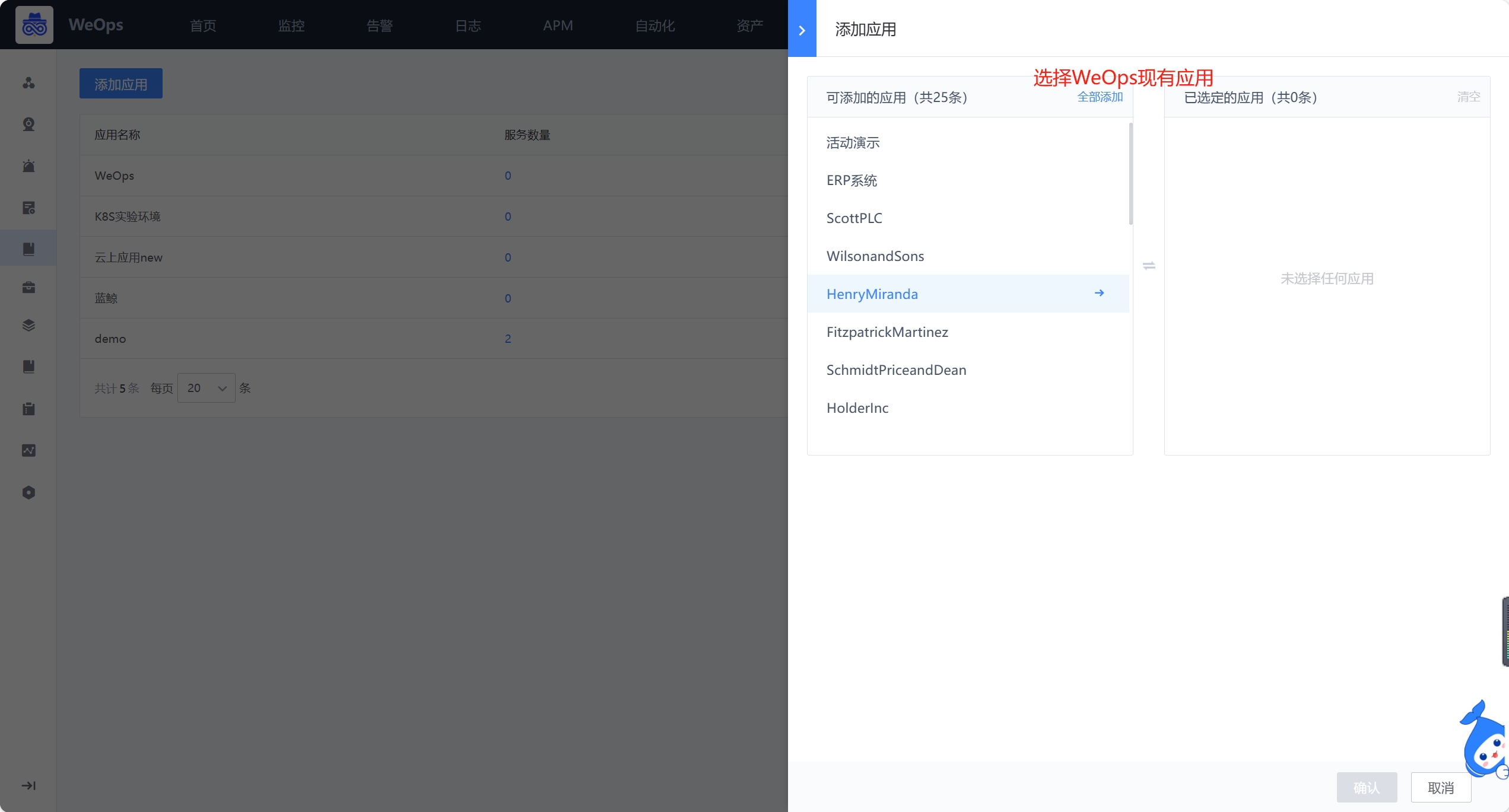

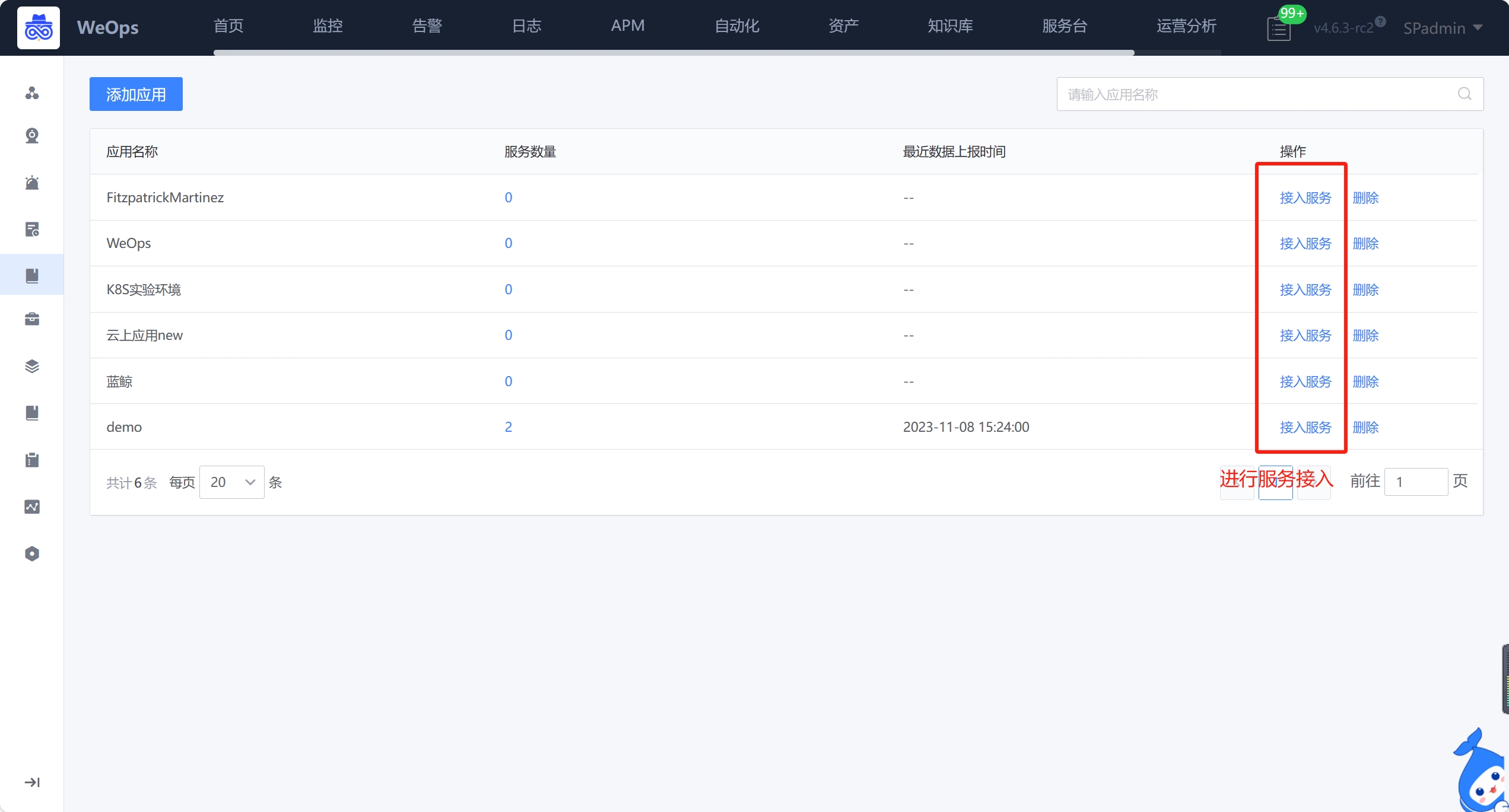

应用接入

应用接入用于管理接入APM的应用,进行数据接入以及查看接入服务的数据上报情况。

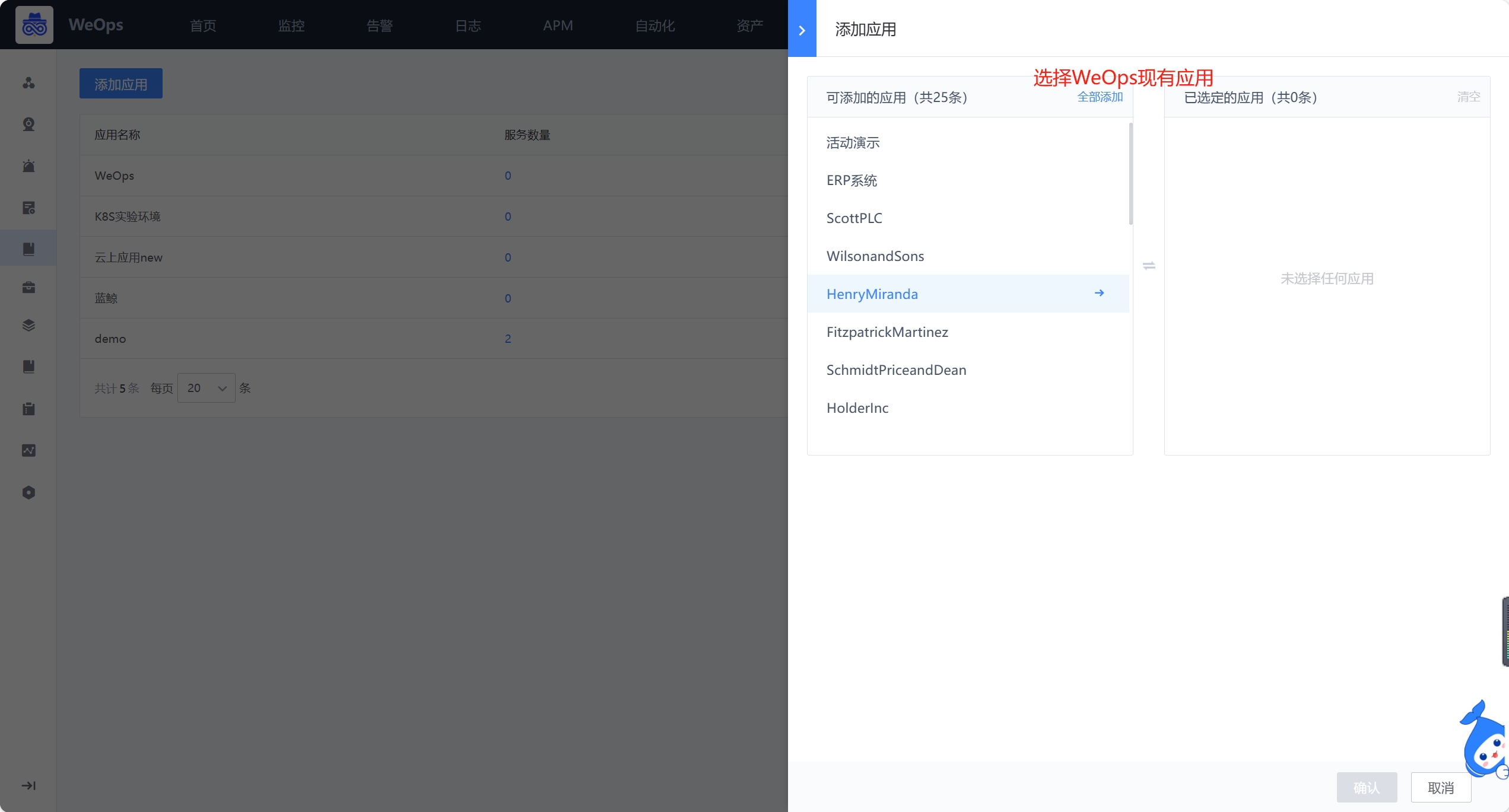

- 添加应用:支持选择WeOps现有应用,加入列表后,并为该应用接入服务

- 为应用进行服务的接入,WeOps采用无代码入侵的方式进行探针的安装和采集,支持java、python等开发语言和数十种开发框架(具体开发框架详见《内容说明——4、APM内容说明》),接入成功后,可以查看各个服务的数据上报情况。

- 健康配置:为了呈现应用/服务/接口的健康状态,支持以“平均时延P95”作为指标,进行阈值的设置和健康状态的展示,分为三个等级“正常、缓慢、异常”,设置成功后,在应用/服务的拓扑图展示每个服务的健康状态,在接口分析中展示接口整体健康状态,并以折线图展示健康状态变化。

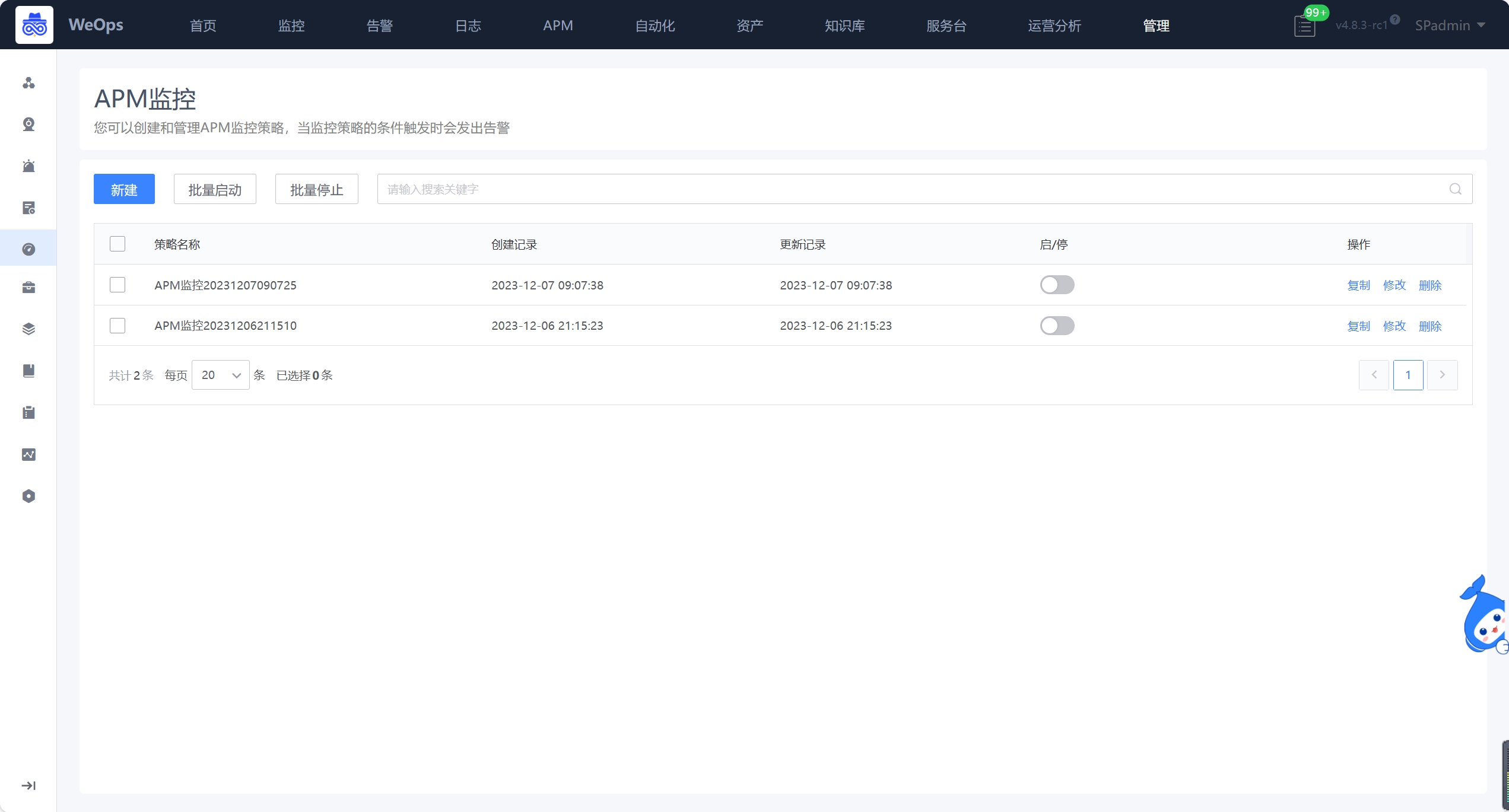

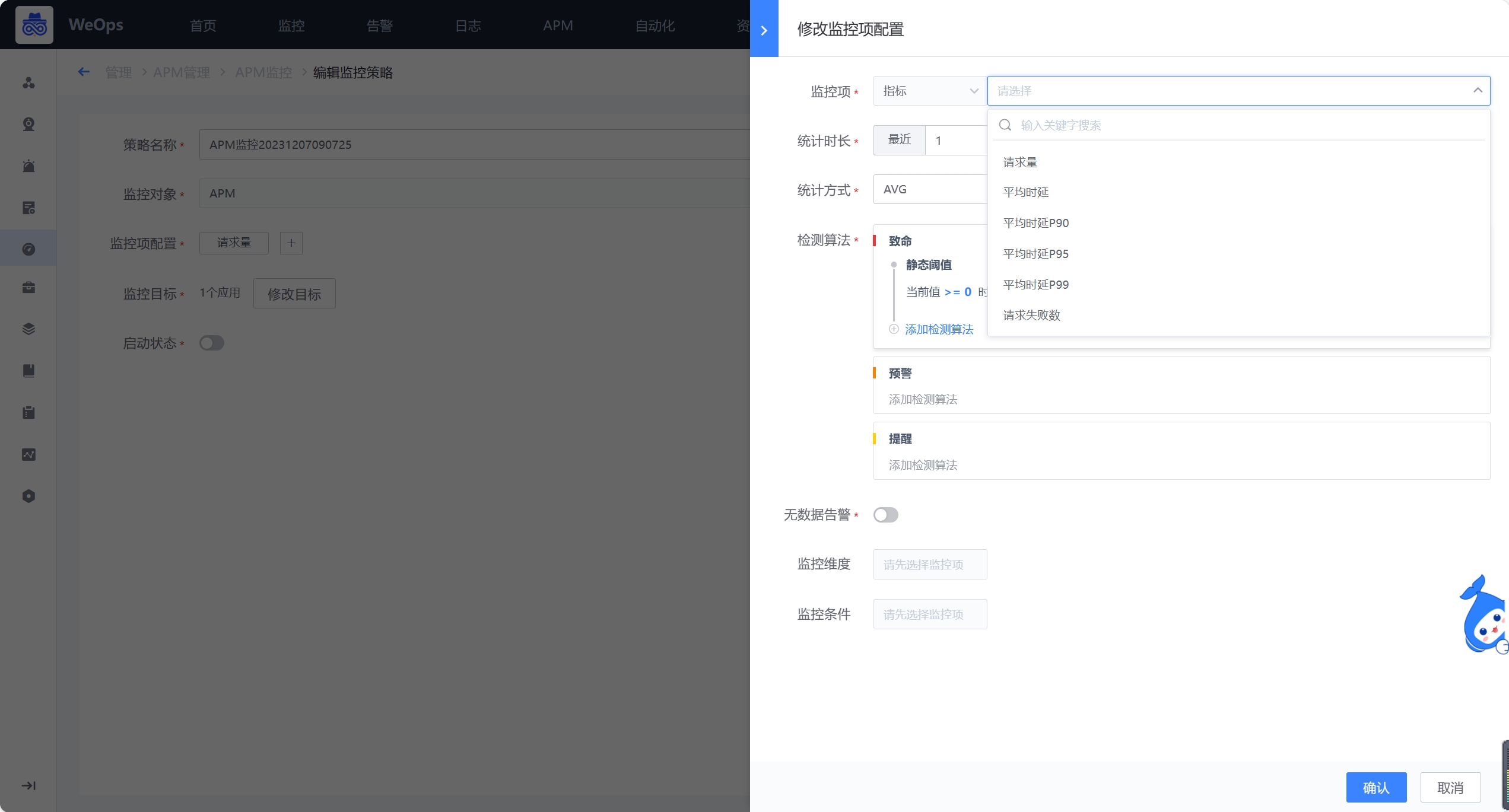

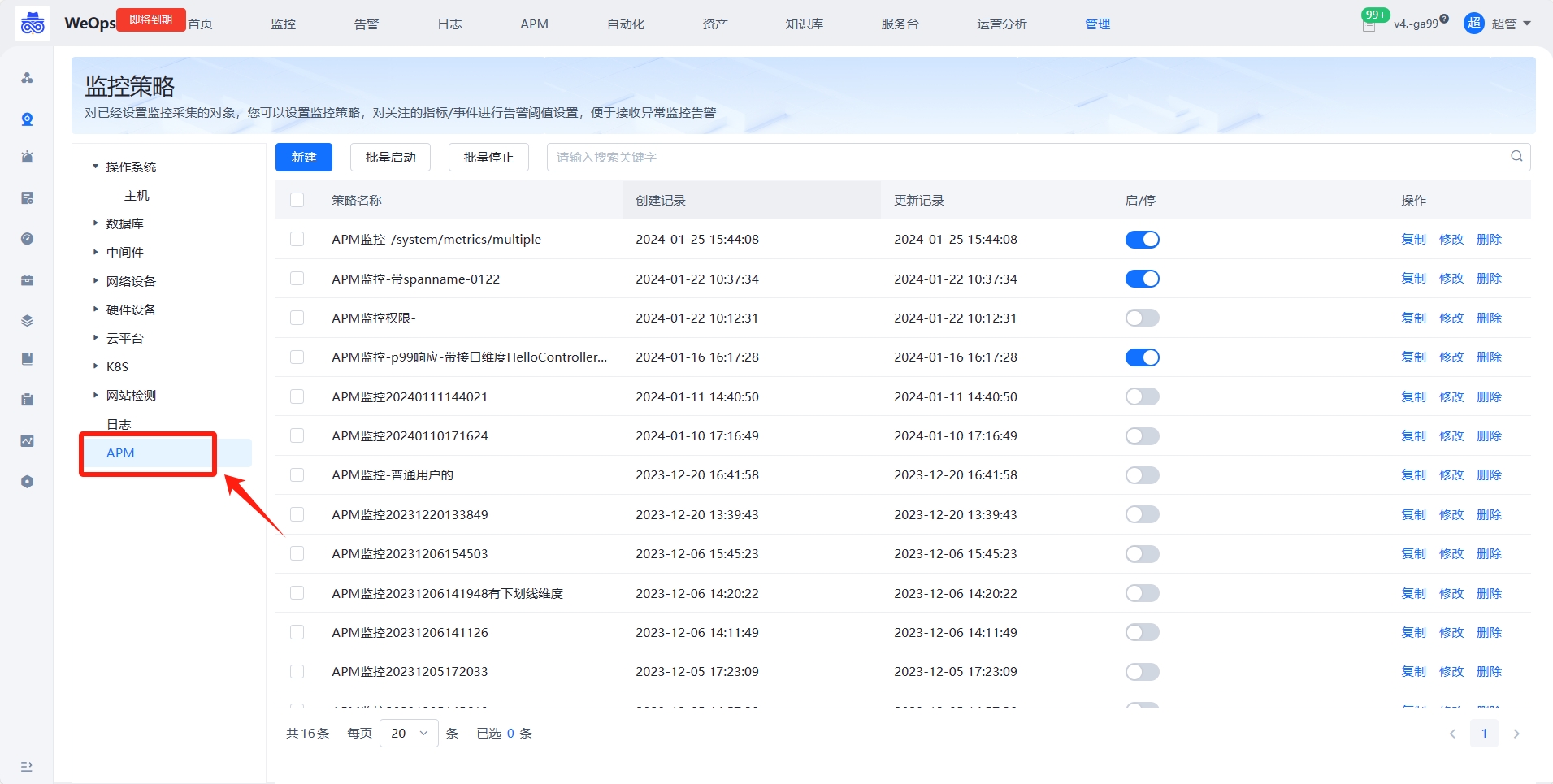

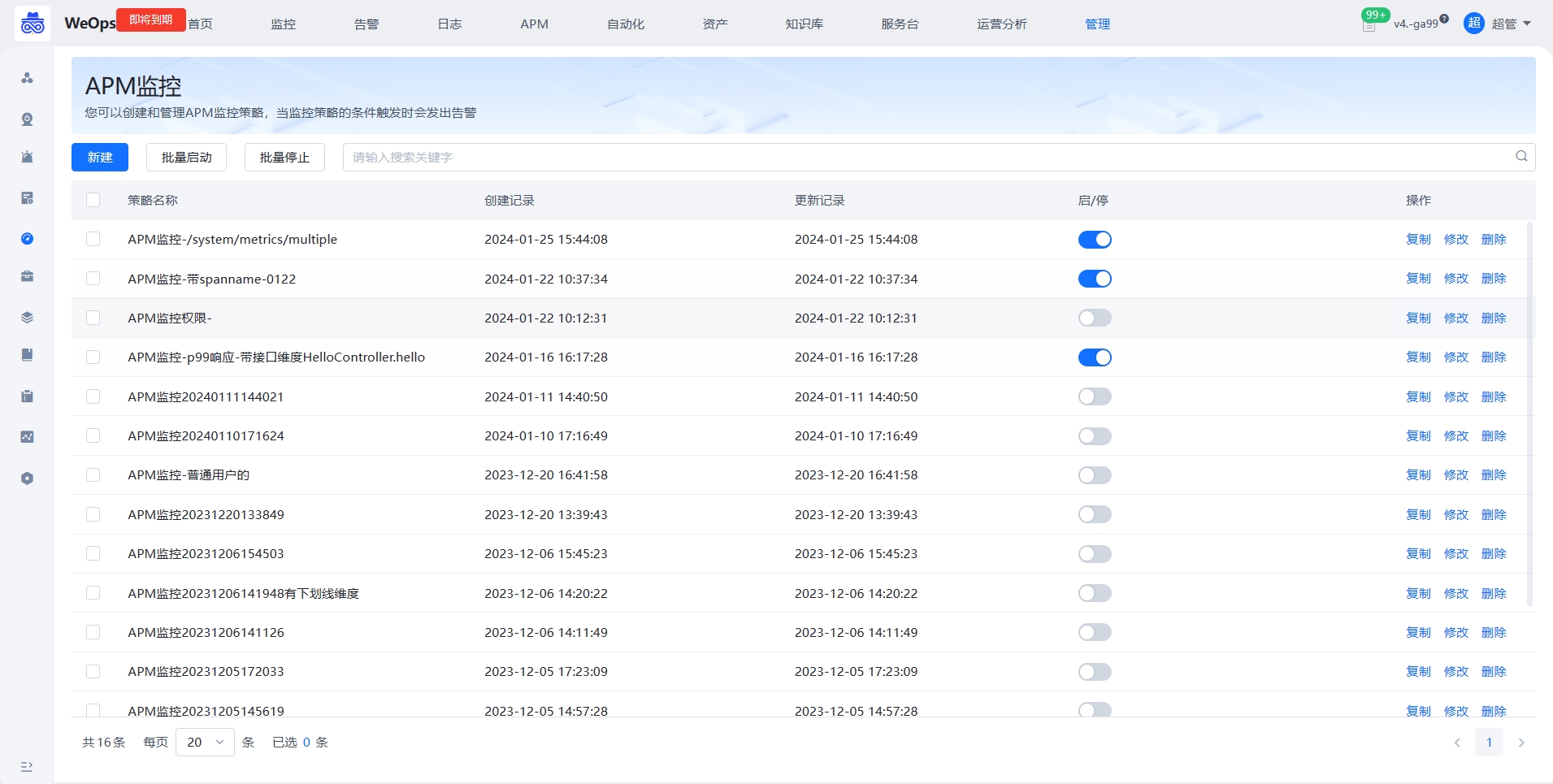

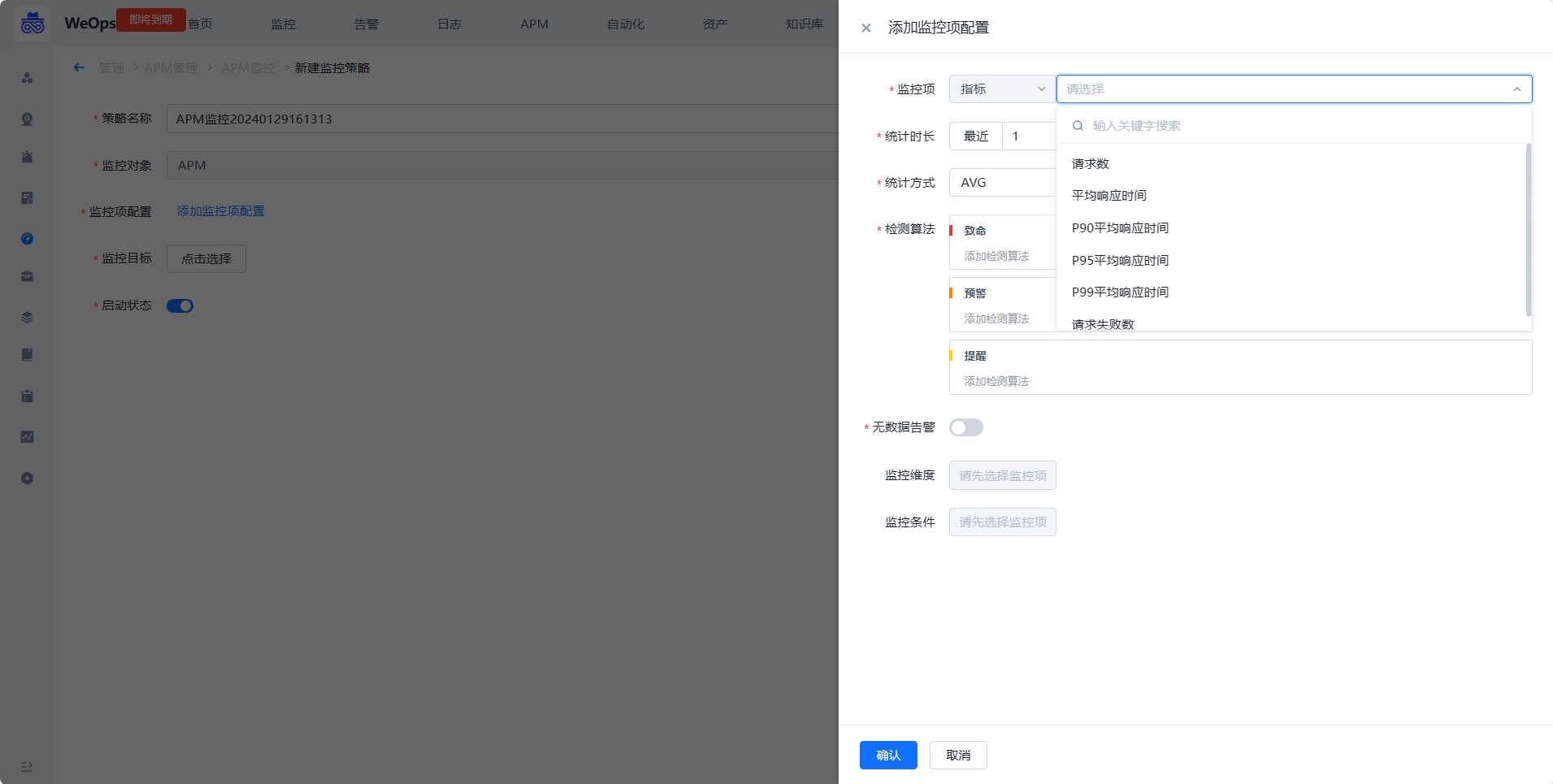

APM监控

- 可以创建和管理APM监控策略,当监控策略的条件触发时会发出告警

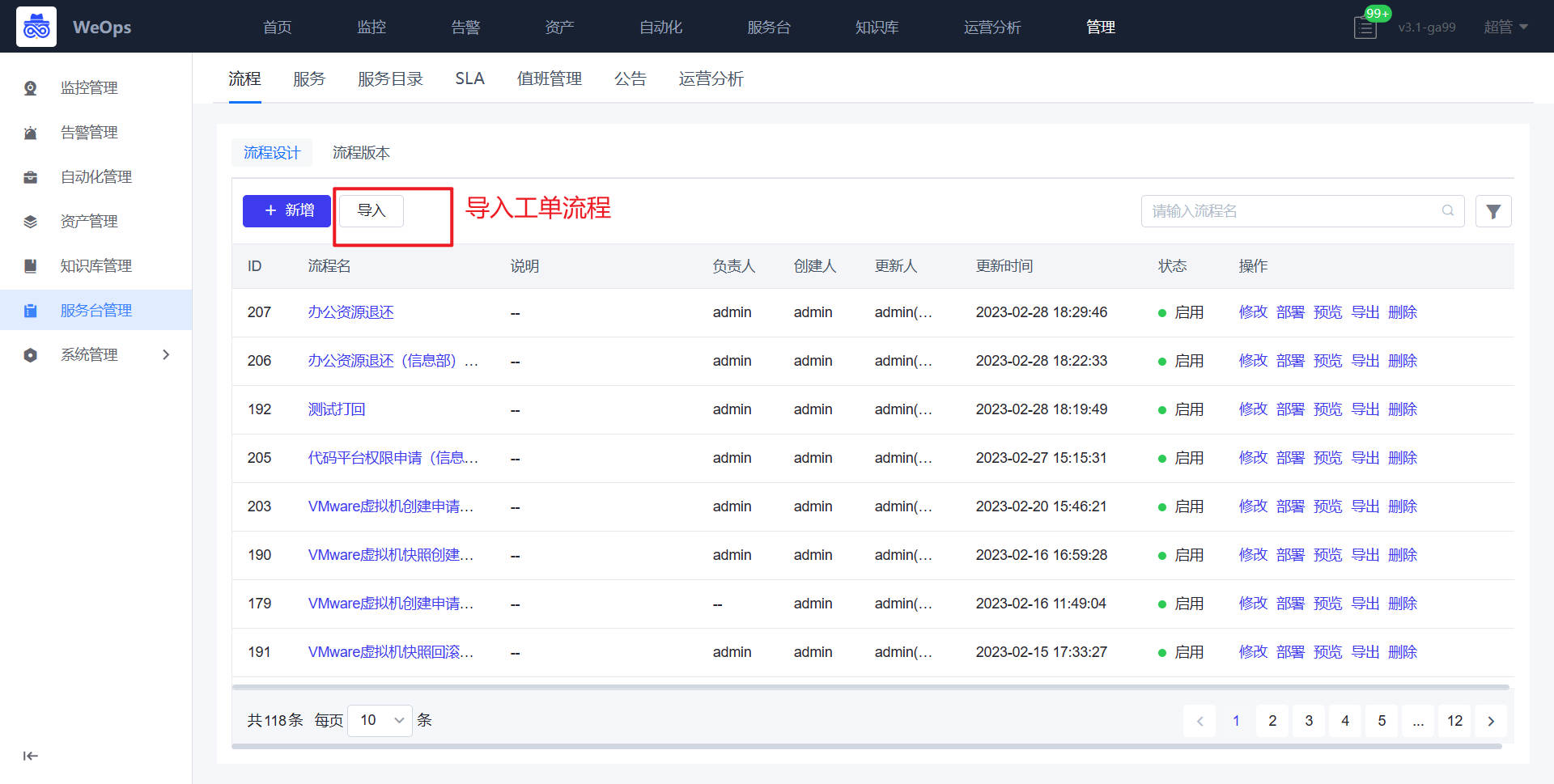

服务台管理

服务台管理主要进行IT服务台的后台配置,包括“流程”、“服务”、“服务目录”、“SLA”、“运营分析”、“值班管理”、“公告”

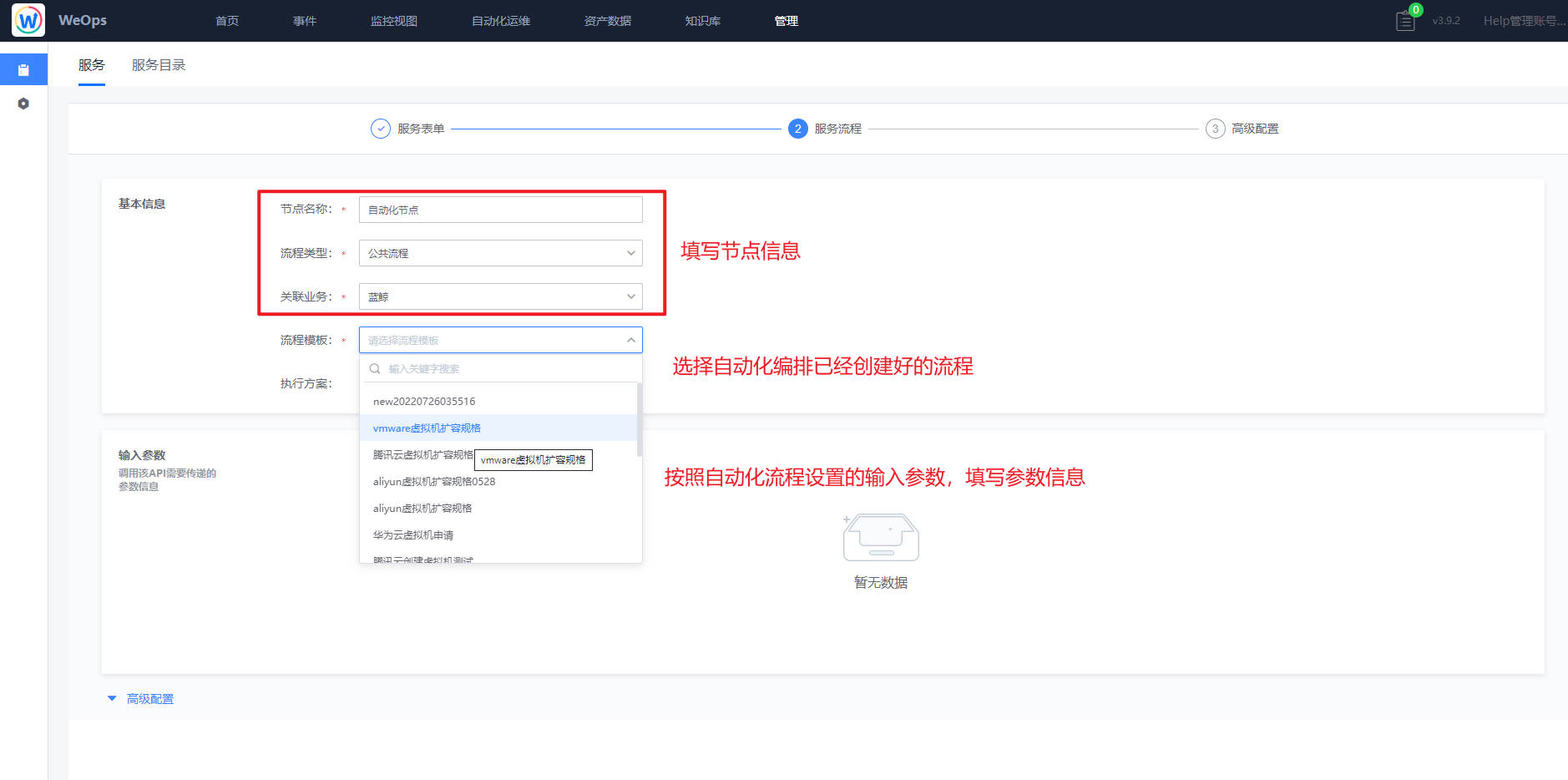

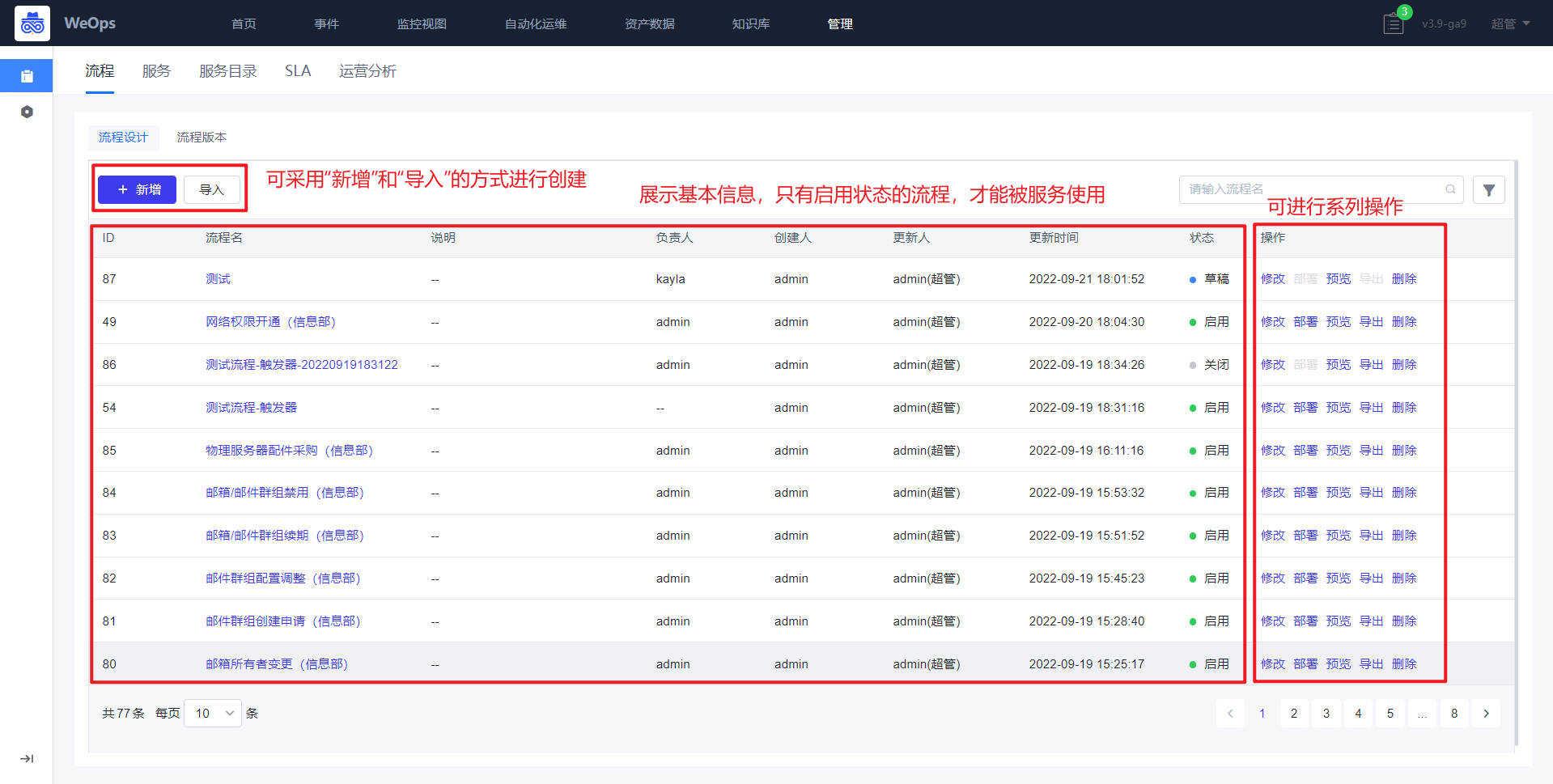

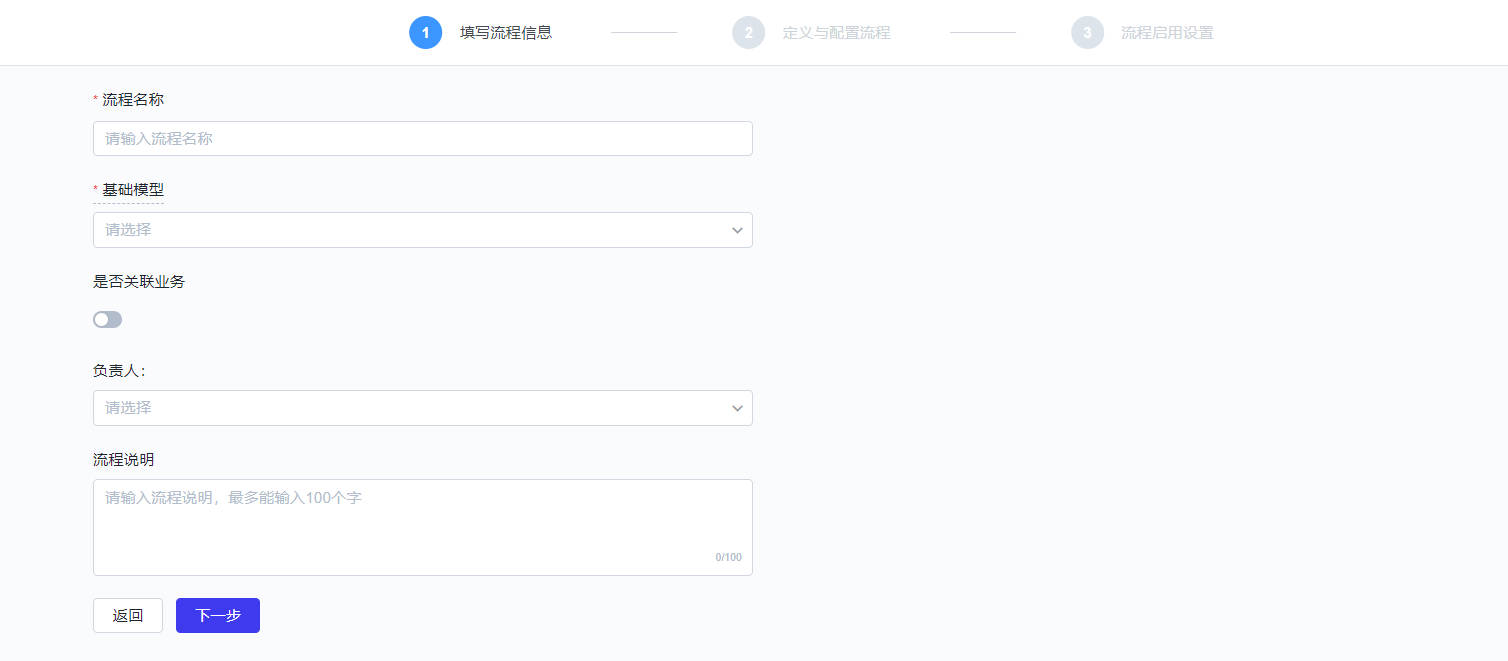

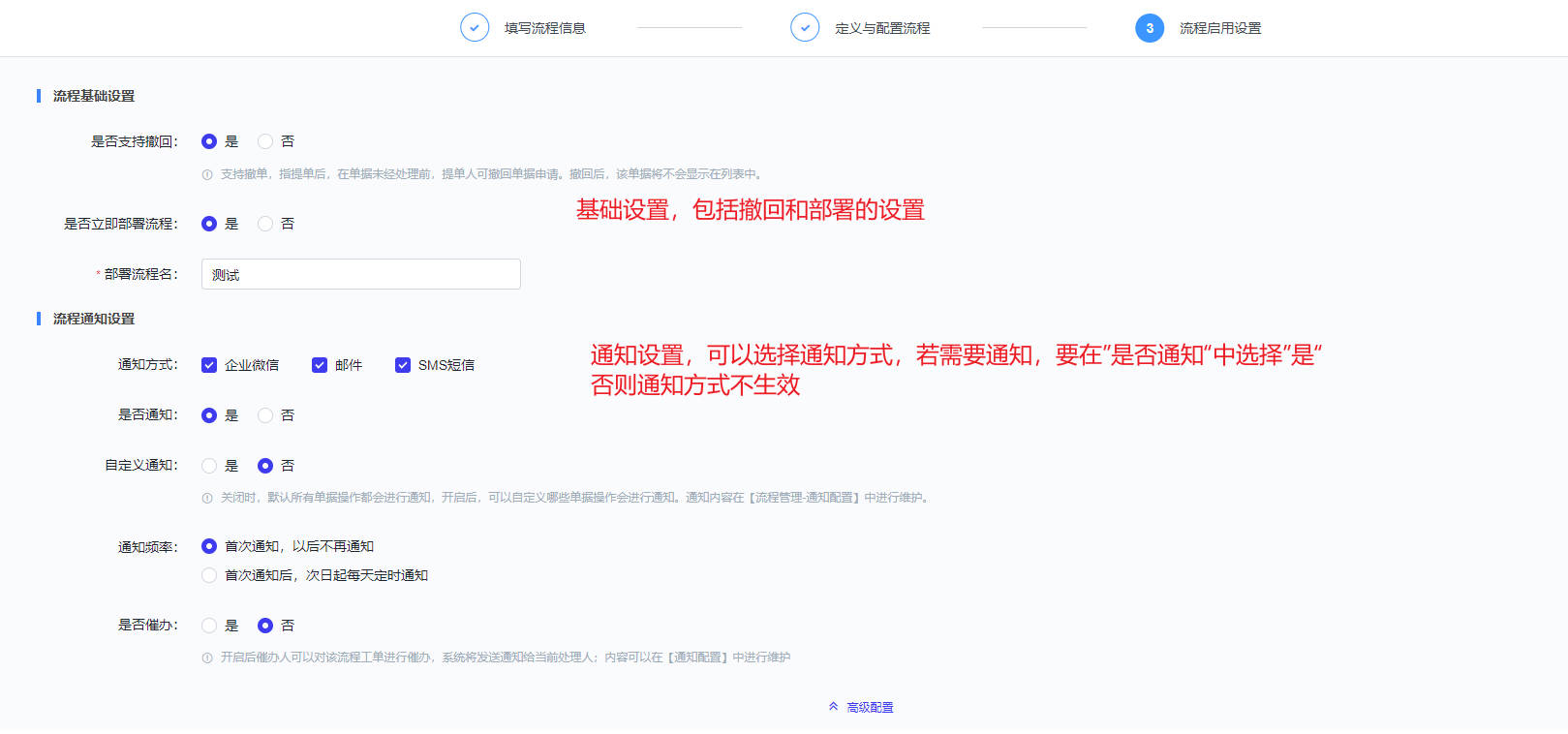

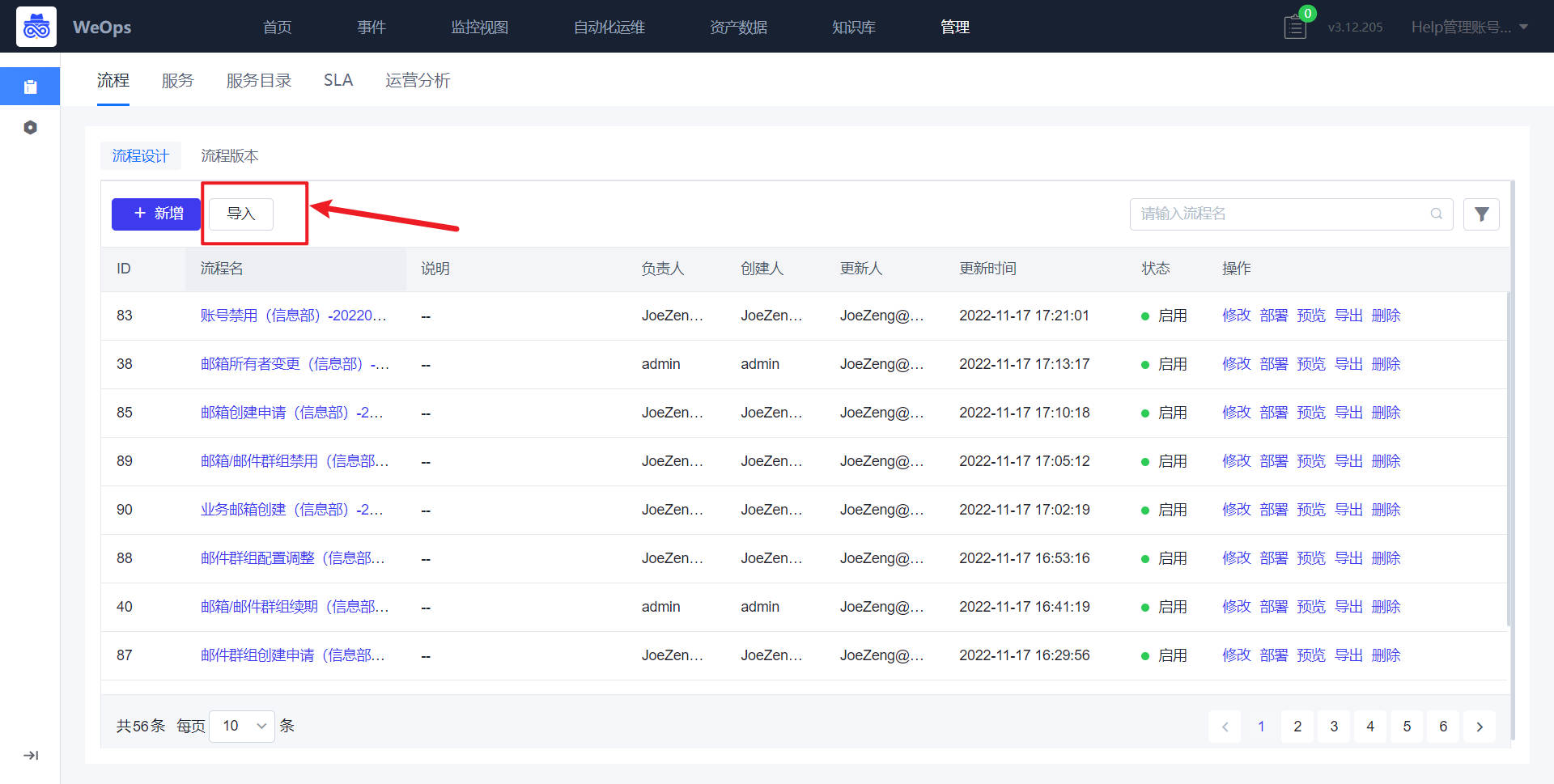

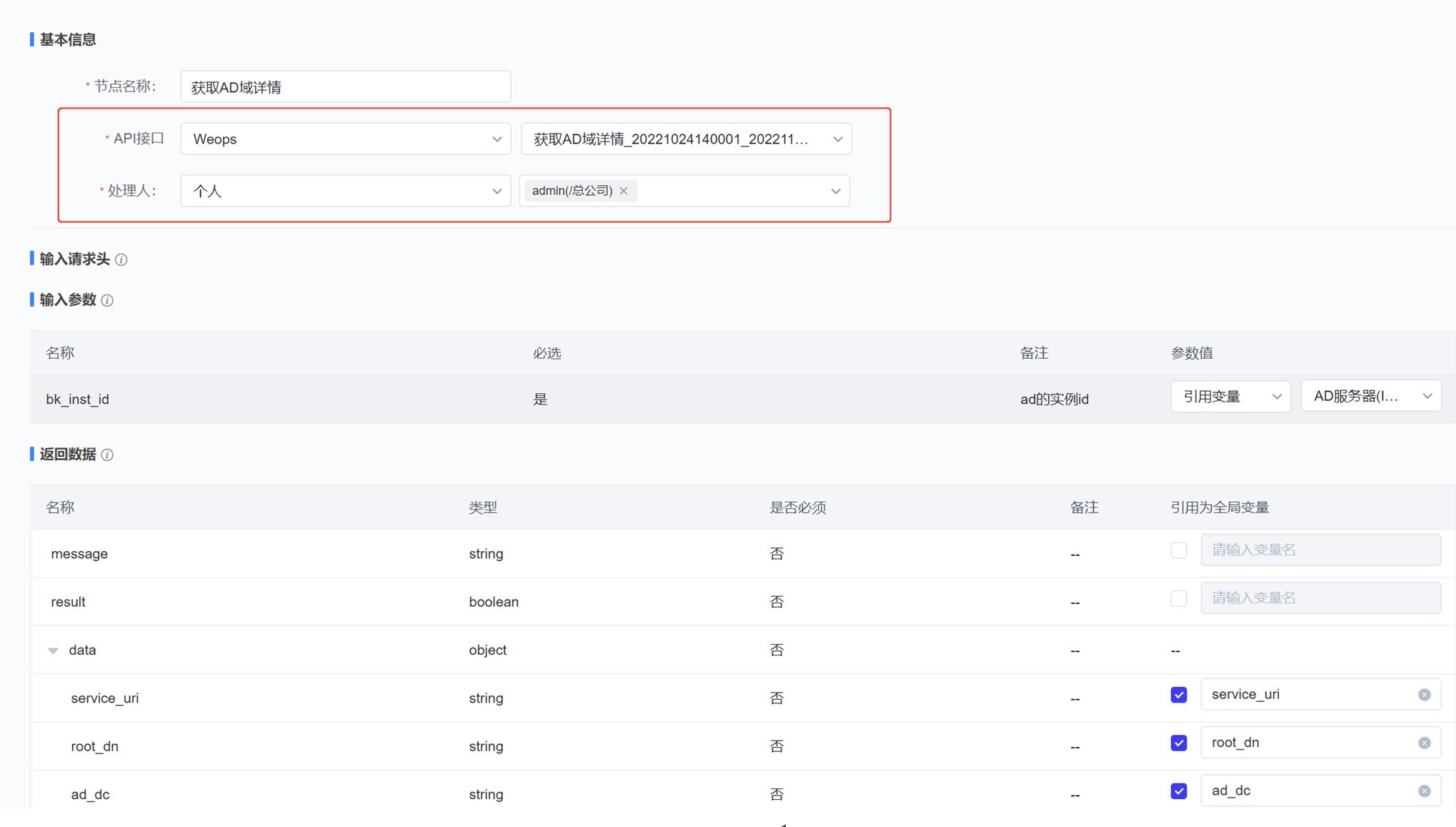

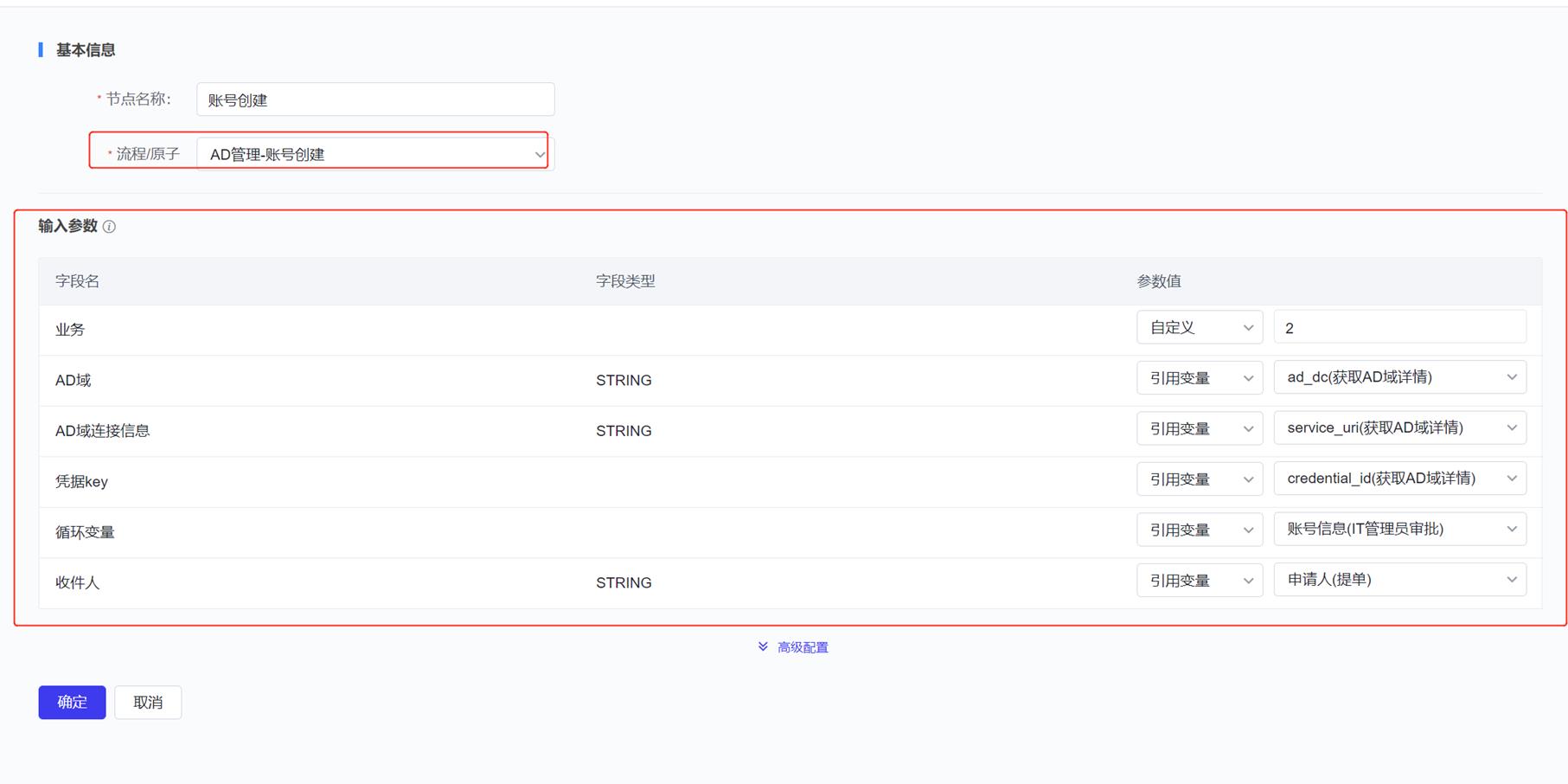

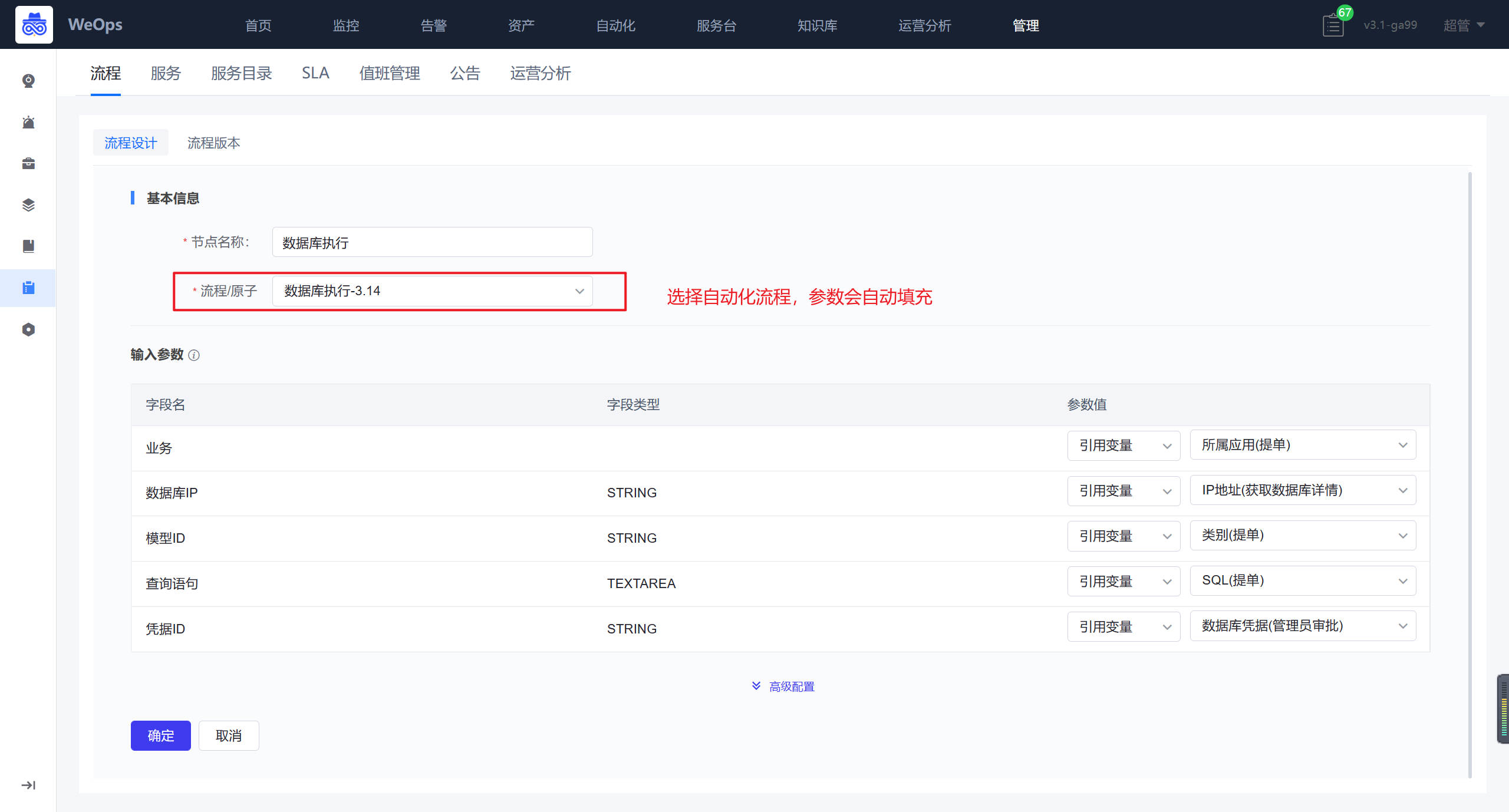

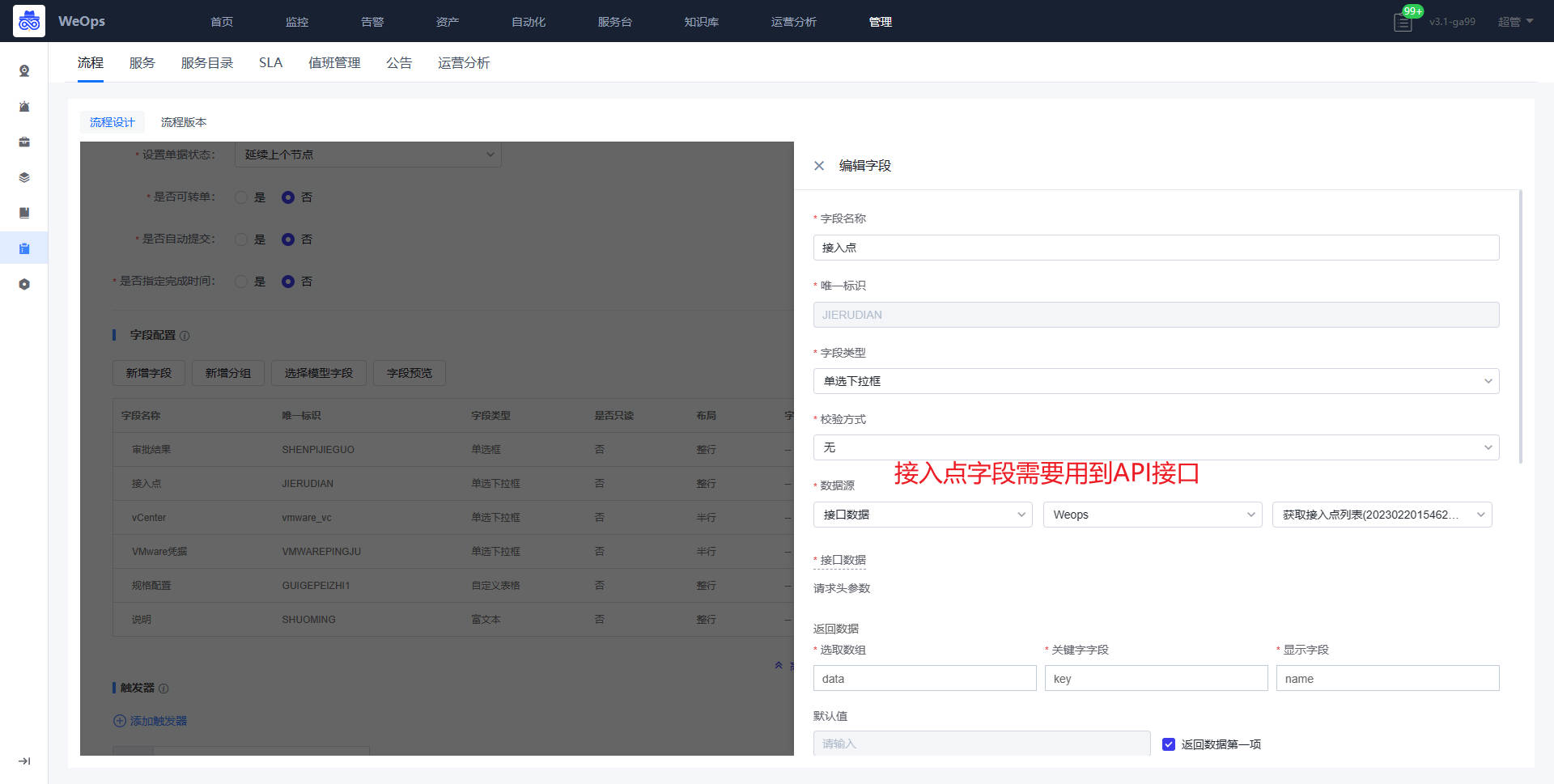

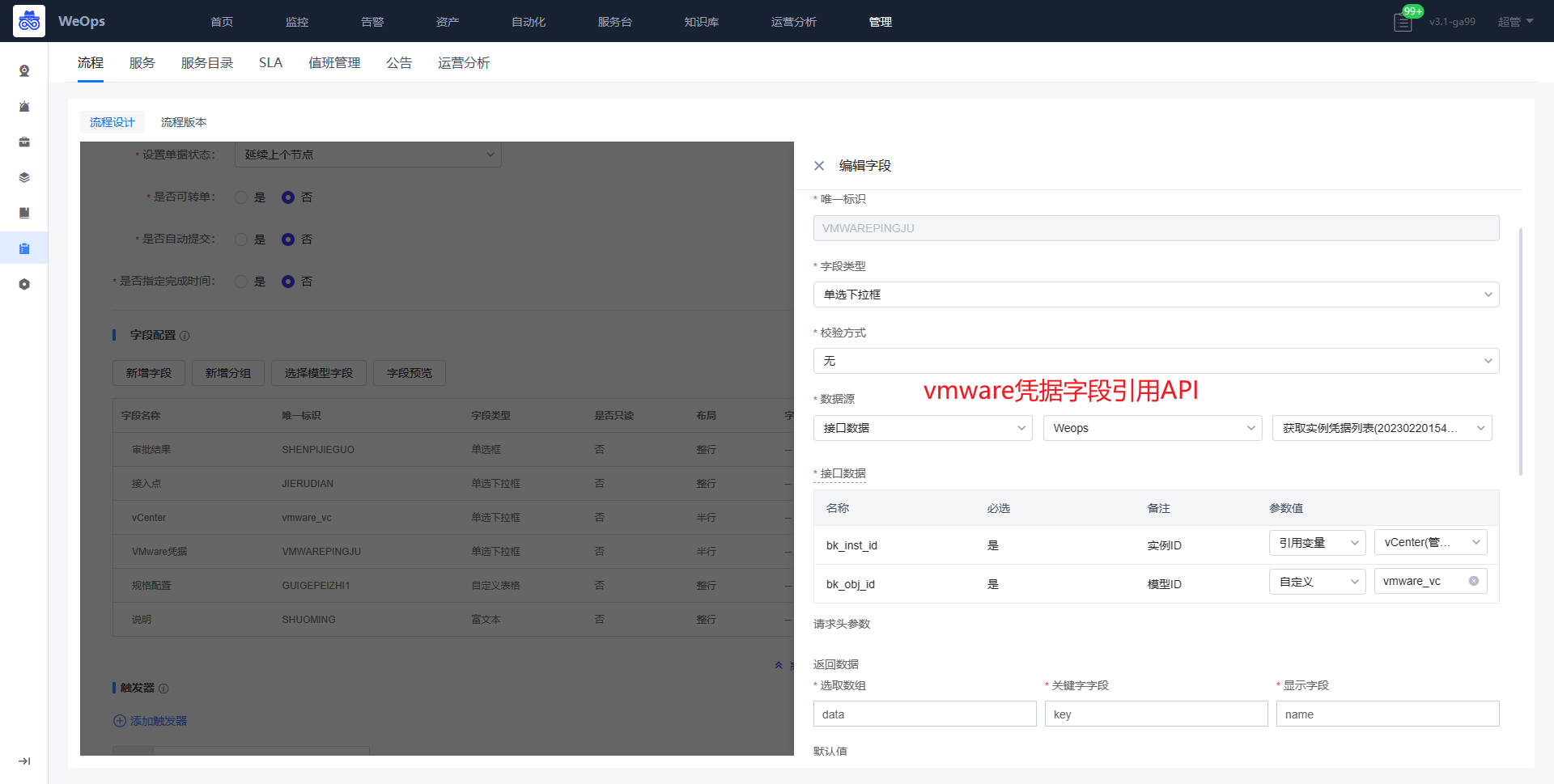

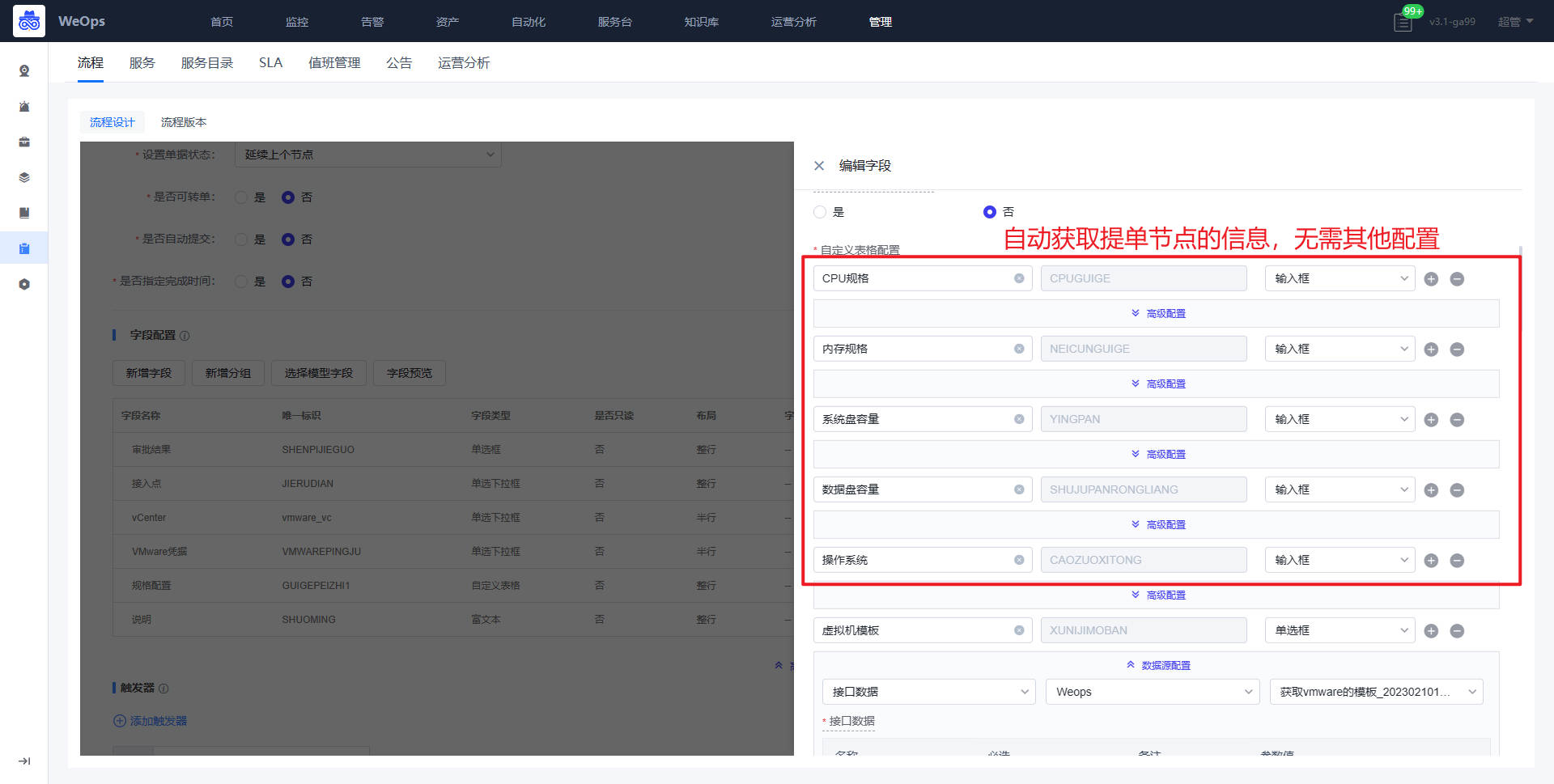

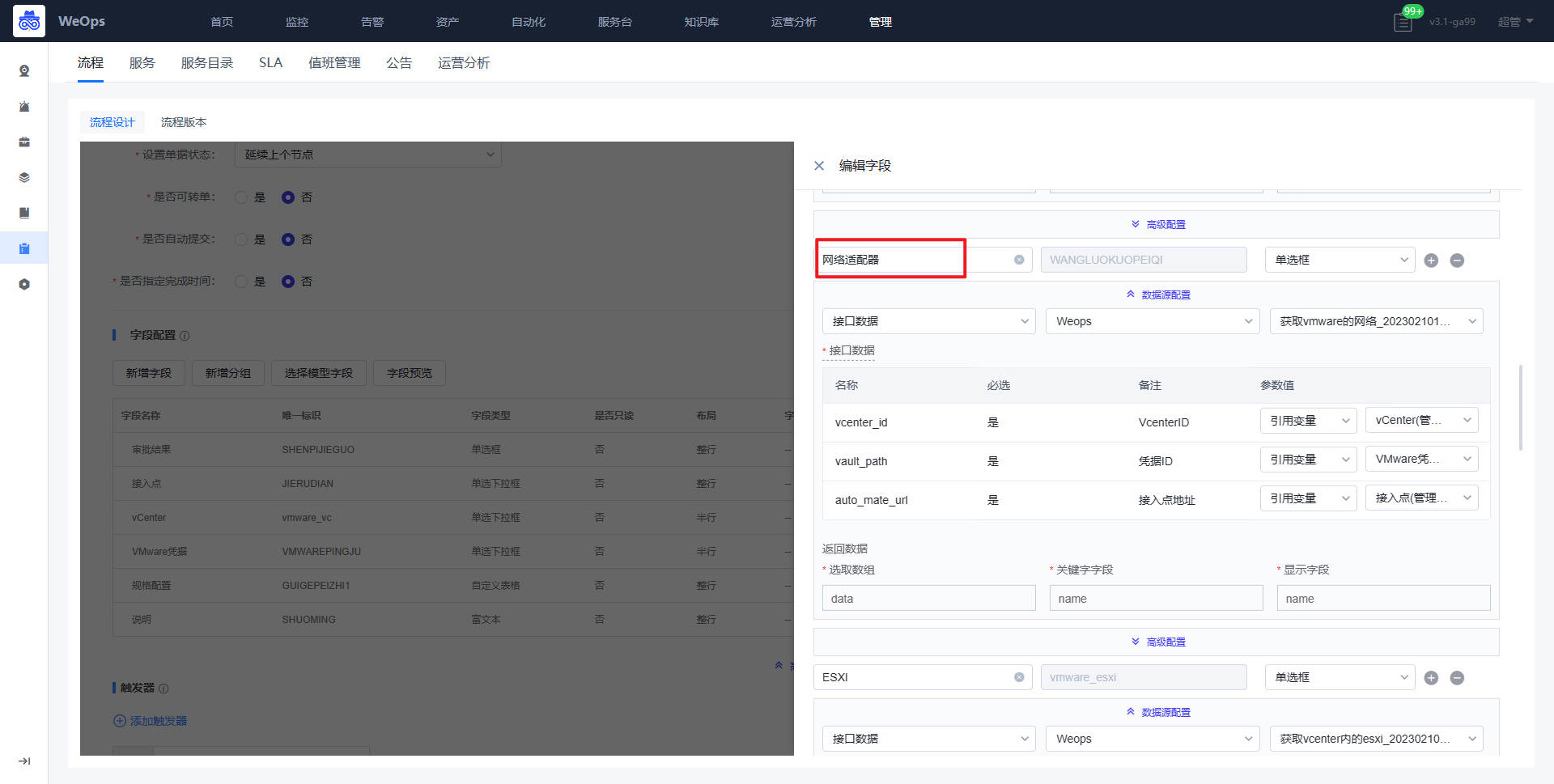

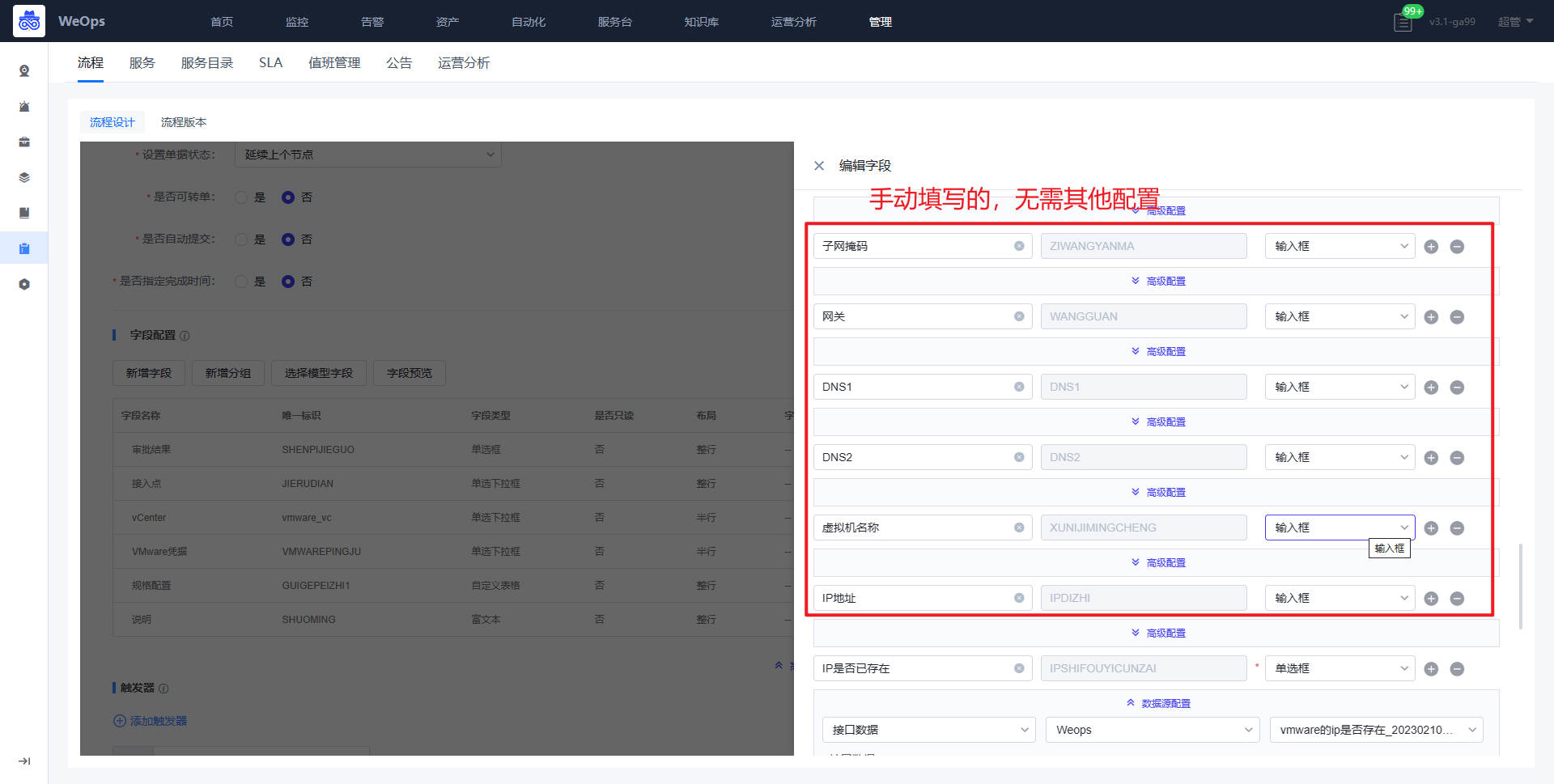

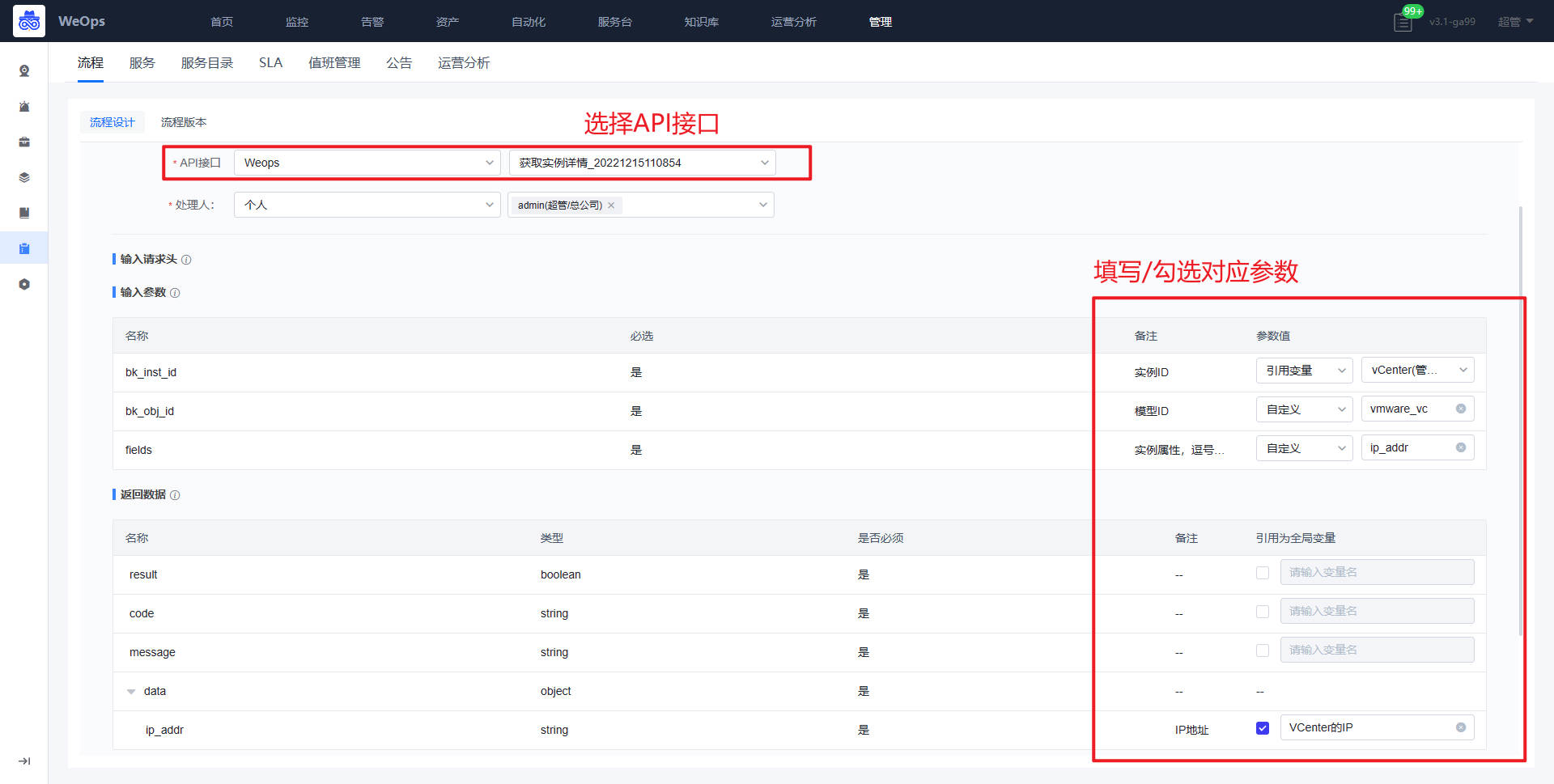

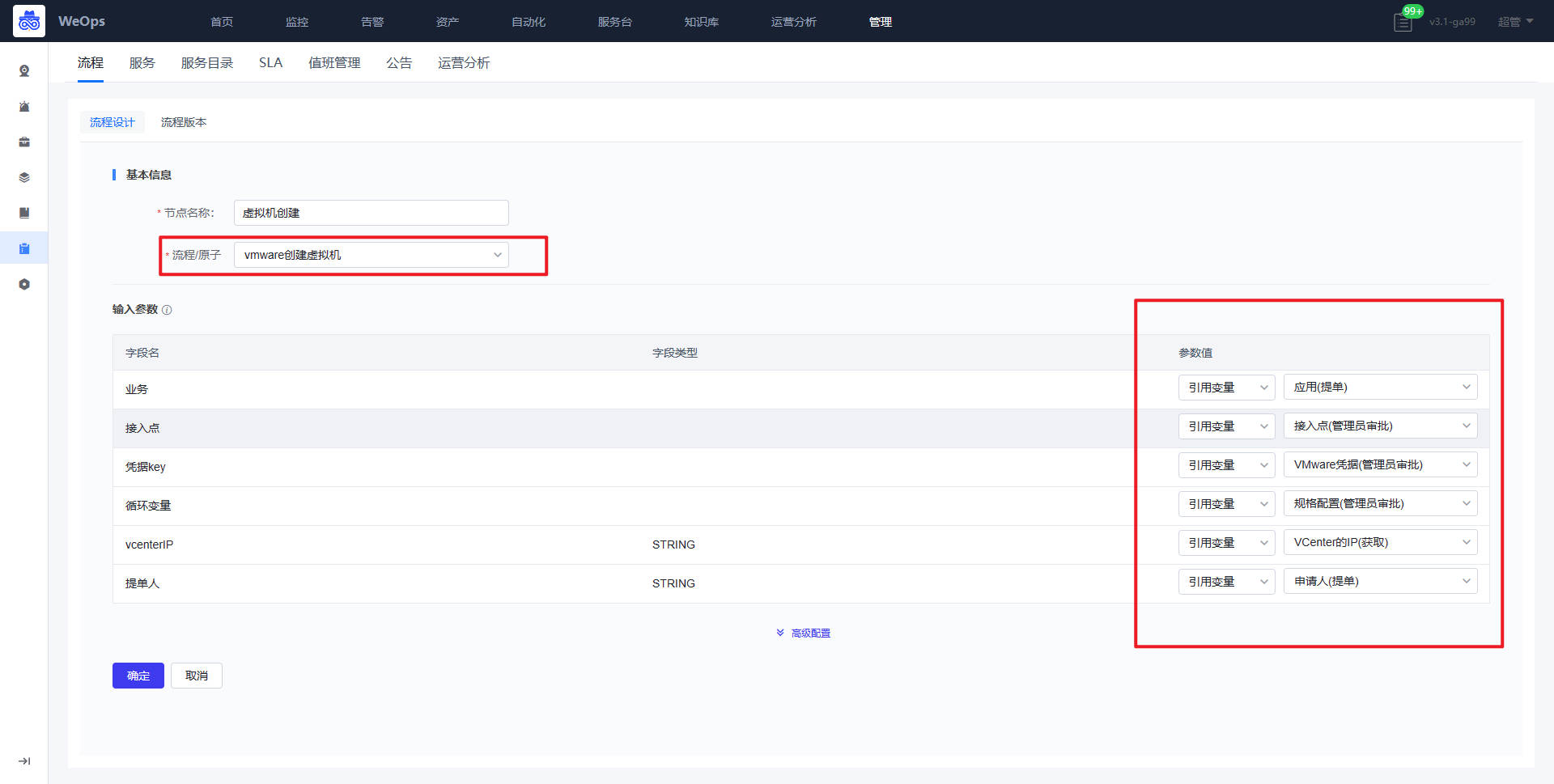

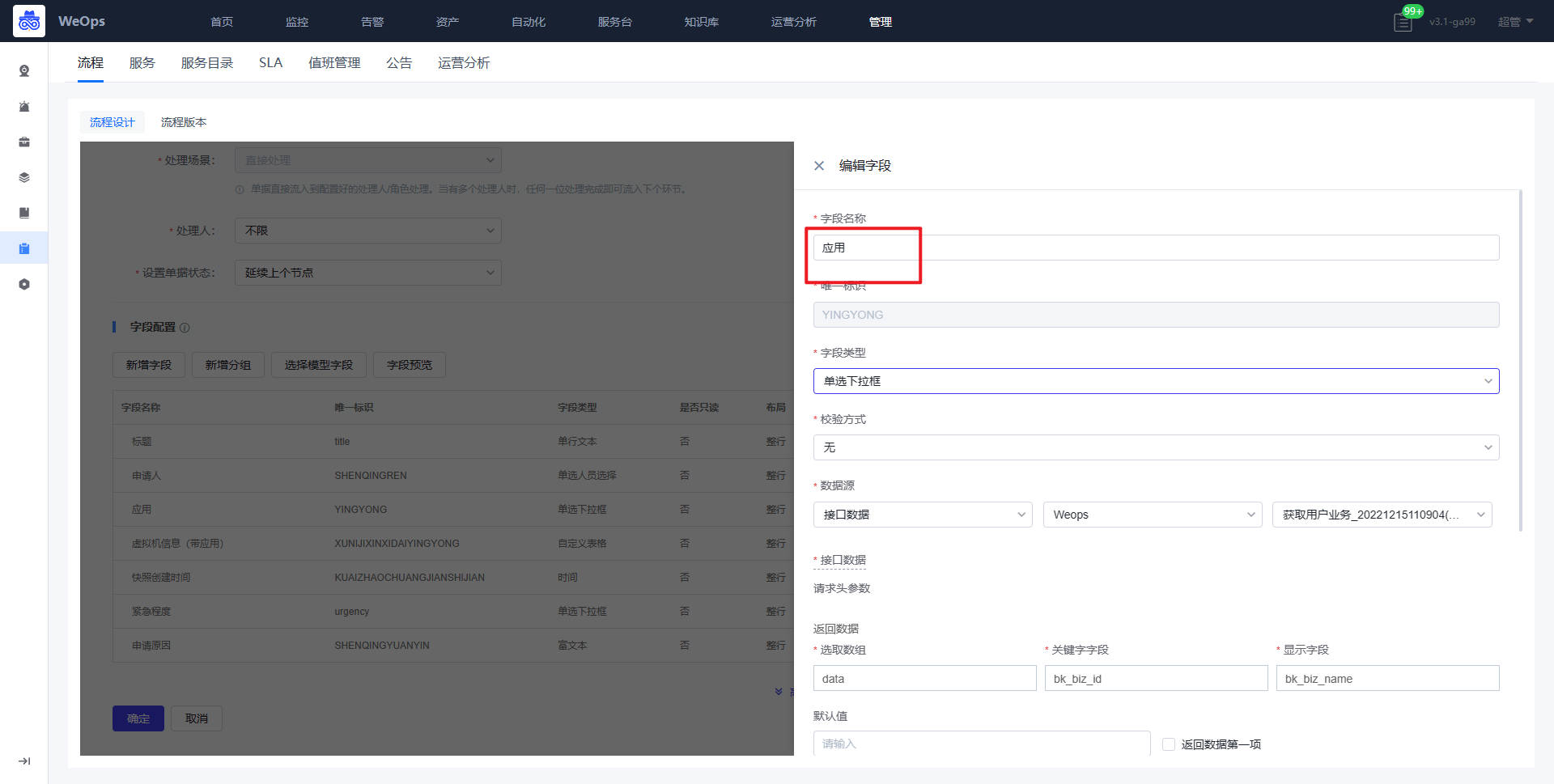

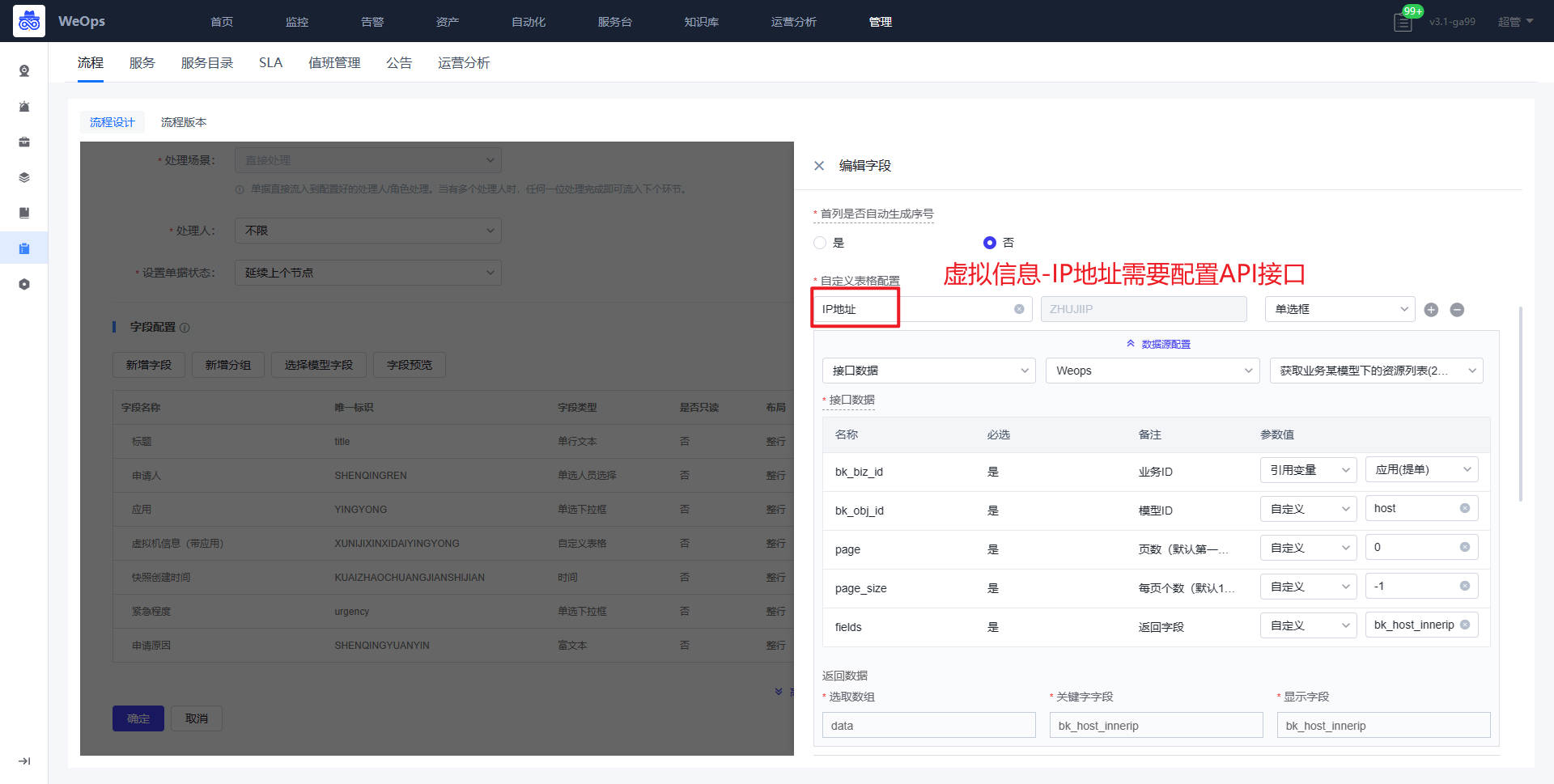

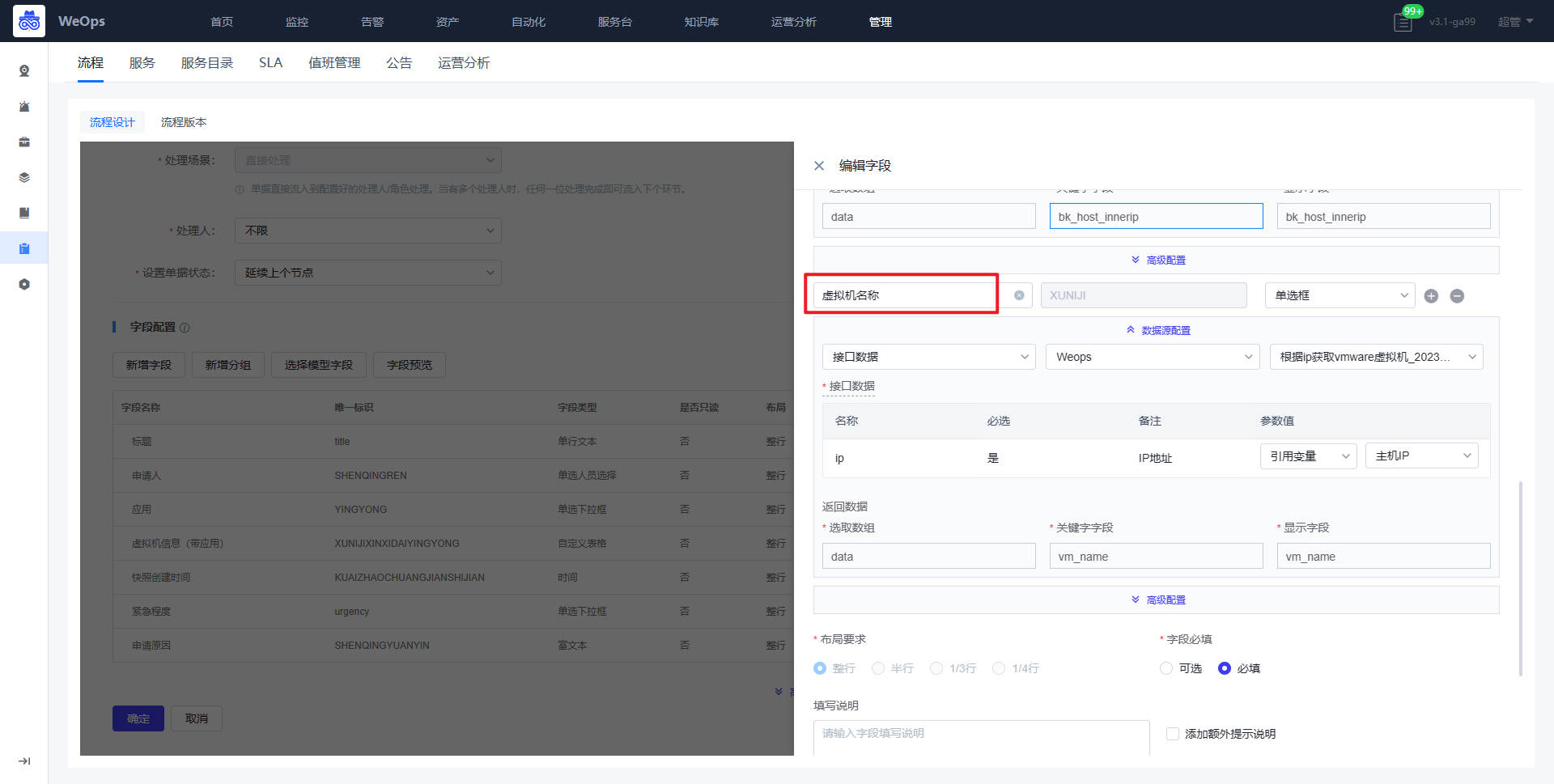

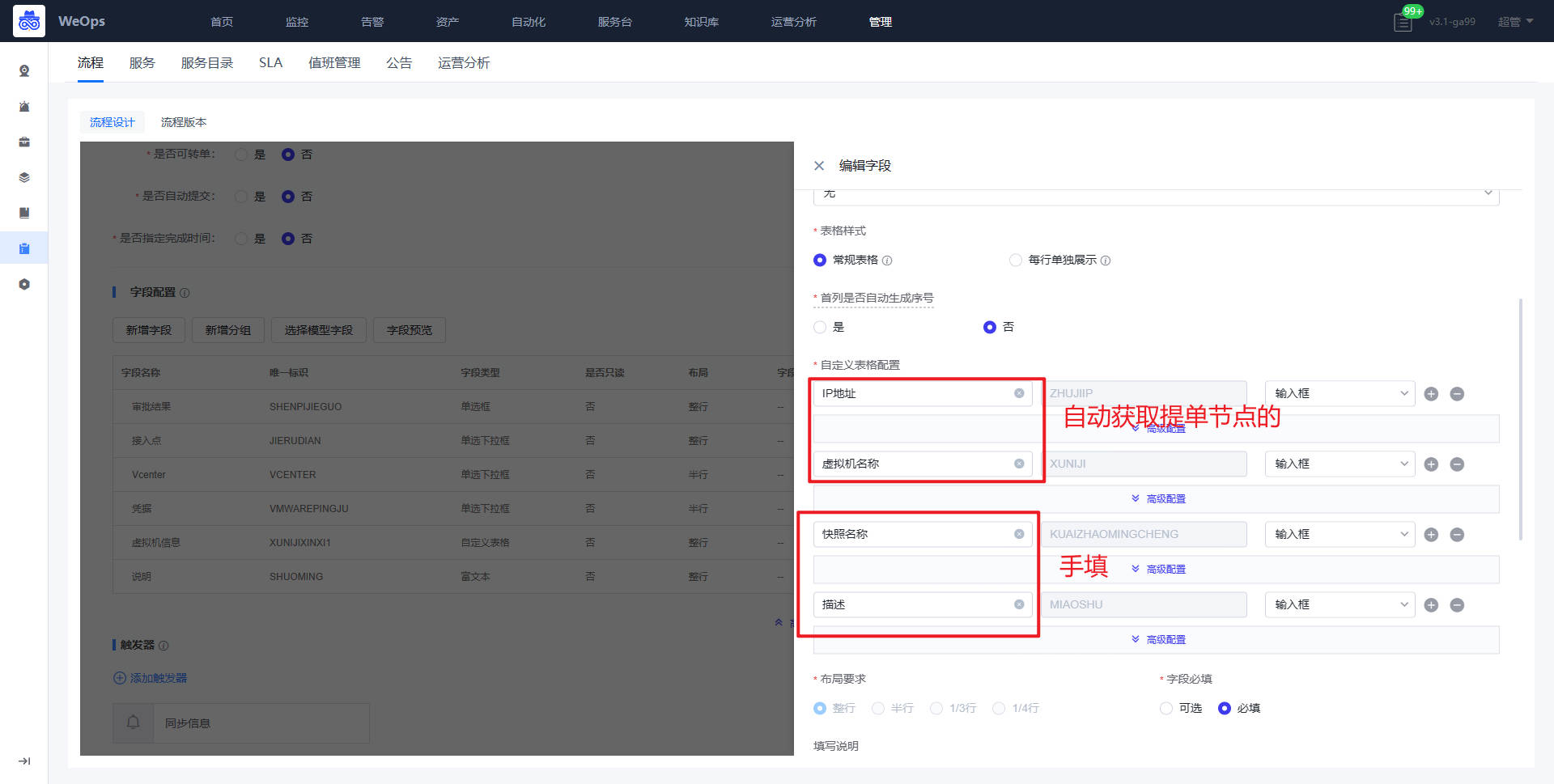

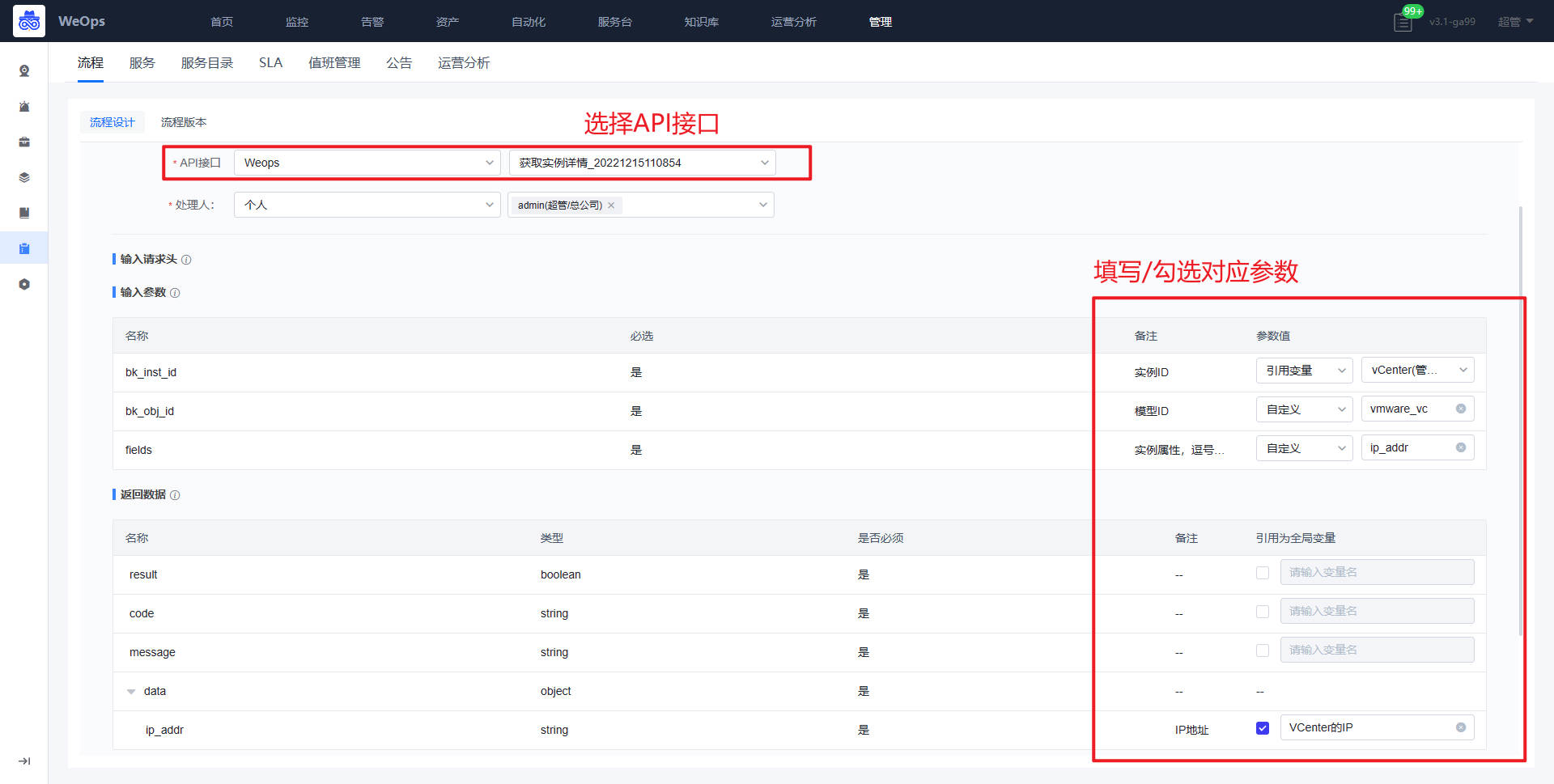

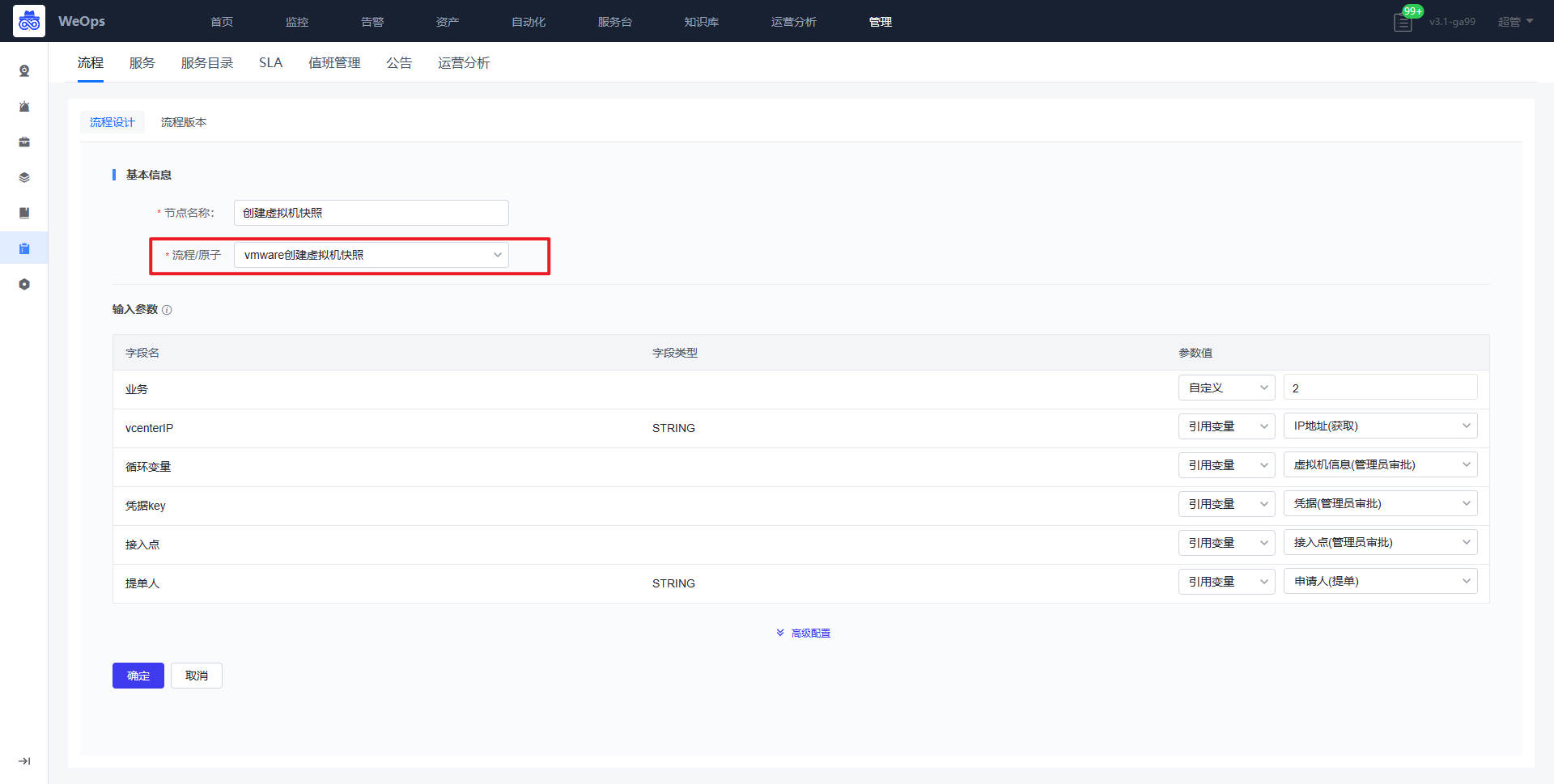

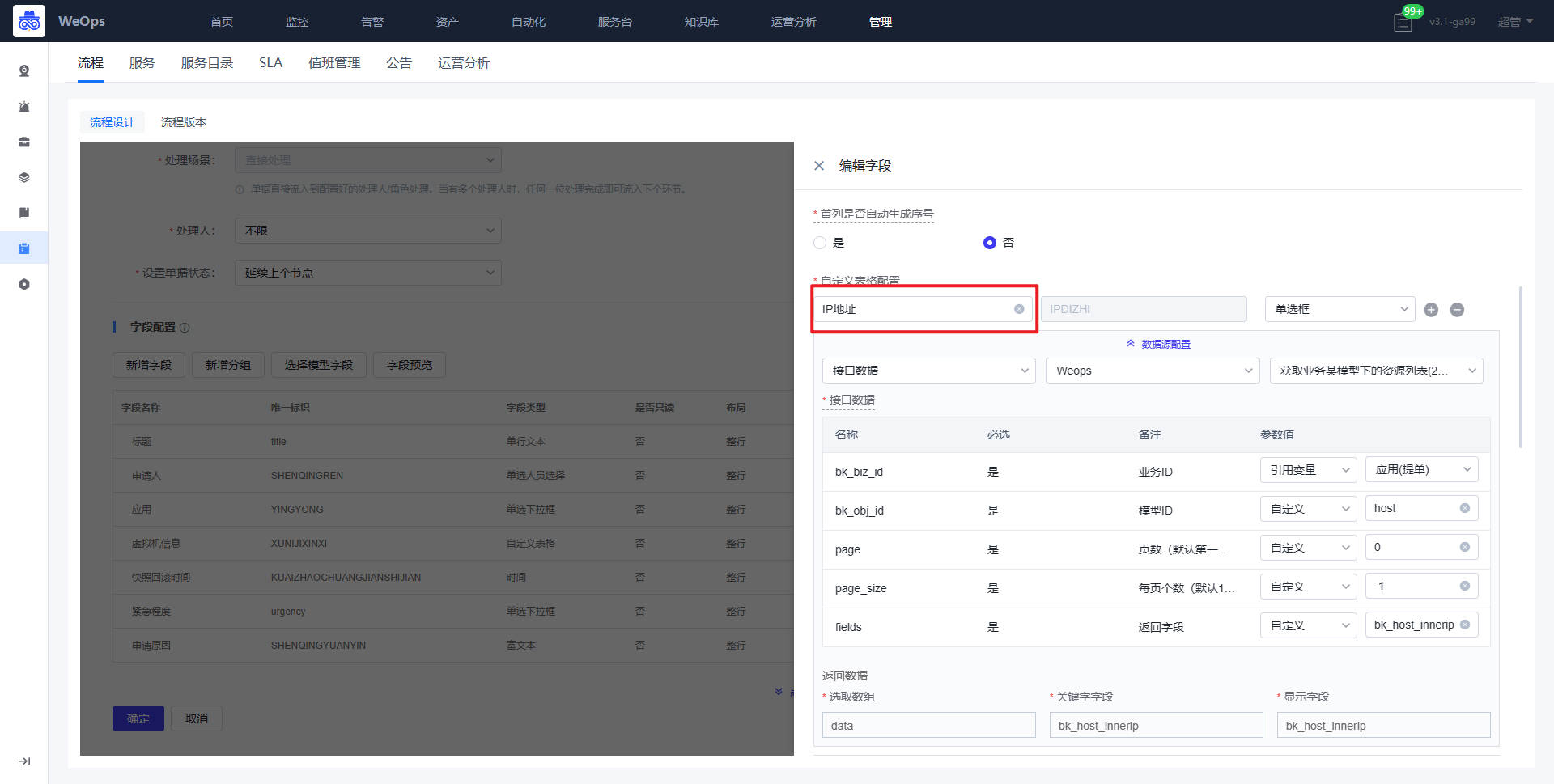

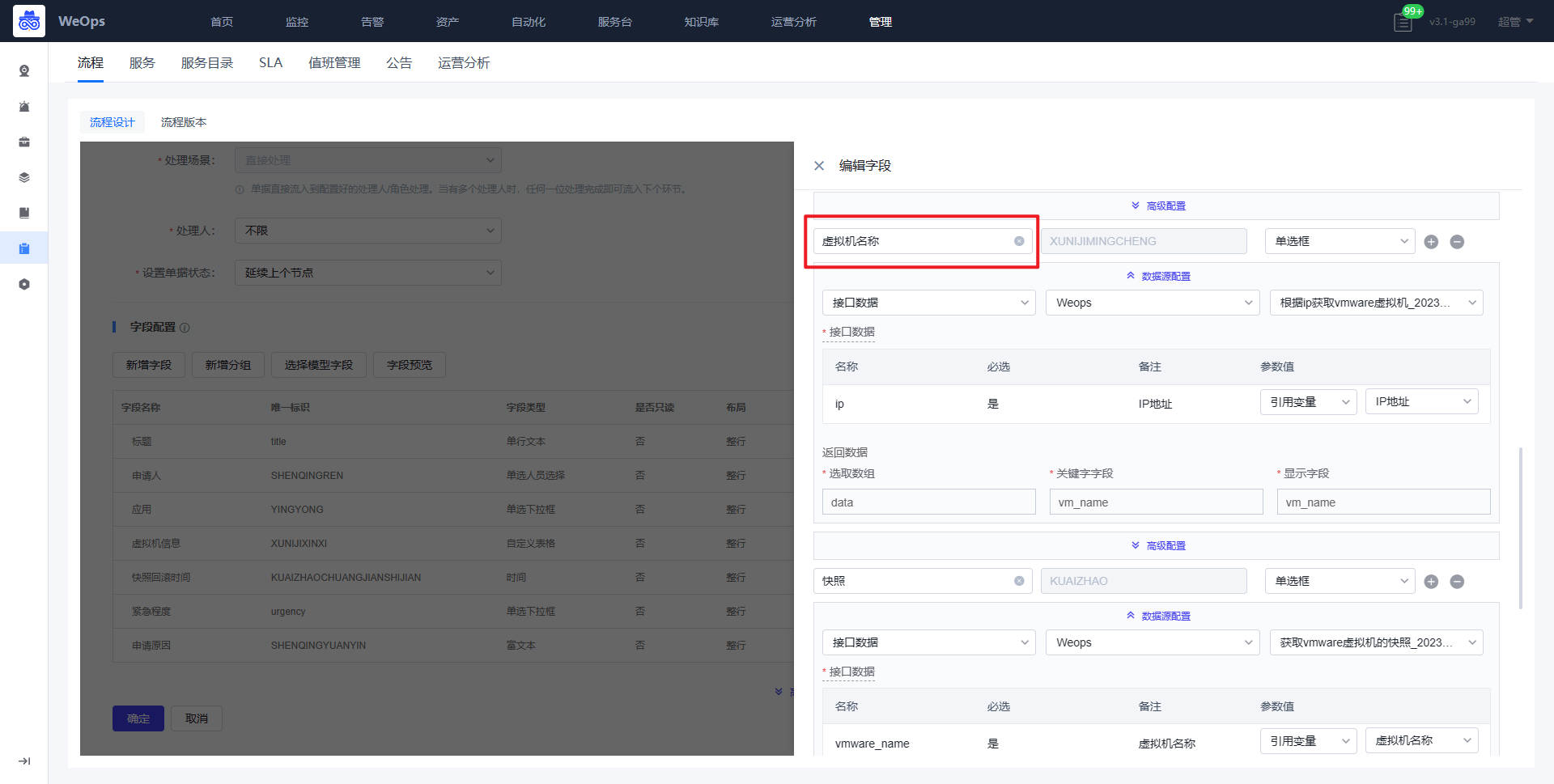

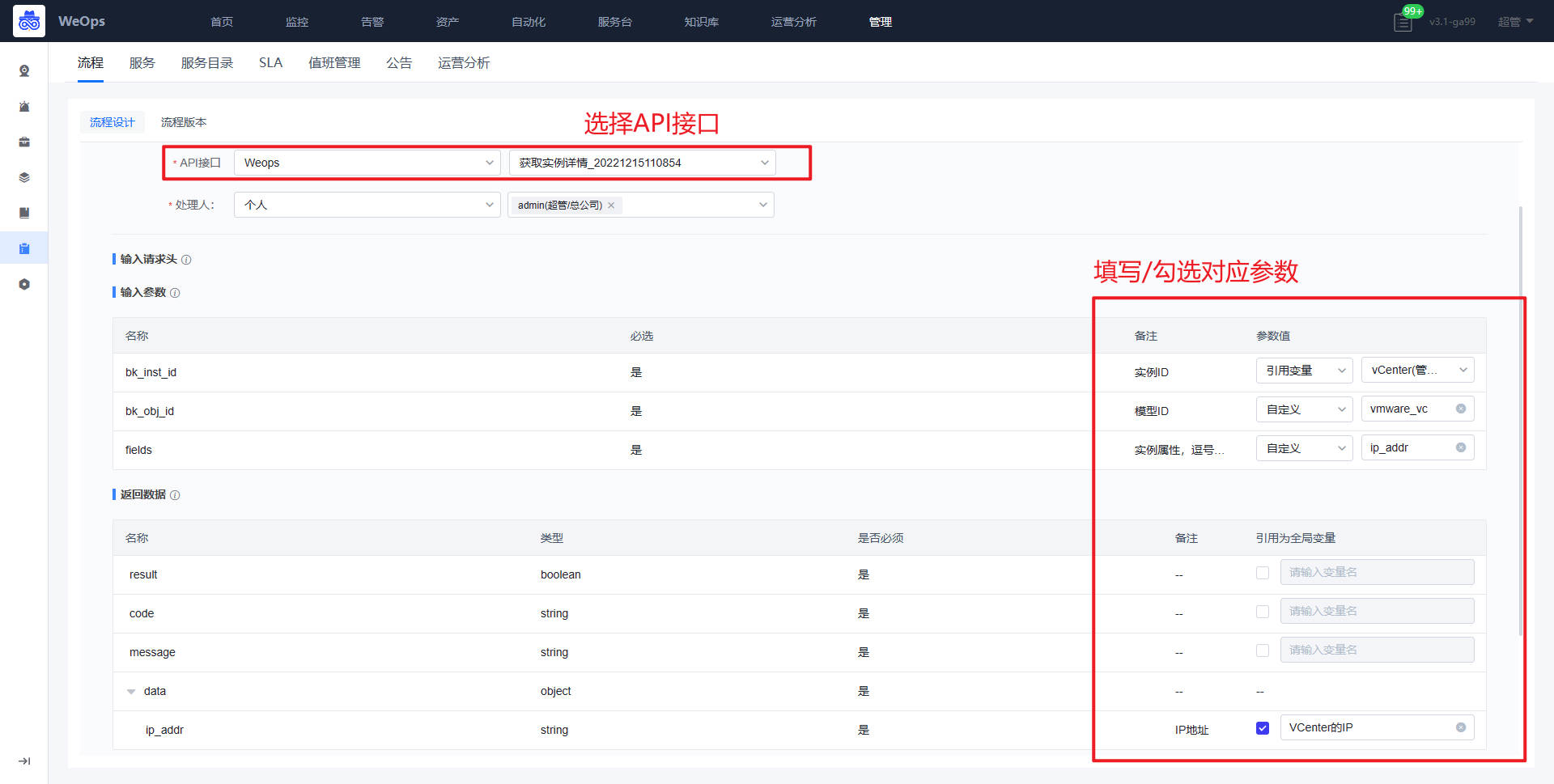

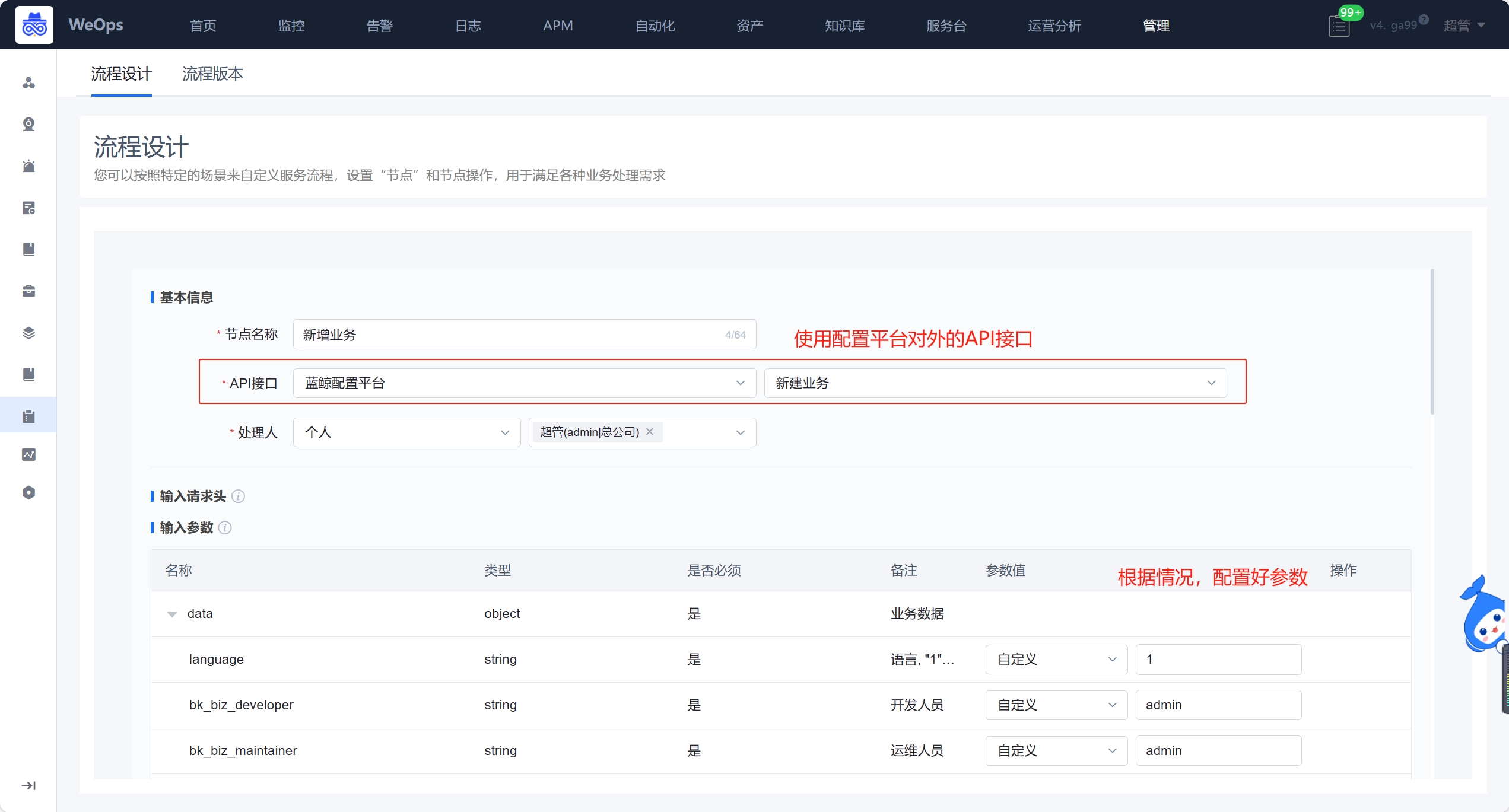

- 流程:如下图主要进行服务流程的管理和新建,包括流程设计和流程版本两项

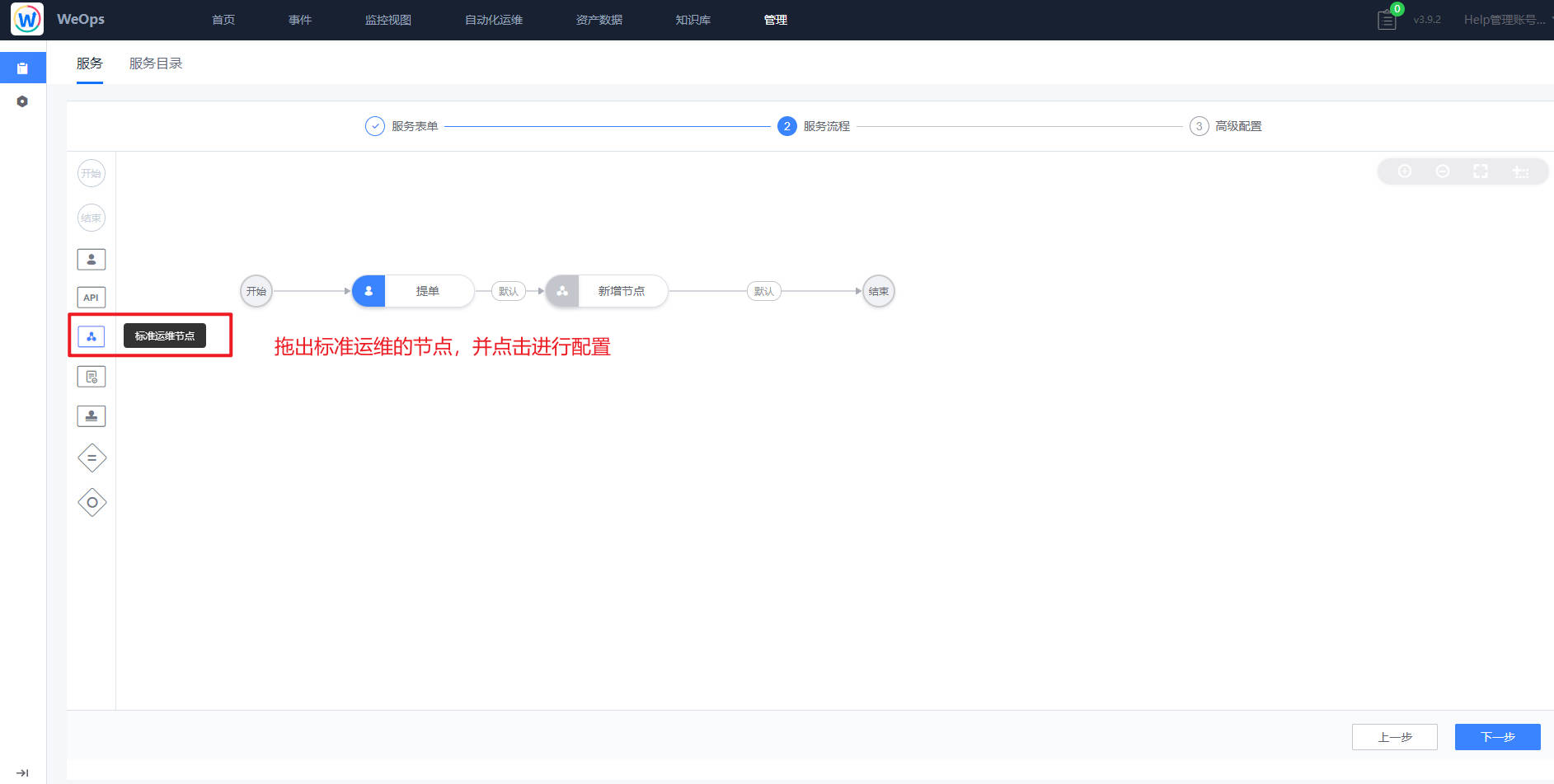

- 流程设计主要分为三个步骤:填写流程信息、配置流程、流程启用设置

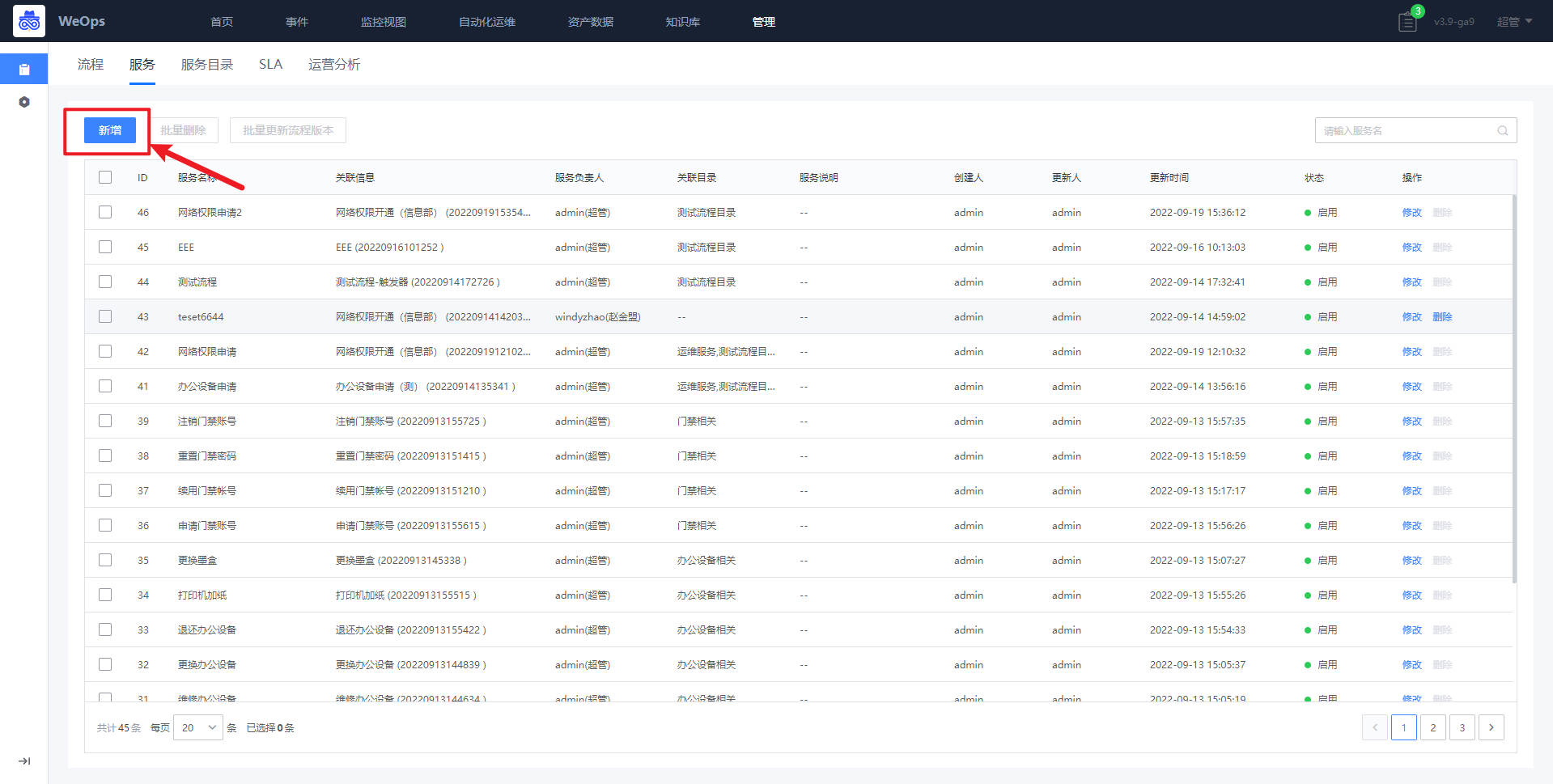

- 服务:如下图,展示所有新建的服务列表,需要绑定流程版本,只有关联服务目录并且启用的服务,才可以在IT服务台查看并使用。

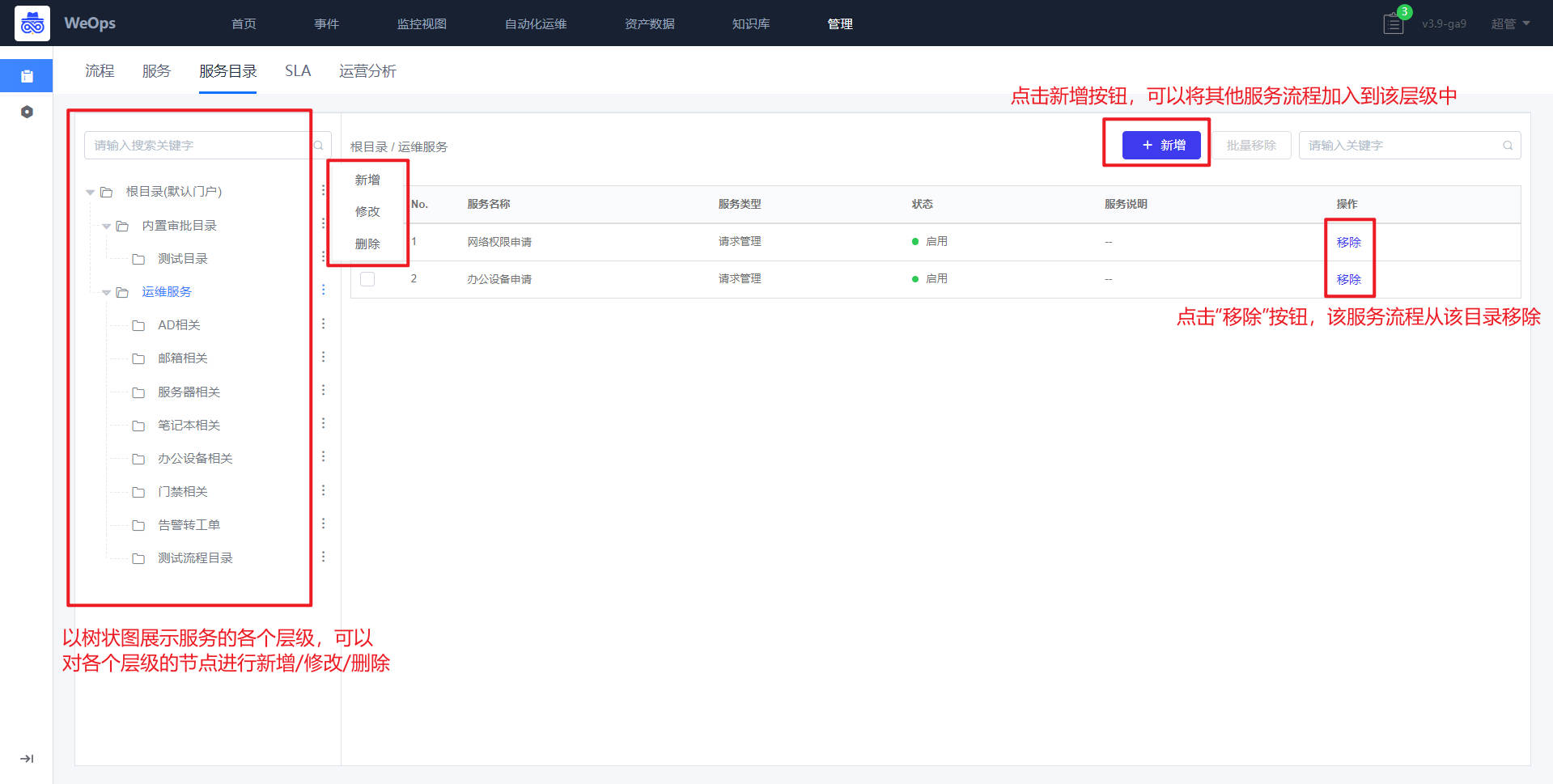

- 服务目录:如下图,主要展示各个服务流程的层级关系,可以进行流程的新增和移除

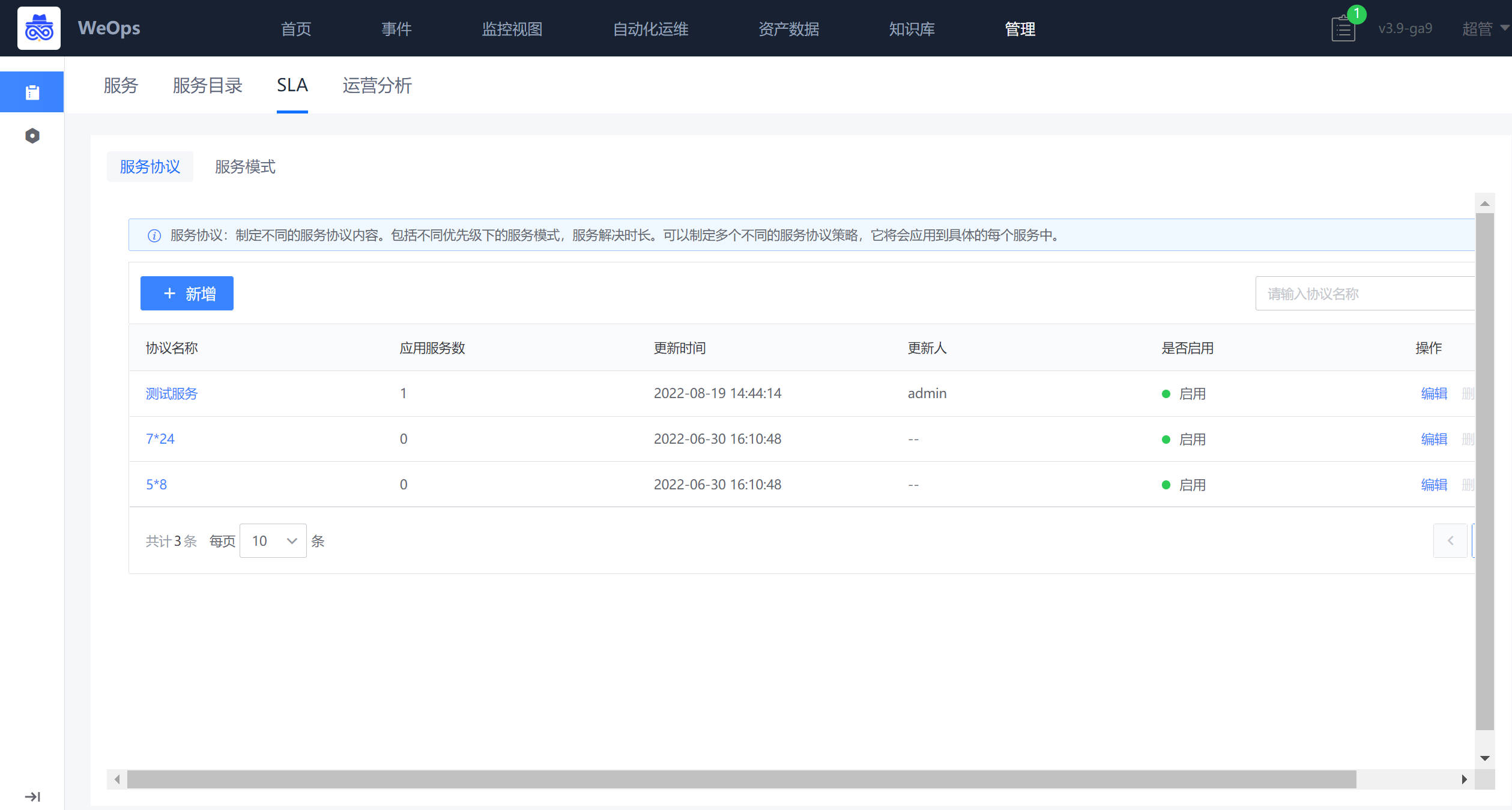

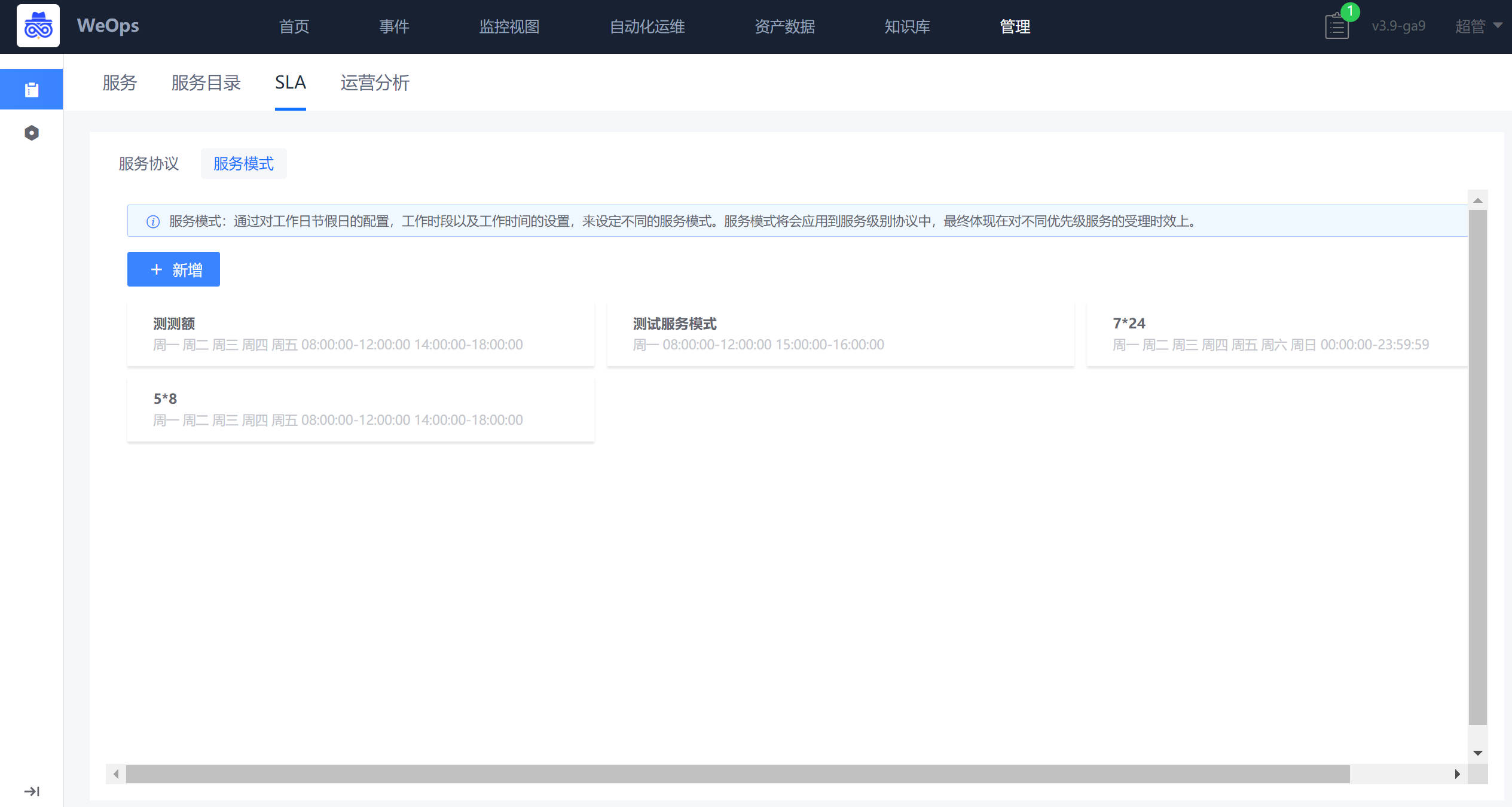

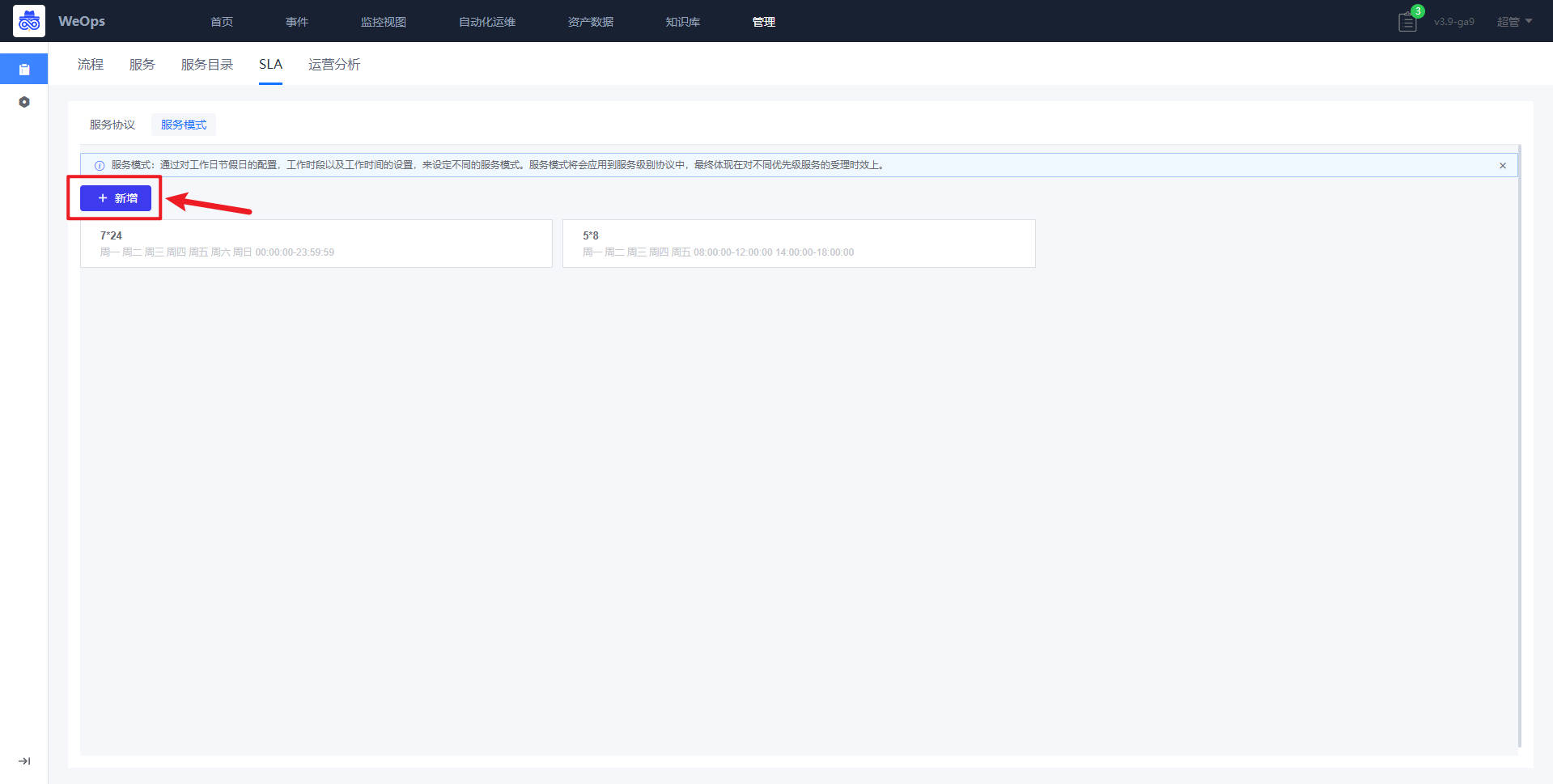

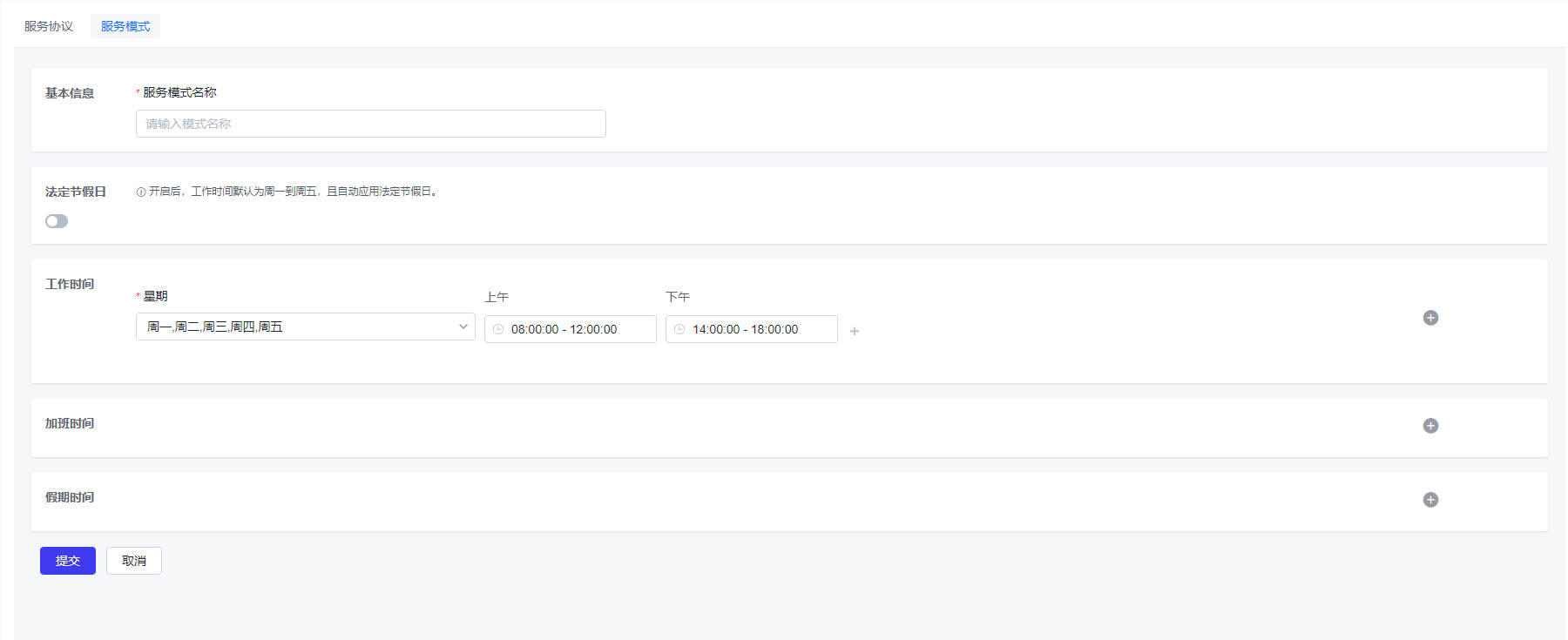

- SLA:如下图,主要用于服务模式创建(设置工作时间/加班时间/假期时间)和服务协议创建(SLA条件设置和提供设置)

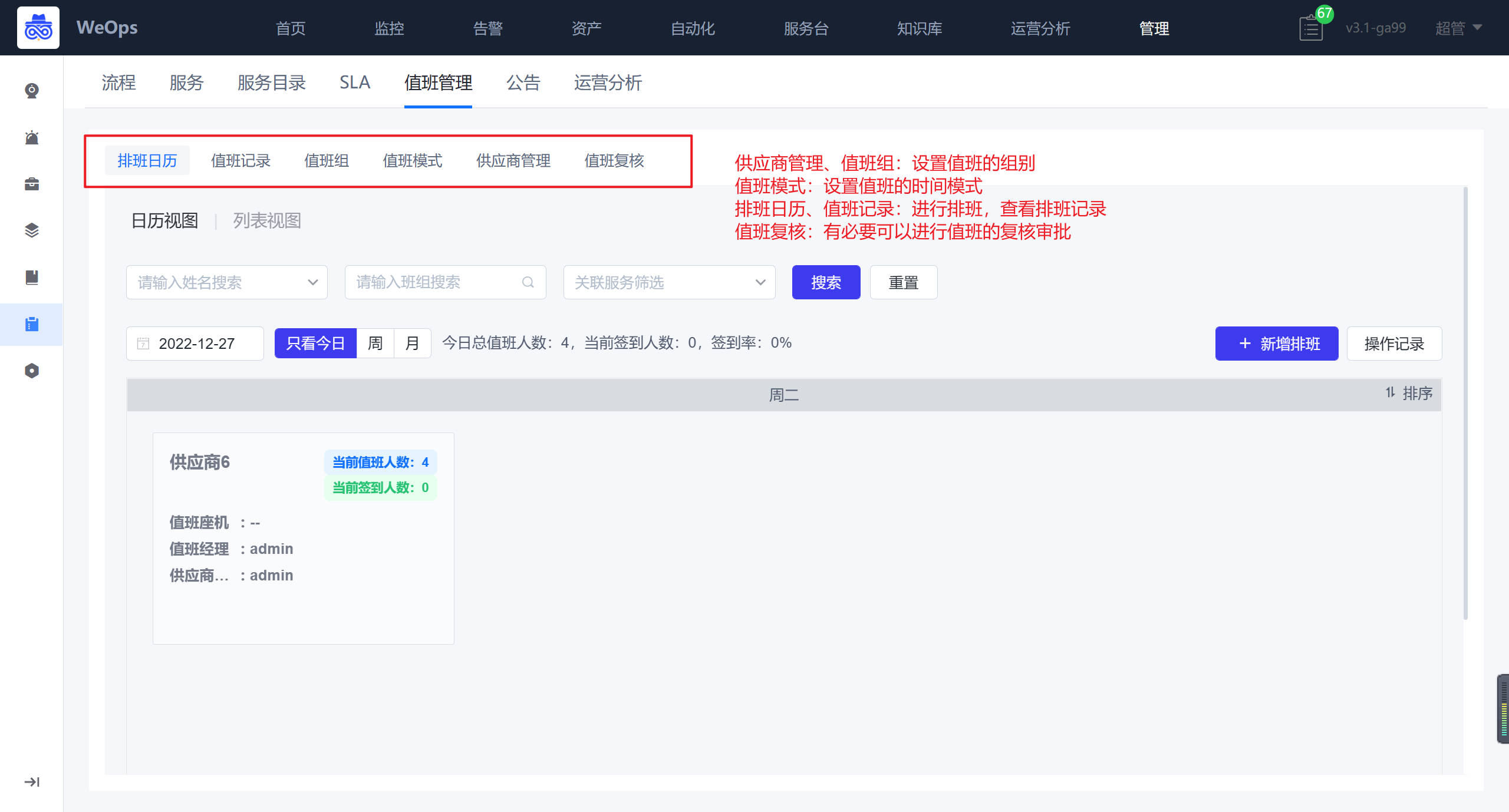

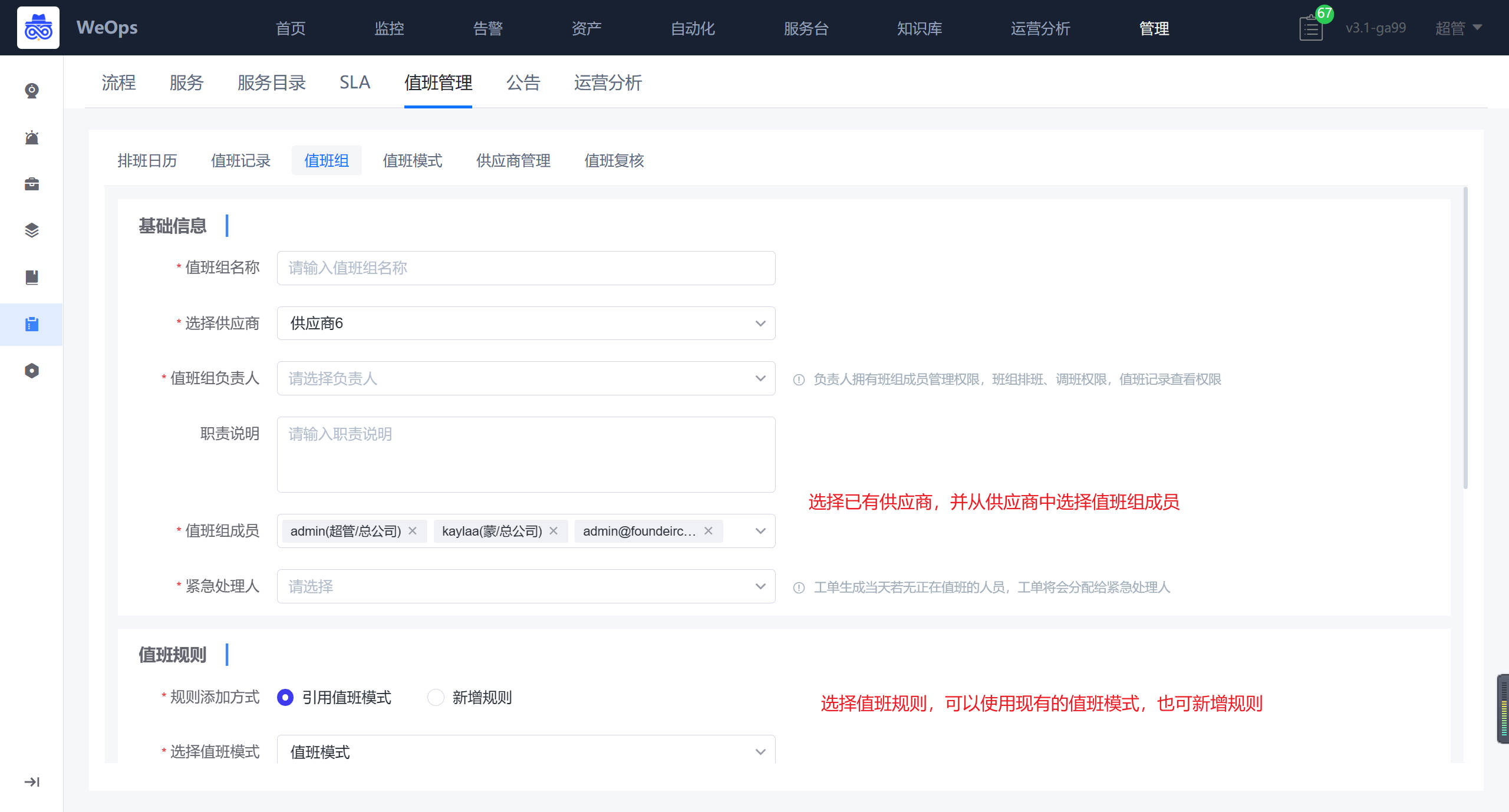

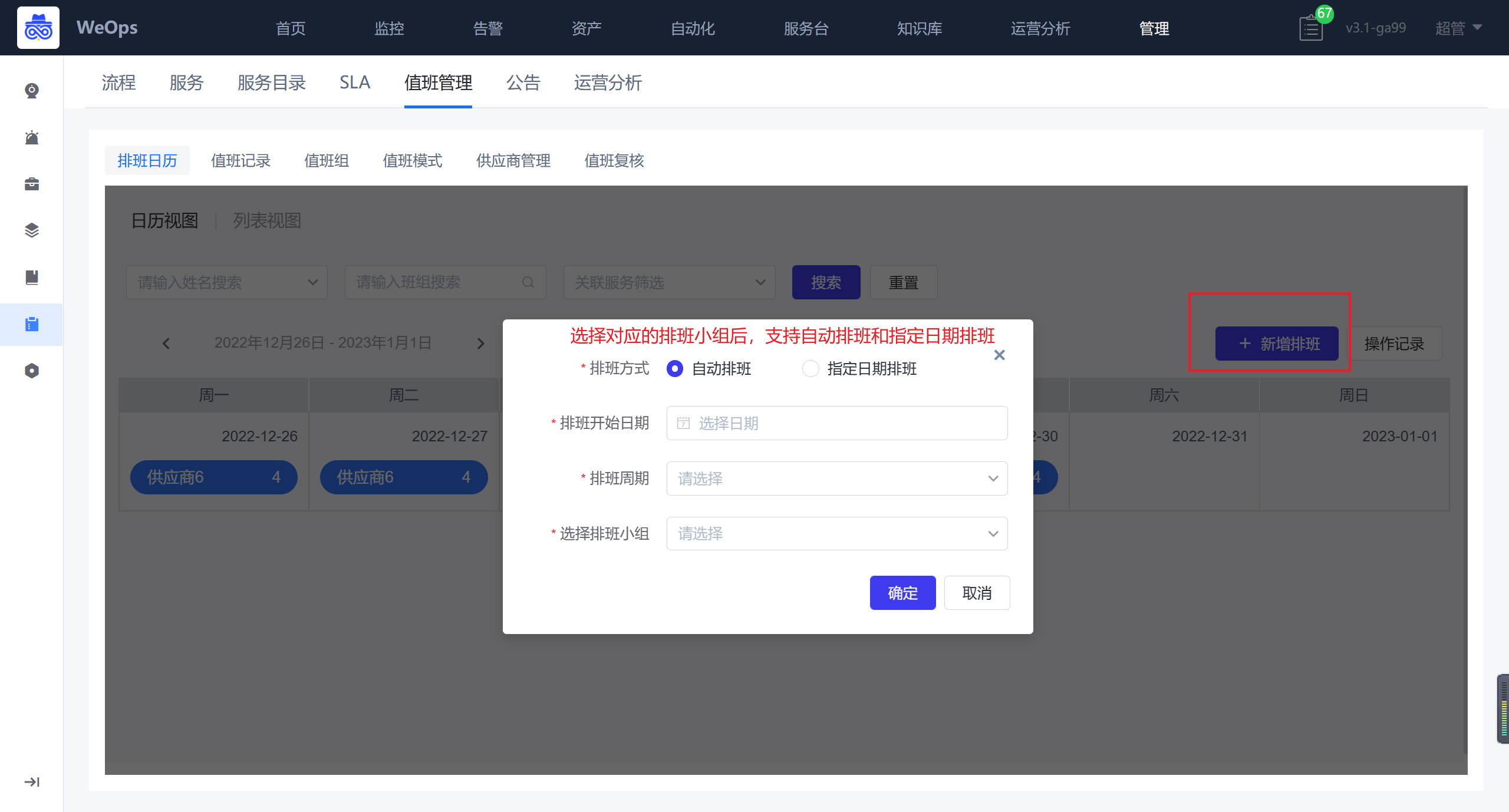

- 值班管理:对服务台各个值班组的值班进行排班,排班完成后可以按照当值人员进行工单的分派和处理。

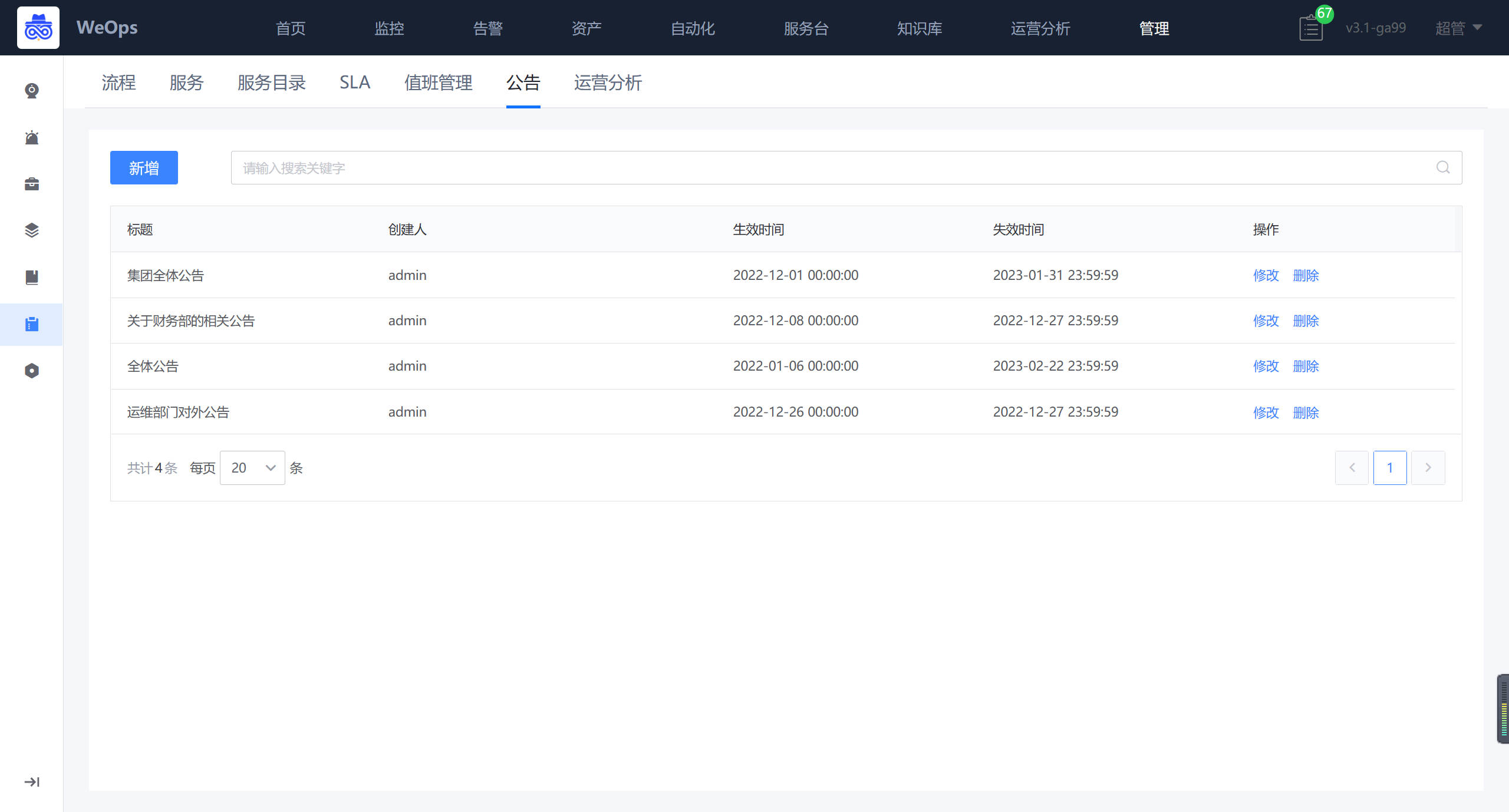

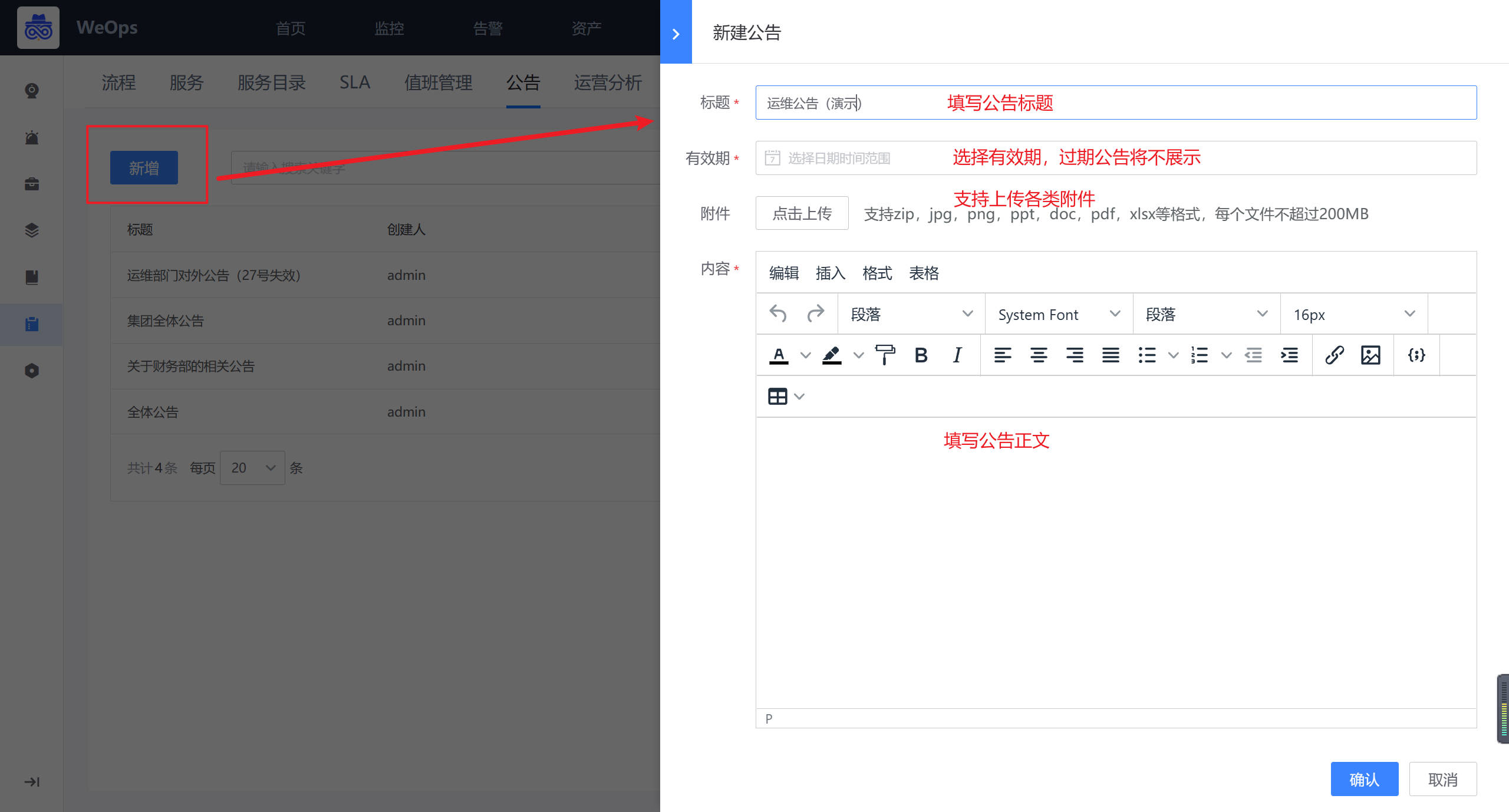

- 公告:对服务台的公告进行设置,可设置公告的内容、有限期、附件等

- 运营分析:对IT服务台的单据进行分类分析,包括服务使用统计、单据类型统计、单据状态统计等

- 例行工作:可设置按照不同频率,设置工单的自动提交

- 门户主题:内置不同风格的主题,可为IT服务台切换不同的门户风格,针对不同的主题,可以设置主题的背景色和欢迎语等

系统管理

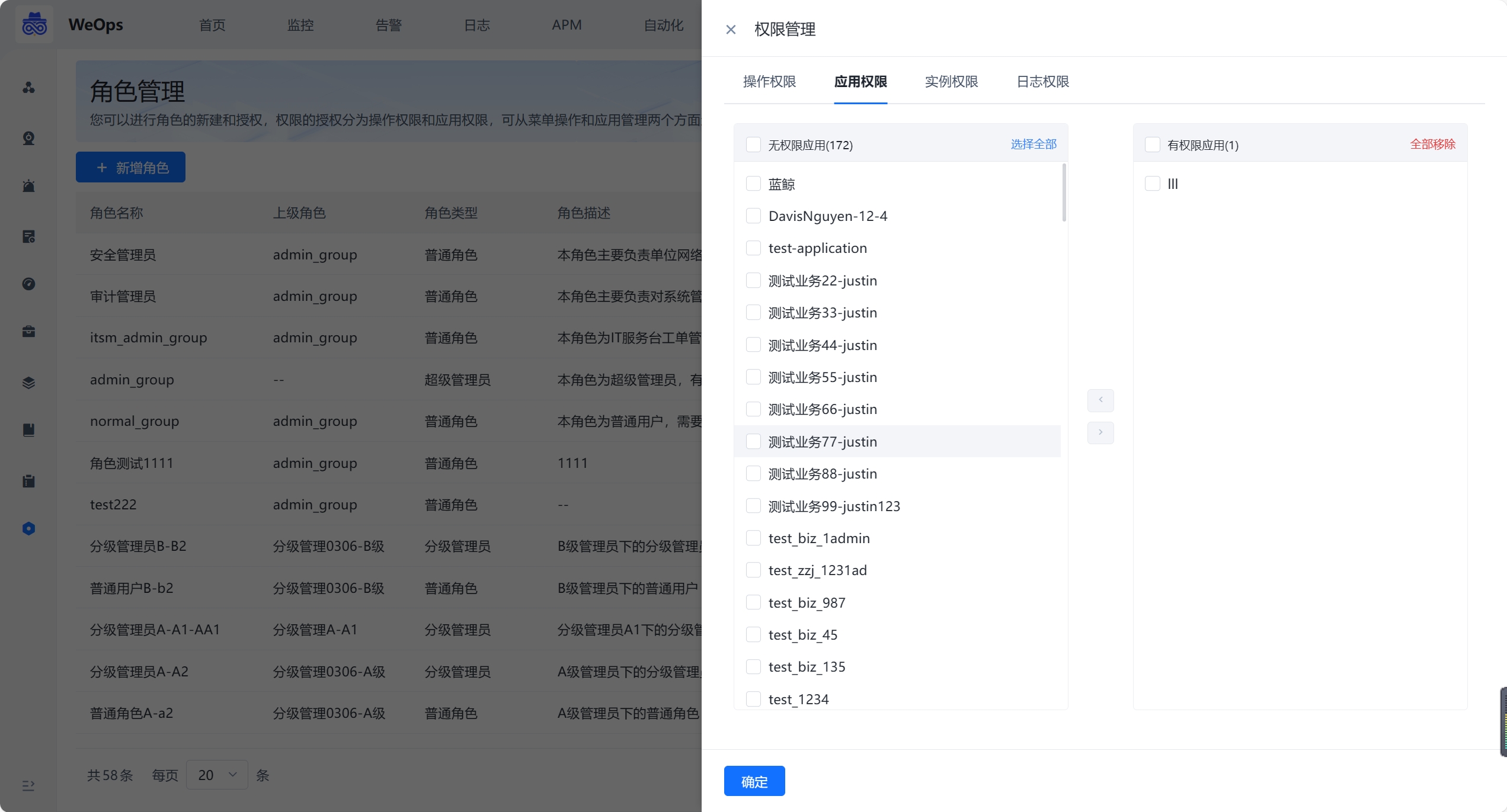

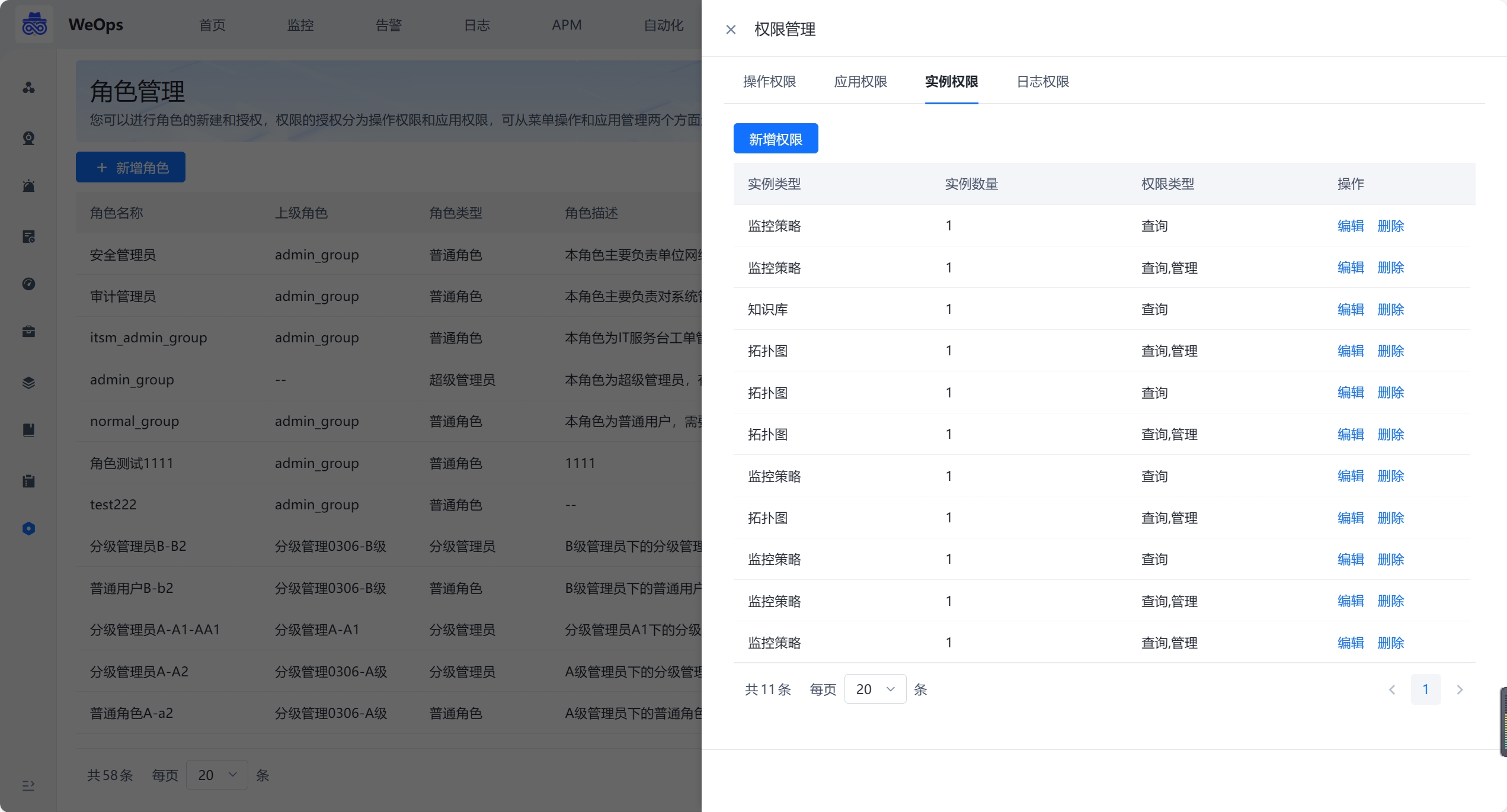

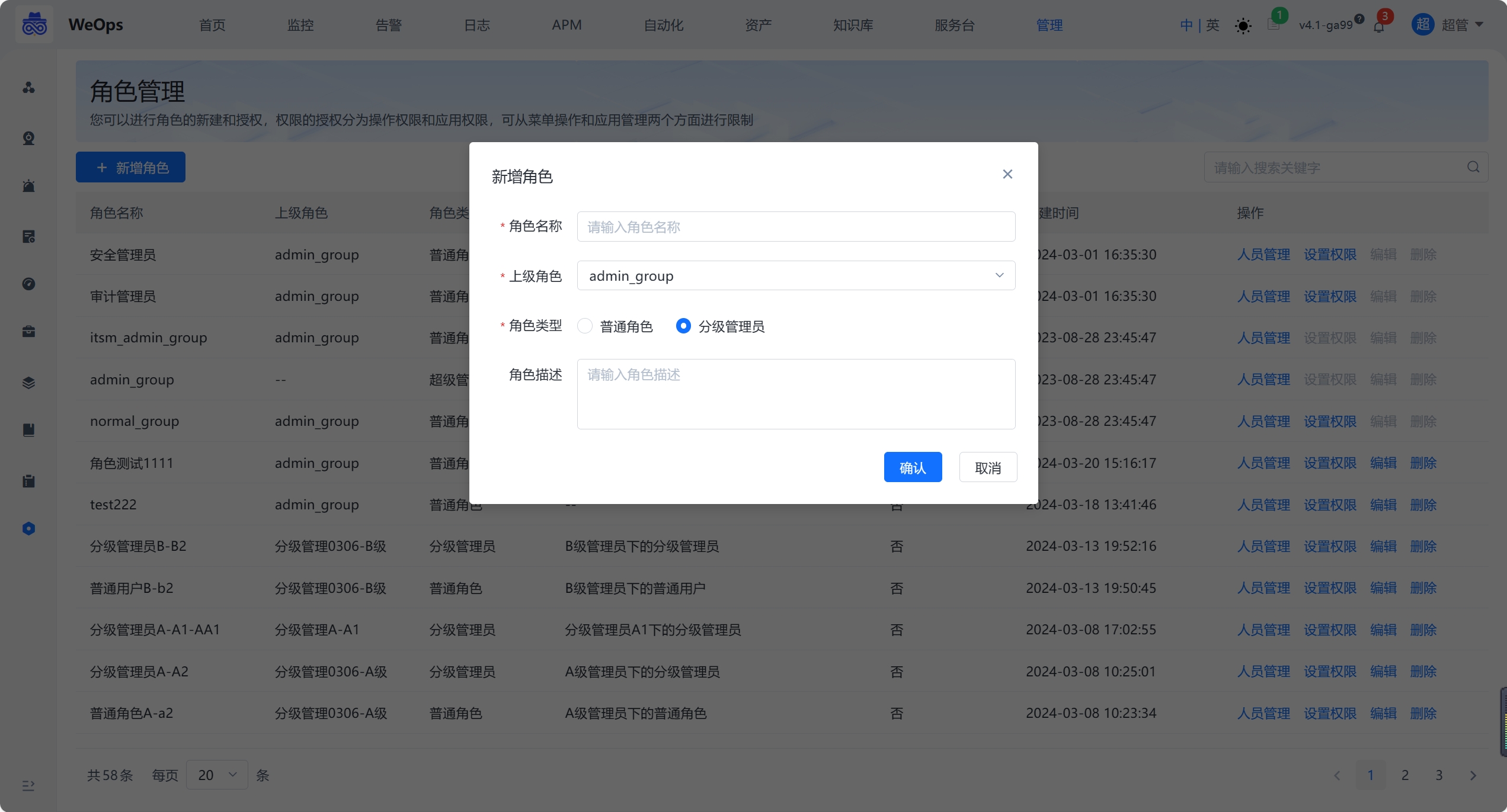

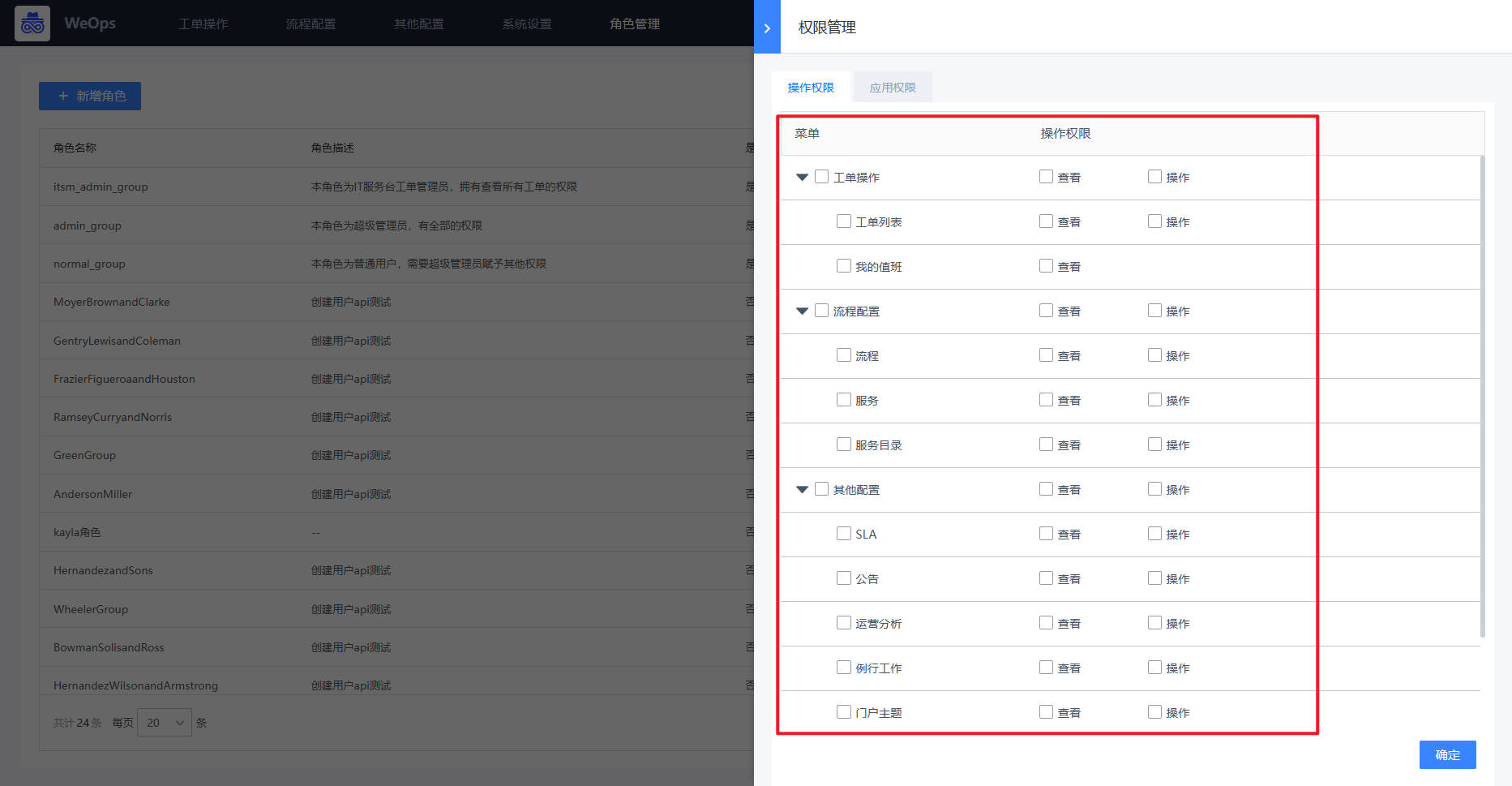

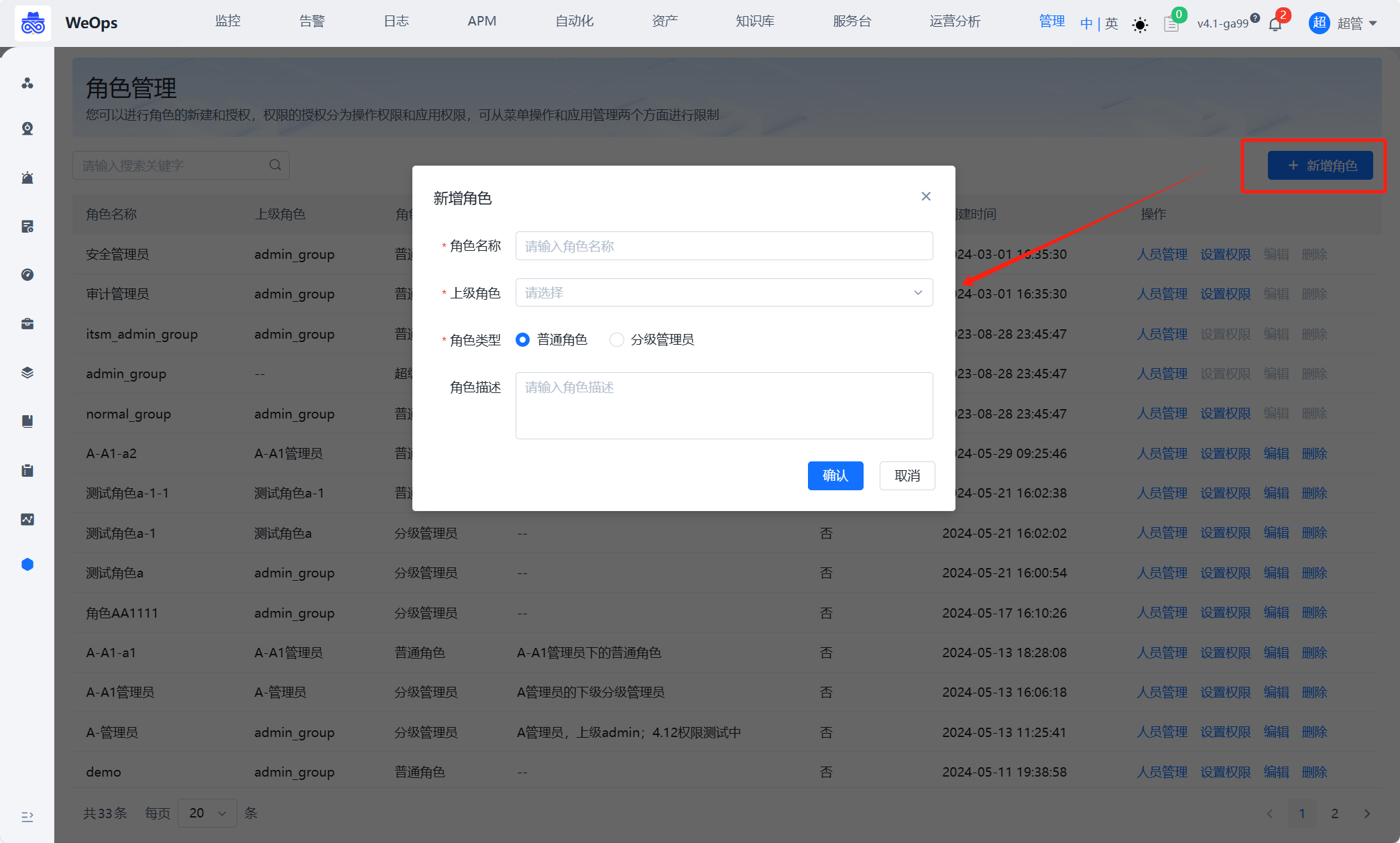

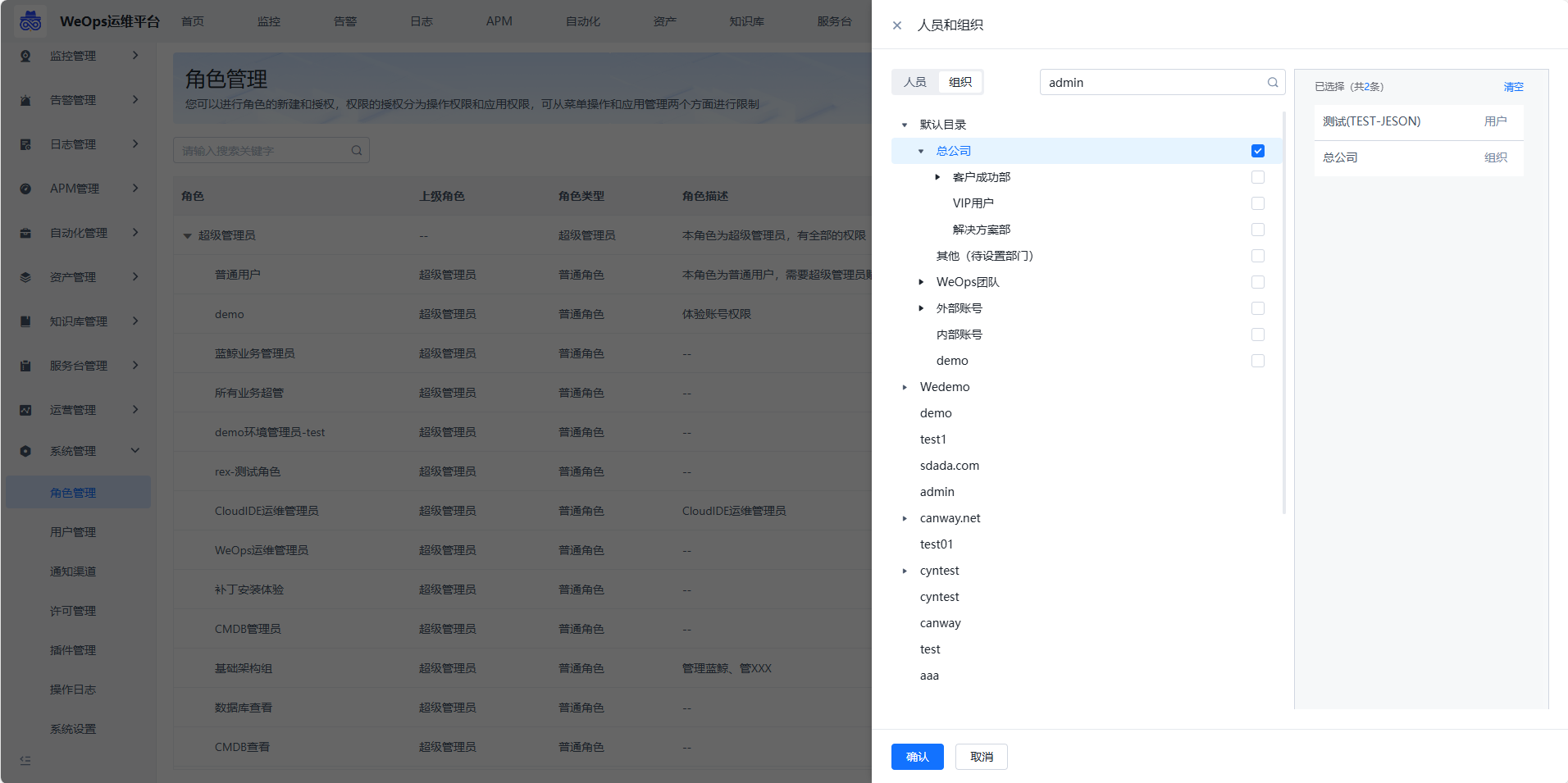

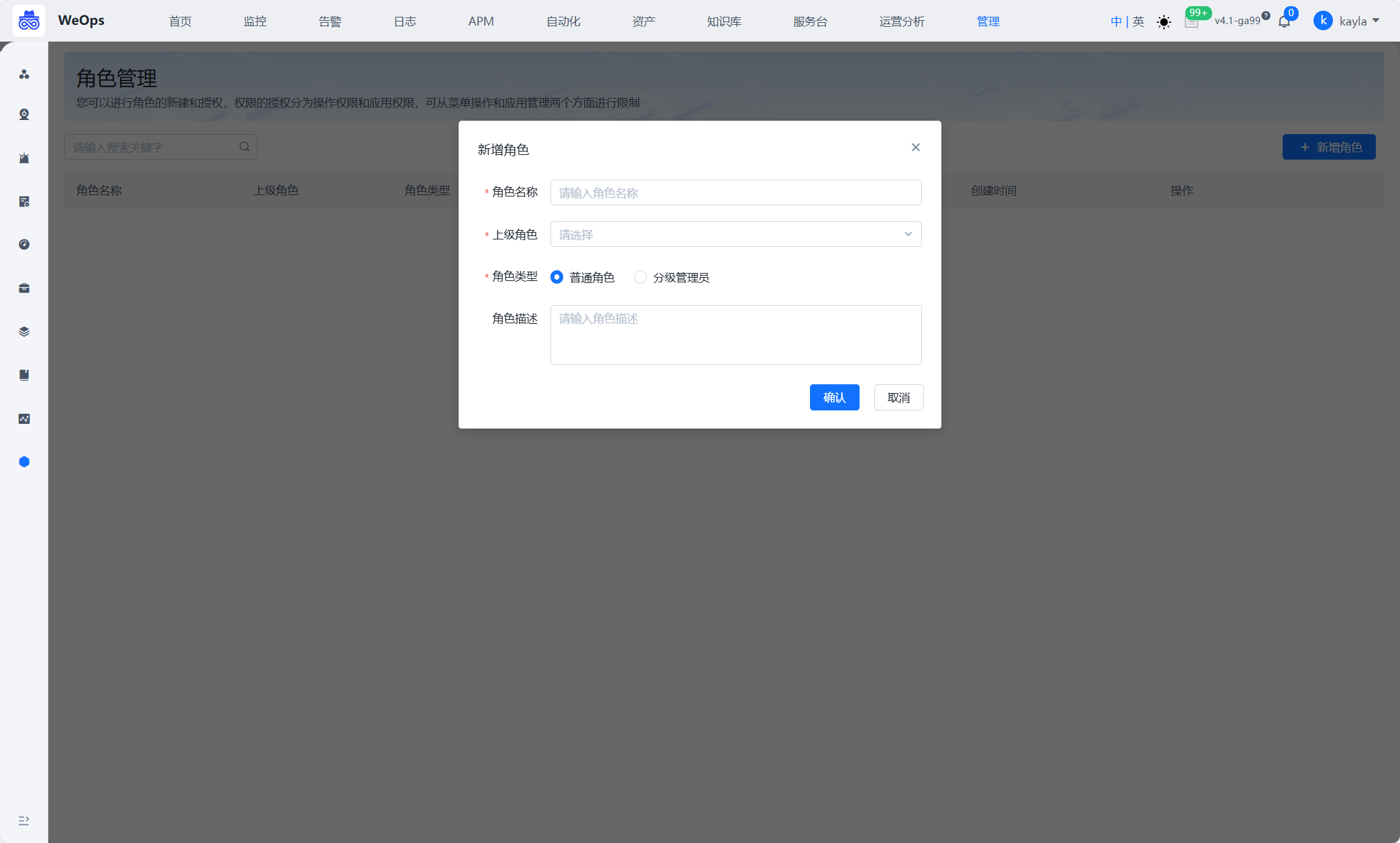

角色管理

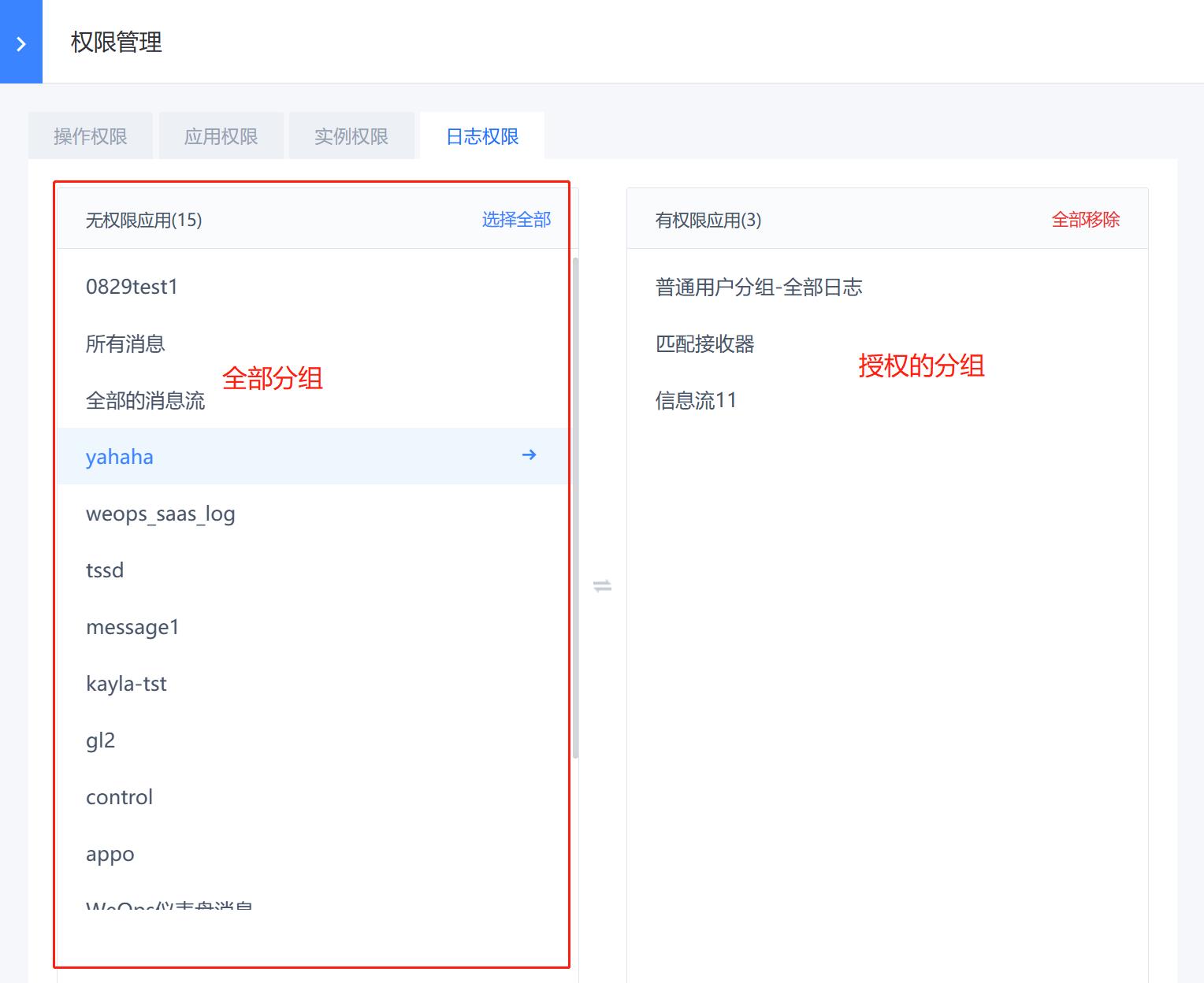

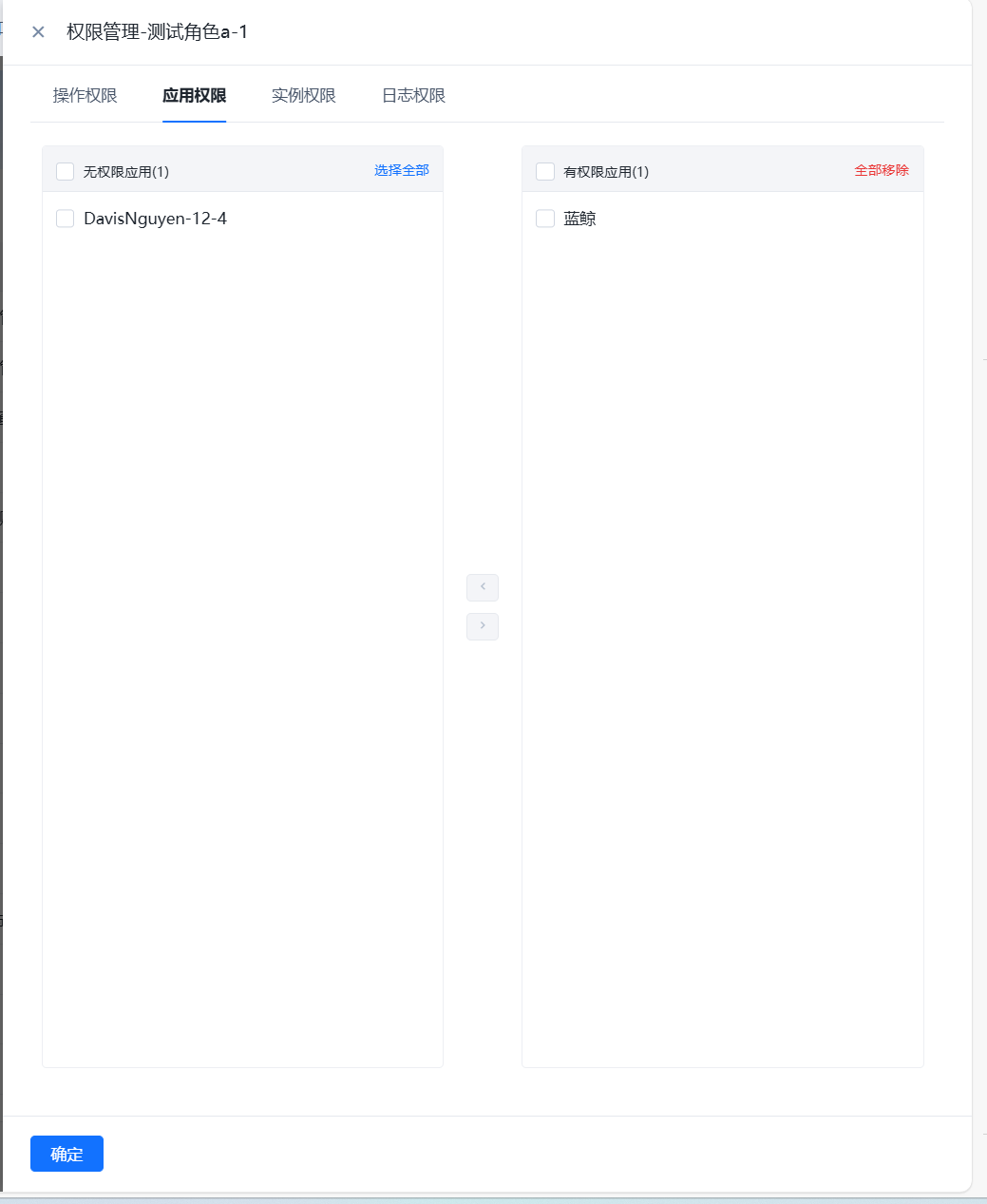

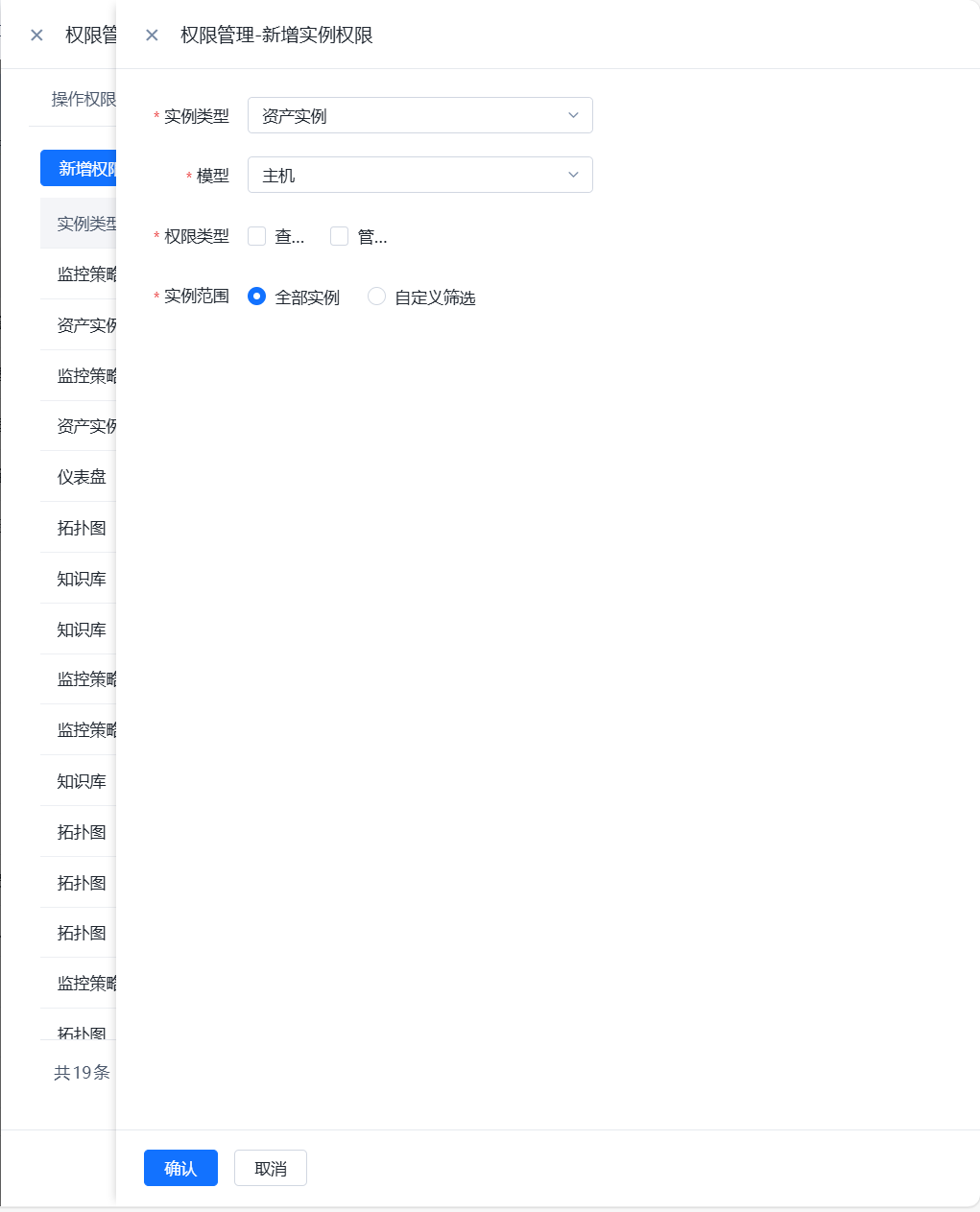

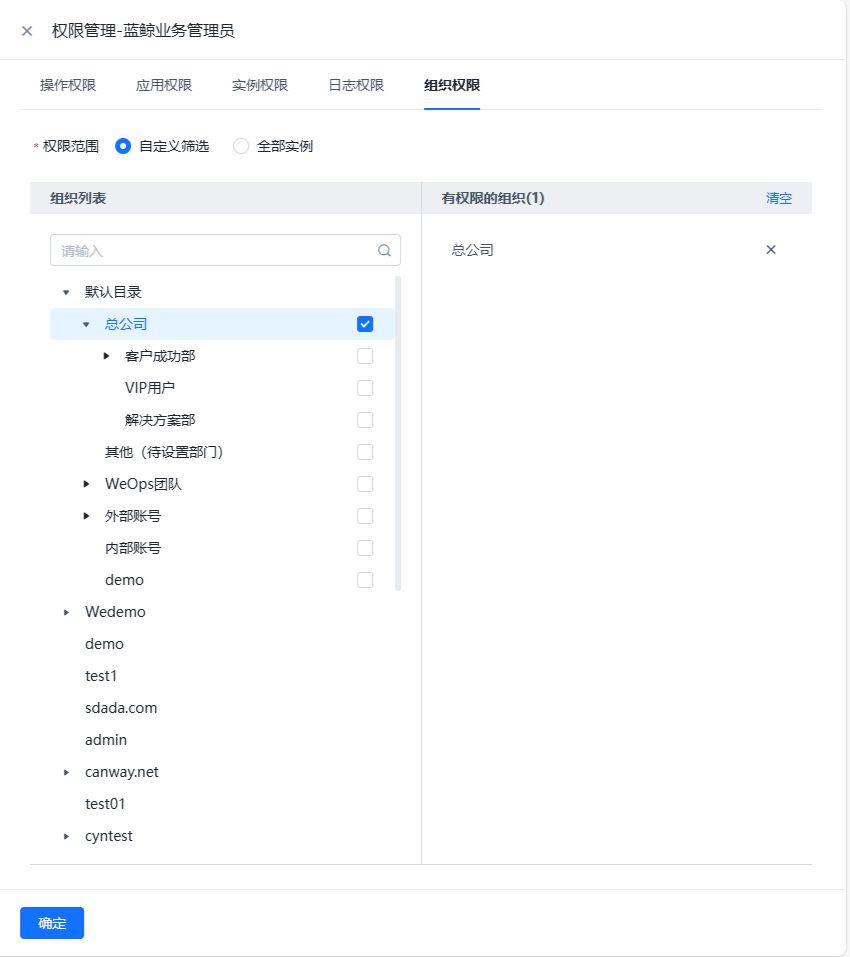

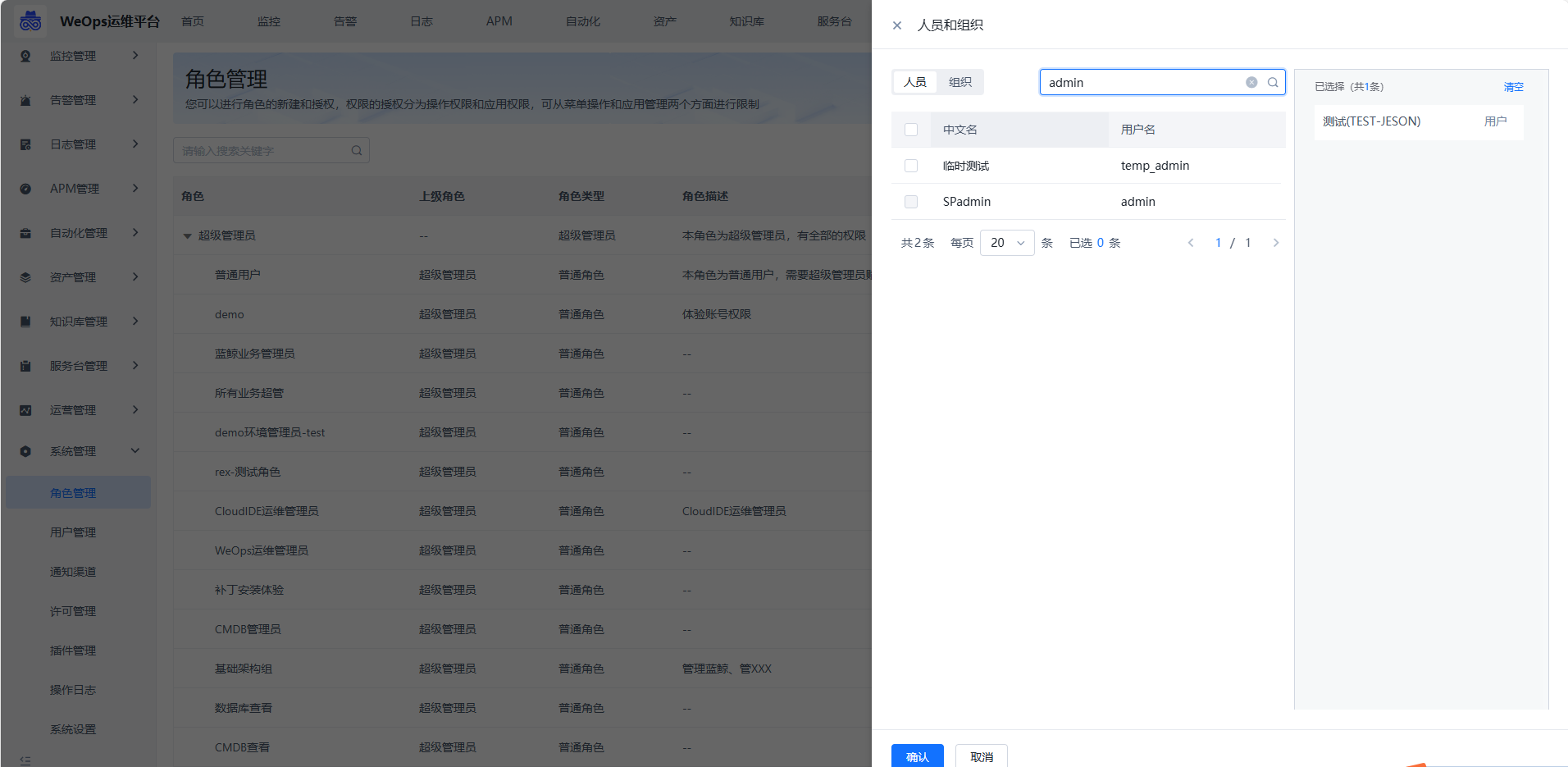

- 进行WeOps的用户角色管理,可以进行角色的新建和授权,权限的授权分为操作权限、应用权限、实例权限(拓扑图、仪表盘、文章、运维工具、监控采集任务、监控策略任务、数据大屏、运营报表),可从菜单操作、应用管理、实例、日志分组四个方面进行限制

- 还支持“分级管理员”功能,作为分级管理员,支持再次创建角色,并进行二次授权。

- 还支持“分级管理员”功能,作为分级管理员,支持再次创建角色,并进行二次授权。

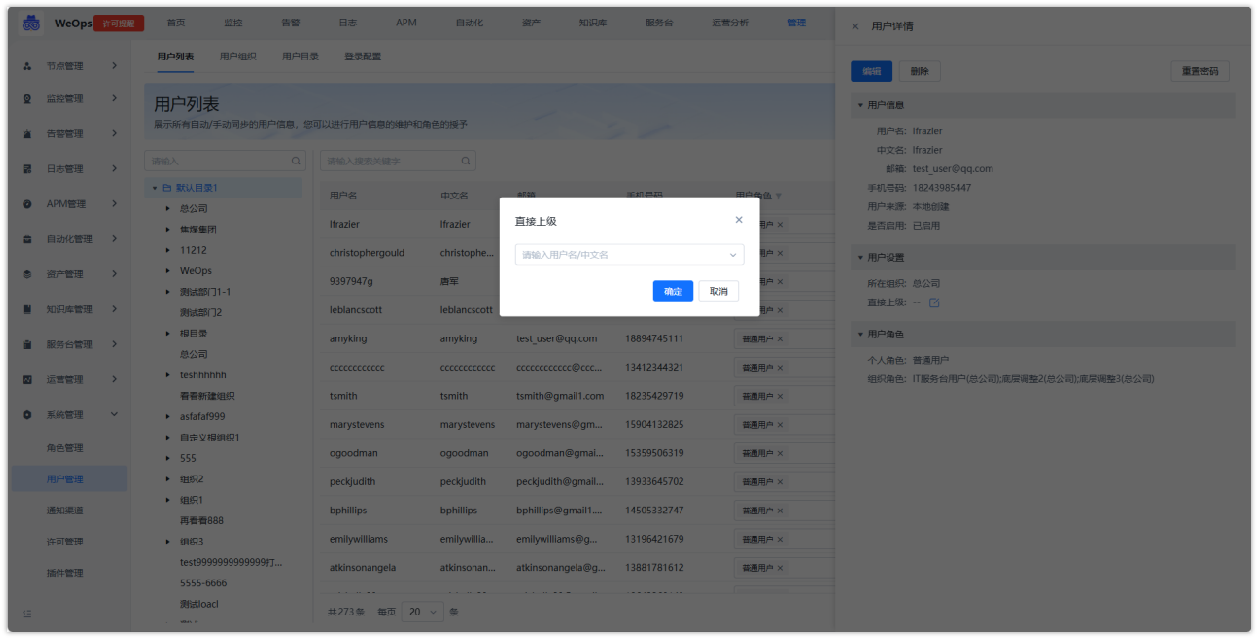

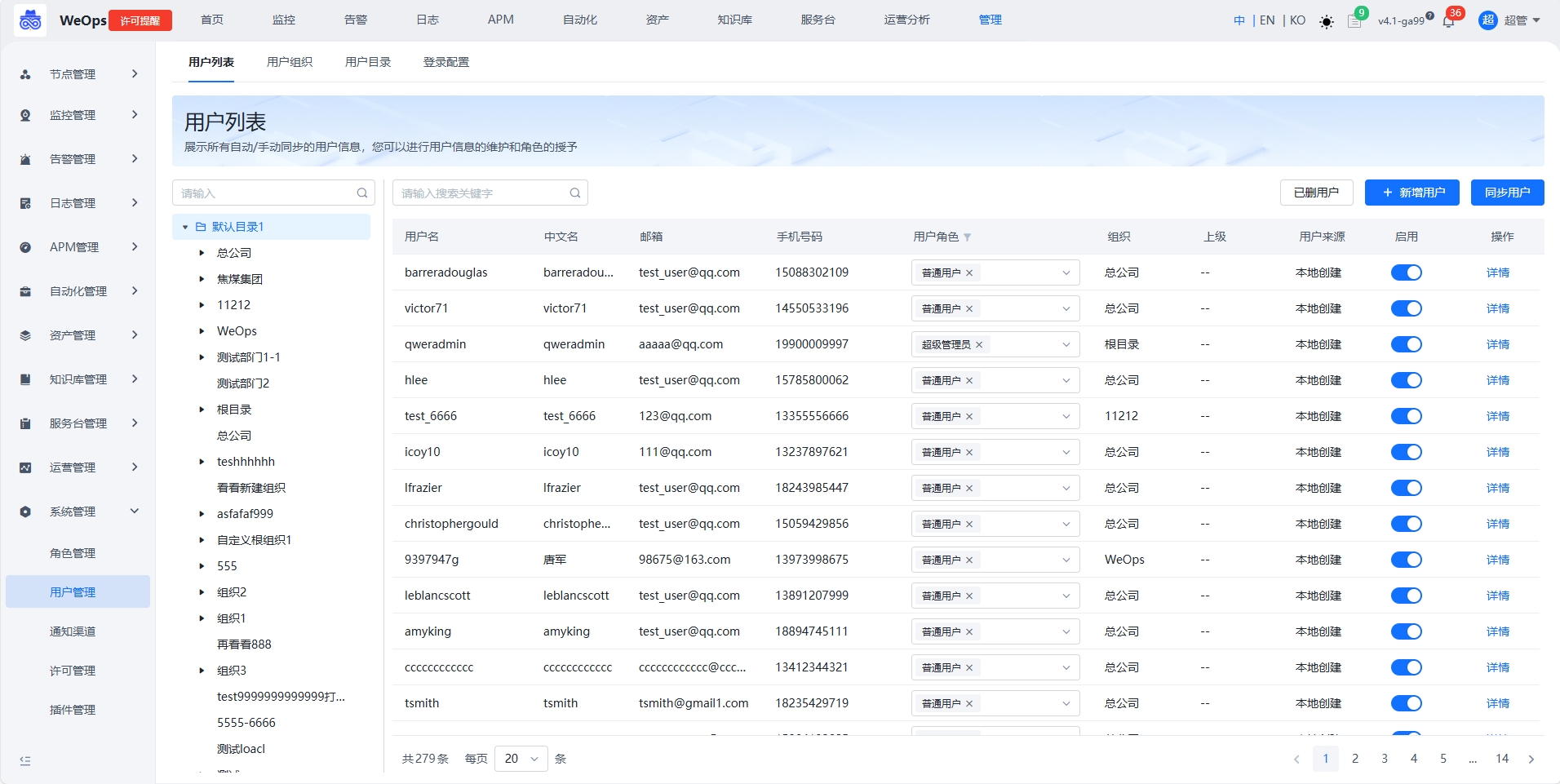

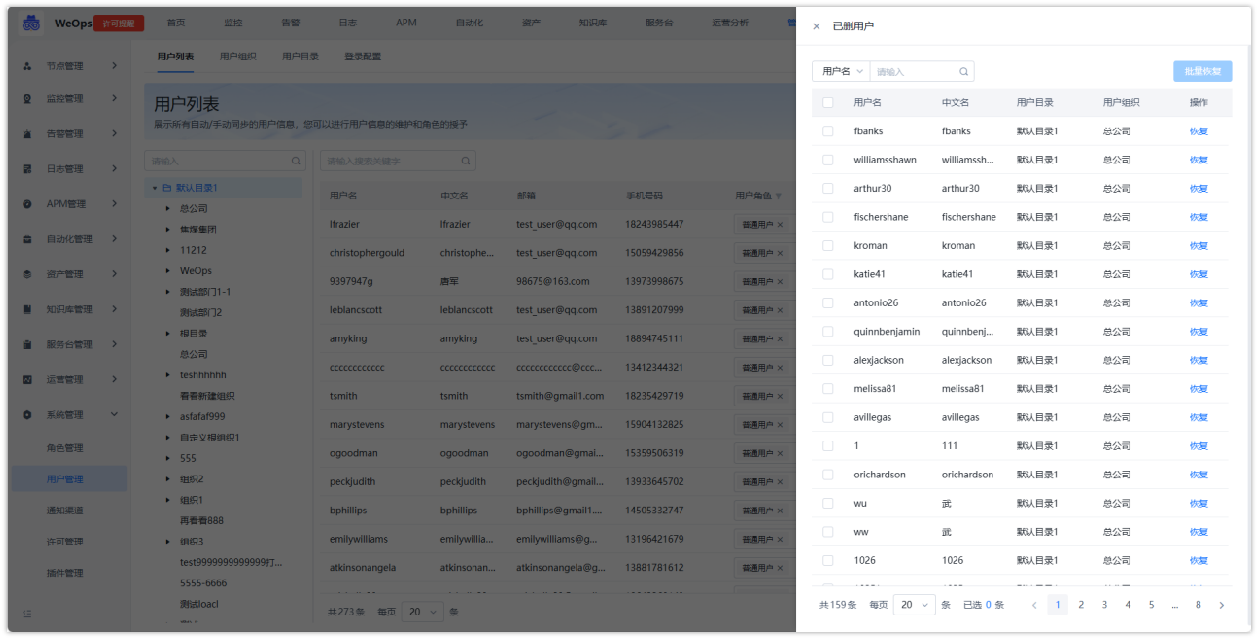

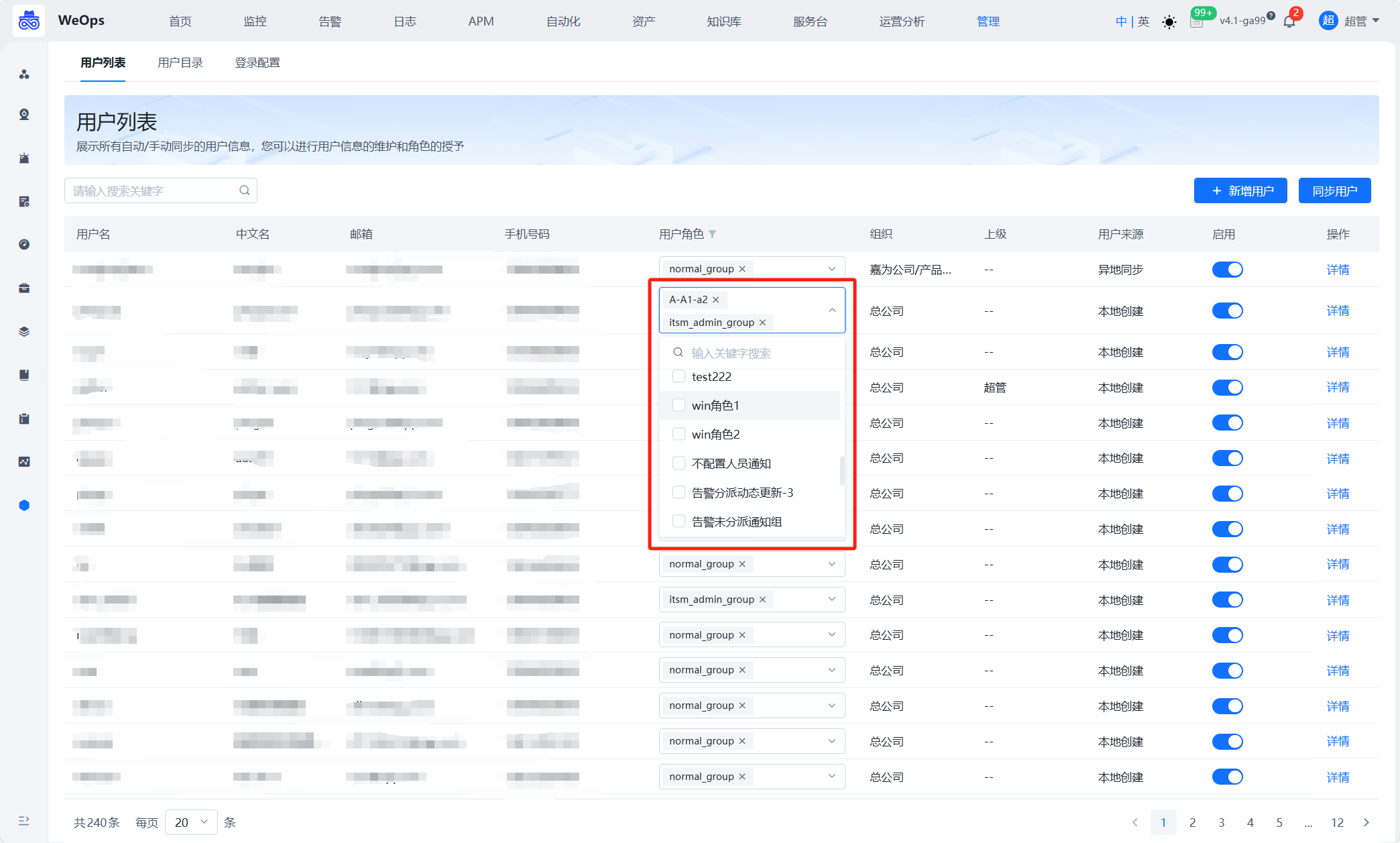

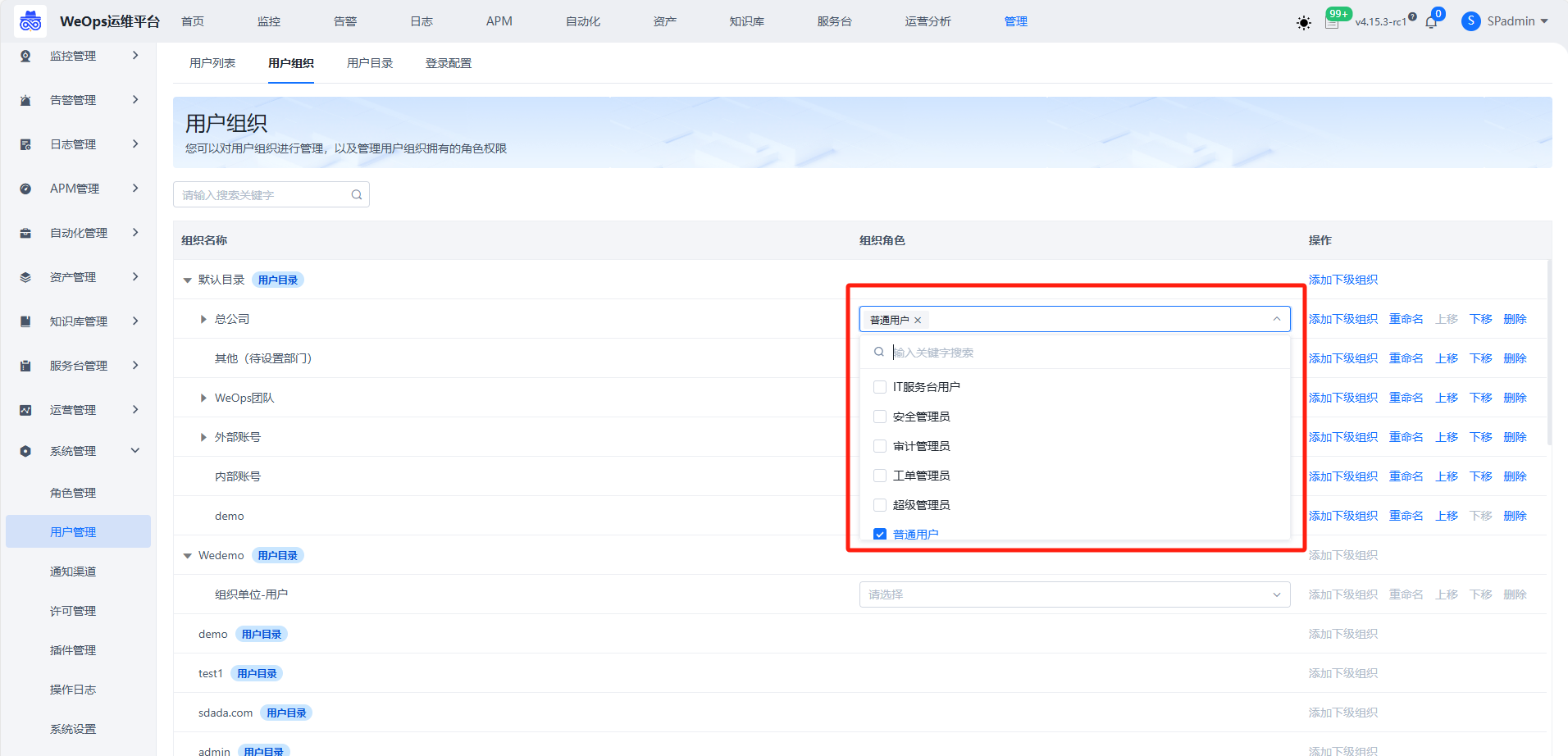

用户管理

- 用户管理接入AD/LDAP需要开放用户组织权限。管理员能够在WeOps中维护AD/LDAP用户的上级信息,并且不会因每次同步用户所覆盖。

- 进行用户的新建,用户角色的配置,同时展示用户所属组织的管理。

- 用户管理支持双因子认证的设置,可将用户/角色组添加双因子认证的白名单。

- 支持查看和恢复已删用户。

通知渠道

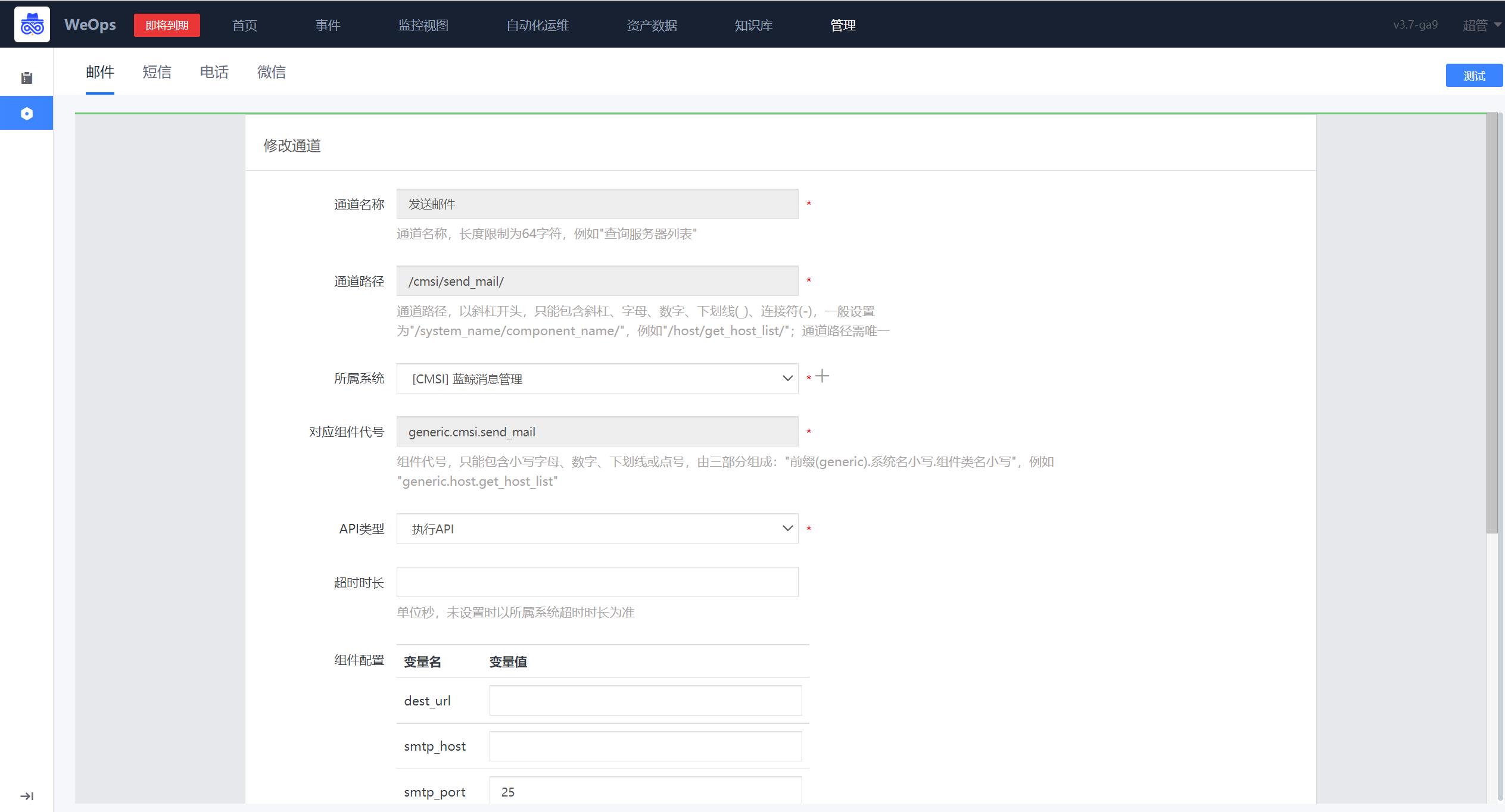

- 通知渠道设置可对WeOps的对外通知渠道的进行配置,包括邮件、短信、电话和企业微信。

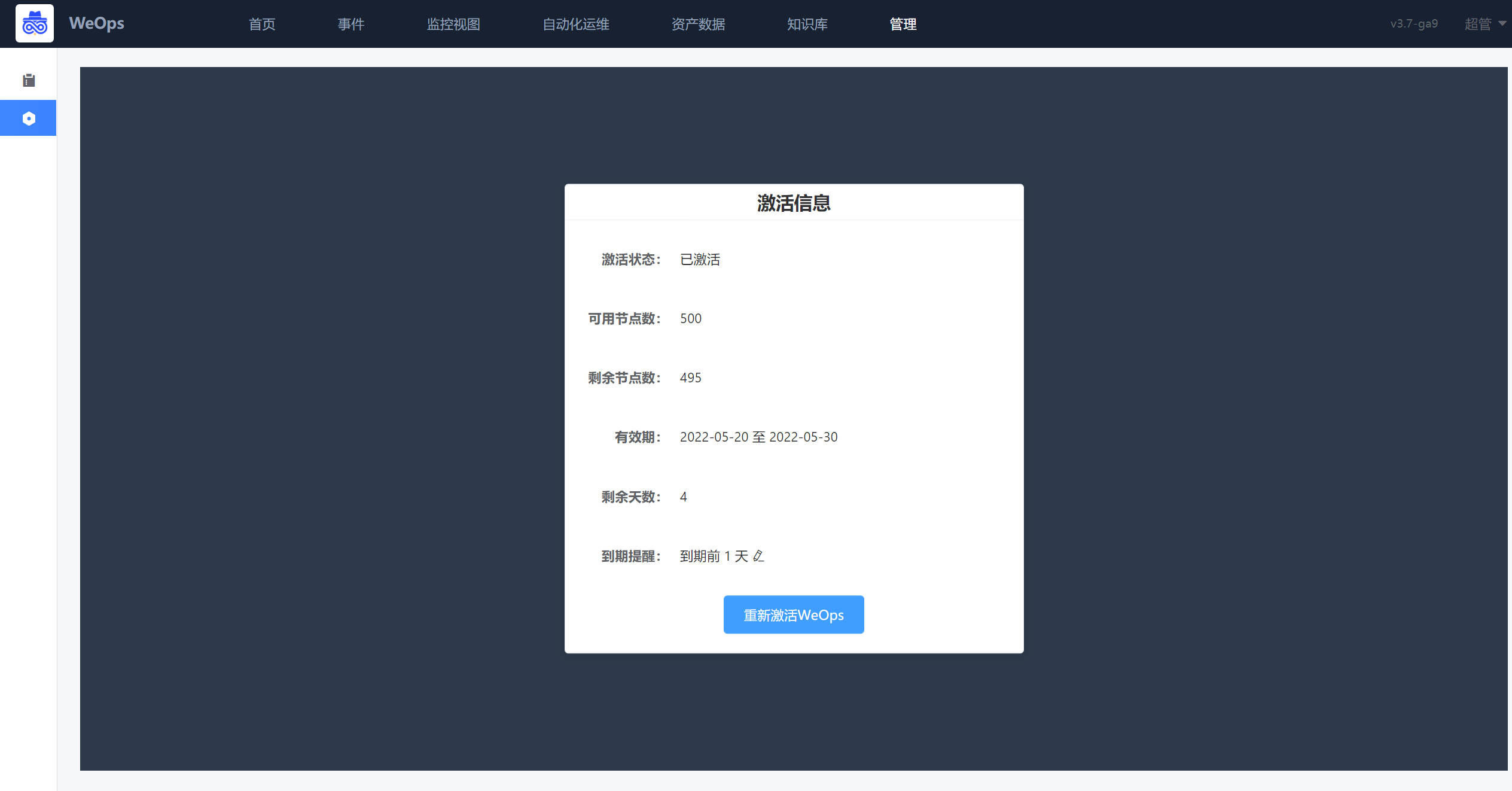

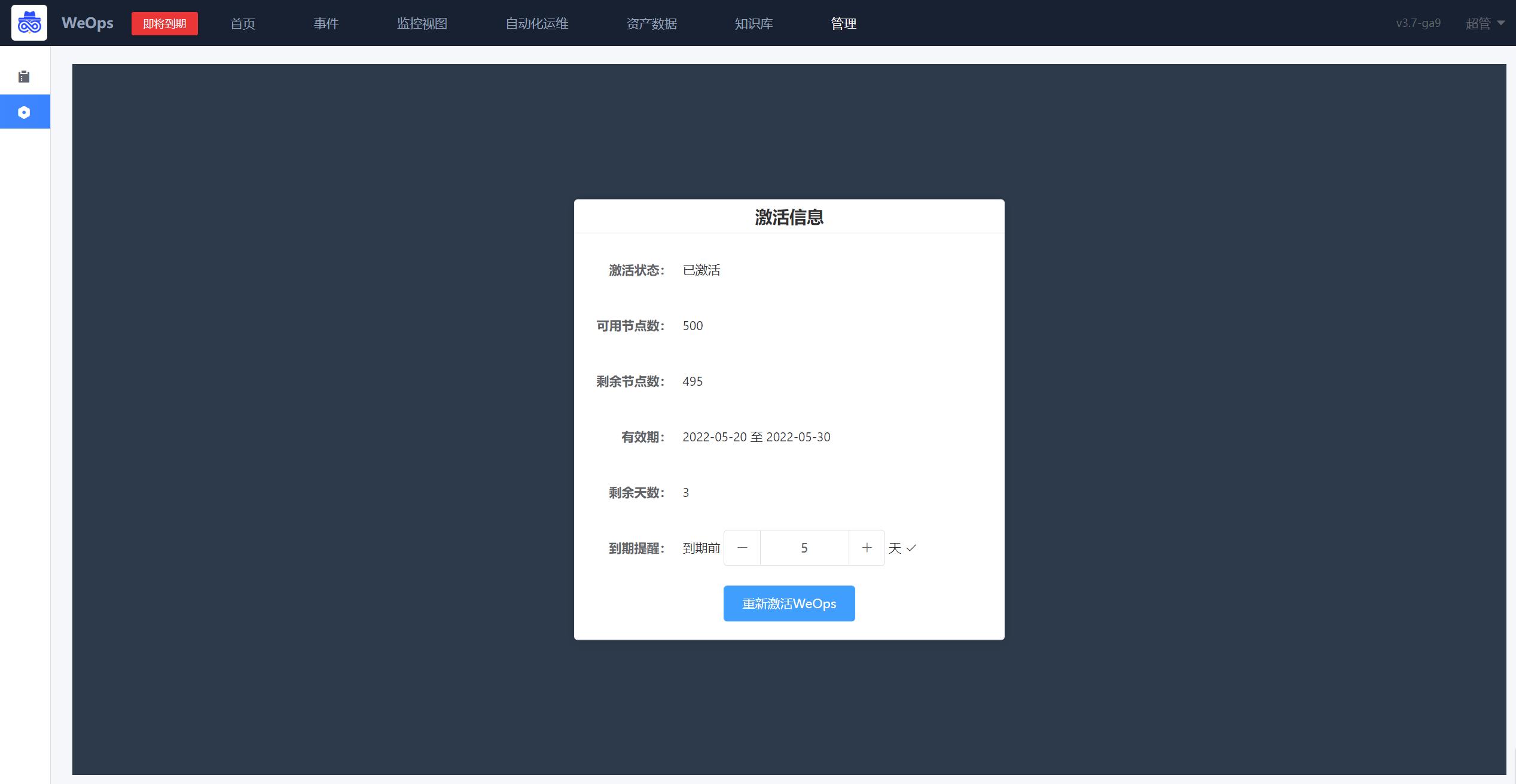

许可管理

- 展示了weops系统的节点数量、有限期等信息,可进行到期提醒,到期提醒设置成功后,可在左上角进行提示。

操作日志

- 展示WeOps相关的增删改等历史记录。

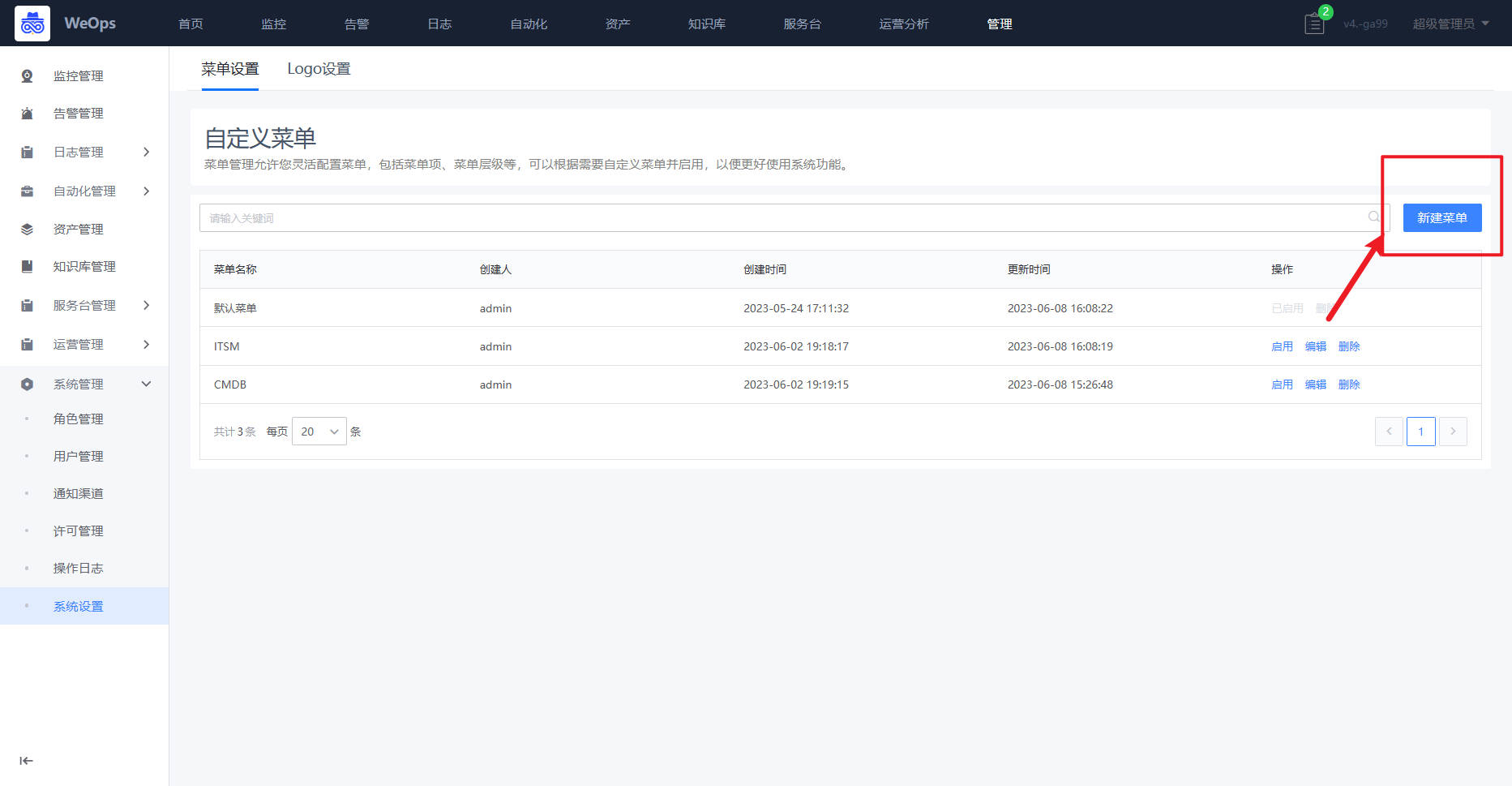

系统设置

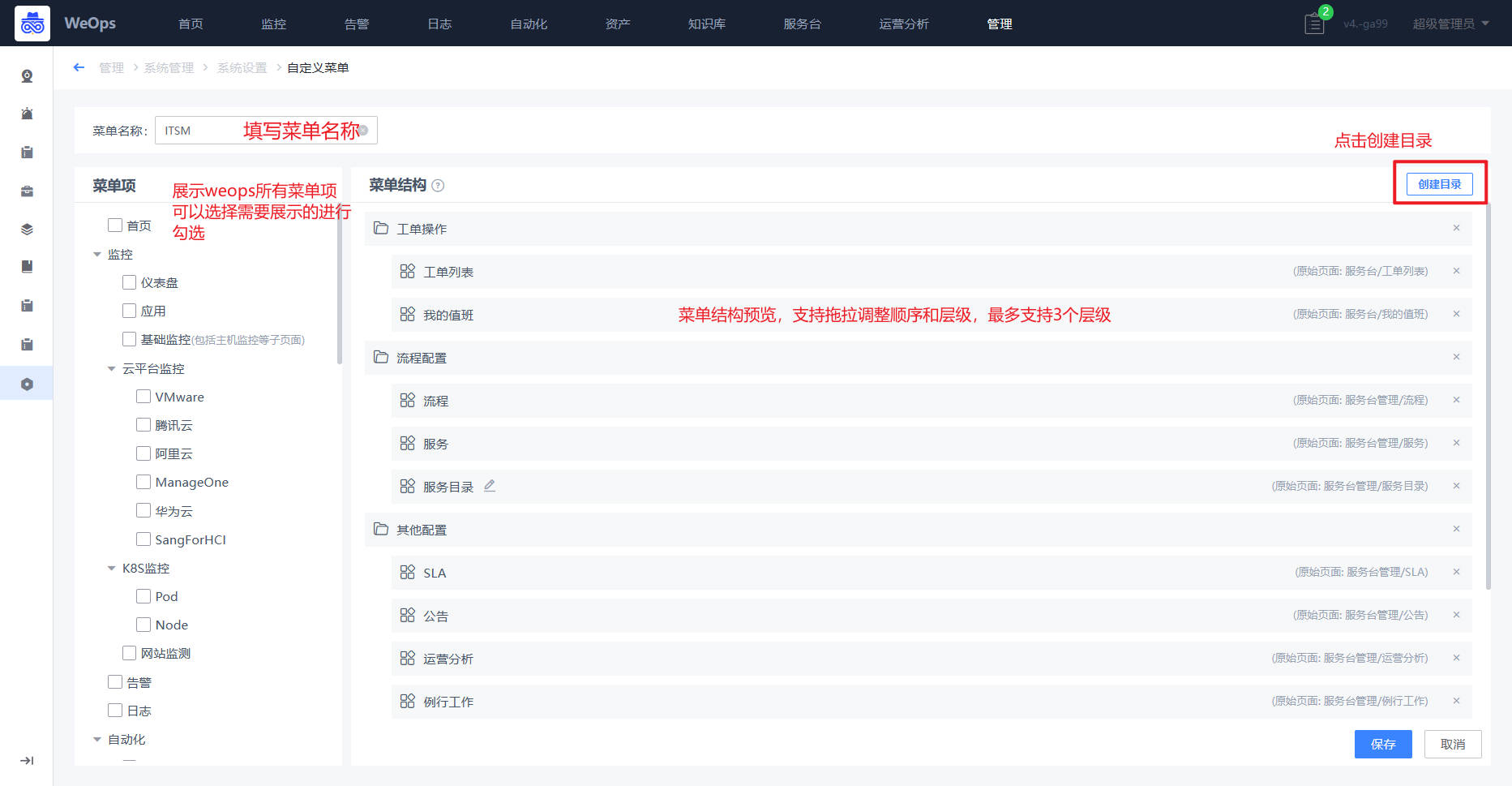

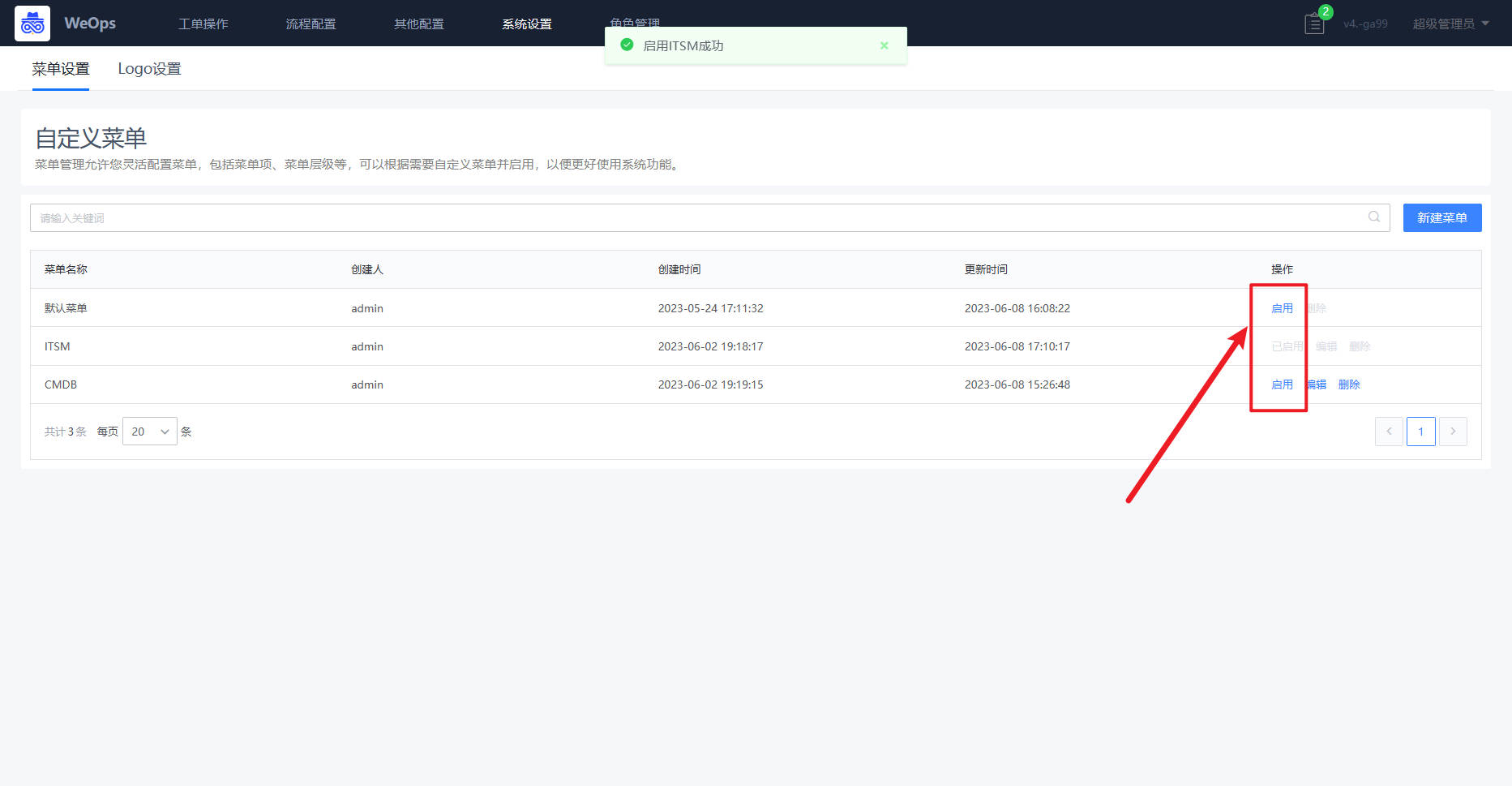

- 自定义菜单:支持灵活配置菜单,包括菜单项、菜单层级、菜单顺序等,可以根据需要自定义菜单并启用,以便更好使用系统功能。

- 自定义产品名称:支持修改运维门户、服务台门户的产品名称。

- 自定义产品LOGO:支持上传修改运维门户、服务台门户的产品LOGO。

- 页面水印:支持为运维门户、服务台门户所有页面配置水印。

操作手册

资源纳管配置

资产和应用关系说明

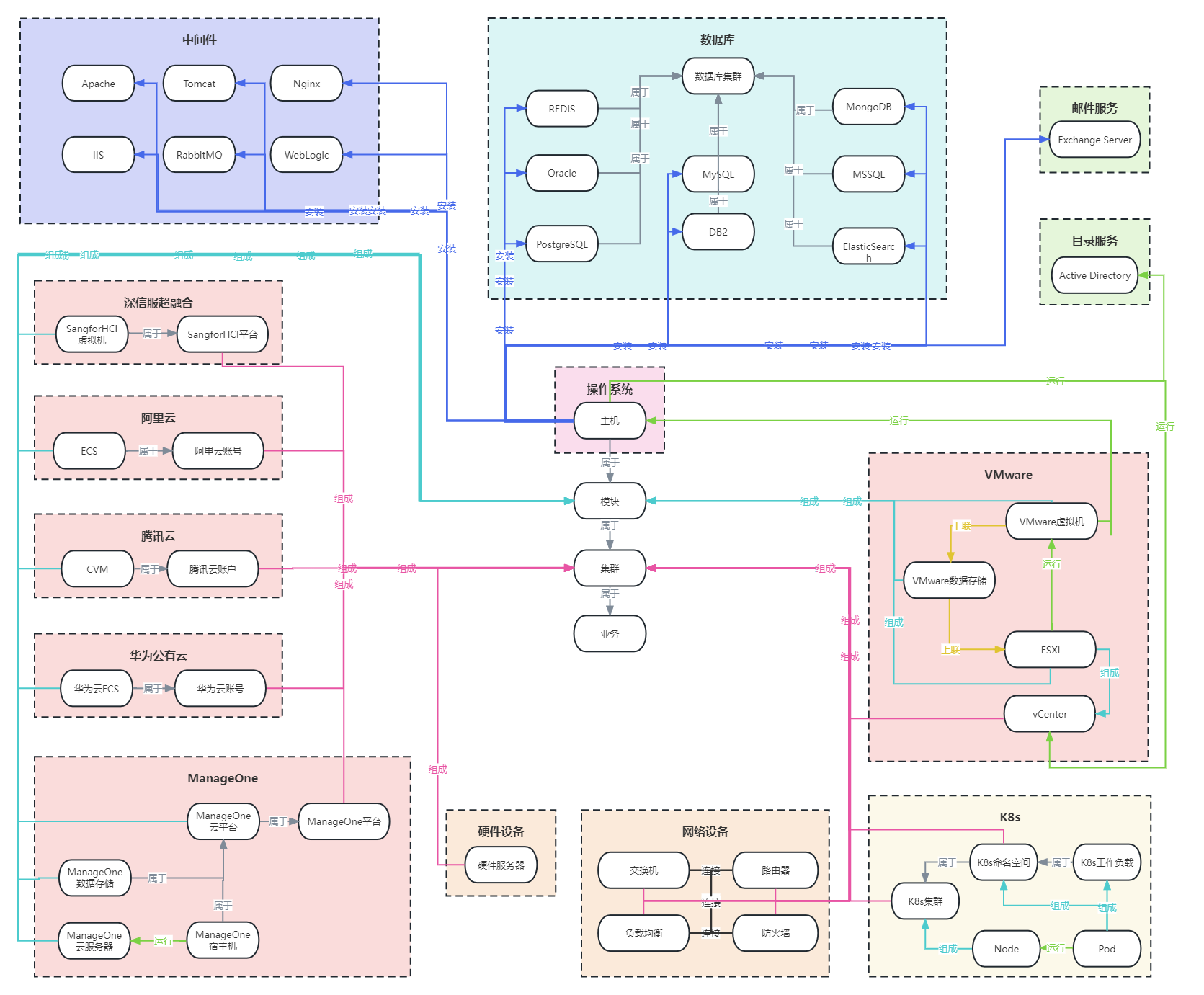

WeOps所有资源模型之间的关联关系如下:

不同客户不同资产的应用归属链路略有不同,为了满足不同客户的特殊需求,支持对各个资产的应用归属链路进行自定义。

- 应用链路配置页面:每个资产只能开启一条应用链路,并依据该链路寻找归属应用(k8s的workload、pod支持同时开启所有默认链路规则)

- 内置各资产应用链路:各内置资产模型均内置默认应用链路规则,具体内置链路说明如下

主机

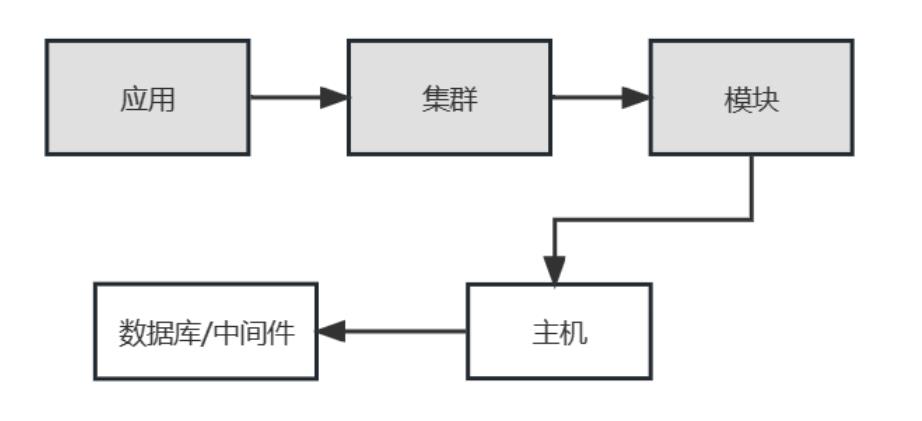

如下图,主机直接与“模块”关联,其应用归属来自于所属的模块的应用。

数据库/中间件

如下图,数据库/中间件与主机关联,其应用归属来自于关联的主机应用属性。

K8S

如下图,K8S集群、命名空间、工作负载、pod、node的关联关系如图,各个模型的应用属性描述如下:

K8S集群:直接与集群关联,从而获得应用属性

命名空间:直接与集群关联,从而获得应用属性

node:来自于关联的K8S集群的应用属性

工作负载:共有两条链路,“K8S工作负载-K8S命名空间-集群”、“K8S工作负载-K8S工作负载-K8S命名空间-集群”

pod:共有三条链路,“Pod-K8S工作负载-K8S命名空间-集群”、“ Pod-K8S命名空间-集群”、“Pod-K8S工作负载-K8S工作负载-K8S命名空间-集群”

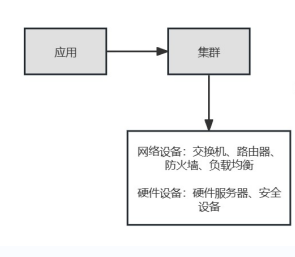

网络设备&硬件设备

如下图,交换机、路由器、负载均衡、防火墙等网络设备,硬件服务器、安全设备等硬件设备都直接与集群关联,从而获得对应的应用属性。

云平台-VMware

如下图,Vcenter、虚拟机、ESXI、数据存储直接的关联关系如图,各个模型的应用属性描述如下

vcenter:直接与集群关联,从而获得应用属性

虚拟机、ESXI、数据存储:各自直接与模块关联,从而获得应用属性

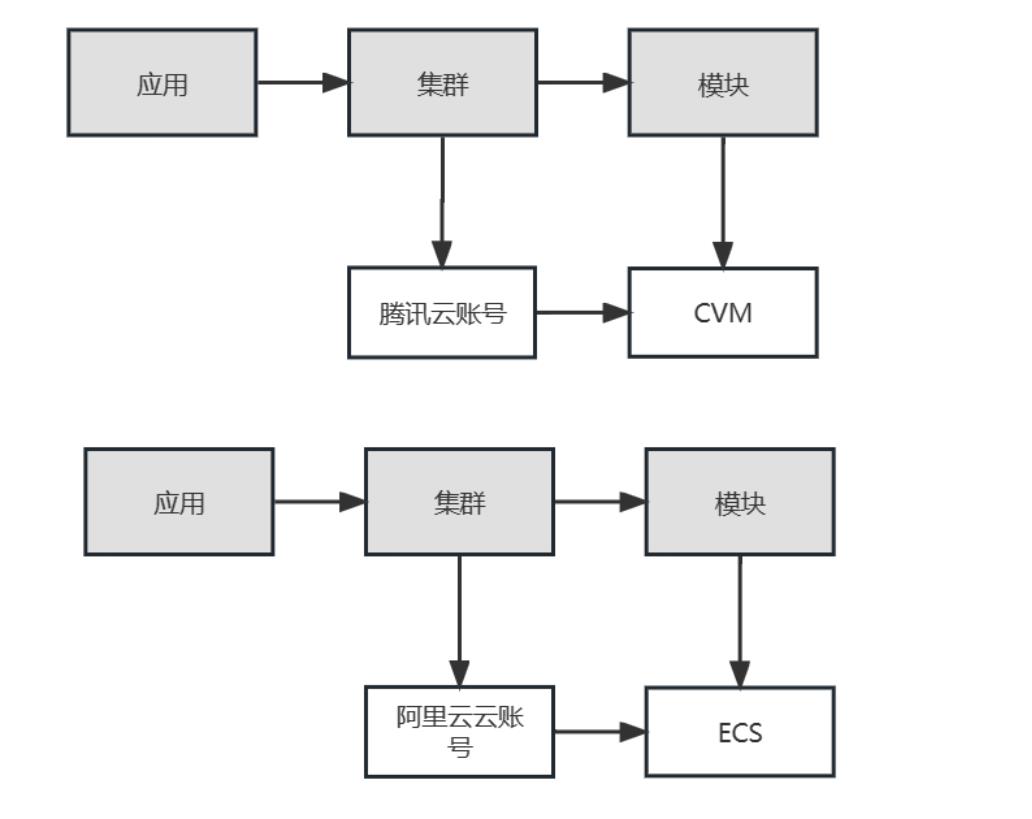

云平台-腾讯云/阿里云

如下图,云账户直接与集群关联,从而获得应用属性,云服务器(CVM、ECS)直接与模块关联,从而获得应用属性。

云平台-manageone

如下图,华为云Manageone平台的关联关系如下,各类对象的的应用归属描述如下

- ManageOne平台:与集群管理,从而获得应用属性

- 云服务器、云平台、宿主机、数据存储:直接与模块关联,从而获得应用属性

云平台-SangforHCI

如下图,SangforHCI平台的关联关系如下,各类对象的应用归属米搜狐如下

- SangforHCI平台:直接与集群关联,从而获得集群的应用属性

- 虚拟机:直接与模块关联,从而获得应用属性

云平台-FusionInsight

如下图,FusionInsight平台的关联关系如下,各类对象的应用归属米搜狐如下

- FusionInsight平台:直接与集群关联,从而获得集群的应用属性

- FusionInsight集群/主机:直接与模块关联,从而获得应用属性

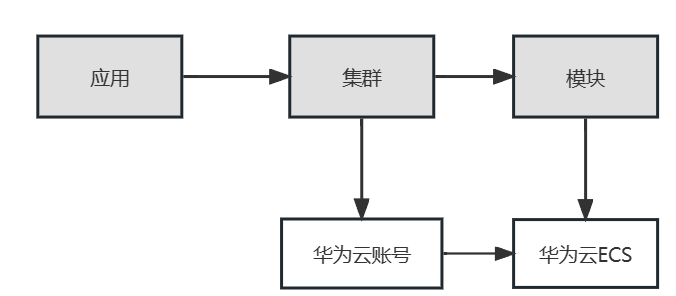

云平台-华为云

如下图,华为云平台的关联关系如下,各类对象的应用归属米搜狐如下

- 华为云账号:直接与集群关联,从而获得集群的应用属性

- 华为云ECS:直接与模块关联,从而获得应用属性

主机纳管

背景介绍:需要把主机纳入到WeOps的管理中,有两种方式进行:一是手动创建仅记录主机信息,二是安装Agent进行主机信息的自动采集

方式一:手动创建

路径:资产-资产记录-主机

手动创建仅录入主机的相关信息,进行主机的信息管理和拓扑展示,若需要对手动创建的主机进行监控数据采集,需要对其进行Agent安装。

Step1:进入界面,点击“新建”

Step2:填写主机相关信息

在弹出的抽屉中填写相关主机信息,必填字段包括:内网IP、云区域

手动创建的主机agent状态为“未安装”,若需要安装agent,则前往“管理-管理中心-监控管理-监控采集”进行agent的安装。

方式二:安装Agent

路径:管理-监控管理-监控采集

以安装agent的方式进行主机的纳管,在agent安装后,可在“资产数据-资产记录(主机)”中形成对应的主机信息,同时支持监控数据的采集。可以选择手动单个agent安装,或者利用表格导入进行批量安装,安装步骤基本一致。

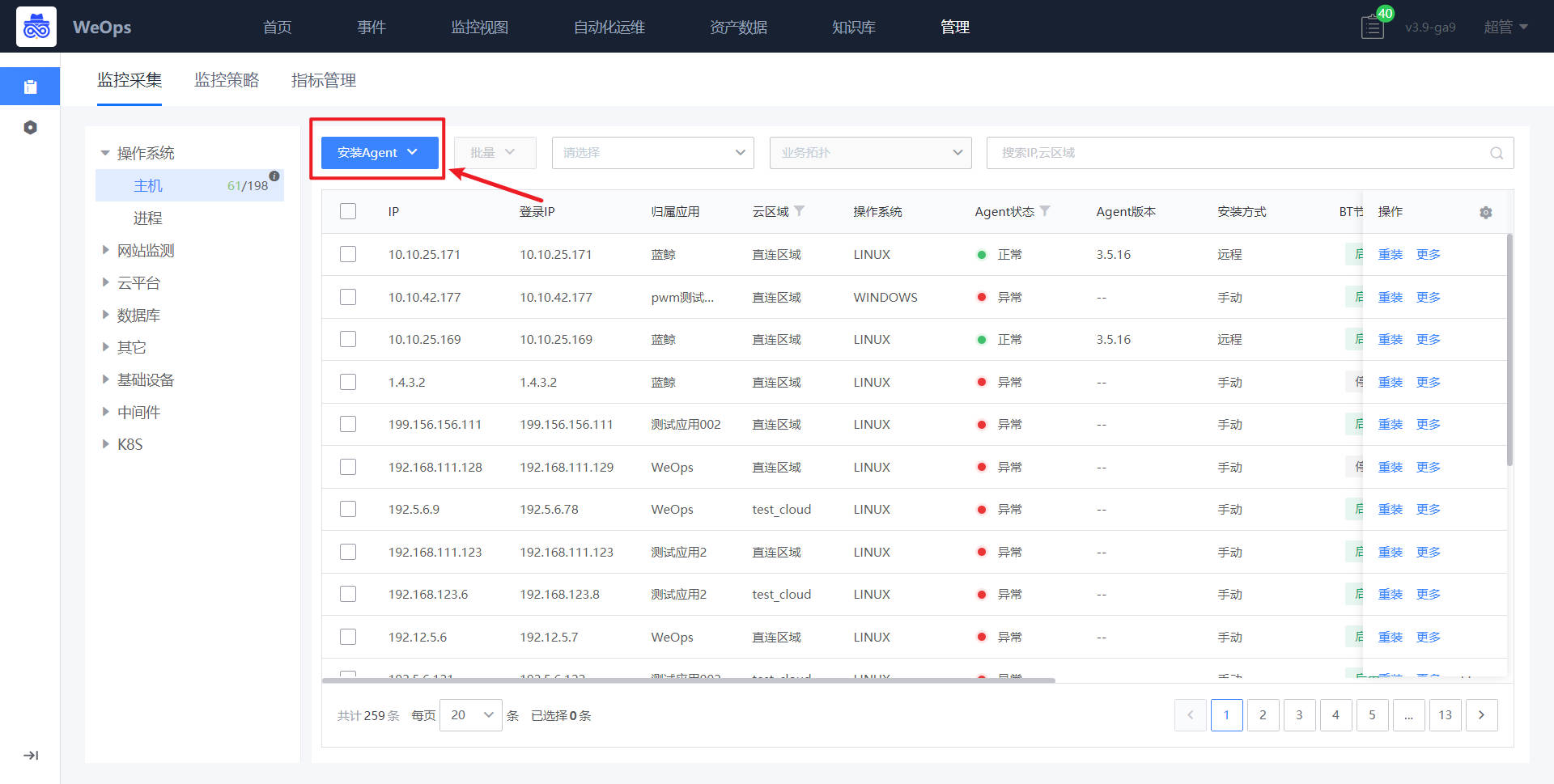

Step1:进入界面,点击安装Agent

如下图所示,选择“操作系统-主机”,进入主机Agent安装界面,点击“安装Agent”

Step2:填写相关信息

在安装的界面,选择该主机归属的业务、云区域以及接入点。随后在安装信息输入该纳管主机的IP地址,登录账号和密码等核心配置。输入完成之后点击[安装]按钮即可将agent部署至该主机。

Step3:等待安装成功

上一步骤点击安装将会跳转至安装界面,可以查看执行状态,点击查看日志可以查阅安装过程。

安装完成回到主机纳管的界面可以看到该主机的Agent已经顺利安装。

应用新建

背景介绍:当有新应用上线时,需要在WeOps的应用管理对该应用进行纳管,具体步骤如下:新建应用,填写该应用相关信息→确定该应用层级并配置拓扑→添加主机,进行管理。

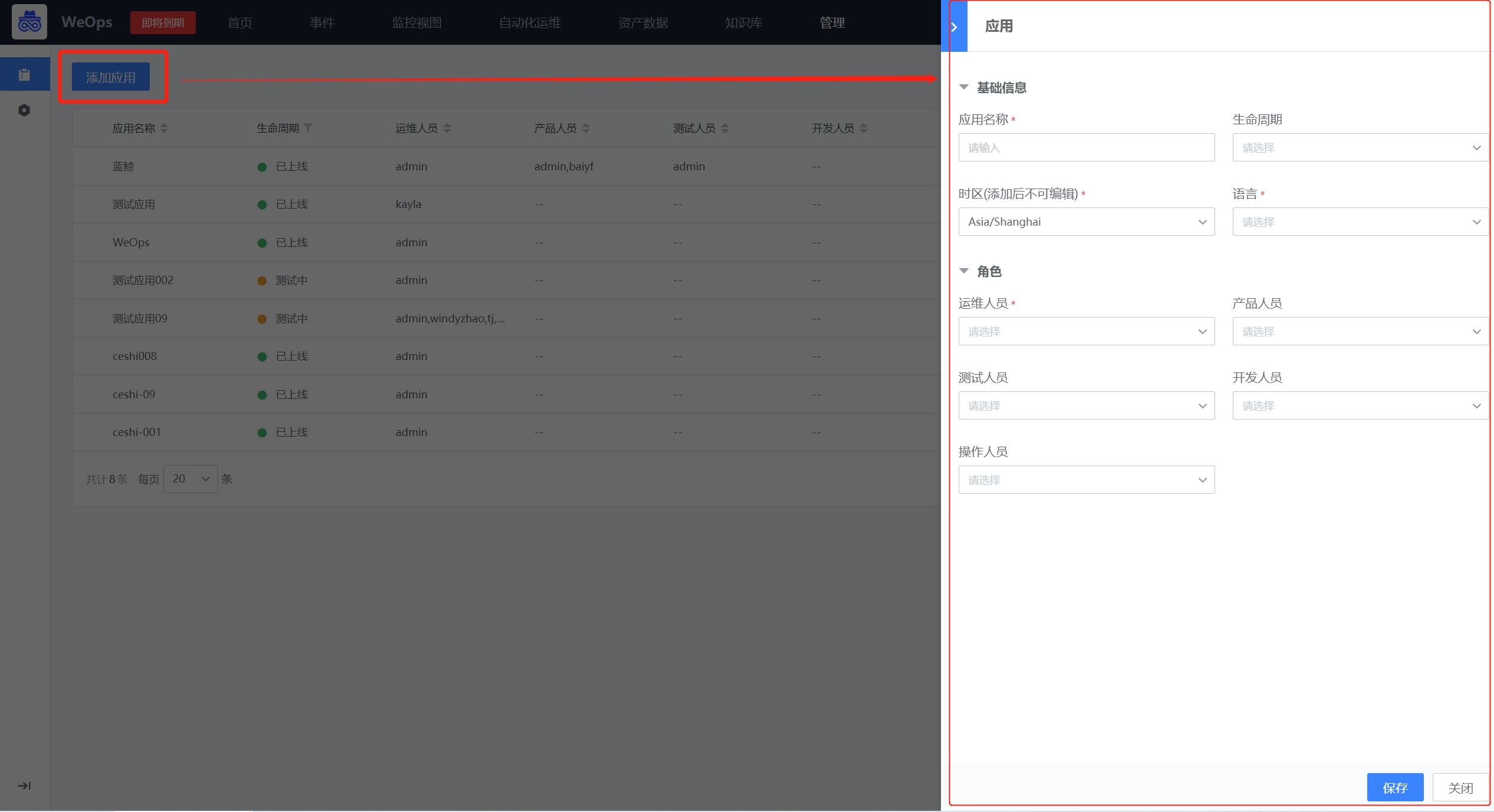

Step1:新建业务

路径:资产-应用

在应用列表页面,点击“添加应用”按钮,可以进行应用的新建。需填写基础信息和角色信息。

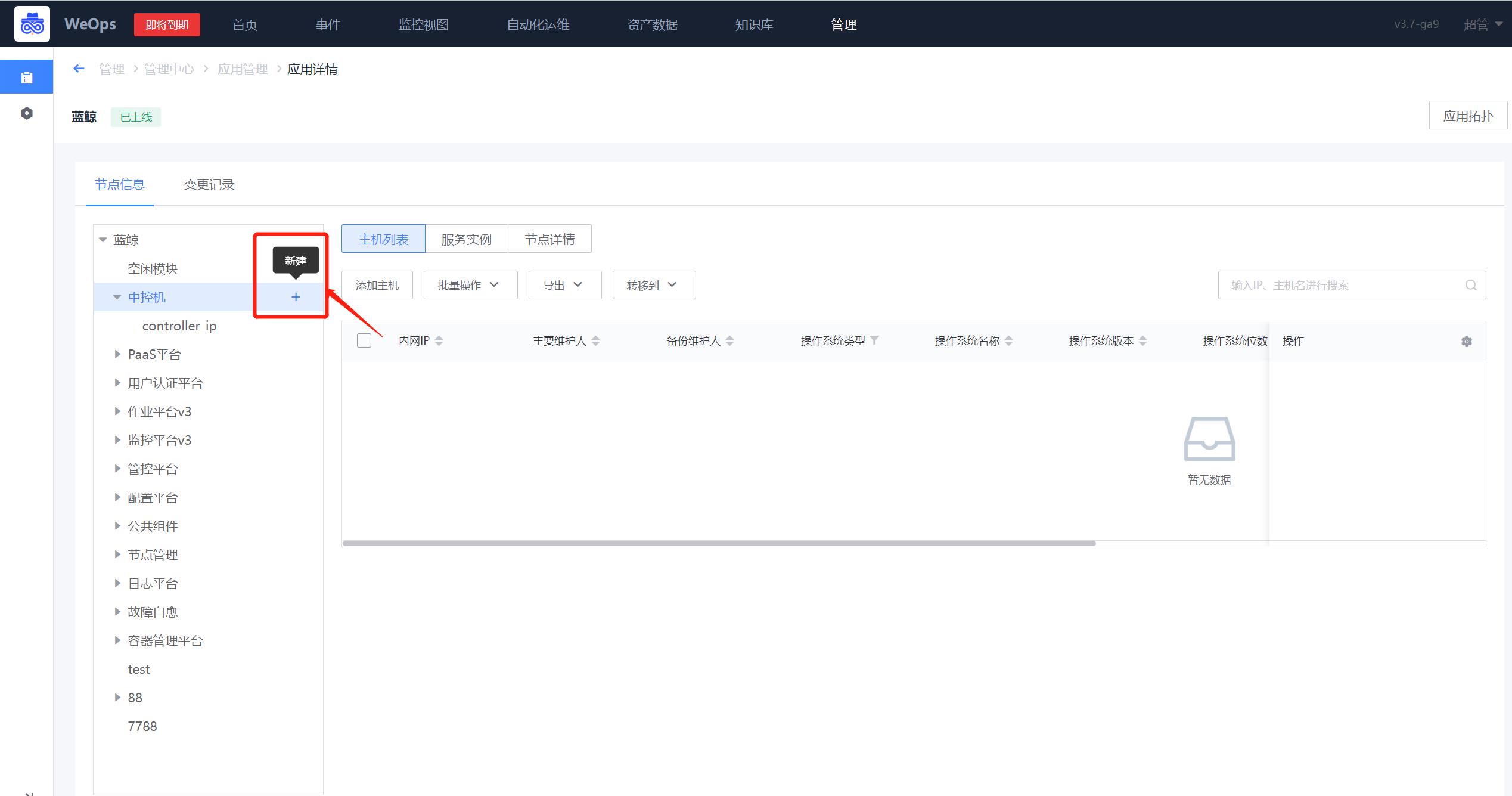

Step2:配置应用拓扑

路径:资产-应用

- 进入新创建的应用的详情页面,点击左侧的节点信息,展示该应用的拓扑

- 点击页面左侧的拓扑的对应节点,可依据实际情况依次添加“子应用”、“集群”和“模块”等层级

Step3:主机分配和移动

路径:资产-应用

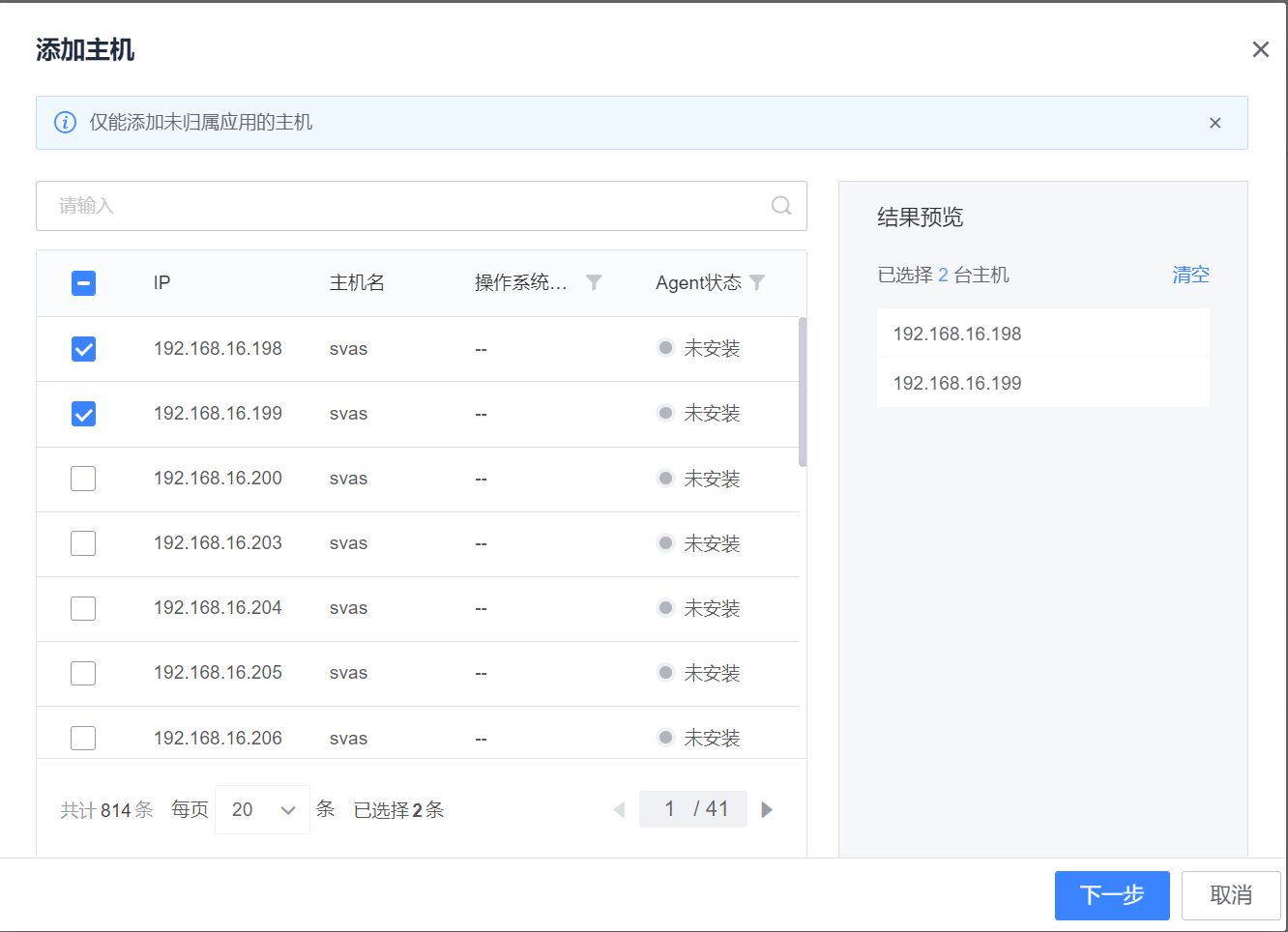

应用的拓扑新建完成后,可以向各个节点添加主机。选中需要添加的节点,点击“主机列表”下的“添加主机”按钮,这里展示了所有没有归属应用的主机列表(展示手动创建/安装Agent两种方式下未归属应用主机),选择需要加入的主机,点击下一步,选择模块即可添加成功。

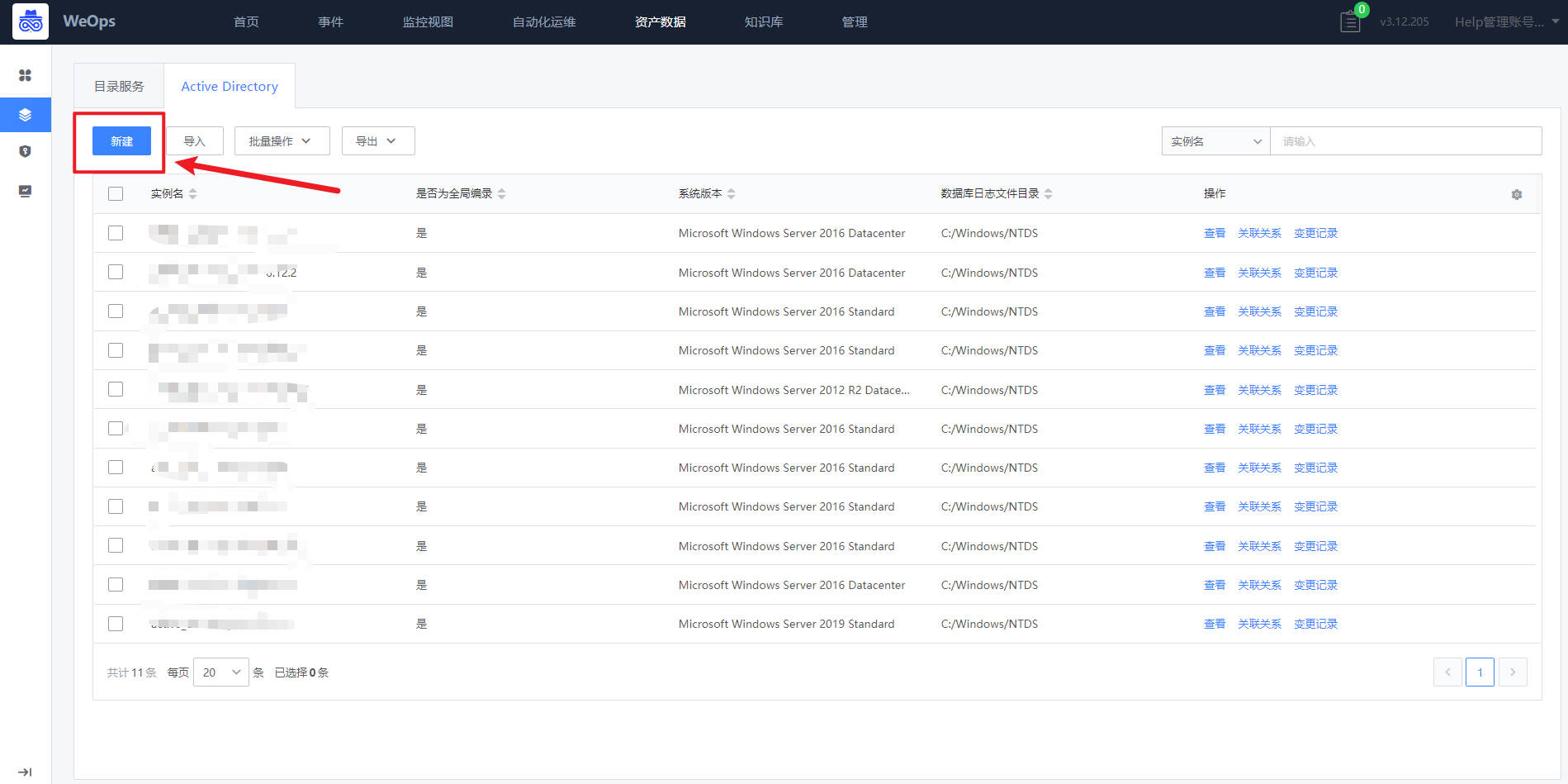

数据库/中间件纳管

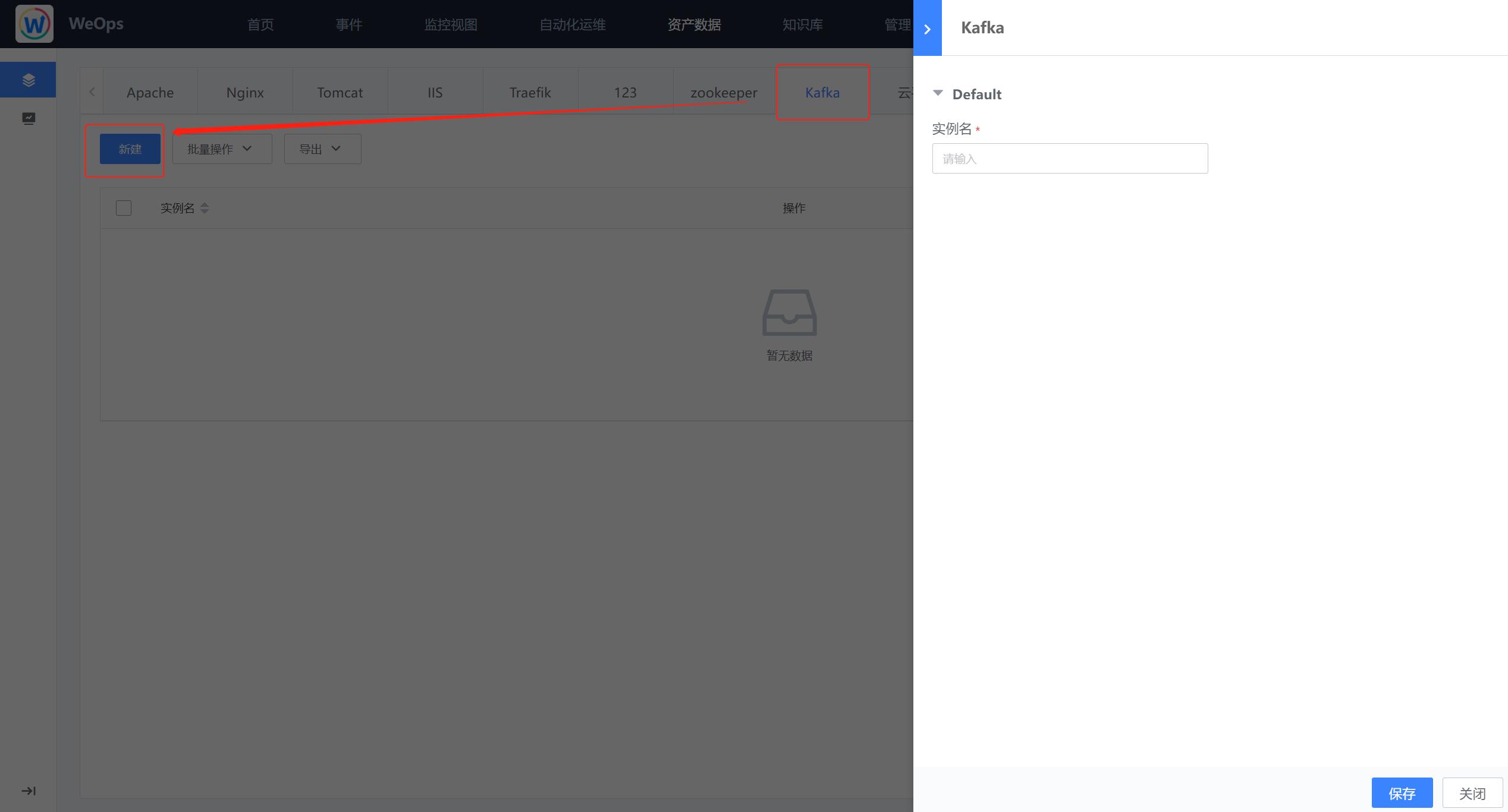

背景介绍:关联主机已经进行Agent的安装,并且Agent正常(主机Agent安装详见1.1主机纳管),这里以Oracle为例进行介绍,有两种方式进行资源的纳管,一种是手动纳管,一种是创建自动发现任务进行资产纳管。

方法一:手动纳管

路径:资源-资源记录-数据库(Oracle)

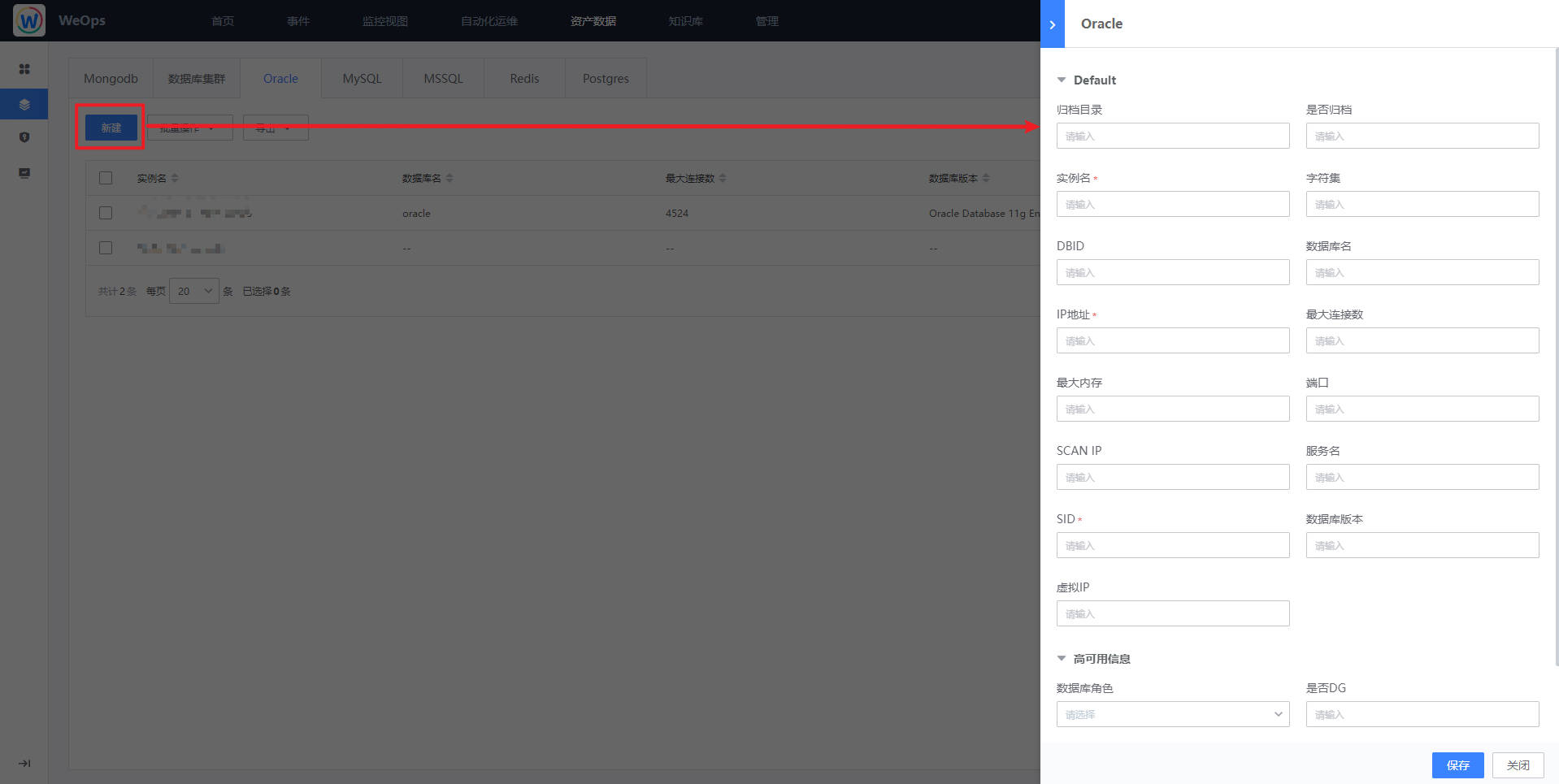

Step1:进入界面,点击“新建”,进行实例信息录入

点击“新建”按钮后,在弹出的抽屉中,填入Oracle的相关信息。

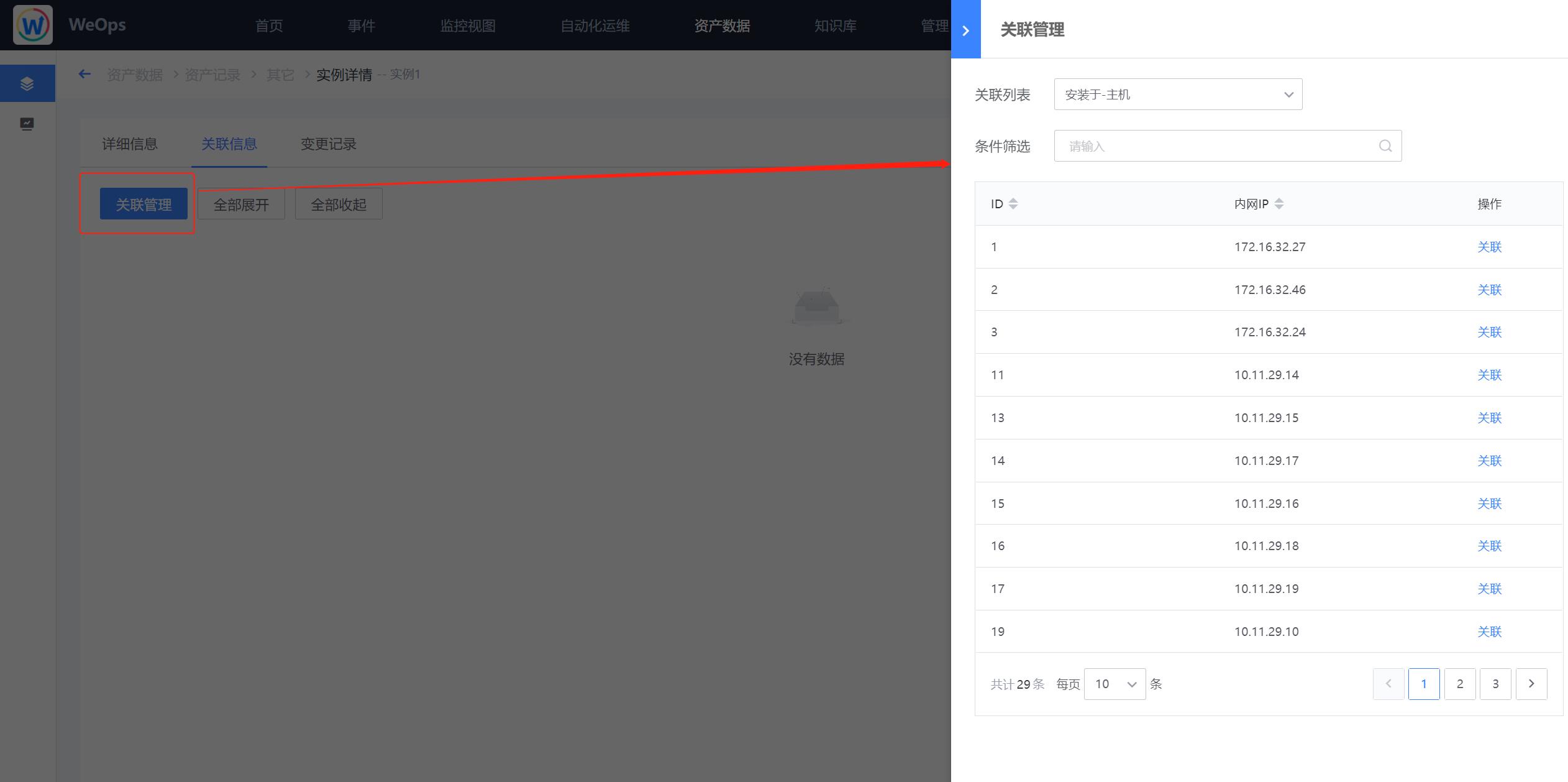

Step2:建立与主机的关联

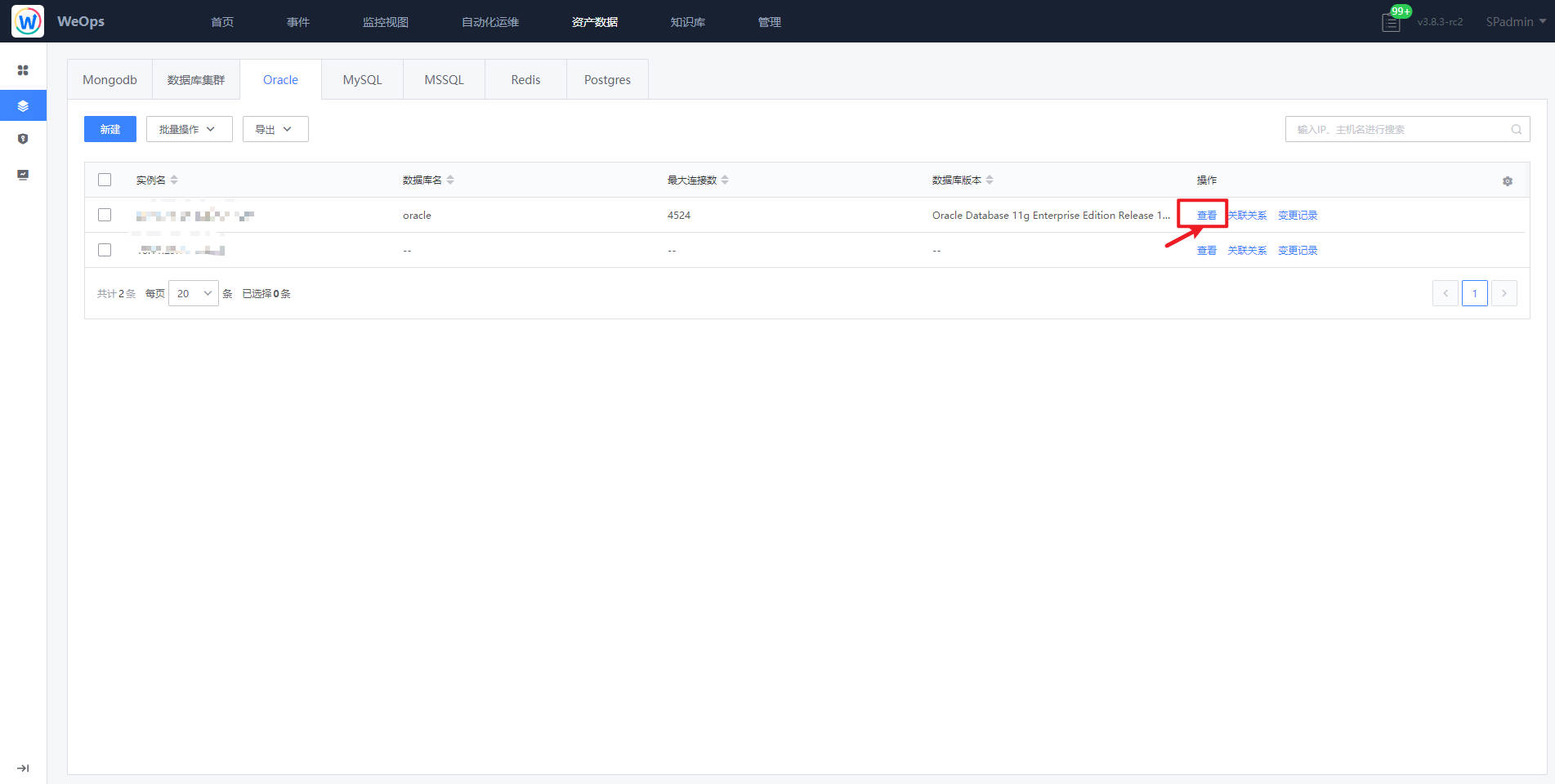

实例新建完成后,点击“查看”按钮,进入到该实例的详情页。

点击“关联信息”中的“关联管理”,建立该Oracle数据库和对应主机的关联关系。

手动创建的资产的配置信息需求手动维护和更新。

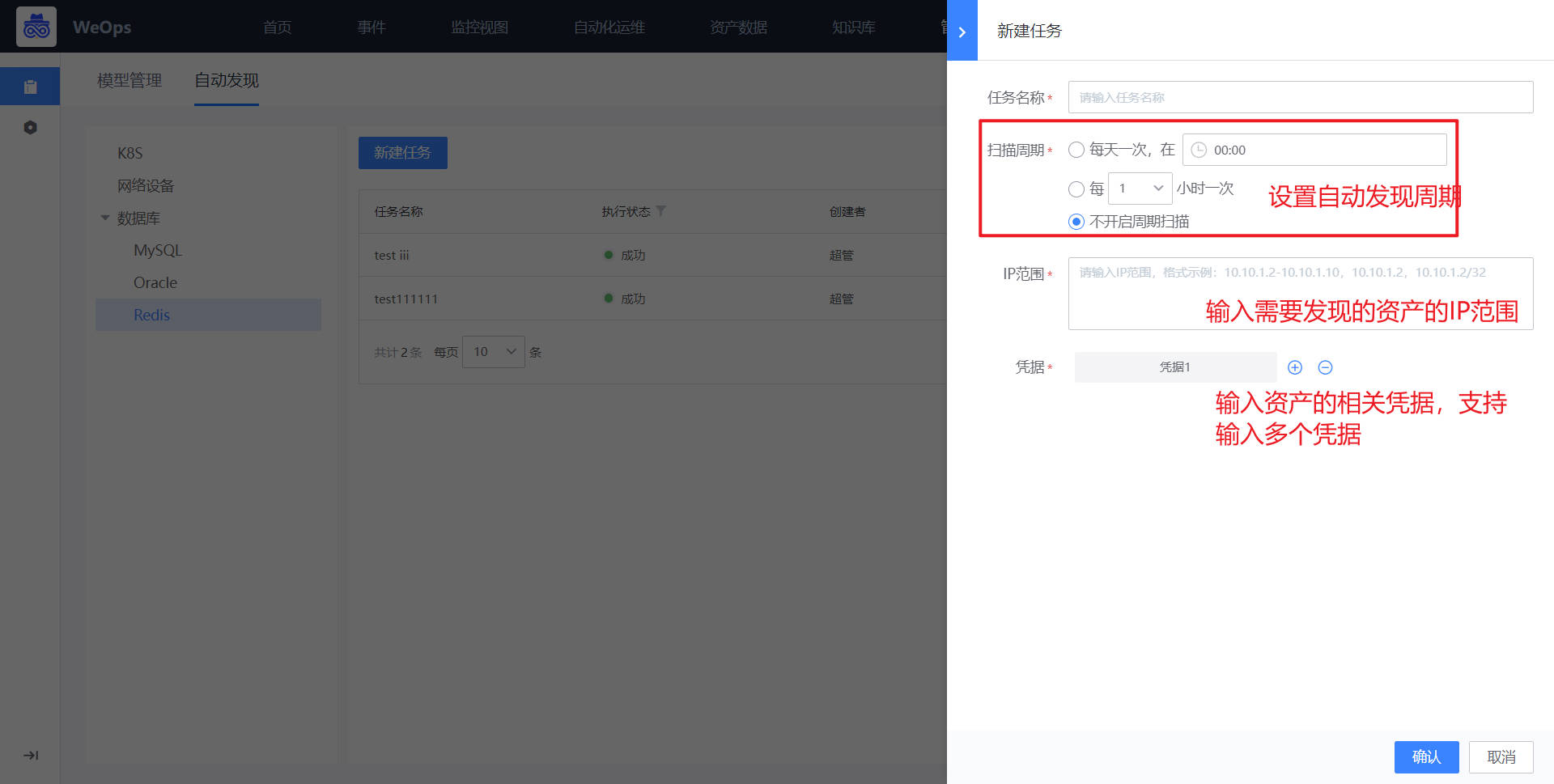

方法二:自动发现

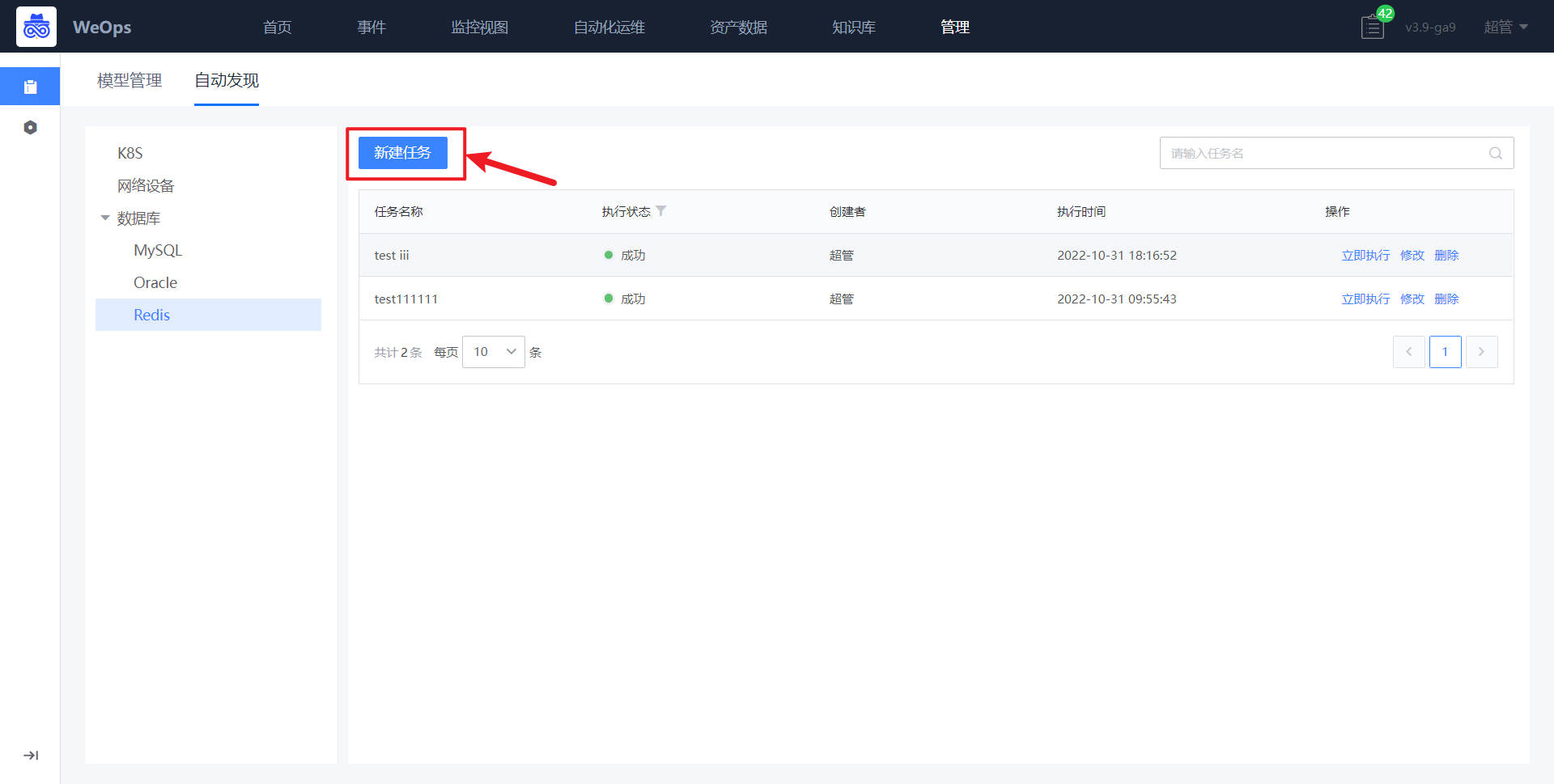

路径:管理-资产管理-自动发现

选择数据库-Oracle,创建自动发现任务,新建任务时,选择资产的IP范围、输入对应凭据

自动发现任务执行完成后,资产数据有如下更新:新增Oracle资产、根据周期实时更新资产配置信息、自动关联对应主机。

云平台纳管(以腾讯云为例)

背景介绍:运维部门需要对云平台(VMware/阿里云/腾讯云)进行资产管理,并展示其直接的关联关系,可以在WeOps的资产数据进行管理,进行云平台的纳管,有两种方式进行:一是手动纳管,手动维护资产信息和关联关系,二是自动发现,自动发现资产信息、关联关系,并自动更新。这里以阿里云为例进行介绍。

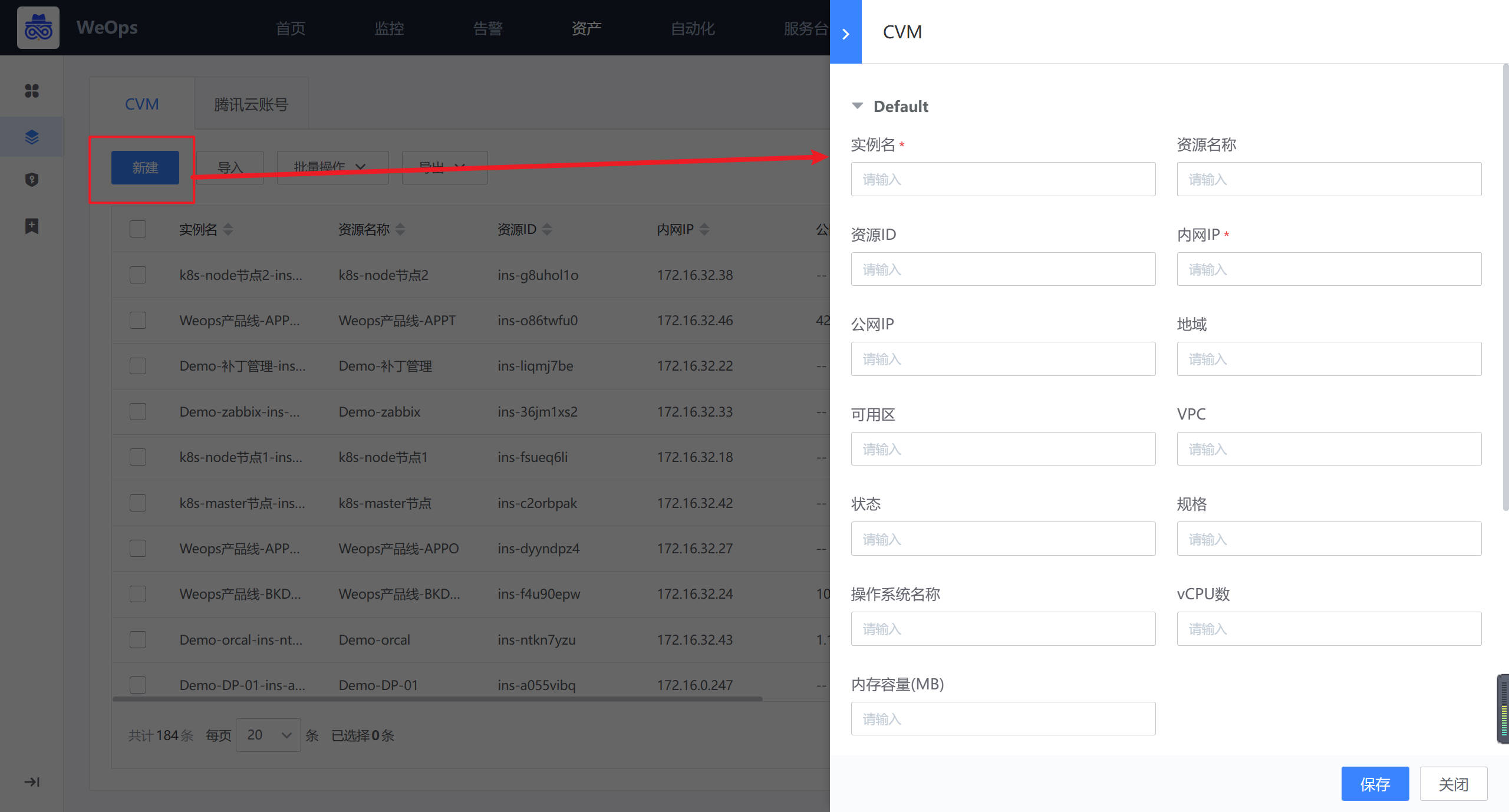

方法一:手动纳管

路径:资源-资源记录-腾讯云

如下图,在“腾讯云—云账户”页面,点击“新建”按钮,进行腾讯云账号的创建,这里的“腾讯云账号”是为了区分不同账号下的云服务器而创建的资产模型

如下图,在“腾讯云-CVM”页面,点击“新建”按钮,进行云服务器的创建,并手动填写对应信息。

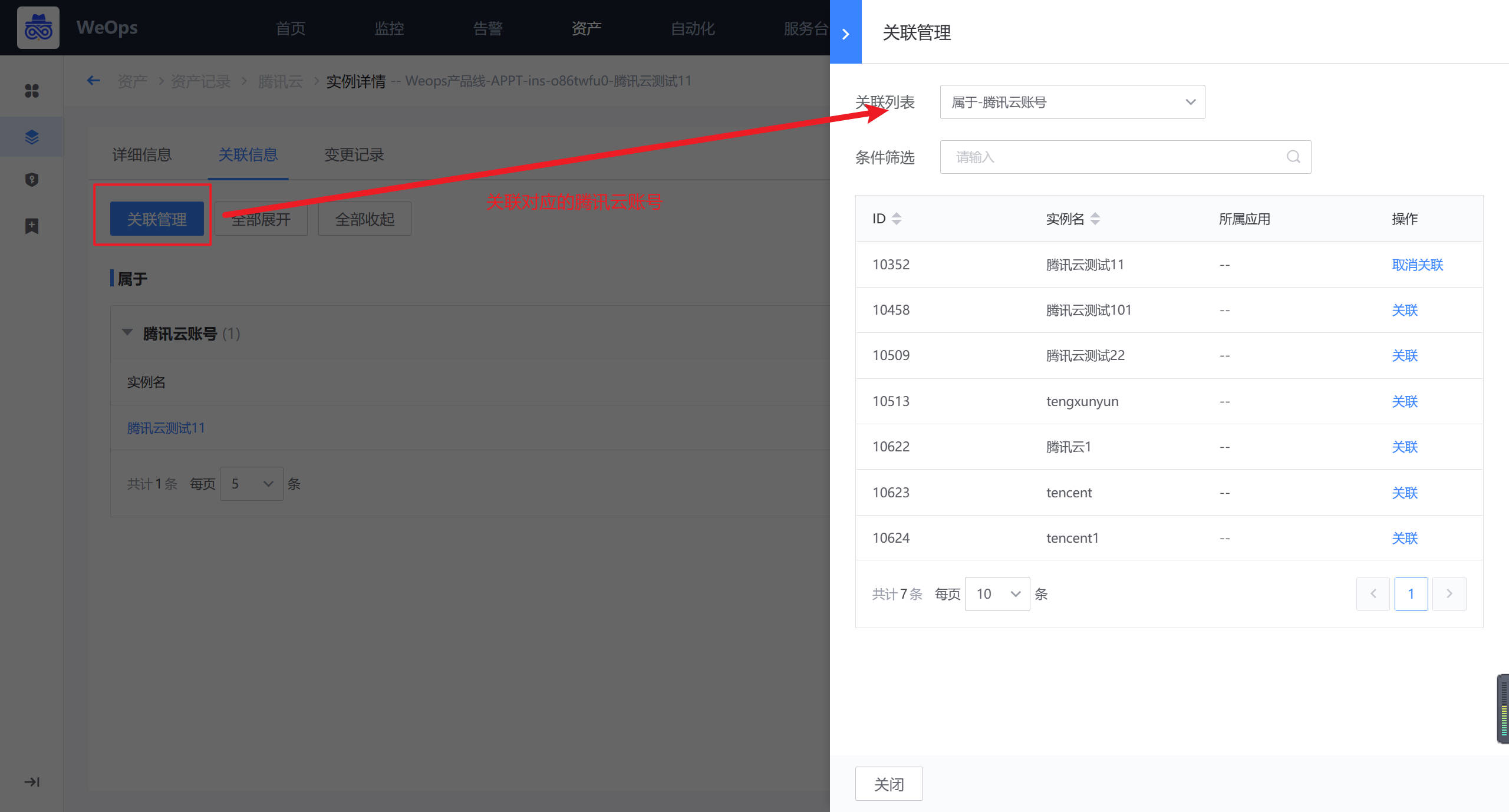

创建完成后,在CVM的实例详情中,进行其与云账户的关联。

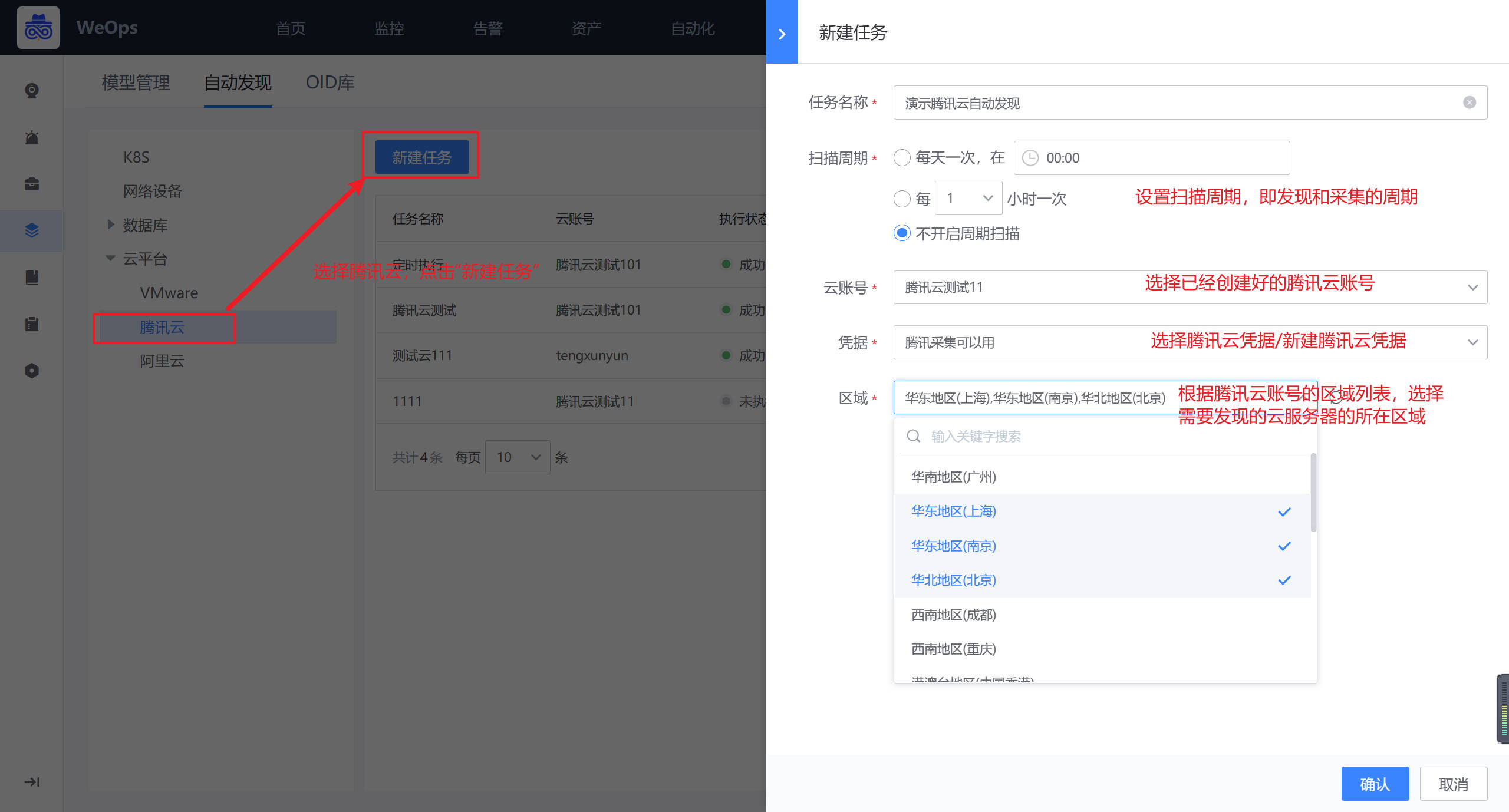

方法二:自动发现

路径:资源-资源记录-腾讯云

如下图,在“腾讯云—云账户”页面,点击“新建”按钮,先进行腾讯云账号的创建。

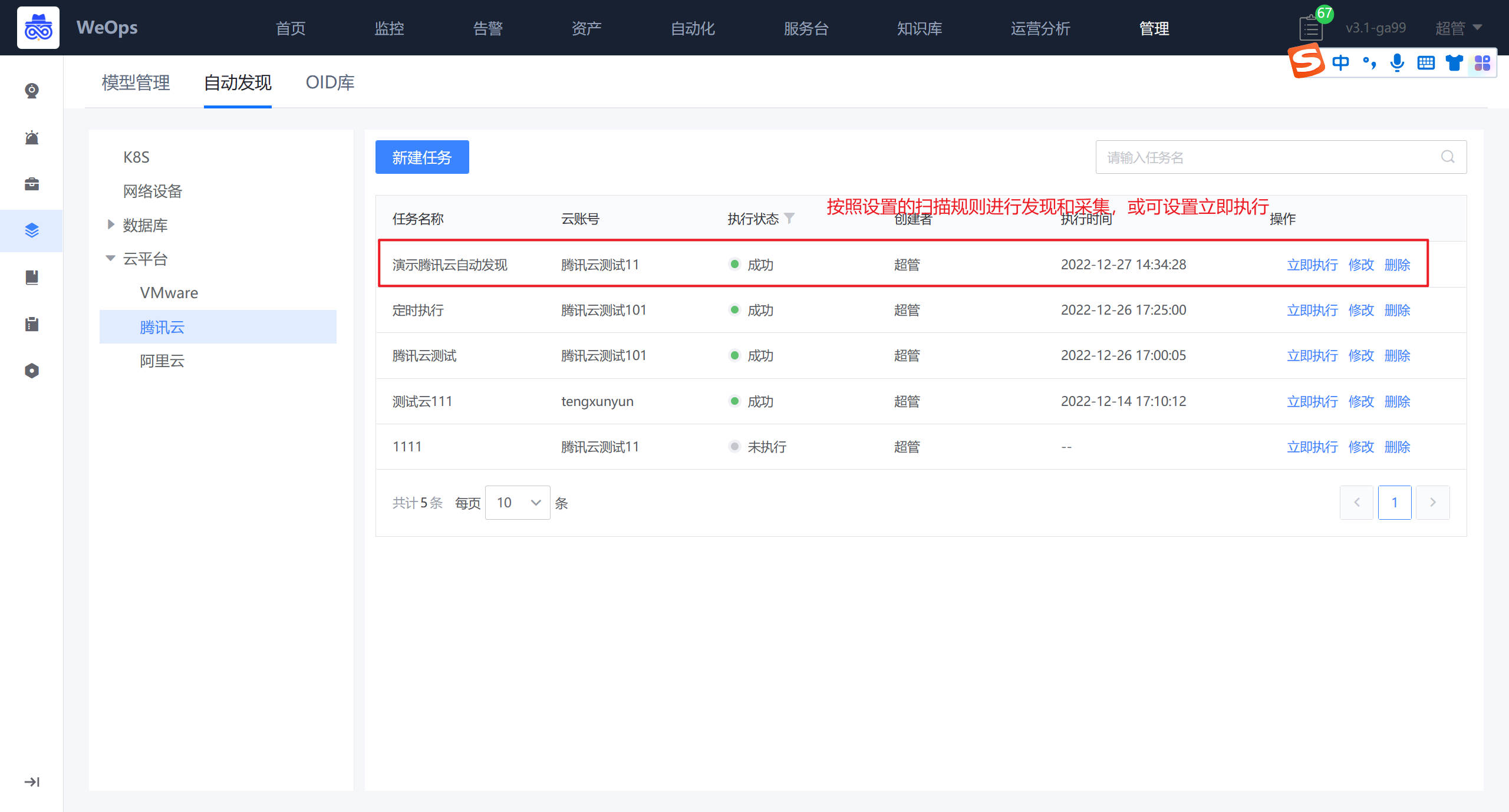

路径:管理-资产管理-自动发现(腾讯云)

在自动发现页面,选择腾讯云,进行腾讯云某个账号下云服务器的发现和采集。在创建采集任务时,可以选择使用已有的凭据,云平台的凭据可在“资产-凭据管理-云平台”中维护,若无关联凭据,在新建自动发现任务时可以新建凭据。

- 阿里云/腾讯云/VMware设置自动发现的账号需要的最小化权限为:只读权限,具体如下

- 域名配置如下:阿里云的域名都是带{资源}+{region}的,例如ecs.cn-guangzhou.aliyuncs.com。腾讯云的域名带{资源}的,例如cvm.tencentcloudapi.com

自动发现完之后,自动采集该腾讯云账号下的所有的CVM及其信息,并在“资产记录-腾讯云-CVM”中自动新增/更新信息。

K8S纳管

背景介绍:需要对K8S集群以及相关的命名空间、工作负载、pod、node的信息进行采集和呈现。“WeOps-资产记录”已经内置K8S五项模型及关联关系,包括“K8S集群”、“K8S命名空间”、“K8S工作负载”、“Pod”、“Node”

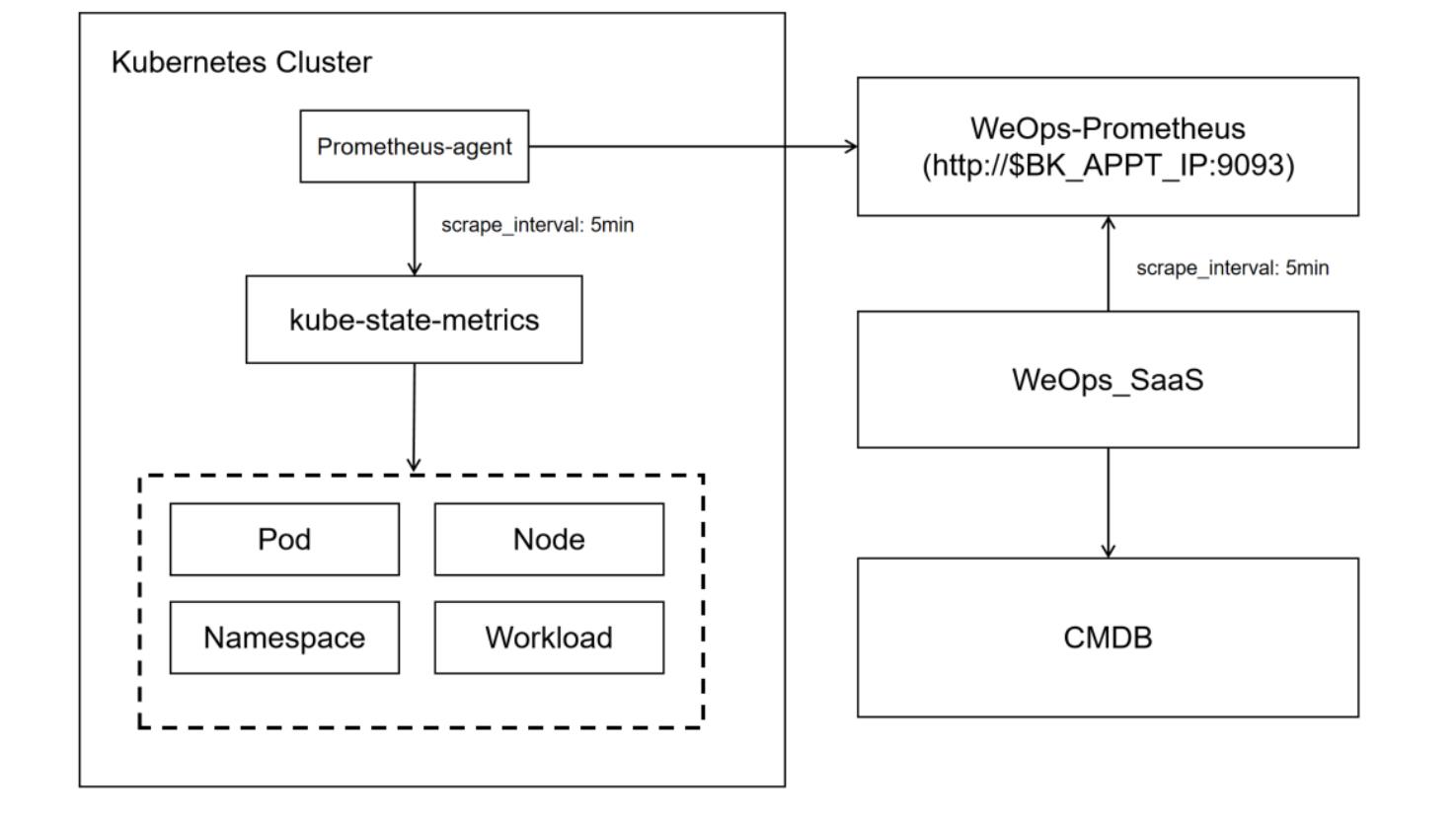

原理介绍:

WeOps对k8s进行配置发现与采集的原理如图

需要额外部署的组件和功能:

1、kube-state-metrics: 集群配置信息的发现采集,需要其他服务主动调取,采用helm的形式在k8s中部署

2、Prometheus-agent: 从kube-state-metrics中获取数据,并推送到weops-prometheus,用helm chart的形式在k8s中部署

3、weops-promtheus: 数据临时存储,weops从此获取原始的资产数据,用docker的形式部署在appt

整体步骤:K8S部署操作——手动创建K8S集群实例——设置自动采集任务——自动采集K8S命名空间、工作负载、pod、node信息,并形成关联拓扑图

Step1:K8S部署操作

1、环境准备(basic auth的用户名密码默认为admin:admin,可按需调整)

在蓝鲸配置平台导入k8s模型组(关联关系必须准确)

#!/bin/bash

mkdir /data/weops/prometheus/tsdb -p

cd /data/weops/prometheus

cat << "EOF" > prometheus-web.yml

basic_auth_users:

admin: $2y$12$Dx1PAPXkUcW10NhuRh.3iuHHDzmT7h6sgv1siHXksRbYk8RrqKkvC

EOF

cat << "EOF" > prometheus.yml

global:

scrape_interval: 15s

evaluation_interval: 15s

EOF

docker load < prometheus.tgz2、在appt启动weops附带的prometheus实例:

docker run -d --net=host -v /data/weops/prometheus/prometheus-web.yml:/opt/bitnami/prometheus/conf/prometheus-web.yml -v /data/weops/prometheus/prometheus.yml:/opt/bitnami/prometheus/conf/prometheus.yml bitnami/prometheus --name=prometheus --web.listen-address=0.0.0.0:9093 --web.enable-remote-write-receiver --web.config.file=/opt/bitnami/prometheus/conf/prometheus-web.yml --config.file=/opt/bitnami/prometheus/conf/prometheus.yml --storage.tsdb.retention.time=30m运行后telnet localhost 9093 验证部署是否成功

3、在k8s集群中部署kube-state-metrics和promtheus(要求客户的镜像仓库中已有kube-state-metricsd:v2.5.0和prometheus:2.38.0镜像)

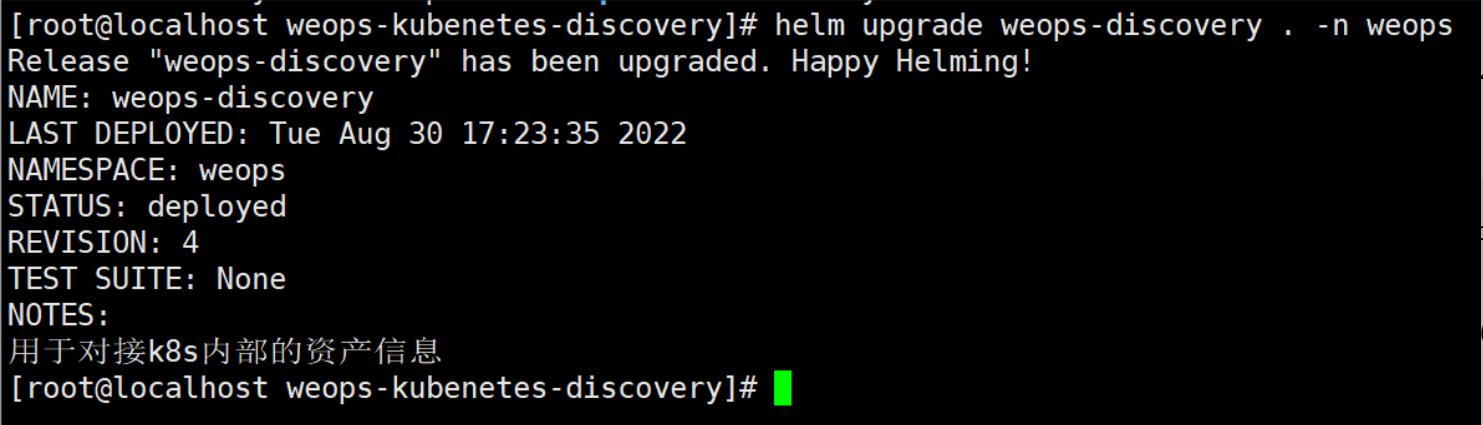

在k8s的control-plane上解压helm chart并部署,具体操作步骤可以查看gihub具体解释和操作步骤:https://github.com/WeOps-Lab/WeOps-Charts/

正常应输出(REVISION: 1):

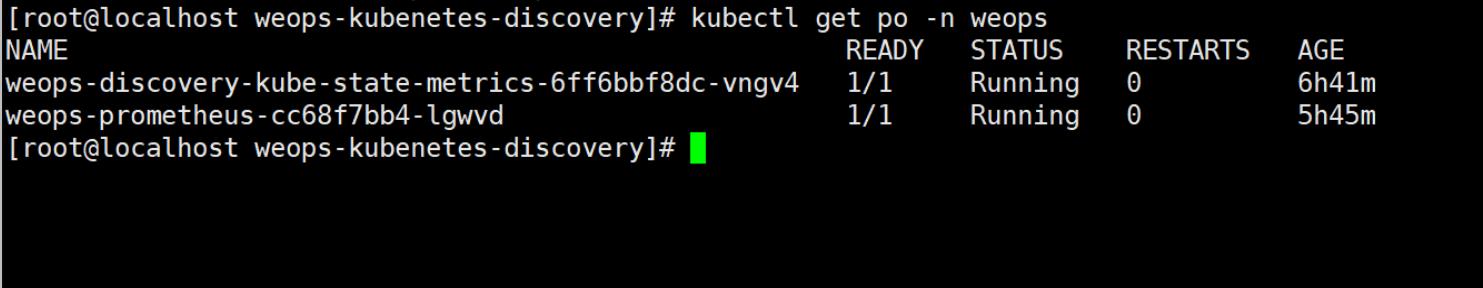

检查pod状态:

kubectl get po -n weops

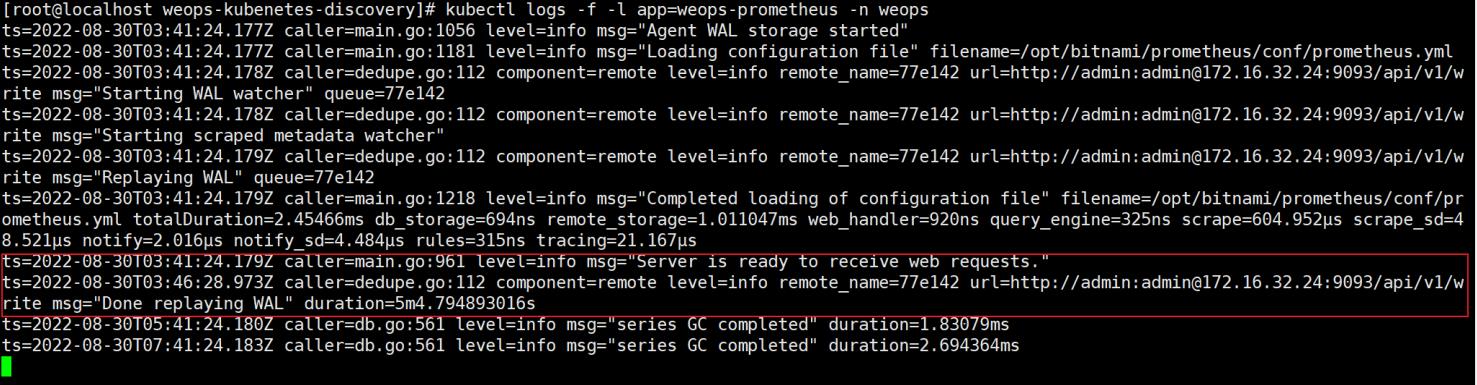

检查prometheus-agent状态:

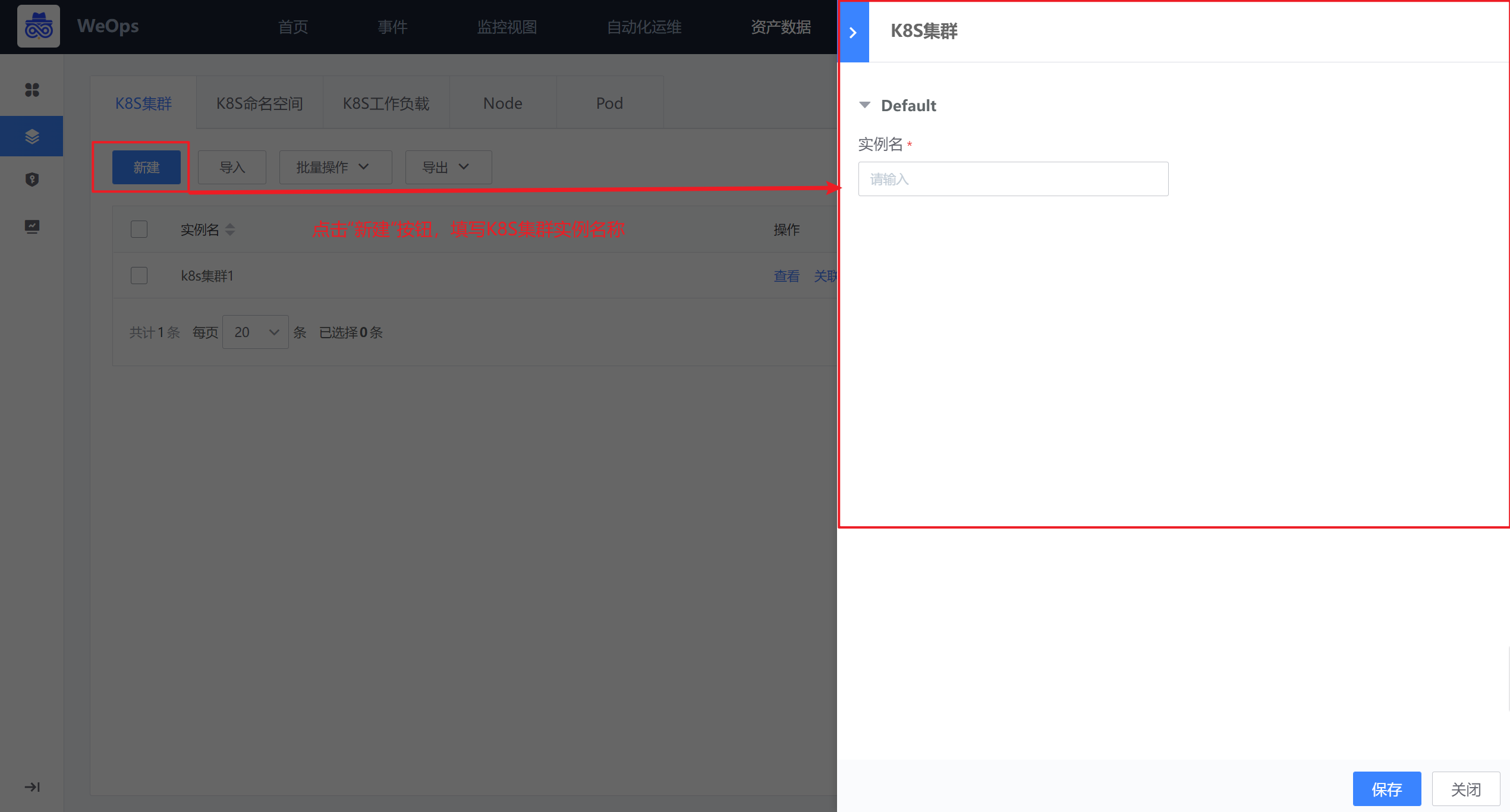

Step2:创建K8S集群实例

路径:资源-资源记录-K8S(K8S集群)

如下图,在K8S集群页面中点击“新建”按钮,进行K8S集群实例的创建

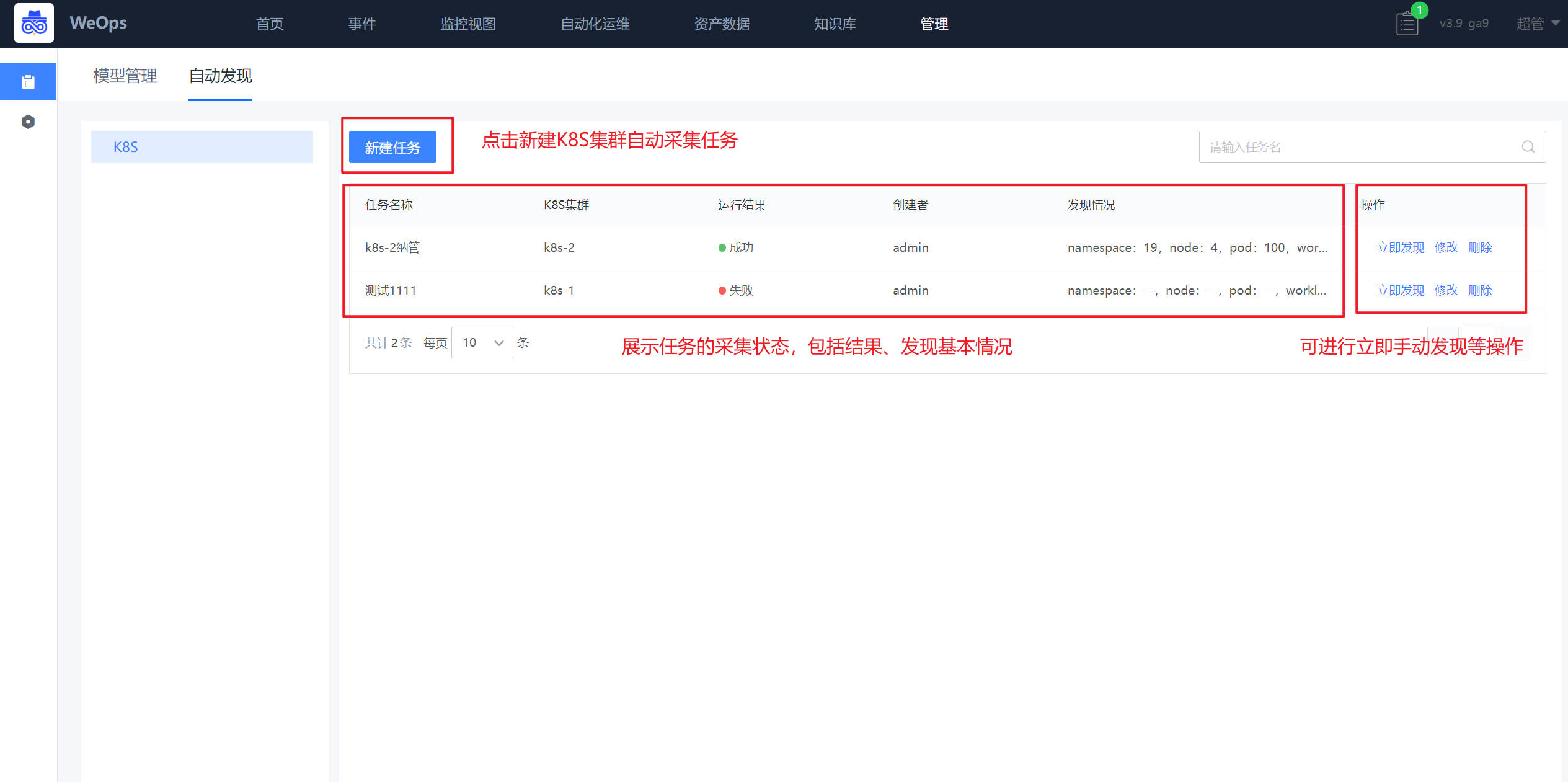

Step3:创建K8S集群自动发现

路径:管理-资产管理-自动发现

如下图,在自动页面中点击“新建”按钮,进行K8S集群自动发现的任务的创建,创建时仅需要填写任务名称、选择需要采集K8S集群实例名称、设置采集频率即可。

任务创建完成后,可根据设置的采集频率进行采集,也可点击“立即发现”

Step4:自动发现相关信息

路径:资源-资源记录-K8S(K8S命名空间、K8S工作负载、Pod、Node)

设置自动发现任务后,自动发现该K8S集群下的命名空间、工作负载、Pod、Node相关实例信息,及其关联关系

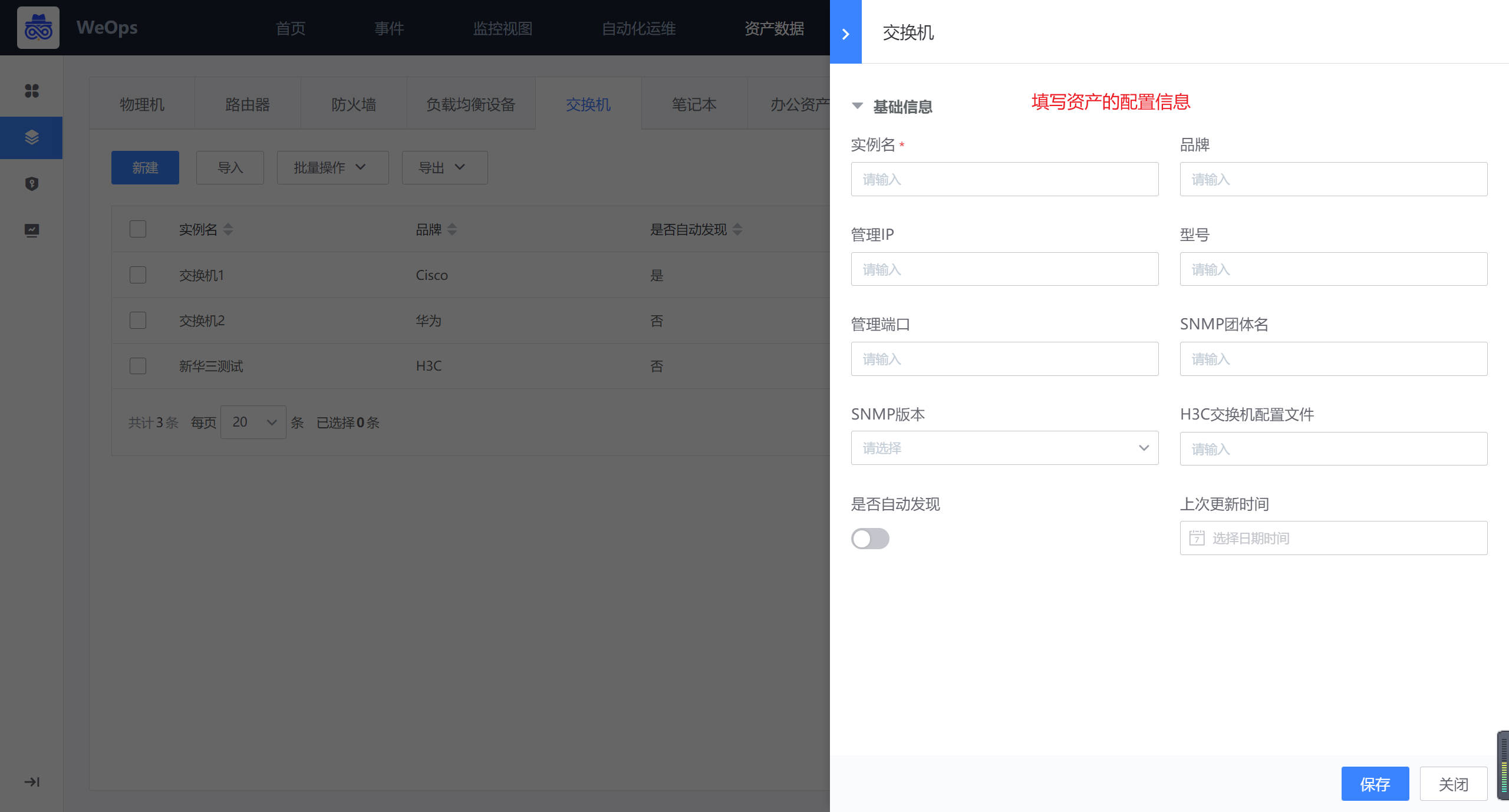

网络设备纳管

背景介绍:运维部门需要对网络设备(交换机/路由器/负载均衡/防火墙)进行资产管理,并展示其直接的关联关系,可以在WeOps的资产数据进行管理,第一步需要进行网络设备的纳管,有两种方式进行:一是手动纳管,手动维护资产信息和关联关系,二是自动发现,自动发现资产信息、关联关系,并自动更新。这里以交换机为例进行介绍。

方法一:手动纳管

路径:资源-资源记录-基础设备(交换机)

在交换机的页面,点击“新建”按钮,进行资产的新建,填写必要的信息,包括品牌/型号等等,手动创建的资产需要手动维护/更新配置信息。

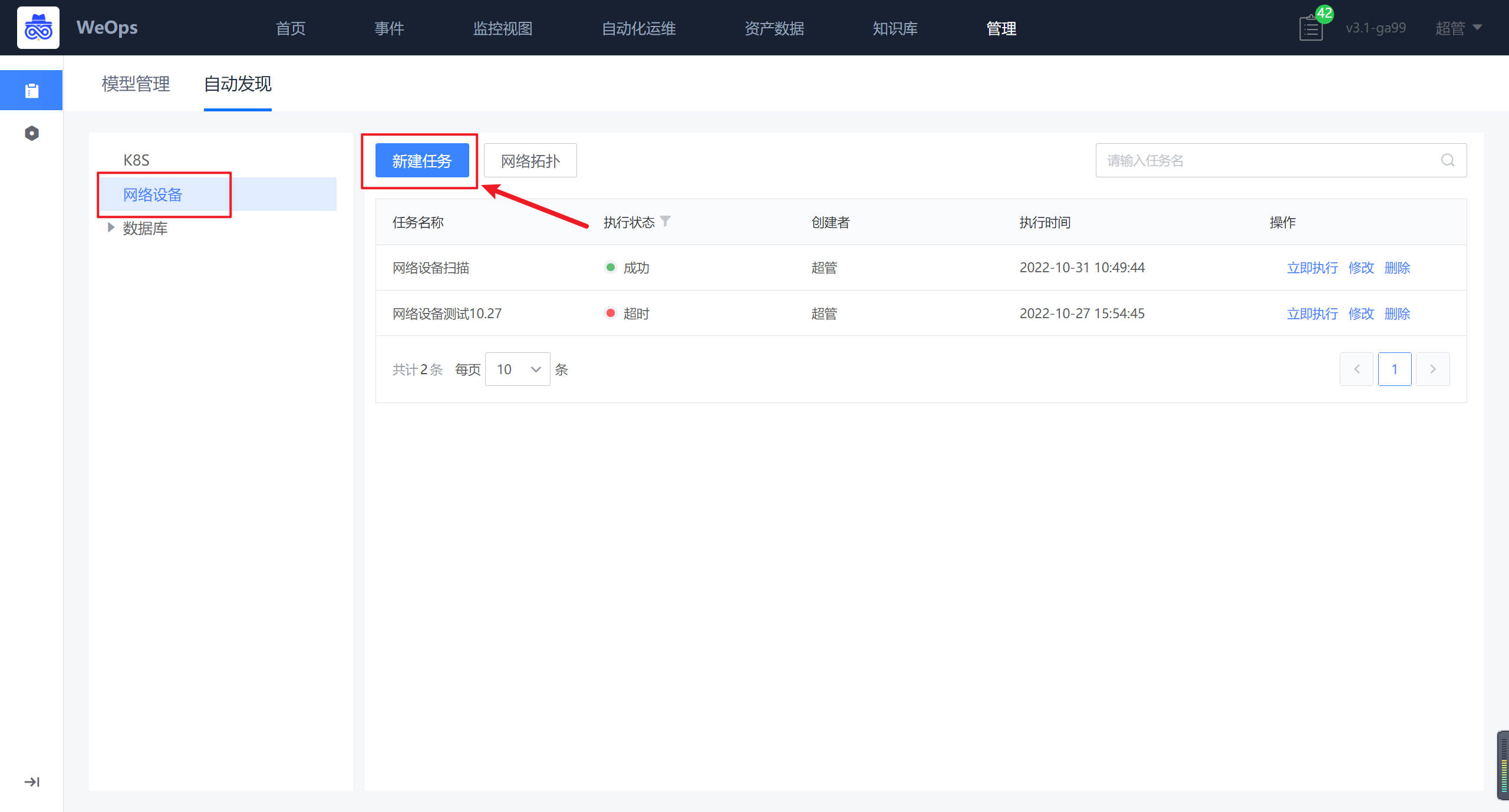

方法二:自动发现

路径:管理-资产管理-自动发现(网络设备)

在自动发现页面,选择网络设备,进行网络设备的自动发现任务的创建。

任务创建完成后,任务将会按照填写的信息和时间进行执行,执行完后,若有未识别到的OID,建议点击按照提示添加到OID库,以便后续可以直接自动发现和采集相关的信息。

【特殊说明如下】

在网络设备自动发现过程中,只有网络设备的品牌和型号在OID库的,才能自动发现和采集到相关的信息。如果需要拓展自动发现的范围有两种方式

(1)在管理-资产管理-OID库手动添加需要自动发现的网络设备的品牌型号的OID,添加完成后,自动发现即可发现相关信息。

(2)创建自动发现任务后,经过一次扫描,若有未识别到的OID,根据提示,在OID库中添加,添加完成后,自动发现即可发现相关信息自动发现完成以后,自动采集到的网络设备已经对应的品牌、型号会自动更新到“资产数据-资产记录-交换机“里面

网络拓扑,对于自动发现的网络设备,展示了各个设备的拓扑图,可以通过自动关联/手动关联的方式,完善网络设备的拓扑图。

- 注:只有符合内置OID库的网络设备品牌和型号的设备才可以被自动发现,若需要拓展OID库,如下图,可进行不同品牌型号的网络设备的OID新增,新增完成后,可进行自动发现和采集。

配置文件纳管(以主机配置文件为例)

背景介绍:运维部门需要对资源的配置文件进行资产管理,方便查看和使用,目前WeOps已经内置好“配置文件”的模型,已经与各个资产模型相关联,支持对各个资源的配置文件上传和管理,另外WeOps支持对主机类/网络设备类的配置文件自动发现和更新。

Step1:前提条件,确认关联

路径:管理-资产管理-模型管理

如下图,以主机为例,在资产管理-模型管理中,点击“配置文件”模型的按钮,在“关联”中,检查关联情况

Step2:配置文件创建

路径:资源-资产记录-主机

当资源模型的关联配置完成以后,就可以在主机的详情页看到配置文件的tab,如下图,在主机列表中,点击“查看”按钮

如下图,可以进行配置文件的创建,选择对应的维护人,每个配置文件点击详情后,可以查看这个配置文件的具体内容

- 关于文件的上传有两种方式,对于主机/网络设备类的资产,已经支持自动采集的能力,可以创建配置文件的自动采集任务进行文件的采集和版本的更新;对于其他资产的配置文件来说,需要进行手动的上传和版本的维护。

Step3:配置文件自动采集

路径:管理-资源管理-自动发现

- 对于主机/网络设备来说,配置文件支持自动发现和自动采集,所以在自动发现页面,选择配置文件进行配置文件自动采集任务的创建,这里以主机为例进行介绍

- 任务执行后,可以在“资源-资产记录-主机-配置文件”中,查看这个主机的这个配置文件的采集信息

Step3:配置文件手动维护

路径:资源-资产记录-主机

- 对不同版本的配置文件进行手动上传文件,修改/删除等操作,也可以支持预览

Step4:配置文件使用

- 针对不同版本的文件,支持选择两个版本的文件进行对比,并标出差别之处

- 针对变更记录,可查看每个配置文件的变更情况,以及变更前后的对比。

SSL证书纳管

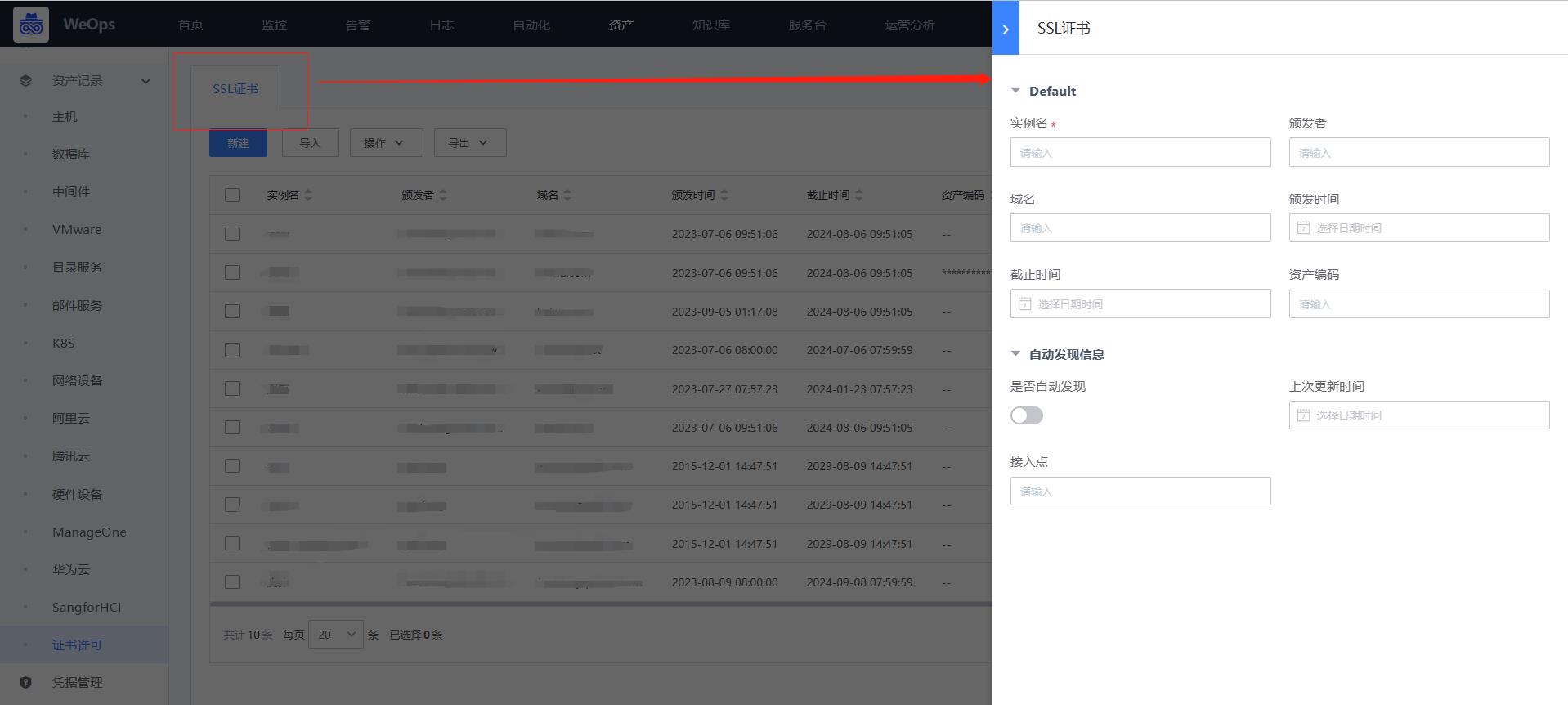

背景介绍:运维部门关于多个域名,对于域名的证书相关信息的管理也尤为重要,尤其是证书的到期时间,WeOps提供SSL证书自动发现和采集能力,支持定期采集/更新证书的信息,结合事件到期提醒功能,即将到期的证书发送提醒。

Step1:创建证书实例

路径:资源-资产记录-证书

- 如下图,在资产记录中创建一个SSL证书的实例,以便后续自动发现使用。

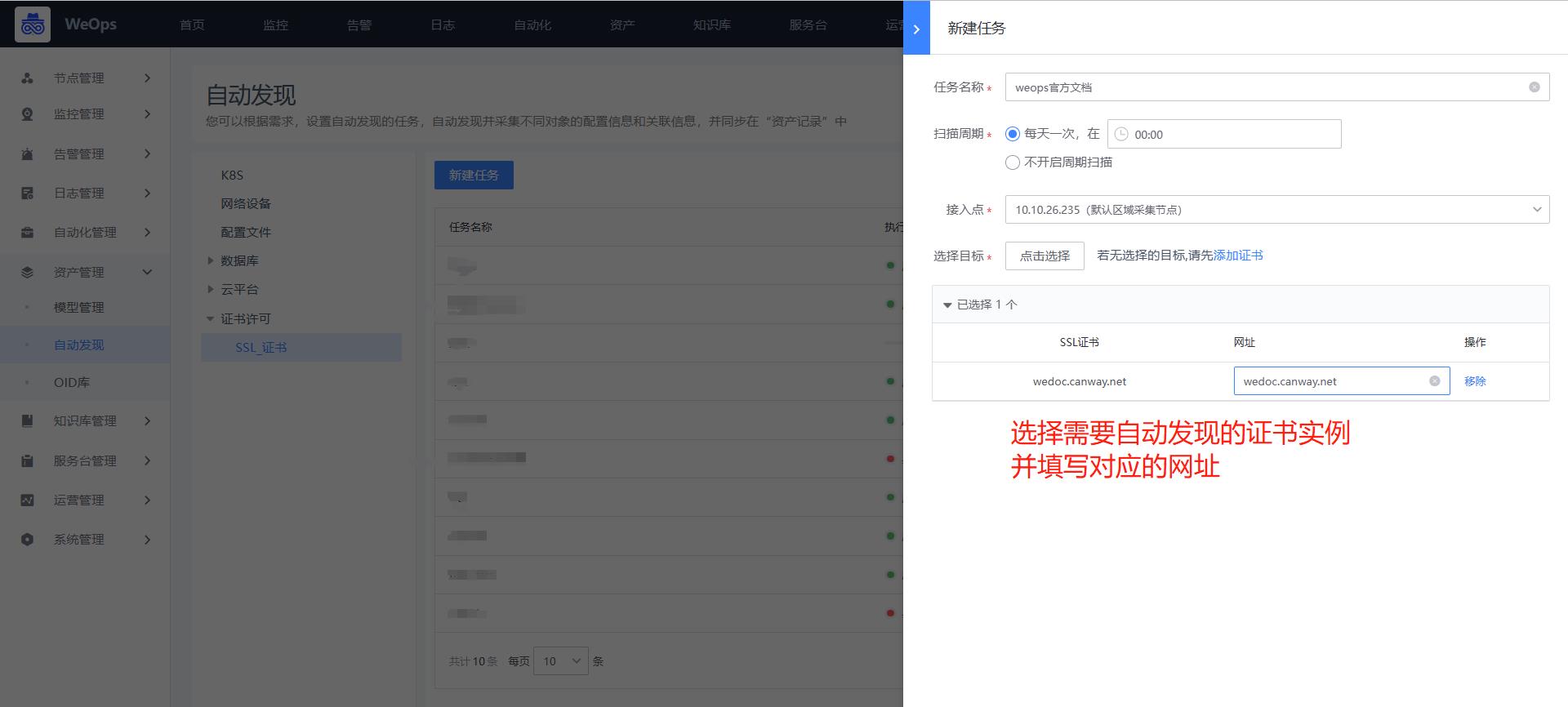

Step2:创建证书自动发现

路径:管理-资产管理-自动发现

- 如下图,选择自动发现-SSL证书,选择刚才创建的正式实例,并为这个证书填写域名,比如“wedoc.canway.net”,填写完成,选择对应的扫描周期,即可按照周期进行扫描。当证书更新后,也会根据最新的扫描情况,进行更新相关信息。

Step3:证书自动发现/更新

路径:资源-资产记录-证书

*任务执行完成后,在资产记录的列表,可以看到采集的证书信息,包括“颁发者”、“域名”、“颁发时间”、“截止日期”等信息。

Step4:到期提醒

路径:资源-事件订阅

- 当证书自动发现和采集创建完成之后,可以针对需求,对证书的到期时间进行订阅,在“事件订阅”中创建任务,选择证书的“截止日期”字段,创建扫描和提醒的时间,配置完后,会安装配置的提醒时间,发送邮件提醒。

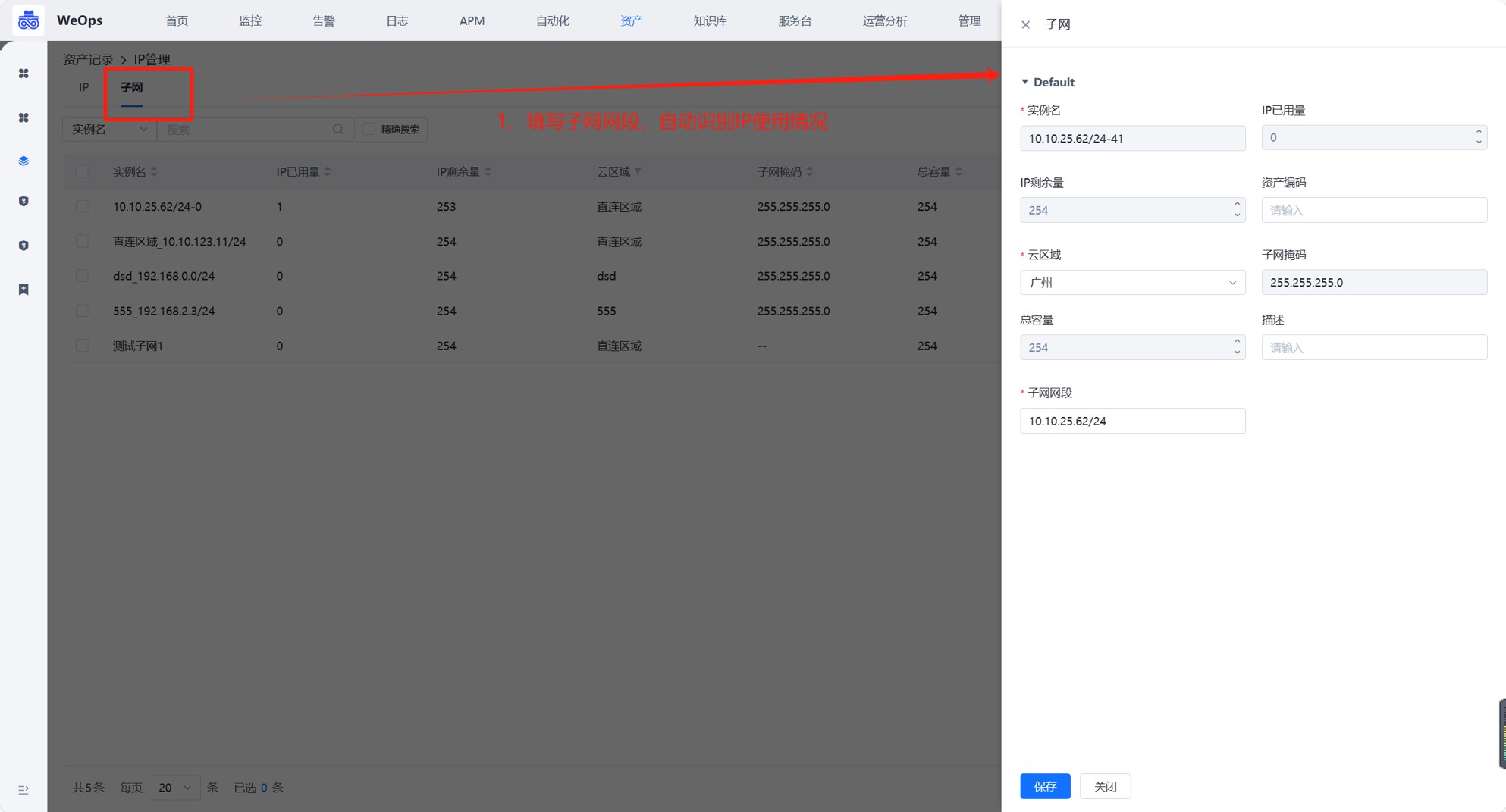

IP发现

背景介绍:适用于以下场景

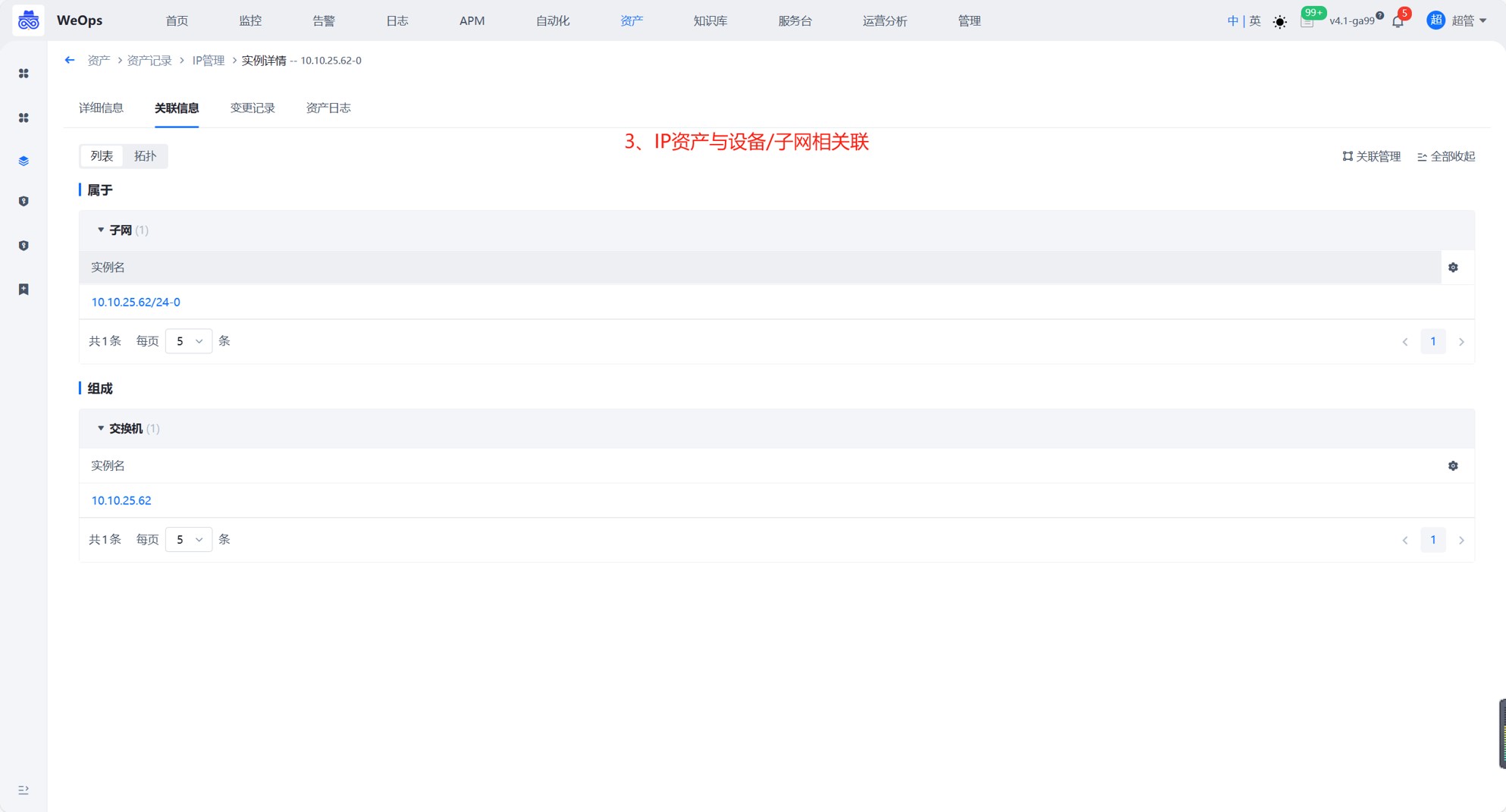

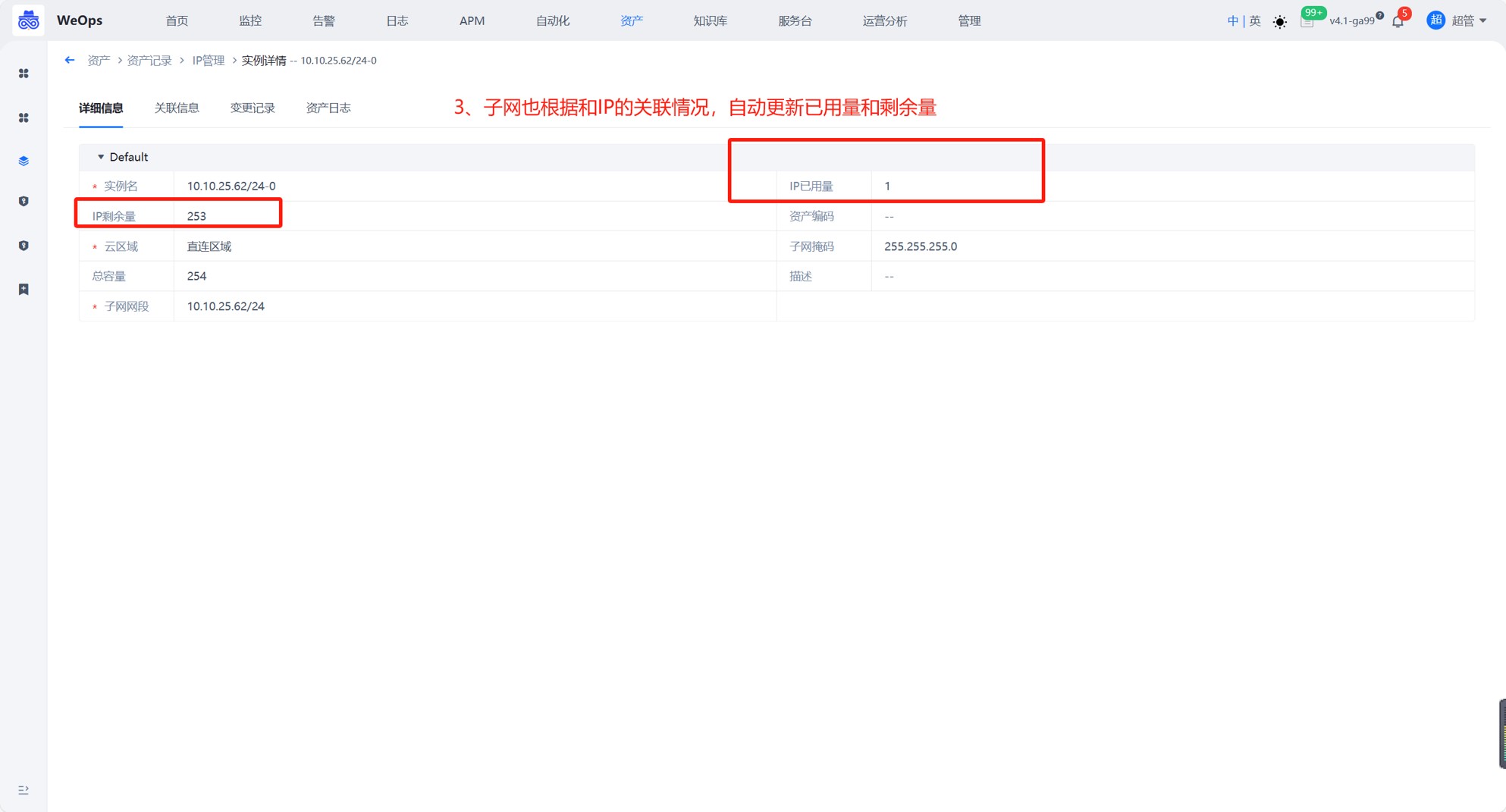

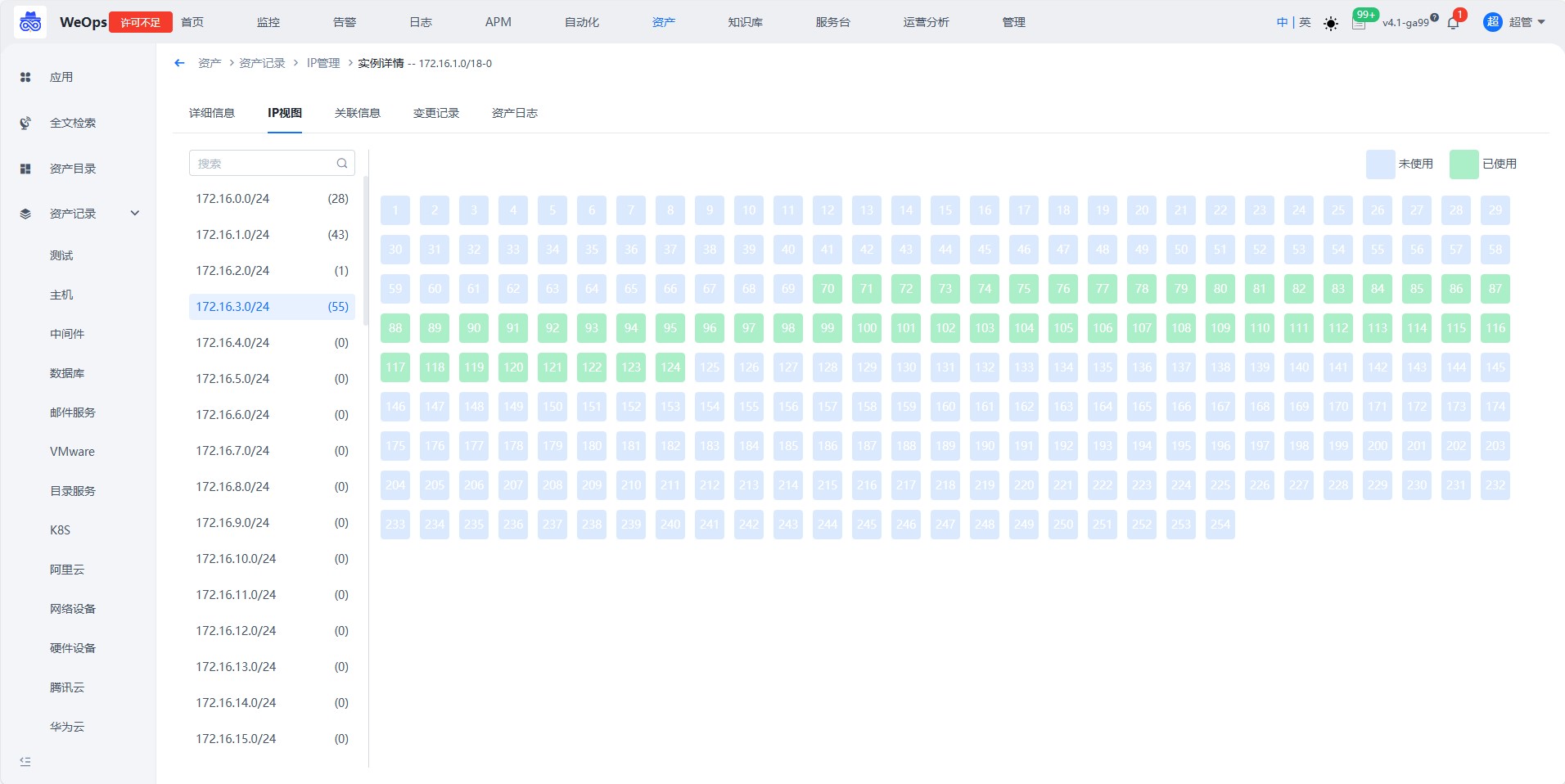

1、查看资产IP:自动发现的IP和资产关联,可以查看资产使用的IP情况 2、判断IP是否空闲:查看IP列表,确定IP是否被使用 3、查看子网IP的使用情况:通过子网的关联情况和剩余量等数据,查看子网使用情况

step1:手动录入子网

路径:资产-资产记录-IP管理-子网

录入子网的网段,比如192.168.0.0/24,录入后:自动识别子网总容量、自动识别子网掩码

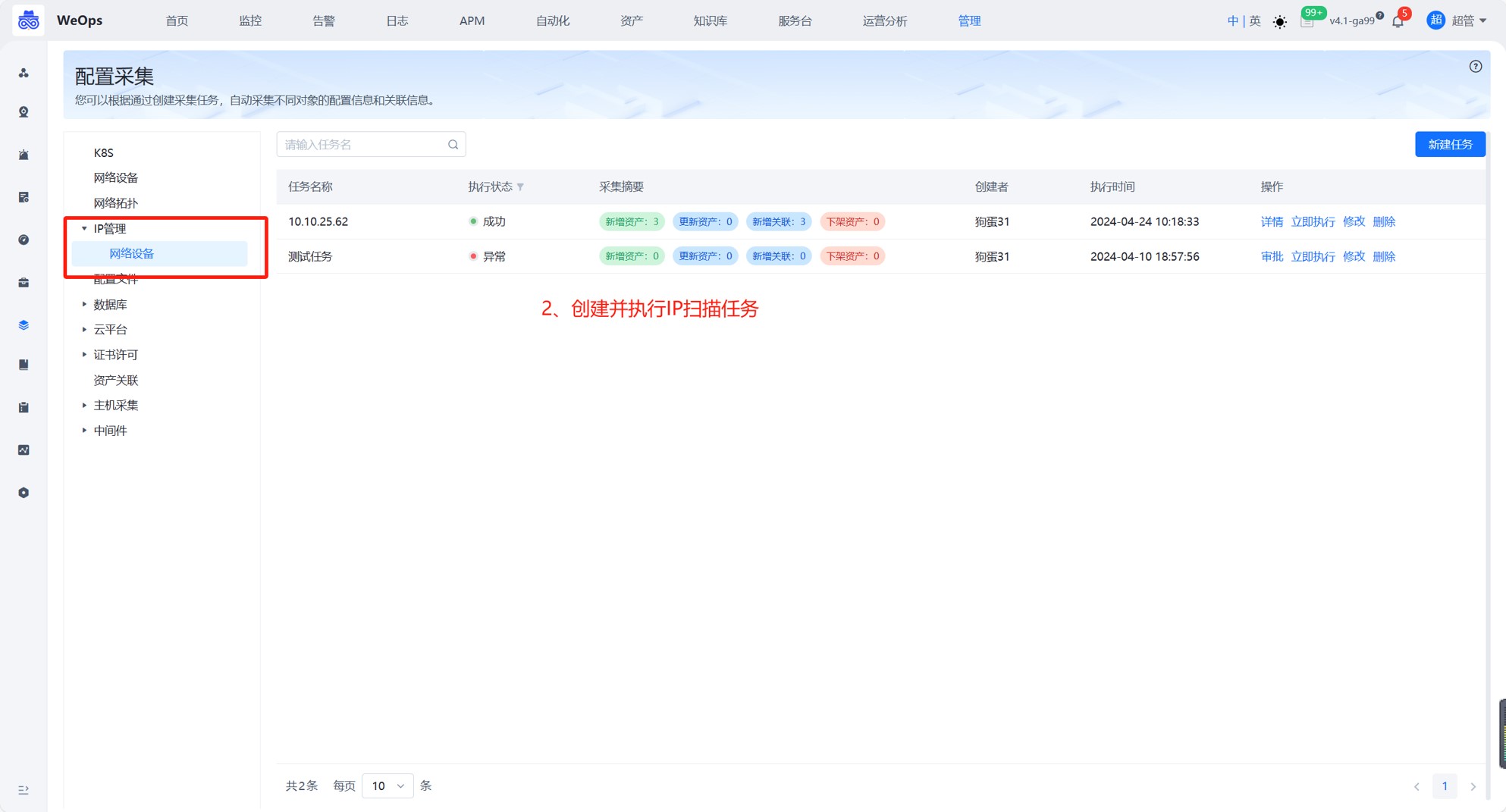

step2:创建IP自动扫描任务

路径:管理-资产管理-配置采集-IP

选择对象类型(目前支持网络设备的),选配扫描周期,选配凭据等信息

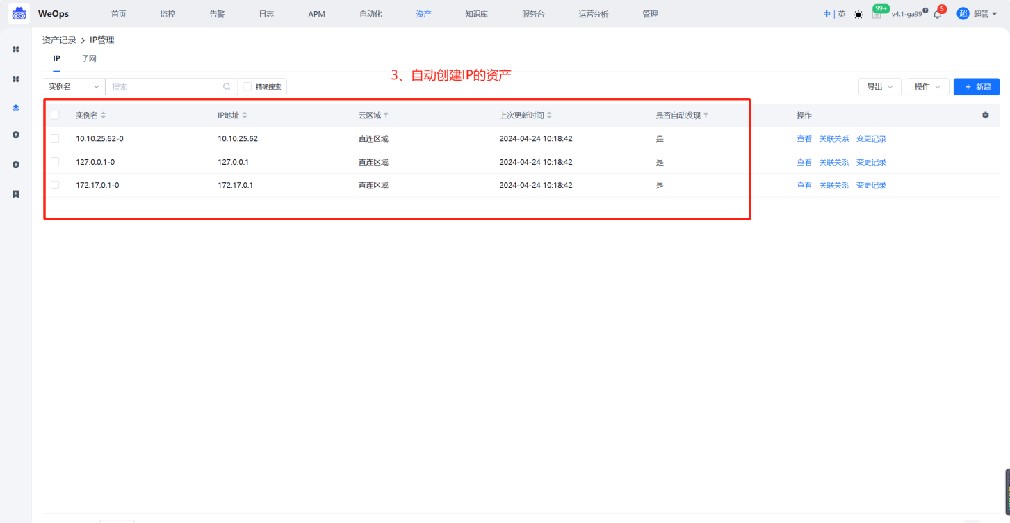

step2:效果查看

路径:资产-资产记录-IP管理-子网/IP

1、自动录入IP信息和关联关系

2、子网根据关联的IP地址情况,自动更新余量信息

3、根据子网和IP的关联信息,自动生成IP视图,展示该子网下所有IP地址的使用情况

资产扫描

背景介绍:资产扫描一般有以下几种应用场景:一、纳管层面:资产扫描是从空白到扫描出来有资产的,然后进行配置发现,自动更新配置的;二、安全层面,比如护网全量扫描不在cmdb的资产,扫出来异常的ip进行重点关注;三、运营层面,扫描ip不在管理范围内的,进行ip认领或者回收

- 目前WeOps资产扫描支持的协议有telnet和ICMP ping。

- ICMP Ping扫描:ICMP是Internet控制报文协议,其中的Ping命令可以用于检测目标主机的可达性。Ping扫描程序会向目标主机发送ICMP Echo Request包,如果目标主机响应了ICMP Echo Reply包,就表示目标主机是可达的。

- Telnet是一种远程登录服务,在扫描中常用于探测目标主机的开放端口。扫描程序会发送一个特定的Telnet请求到目标主机的目标端口,如果返回的响应表明该端口是开放的,就表示目标主机上运行着相应的服务

step1:设置好识别规则

路径:管理-资产管理-资产扫描

telnet协议需要扫描特定的端口,需要提前定义好端口和资产类型之间的关系,便于根据开放的端口识别资产类型。如下图,weops根据数据库和中间件默认的端口内置了一条规则,支持调整。

step2:创建扫描任务

路径:管理-资产管理-资产扫描

扫描任务,如下图,支持资产扫描任务的创建,可设置IP扫范围,支持ping(IP)、telnet(IP+端口)从网络中发现IT资产,支持配置CMDB的对比范围,进行对比。安装扫描的协议扫描出来的资产,会根据cmdb的资产范围进行对比,未纳管的资产,会呈现在“未纳管”列表中。

- 未纳管资产,扫描的结果中,和cmdb对比后,cmdb没有纳管的资产会呈现在列表中,并按照识别规则展示资产的类型,对于未纳管的资产,支持一键纳管至cmdb中

机房视图

背景介绍

为了直观的展示机柜内设备的布局和状态,新增机房视图,用于各类IT设备的集中管理和展示。

step1:资产设置

路径:资产-资产记录-数据中心

在资产记录中已经内置常用资产模型“数据中心-机房-机柜-设备(网络设备/硬件设备等)”,需要在资产记录的对应位置创建资产实例、填写位置信息并创建关联,步骤如下

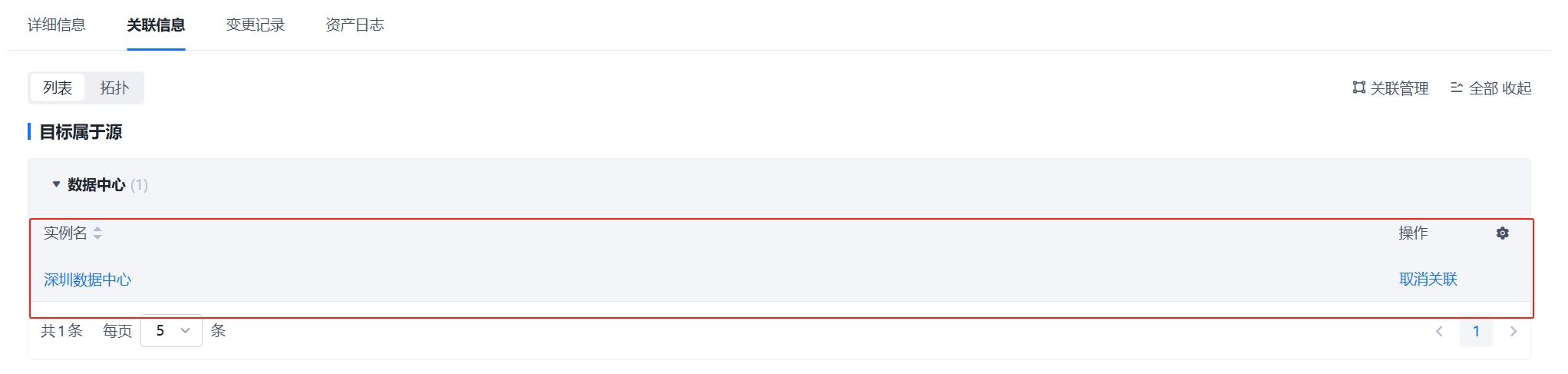

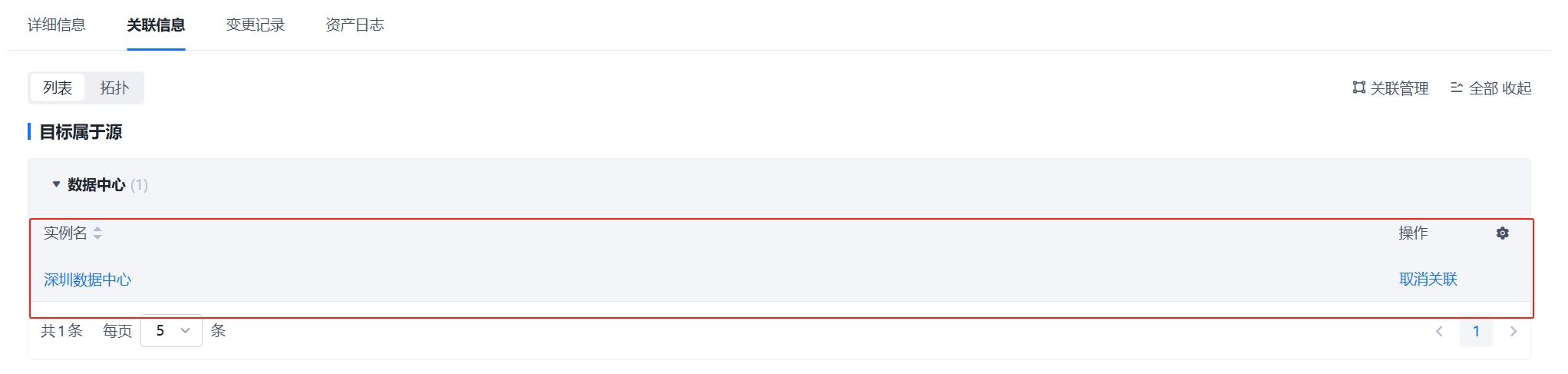

①:创建数据中心实例并填写信息。比如“深圳数据中心”

②:创建机房实例,并且关联到数据中心。比如创建“2号机房”,并且创建它与“深圳数据中心”的关联

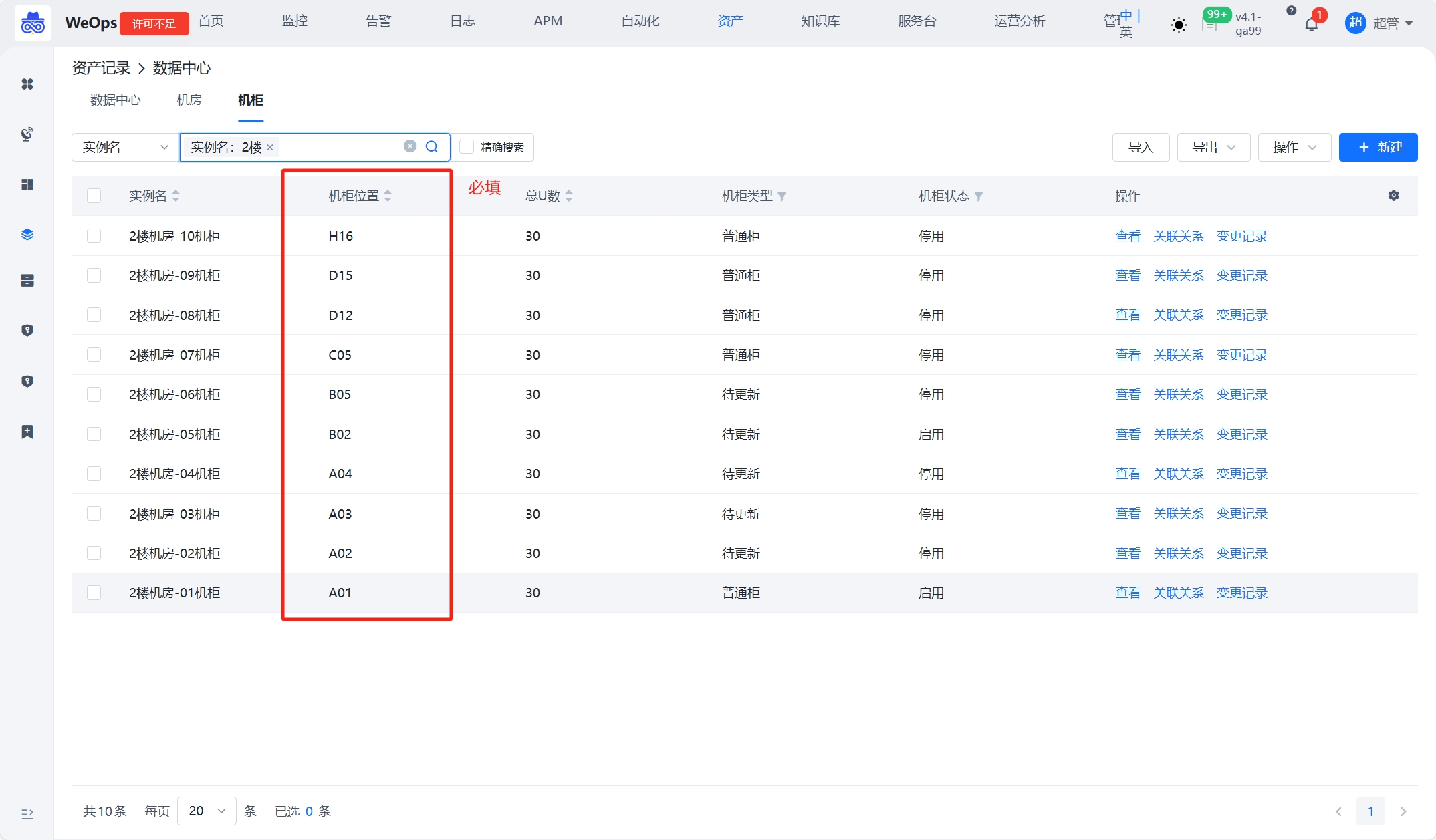

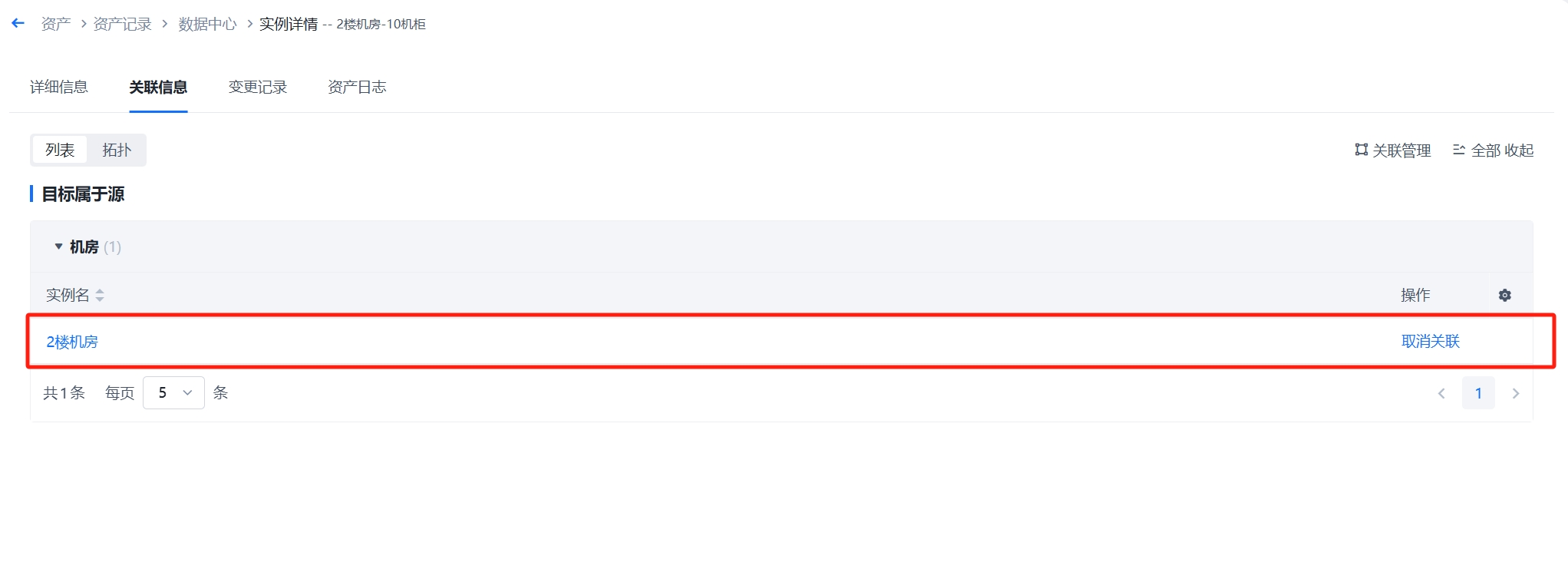

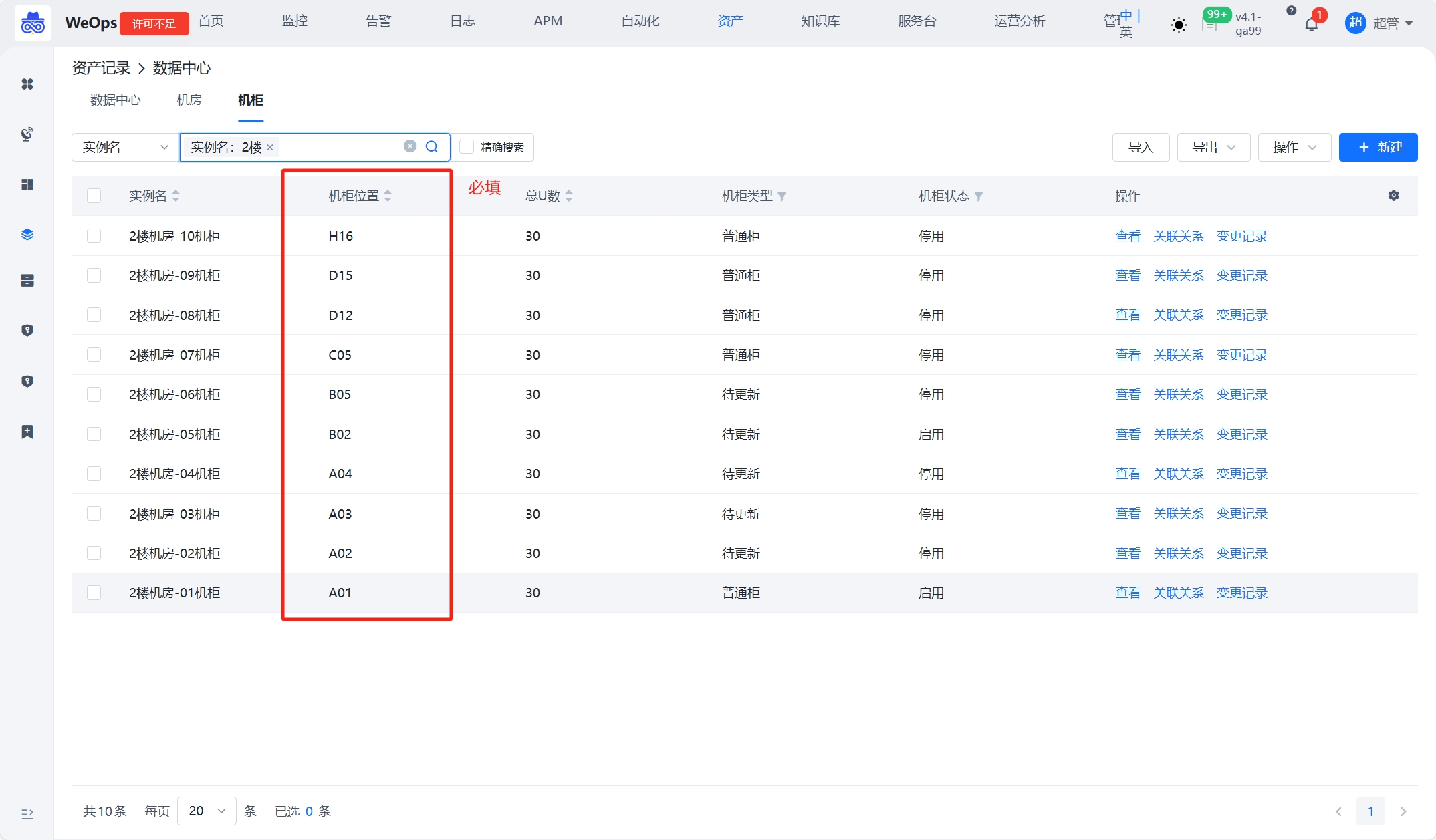

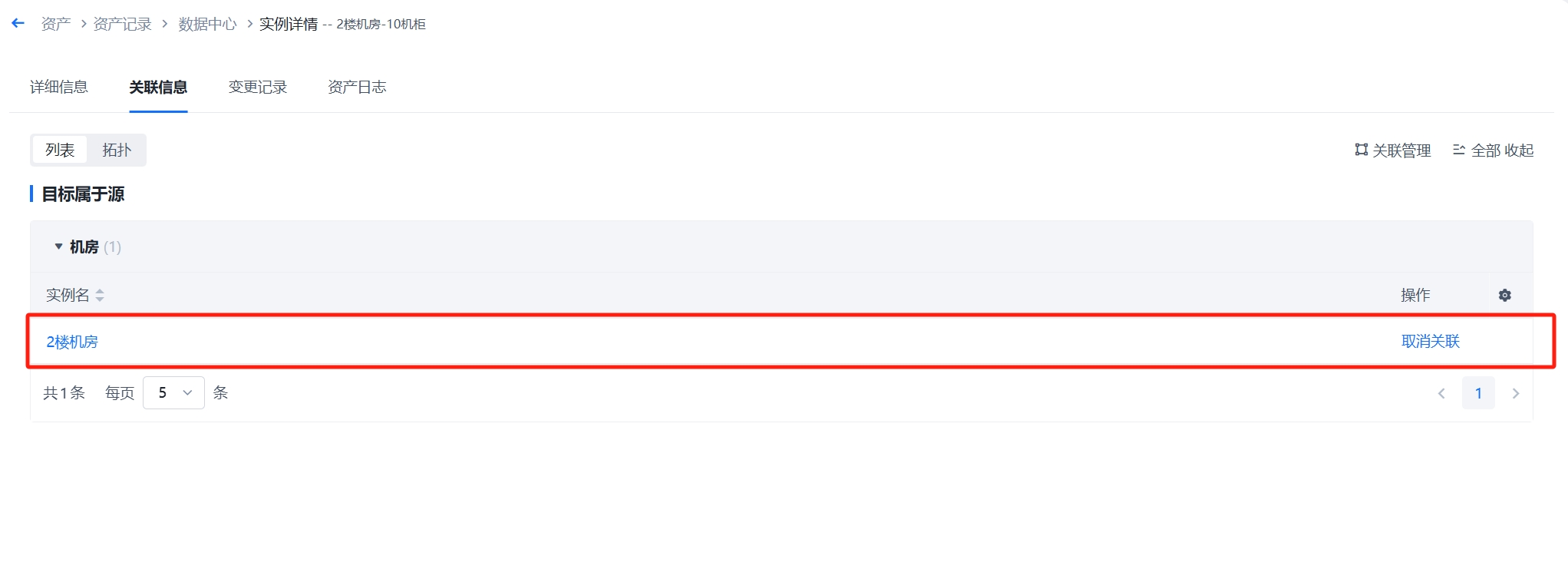

③:创建机柜实例,必须填写“机柜位置”字段,并且创建机柜与机房的关联关系。比如2楼机房放置了10个机柜,需要填写机柜的基本信息,必填“机柜位置”(机柜位置的填写标准格式为“A01”、“B11”等),创建机柜与机房的关联。通过机柜的位置和关联关系,可在机房视图中渲染出位置。

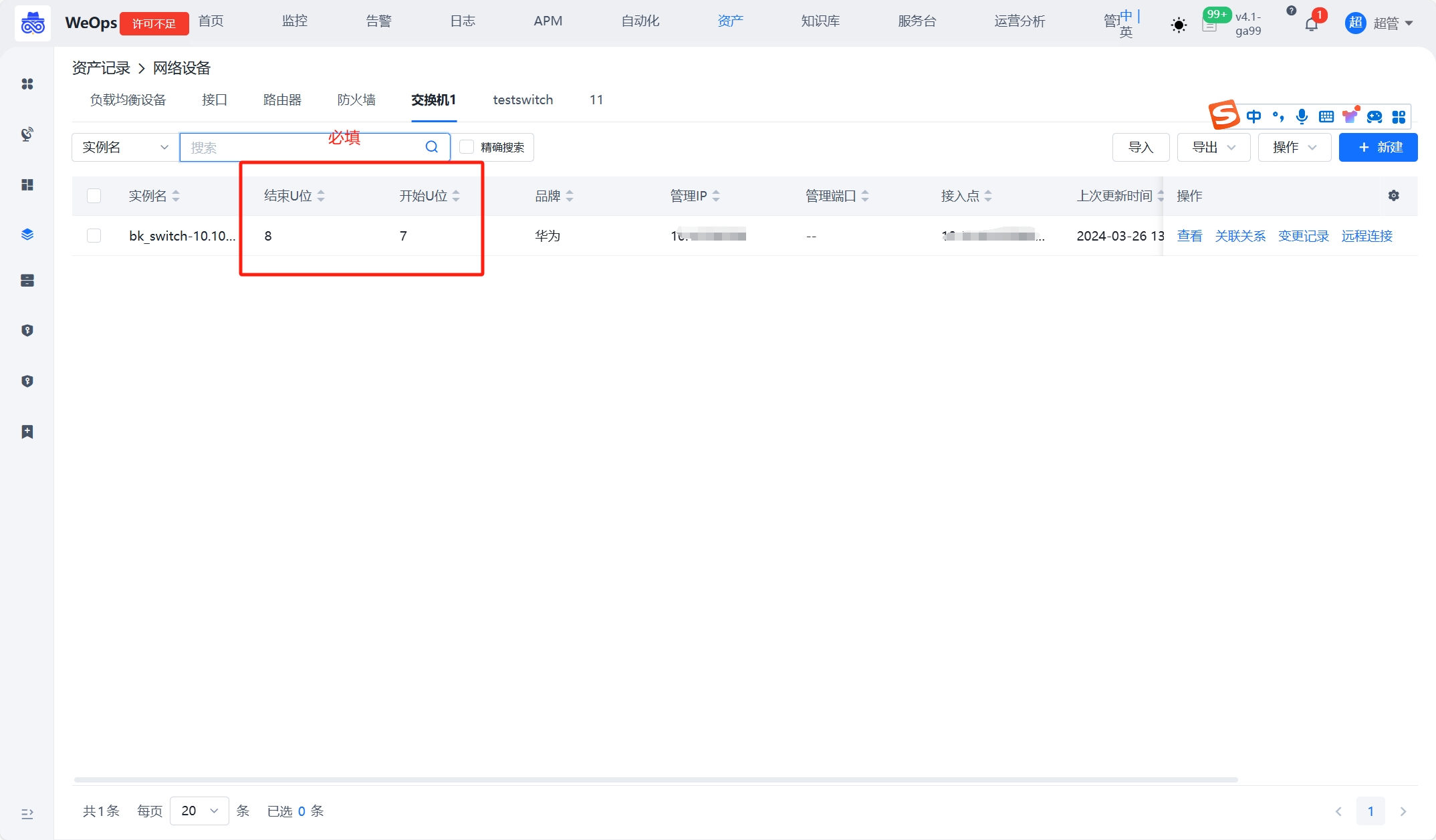

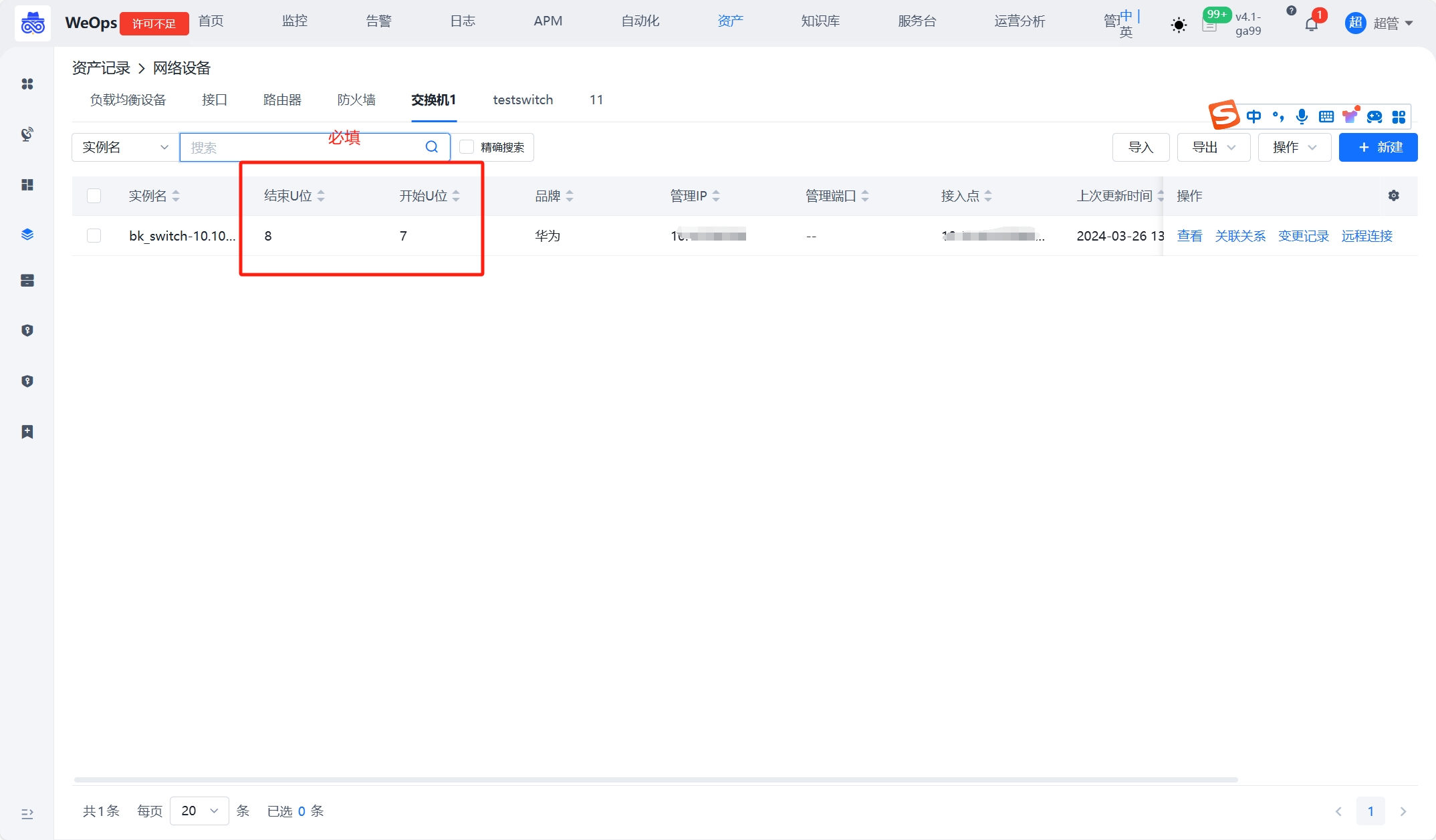

④:创建设备实例,支持“网络设备”和“硬件设备”分组下的实例,放置在对应机柜中,设备需要填写开始U位和结束U位,并创建与机柜的关联,可以渲染出机柜视图。

step2:查看视图

路径:资产-机房视图

根据“机房-机柜”关联和填写机柜的位置,在视图中按照机柜的位置和类型展示。

根据“机柜-设备”关联和设备的开始U位和结束U位,在机柜视图中展示设备的位置和信息

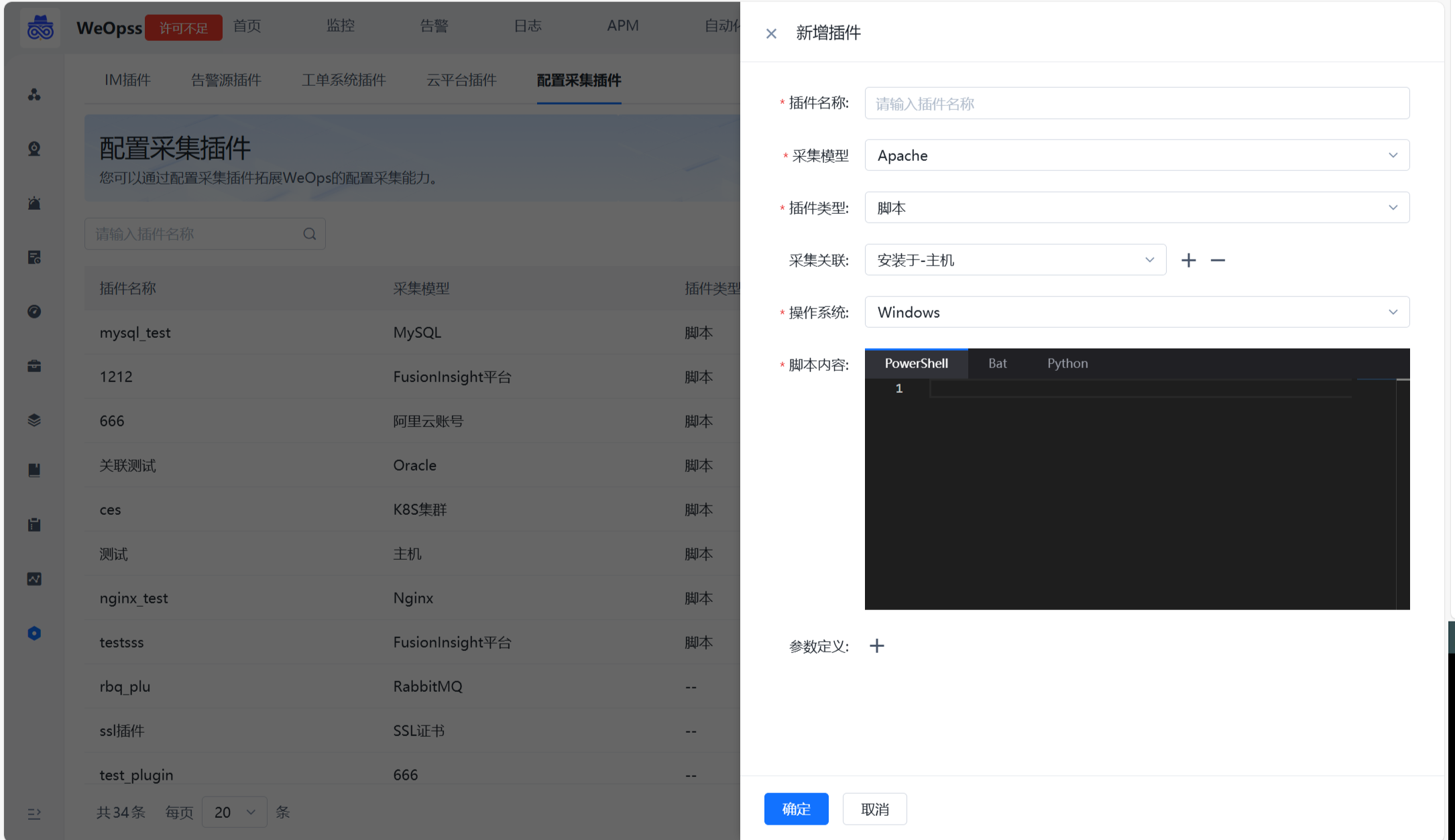

自动发现插件拓展

背景介绍

企业通常使用各种不同类型的技术和工具,涉及到中间件、数据库等多种资产。手动收集这些配置信息不仅费时费力,而且容易出错。因此,引入了自动发现和采集资产配置信息的功能,针对不同的对象,可以通过撰写脚本插件的方式拓展自动发现的支持的模型

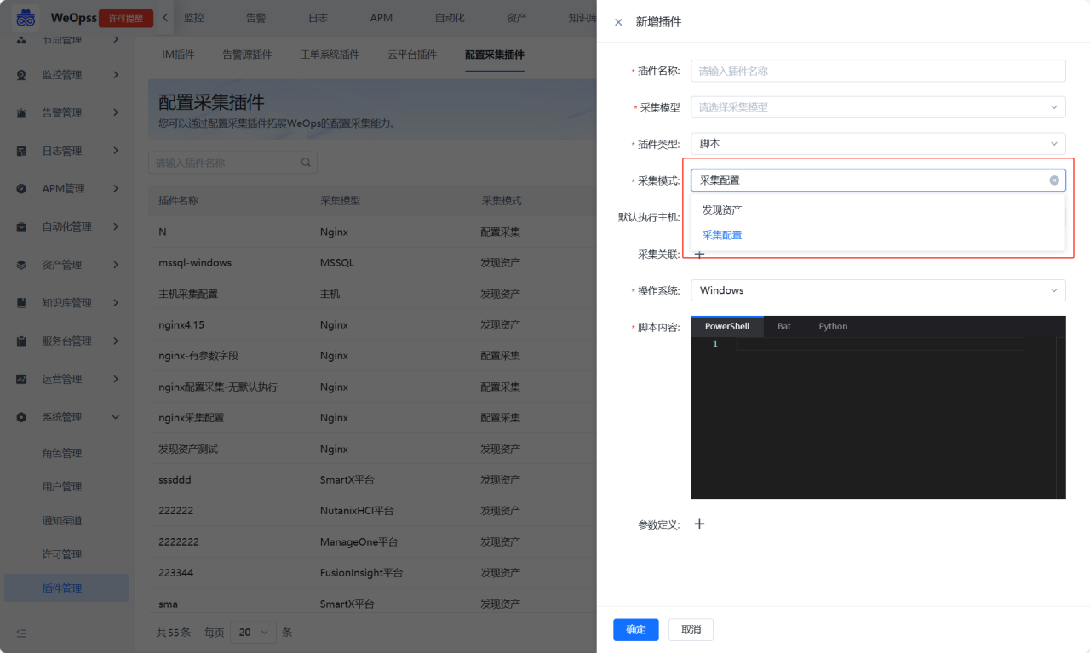

自动发现插件

step1:创建插件

路径:管理-系统管理-插件管理

针对不同的对象,可以通过撰写脚本插件的方式拓展自动发现的支持的模型,自动发现主要用于发现未纳管的资产以及资产少数的配置信息,并自动更新至CMDB中。

新建插件需要填写的信息如下

插件名称:自定义,便于识别

采集模型:选择需要采集的模型,可以自动发现该资产的相关信息

插件类型:目前只支持“脚本”类

采集关联:采集到的该资产的关联关系,脚本执行完后,可以自动创建关联

操作系统:支持Windows和linux两类,以及对应的脚本撰写的语言

脚本内容:定义脚本执行的参数、脚本采集的内容、输出格式等信息,详见下方详细介绍

参数定义:在脚本执行过程中需要输入的参数,采用位置参数的形式,$1、$2确定位置采集脚本的编写内容主要包括:

1、脚本参数:脚本支持定义位置参数,如shell脚本通过$1、$2定义。在脚本内容中的定义的参数需同时在“参数定义”中定义好,以便创建采集任务时填写和传入参数.

2、脚本采集内容:采集信息需要执行的命令.

3、脚本输出格式:为了在CMDB中存储,需要对输出的格式进行规范化,以便WeOps识别和存储。输出格式的定义可查看如下示例,其中 bk_inst_name、bk_obj_id是必填项,bk_inst_name作为示例的唯一值,通过实例名,将输出的字段信息更新到CMDB中, bk_obj_id则是该采集对象的资产模型ID。

4、关联关系:如果该资产模型是与主机相关联,直接在页面上填充字段“采集关联”即可,脚本中不必特殊定义。执行脚本后,可以自动采集并关联对应的主机。

Shell示例

以Shell脚本为例,发现Apache的实例和对应信息,定义输出格式的示例如下:

#!/bin/bash

bk_host_innerip={{bk_host_innerip}}

...

# =============can extend key=================

json_template='{ "bk_inst_name": "%s-apache-%s", "bk_obj_id": "apache", "ip_addr": "%s", "listen_port": "%s", "httpd_path": "%s", "version": "%s", "doc_root": "%s" }'

json_string=$(printf "$json_template" "$bk_host_innerip" "$port_str" "$bk_host_innerip" "$port_str" "$exe_path" "$apache_version" "$document_root")

echo "$json_string"

...json_template='{ "bk_inst_name": "%s-apache-%s", "bk_obj_id": "apache", "ip_addr": "%s", "listen_port": "%s", "httpd_path": "%s", "version": "%s", "doc_root": "%s" }'···定义了一个JSON模板字符串,其中的占位符(例如%s)将被具体的变量值替换。该模板包含以下字段: ●bk_inst_name: 实例名称,格式为 “主机内网IP-apache-端口号”,必填,可自行用采集字段拼接 ●bk_obj_id: 固定值 “apache”,必填,根据采集的模型定义 ●ip_addr: 主机内网IP,根据发现字段自定义 ●listen_port: 监听端口,根据发现字段自定义 ●httpd_path: Apache可执行文件路径,根据发现字段自定义 ●version: Apache版本,根据发现字段自定义 ●doc_root: 文档根目录,根据发现字段自定义

json_string=$(printf "$json_template" "$bk_host_innerip" "$port_str" "$bk_host_innerip" "$port_str" "$exe_path" "$apache_version" "$document_root")使用printf命令将模板字符串中的占位符替换为实际的变量值,具体替换如下: ● “$bk_host_innerip”: 主机内网IP。 ●”$port_str”: 端口号。 ●”$exe_path”: Apache可执行文件路径。 ●”$apache_version”: Apache版本。 ●”$document_root”: 文档根目录。 最终生成一个完整的JSON字符串,并将其赋值给json_string变量。

echo "$json_string"输出生成的JSON字符串。

PowerShell示例

以PowerShell脚本为例,发现Apache的实例和对应信息,定义输出格式的示例如下:

...

foreach ( $httpd_instance in $httpd_instance_list){

...

$output = @{

"version" = $httpd_version.trim()

"listen_port" = $httpd_port

"ip_addr" = "{{bk_host_innerip}}"

"documentroot" = $httpd_DocRoot

"httpd_root" = $httpd_root

"errorlog" = $error_log

"customlog" = $custom_Log

"include" = $httpd_include

"httpd_conf_path" = $httpd_confile

"httpd_path" = $httpd_path

"bk_inst_name" = "apache-{{bk_host_innerip}}-$httpd_port"

"bk_obj_id" = "apache"

}

$outputJson = ConvertTo-Json $output

Write-Output $outputJson

}

...$output = @{ ... }定义了一个哈希表$output,其中包含多个键值对,每个键值对对应Apache服务的一个配置信息字段。 ●”version” = $httpd_version.trim(): Apache版本,去除空白字符后存储。 ●”listen_port” = $httpd_port: 监听端口。 ●”ip_addr” = “{{bk_host_innerip}}”: 主机内网IP,使用占位符表示。 ●”documentroot” = $httpd_DocRoot: 文档根目录。 ●”httpd_root” = $httpd_root: Apache根目录。 ●”errorlog” = $error_log: 错误日志路径。 ●”customlog” = $custom_Log: 自定义日志路径。 ●”include” = $httpd_include: 包含的配置文件路径。 ●”httpd_conf_path” = $httpd_confile: Apache配置文件路径。 ●”httpd_path” = $httpd_path: Apache可执行文件路径。 ●”bk_inst_name” = “apache-{{bk_host_innerip}}-$httpd_port”: 实例名称,格式为 “apache-主机内网IP-端口号”,必填,可自行用采集字段拼接 ●”bk_obj_id” = “apache”: 固定值 “apache”,必填,根据采集的模型定义

$outputJson = ConvertTo-Json $output使用ConvertTo-Json命令将哈希表$output转换为JSON格式,并将结果赋值给变量$outputJson。 Write-Output $outputJson输出转换后的JSON字符串。

通过上述定义后,执行脚本可得到对应的结果,输出结果示例如下。可按照如下结果保存在CMDB中。

{

"bk_inst_name": "abcsql-1",

"bk_obj_id": "abcsql",

"ip_addr": "10.10.10.10",

"version": "6.7"

}

{

"bk_inst_name": "abcsql-2",

"bk_obj_id": "abcsql",

"ip_addr": "10.10.10.11",

"version": "6.8"

}

step2:创建采集任务

路径:管理-资产管理-配置采集

通过配置采集页面左侧,找到需要采集的类型(Kubernetes、网络设备、数据库、云平台、SSL证书、配置文件等)。通过右侧按钮创建并配置采集任务,可以使用刚才创建的脚本插件进行采集。

支持通过配置录入方式选择自动录入或审批录入,其中自动录入为当任务执行后发现新的资产,自动录入到CMDB,审批录入则需要人工在页面审批后录入资产。任务执行过程中,支持手动终止该任务。

step3:采集结果

路径:资产-资产目录-对应资产

采集任务执行后,可以在任务列表中的采集摘要中查看任务的采集情况。

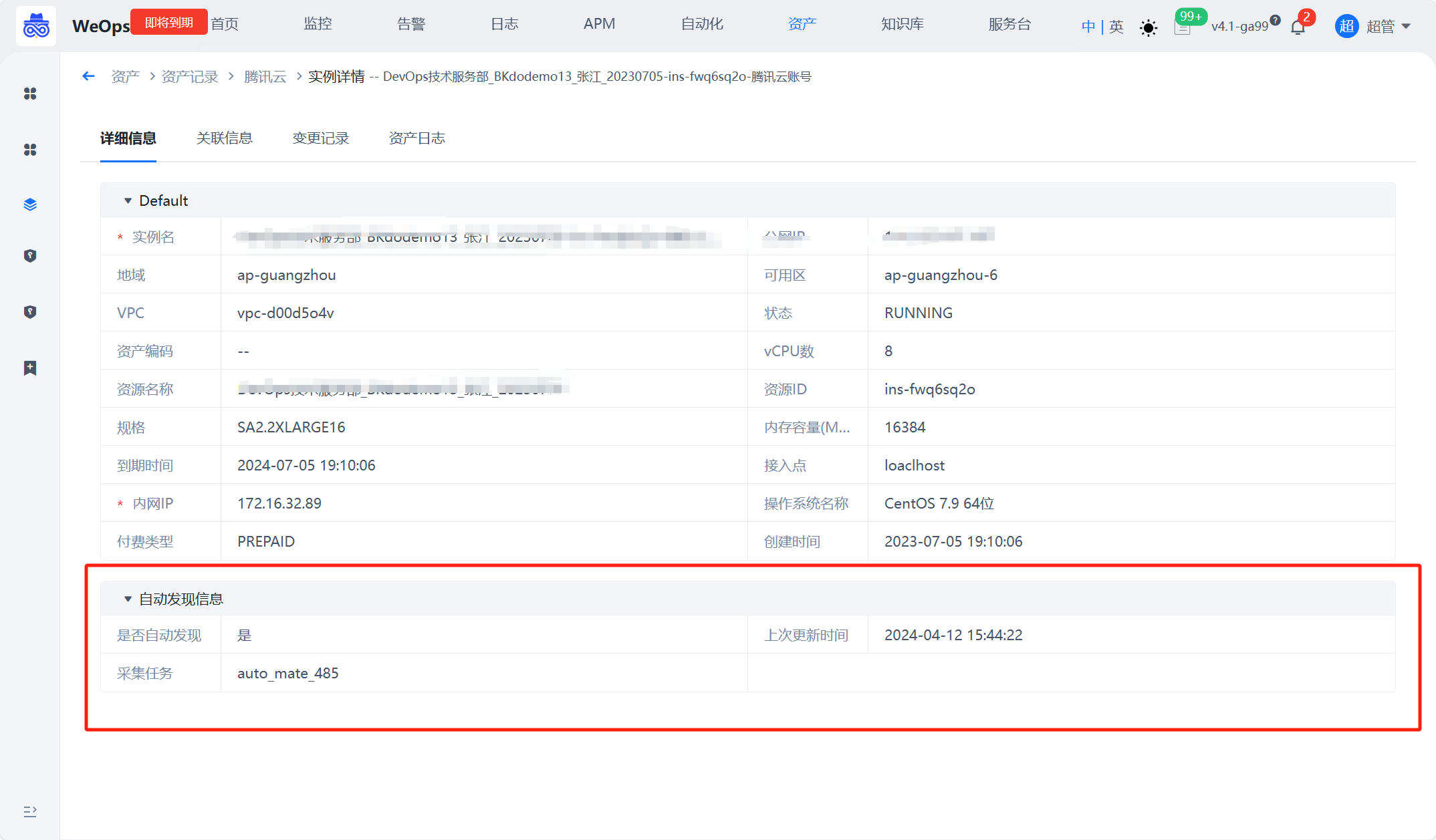

任务详情:展示任务执行后资产新增、更新和下架等情况,具体说明如下

新增资产:通过对比实例名识别出的新增资产,可自动/审批录入至CMDB

资产更新:通过对比实例名识别出的已有资产,自动更新该资产的配置信息

新增关联:该任务采集到的资产之间新的关联关系数,若任务为审批录入,则需审批录入后再执行采集任务补充关联关系

下架资产:通过对比该采集任务以往录入的实例识别出已经下架的资产,需要手动确认,才会在CMDB删除资产记录更新:当任务执行完成后,或者通过手动审批/手动下架后,“资产记录”会更新到最新的资产列表、资产字段值、资产关联关系,并用字段“上次更新时间”、“是否自动发现“和”采集任务“标识本次自动更新的信息。

配置采集插件

针对不同的对象,可以通过撰写脚本插件的方式拓展配置采集支持的模型,配置采集主要用于发现已经纳管的资产更详细的配置信息,并自动更新至CMDB中。 在插件管理-配置采集插件中支持创建“配置采集”类的插件,采集配置模式下,需要勾选“默认采集主机”,用于下发采集。

采集任务:创建配置采集任务,选择执行对象和主机,执行结果仅展示“更新资产+新建关联”,并更新至CMDB中。

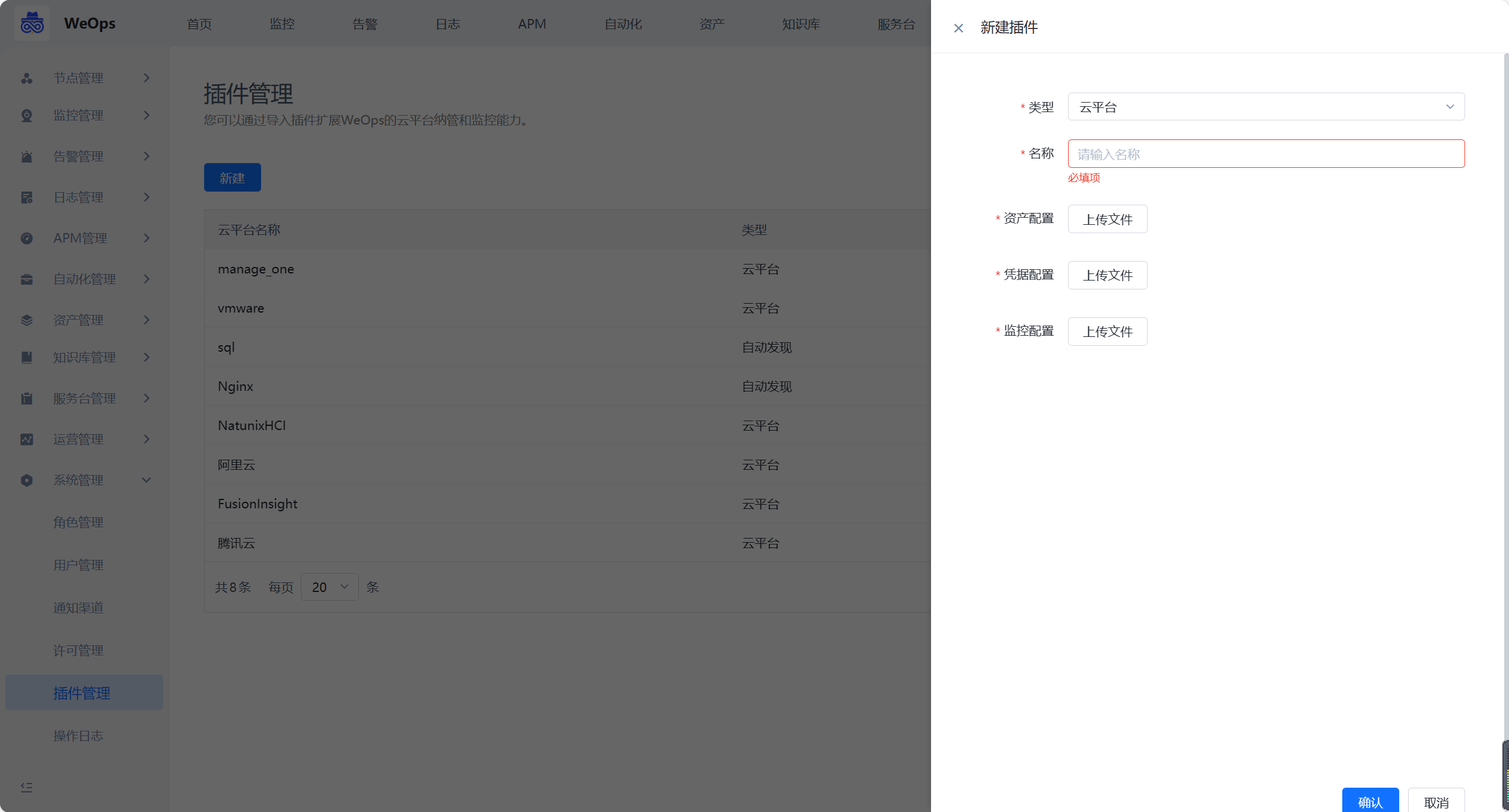

云平台插件

如下图,需要编写并导入云平台的资产配置文件、凭据文件、监控配置文件。(配置文件的编写和模板详见《WeOps高级开发指南》)

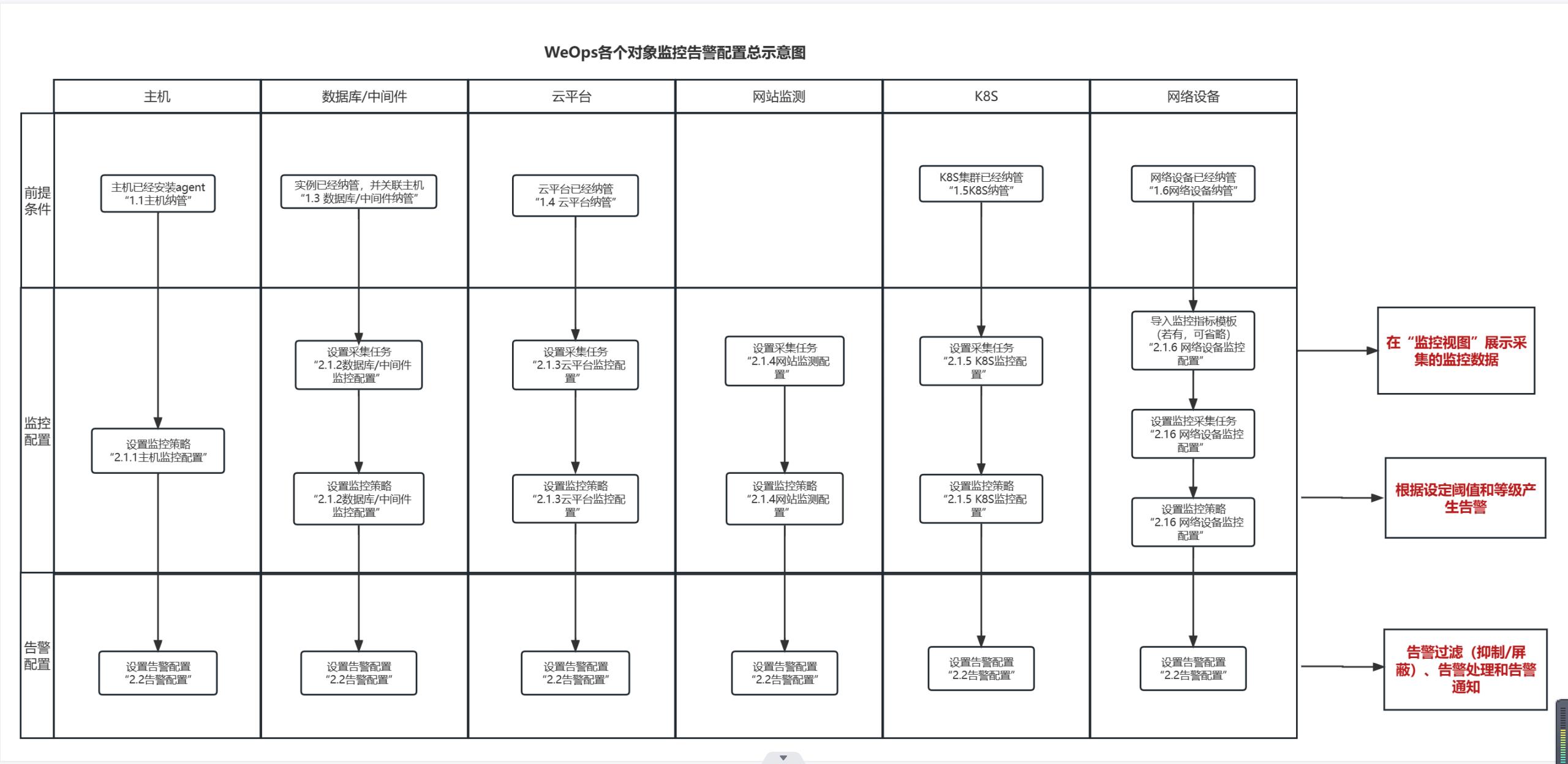

监控告警配置

关于WeOps各个对象的监控告警配置总示意图如下

- 关于主机/数据库/中间件/k8s/云平台/网络设备的纳管,详情可参考“1、资源纳管”

- 各类对象的监控采集和监控策略配置,详情可参考“2.1 监控配置-分对象介绍”

- 各类对象的告警配置,包括告警抑制/告警屏蔽/自动处理/自动分派、人员通知,详情可参考“2.2告警配置”,各对象配置方法通用

监控配置

主机监控配置

背景介绍:主机已经安装完Agent,已经完成纳管,纳管的步骤详情可见“1、资源纳管-主机纳管”,现需要对主机的监控策略进行配置。

Step1:监控采集

主机已经安装完Agent,就已经可以进行监控数据的采集,详情可见“1、资源纳管-主机纳管”这里不在赘述。

Step2:监控策略配置

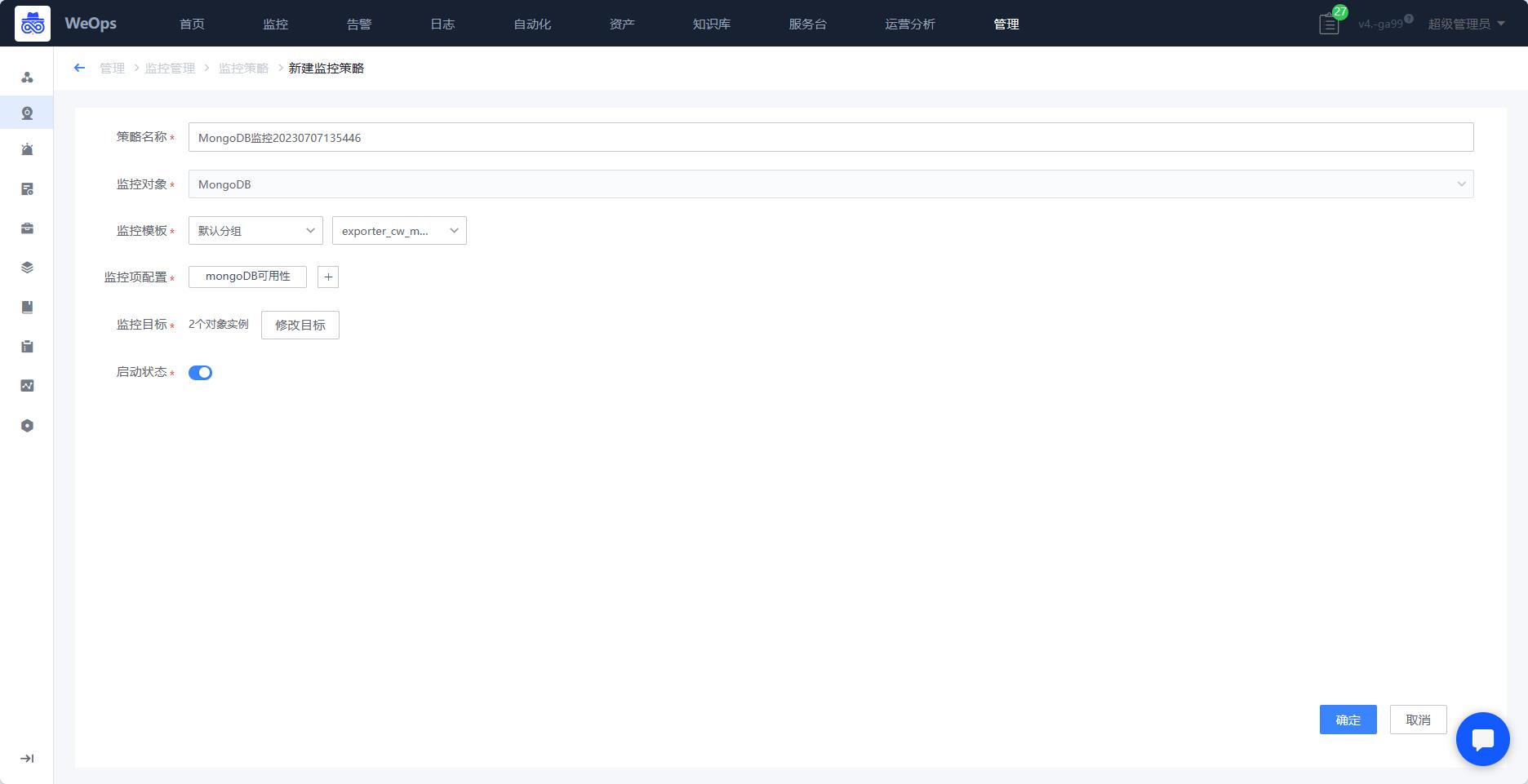

路径:管理-监控管理-监控策略-主机

- 进入WeOps的管理中心的监控管理,找到监控策略。

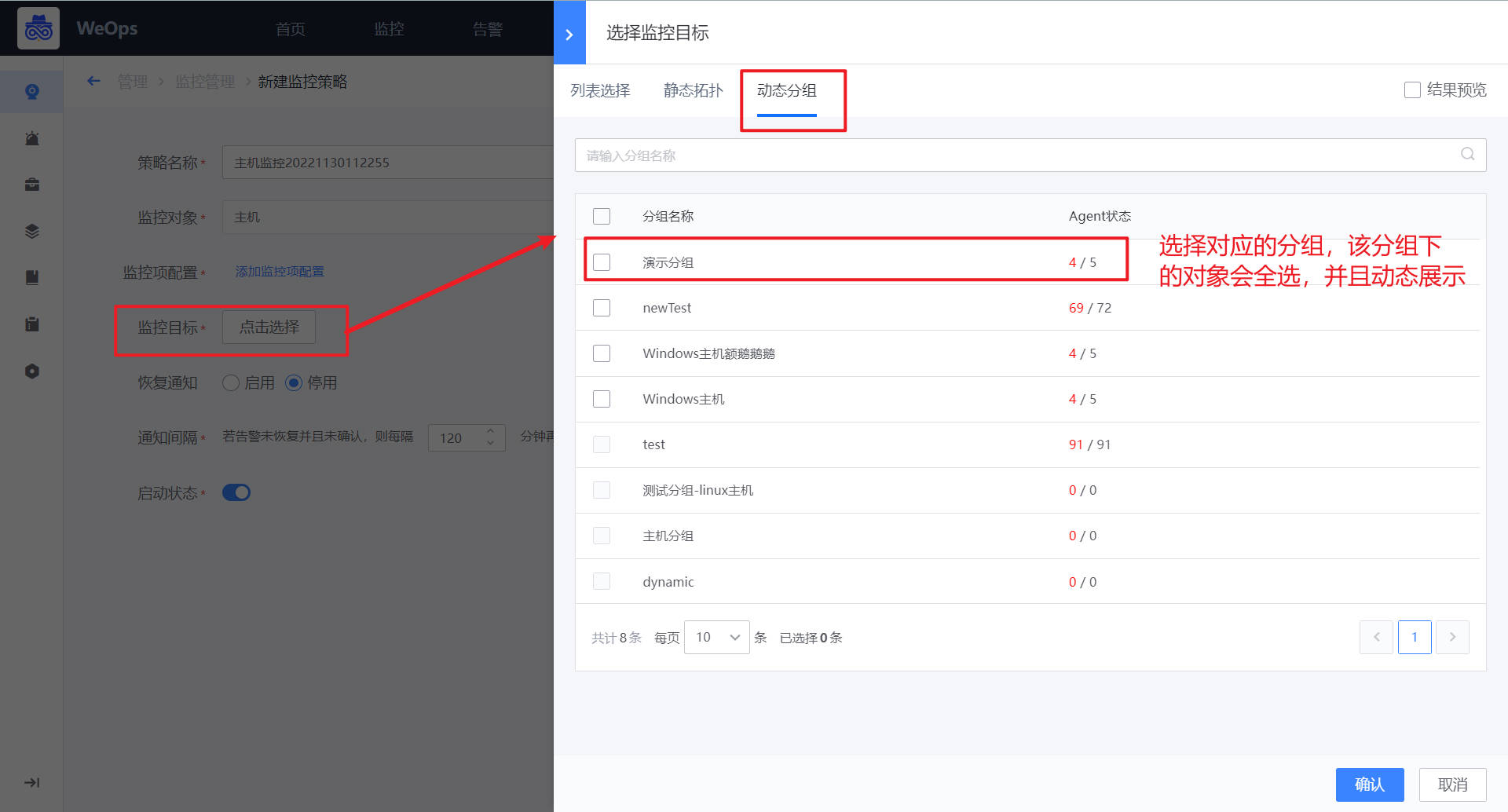

- 如下图所示,进入新建监控模板配置界面,默认填写策略名称、监控对象

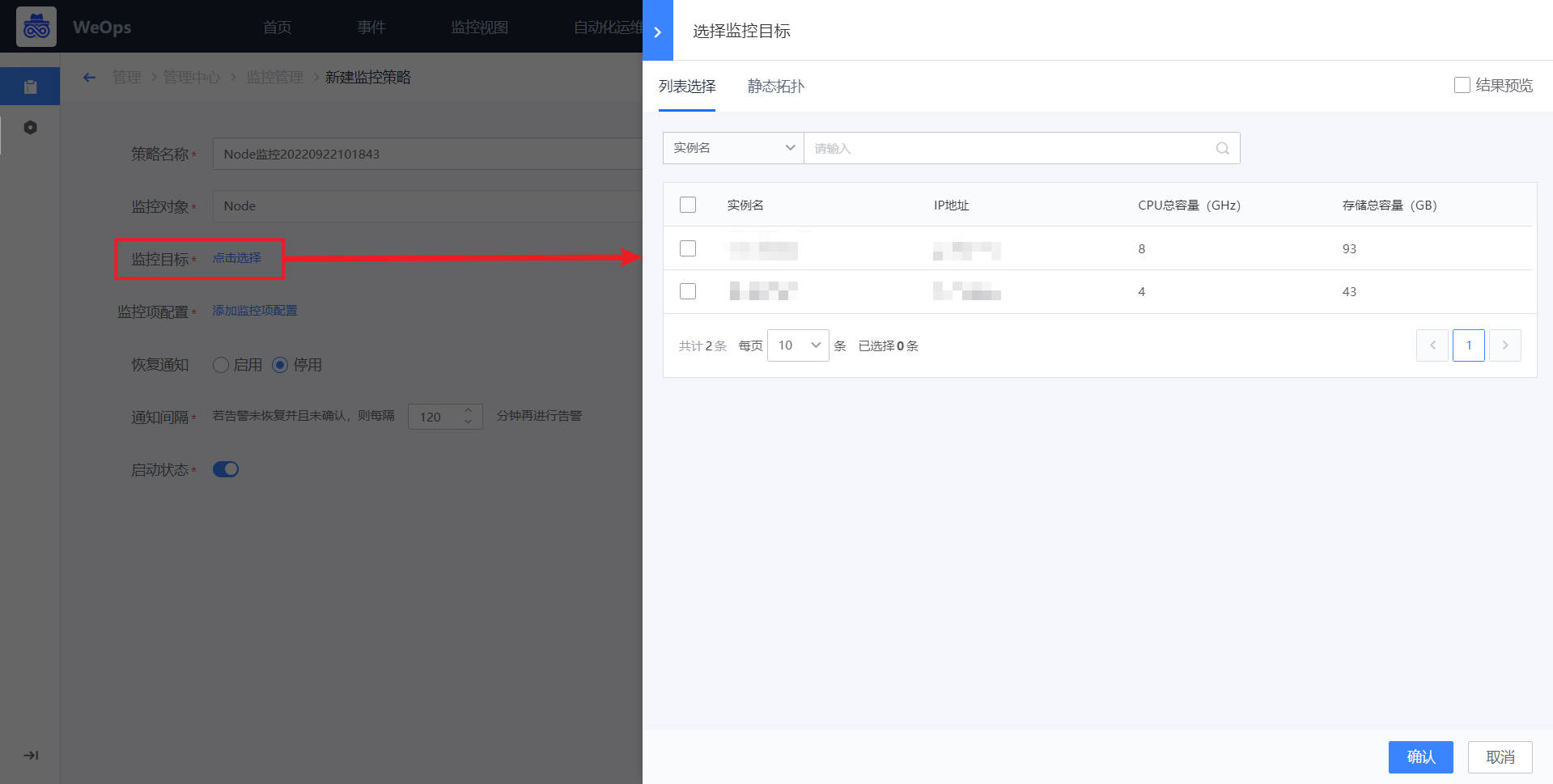

- 如下图所示,点击“选择监控目标”,可以采用列表选择/静态拓扑选择的方式,选择需要监控的目标。

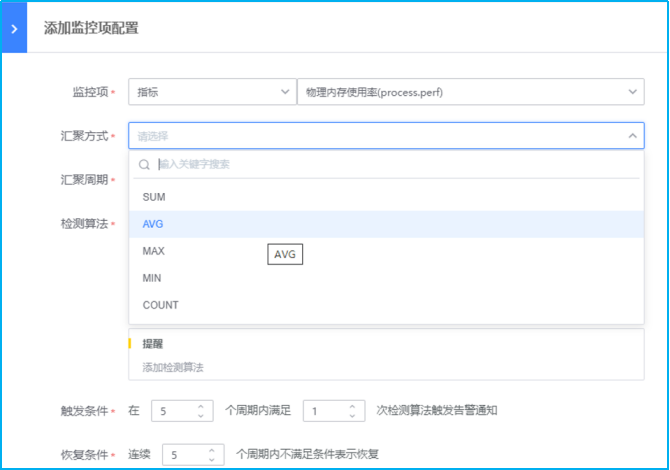

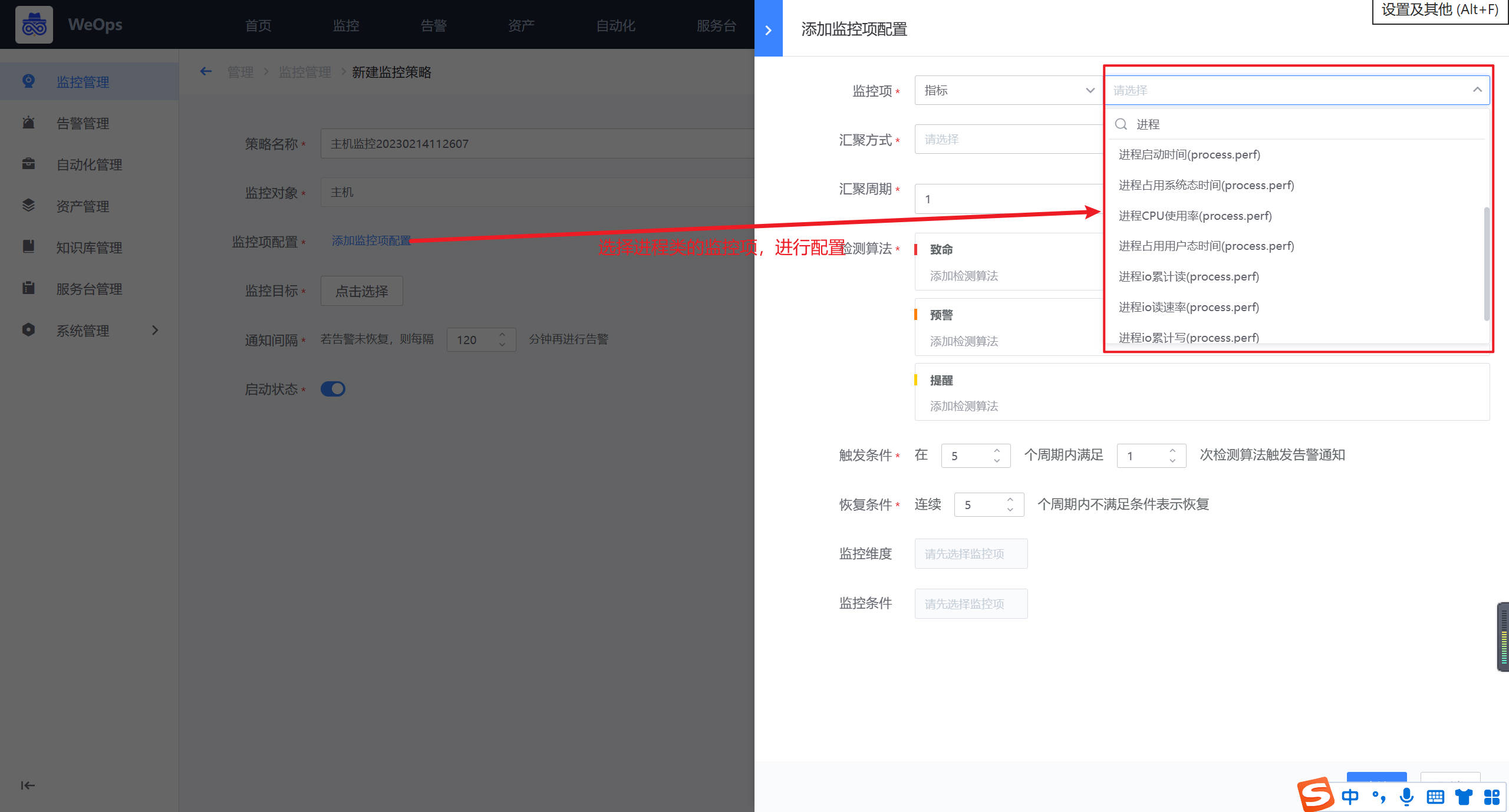

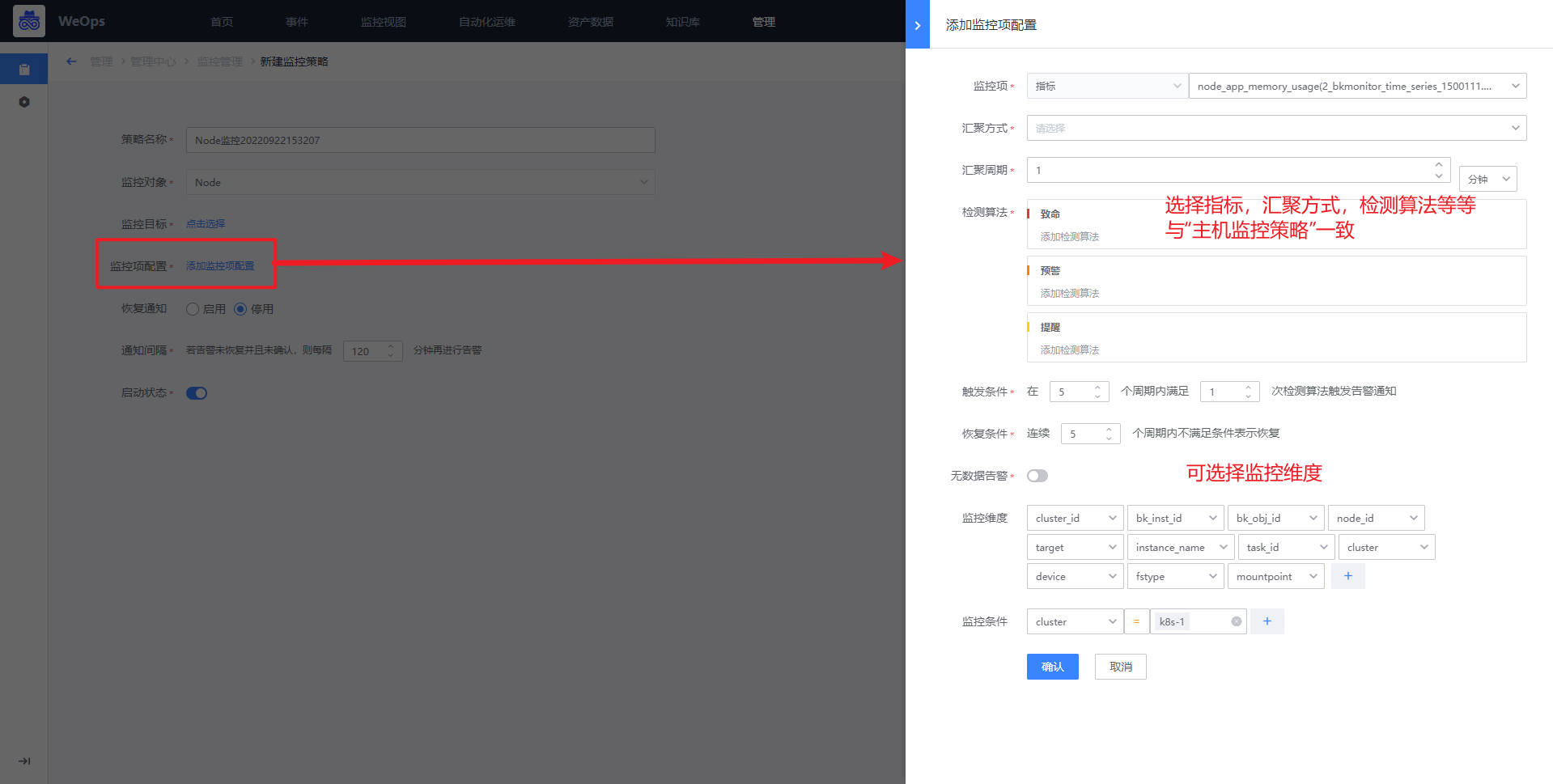

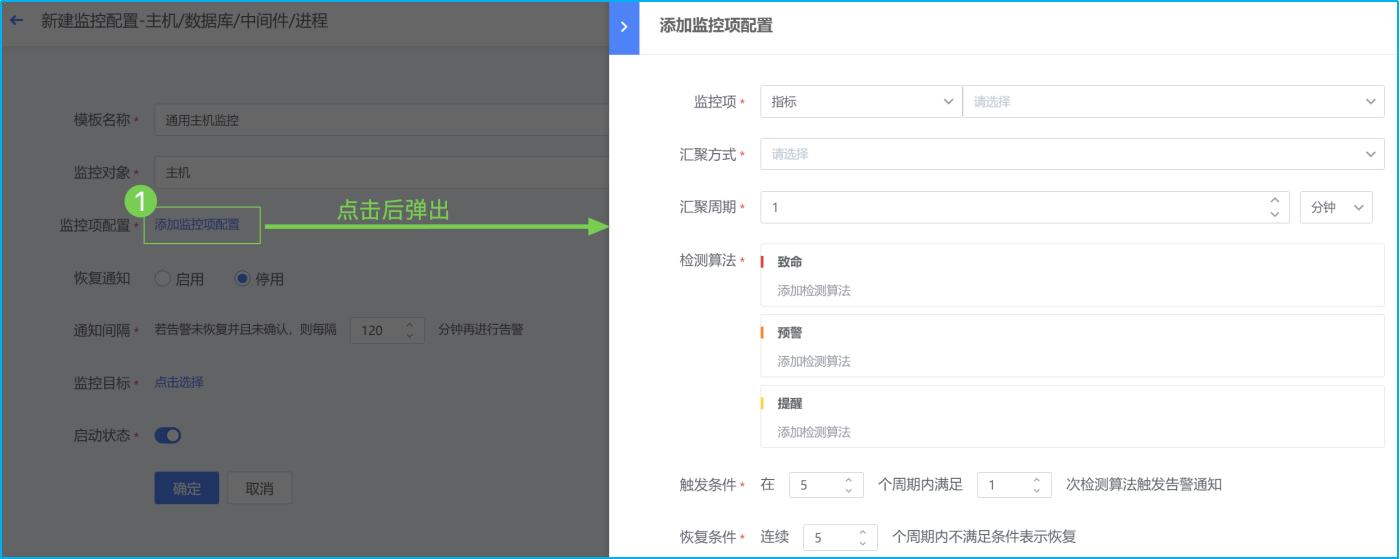

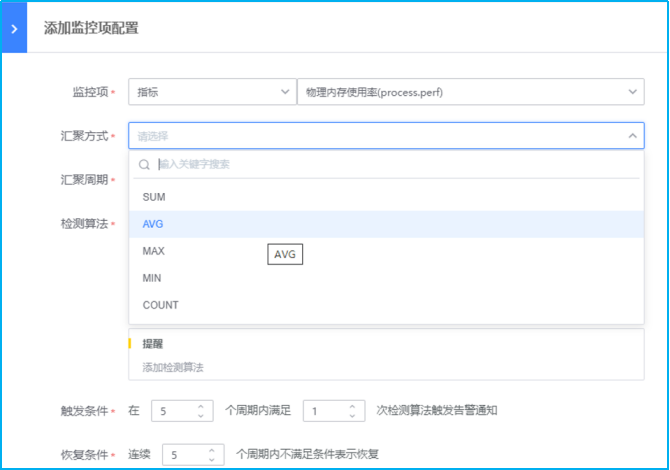

- 如下图所示,点击蓝色字体【添加监控项配置】即会弹出对应界面。主机监控项分为“指标”和“事件”两类。指标主要为常见的CPU、内存、磁盘、进程等监控指标。而事件则是指Agent心跳、Ping可达、主机重启等。

- 选择监控项为指标类,搜索监控项

- 选择汇聚方式为平均数,即AVG方式。SUM代表总数,AVG代表平均数,MAX代表最大值,MIN代表最小值,COUNT代表计数/总数。

- 选择汇聚周期,汇聚周期即采集数据的周期。(注:汇聚1min即是服务端每分钟向Agent采集1次数据。若是汇聚周期设置为5min则表示服务端向Agent每5分钟采集1次数据,此刻的Agent已经采集到了5次数据。之后,并根据汇聚方式将这5个数据进行计算(AVG/MAX/MIN等),计算得出的数值再于检测算法设置的阈值进行比较。)

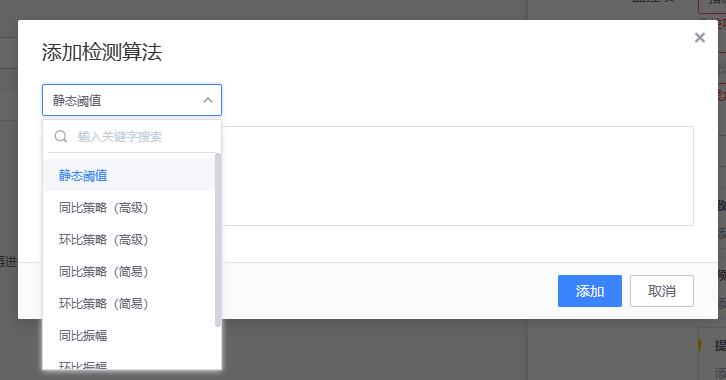

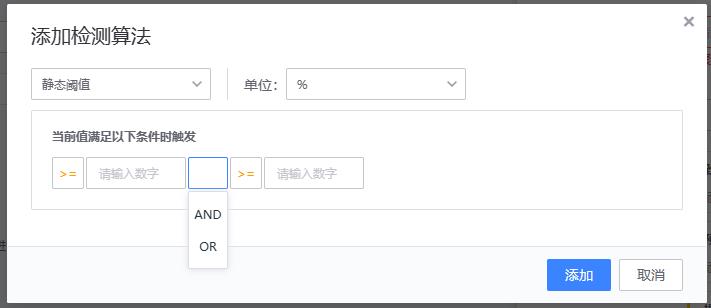

- 如下图所示,点击蓝色字体添加检测算法,进行不同监控等级阈值的设置。以下示例采用检测静态阈值触发告警。此外还有高级的阈值检测方式可选择:各种同比/环比策略,共有8种算法

- 8种算法具体解释如下

- 【1、静态阈值】静态阈值是最简单也是使用最普遍的检测算法,只要值满足条件即为异常。是一种固定的设定方法。大多数的都是以静态阈值为主。

- 适用场景: 适用于许多场景,适用可以通过固定值进行异常判断的。如磁盘使用率检测,机器负载等。

- 配置方法

- 实现原理

{value} {method} {threshold}

# value:当前值

# method:比较运算符(=,>, >=, <, <=, !=)

# threshold: 阈值

# 当前值 (value) 和阈值 (threshold) 进行比较运算

多条件时,使用and或or关联。 判断规则:or 之前为一组

例:

>= 10 and <= 100 or = 0 or >= 120 and <= 200

(>= 10 and <= 100) or (= 0) or (>= 120 and <= 200) - 【2、同比策略(简易)/同比策略(高级)】

- 适用场景:适用于以周为周期的曲线场景。比如 pv、在线人数等

- 配置方法

- 实现原理

同比策略(简易)

{value} >= {history_value} * (100 + ceil) * 0.01)

or

{value} <= {history_value} * (100 - floor) * 0.01)

# value:当前值

# history_value:上周同一时刻值

# ceil:升幅

# floor:降幅

# 当前值(value) 与上周同一时刻值 (history_value)进行升幅/降幅计算示例:当 value(90),ceil(100),history_value(40)时,则判断为异常

同比策略(高级)

# 算法原理和同比策略(简易)一致,只是用来做比较的历史值含义不一样。

{value} >= {history_value} * (100 + ceil) * 0.01)

or

{value} <= {history_value} * (100 - floor) * 0.01)

# value:当前值

# history_value:前n天同一时刻绝对值的均值

# ceil:升幅

# floor:降幅

# 当前值(value) 与前n天同一时刻绝对值的均值 (history_value)进行升幅/降幅计算

# 前n天同一时刻绝对值的均值计算示例

以日期2019-08-26 12:00:00为例,如果n为7,历史时刻和对应值如下:

取绝对值,因此所有的值为正数

history_value = (12 + 22 + 32 + 42 + 52 + 62 +72) / 7 = 42示例:当 value(90),ceil(100),history_value(42)时,则判断为异常

- 【3、环比策略(简易)/环比策略(高级)】

- 适用场景:适用于需要检测数据陡增或陡降的场景。如交易成功率、接口访问成功率等

- 配置方法

- 实现原理

环比策略(简易)

算法原理和同比策略(简易)一致,只是用来做比较的历史值含义不一样。

{value} >= {history_value} * (100 + ceil) * 0.01)

or

{value} <= {history_value} * (100 - floor) * 0.01)

# value:当前值

# history_value:前一时刻值

# ceil:升幅

# floor:降幅

# 当前值(value) 与前一时刻值 (history_value)进行升幅/降幅计算示例:当 value(90),ceil(100),history_value(40)时,则判断为异常

环比策略(高级)

# 算法原理和同比策略(简易)一致,只是用来做比较的历史值含义不一样。

{value} >= {history_value} * (100 + ceil) * 0.01)

or

{value} <= {history_value} * (100 - floor) * 0.01)

# value:当前值

# history_value:前n个时间点的均值

# ceil:升幅

# floor:降幅

# 当前值(value) 与前个时间点的均值 (history_value)进行升幅/降幅计算

# 前n个时间点的均值计算示例(数据周期1分钟)

以日期2019-08-26 12:00:00为例,如果n为5,历史时刻和对应值如下:

history_value = (12 + 22 + 32 + 42 + 52) / 5 = 32示例:当 value(90),ceil(100),history_value(32)时,则判断为异常

- 【4、同比振幅】

- 适用场景:场景:适用于监控以天为周期的事件,该事件会明确导致指标的升高或者下降,但需要监控超过合理范围幅度变化的场景。比如每天上午 10 点有一个抢购活动,活动内容不变,因此请求量每天 10:00 相比 09:59 会有一定的升幅。因为活动内容不变,所以请求量的升幅是在一定范围内的。使用该策略可以发现异常的请求量。

- 配置方法

- 实现原理

# 算法示例:

当前值 − 前一时刻值 >= 过去 5 天内任意一天同时刻差值 × 2 + 3

以日期2019-08-26 12:00:00为例,如果n为5,历史时刻和对应值如下:

# 当前值

value = 26

# 前一时刻值

prev_value = 10

# 比较运算符(=,>, >=, <, <=, !=)

method = ">="

# 波动率

ratio = 2

# 振幅

shock = 3

# 当前值一前一时刻值的差值

current_diff = 16

# 5天内同时刻差值

prev5_diffs = [7, 6, 8, 10, 12]

前第二天(2019-8-24)同时刻差值: 6 * ratio(2) + shock(3) = 15

current_diff(16) >= 15

# 当前值(26) - 前一时刻值(10) >= 2天前的同一时刻差值6 * 2 + 3

此时算法检测判定为检测结果为异常:

- 【5、同比区间】

- 适用场景:温水煮青蛙型 – 数据缓慢上升或下降,适用于以天为周期的曲线场景。由于该模型中数据是缓慢变化的,所以使用【环比策略】、【同比振几幅】都检测不出告警,因为这两种模型主要使用于突升、突降、大于或小于指定值的情况。【同比区间】才适用于这种情况,因为随着数据的变化,当前值和模型值差距越来越大,而区间比较主要就是那当前值和历史模型值做比较。

- 配置方法

- 实现原理

# 算法示例:

当前值 >= 过去 5 天内同时刻绝对值 × 2 + 3

以日期2019-08-26 12:00:00为例,如果n为5,历史时刻和对应值如下:

# 当前值

value = 11

# 比较运算符(=,>, >=, <, <=, !=)

method = ">="

# 波动率

ratio = 2

# 振幅

shock = 3

前第3天(2019-8-23)同时刻值: 13 * ratio(2) + shock(3) = 26

value(26) >= 26

# 当前值(26) >= 3天前的同一时刻绝对值13 * 2 + 3

此时算法检测判定为检测结果为异常: - 【6、环比振幅】

- 适用场景:适用于指标陡增或陡降的场景,如果陡降场景,ratio(波动率)配置的值需要 < -1 该算法将环比算法自由开放,可以通过配置 波动率 和 振幅,来达到对数据陡变的监控。同时最小阈值可以过滤无效的数据

- 配置方法

- 实现原理

# 当前值(value) 与前一时刻值 (prev_value)均>= (threshold),且之间差值>=前一时刻值 (prev_value) * (ratio) + (shock)

# value:当前值

# prev_value:前一时刻值

# threshold:阈值下限

# ratio:波动率

# shock:振幅

以日期2019-08-26 12:00:00为例:

# 当前值

value = 46

# 前一时刻值

prev_value = 12

# 波动率

ratio = 2

# 振幅

shock = 3

value(46) >= 10 and prev_value(12) >=10

value(46) >= prev_value(12) * (ratio(2) + 1) + shock(3)

此时算法检测判定为检测结果为异常:

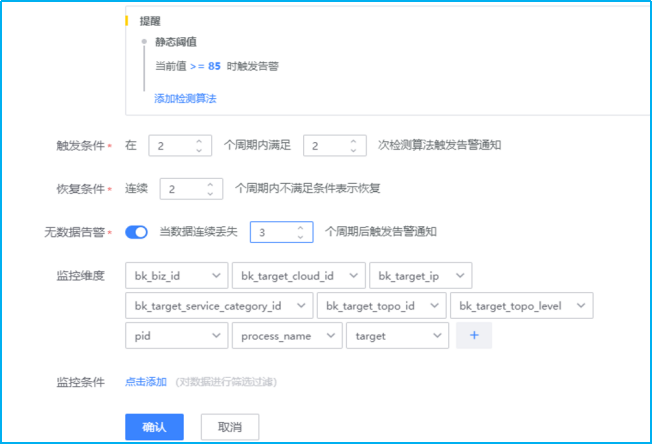

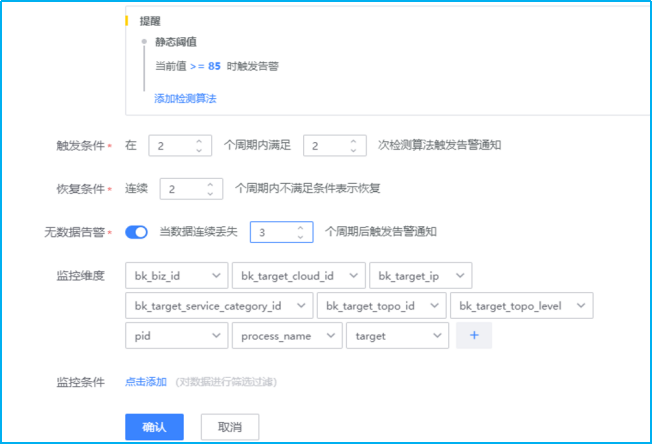

# 当前值(46)与前一时刻值(12)均>= (10),且之间差值>=前一时刻值 (12) * (2) + (3)- 如下图所示,进行“触发条件”、“恢复条件”、“无数据告警”、“监控纬度”以及“监控条件”的设置。

触发条件:2个周期内满足2次检测算法触发告警。结合以上汇聚周期1min(监控数据采集周期也是1min),汇聚方式设置为AVG平均数(1个数的平均数亦是其本身)。综上,每分钟检测1次,连续2次检测满足检测算法设置的阈值即会触发对应的告警等级。

恢复条件:连续2个周期内不满足条件表示恢复。表示:每分钟检测1次,连续2次检测不满足即表示恢复。

无数据告警:开启。当数据连续丢失3个周期后触发告警通知。表示:每分钟检测1次数据汇聚情况,若是连续3次(即3分钟内无任何数据),则触发无数据告警通知。

监控纬度:不同的监控项有不同的监控纬度。默认监控所有纬度,可以根据需求进行增删。默认情况下是监控所有纬度。例如监控项磁盘空间,那么windows的监控纬度则会是自发现的C:\ D:\ E:\等,而Linux则会是/、/root、/dev等。

监控条件:监控条件是对监控纬度的筛选,若是不选择则代表监控所有纬度。磁盘监控项中若是监控条件选择C:\则代表只监控磁盘C分区。- 如下图所示,对监控项进行一一添加后再进行其他配置即可完成监控策略的配置。

- 主机监控策略配置完成后,若采集的监控数据超过设定的阈值,则按照致命/预警/提醒三个等级进行告警。

- 下一步“告警配置”可查看“2.2告警配置”

进程监控配置

背景介绍:进程监控采集任务配置好下发到目标机器后,会基于采集的任务信息进行工作。通过配置需要监控的进程名,条件可以选择包含/不包含(排除)某些命令行的关键字,过滤出需要的进程,然后探测该进程是否开启端口(可选功能),同时会采集该进程的相关使用情况。

Step1:监控采集

监控采集的创建有两种路径进入

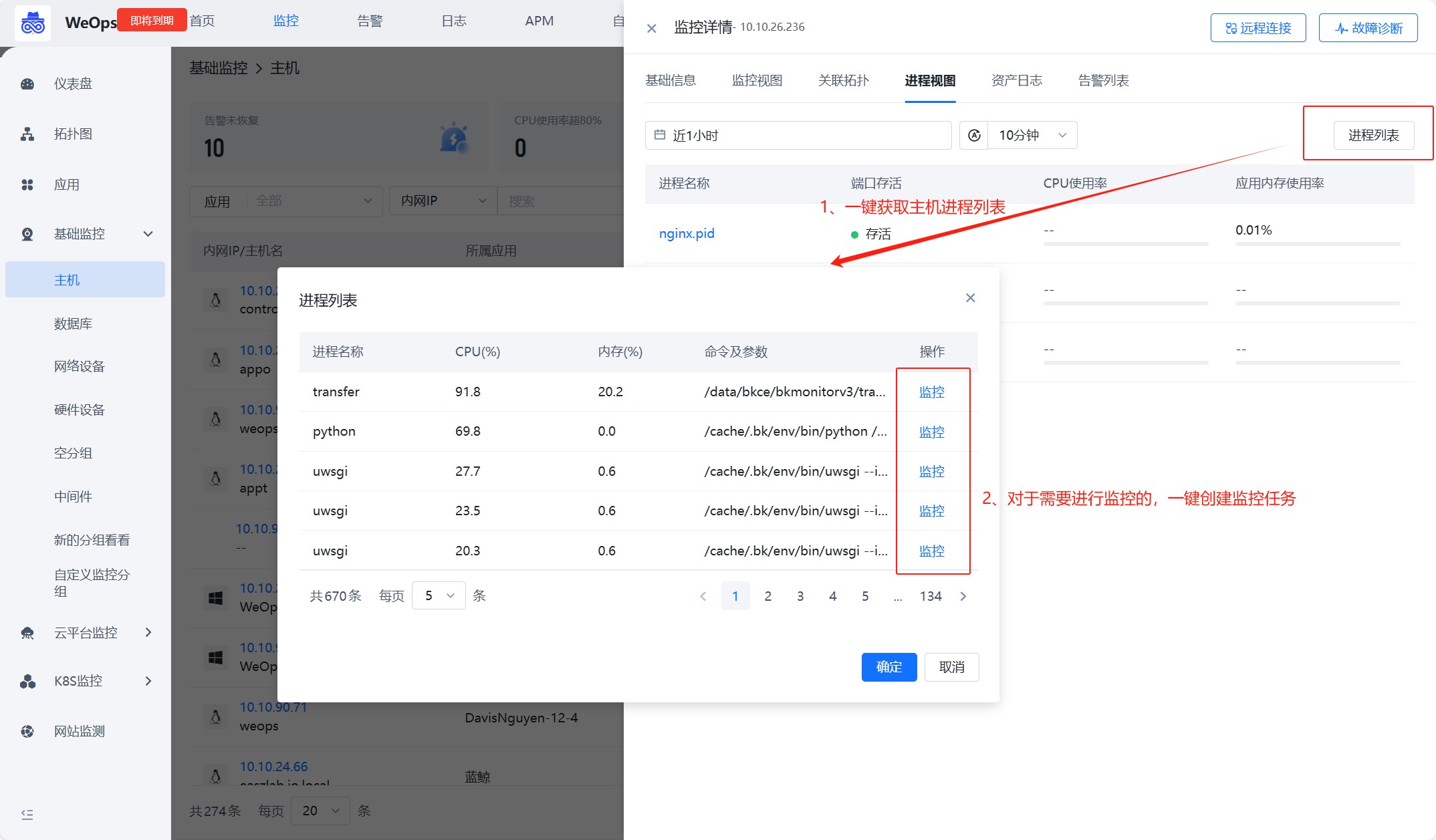

- 第一种,通过主机监控视图进入

路径:监控-基础监控-主机

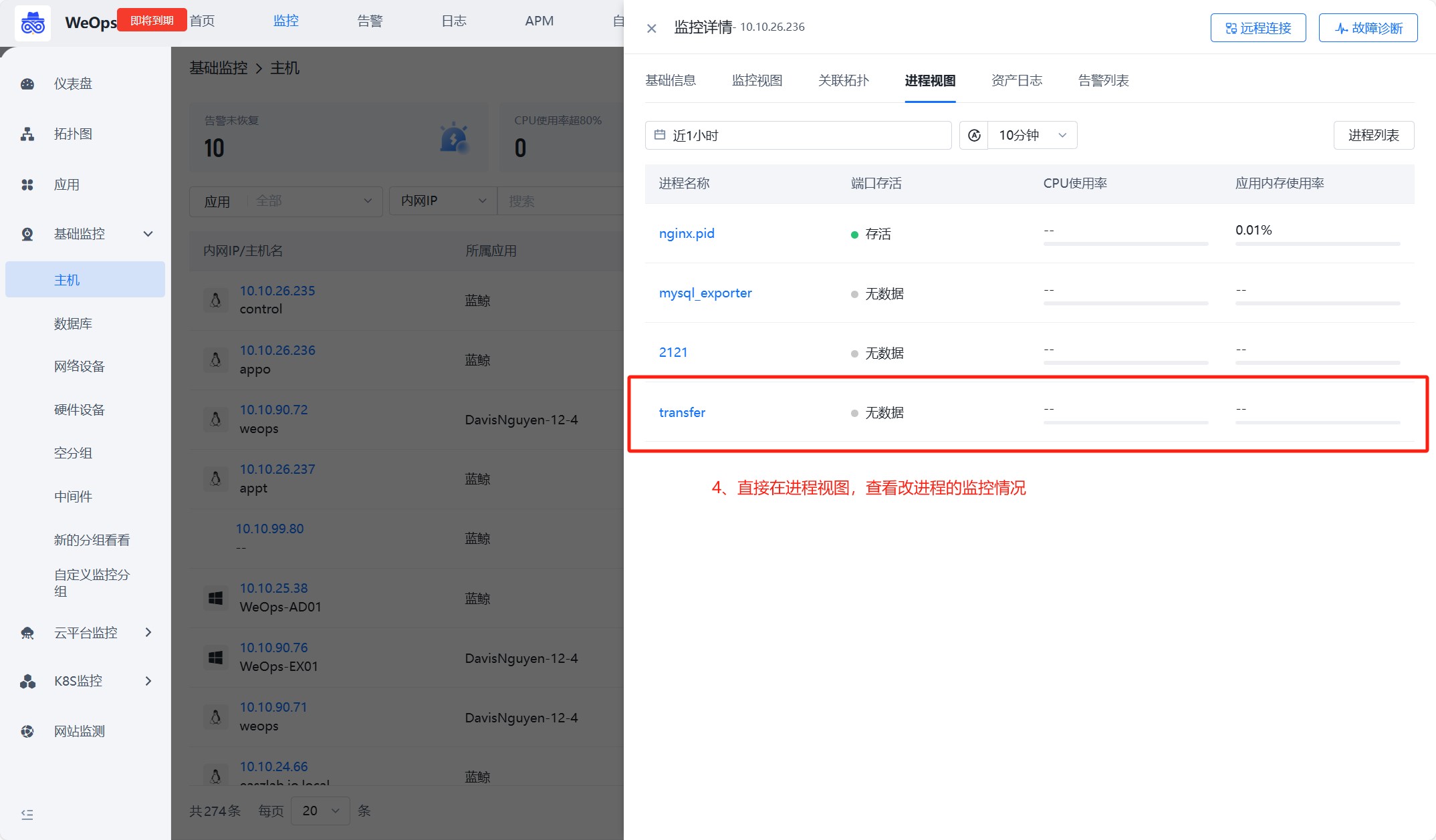

如下图,第一步,一键获取主机进程列表:在主机监控中,可以直接获取进程列表。二三步,快捷创建监控任务:对需要监控的进程,快捷创建监控采集任务,并且自动填充关键信息。第四步,任务创建完成后,可以在进程视图中,正常查看该进程的监控情况

- 第二种,直接在监控采集创建

路径:管理-监控管理-监控采集

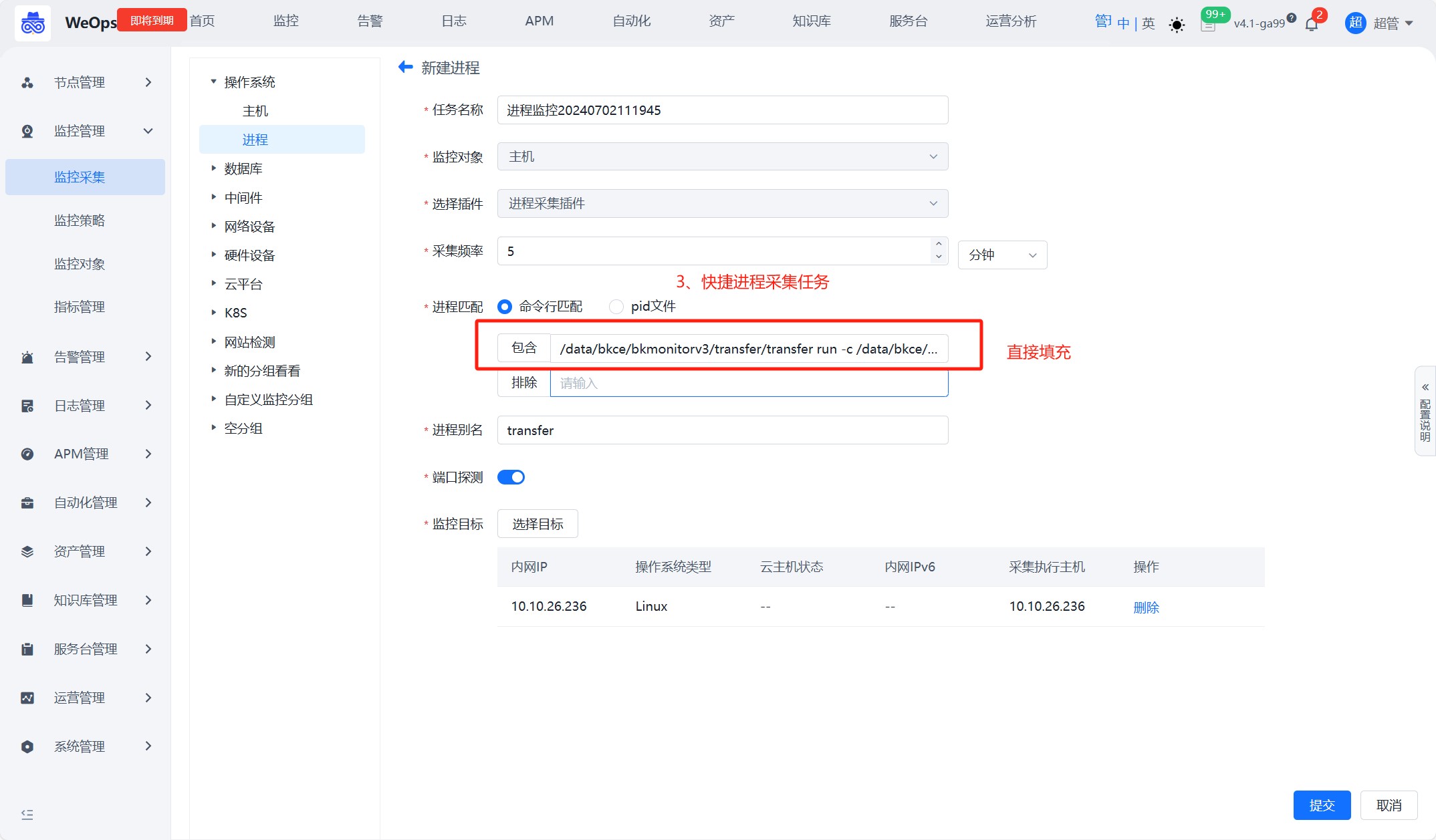

如下图,进入到进程采集的页面,点击进行端口采集新建。目前仅支持主机的进程采集和监控。

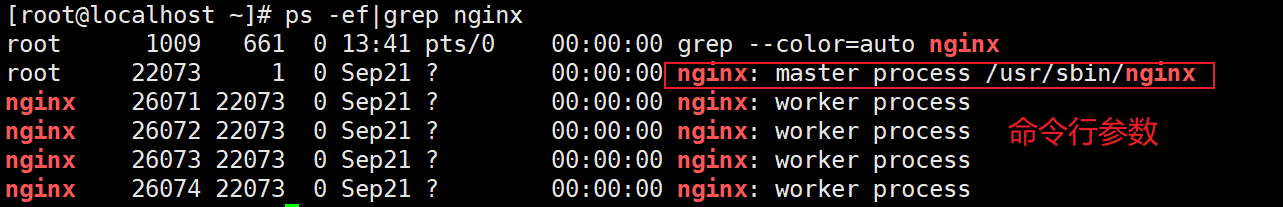

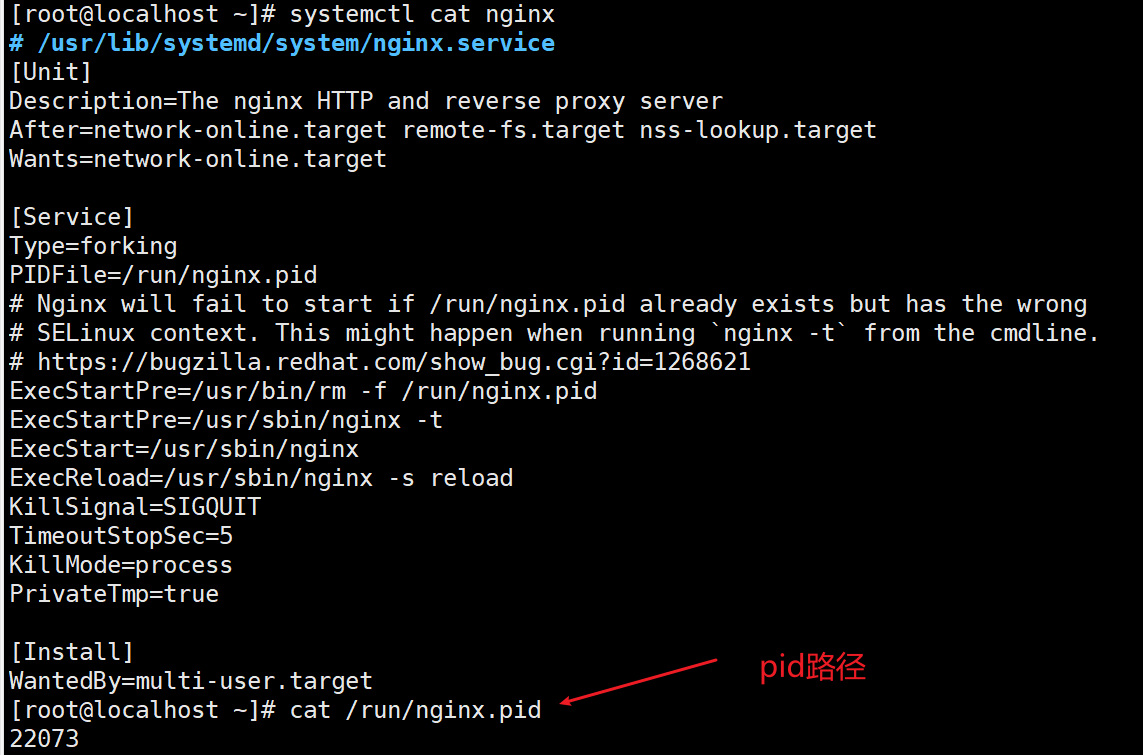

- 两种匹配方式,一种是命令行匹配,查询到命令行关键词,把参数复制进来就可以了,一种是pid路径匹配,把pid路径复制进来,命令行和pid两类详细说明如下

1、命令行参数:通过命令 ps -ef 获取到需要监控的进程的命令参数,在进程监控配置中,填写命令行参数,如果出现命令行参数无法区分两个进程的情况,可以采用排除关键词的方式,准确定位到需要监控测进程。

包含:进程匹配字符串,一般是进程的名称,注意Linux是cmdline, windows是匹配进程名。

排除:即不上报的进程,可以填写正则表达式,如(\d+),不采集匹配数字的进程。

如下图是通过命令 ps -ef 搜索到所有进程,以及进程的命令行参数(linux)

2、pid比较准确,可以准确识别到需要监控的进程,但是对程序的运行有要求,并非每个进程都会有pid文件,所以建议使用命令行的方式进行监控进程。

- 主机的进程采集设置完成后,可以在主机的对应监控视图中,查看该主机所有进程的监控情况,如下图

Step2:监控策略配置

路径:管理-监控管理-监控策略

如下图,在监控策略页面,找到主机,点击“创建”按钮,进行主机进程的监控策略的创建

- 如下图所示,填写策略名称,进行监控项的添加(选择进程类的指标)、监控阈值的配置、监控对象的选择等之后,点击保存即完成监控阈值的配置。

配置完成后,可以根据设定的指标、阈值和告警等级等产生对应的告警。

数据库/中间件监控配置

背景介绍:需要将数据库/中间件的实例已经新建完成,并且与对应主机已经建立了关联,数据库/中间件纳管的步骤详情可见“1.3 数据库/中间件纳管”,现需要对该实例进行监控采集和监控策略的设置。(这里以oracle为例进行介绍。)

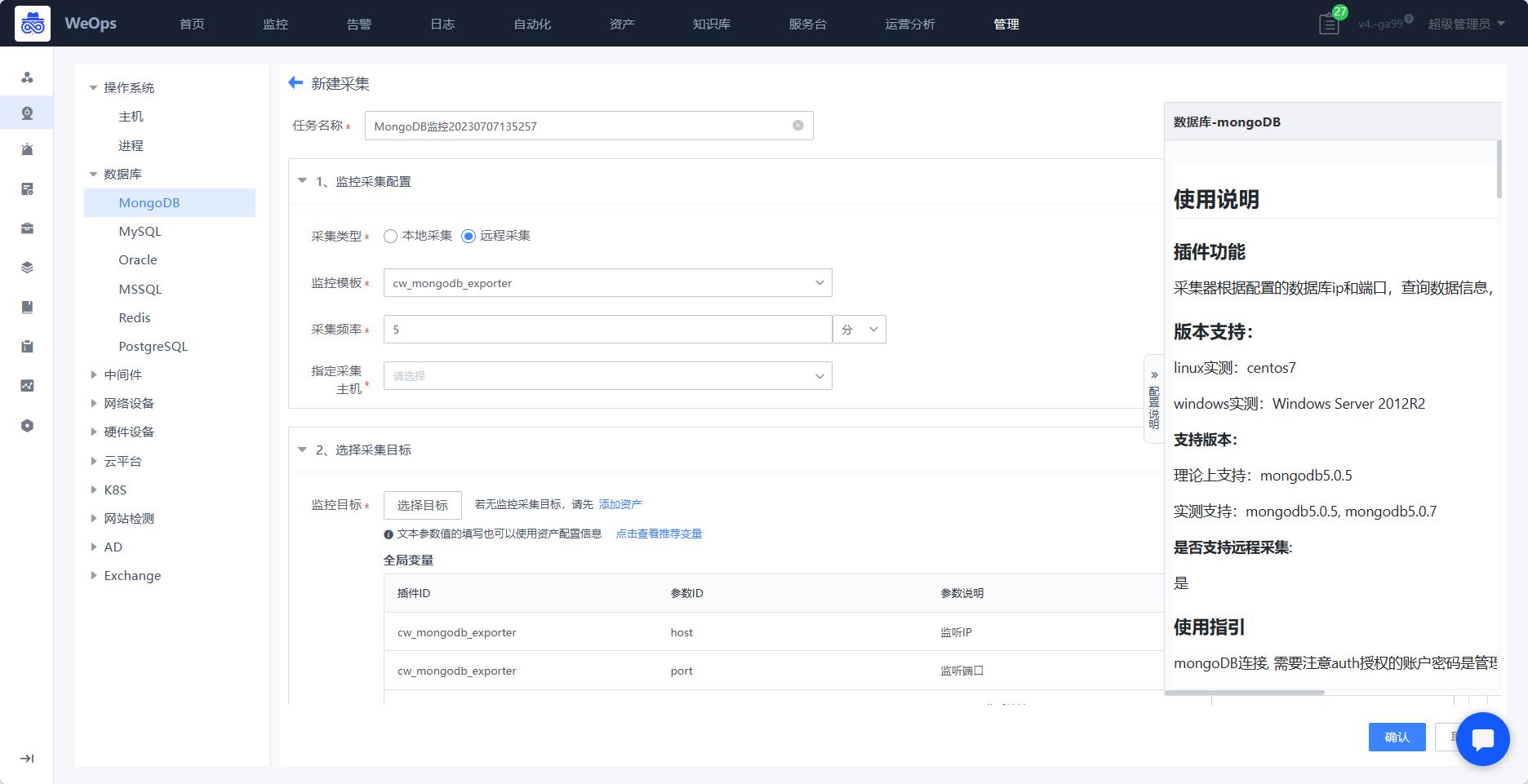

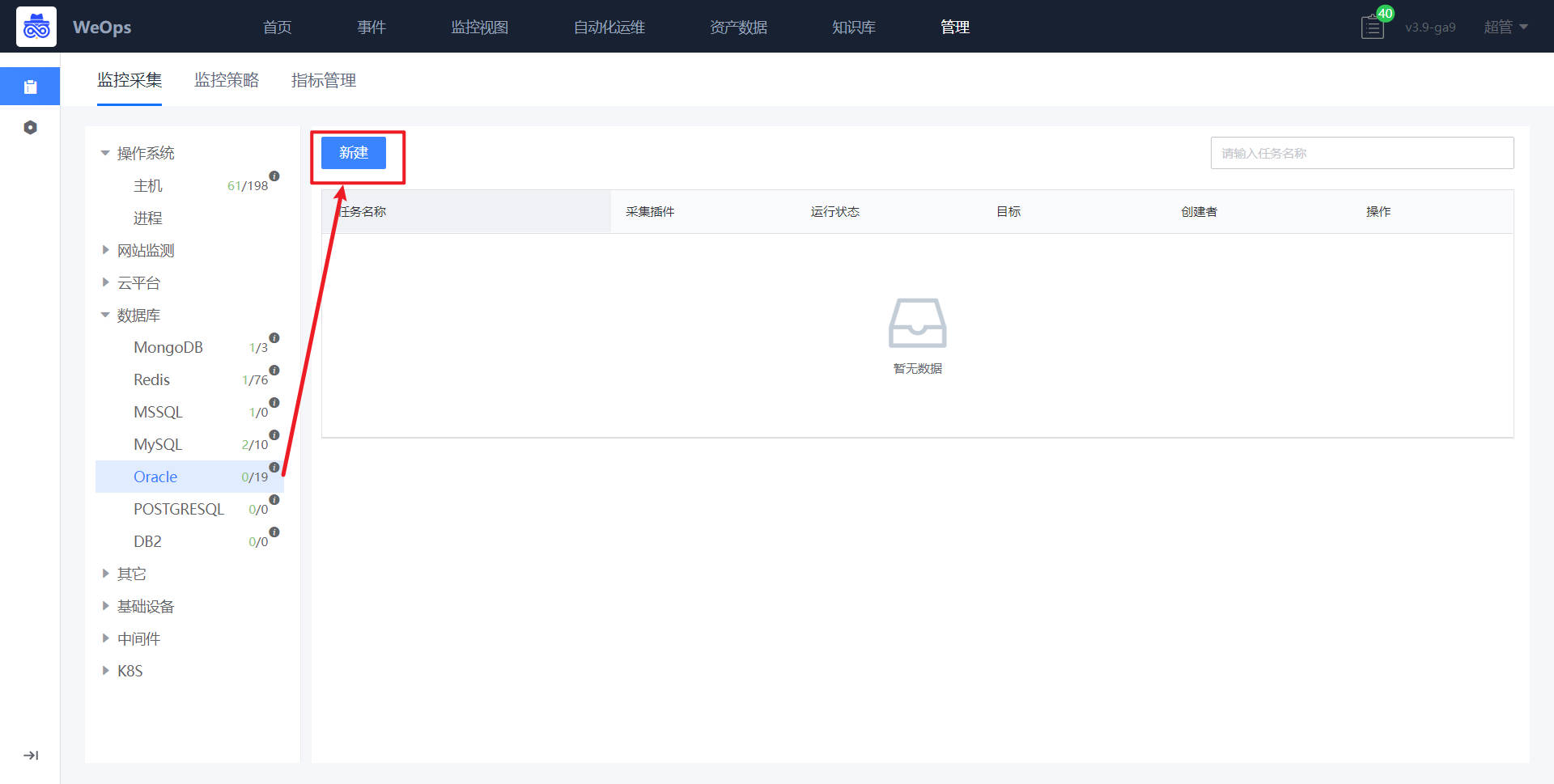

Step1:监控采集

路径:管理-监控管理-监控采集

- 如下图所示,进入监控采集页面,点击数据库-oracle,进行oracle监控采集任务新建。

- 如下图所示,采集任务、监控对象、采集插件、采集频率等信息已经默认填写,只需要选择目标(监控oracle主机)

- 如下图所示,在选择完监控目标后,若所有目标的监控采集参数一致,则在全局参数中填写,若是特殊oracle主机节点有不同的监控采集参数,例如账号密码等,则在对应监控目标后填写。

- 数据库/中间件的监控采集配置完成后,可在“监控视图-基础监控-数据库/中间件”中查看对应的监控情况和监控视图。

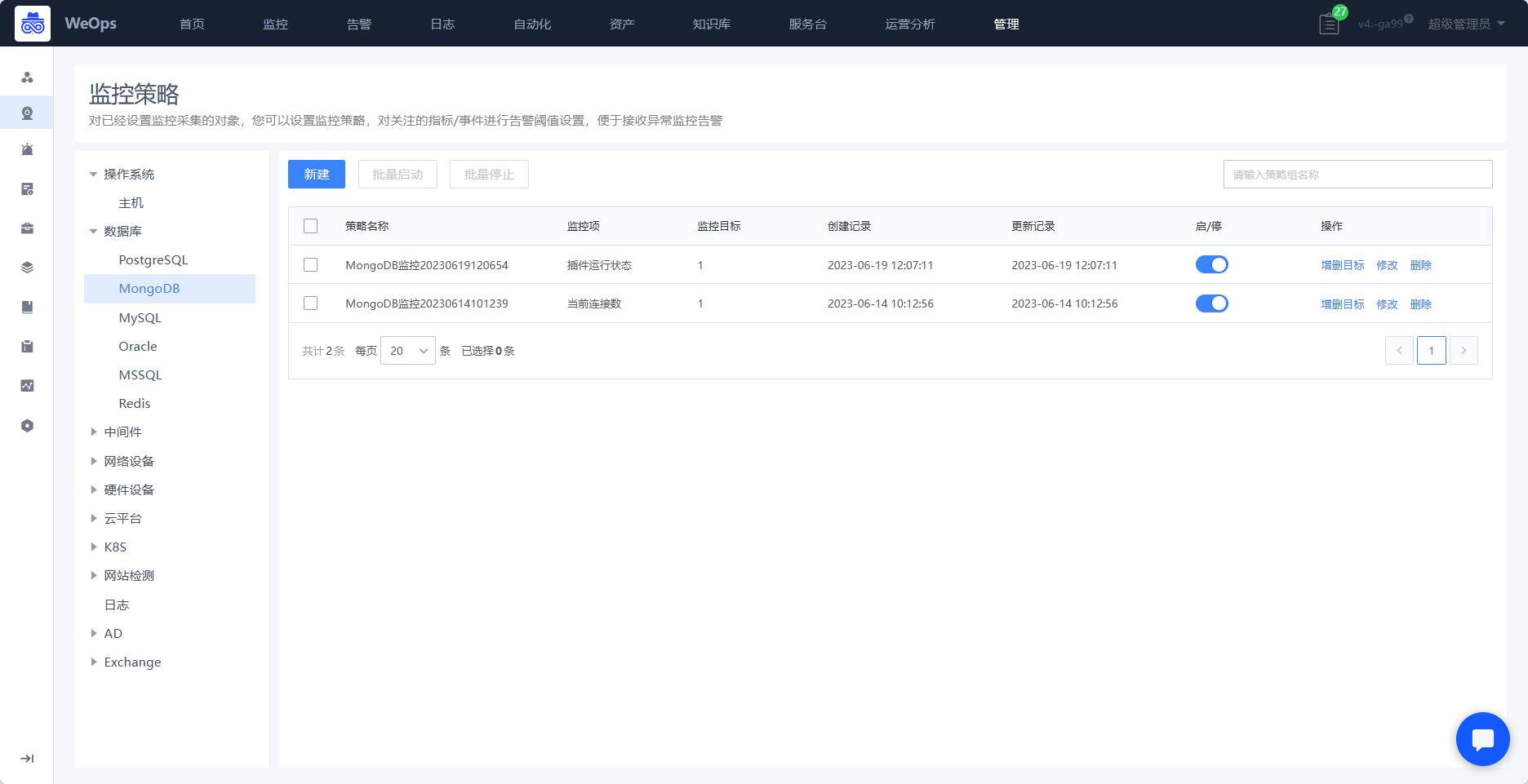

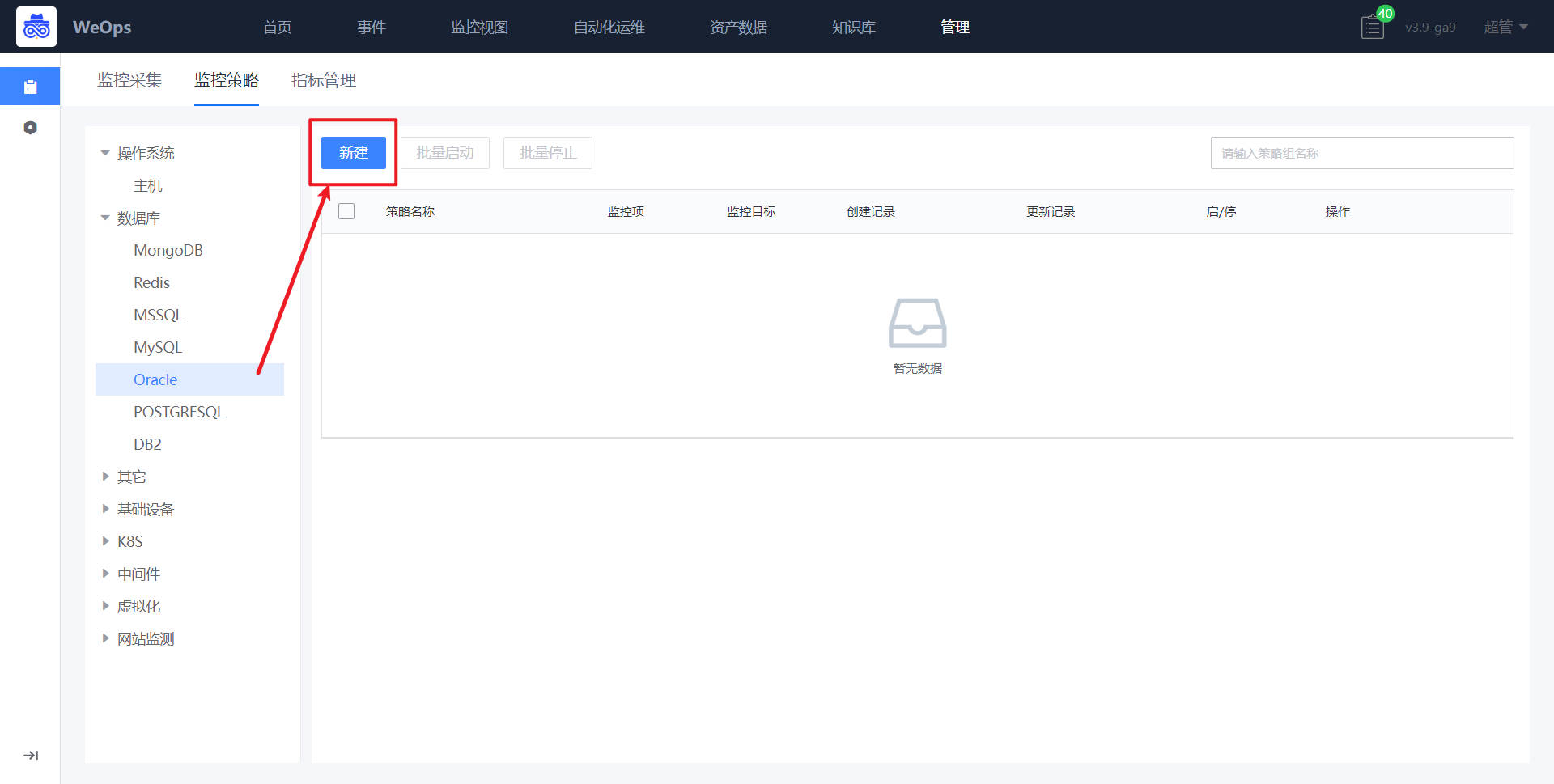

Step2:监控策略配置

路径:管理-监控管理-监控策略

- 如下图所示,进入到监控管理的监控策略页面,点击新增监控配置。

- 如下图所示,依照主机监控配置方式(可参见“1、资源配置-监控配置-主机监控配置”),进行监控项的添加、监控阈值的配置、监控对象的选择等之后,点击保存即完成监控阈值的配置。

- 数据库/中间件监控策略配置完成后,若采集的监控数据超过设定的阈值,则按照致命/预警/提醒三个等级进行告警。

- 下一步“告警配置”可查看“2.2告警配置”

云平台监控配置(以腾讯云为例)

背景介绍:需要将云平台纳入监控数据采集中,包括VMware、腾讯云和阿里云等,并设置对应监控策略。

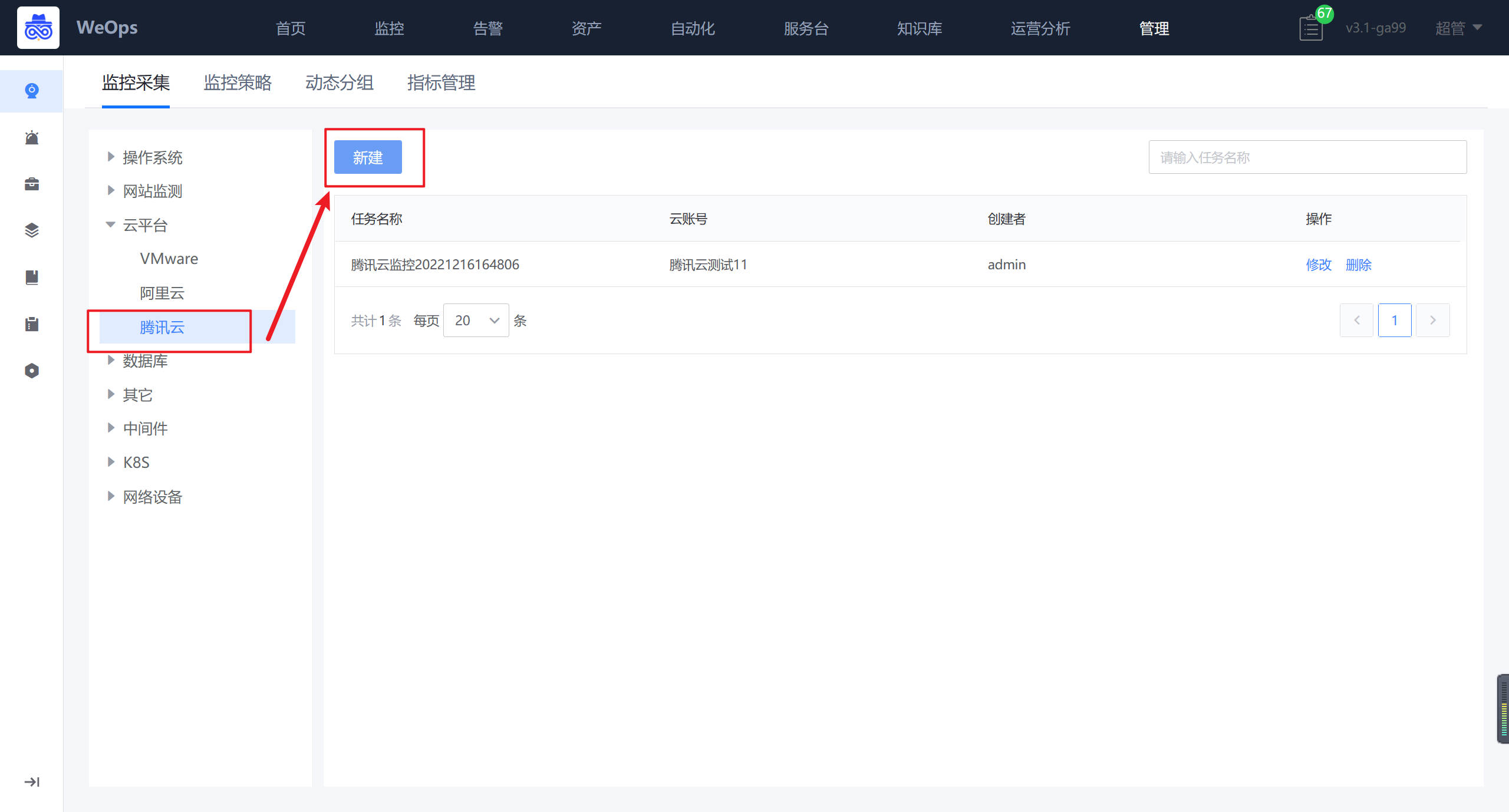

Step1:监控采集

路径:管理-监控管理-监控采集

- 如下图所示,进入云平台的监控采集界面,进行新增。

- 如下图所示,依次填写任务名称、腾讯云账号、对应凭据、采集频率等

- 新建完成后,,可对该腾讯云账号下所有的CVM进行监控数据的采集,并可以在WeOps-监控视图-云平台监控-腾讯云(CVM)中查看已经采集监控数据和监控视图

Step2:监控策略配置

路径:管理-监控管理-监控策略(虚拟化监控)

- 如下图所示,进入到监控管理的监控策略页面,点击新增云平台-腾讯云监控策略。

- 如下图所示,默认填写策略名称、监控对象,只需要选择监控项和监控目标即可(与主机监控策略配置操作一致)

- 监控策略配置完成后,若采集的监控数据超过设定的阈值,则按照致命/预警/提醒三个等级进行告警。

- 下一步“告警配置”可查看“2.2告警配置”

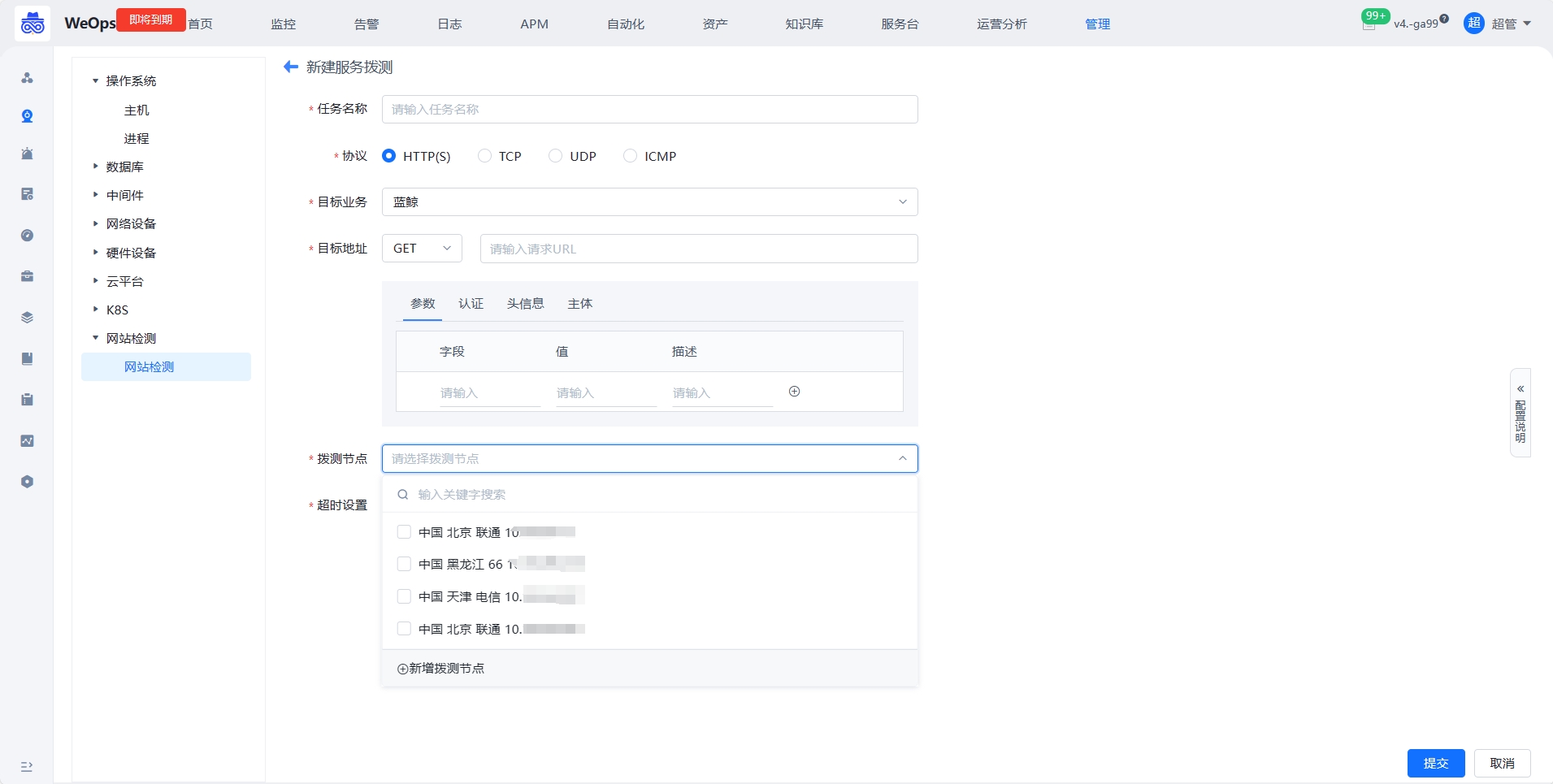

网站监控配置

背景介绍:需要将新的网站纳入拨测监控中,并配置相应的监控策略。

Step1:监控采集

路径:管理-监控管理-网站监测

- 如下图所示,进入网站监测的纳管界面,进行新增拨测任务。

- 如下图所示,对任务进行配置后点击提交。提交之际系统会进行一次拨测,拨测成功后该任务才算创建成功,否则无法创建。若是创建失败请检查相关配置。

- 新建完成后,可以在监控视图-网站监测中查看已经采集监控数据和监控视图

Step2:监控策略配置

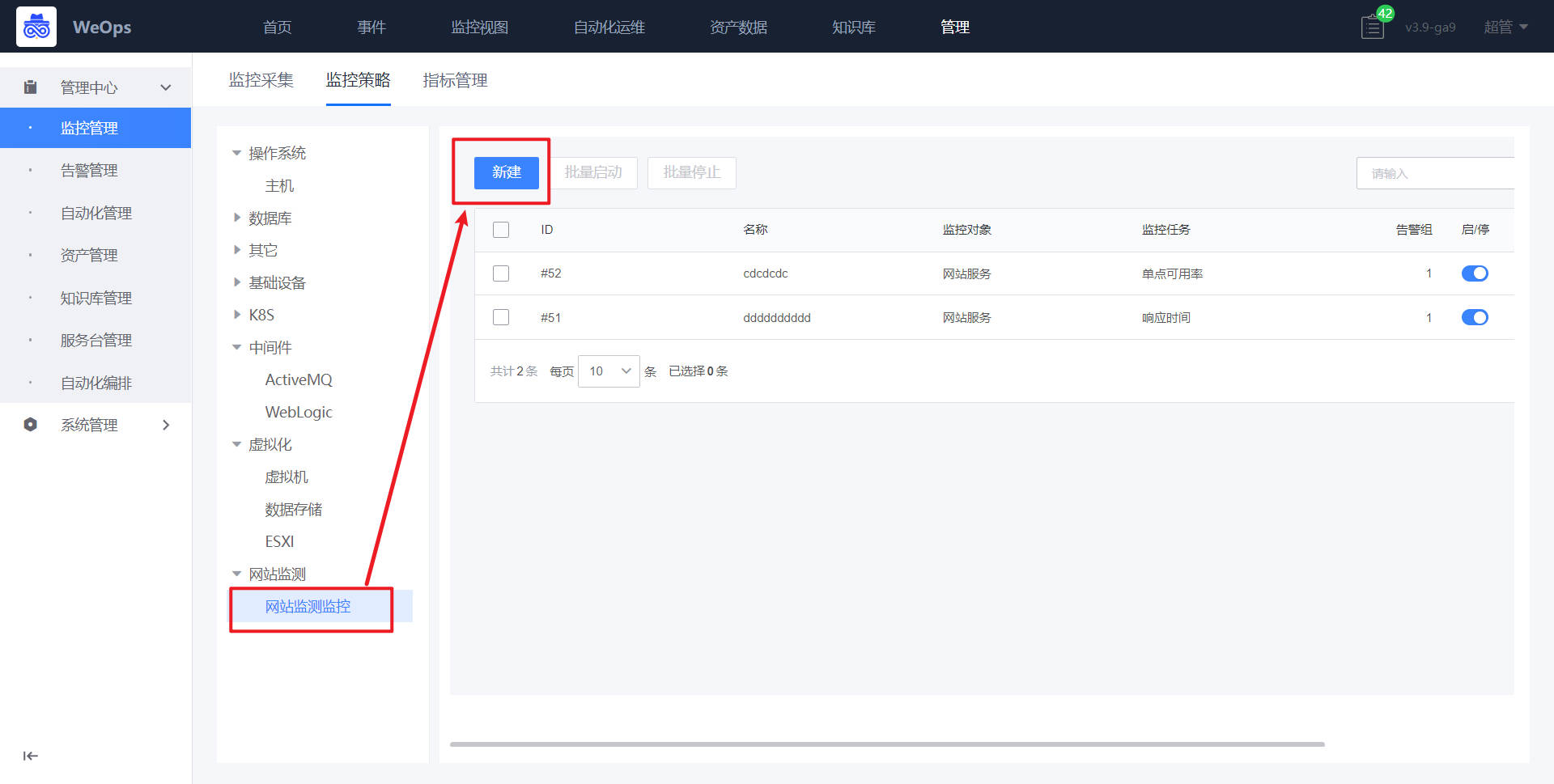

路径:管理-监控管理-监控策略(网站监测)

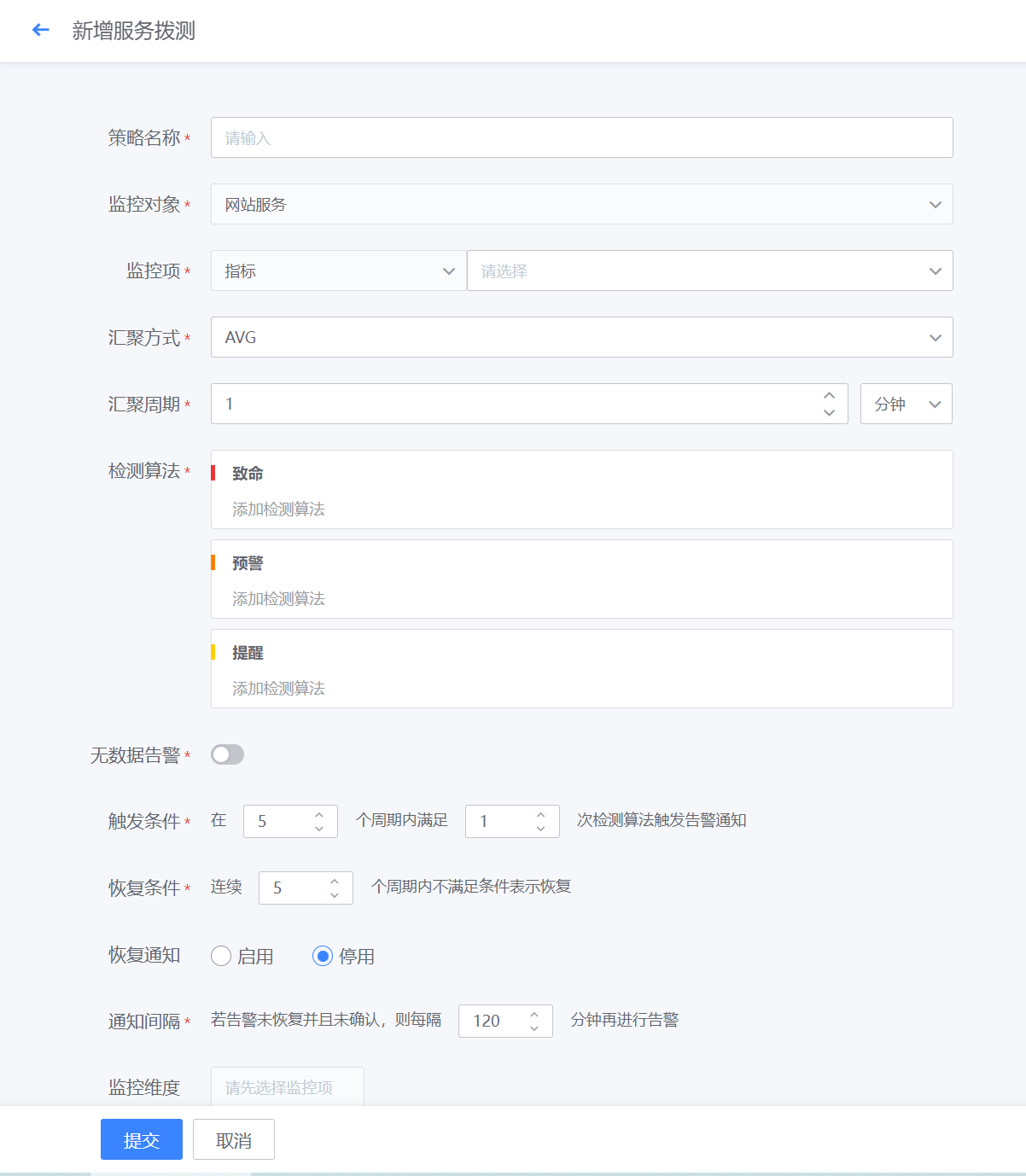

- 如下图所示,进入网站监测的配置界面,进行新增拨测监控。

- 如下图所示,进行监控项的相关配置,并配置触发和恢复规则,以及选择监控对象,点击确定,即完成对应服务拨测的监控配置

- 网站监控策略配置完成后,若采集的监控数据超过设定的阈值,则按照致命/预警/提醒三个等级进行告警。

- 下一步“告警配置”可查看“2.2告警配置”

K8S监控配置

背景介绍:需要将K8S集群中的pod/node纳入监控中,并配置相应的监控策略。

Step1:监控采集

路径:管理-监控管理-监控采集

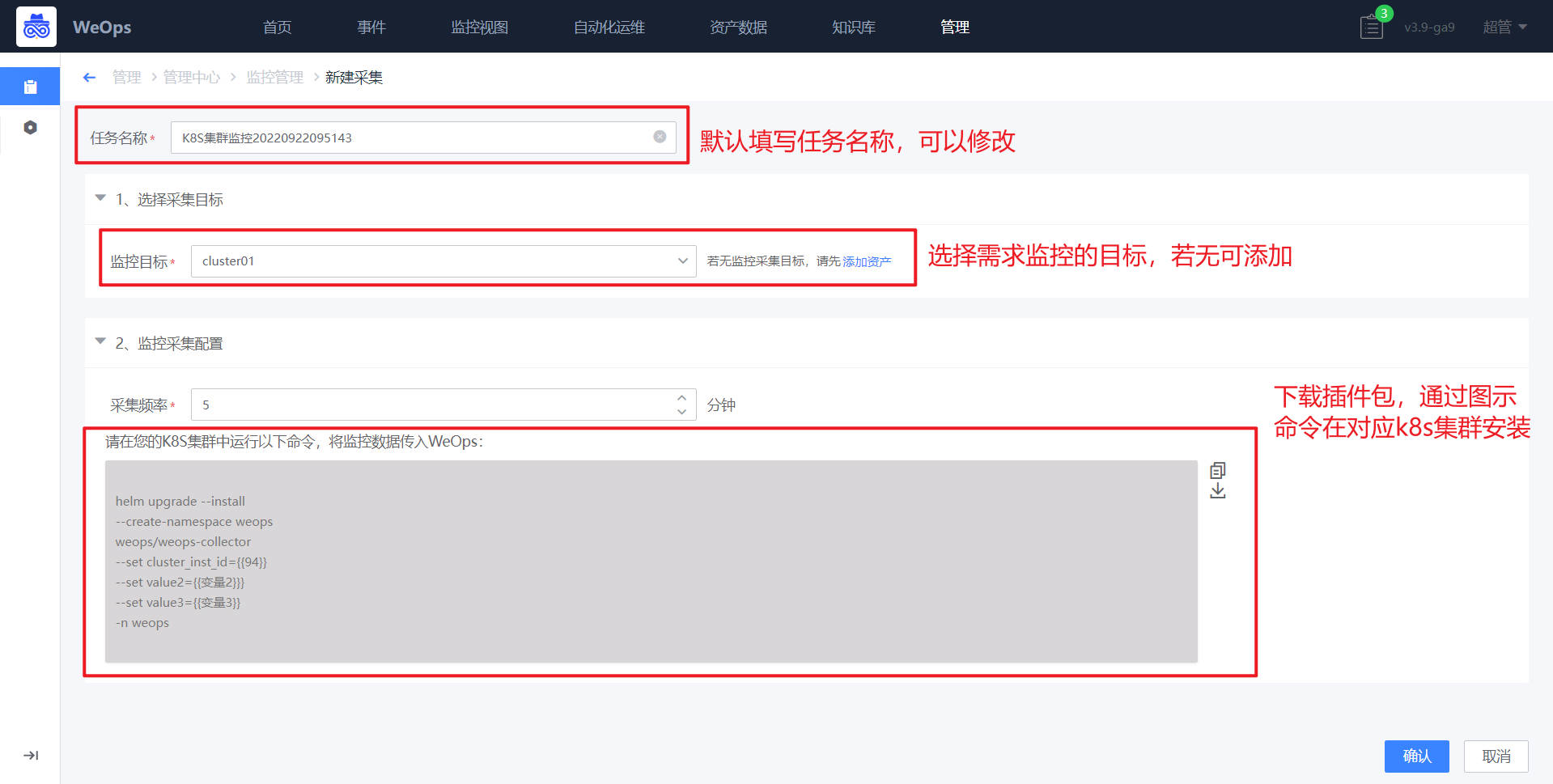

- 如下图,进入监控采集页面,选择K8S,K8S采集任务的新建。

- 如下图,在采集新建界面,选择需要采集的K8S集群名称(若无可以在该页面进行添加)、配置采集频率,进行K8S监控需要将对应的安装包安装到对应的k8s集群里面,可以从该界面下载安装包,并运行一下命令进行部署

- 【注】 监控的采集安装包和自动发现的一样的,如果该K8S已经在自动发现时进行了的部署,配置监控采集时可以省去“部署安装包”这一步操作

注:有以下两种情况

(1)若集群可以使用公网镜像源时,解压安装包,进行安装即可

tar -zxvf weops-kubernetes.tgz

helm install weops-collecter weops-kubenetes-discovery-3.11.0.tgz -n weops --create-namespace --set remoteWrtieUrl=http://$(接收数据的Prometheus IP,一版为weops的appt ip):$(接收数据的Prometheus端口,一般为9093)/api/v1/write

(2)若不能使用公网镜像源时,需要先手动导入镜像并推送到私有仓库中,当集群不能使用公网镜像源时,需要手动导入镜像并推送到私有仓库中,压缩包里附带了需要用到的镜像文件,kube-state-metrics.tgz,node_exporter.tgz,cadvisor.tgz,prometheus.tgz

需要在helm install时指定本地仓库镜像helm install weops-collecter weops-kubenetes-discovery-3.11.0.tgz -n weops --create-namespace \

--set remoteWrtieUrl=http://$(接收数据的Prometheus IP,一般为weops的appt ip):$(接收数据的Prometheus端口,一般为9093)/api/v1/write \

--set image.repository=$(prometheus的私有仓库,如10.10.10.10:5000\prometheus) \

--set kube-state-metrics.image.repository=$(kube-state-metrics的私有仓库,如10.10.10.10:5000\kube-state-metrics) \

--set cadvisor-exporter.image=$(cadvisor的私有仓库,如10.10.10.10:5000\cadvisor):latest \

--set node-exporter.image=$(node-exporter的私有仓库,如.10.10.10:5000\cadvisor):latestStep2:监控策略配置(以node为例)

路径:管理-监控管理-监控策略(K8S)

- K8S集群监控采集新建完成以后,可以对pod和node进行监控策略的配置。

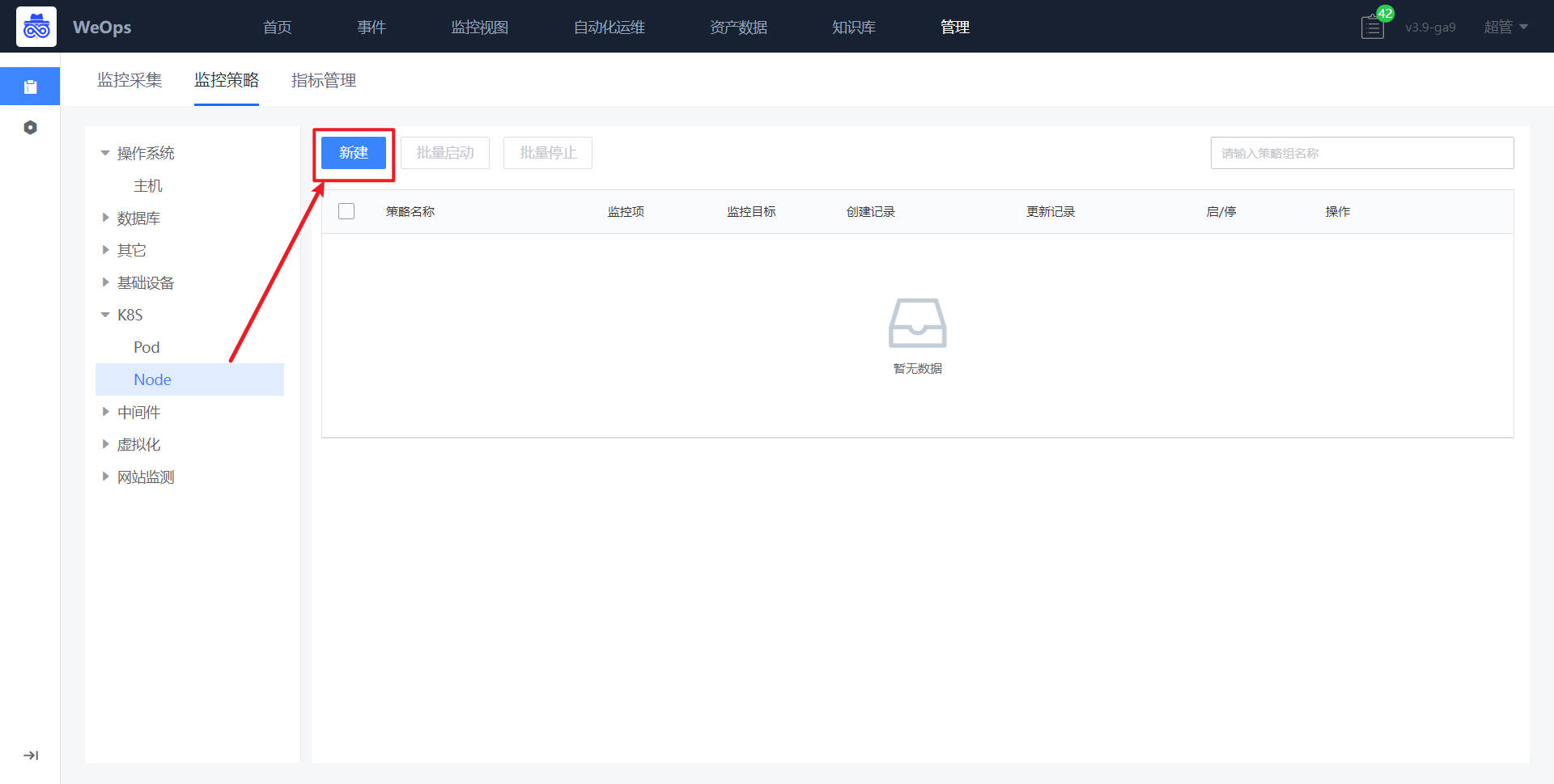

- 如下图,进入到监控策略页面,选择K8S-node,点击“新建”按钮

- 在新建界面,策略名称、和监控对象已经默认填写。

- 如下图,点击“选择监控目标”,进行监控对象的选择

*如下图,点击“添加监控项配置”,可进行监控项的选择和配置,这里需要说明的是,由于K8S的特性,监控目标(pod和node)常常处于变化中,可以采取设置监控维度的方式,对某个集群/某个命名空间/某个工作负载下的pod/node进行监控策略的配置,配置成功后,无需选择具体的监控目标,该策略即可生效。

- 监控策略配置完成后,若采集的监控数据超过设定的阈值,则按照致命/预警/提醒三个等级进行告警。

- 下一步“告警配置”可查看“2.2告警配置”

网络设备监控配置(以交换机为例)

背景介绍:需要将网络设备纳入监控中,并配置相应的监控策略,前提是已经将网络设备手动/自动发现纳入到资产中了

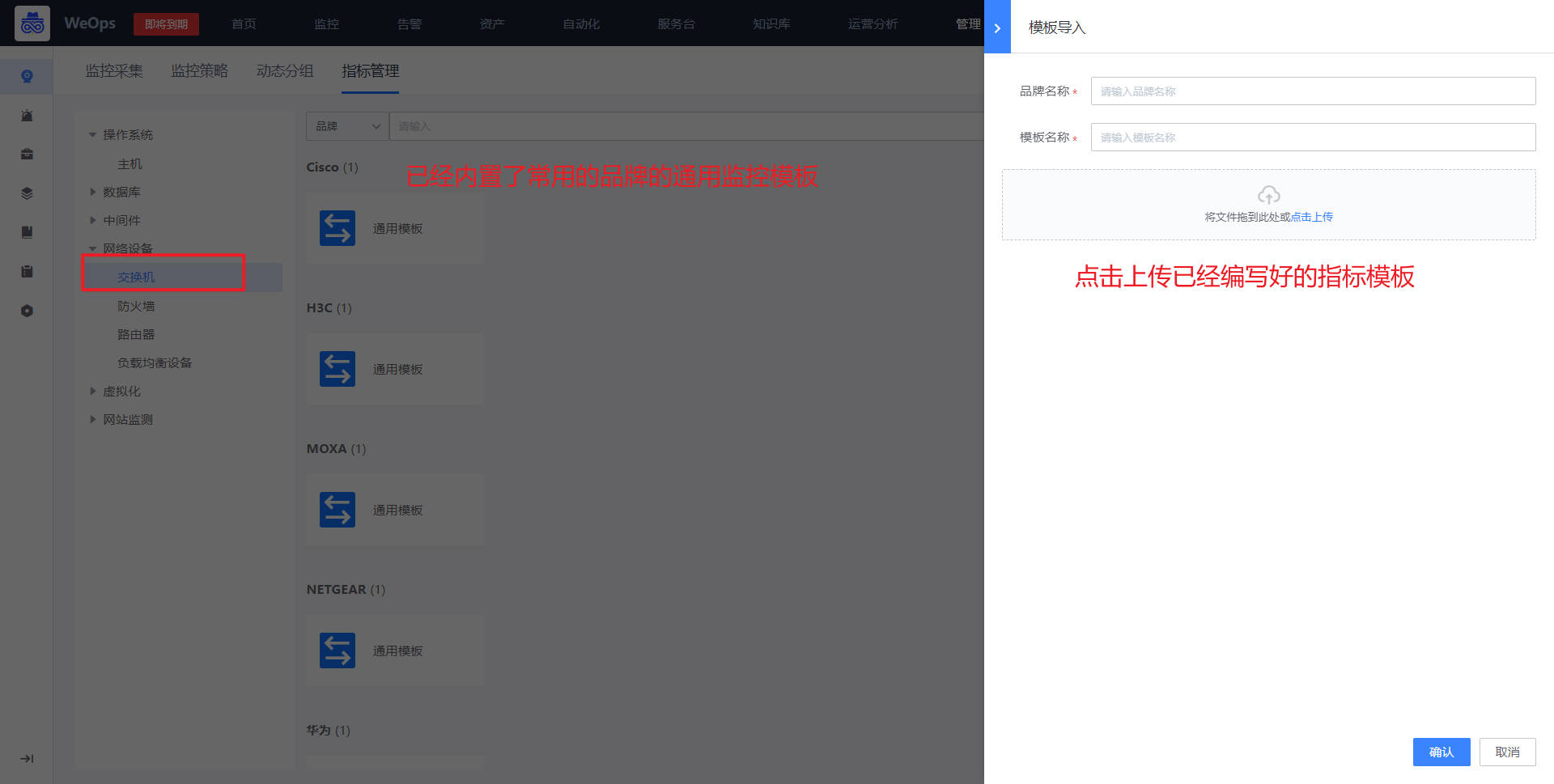

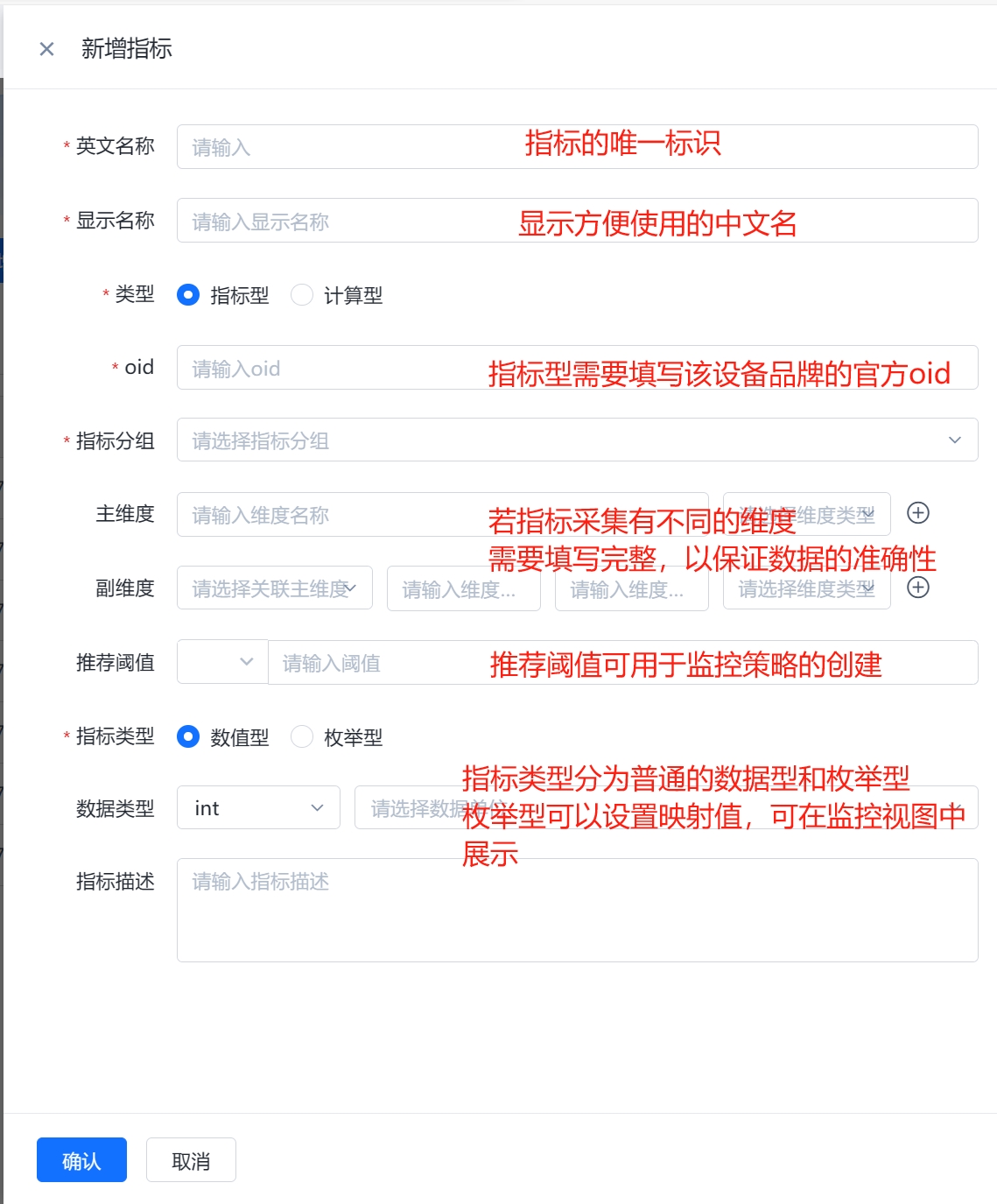

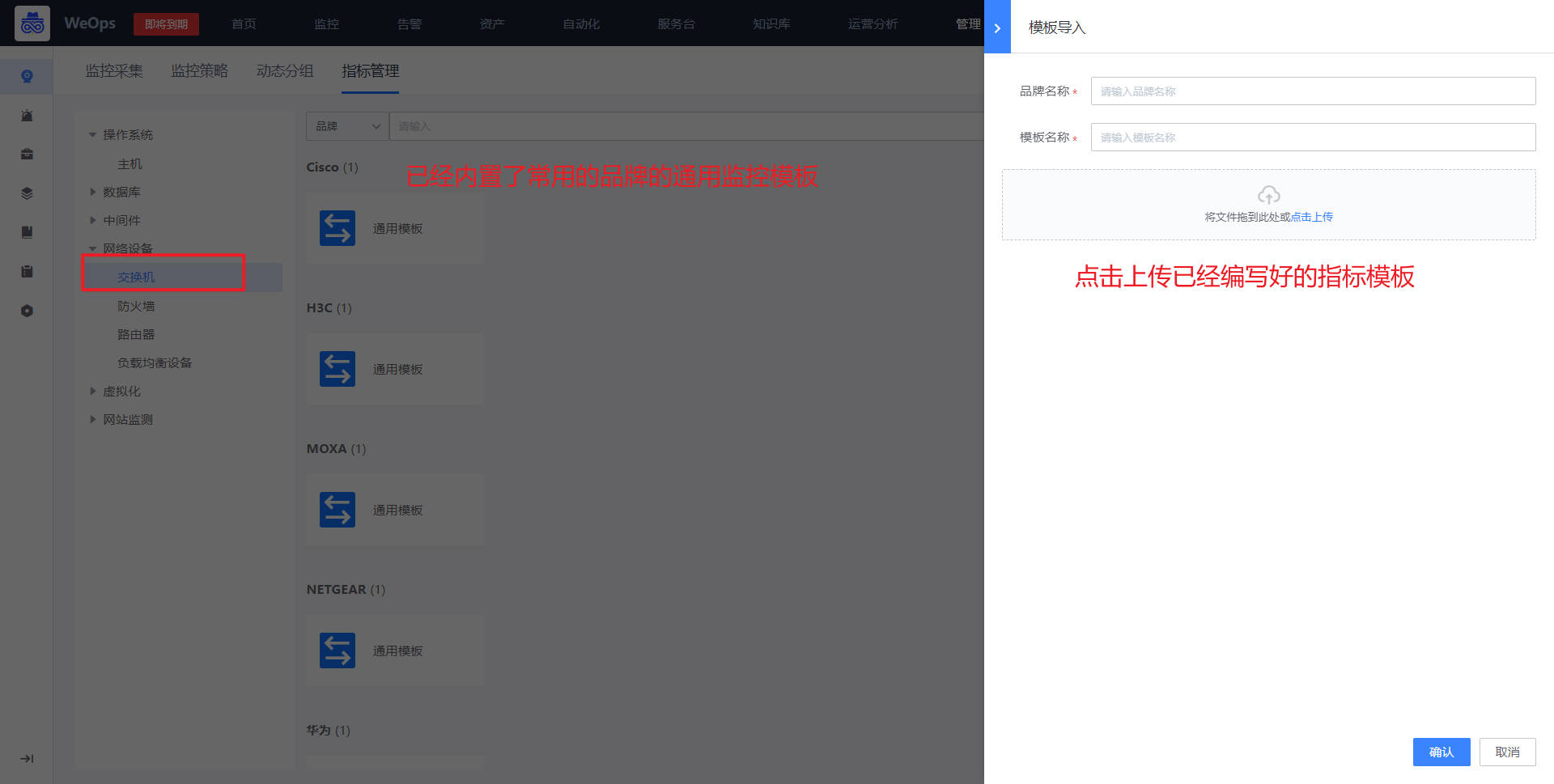

Step1:导入/新建网络设备指标模板

路径:管理-监控管理-指标管理

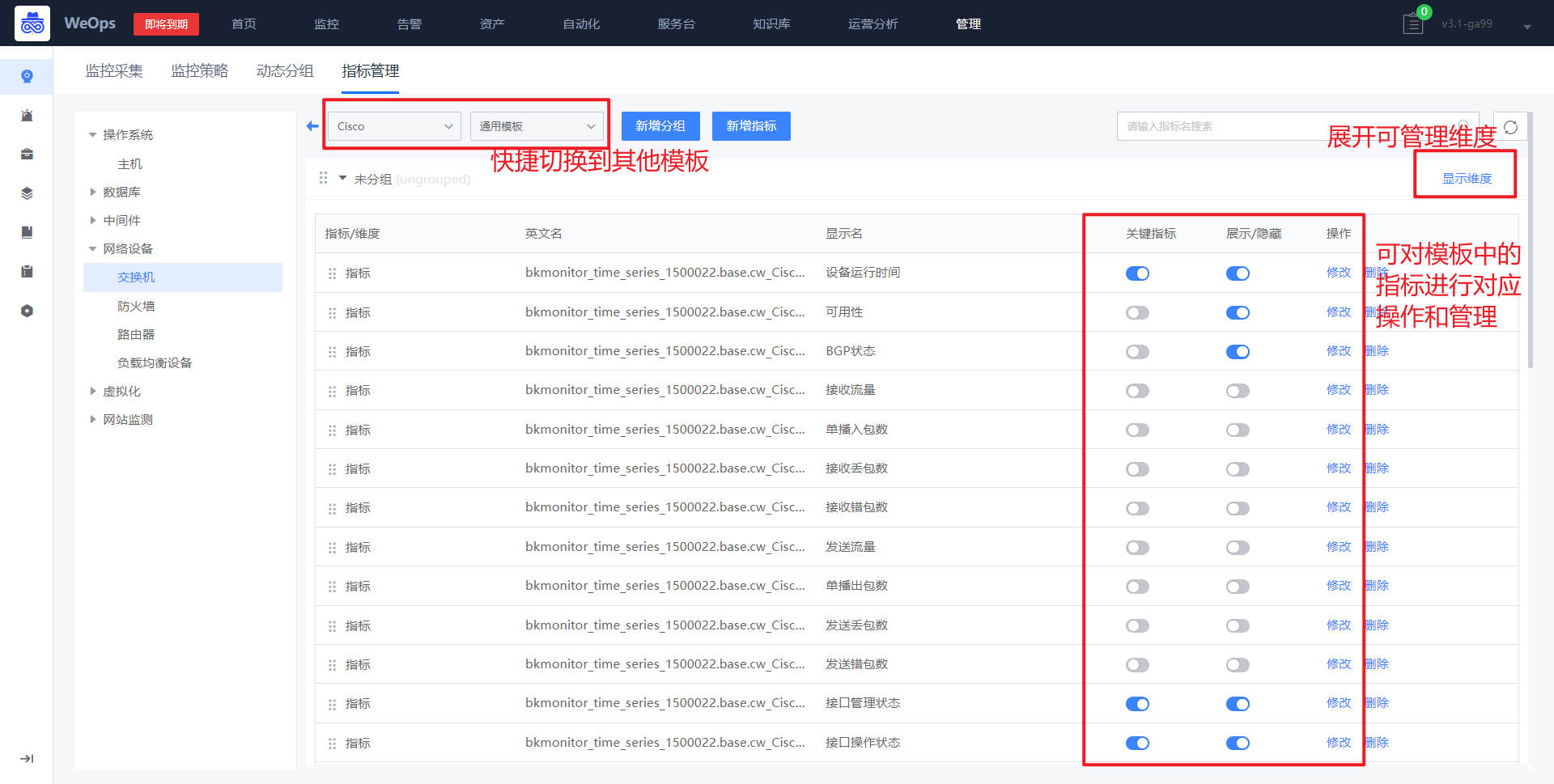

如下图,在指标管理中,选择网络设备-交换机,点击导入模板,可以进行不同品牌和型号的指标模板导入(WeOps提供了网络设备指标模板导入的入口,可监控的设备品牌、型号等支持拓展。)

如下图,对于导入好的指标模板可以进行对应维度/指标的编辑,便于后续使用。

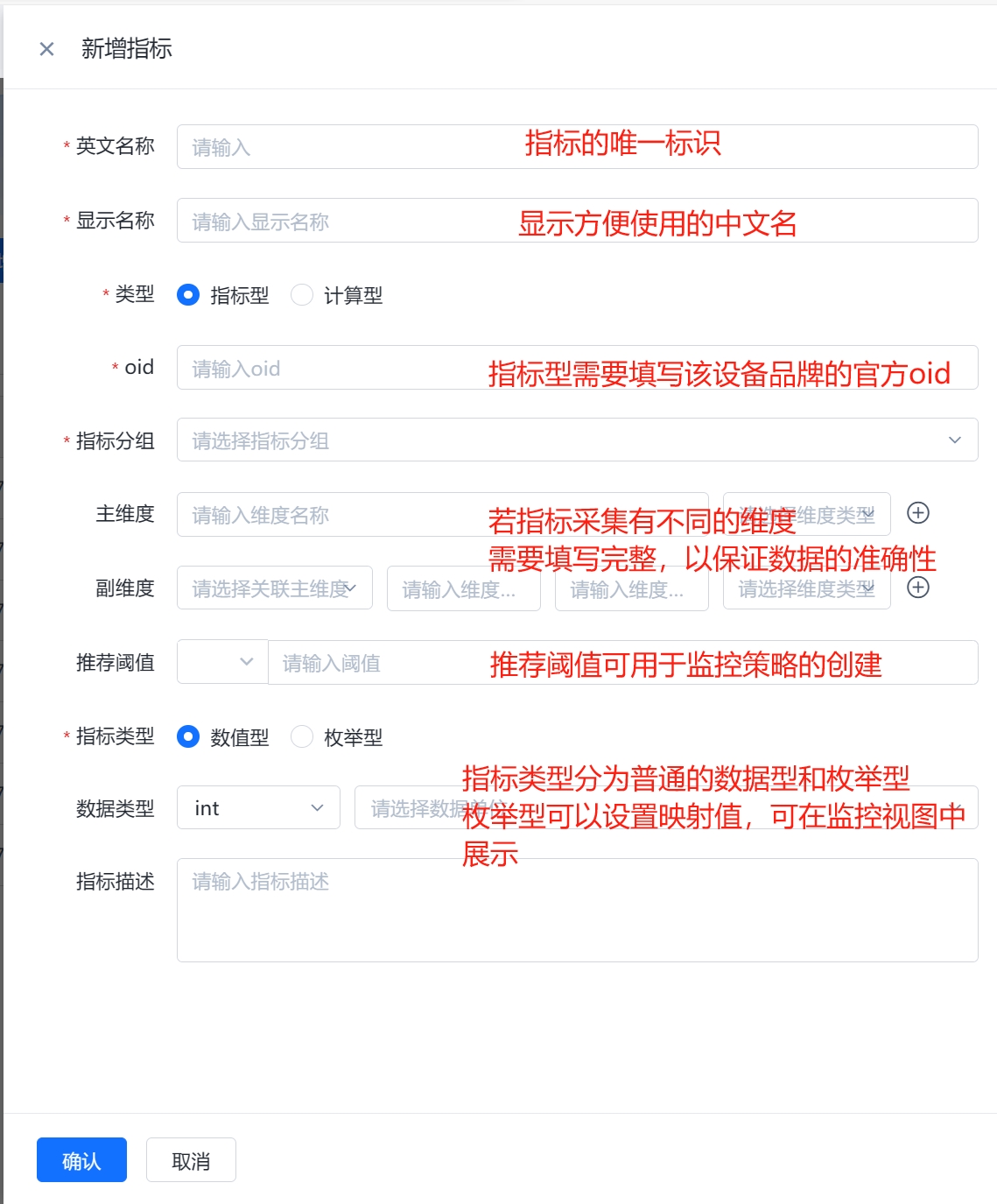

也可以进行指标的新建,具体说明如下

(1)指标型:指标型指标是通过设备的OID(对象标识符)来采集设备的实际数值。所以当某个指标可以找到对应oid进行数据采集时,可以创建指标型指标进行采集。

(2)计算型:对指标型指标的数值进行计算得到的指标。计算型指标可以用于更细粒度地监控设备性能,在计算型指标的公式中,需要引用现有指标,可以采用(指标英文名{template_id})的格式进行引用,公式中固定变量“template_id”为指标所在的模板ID,固定不变。比如“irate(ifOutOctets{template_id}[5m])”。

Step2:监控采集

当需要监控的网络设备已经纳管,并且有适用的监控指标模板(可以是内置的,也可以是导入创建的),可以对网络设备进行监控采集的创建,选择对应的目标,适用的指标模板,并填写凭据信息。

如下图,监控采集创建完成以后,可以在监控视图中,查看对应监控对象的监控信息

Step3:监控策略配置(以交换机为例)

- 网络设备监控采集新建完成以后,可以网络设备进行监控策略的配置。

- 如下图,进入到监控策略页面,选择网络设备-交换机,点击“新建”按钮

- 在新建界面,策略名称、和监控对象已经默认填写。点击“选择监控目标”,进行监控对象的选择点击“添加监控项配置”,可进行监控项的选择和配置

- 监控策略配置完成后,若采集的监控数据超过设定的阈值,则按照致命/预警/提醒三个等级进行告警。

- 下一步“告警配置”可查看“2.2告警配置”

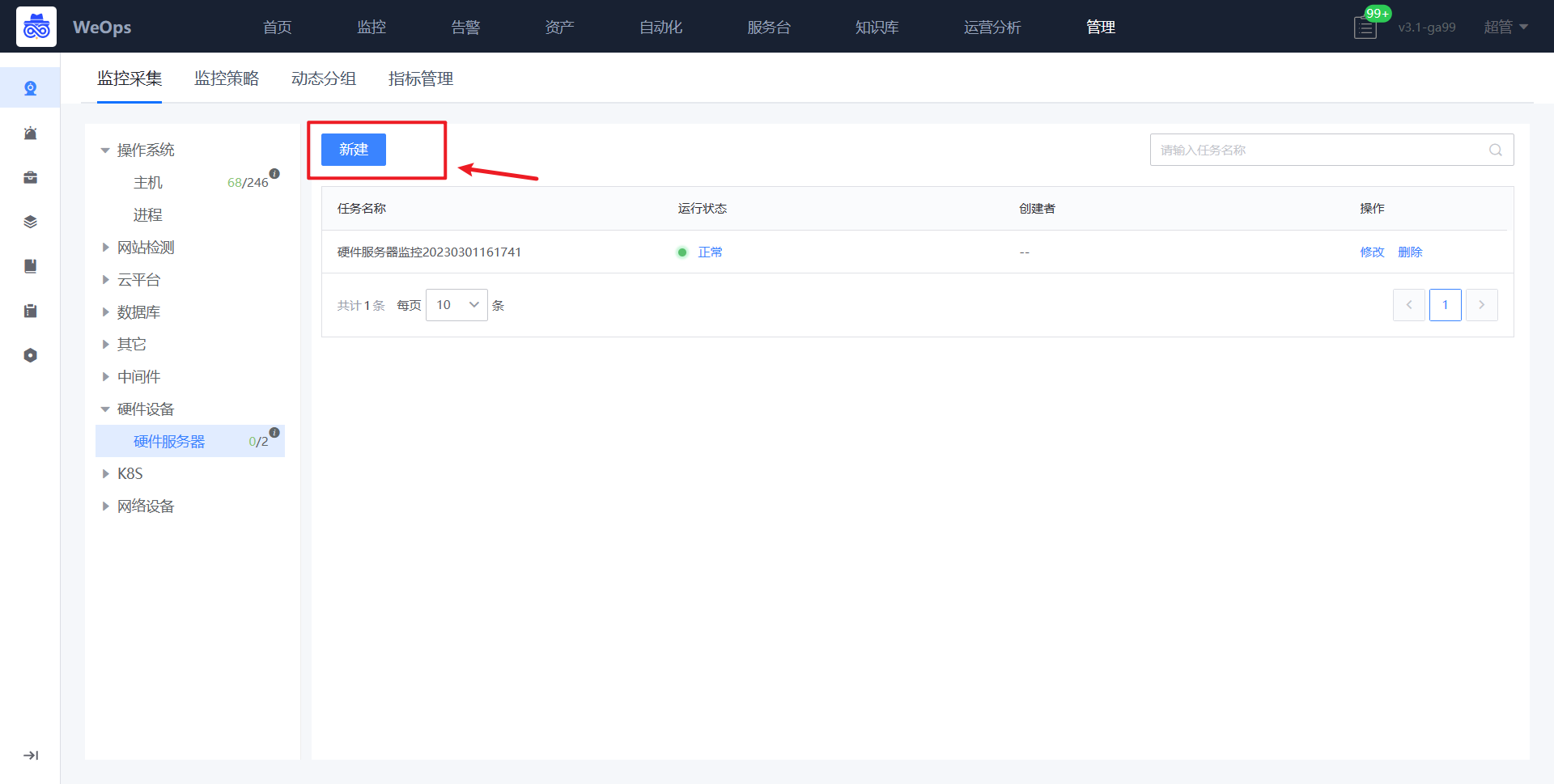

硬件设备监控配置

背景介绍:需要将硬件设备纳入监控数据采集中,并设置对应监控策略。

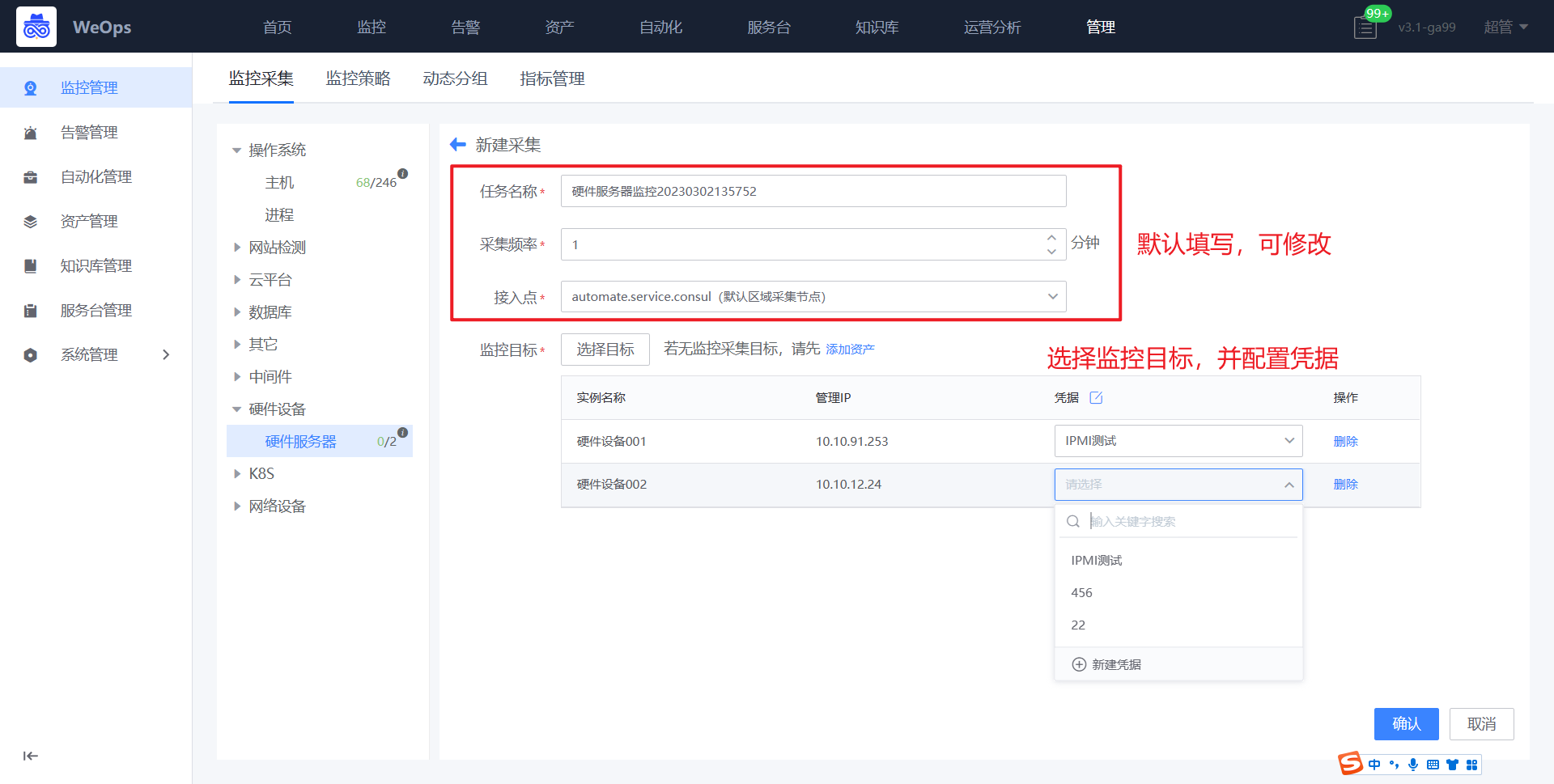

注意:ipmi采集暂时不支持自定义端口Step1:监控采集

路径:管理-监控管理-监控采集

- 如下图所示,进入硬件服务器的监控采集界面,进行新增。

- 如下图所示,依次填写任务名称、腾讯云账号、对应凭据、采集频率等

- 新建完成后,可对该设置的硬件设备进行监控数据的采集,并可以在WeOps-监控视图-基础监控-硬件设备中查看已经采集监控数据和监控视图

Step2:监控策略配置

路径:管理-监控管理-监控策略(硬件监控)

- 如下图所示,进入到监控管理的监控策略页面,点击新增硬件设备-硬件服务器监控策略。

- 如下图所示,默认填写策略名称、监控对象,只需要选择监控项和监控目标即可(与主机监控策略配置操作一致)

- 监控策略配置完成后,若采集的监控数据超过设定的阈值,则按照致命/预警/提醒三个等级进行告警。

- 下一步“告警配置”可查看“2.2告警配置”

告警配置

背景介绍:监控对象已经进行监控数据采集,并配置好相关的监控策略,需要对产生的告警配置抑制、屏蔽、自动分派、自动处理等策略,或设置人员通知。各个对象的告警配置一致,此处介绍通用方法。

告警抑制

通过用户自定义配置告警抑制策略,让符合筛选条件的告警被抑制(即不会成为有效告警)。

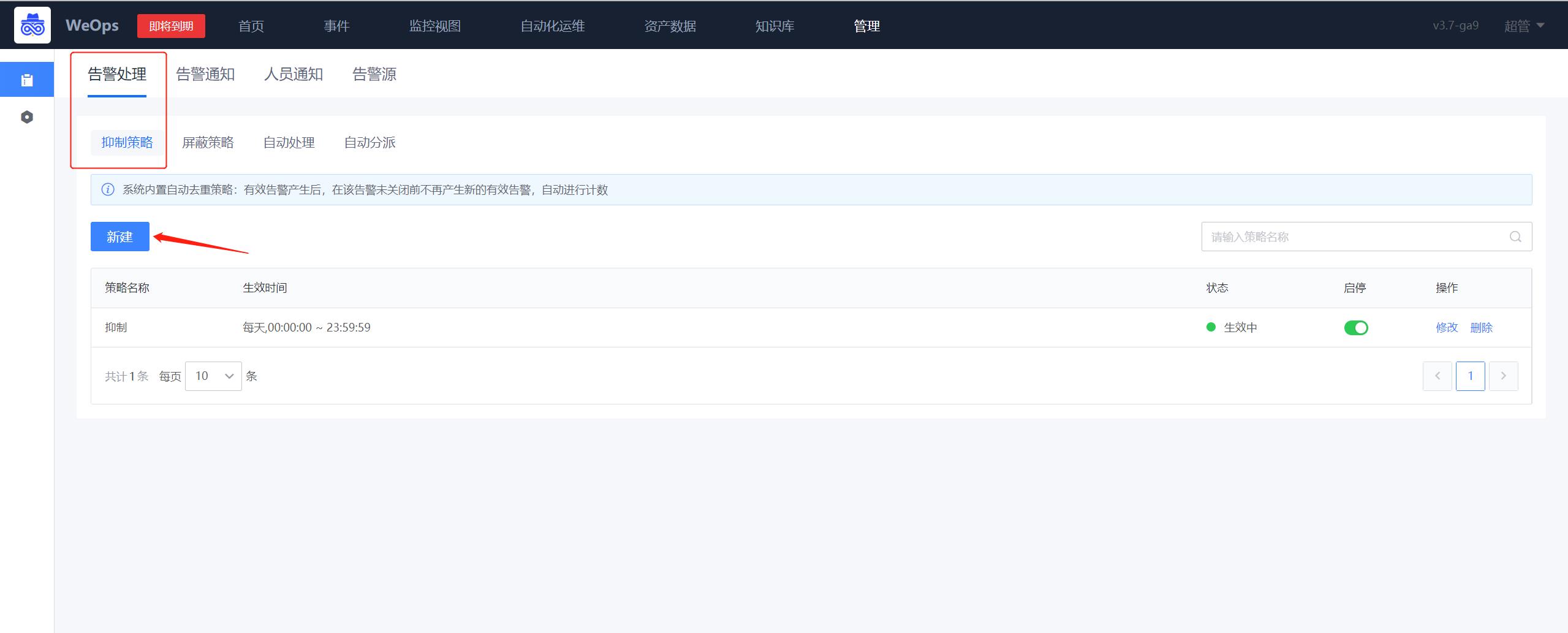

路径:管理-告警管理-告警处理-抑制策略

- 如下图所示,点击新增告警抑制策略规则。

- 如下图所示,按照如下指示输入匹配规则相关信息,随后点击提交即可完成配置。

注:目前有三种抑制策略

【第一种,内置的自动去重策略】:统一告警中心的告警都有一个告警事件 ID 字段,由告警源插件来设定这个字段的清洗规则,当一条告警成为有效告警后,在此条告警未关闭也未恢复的情况下,相同告警事件 ID 的告警自动被收敛。

【第二种,防抖抑制】:抑制抖动类指标偶发性产生的告警事件,如: CPU 使用率、内存使用率、磁盘 IO、网卡流量等

抑制规则: n 时间内出现 x 次则产生一条有效告警, 且告警关闭前不再产生新的告警。假设用户设定, 5min 内出现 4 次则产生一条有效告警;那么当告警中心接收到 1 条告警后,没有被自动去重,它会等待 5min,如果这 5 分钟内再次产生了 3 条及以上告警(除告警时间外,其他字段都相同),才会产生有效告警,5min 内产生的告警数量不足以达到数量要求,那这些告警全部被收敛,不会产生有效告警。

【第三种,关联聚合】:将关联字段相同的告警聚合,如: 7 分钟内“ 告警源+告警指标+告警对象+CMDB 业务+告警等级” 告警相同的告警聚合为 1 条有效告警。

聚合:第一条有效告警产生后,如果设定的时间窗口内产生关联字段相同的告警,那么这些告警被收敛。

执行顺序:如果一条告警被接收到后,之前没有相同告警事件 ID 的有效告警,则自动去重无法生效,执行告警抑制策略匹配,待产生有效告警后,后续接收的,相同告警事件 ID 的告警,会被自动去重;如果一条告警被接收到后,之前已有相同告警事件 ID 的有效告警,则优先执行自动去重,不会也不必再去执行抑制策略。告警屏蔽

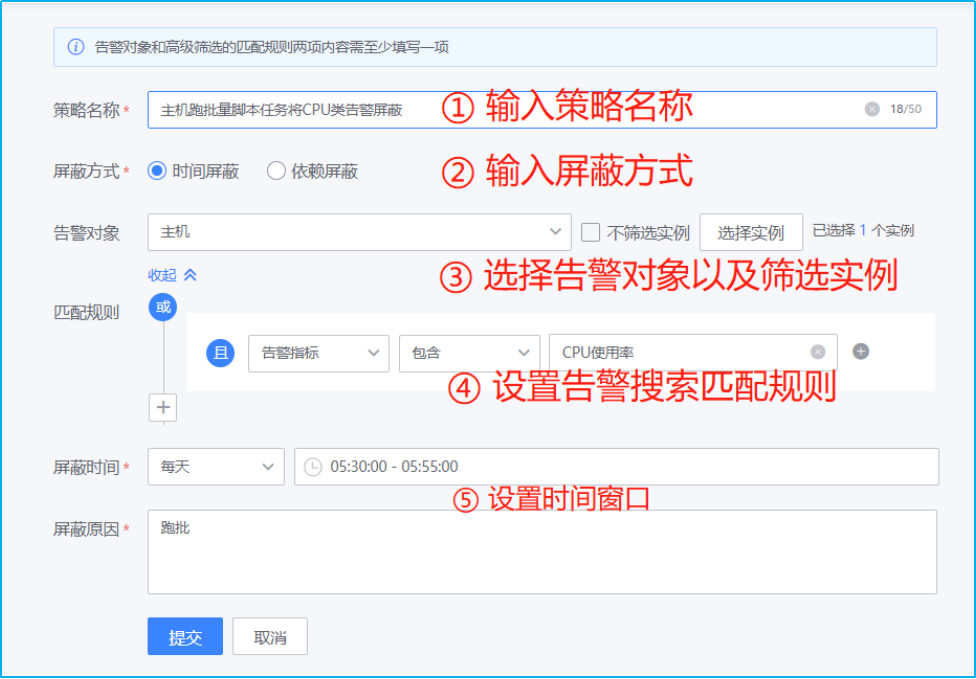

某些主机在执行一些日常任务的时候,例如定时备份任务,会导致CPU或是磁盘IO超过监控阈值。生成了”无效”告警,故可以采取该功能进行将特定条件下生成的告警事件进行屏蔽。

路径:管理-告警管理-告警处理-屏蔽策略

- 如下图所示,点击新增告警屏蔽策略规则。

- 如下图所示,按照如下指示输入匹配规则相关信息,随后点击提交即可完成配置。

注:支持两种屏蔽方式:时间屏蔽(即维护期屏蔽,按时间段屏蔽符合筛选条件的告警)、依赖屏蔽(当符合 A 筛选条件的告警产生时,屏蔽之后 XX 时间段内的符合B 筛选条件的告警)。告警自动处理

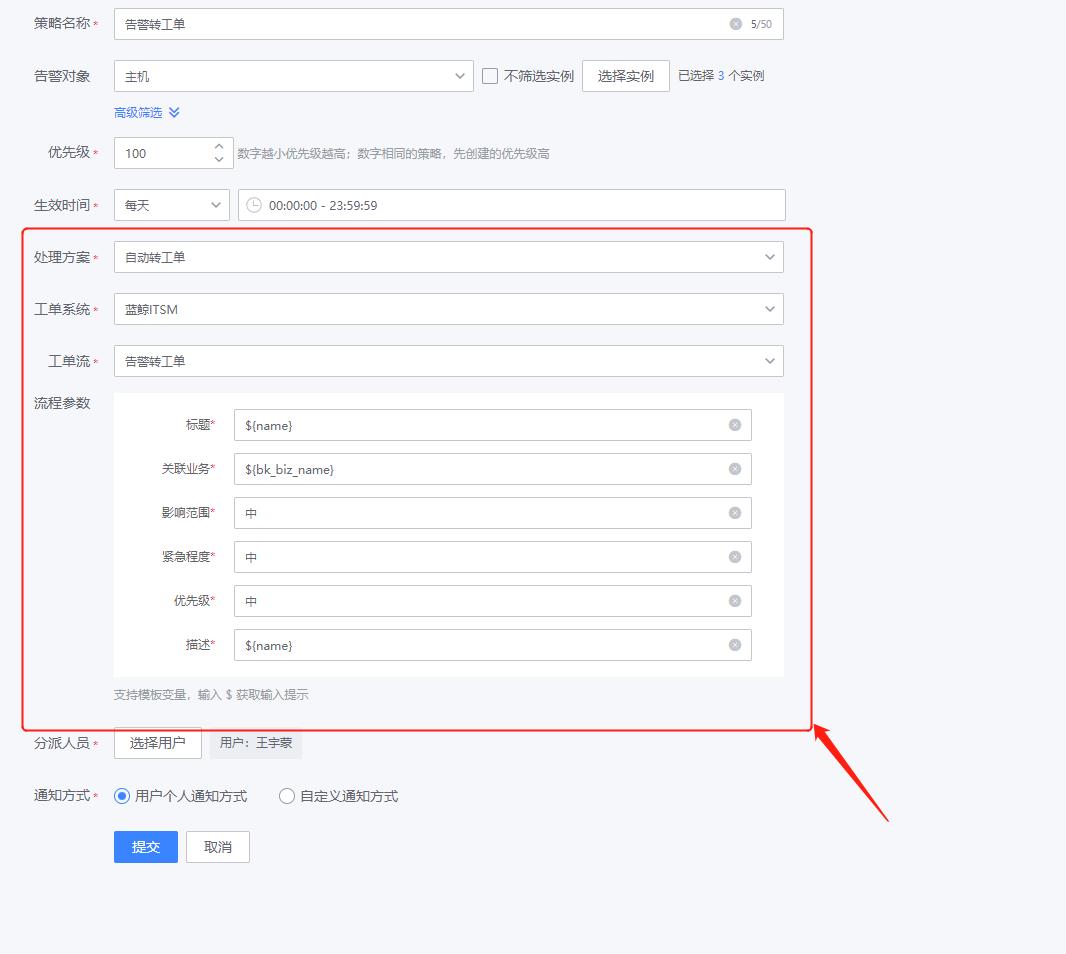

管理-告警管理-告警处理-自动处理

- 如下图所示,点击新增告警处理策略规则

- 如下图所示,新建页面,配置自动处理策略,让符合筛选条件的告警,根据策略优先级执行自动处理方案(包括自动转工单、自愈处理、自动关闭),可设置策略优先级、生效时间、分派人员、通知方式等

优先级: 1~100,数字越小执行该条策略的优先级越靠前,相同优先级数字的策略,创建时间早的的优先级更靠前。

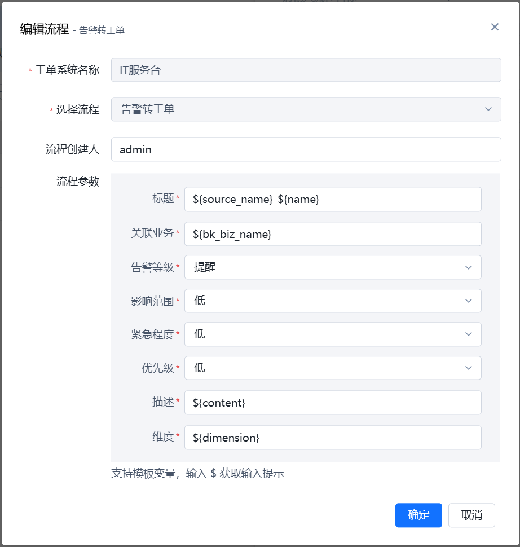

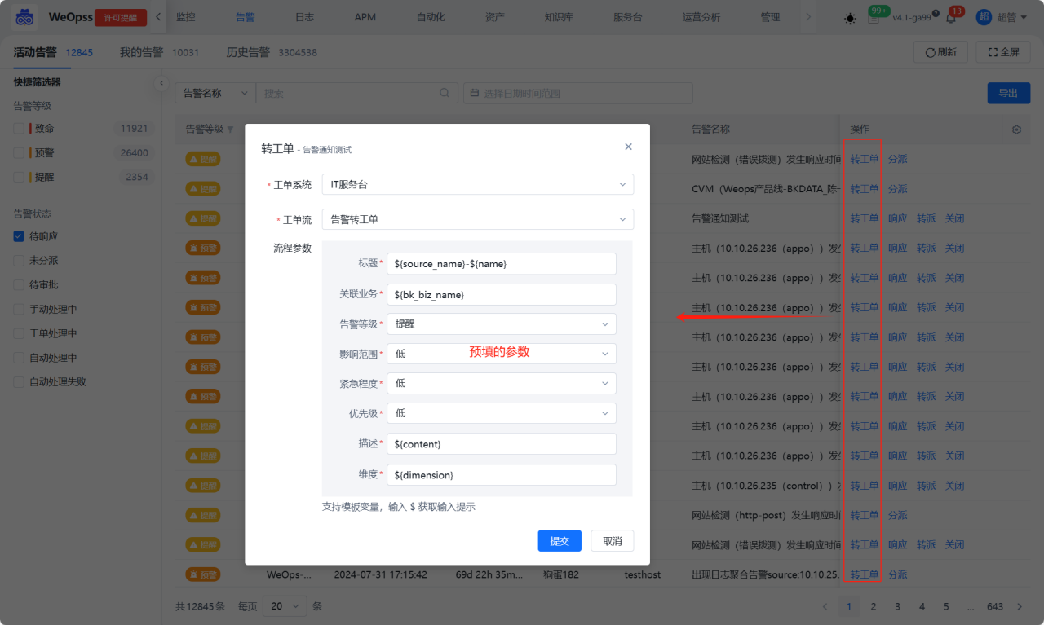

分派人员:可根据组织目录的展开,选择用户;也可切换为全部用户,对用户名进行模糊搜索;还可以选择用户组(包括内置通知用户组和统一告警中心用户与组页面创建的用户组)。这里特殊说明下告警转工单,在“自动处理”中选择处理方案为“自动转工单”,按照工单模块内置的告警转工单流程进行相关字段的填写,设置完成后,符合该策略的告警将会转为工单处理,工单处理结束后,告警会自动关闭。

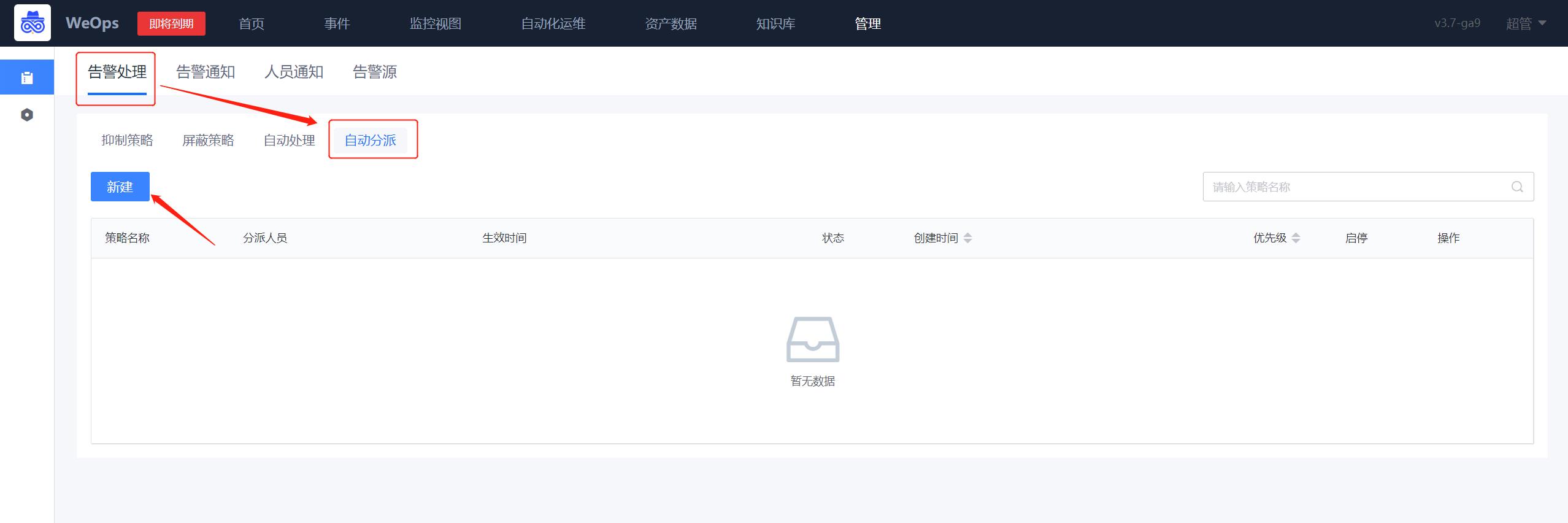

告警自动分派

配置告警自动分派策略,让符合筛选条件的告警,分派给指定人员或用户组,并可选添加附言、是否通知、通知方式等,这里以【短信】通知的形式来进行介绍

路径:管理-告警管理-告警处理-自动分派

- 如下图所示,进入到告警分派的界面,点击新增告警分派规则。

- 如下图所示,在第②步选择告警对象,若是不筛选实例则勾选【√不筛选实例】,若是需要筛选则按照第③步进行oracle主机的选择。随后按照第④步添加告警通知人员。在第⑤步选择“自定义通知方式-短信“。随后点击保存即可完成配置。

*分派策略优先级,同处理策略,优先级1~100,数字越小执行该条策略的优先级越靠前,相同优先级数字的策略,创建时间早的的优先级更靠前。

*优先执行告警处理策略,其后再执行告警分派策略。

*支持分派升级,当告警被分派,且分派用户在设定时间内未响应,可以升级分派给其他人,支持多级升级通知。还可设置分派通知规则,当告警未响应/未关闭时,重复通知给被分派用户。

*可设置通知频率,当告警未响应/未关闭时,重复发送通知。

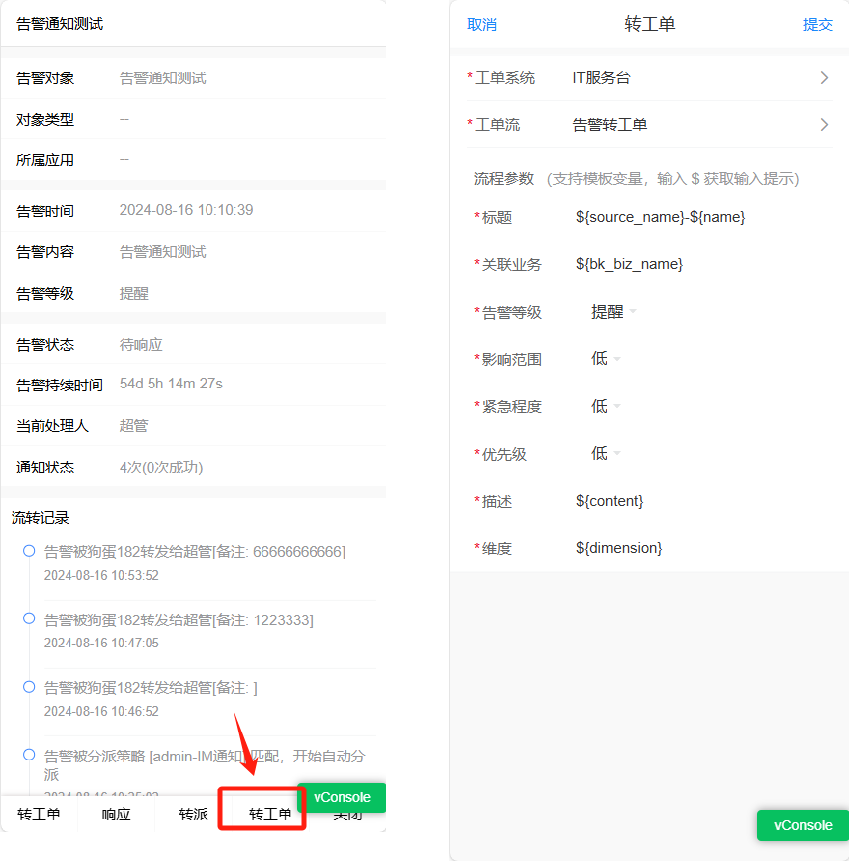

*当告警的触发时间与恢复时间间隔少于一分钟,我们将其视为偶发且无效的告警,并不会发送告警通知。告警转工单

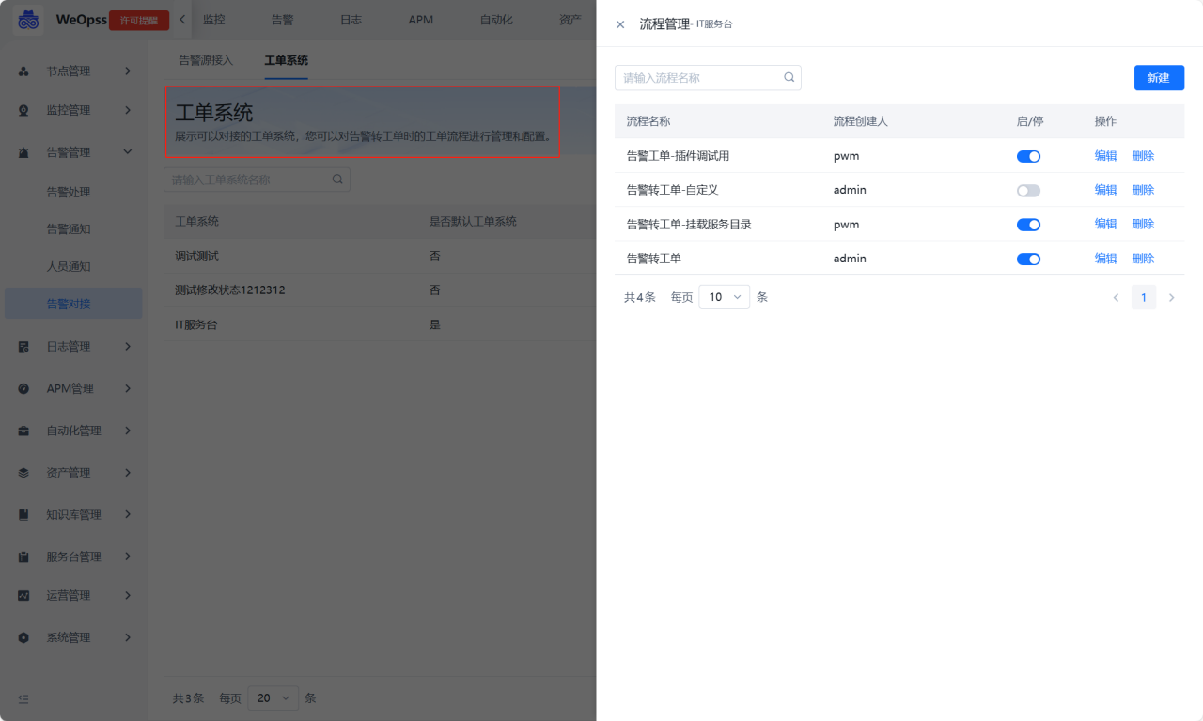

为了让告警故障处理更加规范化,可以在工单系统留存相关信息和处理方案,WeOps支持接入不同的工单系统,并支持使用该工单系统的流程服务作为告警转工单的流程。

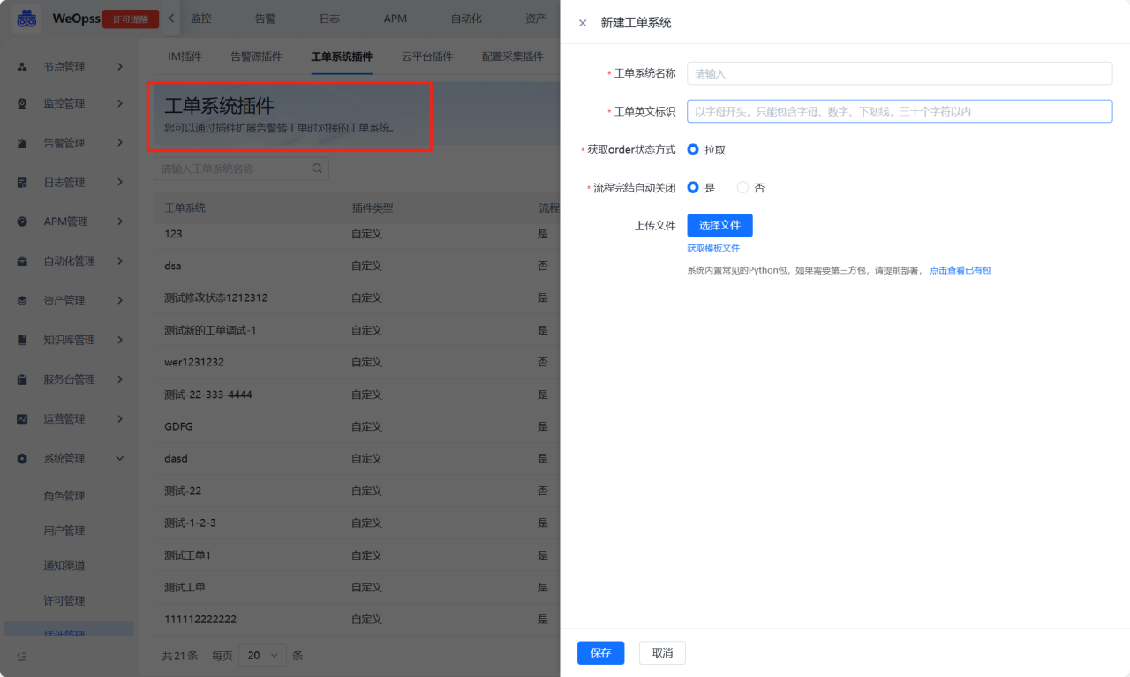

(1)工单系统插件

支持通过插件的方式新增工单系统,以便转工单时选择

(2)系统配置

支持选择使用的工单流程,并对系统的工单选择使用。已经内置的IT服务台系统,只能选择使用“事件类”的服务。

针对各个流程服务支持定义流程的默认参数,定义好后,在手动转工单时,就不需要填写参数,可以直接使用默认参数进行调整即可。

(3)手动转工单

PC端和移动端均支持转工单,两类情况下支持手动转工单: ①状态为未分派、待响应的告警 ②状态为手动处理中,且处理人是我的告警

人员通知

路径:管理-告警管理-人员通知

- 如下图,进入通知配置界面,选择对应的用户,点击“配置”按钮,可以进行通知方式的配置,可选“邮件、短信、企业微信、电话”等形式

动态分组配置

背景介绍:当监控策略的监控对象经常变动的时候,可以采用动态分组的方式,设置动态分组并设置监控策略。

分组设置

路径:管理-监控管理-动态分组

如下图,点击“新建“按钮,可以针对不同的对象,设置不同的分组条件。设置完成后,符合添加的对象会动态展示,一旦对象发生变化,该动态分组也会发生变化

分组效果

路径:管理-监控管理-监控策略

如下图,在监控策略中,选择监控目标的时候,可以选择该分组,当对象发生变化的时候,动态分组里面的对象也会对应变化,保证该监控策略始终监控的是符合条件的对象。

监控指标配置

监控指标通用配置

背景介绍:监控对象已经纳管进来,并进行监控指标采集,需要对监控指标进行管理和分组,便于在监控视图中更方便的查看各个指标视图。

指标管理设置

路径:管理-监控管理-指标管理

如下图可以对指标的分组、设置关键指标、指标内容等方面的设置/编辑

- 指标分组:针对不同对象可以进行指标分组新建,分组创建完成后,可以通过拖拽的方式把指标拖拽至对应分组中。

- 设置关键指标:可以将指标设置为“关键指标”,设置成功后,在监控视图的顶端就可以看到“关键指标”的分组。

- 指标编辑:支持对指标的显示名、分组、推荐阈值和描述进行编辑,可以修改指标类型,对于枚举值的指标可以设置映射值,设置成功后可以在对应的监控视图看到设置的映射值。

- 指标维度:展示对应指标的维度,可以对维度的显示名,是否显示等进行编辑

指标视图展示

路径:监控视图-应用/基础监控-主机/数据库/中间件等

如下图,指标管理配置完成后,在“监控视图-应用/基础监控”中的监控视图抽屉中,可以看到分组后的监控视图。

- 关键指标:标为关键指标的指标,在监控视图中的顶端可以看到“关键指标”的分组以及对应指标视图

- 指标分组:按照后台设置的分组情况进行展示,可进行搜索和条件筛选等操作

自定义监控插件(脚本插件)

背景介绍:脚本的是一种灵活和快速的监控采集方式,不同层的监控对象都可以用本来完成。只要目标对象能够提供对应的脚本运行环境,就有对应的命令或脚本方法能够获取相应的指标数据; 此类型插件由于是调用已经封装好的命令,导致性能较低,采集耗时和资源占用多。

支持的脚本有:

Linux:Shell,Python

Windows:Shell,Python,PowerShell

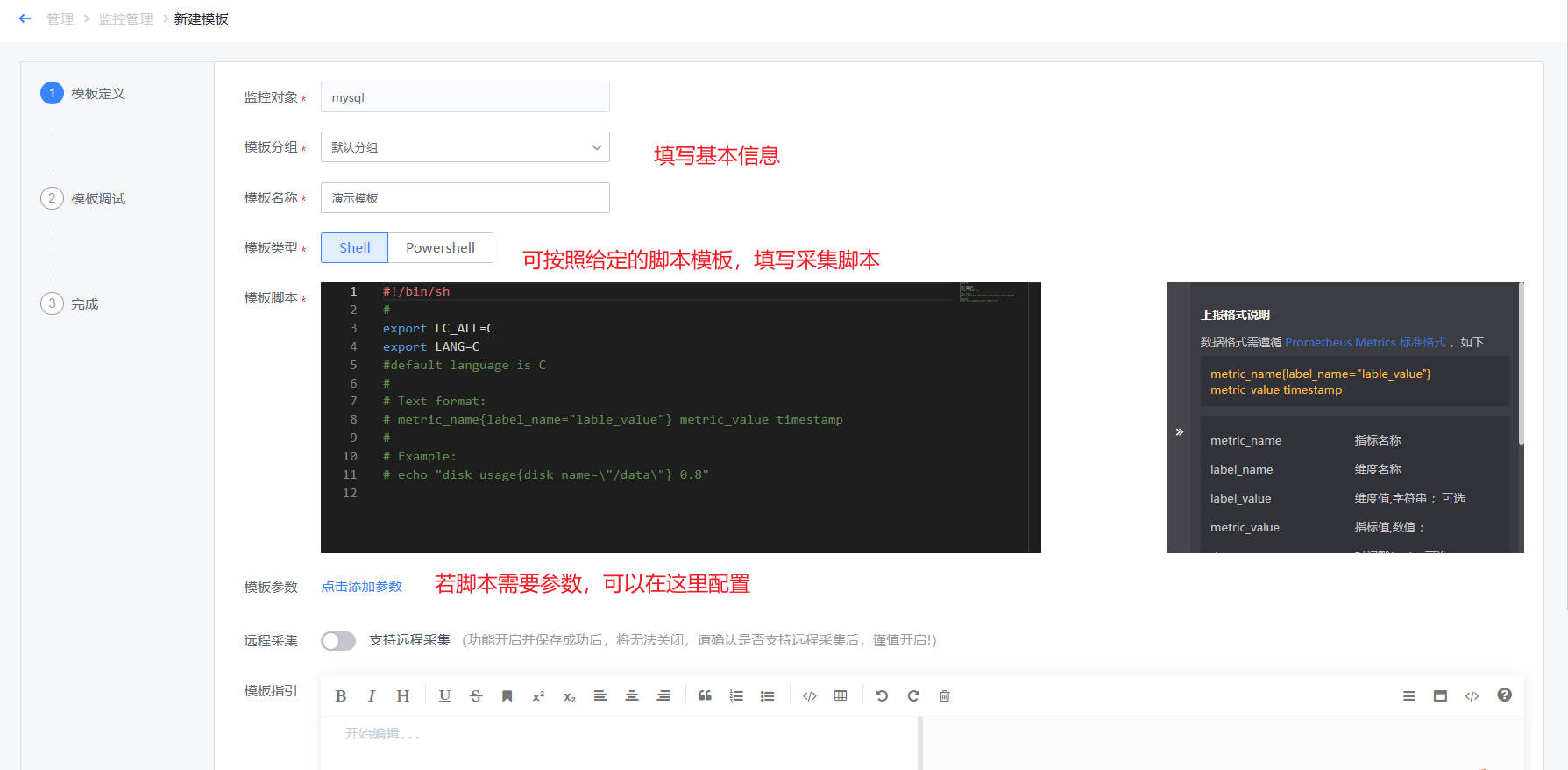

脚本(Script)适用的对象有:操作系统、数据库、中间件

Step1:自定义插件制作

路径:管理-监控管理-监控指标-新建模板

如下图,点击“新建模板”,进入到插件定义页面,脚本插件的制作分为三步:插件定义、插件调试、编辑指标和维度等信息

- 第一步,插件定义:如下图,需要填写插件基本信息、脚本内容、参数信息等。若需要定义监控采集时需要的参数,可以点击新增参数,并在脚本中用$1、$2来确定位置参数

接下来以 磁盘使用率为例 为例实现脚本采集以及指标监控,脚本内容可参考如下脚本格式

#!/bin/bash

#获取磁盘使用率

disk_name="$1"

diskUsage=`df -h | grep ${disk_name} | awk -F '[ %]+' '{print $5}'`

echo "disk_usage{disk_name=\"${disk_name}\"} ${diskUsage}"- 脚本参数,脚本中使用到的参数以$1、$2等来确定位置参数,并填写在参数定义中,以便后续下发时填写。

- 输出格式

echo "disk_usage{disk_name=\"${disk_name}\"} ${diskUsage}"●指标名:disk_usage 是一个自定义的指标名称,表示磁盘使用率。

●维度 :{disk_name=\”${disk_name}\”} 是一个维度部分,用于进一步描述或区分指标。包含一个键值对:disk_name 是标签的键。\”${disk_name}\” 是值,表示传入的磁盘名称。注意,这里使用了反斜杠 \ 来转义双引号,使得双引号作为字符串的一部分被保留下来。

●指标值 :${diskUsage} 是实际的指标值,即磁盘的使用率。它是通过前面的命令(df -h | grep ${disk_name} | awk -F ‘[ %]+’ ‘{print $5}’)提取出来的。

执行结果示例如下

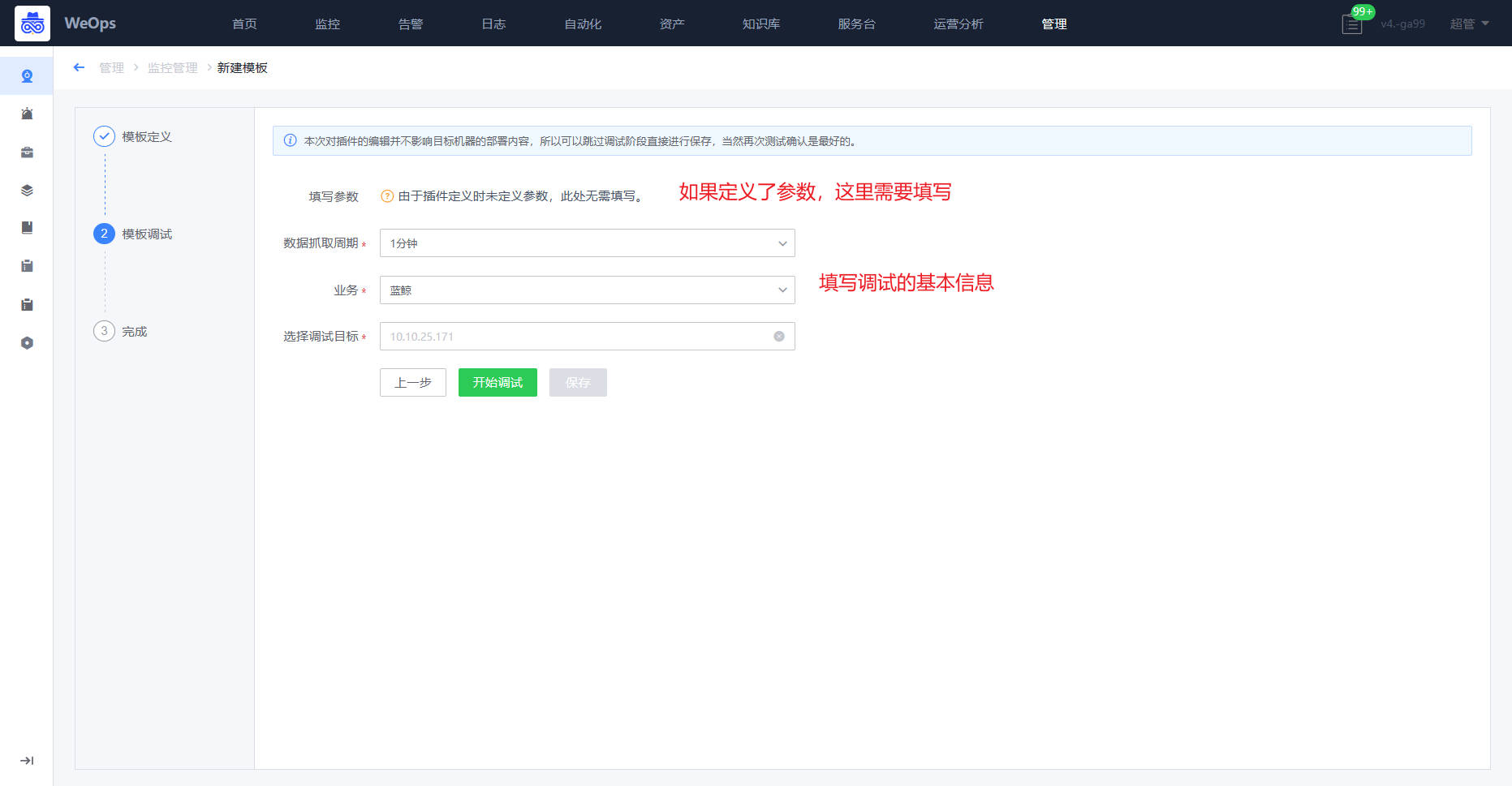

disk_usage{disk_name="/dev/sda1"} 75%- 第二步,进行调试,这里的服务和下发都是测试联调的。填写的内容在后面的监控采集配置是一样的,主要就是为了验证插件制作是否合理,结果是否如预期。

- 注意:整个调试过程超时时间为 600 秒,如果 600 秒内没有保存就会关闭这个调试过程,保证服务器上不会有残留的调试进程。

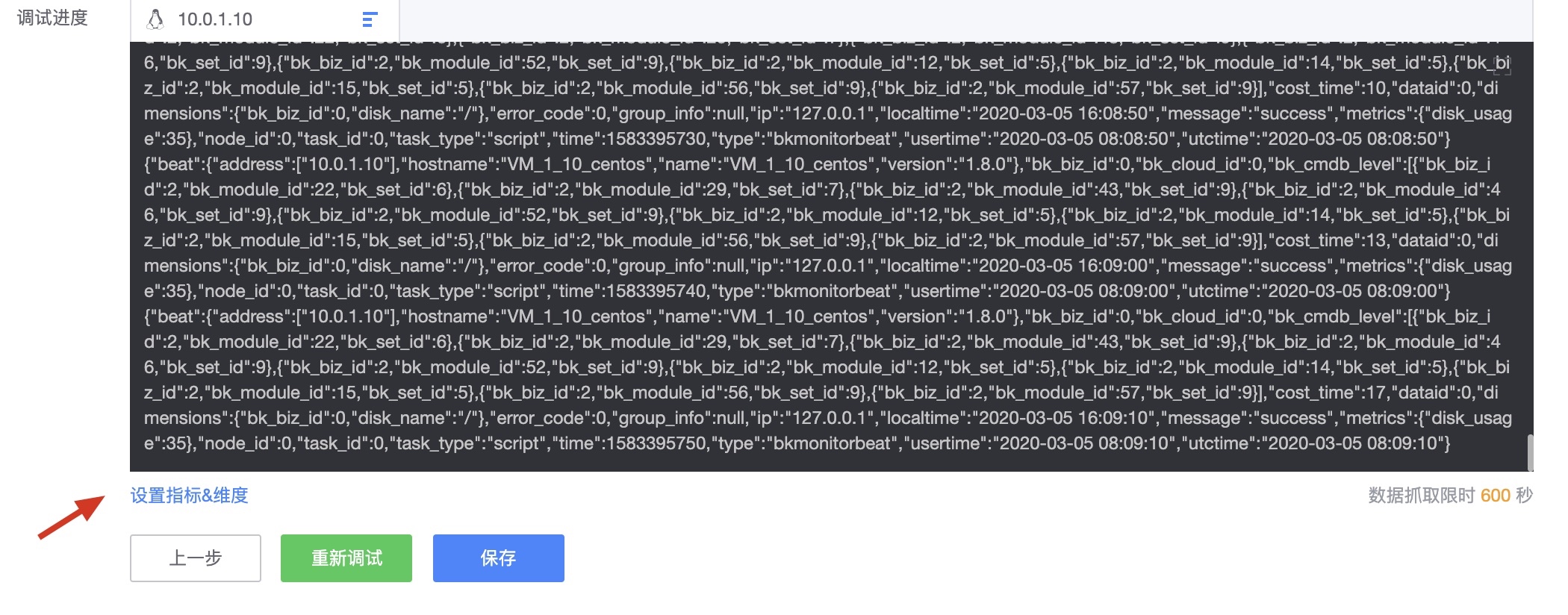

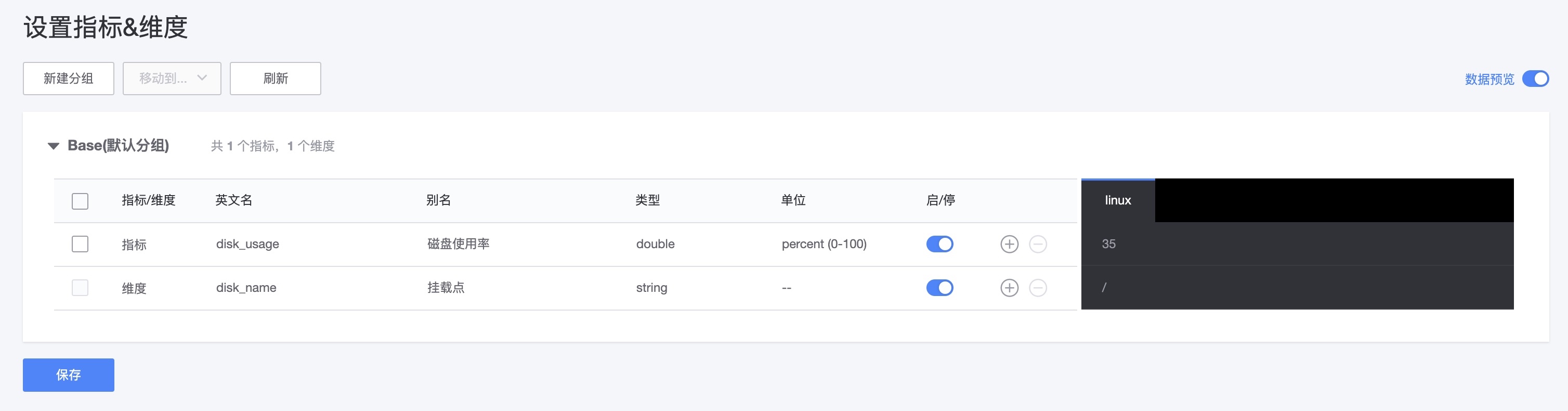

- 当联调获取到数据后会进行指标维度的设置确认。

- 确认联调结果并设置指标和维度,WeOps可识别脚本中的指标和维度,可以进行编辑和设置,比如设置中文名称等。此外,支持数据预览,方便的看到调试获取的数据值是否符合预期

- 第三步,保存插件。后续可在监控采集中使用该监控插件进行采集

Step2:设置监控采集

路径:管理-监控管理-监控采集

自定义插件制作完成后,可以在“监控采集”中对监控目标进行监控插件的下发和采集。

Step3:设置监控数据呈现

路径:监控视图-仪表盘/基础监控

监控采集设置完成后,和内置的监控插件一样,监控数据就可以上报,在监控视图、仪表盘可以展示出该插件采集上来的数据。

自定义监控插件(JMX插件)

背景介绍:可以采集任何开启了JMX服务端口的Java进程的服务状态,通过JMX采集Java进程的JVM信息;使用前提目标对象能够支持远程JMX协议连接,配置JMX远程支持需要重启中间件。 适用于所有的Java类型中间件软件的监控,无需开发,仅需提供配置信息;

step1:开启 JMX 远程访问功能

java 默认自带的了 JMX RMI 的连接器。所以,只需要在启动 java 程序的时候带上运行参数,就可以开启 Agent 的 RMI 协议的连接器。

- 对于自研 java 程序,例如 java 程序为 app.jar,其启动命令为:

java -jar app.jar - 对于第三方组件:各个组件的远程 JMX 开启方式,请参考各组件文档。

- 检查是否启动成功

客户端可以通过以下 URL 去远程访问 JMX 服务。其中,hostName 为目标服务的主机名/IP,portNum 为以上配置的 jmxremote.port。

service:jmx:rmi:///jndi/rmi://${hostName}:${portNum}/jmxrmi

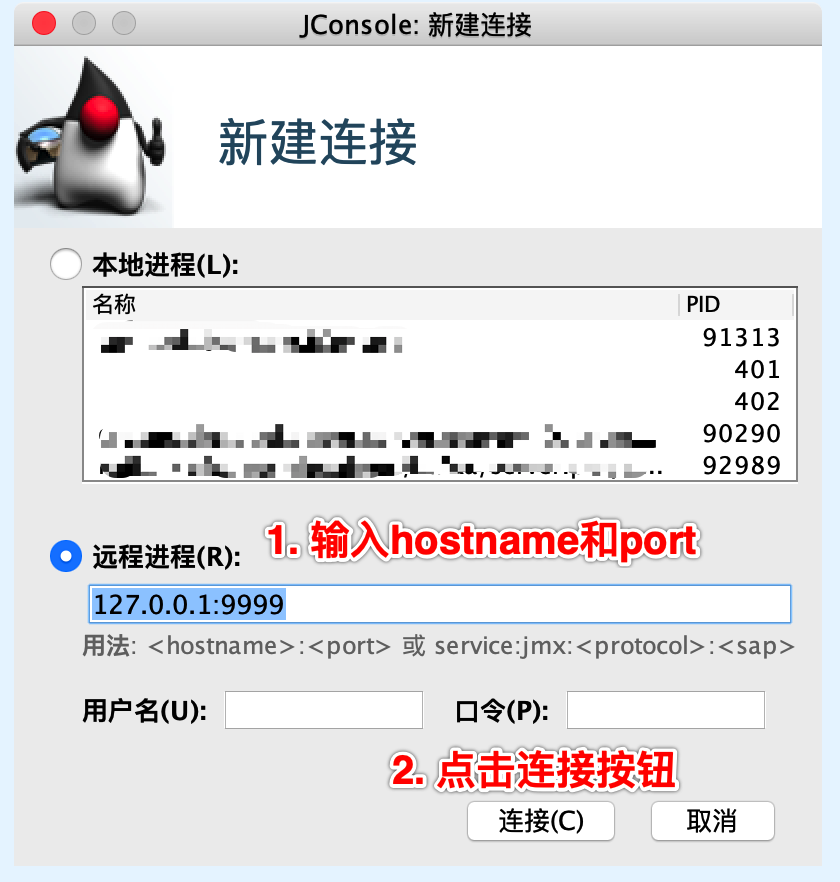

可通过以下两种方式检查是否已经配置成功:

1.简单地可通过检查端口是否存在,以及 PID 是否匹配,来确认 JMX 远程访问是否已经成功启动

netstat -anpt | grep ${portNum}

2.如果安装了 JConsole,也可直接连接测试

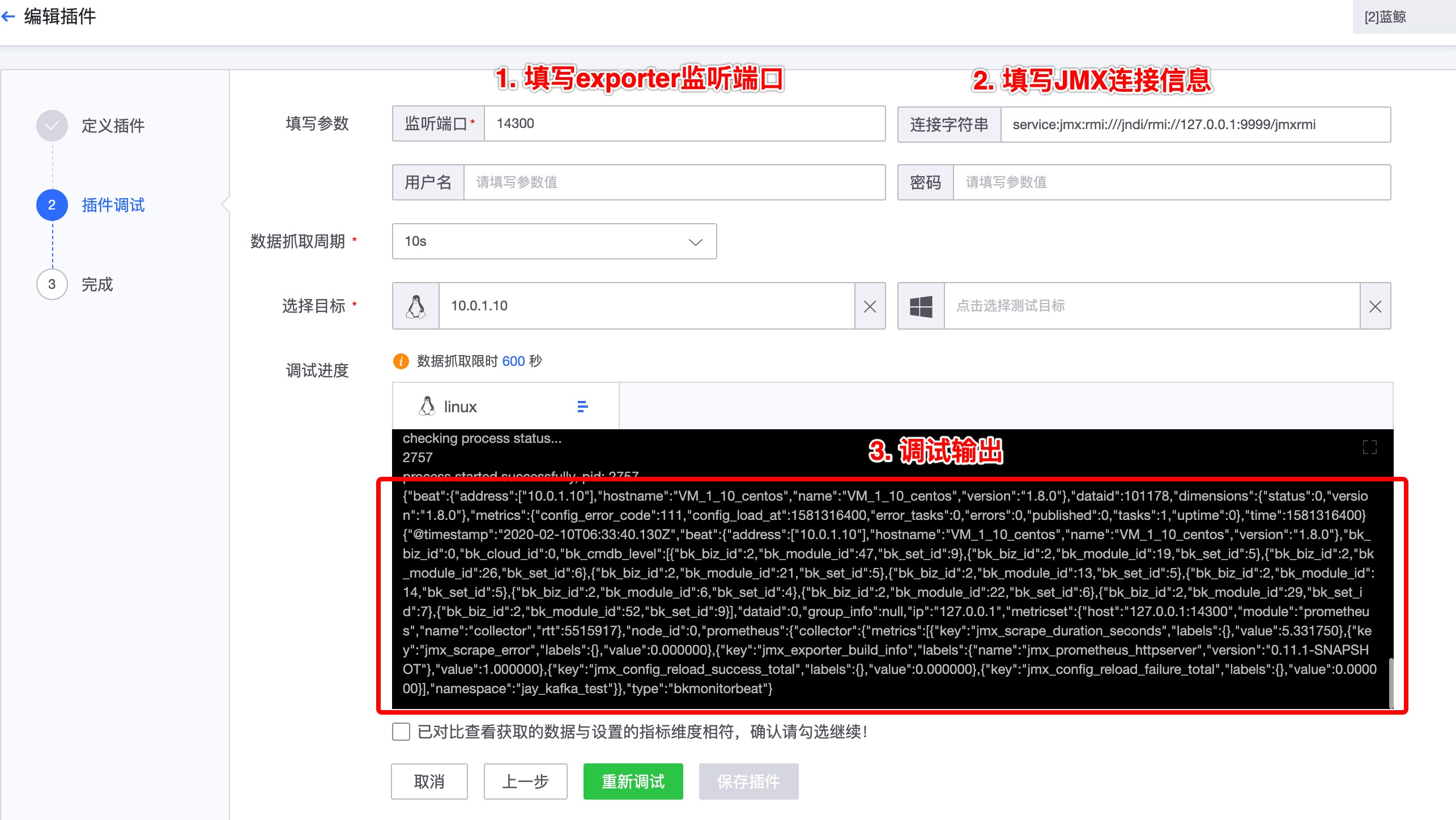

Step1:自定义插件制作

路径:管理-监控管理-监控指标-新建模板

如下图,点击“新建模板”,进入到插件定义页面,脚本插件的制作分为三步:插件定义、插件调试、编辑指标和维度等信息

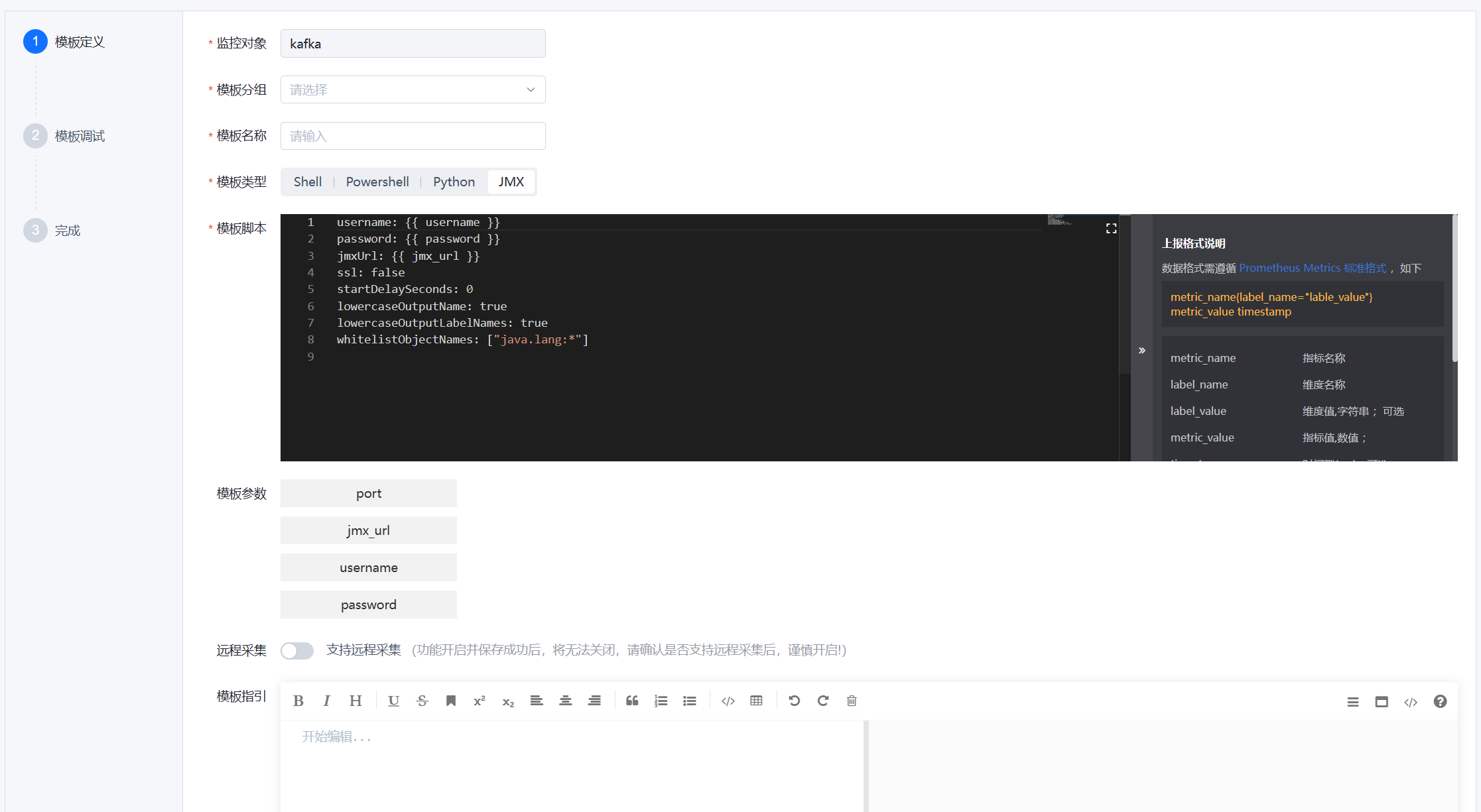

- 第一步,模板定义,填写对应采集配置,可参考以下示例:

# ==== 固定配置开始 ====

username:

password:

jmxUrl:

ssl: false

# ==== 固定配置结束 ====

# ==== 自定义配置开始 ====

startDelaySeconds: 0

lowercaseOutputName: false

lowercaseOutputLabelNames: false

whitelistObjectNames: ["Catalina:*", "java.lang:*"]

blacklistObjectNames: ["Catalina:j2eeType=Servlet,*"]

rules:

- pattern: 'Catalina<type=ThreadPool, name="(\w+-\w+)-(\d+)"><>(currentThreadCount|currentThreadsBusy|keepAliveCount|pollerThreadCount|connectionCount):(.*)'

name: tomcat_threadpool_$3

value: $4

valueFactor: 1

labels:

port: "$2"

protocol: "$1"

自定义配置结束 - 固定配置都必须严格包含以下属性。否则将无法正确地进行指标采集。

username:

password:

jmxUrl:

ssl: false- 自定义配置的字段的说明如下

| 字段名 | 含义 |

|---|---|

| startDelaySeconds | 启动延迟。延迟期内的任何请求都将返回空指标 |

| lowercaseOutputName | 小写输出指标名称。适用于 name。默认为 false |

| lowercaseOutputLabelNames | 小写输出指标的标签名称。适用于 labels。默认为 false |

| whitelistObjectNames | 要查询的 ObjectNames 列表。默认为所有 mBeans |

| blacklistObjectNames | 要查询的 ObjectNames 列表。优先级高于 whitelistObjectNames。默认为 none |

| rules | 要按顺序应用的规则列表,在第一个匹配到的规则处停止处理。不收集不匹配的属性。如果未指定,则默认以默认格式收集所有内容 |

| pattern | 用正则表达式模式匹配每个 bean 属性。匹配值(用小括号标识一个匹配值)可被其他选项引用,引用方式为$n(表示第 n 个匹配值)。默认为匹配所有内容 |

| name | 指标名称。可以引用来自 pattern 的匹配值。如果未指定,将使用默认格式:domainbeanPropertyValue1_key1_key2…keyN_attrName |

| value | 指标的值。可以使用静态值或引用来自 pattern 的匹配值。如果未指定,将使用 mBean 值 |

| valueFactor | 用于将指标的值 value 乘以该设置值,主要用于将 mBean 值从毫秒转换为秒。默认为 1 |

| labels | 标签名称到标签值的映射。可以引用来自 pattern 的匹配值。使用该参数必须先设置 name。如果使用了 name 但未指定该值,则不会输出任何标签 |

- 定义参数,JMX 插件不支持自定义参数,均为固定参数,各固定参数含义如下:

监听端口:JMX Exporter 启动时监听的 HTTP 端口,注意不是 JMX 端口

连接字符串:JMX RMI 的 URL,格式为 service:jmx:rmi:///jndi/rmi://${hostName}:${portNum}/jmxrmi。hostName 为目标服务的主机 IP,portNum 为 JMX 监听的端口号。将替换采集配置中的

用户名:若开启了用户认证,则需要输入,否则置空。将替换采集配置中的

密码:若开启了用户认证,则需要输入,否则置空。将替换采集配置中的 - 第二步,模板调试

填写相关参数,然后点击“开始调试”,稍等片刻后可查看调试输出。

指标维度,在插件调试获取到结果后,根据实际需要定义指标和维度。

- 第三步,保存插件,调试并确认数据上报正常后,可进入下一步进行保存。自此,一个 JMX 插件即制作完成。

Step2:设置监控采集

路径:管理-监控管理-监控采集

自定义插件制作完成后,可以在“监控采集”中对监控目标进行监控插件的下发和采集。

Step3:设置监控数据呈现

路径:监控视图-仪表盘/基础监控

监控采集设置完成后,和内置的监控插件一样,监控数据就可以上报,在监控视图、仪表盘可以展示出该插件采集上来的数据。

自定义监控插件(snmp插件)

背景介绍:SNMP是一个被业界广泛接受的,用于监测网络设备(计算机、路由器)甚至其他设备(例如UPS)的网络协议,属于应用层协议。

使用前提:用户具备可用的MIB库和被监控设备的oid值,用于生成采集监控模板。OID:设备通用的SNMP标识,格式是一段数字如1.3.6.1,使用snmp协议并通过oid访问 设备,即可获取对应oid下的设备信息,如启动时间等。MIB库:各设备官方提供的 设备oid描述文件,可以根据该文件得到能够用于监控的oid以及oid的内容描述信息

SNMP模板的适用对象:网络设备、硬件设备

1:导入SNMP指标模板

路径:管理-监控管理-指标管理

如下图,在指标管理中,选择网络设备-交换机,点击导入模板,可以进行不同品牌和型号的指标模板导入(WeOps提供了网络设备指标模板导入的入口,可监控的设备品牌、型号等支持拓展。可直接使用WeOps产研提供的文件进行导入拓展)

2:创建SNMP指标模板

路径:管理-监控管理-指标管理

点击进行snmp模板的新建,对于snmp模板可以进行对应指标的新增,便于后续使用。

具体说明如下

(1)指标型:指标型指标是通过设备的OID(对象标识符)来采集设备的实际数值。所以当某个指标可以找到对应oid进行数据采集时,可以创建指标型指标进行采集。

(2)计算型:对指标型指标的数值进行计算得到的指标。计算型指标可以用于更细粒度地监控设备性能,在计算型指标的公式中,需要引用现有指标,可以采用(指标英文名{template_id})的格式进行引用,公式中固定变量“template_id”为指标所在的模板ID,固定不变。比如“irate(ifOutOctets{template_id}[5m])”。

Step2:监控采集

当需要监控的网络设备已经纳管,并且有适用的监控指标模板(可以是内置的,也可以是导入创建的),可以对网络设备进行监控采集的创建,选择对应的目标,适用的指标模板,并填写凭据信息。

如下图,监控采集创建完成以后,可以在监控视图中,查看对应监控对象的监控信息

Step3:监控策略配置(以交换机为例)

- 网络设备监控采集新建完成以后,可以网络设备进行监控策略的配置。

- 如下图,进入到监控策略页面,选择网络设备-交换机,点击“新建”按钮

- 在新建界面,策略名称、和监控对象已经默认填写。点击“选择监控目标”,进行监控对象的选择点击“添加监控项配置”,可进行监控项的选择和配置

- 监控策略配置完成后,若采集的监控数据超过设定的阈值,则按照致命/预警/提醒三个等级进行告警。

日志配置

日志数据接入(syslog协议)

背景介绍:公司有许多的设备,这些运维设备/系统的日志比较分散,存储和搜索等不方便,可以统一接入WeOps的日志管理中,进行统一存储,统一查询、统一使用。

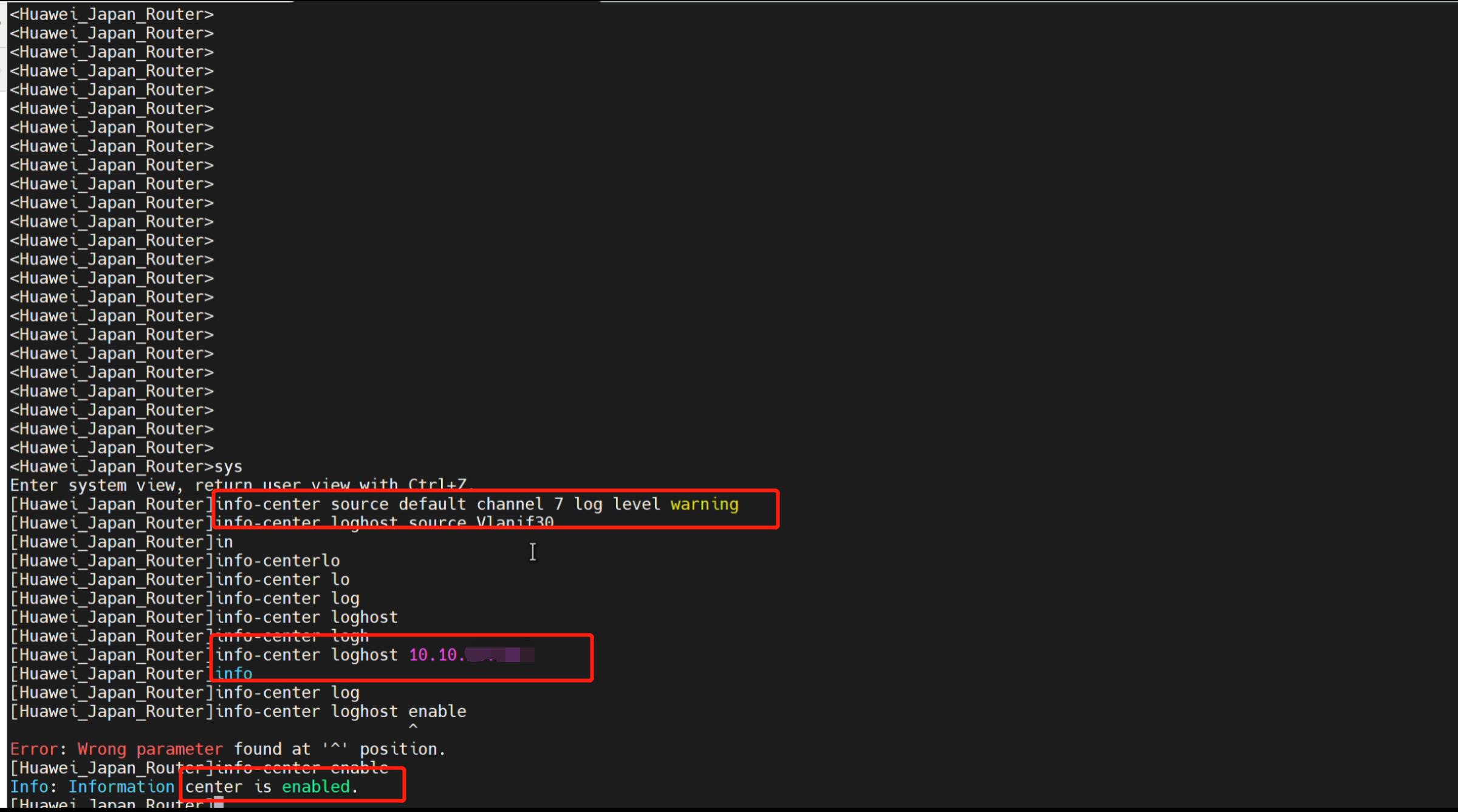

整体步骤:交换机配置——日志接入——日志展示

Step1:交换机配置

- 开通交换机和日志服务器的相关策略,包括开通端口和协议。(注意:使用syslog协议进行日志收集,需要开通【网络设备→日志服务器】的UDP协议,端口为514。)

- 使用以下命令对交换机进行配置,配置传输日志的级别,使用的VLAN和日志服务器。

info-center source default channel 7 log level warning

info-center loghost source Vlanif30

info-center loghost 10.10.xx.xx

Info-center enable

Step2:日志接入

路径:管理-日志管理-数据接收

- 交换机配置完成后,如下图,在WeOps中进行日志的接入,选择syslog UDP/TCP(适用于网络设备和安全设备的日志接入),填写相关信息,注意协议和端口要和第一步开通的策略一致。

设置完成之后,符合该协议该端口下的所有设备的日志信息会通过该接收器被WeOps的日志管理接收,可以查看日志接收的速率等情况。

Step3:日志展示

路径:日志

日志数据接收完成之后,可以在“日志”中查看这个接收器的日志情况,支持进行搜索。

日志数据接入(探针模式)

背景介绍:公司需要接入一批日志数据,需要通过安装探针的方式进行采集,可以使用WeOps-日志探针安装和下发模块进行。对于探针的安装支持agent和无agent两种模式

(1) agent模式(自动安装)

整体步骤:主机安装agent——安装控制器——安装探针——创建配置文件——安装探针、关联配置文件进行下发。

Step1:前提条件,开通对应网络策略,主机安装agent

- 使用探针的方式进行日志数据的接入,需要开通对应的网络策略,需要开通的策略具体如下。

| 源 | 目标 | 协议 | 端口 | 用途 |

|---|---|---|---|---|

| 采集服务器 | 日志服务器 | tcp | 9000 | 配置同步 |

| 采集服务器 | 采集kafka | tcp | 9092 | 数据传输 |

路径:管理-节点管理-Agent

- 使用的主机已经安装了agent,具体安装方法可见《操作手册-资源纳管-主机纳管》

Step2:安装控制器

路径:管理-节点管理-日志节点

- 对需要使用到的服务器,安装控制器,控制器的作用是控制探针的一些操作,所以安装探针之前需要对服务台安装控制器

- 如下图,进入日志节点页面,点击“添加主机按钮”选择需要安装控制器的主机,加入到列表后,同时进行控制器的安装,控制器的状态为“正常”可进行下一步。

Step3:安装探针

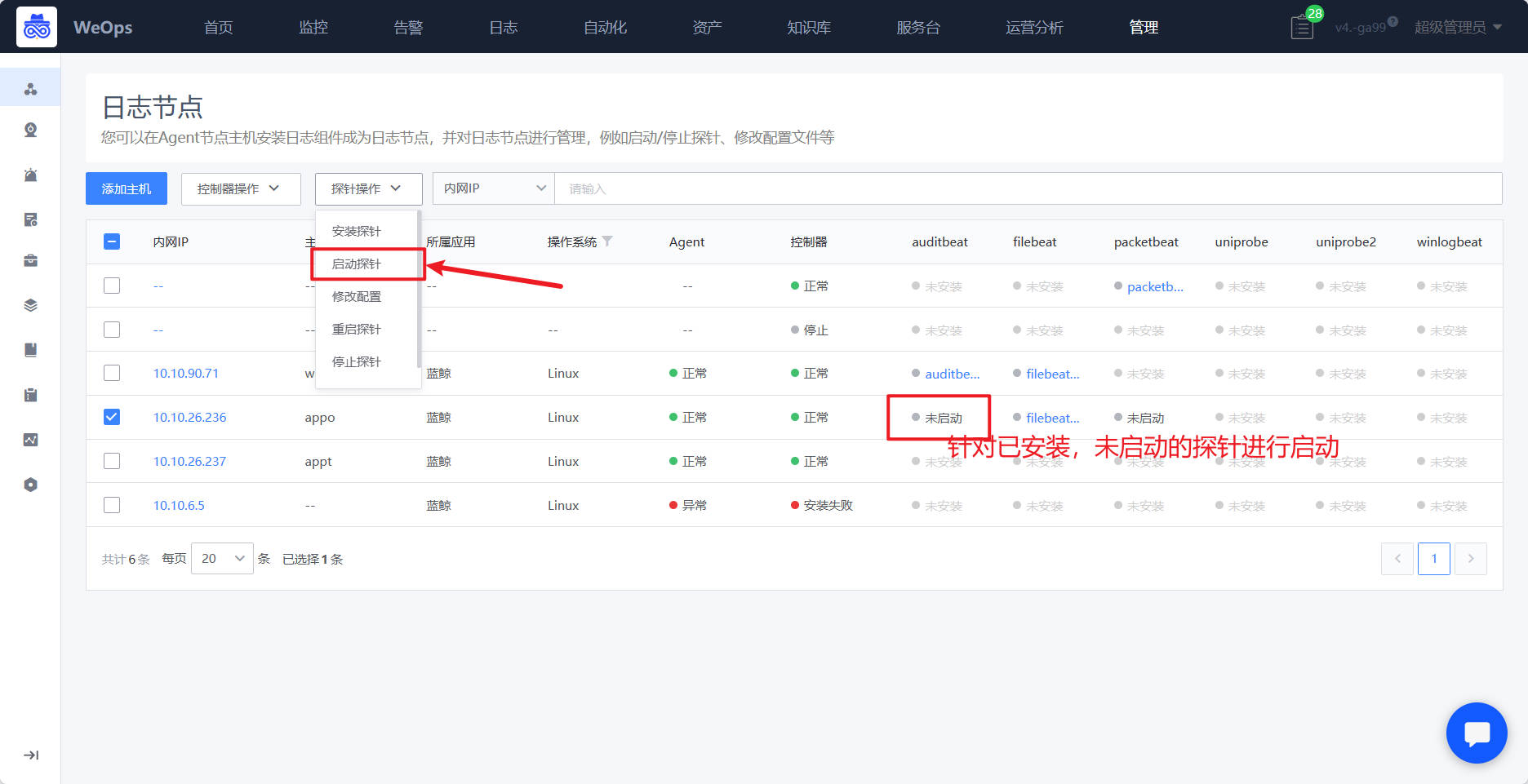

路径:管理-节点管理-日志节点

- 控制器安装好了以后,需要安装探针,目前WeOps内置了5类探针,auditbeat、packetbeat、filebeat、uniprobe、winlogbeat,需要使用哪类探针,勾选目标服务器后,点击“安装探针”按钮,选择给这个服务器安装探针,探针安装完后,显示“未启用”状态,需要后续关联配置文件方可启用。

Step4:创建配置文件

路径:管理-日志管理-采集配置

- 探针的启用需要关联对应的配置文件,WeOps支持对不同的探针设置配置文件,具体如下图

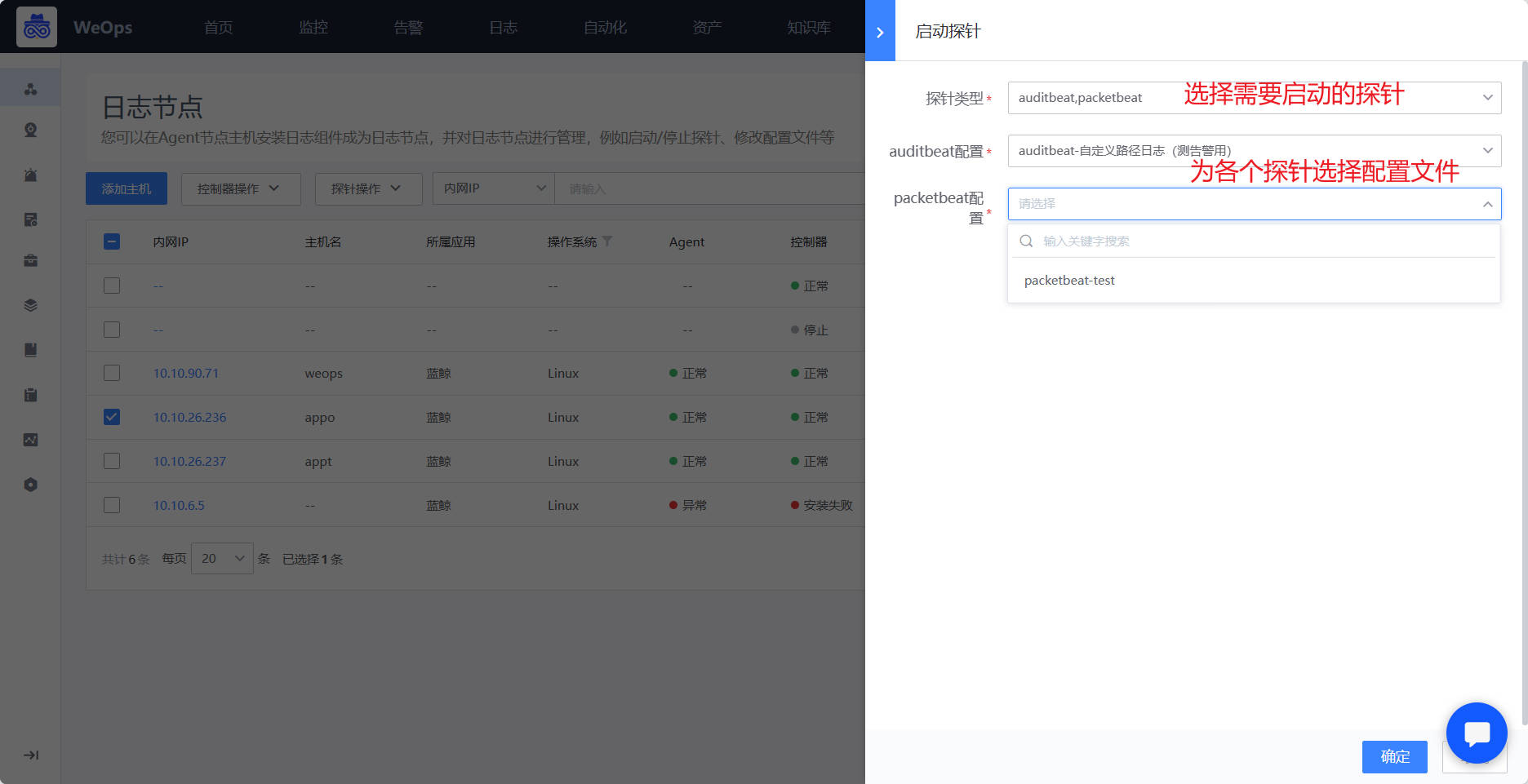

Step5:启动探针、关联配置文件进行下发

路径:管理-日志管理-采集配置

路径:管理-节点管理-日志节点

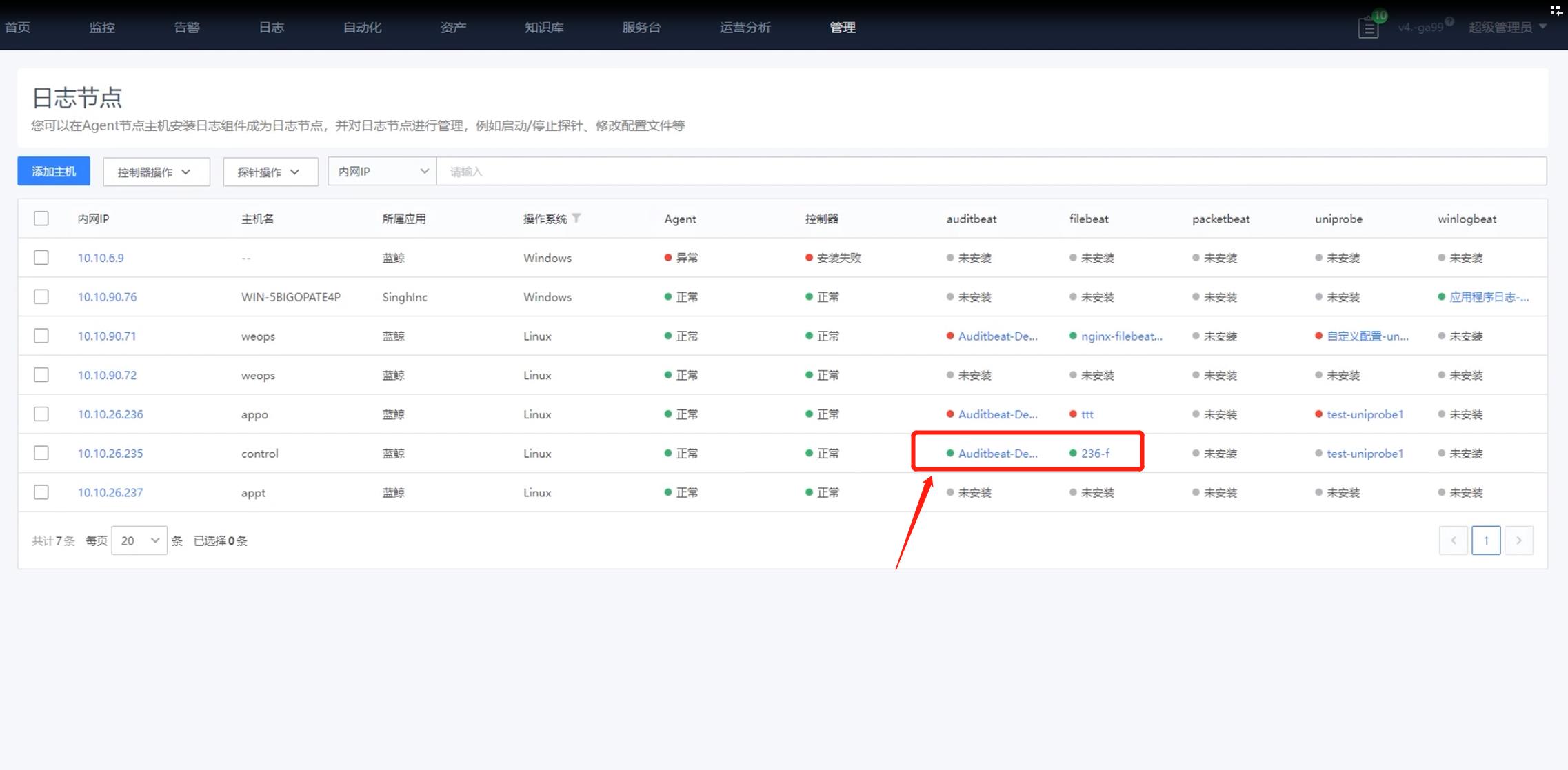

- 配置文件创建完成之后,需要把配置文件启用在具体探针上,有两种方式进行,一种是在配置文件列表点击“启用”按钮,把该配置文件启用在对应服务器的探针上面,如下图。第二种,是在日志节点页面,选择需要启动的服务器,选择需要启动的探针,为这个探针选择对应的配置文件。

- 当探针的状态为“绿色”则表明采集正常,可以在“日志搜索”页面查看接收到的日志信息

(2) 无agent模式(手动安装)

主机无需安装agent,采用手动的方式在服务器直接安装控制器和探针的安装包,并进行后续的使用。

整体步骤:手动安装————创建配置文件——关联配置文件进行下发。

Step1:安装控制器

- 如下图,点击“添加主机”,选择“手动安装”,这里可以选择没有安装agent/agent异常的主机,进入到手动安装页面,根据各个操作系统的指引进行安装(每个主机的步骤和参数略有不一样),安装成功后,自动获取状态为“安装成功”

- 安装成功的主机会自动呈现在外层的列表中,标识为“手动安装”,这是控制器状态为“正常”,其他所有探针状态为“未启动”,选择对应配置文件即可启动对应探针。

Step2:创建配置文件 Step3:关联配置文件进行下发

配置文件的创建和配置文件的关联和下发同“(1)agent模式(自动安装)”

- 日志控制器操作,包括安装、启动、重启、停止、卸载等操作可以根据指引进行手动操作,探针则包括安装探针、启动探针、修改配置、重启探针、修改探针等操作和自动安装的服务器一样,可以选择后自动操作。

日志分组配置

背景介绍:某公司接入的日志数据过多,对于日志的权限控制比较严格,可以通过日志分组的功能,对所有的日志消息进行划分不同的分组,并授权给不同的人员查看和使用。

整体步骤:设置日志分组——日志分组授权——日志分组使用

Step1:设置日志分组

路径:管理-日志管理-日志分组

- 如下图,创建日志分组,并为该分组创建符合的规则

- 分组规则:一个分组支持多个分组规则,可以在分组中进行创建和管理,分组创建完成之后,所有的原始日志会根据规则流入不同的分组,以便后续根据分组进行授权和使用。

Step2:日志分组授权

路径:管理-系统管理-角色管理

- 当日志分组创建完成之后,对不同角色进行授权,该角色即有该日志分组内日志的搜索和使用权限,授权过程如下:

Step3:日志分组使用

- 当普通用户拥有部分分组的权限时,将会体现在在以下位置

(1)日志搜索:普通用户在进行日志搜索的时候,可以选择自己有权限的分组和分组下的日志。

(2)日志监控策略创建:普通用户在创建日志的监控策略时,支持选择有权限的日志分组。

(3)仪表盘-日志组件:普通用户在使用仪表盘的日志组件的时候,支持选择有权限的日志分组。

日志提取配置

背景介绍:接入的日志数据比较原始,是非结构化/半结构化的数据,需要进一步进行提取,形成方面搜索/统计的字段,可使用日志提取功能

整体步骤:添加提取器(两种方式)——提取器效果

Step1:添加提取器(搜索页面进入)

路径:日志

- 在日志的搜索页,根据搜索条件展示出来需要的原始日志,在原始日志的字段值上可以进行创建提取器

- 支持复制输入、Grok模式等类型的提取器,以正则表达式为例,设置提取器支持填写正则表达式、设置条件(什么情况下进行提取)、存储字段、提取策略(复制一个新的,剪切成为一个新的)、添加特殊格式的转换器

Step1:添加提取器(数据接收进入)

路径:管理-日志管理-数据接收

- 支持为每个接收器创建提取器,选择提取的字段,为该字段选择适用的提取类型,设置提取规则并保存为新字段,以便后续使用。

- 在数据接收页面,点击“管理提取器”,进入到提取器管理页面,

- 在提取器管理页面,点击“开始提取”,通过最新数据/条件搜索两种方式,展示原始日志字段,用于创建提取器

- 这里以“正则为例”,展示提取器需要填写基础信息、提取规则,提取策略等相关信息,如下图,提取器设置完后,可以查看该提取器的性能情况。

- WeOps支持的提取器如下表

| 提取器名称 | 适用 | 说明 |

|---|---|---|

| 复制输入 | 适用于需要从非结构化的日志数据中提取特定字段或值的场景。 | 将原始消息中的一部分数据复制到提取器的规则中,并将其存储在结构化的数据字段中 |

| Grok模式 | 适用于需要从非结构化的日志数据中提取特定字段或值的场景。 | 用于从非结构化的日志数据中提取结构化数据。它使用预定义的Grok模式或自定义Grok模式来匹配和提取数据,包括一些特殊的模式,用于匹配常见的数据格式,如IP地址、日期、时间戳等。(WeOps内置常用的Grok表达式)(Grok表达式是一种用于解析非结构化或半结构化数据的模式匹配工具。它是由Elasticsearch社区开发的一种基于正则表达式的模式匹配语言) |

| JSON | 适用于处理JSON格式的日志数据的场景。 | 可以从JSON格式的数据中提取特定的字段,并将它们存储在结构化的数据字段中。 |

| 正则表达式 | 适用于需要从未结构化的日志数据中提取特定字段或值的场景。 | 使用正则表达式从数据中提取特定的字段,并将它们存储在结构化的数据字段中 |

| 正则表达式替换 | 适用于需要替换日志数据中特定字符串的场景。 | 正则表达式替换器可以使用正则表达式从数据中匹配特定的模式,并将其替换为指定的字符串 |

| 分隔 | 适用于需要从日志数据中提取特定字段或值的场景。 | 使用指定的分隔符将数据分割成多个部分,并将它们存储在结构化的数据字段中 |

| 子窜捕获 | 适用于需要从日志数据中提取特定子字符串的场景。 | 使用指定的开始和结束字符串或位置来捕获数据中的子串,并将它们存储在结构化的数据字段中 |

Step2:日志字段使用

路径:日志

- 在日志搜索页,可以查看提取后的字段和字段值,进行搜索和统计使用。

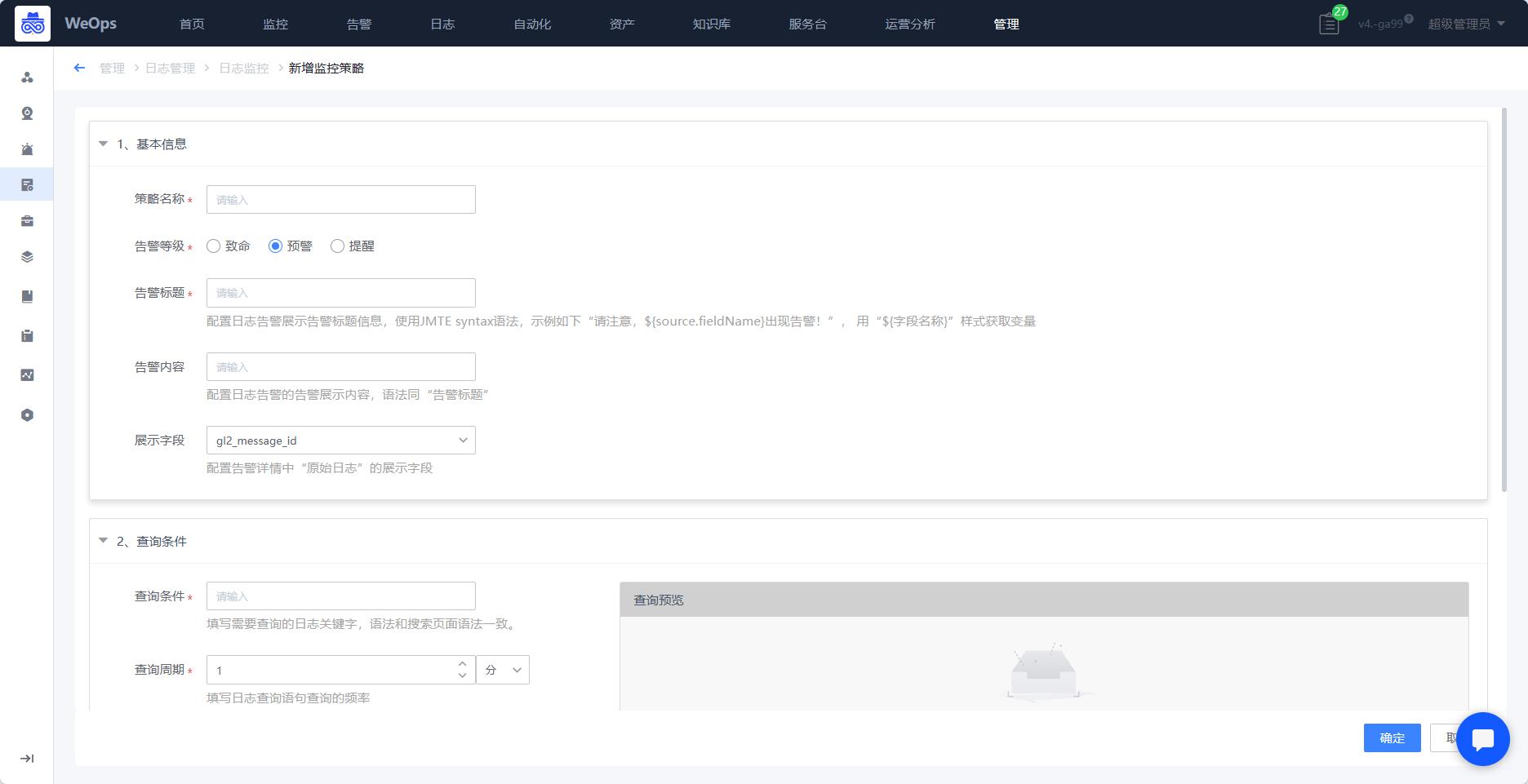

日志监控告警配置

背景介绍:公司的设备已经接入WeOps-日志,需要对某些设备日志监控监控,一旦发现异常情况,发出告警通知对应人员及时进行处理。

整体步骤:日志监控策略配置——日志告警查看和处理

Step1:日志监控策略配置

日志监控策略配置的入口有以下三种

- (1)日志搜索快捷创建:如下图,当日志搜索时,需要将搜索的关键词直接设置为日志监控搜索语句,可以通过

路径:日志-新建监控

- (2)监控策略:如下图,在监控管理-监控策略中也可以直接找到日志监控策略进行创建

路径:管理-监控管理-监控策略-日志策略

- (3)日志监控:如下图,在日志的管理的日志监控中,也可进行日志监控策略的创建

路径:管理-日志管理-日志监控

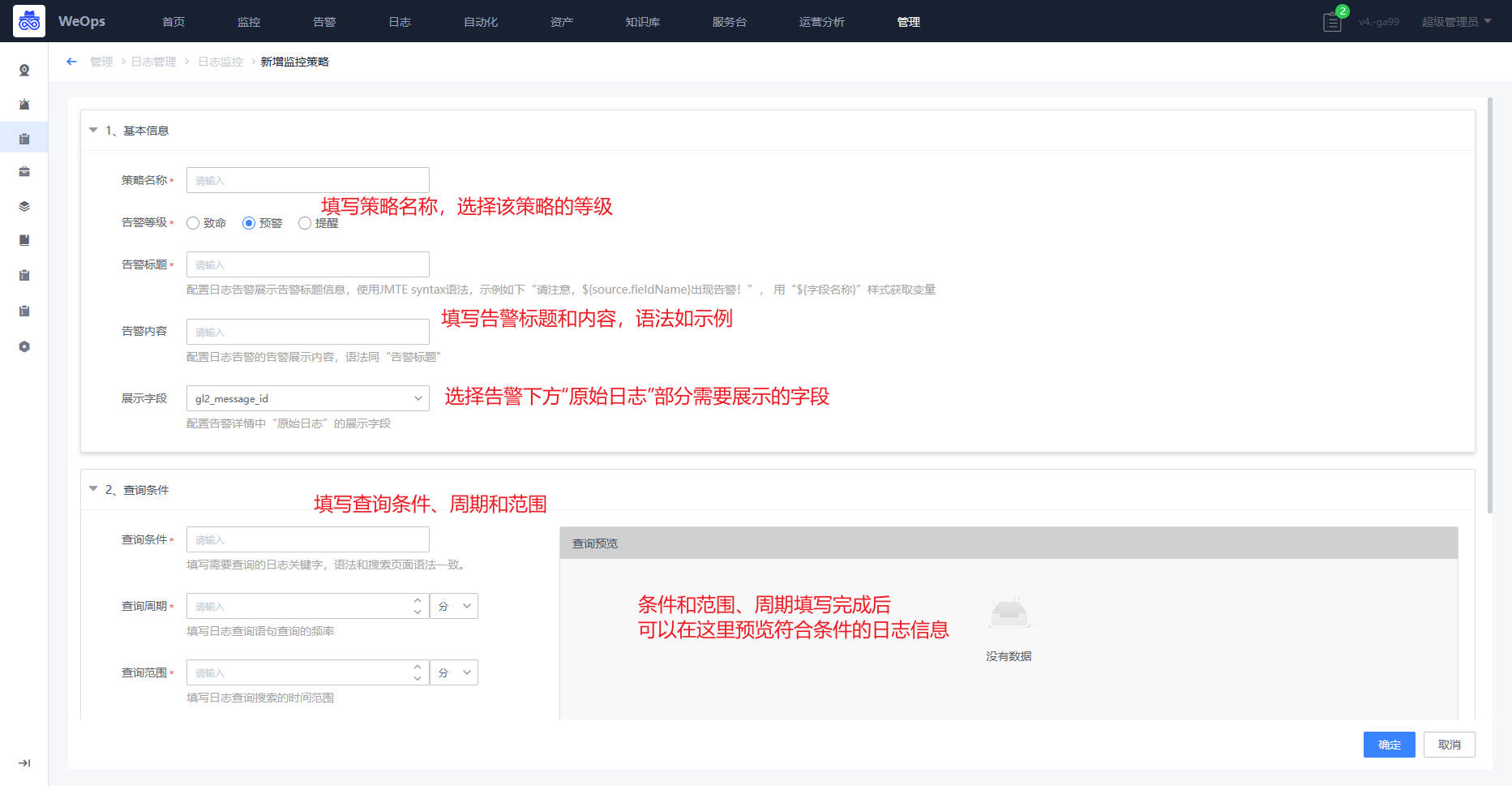

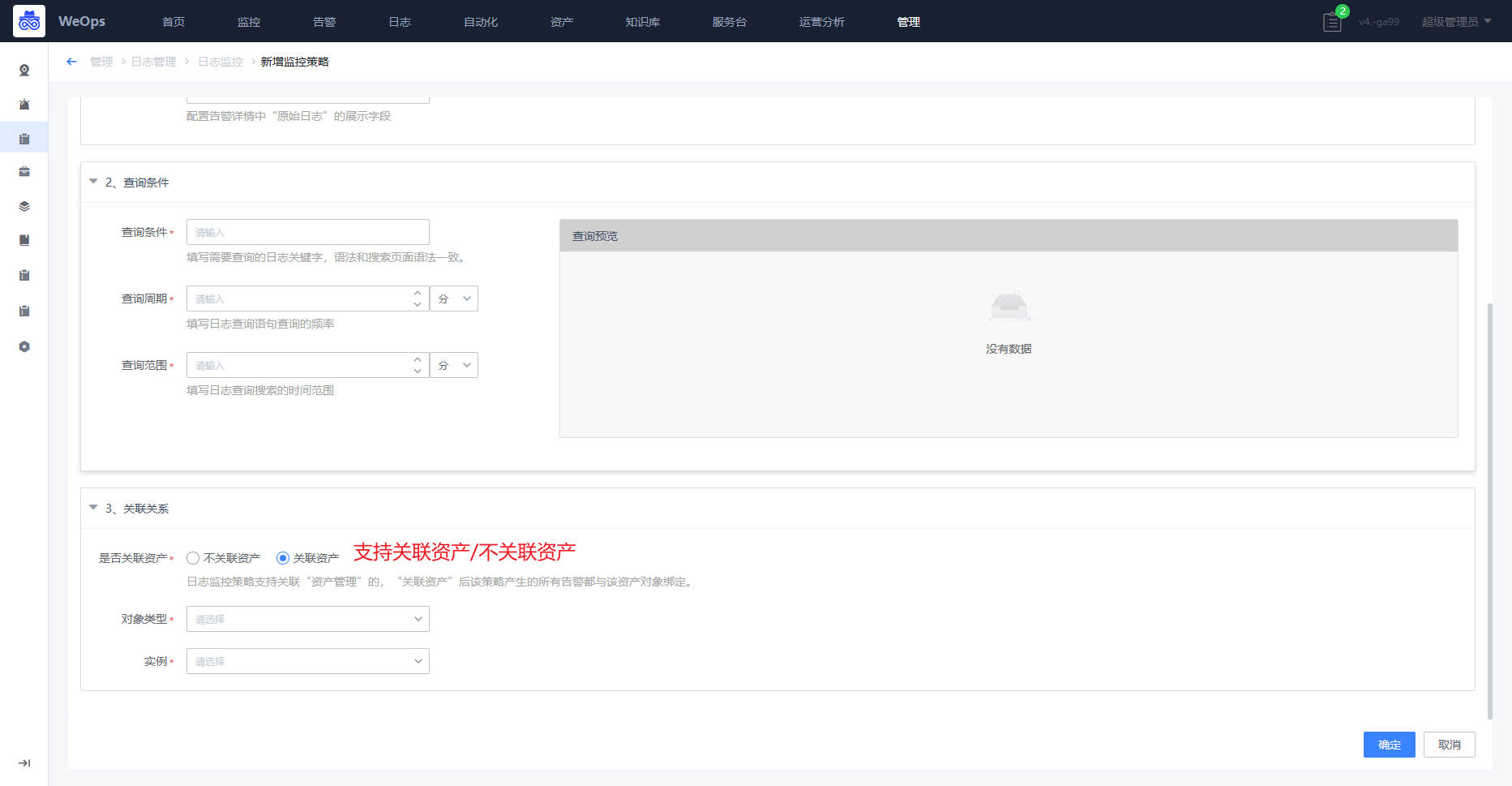

- 三个入口的日志监控创建策略页面一致,具体如下图

- (1)基本信息:

- (2)查询条件:支持

- (3)关联资产

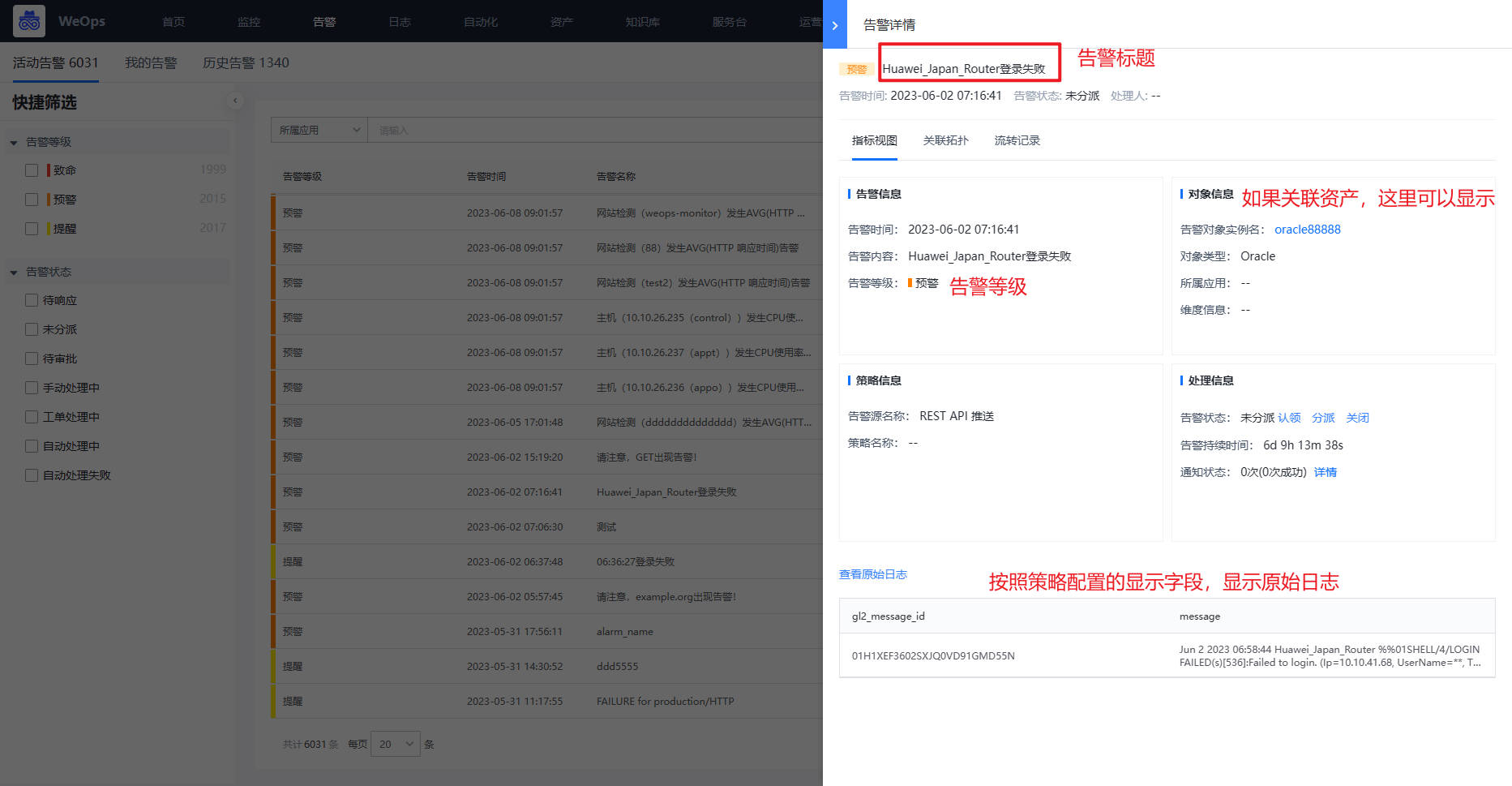

Step2:日志告警查看和处理

- 安装日志监控策略进行监控,一旦符合策略配置的条件,即可产生告警,告警内容如下图

日志关联资产

背景介绍:已经接入对应的日志数据,需要从资产的角度查询和使用对应的日志,可以将日志与资产进行匹配关联

整体步骤:创建数据关联——查看资产的日志数据

Step1:创建数据关联

路径:管理-资产管理-数据关联

如下图,点击“新建关联”,选择对应的关联资产模型(比如主机),可以过滤需要的日志(从日志分组和查询语句两个角度进行过滤),并且通过字段的匹配,动态查找到对应的资产(比如source字段匹配主机的内网IP,当出现的日志数据中source是某个固定的IP时,就会归属到这个对应资产)

Step2:查看资产的日志数据

当匹配设置完成后,设置了匹配规则的模型下的资产,会增加“资产日志”的tab,呈现该资产的日志数据,具体有如下两个地方。

路径:资产-资产记录-对应模型/资产

- 如下图,当在“资产管理-数据关联”中配置好资产和日志的匹配关联后,可以在此处查看该资产的相关日志信息

路径:监控-告警对象/监控视图-对应资产

- 通过“资产管理-数据关联”设置资产和日志的匹配规则,将会在资产的监控信息中展示与该个资产相关联的所有的日志数据

自动化运维配置

工具管理

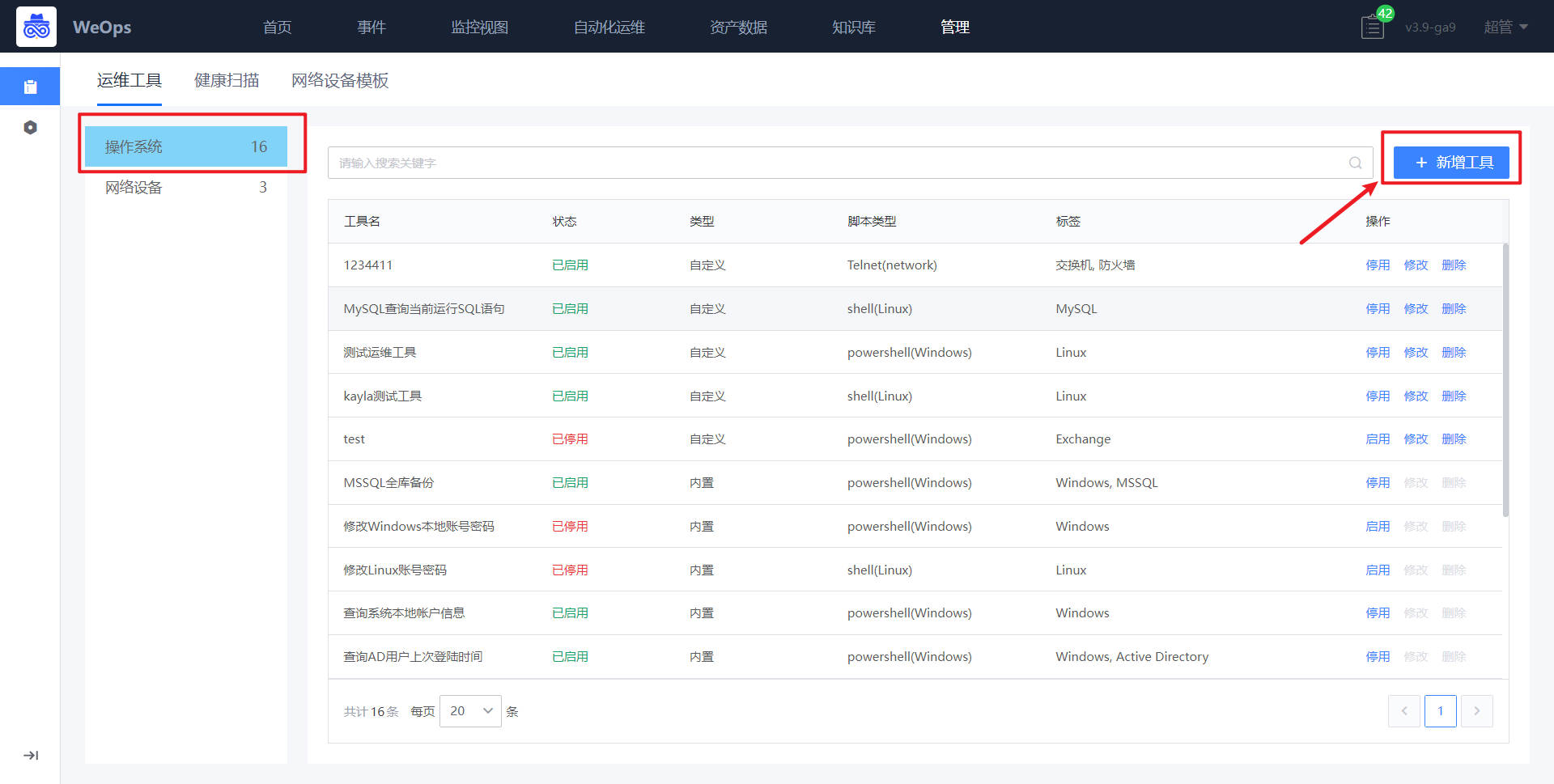

背景介绍:公司有经验的运维人员需要将自己沉淀的脚本转化为小工具,便于后续其他运维人员使用。

整体步骤:新建工具——工具使用

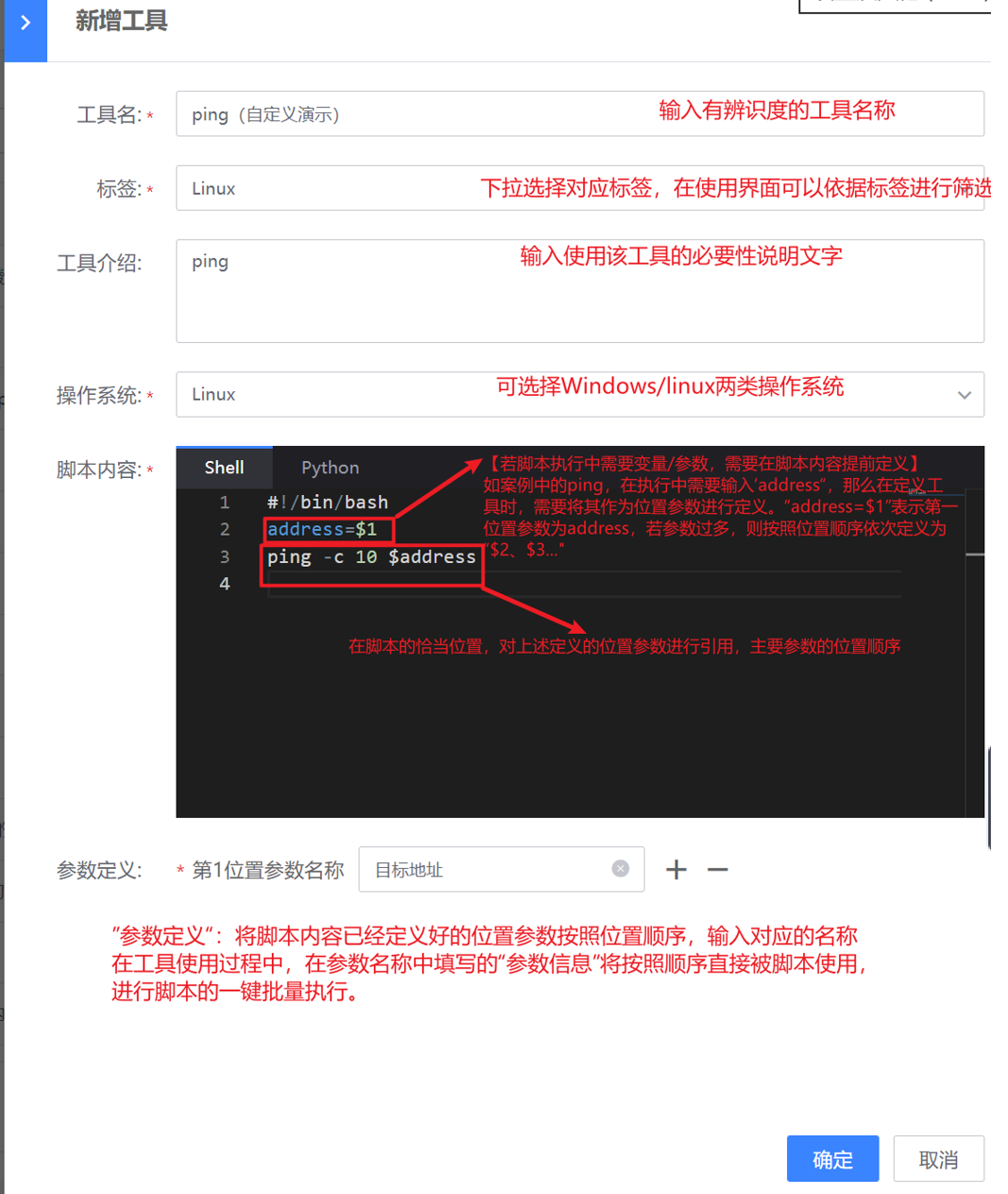

新建工具

路径:管理-管理中心-自动化运维-运维工具

WeOps-运维工具包括操作系统和网络设备两类

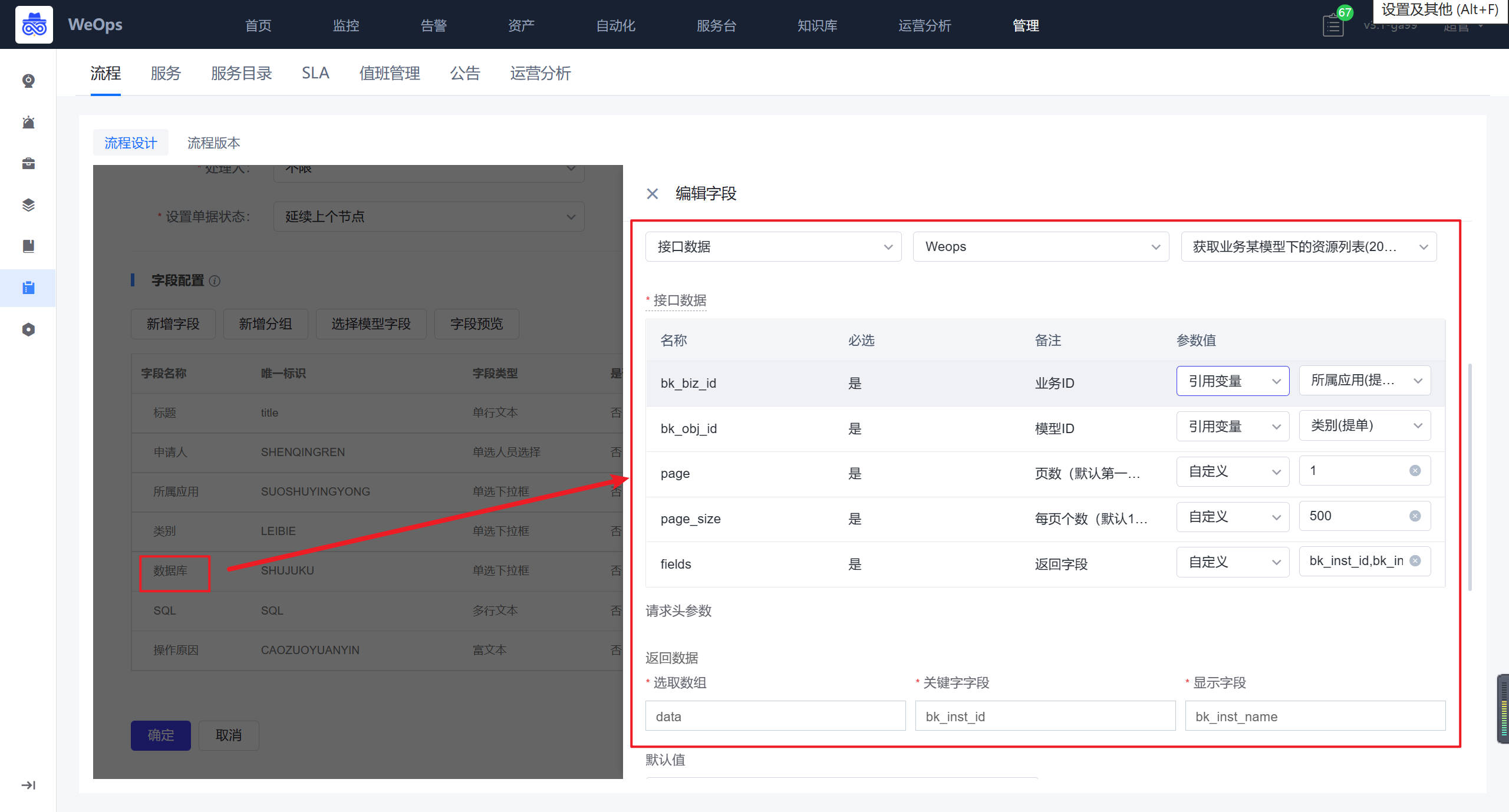

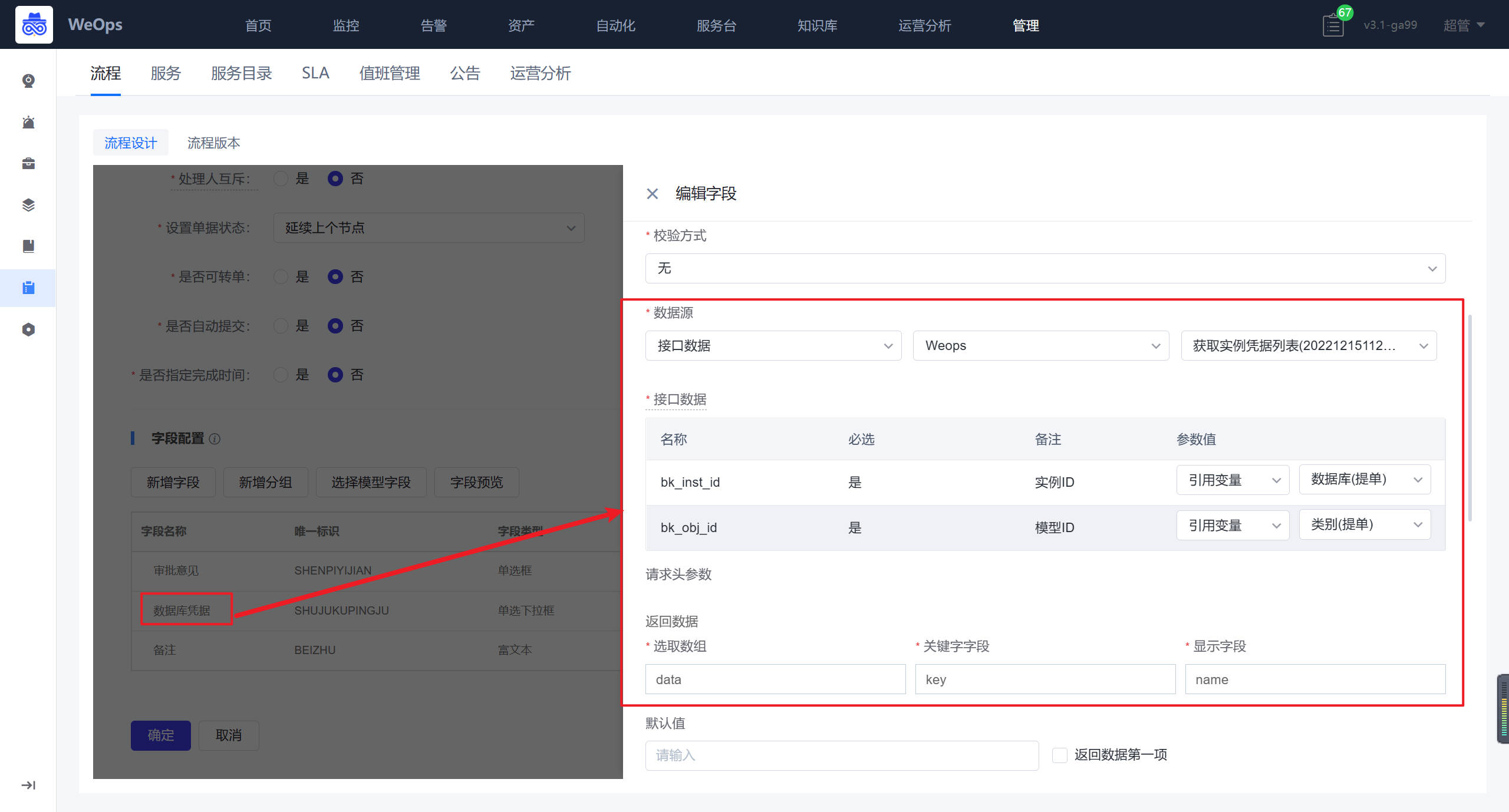

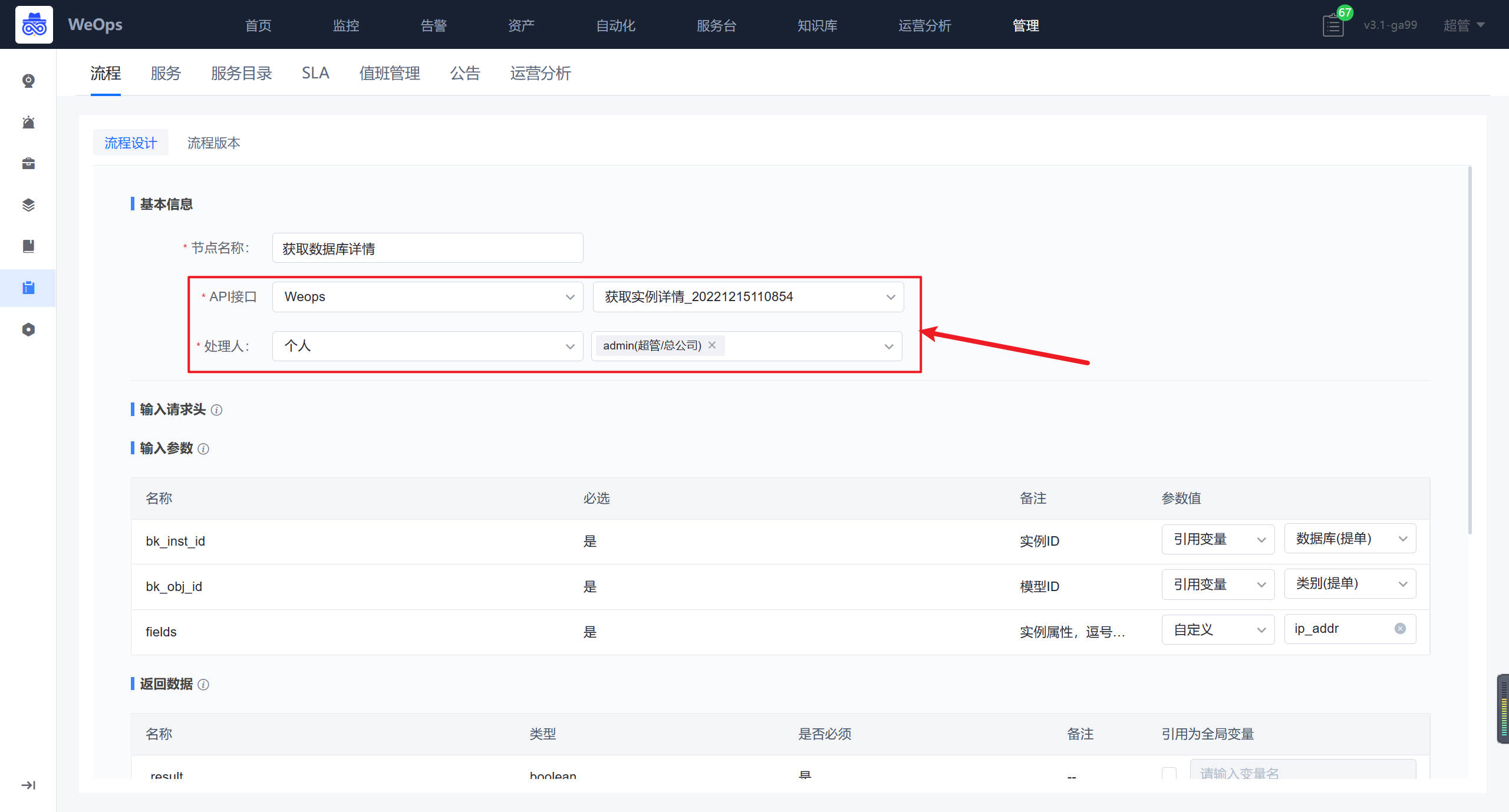

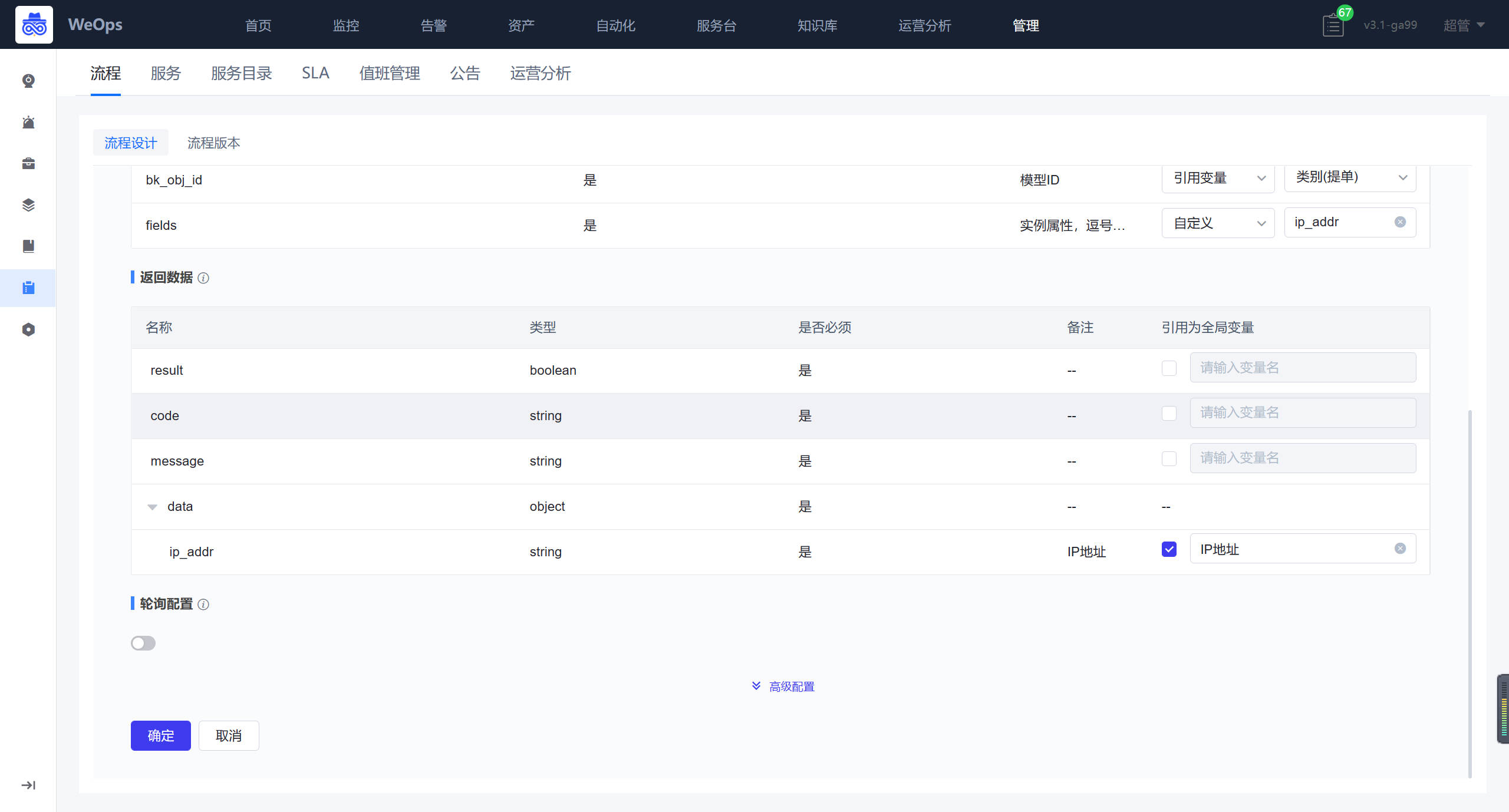

首先是操作系列类的工具新建:在工具管理界面,点击“新增工具”可进行工具的新增